2. 南京信息工程大学 计算机学院, 南京 210044;

3. 南京理工大学 计算机科学与工程学院, 南京 210094

2. School of Computer Science, Nanjing University of Information Science and Technology, Nanjing 210044, China;

3. School of Computer Science and Engineering, Nanjing University of Science and Technology, Nanjing 210094, China

在遥感图像目标检测等特殊领域中, 物体通常密集排列并且呈现出任意方向的分布. 针对这种情况, 在遥感图像中使用通用的水平目标检测方法会导致一系列问题, 包括目标边界框的大量重叠以及目标框包围背景范围过大等[1], 如图1(a)所示. 相比之下, 采用旋转矩形表示的定向边界框提供了一种更为紧密和准确地描述遥感图像中具有任意方向目标的有效替代方案. 首先, 它能够准确反映目标的真实宽高比. 其次, 定向边界框有助于有效地将目标与背景分离, 特别是对于密集排列的目标更具优势. 因此, 针对遥感图像的目标检测任务常被称为定向目标检测.

|

图 1 遥感图像目标检测示意图 |

在目标检测任务中, 精确评估算法性能的指标是至关重要的. 平均精度(AP)被广泛用于量化检测模型在不同交并比(IoU)阈值下的准确性. 其中, AP50和AP75分别代表的是当预测框与真实目标框的交并比达到50%和75%时的检测精度, 是主要的评价指标. 目前定向目标检测的算法性能主要是由AP50来衡量[2], 意味着预测框和真实值之间的倾斜交并比(SkewIoU)大于0.5就被确定为正样本. 然而航空遥感图像的某些类别物体往往具有宽高比过大的特征, 如桥梁、大巴车和舰船等. AP50这一评价指标无法精准衡量具有过大宽高比例的目标的预测角度准确性. 这是因为不同宽高比的目标框在SkewIoU方面呈现两种明显趋势: 当宽高比小于1.5时, SkewIoU对于角度偏差不敏感, 几乎始终大于0.5; 而当宽高比大于1.5时, SkewIoU随着角度偏差的增大快速衰减, 但仍保持较大范围的角度偏差容忍限度[3]. 然而在定向目标检测中, 角度作为一个独特的参数在实现高精度检测方面发挥着至关重要的作用. 因此, AP50不适合定向目标检测任务, 尤其是高精度检测. 在这一背景下, 更严格的度量(AP75)成为关键的性能评价标准. AP75要求检测算法在IoU为75%时取得良好的性能, 这正是在处理大宽高比目标时尤为重要的一个阈值. 通过这一指标, 衡量定向目标检测算法是否更关注角度的预测, 并促进算法专注于更有意义的高精度定向目标检测.

此外, 航空遥感图像通常具有广阔的视场, 大多数目标呈微小且密集排列的状态, 如图1(b)所示. 同时由于航空遥感图像背景的复杂性, 目标周围经常存在各种干扰因素, 例如建筑物、道路、植被等, 导致目标的边缘特征和纹理不够明显. 这给目标的密集预测精确定位带来了巨大挑战, 增加了检测的难度.

针对上述挑战, 本文设计了一种全局上下文注意力特征融合网络(global contexts attentional feature fusion pyramid network, GCAFFPN), 包含一个三重注意力特征融合模块(triple attentional feature fusion, TAFF), 更有效地融合带有不同语义和尺度特性的特征, 从而提高模型的整体性能. 此外, 通过层内调节方法的引入, 本文改进并提出全局上下文信息增强网络(global contexts enhance network, GCEN), 通过对深层特征进行细化, 动态增强密集排列小目标的边缘纹理及. 在此基础上, 本文借鉴全局集中调节的思想构建了GCAFFPN, 通过注意力调制特征, 自上而下地调节浅层多尺度特征, 提高模型对不同尺度下目标的全局感知能力. 本文对提出的方法在两个流行的遥感图像旋转目标检测数据集基准(DOTA-v1.0[1]和HRSC2016[4])上进行了全面评估, 在不同数据集上均表现出卓越的高精度定向目标检测性能. 总的来说, 本文的主要贡献包括以下内容.

● 针对遥感图像背景复杂, 目标尺寸微小、宽高比过大的问题, 通过引入层内特征调节方法改进并设计了一个全局上下文信息增强网络(GCEN)对主干网络提取的最深层特征进行细化调节. 此外, 本文提出了一种三重注意力特征融合模块(TAFF)来融合从主干网络中提取的多尺度特征图以及经过全局上下文信息增强的深层特征.

● 本文在提出的三重注意力特征融合模块和全局上下文信息增强网络的基础上, 改进并设计了一种全局上下文注意力特征融合金字塔网络(GCAFFPN), 进一步提高模型对不同尺度间信息融合的能力, 提升网络高精度检测的性能.

● 在目前主流的遥感图像目标检测开源数据集上的广泛实验: 在DOTA-v1.0和HRSC2016数据集上展示了本文提出的方法的有效性. GCAFFPN在定向目标检测高精度评价指标上实现了较为先进的性能.

2 相关工作近年来, 由于遥感技术应用的深入研究, 定向目标检测作为目标检测应用的扩展受到了广泛关注[2,5–10]. 具体来说, RoI Transformer[2]提出了一个有监督的旋转RoI学习器, 它从RPN网络生成的水平RoI中学习旋转的RoI, 这种方法大大提高了有向物体的检测精度. Yang等人[5]在通用目标检测算法Faster R-CNN的框架上构建了一种旋转目标检测方法SCRDet, 这一方法针对小目标提出了一种特征融合结构, 并引入了多维注意网络来减少背景噪声. 为了进一步解决遥感目标检测的挑战, Yang等人在文献[6,7]的工作中使用密集特征金字塔(DFPN)进行多尺度特征融合以及旋转回归的结合用于遥感图像中船舶的定向检测. Zhang等人[8]提出的CAD-Net设计了一个上下文感知网络来学习全局和局部上下文, 并利用注意调制特征和空间和尺度感知的注意模块来引导网络在适当的特征尺度上关注更多信息区域, 同时抑制无关信息. Xie等人[9]提出的Oriented R-CNN设计一个精简的定向区域建议网络(Oriented-RPN)来直接生成高质量的定向候选区域, 大大提高了两阶段检测器的效率. 最近, ReDet[10]使用旋转等变主干来编码旋转等变特征, 并设计了一种新颖的旋转不变RiRoI Align模块来从旋转等变特征中自适应地提取旋转不变特征.

在遥感图像目标检测领域, 研究定向目标检测的方法旨在提升算法对尺度变化的适应性和鲁棒性, 这些方法着眼于解决遥感图像中目标尺度多样性和复杂背景带来的挑战, 为提高检测性能提供有效手段, 以满足实际应用对高效、准确检测的需求. 目前的大多数方法主要仅关注AP50评价指标的结果, 并在AP50指标上实现了较高性能[2,11–13]. 但在面对大巴车、桥梁、舰船和码头等目标时, 继续使用AP50指标无法精确衡量预测角度的准确性. 现有的大多数方法往往无法很好地应对遥感图像中小目标密集排列以及大宽高比目标等具有挑战性的场景, 导致高精度检测性能存在明显的缺陷. 同一模型的实验结果(AP50)相较于精度要求更高的AP75评价指标存在较大的差距.

最近, 针对高精度定向目标检测这一需求, 一些方法[3,14]通过引入特定的损失函数和优化策略, 致力于解决传统回归损失在处理大宽高比目标时容易导致的问题. 具体而言, Yang等人[14]提出的KLD损失将旋转后的边界框变换成光滑的高斯分布, 计算高斯分布之间的KL散度作为回归损失, 使其在处理大宽高比目标时能够更加准确和稳健. 在之后的工作中, Zeng等人[3]提出应用Transformer的高精度定向检测器ARS-DETR, 设计了一种新的角度分类方法, 称为AR-CSL, 采用基于宽高比的动态权重系数来计算角度损失以更好地适应目标的尺度和长宽比变化, 从而提高检测模型对于大宽高比目标的角度定位能力. Xu等人[15]针对边界框旋转角度不连续问题提出了基于极坐标分解的角度修正模块ACM, 旨在以更合理的方式平滑角度标签, 将模型输出的平滑值转换为锯齿状的角度值, 从而消除了因断点问题导致的角度预测的不稳定性. 通过这一策略, 模型能够更好地利用类IoU损失来进行边界框回归参数的优化, 在高精度定向目标检测方面表现出具有竞争力的性能.

上述工作都提倡使用AP75作为高精度定向目标检测更可靠的指标, 避免AP50对角度偏差灵敏度的不足, 并为高精度定向目标检测方法的发展提供了有效的途径. 此外, 前面提到的ReDet[10]在高精度定向方面也有着显著提升, 显示了旋转等变主干网络ReResNet50对定向目标高精度定位的卓越能力. 因此本文的方法以ReDet为基线模型, 致力于改进不同尺度间信息融合的能力, 实现高精度定向目标检测.

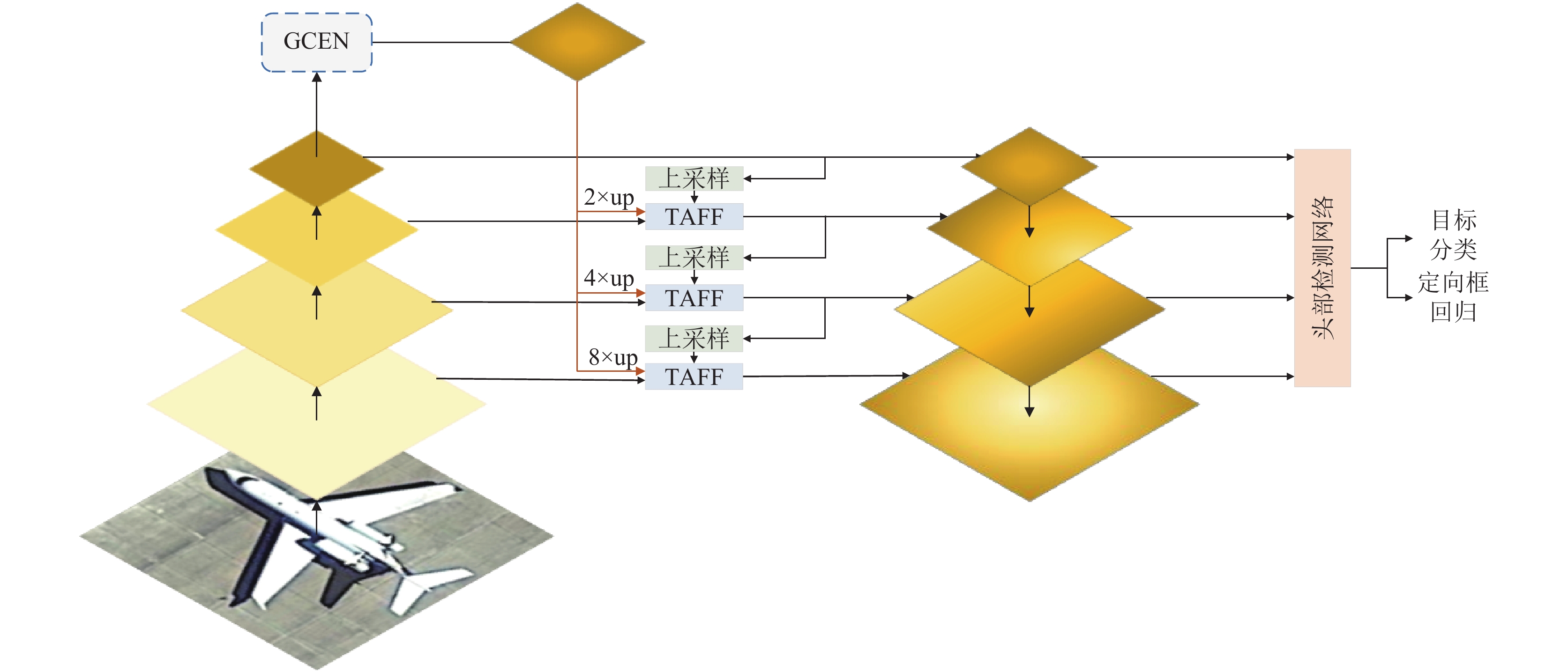

3 模型概述本文提出的整体框架如图2所示, 全局上下文注意力特征融合金字塔网络(GCAFFPN)主要由以下部分组成: 输入图像、主干网络ReResNet50用于提取P2–P5多尺度特征、改进的全局上下文信息增强网络(GCEN)、所提出的三重注意力特征融合(TAFF)和检测头部网络(由分类损失和回归损失共同组成)用于目标检测. 如图2所示, 本文的GCAFFPN以旋转等变检测器ReDet[10]为基线模型, 其建立在经典的两阶段检测网络Cascade-RCNN[16]和FPN[17]的结构上. GCAFFPN的设计使其能够轻松地与现有的检测网络集成, 无需进行任何适应或额外的监督信息. 更多细节将在后续小节中展开讨论.

|

图 2 全局上下文特征融合金字塔网络架构图 |

3.1 三重注意力特征融合

注意力机制是近年来卷积网络中常用的特征调制方法, 用于提升模型自适应的能力. 经典的通道注意力SE-Net[18]只利用了全局通道注意, 偏向于全局特征范围的上下文信息. 而多尺度通道注意力模块MS-CAM[19]不仅实现了全局尺度注意, 还自适应地聚合了局部通道上下文, 这有助于网络关注背景噪音较少的对象, 更有利于微小目标的检测. MS-CAM通过尺度不同的两个分支来提取全局特征

|

图 3 三重注意力特征融合模块结构图 |

这部分操作可以表示为:

| L(X)=BN(PWConv2(σ(BN(PWConv1(X))))) | (1) |

| F(X)=G(X)⊕L(X)=GAP(L(X))⊕L(X) | (2) |

其中,

在此之后, 本文设计了一个能够分配三重特征层权重的分配模块(weight allocation module, WAM), 如图3(b)所示, 包含stack堆叠、Softmax计算和split分割等操作, 计算共同输入的三重特征各自的注意力权重信息. 本文在引入多尺度通道注意力(MS-CAM)的基础上, 设计了一种三重注意力特征融合模块, 见图3(c).

| X′=X⊗WAM(F(X)) | (3) |

最终借鉴迭代注意力特征融合iAFF[19]的方法, 将第1轮得到的注意力特征

| {\boldsymbol{X}}'' = {\boldsymbol{X}}' \otimes WAM(F({\boldsymbol{X}}')) | (4) |

| {\boldsymbol{O}} = {\boldsymbol{X}}'' + {\boldsymbol{Y}}'' + {\boldsymbol{Z}}'' | (5) |

同理,

现有的特征金字塔网络[17,20]常使用骨干提取最深层的4层或5层特征作为自上而下特征融合的输入, 主要集中在层间特征交互上, 然而却忽略了层内特征的规范对小目标密集预测任务的有效性[21,22]. 在本文的工作中, 改进了一个全局上下文信息增强网络(GCEN), 其结构如图4所示. 首先引入层内特征调节方法: 显式视觉中心[23], 同时借鉴InceptionV3的理论, 将原来的输入颈块替换为一个Inception结构.

|

图 4 全局上下文信息增强网络结构图 |

如图4所示, GCEN主要由两个并行的模块组成, 分别是一个轻量化MLP和一个可学习的视觉中心, 不仅可以提取全局远程依赖关系, 还尽可能地保留输入图像的局部角点区域信息. GCEN的输出是两个模块的结果特征图沿着通道维度上连接在一起的特征图. 上述过程可以表述为:

| {\boldsymbol{X}} = con{v^{1 \times 1}}(Cat(MLP({{\boldsymbol{X}}_{\rm in}}), LVC({{\boldsymbol{X}}_{\rm in}}))) | (6) |

其中, X为GCEN的输出.

| {{\boldsymbol{X}}_{\rm in}} = \sigma (BN(Inception({{\boldsymbol{P}}_4}))) | (7) |

其中,

在本文提出的架构中使用GCEN对最顶层特征层P4进行全局上下文信息增强, 并将经过GCEN调节后的更精细的顶层空间特征称为全局上下文信息增强特征, 这对于遥感图像的小目标宽高比过大、密集排列的预测任务非常重要.

3.3 全局上下文注意力特征融合金字塔网络基于第3.1节和第3.2节提出的TAFF和GCEN, 本文借鉴全局集中调节的思想进一步以自上而下的方式设计一个全局上下文注意力特征融合金字塔GCAFFPN. 如图2中所示, 本文的GCEN首先在金字塔最顶层上实现, 然后使用所提出的TAFF自适应地融合来自主干网络的多尺度特征以及最顶层GCEN得到的上下文增强特征, 利用高级语义信息同时调节所有浅层特征(即P3–P1). 实现过程中, 在每个相应的低级特征上, 将深层调节过的特征上采样到与低级特征相同的空间尺度, 然后沿着通道维度拼接, 并将拼接后的特征通过1×1卷积下采样到256通道大小. 最后将这些多尺度特征聚合成一个解耦的头部检测网络进行分类和回归任务. 最终设计的GCAFFPN, 能够在自顶向下路径中显式地增加特征金字塔每一层多尺度表达的能力, 避免直接融合不同尺度的特征所带来大量的冗余信息和冲突信息, 从而提升模型处理遥感图像背景复杂且目标尺度变化大等关键问题的能力.

4 实验本节介绍实验, 包括数据集和评估指标、实现细节、两个公共遥感目标检测数据集上的实验结果以及所提出的GCAFFPN的消融研究.

4.1 数据集和实现细节DOTA-v1.0[1]是遥感图像定向目标检测应用中最大的数据集之一. 该数据集涵盖了各种图像尺寸、地面样本距离(GSDs)、传感器类型等多方面的差异, 捕捉到的物体在尺度、形状和方向上呈现丰富的变化. 它由来自不同传感器和平台的

HRSC2016[4]是另一个具有挑战性的任意方向船舶检测的遥感图像数据集, 包含

本文的实验设置与基线模型ReDet在训练和测试期间的设置基本一致. 使用一台NVIDIA RTX 3090 GPU进行训练和测试, 本文中的所有模型均采用基于PyTorch框架的 MMRotate [24]实现, 并使用SGD 优化器进行训练. 初始学习率设定为

采用上述方法, 本文在两个具有不同特性和难度的遥感图像数据集, 即DOTA-v1.0和HRSC2016上进行了详尽的实验评估. 在主张高精度定向目标检测的方法[3,14]之后, 本文继续采用AP75作为主要指标, AP50为辅助指标, 旨在全面验证所提出方法在应对遥感图像复杂场景时的鲁棒性以及高精度检测的性能表现.

4.2 消融实验为了研究全局上下文信息增强网络(GCEN)和三重注意力特征融合(TAFF)在高精度定向目标检测任务中的有效性, 本文在表1中进行了详细的消融研究, 使用带有旋转等变金字塔(ReFPN)的ReDet[10]作为基线. 为了公平比较, 本文设置相同的超参数进行消融实验.

| 表 1 不同组件在DOTA-v1.0上的消融研究 (%) |

从表1可知, GCEN和TAFF都能够显著提升高精度定向检测的性能, 在AP75指标上, GCEN提高了1.20%, 这表明GCEN对网络深层特征提取全局上下文信息的有效性, 从而大幅提升模型的检测性能. 而加入的TAFF模块进一步向浅层特征中融合来自GCEN的高级语义信息, 以达到充分利用深层高级语义改善高精度定向检测效果的目的. 这一实验的AP75在提升0.65%的同时, AP50的结果也有着一定提升. 具体而言, 在高精度定向目标检测任务中, 当同时使用GCEN和TAFF模块时, 均较不添加或单独使用时提升更为明显, 这表明全局上下文信息增强和多尺度特征融合机制的结合使用对于大宽高比目标的深层语义信息激活能起到相互促进的效果, 对于解决遥感图像中高精度目标检测的挑战具有明显的贡献.

4.3 对比实验本文将提出的GCAFFPN方法与8种应用DOTA数据集的定向目标检测方法和5种应用HRSC2016数据集的目标检测方法进行了比较. 表2和表3分别报告了DOTA-v1.0和HRSC2016数据集的详细对比结果. 其中R50表示ResNet50[25], Swin-T表示Swin-Transformer[26], ReR50表示ReResNet50[10].

| 表 2 不同方法在DOTA-v1.0上的比较 (%) |

| 表 3 不同方法在HRSC2016上的比较 (%) |

● DOTA-v1.0的结果. 如表2, 本文在DOTA-v1.0数据集上进行了实验, 将提出的GCAFFPN与遥感目标检测领域其他最先进的方法进行了实验对比. 所有结果均通过单尺度训练和测试得到. 在AP50指标上, 本文方法的准确率达到了76.06%, 与当前最先进的方法相比具有很强的竞争力, 这表明GCAFFPN在检测大多数定向目标时具有较高的准确率. 然而, 更值得关注的是GCAFFPN在AP75指标上的表现. 在这一更为严格的高精度定向评价标准下, 本文提出的方法取得了52.25%的准确率, 对基线模型ReDet (双阶段旋转等变检测器)有较大的提升, 提高了1.85%. 这一结果表明GCAFFPN在预测角度时的偏差更小, 尤其在处理大宽高比目标的情况下表现出色. 与其他先进方法相比, GCAFFPN在更严格的高精度评价指标下取得了更好的性能, 这进一步证实了其在高精度定向目标检测中的有效性.

● HRSC2016的结果. 如表3, 列出了不同方法在PASCAL VOC 2007和VOC 2012指标下的评估结果. 本文提出的方法在mAP (2007)和mAP (2012)两个指标上分别将性能提高了0.06%、0.24%, 都展现出了令人鼓舞的性能表现. 值得注意的是, 本文方法能够在两个不同的评价标准下都取得最佳精度, 这进一步验证了其在定向目标检测任务中的有效性和可靠性. 这些结果反映了本文方法在处理复杂背景遥感图像中的任意方向目标时的卓越性能, 尤其是在小目标密集排列和大宽高比目标高精度定向检测的情况下.

4.4 可视化分析除了使用量化评价指标对本文模型的高精度定向检测效果进行分析外, 图5列出了基线模型与本文方法检测结果的可视化对比. 因篇幅限制, 仅列举出DOTA-v1.0数据集中5种类别的检测效果. 从图5(a)和(b)中可以观察到, 基线模型在针对大宽高比目标(如桥梁、海港)的高精度检测时存在角度偏差的缺陷, 而本文提出的GCAFFPN方法在处理大宽高比目标时相对基线模型的角度偏差问题有一定的减轻. 此外, 图5(c)–(e)展示了基线模型在检测密集排列的小目标(如舰船、直升机、泳池)时均存在一定程度的漏检和误检情况, 相比之下, 本文方法相对于基线模型在漏检和误检方面有所改善, 检测精度得到了显著提升.

总体而言, 本文的实验结果证明了集成GCEN和TAFF的GCAFFPN对高精度检测性能的提升的有效性, 在不同数据集上均表现出较高的准确率, 具有较强的竞争力. 为解决遥感图像高精度定向目标检测问题提供了可行的解决方案.

|

图 5 本文模型检测结果可视化对比 |

5 总结

针对航空遥感图像中的复杂背景、微小目标、宽高比过大等问题, 本文提出了一种全局上下文注意力特征融合金字塔网络(GCAFFPN). 通过全局上下文信息增强网络(GCEN)对最深层特征进行层内调节, 丰富目标与背景之间的高级语义信息和空间特征. 并设计了一种三重注意力特征融合模块(TAFF), 实现了多重输入特征自适应地融合, 有效解决了输入特征之间语义和尺度的不一致问题. 通过全局上下文信息增强和注意力特征融合, 自上而下地对多尺度特征进行全局集中调节, 提高了模型对不同尺度信息的整合能力, 进一步优化模型的高精度定向目标检测的表现. 与其他先进的定向目标检测方法相比, 本文提出的方法在主流公开数据集中更严格的高精度评价指标上表现出色. 这表明本文的方法在应对遥感图像中具有挑战性的场景时取得了显著的性能提升.

| [1] |

Xia GS, Bai X, Ding J, et al. DOTA: A large-scale dataset for object detection in aerial images. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 3974–3983. [doi: 10.1109/cvpr.2018.00418]

|

| [2] |

Ding J, Xue N, Long Y, et al. Learning RoI Transformer for oriented object detection in aerial images. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 2844–2853. [doi: 10.1109/CVPR.2019.00296]

|

| [3] |

Zeng Y, Chen YS, Yang X, et al. ARS-DETR: Aspect ratio-sensitive detection Transformer for aerial oriented object detection. IEEE Transactions on Geoscience and Remote Sensing, 2024, 62: 1-15. DOI:10.1109/TGRS.2024.3364713 |

| [4] |

Liu ZK, Yuan L, Weng LB, et al. A high resolution optical satellite image dataset for ship recognition and some new baselines. Proceedings of the 6th International Conference on Pattern Recognition Applications and Methods. Porto: SciTePress, 2017. 324–331. [doi: 10.5220/0006120603240331]

|

| [5] |

Yang X, Yang JR, Yan JC, et al. SCRDet: Towards more robust detection for small, cluttered and rotated objects. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 8231–8240. [doi: 10.1109/ICCV.2019.00832]

|

| [6] |

Yang X, Sun H, Sun X, et al. Position detection and direction prediction for arbitrary-oriented ships via multitask rotation region convolutional neural network. IEEE Access, 2018, 6: 50839-50849. DOI:10.1109/ACCESS.2018.2869884 |

| [7] |

Yang X, Sun H, Fu K, et al. Automatic ship detection in remote sensing images from Google earth of complex scenes based on multiscale rotation dense feature pyramid networks. Remote Sensing, 2018, 10(1): 132. DOI:10.3390/rs10010132 |

| [8] |

Zhang GJ, Lu SJ, Zhang W. CAD-Net: A context-aware detection network for objects in remote sensing imagery. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(12): 10015-10024. DOI:10.1109/TGRS.2019.2930982 |

| [9] |

Xie XX, Cheng G, Wang JB, et al. Oriented R-CNN for object detection. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 3500–3509. [doi: 10.1109/ICCV48922.2021.00350]

|

| [10] |

Han JM, Ding J, Xue N, et al. ReDet: A rotation-equivariant detector for aerial object detection. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 2785–2794. [doi: 10.1109/CVPR46437.2021.00281]

|

| [11] |

Yang X, Yan JC, Feng ZM, et al. R3Det: Refined single-stage detector with feature refinement for rotating object. Proceedings of the 35th AAAI Conference on Artificial Intelligence. Palo Alto: AAAI, 2021. 3163–3171. [doi: 10.1609/aaai.v35i4.16426]

|

| [12] |

Han JM, Ding J, Li J, et al. Align deep features for oriented object detection. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5602511. DOI:10.1109/TGRS.2021.3062048 |

| [13] |

Yang X, Yan JC. On the arbitrary-oriented object detection: Classification based approaches revisited. International Journal of Computer Vision, 2022, 130(5): 1340-1365. DOI:10.1007/s11263-022-01593-w |

| [14] |

Yang X, Yang X, Yang J, et al. Learning high-precision bounding box for rotated object detection via Kullback-Leibler divergence. Proceedings of the 2021 International Conference on Neural Information Processing Systems. NeurIPS, 2021. 18381–18394.

|

| [15] |

Xu H, Liu XY, Xu HN, et al. Rethinking boundary discontinuity problem for oriented object detection. arXiv:2305.10061, 2023.

|

| [16] |

Cai ZW, Vasconcelos N. Cascade R-CNN: Delving into high quality object detection. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 6154–6162. [doi: 10.1109/CVPR.2018.00644]

|

| [17] |

Lin TY, Dollár P, Girshick R, et al. Feature pyramid networks for object detection. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 936–944. [doi: 10.1109/CVPR.2017.106]

|

| [18] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7132–7141. [doi: 10.1109/CVPR.2018.00745]

|

| [19] |

Dai YM, Gieseke F, Oehmcke S, et al. Attentional feature fusion. Proceedings of the 2021 IEEE Winter Conference on Applications of Computer Vision. Waikoloa: IEEE, 2021. 3559–3568. [doi: 10.1109/WACV48630.2021.00360]

|

| [20] |

Tan MX, Pang RM, Le QV. EfficientDet: Scalable and efficient object detection. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 10778–10787. [doi: 10.1109/CVPR42600.2020.01079]

|

| [21] |

Cao Y, Xu JR, Lin S, et al. GCNet: Non-local networks meet squeeze-excitation networks and beyond. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision Workshop. Seoul: IEEE, 2019. 1971–1980. [doi: 10.1109/ICCVW.2019.00246]

|

| [22] |

Zhang D, Zhang HW, Tang JH, et al. Feature pyramid Transformer. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 323–339. [doi: 10.1007/978-3-030-58604-1_20]

|

| [23] |

Quan Y, Zhang D, Zhang LY, et al. Centralized feature pyramid for object detection. IEEE Transactions on Image Processing, 2023, 32: 4341-4354. DOI:10.1109/TIP.2023.3297408 |

| [24] |

Zhou Y, Yang X, Zhang GF, et al. MMRotate: A rotated object detection benchmark using PyTorch. Proceedings of the 30th ACM International Conference on Multimedia. Lisboa: ACM, 2022. 7331–7334. [doi: 10.1145/3503161.3548541]

|

| [25] |

He KM, Gkioxari G, Dollár P, et al. Mask R-CNN. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 2980–2988. [doi: 10.1109/ICCV.2017.322]

|

| [26] |

Liu Z, Lin YT, Cao Y, et al. Swin Transformer: Hierarchical vision Transformer using shifted windows. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 9992–10002. [doi: 10.1109/ICCV48922.2021.00986]

|

| [27] |

Lin TY, Goyal P, Girshick R, et al. Focal loss for dense object detection. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 2999–3007. [doi: 10.1109/iccv.2017.324]

|

2024, Vol. 33

2024, Vol. 33