图像超分辨率(super-resolution, SR)旨在从低分辨率图像(low resolution, LR)重建高分辨率图像(high resolution, HR). 它是一种基础的低层次视觉任务, 其目标是利用先进的图像处理和机器学习技术重建缺失的细节, 提高图像质量. 在遥感成像、视频处理、医学图像分析等方面具有广泛的应用.

SR方法可以概括为3种范式, 即基于插值的方法、基于优化的方法、基于学习的方法. 基于插值的方法主要依赖最近邻插值、双线性插值、双三次插值等操作来获得从LR图像到HR图像的映射. 尽管基于插值的方法简单易行, 但在高质量图像重建方面的性能较差. 为此, 部分研究者通过基于优化方法来恢复高质量的图像. 例如, 利用稀疏先验知识获得线性组合可有效预测HR图像. 迭代背投影(iterative back-projection, IBP)[1]通过迭代计算模拟低分辨率图像与观测的低分辨率图像之间距离, 不断更新预测的HR图像. 虽然以上基于优化的方法在图像超分辨率方面取得了很好的效果, 然而, 这种方法往往具有巨大的参数, 计算成本高, 不能在一些计算资源有限的设备上实际使用. 在单图像超分辨率(single image super-resolution, SISR)领域, 探索实用和实时的SR解决方案已经成为一个日益增长的趋势. 为了解决这一问题, 基于深度学习技术的图像SR方法应运而生. 与传统方法相比, 基于深度学习的方法能够更好地捕捉图像中的细节和结构信息, 提高图像重建的质量和准确性. 此外, 在深度学习中卷积神经网络(convolutional neural network, CNN)具有良好的自学习能力, 能够针对图像获取过程中存在的模糊和噪声等退化因素提供有效预防. 因此, CNN在图像超分辨率领域得到了扩展.

Dong等[2] 基于 CNN提出了一种图像超分辨率方法SRCNN (super-resolution CNN)对图像超分辨率做出了重大贡献, 该方法只使用了3个CNN层进行特征提取. 虽然与传统的图像超分辨率方法相比, 它获得了更好的性能, 但可扩展性差. Kim等[3]以残差学习[4]为基础, 提出了VDSR (very deep convolutional networks super-resolution)将网络深度增加到了20层, 并利用残差块加速模型收敛, 提高性能, 但增加了计算复杂度, 并且可能产生梯度消失的问题. Lim 等[5]提出的突破性的EDSR (enhanced deep residual network for super-resolution)将网络层数叠加到60层以上, 其卓越的性能充分体现了网络深度对图像重建质量的深刻影响. 另外, Tai等[6]利用门单元、跳跃连接和密集连接结构将获得的浅层特征继承到深层, 增强浅层对图像超分辨率的记忆能力. 虽然这些方法可以很好地实现图像的超分辨率, 但它们的输入较大, 可能会导致较大的计算成本.

随着注意力机制[7–9]和Transformer[10,11]模型在图像处理领域的引入, 极大地推动了SISR的发展. Zhang等[8]设计的RCAN (residual channel attention network)通过残差结构来实现网络连接, 通过引入通道注意力来调整不同信道之间模型的权值, 增强网络对图像特征的建模能力. 肖子安等[12]提出了一种多个级联的多尺度特征和坐标注意力模块, 实现对低分辨率遥感图像高频特征进行更充分的提取, 同时有效融合多尺度空间信息. Liang等[13]在图像恢复领域引入了Swin Transformer, 并提出了swinIR (image restoration using Swin Transformer)方法. swinIR是一种基于Transformer的图像超分辨率方法, 它利用了Transformer的强大表达能力, 实现了超分辨率领域先进的性能. 无论使用的是注意力机制还是Transformer. 随着网络性能的提高, 模型参数的数量和计算工作量也显著增加, 使得超分辨率网络的实际应用变得不可行. 虽然这些方法是有效的, 并且极大地推动了图像超分辨率的发展, 但他们需要依赖更深的网络架构和强大的算力, 难以在资源受限设备实际应用. 此外, 以上方法获取的信息不能完全表达复杂场景下预测的高质量图像.

针对上述问题, 本文提出了一种宽结构图像动态超分辨率网络(wide-structure dynamic image super-resolution network, W-SDNet), 旨在不显著增加计算负担的前提下提升图像重建质量. W-SDNet采用了一种递进动态网络架构, 通过融合浅层特征提取块、残差增强块、宽增强块、特征细化块和构造块, 实现了对复杂场景中丰富特征的有效提取和细化. 本网络的核心在于动态调整网络结构以适应不同的图像内容, 从而更精确地重建高质量图像. 本文的主要贡献概括如下.

(1)引入了移位卷积残差块, 通过移位卷积层有效提取高频特征, 同时降低模型的参数数量和计算成本.

(2)提出了一个具有宽网络结构的动态宽增强块, 结合蓝图可分离卷积和边缘检测算法的增强空间注意力模块, 增强了模型对图像边缘特征表达能力.

(3)通过采用组卷积和信道分割操作, 进一步降低了计算复杂度, 并利用特征细化块精确地学习和细化获得的特征. 实验结果证明, 相比现有的主流方法, W-SDNet在提升重建效果和降低模型复杂度方面展现了显著的优势.

2 相关工作 2.1 用于图像超分辨率的轻量级模型为了提高图像处理的效果而增加网络深度, 导致了巨大的计算成本, 不利于超分辨率方法在现实生活中的应用. 为了解决这个问题, 研究人员提出了越来越多的精确和高效的模型. Kim等[14]和Tai等[15]分别设计了DRCN (deeply-recursive convolutional network)和DRRN (deep recursive residual network)模型, 利用递归结构和参数共享机制, 大幅减少了模型参数的数量. 然而, 递归结构并没有减少计算工作量. Ahn等[16]提出了一种具有群卷积的高效级联残差网络(cascade residual network, CARN), 提高了超分辨率的性能和效率. Hui等[17]实现了一个轻量级信息多蒸馏网络(iterative mean distillation network, IMDN), 利用信息蒸馏机制(information distillation mechanism, IDM)逐级提取分层特征. RFDN (residual feature distillation network)[18]改进了IMDN的体系结构, 提出了残差特征精馏网络, 用特征精馏连接代替IDM. 王一宁等[19]利用密集块和反卷积提出一种拥有较少的层和参数的轻量密集神经网络模型, 在训练速度和内存消耗方面均取得了良好的效果. 周登文等[20]设计了轻量化且高效的区域互补注意力和多维注意力模块, 在信道维度与空间维度对像素间的依赖关系建模, 实现了轻量SR. Gao等[21]将多路注意力模块、轻量级卷积块组合在一起, 实现轻量级CNN, 以便获得更准确的信息, 提高图像超分辨率效果. 陈豪等[22]针对网络复杂度较高的问题, 提出了基于Transformer-CNN的轻量SR方法, 使网络能够更好地捕获到图像中局部与全局的深度特征, 降低了推理时间.

根据上面提到的模型发现, 优化网络架构对于实现图像超分辨率的轻量级CNN是有效的. 虽然最近的轻量化SISR模型取得了良好的效果, 但在高频恢复图像细节方面仍存在一些问题. 所以考虑到获取的信息对复杂场景的鲁棒性, 利用动态门、多视图思想和深度网络的设计原则, 实现了一种基于CNN的轻量级的图像超分辨率.

2.2 图像超分辨率的动态神经网络传统的神经网络结构一般是固定的, 不能根据不同的场景灵活变化, 这影响了他们在复杂场景中的表现. 针对这一问题, 研究人员开发了动态神经网络, 动态网络能够根据输入数据特征及上下文信息, 对网络结构和参数进行自适应调整, 增加网络的自适应性和灵活性, 并提高模型的鲁棒性和稳定性. 由于动态网络模型优越性, 已被应用于图像超分辨率领域. 例如, Shi等[23]使用了一种内容自适应技术, 对齐现实世界中的图像以实现图像超分辨率. 内容自适应技术可以根据输入数据的特征和上下文信息, 动态地选择和调整网络的层次结构、连接方式和参数设置. 使网络更好地适应不同的输入数据, 并提高网络的性能和泛化能力. Wu等[24]使用显著性感知模型来提取遥感图像中的显著性信息, 然后通过动态路由策略将低分辨率图像的特征映射动态地分配给高分辨率图像的不同区域, 以保留更多的细节信息进而实现超分辨率重建. Chen等[25]通过边缘信息分配不同的网络来恢复图像超分辨率中的详细信息. 为了提高图像超分辨率的性能, 采用不同的注意机制分别提取局部和全局特征, 从而为图像超分辨率提供更有用的详细信息. 根据上述所提, 可以看到动态网络对于图像的超分辨率是有效的. 受此启发, 本文应用了一个动态网络实现图像超分辨率.

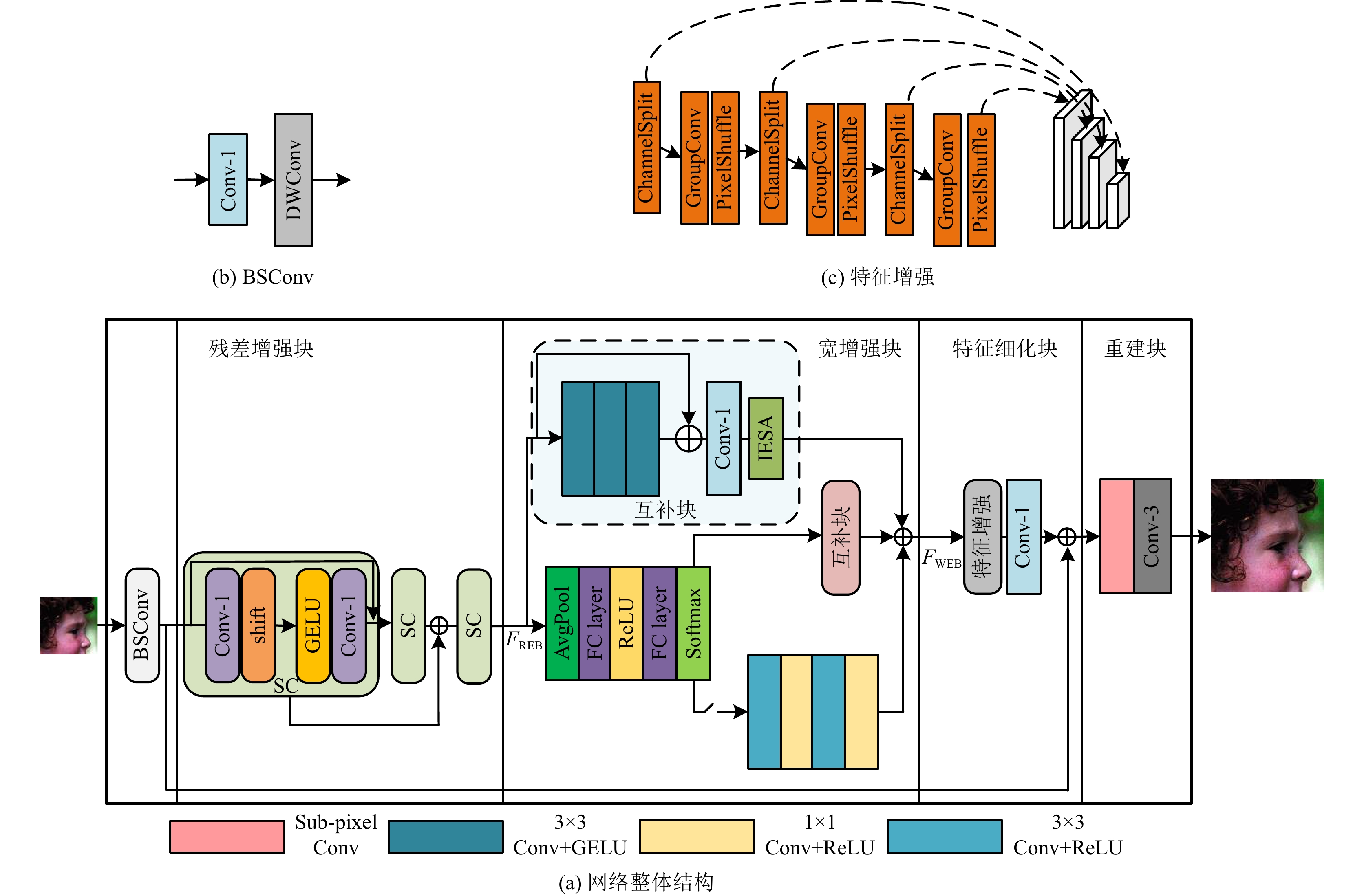

3 本文方法 3.1 网络架构基于CNN的单图像超分辨率方法通常倾向于增加网络深度以提高图像处理性能. 然而, 这种方法容易导致计算成本增加, 并且不利于在低配置设备上实现. 此外, 单一的网络结构往往难以提取复杂场景中的丰富特征. 针对这些问题, 本文提出了一种新型的递进动态网络(W-SDNet). 整体结构如图1所示, 该网络由多个组件组成, 包括浅层特征提取块、残差增强块、宽增强块、特征细化块以及构造块. 首先, 低分辨率图像经过蓝图可分离卷积(blueprint separable convolution, BSConv)[26]进行浅层特征的提取. 接下来, 通过由3个移位卷积残差块(shift-conv residual block, SC-ResBlock)组成的残差增强块, 对图像的层次信息进行提取和增强, 从而丰富特征的层次表达. 为了应对复杂场景的挑战, 引入了宽增强块. 这个模块采用结合改进增强空间注意力机制的互补块(complementary block, CBlock)和一个动态门机制, 以更有效地为复杂场景提取更丰富的信息. 通过这种设计, 网络能够更好地适应各种复杂场景, 并提取更具表达力的特征. 在宽增强块之后, 使用了特征细化块. 这个模块通过组卷积和信道分割的策略, 消除了宽增强块中可能产生的干扰, 进一步优化了从宽增强块中学习到的特征. 最后, 构造块负责通过上采样和卷积层, 将前述模块提取的特征和浅层特征进行整合, 以重建高质量的图像. 通过这种方式, W-SDNet不仅优化了特征提取的过程, 同时也提升了最终图像的重建质量. 实现过程如式(1)所示:

| IHR=W-SDNet(ILR)=RB(FEB(WEB(REB(SF(ILR))))) | (1) |

其中,

|

图 1 网络结构图 |

3.2 浅层特征提取块

浅层特征提取部分采用蓝图可分离卷积对输入图像进行浅层特征提取, BSConv具体架构如图1(b)所示. BSConv是深度可分离卷积(depthwise separable convolution, DSConv)[27]的改进变体, 它由1×1卷积和深度卷积组成. 更好地利用了核内相关性, 相比于普通卷积减少了冗余运算, 文献[26]证明BSConv对于高效SR是有利的.

| FSF = SF(ILR) | (2) |

残差网络已经广泛应用在图像超分辨率领域, 大量研究表明, 通过增加网络层深度, 所提取的特征就越丰富, 但过深的网络层数会引起梯度爆炸或梯度消失的问题, 而多个残差连接的残差块可以很好地解决这个问题, 所以本文模型利用残差增强块对层次信息进行提取和增强. 残差增强块采用3个移位卷积残差块(shift-conv residual block, SC-ResBlock)提取深度信息, SC-ResBlock是由移位残差卷积层, GELU[28]激活函数, 1×1卷积层组成. 最后使用残差学习操作收集浅层特征, 以增强模型的记忆能力.

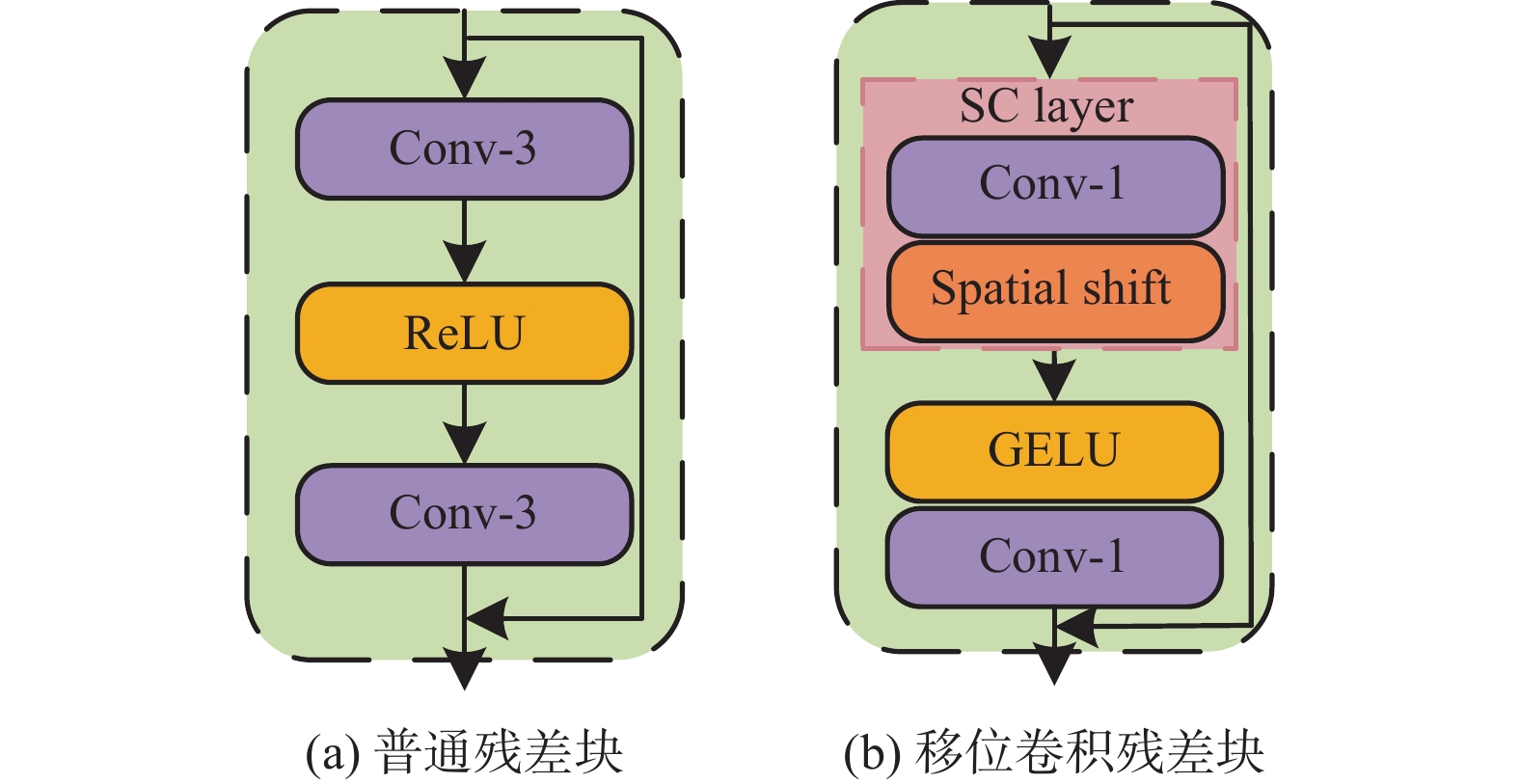

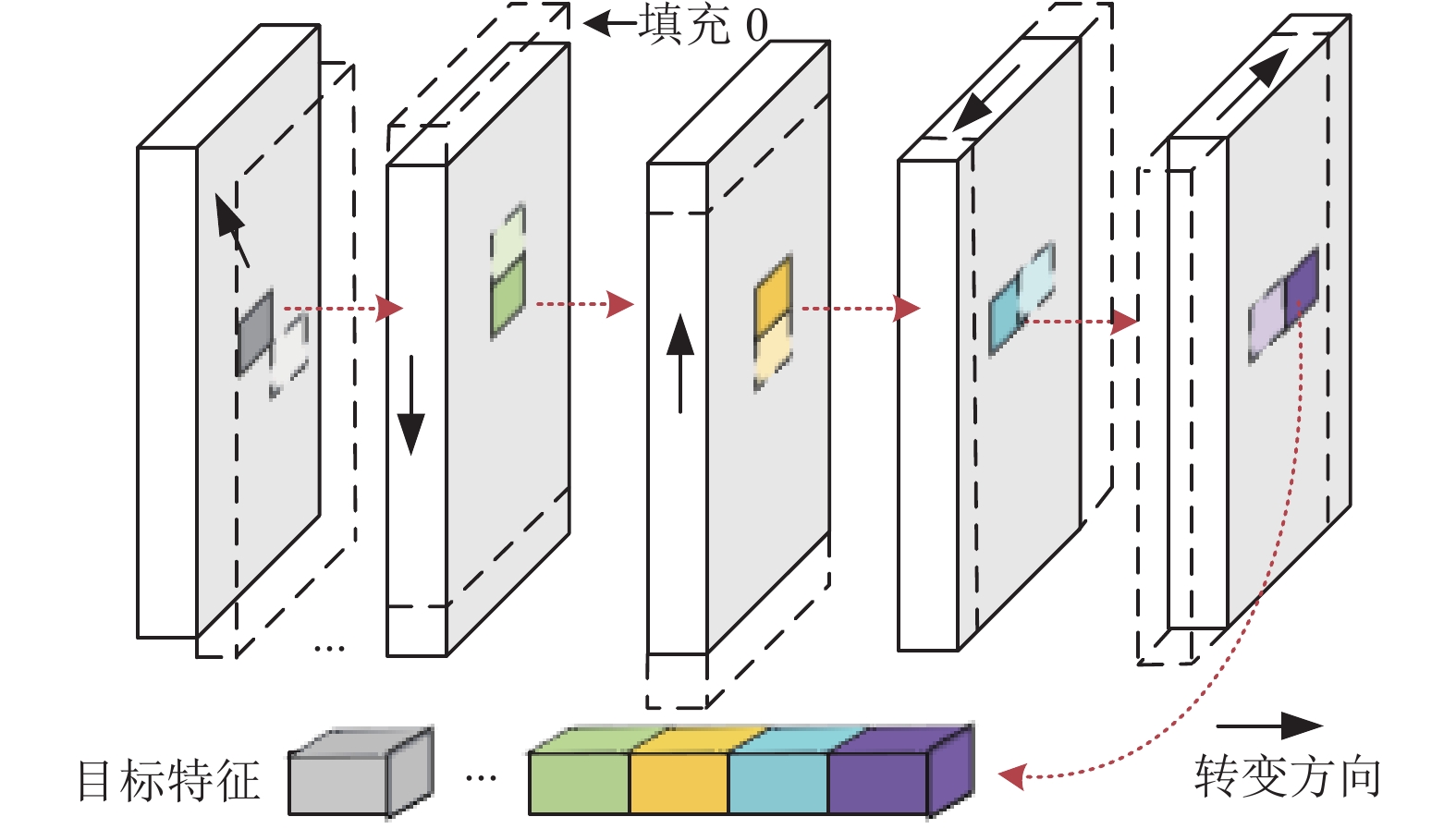

如图2(a)所示是文献[5]中提出的残差块, 广泛应用于SR网络中. 3×3卷积运算在平衡模型容量和计算成本方面具有一定优势, 但会增加参数和计算开销, 所以将3×3卷积层替换成计算成本更低的1×1卷积层, 虽然1×1卷积很大程度上减少了参数数量和计算成本, 但是由于1×1卷积操作只对单个像素的特征进行处理, 这会影响建模, 因此在这里通过空间移位操作[29], 如图3所示. 通过重新排列特征图的空间位置, 在不增加计算成本的情况下, 增强了跨信道组的局部空间特征聚合. Shift-Conv层(简化为SC层)由1×1卷积层和空间移位操作堆叠, 因此SC层扩展了正常的1×1卷积, 具有局部特征聚合, 且参数更少. 与正常的3×3卷积相比, SC层在保持相当性能的同时显著减少了参数数量. 在激活单元方面, GELU具有良好非线性表达能力, 逐渐成为近期研究的首选. 残差增强块具体操作如式(3):

| FREB=REB(FSF)=SC(FSF+SC(SC(FSF))) | (3) |

其中, REB表示残差增强函数, SC表示移位卷积残差操作,

|

图 2 两种残差块对比 |

3.4 宽增强块

现有图像超分辨率网络普遍通过增加网络深度来提升网络重建效果, 但忽视了网络宽度对于网络影响, 根据GoogLeNet[30], 已知增大宽度可以提取更多的互补信息, 以提高图像应用的性能. 受此启发, 构建了宽增强块, 用以增加网络特征表达能力, 提高网络性能, 进一步证明增加网络宽度对图像重建具有积极影响. 宽增强块紧跟在残差增强块之后, 接收残差增强块的输出

| FWEB=WEB(FREB)=(CB(FREB)+FDG(GM(FREB)))ΘSDG(GM(FREB)) | (4) |

其中,

|

图 3 空间位移操作说明 |

3.4.1 互补块

为了增强特征表达能力和模型的鲁棒性, 在宽增强块中增加了互补块. 受文献[31]启发, 互补块采用剩余局部特征块, 在保持模型容量的前提下, 显著减少推理时间, 互补块只用3个叠加的Conv+GELU进行特征提取, 过程如式(5):

| {Frefined1=RM1(FREB)Frefined2=RM2(Frefined1)Frefined3=RM3(Frefined2) | (5) |

其中,

| Frefined=FREB+Frefined3 | (6) |

最后通过一个1×1卷积进行特征融合和降维, 通过改进的增强空间注意力模块, 增强边缘信息和重要信息表达能力. 如式(7):

| FWEB=DSA(C1(Frefined)) | (7) |

其中,

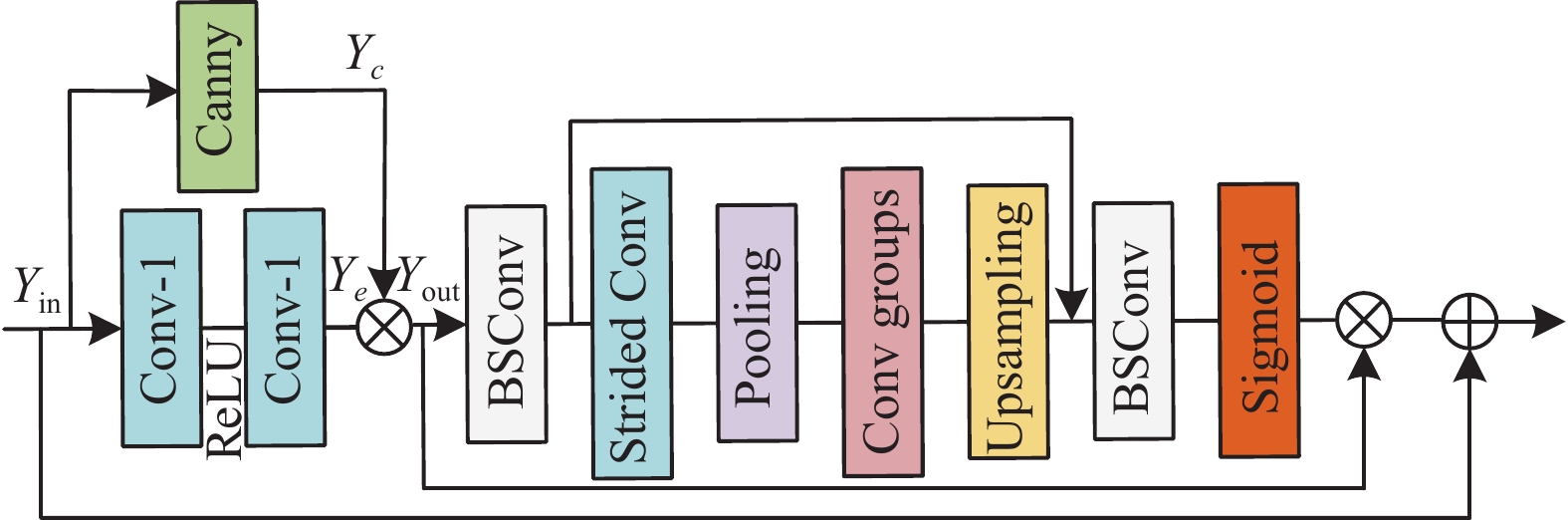

注意力机制提出以来被广泛应用到图像领域, 并取得了令人满意的效果, ESA (enhanced spatial attention)[17]注意力是一种增强空间注意力的方法, 其在提升模型表达能力和改善长距离依赖方面具有有效性, 但随之而来的是参数量的增加和计算复杂度的增加, 另一方面, 在对图像的高低频信息进行区分和整合的过程中需要额外关注边缘信息, 因为图像每个通道都包含大量高低频信息分量, 而高频信息分量往往含有许多边缘信息, 但现有方法大都不注重边缘的高频信息[32]. 为解决以上问题, 设计了如图4所示的IESA (improved enhanced spatial attention), 该注意力模块在ESA注意力机制的基础上, 融合了Canny边缘检测算子[33], 对输入特征图进行边缘特征提取, 并与利用卷积操作得到的特征图进行融合运算. 得到边缘特征增强的特征图, 如式(8)所示:

| {Yc=Canny(Yin)Yout=Ye⊗Yc | (8) |

其中,

针对参数量的增加和计算复杂度的增加的问题, 采用BSConv卷积代替原有的普通卷积, 因为与普通卷积相比, BSConv采用分离卷积方式, 降低了计算复杂度和参数量, 提升计算速度, 同时BSConv采用不同卷积核进行特征提取, 可以更好地捕捉到输入数据的局部和全局特征. 将经过边缘增强的特征图, 通过BSConv降低输入特征的通道维数. 然后使用大步卷积和大步最大池化层来减小空间大小. 通过一组卷积学习特征图空间维度之间的相关性, 采用基于插值的上采样来恢复空间大小. 为了提高效率结合跳跃连接, 通过BSConv对特征进行进一步处理, 恢复信道大小. 最后, 通过Sigmoid函数生成注意矩阵, 并乘以原始输入特征. 通过跳跃连接初始特征图与网络底层连接进行残差学习, 以降低网络训练难度.

|

图 4 改进的增强空间注意力 |

3.5 特征细化块

为了防止宽增强块中某些成分的干扰, 对宽增强块中获得的特征进行特征细化. 通过组卷积逐渐添加高频细节, 并利用组卷积和信道分割操作来降低计算复杂度, 获得一组分辨率逐渐提高的特征图, 如图1(c)所示. 首先, 将输入的特征映射

| {M1,˜M1 = Split(Min) M2,˜M2 = Split(PixelShuffle(GroupConv(3)3,3C(˜M1)) M3,˜M3 = Split(PixelShuffle(GroupConv(2)3,2C(˜M2)) M4 = PixelShuffle(Conv3,C(˜M3)) | (9) |

其中,

| FFRB=C1(M1,M2,M3,M4) | (10) |

重建块由亚像素卷积层和3×3卷积组成, 重建阶段首先由亚像素卷积对融合后特征图进行上采样, 再使用3×3卷积构建高质量图像. 得到最终高分辨率图像

| FHR=RB(FFRB+FSF)=C3(Sub(FFRB+FSF)) | (11) |

其中,

在不增加计算成本的情况下, 增强了跨信道组的局部空间的均方误差(mean squared error, MSE)[34]是SR任务的常用损失函数. 通过估计量与被估计量之间差异程度反应模型重建情况, 均方误差越小, 说明模型的预测能力越强. 通过实验对比MSE更适合模型, 所以为了更好地提升模型性能, 选择MSE作为损失函数来训练W-SDNet模型. 即将训练数据集的

| L(p)=12nn∑i=1‖W-SDNet(IiL)−IiH‖2 | (12) |

其中, L为MSE的损失函数, p表示学习到的参数.

4 实验结果分析 4.1 数据集选取使用广泛的DIV2K[35]公共数据集训练模型. DIV2K在NTIRE 2017挑战赛被提出, 并广泛应用于图像超分辨率领域. 该数据集由

所提方法采用了3个关键指标来全面评估超分辨率重建模型的性能: Y信道平均峰值信噪比(PSNR)、结构相似度(SSIM)、感知图像相似性(learned perceptual image patch similarity, LPIPS). PSNR和SSIM作为基础指标, 主要衡量图像质量的传统视觉特征, 其中高值代表更优的图像恢复质量. 为进一步评估图像的感知细节质量, 引入了LPIPS指标. LPIPS通过分析图像深层特征的差异, 专注于图像内容的感知属性, 低LPIPS值表示重建图像与原始图像在视觉上更为相似.

4.2 实验设置本文实验在 NVIDIA RTX 3090 GPU 上进行; 选用Ubuntu 20.04版本, Python 3.8.13作为编程环境, 并选择深度学习框架PyTorch 1.13.1, CUDA 版本11.7, cuDNN 8.5.0; Batch和patch size分别设置为64, 步数是6E+5. 在实验中, 初始学习率为1E–4, 每走4E+5步, 学习速度就会减半. 采用Adam优化器进行优化, 其中参数β1为0.9, β2为0.999.

4.3 实验与结果分析为了验证W-SDNet的先进性, 对 W-SDNet算法与已有先进算法进行了广泛的实验对比. 实验结果如表1–表3 所示, 分别展示了所提算法与其他先进算法在 2 倍、3 倍、4 倍超分辨率任务上的客观评价指标结果(其中加粗字体表示最优结果, 下划线字体表示次优结果, *表示重新复现的结果).

由表1–表3可以看出, 本文方法在不同放大倍数上大都取得了最优和次优的良好表现. 当放大倍数为4时, 相比于其他算法, 本文算法在5个测试数据集中均取得了最优的PSNR. 在Set5数据集放大倍数为3时, 相比于DSRNet[42], 本文方法获得的PSNR和SSIM提高了0.06 dB和

为了进一步评估图像的感知细节质量, 将提出的W-SDNet在质量更高的AIM2019和RealSR数据集上做了进一步的测试, 并与现有的主流方法ZSSR、DASR等方法进行了实验对比分析, 对比结果如表4所示. 实验结果表明, 相比于其他先进的超分辨率模型, 所提方法在两个数据集上均展现出了优异的感知图像重建性能. 特别是在RealSR数据集上, 低LPIPS值表明本文方法能够有效地减少图像间的感知差异, 重建出与原始图像在视觉上更为接近的高质量图像.

| 表 1 放大倍数为2时各算法在不同数据集上的平均 PSNR (dB) 和 SSIM 值对比 |

| 表 2 放大倍数为3时各算法在不同数据集上的平均 PSNR (dB) 和 SSIM 值对比 |

| 表 3 放大倍数为4时各算法在不同数据集上的平均 PSNR (dB) 和 SSIM 值对比 |

| 表 4 不同方法在AIM2019和RealSR测试集放大4倍细节感知对比 |

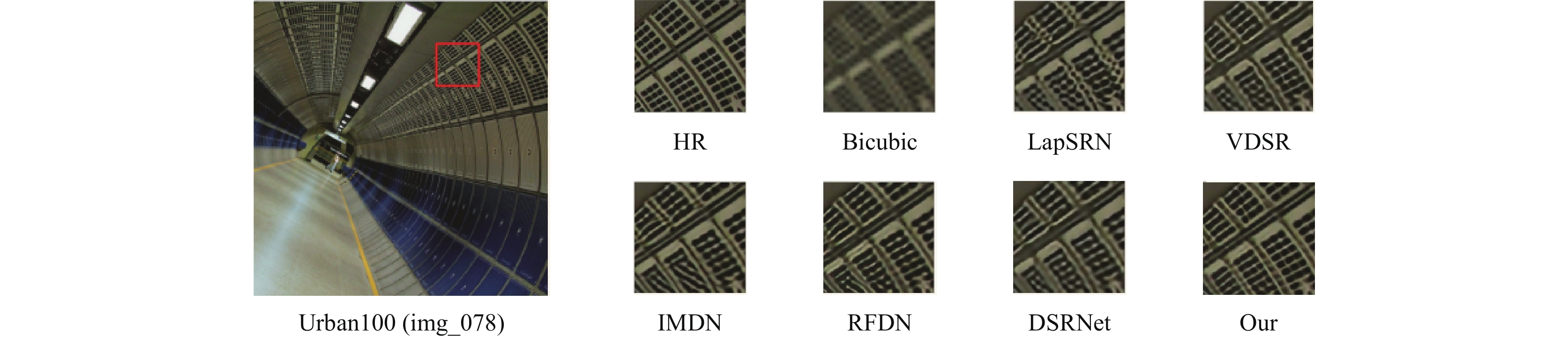

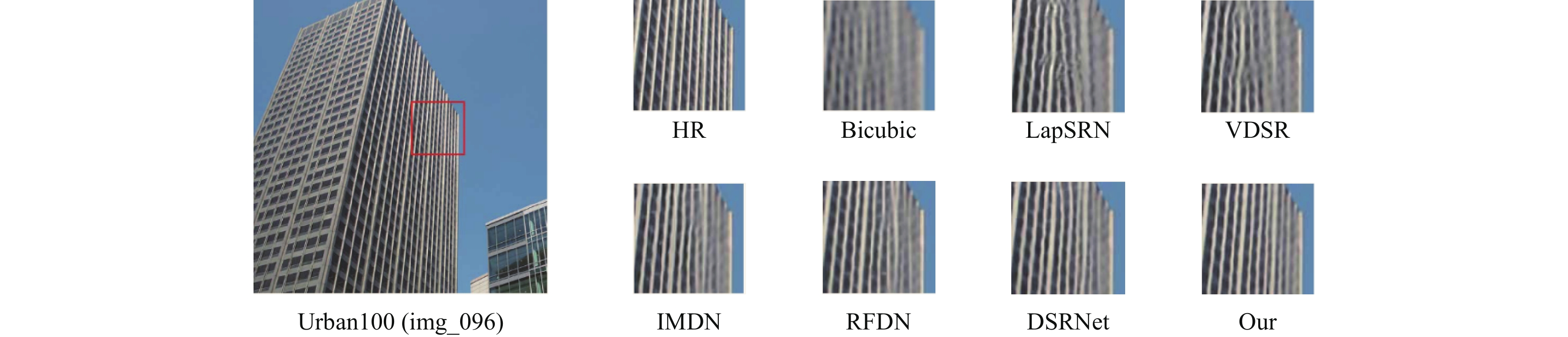

将提出的W-SDNet与经典模型LapSRN、VDSR, 先进轻量级模型IMDN、RFDN, 基准模型DSRNet进行了视觉质量比较, 在Urban100测试数据集上放大4倍SR结果如图5和图6所示. 对于img_078可以发现LapSRN和VDSR生成的图像相对模糊, 条纹存在伪影, 线条变形, 而本文提出W-SDNet虽然存在形变, 但相比于其他方法纹理更清晰, 更贴近高分辨率图像. 对于img_096发现LapSRN、VDSR、IMDN、DSRNet不仅产生的图像模糊, 而且线条变形严重, 不能准确恢复图像纹理细节, W-SDNet恢复了图像大多细节, 失真更小具有更好的视觉效果. 对于图片纹理细节恢复的优势, 得益于本文提出的融合边缘检测算子的注意力机制, 更加关注边缘纹理信息, 使生成的SR图像可以更好表达边缘特征.

|

图 5 放大倍数为4各算法在img_078视觉对比 |

|

图 6 放大倍数为4各算法在img_096视觉对比 |

4.4 模型复杂度分析

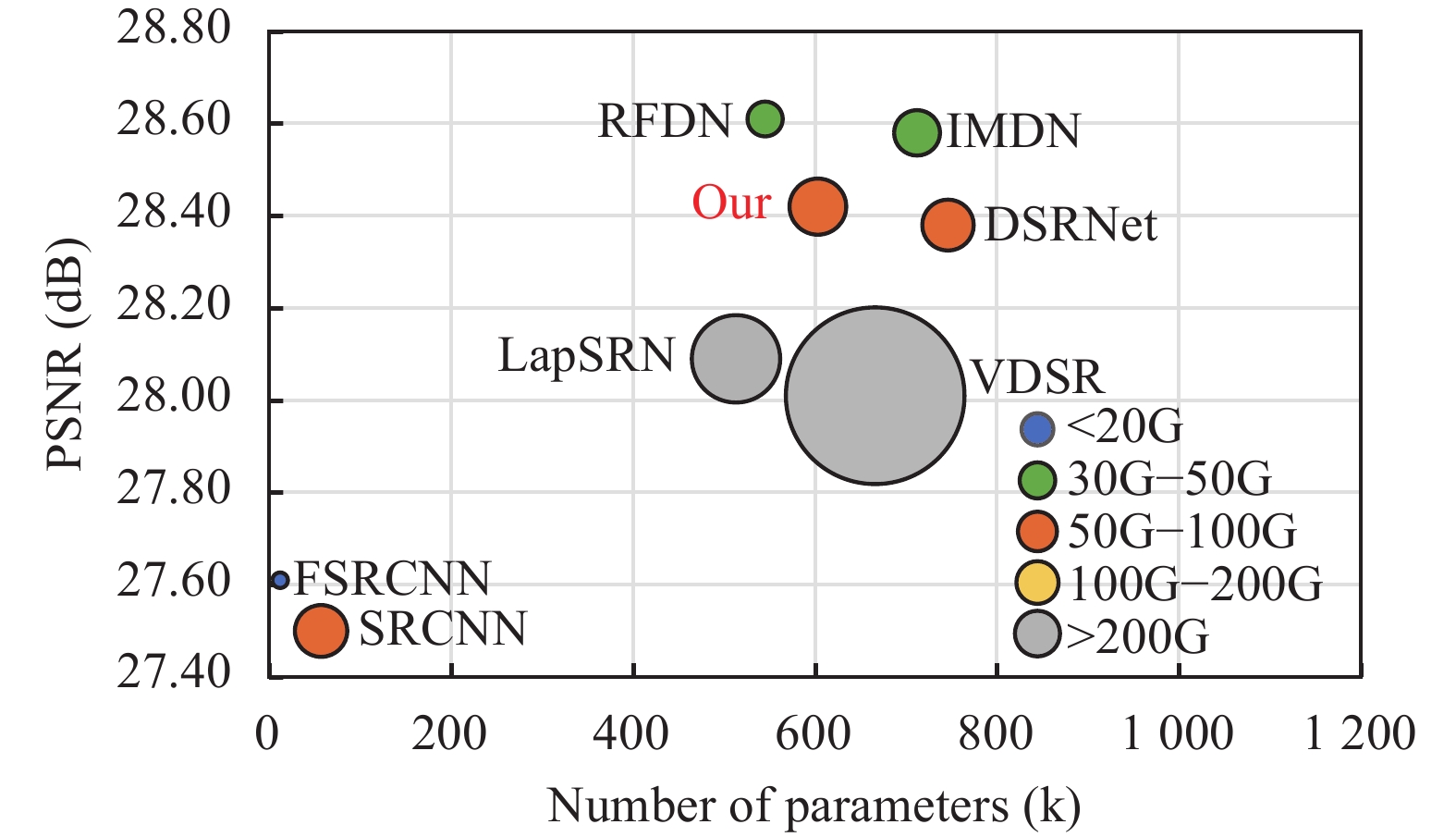

在本节中, 对算法的模型复杂度进行了研究, 包括大小、运行时间、Flops, 并与其他经典图像超分辨率算法进行了比较. 如表5和图7所示, 本文提出的方法平均运行时间在所提方法中排名第四, 虽然SRCNN、FSRCNN、VDSR运行时间相比于本文方法更短, 但本文算法的PSNR显著高于这3种模型, 且参数量和Flops少于VDSR. 表5中IMDN与RFDN的PSNR略高于本文方法, 但本文方法参数量更少的同时单幅图像平均运行时间仅为这两种方法的1/4. 通过以上实验对比分析, 本文方法很好地平衡了模型性能和运行时间之间的矛盾, 保持性能的同时降低了模型的参数量和运行时间.

4.5 消融实验为了验证算法各模块的有效性进行了消融实验, 通过在Set14数据集上放大2倍的SSIM、PSNR的变化, 验证移位残差块、互补块、注意力机制、特征增强块的有效性, 以及门机制中阈值的选取和损失函数的选取.

| 表 5 不同方法在Set14数据集放大4倍复杂度对比 |

(1)验证移位残差块, 互补块, 特征增强块有效性. 在验证各模块有效性之前, 将DSRNet作为基线网络, 对DSRNet中对应模块进行替换, 通过模型参数量和PSNR变化来验证各模块对模型性能. 通过表6所示, 可以发现移位残差块和特征细化块可以在损失很少的PSNR情况下, 极大地减少模型的参数. 而互补块虽然增加了一些参数和运算量, 但对模型的重建性能提高有帮助, 通过各模块的组合, 可以在不损失重建效果的情况下, 减少模型参数, 提升模型性能. 这表明各模块对于提升图像超分辨率性能指标是有效的.

|

图 7 在Set14数据集放大4倍参数量、Flops、PSNR对比 |

| 表 6 放大倍数为4时各模块的PSNR值和参数量对比 |

(2)验证互补块IESA的有效性. 为了验证本文提出的IESA注意力模块的有效性, 在本文算法的基础上通过替换其他3种不同的注意力模型, 对比不同注意力机制对于网络参数量和PSNR、SSIM的变化情况, 验证增强注意力机制性能. 通过表7所示, 不同注意力对于网络参数量以及PSNR、SSIM具有不同的影响. 仅使用通道平均值的SA 和CCA的模型虽然参数较少, 但性能明显比使用ESA和本文注意力模型的差. 而使用本文的模型保持与ESA相当参数的同时, 取得了比使用 ESA 的模型更好的性能. 所以尽管本文提出的注意力增加了少量参数, 但是获得了最好的PSNR和SSIM. 证明该注意力模型具有有效性.

| 表 7 使用不同注意力对模型参数量和性能影响 |

(3)门机制中阈值的选取. 宽增强块中动态门阈值的选取对于动态神经网络十分重要, 阈值选取的好坏直接影响动态网络的性能, 所以选择一种二分法来设置他的阈值. 选取了0.5、0.75、0.9这3个值来作为动态门的备选阈值. 通过实验, 如表8所示, 发现当阈值为0.75时, 网络的PSNR高于其他阈值的PSNR, 所以选择0.75作为动态门阈值.

(4)损失函数的选取. 为了探索不同损失函数对于模型的影响, 选取了在图像超分辨率领域使用最广泛的L1 Loss (mean absolute error, MAE)、L2 Loss (mean squared error, MSE)和平滑L1损失(smooth L1 Loss, SLL) 3种损失函数和文献[50]提出的FFT损失函数(fast Fourier transform loss function, FFT). 在Set14数据集放大倍数为4倍下, 比较模型使用这4种不同损失函数的PSNR.

| 表 8 不同阈值动态门的PSNR比较 |

通过表9所示, 发现本文方法使用MSE损失函数获得了最高的PSNR, 并且在实验中发现L1 Loss收敛速度较慢, SLL Loss的PSNR比较低, FFT Loss开始收敛速度很慢, 后续甚至出现梯度消失的问题, 所以通过综合考量, 决定使用MSE作为本文模型的损失函数.

| 表 9 不同损失函数对模型PSNR的影响 |

5 结语

本文提出的一种具有宽网络结构的图像动态超分辨率网络(W-SDNet), 包含浅层特征提取块、残差增强块、宽增强块、特征细化块和构造块. 设计了引入移位卷积层的移位残差块(SC-ResBlock), 减少模型参数数量和计算成本. 构建了具有双分支4层并行网络结构的动态宽增强块, 并在其中嵌入了结合BSConv和边缘检测算法的增强空间注意力模块(IESA), 提取更丰富的信息, 增强所获得的超分辨率模型对不同应用场景的适用性. 最后选用组卷积和信道分割操作来降低计算复杂度, 提高模型重建速度. 通过大量实验结果表明, W-SDNet不仅可以方便地获取丰富的结构信息, 而且具有轻量化的特点, 很好地平衡了图像重建性能和运行时间之间的矛盾. 未来希望在此模型的基础上实现任意尺度图像超分辨率.

| [1] |

Yoo JS, Kim JO. Noise-robust iterative back-projection. IEEE Transactions on Image Processing, 2020, 29: 1219-1232. DOI:10.1109/TIP.2019.2940414 |

| [2] |

Dong C, Loy CC, He KM, et al. Learning a deep convolutional network for image super-resolution. Proceedings of the 13th European Conference on Computer Vision. Zurich: Springer, 2014. 184–199.

|

| [3] |

Kim J, Lee JK, Lee KM. Accurate image super-resolution using very deep convolutional networks. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE, 2016. 1646–1654.

|

| [4] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 770–778.

|

| [5] |

Lim B, Son S, Kim H, et al. Enhanced deep residual networks for single image super-resolution. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Honolulu: IEEE, 2017. 1132–1140.

|

| [6] |

Tai Y, Yang J, Liu XM, et al. MemNet: A persistent memory network for image restoration. Proceedings of the 2017 IEEE International Conference on Computer Vision (ICCV). Venice: IEEE, 2017. 4549–4557.

|

| [7] |

Hu J, Shen L, Sun G. Squeeze-and-excitation network. Proceeding of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7132–7141.

|

| [8] |

Zhang YL, Li KP, Li K, et al. Image super-resolution using very deep residual channel attention networks. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 294–310.

|

| [9] |

Dai T, Cai JR, Zhang YB, et al. Second-order attention network for single image super-resolution. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 11057–11066.

|

| [10] |

Dosovitskiy A, Beyer L, Kolesnikov A, et al. An image is worth 16x16 words: Transformers for image recognition at scale. Proceedings of the 9th International Conference on Learning Representations. OpenReview.net, 2021.

|

| [11] |

Wang WH, Xie EZ, Li X, et al. PVT v2: Improved baselines with pyramid vision Transformer. Computational Visual Media, 2022, 8(3): 415-424. DOI:10.1007/s41095-022-0274-8 |

| [12] |

肖子安, 张静, 苑馨方, 等. 基于多尺度特征提取和坐标注意力的光学遥感图像超分辨率重建. 计算机系统应用, 2023, 32(7): 105-112. DOI:10.15888/j.cnki.csa.009168 |

| [13] |

Liang JY, Cao JZ, Sun GL, et al. SwinIR: Image restoration using Swin Transformer. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision Workshops. Montreal: IEEE, 2021. 1833–1844.

|

| [14] |

Kim J, Lee JK, Lee KM. Deeply-recursive convolutional network for image super-resolution. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE, 2016. 1637–1645.

|

| [15] |

Tai Y, Yang J, Liu XM. Image super-resolution via deep recursive residual network. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 2790–2798.

|

| [16] |

Ahn N, Kang B, Sohn KA. Fast, accurate, and lightweight super-resolution with cascading residual network. Proceedings of the 15th European Conference on Computer Vision (ECCV). Munich: Springer, 2018. 256–272.

|

| [17] |

Hui Z, Gao XB, Yang YC, et al. Lightweight image super-resolution with information multi-distillation network. Proceedings of the 27th ACM International Conference on Multimedia. Nice: ACM, 2019. 2024–2032.

|

| [18] |

Liu J, Tang J, Wu GS. Residual feature distillation network for lightweight image super-resolution. Proceedings of the 2020 Workshops on Computer Vision. Glasgow: Springer, 2020. 41–55.

|

| [19] |

王一宁, 赵青杉, 秦品乐, 等. 基于轻量密集神经网络的医学图像超分辨率重建算法. 计算机应用, 2022, 42(8): 2586-2592. |

| [20] |

周登文, 王婉君, 马钰, 等. 基于区域互补注意力和多维注意力的轻量级图像超分辨率网络. 模式识别与人工智能, 2022, 35(7): 625-636. DOI:10.16451/j.cnki.issn1003-6059.202207005 |

| [21] |

Gao DD, Zhou DW. A very lightweight and efficient image super-resolution network. Expert Systems with Applications, 2023, 213: 118898. DOI:10.1016/j.eswa.2022.118898 |

| [22] |

陈豪, 夏振平, 程成, 等. 基于Transformer-CNN的轻量级图像超分辨率重建网络. 计算机应用, 2024, 44(1): 292-299. |

| [23] |

Shi YK, Zhong HY, Yang ZJ, et al. DDet: Dual-path dynamic enhancement network for real-world image super-resolution. IEEE Signal Processing Letters, 2020, 27: 481-485. DOI:10.1109/LSP.2020.2978410 |

| [24] |

Wu HL, Ni N, Zhang LB. Lightweight stepless super-resolution of remote sensing images via saliency-aware dynamic routing strategy. IEEE Transactions on Geoscience and Remote Sensing, 2023, 61: 5601717. |

| [25] |

Chen BH, Lin MB, Sheng KK, et al. ARM: Any-time super-resolution method. Proceedings of the 17th European Conference on Computer Vision. Tel Aviv: Springer, 2022. 254–270.

|

| [26] |

Haase D, Amthor M. Rethinking depthwise separable convolutions: How intra-kernel correlations lead to improved MobileNets. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 14588–14597.

|

| [27] |

Chollet F. Xception: Deep learning with depthwise separable convolutions. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 1800–1807.

|

| [28] |

Hendrycks D, Gimpel K. Gaussian error linear units (GELUs). arXiv:1606.08415, 2016.

|

| [29] |

Wu G, Jiang JJ, Jiang K, et al. Fully 1×1 convolutional network for lightweight image super-resolution. arXiv:2307.16140, 2023.

|

| [30] |

Szegedy C, Liu W, Jia YQ, et al. Going deeper with convolutions. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 1–9.

|

| [31] |

Kong FY, Li MX, Liu SW, et al. Residual local feature network for efficient super-resolution. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. New Orleans: IEEE, 2022. 765–775.

|

| [32] |

李众, 王雅婧, 马巧梅. 基于空洞卷积的医学图像超分辨率重建算法. 计算机应用, 2023, 43(9): 2940-2947. |

| [33] |

Canny J. A computational approach to edge detection. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1986, PAMI-8(6): 679-698. DOI:10.1109/TPAMI.1986.4767851 |

| [34] |

Wang Z, Bovik AC. Mean squared error: Love it or leave it? A new look at signal fidelity measures. IEEE Signal Processing Magazine, 2009, 26(1): 98-117. DOI:10.1109/MSP.2008.930649 |

| [35] |

Timofte R, Gu SH, Wu JQ, et al. NTIRE 2018 challenge on single image super-resolution: Methods and results. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Salt Lake City: IEEE, 2018. 852–863.

|

| [36] |

Bevilacqua M, Roumy A, Guillemot C, et al. Low-complexity single-image super-resolution based on nonnegative neighbor embedding. Proceedings of the 2012 British Machine Vision Conference. Surrey: BMVA Press, 2012. 1–10.

|

| [37] |

Yang JC, Wright J, Huang TS, et al. Image super-resolution via sparse representation. IEEE Transactions on Image Processing, 2010, 19(11): 2861-2873. DOI:10.1109/TIP.2010.2050625 |

| [38] |

Martin D, Fowlkes C, Tal D, et al. A database of human segmented natural images and its application to evaluating segmentation algorithms and measuring ecological statistics. Proceedings of the 8th IEEE International Conference on Computer Vision (ICCV). Vancouver: IEEE, 2001. 416–423.

|

| [39] |

Huang JB, Singh A, Ahuja N. Single image super-resolution from transformed self-exemplars. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 5197–5206.

|

| [40] |

Aizawa K, Fujimoto A, Otsubo A, et al. Building a manga dataset “Manga109” with annotations for multimedia applications. IEEE MultiMedia, 2020, 27(2): 8-18. DOI:10.1109/MMUL.2020.2987895 |

| [41] |

Cai JR, Zeng H, Yong HW, et al. Toward real-world single image super-resolution: A new benchmark and a new model. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 3086–3095.

|

| [42] |

Tian CW, Zhang XY, Zhang Q, et al. Image super-resolution via dynamic network. arXiv:2310.10413, 2023.

|

| [43] |

Dong C, Loy CC, Tang XO. Accelerating the super-resolution convolutional neural network. Proceedings of the 4th European Conference on Computer Vision. Amsterdam: Springer, 2016. 391–407.

|

| [44] |

Lai WS, Huang JB, Ahuja N, et al. Deep Laplacian pyramid networks for fast and accurate super-resolution. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 5835–5843.

|

| [45] |

欧阳宁, 韦羽, 林乐平. 结合感知边缘约束与多尺度融合网络的图像超分辨率重建方法. 计算机应用, 2020, 40(10): 3041-3047. |

| [46] |

Tian CW, Xu Y, Zuo WM, et al. Asymmetric CNN for image superresolution. IEEE Transactions on Systems, Man, and Cybernetics: Systems, 2022, 52(6): 3718-3730. DOI:10.1109/TSMC.2021.3069265 |

| [47] |

Wei RJ, Zhang SW, Liu ZC, et al. EBSR: Enhanced binary neural network for image super-resolution. arXiv:2303.12270, 2023.

|

| [48] |

Shocher A, Cohen N, Irani M. “Zero-shot” super-resolution using deep internal learning. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 3118–3126.

|

| [49] |

Wang LG, Wang YQ, Dong XY, et al. Unsupervised degradation representation learning for blind super-resolution. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 10576–10585.

|

| [50] |

Zhang R, Isola P, Efros AA. Split-brain autoencoders: Unsupervised learning by cross-channel prediction. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 645–654.

|

2024, Vol. 33

2024, Vol. 33