2. 工业智能数据安全安徽省重点实验室, 芜湖 241002

2. Key Laboratory of Industrial Intelligent Data Security of Anhui Province, Wuhu 241002, China

高维数据由于高维空间中样本之间距离的稀疏性, 导致数据稀疏和冗余, 增加了计算和存储成本, 因此在处理和分析时面临挑战. 作为常用的降维算法之一, 投影学习在高维数据处理和分析中具有重要意义[1–3]. 通过保留数据的基本信息并将其映射到低维空间, 投影学习可以显著减少数据的冗余和复杂性, 同时保持数据点之间的关键关系. 这简化了问题求解, 提高了计算效率, 并促进了数据可视化和理解[4].

降维算法的演进经历了从传统线性方法, 如主成分分析 (principal component analysis, PCA)[5] 和线性判别分析 (linear discriminant analysis, LDA)[6], 到基于流形学习的非线性方法的过程. 在这个过程中, 出现了一系列基于流形学习的降维算法, 包括等距映射 (isometric mapping, ISOMAP)[7]、局部线性嵌入 (locally linear embedding, LLE)[8]和拉普拉斯特征映射 (Laplacian eigenmap, LE)[9]等. 这些方法致力于将高维数据映射到低维流形空间, 以便更好地捕捉数据中的非线性特征和结构. 然而, 尽管非线性流形学习方法在处理复杂数据结构方面表现出色, 但在样本外推和泛化方面仍然存在挑战. 在一些应用中, 线性投影技术表现突出成为最常用和稳定的方法. 因此, 经典的局部保持投影 (locality preserving projection, LPP)[10]作为一种线性降维方法, 利用 LE 在原始和嵌入空间之间建立线性映射. 同时, 通过保持样本之间的局部邻域关系, LPP 可以更好地揭示数据的局部结构. 随着研究的深入, 逐渐出现了许多将其他优秀的数据挖掘工具 (如低秩或稀疏属性) 与投影学习相结合的投影学习方法[11–14].

众所周知, 类似于 LPP 的方法在执行之前需要预定义一个图来描述数据样本之间的局部关联. 显然, 在稀疏高维空间中, 随着欧氏度量逐渐失效, 基于任何假设的任何预定义图都将是徒劳的. 近年来, 提出了许多同时优化图和投影矩阵的方法[15–18]. 在类内样本之间的亲和度满足二次条件的前提下, Li 等人[19]研究了全连接的类内图, 并提出了局部自适应判别分析 (locality adaptive discriminant analysis, LADA), 可以很好地揭示潜在的数据流形结构. Pang 等人[20]提出了同时学习邻居和投影矩阵的方法 (simultaneously learning neighborship and projection matrix, SLNP), 使相似度和邻居成为低维子空间中的变量. 然后通过最小化统一的目标函数获得最佳相似度和投影矩阵. Nie 等人[21]提出了自适应局部线性判别分析 (adaptive local linear discriminant analysis, ALLDA), 它从数据本身自适应地学习了一个

在流形学习的背景下, 基本假设是数据分布在一个低维流形上, 这意味着该流形的局部区域可以同胚于某个欧几里得空间 (通常是低维空间). 在这些局部区域中, 数据在流形上呈近似线性, 允许在欧几里得空间中使用线性关系对其进行近似. LLE 是一个经典的为此目的设计的流形学习算法, 而邻域保持嵌入(neigh-borhood preserving embedding, NPE)[22]是一个具有线性投影学习的扩展版本. LLE 和 NPE 使每个样本可以通过其相邻样本的线性组合在低维空间中近似重构, 同时保持数据点之间的局部关系. 然而, 在环境空间(ambient space)中选择

以上的介绍涵盖了2种代表性的技术. 其中一种源于 LPP 方法, 从预定义的亲和度图演变为动态亲和度图. 另一种是基于 NPE 方法构建的, 从

本文第 2 节介绍本文写作中的一些符号, 并简要概述了该领域的相关方法. 接下来, 在第 3 节中, 本文提出一种创新的模型, 讨论了优化过程, 并分析了其计算复杂性. 实验设置和结果在第 4 节详细说明. 最后, 在第 5 节中, 我们总结了全文.

2 相关工作 2.1 符号与定义假设有一个数据矩阵

| yi=Qxi | (1) |

其中,

LPP 是一种线性降维方法, 旨在保持高维数据的局部邻域, 并确保低维空间中的数据样本投影与其在高维空间中的原始局部关系紧密相符. 一般来说, 其目标函数可以表示为:

| minQ12n∑i,j=1‖Qxi−Qxj‖22wij | (2) |

其中,

| 12n∑i,j=1‖Qxi−Qxj‖22wij=tr(QXLXTQT) | (3) |

其中,

| min | (4) |

利用拉格朗日乘子法, 约束问题 (4) 等价于以下广义特征值分解问题:

| XL{X^{\mathrm{T}}}{q^{\mathrm{T}}} = \alpha XD{X^{\mathrm{T}}}{q^{\mathrm{T}}} | (5) |

其中,

稀疏表示[31–33]是信号处理和机器学习领域常用的技术之一, 旨在将信号或数据表示为尽可能少的非零元素的线性组合, 有助于从信号中提取关键特征, 降低数据维度, 并展现出了优秀的噪声鲁棒性. 假设要表示的信号是一个向量

| \mathop {\min }\limits_w {\left\| w \right\|_0}\;\;\;\;{\text{s.t.}}\;x = Dw | (6) |

其中,

然而, 问题 (6) 是一个 NP-hard 问题, 因为计算

| \mathop {\min }\limits_w {\left\| w \right\|_1}\;\;\;\;{\text{s.t.}}\;x = Dw | (7) |

其中,

| \underset{w}{\mathrm{min}}{\Vert w\Vert }_{1}\;\;\;\;\text{s.t.}\;\Vert x-Dw\Vert \leqslant \epsilon | (8) |

其中,

SPP 是 LLE 和 NPE 的一种变体, 专注于在将高维数据投影到低维空间时保持数据的稀疏性. LLE、NPE 和 SPP 使用一个共同目标函数, 可以表达为:

| \underset{Y}{\mathrm{min}}{\displaystyle \sum _{i=1}^{n}\Vert {y}_{i}-{\displaystyle \sum _{j=1}^{n}{w}_{ij}}{y}_{j}{\Vert }_{2}^{2}}\;\;\;\;\text{s.t.}\;Y{Y}^{\rm T}=I | (9) |

其中,

| \underset{W}{\mathrm{min}}{\displaystyle \sum _{i=1}^{n}\Vert {x}_{i}-{\displaystyle \sum _{j=1}^{n}{w}_{ij}}{x}_{j}{\Vert }_{2}^{2}}\;\;\;\;\text{s.t.}\;{\displaystyle \sum _{j}{w}_{ij}}=1 | (10) |

其中,

| \underset{{w}_{i}}{\mathrm{min}}\Vert {w}_{i}{\Vert }_{1}\;\;\;\;\text{s.t.}\;\Vert {x}_{i}-X{w}_{i}{\Vert }_{2}^{2}\leqslant \epsilon , \text{ }{\displaystyle \sum _{j}{w}_{ij}}=1 | (11) |

其中, 字典选择为

考虑到现有方法的优点和局限性, 在本节中, 我们将逐步完善所提出的模型 LPP_SRL, 并设计了一个高效的迭代算法来优化它. 此外, 我们还分析了所提出模型的求解算法的计算复杂度.

3.1 模型建立如第1节所述, 在投影学习过程中学习到的图在许多情景下表现出了良好的性能, 但原始空间中基于欧氏距离定义的图也确实包含了对后续分类任务有益的某些特征信息. 因此, 所提出的模型继承了原始 LPP 如下:

| \underset{Q}{\mathrm{min}}\frac{1}{2}{\displaystyle \sum _{i, j=1}^{n}\Vert Q{x}_{i}-Q{x}_{j}{\Vert }_{2}^{2}}{w}_{ij} | (12) |

此外, 考虑到特定亲和度假设的适用性可能不够灵活, 我们只利用环境空间中样本的

| {w_{ij}} = \left\{ {\begin{array}{*{20}{l}} {1/k, }&{{x_i} \in {N_k}({x_j})} \\ {0, }&{{\text{otherwise}}} \end{array}} \right. | (13) |

其中,

此外, 我们认为稀疏局部表示能揭示数据样本之间的内在连接. 因此, 得到以下目标函数:

| \underset{{{\textit{z}}}_{i}}{\mathrm{min}}\Vert {{\textit{z}}}_{i}{\Vert }_{1}+\lambda \Vert {e}_{i}{\Vert }_{1}\;\;\;\;\text{s.t.}\;{x}_{i}=X{{\textit{z}}}_{i}+{e}_{i} | (14) |

其中,

| \mathop {\min }\limits_Z {\left\| Z \right\|_1} + \lambda {\left\| E \right\|_1}\;\;\;\;{\text{s.t.}}\;X = XZ + E | (15) |

事实上, 式(15) 不能直接与投影学习过程集成, 除非利用表示系数以图的形式描述数据样本之间的连接. 此外, 从现实场景中收集到的数据

| {x_i} = {p_1}{y_{1i}} + {p_2}{y_{2i}} + \cdots + {p_m}{y_{mi}} + {r_i} | (16) |

其中, 残差向量

| X = PQX + R | (17) |

然后, 将式 (17) 替换进方程

| X = PQXZ + RZ + E | (18) |

其中,

| \mathop {\min }\limits_Z {\left\| Z \right\|_1} + \lambda {\left\| E \right\|_{2, 1}}{\text{ s}}{\text{.t}}{\text{. }}X = PQXZ + E | (19) |

其中, 用

综合考虑式(12)和式(19)可以实现相互促进学习的目的, 导出最终目标函数如下:

| \left\{\begin{split} &\underset{P, Q, Z, E}{\mathrm{min}}\frac{1}{4}{\displaystyle \sum _{i, j=1}^{n}\Vert Q{x}_{i}-Q{x}_{j}{\Vert }_{2}^{2}}{w}_{ij}+ {\lambda }_{1}\Vert Z{\Vert }_{1} \\ &\quad+{\lambda }_{2}\Vert E{\Vert }_{2, 1}+\frac{{\lambda }_{3}}{2}\Vert Q{\Vert }_{F}^{2}\\ &\text{s.t.}\;X=PQXZ+E, \text{ }{P}^{\rm T}P=I\end{split} \right. | (20) |

其中,

在本节中, 我们将通过采用交替方向乘子法 (alternating direction method of multipliers, ADMM) 框架[34]解决式(20)中的优化问题. 关于 ADMM 在非凸问题上的详细收敛分析可以在文献 [35] 中找到. 为了简化优化过程, 我们首先引入一个辅助变量

| \left\{\begin{split} &\underset{P, Q, Z, E, B}{\mathrm{min}}\frac{1}{2}{\mathrm{tr}}(QX{L}_{W}{X}^{\rm T}{Q}^{\rm T})+{\lambda }_{1}\Vert B{\Vert }_{1}+{\lambda }_{2}\Vert E{\Vert }_{2, 1}+\frac{{\lambda }_{3}}{2}\Vert Q{\Vert }_{F}^{2}\\ &\text{s.t.}\;X=PQXZ-E, \text{ }{P}^{\rm T}P=I, \text{ }Z=B\end{split} \right. | (21) |

其中, 拉普拉斯矩阵

紧接着, 问题 (21) 的增广拉格朗日函数定义如下:

| \left\{\begin{split} &\mathcal{L}(P, Q, Z, E, B)\\ &=\frac{1}{2}{\mathrm{tr}}(QX{L}_{W}{X}^{\rm T}{Q}^{\rm T})+{\lambda }_{1}\Vert B{\Vert }_{1}+{\lambda }_{2}\Vert E{\Vert }_{2, 1}\\ &\quad+\frac{{\lambda }_{3}}{2}\Vert Q{\Vert }_{F}^{2}+\langle {C}_{1}, X-PQXZ+E\rangle +\langle {C}_{2}, Z-B\rangle \\ &\quad+\frac{\mu }{2}\left(\Vert X-PQXZ-E{\Vert }_{F}^{2}+\Vert Z-B{\Vert }_{F}^{2}\right)\\ &\text{s.t.}\;{P}^{\rm T}P=I\end{split} \right. | (22) |

其中,

通过使用一些数学技巧, 问题 (22) 可以重新表述为:

| \left\{ \begin{split} &\mathcal{L}(P, Q, Z, E, B)\\ &=\frac{1}{2}{\mathrm{tr}}(QX{L}_{W}{X}^{\rm T}{Q}^{\rm T})+{\lambda }_{1}\Vert B{\Vert }_{1}+{\lambda }_{2}\Vert E{\Vert }_{2, 1}+\frac{{\lambda }_{3}}{2}\Vert Q{\Vert }_{F}^{2}\\ &\quad+\frac{\mu }{2}\left(\Vert X-PQXZ-E+\frac{{C}_{1}}{\mu }{\Vert }_{F}^{2}+\Vert Z-B+\frac{{C}_{2}}{\mu }{\Vert }_{F}^{2}\right)\\ &\quad-\frac{1}{2\mu }\left(\Vert {C}_{1}{\Vert }_{F}^{2}+\Vert {C}_{2}{\Vert }_{F}^{2}\right)\\ &\text{s}\text{.t}\text{. }{P}^{\rm T}P=I\end{split} \right. | (23) |

为了解决问题 (23), 需要交替更新变量

● 更新

| \underset{Z}{\mathrm{min}}\Vert X-PQXZ-E+\frac{{C}_{1}}{\mu }{\Vert }_{F}^{2}+\Vert Z-B+\frac{{C}_{2}}{\mu }{\Vert }_{F}^{2} | (24) |

定义

| ({X^{\mathrm{T}}}{Q^{\mathrm{T}}}QX + I)Z = {X^{\mathrm{T}}}{Q^{\mathrm{T}}}{P^{\mathrm{T}}}F + T | (25) |

然后, 从式(25)计算出:

| Z = {({X^{\mathrm{T}}}{Q^{\mathrm{T}}}QX + I)^{ - 1}}({X^{\mathrm{T}}}{Q^{\mathrm{T}}}{P^{\mathrm{T}}}F + T) | (26) |

● 更新

| \underset{B}{\mathrm{min}}{\lambda }_{1}\Vert B{\Vert }_{1}+\frac{\mu }{2}\Vert B-J{\Vert }_{F}^{2} | (27) |

其中,

| B = {\Omega _{\frac{{{\lambda _1}}}{\mu }}}(J) | (28) |

其中,

| {B_{ij}} = {\text{sgn}}({J_{ij}}) \cdot \max \left(|{J_{ij}}| - \frac{{{\lambda _1}}}{\mu }, {\text{ }}0\right) | (29) |

其中,

● 更新

| \begin{split} &\underset{Q}{\mathrm{min}}\frac{1}{2}{\mathrm{tr}}(QX{L}_{W}{X}^{\rm T}{Q}^{\rm T})+\frac{{\lambda }_{3}}{2}\Vert Q{\Vert }_{F}^{2}\\ &\text{ }+\frac{\mu }{2}\Vert X-PQXZ-E+\frac{{C}_{1}}{\mu }{\Vert }_{F}^{2}\end{split} | (30) |

对

| Q({\lambda _3}I + X{L_W}{X^{\mathrm{T}}} + \mu XZ{Z^{\mathrm{T}}}{X^{\mathrm{T}}}) = \mu {P^{\mathrm{T}}}F{Z^{\mathrm{T}}}{X^{\mathrm{T}}} | (31) |

其中,

| Q = \mu {P^{\mathrm{T}}}F{Z^{\mathrm{T}}}{X^{\mathrm{T}}}{({\lambda _3}I + X{L_W}{X^{\mathrm{T}}} + \mu XZ{Z^{\mathrm{T}}}{X^{\mathrm{T}}})^{ - 1}} | (32) |

● 更新

| \underset{P}{\mathrm{min}}\Vert F-PQXZ{\Vert }_{F}^{2}\;\;\text{s.t.}\;{P}^{\rm T}P=I | (33) |

问题 (33) 是一个正交普鲁克问题 (orthogonal Procrustes problem, OPP)[37], 其解可以直接从thin SVD 中获得, 即:

| F{Z^{\mathrm{T}}}{X^{\mathrm{T}}}{Q^{\mathrm{T}}} = U\Sigma {V^{\mathrm{T}}} | (34) |

然后, 我们得到:

| P = U{V^{\mathrm{T}}} | (35) |

其中,

● 更新

| \underset{E}{\mathrm{min}}{\lambda }_{2}\Vert E{\Vert }_{2, 1}+\frac{\mu }{2}\Vert X-PQXZ-E+\frac{{C}_{1}}{\mu }{\Vert }_{F}^{2} | (36) |

令

| \underset{E}{\mathrm{min}}\frac{{\lambda }_{2}}{\mu }\Vert E{\Vert }_{2, 1}+\frac{1}{2}\Vert E-K{\Vert }_{F}^{2} | (37) |

可以分解为:

| \underset{{e}_{i}}{\mathrm{min}}\frac{{\lambda }_{2}}{\mu }\Vert {e}_{i}{\Vert }_{2}+\frac{1}{2}\Vert {e}_{i}-{k}_{i}{\Vert }_{2}^{2} | (38) |

其中,

| {e}_{i}=\left\{\begin{array}{ll}\left(1-\dfrac{{\lambda }_{2}/\mu }{\Vert {k}_{i}{\Vert }_{2}}\right){k}_{i}, & \Vert {k}_{i}{\Vert }_{2} \gt \dfrac{{\lambda }_{2}}{\mu } \\ 0, & \Vert {k}_{i}{\Vert }_{2}\leqslant \dfrac{{\lambda }_{2}}{\mu } \end{array}\right. | (39) |

● 更新

| \left\{ \begin{gathered} {C_1} = {C_1} + \mu (X - PQXZ - E) \\ {C_2} = {C_2} + \mu (Z - B) \\ \mu = \min (\rho \mu , {\text{ }}{\mu _{\rm max}}) \\ \end{gathered} \right. | (40) |

模型 (20) 的详细优化过程见算法 1.

算法1. 通过ADMM优化模型(20)的算法

输入: 训练样本矩阵

初始化:

重复:

1. 使用式(26)更新

2. 使用式(29)更新

3. 使用式(32)更新

4. 使用式(35)更新

5. 使用式(39)更新

6. 使用式(40)更新

直到: 以下约束条件被满足

输出: 判别投影矩阵

在本节中, 对解决所提出模型 LPP_SRL 所涉及的计算复杂性进行了全面分析. 算法 1 涉及几个关键步骤, 其中矩阵求逆是解决

在本节中, 我们评估了所提出方法在6个广泛使用的公共数据集上的有效性, 这些数据集收集自不同的场景, 包括: (1) EYaleB[39]; (2) YTC[40]; (3) Binalpha (https://cs.nyu.edu/~roweis/data.html); (4) USPS[41]; (5) Caltech101 Silhouettes[42]; (6) ETH80[43]. 为了进行有说服力的比较, 我们将所提方法与一些先进的方法进行比较, 包括 LDA[6], Supervised LPP (SLPP)[44], LSDA[45], OLSDA[46], FOLPP[47], LADA[19], RSLDA[48], SLNP[20], ALLDA[21], SN-TSL[49], LRPER[3]. 在本文的实验中, 使用最近邻 (1-NN) 分类器利用欧氏距离对样本进行分类, 并将上述方法的参数调试到最佳范围之内或直接采用作者推荐的值. 此外, 我们针对每个数据集固定了所有参数, 并同时改变训练样本的数量. 为了公平起见, 我们对所有算法在比较实验中进行了 10 次实验, 并计算出平均识别率. 在每一次实验中, 我们随机选择每个类别的一些样本作为训练数据 (#Tr), 同时使用剩余的样本作为测试数据. 为了提高计算效率, 我们首先对样本进行归一化, 即

Extended Yale B (EYaleB) 数据集包括从 38 名志愿者那里获取的共

|

图 1 EYaleB 人脸数据集的一些样本 |

| 表 1 在 EYaleB 数据集上不同方法的平均识别准确率(%)和标准差 |

4.2 在 YTC 数据集上的实验

YouTube-Celebrities (YTC) 数据集包括来自 YouTube 的 47 位名人的

|

图 2 YTC 人脸数据集的一些样本 |

| 表 2 在 YTC 数据集上不同方法的平均识别准确率(%)和标准差 |

4.3 在 Binalpha 数据集上的实验

该数据集包含分布在 36 个类别中的

|

图 3 Binalpha数据集的一些样本 |

| 表 3 在 Binalpha 数据集上不同方法的平均识别准确率(%)和标准差 |

4.4 在 USPS 数据集上的实验

USPS 数据集是一个手写数字图像集合, 包括从“0”至“9”的 10 类, 该数据集包含共

Caltech101 数据集包含 101 个不同类别的物体图像, 每个类别包含 31–798 张图像, 大多数类别大约有 50 张图像, 该数据集中的每个图像都包含一个高质量的多边形轮廓, 勾勒出场景中的主要对象. 在这里, 我们利用了 Caltech101 Silhouettes 数据集, 它专门关注物体轮廓, 以研究每种方法在形状识别中的性能, 在该数据集中, 轮廓被呈现为填充的黑色多边形, 背景为白色. 该数据集包含来自原始数据集的

|

图 4 USPS数据集的一些样本 |

| 表 4 在 USPS 数据集上不同方法的平均识别准确率 (%) 和标准差 |

|

图 5 Caltech101 数据集的一些样本 |

| 表 5 在 Caltech101 Silhouettes 数据集上不同方法的平均识别准确率 (%) 和标准差 |

4.6 在 ETH80 数据集上的实验

ETH80 数据集包括属于 8 个不同类别的物体图像, 包括苹果、汽车、奶牛、杯子、狗、马、梨和番茄, 每个类别有 10 个对象实例, 并且每个对象实例有来自 41 个不同视角的图片, 图6 展示了 ETH80 数据集中的一些样本. 在本文的实验中, 我们将灰度图像调整大小为 20×20 像素, 并将其转换为 400 维向量, 我们随机选择每个类别的 10、20、30 和 40 个图像作为训练集, 剩余的作为测试集. 从表6 呈现的结果中, 可以明显看出所提出方法的优越性能.

|

图 6 ETH80 数据集的一些样本 |

| 表 6 在 ETH80 数据集上不同方法的平均识别准确率 (%) 和标准差 |

4.7 实验结果与分析

根据表1–表6 中呈现的实验结果, 所提出的方法在包括人脸识别、手写识别、形状识别和物体识别在内的所有6个图像数据集上表现出优越的性能. 这表明了所提出方法的普适性, 并且我们从观察中发现了以下有趣的现象.

(1) 保留高维数据的局部结构通常会产生更好的性能. 例如, LPP 胜过 LDA, 因为 LPP 有效地保留了数据的局部结构, 而 LDA 则忽略了这一点. 此外, FOLPP 比 LPP 具有更强的局部保持能力[47], 从而得到更高的识别率. 另外, 正如本文前面所讨论的一样, 预定义图方法和自适应优化图方法的性能没有显著差异.

(2) 本文提出的方法和 RSLDA 在所有数据集上都能稳定表现出较高的识别率, 而其他方法则无法保持稳定. 例如, SLNP 在 Binalpha 和 ETH80 数据集中, 以及 SN-TSL 在 Binalpha 数据集中, 表现出较差的识别率. 原因在于所提出的方法和 RSLDA 通过在投影学习过程中考虑数据重建来有效地保留数据的主要成分.

(3) 在大多数情况下, 所提出的方法优于 RSLDA. 这是因为我们的方法不仅保留了基于距离的邻域, 而且自适应地学习了局部稀疏自表示, 丰富了数据的局部拓扑结构的描述. 相比之下, RSLDA 忽略了这个对于有效分类至关重要的结构. 这表明我们方法中的局部保持增强策略的确有助于保持数据的局部内在结构.

(4) 在ETH80数据集上使用 LADA、SLNP 和 ALLDA 时, 需要预先消除全局散布矩阵

总之, 实验结果表明了我们所提出的方法在各种图像识别任务中的有效性和泛用性.

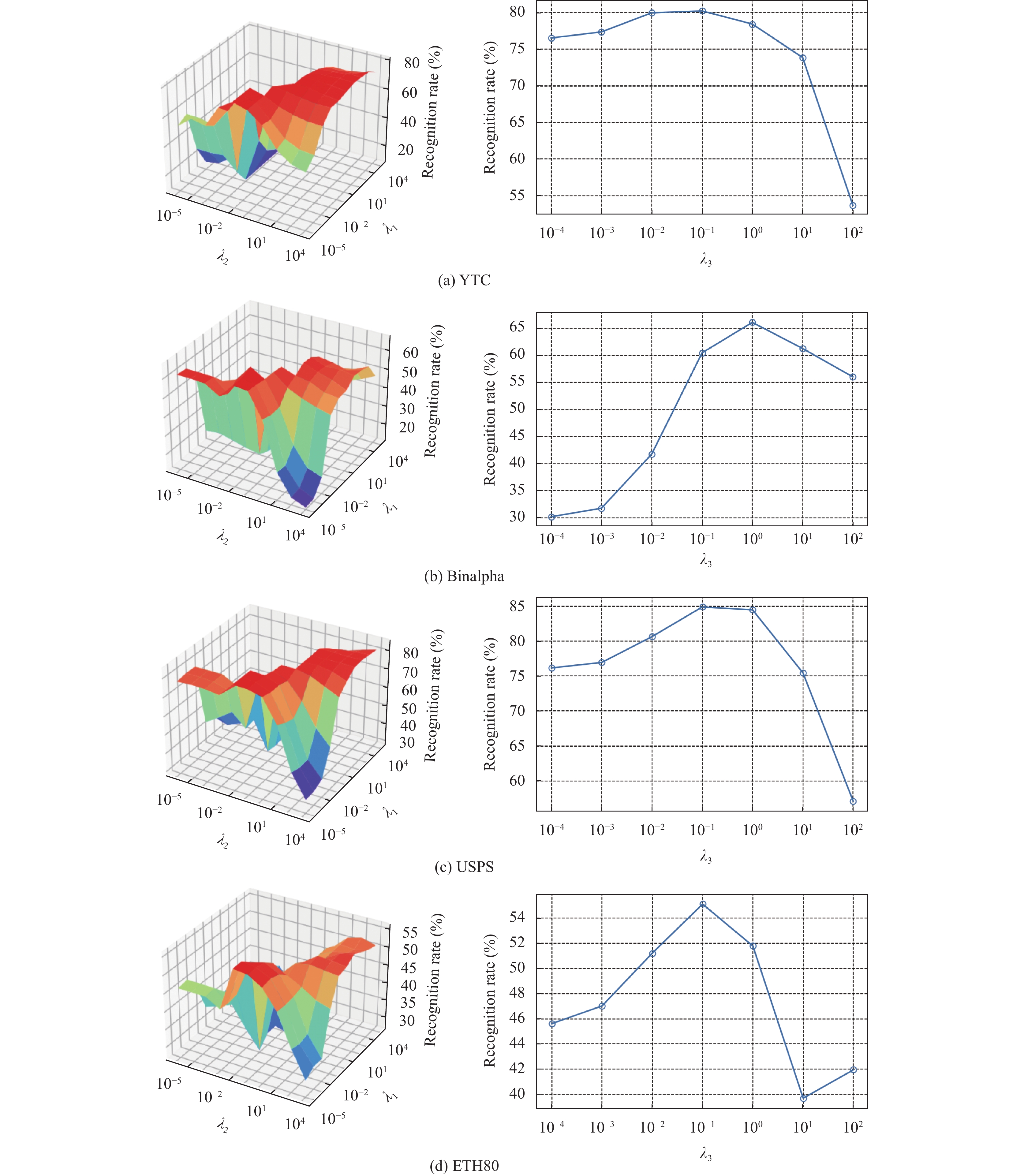

4.8 参数敏感性研究目标模型(20)的分类性能可能会受到4个可调整参数的影响, 即

在本节中, 我们测试不同参数组合下的分类准确率, 来分析这4个参数的影响. 通过实验, 我们观察到

|

图 7 识别准确率和参数 |

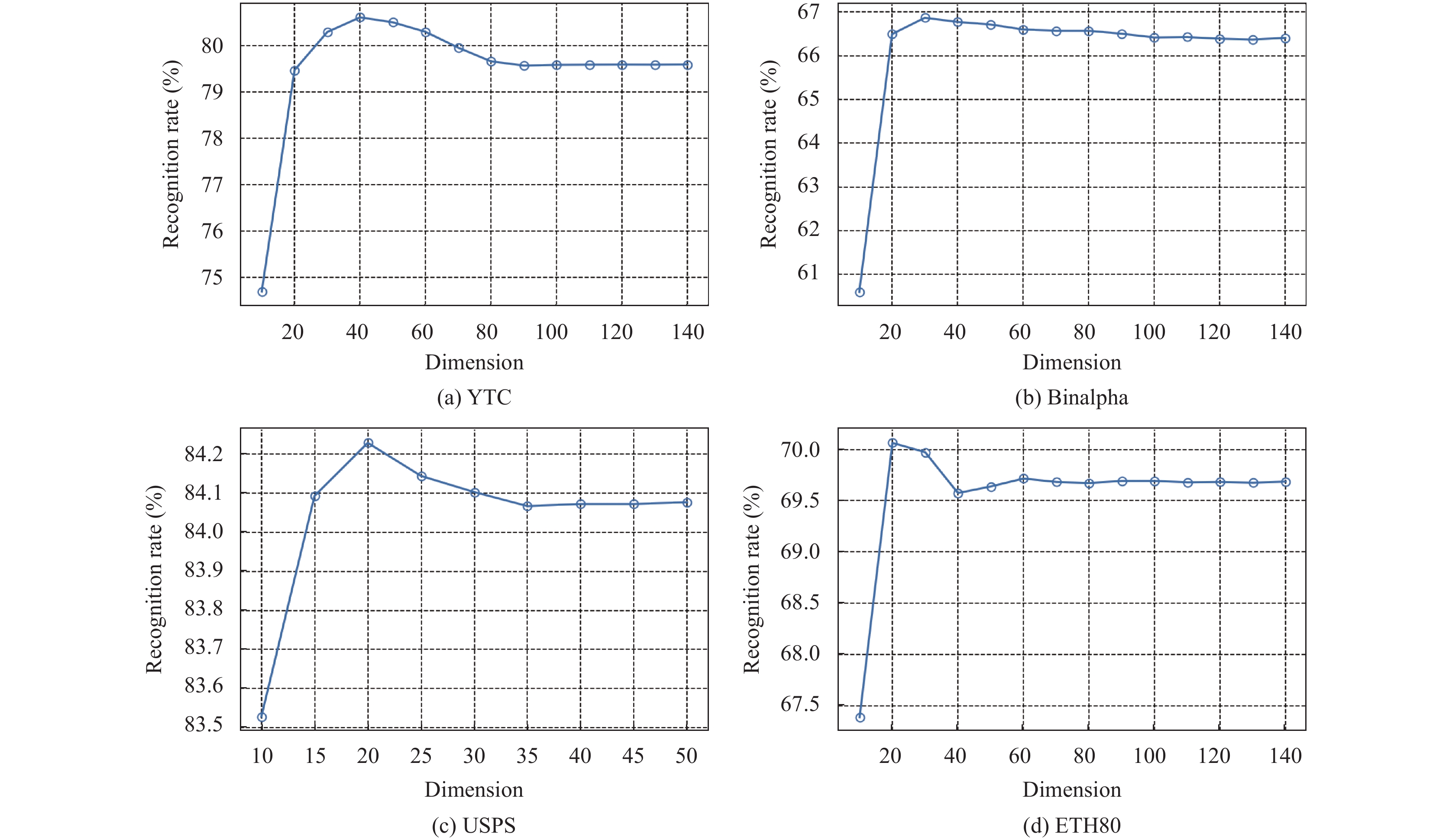

4.9 对维度敏感性的研究

为了进行特征提取, 我们在4个不同的数据集上分别评估了所提出方法在各种维度下的性能. 图9 展示了识别率与降维后维度之间的关系. 从图9中可以观察到, 只要不设定过低的维度, LPP_SRL 在各种特征维度上都能表现出一致且可观的性能. 在表1–表6 的实验结果中, 我们对所有除了 SN-TSL 外的方法设定了统一的子空间维度, 在 EYaleB、YTC、Binalpha、USPS、Caltech101 Silhouettes 和 ETH80 数据集上分别为 80、40、50、25、50 和 20. 对于 SN-TSL, 降维后的维度则始终设置为

|

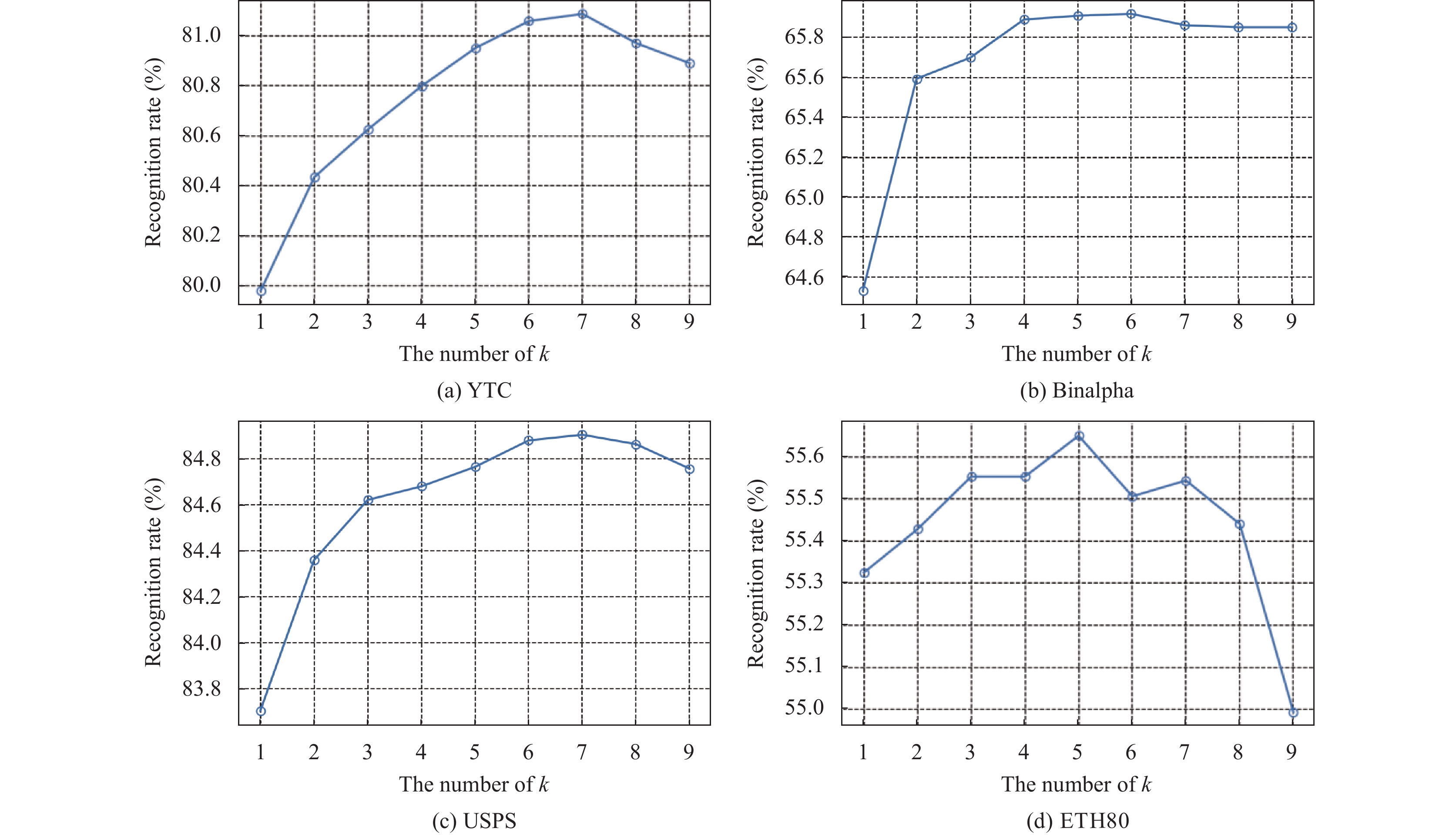

图 8 识别准确率和邻域个数之间的关系, 在4个数据集上每个类别的训练样本个数分别为 15、10、10和10 |

|

图 9 识别准确率和降维维度之间的关系, 在4个数据集上每个类别的训练样本个数分别为15、10、10和40 |

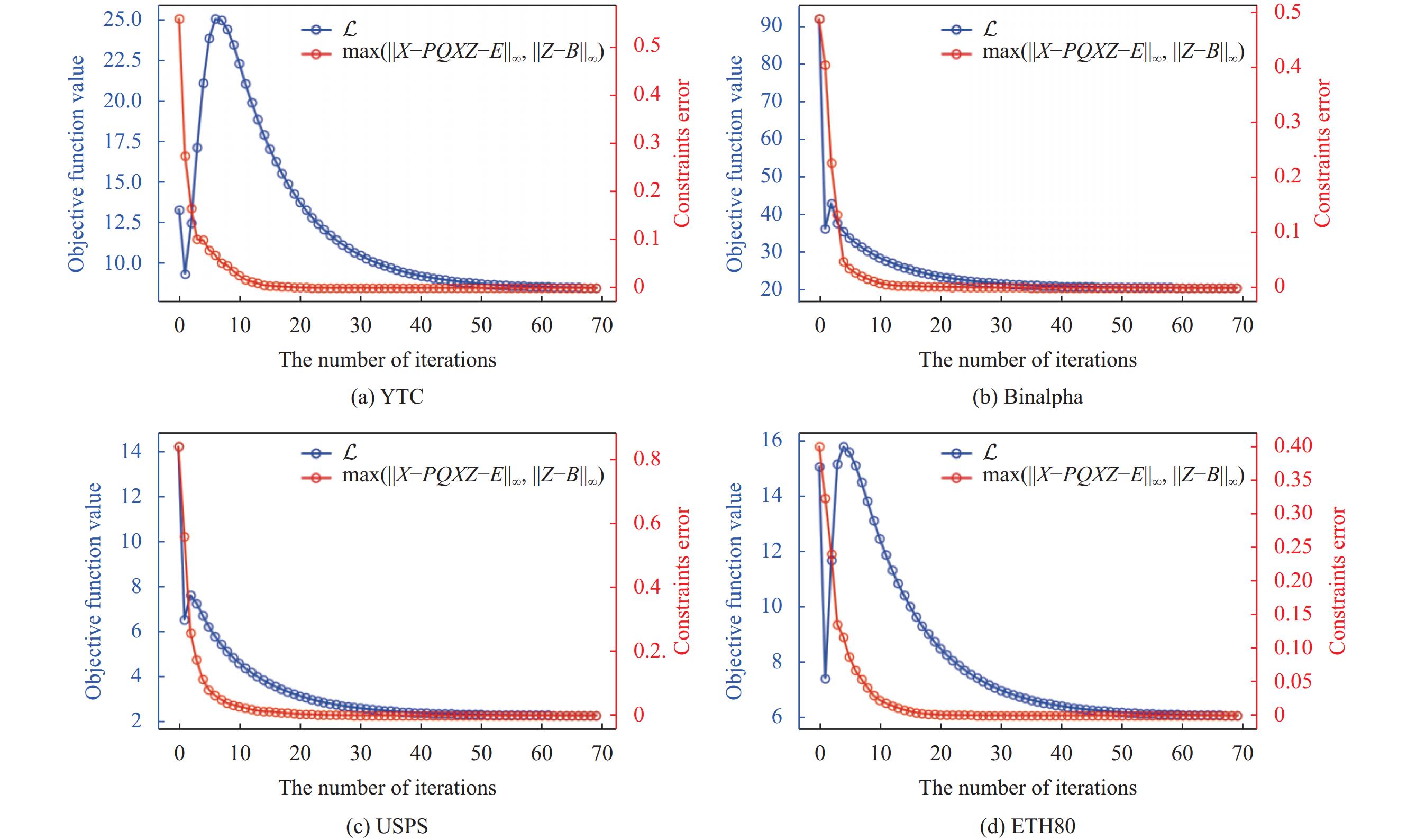

4.10 收敛性研究

在本节中, 我们从实验的角度展示了所提出方法的收敛性, 在 YTC、Binalpha、USPS 和 ETH80 这4个数据集上进行了实验. 图10 显示了模型在4个数据集的不同迭代次数下的目标函数值和约束误差. 从中可以观察到, 所提出的学习模型 (20) 的目标函数损失和约束误差稳步减小, 并最终趋于稳定. 这一观察结果表明我们设计的优化算法表现出了良好的收敛特性.

|

图 10 所提出方法的收敛曲线, 在4个数据集上每个类别的训练样本个数分别为 15、10、10和40 |

5 结论

本文提出了一种监督降维方法, 通过潜在稀疏表示学习增强了局部保持投影的性能. 本文将保持邻域结构和局部稀疏自表示集成到统一框架中, 解决了传统方法的局限性, 并丰富了数据的局部拓扑结构描述.

在稀疏自表示模块中, 本文使用重建样本作为字典, 并将其与投影学习相结合, 以有效捕获数据的主要成分、消除冗余特征和去除噪声. 通过高效的迭代算法和在多个公开可用数据集上的实验, 所提出的方法在降维方面表现出了出色的性能. 对于未来的工作, 我们计划设计一种不基于任何假设的图学习方法, 并进一步将其整合到我们的方法中, 以增强其在不同场景下的泛化能力.

| [1] |

Meenakshi, Srirangarajan S. Locality-aware discriminative subspace learning for image classification. IEEE Transactions on Instrumentation and Measurement, 2022, 71: 5015414. DOI:10.1109/TIM.2022.3187735 |

| [2] |

Zhao SP, Wu JG, Zhang B, et al. Adaptive graph embedded preserving projection learning for feature extraction and selection. IEEE Transactions on Systems, Man, and Cybernetics: Systems, 2023, 53(2): 1060-1073. DOI:10.1109/TSMC.2022.3193131 |

| [3] |

Zhang T, Long CF, Deng YJ, et al. Low-rank preserving embedding regression for robust image feature extraction. IET Computer Vision, 2024, 18(1): 124-140. DOI:10.1049/cvi2.12228 |

| [4] |

Lu XH, Long J, Wen J, et al. Locality preserving projection with symmetric graph embedding for unsupervised dimensionality reduction. Pattern Recognition, 2022, 131: 108844. DOI:10.1016/j.patcog.2022.108844 |

| [5] |

Wold S, Esbensen K, Geladi P. Principal component analysis. Chemometrics and Intelligent Laboratory Systems, 1987, 2(1–3): 37-52. DOI:10.1016/0169-7439(87)80084-9 |

| [6] |

Martinez AM, Kak AC. PCA versus LDA. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2001, 23(2): 228-233. DOI:10.1109/34.908974 |

| [7] |

Tenenbaum JB, Silva VD, Langford JC. A global geometric framework for nonlinear dimensionality reduction. Science, 2000, 290(5500): 2319-2323. DOI:10.1126/science.290.5500.2319 |

| [8] |

Roweis ST, Saul LK. Nonlinear dimensionality reduction by locally linear embedding. Science, 2000, 290(5500): 2323-2326. DOI:10.1126/science.290.5500.2323 |

| [9] |

Belkin M, Niyogi P. Laplacian eigenmaps and spectral techniques for embedding and clustering. Proceedings of the 14th International Conference on Neural Information Processing Systems: Natural and Synthetic. Vancouver: MIT Press, 2001. 585–591.

|

| [10] |

He XF, Niyogi P. Locality preserving projections. Proceedings of the 16th International Conference on Neural Information Processing Systems (NIPS). Whistler: MIT Press, 2003. 153–160.

|

| [11] |

Wen J, Han N, Fang XZ, et al. Low-rank preserving projection via graph regularized reconstruction. IEEE Transactions on Cybernetics, 2019, 49(4): 1279-1291. DOI:10.1109/TCYB.2018.2799862 |

| [12] |

Liu ZH, Lu Y, Lai ZH, et al. Robust sparse low-rank embedding for image dimension reduction. Applied Soft Computing, 2021, 113: 107907. DOI:10.1016/j.asoc.2021.107907 |

| [13] |

Wan MH, Yao Y, Zhan TM, et al. Supervised low-rank embedded regression (SLRER) for robust subspace learning. IEEE Transactions on Circuits and Systems for Video Technology, 2022, 32(4): 1917-1927. DOI:10.1109/TCSVT.2021.3090420 |

| [14] |

Jiang L, Fang XZ, Sun WJ, et al. Low-rank constraint based dual projections learning for dimensionality reduction. Signal Processing, 2023, 204: 108817. DOI:10.1016/j.sigpro.2022.108817 |

| [15] |

Lu JL, Wang HL, Zhou J, et al. Low-rank adaptive graph embedding for unsupervised feature extraction. Pattern Recognition, 2021, 113: 107758. DOI:10.1016/j.patcog.2020.107758 |

| [16] |

Hu LC, Zhang WS, Dai ZL. Joint sparse locality-aware regression for robust discriminative learning. IEEE Transactions on Cybernetics, 2022, 52(11): 12245-12258. DOI:10.1109/TCYB.2021.3080128 |

| [17] |

Hu LC, Dai ZL, Tian L, et al. Class-oriented self-learning graph embedding for image compact representation. IEEE Transactions on Circuits and Systems for Video Technology, 2023, 33(1): 74-87. DOI:10.1109/TCSVT.2022.3197746 |

| [18] |

Wen J, Zhong ZF, Zhang Z, et al. Adaptive locality preserving regression. IEEE Transactions on Circuits and Systems for Video Technology, 2020, 30(1): 75-88. DOI:10.1109/TCSVT.2018.2889727 |

| [19] |

Li XL, Wang Q, Nie FP, et al. Locality adaptive discriminant analysis framework. IEEE Transactions on Cybernetics, 2022, 52(8): 7291-7302. DOI:10.1109/TCYB.2021.3049684 |

| [20] |

Pang YW, Zhou B, Nie FP. Simultaneously learning neighborship and projection matrix for supervised dimensionality reduction. IEEE Transactions on Neural Networks and Learning Systems, 2019, 30(9): 2779-2793. DOI:10.1109/TNNLS.2018.2886317 |

| [21] |

Nie FP, Wang Z, Wang R, et al. Adaptive local linear discriminant analysis. ACM Transactions on Knowledge Discovery from Data, 2020, 14(1): 9. DOI:10.1145/3369870 |

| [22] |

He XF, Cai D, Yan SC, et al. Neighborhood preserving embedding. Proceedings of the 10th IEEE International Conference on Computer Vision, Vol. 1. Beijing: IEEE, 2005. 1208–1213. [doi: 10.1109/ICCV.2005.167]

|

| [23] |

Qiao LS, Chen SC, Tan XY. Sparsity preserving projections with applications to face recognition. Pattern Recognition, 2010, 43(1): 331-341. DOI:10.1016/j.patcog.2009.05.005 |

| [24] |

Zhang YP, Xiang M, Yang B. Low-rank preserving embedding. Pattern Recognition, 2017, 70: 112-125. DOI:10.1016/j.patcog.2017.05.003 |

| [25] |

Wong WK, Lai ZH, Wen JJ, et al. Low-rank embedding for robust image feature extraction. IEEE Transactions on Image Processing, 2017, 26(6): 2905-2917. DOI:10.1109/TIP.2017.2691543 |

| [26] |

Fang XZ, Han N, Wu JG, et al. Approximate low-rank projection learning for feature extraction. IEEE Transactions on Neural Networks and Learning Systems, 2018, 29(11): 5228-5241. DOI:10.1109/TNNLS.2018.2796133 |

| [27] |

Ren ZW, Sun QS, Wu B, et al. Learning latent low-rank and sparse embedding for robust image feature extraction. IEEE Transactions on Image Processing, 2020, 29: 2094-2107. DOI:10.1109/TIP.2019.2938859 |

| [28] |

Zhou JH, Zhang B, Zeng SN, et al. Joint discriminative latent subspace learning for image classification. IEEE Transactions on Circuits and Systems for Video Technology, 2022, 32(7): 4653-4666. DOI:10.1109/TCSVT.2021.3135316 |

| [29] |

Zhang XQ, Tan Z, Sun HJ, et al. Orthogonal low-rank projection learning for robust image feature extraction. IEEE Transactions on Multimedia, 2022, 24: 3882-3895. DOI:10.1109/TMM.2021.3109442 |

| [30] |

Hui KF, Shen XJ, Abhadiomhen SE, et al. Robust low-rank representation via residual projection for image classification. Knowledge-based Systems, 2022, 241: 108230. DOI:10.1016/j.knosys.2022.108230 |

| [31] |

Donoho DL, Elad M. Optimally sparse representation in general (nonorthogonal) dictionaries via ℓ1 minimization. Proceedings of the National Academy of Sciences of the United States of America, 2003, 100(5): 2197-2202. DOI:10.1073/pnas.0437847100 |

| [32] |

Donoho DL. For most large under determined systems of linear equations the minimal ℓ1-norm solution is also the sparsest solution. Communications on Pure and Applied Mathematics, 2006, 59(6): 797-829. DOI:10.1002/cpa.20132 |

| [33] |

Candes EJ, Tao T. Near-optimal signal recovery from random projections: Universal encoding strategies? IEEE Transactions on Information Theory, 2006, 52(12): 5406–5425. [doi: 10.1109/TIT.2006.885507]

|

| [34] |

Boyd S, Parikh N, Chu E, et al. Distributed optimization and statistical learning via the alternating direction method of multipliers. Foundations and Trends® in Machine Learning, 2011, 3(1): 1-112. DOI:10.1561/2200000016 |

| [35] |

Hong MY, Luo ZQ, Razaviyayn M. Convergence analysis of alternating direction method of multipliers for a family of nonconvex problems. SIAM Journal on Optimization, 2016, 26(1): 337-364. DOI:10.1137/140990309 |

| [36] |

Candès EJ, Li XD, Ma Y, et al. Robust principal component analysis? Journal of the ACM, 2011, 58(3): 11. [doi: 10.1145/1970392.1970395]

|

| [37] |

Zou H, Hastie T, Tibshirani R. Sparse principal component analysis. Journal of Computational and Graphical Statistics, 2006, 15(2): 265-286. DOI:10.1198/106186006X113430 |

| [38] |

Liu J, Ji SW, Ye JP. Multi-task feature learning via efficient ℓ2,1-norm minimization. Proceedings of the 25th Conference on Uncertainty in Artificial Intelligence. Montreal: AUAI Press, 2009. 339–348.

|

| [39] |

Georghiades AS, Belhumeur PN, Kriegman DJ. From few to many: Illumination cone models for face recognition under variable lighting and pose. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2001, 23(6): 643-660. DOI:10.1109/34.927464 |

| [40] |

Wolf L, Hassner T, Maoz I. Face recognition in unconstrained videos with matched background similarity. Proceedings of CVPR 2011. Colorado: IEEE, 2011. 529–534. [doi: 10.1109/CVPR.2011.5995566]

|

| [41] |

Hull JJ. A database for handwritten text recognition research. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1994, 16(5): 550-554. DOI:10.1109/34.291440 |

| [42] |

Hu LC, Xu JK, Tian L, et al. Self-centralized jointly sparse maximum margin criterion for robust dimensionality reduction. Knowledge-based Systems, 2020, 206: 106343. DOI:10.1016/j.knosys.2020.106343 |

| [43] |

Leibe B, Schiele B. Analyzing appearance and contour based methods for object categorization. Proceedings of the 2003 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Madison: IEEE, 2003. II–409. [doi: 10.1109/CVPR.2003.1211497]

|

| [44] |

He XF, Yan SC, Hu YX, et al. Face recognition using Laplacianfaces. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2005, 27(3): 328-340. DOI:10.1109/TPAMI.2005.55 |

| [45] |

Cai D, He XF, Zhou K, et al. Locality sensitive discriminant analysis. Proceedings of the 20th International Joint Conference on Artifical Intelligence. Hyderabad: Morgan Kaufmann Publishers Inc., 2007. 708–713.

|

| [46] |

Nie FP, Xiang SM, Liu Y, et al. Orthogonal vs. uncorrelated least squares discriminant analysis for feature extraction. Pattern Recognition Letters, 2012, 33(5): 485-491. DOI:10.1016/j.patrec.2011.11.028 |

| [47] |

Wang R, Nie FP, Hong RC, et al. Fast and orthogonal locality preserving projections for dimensionality reduction. IEEE Transactions on Image Processing, 2017, 26(10): 5019-5030. DOI:10.1109/TIP.2017.2726188 |

| [48] |

Wen J, Fang XZ, Cui JR, et al. Robust sparse linear discriminant analysis. IEEE Transactions on Circuits and Systems for Video Technology, 2019, 29(2): 390-403. DOI:10.1109/TCSVT.2018.2799214 |

| [49] |

Chen Z, Wu XJ, Cai YH, et al. Sparse non-negative transition subspace learning for image classification. Signal Processing, 2021, 183: 107988. DOI:10.1016/j.sigpro.2021.107988 |

2024, Vol. 33

2024, Vol. 33