行人重识别(person re-identification, ReID)[1]在智能安全监控系统中是一项至关重要的任务, 旨在将查询集中的单个行人图像与不同摄像机拍摄的图库集中的图像进行匹配. 传统的ReID方法侧重于匹配可见光摄像机拍摄的行人图像, 可以认定是一个在可见光场景下的单模态检索问题. 然而, 当行人出现在光线较差或黑暗的环境下时, 可见光摄像机通常无法提供准确的外观信息, 导致这种方法具有局限性. 为了克服这个限制, 监控系统引入了红外摄像机, 在夜间可以拍摄清晰的红外模态行人图像. 为了可以匹配可见光图像和红外图像中的同一行人, 可见光-红外的跨模态行人重识别(visible-infrared person re-identification, VI-ReID)[2]成为一个日益受关注的问题.

VI-ReID主要实现在黑暗环境下捕获的红外图像和光线较好情况下拍摄的可见光图像之间的行人匹配. 通过结合可见光模态和红外模态的图片数据, VI-ReID试图在极具挑战性的照明条件下提高行人匹配的准确性和稳健性. 但是在实际应用过程中, VI-ReID面临着很多挑战. 一方面, 和ReID一样, 由于待检索的图像都是不同的摄像机在不同时间地点下拍摄的, 导致图像出现背景噪声、遮挡、行人姿态变化、拍摄异常等问题. 另一方面, VI-ReID面临的最主要挑战是红外模态和可见光模态之间存在的模态差异.

为了缓解模态差异, 研究人员从不同方面提出了许多有效的解决方案, 这些方法主要可以分为基于表征学习、度量学习以及模态互换3类. 其中, 基于表征学习的方法主要研究如何设计合理的网络架构, 提取不同模态中具有鉴别性的特征, 以减少模态差异. Wu等人[3]首次提出深度零填充(zero-padding)的方法学习共享模态特征. 为了进一步增强特征表示的能力, Ye等人[4]提出了一种动态双注意聚合(dynamic dual-attentive aggregation, DDAG)学习方法来挖掘模态内部和跨模态图像之间的上下文线索. Wu等人[5]提出了一种联合模态和模式对齐网络(joint modality and pattern alignment network, MPANet)来发现跨模态之间的细微差别. Zhang等人[6]提出了一种多样化嵌入扩展网络(diverse embedding expansion network, DEEN), 可以有效地生成不同的嵌入来学习特征表示. 此外, 基于度量学习的方法旨在设计一个合理的度量方法或损失函数来学习图像的相似度. Jia等人[7]提出了一种相似性推理度量(similarity inference metric, SIM), 通过连续相似图推理和相互最近邻推理, 利用模态内样本相似性来挖掘跨模态样本之间的相似性. Liu等人[8]提出了一种记忆增强单向度量(memory-augmented unidirectional metric, MAUM)学习方法, 通过单向度量和基于记忆增强的两种设计实现跨模态关联. Miao等人[9]通过层次特征约束(hierarchical feature constraint, HFC)对全局特征和局部特征进行学习, 全局特征使用知识蒸馏策略对局部特征进行监督. 还有基于模态转换的方法主要通过生成对抗性网络(generative adversarial network, GAN)实现可见光图像和红外图像之间模态转换, 如alignGAN[10]、TS-GAN[11]、JSIA[12]、FMCNet[13]等, 它们在很大程度上减少了模态之间存在的差异.

尽管如此, 由于成像过程的异质性, 红外图像中的相同灰度在可见光图像中可能是完全不同的颜色, 不同模态的行人图像中彼此缺少对应的模态信息, 导致网络提取的特征缺失足够的鉴别性, 从而影响模型的性能. 为了充分融合红外模态和可见光模态的行人身份信息, 使得提取的特征具有足够的鉴别性, 促进模型实现行人匹配, 本文提出一种基于注意力特征融合的跨模态行人重识别方法. 首先以ResNet-50[14]构建双流结构的特征提取网络, 分别提取两种模态的特定特征和共享特征. 为了提高特征的鉴别性, 本文设计了一种注意力融合模块, 通过局部注意力模块和全局注意力模块将提取特征之间的模态信息进行融合. 此外, 由于不同模态的融合特征之间仍然存在模态差异, 为了进一步减少模态差异, 本文还引入了一种最大均值差异损失优化模型, 通过减少红外模态和可见光模态特征之间的分布差异以实现模态对齐. 本文主要贡献如下.

(1)提出一种注意力融合模块, 利用局部和全局注意力机制分别将特征中显著的身份信息提取出来, 并通过融合操作使得最终提取的特征具有充分的鉴别性.

(2)设计一种由最大均值差异损失、身份损失和中心聚类损失联合优化模型的方法, 减少可见光模态和红外模态中同一行人的分布差异, 促进模型更准确地进行行人匹配.

(3)本方法在SYSU-MM01和RegDB两个公开的跨模态数据集上进行了实验, 结果领先其他很多算法, 证实了有效性.

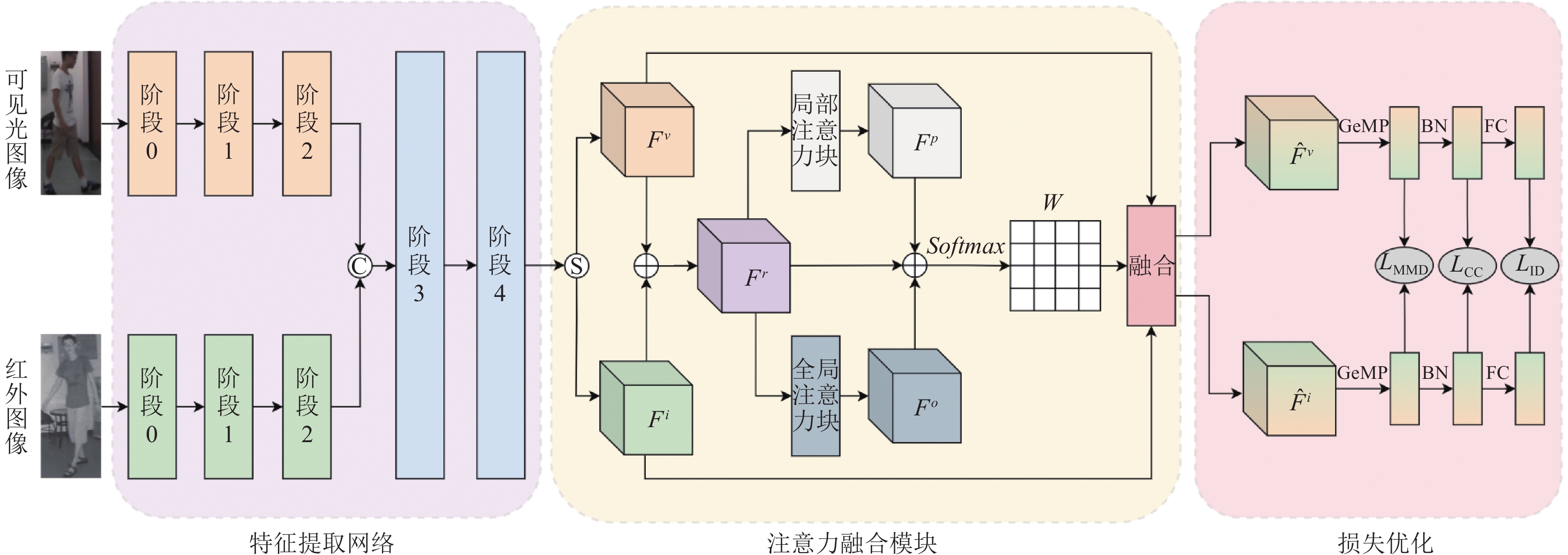

1 本文方法为了融合红外模态和可见光模态彼此相关的身份信息, 使得模型提取的特征更具有鉴别性, 本文提出一种基于注意力特征融合的跨模态行人重识别方法. 如图1所示, 本文提出的方法由特征提取网络、注意力融合模块和损失优化3个部分组成. 首先, 将可见光图像和红外图像分别输入到特征提取网络的两个分支中, 通过特征提取网络对图像中的行人进行特征提取. 其次, 从特征提取网络获取的可见光特征和红外特征分别输入到注意力融合模块中, 通过局部注意力和全局注意力将特征中显著的行人信息进行提取, 并通过融合操作将信息进行融合, 最终可以得到更具有鉴别性的特征用于行人匹配. 最后, 为了缓解模态差异, 本文利用最大均值差异和中心聚类损失联合优化模型. 接下来对本方法中的各个部分做详细介绍.

|

图 1 基于注意力特征融合的跨模态行人重识别方法框架 |

1.1 特征提取网络

本文利用ResNet-50为基础构建双流结构的特征提取网络, 网络共分为5个阶段, 每个阶段的结构和ResNet-50每个阶段的结构相同. 其中, 前3个阶段设置成参数不共享的两个分支, 分别用来提取可见光图像和红外图像的特定模态特征. 其余两个阶段设置成共享模态阶段, 主要是将两个特定模态的特征沿批次维度进行拼接形成一个整体特征, 得到的整体特征通过参数共享的阶段3和阶段4进一步提取共享模态特征, 然后得到特征提取网络最终的输出结果.

1.2 注意力融合模块首先, 将特征提取网络最终的输出结果按批次维度重新拆分成可见光特征

| Fr=Fv⊕Fi | (1) |

其中,

为了保持模型轻量化, 本文利用局部注意力机制和全局注意力机制通过改变空间池化的大小, 在不同尺度上实现通道注意, 从而提取初步融合特征

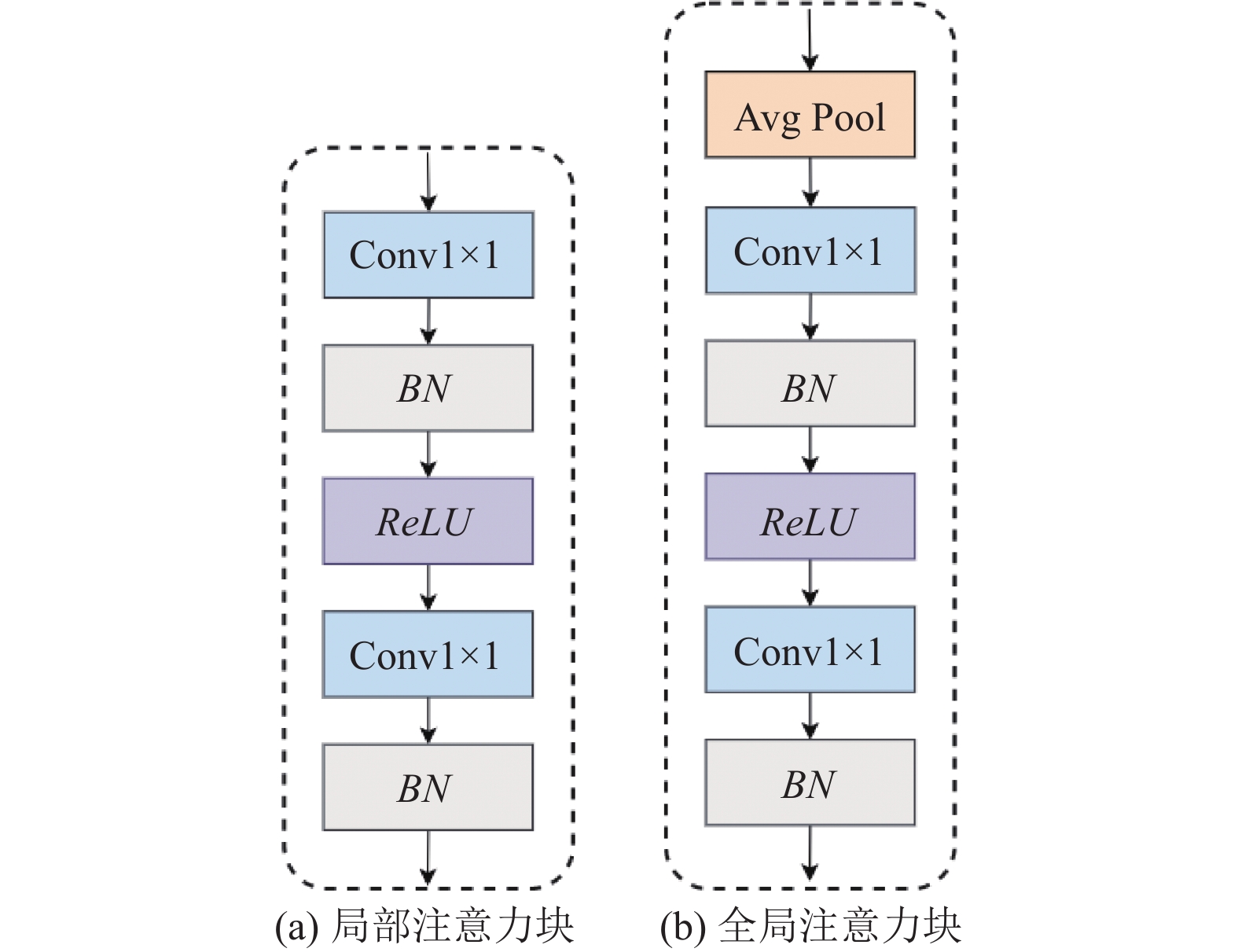

如图2(a)所示, 局部注意力块主要由两个点卷积层, 两个批归一化层(batch normalization, BN)和一个ReLU层组成. 局部注意力块作为局部通道上下文聚合器, 只对初步融合特征

| Fp=BN(Conv1×1(ReLU(BN(Conv1×1(Fr))))) | (2) |

其中,

|

图 2 局部注意力块和全局注意力块的结构图 |

如图2(b)所示, 全局注意力块主要由一个平均池化层、两个点卷积层、两个批归一化层和一个ReLU层组成. 全局注意力块主要聚合初步融合特征

| Fo=Avg(BN(Conv1×1(ReLU(BN(Conv1×1(Fr)))))) | (3) |

其中,

接下来将初步融合特征

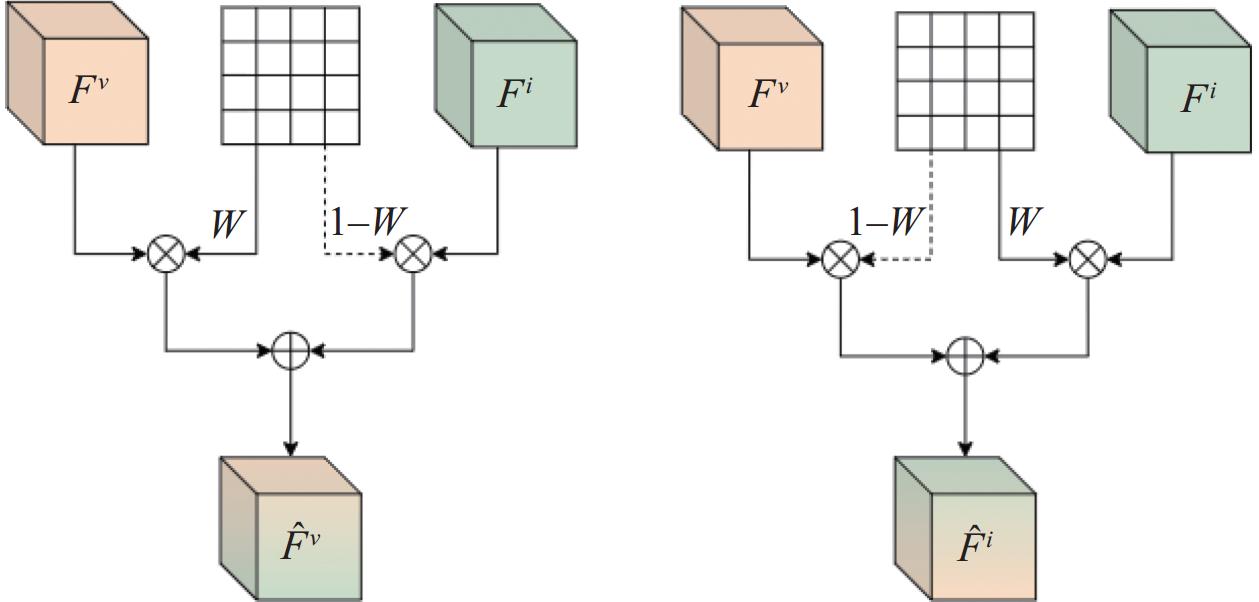

|

图 3 注意力融合模块中融合的具体过程 |

在融合过程中, 以可见光特征

| ˆFv=(Fv⊗W)⊕(Fi⊗(1−W)) | (4) |

其中,

| ˆFi=(Fi⊗W)⊕(Fv⊗(1−W)) | (5) |

本文使用最大均值差异损失

| LMMD=1PP∑q=1(MMD2(G(ˆFvq),G(ˆFiq))) | (6) |

其中, P为每批处理中的身份数,

| MMD2(F1,F2)=‖1KvKv∑kv=1ϕ(F1kv)−1KiKi∑ki=1ϕ(F2ki)‖2=1(Kv)2Kv∑kv=1Kv∑kv′=1ϕ(F1kv)⊤ϕ(F1kv′)+1(Ki)2Ki∑ki=1Ki∑ki′=1ϕ(F2ki)⊤ϕ(F2ki′)−2KvKiKv∑kv=1Ki∑ki=1ϕ(F1kv)⊤ϕ(F2ki) | (7) |

其中,

身份损失

| LID=−1PP∑q=1yqlog(cq) | (8) |

其中, P为每批次中的行人身份数,

中心聚类损失

| LCC=1NN∑a=1D(fa,hya)+2P(P−1)P−1∑k=1P∑b=k+1[ρ−D(hyk,hyb)]+ | (9) |

其中, N为当前批次中可见光图片和红外图片的数量,

最后, 本方法的总损失函数L可以表示为:

| L=αLMMD+βLID+γLCC | (10) |

其中,

本文接下来进行的实验均在目前主流的跨模态行人重识别数据集SYSU-MM01[3]和RegDB[15]上进行, 这两个数据集的详情如表1所示. 此外, 本文的所有实验的评价指标均为累积匹配特征曲线(cumulative matching characteristics curve, CMC)和平均检索精度(mean average precision, mAP).

| 表 1 跨模态行人重识别常用数据集对比 |

2.2 实验设置

本方法实验基于PyTorch实现, 硬件配置环境为NVIDIA GeForce RTX 3090 显卡、内存24 GB和CPU为i5. 在数据预处理阶段, 将所有图像的大小调整为288×144, 并使用各种增强策略对图像进行处理, 包括随机水平翻转、随机擦除、随机裁剪、随机旋转和随机通道增强. 在训练阶段, 随机抽取6个身份的行人, 每个训练批次分别选择4张可见光图像和4张红外图像. 本方法使用SGD优化器进行了100次迭代, 初始学习率设置为0.01. 在前16次迭代过程中采用线性的预热策略(warm-up), 然后在第20次和第30次逐渐衰减5倍, 在第45次和第60次逐渐衰减10倍. 此外, 总损失函数的平衡参数

本文在SYSU-MM01和RegDB两个主流的跨模态行人重数据集上和现有的一些方法进行了对比实验. 结果表明本文的方法具有优秀的性能, 超过了大多数现有的方法.

● 在SYSU-MM01数据集上的对比实验: 如表2所示, 其中, 加粗为最优结果, 下划线为次优结果, 本方法的性能优于所有对比的方法. 在All-Search模式下, 本方法达到了72.74%的Rank-1和67.83%的mAP, 分别超过CMIT的1.8%和2.32%. 此外, 在Indoor-Search模式下, 本方法实现了76.50%的Rank-1和79.44%的mAP. 总的来说, 实验结果证明了本方法的有效性.

| 表 2 在SYSU-MM01数据集上的对比实验 (%) |

● 在RegDB数据集上的对比实验: 如表3所示, 其中, 加粗为最优结果,下划线为次优结果.

| 表 3 在RegDB数据集上的对比实验 (%) |

由表3可见, 本方法的性能超过了大多数对比方法的性能. 其中, 在Visible to Infrared模式下, 本方法达到了89.97%的Rank-1和83.56%的mAP, 不过相较于性能最好的对比方法DFLN-ViT在Rank-1指标上低了2.13%. 此外, 在Infrared to Visible模式下, 本方法实现了88.75%的Rank-1和84.29%的mAP, 同样比DFLN-ViT在Rank-1上低了2.46%. 由于本文的骨干网络使用的是ResNet-50, 而DFLN-ViT方法的骨干网络使用的是ViT, ResNet-50相较于ViT, 捕捉样本内不同位置和通道之间相关性的能力不足, 导致模型提取的行人特征信息有所欠缺. 此外, DFLN-ViT对骨干网络每层中不同粒度的特征信息进行编码融合, 并且在每个通道上细化表示, 有助于从全局角度建模通道之间的长期依赖性. 而本文方法只对单一粒度的特征进行局部和全局的注意力融合, 缺少多粒度的身份信息. 不过总的来说, 实验结果超过了大多数的方法, 本方法依旧具有一定的竞争力.

2.4 消融实验为了验证本方法中每个部分对模型性能的贡献度, 本文在SYSU-MM01数据集上进行了消融实验, 实验结果如表4所示. 其中B表示由特征提取网络、身份损失

| 表 4 在SYSU-MM01数据集上的消融实验 (%) |

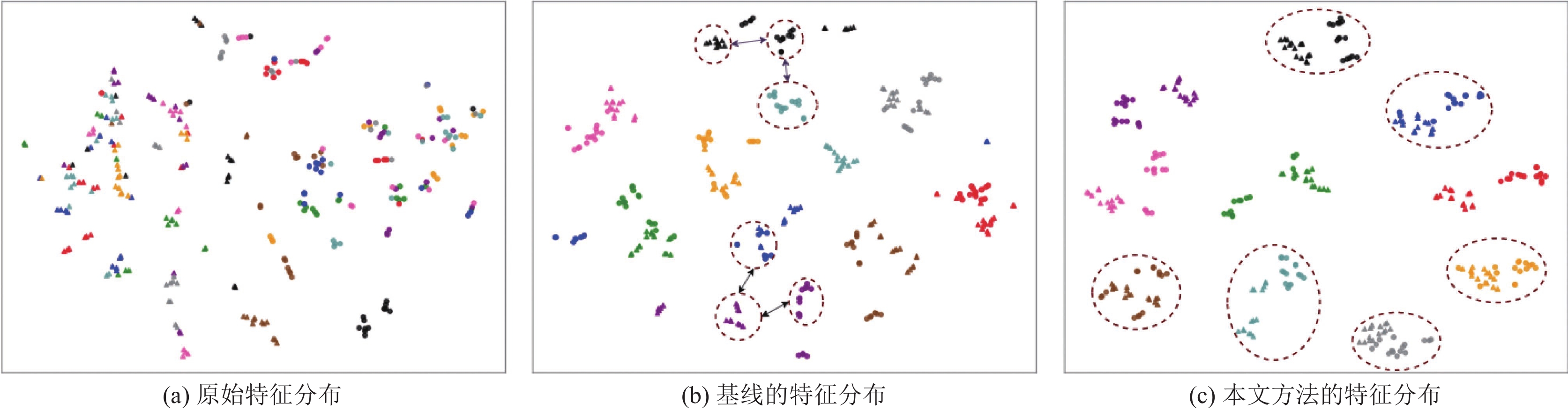

2.5 特征分布可视化

为了进一步分析本文所提出方法提取特征的分布情况, 从SYSU-MM01的测试集中随机抽取10个身份行人的图像利用t-SNE进行可视化实验. 对于每个身份, 随机选择15张可见光图像和15张红外图像. 从图4可以看出, 原始的特征分布杂乱无章. 在经过基线的作用下, 相同身份的红外特征和可见光特征逐渐靠近, 但是相同身份的特征和不同身份的特征之间的距离过于相似, 难以分辨模态距离. 在图4(c)中, 通过注意力融合和多种损失的共同优化下, 模型提取的特征分布形成了多个明显的簇团, 表明了相同身份行人之间的距离得到减小, 不同身份行人之间的距离得到扩大, 使得模型可以促进行人匹配.

|

图 4 特征分布的可视化结果 |

3 结论与展望

针对现有跨模态行人重识别方法存在的特征缺失模态信息的问题, 本文提出了一种基于注意力特征融合的跨模态行人重识别方法. 首先, 构建基于ResNet-50的双流特征提取网络, 分别提取可见光图像和红外图像中行人的特定模态特征和共享模态特征. 然后, 设计一种注意力融合模块, 将特征提取网络提取出来的特征分割成红外特征和可见光特征并输入其中, 对两者彼此缺失的模态信息进行补偿, 使得最终的特征具有充分的鉴别性. 最后, 利用最大均值差异损失、身份损失和中心聚类损失对模型进行优化. 本文通过特征提取网络、注意力融合模块和多种损失的作用下, 提高了模型匹配行人的准确度.

| [1] |

王琦, 刘志刚, 王淼, 等. 姿态驱动的局部特征对齐的行人重识别. 计算机系统应用, 2023, 32(4): 268-273. DOI:10.15888/j.cnki.csa.009035 |

| [2] |

陈丹, 李永忠, 于沛泽, 等. 跨模态行人重识别研究与展望. 计算机系统应用, 2020, 29(10): 20-28. DOI:10.15888/j.cnki.csa.007621 |

| [3] |

Wu AC, Zheng WS, Yu HX, et al. RGB-infrared cross-modality person re-identification. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 5390–5399.

|

| [4] |

Ye M, Shen JB, Crandall DJ, et al. Dynamic dual-attentive aggregation learning for visible-infrared person re-identification. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 229–247.

|

| [5] |

Wu Q, Dai PY, Chen J, et al. Discover cross-modality nuances for visible-infrared person re-identification. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 4328–4337.

|

| [6] |

Zhang YK, Wang HZ. Diverse embedding expansion network and low-light cross-modality benchmark for visible-infrared person re-identification. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE, 2023. 2153–2162.

|

| [7] |

Jia MX, Zhai YP, Lu SJ, et al. A similarity inference metric for RGB-infrared cross-modality person re-identification. Proceedings of the 29th International Joint Conference on Artificial Intelligence. Yokohama: IJCAI, 2020. 1026–1032.

|

| [8] |

Liu JL, Sun YF, Zhu F, et al. Learning memory-augmented unidirectional metrics for cross-modality person re-identification. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022. 19344–19353.

|

| [9] |

Miao YQ, Huang NC, Ma X, et al. On exploring pose estimation as an auxiliary learning task for visible-infrared person re-identification. Neurocomputing, 2023, 556: 126652. DOI:10.1016/j.neucom.2023.126652 |

| [10] |

Wang GA, Zhang TZ, Cheng J, et al. RGB-infrared cross-modality person re-identification via joint pixel and feature alignment. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 3622–3631.

|

| [11] |

Zhang ZY, Jiang S, Huang CZT, et al. RGB-IR cross-modality person ReID based on teacher-student GAN model. Pattern Recognition Letters, 2021, 150: 155-161. DOI:10.1016/j.patrec.2021.07.006 |

| [12] |

Wang GA, Zhang TZ, Yang Y, et al. Cross-modality paired-images generation for RGB-infrared person re-identification. Proceedings of the 34th AAAI Conference on Artificial Intelligence. New York: AAAI, 2020. 12144–12151.

|

| [13] |

Zhang Q, Lai CZ, Liu JN, et al. FMCNet: Feature-level modality compensation for visible-infrared person re-identification. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022. 7339–7348.

|

| [14] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 770–778.

|

| [15] |

Nguyen DT, Hong HG, Kim KW, et al. Person recognition system based on a combination of body images from visible light and thermal cameras. Sensors, 2017, 17(3): 605. DOI:10.3390/s17030605 |

| [16] |

Ye M, Shen JB, Lin GJ, et al. Deep learning for person re-identification: A survey and outlook. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 44(6): 2872-2893. DOI:10.1109/TPAMI.2021.3054775 |

| [17] |

Zhao JQ, Wang HZ, Zhou Y, et al. Spatial-channel enhanced Transformer for visible-infrared person re-identification. IEEE Transactions on Multimedia, 2023, 25: 3668-3680. DOI:10.1109/TMM.2022.3163847 |

| [18] |

Feng YJ, Yu J, Chen F, et al. Visible-infrared person re-identification via cross-modality interaction Transformer. IEEE Transactions on Multimedia, 2023, 25: 7647-7659. DOI:10.1109/TMM.2022.3224663 |

| [19] |

Yu H, Cheng X, Peng W. TOPLight: Lightweight neural networks with task-oriented pretraining for visible-infrared recognition. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE, 2023. 3541–3550

|

| [20] |

Lu H, Zou XZ, Zhang PP. Learning progressive modality-shared Transformer s for effective visible-infrared person re-identification. Proceedings of the 37th AAAI Conference on Artificial Intelligence. Washington: AAAI, 2023. 1835–1843.

|

| [21] |

Shi HC, Luo MD, Zhang XY, et al. Learning cross-modality information bottleneck representation for heterogeneous person re-identification. arXiv:2308.15063, 2023.

|

| [22] |

Wei ZY, Yang X, Wang NN, et al. Syncretic modality collaborative learning for visible infrared person re-identification. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 225–234.

|

| [23] |

Chen CQ, Ye M, Qi MB, et al. Structure-aware positional Transformer for visible-infrared person re-identification. IEEE Transactions on Image Processing, 2022, 31: 2352-2364. DOI:10.1109/TIP.2022.3141868 |

2024, Vol. 33

2024, Vol. 33