高分辨率遥感图像包含丰富的道路网络信息, 从中高效、准确地提取道路信息对城市规划建设[1]、公共交通管理[2]和灾害监测[3]等具有重要作用. 遥感图像中道路具有结构复杂、跨度大和狭窄曲折等特性且易受到建筑阴影、林木和铁路等背景信息的干扰[4], 因此, 从高分遥感图像中准确高效地提取道路信息仍是一项极具挑战的任务[5].

传统道路提取如基于形态学、基于手工特征等方法可有效获取道路形状特征, 在遥感影像道路提取领域取得了一定的成果, 但这些算法提取过程繁杂, 自动化程度较低[6], 当前, 以卷积神经网络为代表的深度学习算法因其良好的性能和泛化能力而广泛应用于遥感影像智能化处理研究中[7]. Ronneberger等[8]提出的U-Net通过对称的上采样-下采样结构, 在准确度与处理速度之间取得了平衡, LinkNet[9]和D-LinkNet[10]选用残差网络作为编码器主干网络以提高感受野, 并将中间特征拼接部分替换成跳跃连接结构以减少参数量, 后者加入并行级联的空洞卷积模块, 使模型在保留中心特征信息的同时最大化感受野. 但遥感影像中存在植被、建筑物阴影遮挡现象时, 以卷积为主的类U-Net模型易出现道路提取结果连续性差及细小道路缺失现象, 其原因如下: (1)受卷积神经网络归纳偏置影响, 类U-Net模型在提取局部有效信息时相对高效, 但缺乏对通道维度之间关系的显式建模[11], 提取全局信息时表现较差, 导致提取结果存在断裂问题. (2)跳跃连接结构中采用逐元素相加或拼接操作时易造成冗余信息堆叠和关键信息丢失等问题, 编码器中不同深度的特征层具有不同性质特征信息, 浅层特征包含更多空间位置信息, 便于捕获道路的细微边界, 深层特征则富含语义信息[12], 而跳跃连接结构使特征传递局限于相同层级间, 导致部分空间关联性信息损失, 提取复杂道路网络时易出现误提和漏提现象.

针对CNN归纳偏置影响, 可通过将卷积神经网络与注意力机制结合以增强全局特征信息提取能力, 张亚宁等[13]将残差网络与CBAM注意力模块[14]结合使用, 促进上下文信息融合, 提高全局语义特征提取能力; NL-LinkNet[15]将Non-Local注意力[16]模块与残差网络组合构成编码器主体网络以捕获长程依赖关系, 张立恒等[17]引入双注意力机制以捕获道路信息的全局特征依赖. 针对跳跃连接无法充分利用空间位置信息的问题, 陈国军等[18]通过在跳跃连接处加入特征融合模块, 提高模型全局特征提取能力. 陈果等[19]通过特征金字塔模块将多尺度下跳跃连接特征进行聚合, 为解码器提供更有效的特征信息.

结合以上问题, 本文提出一种基于多尺度差异聚合机制的道路提取方法MSDANet (multi-scale difference aggregation network), 主要工作如下.

(1)以多尺度残差网络Res2Net[20]作为编码器主体网络, 提取细粒度特征信息, 提高网络分割性能. (2)结合道路形态特性, 提出一种门控轴向引导模块, 引导模型专注于提取横向或纵向道路特征信息. (3)提出一种多尺度差异聚合模块, 用以减少跳跃连接结构在特征传递时的空间信息损失. (4)提出一种特征融合模块, 融合差异聚合模块输出与解码特征, 提升道路提取准确性.

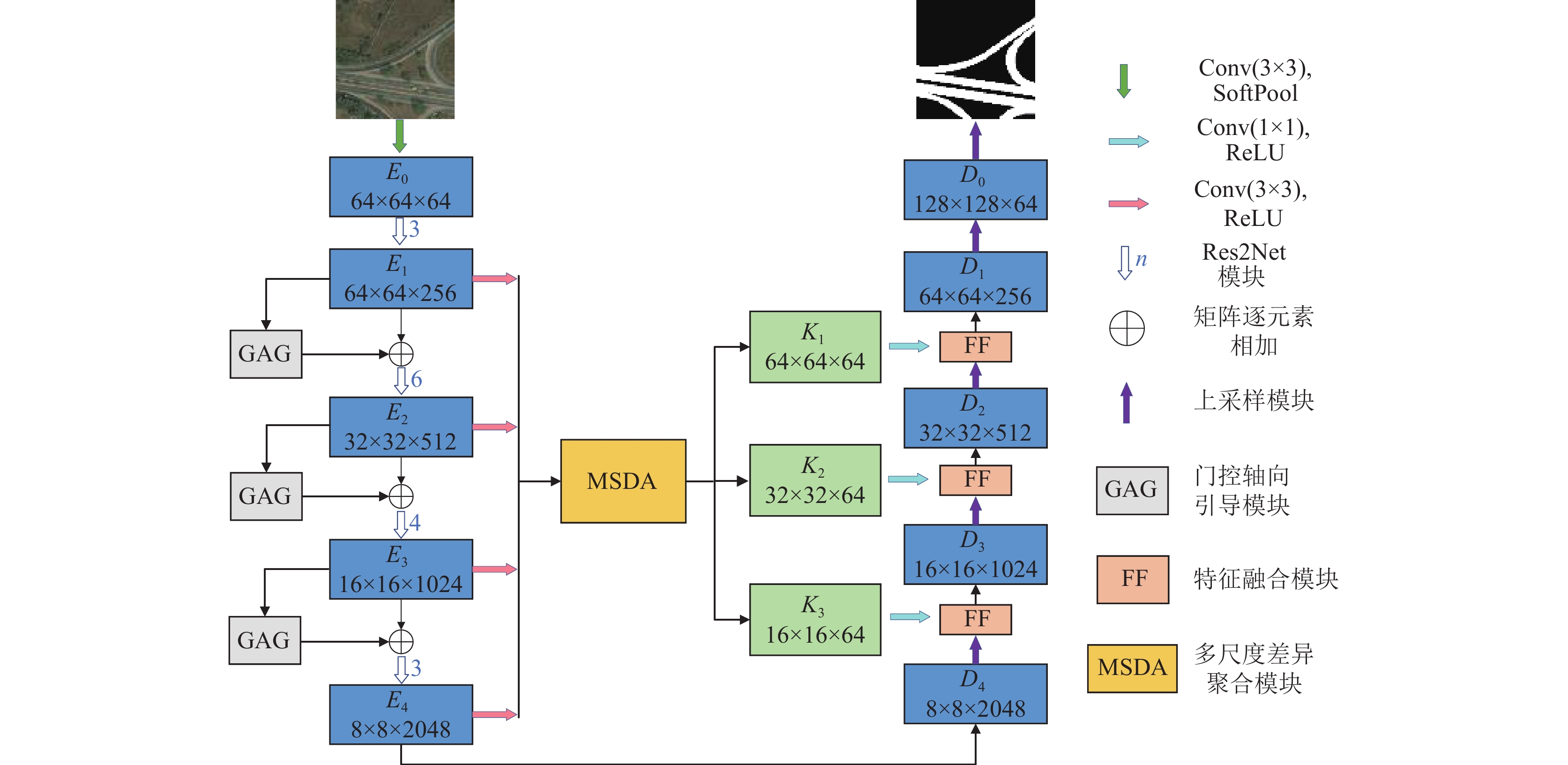

1 网络结构本文方法整体结构如图1所示, MSDANet网络模型以LinkNet为基础, 主要由编码器、门控轴向引导(gated axial guidance, GAG)模块、多尺度差异聚合(multi-scale difference aggregation, MSDA)模块、特征融合(feature fusion, FF)模块和解码器构成. 遥感图像输入后不同于传统7×7卷积层和最大池化层, 本文采用3个3×3卷积和SoftPool[21]下采样层进行特征粗提取, 增加感受野的同时减少下采样过程中的信息损失. 特征输入Res2Net模块编码模块, 得到4个尺度下的细粒度编码特征

编码器模块通常用于提取道路细节特征信息和语义信息, 多数以残差神经网络ResNet作为编码骨干网络的模型特征表达能力不足, 为实现更高效的特征提取, 本文采用多尺度深度残差网络Res2Net作为编码骨干网络, 增加网络层的感受野, 提取更细粒度道路特征.

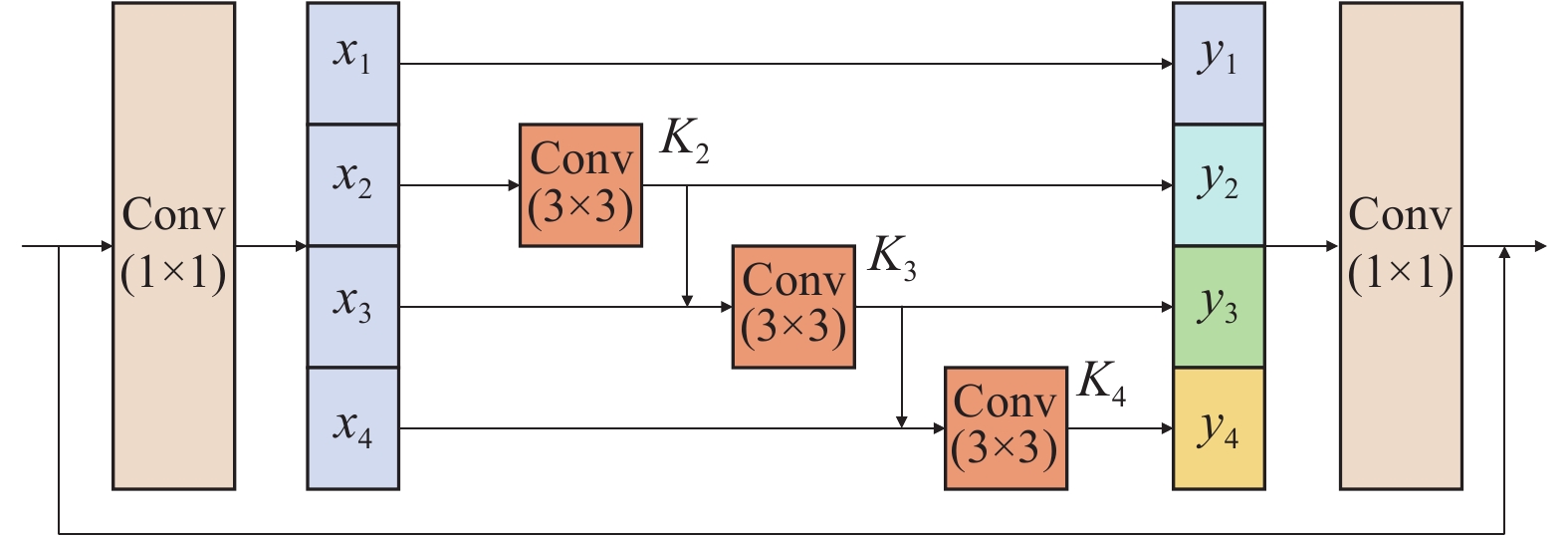

如图2所示输入特征图经过1×1卷积降维后, 将通道平均拆分成

| yi={xi,i=1Ki(xi),i=2Ki(xi+yi−1),3⩽i⩽s | (1) |

|

图 1 MSDANet 网络整体结构 |

|

图 2 Res2Net模块 |

所有中间特征

Res2Net沿用了残差网络的恒等映射结构用以缓解网络模型在深度增加时伴随出现的退化问题, 并对中间特征采取先分组, 后分布递进提取的方式, 获取不同信息融合度的子集特征, 最后将其合并, 这种策略有效地控制了计算开销, 并通过不同尺度的上下文信息减少局部信息不足造成的歧义, 提高整体网络模型多尺度表达能力.

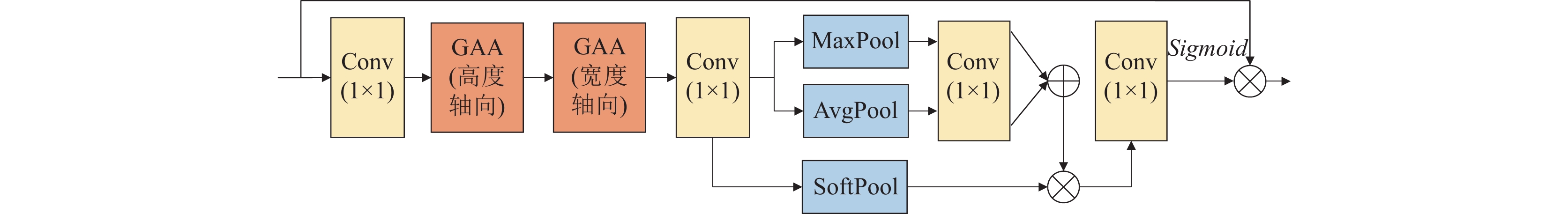

1.2 门控轴向引导模块Res2Net模块在空间维度上提取特征信息时, 因卷积神经网络归纳偏置影响, 全局特征提取能力不足, 同时缺少对通道维度相关性的显式建模, 进而限制编码器特征提取能力, 因此本文提出了门控轴向引导模块, 其结构如图3所示, 分为轴向特征提取和轴向权重嵌入两部分, 结合图1结构图可知, 该模块以不同尺度下的编码特征

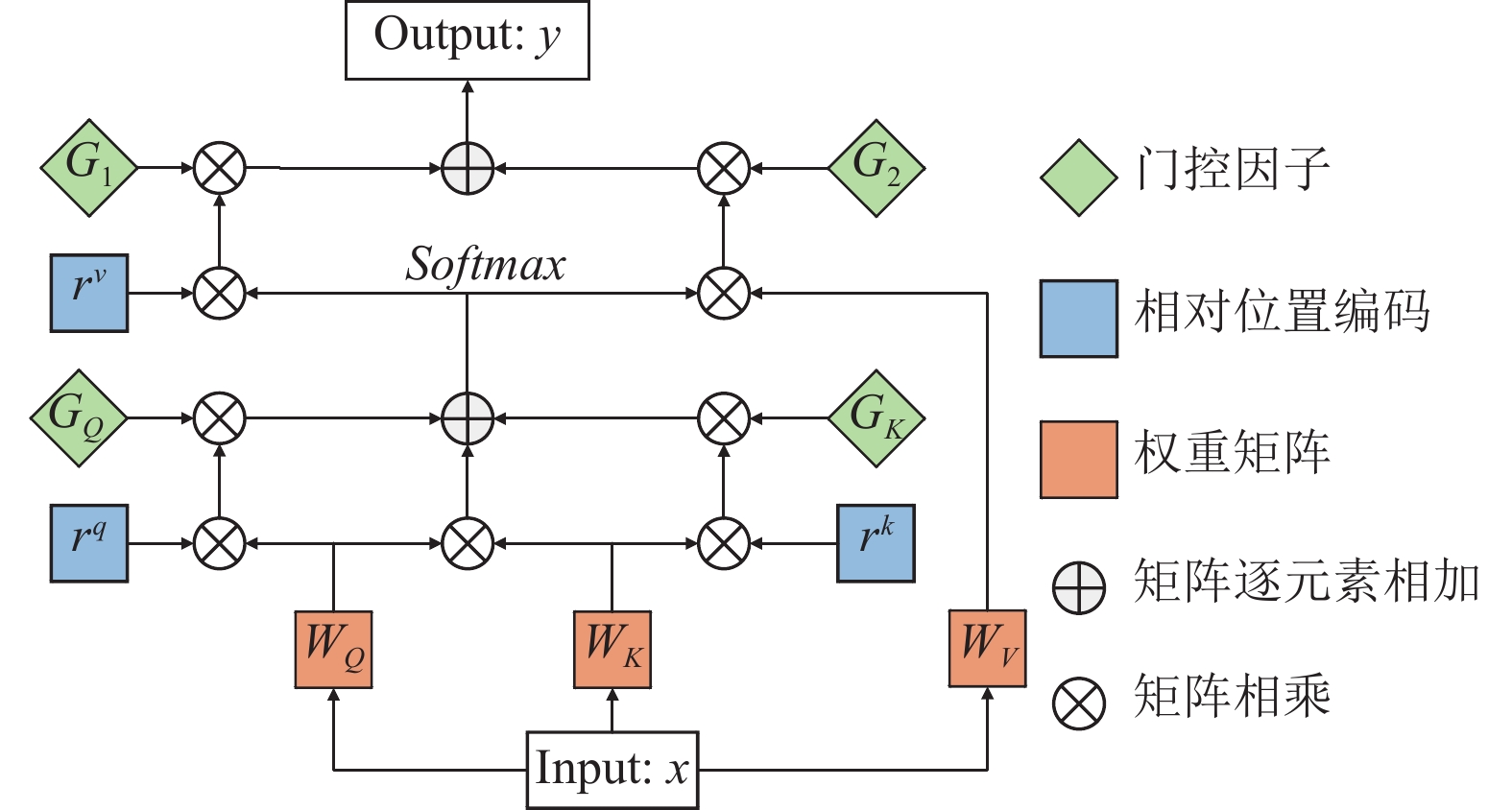

轴向特征提取部分通过头尾1×1卷积层控制中间特征图维度, 减少模型参数和计算开销, 通过高宽轴向门控注意力, 计算特征图中两个特定位置间相似关联性并分配相应关注度, 其中, 门控轴向注意力机制为自注意力机制[23]变体, 具体结构如图4所示, 可解构为两部分即门控机制和轴向注意力, 以沿宽度轴方向为例门控轴向注意力机制, 计算过程如式(2):

| FGij=W∑w=1Softmax(qTijkiw+GQqTijrqiw+GkkTiwrkiw)(G1rviw+G2viw) | (2) |

|

图 3 门控轴向引导模块 |

|

图 4 门控轴向注意力 |

给定输入特征图为

轴向权重嵌入部分将

| FGMA=σ(C1(MaxPool(FG)))+σ(C1(AvgPool(FG))) | (3) |

| FGS=σ(SoftPool(FG)) | (4) |

其中,

| Ti=δ(C1(FGP⊗FGMA))⊗Ei | (5) |

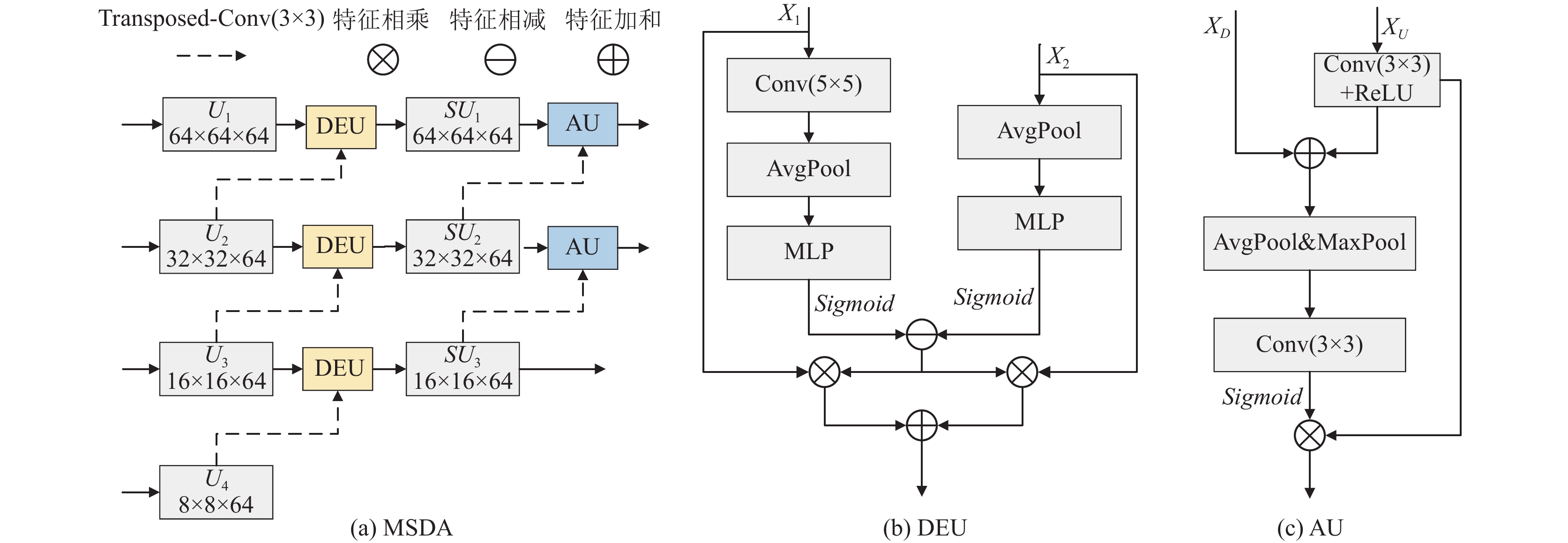

当前以编码-解码结构为基础的语义分割模型, 多采用单一的跳跃连接/拼接操作来传递编码特征, 其过程中忽略了不同尺度下中间特征间的差异性信息, 本文提出一种多尺度差异聚合模块, 通过若干个差异聚合单元在多个尺度下进行差异信息提取, 将深层丰富感受野嵌入到浅层特征中, 同时保留一部分浅层特征的道路信息, 实现浅层次单一特征向深层次多元特征转化, 以此输出不同差异融合度的特征, 具体结构如图5(a)所示.

|

图 5 多尺度差异聚合模块 |

结合图1可知编码特征

| {X′1=δ(W12σ(W11(AvgPool(C5(X1)))))X′2=δ(W22σ(W21(AvgPool(X2)))) | (6) |

其中,

| P=|(X′1⊖X′2)| | (7) |

| SU1=σ(C3(X1⊗P+X2⊗P)) | (8) |

其中,

| {XF=σ(C3(XU)))+XDX′F=c(MaxPool(XF),AvgPool(XF)) | (9) |

| K=Sigmoid(C3(X′F))⊗σ(C3(XU))) | (10) |

其中,

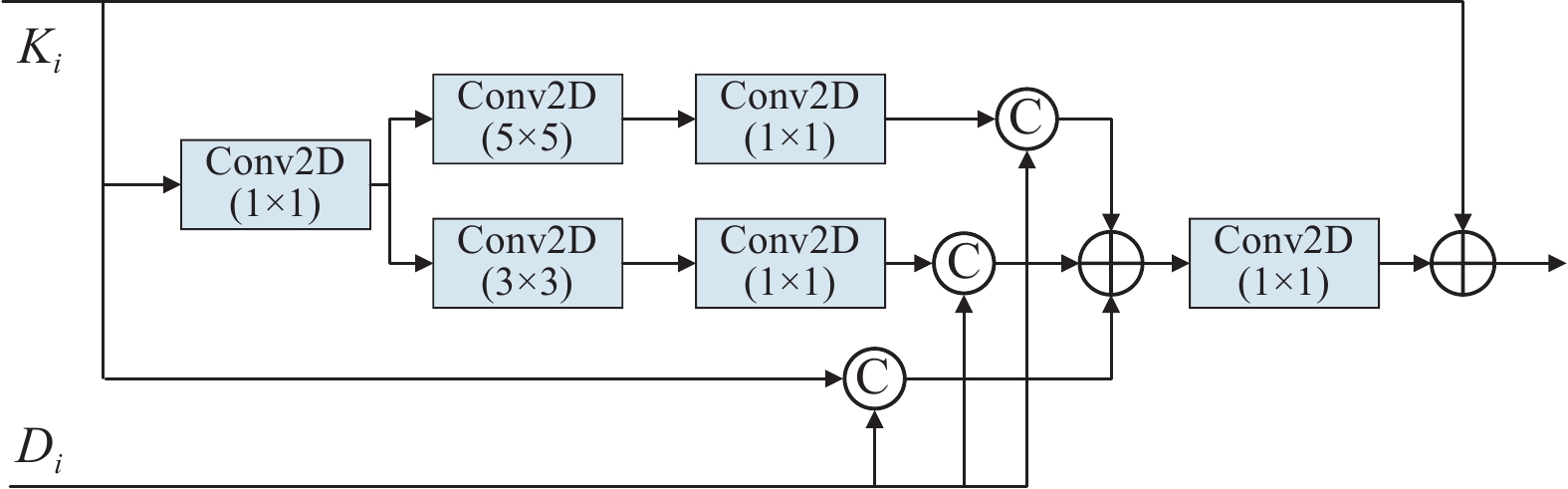

解码特征通常与中间传递特征直接加和或拼接, 此类融合方式忽略了二者间感受野的差异, 使解码过程中特征重建恢复程度有限, 易导致浅层解码器难以优化, 为促进解码器准确还原道路细节, 本文提出一种特征融合模块, 用于融合解码特征

如图6所示, 通过不同尺度卷积层分支, 提高互补增强特征

| M′i=c(Ki,Di)+c(S(C3(Ki)),Di)+c(S(C5(Ki)),Di) | (11) |

| D′i=C1(M′i)+Ki | (12) |

其中,

|

图 6 特征融合模块 |

2 实验设置与评价指标 2.1 实验数据集

为综合评估MSDANet的有效性, 本文在公开数据集DeepGlobe[25]和CHN6-CUG[26]上进行模型性能评估.

DeepGlobe公开道路数据集是2018年道路提取挑战赛提出的一组高分辨率遥感图像, 每张影像尺寸为1024×1024像素, 其地面分辨率为0.5 m/像素, 标签为二值化图像, 其道路像素值为1, 背景像素值为0. DeepGlobe数据集包含

CHN6-CUG公开道路数据集是中国首套城市大尺度卫星遥感影像道路数据集, 包含

本文实验环境为Ubuntu操作系统, GPU为24 GB显存的NVIDIA GeForce RTX 3090, 采用PyTorch作为深度学习训练框架. 训练过程中, DeepGlobe数据集的初始学习率设置为0.001, 批处理大小为32, CHN6-CUG数据集初始学习率设置为

实验指标准确率(Precision)、召回率(Recall)、F1值和交并比(IoU)可有效对模型性能进行评估. 本文选用准确率、F1值和IoU作为主要评价指标. F1值表示准确率和召回率的调和均值; IoU表示预测值和真实值两个集合的交集与并集之比. TP表示正确预测为道路的像素, FP表示将背景错误预测为道路的像素, TN表示正确预测为背景的像素, FN表示将道路错误预测为背景的像素.

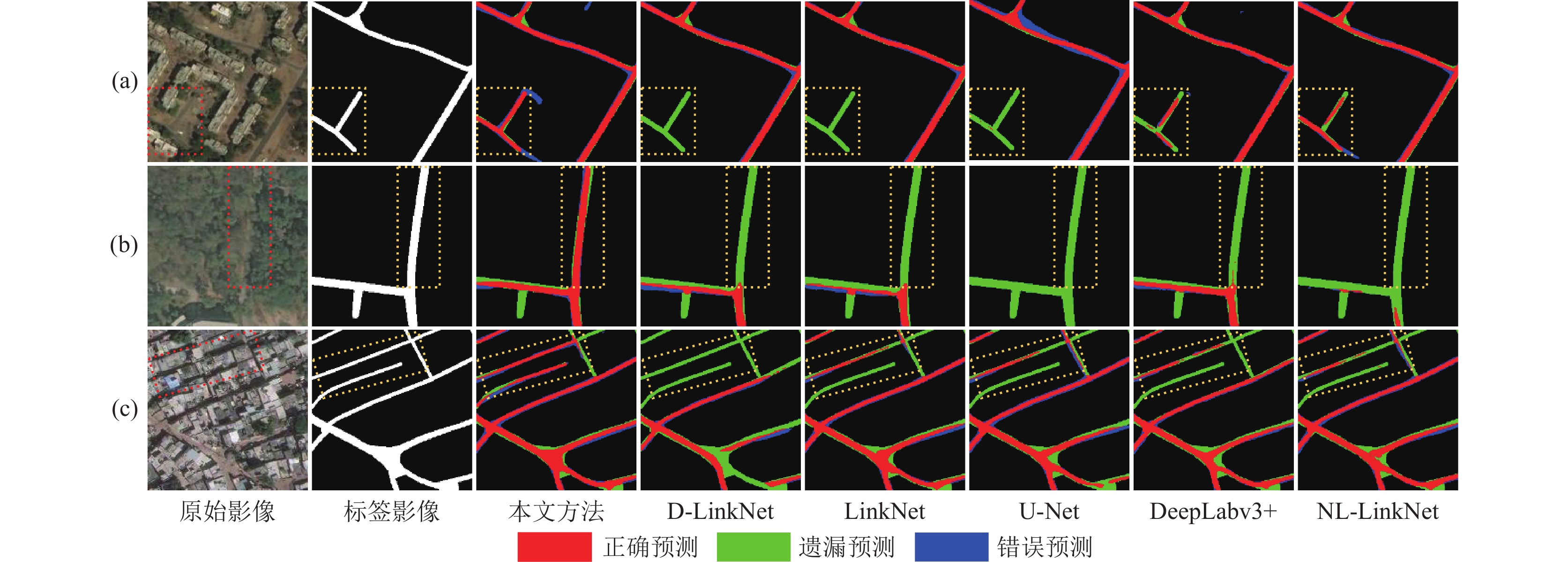

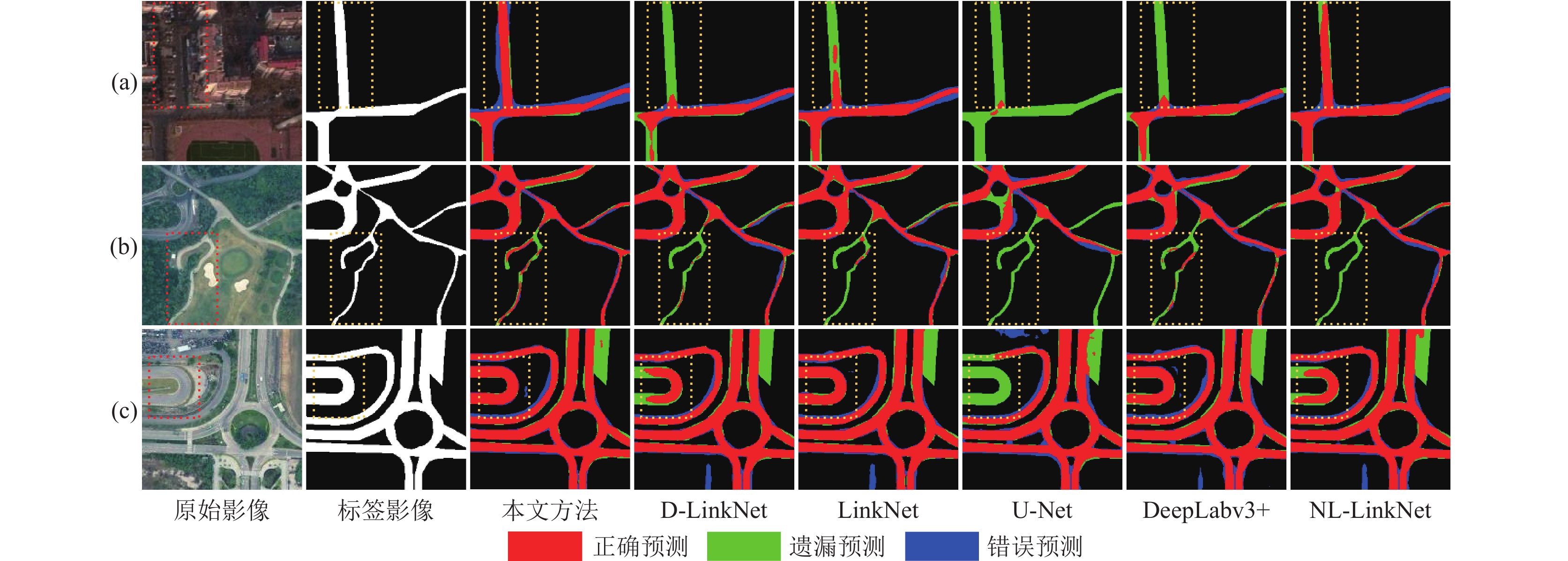

3 实验分析 3.1 DeepGlobe数据集实验分析为综合分析模型道路提取能力, 在相同的实验环境下使用256×256像素数据集I和512×512像素数据集II对各模型进行训练, 通过数据集I可视化结果评估模型局部小范围提取精准性, 通过数据集II可视化结果评估模型较大范围场景下道路提取能力, 如图7和图8所示为部分道路提取结果, 红色表示正确提取区域, 绿色表示遗漏提取区域, 蓝色表示错误提取区域.

3.1.1 数据集I实验结果分析由表1可知本文模型在F1值、IoU和准确率上提升明显, 相较于对比模型方法中最高数据, 分别提升1.19%、1.64%和1.13%, 相较于基线模型LinkNet分别提升1.50%、2.07%和3.05%.

| 表 1 不同模型在数据集I的道路提取结果对比 (%) |

如图7所示, (a)组标注区域因光谱纹理不明显, U-Net、LinkNet和D-LinkNet均无法识别特征不显著道路区域因而造成漏提现象, DeepLabv3+和NL-LinkNet可提取到部分道路但存在断连现象, MSDANet通过多尺度编码器模块更好地提取了道路细节和轮廓特征, GAG模块使提取结果更加连贯. (b)组道路区域存在林木遮挡现象, 从目视解译角度标注区域仍与主干道有明显连结地带, LinkNet、D-LinkNet和DeepLabv3+仅能提取到该区域部分道路, 本文方法提取结果相对准确完整, 体现了模型在遮蔽环境下的抗干扰能力; (c)组存在建筑阴影遮蔽现象, 由提取结果可知MSDANet预测结果相对平滑完整, 道路交叉口区域轮廓完整清晰, 但仍存在漏提问题.

|

图 7 DeepGlobe数据集I分割结果 |

3.1.2 数据集II实验结果分析

由表2可知本文模型在F1值、IoU上提升明显, 相较于对比模型方法中最高数据, 分别提升0.78%和1.11%, 相较于基线模型LinkNet分别提升1.17%和1.65%.

| 表 2 不同模型在数据集II的道路提取结果对比(%) |

如图8所示, 本文模型在大范围场景下提取结果连贯完整, 整体道路网络断裂现象较少, 局部道路细节还原较好, 道路交汇和连接处的提取相对准确, 综合数据集I提取结果分析, 相较于其他对比模型, 本文方法提高了道路提取结果的整体效果.

3.1.3 交叉验证实验结果分析为评估MSDANet泛化能力, 本文使用数据集I进行4折交叉验证, 将数据集随机分为4份, 按3:1的比例分为训练集和测试集, 每一折实验环境均与数据集I各模型训练测试环境相同.

|

图 8 DeepGlobe数据集II分割结果 |

由表3 中4折交叉验证结果可知, 在3项指标上4折结果中的3折略低于数据集I, 由平均值可知各项评价指标整体与数据集I结果相近, 因此本文模型具有较强泛化能力.

| 表 3 交叉验证结果对比(%) |

3.2 CHN6-CUG数据集实验结果分析

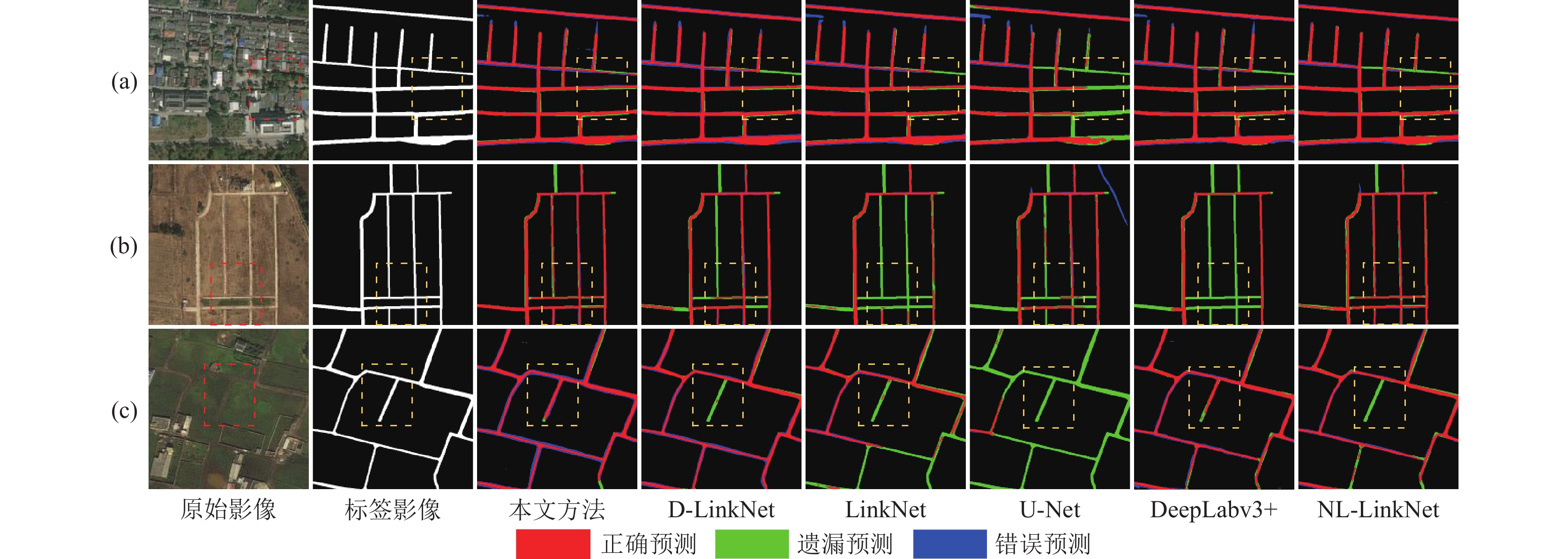

为进一步验证模型在其他数据集上的泛化能力, 选用CHN6-CUG数据集进行测试, 所有实验均在相同实验环境下训练和评估, 部分提取结果如图9所示.

由表4可知模型在F1值和IoU两项指标上均有提升, 相较于对比方法中最高数据分别提升0.77%、1.04%, 相较于基线方法LinkNet分别提升0.91%、1.22%, 准确率略高于基线方法.

如图9所示, (a)组提取结果体现了本文模型能从复杂背景下辨识不同拓扑结构的道路网络, 标注区域背景复杂, 仅MSDANet和NL-LinkNet能完整提取; (b)组标注区域道路交汇连接处较窄, 所有模型均有漏提现象, MSDANet预测结果相对完整, 进一步体现本文方法在面对复杂路段时有较好的提取能力; (c)组整体道路区域清晰, U-Net、LinkNet和NL-LinkNet因采用跳跃拼接/连接结构将单一的中间特征信息传递到解码器, 使高权重特征信息不断叠合, 部分低权重关键特征信息被稀释, 导致部分与背景颜色、纹理相似的道路区域易出现漏提和细节缺失现象, 本文方法通过MSDA模块获取更多上下文信息, 使模型对道路特征提取更加准确. 综合提取结果可知, 本文模型泛化能力以及对于不规则道路提取能力优于对比模型.

3.3 消融实验本文通过DeepGlobe数据集进行消融实验, 验证和分析GAG模块、MSDA模块以及FF模块对MSDANet的性能影响, 所有消融实验均采用相同训练和测试环境, 消融实验定量分析如表3所示. 其中, No.1为基线模型LinkNet其编码器主干网络为ResNet, No.2–No.4以LinkNet为基础分别加入对应模块, No.5将主干网络替换为Res2Net, No.6–No.11以No.5为基础加入对应模块以及模块组合.

如表5对FF模块消融实验定量分析所示, ResNet对比组中的No.2相较于No.1在准确率、F1值和IoU上分别提升2.15%、0.5%和0.68%, Res2Net对比组中No.6相较于No.5分别提升0.74%、0.36%和0.46%, 通过对比可知, 因主干网络替换为Res2Net后整体精度提升, Res2Net对比组中整体提升幅度降低, FF模块与GAG模块和MSDA模块组合使用时有助于促进中间传递特征与解码特征融合, 进一步提升模型提取准确性。

|

图 9 CHN6-CUG数据集分割结果 |

| 表 4 不同模型在CHN6-CUG数据集的道路提取结果对比(%) |

| 表 5 消融实验结果对比 |

通过对GAG模块消融实验定量分析可知, ResNet对比组中的No.3相较于No.1在准确率、F1值和IoU上分别提升2.26%、1.0%和1.38%, Res2Net对比组中No.7相较于No.5分别提升1.12%、0.54%和0.75%, 通过对比可知, 该模块在道路分割任务中表现较好; GAG模块通过突出道路形态特征, 引导模型提取道路元素间的关联关系, 因此应用于不同骨干网络时均提升明显, 适用于道路提取任务.

通过对MSDA模块消融实验定量分析可知, ResNet对比组中的No.4相较于No.1在准确率、F1值和IoU上分别提升1.85%、0.81%和1.11%, Res2Net对比组中No.8相较于No.5分别提升0.99%、0.65%和0.89%, 各指标在主干网络更换后提升幅度略有降低, 进一步对比No.8与No.10、No.11可知, 将FF模块和GAG模块与MSDA模块组合使用时F1值和IoU均略有提升, 体现了三者组合使用具有一定协调性, 共同促进模型提取能力进一步提升; 综合上述分析可知, FF、GAG和MSDA模块均可有效增强网络模型表征能力和特征提取融合能力.

4 结论本文针对高分遥感图像中, 因背景复杂、道路拓扑结构多变等因素, 提取结果准确性低、连续性差问题, 提出一种基于多尺度差异聚合机制的道路提取网络MSDANet, 采用Res2Net作为编码骨干网络, 通过门控轴向引导模块引导编码器道路形态特征, 利用多尺度差异聚合模块提取跨层级差异特征, 最终通过特征融合模块将互补增强特征与解码特征融合. 为评估网络模型性能, 在DeepGlobe和CHN6-CUG数据集上设置了定量分析实验, 实验结果表明, MSDANet整体优于对比模型, 有效改善了错分和漏分现象. 未来研究工作将从以下方面展开: ① 优化模型算法, 进一步平衡模型参数量和分割精准度. ② 扩大应用范围, 使其应用于其他地物提取任务中.

| [1] |

赫晓慧, 李代栋, 李盼乐, 等. 基于EDRNet模型的高分辨率遥感影像道路提取. 计算机工程, 2021, 47(9): 297-303, 312. |

| [2] |

戴激光, 王杨, 杜阳, 等. 光学遥感影像道路提取的方法综述. 遥感学报, 2020, 24(7): 804-823. |

| [3] |

Geng K, Sun X, Yan ZY, et al. Topological space knowledge distillation for compact road extraction in optical remote sensing images. Remote Sensing, 2020, 12(19): 3175. DOI:10.3390/rs12193175 |

| [4] |

Sarukkai V, Jain A, Uzkent B, et al. Cloud removal in satellite images using spatiotemporal generative networks. Proceedings of the 2020 IEEE Winter Conference on Applications of Computer Vision. Snowmass: IEEE, 2020. 1785–1794.

|

| [5] |

Dai L, Zhang GY, Zhang RT. RADANet: Road augmented deformable attention network for road extraction from complex high-resolution remote-sensing images. IEEE Transactions on Geoscience and Remote Sensing, 2023, 61: 1-13. |

| [6] |

Chen ZY, Deng LA, Lu YH, et al. Road extraction in remote sensing data: A survey. International Journal of Applied Earth Observation and Geoinformation, 2022, 112: 102833. DOI:10.1016/j.jag.2022.102833 |

| [7] |

佘佐明, 申勇智, 宋剑虹, 等. 利用经典CNN网络方法构建贵阳市道路要素遥感影像自动提取模型. 测绘通报, 2023(4): 177-182. |

| [8] |

Ronneberger O, Fischer P, Brox T. U-Net: Convolutional networks for biomedical image segmentation. Proceedings of the 18th International Conference on Medical Image Computing and Computer-assisted Intervention. Munich: Springer, 2015. 234–241.

|

| [9] |

Chaurasia A, Culurciello E. LinkNet: Exploiting encoder representations for efficient semantic segmentation. Proceedings of the 2017 IEEE Visual Communications and Image Processing. St. Petersburg: IEEE, 2017. 1–4.

|

| [10] |

Zhou LC, Zhang C, Wu M. D-LinkNet: LinkNet with pretrained encoder and dilated convolution for high resolution satellite imagery road extraction. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW). Salt Lake City: IEEE, 2018. 192–1924.

|

| [11] |

He X, Zhou Y, Zhao JQ, et al. Swin Transformer embedding UNet for remote sensing image semantic segmentation. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 4408715. |

| [12] |

Zhong GQ, Ling X, Wang LN. From shallow feature learning to deep learning: Benefits from the width and depth of deep architectures. WIREs Data Mining and Knowledge Discovery, 2019, 9(1): e1255. DOI:10.1002/widm.1255 |

| [13] |

张亚宁, 张春亢, 王朝, 等. 融合残差和卷积注意力机制的U-Net网络高分影像道路提取. 航天返回与遥感, 2023, 44(3): 119-132. DOI:10.3969/j.issn.1009-8518.2023.03.013 |

| [14] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7132–7141.

|

| [15] |

Wang Y, Seo J, Jeon T. NL-LinkNet: Toward lighter but more accurate road extraction with nonlocal operations. IEEE Geoscience and Remote Sensing Letters, 2022, 19: 3000105. |

| [16] |

Wang XL, Girshick R, Gupta A, et al. Non-local neural networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7794–7803.

|

| [17] |

张立恒, 王浩, 薛博维, 等. 基于改进D-LinkNet模型的高分遥感影像道路提取研究. 计算机工程, 2021, 47(9): 288-296. |

| [18] |

陈国军, 朱燕宁, 耿润田, 等. 基于iHDODC-LinkNet网络的遥感图像道路提取方法. 光电子·激光, 2024, 35(1): 51-58. |

| [19] |

陈果, 胡立坤. 基于边缘引导和多尺度感知的遥感图像道路提取. 激光杂志, 1–6. http://kns.cnki.net/kcms/detail/50.1085.TN.20231103.1339.004.html. [2024-02-29].

|

| [20] |

Gao SH, Cheng MM, Zhao K, et al. Res2Net: A new multi-scale backbone architecture. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(2): 652-662. DOI:10.1109/TPAMI.2019.2938758 |

| [21] |

Stergiou A, Poppe R, Kalliatakis G. Refining activation downsampling with SoftPool. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision (ICCV). Montreal: IEEE, 2021. 10337–10346.

|

| [22] |

Valanarasu JMJ, Oza P, Hacihaliloglu I, et al. Medical Transformer: Gated axial-attention for medical image segmentation. Proceedings of the 24th International Conference on Medical Image Computing and Computer-assisted Intervention. Strasbourg: Springer, 2021. 36–46.

|

| [23] |

Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need. Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach: Curran Associates Inc., 2017. 6000–6010.

|

| [24] |

Shaw P, Uszkoreit J, Vaswani A. Self-attention with relative position representations. Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. New Orleans: ACL, 2018. 464–468.

|

| [25] |

Demir I, Koperski K, Lindenbaum D, et al. DeepGlobe 2018: A challenge to parse the earth through satellite images. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW). Salt Lake City: IEEE, 2018. 172–17209.

|

| [26] |

Zhu QQ, Zhang YN, Li ZQ, et al. Oil spill contextual and boundary-supervised detection network based on marine SAR images. IEEE Transactions on Geoscience and Remote Sensing, 2021, 60: 5213910. |

| [27] |

Loshchilov I, Hutter F. Decoupled weight decay regularization. Proceedings of the 7th International Conference on Learning Representations. New Orleans: OpenReview.net, 2019. 1–19.

|

2024, Vol. 33

2024, Vol. 33