图像超分辨率是计算机视觉领域中一个具有挑战性的任务, 其目的是从低分辨率图像中提取特征信息, 然后重建出高分辨率图像. 图像超分辨率在生活中具有广泛的应用, 如医学成像[1,2]、遥感图像处理[3,4]、安防监控[5]等. 图像超分辨率不仅能提高图像的质量, 更重要的是服务于其他计算机视觉任务, 如目标检测、图像分割等. 这些任务中, 图像质量越好, 实验结果往往越理想.

遥感图像是通过卫星、航空器、无人机等设备获取的地球表面的图像. 通过对遥感图像的分析, 能够为环境监测、地形地貌分析、城市规划、水资源管理、自然灾害监测等提供巨大的帮助. 然而, 由于硬件设备的性能有限、大气扰动和云覆盖以及图像传输过程中的压缩等因素, 遥感图像的分辨率通常较低, 直接分析原始遥感图像效果可能不理想. 因此在分析之前需要对原始图像进行处理, 以充分挖掘图像中的信息, 提高分辨率, 使其更适用于各种实际应用场景. 故可以使用图像超分辨率来解决这个问题, 充分提取原始图像的高频信息重建出高分辨率图像, 然后再应用到其他视觉任务.

由于图像退化的原因不确定, 所以很难找到统一的方法来重建高分辨率图像, 因此图像超分辨率是一个不适定问题(ill-posed problem). 基于插值的传统方法根据邻近像素点的值来获得高分辨率图像, 虽然计算复杂度低, 但是一些高频信息容易被忽略, 导致重建图像太平滑, 视觉效果很差. 随着深度学习的发展, 越来越多的研究者致力于使用深度学习方法来实现图像超分辨率的任务. Dong等首次提出基于神经网络的图像超分辨率模型SRCNN[6], 实验结果表明其重建效果远好于传统方法, 自此图像超分辨率进入了深度学习时代. 先后出现了EDSR[7]、VDSR[8]、RCAN[9]等基于CNN的图像超分辨率模型, 这些模型结构更复杂、网络层数更多, 能够提取更多高频信息, 因此重建的图像视觉效果更佳. 生成对抗网络(generative adversarial network)出现之后, 研究人员发现这种结构非常适合图像超分辨率任务, SRGAN[10]、ESRGAN[11]、RankSRGAN[12]等基于GAN的图像超分辨率模型都取得了不错的效果. Transformer在自然语言处理中的成功让人们开始思考其是否可用于图像处理之中, ViT[13]、Swin Transformer[14]的出现证明了Transformer应用到计算机视觉领域的可行性. SwinIR[15]、ESRT[16]、HNCT[17]、HAT[18]等基于Transformer的超分辨率重建模型开创了SR的新纪元, 在各个常用测试集上都取得了最好的效果.

遥感图像超分辨率重建主要有两种思路: 一是直接将自然图像超分辨率方法用于遥感图像超分辨率, 另一种是根据遥感图像的特点设计更适合遥感图像超分辨率的模型. 实验结果表明, 第1种方法的效果不太理想, 因此更多研究者倾向于研究新的方法. Haut等[19]提出一种卷积生成模型, 该模型先学习低分辨率图像到高分辨率图像的映射关系, 然后将数据对称投影到目标分辨率, 保证低分辨率输入图像的重建约束. DRGAN[20]根据遥感图像的特点设计了一个密集残差网络作为GAN中的生成器网络, 这种结构可以充分提取低分辨率图像的层次特征, 同时根据具有梯度惩罚的Wasserstein GAN[21]修改了损失函数并更改了判别器网络的结构, 以便训练过程更稳定. MHAN[3]中提出了用于恢复细节的高阶注意力(HOA)机制, 同时为了充分利用分层特征, 作者引入了频率感知来连接特征提取和特征细化网络. Jia等[4]将注意力机制与生成对抗网络结合提出了多注意力GAN (MA-GAN), 其中的PCRD模块可以自动学习和调整残差的比例, AUP模块使用像素注意力(PA)来实现图像的重建.

自然图像中通常包含丰富的颜色、纹理和确定的结构, 遥感图像则恰恰相反. 遥感图像在不同的场景中差异较大, 如城镇、森林等场景的图像内容丰富、纹理细节清晰, 但是沙漠、海洋等场景的图像颜色单一、高低频信息不明确, 这种差异给超分辨率任务带来了巨大的挑战. 其次, 基于Transformer的方法中间特征往往会出现块伪影(blocking artifacts), 移位窗口机制并不能很好地实现跨窗口信息交互[18].

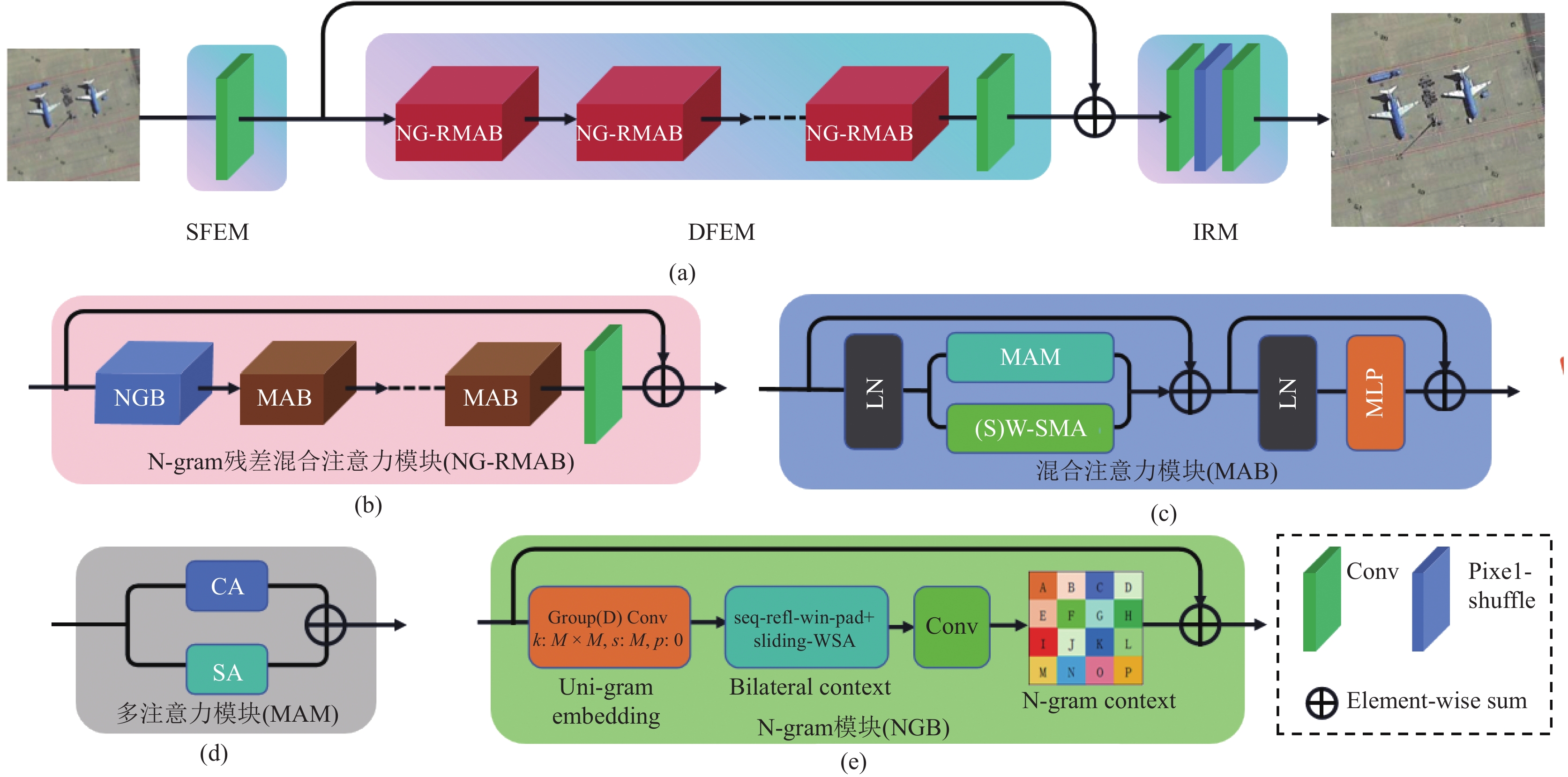

为了解决上述问题, 本文提出了基于多注意力和N-gram模型的Transformer模型NG-MAT, 如图1所示.

|

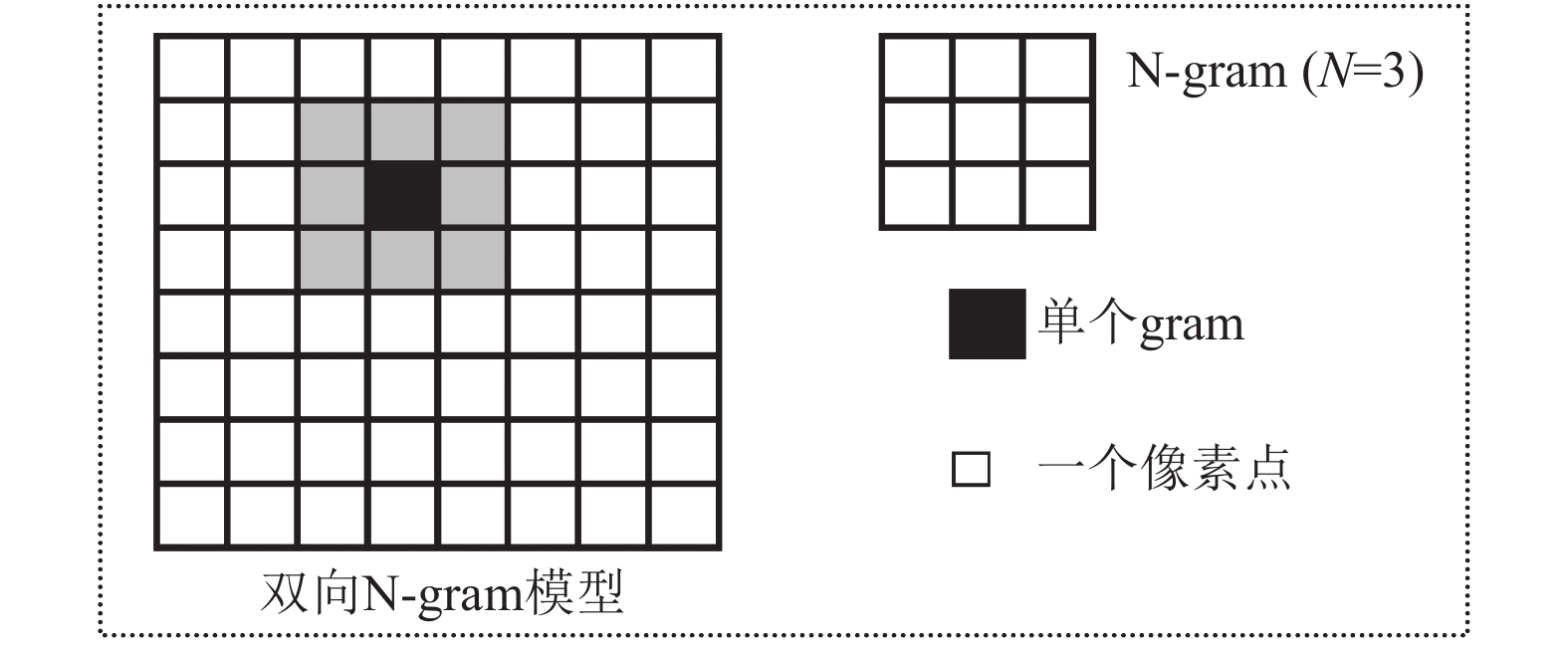

图 1 图像中的N-gram模型(N=3) |

本文提出的NG-MAT模型主要由MAB和NGB两个模块构成. MAB模块结合了通道注意力、空间注意力和自注意力机制, 能够充分提取图像中的局部信息和全局信息, 全局特征信息反映了图像的轮廓特征, 是图像的整体属性, 局部特征反映了图像的细节特征, 是图像的区域属性, 因此这种结构能适应遥感图像复杂的场景; 此外, 本文还使用N-gram模块来提取相邻窗口内的特征, 实现窗口之间的特征交互. 实验结果表明, 本文提出的模型在定量对比和视觉效果对比上, 都取得了最好的效果. 本文的主要贡献可归纳如下.

(1) 将NLP领域的三元N-gram语言模型应用到图像处理领域. 本文用NGB模块提取遥感图像的N-gram context, 实现跨窗口信息交互.

(2)提出MAM模块从两个不同维度提取图像的特征信息. 将通道注意力和空间注意力通过并联方式结合, 能够从两个不同维度提取图像的全局特征信息.

(3)在原始Transformer计算自注意力的分支上并联MAM模块, 同时提取遥感图像的全局特征和局部特征.

本文第2节介绍本文提出的NG-MAT模型的结构. 第3节为本文的实验结果及分析. 第4节是结论.

2 本文方法 2.1 模型整体结构如图2(a)所示, 本文提出的NG-MAT主要由3部分构成: 浅层特征提取模块(shallow feature extraction module)、深层特征提取模块(deep feature extraction module)和图像恢复模块(image reconstruction). 这种结构和已有的一些超分辨率结构一样(SwinIR、HAT). 具体来说, 对于低分辨率输入图像

| FS=HSFE(ILR)=WS∗ILR | (1) |

其中,

|

图 2 NG-MAT模型整体架构 |

然后将提取到的浅层特征

| FD=HDFE(FS)=HNG-RMAB(FS)×n | (2) |

上述两步操作之后, 使用残差连接融合

| ISR=HIR(FS+FD) | (3) |

每个NG-RMAB模块由一个N-gram模块(NGB)和几个混合注意力模块(MAB)构成. 图像恢复模块中使用Pixel-shuffle方法来放大特征的尺寸, 使用卷积神经网络来改变输入输出特征的维度.

本文采用L1 loss来优化模型参数, 训练的目标是最小化损失函数

| L=‖ISR−IGT‖1=1N‖IiSR−IiGT‖1 | (4) |

NLP中的N-gram模型: N-gram在NLP领域内是一种语言统计模型, 即一个序列中下一个位置出现某个词的概率只取决于固定窗口中已经确定的词. 常见的N-gram模型有3种: 一元模型(unigram model)、二元模型(bigram model)和三元模型(trigram model), 主要的区别在于可见窗口的不同, 其中二元模型有前向和反向两种, 本文以文本“这本书非常有用”来解释3种模型的区别, 如表1所示.

| 表 1 NLP中的N-gram模型 |

图像处理中的N-gram模型: 图像中的N-gram应该具有和NLP中相同的意义. 因此可以将一个gram定义为Swin Transformer里不重叠的小窗口, N-gram则表示由

本文的N-gram (N=3)模块计算过程如图2(e)所示. 首先使用卷积核大小为

Swin Transformer的出现解决了ViT计算复杂度高的问题, 这种方法是将输入图像划分为若干个局部窗口, 然后在这些局部窗口内计算自注意力, 这说明Transformer提取的是窗口的局部信息, 而各个窗口之间缺乏信息交互. 为了解决这个问题, 本文提出了图2(c)的结构, 在原始Swin Transformer 计算自注意力的分支上并联一个MAM (在第2.4节中介绍)模块来增加各个窗口之间的交互, 将其称为mixed attention block (MAB). 和原始Swin Transformer一样, 本文的模型交替计算window-based multi-head self-attention (W-MSA)和shifted window-based multi-head self-attention (SW-MSA). 为了避免各个窗口之间的交互信息过度影响窗口内的自注意力, 使用参数

| {XSA=H(S)W-MSA(LN(Xi))XMAM=HMAM(LN(Xi))X1=XSA+θXMAM+XiXo=HMLP(LN(X1))+X1 | (5) |

其中,

Swin Transformer中基于窗口的自注意力计算过程如下: 对于大小为

局部特征

| Q=Wq∗Xh, K=Wk∗Xh,V=Wv∗Xh | (6) |

为了减少内存的消耗, 不同的局部窗口采用共享的映射矩阵

| Atten(Q,K,V)=Softmax(QKT√d+B)V | (7) |

其中,

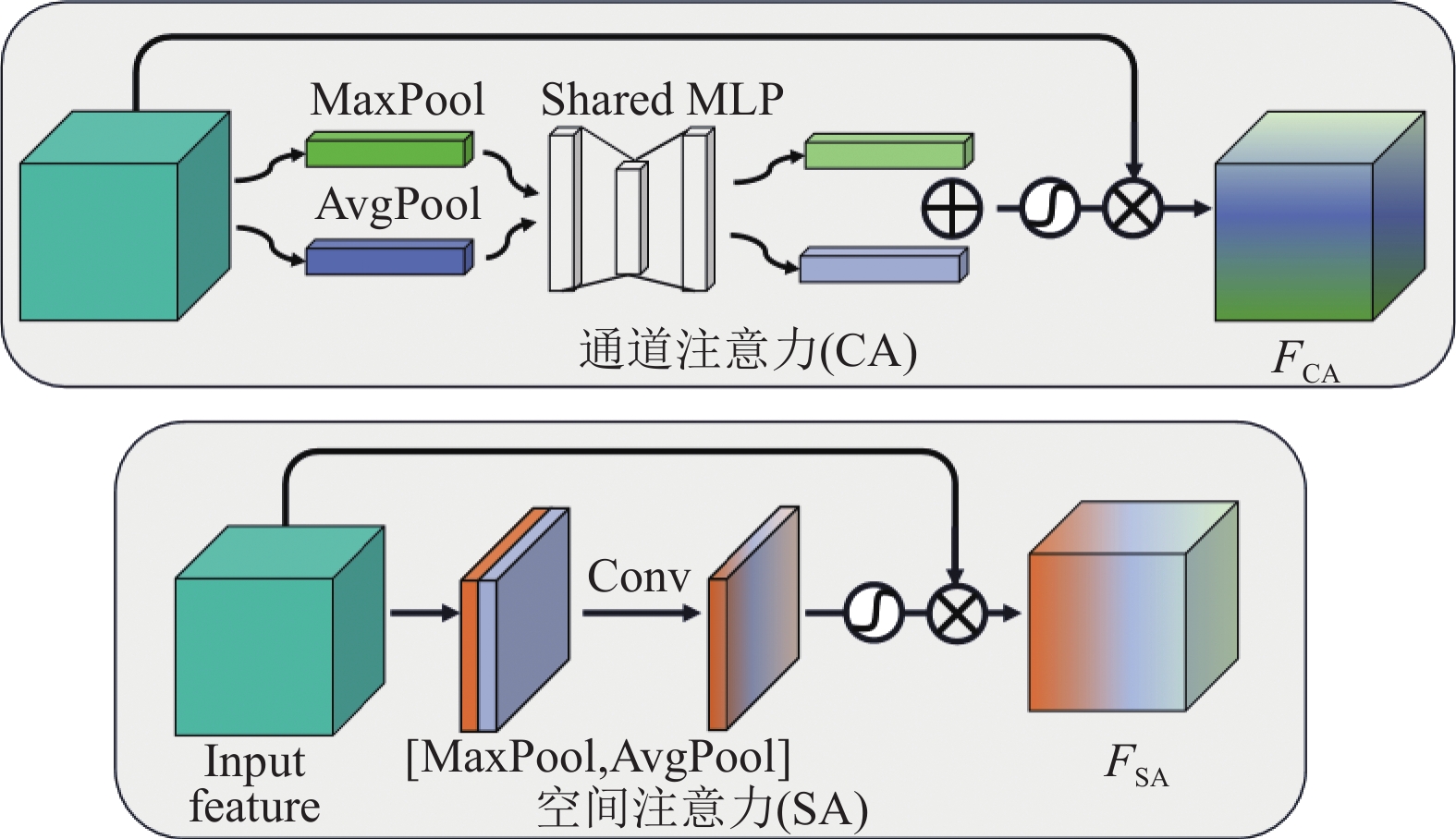

MAM是本文提出的一种多注意力结构, 由通道注意力和空间注意力构成, 它从两个不同的维度提取输入图像的全局特征信息, MAM模块结构如图2(d)所示. 通道注意力和空间注意力的计算如图3所示.

通道注意力: 对于输入特征

|

图 3 通道注意力和空间注意力结构 |

空间注意力: 对于输入特征

| \left\{\begin{gathered} {F_{{\mathrm{CA}}}} = (F_{\max }^c + F_{{\mathrm{avg}}}^c) \otimes {F_{{\mathrm{in}}}} \\ {F_{{\mathrm{SA}}}} = {H_{{\mathrm{Conv}}}}([F_{\max }^s, F_{{\mathrm{avg}}}^s]) \otimes {F_{{\mathrm{in}}}}\;\;\;\;\;\;\;\;\;\;\;\;\;\; \\ {F_{{\mathrm{MAM}}}} = {F_{{\mathrm{CA}}}} + {F_{{\mathrm{SA}}}} \\ \end{gathered}\right. | (8) |

数据集: 本文实验选择AID[23]和NWPU-RESISC45[24]两个数据集作为训练集和测试集, 它们在目标检测和图像超分辨率等任务中被广泛使用. AID数据集包含30个场景的遥感图像, 每个场景约200–420张, 一共有

实验设置: 本文提出的模型NG-MAT在NVIDIA GeForce RTX 4080, 显存为16 GB的设备上训练. 与SwinIR一样, 我们将模型的NG-RMAB模块和MAB模块的个数设置为6, 在窗口内计算多头注意力时的h设置为6, 窗口大小设置为8. MAB中的权重参数

本节所有的实验都是在upscale为2的条件下进行, 同时PSNR/SSIM值为验证集的推理结果.

不同

|

表 2 不同权重因子 |

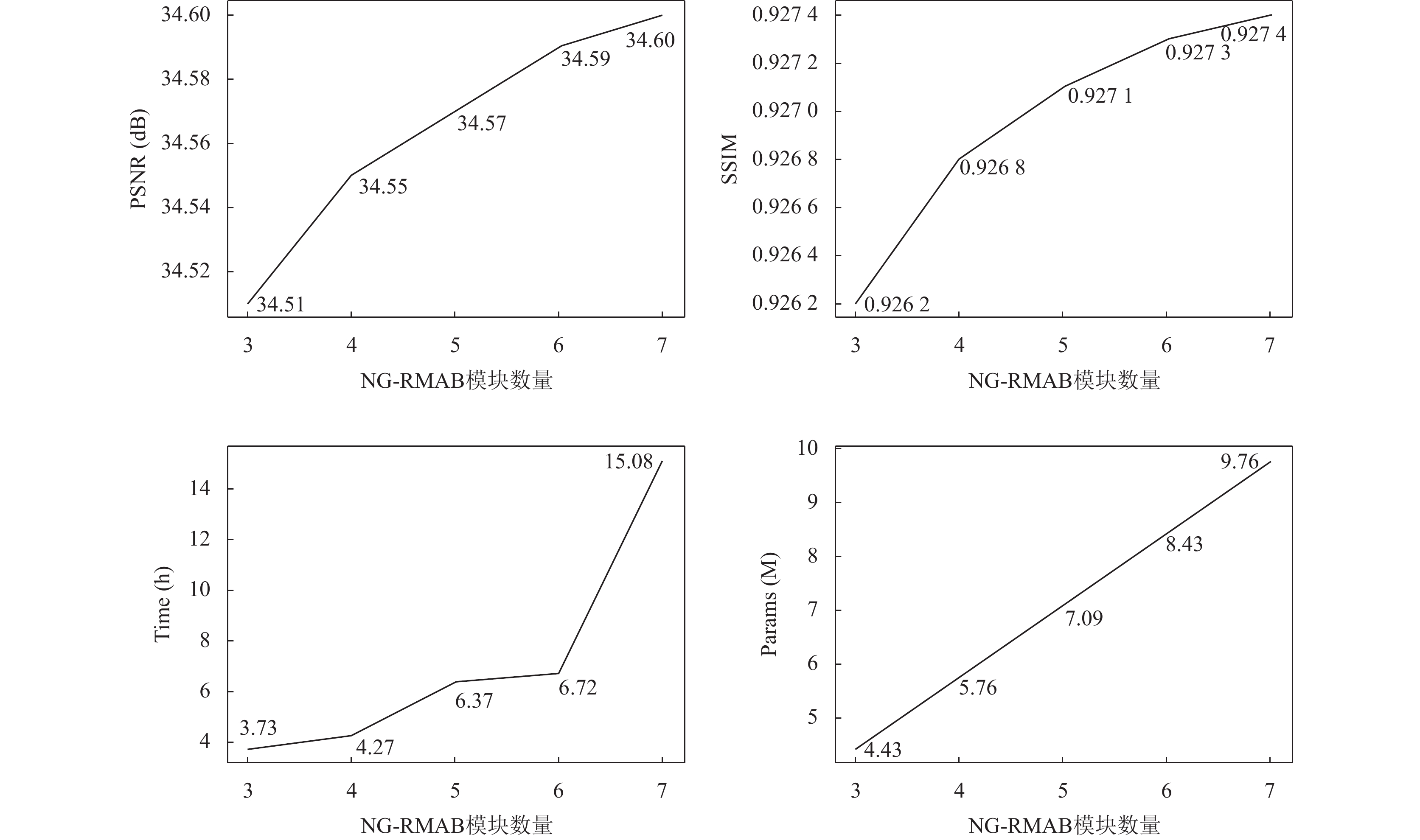

NG-RMAB模块数量对模型的影响: 在本文提出的NG-MAT模型中, 最重要的是深度特征提取部分中的NG-RMAB模块, 这一部分直接决定了重建图像是否具有丰富的细节和纹理特征. 根据深度学习领域的经验, NG-RMAB模块的个数越多, 效果可能会越好, 但是这样会导致网络参数量增加, 增加了模型训练和应用的难度, 因此需要找到一个折中的选择. 选取NG-RMAB模块的个数为{3, 4, 5, 6, 7}进行实验, 除了NG-RMAB模块的个数外, 其他实验设置与第3.1节中相同, 分别对比PSNR、SSIM、训练时间、模型参数量4个指标, 实验结果如图4所示. 一共训练

|

图 4 不同NG-RMAB数量对模型效率的影响 |

分析实验结果可知, PSNR、SSIM、参数量Params基本与NG-RMAB的数量呈线性关系. 训练时间与NG-RMAB的数量则有明显的差异, NG-RMAB个数为6时训练时间为6.72 h, 但NG-RMAB个数为7时, 训练时间急剧增加到15.08 h.

综上可知, NG-RMAB个数为6时, 能够实现模型效率的最大化, 同时尽可能减少模型的训练时间和参数量.

NGB和MAM模块对模型的影响: 本文设计了实验来验证所提出模块NGB和MAM的有效性. 除了是否加入NGB模块或MAM模块外, 其他实验设置与第3.1节中保持一致. 实验结果如表3所示. 由实验结果可知, 分别加入NGB模块、MAM模块都提高了PSNR/SSIM值, 当两个模块同时都加入时, PSNR和SSIM分别提高了0.19 dB和0.002 5. 因此, 实验结果证明了本文提出模块的有效性.

3.3 与其他方法的比较我们将NG-MAT与其他遥感图像超分辨率模型进行了比较, 包括bicubic interpolation (双三次插值)、SRCNN[6]、EDSR[7]、VDSR[8]、SRGAN[10]、RCAN[9]、SwinIR[15], 其中bicubic interpolation是传统超分辨率方法, SRCNN、EDSR、VDSR、RCAN是基于CNN的方法, SRGAN是基于生成对抗网络的方法, SwinIR是基于Transformer的方法, 它们代表了超分辨率算法发展的历程. 为了保证公平性, 每个模型的训练环境及训练数据集均保持一致.

| 表 3 NGB和MAM模块的有效性 |

定量比较: 表4–表6为不同放大因子时, 各个模型在不同场景的遥感图像测试集上的定量对比结果. 由于篇幅的限制, 每个表格中只列出了9个场景的测试结果, 除此之外, 最后的两行平均值(9)和平均值(45)分别表示表格中前9个场景的平均测试结果和整个测试集45个场景的平均测试结果. 为了尽量测试所有的场景, 不同的放大因子时选取不同的场景进行测试, 测试最好的结果用加粗表示.

| 表 4 在NWPU-RESISC45数据集上NG-MAT与7种方法的定量比较(upscale=2) |

| 表 5 在NWPU-RESISC45数据集上NG-MAT与7种方法的定量比较(upscale=3) |

从测试结果可以看出, 传统方法bicubic interpolation的性能总是比深度学习方法差, 本文提出的NG-MAT模型几乎在各个场景都取得了最好的结果. 具体来说, 当放大因子upscale=2时, NG-MAT在除了教堂场景之外的其他场景都取得了最好的结果; 在9个场景的平均测试中, PSNR、SSIM值分别达到了34.24 dB,

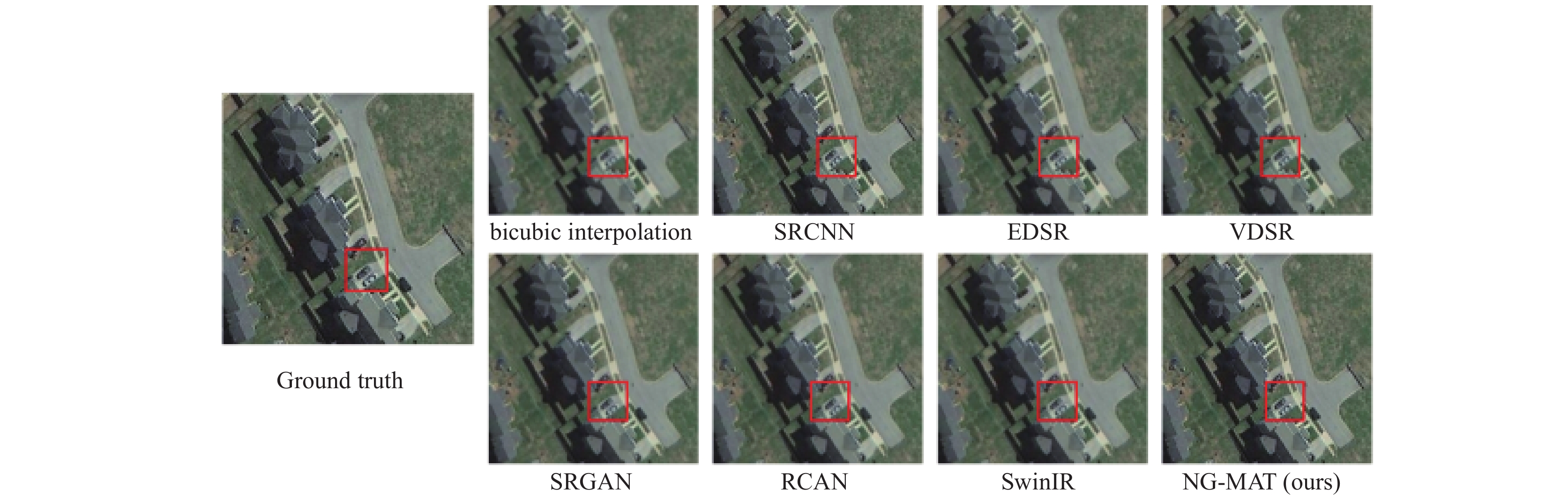

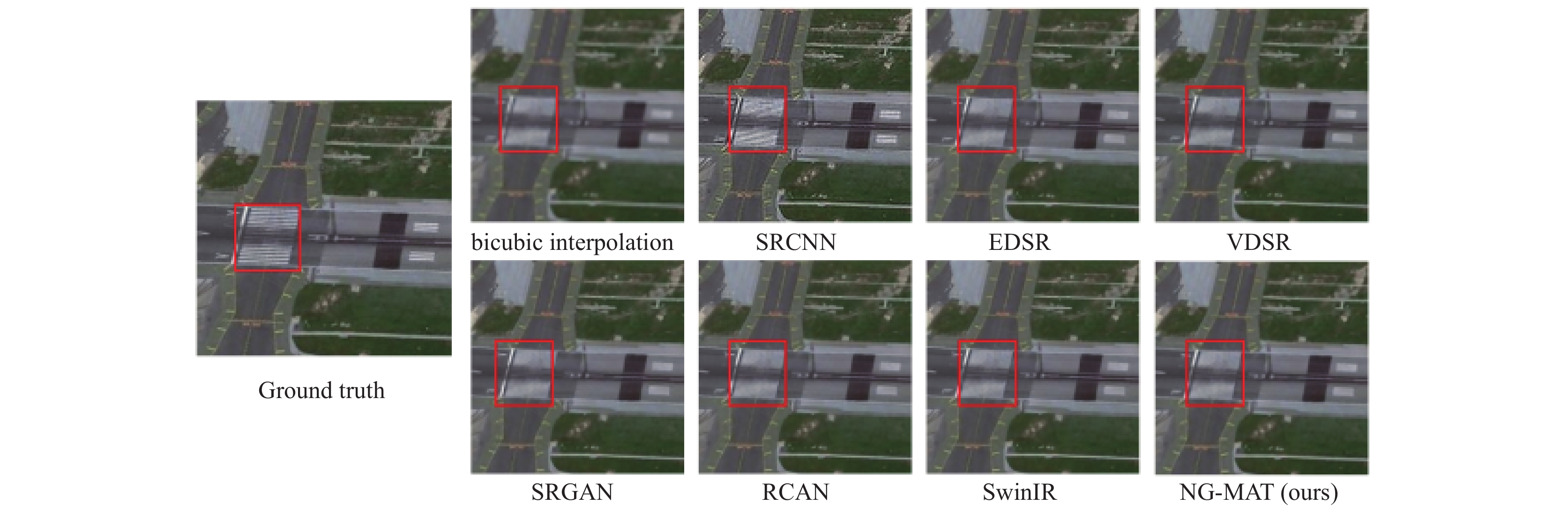

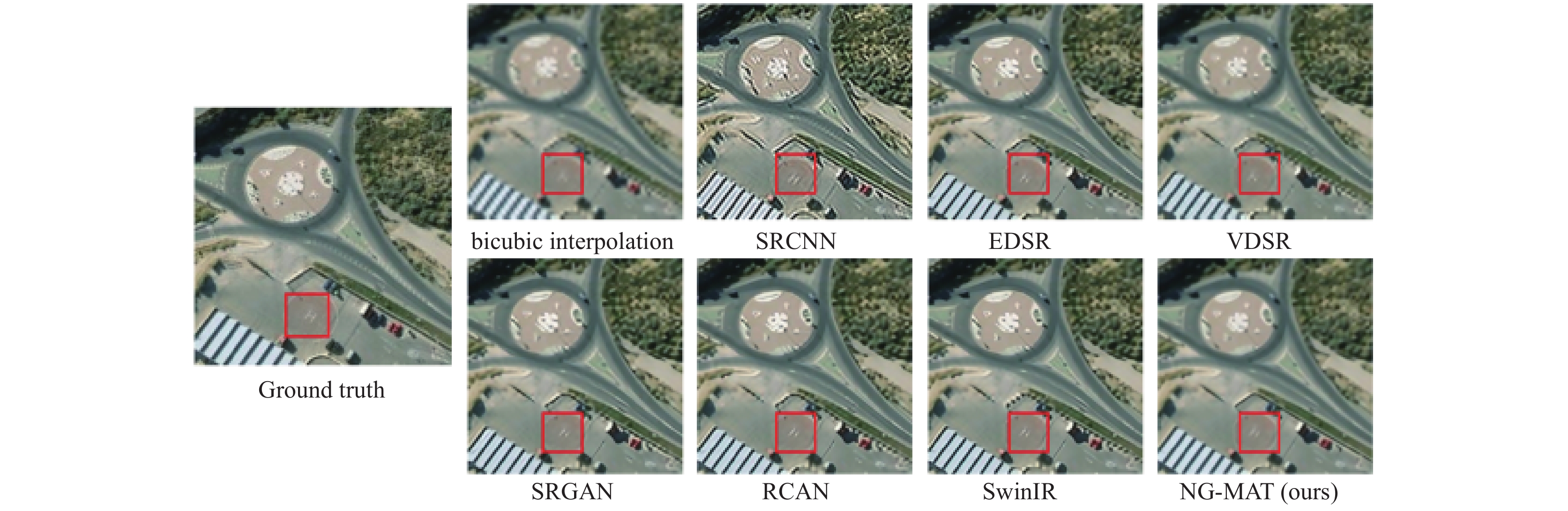

视觉效果对比: 图5–图7给出了放大因子为2、3、4时, NG-MAT与其他基础模型超分辨率重建的视觉对比. 图5–图7中对应数据集中的图像分别为中型住宅655、道路497、环形路口369. 我们可以观察到, 与其他基础模型相比, NG-MAT对于图像纹理和细节的重建效果更接近真实图像, 甚至视觉效果更好, 例如当放大因子upscale=2时, 本文提出的模型重建的图像与真实图像相比噪声更少, 纹理细节丰富. 但是当放大因子变大时, 各种超分辨率模型的重建效果均会变差, 主要是因为原始低分辨率图像中含有的高频信息太少, 难以达到真实图像的视觉效果, 但是NG-MAT重建图像的视觉效果仍然优于其他超分辨率方法. 视觉效果的比较进一步验证了本文提出的NG-MAT的有效性.

| 表 6 在NWPU-RESISC45数据集上NG-MAT与7种方法的定量比较(upscale=4) |

|

图 5 在NWPU-RESISC45数据集上NG-MAT与其他SR方法的视觉对比(upscale=2) |

|

图 6 在NWPU-RESISC45数据集上NG-MAT与其他SR方法的视觉对比(upscale=3) |

|

图 7 在NWPU-RESISC45数据集上NG-MAT与其他SR方法的视觉对比(upscale=4) |

4 结论

本文提出了一种基于Swin Transformer和N-gram模型的遥感图像超分辨率重建网络. 由于不同场景的遥感图像之间差异较大, 而卷积神经网络又不能很好地提取图像的全局特征信息, 因此本文采用Transformer作为超分辨率重建的基准模型, 同时引入N-gram模型来加强Transformer窗口之间的信息交互. 针对现有模型感受野有限的问题, 本文结合通道注意力、空间注意力和自注意力, 从3个不同维度提取图像的特征信息, 激活更多像素. 本文模型在AID和NWPU-RESISC45两个遥遥感数据集上进行训练、验证和测试, 分别通过定量对比和视觉对比验证了模型的有效性. 重建图像纹理细节也更丰富, 能够兼顾多个场景的差异, 有效解决了现有模型存在的一些的问题.

| [1] |

Ahmad W, Ali H, Shah Z, et al. A new generative adversarial network for medical images super resolution. Scientific Reports, 2022, 12(1): 9533. DOI:10.1038/s41598-022-13658-4 |

| [2] |

Qiu DF, Zheng LX, Zhu JQ, et al. Multiple improved residual networks for medical image super-resolution. Future Generation Computer Systems, 2021, 116: 200-208. DOI:10.1016/j.future.2020.11.001 |

| [3] |

Zhang DY, Shao J, Li XY, et al. Remote sensing image super-resolution via mixed high-order attention network. IEEE Transactions on Geoscience and Remote Sensing, 2021, 59(6): 5183-5196. DOI:10.1109/TGRS.2020.3009918 |

| [4] |

Jia S, Wang ZH, Li QQ, et al. Multiattention generative adversarial network for remote sensing image super-resolution. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5624715. |

| [5] |

Rasti P, Uiboupin T, Escalera S, et al. Convolutional neural network super resolution for face recognition in surveillance monitoring. Proceedings of the 9th International Conference on Articulated Motion and Deformable Objects. Palma de Mallorca: Springer International Publishing, 2016. 175–184.

|

| [6] |

Dong C, Loy CC, He KM, et al. Learning a deep convolutional network for image super-resolution. Proceedings of the 13th European Conference Computer Vision. Zurich: Springer, 2014. 184–199.

|

| [7] |

Lim B, Son S, Kim H, et al. Enhanced deep residual networks for single image super-resolution. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Honolulu: IEEE, 2017. 136–144.

|

| [8] |

Kim J, Lee JK, Lee KM. Accurate image super-resolution using very deep convolutional networks. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 1646–1654.

|

| [9] |

Zhang YL, Li KP, Li K, et al. Image super-resolution using very deep residual channel attention networks. Proceedings of the 15th European Conference on Computer Vision (ECCV). Munich: Springer, 2018. 286–301.

|

| [10] |

Ledig C, Theis L, Huszár F, et al. Photo-realistic single image super-resolution using a generative adversarial network. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 105–114.

|

| [11] |

Wang XT, Yu K, Wu SX, et al. ESRGAN: Enhanced super-resolution generative adversarial networks. Proceedings of the 2018 Conference on Computer Vision—ECCV 2018 Workshops. Munich: Springer, 2018. 63–79.

|

| [12] |

Zhang WL, Liu YH, Dong C, et al. RankSRGAN: Generative adversarial networks with ranker for image super-resolution. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 3096–3105.

|

| [13] |

Dosovitskiy A, Beyer L, Kolesnikov A, et al. An image is worth 16x16 words: Transformers for image recognition at scale. Proceedings of the 9th International Conference on Learning Representations. OpenReview.net, 2021.

|

| [14] |

Liu Z, Lin YT, Cao Y, et al. Swin Transformer: Hierarchical vision Transformer using shifted windows. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 9992–10002.

|

| [15] |

Liang JY, Cao JZ, Sun GL, et al. SwinIR: Image restoration using Swin Transformer. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 1833–1844.

|

| [16] |

Lu ZS, Li JC, Liu H, et al. Transformer for single image super-resolution. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. New Orleans: IEEE, 2022. 456–465.

|

| [17] |

Fang JS, Lin HJ, Chen XY, et al. A hybrid network of CNN and Transformer for lightweight image super-resolution. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Orleans: IEEE, 2022. 1102–1111.

|

| [18] |

Chen XY, Wang XT, Zhou JT, et al. Activating more pixels in image super-resolution Transformer. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE, 2023. 22367–22377.

|

| [19] |

Haut JM, Fernandez-Beltran R, Paoletti ME, et al. A new deep generative network for unsupervised remote sensing single-image super-resolution. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(11): 6792-6810. DOI:10.1109/TGRS.2018.2843525 |

| [20] |

Ma W, Pan ZX, Yuan F, et al. Super-resolution of remote sensing images via a dense residual generative adversarial network. Remote Sensing, 2019, 11(21): 2578. DOI:10.3390/rs11212578 |

| [21] |

Arjovsky M, Chintala S, Bottou L. Wasserstein GAN. arXiv:1701.07875, 2017.

|

| [22] |

Wu K, Peng HW, Chen MH, et al. Rethinking and improving relative position encoding for vision Transformer. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 10013–10021.

|

| [23] |

Cheng G, Han JW, Lu XQ. Remote sensing image scene classification: Benchmark and state of the art. Proceedings of the IEEE, 2017, 105(10): 1865-1883. DOI:10.1109/JPROC.2017.2675998 |

| [24] |

Xia GS, Hu JW, Hu F, et al. AID: A benchmark data set for performance evaluation of aerial scene classification. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(7): 3965-3981. DOI:10.1109/TGRS.2017.2685945 |

2024, Vol. 33

2024, Vol. 33