2. 江苏省大气环境与装备技术协同创新中心, 南京 210044

2. Jiangsu Collaborative Innovation Center of Atmospheric Environment and Equipment Technology, Nanjing 210044, China

伪装目标检测 (camouflaged object detection, COD)[1]旨在识别与周围环境具有相似纹理的目标. 伪装的物体大致可以分为两类, 即自然伪装物体和人工伪装物体. 自然伪装对象隐藏在背景环境中, 具有自身优势(如颜色、形状等)来适应环境[2,3], 人工伪装对象往往出现在现实场景中. 它有多种应用, 如安全和监视(如搜索和救援工作[4])、农业(如检测农业)和医学成像分析[5] (如肺部感染分割[6]和息肉分割[7]). 因此, COD由于其应用和科学价值, 在医疗与工业领域备受关注, 成为计算机视觉领域的研究热点之一.

COD与传统的显著物体检测(salient object detection, SOD)[8–10]在任务实现的细节上有相似之处. 任务的侧重点都关于分离图像中的前景和背景. 然而, COD任务中需要分割的目标在视觉上与背景高度相似, 模型在预测时往往会出现边界模糊, 错判对象等问题, 而SOD任务的难题则是注重对于显著物体的判断, 因此前者任务在对于前景与背景的区分难度上相比后者要高很多, 因此更具挑战性. 由于伪装目标与背景之间的内在相似性较高, 在早期的机器学习时代甚至更早期的方法[11–13]主要依赖研究者自己手工设计特征(如纹理、颜色、强度等), 这些方法受限于早期的硬件水平具有很强的局限性, 即便是在指标上表现很好的方法缺乏泛化性.

随着深度学习在计算机视觉领域的快速发展, 现代的COD方法也得到了巨大进步, 成为领域内的主流. 例如, Anet[14]利用分类网络来确定图像中是否包含伪装物体, 然后利用全卷积网络处理COD任务. SINet[1]提出了使用搜索模块粗略选择伪装物体候选区域, 然后引入识别模块来进行精确的伪装物体检测. 此外, 还提出了一个用于COD的大规模数据集, 推动了该领域的发展并促进了更多的探索. PraNet[5]使用并行部分解码器在高级层中聚合特征, 然后基于组合特征生成全局映射提供初始指导区域, 同时利用反向注意模块来建立区域与边界线索之间的关系. FAPNet[15]采用边界引导与特征聚合的方法来提升模型对于复杂场景下的特征提取能力.

尽管目前主流的深度学习方法相较于传统方法在各项评价指标上都有巨大的提升, 但由于任务中最大的难题, 即前景与背景在视觉上的高度相似性, 现有方法仍容易误判目标的轮廓. 此外, 现实任务中还存在许多挑战, 例如目标大小尺度差距过大, 目标外形极度不规则, 模型分割时出现语义分歧等. 即使目前主流的方法也难以在复杂场景中准确识别伪装物体, 因此COD仍有很大的改进空间. 为了解决上述提到的问题, 本文分析得出如下改进的方向.

首先, 尺度变化是COD的主要挑战之一, 因为从骨干网络中提取的浅层特征只能获得较小的感受野, 所以如何有效地从卷积层提取多尺度信息值得进一步探索. 其次, 目前的方法通常将多层次特征整合并输入到解码器网络中, 但忽略了来自不同编码器块的特征表示对结果的贡献. 依据上面分析得出的改进方向, 本文设计了一个基于多尺度特征融合与交互的伪装目标检测网络, 综合考虑了多尺度特征中的各种信息, 使得网络能够兼顾全局语义与局部细节. 具体而言, 主要设计了两个关键模块: 多尺度特征感知模块从伪装物体场景中全面地提取从局部到全局、从小尺度到大尺度的多级特征; 双阶段邻级交互模块则通过跨层融合的方式来有效整合多级特征. 本文的主要创新点如下.

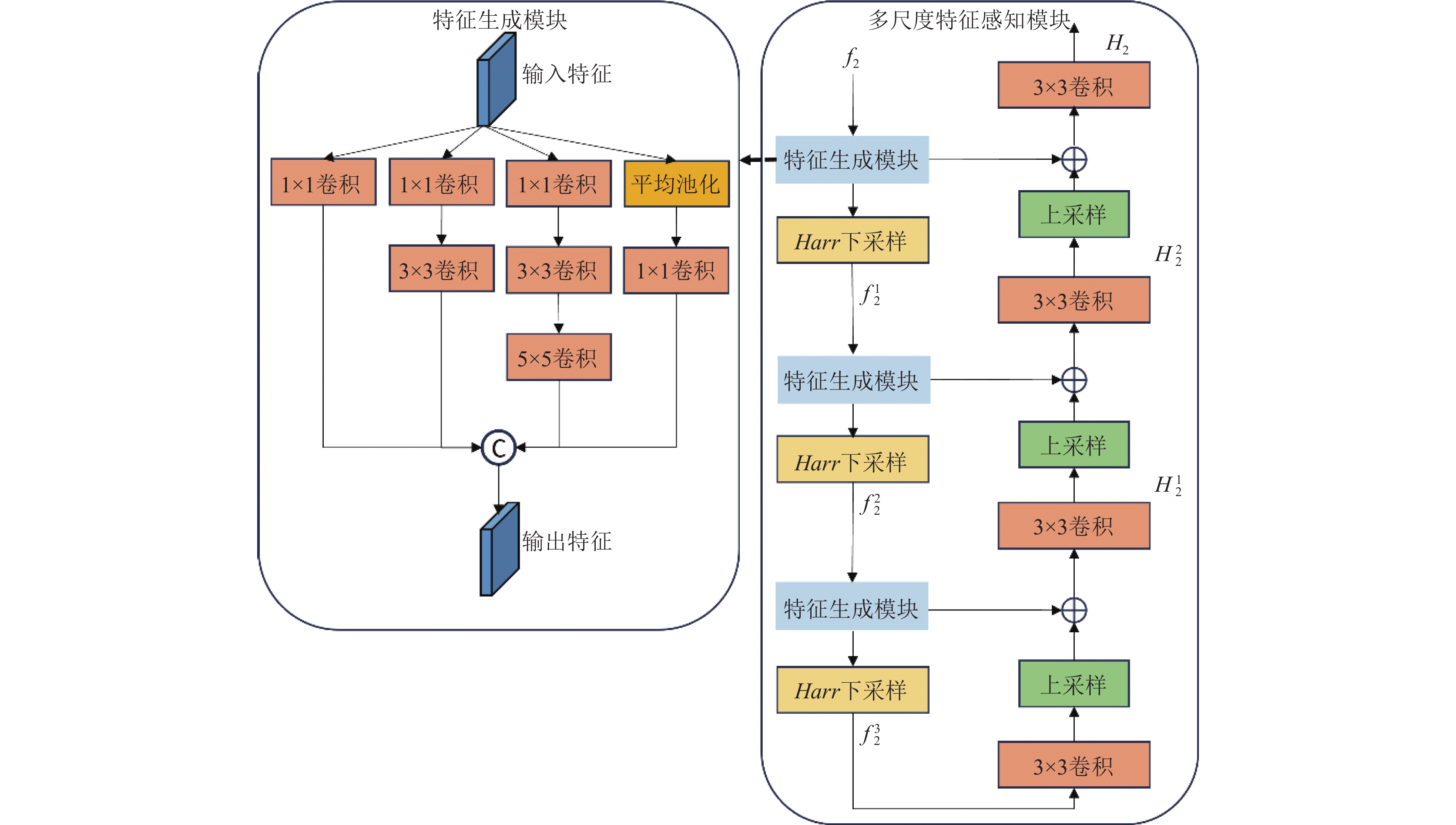

(1)本文设计了一种多尺度特征感知模块, 提出了一种并行特征提取模块, 通过结合多次下采样操作来获得丰富的多尺度场景信息, 然后再逐步上采样聚合解码来还原特征图的尺寸.

(2)本文设计了一种双阶段邻级交互模块来有效地融合逐级相邻的两层特征, 并将有用信息从编码器传播到解码器网络, 这使得模型可以自适应地来平衡网络中每个编码器块提供的特征对于解码器网络的贡献.

1 模型结构受到渐进聚合多尺度场景上下文特征的伪装目标检测[16]启发, 本文设计了一个全新的网络结构. 图1展示了本文所提出的整体网络架构. 网络由两个关键模块组成: 多尺度特征感知模块和双阶段邻级交互模块. 具体而言, 首先将图像输入编码器骨干网络(以Res2Net-50[17]为主干网络)以提取多层次特征, 分别表示为

|

图 1 本文方法的总体网络结构图 |

1.1 空洞空间金字塔池化(ASPP)

经过5层残差块编码后, 会得到具有强语义表征能力的特征

最后, 将各个分支的输出进行通道维度拼接, 再通过

因为每个卷积层只能处理一个特殊的尺度, 所以尺度变化是COD任务中的主要挑战之一. 受到U-Net[19]在复杂医疗场景下的成功运用的启发, 本文设计了多尺度特征感知模块来实现从单层捕获多尺度信息来表征对象尺度的变化.

将除

| {f12=Harr(FG(f2))f22=Harr(FG(f12))f32=Harr(FG(f22)) | (1) |

式(1)介绍了多尺度特征感知模块中的下采样流程, 其中

| {H12=Conv3(FG(f22)+up(Conv3(f32)))H22=Conv3(FG(f12)+up(H12))H2=Conv3(FG(f2)+up(H22)) | (2) |

式(2)介绍了多尺度特征感知模块中的上采样流程, 其中

图2中的特征生成模块通过在输入特征

粗暴地将所有特征传递给解码器网络而不去关注不同层次的特征的贡献是不应该的. 于是本文设计了这个双阶段邻级交互模块.

如图3所示, 本文以两个多尺度特征感知模块的输出特征

|

图 2 多尺度特征感知模块结构图 |

|

图 3 双阶段邻级交互模块结构图 |

首先通过加法操作融合这两个特征, 然后将结果输入带有Sigmoid激活函数的

| faddn=σ(Conv3(fawaren⊕fawaren+1)) | (3) |

其中,

| {ˆfawaren=Conv3(fawaren⊗faddn+fawaren)ˆfawaren+1=Conv3(fawaren+1⊗faddn+fawaren+1) | (4) |

| ˆFn=Conv3(ˆfawaren⊕ˆfawaren+1) | (5) |

在之后的流程中, 将

| Fen=ConvCBR(ˆFn⊕Fl) | (6) |

接着将

| {Fattl=CA(Fl,Fen)ˆFattn=CA(ˆFn,Fen) | (7) |

其中,

| Fn=ConvCBR(Fattl⊗Fl)⊕ConvCBR(ˆFattn⊗ˆFn) | (8) |

通过交叉注意力操作替代先前直接简单相加或者相乘的操作来聚合邻级多尺度特征, 可以在不产生多余噪声的前提下充分获得不同特征之间的聚合信息, 而且减少了融合步骤, 避免了多次特征融合产生的特征冗余. 经过残差连接和组合卷积块得到的最终输出 具有被加强的全局语义的同时还具有相对精细的局部细节.

1.4 损失函数二元交叉熵是分割任务中广泛应用的损失函数之一, 但是其在独立计算时仅考虑了每个像素的损失而忽略了图像的全局结构. 结合标准交并比(IoU)与显著目标检测中的加权交并比[21], 本文设计了一个如下损失函数:

| Ltotal=4∑i=1λiLdet(Gdowni,Si) | (9) |

其中,

本文网络结构是端到端的模型, 使用两块NVIDIA 2080Ti GPU, 在PyTorch 1.2.0框架上进行训练. 使用了用骨干网络(Res2Net-50), 该网络已经在ImageNet[22]上进行了预训练, 在训练图像大小为352×352, 使用额外的数据增强策略包括随机翻转、裁剪旋转以进行数据扩充. 测试时保持图像大小为352×352. 使用Adam算法[23]对训练过程进行参数优化. 初始学习率设置为

在测试阶段本文不对模型进行任何调整, 仅调整输入图片大小再送入模型进行推理, 对于推理的结果使用双线性插值法将模型输出调整至原图大小.

2.2 数据集本文在伪装目标检测任务的3个公共数据集上进行实验. CHAMELEON[1]是通过Google搜索引擎收集的数据集, 包含 76 张伪装动物的图像用于测试. CAMO-Test[14]有

本文在伪装目标检测的3个数据集上进行对比实验, 对比实验所采用的评价指标如下: 平均绝对误差(MAE)[24]、平均E-measure (

本文选取了11个具有代表性的基于深度学习的方法与本文所提出的方法进行了对比. 在表1展示了所有方法的指标结果, 其中黑色加粗代表最好的性能, 下划线代表第2名的性能, ↑表示该指标越大越好, ↓表示该指标越小越好. 可见本文的方法在3个数据集上均表现优异, 证明了本文方法的有效性.

本文方法在最大数据集COD10K-Test上各项指标的性能数据都超越了其他模型, 4个指标相对于第2名分别提升了0.2%、0.2%、0.1%、0.3%. 在数据量相对较少的数据集CHAMMELEON上

| 表 1 CHAMELEON、CAMO-Test和COD10K-Test测试集上的对比实验 |

|

图 4 不同方法的定性比较可视化图 |

2.3.2 消融实验分析

为了证明本文所提出的方法中的各个模块有效性, 如表2所示, 本文在CHAMELEON数据集上进行了消融实验.

| 表 2 在CHAMELEON数据集上的消融实验 |

ASPP的有效性: ASPP结合骨干网络提取的最深层特征, 通过全局池化增强了全局语义. 从实验(1)和(2)中可见, 加入ASPP后各项指标获得了提升.

多尺度特征感知模块的有效性: 多尺度特征感知模块用于提取局部细节丰富的多尺度特征. 从实验(2)和(3)可以看出. 在ASPP模块的基础上加入多尺度特征感知模块使得指标获得了一定的提升.

双阶段邻级交互模块的有效性: 双阶段邻级交互模块用于将多尺度特征感知模块提取的多尺度特征进行融合. 从实验(4)和(5)中可以看出, 在加入了该模块后, 整个模型的性能有了较大的提升, 说明该模块有效地集成了相邻层级的特征.

3 结束语本文提出了一个基于多尺度特征融合与交互的网络来进行伪装目标检测. 其中, 网络的多尺度特征感知模块使得网络能够从原始图像中获得更加丰富的多尺度场景的全局与局部信息; 双阶段邻级交互模块则有效地融合了相邻层级的特征, 并将它们与编码器中得到的上下文信息一起传递到解码器网络. 本文所提出的网络在伪装目标检测的3个公共数据集上进行了全面实验, 结果显示该网络能够显著提升检测的速度与准确度, 相较于现有方法具有更高的性能表现.

| [1] |

Fan DP, Ji GP, Sun GL, et al. Camouflaged object detection. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 2777–2787.

|

| [2] |

Li S, Florencio D, Li WQ, et al. A fusion framework for camouflaged moving foreground detection in the wavelet domain. IEEE Transactions on Image Processing, 2018, 27(8): 3918-3930. DOI:10.1109/TIP.2018.2828329 |

| [3] |

Chen G, Liu SJ, Sun YJ, et al. Camouflaged object detection via context-aware cross-level fusion. IEEE Transactions on Circuits and Systems for Video Technology, 2022, 32(10): 6981-6993. DOI:10.1109/TCSVT.2022.3178173 |

| [4] |

Mishra B, Garg D, Narang P, et al. Drone-surveillance for search and rescue in natural disaster. Computer Communications, 2020, 156: 1-10. DOI:10.1016/j.comcom.2020.03.012 |

| [5] |

Fan DP, Ji GP, Zhou T, et al. PraNet: Parallel reverse attention network for polyp segmentation. Proceedings of the 23rd Medical Image Computing and Computer Assisted Intervention. Lima: Springer, 2020. 263–273.

|

| [6] |

Fan DP, Zhou T, Ji GP, et al. Inf-Net: Automatic COVID-19 lung infection segmentation from CT images. IEEE Transactions on Medical Imaging, 2020, 39(8): 2626-2637. DOI:10.1109/TMI.2020.2996645 |

| [7] |

Qiu LT, Wu XJ, Yu ZY. A high-efficiency fully convolutional networks for pixel-wise surface defect detection. IEEE Access, 2019, 7: 15884-15893. DOI:10.1109/ACCESS.2019.2894420 |

| [8] |

Li TP, Song HH, Zhang KH, et al. Recurrent reverse attention guided residual learning for saliency object detection. Neurocomputing, 2020, 389: 170-178. DOI:10.1016/j.neucom.2019.12.109 |

| [9] |

Liu N, Han JW, Yang MH. PiCANet: Learning pixel-wise contextual attention for saliency detection. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 3089–3098.

|

| [10] |

Qin XB, Zhang ZC, Huang CY, et al. BASNet: Boundary-aware salient object detection. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 7471–7481.

|

| [11] |

Bhajantri NU, Nagabhushan P. Camouflage defect identification: A novel approach. Proceedings of the 9th International Conference on Information Technology. Bhubaneswar: IEEE, 2006. 145–148.

|

| [12] |

Zhang X, Zhu C, Wang S, et al. A Bayesian approach to camouflaged moving object detection. IEEE Transactions on Circuits and Systems for Video Technology, 2017, 27(9): 2001-2013. DOI:10.1109/TCSVT.2016.2555719 |

| [13] |

Pan YX, Chen YW, Fu Q, et al. Study on the camouflaged target detection method based on 3D convexity. Modern Applied Science, 2011, 5(4): 152-157. |

| [14] |

Le TN, Nguyen TV, Nie ZL, et al. Anabranch network for camouflaged object segmentation. Computer Vision and Image Understanding, 2019, 184: 45-56. DOI:10.1016/j.cviu.2019.04.006 |

| [15] |

Zhou T, Zhou Y, Gong C, et al. Feature aggregation and propagation network for camouflaged object detection. IEEE Transactions on Image Processing, 2022, 31: 7036-7047. DOI:10.1109/TIP.2022.3217695 |

| [16] |

刘研, 张开华, 樊佳庆, 等. 渐进聚合多尺度场景上下文特征的伪装物体检测. 计算机学报, 2022, 45(12): 2637-2651. DOI:10.11897/SP.J.1016.2022.02637 |

| [17] |

Gao SH, Cheng MM, Zhao K, et al. Res2Net: A new multi-scale backbone architecture. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(2): 652-662. DOI:10.1109/TPAMI.2019.2938758 |

| [18] |

Chen LC, Papandreou G, Schroff F, et al. Rethinking atrous convolution for semantic image segmentation. arXiv:1706.05587, 2017.

|

| [19] |

Ronneberger O, Fischer P, Brox T. U-Net: Convolutional networks for biomedical image segmentation. Proceedings of the 18th Medical Image Computing and Computer-assisted Intervention. Munich: Springer, 2015. 234–241.

|

| [20] |

Xu GP, Liao WT, Zhang X, et al. Haar wavelet downsampling: A simple but effective downsampling module for semantic segmentation. Pattern Recognition, 2023, 143: 109819. DOI:10.1016/j.patcog.2023.109819 |

| [21] |

Wei J, Wang SH, Huang QM. F³Net: Fusion, feedback and focus for salient object detection. Proceedings of the 34th AAAI Conference on Artificial Intelligence. New York: AAAI Press, 2020. 12321–12328.

|

| [22] |

Russakovsky O, Deng J, Su H, et al. ImageNet large scale visual recognition challenge. International Journal of Computer Vision, 2015, 115(3): 211-252. DOI:10.1007/s11263-015-0816-y |

| [23] |

Kingma D, Ba J. Adam: A method for stochastic optimization. arXiv:1412.6980, 2014.

|

| [24] |

Perazzi F, Krähenbühl P, Pritch Y, et al. Saliency filters: Contrast based filtering for salient region detection. Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Providence: IEEE, 2012. 733–740.

|

| [25] |

Fan DP, Gong C, Cao Y, et al. Enhanced-alignment measure for binary foreground map evaluation. Proceedings of the 27th International Joint Conference on Artificial Intelligence. Stockholm: IJCAI.org, 2018.

|

| [26] |

Fan DP, Cheng MM, Liu Y, et al. Structure-measure: A new way to evaluate foreground maps. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 4548–4557.

|

| [27] |

Achanta R, Hemami S, Estrada F, et al. Frequency-tuned salient region detection. Proceedings of the 2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami: IEEE, 2009. 1597–1604.

|

| [28] |

Lin TY, Dollár P, Girshick R, et al. Feature pyramid networks for object detection. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 2117–2125.

|

| [29] |

Zhao HS, Shi JP, Qi XJ, et al. Pyramid scene parsing network. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 6230–6239.

|

| [30] |

Zhou ZW, Siddiquee MR, Tajbakhsh N, et al. UNet++: Redesigning skip connections to exploit multiscale features in image segmentation. IEEE Transactions on Medical Imaging, 2020, 39(6): 1856-1867. DOI:10.1109/TMI.2019.2959609 |

| [31] |

Wu Z, Su L, Huang QM. Cascaded partial decoder for fast and accurate salient object detection. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 3902–3911.

|

| [32] |

Zhao JX, Liu JJ, Fan DP, et al. EGNet: Edge guidance network for salient object detection. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 8778–8787.

|

| [33] |

Lv YQ, Zhang J, Dai YC, et al. Simultaneously localize, segment and rank the camouflaged objects. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 11591–11601.

|

| [34] |

Mei HY, Ji GP, Wei ZQ, et al. Camouflaged object segmentation with distraction mining. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 8772–8781.

|

2024, Vol. 33

2024, Vol. 33