2. 江苏省大气环境与装备技术协同创新中心, 南京 210044;

3. 东南大学 计算机科学与工程学院, 南京 211189

2. Jiangsu Collaborative Innovation Center of Atmospheric Environment and Equipment Technology, Nanjing 210044, China;

3. School of Computer Science and Engineering, Southeast University, Nanjing 211189, China

遥感影像是指通过遥感技术获取的反映地表各类地物电磁波辐射和反射信息的图像, 通过对遥感影像进行处理, 可以获取丰富的地物信息. 近年来, 随着遥感技术的迅速发展, 遥感影像在环境监测[1]、土地覆盖分类[2]、城市规划[3]等多个领域得到了广泛应用. 随着遥感数据量的激增, 传统的识别方法已经无法满足现有需求, 如何准确高效地识别影像中地物成为遥感影像领域的重要研究课题.

相较于传统的分割方法, 如聚类分割[4]、边缘分割[5]和阈值分割[6], 卷积神经网络(convolutional neural network, CNN)在遥感影像语义分割领域[7]具有显著的优势. CNN能够自动学习遥感影像中不同层次的特征, 从而提高分割结果的准确性和鲁棒性. FCN[8]首次采用全卷积网络实现了对任意尺寸的图像分割. U-Net[9]采用编码器-解码器结构来提取图像特征, 并通过跳跃连接实现深度与浅层信息的融合, 以保留更多的细节信息. UNet++[10]在U-Net的基础上重新设计跳跃连接路径, UNet3+[11]引入全尺度跳跃连接, 并设计分类指导模块以减少图像的过度分割, RA-UNet[12]通过结合残差和注意力机制, 加强模型对图像特定区域的分割能力. DeepLab[13]将全连接条件随机场引入到FCN中, 增加了上下文信息的提取能力. 为提高对遥感影像小尺度目标的识别能力, 张寅等人通过特征增强模块提升目标特征提取能力, 并利用注意力机制与空间注意力模块组成的级联注意力机制, 实现精准地捕获小目标特征[14]. 尽管卷积神经网络在遥感影像语义分割领域取得了显著的进展, 但现有方法往往聚焦于局部上下文特征的学习, 无法有效建模不同物体之间的全局分布关系, 进而制约了模型的分割性能.

为了解决这一问题, 本文提出了语义引导与多尺度增强的分割网络(semantic guided and multi-scale enhanced segmentation network, SGMESN). 该方法在卷积神经网络的基础上, 构建了全局语义关系学习模块, 充分学习不同物体之间的共生关系, 有效地增强了模型的表征能力. 在此基础之上, 考虑到同一场景中, 遥感影像分割物体的尺度存在差异性, 设计了多尺度学习模块, 以融合不同尺度的全局语义关系. 在Potsdam和Vaihingen两个常用的遥感影像分割数据集上进行的实验结果表明, 本方法与其他分割模型相比, 能够实现更加精准的分割效果, 证明了全局语义关系在遥感影像分割中的重要性和有效性.

1 SGMESN网络整体结构本文提出一种语义引导与多尺度增强的遥感影像分割方法, 如图1所示. 网络整体结构由主干网络、全局语义关系学习模块(GRLM)和多尺度关系学习模块(MRLM)组成.

|

图 1 语义引导与多尺度增强的遥感影像分割网络 |

2 SGMESN网络详细介绍 2.1 主干网络

为了充分利用遥感图像中丰富的细节信息和上下文信息, 本文采用U-Net作为主干网络进行特征提取, 利用其强大的特征提取能力和对细节信息的关注, 以确保在处理复杂特征的同时能够保留关键细节信息的完整性.

对于输入网络的遥感影像数据

卷积神经网络方法通常专注于提取局部上下文特征的学习, 未能充分利用图像中的不同物体之间的全局分布关系, 进而制约了模型的分割性能. 如图2所示在不同区域中, 汽车与周围物体存在全分布关系, 图2(a)中汽车周围出现建筑与不透水表面, 图2(b)中汽车周围出现低植被、树木和不透水表面, 汽车出现时必然出现不透水表面.

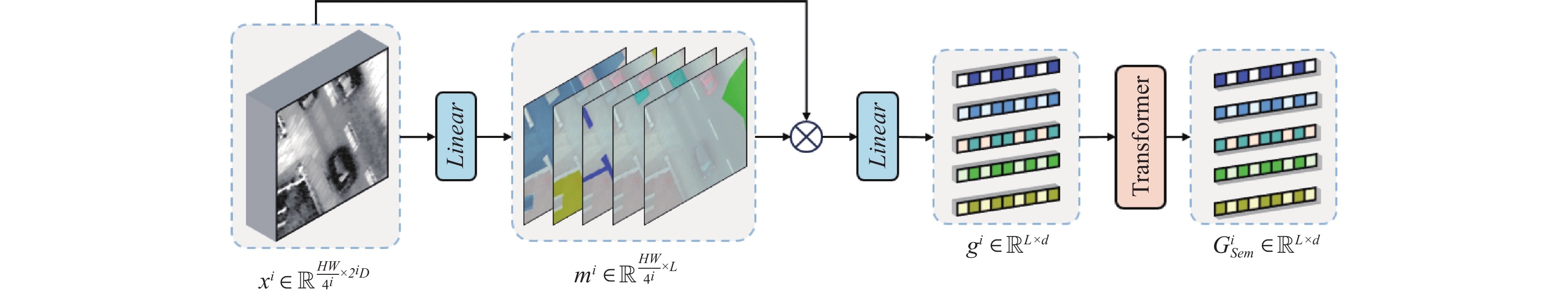

针对此问题本文设计了全局语义关系学习模块, 如图3所示. 首先通过Reshape操作将输入特征进行转化, 表示为:

| $ {E^i} \in {\mathbb{R}^{\frac{H}{{{2^i}}} \times \frac{W}{{{2^i}}} \times {2^i}D}} \to {x^i} \in {\mathbb{R}^{\frac{{HW}}{{{4^i}}} \times {2^i}D}} $ | (1) |

其中, i代表不同的编码层. 其次利用全连接层(Linear)将通道维度转换为类别数量(L), 即:

| $ {m^i} \in {\mathbb{R}^{\frac{{HW}}{{{4^i}}} \times L}} $ | (2) |

|

图 2 不同物体之间存在的全局分布关系 |

|

图 3 全局语义关系学习模块 |

然后经过Softmax函数对

| $ {g^i} = {\mathit{Linear}}[\mathit{Softmax}({\mathit{Linear}}{({x^i})^{\mathrm{T}}} \cdot {x^i})] $ | (3) |

在获取

| $ {G_{\rm Sem}} = \mathit{FFN}\left(Attention\left(\frac{{{q^i} \cdot {k^i}^{\rm T}}}{{\sqrt d }}\right) \cdot {g^i}\right) $ | (4) |

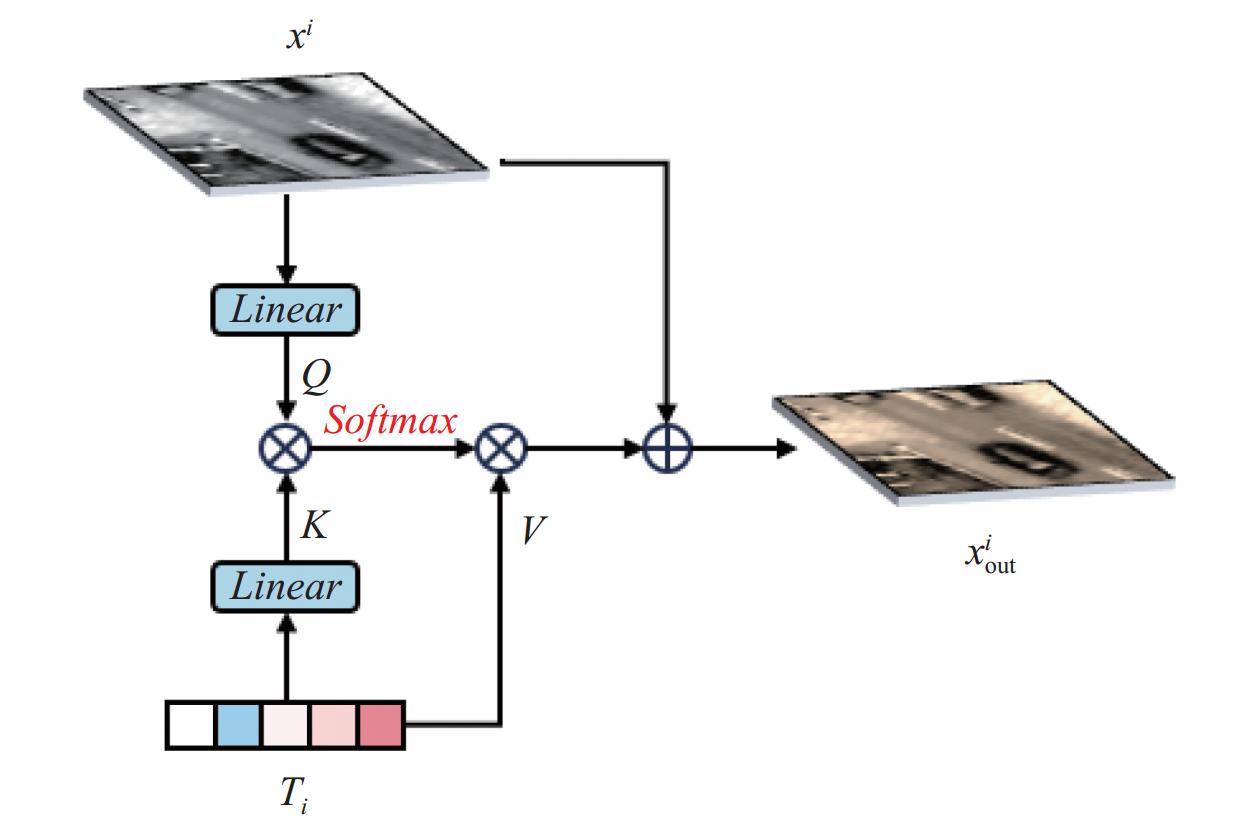

考虑到同一场景下, 待分割物体的尺度存在差异性. 为了更好地融合不同尺度的全局语义关系, 本文设计了一种多尺度关系学习模块. 该模块将不同编码层中全局语义关系学习模块所获取的

| $ \begin{array}{*{20}{c}} {x_{\rm out}^i = {x^i} + {\mathit{Softmax}}\left( {{{\Phi }}\left( {{x^i}} \right) \cdot {{\left( {{{\Phi }}\left( {{T_i}} \right)} \right)}^{\mathrm{T}}}} \right) \cdot {T_i}} \end{array} $ | (5) |

其中,

|

图 4 融合过程 |

3 实验与分析 3.1 实验数据

为了全面评估本文提出方法的有效性, 在两个公开的数据集进行了系统性地测试. 这两个数据集分别是Potsdam和Vaihingen数据集.

Potsdam数据集由38幅高质量遥感图像组成, 覆盖了德国勃兰登堡首都上空的区域. 每幅图像由3波段组成分别为红外波段、红色波段和绿色波段, 以TIFF格式存储, 具有9 ms的空间分辨率, 且图像尺寸为6000×6000像素. 此外, 该数据集还提供了一个单波段的数字表面模型(DSM), 为理解地形的三维信息提供了重要依据. 这些图像包括6种不同的地物类别: 低植被、不透水表面、建筑、树木、汽车和背景. 本文使用的合成图像包含6个通道: 近红外、红色、绿色、归一化植被指数(NDVI)、DSM和nDSM. 其中归一化植被指数(NDVI)的引入是为了提供有关植被的信息, 这对于植被分割尤为重要, NDVI计算如下:

| $ {NDVI = \frac{{NIR - Red}}{{NIR + Red}}} $ | (6) |

其中, NIR表示近红外中的反射率, Red表示红色波段中的反射率. NDVI的值在−1到1的范围内, 其值越高, 代表植被的密度越大. nDSM通过滤除DSM中的地表信息, 提取出能够真实反映地物高度的信息, 有助于区分不同类别的地物. 该数据集被划分为24幅图像的训练集和14幅图像的测试集. 在进行训练和验证之前, 对数据集中的图像使用一个步幅为200的256×256滑动窗口进行裁剪, 最终分别得到

Vaihingen数据集由33幅大小不一的遥感图像组成, 平均尺寸约为2494×2064像素. 该数据集的地物类别数与Potsdam数据相同, 同样采用6通道的合成图像作为模型的输入. 训练集包含16幅图像, 剩余17幅图像则作为测试集. 在进行训练和验证之前, 对数据集中的图像使用一个步幅为64的256×256滑动窗口进行裁剪, 最终分别得到

为了全面评估本文方法的性能, 采用了以下关键的评估指标, 以提供对模型性能的定量评价结果: 总体准确度(overall accuracy, OA)、F1分数(F1-score)、平均 F1分数(mean F1)以及平均交并比(mean intersection over union, mIoU). 具体F1和mIoU指标计算方法如下:

| $ {OA = \frac{{TN + TP}}{{TN + TP + FN + FP}}} $ | (7) |

| $ {F1 = 2 \cdot \frac{{Precision \cdot Recall}}{{Precision + Recall}}} $ | (8) |

| $ {mIoU = \frac{{TP}}{{FP + FN + TP}}} $ | (9) |

其中, Precision代表标记为正样本中被正确标记的比例, Recall代表预测为正样本中被正确预测的比例, TP是正样本被正确识别的数量, TN是负样本被正确识别的数量, FP是误报的负样本数量, FN是漏报的正样本数量.

3.3 实验配置本文实验在一台配备64位体系结构操作系统和NVIDIA GeForce GTX 3090 GPU的计算机上进行, 使用PyTorch框架搭建模型. 训练过程中, 采用交叉熵损失作为损失函数, 并使用随机梯度下降算法(SGD)进行优化, SGD的动量设置为0.9, 初始学习率设为0.01. 此外, 为了更好地调整学习率, 本文采用了自适应学习率调整策略, 其计算公式如下:

| $ {lr = bas{e_{lr}} \cdot {{\left( {1 - \frac{{epoch}}{{epochs}}} \right)}^{power}}} $ | (10) |

其中,

为深入了解全局语义学习模块中类别数量对网络分割性能的具体影响, 在Potsdam和Vaihingen数据集上进行了一系列实验. 在{2, 6, 12, 18, 24, 30}范围内进行类别数(L)设定的测试, 同时保持其他的超参数不变, 结果如表1所示.

| 表 1 全局语义特征中类别数量的分析 (%) |

当类别数(L)从2增加到6时, 在Potsdam和Vaihingen数据集上的mIoU值分别提高了1.2%和0.8%. 进一步增加至12个类别时, 可以观察到网络性能达到最高值, 分别提升0.9%和1.5%. 然而, 当类别数继续增加时, 模型的分割性能并未进一步提升, 反而有所下降. 这一结果表明, 一个适中的全局语义特征列别数能够代表特征图的高级语义信息. 因此, 本文在两个数据集上全局语义特征的类别数量均设置为12.

3.4.2 Transformer中head数量的分析为了评估全局语义关系学习模块Transformer中的head数量对于网络分割性能的影响, 本文从{1, 2, 4, 8, 16, 32, 64}中, 依次选择不同的head数量, 并固定其他超参数进行实验, 结果如表2所示. 随着head数量从1逐渐增加至8, 模型在两个数据集上的mIoU值有明显提升, 分别提升0.6%和0.3%. 特别地, 在Potsdam数据集上, 当head数量为16和32时, mIoU指标相近. 然而, 当head数量超过8后, 两个数据集上的mIoU值都有出现了下降. 基于这一实验结果, 本文在两个数据集上将全局语义关系学习模块中Transformer的head数量设置为8.

| 表 2 Transformer中head数量的分析 (%) |

3.4.3 测试集的裁剪滑动步长分析

由于裁剪步长决定了模型在处理图像时的空间采样密度, 因此本文为了验证测试集裁剪步长对网络分割性能的影响. 在全局语义关系学习模块设置不同的全局语义特征尺寸的情况下, 依次对测试集进行裁剪滑动步长的实验. 依次从{16, 32, 64, 100, 200}范围内选择不同的值, 并固定其他超参数进行实验. 在表3和表4中, 展示了两个数据集的测试集在不同的裁剪滑动步长下对mIoU值的影响.

| 表 3 Potsdam数据集上测试集的裁剪滑动步长分析 |

如表3所示, 在Potsdam数据集上, 当全局语义特征尺寸设置为512×12时, 随着测试集滑动步长从200降低到16时, mIoU值出现持续增加的趋势. 而在全局语义特征尺寸为1024×12时, 随着裁剪滑动步长逐渐降低, 其mIoU值也逐渐提升至77.5%, 略低于77.8%. 因此, 本文中全局语义特征尺寸被设置为512×12, 同时测试集的裁剪滑动步长设置为16. 类似地, 在Vaihingen数据集上的实验结果如表4所示, 当全局语义特征尺寸设置为1024×12, 测试集上的裁剪滑动步长设置为64时, mIoU值相比表现得更优异.

| 表 4 Vaihingen数据集上测试集裁剪滑动步长的分析 |

3.5 对比实验

为了全方面评估本文方法的有效性, 与多个先进分割模型进行对比实验, 其中基于卷积神经网络的方法有FCN-8s、UNet、PSPNet[16]、DeepLabv3+[17]、CGFDN[18] 、CTFNet[19] 、HSDN[20]. 另外一方面, 基于Transformer改进的方法包括Swin-Unet[21]、TransUNet[22]、DC-Swin[23]和UNetFormer[24]. 所有模型均在Potsdam和Vaihingen数据集上进行训练和测试.

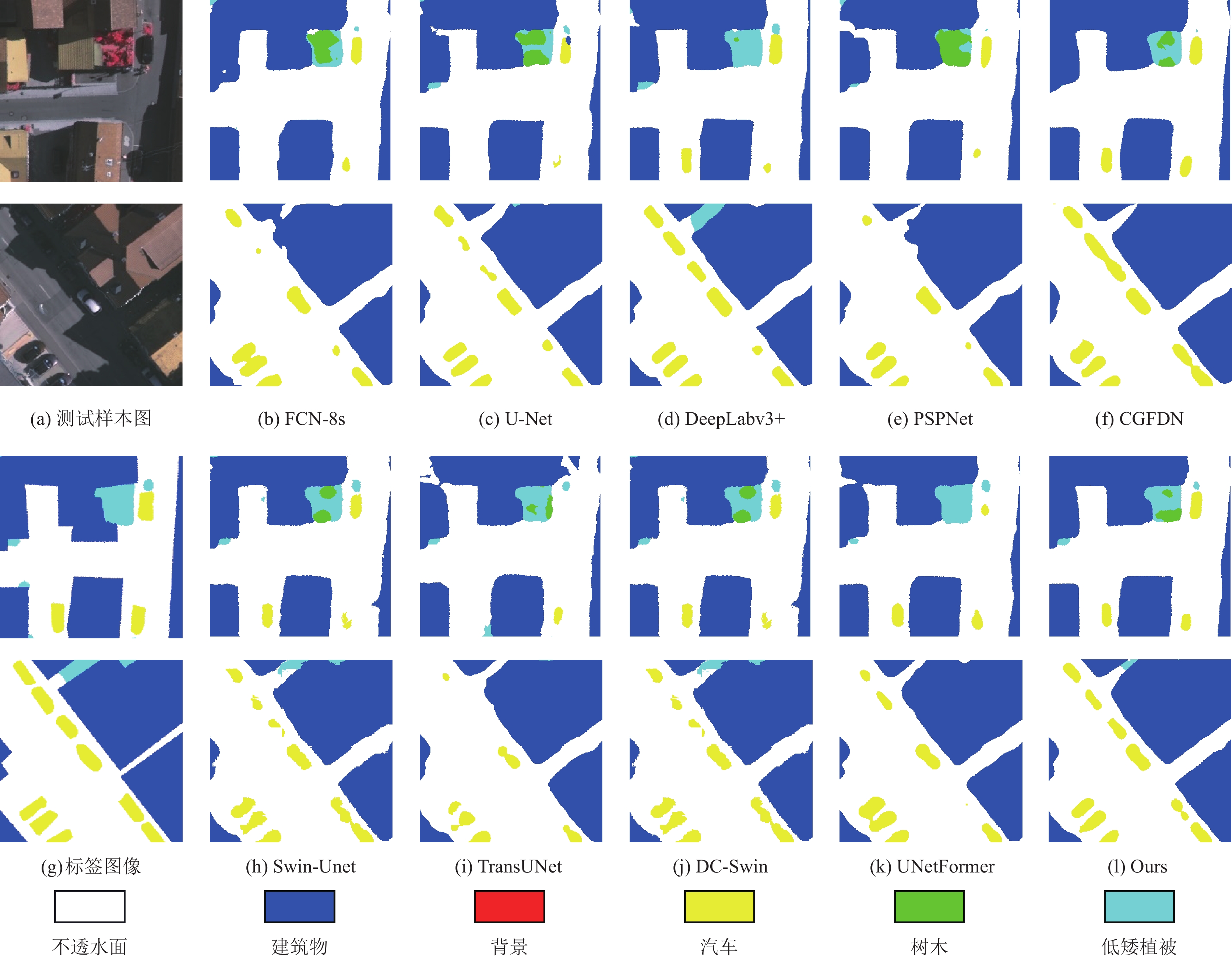

表5和表6中的数据展示了不同模型在Potsdam数据集和Vaihingen数据集上的分割性能结果, 其中加粗数值为每个地物类别中最高的分割精度. 此外, 本文还进行了分割结果的可视化对比, 如图5和图6所示, 不同地物类型使用不同颜色标注. 通过对比不同模型的分割结果, 可以明显地看出本文方法在分割准确度上的优势.

| 表 5 Potsdam数据集上不同模型的性能比较 (%) |

| 表 6 Vaihingen数据集上不同模型的性能比较 (%) |

通过对比实验和分析, 得出以下结论: 首先, 本文选择FCN-8s作为基准模型, 并通过OA、mean F1和mIoU等指标进行定量分析. 在2个数据集上, 基于卷积神经网络的方法和基于Transformer的方法都表现出了良好的分割性能. 然而, 缺乏全局一致性和物体尺度变换多样导致的分割错误. 相比之下, 本文提出的方法通过全局语义关系学习模块和多尺度关系学习模块, 有效地克服了这些限制. 特别是在OA、mean F1和mIoU等关键指标上, 本文方法均取得了最佳表现. 在Potsdam数据集上, 本文方法的OA、mean F1和mIoU分别为91.2%、92.5%和77.8%, 相比最佳的卷积神经网络方法HSDN分别提升了0.3%、0.4%和0.9%. 在Vaihingen数据集上, 同样实现了最佳性能.

从可视化结果中可以看到, 本文方法在处理具有显著尺度变化的场景时表现更为出色. 与其他方法相比, 本文方法能够更准确地分割出建筑、汽车、树木和低植被等地物类型. 特别是在处理小目标和背景类分割时, 本文方法展现出了更高的准确性和鲁棒性. 综上所述, 通过对比实验和分析, 验证了本文方法的有效性和优越性. 本文提出的全局语义和多尺度关系学习模块显著地提升遥感图像分割的性能, 为该领域的研究和应用提供了有价值的参考.

|

图 5 Potsdam数据集上不同模型的实验结果对比图 |

3.6 消融实验

本文提出的方法包括全局语义关系学习模块和多尺度关系学习模块. 前者致力于从特征中提取并学习全局语义信息及其之间的关系, 以帮助模型理解类别的多尺度关系, 并将学习到的类别间共生关系和多尺度关系融入特征中, 从而提高分割精度. 为了评估各模块对整体网络分割精度的影响, 进行模块消融实验. 本实验中将主干网络结构作为Baseline. GRLM [1, 2, …, i]表示在获取到

表7和表8展示了在Potsdam和Vaihingen数据集上的消融实验结果.

结果表明与Baseline相比, 通过加入全局语义关系学习模块和多尺度关系学习模块, 两个数据集上的mIoU值分别提升了约1.0%和1.6%.

|

图 6 Vaihingen数据集上不同模型的实验结果对比图 |

| 表 7 Potsdam数据集上的消融实验 |

| 表 8 Vaihingen数据集上的消融实验 |

4 结论与展望

通过在遥感图像语义分割任务中, 现有的方法在特征提取中通常面临着缺乏全局一致性和尺度变化多样的挑战, 导致分割结果不准确. 本文提出了一种语义引导与多尺度增强的遥感影像分割方法, 有效应对了这些挑战. 通过主干网络提取多尺度特征, 并嵌入全局语义关系学习模块, 本文方法能够有效捕获类别间的共生关系, 提高了全局一致性; 多尺度关系学习模块进一步增强了模型在处理多尺度变化时的能力, 并将学习到的类别间的共生关系和多尺度关系融入特征中, 显著提升了分割性能. 通过在Potsdam和Vaihingen两个数据集上的对比实验与消融实验, 验证了本文方法的有效性.

| [1] |

李云梅, 赵焕, 毕顺, 等. 基于水体光学分类的二类水体水环境参数遥感监测进展. 遥感学报, 2022, 26(1): 19-31. DOI:10.11834/jrs.20221212 |

| [2] |

Hang RL, Yang P, Zhou F, et al. Multiscale progressive segmentation network for high-resolution remote sensing imagery. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5412012. DOI:10.1109/TGRS.2022.3207551 |

| [3] |

龙丽红, 朱宇霆, 闫敬文, 等. 新型语义分割D-UNet的建筑物提取. 遥感学报, 2023, 27(11): 2593-2602. |

| [4] |

于波, 孟俊敏, 张晰, 等. 结合凝聚层次聚类的极化SAR海冰分割. 遥感学报, 2013, 17(4): 887-904. |

| [5] |

Hu XY, Shen JJ, Shan J, et al. Local edge distributions for detection of salient structure textures and objects. IEEE Geoscience and Remote Sensing Letters, 2013, 10(3): 466-470. DOI:10.1109/LGRS.2012.2210188 |

| [6] |

吴一全, 吉玚, 沈毅, 等. Tsallis熵和改进CV模型的海面溢油SAR图像分割. 遥感学报, 2012, 16(4): 678-690. DOI:10.11834/jrs.20121192 |

| [7] |

Zheng Z, Zhong YF, Wang JJ, et al. Foreground-aware relation network for geospatial object segmentation in high spatial resolution remote sensing imagery. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 4096–4105. [doi: 10.1109/CVPR42600.2020.00415]

|

| [8] |

Shelhamer E, Long J, Darrell T. Fully convolutional networks for semantic segmentation. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(4): 640-651. DOI:10.1109/TPAMI.2016.2572683 |

| [9] |

Ronneberger O, Fischer P, Brox T. U-Net: Convolutional networks for biomedical image segmentation. Proceedings of the 18th International Conference on Medical Image Computing and Computer-assisted Intervention. Munich: Springer, 2015. 234–241. [doi: 10.1007/978-3-319-24574-4_28]

|

| [10] |

Zhou ZW, Siddiquee MR, Tajbakhsh N, et al. UNet++: A nested U-Net architecture for medical image segmentation. Proceedings of the 4th International Workshop on Deep Learning in Medical Image Analysis. Granada: Springer, 2018. 3–11. [doi: 10.1007/978-3-030-00889-5_1]

|

| [11] |

Huang HM, Lin LF, Tong RF, et al. UNet 3+: A full-scale connected UNet for medical image segmentation. Proceedings of the 2020 IEEE International Conference on Acoustics, Speech and Signal Processing. Barcelona: IEEE, 2020. 1055–1059. [doi: 10.1109/icassp40776.2020.9053405]

|

| [12] |

Jin QG, Meng ZP, Sun CM, et al. RA-UNet: A hybrid deep attention-aware network to extract liver and tumor in CT scans. Frontiers in Bioengineering and Biotechnology, 2020, 8: 605132. DOI:10.3389/fbioe.2020.605132 |

| [13] |

Chen LC, Papandreou G, Kokkinos I, et al. DeepLab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848. DOI:10.1109/TPAMI.2017.2699184 |

| [14] |

张寅, 朱桂熠, 施天俊, 等. 基于特征融合与注意力的遥感图像小目标检测. 光学学报, 2022, 42(24): 2415001. |

| [15] |

Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need. Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach: Curran Associates Inc., 2017. 6000–6010.

|

| [16] |

Zhao HS, Shi JP, Qi XJ, et al. Pyramid scene parsing network. Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 2881–2890.

|

| [17] |

Chen GZ, Zhang XD, Wang Q, et al. Symmetrical dense-shortcut deep fully convolutional networks for semantic segmentation of very-high-resolution remote sensing images. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2018, 11(5): 1633-1644. DOI:10.1109/JSTARS.2018.2810320 |

| [18] |

Zhou F, Hang RL, Liu QS. Class-guided feature decoupling network for airborne image segmentation. IEEE Transactions on Geoscience and Remote Sensing, 2021, 59(3): 2245-2255. DOI:10.1109/tgrs.2020.3006872 |

| [19] |

Wu HL, Huang P, Zhang M, et al. CTFNet: CNN-Transformer fusion network for remote-sensing image semantic segmentation. IEEE Geoscience and Remote Sensing Letters, 2024, 21: 5000305. DOI:10.1109/LGRS.2023.3336061 |

| [20] |

Zheng CY, Nie J, Wang ZX, et al. High-order semantic decoupling network for remote sensing image semantic segmentation. IEEE Transactions on Geoscience and Remote Sensing, 2023, 61: 5401415. DOI:10.1109/TGRS.2023.3249230 |

| [21] |

Cao H, Wang YY, Chen J, et al. Swin-Unet: Unet-like pure Transformer for medical image segmentation. Proceedings of the 2022 European Conference on Computer Vision. Tel Aviv: Springer, 2022. 205–218. [doi: 10.1007/978-3-031-25066-8_9]

|

| [22] |

Chen JN, Lu YY, Yu QH, et al. TransUNet: Transformers make strong encoders for medical image segmentation. arXiv:2102.04306, 2021.

|

| [23] |

Wang LB, Li R, Duan CX, et al. A novel Transformer based semantic segmentation scheme for fine-resolution remote sensing images. IEEE Geoscience and Remote Sensing Letters, 2022, 19: 6506105. DOI:10.1109/lgrs.2022.3143368 |

| [24] |

Wang LB, Li R, Zhang C, et al. UNetFormer: A UNet-like Transformer for efficient semantic segmentation of remote sensing urban scene imagery. ISPRS Journal of Photogrammetry and Remote Sensing, 2022, 190: 196-214. DOI:10.1016/j.isprsjprs.2022.06.008 |

2024, Vol. 33

2024, Vol. 33