2. 武汉科技大学 智能信息处理与实时工业系统湖北省重点实验室, 武汉 430065;

3. 华中科技大学 人工智能与自动化学院, 武汉 430074

2. Wuhan University of Science and Technology Hubei Province Key Laboratory of Intelligent Information Processing and Real-time Industrial System, Wuhan 430065, China;

3. School of Artificial Intelligence and Automation, Huazhong University of Science and Technology, Wuhan 430074, China

固体氧化物燃料电池(solid oxide fuel cell, SOFC)是一种直接将化学能转化为电能的装置[1]. 它具有高效、低排放、安静、燃料灵活性等特点[2], 成为当下绿色新能源开发的研究热点. 电堆是SOFC发电系统的核心组成部分[3], 由若干单片SOFC封装而成. 单片SOFC质量将影响电堆的使用寿命. 在复杂的生产工艺下, 其表面可能会随机出现各种类型的缺陷, 如裂纹、凹陷、划痕、压痕等. 这些缺陷不仅会不同程度影响SOFC性能, 而且影响SOFC系统的使用寿命和稳定性[4].

SOFC表面缺陷微小, 人眼识别能力受限. 因此, 其缺陷图像的提取及相关定量分析依赖光学显微镜实现. 然而, 通过光学显微镜采集的图像存在光照不均和缺陷边界模糊等问题, 且缺陷的大小和形状具有随机性和多样性, 给缺陷区域的自动分割造成一定的困难. 目前, 缺陷相关定量分析完全依赖人工操作, 质量检测结果受人为影响较大, 检测效率低、耗时、人工成本高. 利用图像分割方法对电池片表面缺陷进行感兴趣区域的提取. 图像分割的结果客观提供SOFC表面缺陷的位置、形状和大小参数, 为后续相关定量分析和生产工艺优化研究奠定基础. 实现SOFC表面缺陷的图像分割, 对单片SOFC质量检测具有重要意义.

传统图像分割方法在表面缺陷图像分割领域存在一定局限性. 其分割结果易受到初始参数影响. 由于深度学习可自动学习图像特征, 通常在图像分割任务中取得较好的效果. 因此, 基于深度学习的图像分割方法广泛应用于医学图像、粘性矿石图像、自然场景图像、遥感图像、表面缺陷图像等领域. 研究表明, 有学者利用基于深度学习的方法, 进行表面缺陷图像分割的研究. Youkachen等人[5]使用卷积自动编码器实现钢带表面缺陷分割, 提高钢带生产可靠性. Qi等人[6]提出一种用于航空发动机缺陷分割的弱监督水平集框架, 满足实时检查要求. Chen等人[7]使用改进的任意分段模型实现织物缺陷图像分割, 大大提高织物缺陷检测的准确性. 上述缺陷图像分割方法仅在其研究对象上取得较好效果, 不具备通用性. 随着深度学习图像分割技术的发展, Chen等人[8]利用空洞卷积扩大感受野实现图像分割, 但该方法上下文图像特征获取能力有限. Wang等人[9]在图像分割网络中引入多个分支结构, 保留不同尺度特征信息, 但该方法模型和计算复杂性高. Liu等人[10]将Transformer引入图像分割, 增强编码的远程依赖, 不过缺乏低分辨率细粒度特征的提取. 综上所述, 现有的图像分割方法在特征提取及结构上存在局限性, 影响分割精度. 且对于边缘模糊、背景复杂的单片SOFC表面缺陷图像, 仍难以取得令人满意的效果. 由于EDRNet[11]在钢带表面缺陷分割中取得较好结果, 且与本文研究对象类似.

鉴于此, 本文基于EDRNet结构提出一种融合自注意力(fusion self-attention, FSA)的分割方法, 以实现背景噪声强干扰下的SOFC表面缺陷图像分割. 主要优势如下.

(1)该方法提出的FSA模块主要用于改进跳跃连接处, 以提升模型对特征的提取与传递.

(2) 提出多通道自注意力(multi-channel self attention, MCSA)模块, 用于增强通道间的特征联系, 同时使用分支结构及融合注意力机制, 多层次保留不同尺度的特征信息.

(3) 构建三元联合损失函数(triplet joint loss function, TJLF)对训练过程进行监督, 提升网络对像素级信息、前景结构及缺陷边界的理解能力.

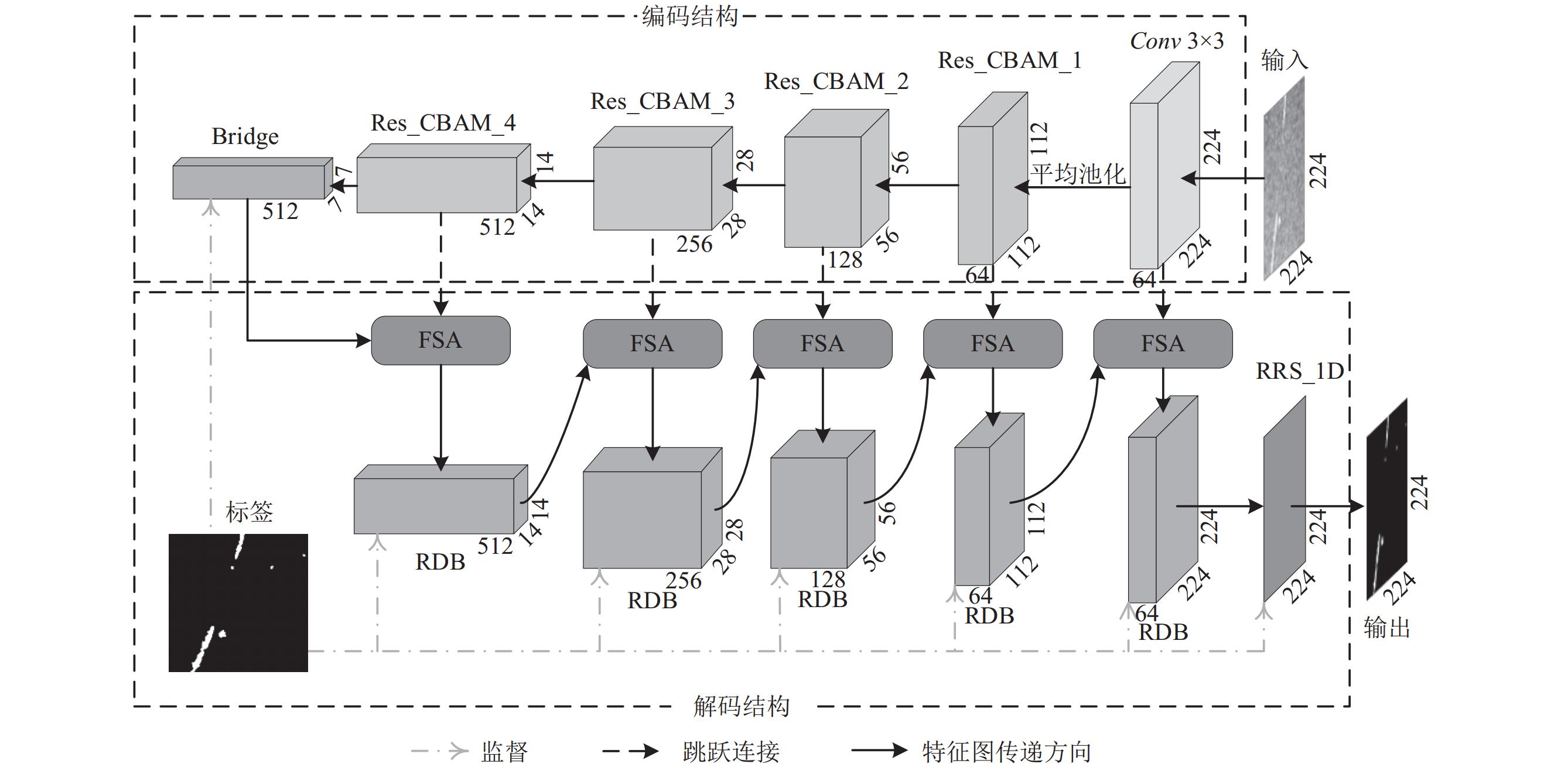

1 本文方法根据单片SOFC表面缺陷的多样性和随机性, 本文提出一种融合自注意力的SOFC表面缺陷图像分割方法. 本文方法网络结构如图1所示. 网络主要由输入、编码结构、解码结构及输出4个部分组成. 编码结构由3×3卷积、基于ResNet34框架的残差特征提取块(Res_CBAM)及Bridge模块[11]组成. 解码结构由FSA模块、残差解码块(residual decoder block, RDB)和一维滤波器的残差细化结构(residual refinement structure with 1D Filters, RRS_1D)组成. 同时, 本文构建三元联合损失函数, 在训练过程中使用标签对7个不同位置进行监督, 通过反向传播, 指导网络优化, 使模型更好的拟合SOFC表面缺陷图像.

首先输入SOFC表面缺陷图像, 经过3×3卷积得到尺度不变64通道的特征图. 再依次通过4个Res_CBAM, 进行特征深度提取. 除第1次通道数不变外, 每次都得到尺寸减半、通道翻倍的特征图. 其次利用Bridge模块连接编码结构和解码结构. 然后使用FSA模块实现与Res_CBAM模块的跳跃连接. 通过RDB模块进行特征图的压缩及分辨率的恢复. 最后, 利用RRS_1D实现特征图优化, 输出SOFC表面缺陷图像的二值分割结果.

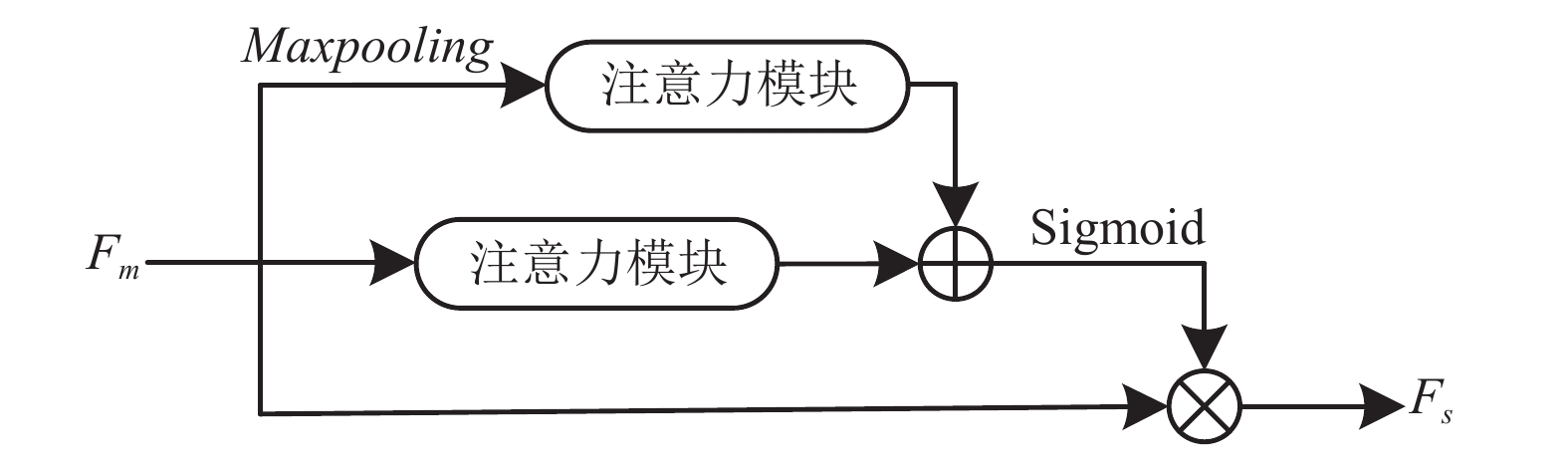

1.1 FSA模块常规通道注意力仅关注单通道间关系而忽略空间信息. 为此本文提出FSA模块, 如图2所示. 融合自注意力由MCSA通过注意力融合机制获得, 实现MCSA模块多尺度融合.

1.1.1 注意力融合注意力融合旨在解决特征融合尺度不统一的问题, 同时实现上下文本信息整合. 注意力融合机制如图3所示, 对于注意力融合模块的输入Fm, 分别经过全局最大池化后的注意力和未经全局最大池化的注意力. 通过扩展相加的方式将不同尺度的特征图进行融合. 然后对其使用Sigmoid函数, 最后与输入Fm进行残差相乘, 得到注意力融合输出Fs. 其中注意力模块可以是任意的注意力模块, 利用此分支结构可多尺度的保留特征信息.

|

图 1 SOFC表面缺陷图像分割网络结构图 |

|

图 2 FSA模块结构图 |

|

图 3 注意力融合模块 |

1.1.2 MCSA模块

MCSA结构如图4, 通过多个头的划分, 增强多个通道之间的联系, 有助于多个通道间的远程信息交互, 实现多通道间自我关联. FSA利用注意力融合机制, 多尺度的增强通道的表达能力, 同时抑制无关信息和噪声的干扰. MCSA定义如下.

| MCSA(I)=Conv1×1(σ(σ(Q×K√dk)×V)×I) | (1) |

其中,

|

图 4 MCSA模块结构图 |

MCSA模块由输入I、多通道交互计算和输出MCSA(I)组成. 首先, 将输入I的通道等分为由n个头组成的通道. 然后运用Transformer中远程交互的思想, 生成通道自注意力特征图. 将V与注意力特征图相乘, 使得每个头与其他头中的通道建立联系. 再对其使用Sigmoid激活函数, 与I进行残差连接. 最后, 经过1×1的卷积, 得到通道远程交互增强的输出MCSA(I).

FSA模块有两个输入X和Y, 如图2. 首先将X和Y在通道维度拼接得到特征图Fm, 其次通过最大池化获得不同尺度特征, 然后在不同尺度特征上利用多通道自注意力模块, 得到多尺度通道交互增强特征, 再使用残差连接得到Fs, 其定义为:

| Fs=Fm∗σ(MCSA(GMP(Fm))+MCSA(Fm)) | (2) |

其中, *表示特征图相乘, GMP(·)表示全局最大池化,

最后, 通过特征融合可以得到具有前馈联系的融合自注意力模块:

| FSA(X,Y)=X∗(1−σ(Fs))+Y∗σ(Fs) | (3) |

其中, FSA(X, Y)为输入X和Y经过MSCA模块后的输出.

1.2 三元联合损失函数SOFC表面缺陷图像中, 不同类型缺陷对应的图像呈现形式也不同, 存在不同种类缺陷区域数据不平衡及部分类型缺陷难以分割的问题. 为此, 本文构建三元联合损失函数LTJ对网络的训练过程进行监督, 以实现图像前景结构的感知和缺陷边界信息的学习, 其定义为:

| LTJ=LFocal+LIoU+LSSIM | (4) |

其中, LFocal、LIoU、LSSIM分别由式(5)–式(7)给出.

SOFC表面缺陷图像分割可以理解为背景和缺陷的二分类. 目前, 常用二元交叉熵损失(binary cross-entropy, BCE)对模型进行监督, 但此种方法不能有效平衡背景与缺陷区域数据[12], 造成负样本主导梯度. 本文使用焦点损失(focal loss, Focal)减轻简单样本的权重, 将训练过程的注意力集中在困难的负例样本上. 其定义为:

| LFocal=−∑(x,y)(1−P(x,y))γlog(P(x,y)) | (5) |

其中, P(x, y)分别表示标签在(x, y)处为缺陷时预测结果为缺陷的概率.

由于焦点损失是逐像素的, 且可能发生过拟合, 并不能对缺陷的边缘和结构起到良好的监督作用. 鉴于此, 本文引入了边界IoU损失和结构感知SSIM损失, 提升对缺陷边缘和结构的监督能力. IoU、SSIM损失分别定义为:

| LIoU=1−P∩GP∪G | (6) |

| LSSIM=1−(2μwμg+ξ1)(2σwg+ξ2)(μw+μg+ξ1)(σw+σg+ξ2) | (7) |

其中, P和G分别为预测结果和标签图像. w和g是分别从预测结果P和标签G相应位置裁剪下来的图像块, μw、μg和σw、σg分别为w和g的均值和方差, σwg是协方差. ξ1和ξ2为极小常数, 防止分母为0.

2 实验及结果分析本实验图像均来源于华中科技大学常州先进陶瓷智能传感技术研究院. 通过使用光学显微镜对SOFC单片电池缺陷图像采样. 共采集缺陷图像876张, 每张图像均包含1种或多种类型缺陷, 其中缺陷类型可分为裂纹、凹陷、划痕、压痕和其他. 邀请多位质量检测专家对图像中的缺陷进行标注, 缺陷标记为白色, 背景为黑, 以此方式制作标签. 为了降低训练过程中显存消耗, 图像统一裁剪为224×224像素, 得到SOFC表面缺陷数据集共

本实验采用 Python 环境下的 PyTorch 深度学习框架, 构建网络模型并完成实验. 所用服务器配置为 Intel(R) Xeon(R) Gold 6326 CPU @ 2.90 GHz, GPU 显卡配置为 NVIDIA GeForce RTX 3090, 操作系统为 Ubuntu 22.10. 在训练过程中, 先将每张图像的大小调整为256×256, 再将图像进行随机裁剪为224×224, 最后对数据进行归一化处理. 本实验采用He初始化策略来初始化残差特征提取块的参数. 设置epoch为150, 批大小batch_size为8, 使用RAdam优化器训练网络, 初始学习率设置为0.001, 衰减系数设置为0.9, 其他参数均为默认值.

2.1 模块消融及损失函数对比模块消融实验主要用于验证融合自注意力模块的有效性, 将FSA模块与原始EDRNet[11]中通道权重模块(channels weighted block, CWB)进行对比实验. CWB模块可以有效捕获特征区域及背景噪声的滤除, 但无法建立通道间的联系及通道的远程交互. 受到Tansformer中远程交互思想的启发, 考虑对通道间关系进行远程编码建模, 设计MCSA模块, 实现通道间信息的交互, 增强不同通道间特征的关联性. 此外, 通过多尺度注意力融合机制, 进一步增强多尺度通道特征表达. 同时, 采用平均绝对误差(mean absolute error, MAE)[13]、F1分数(F1-score)[14]、结构度量(struct measure, SM)[15]、IoU[12]、Pratt’s 品质因数(Pratt’s figure of merit, PFOM)[11]等评估指标, 客观评估各模块的分割性能.

由表1可知, 本文提出方法融合自注意力在各指标上均取得最优效果, 且单独使用FSA中的MCSA模块取得次优结果. 其中, 只有SM指标略低于原始CWB模块, 其余指标均优于CWB模块. 对于MAE指标, FSA较CWB下降5%, 表明每个像素点分割错误的概率降低. 此外, FSA模块在F1-score和IoU指标上取得较好的提升, 直观上反映FSA模块较好的分割性能. 融合自注意力模块在客观指标上的提升, 侧面反映增强通道间的远程交互及多尺度的特征提取, 有助于提升整个网络的分割性能.

| 表 1 模块消融对比 |

为了验证提出三元联合损失函数的有效性, 本文进行如表2所示的损失函数对比实验. 由表2可知, 单独使用Focal损失函数时, 各指标均取得较为均衡的结果. 而单独使用SSIM和IoU损失函数时, 只在其对应的SM和IoU指标上取得较好的分数. 此外, 将这3个损失函数两两结合使用, 得到综合性较好的结果. 如将Focal损失与IoU损失联合使用, 得到IoU分数较好其他指标均衡的结果. 因此, 考虑将三者联合提出LTJ损失函数. 经实验得出, 三元联合损失函数LTJ在各项指标上均表现出良好的监督性能.

| 表 2 不同损失函数在指标上的表现 |

2.2 各网络对比实验

为了能够公平合理的验证提出方法融合自注意力的有效性, 本文使用提出的SOFC表面缺陷数据集重新训练BASNet[16]、EDRNet[11]、Swin-Unet[17]、TransUNet[12]等分割网络, 并使用各网络的默认参数, 最后在测试集上进行对比验证. 各网络的分割结果如图5所示.

对于图5中的划痕、裂纹, 各网络均能分割出较明显的划痕, 图5(c)、图5(d)方法有一定的抗噪声干扰能力, 但缺乏对非显著特征的提取. 对于图5中的凹陷和压痕, 各网络均有不同程度的特征丢失, 受到背景噪声的干扰较大, 融合自注意力的分割方法展现出更强的背景噪声抑制能力. 相较于图5(c)、图5(d)、图5(e)、图5(f)方法, 本文方法的FSA模块对缺陷边缘的处理能力更强. 对于图5中的其他类型缺陷, 此种缺陷特征较为显著, 分割目标较小, 图5(c)、图5(f)方法表现出较强的细节保留能力. 图5(e)方法整体上缺乏对缺陷边缘特征的提取, 导致分割结果出现边缘模糊的问题. 直观上, 本文方法分割效果均优于比较模型, 对于较小的、非显著性缺陷图像, 分割结果更接近标签图像. 对于单片SOFC表面缺陷的随机性和多样性, 本文方法表现出较强的鲁棒性.

|

图 5 不同方法分割结果对比 |

由表3可知, 本文方法与现有分割方法Swin-Unet相比, 平均每像素差异降低了16.7%, F1-score、SM、IoU、PFOM分别提升了10.8%、7.6%、13.5%、18.33%, 反映出FSA模块在分割精度、缺陷对象感知及缺陷区域感知的卓越性能. 此外, 通过PFOM指标对缺陷的边缘进行定量评估, 说明提出方法在缺陷图像存在边缘模糊、难以界定时, 能更好地分割缺陷边缘.

| 表 3 不同方法在指标上的表现 |

2.3 缺陷图像分析

SOFC表面缺陷分割精度提高有利于对缺陷进行更准确的定量分析, 通过分割结果可容易得出单片SOFC表面缺陷数量、位置和大小等参数. 这些参数可作为单片SOFC评估的客观指标, 避免人眼的主观臆断, 进而提高质检效率及稳定性. 表4是对图5中分割结果进行缺陷的定量分析.

| 表 4 不同分割方法分割结果的定量分析 |

表4中, 缺陷数量可以体现缺陷的检出率, 而大小则反映缺陷的查全率. 显然, 本文方法不论是在缺陷数量还是缺陷大小占比结果上都取得与标签接近的值, 进一步说明缺陷图像分割的精度将影响缺陷的客观评估, 从而影响SOFC电池片检测人员对电池片质量的判断.

3 结论与展望围绕单片SOFC质量检测这一实际问题, 本文结合SOFC表面缺陷的特点, 提出一种融合自注意力的图像分割方法, 实现SOFC表面缺陷图像的自动分割. 通过分割结果, 能客观的获取SOFC表面缺陷的位置、形状和大小参数, 为后续的定量分析及生产工艺优化奠定基础. 实验结果表明, 提出方法在SOFC表面缺陷图像分割的有效性, 较现有方法能更好地对抗噪声干扰、保留细节和处理复杂缺陷的边缘, 有效提高分割精度. 但对于分割精度方面, 仍有较大改进空间, 主要由于本文使用数据集不同类型缺陷图像数量存在一定差异, 导致提出网络模型对不同类型缺陷特征的学习能力不一致, 最终影响对较少缺陷类型的分割精度. 此外, 编码-解码结构中编码部分特征提取能力与准确性, 也将影响最终的分割精度. 接下来的研究中, 将采集更多的SOFC表面缺陷图像, 尽可能减少不同类型缺陷图像的数量差异, 同时, 考虑到编码部分特征提取存在不足的问题, 将结合SOFC表面缺陷图像中存在部分缺陷与背景难以识别的特点, 增强编码部分的特征提取能力, 进一步提高低对比度, 复杂纹理缺陷图像的分割精度.

| [1] |

Peng JX, Zhao DQ, Xu YW, et al. Comprehensive analysis of solid oxide fuel cell performance degradation mechanism, prediction, and optimization studies. Energies, 2023, 16(2): 788. DOI:10.3390/en16020788 |

| [2] |

Raza T, Yang JJ, Wang RM, et al. Recent advance in physical description and material development for single component SOFC: A mini-review. Chemical Engineering Journal, 2022, 444: 136533. DOI:10.1016/j.cej.2022.136533 |

| [3] |

Salogni A, Colonna P. Modeling of solid oxide fuel cells for dynamic simulations of integrated systems. Applied Thermal Engineering, 2010, 30(5): 464-477. DOI:10.1016/j.applthermaleng.2009.10.007 |

| [4] |

Xiang Y, Zhong Z, Jiao ZJ. An adaptive thermo-mechanical peridynamic model for crack analysis in anode-supported solid oxide fuel cell. Journal of Power Sources, 2022, 547: 231998. DOI:10.1016/j.jpowsour.2022.231998 |

| [5] |

Youkachen S, Ruchanurucks M, Phatrapomnant T, et al. Defect segmentation of hot-rolled steel strip surface by using convolutional auto-encoder and conventional image processing. Proceedings of the 10th International Conference of Information and Communication Technology for Embedded Systems (IC-ICTES). Bangkok: IEEE, 2019. 1–5. [doi: 10.1109/ICTEmSys.2019.8695928]

|

| [6] |

Qi HC, Cheng L, Kong XW, et al. WDLS: Deep level set learning for weakly supervised aeroengine defect segmentation. IEEE Transactions on Industrial Informatics, 2024, 20(1): 303-313. DOI:10.1109/TII.2023.3261889 |

| [7] |

Chen ZW, Wong WK, Zhong ZF, et al. Effective transfer of pretrained large visual model for fabric defect segmentation via specifc knowledge injection. arXiv:2306.16186, 2024.

|

| [8] |

Chen L C, Zhu YK, Papandreou G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 833–851. [doi: 10.1007/978-3-030-01234-2_49]

|

| [9] |

Wang JD, Sun K, Cheng TH, et al. Deep high-resolution representation learning for visual recognition. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(10): 3349-3364. DOI:10.1109/TPAMI.2020.2983686 |

| [10] |

Liu Z, Lin YT, Cao Y, et al. Swin Transformer: Hierarchical vision Transformer using shifted windows. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 9992–10002. [doi: 10.1109/iccv48922.2021.00986]

|

| [11] |

Song GR, Song KC, Yan YH. EDRNet: Encoder-decoder residual network for salient object detection of strip steel surface defects. IEEE Transactions on Instrumentation and Measurement, 2020, 69(12): 9709-9719. DOI:10.1109/TIM.2020.3002277 |

| [12] |

Chen JN, Lu YY, Yu QH, et al. TransUNet: Transformers make strong encoders for medical image segmentation. arXiv:2102.04306, 2024.

|

| [13] |

Wu YH, Liu Y, Zhang L, et al. EDN: Salient object detection via extremely-downsampled network. IEEE Transactions on Image Processing, 2022, 31: 3125-3136. DOI:10.1109/TIP.2022.3164550 |

| [14] |

Xiao M, Yang B, Wang SL, et al. Fine coordinate attention for surface defect detection. Engineering Applications of Artificial Intelligence, 2023, 123: 106368. DOI:10.1016/j.engappai.2023.106368 |

| [15] |

Wang ZY, Zhang YZ, Liu Y, et al. TF-SOD: a novel Transformer framework for salient object detection. Neural Computing and Applications, 2022, 34(14): 11789-11806. DOI:10.1007/s00521-022-07069-9 |

| [16] |

Qin XB, Zhang ZC, Huang CY, et al. BASNet: Boundary-aware salient object detection. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 7471–7481. [doi: 10.1109/CVPR.2019.00766]

|

| [17] |

Cao H, Wang YY, Chen J, et al. Swin-Unet: Unet-like pure Transformer for medical image segmentation. Proceedings of the 2022 European Conference on Computer Vision. Tel Aviv: Springer, 2022. 205–218. [doi: 10.1007/978-3-031-25066-8_9]

|

2024, Vol. 33

2024, Vol. 33