2. 南京邮电大学 计算机学院、软件学院、网络空间安全学院, 南京 210023;

3. 南京航空航天大学, 南京 211106;

4. 南京邮电大学, 南京 210023

2. School of Computer Science, Nanjing University of Posts and Telecommunications, Nanjing 210023, China;

3. Nanjing University of Aeronautics and Astronautics, Nanjing 211106, China;

4. Nanjing University of Posts and Telecommunications, Nanjing 210023, China

三维点云目标分类技术是构建三维世界感知框架的基础, 在自动驾驶、智能机器人、增强现实等诸多领域得到广泛运用. 大多数基于深度学习的点云目标分类技术[1–5]都要在获得所有训练数据后进行离线训练, 要求数据集满足独立同分布的条件. 然而, 由于三维点云数据的迭代增长和三维应用需求的不断扩展, 现实场景中数据通常是按次序分批到达, 并且不同批次数据的分布存在差异. 对此, 常规方法需要在每个批次数据到达时, 联合所有批次的数据重新训练, 以提升模型的能力, 但是联合训练面临着巨大的计算资源消耗. 此外, 物理内存大小的限制、数据隐私安全的制约等因素会导致过去批次的完整数据不可重用. 因此, 如何在数据访问受限且分批到达的场景下完成训练任务是现实应用中亟待解决的问题.

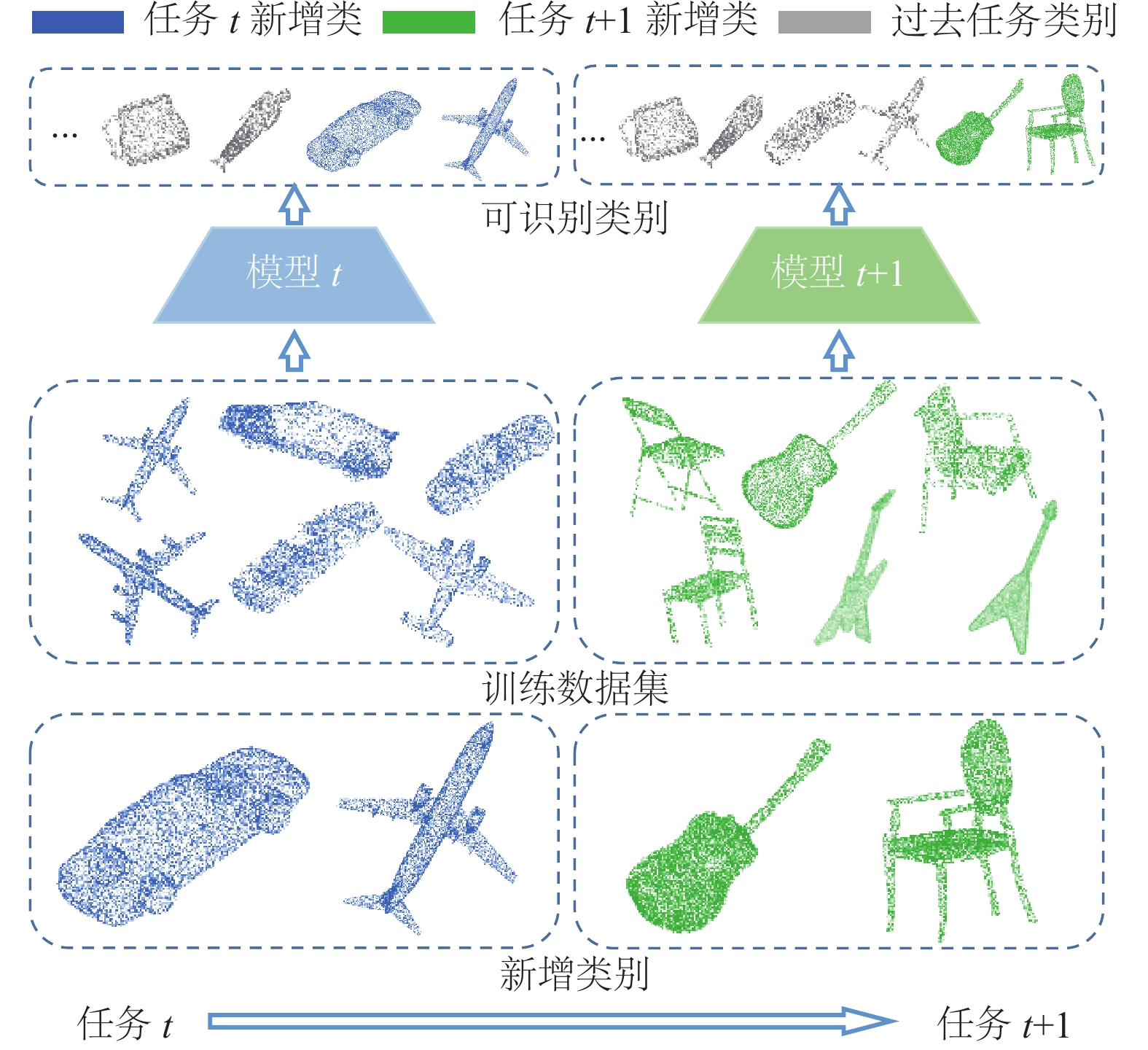

为了缓解过去批次数据访问受限造成的灾难性遗忘[6]问题, 增量学习设计渐进式学习的人工神经网络去模拟人类认知系统[7]. 具体而言, 就是通过模型结构和训练策略的设计, 防止神经网络在内容不同的新批次数据上学习新知识时忘记旧数据上学习的旧知识. 在自然图像理解领域, 大量的增量学习工作[8–11]已经取得了巨大的成功. 近些年, 三维点云增量学习也逐渐得到关注. L3DOC[12]首次将点云目标分类和增量学习相结合, 将深度网络逐层解耦为负责旧知识的点知识部分和负责新知识的任务特异部分, 特定的更新策略使模型学习达到较好的可塑性-稳定性的平衡[13]. 其后, 一些工作关注增量学习中更加困难的类增量学习问题, 即新批次中仅包含新类别数据, 其过程如图1所示. 其中, I3DOL[14]使用局部质心重构模块自适应地选择特征学习过程中局部感知的区域, 以缓解点云类增量学习过程中的表征不规则问题. RCR[15]提出了点云随机压缩回放, 仅用极小的内存代价保留了用于回放的旧样例集, 并引入重建损失作为正则项约束模型优化.

|

图 1 点云目标分类的类增量学习过程示意图 |

尽管上述方法通过设计复杂的点云网络结构和旧样例回放方法推动了点云类增量学习的发展, 但仍存在不足. 如图2, iCaRL[8]和I3DOL在最后增量阶段对旧类目标分类错误, 产生遗忘现象的原因是类别增量后的学习阶段本质上是一个新旧类样本不平衡的学习过程.

|

图 2 不同方法的关注点示例图 |

该过程中新类训练样本远多于旧样例, 使模型过拟合于新类特征, 而对旧类特征的关注不足, 最终造成新旧类特征缺少区分度, 模型易于将旧类混淆为新类.

因此, 要缓解类增量学习中的灾难性遗忘问题, 关键在于缓解对新类的学习偏好问题. 首先, 是要增强点云特征学习过程中对局部差异性特征的辨别能力. 由于点云数据仅包含三维坐标, 没有纹理等信息, 因此点云分类主要依赖于局部结构信息. 例如, 图2中吉他琴头等有代表性的局部结构包含差异性特征, 有利于类别区分. 而平面等广泛存在于各类目标中的局部结构则对应类别信息较少的相似性特征. 然而, 不平衡的样本数量意味着旧类即使分类错误带来的惩罚也极小, 使新类与旧类特征趋向相似性局部结构. 所以, 为了捕获有区分度的特征, 应当去关注类别表征明显的差异性局部结构. 其次, 旧类信息的不足直接导致了偏好问题加剧, 尽管通过回放旧样例集可以直接回顾到旧类知识, 但是有限的缓存大小使各个旧类的可重用样本数量被不断压缩, 导致各类的旧信息不断减少, 并且这种非结构化知识的质量依赖于精心设计的旧样例集选择策略, 所以此单一来源的旧知识无法满足长期的增量学习过程. 而旧知识不仅存在于旧样例集中, 也以更加结构化、抽象化的形式存在于过去阶段的旧模型[10]之中. 所以, 提炼旧模型中的结构化知识进行多源知识补充是增加旧类信息的可行方案.

针对上述问题, 本文提出了双重特征增强的三维点云类增量学习方法(dual feature enhancement for class-incremental 3D point cloud object learning, DFE3D).

DFE3D设计了对于不同局部结构进行区别关注的差异性局部增强模块(discriminative local enhancement, DLE), 通过增强差异性局部特征的感知能力, 缓解新旧类特征区分度不足的问题. 并且, 在回放的基础上设计了知识注入网络(knowledge injection network, KIN), 将旧模型中的旧知识以高维特征的形式直接融合到新阶段模型中, 以缓解旧类信息不足造成的新类偏好加剧. 具体而言, DLE分别编码点云数据各局部的特征信息与空间信息, 通过对两个层次的信息进行融合获得点云数据中丰富的局部语义特征. 同时, 通过各局部在全局中的高维特征信息自适应地引入了各局部结构的重要性权重, 强化对差异性结构的感知并减小相似性结构引入的冗余信息干扰, 扩大不同类别目标间的特征区分度. 随后, KIN将新增模型分支作为适应新批次数据的可塑性分支, 同时将旧模型作为稳定性分支, 自适应地生成旧知识注入可塑性分支中, 形成增强后的混合知识特征来缓解知识来源单一的特征造成的旧类信息短缺问题, 进一步缓解新类的偏好现象. 本文设计了多个三维点云类增量学习的实验方案, 并且与通用类增量学习方法和三维点云类增量学习方法进行对比, 验证了DFE3D的有效性. 消融实验也验证了DFE3D中两个模块的有效性. 本文的主要贡献可以概括为以下3点.

● 针对数据访问受限且分批次到达的现实场景下的三维点云目标分类任务, 提出了双重特征增强的三维点云类增量学习方法, 通过增加差异性局部结构的辨识度和利用多源旧类知识来缓解点云类增量学习过程中产生的灾难性遗忘.

● 设计了差异性局部增强模块去感知差异性局部结构信息并且减少冗余的相似性局部结构信息干扰, 缓解增量学习过程中的点云新旧类特征辨识度不足的问题.

● 设计了知识注入网络, 在新模型分支作为可塑性分支的基础上, 引入了旧模型构成的稳定性分支进行旧知识的结构化注入, 通过多源知识补充缓解了旧类信息不足而加剧的新类偏好问题.

1 相关工作 1.1 点云目标分类点云目标分类任务的一个挑战在于点云数据固有的置换不变性和不规则性. 对此, 点云目标分类方法大体可以分为以下3类: 第1类基于投影[1,16], 这类方法将三维点云投影成多视角的二维图像, 然后使用二维卷积网络去分析不同视角间的特征关联性. 第2类方法基于体素[2,17], 这类方法体素化三维点云, 然后使用三维卷积处理规则的体素表示. 一些方法[18,19]使用稀疏卷积来缓解体素化后由于点云稀疏性引起的数据利用低效问题. 然而, 基于投影或体素的方法引入了中间表征, 在点云数据处理的过程中不可避免会遭受信息损失. 因此, 第3类基于点的方法在近些年发展迅速, 这类方法直接对原始点云数据进行处理. PointNet[3]首先提出使用共享的多层感知机(multi-layer perceptron, MLP)单独对每个点的特征处理, 随后聚合形成全局特征. 由于点云数据的局部结构语义丰富, PointNet++[4]在PointNet的基础上设计了分层结构, 并对点云局部结构进行逐层编码. 之后工作为了进一步探索点云局部结构中的语义特征, 设计了基于图[20,21]和基于卷积[5,22]的方法提升点云局部特征提取的能力. 近年来, 一些受Transformer启发的方法[23,24]将注意力机制使用到局部或全局中点关系的建模中, 成为基于点的方法发展的趋势. 尽管这些方法在获得所有数据时表现优秀, 但是在多任务或多阶段的现实场景任务中性能会快速下降, 产生灾难性遗忘.

1.2 类增量学习类增量学习严格定义新批次的数据类别与之前所有批次数据类别不重叠, 在增量学习3大场景[7]中最具有挑战性, 近年来受到广泛关注. 类增量学习方法可以分为无记忆和基于回放的方法.

无记忆的方法不需要在增量学习过程中维护一个额外的旧样例集. 一些方法[9,25]引入额外的正则项对模型参数和超参数的更新过程进行限制, 从而防止旧知识的快速遗忘. 另外一些方法[26,27]通过生成模型或预训练模型取代内存缓冲区, 将生成信息或提示信息用于新阶段的学习. 这些无记忆的方法受到的限制小, 但是由于多阶段增量时正则约束力逐渐减弱、生成模型训练困难和提示设计困难等原因, 表现逊色于基于回放的方法.

基于回放的方法保留当前阶段之前所有批次数据的子集作为旧样例集, 在后续的增量过程重用旧样例集来帮助网络回忆旧类知识, 从而缓解灾难性遗忘. iCaRL[8]首先提出使用适量的内存保留旧样例集, 随后使用知识蒸馏[28]来利用过去模型约束新类的特征学习, 并且使用最近类均值分类器替代全连接层分类器和利用羊群算法更新旧样例集, 随后的方法在此工作流程上进行了改进. 文献[29]提出了新旧类数据不平衡会引起新类偏好问题, 并重新训练一个分类器权重修正器来缓解. 之后, 一些工作[30–33]针对缓解新类偏好问题进行了研究. 另外, 一些工作[34–36]针对旧样例集的更新进行研究. GSS[35]以参数梯度为特征, 通过最小化固定角约束提高旧样例集多样性. GCR[36]根据模型参数关于过去数据上的梯度维护一个核心集. 一些工作[10,37,38]通过采用不同的知识蒸馏变体, 利用旧模型参数中的旧知识约束新模型优化. GeoDL[37]利用不同特征构造低维流形, 并最小化测地路径上流形间的差异. CSCCT[38]提出跨空间聚类和控制迁移分别扩大类间差异和约束类间的特征传输. 这些方法尝试设计通用的类增量学习方法, 可以简单并有效地迁移到不同模态下的数据上. 但是, 由于点云目标通常存在噪声和不规则性, 这些方法无法感知有利于防止灾难性遗忘的几何特征. 同时, 基于动态架构[39]和Transformer的方法[40]发展迅速, 但是由于点云领域的网络设计与二维领域存在差异, 该类方法难以迁移到点云类增量学习领域.

因此, 点云类增量学习近年来逐渐受到关注. I3DOL[14]方法使用局部质心重构模块和注意力机制动态地感知局部特征, 并通过数据统计信息来缓解偏好问题. 但是该方法依赖质心的重构质量, 并且统计信息生成的全局协调项会受到达类别顺序影响, 在增量过程中表现不稳定. RCR[15]方法保留降采样后的点云作为旧样例集, 并且使用重建损失来作为正则项, 防止潜在特征对新数据的过度拟合. 但是, RCR方法的性能受限于重建分支的表现, 并且需要保留所有样本的降采样数据, 在数据严格保密的场景下无法应用. 区别于先前的方法, 本文提出的DFE3D方法不需要额外保存统计信息和所有的点云数据, 仅通过双重的特征增强策略来最大限度地平衡类增量学习过程中的可塑性-稳定性.

2 方法 2.1 问题定义和方法概要本文研究点云类增量学习问题. 假设点云数据分批次到达, 即需要按次序处理一系列独立的点云任务

本文提出了双重特征增强的三维点云类增量学习方法(DFE3D), 其结构如图3. 首先使用点云编码器处理原始点云输入, 得到编码后的特征信息和空间信息. 随后, 差异性局部增强模块(第2.2节)的局部邻域特征提取操作表征出语义丰富的局部特征, 全局感知的重要性评估操作对差异性结构和相似性结构进行区别感知, 强化对差异性结构的关注. 编码器和差异性局部增强模块共同构成该网络的特征提取部分

|

图 3 DFE3D方法总览图 |

2.2 差异性局部增强

常规点云目标分类方法[4,5]通过复杂的点对设计提取局部语义, 但忽视了各局部结构的差异化感知, 受新旧类数据不均衡导致的新类偏好问题影响较大, 在类增量学习场景中会迅速丧失对旧类的特征感知能力. 对此, 为了区别感知差异性局部特征和冗余的相似性局部特征, 以使点云局部特征学习适应点云类增量学习场景, 本文提出了差异性局部增强模块(DLE), 其主要思路为: 局部邻域特征提取操作分别处理局部的特征信息和空间信息, 融合以获得丰富的局部特征. 全局感知的重要性评估操作根据每个局部在全局中的特征自适应地生成重要性权重, 根据每个局部对于点云目标的重要性以差异化地关注不同局部特征.

首先局部邻域特征提取操作分别从每个局部结构的空间信息与特征信息中表征出每个局部的几何关系与特征关系, 将其自适应地融合, 从而明确点云数据中每个局部结构的特性. 假设编码器的输出

对于局部空间信息, 为了获得更丰富的空间信息特征, 根据给定的锚点坐标

| ˆPi=MaxPooling(MLP(ˆpi,1,ˆpi,2,⋯,ˆpi,k)) | (1) |

其中,

| ˆpi,j=concat(‖pi−pi,j‖,pi,pi,j,pi−pij) | (2) |

其中,

对于局部特征信息, 通过利用锚点

| ^Fi=MaxPooling(α⊙(ˆfi,1,ˆfi,2,⋯,ˆfi,k)+β) | (3) |

其中,

为了减少信息间的差异, 使空间信息与特征信息可以更好地融合, 引入一个可学习的参数在通道维度放缩空间信息, 操作如下:

| Filocal=ω⊙ˆPi+ˆFi | (4) |

其中,

尽管局部邻域特征提取操作提取出输入点云中丰富的局部特征, 但是该过程是逐点的特征增强, 没有下采样阶段, 存在冗余的局部结构信息干扰类别辨识. 为了突出点云差异性局部结构, 使用全局感知的重要性评估部分通过每个局部的全局信息评估每个局部对于该目标类别分辨的重要性, 并通过生成的重要性权重自适应地给予不同局部结构差异性的关注.

由于

| Figlobal=MLP(pi) | (5) |

其中,

随后, 将全局特征以逐通道的注意力形式融合到之前提取出的局部特征中, 形成全局感知后每个局部的特征, 融合后的特征送入一个映射函数得到逐通道的重要性权重, 根据映射后的重要性权重, 调整对各局部特征的关注程度. 具体操作如下:

| Fifinal=γ(Filocal⊙Figlobal)⊙Filocal | (6) |

其中,

DLE加强了对点云实例中差异性局部结构的感知, 一定程度上缓解了点云特征中的新类拟合现象, 但仍存在旧类信息不足的问题. 单分支网络在类增量学习过程中依赖旧样例集进行旧类特征学习. 但是由于缓存大小有限, 各旧类保存的样本数量随着增量过程不断被压缩, 对新类特征的拟合逐渐加剧, 所以单一来源的旧信息很难指导多阶段的增量过程.

为了解决这个问题, 知识注入网络(KIN)引入了过去阶段旧模型来指导当前阶段的特征学习. KIN将原单分支网络扩展为双分支网络, 由可塑性分支和稳定性分支共同构成. 其中, 可塑性分支即为新增模型分支, 负责充分学习当前训练数据的特征信息, 最大限度地拟合当前可用数据. 稳定性分支由过去阶段学习到的旧模型构成, 自适应地提供旧模型中结构化的旧知识. 最后, 通过将稳定性分支的旧知识注入当前的可塑性分支中, 形成增强后的双重知识特征送入分类器进行学习和预测.

由于过去阶段的知识已经作为高度抽象的高维信息存在于过去阶段的旧模型中, 随意地改动都会让结构化信息受到破坏. 在阶段

| hstab=Φ′t−1(x);hplas=Φt(x) | (7) |

其中,

为了在注入旧知识后获得更加紧凑的特征表示, 并最小化对稳定性旧知识的影响, KIN引入了一个稳定性特征修正系数, 动态地调整稳定性分支. 具体公式如下:

| hmix=λ⊙hstab+hplas | (8) |

其中,

针对输入的点云

| Ltcls(x,y)=−Kt∑k=1δk=ylog(ck(x)) | (9) |

其中,

算法1. DFE3D算法的训练流程(第t阶段)

输入: 训练数据

// 编码器和差异性局部增强模块共同构成

输出:

1) 初始化:

2) 参数冻结:

3) for epochs do

for

计算分类损失

End for

End for

4) 使用随机采样策略更新获得旧样例集

为了验证双重特征增强的三维点云类增量学习方法(DFE3D)的有效性, 本文分别在两个合成点云分类数据集ModelNet40[41]、Shape-Net[42], 两个真实室内场景下的点云分类数据集ScanObjectNN[43]、ScanNet[44]上与通用类增量学习方法和三维点云类增量学习方法进行对比. 此外, 本文的消融实验评估了差异性局部增强模块(DLE)和知识注入网络(KIN)的有效性.

3.1 实验设置 3.1.1 对比方法由于点云类增量学习相关工作较少, 并且一些在二维图像上进行实验的类增量学习方法并不依赖于图像特性, 旨在设计通用的类增量学习方法, 可以简单有效的迁移到各种模态下. 所以, 本文将DFE3D方法与通用类增量学习方法和三维点云类增量学习方法进行对比. 本文选择了9个先进的基于回放的通用类增量学习方法, 包括iCaRL[8]、BiC[29]、WA[30]、GDumb[34]、LUCIR[31]、SS-IL[32]、GeoDL[37]、CSCCT[38]和CafeBoost[33]. 同时, 点云类增量学习方法中, 考虑到数据回放策略的公平性, 本文选择I3DOL[14]进行对比. 对于每个方法的旧样例集采样方法, iCaRL、LUCIR、GeoDL、CSCCT和CafeBoost方法选择羊群采样策略, 而其他方法采用随机采样策略.

3.1.2 数据集本文实验选用两个合成点云数据集和两个室内场景下的点云数据集. 其中, ModelNet40是通过对三维CAD模型的表面进行随机点采样得到合成数据集, 包含了40个常见类别, 有

参考类增量学习中最常用实验场景CIFAR100-B0[8], 本文将在以下4个实验场景下进行测试: 1) ModelNet40-B0: 将40个类别平均划分为10个增量阶段, 每个阶段新增4个新类别的数据, 固定保留样本上限为800个样本. 2) ScanObjectNN-B0: 将15个类平均划分为5个增量阶段, 每个阶段新增3个新类别的数据, 固定保留样本上限为600. 3) ScanNet-B0: 将17类划分为6个增量阶段, 每个阶段新增3个新类别的数据, 最后一个增量阶段新增2类, 固定保留样本上限为600. 4) ShapeNet-B0: 将55个类划分为9个增量步骤, 每个阶段新增6个新类别的数据, 最后1个增量阶段新增7类, 固定保留样本上限为

实验中评价指标为Top-1平均增量准确率[7], 其定义为所有增量阶段的Top-1增量准确率的平均值, 以反映方法的综合增量性能表现. 其中, 每个阶段的Top-1增量准确率是在包含当前阶段所有已知类别的点云测试数据集上测得的Top-1分类准确率, 反映不同阶段模型的增量性能, 具体公式如下:

| Accavg=T∑iAcciT | (10) |

其中,

本文的实验部署平台为PyTorch, 运算平台为搭载NVIDIA GeForce RTX 3090 GPU的服务器. 本文所有方法的编码器使用PointNet[3]网络. 训练过程优化器选择Adam, 初始学习率为0.01, batchsize为32, 每个增量阶段训练120轮, 并在58和96轮时, 将学习率降为之前的0.1倍.

3.2 定量对比实验结果表1–表4分别报告了ModelNet40-B0、ScanObjectNN-B0、ScanNet-B0、ShapeNet-B0上的结果. 实验显示各阶段已知类别数, 并列出各阶段的增量准确率, 加粗代表最优效果,

| 表 1 ModelNet40-B0实验场景上的定量对比实验和消融实验结果(%) |

| 表 2 ScanObjectNN-B0实验场景上的定量对比实验和消融实验结果(%) |

3.3 消融实验结果

为了验证DFE3D方法中DLE模块和KIN的有效性, 本文在ModelNet40-B0、ScanObjectNN-B0、ScanNet-B0、ShapeNet-B0上进行了消融实验, 如表1–表4所示, DFE3D w/o DLE和DFE3D w/o KIN分别代表DFE3D方法在没有DLE模块和KIN时的性能表现. 与DFE3D方法相比, DFE3D w/o DLE缺少了增量学习过程中针对点云数据本身特性的设计, 未差异化地对待点云局部特征, 导致其在4个实验场景下的性能分别下降4.94%、4.13%、2.48%、3.50%, 反映了DLE模块在类增量学习中对于DFE3D方法特征感知部分的重要性. 即便DFE3D w/o DLE中存在旧模型中旧知识的特征注入, 但性能下降仍然严重, 反映出知识注入网络最终的作用受稳定性分支所提供旧知识质量的影响. DFE3D w/o KIN是仅利用DLE模块的单分支网络用于点云类增量学习过程, 由于缺少额外的模型旧知识的注入, 最终在各个实验场景下的性能下降3.06%、3.71%、1.84%、2.38%, 反映了KIN的设计引入的多源知识对于点云类增量学习的有效性.

| 表 3 ScanNet-B0实验场景上的定量对比实验和消融实验结果(%) |

| 表 4 ShapeNet-B0实验场景上的定量对比实验和消融实验结果(%) |

3.4 增量任务数量的定量分析

为了验证DFE3D方法在增量任务数量不同时的性能表现, 本文在3个实验场景下进行实验, 并在图4中展示结果. 其中, 图4(a) ModelNet40-B0-20 steps将ModelNet40数据集划分为20个任务, 每个任务新增2类数据; 图4(b) ScanObjectNN-B0-7 steps将ScanObjectNN数据集划分为7个任务, 每个任务新增2类数据, 最后任务新增3类数据; 图4(c) ShapeNet-B0-18 steps将ShapeNet数据集划分为18个任务, 每个任务新增3类, 最后任务新增4类数据.

|

图 4 不同增量任务数量时的定量分析 |

如图4(a)所示, DFE3D方法在前8个增量任务下性能表现一般, 但是后续的增量任务中, 各个对比方法由于难以平衡多阶段增量过程中的可塑性和稳定性, 与DFE3D方法的差异逐渐显现. DFE3D的增量准确率均优于对比方法, 性能曲线也保持平稳, 且最后阶段的性能指标也保持最优. 验证了即使在面对更多的增量任务时, DFE3D方法依旧能很好地缓解点云类增量学习过程中的灾难性遗忘. 同时, 在另外两个实验场景图4(b)和图4(c)中也存在着和图4(a)一样的现象, DFE3D都能够完成多阶段点云类增量学习任务, 进一步验证了DFE3D方法在更多任务增量情景下的广泛适用性.

3.5 不同的旧样例集容量大小的定量分析为了进一步研究旧样例集大小对DFE3D方法的影响, 本实验在ScanObjectNN-B0实验场景下, 将旧样例集容量大小从600个实例分别调整为300和900个实例, 并进行实验测试. 如图5所示, 各方法在点云类增量学习过程中对旧样例集容量都较为敏感, 在容量从900下降到300时, 各方法自身的平均增量准确率下降6.52%–9.64%, 说明回放策略对于点云类增量学习的重要性. 尽管如此, DFE3D在旧样例集容量为300和900时, 对比其他方法仍然有较好的性能表现, 分别在平均增量准确率上提升了1.28%和1.76%. 验证了DFE3D方法对于过去旧信息利用的合理性.

|

图 5 不同旧样例集大小的定量分析 |

3.6 不同的增量类别顺序的定量分析

为了进一步验证DFE3D在增量过程中的鲁棒性, 本实验测试按次序到达的数据的类别变化对各方法的影响. 在ScanObjectNN-B0实验场景下, 将15个类别的到达顺序随机打乱, 并且重新划分为5个增量任务. 如表5所示, 加粗代表最优结果,

| 表 5 ScanObjectNN-B0实验场景上不同增量类别顺序下的对比实验(%) |

4 结论与展望

本文提出了双重特征增强的三维点云类增量学习方法, 使点云目标分类技术能够适应新类数据分批到达的现实场景. DFE3D方法的差异性局部增强模块提取点云数据局部的特征信息与空间信息以获得丰富的局部结构特征, 并且通过全局感知的重要性评估操作突出差异性局部区域, 扩大了新旧类特征间的区分度. 同时, 知识注入分支将额外的旧模型知识结构化地注入模型的可塑性分支中, 以混合知识特征缓解单一知识来源造成旧类信息不足问题. 多个数据集上的对比实验证明了本文方法的有效性, 消融实验验证了该方法两个模块的有效性. 实验还证明了该方法在更多增量任务时的稳定性, 对旧样例集容量和增量类别顺序的鲁棒性. 然而, 本文专注于类增量场景下的三维点云目标分类任务, 仍然存在着任务场景上的局限. 在未来的工作中, 我们将进一步探索增量式的点云目标检测、语义分割等三维场景理解任务.

| [1] |

Hamdi A, Giancola S, Ghanem B. MVTN: Multi-view transformation network for 3D shape recognition. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 1–11.

|

| [2] |

Riegler G, Osman Ulusoy A, Geiger A. OctNet: Learning deep 3D representations at high resolutions. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 6620–6629.

|

| [3] |

Qi CR, Su H, Mo KC, et al. PointNet: Deep learning on point sets for 3D classification and segmentation. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 77–85.

|

| [4] |

Qi CR, Yi L, Su H, et al. PointNet++: Deep hierarchical feature learning on point sets in a metric space. Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach: Curran Associates Inc., 2017. 5105–5114.

|

| [5] |

许翔, 帅惠, 刘青山. 基于卦限卷积神经网络的3D点云分析. 自动化学报, 2021, 47(12): 2791-2800. |

| [6] |

McCloskey M, Cohen NJ. Catastrophic interference in connectionist networks: The sequential learning problem. Psychology of Learning and Motivation, 1989, 24: 109-165. |

| [7] |

周大蔚, 汪福运, 叶翰嘉, 等. 基于深度学习的类别增量学习算法综述. 计算机学报, 2023, 46(8): 1577-1605. |

| [8] |

Rebuffi SA, Kolesnikov A, Sperl G, et al. iCaRL: Incremental classifier and representation learning. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 5533–5542.

|

| [9] |

Kirkpatrick J, Pascanu R, Rabinowitz N, et al. Overcoming catastrophic forgetting in neural networks. Proceedings of the National Academy of Sciences of the United States of America, 2017, 114(13): 3521-3526. |

| [10] |

Douillard A, Cord M, Ollion C, et al. PODNet: Pooled outputs distillation for small-tasks incremental learning. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 86–102.

|

| [11] |

张子颖, 王敏. 基于Faster R-CNN和增量学习的车辆目标检测. 计算机系统应用, 2020, 29(2): 181-186. DOI:10.15888/j.cnki.csa.007259 |

| [12] |

Liu YY, Cong Y, Sun G, et al. L3DOC: Lifelong 3D object classification. IEEE Transactions on Image Processing, 2021, 30: 7486-7498. DOI:10.1109/TIP.2021.3106799 |

| [13] |

Grossberg S. Consciousness CLEARS the mind. Neural Networks, 2007, 20(9): 1040-1053. DOI:10.1016/j.neunet.2007.09.014 |

| [14] |

Dong JH, Cong Y, Sun G, et al. I3DOL: Incremental 3D object learning without catastrophic forgetting. Proceedings of the 35th AAAI Conference on Artificial Intelligence. AAAI, 2021. 6066–6074.

|

| [15] |

Zamorski M, Stypułkowski M, Karanowski K, et al. Continual learning on 3D point clouds with random compressed rehearsal. Computer Vision and Image Understanding, 2023, 228: 103621. DOI:10.1016/j.cviu.2023.103621 |

| [16] |

Wei X, Yu RX, Sun J. Learning view-based graph convolutional network for multi-view 3D shape analysis. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2023, 45(6): 7525-7541. DOI:10.1109/TPAMI.2022.3221785 |

| [17] |

Wang PS, Liu Y, Guo YX, et al. O-CNN: Octree-based convolutional neural networks for 3D shape analysis. ACM Transactions on Graphics, 2017, 36(4): 72. |

| [18] |

Graham B, Engelcke M, van der Maaten L. 3D Semantic segmentation with submanifold sparse convolutional networks. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 9224–9232.

|

| [19] |

Choy C, Gwak JY, Savarese S. 4D Spatio-temporal ConvNets: Minkowski convolutional neural networks. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 3070–3079.

|

| [20] |

孟繁林, 何晓曦, 刘应浒, 等. 基于自注意力机制的点云分类分割. 计算机系统应用, 2024, 33(1): 177-184. DOI:10.15888/j.cnki.csa.009341 |

| [21] |

Wang Y, Sun YB, Liu ZW, et al. Dynamic graph CNN for learning on point clouds. ACM Transactions on Graphics, 2019, 38(5): 146. |

| [22] |

Xu MT, Ding RY, Zhao HS, et al. PAConv: Position adaptive convolution with dynamic kernel assembling on point clouds. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 3172–3181.

|

| [23] |

Zhao HS, Jiang L, Jia JY, et al. Point Transformer. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 16239–16248.

|

| [24] |

Liu YH, Tian B, Lv YS, et al. Point cloud classification using content-based Transformer via clustering in feature space. IEEE/CAA Journal of Automatica Sinica, 2024, 11(1): 231-239. DOI:10.1109/JAS.2023.123432 |

| [25] |

Dhar P, Singh RV, Peng KC, et al. Learning without memorizing. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 5133–5141.

|

| [26] |

Gao QK, Zhao C, Ghanem B, et al. R-DFCIL: Relation-guided representation learning for data-free class incremental learning. Proceedings of the 17th European Conference on Computer Vision. Tel Aviv: Springer, 2022. 423–439.

|

| [27] |

Smith JS, Karlinsky L, Gutta V, et al. CODA-Prompt: COntinual decomposed attention-based prompting for rehearsal-free continual learning. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE, 2023. 11909–11919.

|

| [28] |

Hinton G, Vinyals O, Dean J. Distilling the knowledge in a neural network. arXiv:1503.02531, 2015.

|

| [29] |

Wu Y, Chen YP, Wang LJ, et al. Large scale incremental learning. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 374–382.

|

| [30] |

Zhao BW, Xiao X, Gan GJ, et al. Maintaining discrimination and fairness in class incremental learning. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 13205–13214.

|

| [31] |

Hou SH, Pan XY, Loy CC, et al. Learning a unified classifier incrementally via rebalancing. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 831–839.

|

| [32] |

Ahn H, Kwak J, Lim S, et al. SS-IL: Separated Softmax for incremental learning. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 824–833.

|

| [33] |

Qiu BL, Li HL, Wen HT, et al. CafeBoost: Causal feature boost to eliminate task-induced bias for class incremental learning. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE, 2023. 16016–16025.

|

| [34] |

Prabhu A, Torr PHS, Dokania PK. GDumb: A simple approach that questions our progress in continual learning. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 524–540.

|

| [35] |

Aljundi R, Lin M, Goujaud B, et al. Gradient based sample selection for online continual learning. Proceedings of the 33rd International Conference on Neural Information Processing Systems. Vancouver: Curran Associates Inc., 2019. 1058.

|

| [36] |

Tiwari R, Killamsetty K, Iyer R, et al. GCR: Gradient coreset based replay buffer selection for continual learning. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022. 99–108.

|

| [37] |

Simon C, Koniusz P, Harandi M. On learning the geodesic path for incremental learning. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 1591–1600.

|

| [38] |

Ashok A, Joseph KJ, Balasubramanian VN. Class-incremental learning with cross-space clustering and controlled transfer. Proceedings of the 17th European Conference on Computer Vision. Tel Aviv: Springer, 2022. 105–122.

|

| [39] |

Hu ZY, Li YS, Lyu JC, et al. Dense network expansion for class incremental learning. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE, 2023. 11858–11867.

|

| [40] |

Gao XY, He YH, Dong SL, et al. DKT: Diverse knowledge transfer Transformer for class incremental learning. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE, 2023. 24236–24245.

|

| [41] |

Wu ZR, Song SR, Khosla A, et al. 3D ShapeNets: A deep representation for volumetric shapes. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 1912–1920.

|

| [42] |

Yi L, Kim VG, Ceylan D, et al. A scalable active framework for region annotation in 3D shape collections. ACM Transactions on Graphics, 2016, 35(6): 210. |

| [43] |

Uy MA, Pham QH, Hua BS, et al. Revisiting point cloud classification: A new benchmark dataset and classification model on real-world data. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 1588–1597.

|

| [44] |

Dai A, Chang AX, Savva M, et al. ScanNet: Richly-annotated 3D reconstructions of indoor scenes. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 2432–2443.

|

2024, Vol. 33

2024, Vol. 33