2. 信号与信息处理重庆市重点实验室, 重庆400065

2. Chongqing Key Laboratory of Signal and Information Processing, Chongqing 400065, China

随着深度学习的快速发展, 人脸识别技术在登录、门禁、支付等领域得到了广泛应用. 然而, 其应用不仅局限于此, 还涵盖了用户行为分析和跟踪, 涉及社交媒体档案和个人简历等信息. 为了应对人脸识别模型在应用中可能面临的隐私安全问题, 当前主流方法主要通过在人脸图像中引入微小范围的扰动, 制作对抗样本, 从而使得人脸识别模型难以准确识别, 这些工作为解决人脸识别技术可能带来的隐私风险提供了一种有效途径[1–3].

对抗样本的核心思想是通过对输入数据进行微小扰动引导深度神经网络产生错误的结果. 当前在人脸识别领域, 生成对抗样本通常需要为每个图像迭代生成针对性的对抗扰动[4]. 然而, 在实际应用中处理大量图像时, 逐一生成对抗扰动成本极高. 因此, 研究适用于人脸识别任务的通用对抗扰动生成方法显得尤为重要. 通用对抗扰动, 即图像不可知对抗扰动, 是一种固定扰动, 不依赖于具体图像, 可以直接叠加到数据集中的图像上, 形成对抗样本, 并以较高的概率欺骗深度神经网络. 当前通用对抗扰动在图像分类[5,6]、目标检测[7] 、语音分类[8]等领域取得了显著进展. 然而, 目前生成通用对抗扰动的方法大多具有特定的应用场景, 如果直接将这些方法迁移至人脸识别领域攻击效果较差.

除此以外, 当前人脸识别的对抗样本还存在视觉质量不佳的问题. 目前人脸识别领域中的对抗样本主要通过在脸部图像上添加精心制作的装饰(对抗扰动)来进行攻击[9–11], 然而这些特定扰动的像素值范围并未受到限制. 添加这样的扰动后形成的对抗样本与原始图像差异较大, 导致视觉质量下降, 从而限制了在社交媒体上的实际应用.

在此背景下, 提出了一种利用共性梯度引导的人脸识别通用对抗扰动生成方法. 本文主要的贡献如下.

a) 提出一种利用多张人脸图像进行特定目标攻击, 获取人脸识别对抗扰动共性的方法, 其可以有效缓解通用对抗扰动在训练中出现的灾难性遗忘问题, 提升了扰动的跨图像迁移能力.

b) 利用主导性特征损失将特定身份信息嵌入至通用对抗扰动中, 有效提升扰动攻击成功率.

c) 利用多阶段训练策略, 均衡攻击成功率和视觉质量, 在多个人脸识别模型和数据集上达到人脸识别领域目前最优的攻击成功率和扰动视觉质量.

1 相关工作 1.1 对抗样本对抗样本最早由 Szegedy等人[12]提出, 目前基于梯度迭代生成对抗样本是应用最广泛的方法. Goodfellow等人[13]提出的快速梯度符号法(fast gradient sign method, FGSM)是首次利用梯度迭代生成对抗样本, 其仅用一次迭代就能得到对抗样本, 该方法具有生成简单、迁移性好的特点. I-FGSM (iterative fast gradient sign method)[14]在FGSM的基础上, 利用梯度方向多次迭代, 解决了其攻击成功率较低的问题. I-FGSM得到的扰动更小更精确, 然而其迁移性相比于FGSM会较差. MI-FGSM (momentum iterative fast gradient sign method)[15]主要是引入动量迭代的方法, 可以有效地避免对抗样本在迭代过程中陷入局部最优解, 具有更好的攻击性和迁移性.

在梯度迭代的基础上, 深度愚弄(DeepFool)[16]基于超平面分类, 通过搜索原分类面与其他面之间的最小代价达到攻击效果. 该方法可以显著提高对抗样本的鲁棒性. Carlini等人[17]提出一种将限制扰动大小与优化目标作为整体损失函数的攻击方法, 其通过调节参数增强对抗样本的迁移性, 但是迭代次数较多, 需消耗更多资源. 除此以外, 还有ILCM (iteratice least-likely class method)、UPSET和ANGRI等[18]对抗样本生成算法.

1.2 通用对抗扰动近年来, 通用对抗扰动的研究备受关注, 众多学者从不同角度解释了通用对抗扰动的作用机理. Zhang等人[19]证明通用对抗扰动相对于普通的对抗扰动(依赖图像生成的对抗扰动)具有独立的语义上的特征. Zhang等人[20]认为不易被察觉的通用对抗扰动能够显著影响图像的分类的原因是深度神经网络对于高频信息敏感.

Moosavi-Dezfooli等人[21]提出的通用对抗扰动(universal adversarial perturbations, UAP)的生成算法是通过对依赖图像的普通对抗扰动累加得到通用对抗样本. Kamath等人[22]提出一种基于奇异向量计算通用对抗扰动的方法. Zhang等人[23]采用自监督余弦相似度损失优化通用对抗扰动. Ud Din等人[24]提出一种基于在变换域中计算扰动的通用对抗扰动生成方法. Liu等人[25]提出随机梯度聚集, 该方法使用小批量训练进行预搜索, 将结果作为扰动的梯度更新, 可以增强梯度稳定性以及减少量化误差.

1.3 人脸识别领域中的对抗样本目前人脸识别领域中的对抗攻击主要分为物理世界攻击和数字世界攻击. 物理攻击大多专注于攻击实际应用的人脸识别系统, 比如门禁、登录系统等, 通常不限制扰动大小, 常以面部配饰为手段. Komkov等人[9]提出通过帽子制作对抗样本的方法. Yin等人[10]提出一种将对抗扰动隐藏在妆容中的攻击算法. Zolfi等人[11]提出一种可以在真实世界运用的人脸识别通用对抗面具, 尽管在佩戴口罩的人脸范围内不受扰动大小限制, 但在有监视的人脸识别环境下难以发挥作用. 在数字世界的人脸识别对抗攻击中, 注重对抗样本与实际图像保持高度相似性. Zhong等人[26]提出一种基于随机失活的黑盒攻击算法. Jia等人[27]通过扰动高级语义攻击人脸识别模型.

上述方法都没有从限制扰动的角度生成人脸识别通用对抗扰动. 本文提出的基于共性梯度的通用对抗扰动生成方法, 在保持视觉质量的前提下有效地保护人脸身份信息. 实验结果表明, 该方法在攻击成功率和扰动视觉质量上具有明显优势.

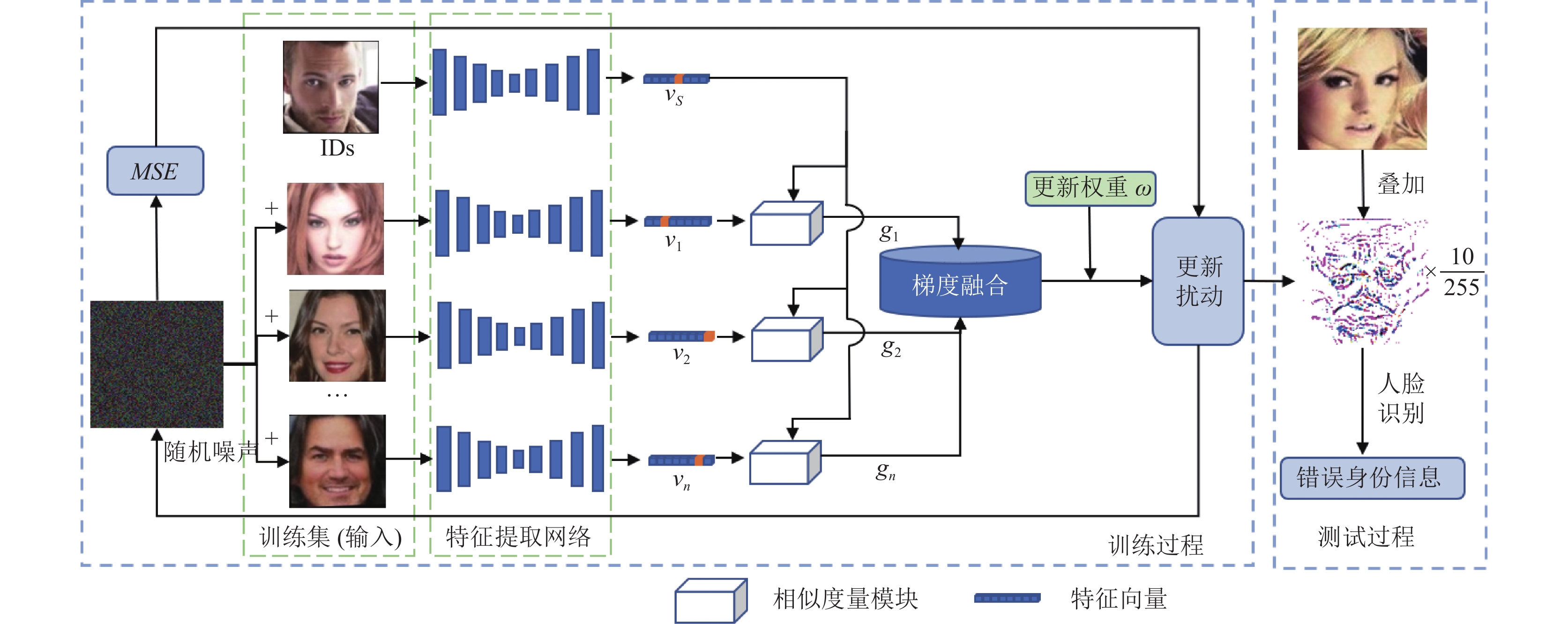

2 本文方法本文所采用的方法框图如图1所示. 首先, 将扰动叠加至多张图像, 同时向身份S进行特定目标攻击, 获取梯度后融合得到共性梯度. 在此过程中, 利用相似度量模块, 按攻击程度对每个梯度的权重进行分配, 使得扰动中的特征主导人脸识别的判定过程. 最后, 采用多阶段训练策略更新权重

|

图 1 总体方法框图 |

2.1 对抗扰动共性计算

对人脸图像进行特征提取可表示为

| Δδ=argminr||r||2 s.t.D(f(xk+δ+r))≠D(f(xk)) | (1) |

| δk+1=δk+Δδ | (2) |

其中,

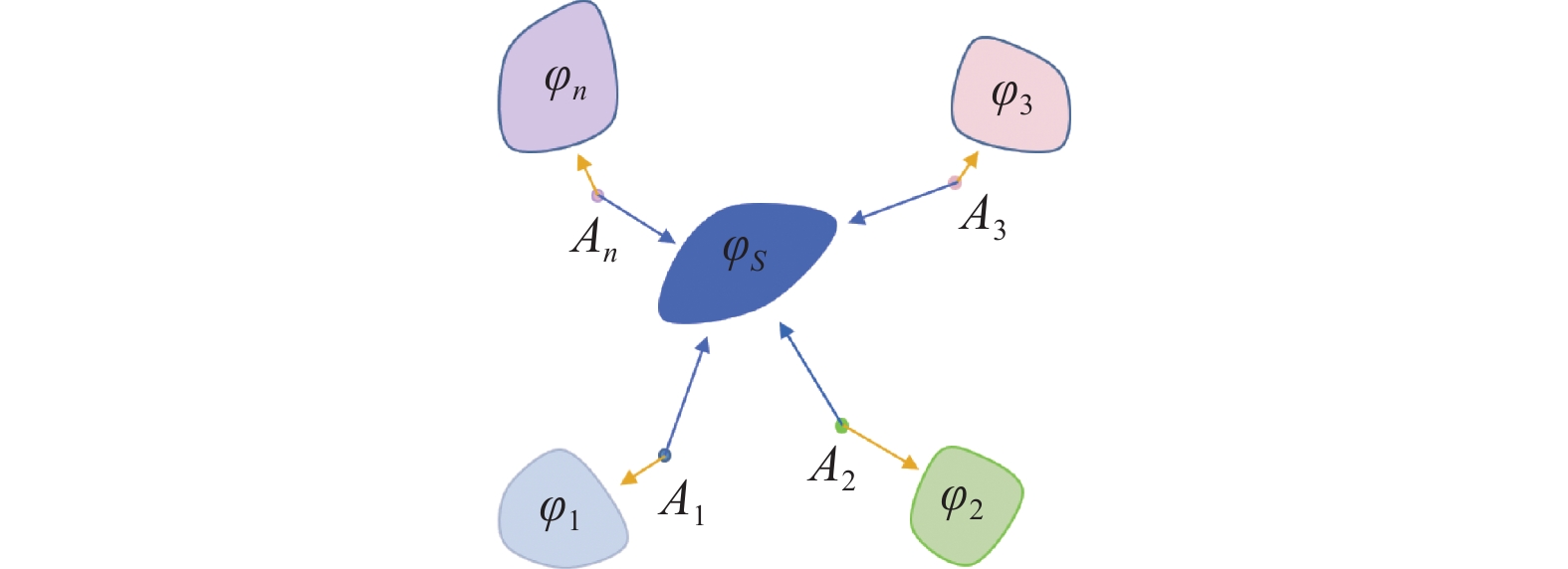

如图2所示,

| δk+1=δk+α⋅sign(g) | (3) |

| g=∇δ1NN∑i=1J(xi,δ,φS,fθ) | (4) |

| ∇δJ(xi,δ,φS,fθ)=gS+gorg | (5) |

其中,

|

图 2 共性计算示意图 |

相比与现有方法将每一张图像的攻击梯度用于直接优化通用对抗扰动, 共性计算可以避免

分类网络将特征向量输入分类头, 求最大值索引判断类别, 而人脸识别网络根据特征向量与人脸数据库中特征向量的相似度或者距离获取身份信息. 相对于分类任务, 人脸识别中的对抗样本需要改变特征向量多个维度的数值, 影响向量之间的相似度才能达到攻击效果[3]. 因此, 在相同大小的扰动限制下, 为分类任务设计的通用对抗扰动生成方法对人脸识别模型的攻击成功率较低. 为解决这一问题, 本文使用对抗样本经过特征提取网络输出的特征向量与身份

在相似性的约束下, 训练时扰动会不断地嵌入特定身份

| g=∇δ1NN∑i=1Sim(f(S),f(xi,δ)) | (6) |

| Sim(a,b)={2θ−cos(a,b),ifcos(a,b)⩽θmax(0,2θ−cos(a,b)θ),else | (7) |

其中,

由于扰动迭代过程会导致对抗样本与

| L=ωN∑i=1Sim(f(S),f(xi,δ))+MSE(δ,0) | (8) |

其中, 通过多阶段训练策略得到的

为有效平衡通用对抗扰动的攻击成功率与视觉质量, 本文通过预热重启和余弦退火的策略对

第1阶段: 对抗扰动初始化. 该阶段的迭代目标是在增强攻击性的同时减少与特征表达无关的扰动. 因此, 本文在第1阶段采用预热重启的策略对

| ω=ωmin+(ωmax−ωmin)Twarm×t | (9) |

其中,

第2阶段: 增强对抗扰动攻击. 在扰动控制在较小范围时, 保持

第3阶段: 优化通用对抗扰动. 第2阶段生成的扰动具有强大的攻击性, 同时包含丰富的S身份纹理信息. 为了缓解扰动中的纹理信息对对抗样本视觉质量的影响, 采用余弦退火策略, 即模拟余弦周期更新

| ω=ωmin+12(ωmax−ωmin)(1+cos(πtcurTcos)) | (10) |

其中,

算法1. 基于共性梯度的通用对抗攻击方法

输入: 人脸识别模型

输出: 通用对抗扰动

1.

2. for t←1 to T do

3.

4. for i←1 to N do

5. select

6.

7.

8. end for

9.

10. if t <

11. 根据式(9)更新

12. else if t ≥

13.

14. else if t ≥

15. 根据式(10)更新

16.

17.

18. end for

19.

20. return

为了全面验证所提方法的泛化性, 本文进行了一系列实验, 涵盖多个人脸识别数据集, 其中包括LFW数据集、AgeDB数据集以及CFP-FP数据集.

LFW数据集包含

AgeDB数据集包含3万张图像, 其中包含亚洲的人脸图像

CFP-FP数据集中每一个身份ID包含10张正面图像以及4张侧脸图像, 其数据集上的测试指标可以有效地衡量人脸识别模型在不同角度获取人脸信息的性能.

实验过程中, 选用人脸识别领域内具有代表性的ArcFace和SphereFace为目标模型. 在ArcFace模型中, 采用了两种不同的主干网络, 分别是ResNet50-IR和MobileFace, 以验证算法在不同结构下的鲁棒性. 利用攻击成功率ASR衡量生成的对抗扰动的攻击性能, 其计算公式为:

| ASR=nerrorntotal | (11) |

其中,

| MSE=1mnm−1∑i=0n−1∑j=0[x(i,j)−y(i,j)]2 | (12) |

| SSIM=(2uxuy+C1)(2σxy+C2)(u2x+u2y+C1)(σ2x+σ2y+C2) | (13) |

其中,

为了全面评估生成算法在攻击成功率和扰动视觉质量等方面的性能, 本文选择了SVD-UAP[22]、Cos-UAP[23]、SGA[25]作为基准方法. 这些基准是在分类任务上提出的通用扰动生成方法, 其中SGA是目前分类任务中攻击性能最好的方法.

本文实验中为与基准方法保持一致性, 限制扰动参数

本文对生成的通用扰动攻击成功率进行了评估, 涵盖多个人脸识别模型以及不同的人脸数据集. 详细的实验结果请参见表1. 可以看出, 本文方法使用3个人脸识别模型进行9次实验取得了83.43%的平均攻击成功率, 相比于SGA方法提升了7.12%. 证明本文方法在人脸识别领域中相比于现有的通用对抗攻击方法在攻击成功率上具有明显优势. 除了攻击成功率之外, 有关数据指标的具体数据详见表2. 本文方法在多个方面取得了显著的成果, 其中包括平均结构相似度得分达到0.91和最小均方误差结果为26.54. 本文方法在损失函数中引入了对扰动大小的限制, 结合多阶段训练策略有效地避免了对非关键区域的过度扰动. 相较于将每张图像的攻击梯度直接应用于优化扰动的方法, 本文方法生成的扰动在视觉质量上具有更优越的表现. 此外, 通过同时获取多张图像的对抗样本共性再进行扰动优化, 本文方法在训练时间上取得了与现有方法相当或更优的性能.

| 表 1 通用对抗扰动的攻击成功率 (%) |

| 表 2 各项指标对比 |

3.3 消融实验

1)验证共性计算算法与主导性特征损失组合的有效性. 选择UAP方法中的利用DeepFool攻击对每一张图像搜索最小扰动, 并依次叠加至通用扰动的方法替换共性计算算法, 表示为

2)多阶段训练策略的优势. 为了验证多阶段策略训练的有效性, 本文在训练时选取固定的

|

图 3 LFW数据集上不同 |

3)训练图像数量对攻击效果的影响. 本文方法中参与共性计算对抗扰动的图像数量直接影响扰动攻击效果. 详细列举共性计算中不同的人脸图像数量N对于最终得到的扰动攻击成功率的影响, 实验结果如图4所示.

图4显示: 逐渐增加参与扰动共性计算的图像数量, 初始阶段扰动的跨图像攻击能力迅速提升, 达到瓶颈后呈现微弱地增长. 随着参与扰动计算的图像数量增加, 训练时间与显存资源需求逐步增加, 所以本文选择在3个人脸识别模型均取得良好的攻击成功率且值偏小的:

|

图 4 LFW数据集上不同 |

4)不同初始化对攻击效果的影响. 为了验证不同的初始化扰动对攻击的影响, 本文选取3种不同初始化结果对比攻击成功率, 分别是将扰动置为0值初始化、扰动在

| 表 3 扰动初始化方式其攻击成功率(%) |

3.4 对抗样本可视化

将通用对抗扰动经过处理后的可视化结果如图5所示. 观察可知, 本文方法中的扰动从随机初始化到训练完成, 更多地学习到人脸特征的细节信息. 叠加通用对抗扰动的人脸图像可视化结果如图6所示, 其中SVD-UAP、SGA以及本文方法进行特定目标攻击, 目标特定身份为John, Cos-UAP进行非特定目标攻击. 图6中, 每一张对抗样本给出人脸识别模型判定可能性最高的身份、特征向量之间的相似度, 以及对抗样本与原图的结构相似度.

|

图 5 对抗扰动可视化结果 |

|

图 6 生成的对抗样本 |

4 结束语

本文提出了一种适用于人脸识别网络的通用对抗扰动生成方法. 该方法通过迭代梯度的共性计算增强了对抗扰动的跨图像迁移能力, 并通过引入主导性特征损失来提高扰动的攻击成功率. 最后, 通过采用多阶段训练策略, 实现了攻击效果与视觉质量的均衡. 相对于当前在分类领域表现最佳的SGA生成方法, 该方法在攻击成功率和扰动视觉质量方面都表现出显著的优势. 然而, 本文方法依然存在一些局限性, 特别是在无法获取人脸识别模型特征向量的黑盒环境中, 如何有效地嵌入主导性特征仍然是一个需要深入探讨的问题.

| [1] |

Liu JY, Zhang WM, Fukuchi K, et al. Unauthorized AI cannot recognize me: Reversible adversarial example. Pattern Recognition, 2023, 134: 109048. DOI:10.1016/j.patcog.2022.109048 |

| [2] |

Hasan MR, Guest R, Deravi F. Presentation-level privacy protection techniques for automated face recognition—A survey. ACM Computing Surveys, 2023, 55(13s): 286. |

| [3] |

Ren M, Zhu YH, Wang YL, et al. Perturbation inactivation based adversarial defense for face recognition. IEEE Transactions on Information Forensics and Security, 2022, 17: 2947-2962. DOI:10.1109/TIFS.2022.3195384 |

| [4] |

Zheng X, Fan YB, Wu BY, et al. Robust physical-world attacks on face recognition. Pattern Recognition, 2023, 133: 109009. DOI:10.1016/j.patcog.2022.109009 |

| [5] |

Deng YP, Karam LJ. Frequency-tuned universal adversarial attacks on texture recognition. IEEE Transactions on Image Processing, 2022, 31: 5856-5868. DOI:10.1109/TIP.2022.3202366 |

| [6] |

Xu YH, Ghamisi P. Universal adversarial examples in remote sensing: Methodology and benchmark. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5619815. |

| [7] |

Mi JX, Wang XD, Zhou LF, et al. Adversarial examples based on object detection tasks: A survey. Neurocomputing, 2023, 519: 114-126. DOI:10.1016/j.neucom.2022.10.046 |

| [8] |

Kim H, Park J, Lee J. Generating transferable adversarial examples for speech classification. Pattern Recognition, 2023, 137: 109286. DOI:10.1016/j.patcog.2022.109286 |

| [9] |

Komkov S, Petiushko A. AdvHat: Real-world adversarial attack on ArcFace face ID system. Proceedings of the 25th International Conference on Pattern Recognition. Milan: IEEE, 2021. 819–826.

|

| [10] |

Yin BJ, Wang WX, Yao TP, et al. Adv-Makeup: A new imperceptible and transferable attack on face recognition. Proceedings of the 30th International Joint Conference on Artificial Intelligence. Montreal: IJCAI, 2021. 1252–1258.

|

| [11] |

Zolfi A, Avidan S, Elovici Y, et al. Adversarial mask: Real-world universal adversarial attack on face recognition models. Proceedings of the 2023 European Conference on Machine Learning and Knowledge Discovery in Databases. Grenoble: Springer, 2023. 304–320.

|

| [12] |

Szegedy C, Zaremba W, Sutskever I, et al. Intriguing properties of neural networks. Proceedings of the 2nd International Conference on Learning Representations. Banff: ICLR, 2014. 1–10.

|

| [13] |

Goodfellow IJ, Shlens J, Szegedy C. Explaining and harnessing adversarial examples. Proceedings of the 3rd International Conference on Learning Representations. San Diego: ICLR, 2015.

|

| [14] |

Kurakin A, Goodfellow IJ, Bengio S. Adversarial examples in the physical world. Proceedings of the 5th International Conference on Learning Representations. Toulon: ICLR, 2017. 99–112.

|

| [15] |

Dong YP, Liao FZ, Pang TY, et al. Boosting adversarial attacks with momentum. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 9185–9193.

|

| [16] |

Moosavi-Dezfooli SM, Fawzi A, Frossard P. DeepFool: A simple and accurate method to fool deep neural networks. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 2574–2582.

|

| [17] |

Carlini N, Wagner D. Towards evaluating the robustness of neural networks. Proceedings of the 2017 IEEE Symposium on Security and Privacy. San Jose: IEEE, 2017. 39–57.

|

| [18] |

白祉旭, 王衡军, 郭可翔. 基于深度神经网络的对抗样本技术综述. 计算机工程与应用, 2021, 57(23): 61-70. |

| [19] |

Zhang DH, Zhang TY, Lu YP, et al. You only propagate once: Accelerating adversarial training via maximal principle. Proceedings of the 33rd International Conference on Neural Information Processing Systems. Vancouver: ACM, 2019. 21.

|

| [20] |

Zhang CN, Benz P, Karjauv A, et al. Universal adversarial perturbations through the lens of deep steganography: Towards a Fourier perspective. Proceedings of the 2021 AAAI Conference on Artificial Intelligence. Palo Alto: AAAI Press, 2021. 3296–3304.

|

| [21] |

Moosavi-Dezfooli SM, Fawzi A, Fawzi O, et al. Universal adversarial perturbations. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE Press, 2017. 86–94.

|

| [22] |

Kamath S, Deshpande A, Subrahmanyam KV, et al. Universalization of any adversarial attack using very few test examples. Proceedings of the 5th Joint International Conference on Data Science & Management of Data. Bangalore: ACM, 2022. 72–80.

|

| [23] |

Zhang CN, Benz P, Karjauv A, et al. Data-free universal adversarial perturbation and black-box attack. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE Press, 2021. 7848–7857.

|

| [24] |

Ud Din S, Akhtar N, Younis S, et al. Steganographic universal adversarial perturbations. Pattern Recognition Letters, 2020, 135: 146-152. DOI:10.1016/j.patrec.2020.04.025 |

| [25] |

Liu XN, Zhong YY, Zhang YH, et al. Enhancing generalization of universal adversarial perturbation through gradient aggregation. Proceedings of the 2023 IEEE/CVF International Conference on Computer Vision. Paris: IEEE Press, 2023. 4412–4421.

|

| [26] |

Zhong YY, Deng WH. Towards transferable adversarial attack against deep face recognition. IEEE Transactions on Information Forensics and Security, 2020, 16: 1452-1466. |

| [27] |

Jia S, Yin BJ, Yao TP, et al. Adv-attribute: Inconspicuous and transferable adversarial attack on face recognition. Proceedings of the 36th International Conference on Neural Information Processing Systems. New Orleans, 2022. 34136–34147.

|

| [28] |

Jia XJ, Zhang Y, Wei XX, et al. Prior-guided adversarial initialization for fast adversarial training. Proceedings of the 17th European Conference on Computer Vision. Tel Aviv: Springer, 2022. 567–584.

|

| [29] |

Deng JK, Guo J, Xue NN, et al. ArcFace: Additive angular margin loss for deep face recognition. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 4685–4694.

|

| [30] |

Liu WY, Wen YD, Yu ZD, et al. SphereFace: Deep hypersphere embedding for face recognition. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 6738–6746.

|

| [31] |

Madry A, Makelov A, Schmidt L, et al. Towards deep learning models resistant to adversarial attacks. Proceedings of the 6th International Conference on Learning Representations. Vancouver: ICLR, 2018. 1–28.

|

2024, Vol. 33

2024, Vol. 33