2. 工业安全与应急技术安徽省重点实验室, 合肥 230601

2. Anhui Province Key Laboratory of Industry Safety and Emergency Technology, Hefei 230601, China

合成孔径雷达(synthetic aperture radar, SAR)成像系统在全天时和全天候条件下能够提供丰富的空间结构信息和高空间分辨率图像, 在土地利用、船舶探测和灾害监测等领域具有独特的优势. 然而, 随着地球观测技术的开展, 单一数据源的遥感场景解译已经无法满足当前的需求. 为了提供更全面的空间信息和更丰富的地物内容, 多源协同遥感技术成为解决地物目标缺失问题的有效手段. 因此, 结合SAR和光学图像的融合技术可以克服单个图像的局限性, 充分利用两者互补的特性, 在目标检测、图像分割以及灾害评估等领域具有重要的意义.

针对光学和SAR图像融合的问题, 研究者提出了多种不同的融合方法, 目前主要借鉴多光谱(multispectral, MS)图像和全色(panchromatic, PAN)图像融合的思想, 即泛锐化融合方法. 传统图像融合方法可归纳为以下3类: 多分辨率分析法[1–4]、基于稀疏表示的方法[5]、混合方法[6,7]. 1)多分辨率分析法(multi-resolution analysis, MRA)通常利用小波(wavelet)变换、拉普拉斯金字塔等从SAR图像中提取空间结构信息. 常用方法包括稀疏表示[1,2]、Shearlet变换法和非下采样轮廓波变换(non subsampled contourlet transform, NSCT)[3,4]. 2)基于稀疏表示的方法[5]一般从多个重叠的图块中训练出一个完备字典, 然后根据字典提出相应的稀疏分解和重构生成结果. 3)混合办法综合了成分替换法(component substitution, CS)和MRA的优势, 以获得更好的融合性能, 例如, Shah等人[6]提出将主成分分析(principal component analysis, PCA)与NSCT相结合, NSCT在保留空间细节信息的同时, 与PCA相结合可以有效地保持图像的光谱信息. 这些方法在像素级进行图像融合, 采用线性模型模拟融合过程, 存在一定的局限性, 难以在提高空间质量和保持光谱质量之间达到最佳平衡. 因此, 为了克服这些限制, 基于深度学习的方法也被提出并得到广泛应用.

近年来, 在遥感图像融合领域中深度学习(deep learning, DL)的作用愈发重要. 卷积神经网络(convo-lutional neural network, CNN)凭借其强大的特征提取和重构能力[8–11], 在图像融合领域得到了广泛应用. 2016年, Masi等人[8]受到卷积神经网络在单幅图像超分辨率方面的启发, 提出了一个具有3层CNN结构的开创性方法. 此后, Yang等人[9]提出了双分支CNN融合架构, 通过输入多源图像来学习细节信息, 并通过低频内容和原始图像生成高通域, 从而改善融合图像的边缘和细节, Liu等人[10]利用两流浅深卷积网络从PAN图像中提取中层和高层空间特征的空间细节, Jin等人[12]引入了拉普拉斯金字塔网络结构, 将全色和多光谱图像进行多尺度分解, 并将金字塔分解的结果逐步集成到CNN中, 吴佼华等人[13]在PanNet的基础上, 针对颜色损失和结构畸变问题提出了双分支网络结构. 值得一提的是, 当前DL技术已经主导了PAN与MS、SAR与MS图像融合的研究, 但针对SAR和光学图像融合的研究相对较少. 在SAR和光学图像的融合方面, Ye等人[14]采用无监督的结构-纹理分解策略进行特征融合, Zhang等人[15]先分别提取光学图像和SAR图像的纹理特征, 然后将其进行分层叠加融合, 以提高图像融合的提取精度. 然而, SAR和光学图像融合的关键挑战在于如何有效地整合两者的互补特征, 以获得全面的特征表达, 而不是只专注于单一成分的增强或改进; 此外, 这些方法通常依赖卷积运算来提取局部感知域的特征, 这可能导致在融合图像中丢失一些重要的全局上下文信息. 另外, 这些方法通常仅关注原始尺度的处理, 未能充分利用更细粒度的网络结构.

综上所述, 针对SAR图像和光学图像的互补特征, 本文提出了一种结合双非局部注意力感知的SAR与光学图像融合方法. 该方法结合多级金字塔结构, 并引入SAR和光学图像封装决策, 有效保留不同尺度下的显著特征并提取丰富的结构和纹理信息. 之后引入双非局部注意力模型作为融合策略, 将基于SAR的结构信息与基于光学的纹理信息进行融合, 建立通道和空间位置上的长程依赖关系, 使网络更加关注图像中的典型目标和细节信息, 从而显著提升了SAR和光学图像融合的效果. 本文主要贡献总结如下.

(1)基于多级金字塔结构设计空间上下文感知模块, 从每个尺度中提取相应的SAR图像空间结构高频信息和光学图像纹理信息高频信息, 并跨尺度融合所有的尺度特征.

(2)引入新的图像协同封装决策以加强SAR强度与光学图像各个波段之间的关联关系, 进一步增强特征耦合度.

(3)提出了一种双非局部感知的融合策略, 实现对通道和空间位置上的有效互补特征融合与重构. 由Sentinel-1与Landsat-8获取的SAR与光学图像进行一系列实验表明所提方法具有一定的优越性.

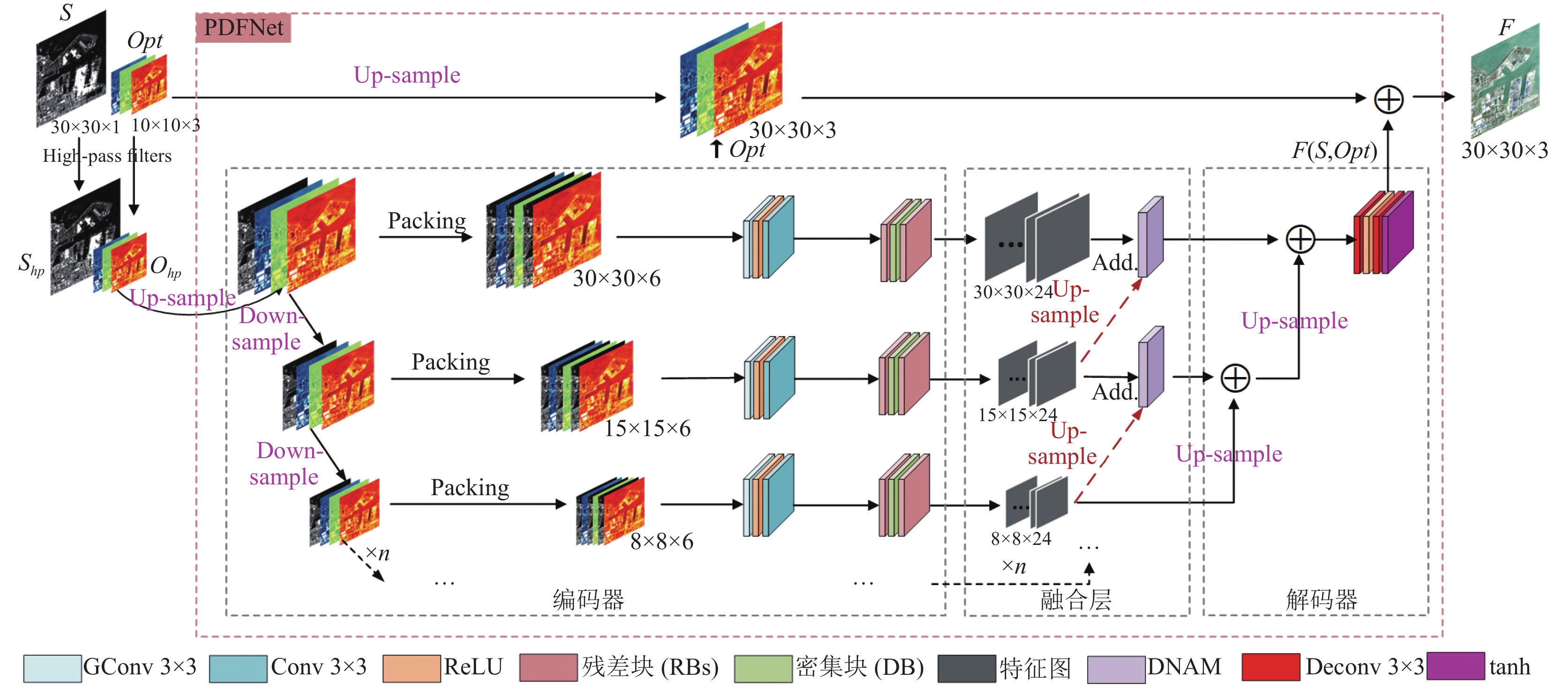

2 研究方法 2.1 整体网络结构本文受PanNet[9]和LPPN[12]启发, 设计遵循编解码结构的结合双非局部注意力感知的SAR和光学图像融合网络(SAR and optical image fusion network with dual nonlocal attention perception, DNAP-Fusion), 该网络由空间上下文感知编码器、双非局部注意力特征融合模块和融合重建解码器组成, 如图1所示.

|

图 1 整体网络结构 |

空间上下文感知编码器模块主要由分组卷积、整流线性单元(ReLU)激活和残差-密集-残差块组成, 它具备提取更深层次语义信息的能力. 用于融合多尺度信息的双非局部注意力特征融合模块(DNAM)是DNAP-Fusion的关键部分, 其使用两个DNAM块, 在不同尺度上融合来自SAR图像的结构信息和光学图像的纹理特征(即编码器的输出). 最后在解码器中合并和重构图像信息, 生成最终融合图像F. 此外, 为了增强SAR图像强度信息与光学图像每个光谱波段之间的关联性, 我们采用了图像封装决策来建立它们之间的映射关系.

2.2 空间上下文感知特征提取模块 2.2.1 封装决策在不同感受野下, 基于CNN的方法所提取的空间上下文存在差异性[15]. 在此启发下, 本文提出了一种在图像域中的方法, 该方法利用显著的卷积归纳偏置参数从多层金字塔中充分提取SAR的结构信息和光学图像的纹理信息. 与传统的深度学习方法不同, 本文采用了一种新的输入格式, 当设计处理每个图像金字塔的子网络时, 将SAR图像和光学图像的一个波段封装在一个处理单元中, 并沿着通道维度排列所有这些单元来构造子网络的输入(式(1)).

| $ \hat{S}=\left[\left[{S}_{};Op{t}_{1}\right]\text{; }\left[{S}_{};Op{t}_{2}\right]\text{; }\cdot \cdot \cdot \text{; }\left[{S}_{};Op{t}_{i}\right]\right],\; i\in \left[1, d\right] $ | (1) |

其中, S表示来自SAR图像的强度值,

这种输入格式的设计是考虑到不同光谱波段描述地物特性时存在差异, 以实现对每个光谱波段的相对独立处理, 可以更好地利用SAR和光学图像之间的互补信息.

2.2.2 基于封装决策的空间上下文感知给定输入SAR图像S和对应光学图像Opt, 通过高通滤波器得到

为了增强SAR和光学图像之间的局部联系, 我们提出了特征聚合块, 该块由带有B滤波器组的深度卷积(即分组卷积)、标准卷积(具有32个3×3大小的滤波器, 没有滤波器组)和线性激活函数(ReLU)组成. 特征聚合块的公式形式为:

| $ Z'_l = BN\left( {\sigma \left\{ {ConvDepthwise\left( {{Z_{l - 1}}} \right)} \right\}} \right) + {Z_{l - 1}} $ | (2) |

| $ {Z_{l + 1}} = BN\left( {\sigma \left\{ {Conv\left( {Z'_l} \right)} \right\}} \right) $ | (3) |

其中,

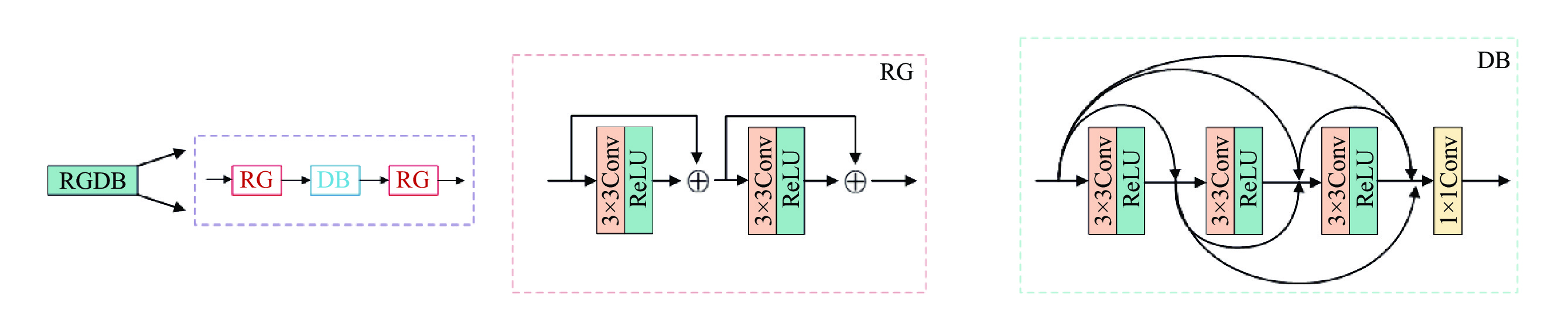

提取的特征被传递到残差-密集-残差块(简称为RGDB块)中, 以提供图像边缘信息[16]. 如图2所示, RGDB块由连续的3个部分组成: 第1部分和第3部分是由两个残差块(RBs)组成的残差组, 称为RG; 第2部分是密集块(dense block), 称为DB. 每个残差块由标准卷积(具有32个3×3大小的滤波器, 没有滤波器组)和线性激活函数(ReLU)组成. DB由3个3×3卷积层、ReLU和1个1×1的卷积层组成, 通过在前层和后层之间创建并行连接来进行跨层信息交换. RB和DB具有强大的特征提取能力, 可以进一步利用两类图像中可用的信息, 提取更具代表性的特征.

|

图 2 RGDB块及其组成部分的体系结构 |

2.3 双非局部注意力特征融合模块

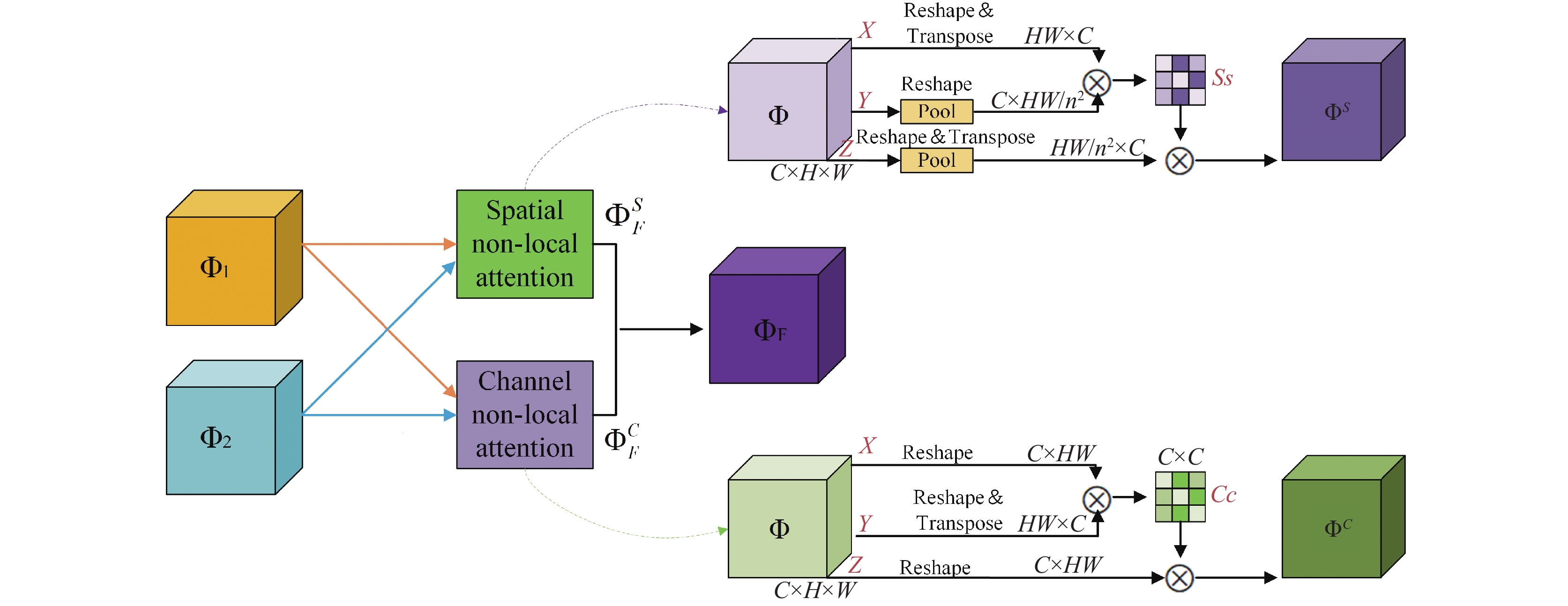

受非局部神经网络[17]的启发, 设计关于非局部的空间和通道注意力模块作为融合策略. 双非局部注意力模型的相应细节如图3所示, 该模块利用跨尺度融合, 将高层与低层特征分别连接到特征融合模块的两个输入端, 用于将每个金字塔层提取的特性互补信息进行融合并获得全局上下文信息[18].

关于多尺度特征图

| $ {\Phi _F}\left( {i, j} \right) = \frac{{\left( {\Phi _F^S\left( {i, j} \right) + \Phi _F^C\left( {i, j} \right)} \right)}}{\sigma } $ | (4) |

其中, i, j代表图像特征图的坐标, i和j的取值在图像特征图长、宽的范围内;

如图3所示(右上方箭头所指模块), 对于特征图

| $ {S^{{S}}}\left( {x, y} \right) = \frac{{E\left( {{\Phi ^X}\left( {x, c} \right) \times {\Phi ^Y}\left( {x, c} \right)} \right)}}{{\displaystyle\sum\limits_{y = 1}^{HW/{n^2}} {E\left( {{\Phi ^X}\left( {x, c} \right) \times {\Phi ^Y}\left( {x, c} \right)} \right)} }} $ | (5) |

其中,

| $ {\Phi ^{{S}}}{\text{ = }}R\left( {\sum\limits_{y = 1}^{HW/{n^2}} {{S^s}\left( {x, y} \right) \times {{\left( {{\Phi ^{\textit{Z}}}\left( {c, y} \right)} \right)}^{\mathrm{T}}}} } \right) + \Phi $ | (6) |

其中,

| $ {\alpha ^{{s}}}(i, j) = \frac{{\Phi _1^S(i, j)}}{{\Phi _1^S(i, j) + \Phi _2^S(i, j)}} $ | (7) |

| $ {\beta ^{{s}}}(i, j) = \frac{{\Phi _2^S(i, j)}}{{\Phi _1^S(i, j) + \Phi _2^S(i, j)}} $ | (8) |

最后, 融合后的空间注意力图

| $ \Phi _F^{{s}}(i, j) = {\alpha ^s}(i, j) \times {\Phi _1}(i, j) + {\beta ^s}(i, j) \times {\Phi _2}(i, j) $ | (9) |

如图3所示(右下方箭头所指模块), 首先将特征图

| $ {S^{{C}}}\left( {c, c} \right) = \frac{{E\left( {\Phi \left( {c, x} \right) \times {{\left( {\Phi \left( {c, x} \right)} \right)}^{\mathrm{T}}}} \right)}}{{\displaystyle\sum\limits_{c = 1}^C {E\left( {\Phi \left( {c, x} \right) \times {{\left( {\Phi \left( {c, x} \right)} \right)}^{\mathrm{T}}}} \right)} }} $ | (10) |

其中,

| $ {\Phi ^C}{\text{ = }}R\left( {\sum\limits_{c = 1}^C {{S^C}\left( {c, c} \right) \times \Phi \left( {c, x} \right)} } \right) + \Phi $ | (11) |

多尺度特征图

| $ {\alpha ^{{c}}}(i, j) = \frac{{\Phi _1^c(i, j)}}{{\Phi _1^c(i, j) + \Phi _2^c(i, j)}} $ | (12) |

| $ {\beta ^{{c}}}(i, j) = \frac{{\Phi _2^c(i, j)}}{{\Phi _1^c(i, j) + \Phi _2^c(i, j)}} $ | (13) |

|

图 3 双非局部注意力模型的融合过程 |

最后, 融合后的通道注意力图

| $ \phi _F^{{c}}(i, j) = {\alpha ^c}(i, j) \times {\phi _1}(i, j) + {\beta ^c}(i, j) \times {\phi _2}(i, j) $ | (14) |

解码器网络由两个与ReLU激活层相连的卷积层组成, 用于重构融合结果. 考虑到输入被归一化到[0, 1]的范围, 本文采用tanh激活层来确保输出结果保持在相同的空间范围内. 参考文献PanNet[9]和细节注入深度神经网络[19]的方法, 我们采用了从输入到输出的跳跃连接方式, 将融合的特征与上采样后的可见光图像进行叠加, 以实现可见光图像的光谱信息(↑Opt)和重构图像的结构纹理信息

| $ F{\text{ = }} \uparrow {{Opt}} \oplus {{F}}\left( {S, Opt} \right) $ | (15) |

参考双分支嵌套融合网络[20], 我们网络架构使采用的损失函数

| $ {L_{{\mathrm{total}}}} = {L_{{\mathrm{spectral}}}} + \lambda {L_{{\mathrm{detail}}}} $ | (16) |

| $ {L_{{\mathrm{spectral}}}} = \frac{1}{N}\sum\limits_{i - 1}^N {\parallel {F^{\left( i \right)}} - G{T^{\left( i \right)}}\parallel _2^2} $ | (17) |

| $ {L_{{\mathrm{detail}} }} = \frac{1}{N} = \sum\limits_{i - 1}^N {\parallel F_{hp}^{\left( i \right)} - S_{hp}^{\left( i \right)}\parallel _2^2} $ | (18) |

其中, 参数

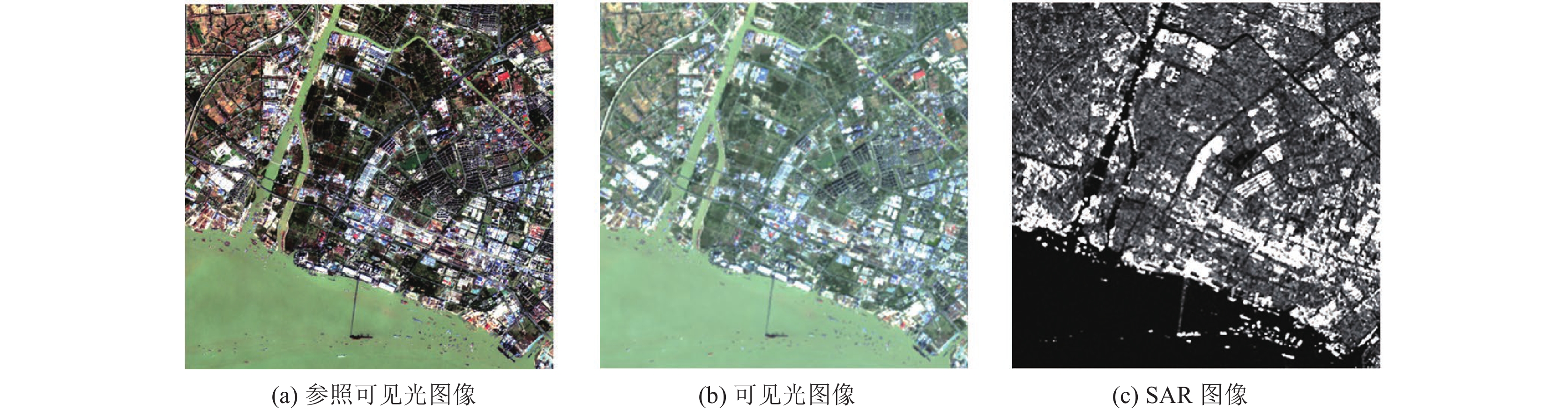

为避免单一地物对实验结果的影响, 实验选取通州湾和南通长江流域的场景作为分析数据集(图4、图5). 第1组数据是南通市通州湾图像, 包含道路、草地、水体等多种类型的地物; 第2组数据为南通芦泾港口及临近长江流域图像, 包括大量房屋、森林、船舶等地物. 由于在实际应用中缺乏理想的标准, 因此添加Sentinel-1原始光学图像数据(空间分辨率为10 m)作为参考图像.

本文使用Sentinel-1和Landsat-8卫星获取的SAR和光学图像作为实验数据集. Sentinel-1卫星提供空间分辨率为10 m的VV/VH强度SAR图像, Landsat-8卫星提供空间分辨率为30 m的光学图像. 本文提取区域大小为900×900的SAR图像的VV通道和区域大小为300×300的蓝、绿、红3个波段光学图像进行配对观测. 本文按照Wald协议[21]对图像进行预处理: SAR图像预处理包括轨道矫正、辐射定标、相干斑滤波和地形校正, 主要使用SNAP进行处理. 光学图像预处理包括辐射定标和大气校正, 主要使用ENVI进行处理. 然后将两者进行图像配准.

|

图 4 通州湾实验数据 |

|

图 5 南通市长江流域实验数据 |

3.2 实验设置

实验采用Intel(R) Xeon(R) CPU E5-2620 v4 @ 2.10 GHz处理器, 显卡为Quadro M2000, CUDA版本为8.0, CUDNN版本为6.0.21. 本文网络结构主要在TensorFlow和Python 3.6的框架下搭建, 学习率、动量衰减因子、批大小和总迭代次数分别设置为

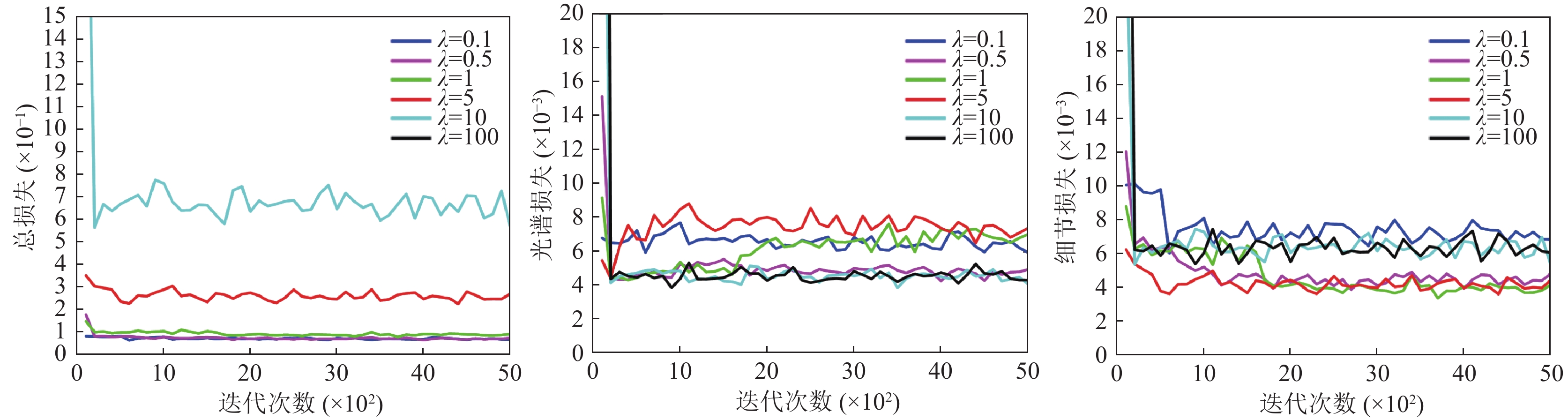

在本文研究中, 针对融合网络的损失函数设计参数进行了详细评估, 以确定最优参数值式(16). 我们选择了一系列参数值(例如

|

图 6 训练阶段损失函数曲线 |

|

图 7 验证阶段损失函数曲线 |

3.3.2 金字塔层数P的消融实验

在其他参数保持不变的情况下, 我们选择最优P值以平衡整体性能和计算量. P值从1变化到3, 并对第1组南通湾数据集进行了实验. 针对光谱信息的有效提取, 我们使用了4种定量性能指标来评价融合结果的光谱质量, 其中CC代表相关系数, 用于评估融合图像与原始图像之间的相似性; QAVE代表平均波段通用图像质量指数, 用来评价多波段图像质量的指数; SAM代表光谱角度映射器, 用来度量两个光谱向量之间的角度, 反映了它们在光谱空间中的相似性; ERGAS代表相对平均光谱误差, 用于评估图像整体光谱性能的指标. SAM和ERGAS的理想值为0, 而QAVE和CC的理想值为1. 每个测试的平均运行时间和定量性能等指标列于表1中, 加粗字体为每列最优值. 在可承受的网络参数数量下, 3个金字塔层产生了令人满意的性能. 我们可以合理地推测, 逐步增加金字塔层数到4层或更高, 可以使更多的信息参与训练过程, 从而实现更精确的图像融合. 然而, 考虑到计算资源数量和时间的增加等其他因素, 我们需要权衡选择.

| 表 1 不同金字塔层数对南通湾测试集的消融结果 |

3.3.3 融合网络的消融实验

在融合层中, 提出了双非局部注意力模型来建模局部特征的长程依赖性, 为验证双非局部注意力特征融合模块在网络结构中的作用, 我们比较了3种验证模型(表2), 即3种融合策略: 加法、只保留空间非局部注意力和只保留通道非局部注意力. 为了全面评估融合图像在空间和光谱质量上的整体效果, 我们选择了6种评估指标来验证, 其中熵(EN)表示图像的信息量, 互信息(MI)度量了融合后图像与原始图像之间的一致性, 峰值信噪比(PSNR)用于量化图像质量, 多尺度结构相似性指数度量(MS-SSIM)是结构相似性指数(SSIM)的多尺度版本, 用于评估图像在不同尺度上的结构相似性. 除ERGAS外, 其他评估指标越高, 表明融合性能越好, 粗体表示最优值, 下划线表示次优值. 在空间非局部注意力和通道非局部注意力方面, 通道得到了EN和MI的最优值, 说明通道在保持亮度方面具有较强的建模能力, 但不可避免地减弱了一些有用的空间信息和细节信息, 空间注意力模型倾向于保留丰富的纹理细节, 可以弥补通道注意力模型的不足. 从多指标评价的角度来看, 本文算法的融合性能优于其他3种融合策略, 说明双非局部注意力模型是有效的, 使用双非局部注意力特征融合模块能融合图像更多的多尺度深度特征, 提高融合性能.

| 表 2 不同特征融合层的评价指标 |

3.4 不同融合方法比较

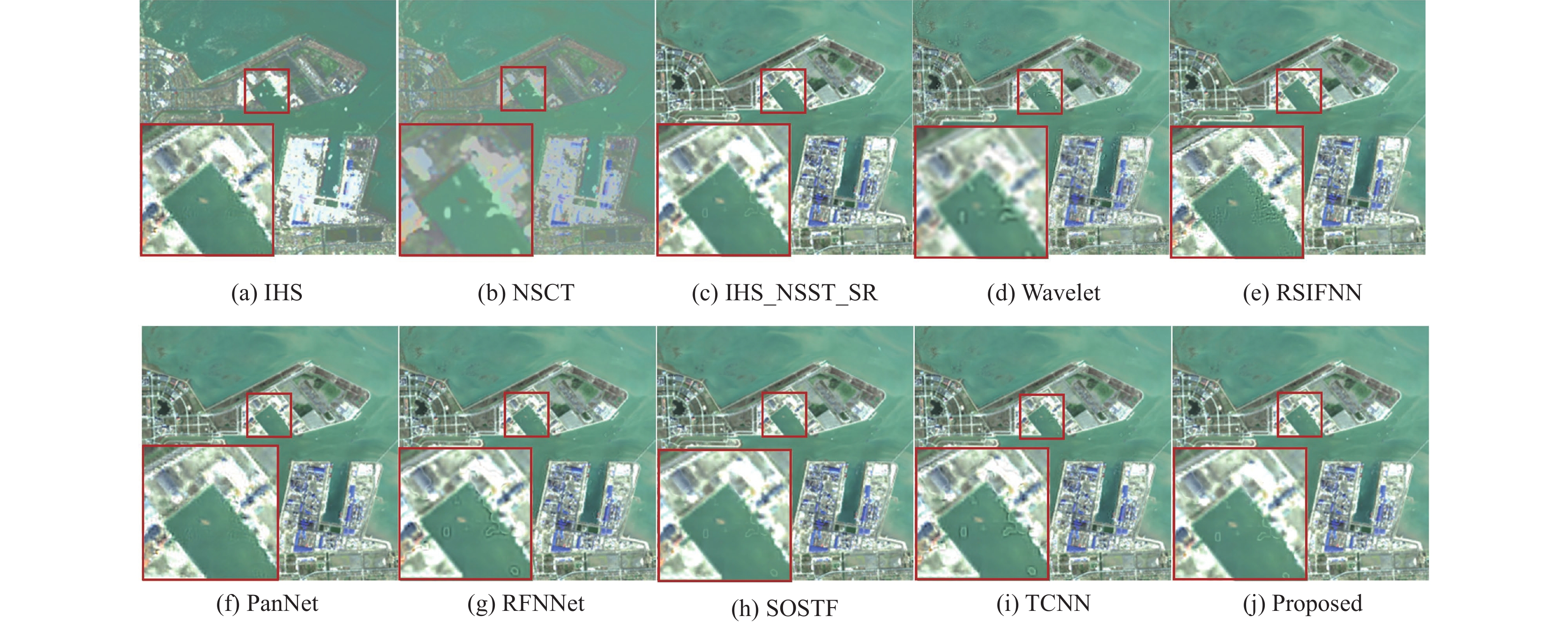

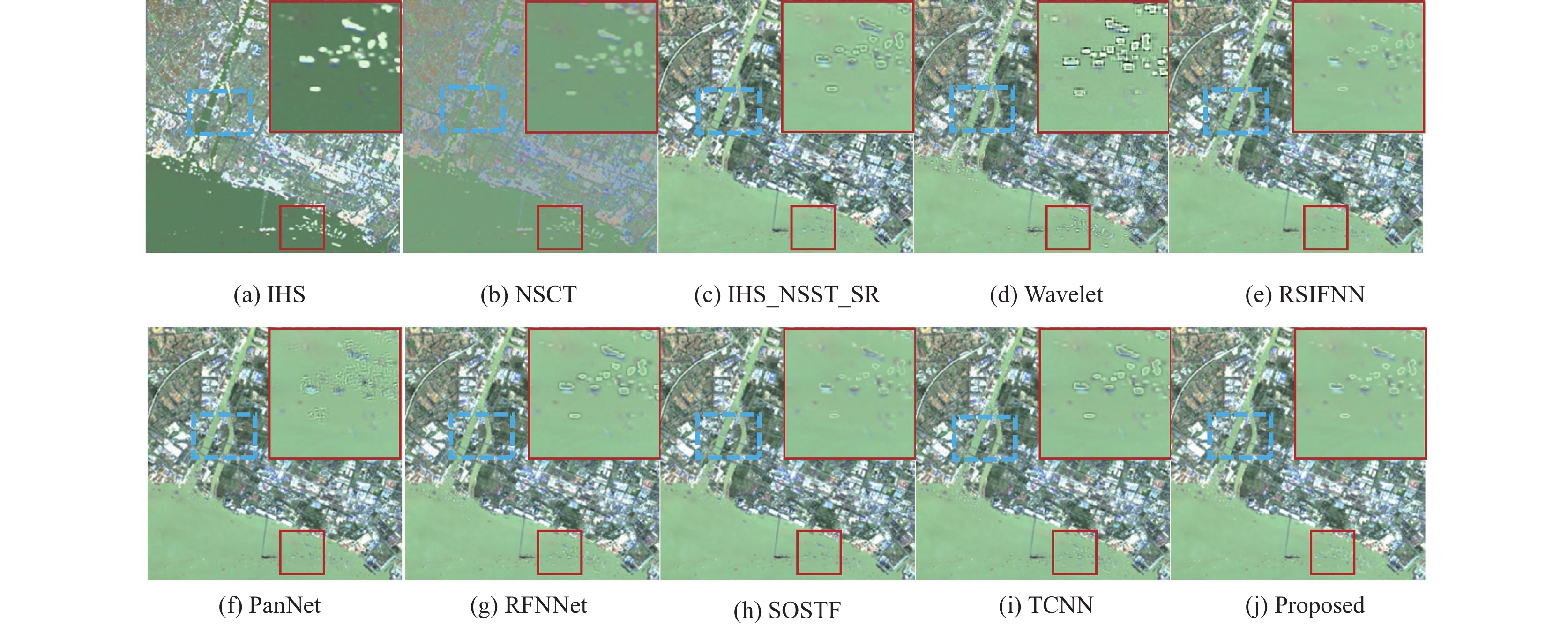

为验证本文算法在融合SAR和光学图像互补特性上的有效性, 将本文算法与传统算法IHS、NSCT[4]、IHS_NSST_SR[22]、Wavelet、深度学习算法RSIFNN[23]、PanNet[9]、RFNNet[24]、SOSTF[14]及双分支卷积神经网络(TCNN)[13]进行比较, 对比算法的参数全部按照原始论文中的参数设置.

3.4.1 定性评价图8和图9显示了不同算法的融合结果, 红色框部分突出显示了融合图像的一些关键区域, 将红框中的区域进行上采样, 放到图像的左下角(图8)和右上角(图9), 以便进行更明显的比较. 与其他方法相比, 图8(j)本文方法实现了细粒度级目标增强, 并充分提取了局部和非局部的特征信息, 得到了最清晰的轮廓、最丰富的纹理和最少的颜色误差. 特别是在有桥梁的图像中, 蓝色虚线方框表明本文方法能够很好保持一些小目标的形状和结构, 而其他方法容易产生一些边缘失真和纹理模糊的现象. 相比之下, 虽然其他方法在处理结构相对简单的水体和山地植被图像时可以达到一定的性能, 但对于其他类型的图像, 它们都存在不同方面的缺陷. 其中, 图8(d) Wavelet算法和图8(e) RSIFNN算法的融合结果纹理锯齿状明显且无法生成清晰的边界, 这在红色放大框中表现得很明显. 在图8(a) IHS算法和图8(b) NSCT算法融合的图像中空间细节明显增强, 但存在严重的颜色失真问题, 特别是在耕地和水体部分. 图8(f) PanNet、图8(g) RFNNet和图8(h) SOSTF的融合结果在大多数类型上都表现得比较好, 但在清晰度和细节方面都不如本文方法, 从建筑区域上可以看出细节不够清晰、边缘比较模糊. 最后, 图8(c) IHS_NSST_SR和图8(i) TCNN在空间细节和光谱保持上都取得了较好的效果, 但在细粒度级目标上仍不理想, 存在地物边缘失真现象. 第2组南通市长江流域数据集的融合结果(图9)与上述评论基本一致. 总之, 本文所提出的方法在融合所有类别的图像上都有较好的效果, 并且融合的结果在视觉上最接近真实图像.

3.4.2 定量评价本文使用5种定量性能指标: 相关系数(CC)、平均波段通用图像质量指数(QAVE)、峰值信噪比(PSNR)、结构相似性(SSIM)、光谱角映射器(SAM)和相对平均光谱误差(ERGAS). SAM和ERGAS的理想值为0, 而CC、QAVE、PSNR和SSIM的理想值为1.

|

图 8 通州湾数据集的不同算法融合结果 |

|

图 9 南通市长江流域数据集的不同算法融合结果 |

表3和表4显示了使用所有测试图像进行定量评估的平均结果. 用粗体标记的值代表所有方法中的最佳值, 下划线表示次优值. 结果表明, 本文方法在空间结构和光谱质量上均取得较好结果. 就CC、PSNR和ERGAS而言, 我们的方法明显优于其他方法. 特别是对于PSNR, 我们的方法获得了最高的值

| 表 3 不同算法通州湾数据集融合结果比较 |

| 表 4 不同算法南通市长江流域数据集融合结果比较 |

4 结论

为了更加有效地融合SAR和光学图像的互补特征, 本文提出一种结合双非局部注意力感知的SAR和光学图像融合网络, 该网络由空间上下文感知编码器、双非局部注意力特征融合模块以及融合重建解码器组成. 通过与传统算法IHS、NSCT、IHS_NSST_SR、Wavelet、深度学习算法RSIFNN、PanNet、RFNNet、TCNN及SOSTF算法进行比较, 实验结果在定性和定量评价上均表现出色, 结论如下.

该方法充分保留了不同尺度下的有效特征, 通过空间上下文感知模块构建多级金字塔结构, 用于提取SAR图像的空间结构信息和光学图像的纹理信息, 并在不同尺度之间进行特征融合; 通过图像封装决策, 将SAR和光学图像的每个通道进行封装重排以便于进行相对独立的处理, 增强SAR图像的强度信息与光学图像的每个光谱波段之间的共性关系, 进一步获得高精度融合结果; 引入双非局部注意力模块作为融合策略, 有效提取SAR图像的结构信息和光学图像的纹理信息, 实现了特征的融合和重建, 极大地提升SAR和光学图像融合的有效性. 未来研究将尝试使用其他可替代的注意力模型, 例如GCNET[25], 以进一步降低计算复杂度, 或者尝试将CNN同Transformer相结合, 改进和优化算法以提高融合性能.

| [1] |

金益如, 杨学志, 董张玉, 等. 一种NSST与稀疏表示相结合的遥感图像融合算法. 地理与地理信息科学, 2016, 32(2): 60-66. DOI:10.3969/j.issn.1672-0504.2016.02.012 |

| [2] |

邰建豪, 潘斌, 赵珊珊, 等. 基于Shearlet变换的SAR与多光谱遥感影像融合. 武汉大学学报(信息科学版), 2017, 42(4): 468-474. |

| [3] |

童涛, 杨桄, 谭海峰, 等. 基于NSCT变换的多传感器图像融合算法. 地理与地理信息科学, 2013, 29(2): 22-25, 59. |

| [4] |

易维, 曾湧, 原征. 基于NSCT变换的高分三号SAR与光学图像融合. 光学学报, 2018, 38(11): 1110002. |

| [5] |

Zhang Q, Liu Y, Blum RS, et al. Sparse representation based multi-sensor image fusion for multi-focus and multi-modality images: A review. Information Fusion, 2018, 40: 57-75. DOI:10.1016/j.inffus.2017.05.006 |

| [6] |

Shah VP, Younan NH, King RL. An efficient pan-sharpening method via a combined adaptive PCA approach and contourlets. IEEE Transactions on Geoscience and Remote Sensing, 2008, 46(5): 1323-1335. DOI:10.1109/TGRS.2008.916211 |

| [7] |

Yang Y, Zhang YM, Huang SY, et al. Infrared and visible image fusion using visual saliency sparse representation and detail injection model. IEEE Transactions on Instrumentation and Measurement, 2021, 70: 5001715. DOI:10.1109/TIM.2020.3011766 |

| [8] |

Masi G, Cozzolino D, Verdoliva L, et al. Pansharpening by convolutional neural networks. Remote Sensing, 2016, 8(7): 594. DOI:10.3390/rs8070594 |

| [9] |

Yang JF, Fu XY, Hu YW, et al. PanNet: A deep network architecture for pan-sharpening. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 1753–1761. [doi: 10.1109/ICCV.2017.193]

|

| [10] |

Liu L, Wang J, Zhang EL, et al. Shallow-deep convolutional network and spectral-discrimination-based detail injection for multispectral imagery pan-sharpening. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2020, 13: 1772-1783. DOI:10.1109/JSTARS.2020.2981695 |

| [11] |

Chen YX, Bruzzone L. Self-supervised SAR-optical data fusion of Sentinel-1/-2 images. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 5406011. DOI:10.1109/TGRS.2021.3128072 |

| [12] |

Jin C, Deng LJ, Huang TZ, et al. Laplacian pyramid networks: A new approach for multispectral pansharpening. Information Fusion, 2022, 78: 158-170. DOI:10.1016/j.inffus.2021.09.002 |

| [13] |

吴佼华, 杨学志, 方帅, 等. 基于双分支卷积神经网络的SAR与多光谱图像融合实验. 地理与地理信息科学, 2021, 37(2): 22-30. DOI:10.3969/j.issn.1672-0504.2021.02.004 |

| [14] |

Ye YX, Liu WC, Zhou L, et al. An unsupervised SAR and optical image fusion network based on structure-texture decomposition. IEEE Geoscience and Remote Sensing Letters, 2022, 19: 4028305. |

| [15] |

Zhang YZ, Zhang HS, Lin H. Improving the impervious surface estimation with combined use of optical and SAR remote sensing images. Remote Sensing of Environment, 2014, 141: 155-167. DOI:10.1016/j.rse.2013.10.028 |

| [16] |

Fang FM, Li JC, Yuan YT, et al. Multilevel edge features guided network for image denoising. IEEE Transactions on Neural Networks and Learning Systems, 2021, 32(9): 3956-3970. DOI:10.1109/TNNLS.2020.3016321 |

| [17] |

Wang XL, Girshick R, Gupta A, et al. Non-local neural networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7794–7803.

|

| [18] |

范艺华, 董张玉, 杨学志. 结合上下文编码与特征融合的SAR图像分割. 中国图象图形学报, 2022, 27(8): 2527-2536. DOI:10.11834/j.issn.1006-8961.2022.8.zgtxtxxb-a202208018 |

| [19] |

Deng LJ, Vivone G, Jin C, et al. Detail injection-based deep convolutional neural networks for pansharpening. IEEE Transactions on Geoscience and Remote Sensing, 2021, 59(8): 6995-7010. DOI:10.1109/TGRS.2020.3031366 |

| [20] |

董张玉, 许道礼, 张晋, 等. 基于双分支多尺度残差融合嵌套的SAR和多光谱图像融合架构与实验. 地理与地理信息科学, 2023, 39(1): 23-30. DOI:10.3969/j.issn.1672-0504.2023.01.004 |

| [21] |

Wald L, Ranchin T, Mangolini M. Fusion of satellite images of different spatial resolutions: Assessing the quality of resulting images. Photogrammetric Engineering and Remote Sensing, 1997, 63(6): 691-699. |

| [22] |

盛佳佳, 杨学志, 董张玉, 等. 基于NSST-IHS变换稀疏表示的SAR与可见光图像融合. 图学学报, 2018, 39(2): 201-208. |

| [23] |

Shao ZF, Cai JJ. Remote sensing image fusion with deep convolutional neural network. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2018, 11(5): 1656-1669. DOI:10.1109/JSTARS.2018.2805923 |

| [24] |

Li H, Wu XJ, Kittler J. RFN-Nest: An end-to-end residual fusion network for infrared and visible images. Information Fusion, 2021, 73: 72-86. DOI:10.1016/j.inffus.2021.02.023 |

| [25] |

Cao Y, Xu JR, Lin S, et al. Global context networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2023, 45(6): 6881-6895. DOI:10.1109/TPAMI.2020.3047209 |

2024, Vol. 33

2024, Vol. 33