无人机的技术迅速发展提高了目标检测技术在航拍任务中的应用价值, 然而传统的目标检测方法如Faster-RCNN[1]、RetinaNet[2]、YOLO[3]等算法框架在以往的目标检测任务中表现出色, 但它们在无人机航拍视角下, 面对复杂场景和光线不均匀等挑战时, 对于目标的检测能力仍显不足. 因此, 需要开发一种无人机小目标检测模型, 从而有效应对这些应用场景的特殊要求.

当前基于深度学习的无人机图像目标检测方法可以分为双阶段与单阶段两类, 双阶段方法以Faster-RCNN为代表, 先通过区域建议网络(RPN)产生候选区域, 再进行分类, 此算法对单张特征图进行处理, 导致图像中的空间信息被高度压缩, 不利于小目标的识别. 对此, Yin等[4]基于Faster-RCNN算法增加了相应的域自适应分量, 对RPN网络进行了改进以提高小目标检测性能, 但模型对训练样本的质量要求较高, 不具备一定的泛化能力.

与此同时, 单阶段方法如RetinaNet和YOLO系列也在快速发展. YOLO系列算法作为单阶段目标检测领域的先驱, 将目标检测任务从传统的分类问题转变为回归问题. 然而, 这类算法在多次下采样的过程中会导致输入图像的分辨率降低, 进而造成特征信息的丢失, 从而影响检测准确度, 尤其对小目标或者密集场景检测具有局限性[5]. RetinaNet采用单阶段架构, 并通过Focal Loss解决类别不均衡问题, 提高了密集目标检测的效率. 这种架构的关键在于能够将深层的强语义信息传递至浅层, 进而增强检测性能. 然而它也存在两大挑战: 特征图在自上而下传播时分辨率降低, 导致小目标信息丢失; 横向连接的通道压缩削弱了小目标特征. 这些限制是当前单阶段检测系统需要优化的关键点. 为了提高这些方法的效率和准确性, 一些研究者进行了进一步的优化. 例如, Zhao等[6]基于RetinaNet, 使用系统聚类方法重新选择锚点的规模和数量, 并优化基于RetinaNet的焦点损失计算来提升无人机检测精度, 但是推理速度有待进一步提升. 黄海生等[7]在YOLOv5基础上引入MobileNetv3骨干网络、CBAM注意力模块和SiLU激活函数, 构建了轻量化且高效的YOLOv5-tiny网络, 有效平衡了航拍场景目标检测的速度与精度. Tan等[8]针对特征金字塔结构进行创新性优化, 提出双向特征金字塔结构以融合不同尺度的特征. Wang等[9]在YOLOv7-tiny基础上引入全局注意力机制 (GAM) 和Context Transformer 模块等方法来提高无人机航拍图像中的检测精度, 同时增加了额外的计算量. Zhang等[10]在YOLOv8中引入sandwich fusion模块, 增强了无人机小目标的检测能力, 但同时也增加了计算负担. Du等[11]设计的稀疏卷积, 在优化检测头的同时减轻了计算量, 但影响模型精度.

基于以上, 针对无人机视角下航拍图像目标检测困难的问题, 本文在YOLOv8n模型的基础上进行改进, 具体如下.

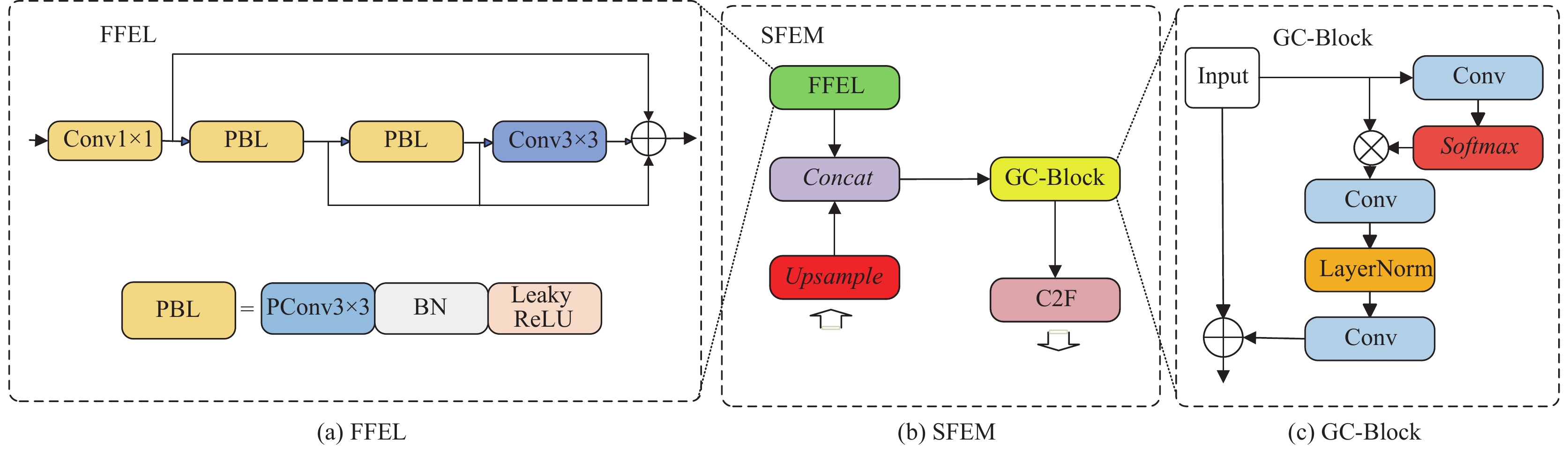

(1)提出浅层特征增强模块(SFEM), 融合浅层空间信息与颈部自顶向下传播的深层语义信息, 使网络更加关注图像的细节信息, 然后利用全局上下文模块(GC-Block)对融合后的特征图进行重校准, 并在此基础上增添小目标检测头, 提升小目标检测性能.

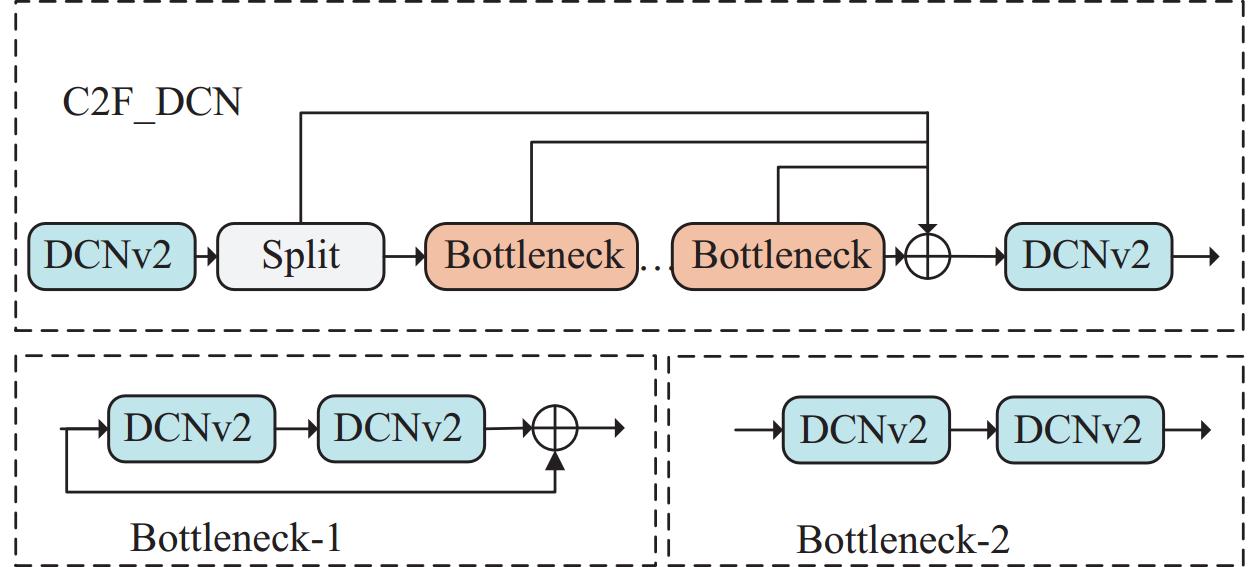

(2)将骨干网中特定的C2F层替换为DCN_C2F模块, DCN_C2F模块引入了可变形卷积(deformable convolutional networks v2, DCNv2)[12]来自适应学习每个卷积点在感受野内的空间偏移, 有效聚焦于目标特征, 克服因下采样引起的特征失真问题.

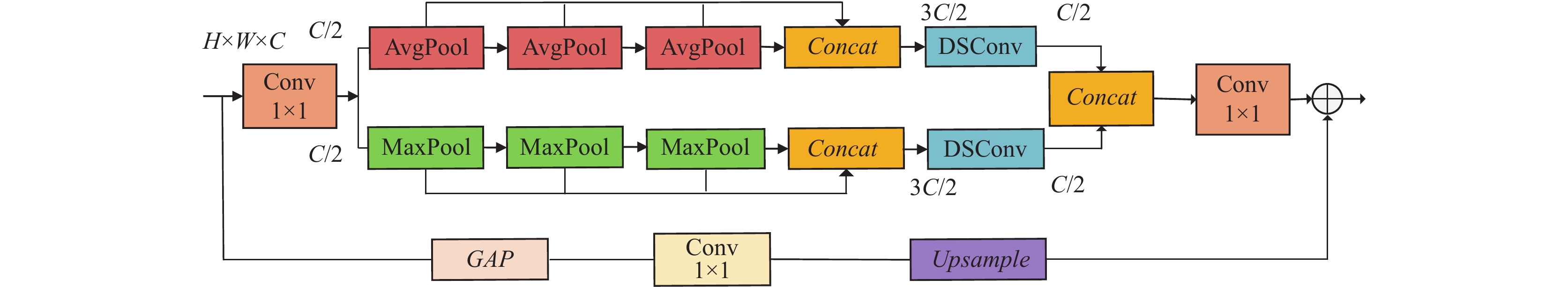

(3) 改进空间金字塔池化 (spatial pyramid pooling-fast, SPPF)[13]结构, 结合全局池化和平均池化的双金字塔池化层来保留高层次的语义信息, 之后通过上采样将低层特征结合来减少空间细节信息的丢失, 提高对小目标的检测灵敏度, 抑制复杂背景的干扰, 从而降低误检与漏检的风险, 确保模型的精确性.

(4)为应对目标特征提取中的尺度下降问题, 引入了中尺度特征合成层(MFSL)让特征过度更平滑, 并在此基础上采用跳跃连接和颈部网络的特征融合层来强化对目标的检测能力, 提高特征融合的效率.

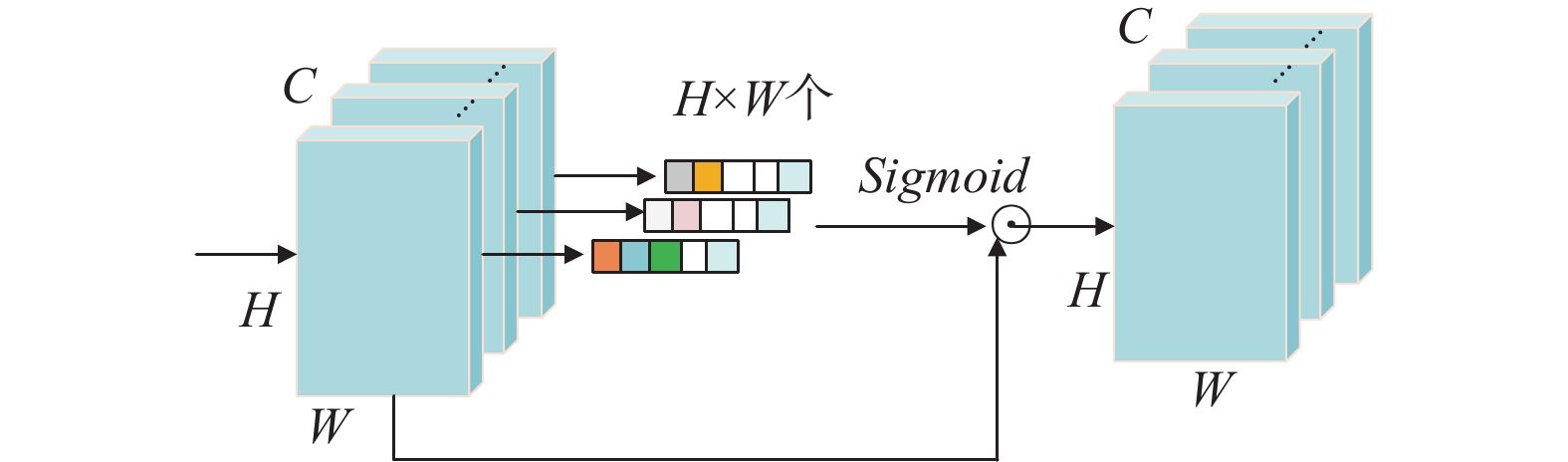

(5) 在模型颈部增添简单无参注意力模块(simple, parameter-free attention module, SimAM)[14], 对特征图中的每个位置赋予不同的权重, 突出重要的特征并抑制不重要的部分, 有助于优化特征传递和融合, 提高检测精度并减少误检率, 进而改善模型的总体性能.

1 网络改进 1.1 改进YOLOv8n网络结构YOLOv8是YOLO系列中最新的目标检测模型, 它在主干网络(Backbone)、颈部(Neck)和头部(Head)方面相比以往版本进行了显著的改进.

(1) 主干网络: YOLOv8主干网络使用C2F模块, 与之前的C3 (CSPDarkNet53)相比, C2F模块通过合并所有瓶颈模块的输出来提高训练速度和改善梯度流, 更快地处理图像并提取重要特征.

(2) 颈部: 颈部的设计对于在不同层级之间传递和融合特征至关重要. YOLOv8在颈部结构中结合了特征金字塔网络(FPN)和路径聚合网络(PAN)[15], 增强对不同尺度目标的检测能力, 有助于提高模型的整体性能.

(3) 头部: YOLOv8的头部结构实现了从基于锚点的方法向无锚点的转变. 它采用了解耦式设计, 使得分类和回归任务分开执行, 从而提升了模型性能. 此外, YOLOv8在损失函数上也做了改进, 引入了任务对齐分数, 这个分数将分类分数与交并比(intersection over union, IoU)分数相结合, 有助于模型在分类和定位上的精确性.

此外, YOLOv8根据网络的深度和宽度分为不同的型号(nano, small, medium, large, extra large), 以适应从轻量级移动设备到高精度需求的各种应用场景, 提供了显著的性能改进和更高的检测精度.

综合考虑算法的检测精度和实际应用, 本文基于YOLOv8n提出了一种改进的目标检测算法(SFE-YOLO), 结构如图1所示, 使用浅层特征增强模块SFEM与C2F_DCN模块优化主干网络, 保持空间细节并减少形变. 改进快速空间金字塔池化结构, 以减少模型的误检率并提高检测精度. 结合中尺度特征合成层和跳跃连接以增强特征重用性, 融入SimAM强化无人机目标检测精度.

|

图 1 改进YOLOv8网络结构 |

1.2 浅层特征增强模块

常见的目标检测网络在深层特征提取过程中往往会丢失空间细节和边缘位置等浅层特征信息, 这对小目标的检测性能影响较大. 因此, 本文提出浅层特征增强模块(shallow feature enhancement module, SFEM). 如图2所示, SFEM首先通过快速特征提取层(fast feature extraction layer, FFEL)提取浅层空间信息. 然后将其与主干网络通过颈部自顶向下传播获得的深层语义信息进行融合, 得到更丰富的特征图, 接着嵌入GC-Block, 通过其捕获全局上下文关系, 对特征图进行重校准, 增强网络去噪能力和细节信息表征能力.

快速特征提取层(FFEL)通过减少计算冗余和内存访问, 提高计算效率, 尤其是通过引入部分卷积(PConv)[16]来减少浮点运算量和参数数量, 同时有效提取特征空间信息. 为解决连续卷积和池化层可能导致关键信息丢失导致模型对小目标检测不利的问题, 嵌入快速特征提取层(FFEL)初步提取浅层信息. 如图2(a)所示, 它由一个Conv1×1层、两个PConv3×3层和一个Conv3×3组成, 并且加入了残差连接. 其中, Conv1×1层负责初步特征提取, 随后的PConv3×3层则通过减少计算冗余和内存访问来提升效率. Conv3×3层负责进一步的特征提取, 残差连接增强了输出特征的维度, 减少有用特征的丢失, 同时缓解网络加深导致的特征衰减问题, 有助于保持网络性能并提高检测精度.

全局上下文块(GC-Block)结合简化非局部(SNL)模块和挤压激励(SE)模块的优点, 可以提供长距离依赖信息的有效建模, 同时保持轻量级的计算量, 通过使用瓶颈结构的转换模块, 从而将参数量大幅降低. 通过GC-Block实现对全局上下文信息的有效捕捉并对特征进行重校准, 增强对小目标特征的捕获能力, 并通过注意力机制的重分配进一步提升了网络对小尺度目标的敏感度, 如式(1)所示, GC-Block的详细体系结构如图2(c)所示.

| $ {Z_i} = X_i + {W_{v2}}ReLU\left(LN\left({W_{v1}}\sum\nolimits_{j = 1}^{Np} {{\varphi _j}} \right)\right) $ | (1) |

| $ {\varphi _j} = \sum\limits_{j = 1}^{Np} {\frac{{{{\mathrm{e}}^{{W_k}{X_j}}}}}{{\displaystyle\sum\limits_{m = 1}^{Np} {{{\mathrm{e}}^{{W_k}{X_m}}}} }}X_j} $ | (2) |

在GC-Block中的输入特征图Xi, 首先经过一个卷积层Wk提取关键信息以计算全局注意力权重. 这些权重通过Wk与特征Xj的线性变换和随后的Softmax正规化获得, 反映了每个特征在全局上下文中的重要性. 接着, 输入特征图Xi通过这些权重进行加权, 强调了重要特征. 加权特征图经由第2个卷积层Wv1进一步变换, 并通过层归一化和ReLU激活函数处理, 以增强特征的非线性表示和训练稳定性. 最终, 通过与原始输入特征图Xi相加, 结合了局部细节和全局上下文信息, 并通过第3个卷积层Wv2的最终处理, 形成了融合后的输出特征图Zi, 为网络的下一步操作或作为最终输出提供了综合丰富的特征表达.

|

图 2 SFEM详细结构 |

1.3 C2F_DCN

在无人机目标检测领域, 面对多尺度及复杂背景小目标的检测任务, 常规卷积神经网络由于固定的感受野和空间几何结构, 在下采样过程中易于引起信息丢失, 尤其是当目标尺寸小或存在变形时. 为此, 在YOLOv8骨干网络中嵌入C2F_DCN模块, 以增强网络对变化目标形态的适应性. 该模块结合了可变形卷积网络(deformable convolutional networks v2, DCNv2), 它能够学习每个卷积点的空间偏移量, 使得卷积核的感受野动态适应目标的实际形态, 缓解传统卷积结构的局限性.

如图3所示, 每个C2F_DCN模块包含2个DCNv2和n个BottleNeck. C2F_DCN模块通过1×1卷积调整输入特征的通道数, 并使用Split操作来划分特征, 不仅降低了参数的数量, 而且通过增强梯度流使得网络结构更加丰富, 有效提取更多样化和多尺度的特征, 适用于无人机目标检测中的多尺度目标.

|

图 3 C2F_DCN结构 |

根据是否需要残差连接, 将Bottleneck结构分为Bottleneck-1结构和Bottleneck-2结构. 在Bottleneck-1中, 输入输出之间采用残差连接, 用于优化骨干网络, 可以缓解梯度爆炸问题. Bottleneck-2采用串行连接的方式进行信息传输, 由于特征融合结构作用在颈部, 直接输出可以在更大程度上保留融合后的特征信息. 由于特征融合结构作用在颈部, 直接输出可以在更大程度上保留融合后的特征信息. Backbone中使用了3个C2F_DCN模块, 分别用于主干特征提取网络的第4层、第6层和第8层.

综上, C2F_DCN模块通过集成DCNv2及其可变形卷积操作和Bottleneck单元, 以处理多尺度和几何变形目标检测任务, 促进特征的有效表示.

1.4 ASPPF在YOLOv8的架构中, 颈部采用的SPPF (spatial pyramid pooling fast)结构为多尺度特征提取和目标检测性能的增强提供了基础. 该模块通过连续的最大池化提取特征, 加快了处理速度. 然而, 在无人机航拍的应用场景中, 由于其图像特征的复杂性和小目标的存在, 原模型会导致部分空间信息的丢失, 同时利用最大池化会将噪声当做显著特征保留, 导致模型产生误检. 因此, 本文对SPPF模块进行改进, 改进后的结构如图4所示. ASPPF通过以下4个步骤实现对无人机航拍图像中目标的高效准确检测.

首先, 特征降维与尺度分解优化: 输入特征图通过一个1×1的卷积层进行初步降维处理, 将通道数减半, 以便减轻计算负担同时保留重要特征信息.

| $ F' = Conv_{1 \times 1}(F) $ | (3) |

|

图 4 ASPPF结构 |

其次, 双重金字塔池化. 平均池化分支: 对降维后的特征图进行3个不同尺度的平均池化操作, 以捕获背景和上下文信息. 最大池化分支: 同时对相同的降维特征图进行3个不同尺度的最大池化操作, 以突出显著特征.

| $ F_{\rm avg} = Concat\left( {AP_{s_1}\left( {F' } \right), AP_{s_2}\left( {F' } \right), AP_{s_3}\left( {F' } \right)} \right) $ | (4) |

| $ F_{\rm max} = Concat(\mathit{MP}_{s_1}(F' ), \mathit{MP}_{s_2}(F' ), \mathit{MP}_{s_3}(F' )) $ | (5) |

其中, AP代表平均池化, MP代表最大池化, si (i=3, 5, 7)代表不同的池化核.

然后, 深度可分离卷积与特征融合. 对两个池化分支的输出分别应用深度可分离卷积, 这种卷积可以进一步提取特征的同时显著降低参数数量. 接着将两个分支的深度可分离卷积输出通过Concat操作合并, 再通过一个1×1卷积层进行融合, 以获得丰富的特征表示.

| $ F_{\rm merged} = Conv_{1 \times 1}(Concat(\mathit{DSConv}({F_{\rm avg}}, {F_{\rm max}})) $ | (6) |

最后, 全局与局部特征的特征融合. 经过全局平均池化, 1×1卷积、批量归一化和非线性处理的高级特征生成全局上下文, 然后将这些全局上下文特征通过上采样与低级特征相结合. 从而实现高阶特征对低阶特征图的补充.

| $ {F_{g}} = \mathit{Upsample}(Con{v_{1 \times 1}}(GAP(F))) $ | (7) |

| $ {F_{\rm final}} = {F_{\rm merged}} + {F_g} $ | (8) |

ASPPF优化了无人机航拍图像中微小目标的识别. 池化层与1×1卷积的融合不仅锚定了高层次的语义信息, 而且通过上采样与低层特征的结合, 减少空间细节信息丢失. 这种特征融合策略显著提高对小目标的检测灵敏度, 抑制复杂背景中的干扰, 降低误检与漏检的风险, 确保模型的精确性.

1.5 中尺度特征合成层在PAN-FPN架构中, 通过将PAN与FPN相结合, 构建了一个自上而下及自下而上的网络结构. 这种结构通过特征融合有效地实现了浅层位置信息与深层语义信息的互补. 然而, 由于主干网络中每一层卷积步长为2, 导致输出特征图的尺寸仅为输入层大小的1/4. 这种显著的尺度降低会导致相邻层间特征过渡不够平滑, 这在无人机航拍图像的目标特征提取中尤为不利. 针对此问题, 提出了一种新的特征融合策略——中尺度特征合成层(mesoscale feature synthesis layer, MFSL), 如图5(a)所示. 该层旨在解决主干网络中由于较大步长导致的特征图尺寸快速缩减问题. 具体来说, 对于主干网络中的输出特征图, 通过下采样或上采样操作, 将输出特征图调整至中间特征图的统一尺寸. 随后, 通过平均加权融合操作将两层特征图融合, 避免Concat操作导致的通道数倍增问题, 并通过3×3卷积层进一步提取合成尺度特征.

|

图 5 SPAN-FPN详细结构 |

为提升小型无人机目标的检测能力, SFE-YOLO引入跳跃连接(skip connections, SK), 将原始输入与同级输出连接, 以丰富深层特征的语义信息. 为充分利用浅层的空间位置信息, 在颈部网络中增加特征融合层, 调整特征图尺度, 并与MFSL提取的中尺度特征信息进行加权融合, 确保了特征融合的高效性和动态性.

最后, 添加一层更适合小目标检测的尺度H2, 分辨率为160×160像素, 相当于在骨干网络中进行了仅两次下采样操作, 包含了更丰富的底层特征信息. H2检测头与原检测头结合使用, 可以有效降低尺度方差带来的负面影响, 提高模型对小目标的检测能力. 虽然增加检测头带来了额外的计算量和内存开销, 但显著提升了对小目标的检测性能.

1.6 SimAM注意力机制SFE-YOLO结合SimAM, 进一步提升无人机目标检测的性能. 如图6所示, 该模块借助一个无需参数的能量函数, 自动调节注意力分布, 从而有效地捕获通道和空间层面的关键特征, 并消除了手动调节超参数的需要. 在颈部末尾添加SimAM增强YOLOv8算法在处理无人机拍摄图像时的目标检测能力, 提高检测的准确性. SimAM源于神经科学理论, 并基于能量函数提取基本特征. 每个神经元的能量函数如下:

| $ {e_t} = \frac{{4\left( {{{\hat \sigma }^2} + \lambda } \right)}}{{{{\left( {t - \hat u} \right)}^2} + 2{\sigma ^2} + 2\lambda }} $ | (9) |

| $ \hat u = \frac{1}{M}\sum _{{{i}} = 1}^Mx_i $ | (10) |

| $ {\hat \sigma ^2} = \frac{1}{M}\mathop \sum \limits_{i = 1}^M {\left( {{x_i} - \hat \mu } \right)^2} $ | (11) |

其中,

| $ \tilde X = \mathit{Sigmoid}\left( {\frac{1}{E}} \right) \odot X $ | (12) |

|

图 6 SimAM注意力结构 |

2 实验分析 2.1 实验数据集

VisDrone2019数据集[17]是主流的无人机航拍数据集之一, 由天津大学机器学习和数据挖掘团队AISKYEYE收集. VisDrone2019包含6471个训练图像, 548个验证图像和1610个测试图像. 这个数据集有10类, 包括行人、人、自行车、汽车、货车、三轮车、遮阳三轮车、公共汽车、卡车和摩托车. 其中, 处于站立或行走姿态的人类图像分类为“行人”, 其他姿态的分类为“人”.

PASCAL VOC2012数据集[18]包含来自各种场景的图像, 例如室内环境、城市街景和自然景观. 共有20个类别的物体, 包括人、动物(如猫、狗)、车辆(如汽车、自行车)和室内物品(如瓶子、椅子), 包含数17125张图像, 每张图像都经过了人工标注, 确保了标注的质量和准确性.

2.2 实验环境和参数实验主要以YOLOv8n网络作为基本对照, 具体实验环境如表1所示. 网络训练使用Adam优化器, 初始学习率为0.01, 权重值衰减为0.0005, 批大小(batch_size)为16, 批次(epoch)为300. 图片输入尺寸为640×640. 此外, 使用默认的数据增强方法, 并且所有消融实验、对比实验均采用相同设置, 无额外的训练.

| 表 1 实验硬件环境 |

2.3 评价指标

本文从精确率(precision, P)、召回率(recall, R)、平均精确率均值(mean average precision, mAP)、模型参数量(parameter, Params)、浮点数运算量(floating point operations, FLOPs)这5个方面来衡量模型的检测性能. 其中, mAP用于网络模型评价的整体性能, mAP@0.5代表IoU阈值为0.5时的平均AP (average precision), FLOPs指每秒浮点运算次数, 理解为计算速度, 可以用来衡量硬件的性能, 相关公式如下:

| $ P = \dfrac{{TP}}{{TP + FP}} $ | (13) |

| $ R = \dfrac{{TP}}{{TP + FN}} $ | (14) |

| $ AP = \int_0^1 {P(R){\text{d}}R} $ | (15) |

| $ mAP = \dfrac{{\displaystyle\sum\nolimits_{i = 1}^k {AP_i} }}{k} $ | (16) |

| $ FLOPs = C_i \times {K^2} \times C_0 \times W \times H $ | (17) |

其中, TP表示准确判定正样本; FP表示错误判定为正样本; FN表示错误判定负样本; K表示样本数据类别. 其中表示C0输出通道数, Ci表示输入通道数, W表示卷积核宽, H表示卷积核高.

2.4 消融实验为了验证改进算法的有效性, 采用VisDrone2019数据集对基线模型进行消融实验, 结果如表2所示.

| 表 2 采用不同改进策略后的检测结果 |

相较于基线模型, 改进的模型F在实验结果精度上有明显提升, mAP@0.5提升3.6%. 模型A使用C2F_DCN代替YOLOv8n主干网络中的部分C2F, mAP@0.5提升0.8%, 可变形卷积的应用扩大网络的接受野, 提高网络对不同形状和位置特征的处理能力. 实验B在颈部结构嵌入了针对小目标的浅层特征增强模块SFEM, 同时结合小目标检测头能够有效检测到更多的小目标. mAP@0.5提升1.3%, 但是由于增加一个检测头以及SFEM模块, 参数量和浮点数运算也有所增加. 实验C改进原有的SPPF结构, 融合全局语义与局部细节特征强化了模型对小目标的识别能力, 并利用深度可分离卷积保证参数量和计算量微小增加, 精度提升1%. 模型D通过在颈部增加平滑尺度信息并融合不同尺度的特征, mAP提升了0.8%, 促进了模型整体性能的优化. 模型E引入了SimAM注意力机制, 能够增强特征表示的而不增加网络的参数量和计算量, mAP@0.5提升了0.7%, 说明在颈部增加SimAM注意力机制能使模型具有更好的特征提取能力. 模型F为改进后的SFE-YOLO模型, 模型参数量和浮点数运算相较于基线分别增加了0.8M和8.2G, mAP@0.5提升了3.5%, 说明改进的模型在不显著增加参数量的情况下, 实现了精度更高的检测效果.

2.5 对比实验 2.5.1 与YOLOv8n进行准确度对比为了证明改进模型对检测性能的提高效果, 将SFE-YOLO与基线进行对比实验, 如表3所示.

| 表 3 VisDrone2019数据集各类别对比结果 (%) |

根据表3的对比结果, 改进方法与基线相比, 各个类别的mAP均有提升, 尤其是人、行人和摩托车3个类别的mAP值提升幅度均在5%以上, 可见模型在对小目标类别具有较好的检测效果, 同时对卡车等相对较大目标检测效果依然明显, 这表明改进后的模型适用于无人机航拍任务. 然而模型对三轮车和遮阳三轮车等特征点不明显的类别检测效果还是较低, 在未来的研究中, 仍需针对这些特殊类别进行更为深入的优化和调整, 以期进一步提高模型的综合检测能力.

2.5.2 主流模型对比对比实验为了进一步证明SFE-YOLO算法在无人机航拍小目标中的检测效果, 在VisDrone2019数据集上将SFE-YOLO与经典的主流模型进行对比. 如表4所示, 加粗部分为该类别在所有算法中的最优值. 通过表4可以得出, SFE-YOLO算法在VisDrone2019数据集上的综合性能优异, 尤其是在行人、人和摩托车等较小物体的检测任务中, AP值分别达到了29.4%、18.7%和28.9%. 此外, 对于汽车等较大物体的检测精度也明显优于其他模型. 尽管与YOLOv7-tiny相比提升幅度不大, 但其参数量仅为YOLOv7-tiny的62%, 在综合性能上更显优势. 总之, SFE-YOLO在无人机航拍检测任务重表现良好, 不仅在较小物体上取得了明显的精度提升, 对较大物体也有明显的优势, 相较于其他常用的检测方法, SFE-YOLO算法综合检测性能占优.

| 表 4 不同算法在VisDrone测试集上的AP与mAP对比 (%) |

2.5.3 通用性对比实验

为了验证所提模型的泛化能力和准确性, 使用数据集PASCLA VOC 2012数据集上设计模型的通用性对比实验. 实验结果如表5所示. SFE-YOLO与基线相比, 精度提升1.3%, mAP提升0.8%, 说明改进的算法具有一定的通用性.

| 表 5 通用性对比实验 |

2.5.4 可视化对比实验

为了验证SFE-YOLO算法在实际场景中的检测效果, 使用VisDrone2019 测试集中白天和夜晚的不同场景, 包括夜间低光照城市交通场景、夜间小目标密集场景、白天复杂建筑施工场景和白天城市道路交通场景. 最终测试效果如图7所示, 左侧为原方法, 右侧为本文的改进方法.

|

图 7 在VisDrone2019数据集上的可视化对比图 |

由图7(a)可以发现, 基线算法对公共汽车存在漏检, 而SFE-YOLO算法能够准确进行识别. 由图7(b)和图7(c)可以发现, 在光线较暗的夜间小目标场景和白天复杂工业建筑场景中, 基线算法受到背景噪声的干扰, 从而产生大量漏检, 而SFE-YOLO算法通过浅层特征增强模块和颈部特征融合模块, 强化网络对感兴趣区域的关注度, 弱化背景噪声, 有效改善了小目标漏检情况. 在图7(d)中, 基线算法将小型建筑物误检为轿车, 而SFE-YOLO算法通过改进空间特征金字塔池化模块, 融合多尺度池化特征, 提高模型对小目标的检测灵敏度, 抑制复杂背景中的干扰, 降低误检, 总体而言, 改进后的算法在处理无人机视角下的小尺寸、背景复杂的图像时具有更强的辨识度, 而且有效减少了误检和漏检等现象.

3 结论与展望本文提出了一种基于YOLOv8n的无人机航拍目标检测算法, 通过引入浅层特征增强模块, 结合浅层空间和深层语义信息, 显著提升模型对小目标的检测精度. 此外, 算法在传统特征金字塔结构的基础上, 通过嵌入中尺度特征合成层和跳跃连接, 使得特征过渡更平滑并减少特征丢失. 嵌入ASPPF模块, 通过双重金字塔池化技术(包含平均池化和最大池化), 有效提取和融合特征, 同时降低模型的漏检率.

在效率方面, 采用部分卷积和深度可分离卷积减少了计算复杂度, 确保了高速推理, 同时通过SimAM注意力机制, 进一步精确地聚焦于关键信息. 在VisDrone2019数据集上的测试结果表明, 该算法在精度方面显著超越基线方法, 特别是在行人等小目标检测上提升明显. 与其他经典算法相比, SFE-YOLO算法具有较低参数量和较高检测精度, 同时, 有广泛的应用潜力和实际价值. 未来研究将进一步优化模型的计算效率和推理时间, 以便更好地适应边缘设备的部署需求.

| [1] |

Jiang HZ, Learned-Miller E. Face detection with the faster R-CNN. Proceedings of the 12th IEEE International Conference on Automatic Face & Gesture Recognition. Washington: IEEE, 2017. 650–657.

|

| [2] |

Lin TY, Goyal P, Girshick R, et al. Focal loss for dense object detection. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 2999–3007.

|

| [3] |

Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 779–788.

|

| [4] |

Yin GX, Yu M, Wang M, et al. Research on highway vehicle detection based on faster R-CNN and domain adaptation. Applied Intelligence, 2022, 52(4): 3483-3498. DOI:10.1007/s10489-021-02552-7 |

| [5] |

欧阳权, 张怡, 马延, 等. 基于深度学习的无人机航拍目标检测与跟踪方法综述. 电光与控制, 2024, 31(3): 1-7. |

| [6] |

Zhao T, Liu JY, Duan ZQ. UAV target detection based on RetinaNet. Proceedings of the 2019 Chinese Control and Decision Conference. Nanchang: IEEE, 2019. 3342–3346. [doi: 10.1109/CCDC.2019.8832517]

|

| [7] |

黄海生, 饶雪峰. 面向无人机航拍场景的轻量化目标检测. 计算机系统应用, 2022, 31(12): 159-168. DOI:10.15888/j.cnki.csa.008866 |

| [8] |

Tan MX, Pang RM, Le QV. EfficientDet: Scalable and efficient object detection. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 10778–10787. [doi: 10.1109/CVPR42600.2020.01079]

|

| [9] |

Wang ZY, Liu ZW, Xu G, et al. Object detection in UAV aerial images based on improved YOLOv7-tiny. Proceedings of the 4th International Conference on Computer Vision, Image and Deep Learning. Zhuhai: IEEE, 2023. 370–374. [doi: 10.1109/CVIDL58838.2023.10166362]

|

| [10] |

Zhang ZX. Drone-YOLO: An efficient neural network method for target detection in drone images. Drones, 2023, 7(8): 526. DOI:10.3390/drones7080526 |

| [11] |

Du BW, Huang YC, Chen JX, et al. Adaptive sparse convolutional networks with global context enhancement for faster object detection on drone images. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE, 2023. 13435–13444. [doi: 10.1109/CVPR52729.2023.01291]

|

| [12] |

Wang RX, Shivanna R, Cheng D, et al. DCN V2: Improved deep & cross network and practical lessons for Web-scale learning to rank systems. Proceedings of Web Conference 2021. 1785–1797.

|

| [13] |

He KM, Zhang XY, Ren SQ, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916. DOI:10.1109/TPAMI.2015.2389824 |

| [14] |

Yang LX, Zhang RY, Li LD, et al. SimAM: A simple, parameter-free attention module for convolutional neural networks. Proceedings of the 38th International Conference on Machine Learning. PMLR, 2021. 11863–11874.

|

| [15] |

Liu S, Qi L, Qin HF, et al. Path aggregation network for instance segmentation. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 8759–8768.

|

| [16] |

Chen JR, Kao SH, He H, et al. Run, don’t walk: Chasing higher FLOPS for faster neural networks. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE, 2023. 12021–12031.

|

| [17] |

Du D, Zhu P, Wen L, et al. VisDrone-DET2019: The vision meets drone object detection in image challenge results. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision Workshops. 2019.

|

| [18] |

Everingham M, Van Gool L, Williams CKI, et al. The pascal visual object classes (VOC) challenge. International Journal of Computer Vision, 2010, 88(2): 303-338. DOI:10.1007/s11263-009-0275-4 |

| [19] |

Bochkovskiy A, Wang CY, Liao HYM. YOLOv4: Optimal speed and accuracy of object detection. arXiv:2004.10934, 2020.

|

| [20] |

Wang CY, Bochkovskiy A, Liao HYM. YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE, 2023. 7464–7475.

|

2024, Vol. 33

2024, Vol. 33