2. 广西混杂计算与集成电路设计分析重点实验室, 南宁 530006

2. Guangxi Key Laboratory of Hybrid Computation and IC Design Analysis, Nanning 530006, China

多种眼科与心血管疾病会影响到视网膜血管的形态特征, 观察视网膜血管的形态学变化是辅助医生临床诊断的重要手段, 及时地发现以及跟踪患者的病况能够让医生更合理地制定治疗方案[1]. 然而, 手动分割视网膜血管的效率较低, 易受到医生主观因素的影响, 难以满足实际生活中大量临床诊断的需求, 为了节省人力资源与时间成本, 视网膜血管的自动分割技术成为医学图像领域的研究热点[2].

近些年来, 深度学习技术的快速发展让其在各个领域中展现了出色的成果, 使用深度学习算法实现视网膜血管的自动分割是研究者们的研究重点. Feng等人[3]使用基于块的全卷积神经网络实现对视网膜血管的分割, 通过局部熵采样与跳跃卷积结构, 加快了模型训练速度的同时也提升了分割的准确度, 但对血管细节特征的分辨能力仍有不足. 考虑到视网膜血管分割任务中正负样本不均衡的问题, Guo等人[4]通过一种空间注意力模块生成注意力特征图, 增强网络对血管部分的表现能力, 但对多尺度信息的利用不够充分. 吕佳等人[5]提出一种边界注意力辅助的动态图卷积视网膜血管分割网络, 通过捕获视网膜血管的全局结构信息和边界信息, 能够改善毛细血管断连的情况. Lin等人[6]提出一种使用多路径多尺度高分辨率表示的深度学习模型来对视网膜血管进行分割, 整体的分割效果得到了提升, 但对细血管部分的处理仍有不足. 王师玮等人[7]通过在编码和解码阶段使用卷积注意力模块, 引入注意力机制对血管的细微结构进行了通道和空间的增强, 但缺乏针对性. 为了改善血管与背景对比度低而难以分割的问题, 谷鹏辉等人[8]提出一种编解码算法, 使用全局卷积网络与边界细化替换了传统的卷积层, 同时引入了位置注意力与通道注意力模块来增加血管与背景之间的对比度. Gao等人[9]针对血管局部细节处理困难的问题, 提出了一种新型的多尺度全局注意力分割模型, 采用全局上下文注意力模块实现多尺度特征的融合, 同时引入注意力门模块改善类不平衡的问题, 使得模型在图像局部细节部分有更强的分割能力, 但获取的细节信息不够全面.

尽管近年来研究者们提出了多种不同的视网膜血管分割算法, 且取得了不错的效果, 但依旧存在着一些问题需要解决. 一方面, 传统卷积块存在信息冗余导致计算量增大的问题, 影响算法的推理速度; 另一方面, 多数算法在分割时对血管细节部分的针对力度不足, 容易造成细节丢失导致细血管的分割精度不高. 针对上述问题, 本文提出一种基于改进U-Net的多流视网膜血管分割算法, 主要贡献如下.

1)构建多特征流的视网膜血管分割算法, 在血管全局分割的基础上, 提供更丰富、更具针对性的细节特征信息, 提升整体分割精度.

2)构建全局分割流(global segmentation flow, GSF), 设计嵌入快速提取模块的改进U-Net结构, 减少特征提取过程中的信息冗余, 加快算法推理速度.

3)构建边缘特化流(boundary-specialized flow, BSF), 利用边缘标签针对性地提供血管边缘特征信息, 采用边缘注意力强调空间特征, 减少背景噪声干扰, 改善细血管分割效果.

1 相关工作 1.1 U-NetU-Net[10]在医学图像处理领域有着广泛的应用, 其模型结构由编码器与解码器组成, 根据特征图大小, 编码器与解码器又可分为4层. 在编码器部分, 各层形状为

U-Net在视网膜血管分割任务中也得到了广泛的应用, 研究者们结合U-Net模型结构简单, 方便扩展的特点, 提出了各种基于U-Net的深度学习模型, 并取得了不错的效果.

1.2 FasterNetFasterNet[11]作为通用的骨干网络, 提出新颖的部分卷积, 有效减少特征冗余、加快模型推理速度. 其核心的FasterNet Block采用部分卷积与逐点卷积的组合, 对于输入特征

| {(Fc,Fr)=S(F)Pc=C((Conv3×3(Fc)),Fr)F′=Conv1×1(σ(ψ(Conv1×1(Pc)))) | (1) |

其中,

针对传统U型网络特征冗余、计算效率低以及细节分割精度不足等问题, 本文提出一种基于改进U-Net的多流视网膜血管分割算法(multi-flow retinal vessel segmentation algorithm based on improved U-Net, MU-Net), 总体框架如图1所示. 算法包含两种特征流向, 分别为全局分割流与边缘特化流. 在全局分割流中, 整体采用4层的U型网络结构, 但不同于传统的U型网络, 全局分割流将传统卷积块替换为具有减少信息冗余、高效提取特征优势的快速提取模块, 加快算法的推理速度. 而在边缘特化流中, 为实现对血管边缘的细化建模, 采用4阶段的边缘提取模块采集血管细节信息, 各个边缘提取模块结合全局分割流中的高级语义特征, 完成粗、细网络的特征融合, 加入边缘注意力增强细血管的特征表达, 减少背景噪声干扰. 最后, 将两种特征流汇集, 使用1×1的卷积与Sigmoid激活函数获取概率特征图.

|

图 1 MU-Net |

2.1 全局分割流

多数U型网络的编解码过程采用传统卷积块实现, 而受文献[11]的启发, 使用传统卷积块容易提取到重复特征, 导致信息冗余以及计算资源的浪费, 影响算法的推理速度. 因此, 本文设计了一种基于改进U-Net的全局分割流, 将传统卷积块替换为快速提取模块, 更为高效地实现血管的特征建模, 加快算法推理速度. 全局分割流的结构如图1所示, 在编码器部分, 先使用3×3的卷积实现通道的扩展, 编码器各层通过快速提取模块提取血管特征, 上层与下层采用2×2的最大池化层进行下采样, 编码器各层输出输送至解码器完成低、高级语义特征的融合. 在解码器部分, 在提取血管特征的同时, 解码器各层输出输送至边缘特化流中, 为细节特征的获取提供高级语义信息, 同时下层特征图通过2×2的转置卷积逐步恢复至原图大小.

2.1.1 快速提取模块快速提取模块(faster extraction block, FE)旨在减少特征信息冗余、加快推理速度, 其在FasterNet Block的基础上引入了DropBlock[12], 这是由于眼底图像具有较强的结构关联, 使用Dropout正则化难以有效地表达特征的空间相关性, DropBlock能从特征映射中丢弃连续区域, 迫使剩余的激活单元拟合血管特征, 同时减少过拟合的风险. FE模块的结构如图2所示, 对于输入特征

| X′=Conv1×1(σ(ψ(ρ(ϕ(X))))) | (2) |

其中,

|

图 2 快速提取模块 |

2.2 边缘特化流

单特征流的视网膜血管分割算法通常在粗血管部位能取得不错的分割效果, 但对于形态特征复杂、对比度低的细血管部位, 容易因其结构特点与背景噪声干扰而分辨困难, 现有的先进算法多数缺乏对细节信息的针对性处理. 因此, 本文为了减少噪声干扰、获取细节特征, 设计了一种线性提取细节信息的边缘特化流, 通过形态学方法获取血管边缘标注信息, 针对性地引导边缘特化流收集更丰富的边缘以及细血管特征. 边缘特化流的处理流程如图1所示, 首先, 边缘特化流经过3×3的卷积层将原图像进行通道扩展, 依次经过4个用于强调细节特征、减少噪声干扰的边缘提取模块, 相邻模块使用残差连接提高算法的鲁棒性. 对于处理后的输出细节特征, 走向两个分支, 一个分支与全局分割流进行合流, 用于血管的全局分割; 另一个分支采用1×1的卷积与Sigmoid激活函数输出细节概率特征图, 用于边缘信息的建模.

2.2.1 边缘提取模块眼底图像中包含细血管在内的细节特征往往都会因其对比度低而难以获取, 边缘提取模块(boundary extraction module, BE)旨在增强算法对边缘特征的关注度, 抑制非必要的噪声信息, 从而提升细血管的分割精度. BE模块的结构如图3所示, 为了弥补其深度不足的缺点, 其内部同时接收上层网络输出

BE模块中的边缘注意力则用于增强细血管的特征表达, 体现血管与背景之间的空间差异性, 抑制非必要的噪声信息, 边缘注意力接收边缘特征与分流特征, 二者经过1×1的卷积压缩通道数, 减少参数量, 同时分流特征通过双线性插值恢复为原图像大小用于与边缘特征的融合, 由于边缘特征与分流特征的特征间隔较大, 受MultiResUNet[13]的启发, 利用1×1与3×3卷积的残差连接缩减二者之间的特征差距再与分流特征结合, 以此得来的综合特征

BE模块的计算过程可表示为:

| {F′b=Conv3×3(Fb)M=C(Conv1×1(F′b),Upsample(Conv1×1(Fg)))W=Conv1×1(C(Conv1×3(M),Conv3×1(M),Conv3×3(M)))A=M+W⊙MF=σ(ψ(A)) | (3) |

其中,

|

图 3 边缘提取模块 |

3 实验结果 3.1 实验设置

本文提出的模型使用PyTorch实现, 在48 GB显存RTX 8000上进行训练, 4张图片作为一个批次, 使用Adam优化器进行模型参数的优化, 初始学习率设为0.001, 动量系数设置为 0.9, 权值衰减系数设置为 0.0005, 训练总轮数设置为200轮. 为了模型能够更接近最优解, 每经过20轮, 学习率变为原来的1/10.

3.2 数据集为了能更好地测试提出的模型性能, 本文在DRIVE以及STARE两个公开的视网膜血管分割数据集上进行实验.

DRIVE数据集[14]是一个公开的视网膜血管分割数据集, 该数据集包含40张糖尿病患者的眼底图像, 每张图像大小为584×565, 图像为彩色, 包含3个通道. 数据集被划分为训练集与测试集两部分, 其中训练集包含20张眼底图像, 另外20张划分在测试集当中, 每一张眼底图像都有与之相对应的像素级标注图像.

STARE数据集[15]包含20张3通道的彩色眼底图像, 每张图像大小为700×605. 该数据集没有对训练集与测试集进行划分, 在本文的实验中, 从数据集中选择了15张眼底图像作为训练集, 剩下的5张图像作为测试集, 每张图像提供了对应的视网膜血管部分的详细标注.

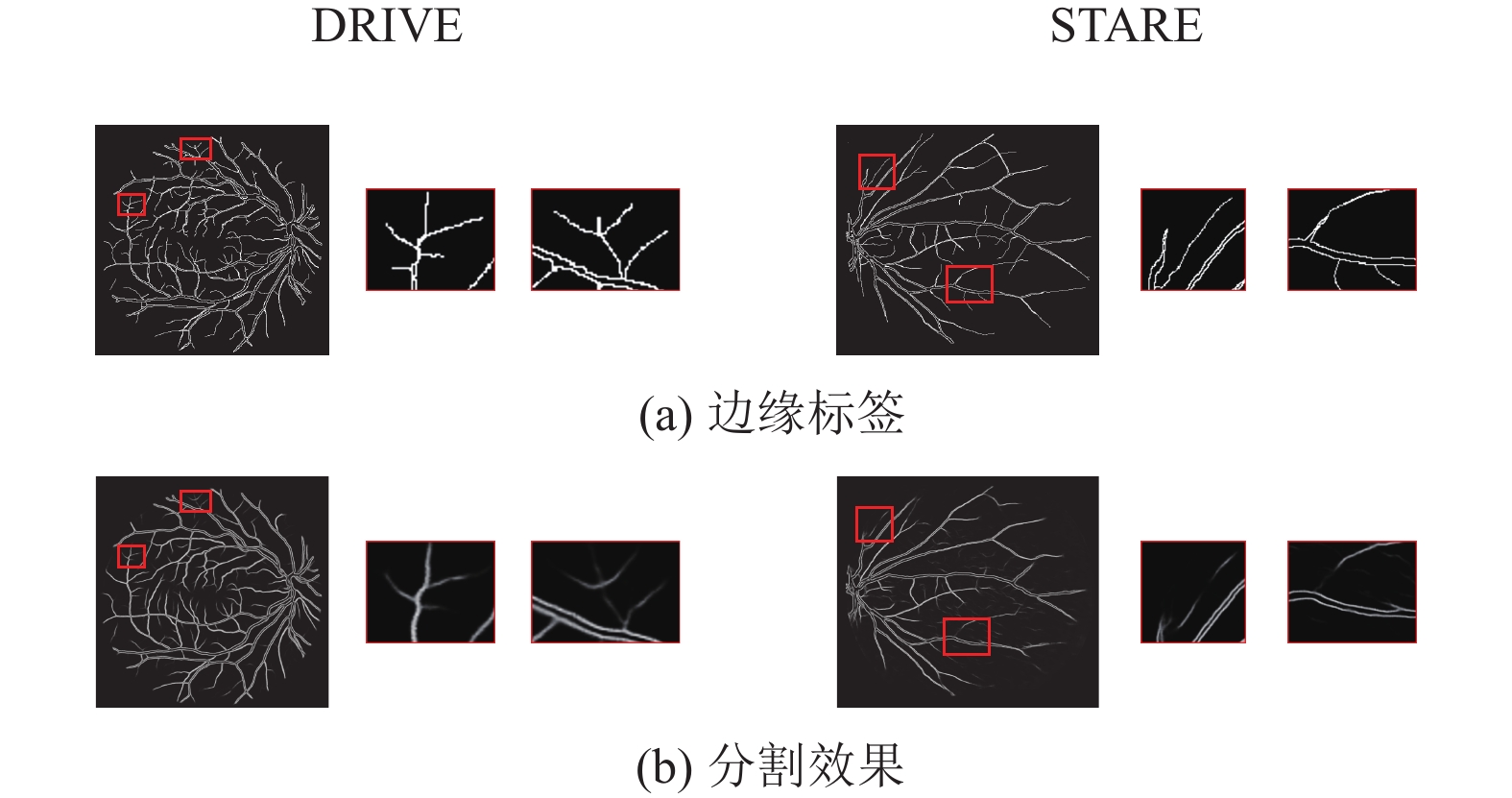

为了拓展眼底图像数据集, 增强算法的鲁棒性, 本文中采用随机翻转、随机旋转、颜色抖动以及添加高斯噪声将一张图像扩展为10张图像. 同时通过形态学方法提取边缘标注图像用于边缘特化流的训练, 边缘标注图像如图4所示.

|

图 4 边缘标签原标注图像和边缘标注图像 |

3.3 评价指标

为了更直观地对模型的性能进行评判, 主要使用以下5种指标作为基本参照依据, 分别是敏感度(sensitivity, SE)、特异度(specificity, SP)、准确率(accuracy, ACC)、F1-score (F1)以及ROC (receiver operating characteristic)曲线下面积 AUC (area under curve). 以下是各指标的计算方式, 其中TP代表真正例, TN代表真反例, FP代表假正例, FN代表假反例,

| SE=TPTP+FN | (4) |

| SP=TPTP+FP | (5) |

| ACC=TP+TNTP+TN+FP+FN | (6) |

| F1=2×TP2×TP+FP+FN | (7) |

| AUC=∑I(pi,nj)pi>njP×N | (8) |

其中, SE代表正确分类对象的像素比例, 用于衡量模型正确分类血管的能力; SP用于衡量模型正确分类背景的能力; ACC代表正确的像素分类数量占总像素数量的比例; F1可以反映类别不平衡的情况下, 二分类模型的精度; AUC能够评估模型分割性能.

3.4 多重损失算法将全局损失与边缘损失结合作为整体损失, 其中, 交叉熵损失作为全局损失, 假定

| Lossg=−(ylog(⌢y)+(1−y)log(1−⌢y)) | (9) |

考虑到边缘标注图像中边缘与背景的类不平衡性, 采用能有效获取边缘特征的Dice loss损失函数作为边缘损失, 表示为:

| Lossb=1−2×N∑i=1pigi+εN∑i=1pi2+N∑i=1gi2 | (10) |

其中,

整体损失为全局损失与边缘损失的加权组合, 表示为:

| Loss=αLossg+βLossb | (11) |

在本文的实验中,

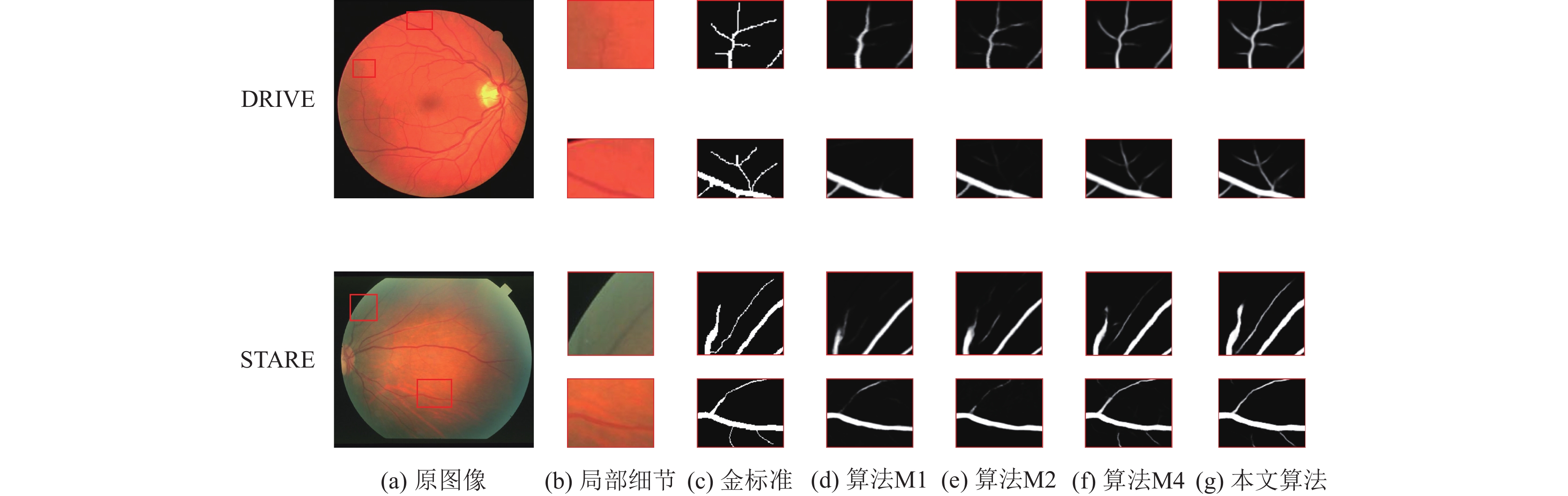

为了验证本文改进策略对算法分割血管性能的影响, 设计了消融实验对改进策略的不同组合方式进行了有效性测试, 实验中将算法分为6种情况, 分别是使用传统卷积块的单流分割算法M1、使用FE模块的单流分割算法M2、以M1为基础但不加入边缘注意力的多流分割算法M3、以M2为基础但不加入边缘注意力的多流分割算法M4、以M1为基础同时加入边缘注意力的多流分割算法M5以及本文提出的算法MU-Net. 在表1与表2中展示了各个算法的分割性能对比, 在图5中给出了不同算法全局的可视化分割结果, 其中图5(a)–图5(f)分别对应原图像、金标准、算法M1、算法M2、算法M4以及MU-Net. 同时, 图6展示了对应的细节分割对比.

| 表 1 DRIVE数据集上的消融实验结果 |

| 表 2 STARE数据集上的消融实验结果 |

|

图 5 消融实验分割结果对比 |

|

图 6 细节分割结果对比 |

从表1与表2可以看出, 在两个数据集上, 算法M2相较于算法M1在各个指标上都有着小幅的提升, 这意味着使用FE模块在分割性能上要优于传统卷积块, 而从图6(d)和(e)的分割细节对比可以看出, 算法M2提取到了算法M1所没有的局部血管特征, 使用FE模块得到更好的特征表达. 而在算法效率上, 表3列出了算法M1与M2参数量与计算量的对比结果, 算法M2的参数量相较于M1减少了28%, 计算量减少了30%, 这代表着FE模块推理速度快的同时, 还能取得更好的分割效果. 而观察多流分割算法M3、M4的各个指标可以发现, 对比单流的M1、M2算法, 多流分割算法在敏感度上得到了明显的提升, M3较M1提升了4.01个百分点, M4较M2提升了4.22个百分点, 这意味着边缘特化流通过对边缘信息的针对性训练, 提供了更丰富的细节特征. 对比图6(e)和(f)也能看出, 多流分割算法对于细节特征的获取要优于单流分割算法, 在细血管的分割效果上有着明显的差异. 但敏感度提升的同时, 算法M3与M4的特异度有所下降, 这是由于区域对比度低, 导致对非边缘区域的误判. 而加入边缘注意力之后即MU-Net, 从表中展示的数据表明, 本文提出的算法在各个指标上都有着最优的表现, 对比算法M4, 敏感度与F1的提升最为明显, 在DRIVE数据集上分别提升了2.83、2.10个百分点, 在STARE数据集上分别提升了2.57、2.51个百分点, 并且在敏感度提升的同时, 没有出现特异度值下降的情况, 这表明加入边缘注意力能够有效改善区域对比度低的问题, 有利于增大血管与背景的差异性, 提升算法对边缘特征的辨别度. 对比图6(f)和(g)的细节部分也能看出, 加入边缘注意力后, 细节特征更丰富, 细血管的表示也更清晰.

同时图7给出了MU-Net在边缘特化流上的输出结果, 从图7中可以看出, 边缘特化流提取边缘细节信息的有效性.

| 表 3 参数量与计算量的对比 |

|

图 7 边缘特化流分割结果 |

通过上述消融实验的对比分析, 可以证实本文改进策略的有效性. 多流算法相较于单流算法有着更优秀的分割性能, 全局分割流使用FE模块能够减少信息冗余, 获取更多的有效特征, 加快算法的推理速度; 边缘特化流能够利用BE模块与边缘注意力针对性的获取所需特征, 实现特点强调、差异特化, 获取更具代表性的空间特征, 缓解图像低对比度的问题, 提升算法在细血管部分的分割精度.

3.6 算法性能对比为了证明本文算法的优越性, 结合近年来研究者们在视网膜血管分割任务中的成果, 分别在DRIVE和STARE数据集上将本文提出的算法与其他先进方法进行了比较, 通过数据可以发现MU-Net在多个指标上有更突出的表现.

表4展示各个算法在DRIVE数据集上的分割性能对比. 本文提出的算法在敏感度、准确率、F1分数、AUC值4个指标上均取得了最优的表现, 对比最新的文献[16]算法有全面的提升, 敏感度提升了1.53个百分点, 特异度提升了0.47个百分点, 准确率上升了1.23个百分点, F1分数与AUC值分别提升了0.17、0.58个百分点; 尽管本文算法在特异度上没有达到最优, 但与特异度最优的文献[17]相比, 敏感度、准确率以及F1分数分别提升了1.53、0.04、0.55个百分点, 而特异度仅表现出些许的下降, 在综合性能上, 本文提出的算法的整体表现更优.

| 表 4 不同算法在DRIVE数据上的性能对比 |

表5为各个算法在STARE数据集上的分割性能对比. 从表5中可以看出, 本文提出的算法在敏感度、准确率以及AUC值上均有着最出色的表现, 在F1分数上, 本文算法相较于文献[16]低了0.07个百分点, 但敏感度、准确率以及AUC上均优于文献[16]的算法, 且在敏感度上有大幅提升, 提升了2.76个百分点, 综合性能上, 本文提出的算法表现更优; 在特异度上, 本文算法比文献[24]低了0.5个百分点, 但其余4个指标均比文献[24]的算法高, 尤其是敏感度与F1分数, 分别高出6.54、2.11个百分点, 在综合性能表现上, 本文的算法明显更优.

| 表 5 不同算法在STARE数据上的性能对比 |

通过上述的数据对比, 可以证实本文算法的优越性. 在综合性能上, 本文算法相较于其他先进算法有着更好的表现.

3.7 血管分割效果对比与分析为了更直观地展示本文算法对比其他算法的优势所在, 图8为本文提出的算法与文献[26]和文献[16]提出算法的可视化分割效果对比, 展现了不同算法在眼底图像整体分割效果的性能差异. 其中, 图8(a)–图8(e)分别表示原图、金标准、文献[26]的算法、文献[16]的算法以及本文算法MU-Net. 图9为对应的细节分割对比.

|

图 8 不同算法分割结果对比 |

从图8的全局分割效果来看, 本文提出的算法相较于文献[26]与文献[16]的算法在血管特征表示上更加丰富, 细血管的分割效果更为清晰, 这意味着本文算法在血管的特征表达上更为出色. 同时对比图9的局部分割效果可以看出, 在原图像中对比度低的血管区域, 背景的干扰导致细血管难以辨别, 而本文算法在低对比度区域的分割效果要更优于其他两种先进算法, 细血管的分割精度更高, 细节表示更为清晰. 这表示本文算法能够有效克服图像对比度低的问题, 更好地分辨出背景信息与血管信息之间的差异, 得到更精准的血管分割结果.

同时图10展示了本文算法在边缘特化流的输出结果, 可以发现, 边缘特化流能有效地提取到包含细血管在内的边缘信息, 为算法提供更具针对性的细节特征.

|

图 9 不同算法细节分割结果对比 |

|

图 10 血管边缘分割结果 |

4 结论与展望

本文提出一种基于改进U-Net的视网膜血管分割算法MU-Net, 旨在解决传统U型网络中特征冗余以及视网膜血管形态复杂、细血管分割困难的问题. 算法通过全局分割流与边缘特化流的多特征流方式完善血管的特征表示. 为减少特征冗余, 采用FE模块在全局分割流中构建了能够高效提取血管特征、加快算法推理速度的改进U-Net模型, 加速算法推理速度的同时提取了更多的有效特征; 为增强血管的细节表达, 设计了用于边缘信息提取的边缘特化流, 构建BE模块收集细节特征, 通过边缘注意力突出特征差异, 有效地改善了低对比度问题, 提升细血管的分割精度.

在DRIVE和STARE数据集上的实验结果验证了本文提出算法在视网膜血管分割任务中的有效性. 然而, 在细血管密集区域的分割效果还有待提升, 这是一个未来研究和探索的重要方向.

| [1] |

Akbar S, Sharif M, Akram MU, et al. Automated techniques for blood vessels segmentation through fundus retinal images: A review. Microscopy Research and Technique, 2019, 82(2): 153-170. DOI:10.1002/jemt.23172 |

| [2] |

Khandouzi A, Ariafar A, Mashayekhpour Z, et al. Retinal vessel segmentation, a review of classic and deep methods. Annals of Biomedical Engineering, 2022, 50(10): 1292-1314. DOI:10.1007/s10439-022-03058-0 |

| [3] |

Feng ZW, Yang J, Yao LX. Patch-based fully convolutional neural network with skip connections for retinal blood vessel segmentation. Proceedings of the 2017 IEEE International Conference on Image Processing (ICIP). Beijing: IEEE, 2017. 1742–1746. [doi: 10.1109/ICIP.2017.8296580]

|

| [4] |

Guo CL, Szemenyei M, Yi YG, et al. SA-UNet: Spatial attention U-Net for retinal vessel segmentation. Proceedings of the 25th International Conference on Pattern Recognition (ICPR). Milan: IEEE, 2021. 1236–1242. [doi: 10.1109/ICPR48806.2021.9413346]

|

| [5] |

吕佳, 王泽宇, 梁浩城. 边界注意力辅助的动态图卷积视网膜血管分割. 光电工程, 2023, 50(1): 220116. DOI:10.12086/oee.2023.220116 |

| [6] |

Lin ZF, Huang JP, Chen YY, et al. A high resolution representation network with multi-path scale for retinal vessel segmentation. Computer Methods and Programs in Biomedicine, 2021, 208: 106206. DOI:10.1016/j.cmpb.2021.106206 |

| [7] |

王师玮, 陈俊, 易才键. 基于改进U-Net的视网膜血管分割. 智能计算机与应用, 2022, 12(7): 151-155, 159. DOI:10.3969/j.issn.2095-2163.2022.07.027 |

| [8] |

谷鹏辉, 肖志勇. 改进的U-Net在视网膜血管分割上的应用. 计算机科学与探索, 2022, 16(3): 683-691. DOI:10.3778/j.issn.1673-9418.2010061 |

| [9] |

Gao G, Li JY, Yang L, et al. A multi-scale global attention network for blood vessel segmentation from fundus images. Measurement, 2023, 222: 113553. DOI:10.1016/j.measurement.2023.113553 |

| [10] |

Ronneberger O, Fischer P, Brox T. U-Net: Convolutional networks for biomedical image segmentation. Proceedings of the 18th International Conference on Medical Image Computing and Computer-assisted Intervention. Munich: Springer, 2015. 234–241. [doi: 10.1007/978-3-319-24574-4_28]

|

| [11] |

Chen JR, Kao SH, He H, et al. Run, don’t walk: Chasing higher FLOPS for faster neural networks. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE, 2023. 12021–12031. [doi: 10.1109/CVPR52729.2023.01157]

|

| [12] |

Ghiasi G, Lin TY, Le QV. DropBlock: A regularization method for convolutional networks. Proceedings of the 32nd International Conference on Neural Information Processing Systems. Montréal: Curran Associates Inc., 2018. 10750–10760.

|

| [13] |

Ibtehaz N, Rahman MS. MultiResUNet: Rethinking the U-Net architecture for multimodal biomedical image segmentation. Neural Networks, 2020, 121: 74-87. DOI:10.1016/j.neunet.2019.08.025 |

| [14] |

Staal J, Abramoff MD, Niemeijer M, et al. Ridge-based vessel segmentation in color images of the retina. IEEE Transactions on Medical Imaging, 2004, 23(4): 501-509. DOI:10.1109/TMI.2004.825627 |

| [15] |

Fraz MM, Remagnino P, Hoppe A, et al. An ensemble classification-based approach applied to retinal blood vessel segmentation. IEEE Transactions on Biomedical Engineering, 2012, 59(9): 2538-2548. DOI:10.1109/TBME.2012.2205687 |

| [16] |

Li JY, Gao G, Liu YH, et al. MAGF-Net: A multiscale attention-guided fusion network for retinal vessel segmentation. Measurement, 2023, 206: 112316. DOI:10.1016/j.measurement.2022.112316 |

| [17] |

Khan TM, Robles-Kelly A, Naqvi SS. T-Net: A resource-constrained tiny convolutional neural network for medical image segmentation. Proceedings of the 2022 IEEE/CVF Winter Conference on Applications of Computer Vision. Waikoloa: IEEE, 2022. 1799–1808. [doi: 10.1109/WACV51458.2022.00186]

|

| [18] |

Aslani S, Sarnel H. A new supervised retinal vessel segmentation method based on robust hybrid features. Biomedical Signal Processing and Control, 2016, 30: 1-12. DOI:10.1016/j.bspc.2016.05.006 |

| [19] |

Mo J, Zhang L. Multi-level deep supervised networks for retinal vessel segmentation. International Journal of Computer Assisted Radiology and Surgery, 2017, 12(12): 2181-2193. DOI:10.1007/s11548-017-1619-0 |

| [20] |

Alom MZ, Yakopcic C, Hasan M, et al. Recurrent residual U-Net for medical image segmentation. Journal of Medical Imaging, 2019, 6(1): 014006. DOI:10.1117/1.JMI.6.1.014006 |

| [21] |

Wang B, Qiu S, He HG. Dual encoding U-Net for retinal vessel segmentation. Proceedings of the 22nd International Conference on Medical Image Computing and Computer Assisted Intervention. Shenzhen: Springer, 2019. 84–92. [doi: 10.1007/978-3-030-32239-7_10]

|

| [22] |

Jin QG, Meng ZP, Pham TD, et al. DUNet: A deformable network for retinal vessel segmentation. Knowledge-based Systems, 2019, 178: 149-162. DOI:10.1016/j.knosys.2019.04.025 |

| [23] |

Lv Y, Ma H, Li JN, et al. Attention guided U-Net with atrous convolution for accurate retinal vessels segmentation. IEEE Access, 2020, 8: 32826-32839. DOI:10.1109/ACCESS.2020.2974027 |

| [24] |

Li LZ, Verma M, Nakashima Y, et al. IterNet: Retinal image segmentation utilizing structural redundancy in vessel networks. Proceedings of the 2020 IEEE Winter Conference on Applications of Computer Vision. Snowmass: IEEE, 2020. 3645–3654. [doi: 10.1109/WACV45572.2020.9093621]

|

| [25] |

Li X, Jiang YC, Li ML, et al. Lightweight attention convolutional neural network for retinal vessel image segmentation. IEEE Transactions on Industrial Informatics, 2021, 17(3): 1958-1967. DOI:10.1109/TII.2020.2993842 |

| [26] |

Li JY, Gao G, Yang L, et al. DEF-Net: A dual-encoder fusion network for fundus retinal vessel segmentation. Electronics, 2022, 11(22): 3810. DOI:10.3390/electronics11223810 |

| [27] |

Hu K, Zhang ZZ, Niu XR, et al. Retinal vessel segmentation of color fundus images using multiscale convolutional neural network with an improved cross-entropy loss function. Neurocomputing, 2018, 309: 179-191. DOI:10.1016/j.neucom.2018.05.011 |

| [28] |

Dharmawan DA, Li D, Ng BP, et al. A new hybrid algorithm for retinal vessels segmentation on fundus images. IEEE Access, 2019, 7: 41885-41896. DOI:10.1109/ACCESS.2019.2906344 |

| [29] |

Yang L, Wang HX, Zeng QS, et al. A hybrid deep segmentation network for fundus vessels via deep-learning framework. Neurocomputing, 2021, 448: 168-178. DOI:10.1016/j.neucom.2021.03.085 |

| [30] |

Khan TM, Khan MAU, Rehman NU, et al. Width-wise vessel bifurcation for improved retinal vessel segmentation. Biomedical Signal Processing and Control, 2022, 71: 103169. DOI:10.1016/j.bspc.2021.103169 |

2024, Vol. 33

2024, Vol. 33