2. 南京信息工程大学 数字取证教育部工程研究中心, 南京 210044

2. Engineering Research Center of Digital Forensics, Ministry of Education, Nanjing University of Information Science and Technology, Nanjing 210044, China

随着输电线路外部环境的变化, 线路遭受外力破坏的事件频频发生, 输电线路的巡检防护工作已成为电力系统安全运行的重中之重[1]. 近年来, 在深度学习浪潮的推进下, 将通用目标检测算法部署于搭载高清摄像器的无人机上, 已成为输电线路巡检的主要手段之一[2]. 然而, 无人机等边缘端设备的存储和计算能力有限, 所以在边缘端部署前需要对目标检测算法进行轻量化, 因此不可避免地面临着高精度损失和较慢检测速度等严峻挑战.

针对上述问题, 研究者们主要采用优化骨干网络结构、改进特征融合网络、融入注意力机制或预处理输入图像等方法, 补偿由于模型轻量化后参数量和浮点数运算量(floating-point operations, FLOPs)减少而带来的精度下降. 李有春等人[3]利用二维重叠滑动切割方法对输入图像进行切割, 并采用融入了空间和通道双重注意力机制的MobileNetV2网络[4]替换原骨干网络, 显著提高了对切割后图片的特征提取能力; 黄磊等人[5]提出了一种新的FS-MobileNetV3骨干网络, 以此取代原YOLOv5中的主干网络, 并为CIoU损失函数引入Power变换, 构建了红外场景下道路目标检测的轻量化模型; 韩汉贤等人[6]为提高无人机输电线路巡检的效率, 将SSD[7]单阶段多预测框检测算法与特征金字塔网络(feature pyramid network, FPN)进行结合, 局部融合层间特征信息, 在绝缘子故障检测方面获得了良好的检测效果; 韦圣贤等人[8]将深度可分离卷积和通道注意力机制相结合, 提出了一种基于AD-Block (attention dilation block)的输电线缆提取算法, 有效提高了网络的感受野以及特征提取能力; 张毅等人[9]在Faster RCNN算法[10]基础上, 针对电力巡检图像背景复杂、目标较小的特点, 利用光学矫正和综合去噪对图像进行预处理, 增大、增多训练尺度, 通过Gabor滤波器提升防震锤的识别效果; 刘浩翰等人[11]以YOLOv7-tiny模型[12]为基础, 将改进后的ShuffleNet网络[13]作为新的特征提取网络, 并采用GSConv算子改进模型的特征聚合层, 引入Mish激活函数, 提升了网络的泛化能力, 在提高了模型精度的同时, 降低了参数量与计算量; 郭璠等人[14]基于YOLOv3算法[15], 引入基于语义分割引导的空间注意力机制和通道注意力机制方法, 使网络在两个维度上聚焦和增强有效特征, 提升了小目标物体的检测精度.

综上所述, 研究者们主要通过使用MobileNet[16]、ShuffleNet和GhostNet[17]等轻量级特征提取网络替换目标检测算法中的骨干网络, 利用计算成本较低的深度卷积(DWConv)或组卷积(GConv)来提取输入图像特征, 以达到降低模型参数量和FLOPs的目的. 尽管上述更换骨干网络的轻量化方式取得了好的效果, 但是却面临着模型精度损失较大的问题. 并且, 改进后模型的检测速度并不会随着FLOPs的减少而获得相应程度的提升, 甚至可能会下降. 这主要是因为在减少计算量的过程中, 卷积算子经常会受到内存访问增加的副作用影响, 从而导致模型的检测速度变慢. 此外, 对于小型模型来说, 上述轻量级网络附带的级联、通道混洗和池化等额外的数据操作会进一步增加模型的运行时间.

为使目标检测模型轻量化后既保持原有的检测精度, 又加快模型的检测速度, 本文提出了一种基于全局上下文增强的稀疏卷积电网防外力破坏检测算法Fast-YOLOv5. 首先, 以目标检测算法YOLOv5模型为基础, 设计FasterNet+网络作为新的骨干网络, 提升模型的特征提取能力; 其次, 在特征融合阶段, 提出融入高效通道注意力的ECAFN模块改进模型的瓶颈层, 增强网络获取跨通道交互信息的能力; 最后, 将稀疏卷积引入到模型检测层, 提出了基于全局上下文增强的稀疏卷积网络(sparse convolutional network (SCN) based on global context enhancement), 通过捕获的全局上下文信息来增强前景焦点特征, 提高模型的检测性能. 改进后的算法在模型规模、准确性和检测速度等方面有了大幅改善, 做到了3个方面性能的有效平衡, 满足输电线路实时高效检测的要求. 本文的主要贡献如下.

(1)提出Fast-YOLOv5算法模型, 设计FasterNet+网络作为新的特征提取网络, 不仅大幅缩小了模型规模, 而且在保持检测精度的同时, 具有更快的检测速度.

(2)设计具有高效通道注意力的ECAFN模块, 通过对通道间的关系建模, 自适应地校准通道方向上的特征响应, 捕获跨通道的交互信息, 增强模型的特征表达能力, 并进一步减少模型的参数量和计算量.

(3)提出了一种基于全局上下文增强的稀疏卷积网络SCN作为模型的检测层, 设计基检测器分类和回归解耦头方法, 通过具有全局上下文增强的稀疏卷积模块SC-CE, 将前景焦点特征与全局特征进行融合, 提升模型的检测性能.

1 算法原理 1.1 YOLOv5算法YOLOv5算法作为经典的单阶段目标检测算法, 因其在检测速度和精度上都取得了很好的效果, 被广泛应用于工业场景中.

YOLOv5主要由骨干网络、瓶颈层、检测层3部分组成. 模型在接收输入图像后, 首先完成一系列的预处理, 包括Mosaic数据增强、自适应锚框计算, 并将图像进行调整和填充等归一化和标准化, 以满足模型所期望的输入尺寸. 骨干网络采用了CSPDarkNet网络作为特征提取网络, 其主要由CBS (conv batch normalization SiLU)、C3以及特征金字塔池化(spatial pyramid pooling fast, SPPF)模块组成. C3模块主要针对网络优化中梯度信息重复导致过度推理的计算问题, 将输入的特征图分为两部分, 通过跨阶段的层次连接结构进行特征的融合, 在保证精度的同时减少了计算量. SPPF模块将输入特征图并行通过3个不同尺寸的最大池化层(MaxPool), 然后利用残差结构做进一步的特征融合, 在一定程度上解决了目标多尺度的问题. 最终骨干网络将提取到的特征提炼成3个有效特征映射作为瓶颈层的输入; 瓶颈层将FPN以及路径聚合网络(path aggregation network, PAN)结合不同层次的特征图进行自顶向下与自底向上的联合特征融合, 获取丰富的上下文信息, 从而增强了多个尺度的语义表达和定位能力, 提高了网络的检测性能; 检测层对瓶颈层深度提炼传入的特征通过非极大值抑制(non-maximum suppression, NMS)等后处理操作消除大量冗余预测框, 输出置信度得分最高的预测类别并返回目标位置.

1.2 FasterNet网络FasterNet网络[18]是一种基于新型算子部分卷积(partial convolution, PConv)构建的轻量级卷积神经网络, 具有识别率高和运行速度快的优势. 并且该网络结构清晰简单, 在整体上对硬件友好, 适用于边缘端设备上部署. 对于下游目标检测任务而言, FasterNet作为骨干网络提取图像特征非常有效.

新型算子PConv的提出, 旨在解决模型轻量化过程中FLOPs减少, 但是内存访问量增加从而导致模型检测速度变慢的问题. 该算子通过利用特征图在不同通道之间具有高度相似性的原理, 进一步优化卷积成本, 以同时减少计算冗余和内存访问次数. PConv只需在输入通道的一部分通道上应用标准卷积进行空间特征提取, 并保持其余通道不变. 对于连续或规则的内存访问, 将特征图第1个或最后一个连续的数量为

| $ h \times w \times 2{c_p} + {k^2} \times c_p^2 \approx h \times w \times 2{c_p} $ | (1) |

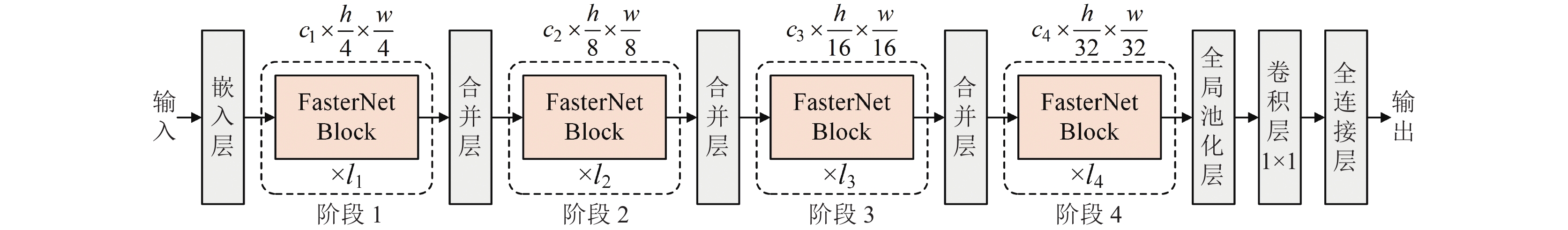

为了充分有效地利用来自所有通道的信息, FasterNet将两个连续的1×1标准卷积附加到PConv层后, 组成了一个FasterNet Block倒置残差块. 其中, 中间层具有扩展的通道数量, 并且加入了残差结构以重用输入特征. 如图1展示了FasterNet网络的整体结构, 该网络共有4个阶段, 每个阶段都有若干个FasterNet Block, 除第1个阶段前是一个嵌入层(Embedding, 一个步长为4, 大小为4×4的标准卷积)外, 其余3个阶段前均有一个合并层(Merging, 一个步长为2, 大小为2×2的标准卷积), 用来空间下采样和通道数扩展.

|

图 1 FasterNet结构 |

2 本文方法

本文针对当前部署于边缘端的轻量级目标检测算法, 存在检测精度不足、推理速度慢等问题, 提出了一种基于全局上下文增强的稀疏卷积电网防外力破坏检测算法Fast-YOLOv5. 首先, 设计了FasterNet+网络作为YOLOv5算法新的特征提取网络, 大幅减少模型规模, 并且在保持较高检测精度的情况下, 该网络通过更少的内存访问量, 获得更快的检测速度.

其次, 提出了具有高效通道注意力(efficient channel attention, ECA)[19]的ECAFN模块, 自适应地校准通道方向上的特征响应, 捕获跨通道的交互信息, 优化瓶颈层的C3模块, 增强模型的特征表达能力.

最后, 提出了一种基于全局上下文增强的稀疏卷积网络SCN作为Fast-YOLOv5模型的检测层. SCN利用具有上下文增强的稀疏卷积模块SC-CE将焦点特征与捕获的全局信息进行融合, 以此来补偿稀疏卷积造成的上下文损失, 并稳定前景区域的分布, 增强模型的目标检测能力.

下面将分别介绍Fast-YOLOv5模型的整体结构和基于全局上下文增强的稀疏卷积网络SCN结构.

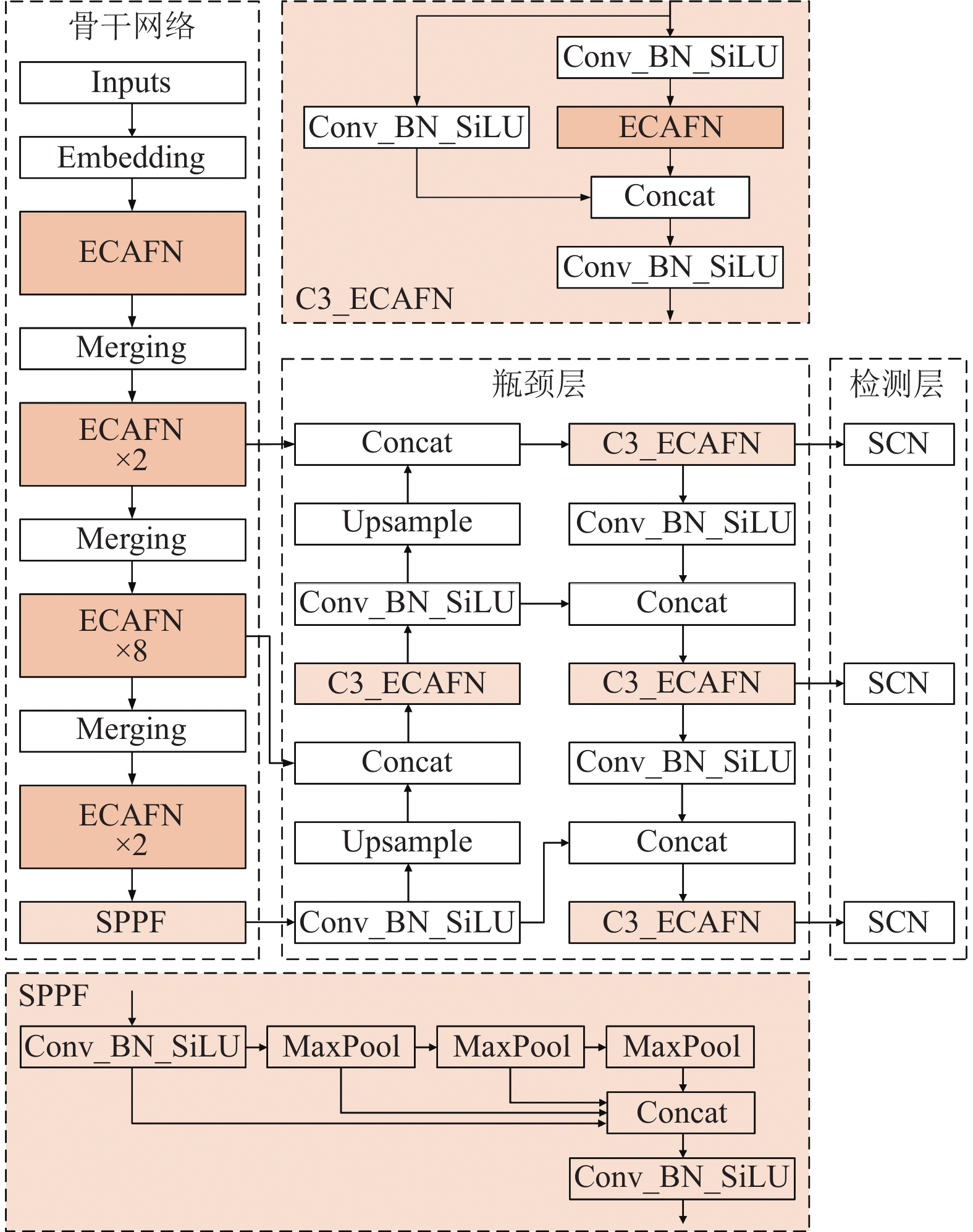

2.1 Fast-YOLOv5算法YOLOv5算法采用了CSPDarkNet作为特征提取网络, 其主要由CBS、C3以及SPPF模块组成, 总体的参数量、计算复杂度以及模型本身规模较大, 不满足在无人机等边缘端设备上部署的要求. 因此, 本文基于YOLOv5算法, 提出了Fast-YOLOv5算法模型, 该模型结构如图2所示.

在特征提取阶段, 本文借鉴FasterNet网络的T0级模型. 考虑到PConv的工作原理, 虽然它利用特征图在不同通道之间具有高度相似性的特点, 只在部分通道上进行标准卷积, 以此降低整体的卷积成本, 显著减少了计算冗余和内存访问量. 但是同样在一定程度上造成了通道维度上的信息丢失. 为了克服此缺点, 本文提出了一种融合高效通道注意力机制的ECAFN模块, 该模块通过对通道之间的关系建模, 自适应地重新校准通道方向上的特征响应, 捕获跨通道的交互信息, 可以有效弥补PConv造成的通道信息损失, 提高网络的特征提取能力.

ECAFN模块如图3所示, 该模块包含一个PConv层和两个连续的逐点卷积(pointwise convolution, PWConv)层, 并在PWConv层之间加入了高效注意力ECA模块. ECA通过不降低通道维度的全局平均池化来聚合卷积特征, 动态地调整不同通道的响应, 学习有效的通道注意力, 以极其轻量级的方式获取跨通道维度上的上下文线索, 增强特征表达能力.

|

图 2 Fast-YOLOv5结构 |

|

图 3 ECAFN结构 |

基于ECAFN模块本文提出了FasterNet+网络, 该网络共进行了4个层次级的空间下采样和通道数扩展, 每个层级分别包含数量为1、2、8、2个ECAFN模块, 且每个层级前均采用与FasterNet网络相对应的嵌入层与合并层结构. 将FasterNet+网络替换YOLOv5中SPPF模块之前的所有网络结构, 以作为新的骨干网络提取输入图像的特征信息. 此外, 将FasterNet+网络第2层级、第3层级以及SPPF模块输出的不同尺度特征图作为瓶颈层的输入.

在特征融合阶段, C3模块采用跨阶段的层次连接结构, 将输入特征图分为两个分支, 各自通过一个标准卷积操作后, 其中的一个分支采用Bottleneck层堆叠, 然后将两个分支提炼的特征进行连接, 最终经过一个标准卷积操作得到特征图. 本文采用ECAFN模块优化C3模块, 替换其中的Bottleneck层, 来增强模型提取跨通道维度上全局上下文信息的能力, 进一步丰富了瓶颈层不同层次特征的语义信息. C3_ECAFN模块如图2右上角所示.

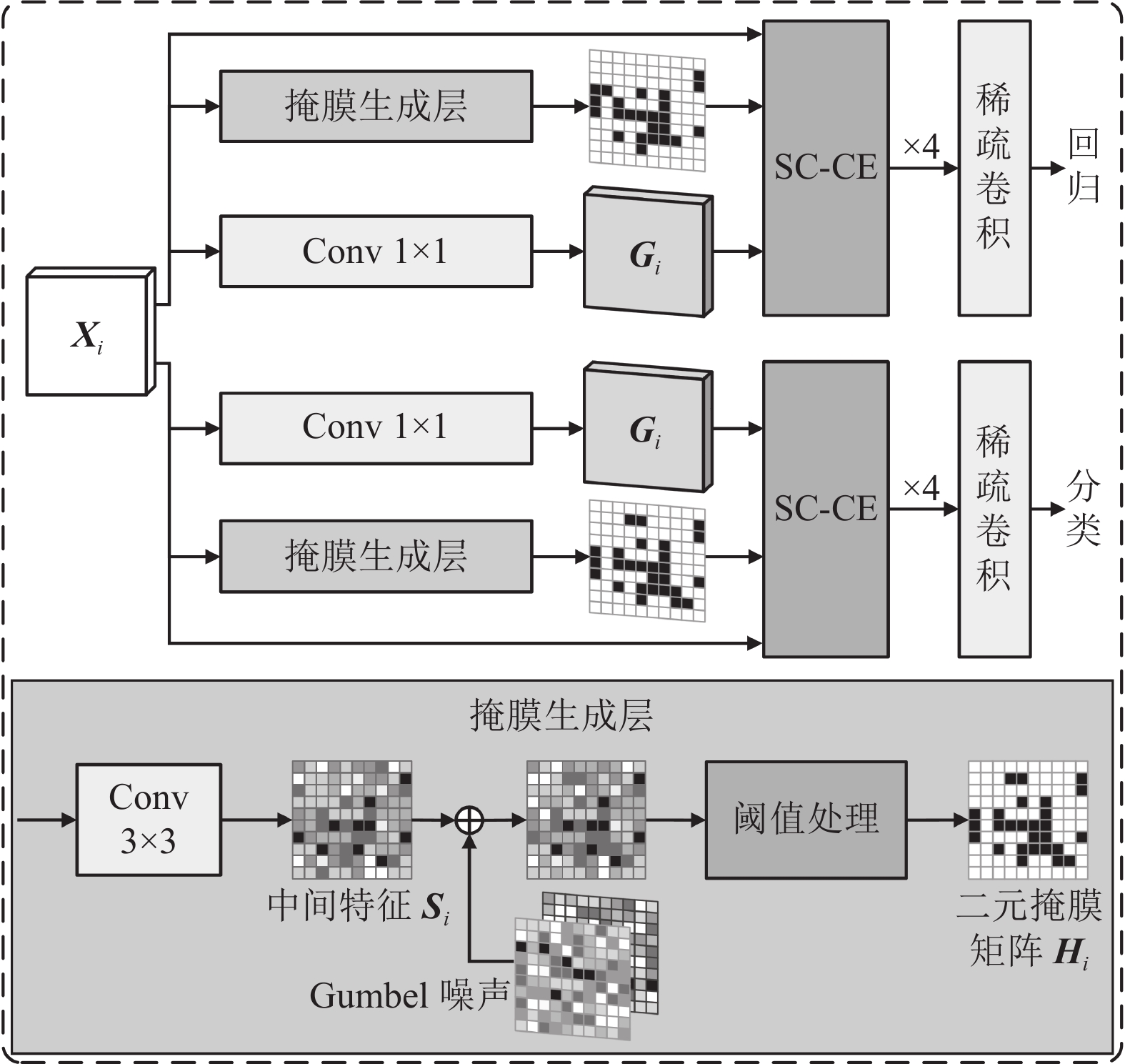

2.2 全局上下文增强的稀疏卷积网络通过观察数据集发现, 输电线路巡检图像中前景区域通常只占背景区域的一小部分, 说明目前大多数基于深度学习的目标检测算法对背景进行了大量的计算, 其中包含的对目标有用的信息要少得多. 对整个特征图进行卷积操作虽然能够充分探索视觉线索, 有利于对小目标物体的探测, 但是同样会带来检测层密度大, 计算复杂度较高的问题. Figurnov等人[20]和Yan等人[21]将稀疏卷积应用于目标检测算法的检测层, 通过利用稀疏掩膜来指导对前景区域进行卷积操作, 被证明在加速目标检测任务的推理阶段是有效的. 因此, 本文构建了基于全局上下文增强的稀疏卷积网络SCN优化模型的检测层.

如图4展示了SCN的整体结构, 给定PAN第

| $ {{\boldsymbol{H}}}_{i}=\left\{\begin{array}{ll}\sigma \left({{\boldsymbol{S}}}_{i}+{g}_{1}-{g}_{2}\right) > 0.5, & 训练阶段 \\ {{\boldsymbol{S}}}_{i} > 0, & 推理阶段 \end{array}\right. $ | (2) |

其中,

根据式(2), 在推理阶段, 只对二元掩码矩阵中值为1的区域进行卷积, 不仅降低了整体的计算成本, 而且加快了模型的推理速度. YOLOv5模型在检测层的3个基础检测器中分别使用一个1×1的标准卷积在不同尺度的特征图上进行预测, 同时完成分类和回归任务. 对此, 本文对每个基础检测器进行优化, 设置一个分类头和回归头分别处理分类和回归任务, 考虑到它们通常关注不同的区域, 再为分类头和回归头分别引入一个掩膜网络. 每个基础检测器采用4个Conv_GN_ReLU层和1个单独Conv层进行预测, 其中用稀疏卷积取代标准卷积.

|

图 4 SCN结构 |

Yang等人[23]将知识蒸馏用于目标检测, 通过全局蒸馏重建不同像素间的关系, 并将其从教师传递给学生, 以补偿局部蒸馏中丢失的全局信息, 证明了全局上下文线索有利于目标检测. 然而, 稀疏卷积仅在前景区域上进行卷积操作, 牺牲了具有有用信息的背景区域, 在面对巡检图像中存在微小目标的情况下, 可能会破坏整体的准确性. 为了解决这个问题, 本文提出了一种轻量级的具有全局上下文增强的稀疏卷积模块SC-CE, 联合利用焦点信息与全局上下文线索, 提升稀疏卷积计算的稳定性. SC-CE模块如图5所示.

|

图 5 SC-CE结构 |

SCN对输入特征图

| $ {{\boldsymbol{F}}_{i, j}} = \alpha \times \frac{{{{\boldsymbol{L}}_{i, j}} - mean\left[ {{{\boldsymbol{G}}_i}} \right]}}{{std\left[ {{{\boldsymbol{G}}_i}} \right]}} + \beta $ | (3) |

其中,

为了进一步减少在进行稀疏卷积时造成的信息损失, 使训练过程更加稳定, 本文在训练过程中除了稀疏卷积之外, 还保留了正常的标准卷积, 生成在全输入特征图上卷积后的特征

| $ {\mathcal{L}_{{\mathrm{MSE}}}} = \frac{1}{{4n}}\sum\limits_{i = 1}^n {\sum\limits_{j = 1}^4 {{{\left\| {{{\boldsymbol{C}}_{i, j}} \times {{\boldsymbol{H}}_i} - {{\boldsymbol{F}}_{i, j}}} \right\|}^2}} } $ | (4) |

其中,

最后, 在激活层之前采用残差结构, 将

本文在构建数据集时, 严格以《架空输电线路巡检影像标注规范》为标准, 使用PASCAL VOC[24]数据集的构建方法, 构建了专业的输电线路防外力破坏数据集. 该数据集共有图像13143张, 涵盖施工机械、异物、山火等9类共计23862个目标. 将该数据集按照8:2划分为训练集与测试集. 标签种类详情如表1所示, 数据集图示如图6所示.

3.2 实验环境配置本文实验主要基于Python 3.9版本的Torch 1.12深度学习框架的软件运行环境. 服务器系统为Ubuntu 18.04, 运行内存为32 GB, 搭载NVIDIA GeForce RTX 2080Ti显卡.

本文实验将图像的输入尺寸设置为640×640像素, 采用随机梯度下降法(stochastic gradient descent, SGD), 将批处理参数设置为8, 动量参数设置为0.937, 权值衰减设置为0.0005, 初始学习率设置为0.01, 随后采用余弦衰减策略自适应调整学习率.

| 表 1 数据集详情 |

|

图 6 数据集图示 |

3.3 评价指标

本文实验采用准确率(Precision)、召回率(Recall)、AP (average precision)、mAP (mean average precision)、FPS (frame per second)作为模型性能的评价指标. 其中Precision和Recall的计算公式如式(5)、式(6)所示:

| $ Precision = \frac{{TP}}{{TP + FP}} $ | (5) |

| $ Recall = \frac{{TP}}{{TP + FN}} $ | (6) |

其中,

通过计算某一类准确率-召回率(Precision-Recall, P-R)曲线与坐标轴围成的面积, 从而求出每一类的AP, 如式(7)所示. mAP是AP总值在所有类别下的均值, 如式(8)所示.

| $ AP = \int_0^1 {P(R){\text{d}}R} $ | (7) |

| $ mAP = \frac{1}{m}\sum\limits_{i = 1}^m {A{P_i}} $ | (8) |

其中,

为了验证本文提出的各模块改进方法的有效性, 设计了若干组消融实验进行对比分析, 以YOLOv5s模型为基准, 训练过程中均采用相同的参数, 在本文构建的输电线路防外力破坏数据集上进行实验. 消融实验结果如表2所示, 其中“√”表示实验中采用该方法, “—”表示不采用该方法.

| 表 2 消融实验 |

由表2可见, 直接将FasterNet网络作为YOLOv5s的骨干网络进行实验(表2第2行), 模型的参数量以及计算复杂度均呈现大幅降低的表现, 但是伴随着巨大的精度损失. 因此直接采用FasterNet网络, 虽然能够有效做到模型轻量化, 但是也牺牲了检测精度, 所以不适合直接采用. 使用本文设计的FasterNet+网络进行实验(表2第3行), 相比于FasterNet网络(表2第2行), 精度提升了1.5个百分点, 与原YOLOv5s算法保持一致水平, 且参数量与计算量大幅优化, 证明了改进的有效性. 由表2第4行可以看出, 采用融合了高效注意力的ECAFN模块替换C3模块中的Bottleneck, 相比于原YOLOv5s模型, 精度有了0.7%的提升, Recall提升了0.9%, 证明了引入高效通道注意力的有效性, 同时计算量更低一些. 这是因为PConv与PWConv的组合卷积方式比标准卷积更加有效. 之后采用FasterNet+网络, 同时对瓶颈层的C3模块进行改进(表2第6行), 与直接采用FasterNet网络(表2第2行)相比, 精度领先了2.6%, mAP@0.5提升了2.5%. 这是因为本文提出的FasterNet+网络通过对通道之间的关系建模, 自适应地重新校准通道方向的特征响应, 捕获跨通道的交互信息, 弥补了PConv造成的通道信息损失, 获得了更多的语义信息, 增强了模型的特征提取能力以及C3模块的特征聚合能力, 提升了网络性能.

如表2第5行所示, 使用SCN网络改进模型的检测层, 相比原YOLOv5s模型的检测精度提升了1.5%, mAP@0.5提升了0.9%, 参数量与计算量出现了较少的增加. 这是因为检测层的基检测器采用了两个分支分别处理分类与回归任务, 并且本文引入了全局上下文线索来增强焦点特征, 大幅提高模型检测能力的同时, 也增添了一些网络深度, 所以增加了较少的计算量. 最后, 使用本文提出的Fast-YOLOv5模型进行实验(表2第7行), 可以看出, 算法整体的检测效果得到了明显提升, 相比原YOLOv5s, 在模型参数量与计算量分别降低了50.56%、53.31%的情况下, 准确度提升了1.9%, mAP@0.5提升了1.5%, 证明了将FasterNet+网络、C3_ECAFN模块和SCN网络组合使用的有效性.

3.4.2 不同骨干网络性能对比为了证明本文提出的FasterNet+网络作为骨干网络对加快模型推理速度的有效性, 本文采用其他主流的轻量级骨干网络替换YOLOv5s的骨干网络, 在相同的实验条件下, 进行了多组实验对比分析, 实验结果如表3所示.

相比于EfficientNet[25]、MobileNet以及GhostNet等当前主流的轻量级骨干网络, FasterNet网络在参数量与计算量保持同一水平的情况下, 精度损失最少, 同时显著提升了模型的检测速度, 相比于YOLOv5s, 具有近乎一倍的提升效果. 通过引入高效通道注意力构建FasterNet+网络, 相比于未引入前, 模型精度提升了0.6%, 进一步补偿了由于模型轻量化造成的不可避免的精度损失, 为后续模型继续优化提供了良好的基础. 因此, 本文采用FasterNet+网络作为特征提取网络对加快模型推理速度更为有效.

3.4.3 不同模型对比实验为了进一步验证本文提出算法的性能, 在相同的实验条件下, 与当前主流目标检测算法模型进行对比实验, 包括SSD512、RetinaNet[26]、EfficientDet[27]、YOLOv5s、YOLOX-tiny[28]、YOLOv7-tiny. 对比实验结果如表4所示.

| 表 3 不同骨干网络实验对比 |

| 表 4 不同模型检测效果对比 |

与如今主流的YOLO系列轻量级目标检测算法YOLOX-tiny和YOLOv7-tiny相比, 本文提出的Fast-YOLOv5算法在参数规模上分别减少了28%、40%, 计算量分别下降了48.7%、40.5%的情况下, 准确率分别提高了2.2%、2.1%, 同时mAP@0.5分别提高了6.3%、1.4%, 这证明了本文算法的优越性; 与传统的目标检测算法SSD (主干网络为VGG16)和RetinaNet (主干网络为ResNet18)相比, 尽管在FPS和准确率上有微小的差距, 但是本文提出的方法降低了5倍的参数量以及10倍的计算量, 同时mAP@0.5指标分别提高了7.1%和7.8%, 证明了本文算法更加适合部署于边缘端设备上; EfficientDet算法采用了大量的深度可分离卷积块, 通过将乘法运算转化为加法运算, 虽然节省了卷积的计算成本, 但是由于DWConv需要频繁访问内存, 从而极大地增加了网络延迟, 降低了模型的检测速度, 本文算法在FPS指标上领先其3.7倍, 更符合在边缘端设备上实时高效检测的要求.

本文提出的Fast-YOLOv5算法与YOLOv5s算法相比, 准确率提高了1.9%, mAP@0.5提高了1.2%, FPS提高了50.4%, 模型的参数量和计算量分别降低了50%和53%. 综合表2和表4可以看出, Fast-YOLOv5算法在进一步提升检测精度与检测速度的情况下, 大幅降低了模型规模, 符合输电线路巡检实时高效检测的要求, 为模型在边缘端设备上部署提供了可靠方案.

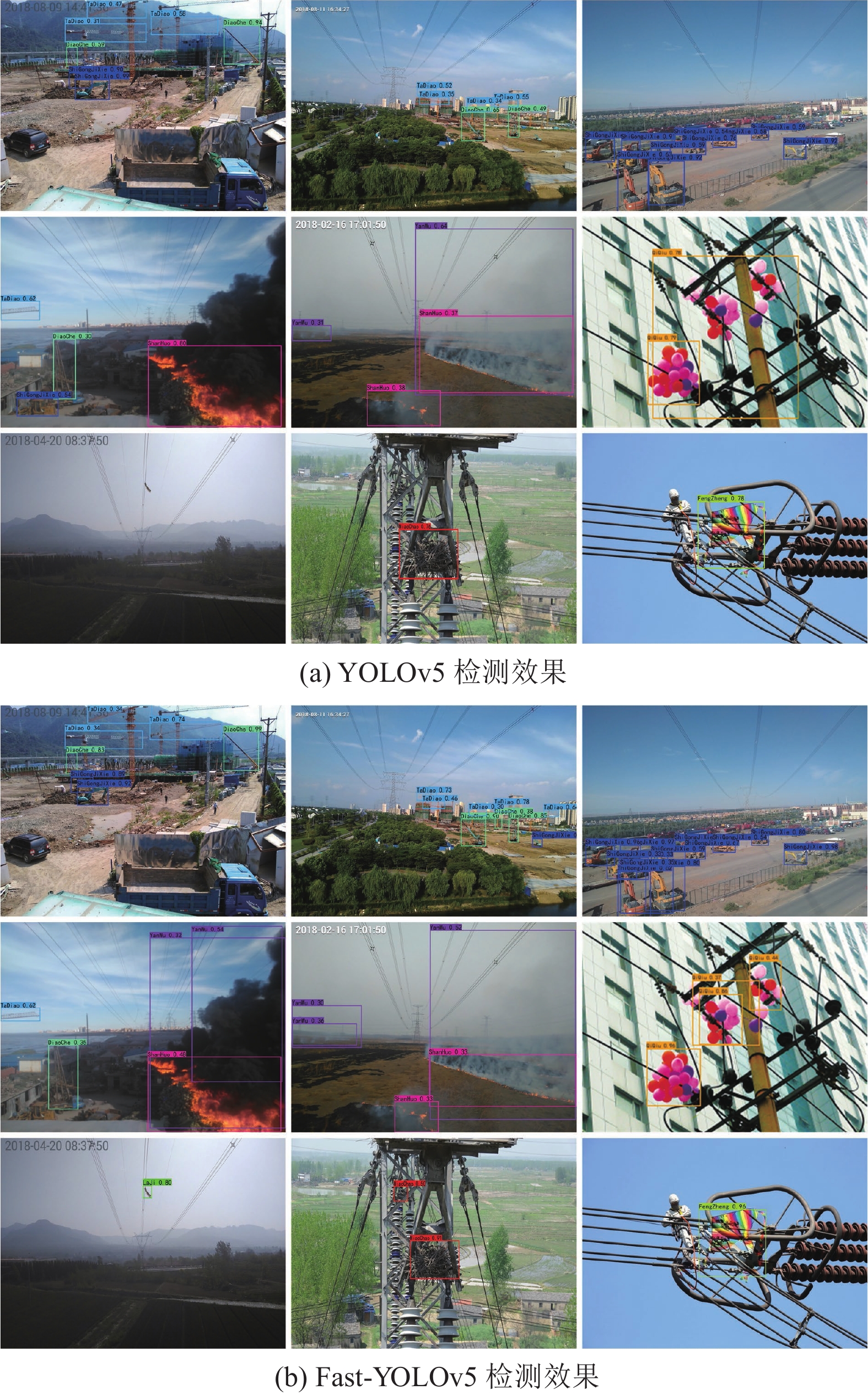

3.4.4 检测结果展示为了进一步直观的分析Fast-YOLOv5算法的性能, 分别用改进前后的模型在验证集上进行测试, 如图7(a)为YOLOv5s模型的检测效果, 图7(b)为Fast-YOLOv5模型的检测效果. 由对比图可以看出, 以第1行为例, Fast-YOLOv5模型在塔吊、吊车与其他施工机械各类目标密集遮挡情况下, 能够识别出更多更准确的目标, 检测精度也更高; 在第2行的山火、烟雾以及气球, 第3行的导线垃圾、鸟巢与风筝目标的检测效果上, Fast-YOLOv5模型整体上漏检率低, 同时定位更准确, 进一步验证了本文提出的Fast-YOLOv5模型在输电线路防外力破坏巡检场景中更具优势.

4 结论与展望本文针对当前部署在边缘端的轻量级目标检测算法存在的检测精度不足、推理速度慢等问题, 提出了一种基于全局上下文增强的稀疏卷积电网防外力破坏检测算法模型Fast-YOLOv5. 具体而言, 设计了FasterNet+网络作为新的特征提取网络, 在保持较高检测精度的情况下, 模型通过更少的内存访问量, 获得更快的检测速度; 提出了融合高效通道注意力的ECAFN模块改进瓶颈层的C3模块, 在特征融合阶段, 通过全局平均池化聚合卷积特征, 动态地调整不同通道的响应, 学习有效的通道注意力, 增强了瓶颈层的特征表达能力, 同时进一步减少模型的参数量与计算量; 提出了一种基于全局上下文增强的稀疏卷积网络SCN作为模型的检测层, 利用捕获的全局信息增强前景焦点特征, 稳定前景区域分布, 有效提升模型的识别能力. 改进后的算法在模型规模、检测精度和推理速度方面有了显著提升, 做到了3个方面性能的有效平衡, 满足输电线路实时高效检测的要求. 在下一步研究中, 将对输电线路恶劣天气条件下的巡检场景, 存在的成像退化、目标遮挡、微小目标等问题优化算法, 进一步提升模型的检测能力.

|

图 7 检测结果对比展示 |

| [1] |

陶彤. 输电线路外力破坏防控措施浅析. 电力安全技术, 2021, 23(2): 72-74. DOI:10.3969/j.issn.1008-6226.2021.02.020 |

| [2] |

马忠梅, 韩宝卿, 李文娟, 等. 智能识别技术在无人机输电线路巡检中的应用. 集成电路应用, 2022, 39(8): 126-127. DOI:10.19339/j.issn.1674-2583.2022.08.050 |

| [3] |

李有春, 汤春俊, 梁加凯, 等. 无人机输电线路巡检照片号牌文字识别方法. 无线电工程. http://kns.cnki.net/kcms/detail/13.1097.TN.20230906.1317.024.html. (2023-09-06).

|

| [4] |

Sandler M, Howard A, Zhu ML, et al. MobileNetV2: Inverted residuals and linear bottlenecks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 4510–4520. [doi: 10.1109/CVPR.2018.00474]

|

| [5] |

黄磊, 杨媛, 杨成煜, 等. FS-YOLOv5: 轻量化红外目标检测方法. 计算机工程与应用, 2023, 59(9): 215-224. DOI:10.3778/j.issn.1002-8331.2210-0487 |

| [6] |

韩汉贤, 罗金满, 刘丽媛, 等. 基于无人机图像的输电线路部件检测方法研究. 电测与仪表, 2024, 61(5): 198–203. [doi: 10.19753/j.issn1001-1390.2024.05.027]

|

| [7] |

Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector. Proceedings of the 14th European Conference on Computer Vision. Amsterdam: Springer, 2016. 21–37. [doi: 10.1007/978-3-319-46448-0_2]

|

| [8] |

韦圣贤, 李勇, 双丰, 等. 面向无人机巡检场景图像的电力线提取算法. 计算机集成制造系统. http://kns.cnki.net/kcms/detail/11.5946.TP.20230531.1122.002.html. (2023-06-01).

|

| [9] |

张毅, 刘天立, 刘越, 等. 深度学习在输电线路无人机巡检中识别防振锤缺陷的应用. 武汉大学学报(工学版), 2022, 55(10): 1065-1071. DOI:10.14188/j.1671-8844.2022-10-012 |

| [10] |

Ren SQ, He KM, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. DOI:10.1109/TPAMI.2016.2577031 |

| [11] |

刘浩翰, 樊一鸣, 贺怀清, 等. 改进YOLOv7-tiny的目标检测轻量化模型. 计算机工程与应用, 2023, 59(14): 166-175. DOI:10.3778/j.issn.1002-8331.2302-0115 |

| [12] |

Wang CY, Bochkovskiy A, Liao HYM. YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Vancouver: IEEE, 2023. 7464–7475. [doi: 10.1109/CVPR52729.2023.00721]

|

| [13] |

Zhang XY, Zhou XY, Lin MX, et al. ShuffleNet: An extremely efficient convolutional neural network for mobile devices. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 6848–6856. [doi: 10.1109/CVPR.2018.00716]

|

| [14] |

郭璠, 张泳祥, 唐琎, 等. YOLOv3-A: 基于注意力机制的交通标志检测网络. 通信学报, 2021, 42(1): 87-99. DOI:10.11959/j.issn.1000−436x.2021031 |

| [15] |

Redmon J, Farhadi A. YOLOv3: An incremental improvement. arXiv:1804.02767, 2018. Redmon J, Farhadi A. YOLOv3: An incremental improvement. arXiv:1804.02767, 2018. |

| [16] |

Howard AG, Zhu ML, Chen B, et al. MobileNets: Efficient convolutional neural networks for mobile vision applications. arXiv:1704.04861, 2017. Howard AG, Zhu ML, Chen B, et al. MobileNets: Efficient convolutional neural networks for mobile vision applications. arXiv:1704.04861, 2017. |

| [17] |

Han K, Wang YH, Tian Q, et al. GhostNet: More features from cheap operations. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle: IEEE, 2020. 1577–1586. [doi: 10.1109/CVPR42600.2020.00165]

|

| [18] |

Chen JR, Kao SH, He H, et al. Run, don’t walk: Chasing higher FLOPS for faster neural networks. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Vancouver: IEEE, 2023. 12021–12031. [doi: 10.1109/CVPR52729.2023.01157]

|

| [19] |

Wang QL, Wu BG, Zhu PF, et al. ECA-Net: Efficient channel attention for deep convolutional neural networks. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle: IEEE, 2020. 11531–11539. [doi: 10.1109/CVPR42600.2020.01155]

|

| [20] |

Figurnov M, Collins MD, Zhu YK, et al. Spatially adaptive computation time for residual networks. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE, 2017. 1790–1799. [doi: 10.1109/CVPR.2017.194]

|

| [21] |

Yan Y, Mao YX, Li B. SECOND: Sparsely embedded convolutional detection. Sensors, 2018, 18(10): 3337. DOI:10.3390/s18103337 |

| [22] |

Verelst T, Tuytelaars T. Dynamic convolutions: Exploiting spatial sparsity for faster inference. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle: IEEE, 2020. 2317–2326. [doi: 10.1109/CVPR42600.2020.00239]

|

| [23] |

Yang ZD, Li Z; Jiang XH, et al. Focal and global knowledge distillation for detectors. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). New Orleans: IEEE, 2022. 4633–4642. [doi: 10.1109/CVPR52688.2022.00460]

|

| [24] |

Everingham M, Van Gool L, Williams CKI, et al. The PASCAL visual object classes (VOC) challenge. International Journal of Computer Vision, 2010, 88(2): 303-338. DOI:10.1007/s11263-009-0275-4 |

| [25] |

Tan MX, Le Q. EfficientNet: Rethinking model scaling for convolutional neural networks. Proceedings of the 36th International Conference on Machine Learning. Long Beach: PMLR, 2019. 6105–6114.

|

| [26] |

Lin TY, Goyal P, Girshick R, et al. Focal loss for dense object detection. Proceedings of the 2017 IEEE International Conference on Computer Vision (ICCV). Venice: IEEE, 2017. 2999–3007. [doi: 10.1109/ICCV.2017.324]

|

| [27] |

Tan MX, Pang RM, Le QV. EfficientDet: Scalable and efficient object detection. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle: IEEE, 2020. 10778–10787. [doi: 10.1109/CVPR42600.2020.01079]

|

| [28] |

Ge Z, Liu ST, Wang F, et al. YOLOX: Exceeding YOLO series in 2021. arXiv:2107.08430, 2021. Ge Z, Liu ST, Wang F, et al. YOLOX: Exceeding YOLO series in 2021. arXiv:2107.08430, 2021. |

2024, Vol. 33

2024, Vol. 33