2. 光电信息控制和安全技术重点实验室, 天津 300308

2. Science and Technology on Electro-optical Information Security Control Laboratory, Tianjin 300308, China

数据的数量和多样性对于深度学习的发展具有重要推动作用, 然而收集和标记数据是一项艰巨的任务. 因此, 为增加现有数据的多样性, 数据增强(data augmen-tation, DA)[1–3]成为一种技术发展趋势, 其通过应用多种变换来实现. 近年来, 一系列混合样本数据增强方法(mixed sample data augmentation, MSDA)[4,5]应运而生. 区别于传统的单一样本数据增强方法, 由于其充分考虑到不同类别样本间的邻近关系, 在图像数据增强过程中取得了较好的增强效果.

为了提高模型性能, Zhang等人[6]提出Mixup方法, 对两幅图像根据随机权重进行全区域混合的操作来生成新样本. 尽管这种简单的变换过程可以提高模型性能, 但需要手动调整混合系数, 操作十分不便. 此外, 该方法还会导致局部纹理特征模糊, 引入一些不自然的伪像素信息. 为减少伪像素信息对网络模型的影响, Yun等人[7]提出CutMix方法, 该方法通过将其他图像的某一部分进行裁剪并填充到原图像相同位置, 以此创建新样本进行训练. 然而, Uddin等人[8]认为用另一个补丁填充图像的随机区域并不能保证补丁具有丰富信息, 为解决此问题, Uddin等人[8]提出一种名为SaliencyMix方法, 该方法将补丁图像中的显著性区域填充到原图像的非显著性区域, 以在生成的样本中获得多个图像的显著性特征. 然而, 这种方法需要额外的计算开销来寻找图像的显著性区域, 实际应用效果不佳.

在2020年, Bochkovskiy等人[9,10]提出一种名为Mosaic的增强方法. 与现有数据增强方法不同, Mosaic通过将4幅随机切分的图像拼接在一起, 生成一幅全新的图像. 同时, Mosaic方法根据4幅图像的面积比例生成新标签, 并将这幅新图像和标签传入网络模型中进行训练. 然而, Mosaic方法存在一个问题, 即部分图像的特征区域会在切分过程中丢失, 容易误导网络模型对图像类别的学习, 影响网络模型性能. 尽管现有的混合样本数据增强方法在网络模型中对描述图像所属某类别方面起到至关重要的作用, 但它们无法提供关于其他混合图像不属于该类别的信息, 不会促使网络模型对图像类别进行反向学习, 从而影响模型的学习效果.

本文方法利用训练数据对原图像进行填充, 以增加图像目标多样性, 并弥补现有数据增强方法中目标相对简单的问题. 同时, 该方法通过反向学习机制, 充分利用图像的类内相似性和类间差异性进行拼接, 生成一幅图像将其作为训练数据的新样本, 使网络模型正确学习图像的类别并反向学习填充图像不属于该类别. 本文方法通过提高图像背景复杂度干扰网络模型学习, 提高网络模型的学习效果和泛化能力. 最后, 在CIFAR-10、CIFAR-100、Fashion-MNIST、Imagenette和Imagewoof这5个数据集上进行了实验, 并与多个模型进行对比, 其分类准确率平均提升3.1%. 不同数据增强方法生成的样本如图1所示.

|

图 1 不同数据增强方法样本示意图 |

2 相关工作 2.1 数据增强

深度卷积神经网络 (convolutional neural network, CNN)[11]在计算机视觉、自然语言处理、语音识别和信号处理等[12]人工智能任务中获得显著成功的原因之一是因为有大量可学习参数. 然而, 过多的参数可能会导致网络模型过度拟合. 因此, 需要使用数据增强技术增加训练数据量, 避免模型过度拟合. 此外, 模型在处理不同分布的训练数据时, 其泛化能力受到严重限制, 因此数据增强技术是提高模型泛化能力的重要方法之一.

在传统数据增强领域, 可以使用旋转[13]、裁剪[14]、颜色抖动[15]、像素域融合[16]等方法. 这些方法会导致图像失真并存在数据高度冗余, 对数据增强方法在实际应用中的发展具有一定影响. 2017年, DeVries等人[17]提出Cutout方法, 该方法在图像中随机选择一个裁剪区域, 并将该区域内的像素内容全部去除, 形成遮挡, 生成与原图不同的新样本. 2018年, Cubuk等人[18]提出一种无监督的数据增强方法AutoAugment, 该方法定义了各种增强技术的搜索空间, 并能自动地设计特定的数据增强方案.

最近, Kim等人[19]提出PuzzleMix方法, 该方法旨在联合优化两个目标: 选择最优掩模和最优混合计划, 其目的是凸显两幅图像中最显著的特征, 最大限度地提高训练样本中的显著性区域. Hong等人[20]提出的StyleMix方法, 解决了不区分内容和样本特征的问题, 该方法将图像的内容和样本特征进行详细分离处理, 并且在数据集上展现出令人印象深刻的性能. Suzuki[21]提出基于对抗策略的TeachAugment数据增强方法, 该方法不需要大量调参, 利用教师模型生成带有关键信息的样本, 取得了较好的数据增强效果.

2.2 反向学习反向学习(opposition-based learning, OBL)[22]是机器学习中的一个新概念. 为提高优化方法、强化学习、人工神经网络和模糊系统等计算方法的性能, OBL的概念被广泛应用.

Ventresca等人[23]通过引入反传递函数的概念来改进BPTT算法, 该算法通过使用反向传播神经网络进行学习. 无论是原始传递函数还是反传递函数, 网络的传递函数都是基于概率估计. 根据网络的误差函数, 计算每个隐藏神经元的概率. 如果网络误差较小, 则相同传递函数的概率增加, 否则它会被还原.

Tizhoosh等人[24]提出一种利用反模糊集的图像阈值分割方法. 该方法将窗口视为对象中心的围绕区域, 并逐步增加其大小. 在每次迭代中, 计算当前窗口内的暗像素作为模糊集的对偶, 确定两个模糊集之间最大熵差的窗口位置, 并根据所选窗口的两个模糊集代表数的平均值计算图像阈值. 同时, 提出一种逼近第2类相对点的方法[25], 该方法利用Takagi-Sugeno或T-S模糊推理系统进行演化模糊推理.

差分目标传播(DTP)能够在复杂任务中匹配反向传播性能的学习算法, 但是DTP权值更新和损失梯度之间的良好一致性只能在非常特定的训练体系结构条件下得到部分保证. Ernoult等人[26]提出了一种新的反馈权重训练方案, 其通过构造将反馈算子的雅可比矩阵推向其前馈对应部分的转置, 以分层的方式, 从而避免了在反馈路径中使用直接反馈连接的需要.

最近出现一种基于反向多领导者的多目标粒子群优化方法[27], 其采用反向选择方法来选择具有良好收敛性的全局最佳值和具有良好多样性的全局最佳值. 反向选择方法为每个粒子匹配合适的领导者, 每个粒子选择合适的学习样本, 使得粒子可以在几个迭代中更接近真实情况.

近年来, 越来越多的研究工作将反向学习概念应用于机器学习, 以应对模式识别与图像处理等多种领域的挑战. 将反向学习用于优化方法, 以解决图像处理和模式识别需要参数调整等问题. 在各个应用领域中, 最常见的反向学习方式是基于基本概念和准对立的学习. 本文采用反向学习中对立的概念, 增强网络模型对图像类别的判定能力.

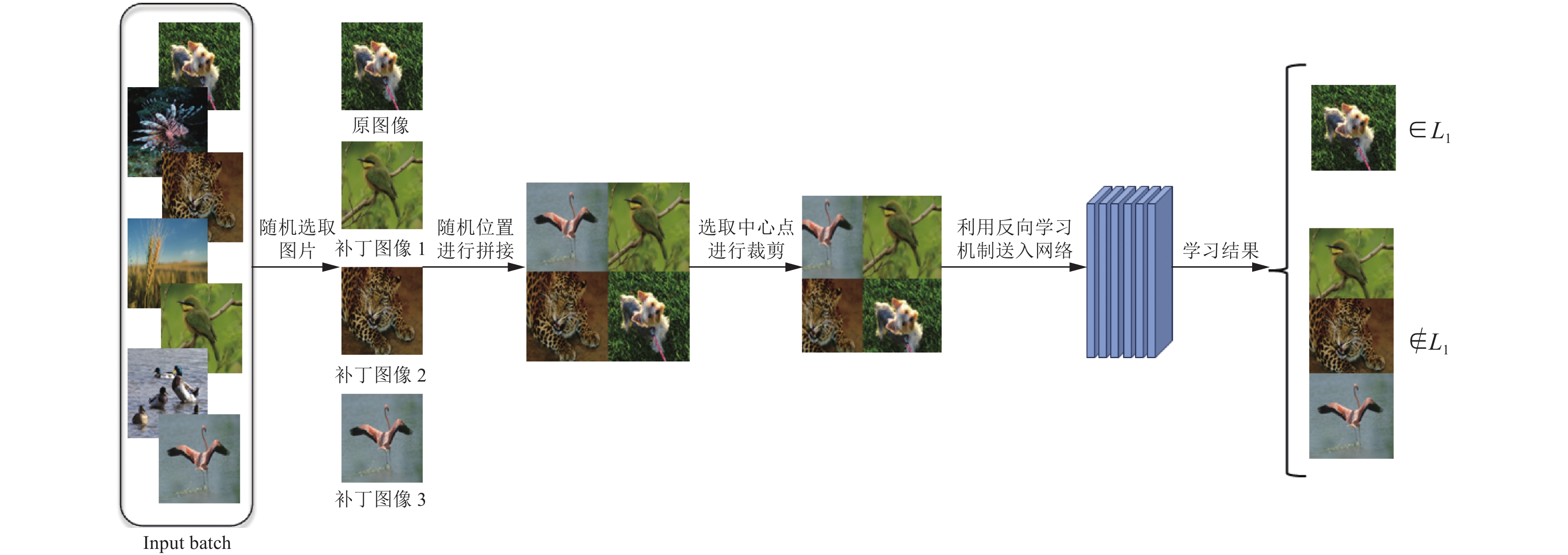

3 本文方法本文方法首先在训练数据中随机选取图像对原图像进行填充, 丰富原图像背景和目标的多样性, 其次选取中心点进行裁剪, 突显原图像的特征信息, 然后将裁剪后的图像送入网络模型中进行训练, 利用反向学习机制使网络模型正确辨别原图像类别, 并反向学习填充图像不属于此类别.

3.1 反向学习机制现有数据增强方法针对图像类别采用正向表达, 对网络模型的学习效果有一定影响, 尤其在混合样本数据增强中对原图像类别的判定. 为此, 本文引入了反向学习机制, 不仅让网络模型能够辨别原图像所属类别, 还排除填充图像属于该类别的可能性.

Tizhoosh在2005年提出反向学习[28], 这是机器学习中的一个概念, 其灵感来源于现实世界中事物之间的相对关系, 比如阴阳、冷热、干湿等. 本文方法根据反向学习中相反数的定义, 分析图像的类间相似性和类内差异性实现对图像类别的准确区分, 并有效地识别出不同的图像类别, 以应对复杂的图像分类等问题.

设

| ˜x=a+b−x | (1) |

利用相反数的定义, 以一维空间为例, 图2表示

|

图 2 相反数 |

明确相反数的定义之后, 将原图像

| Tp={T1,T2,T3,T4} | (2) |

| Lp={L1,L2,L3,L4} | (3) |

| Lp∈L1 | (4) |

| L2,L3,L4∉L1 | (5) |

其中,

本文方法引入了更多图像来增加背景和目标的复杂度, 展示出类内相似性和类间差异性, 从而帮助网络模型更好地学习和理解某一类别的特征, 同时也能够让网络模型学习到不同类别的差异, 进而提升模型的学习效果和泛化能力.

3.2 图像混合现有的混合样本数据增强方法只是采用两幅图像进行混合, 产生的训练样本数量及形式有限. 为了进一步提高样本丰富性, 本文方法在数据集中按批次选取图像, 每批图像包含m幅. 然后, 从批次中随机选取4幅图像进行操作. 设随机选取4幅图像的可能性为

| N=Cnm | (6) |

其中, n为4. 而随机选取两次, 两次图像相同的概率为

| P(N)=(1Cnm)2 | (7) |

根据式(6)和式(7), 本文方法利用随机选取4幅图像生成新样本, 增加训练样本的数量, 并且重复两次选取到4幅相同图像生成样本的可能性极低, 进而避免网络模型过度拟合.

在本文方法中, 有1幅原图像和其他3幅填充图像, 其4幅图像按照四宫格的形式进行拼接. 为让原图像位置随机摆放, 设计一个概率因子ρ, 其取值范围在0和1之间. 当ρ小于0.25时, 原图像所在位置为

本文方法通过对随机选取的4幅图像进行拼接, 确保生成的训练样本包含各种场景、角度和物体的组合, 让网络模型能够同时学习到不同图像, 从而加强网络模型对图像类别的判定能力; 利用其他图像丰富原图像的背景和目标, 增加网络模型对图像进行学习的干扰, 使得网络模型能够更好地适应各种较为复杂的图像场景.

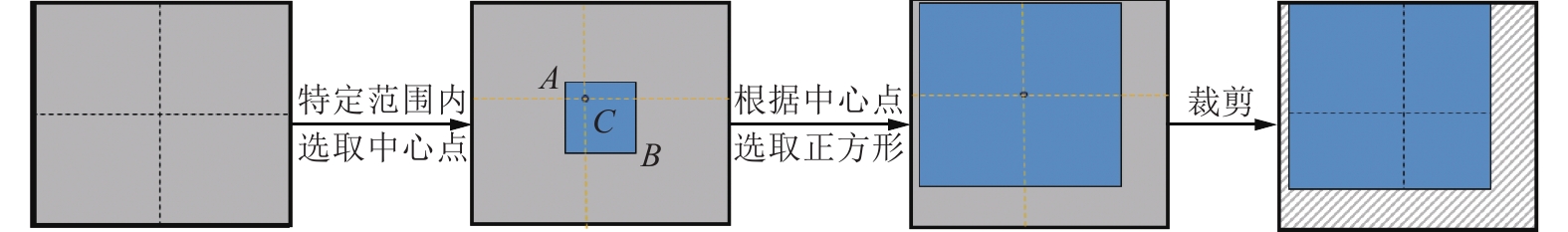

3.3 中心点裁剪由于数据集中的图像尺寸相同, 导致原图像和填充图像的信息一致. 因此, 需要对拼接后的图像进行裁剪, 突显原图像的特征信息. 首先, 设拼接后的图像尺寸为

| xi=min | (8) |

其中,

| X_{l}=x-x_{i},\;X_{r}=x+x_{i} | (9) |

| Y_{b}=y-x_{i}, \;Y_{t}=y+x_{i} | (10) |

最后, 对选取的正方形进行规则裁剪, 得到最终的图像. 具体的中心点裁剪过程如图3所示.

|

图 3 中心点裁剪过程示意图 |

3.4 方法处理流程

反向目标干扰的图像数据增强方法主要处理步骤如下.

Step 1. 在总数据集中取出一个批次(batch)的数据

Step 2. 将

Step 3. 根据

Step 4. 将

本文方法的流程如图4所示.

|

图 4 反向目标干扰的数据增强方法的流程示意图 |

4 实验分析 4.1 数据集及其指标

实验在CIFAR-10, CIFAR-100, Fashion-MNIST, Imagenette和Imagewoof这5个数据集上进行. CIFAR-10数据集是主要用于识别普通物体, 其中的图像尺寸是32×32, 包含飞机、汽车、鸟类等10个类别. CIFAR-100则包含100个类别, 图像尺寸同为32×32. Fashion-MNIST是一个用于服饰分类的数据集, 其图像为单通道, 包含T恤、裤子、套衫等10个类别. Imagenette和Imagewoof是ImageNet的10个易于分类的小型数据集, 图像尺寸为224×224, 其主要指标见表1.

| 表 1 数据集的主要指标 |

4.2 实验环境及参数设置

本文方法与选取的对比方法在同一实验平台下进行实验, 全部实验在Ubuntu 18.04的操作系统, 内存为60 GB的NVIDIA Tesla P100显卡上进行, 深度学习框架为PyTorch, 编程软件为PyCharm.

为验证本文方法的有效性, 本文方法分别与基线方法(Baseline)、传统数据增强方法以及Mixup[6]、CutMix[7]、Mosaic[9]、SaliencyMix[8]以及SaliencyCut- Mix[4]这5种数据增强方法进行比较. 在相同的数据集和网络模型上, 确保比较方法之间的迭代次数(Epoch)、初始学习率(LR)以及批量大小(batch-size)等参数相同, 均使用动量为 0.9 的随机梯度下降(stochastic gradient descent, SGD)模型, 权重衰减为5E–4. CIFAR-10和CIFAR-100数据集采用128张图像批次训练200 Epoch, 学习率为0.1. Fashion-MNIST数据集采用256张图像批次训练200 Epoch, 学习率为0.1. Imagenette和Imagewoof数据集采用16张图像批次训练200 Epoch, 学习率为0.1.

4.3 实验结果分析为比较本文提出的方法与其他数据增强方法的性能, 实验使用ResNet-18、ResNet-34和WideResNet16-8这3种网络模型. 对比方法Mixup执行数据增强的概率为0.5, CutMix[7]、SaliencyMix[8]和SaliencyCutMix[4]方法执行数据增强的概率为1.0. 同时, Mixup和CutMix的α和β值相同且都分别定义为 1.0和3.0.

在ResNet-18网络模型及ResNet-34网络模型中, 本文方法及对比方法的实验结果见表2及表3. 其中, Base-Tra代表传统的数据增强方法, Ours代表本文方法. 实验结果表明, 本文方法的分类准确率总是高于其他方法. 值得注意的是, Fashion-MNIST数据集只有一个通道, 所以本文方法与其他方法的准确率差别不大, 但与传统的数据增强方法相比Top-1准确率提升大约0.6%. 在CIFAR-10数据集上, 本文方法与基线方法进行对比, 其Top-1准确率提升7%左右; 与其他数据增强方法相比, 该方法准确率提升了近1%. 在CIFAR-100数据集上, 该方法的Top-1准确率比其他方法提升了1%左右, 且由于该数据集中类别较多, 样本数量与实际任务相近, 更能体现该方法的优越性. 在Imagenette数据集和Imagewoof数据集上, 该方法的分类准确率与其他方法相比也有所提升. 尤其在Imagenette数据集上, 使用ResNet-18网络模型时该方法比其他方法的分类准确率提升了1%以上.

| 表 2 ResNet-18网络模型的实验结果对比(Top-1) (%) |

| 表 3 ResNet-34网络模型的实验结果对比(Top-1) (%) |

ResNet-18网络模型与ResNet-34网络模型对不同数据集分类准确率呈现显著差异. 具体而言, 两种网络模型对CIFAR-10与 CIFAR-100数据集的分类准确率提升幅度较小, 但对 Imagenette与Imagewoof数据集的分类准确率提升幅度明显. 在CIFAR-10和CIFAR-100数据集中, 图像分辨率只有32×32像素, 而Imagenette和Imagewoof数据集中, 图像分辨率为224×224. 低分辨率图像导致图像细节信息的丢失或模糊, 对网络模型造成一定影响. 因此图像分辨率会对网络模型具有一定影响, 本文方法使用较高分辨率的图像可以更有效地提高模型性能.

表4是本文方法与对比方法在WideResNet16-8网络模型的实验结果. 本文方法在CIFAR- 10、CIFAR-100数据集上的分类准确率与其他方法相比均有提升. 在Fashion-MNIST数据集上, CutMix方法的分类准确率最高, 达到96.2%. 但是, 本文方法比CutMix方法相比Top-1准确率仅下降0.4%左右. 在Imagenette和Image-woof数据集上, 本文方法的分类准确率是89.7% 和78.7%.

| 表 4 WideResNet16-8网络模型的实验结果对比(Top-1) (%) |

实验结果表明, 本文方法在不同数据集的性能表现上存在明显差异. 然而, 相较于Imagenette数据集, 本文方法对Imagewoof数据集的提升效果较为有限. 在ResNet-18和ResNet-34网络中, 本文方法在Imagenette和Imagewoof数据集上与CutMix相比提升分别约0.7% 和0.2%. 在WideResNet16-8网络中, 本文方法相较于CutMix方法在Imagenette数据集上提升1.4%, 而在Imagewoof数据集上提升0.7%. 因为Imagewoof数据集图像均为犬的不同种类, 所以图像区别较小. 本文方法对多幅不同类别道德图像进行拼接, 造成网络模型对Imagewoof数据集进行处理时较容易对不同类别的图像进行混淆, 从而准确率提升有限. 相比较而言, Imagenette数据集含有多种物体的类别, 本文方法使网络模型能更容易区分不同物体的图像, 从而分类准确率得到明显提升.

表5展示了本文方法与对比方法在ResNet-18和ResNet-34网络模型Top-5错误率的实验结果. 本文方法的Top-5错误率与其他方法相比均有下降, 说明本文方法具有提高网络模型的泛化能力.

| 表 5 Imagenette数据集的Top-5错误率对比(%) |

为进一步验证本文方法的有效性, 使用ResNet-50网络模型在CIFAR-10数据集上进行实验, 并生成分类混淆矩阵图, 如图5所示. 图中展示各类样本的预测正确和预测错误的数量以及各种方法的分类准确率. 虽然本文方法的Top-1准确率与其他方法相比提升幅度有限, 但是本文方法在CIFAR-10数据集上能够正确分类的样本数量明显多于其他方法, 尤其是Mixup与CutMix方法. Mixup方法的图像插值混合导致图像模糊, 从而影响了正确分类样本的数量. CutMix方法生成的新样本只包含一幅图像的特征区域, 限制了模型学习能力, 从而影响了预测样本正确的数量. 本文方法与SaliencyMix方法进行对比, 正确预测样本数量近乎相同且准确率提升的幅度较小, 但SaliencyMix方法需要额外的计算开销. 综上, 本文方法通过随机拼接4幅图像, 使模型能够获得更多的特征信息, 并且采用反向学习机制进行学习, 使网络模型能够有效地区分图像类别的同时还加强了对某一类别的判断能力.

4.4 消融实验Mixup、CutMix方法采用两幅图像进行融合, Mosaic方法与本文方法是4幅图像进行拼接的数据增强方法. 为验证本文方法的有效性, 根据各种方法的区别, 使用ResNet-34网络模型进行消融实验, 实验结果见表6.

在CIFAR-10和Imagenette数据集上, 本文方法与Mixup方法结合, 相较于与CutMix方法结合分类准确率分别下降3.4% 和5.3%. 由于Mixup方法通过将两幅图像按照一定比例进行融合来产生新样本, 造成了图像信息的大量丢失, 加大了网络模型对图像类别进行区分的难度, 从而导致与Mixup方法相结合后的分类准确率下降. 而Mosaic方法与Mixup方法结合分类准确率下降幅度更大. Mosaic方法对图像进行随机切分后再拼接, 丢失原图像中的关键特征区域, 网络模型无法充分学习到图像的特征信息, 还容易误导网络模型对图像类别的学习.

|

图 5 方法的混淆矩阵 |

4.5 模型收敛性能分析

本文方法与对比算法Mixup、Mosaic在不同网络模型上的收敛性能对比如图6所示. 在ResNet-18网络模型上, 通过200次迭代过程观察准确率ACC的上升情况, 并把本文方法和其他两种数据增强方法作了对比, 见图6(a). 同时还将本文方法和其他两种方法在ResNet-34网络模型中的分类准确率进行对比, 见图6(b). 根据图6所示, 相较于Mixup和Mosaic方法, 本文方法在准确率方面呈现出更为平稳的上升趋势. 同时, 本文方法在保证准确率稳定提升的前提下, 还能有效减少计算时间. 在训练过程中, 本文方法呈现出更为优异的收敛性.

| 表 6 不同方法消融实验结果 |

|

图 6 方法的Top-1准确率对比 |

图7为本文方法和Mixup、Mosaic方法在ResNet-34网络模型上Top-5错误率的比较. 与Mixup和Mosaic方法相比, 本文方法的Top-5错误率更低, 下降趋势更加平稳, 同时收敛速度在大部分迭代过程中也明显优于其他两种方法. 结果表明, 本文提出的方法在提高模型性能和泛化能力方面具有较大的优势.

|

图 7 方法的Top-5错误率对比 |

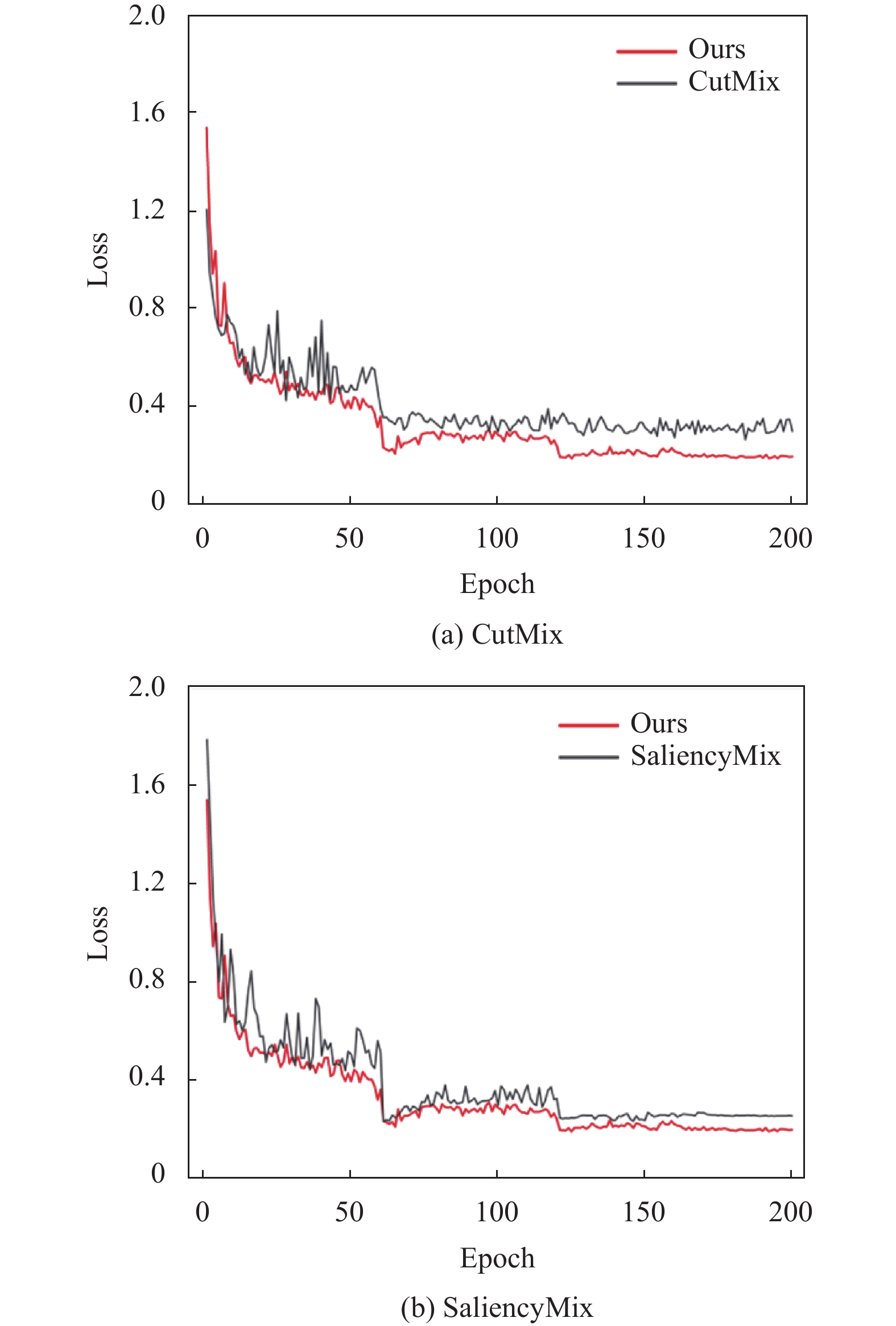

图8为本文方法和CutMix、SaliencyMix方法在ResNet-34网络模型上损失函数的比较. 图8 (a)为迭代200次时, 本文方法和CutMix方法的损失率下降情况. 本文方法在训练前期迅速收敛, 达到较小的损失率. 相比较而言, CutMix方法损失率降低曲线更波动且总体变化趋势更缓慢, 这表明该方法在训练时可能受部分噪声或者异常样本等因素影响而使网络模型不能对训练数据进行稳定拟合. 本文方法在训练过程中能够更好地优化网络模型, 使其更加准确地拟合训练数据. 图8 (b)则展示了该方法和SaliencyMix方法迭代时损失率之间的对比. 总体来看, 本文方法损失率曲线低于SaliencyMix方法. 由于本文方法中采用4幅图像进行拼接的混合策略, 使得模型更加准确地学习图像的重要信息. 这说明本文方法可以减少训练时的损失, 损失率减小就意味着该方法对网络模型的优化程度较高, 同时体现出该方法使网络模型对训练数据有较好的适应能力.

4.6 随机图像对性能影响分析为验证4幅图像随机选取的作用, 在CIFAR-100数据集上使用ResNet-18和WideResNet16-8网络模型进行对比实验, 实验结果见表7、表8.

实验结果表明, 采用随机选取4幅图像进行拼接的方法具有最佳性能, 而随机选取一幅图像进行拼接方法的分类准确率最低. 图像可能包含不同的物体、场景或角度, 拼接4幅图像可以产生更丰富、更复杂的目标特征, 有助于丰富训练样本的特征信息, 使模型能够更好地区分不同类别之间的特征差异. 同时, 还可以减小样本之间的相关性, 降低模型对于特定样本的过拟合风险. 而在选取一幅图像进行拼接的情况下, 模型可能过度依赖于该幅图像的特征, 无法充分利用其他图像包含的信息. 这说明通过随机选取4幅图像进行拼接可以显著增加样本的多样性, 使模型能够学习到更多的特征信息, 从而提升模型的性能. 因此, 本文方法是一种有效的方法, 可以显著提升模型的学习效果和泛化能力.

|

图 8 方法的损失率对比 |

| 表 7 ResNet-18网络模型随机图像的实验(%) |

| 表 8 WideResNet16-8网络模型随机图像的实验(%) |

5 结论与展望

混合样本数据增强方法可以显著提高模型的性能, 然而这些方法仅在网络模型中对图像类别进行正向表达. 为更好地促进网络模型对图像类别的学习, 提出反向目标干扰的图像数据增强方法. 该方法首先利用训练数据中的其他图像丰富图像背景及目标, 然后通过反向学习机制加强网络模型对图像类内和类间的辨别能力. 实验结果表明, 本文方法提高了网络模型的学习效果和泛化能力, 降低了模型过拟合的风险, 与现有数据增强的方法相比具有了良好的性能. 然而, 在进行中心点裁剪时, 图像的小部分特征区域会丢失, 后续将对中心点裁剪方法进行优化研究.

| [1] |

Shorten C, Khoshgoftaar TM. A survey on image data augmentation for deep learning. Journal of Big Data, 2019, 6(1): 60. DOI:10.1186/s40537-019-0197-0 |

| [2] |

Su D, Kong H, Qiao YL, et al. Data augmentation for deep learning based semantic segmentation and crop-weed classification in agricultural robotics. Computers and Electronics in Agriculture, 2021, 190: 106418. DOI:10.1016/j.compag.2021.106418 |

| [3] |

郭文明, 王腾亿. 类激活映射指导数据增强的细粒度图像分类. 计算机辅助设计与图形学学报, 2021, 33(11): 1698-1704. |

| [4] |

曾武, 朱恒亮, 邢树礼, 等. 显著性检测引导的图像数据增强方法. 图学学报, 2023, 44(2): 260-270. |

| [5] |

Harris E, Marcu A, Painter M, et al. Fmix: Enhancing mixed sample data augmentation. arXiv:2002.12047, 2021.

|

| [6] |

Zhang HY, Cissé M, Dauphin YN, et al. Mixup: Beyond empirical risk minimization. Proceedings of the 6th International Conference on Learning Representations. Vancouver: OpenReview.net, 2018.

|

| [7] |

Yun S, Han D, Chun S, et al. CutMix: Regularization strategy to train strong classifiers with localizable features. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 6022–6031.

|

| [8] |

Uddin AFMS, Monira MS, Shin W, et al. SaliencyMix: A saliency guided data augmentation strategy for better regularization. arXiv:2006.01791, 2021.

|

| [9] |

Bochkovskiy A, Wang CY, Liao HYM. YOLOv4: Optimal speed and accuracy of object detection. arXiv:2004.10934, 2020.

|

| [10] |

马宁, 曹云峰, 王指辉, 等. 基于YOLOv5网络架构的着陆跑道检测算法研究. 激光与光电子学进展, 2022, 59(14): 189-195. |

| [11] |

Koushik J. Understanding convolutional neural networks. arXiv:1605.09081, 2016.

|

| [12] |

Kamath U, Liu J, Whitaker J. Deep Learning for NLP and Speech Recognition. Cham: Springer, 2019.

|

| [13] |

Cui JF, Zhang XY, Xiong FB, et al. Pathological myopia image recognition strategy based on data augmentation and model fusion. Journal of Healthcare Engineering, 2021, 2021: 5549779. |

| [14] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 770–778.

|

| [15] |

Krizhevsky A, Sutskever I, Hinton GE. ImageNet classification with deep convolutional neural networks. Communications of the ACM, 2017, 60(6): 84-90. DOI:10.1145/3065386 |

| [16] |

马国祥, 严传波, 张志豪, 等. 基于数据增强的CT图像病灶检测方法. 计算机系统应用, 2021, 30(10): 187-194. DOI:10.15888/j.cnki.csa.008135 |

| [17] |

DeVries T, Taylor GW. Improved regularization of convolutional neural networks with cutout. arXiv:1708.04552, 2017.

|

| [18] |

Cubuk ED, Zoph B, Mane D, et al. AutoAugment: Learning augmentation policies from data. arXiv:1805.09501, 2019.

|

| [19] |

Kim JH, Choo W, Song HO. PuzzleMix: Exploiting saliency and local statistics for optimal mixup. Proceedings of the 37th International Conference on Machine Learning. JMLR.org, 2020. 489.

|

| [20] |

Hong MN, Choi J, Kim G. StyleMix: Separating content and style for enhanced data augmentation. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 14857–14865.

|

| [21] |

Suzuki T. TeachAugment: Data augmentation optimization using teacher knowledge. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022. 10894–10904.

|

| [22] |

Rahnamayan S, Tizhoosh HR, Salama MMA. Opposition-based differential evolution. In: Chakraborty UK, ed. Advances in Differential Evolution. Berlin: Springer, 2008. 155–177.

|

| [23] |

Ventresca M, Tizhoosh HR. Two frameworks for improving gradient-based learning algorithms. In: Tizhoosh HR, Ventresca M, eds. Oppositional Concepts in Computational Intelligence. Berlin: Springer, 2008. 255–284.

|

| [24] |

Tizhoosh HR, Sahba F. Quasi-global oppositional fuzzy thresholding. Proceedings of the 2009 IEEE International Conference on Fuzzy Systems. Jeju: IEEE, 2009. 1346–1351.

|

| [25] |

Tizhoosh HR, Rahnamayan S. Learning opposites with evolving rules. Proceedings of the 2015 IEEE International Conference on Fuzzy Systems. Istanbul: IEEE, 2015. 1–8.

|

| [26] |

Ernoult MM, Normandin F, Moudgil A, et al. Towards scaling difference target propagation by learning backprop targets. Proceedings of the 39th International Conference on Machine Learning. Baltimore: PMLR, 2022. 5968–5987.

|

| [27] |

Chen F, Liu YM, Yang J, et al. Multi-objective particle swarm optimization with reverse multi-leaders. Mathematical Biosciences and Engineering, 2023, 20(7): 11732-11762. DOI:10.3934/mbe.2023522 |

| [28] |

Tizhoosh HR. Opposition-based learning: A new scheme for machine intelligence. Proceedings of the 2005 International Conference on Computational Intelligence for Modelling, Control and Automation and International Conference on Intelligent Agents, Web Technologies and Internet Commerce. IEEE, 2005. 695–701.

|

2024, Vol. 33

2024, Vol. 33