视网膜是人体中负责视觉处理的组织, 视网膜血管的形态的变化或者损害都可能造成严重的健康问题, 例如高血压、糖尿病或者白内障, 但如果可以尽早地发现此类眼部疾病并进行治疗, 就可以极大地提高治愈的成功率, 并减少此类疾病对身体的危害[1,2]. 医学图像分割任务旨在突出图像中的某些部位或是组织的特征, 视网膜血管分割任务就是其中之一, 通过对图像中的血管进行分割, 可以更好地观察到血管的形态的变化. 但是早期的分割一般是依赖于手工进行的, 但这种做法费时费力, 成本高, 需要专业知识技能, 还容易受到主观因素的影响[1]. 因此对自动分割工具的需求快速增长, 自动分割具有高效、快速、准确等特点, 将其应用于诊断中可以极大地提高诊断的速度和效率.

传统的图像分割方法更多是基于图像本身的结构特征, 比如尺寸, 形状, 纹理等, 常用的分割方法有阈值法, 区域生长方法, 边缘检测方法等, 此类方法易实现, 运算速度快, 但是容易受到噪声的影响, 而且有时候需要人为设定参数, 在遇到较为复杂的图像或是对比度不明显, 边缘不清晰的图像时, 传统的分割方法得到的结果离期望的要求还有一定的差距.

近年来, 对卷积神经网络的研究愈发火热, 使用基于深度学习进行医学图像分割的研究数也在不断增长, 深度学习方法相比于传统图像处理方法, 可以在训练过程中自动地对参数进行优化, 而且不易受到噪声的影响, 不论是提取特征的能力还是处理复杂图像信息的能力都更强. 但是深度学习方法的效果依赖于数据量, 而且监督学习也依赖于标注数据, 相比于传统的方法需要较长的训练时间, 对于小批量的数据还容易引起过拟合的问题, 这对于网络的泛化不利.

在图像分割领域, 基于深度学习的方法因其精确度高的特性而被广泛使用着, 如早期常见的有全卷积神经网络FCN[3], 这种编解码器结构的网络, 是为了更好地利用不同分辨率的信息, 实现多分辨率信息的有效合并, U-Net网络[4]在对称编解码器结构的基础上引入了跳跃连接结构, 这种连接结构可以使信息更好地在编解码器之间传递. 同时, 因为U-Net网络具有结构清晰, 易于实现和训练等优势, 在后续的研究中, 大量的方法都是基于U-Net进行优化或者是U-Net的变种, U-Net在医学图像分割领域被广泛地使用着. 但是U-Net也存在不足, 尽管利用跳跃连接实现了编解码器之间不同分辨率的信息传递, 但是这种传递是无侧重性的, 即会把所有的信息全部传递给解码器, 其中可能包括无关冗余信息, 从而影响了分割性能[5]. 同时, U-Net等网络的感受野由于卷积层自身的局限性使得网络不能很好地提取全局信息. 有研究使用可变形卷积的方法, 这种卷积可以根据目标的大小自适应地调整自身感受野的大小. DUNet[6]一文中便利用可变形卷积来提高对血管可变形的建模能力. DCU-Net[7]在此基础上又做了进一步的改动, 通过两轮U-Net的可变形卷积层来由粗到细分割图像, 并使用最大池化和平均池化使通道信息更好地在两个子网络之间传递. 尽管可变形卷积可以自适应地调整感受野大小, 但是可变形卷积的计算过程需要消耗较多资源, 这使得网络在训练的过程中速度会变得极其缓慢.

因此, 在实际的分割任务中需要根据具体的任务内容选择使用合适的方法, 传统的处理方法和深度学习的方法各有各的优势, 因此本文考虑将传统的处理方法与深度网络相结合, 以获得更好的性能. 同时, 为了解决上述研究存在的问题, 本文引入了一种新的具有残差结构的卷积模块, 将传统的小波变换方法嵌入到深度网络中以解决池化层的信息损失问题, 以及使用混合损失函数进行优化的操作, 以实现多尺度的特征提取, 并减少无关像素信息的干扰. 总的来说, 本文的贡献主要有以下几点.

一是提出了一种新的视网膜血管分割网络, 将拥有残差机制的ResDO-conv[8]与可以防止过拟合的DropBlock[9]相结合得到的DR-Conv模块来替换掉原来U-Net的卷积模块, 在增强网络回退能力的同时提高了网络的学习能力.

二是将传统小波变换与深度卷积网络相结合, 通过将图像分解成不同频带的子图实现多分辨率分析, 并实现空域信息与时域信息有效结合.

三是使用了混合的损失函数, 以弥补单个损失函数在网络训练中优化能力不足的问题.

本文第1节主要介绍所用方法的相关工作. 第2节将详细介绍所用方法. 第3节为实验部分. 第4节将对本文进行简要总结.

1 相关工作 1.1 残差网络尽管卷积神经网络CNNs相比其传统机器学习方法稳定性更好, 提取特征的能力更强, 但是在训练过程中, 由于梯度的问题会随着层数的增加而累积, 使得网络的性能退化, 从而影响最终的分割精度. 为了解决上述问题, He等人[10]提出了一种残差神经网络, 此网络在原始卷积网络的基础上增加了额外的跳跃连接, 并将卷积前的输入与进行卷积后的输出相加, 使得网络具有了回退的能力, 解决了退化问题, 使得网络可以堆叠更多层, 获得更强的特征表达能力以及更精确稳定的结果. 因此, 残差网络的优秀特性被广泛用于多个领域, 其中, 医学图像处理方面也出现了不少使用残差结构的网络模块.

Li等人[11]通过研究不同残差模块结构的影响, 提出了一种基于U-Net的使用改进后的残差模块的网络, 用于进行视网膜血管分割, 称为MResU-Net, 改进后的模块拥有更强的特征表达能力, 而且可以使网络在训练时加快收敛速度. 在文献[12]中, 提出了一种叫做AGResU-Net的网络, 主要用于脑组织图像分割, 通过结合残差结构、注意力门以及U-Net, 在训练过程中突出与任务相关的目标信息, 消除无关噪声的影响, 提取更丰富的语义信息, 同时可以更关注小尺寸目标的分割. Liu等人[8]针对原始深度卷积神经网络存在的检测能力不足的问题, 在DO-Conv[13]的基础上, 结合残差结构得到ResDO-conv网络模块, 并将其用于U-Net的主干, 提升网络的特征提取能力, 获取强上下文特征表示, 从而实现对视网膜血管图像的精确分割. Han等人在文献[14]中基于U-Net网络, 通过与ConvNeXt的对比选择了效果更好的残差结构, 改进了卷积模块并提出了一种高效的ConvUNeXt分割网络, 实现了对视网膜血管图像和结肠癌数据集的精确而有效的分割.

1.2 小波变换一些复杂的图像处理有时在空间域内难以进行, 可以把这些任务转化到频域内进行分析. 其中, 傅里叶变换是频谱分析中常用的方法, 式(1)为傅里叶正变换表达式, 式(2)为逆变换表达式:

| F(ω)=∫∞−∞f(t)e−jωtdt | (1) |

| f(t)=12π∫∞−∞F(ω)ejωtdt | (2) |

其中,

小波可以实现不同层次的信号分析, 小波又可分为连续小波和离散小波, 在数字图像处理中常使用离散小波变换. 二维离散小波变换的处理过程分为两步: 首先使用沿x轴方向的滤波器进行水平滤波, 再用沿y轴的滤波器进行垂直滤波, 分解后的子图表现出了不同频率下的特性, 低频下表现为近似图像, 高频下表现为细节图像. 基于傅里叶变换发展而来, 小波使得局部化的思想更得以突出, 且有着可以随着频率改变的时频窗口[15].

由于小波具有优秀的特性, 在医学图像处理领域也有不少相关研究. Li等人[15]将小波与U-Net网络相结合用于医学图像分割, 针对卷积神经网络用池化层造成的不可逆信息损失问题, 通过使用离散小波变换来替换原始的池化下采样以及逆离散小波变换来替换原始的卷积上采样. 文献[16]针对视网膜血管图像存在噪声, 亮度分布不均匀, 图像对比度低的问题, 提出使用小波变换和自适应阈值来过滤噪声, 并使用Daubechies-2小波来对图像进行分割以获得更精确的分割图像. 文献[17]利用小波变换与神经网络实现对骨折X射线图的分割和分类, 其小波分割系统利用信噪比、峰值信噪比和熵等指标从选定的分解层中提取特征, 根据所需的感兴趣区域ROI生成有用分割, 从而保留更多图像重要信息. Liu等人[18]针对肺部图像中存在的强度分布不均匀以及噪声的问题, 在进行分割时通过利用小波变换的多分辨率分析而获得不同尺度下的频率信息, 并结合形态学操作以实现肺部CT图像的自动分割.

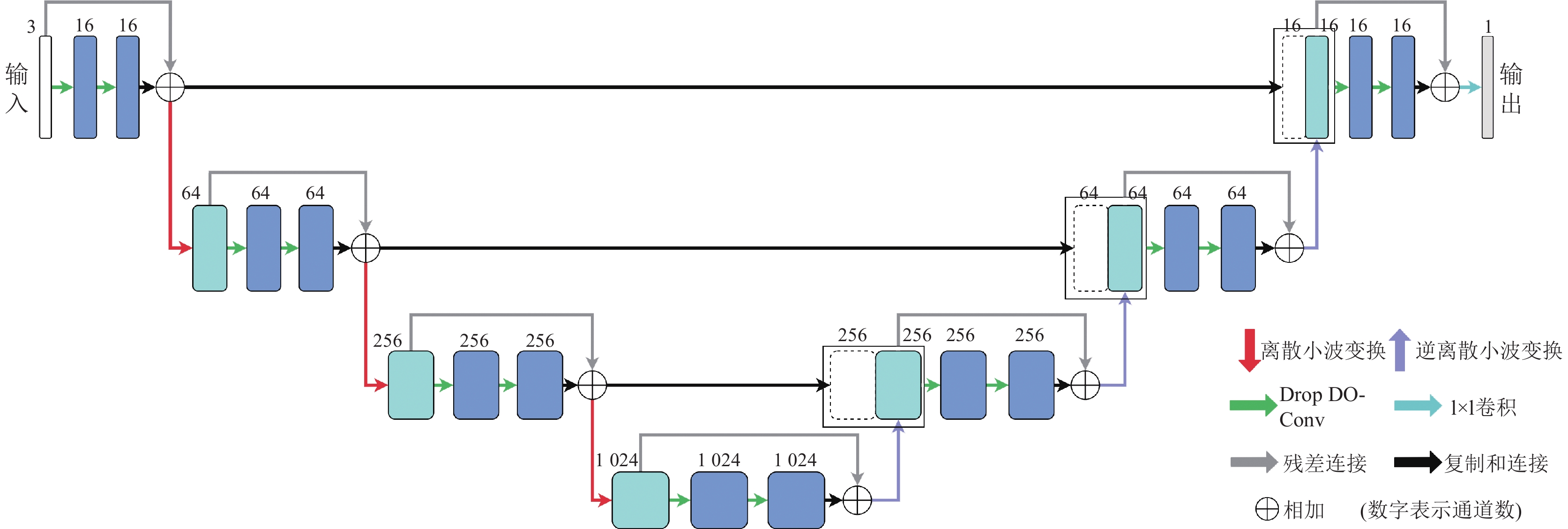

2 方法图1展示了本文网络的整体结构, 通过使用编解码器结构使网络能更好地提取上下文信息. 针对最大池化下采样造成的信息损失问题, 本文中提出使用离散小波变换来替换下采样以及使用逆离散小波变换替换卷积上采样, 并提出一种将DropBlock[9]与ResDO-conv[8]相结合的结构化卷积模块DR-Conv, 并替换原始卷积模块, 来实现更有效的网络特征提取. 同时, 对于单个损失函数优化能力不足的问题, 使用混合损失函数以增强网络的优化能力.

2.1 DR-Conv尽管U-Net结构清晰易实现, 但是传统的卷积模块的特征提取能力已经不足以应付那些比较复杂的分割任务, 而卷积模块的特征提取能力在一定程度上反映了网络的整体性能, 尤其是类似于多类别分割或是有较多小目标待分割的任务, 而视网膜血管分割图像就具有小对象多, 分割目标形状差异变化较大等特点.

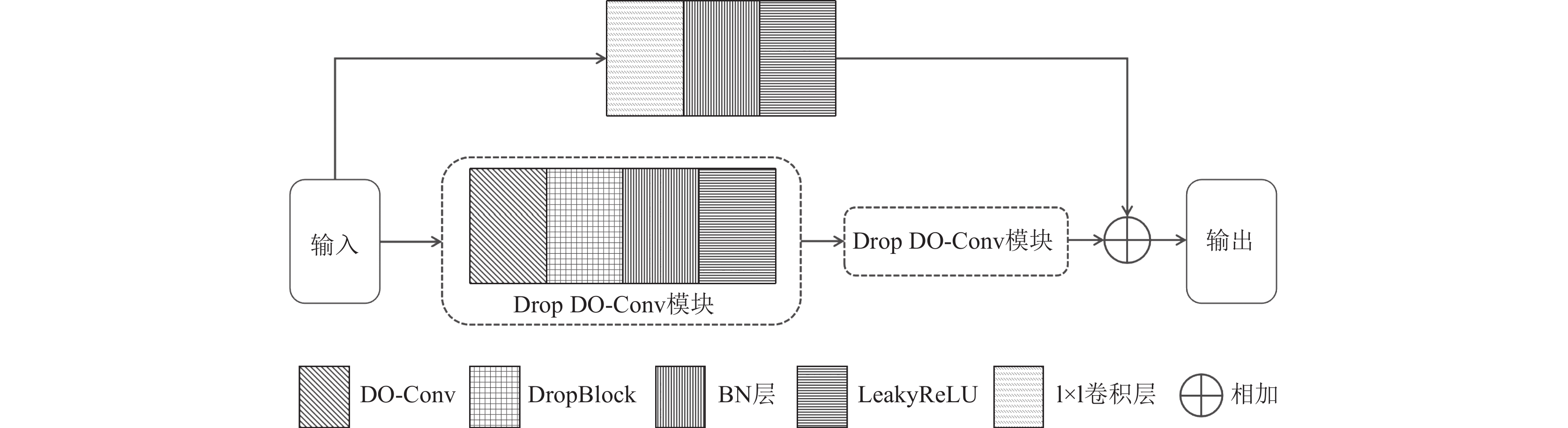

DO-Conv[13]通过引入额外的深度卷积增强了卷积的性能, 又没有额外增加网络的计算复杂度[8]. 在ResDO-UNet[8]中为了进一步增强网络的学习能力将DO-Conv扩展为ResDO-conv, 通过增加额外的支路来利用残差结构的回退机制, 以避免梯度问题出现. 本文将ResDO-conv与DropBlock[9]相结合, 参考SA-UNet[19]中的结构化dropout卷积模块, 最终得到DR-Conv模块, 其结构如图2所示. DR-Conv的主干包含了两个相同的部分, 即Drop DO-Conv模块, 每个模块按DO-Conv, DropBlock, BN和LeakyReLU的顺序进行, 另外一条支线则包含1×1卷积, BN层和LeakyReLU层, 主要用于对输入通道数进行调整. 此模块的提出主要是为了解决以下问题: 一是为了减少计算消耗, 二是引入残差单元以防出现梯度问题, 三是更有效地减少训练过程中特征的依赖关系以防止过拟合.

|

图 1 网络结构 |

|

图 2 DR-Conv结构 |

假设输入的图像为

神经网络常使用池化层来下采样, 但是池化层存在着不可逆的信息损失问题, 以及卷积层存在的固有局限性, 这会影响网络最终的分割结果. 而小波的正逆变换可以实现相似的效果, 是常见的多分辨率分析方法, 它可以从多个不同的方向的分量对图像进行分析. 小波是对图像进行平滑的有效方法之一, 同时, 小波又具有缩放和平移的特性, 适合处理瞬时信号, 常用于图像的滤波, 压缩或者去噪等[20].

小波变换可以有效描述区域特征, 主要分为连续小波变换和离散小波变换. 其中, 连续小波变换的表达式为:

| WTx(a,b)=1√a∫∞−∞x(t)ψ(t−ba)dt | (3) |

其中,

实际上的信号都是难以连续监测的, 需要离散化, 因而引入离散小波变换, 同时, 在数字图像处理中, 用于减少图像分辨率的方法也可以选用离散小波. 要得到离散小波函数, 需要将伸缩因子

| WTx(k,m)=WTx(am0,kb0am0)=(x(t),ψk,m(t))=∫∞−∞x(t)ψk,m(t)dt | (4) |

其中,

考虑到在Wavelet U-Net[15]中使用了小波变换来代替神经网络原始的池化下采样操作, 本文也考虑将小波变换与深度神经网络进行结合, 在编码器中使用二维离散小波变换替换最大池化层, 以及在解码器中使用逆离散小波变换来实现图像的分辨率恢复功能.

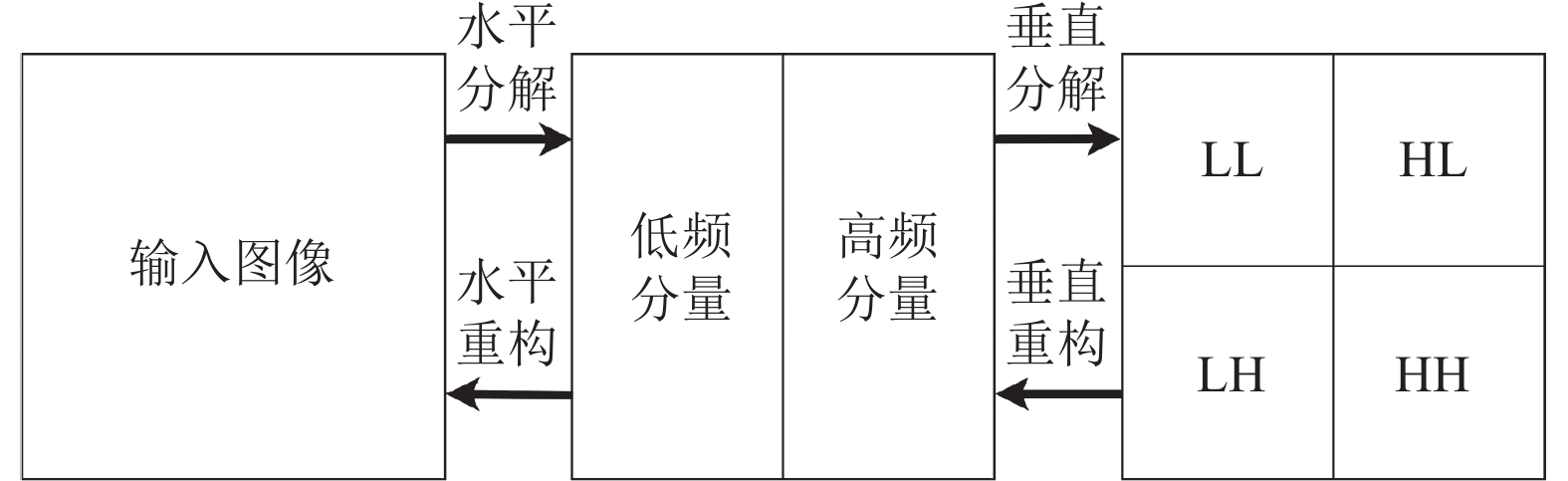

二维离散小波变换可以提供图像的局部的时间和频率的分析, 根据数字图像处理过程, 可以将这种视网膜血管图像视为二维矩阵, 然后进行二维离散小波的分解. 如图3所示为离散小波正逆变换的处理过程, 其分解步骤分为两步: 首先水平分解为高频和低频分量, 再垂直分解为4个分量, 分别表示为LL (两个方向均为低频, 近似分量), HL (水平高, 垂直低), LH (水平低, 垂直高), HH (两个方向均为高频)[21]. 每经过一次分解的结果都为输入图像分辨率的一半, 这和步长为2的池化层一样都可以达到图像大小减少的效果, 而且不会出现像池化层的信息损失问题, 同时, 通道数增加为原来的4倍. 经过小波分解后得到的低频分量表现为原始图像经过平滑之后的图像(即近似图像), 而高频表现为边缘信息.

|

图 3 离散小波分解和重构的过程 |

2.3 混合损失函数

混合损失函数通过结合不同损失函数的特性, 来弥补单个损失函数优化能力不足的问题.

交叉熵损失是分割中常见的损失之一, 由于本文分割的对象为视网膜血管图像, 属于两个类别的分割, 使用二值交叉熵损失函数, 损失的取值范围为[0, 1], 其计算公式如式(5)所示. 尽管二值交叉熵损失函数被广泛使用着, 但是其忽略了图像本身存在的类别不平衡问题, 导致网络在训练中出现偏差, 会更倾向于那些占比大的类别, 使得网络对占比较小的类别或者小目标的感知并不敏感, 这可能会使网络的预测出现错误[22], 不足以达到更优的性能.

| LBCE=−[ylogp+(1−y)log(1−p)] | (5) |

其中,

另一种常见的用于图像分割任务的损失函数为Dice损失函数, 主要用于相似度计算, 即度量网络预测的结果与真实的标签之间的相似度的差距的大小, Dice损失函数与系数的计算公式如式(6)和式(7)所示. 其中Dice损失函数的取值范围为[0, 1], 并且有Dice损失函数+Dice系数=1的关系, 系数越大说明两个图像之间的相似性越大. 而且Dice损失函数还可以在一定程度上弥补图像前景背景类别不平衡的问题[23].

| Dice=2TP2TP+FP+FN | (6) |

| LDice=1−Dice=1−2TP2TP+FP+FN | (7) |

其中,

由于不同的损失函数具有不同的特性, 使用组合损失可以考虑到多种情况并关注不同方面. 对于组合损失函数的选择, 本文将使用二值交叉熵损失函数和Dice损失函数的组合作为网络的最终损失函数

| Ltotal=LBCE+LDice | (8) |

为了选择适合本文网络的损失函数以获得更好的性能, 在后文的实验中将对单个的损失函数及其组合的效果进行测试.

3 实验 3.1 预处理与设置本文实验所用的数据集有DRIVE (训练集和测试集各20张图像)、CHASE_DB1 (8张作为测试集图像, 20张作为训练图), 以及STARE (5张作为测试集图像, 15张作为训练图). 由于每个数据集中的图像数量有限, 为了防止过拟合, 图像增强的操作是必不可少的, 如: 不同方向的翻转, 和每45°旋转一次, 以及添加噪声等.

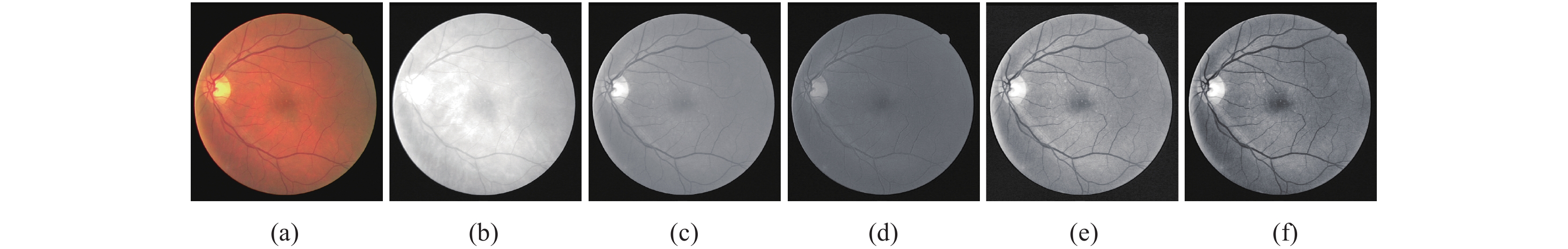

由于3个数据集的原始图像均为彩色图像, 存在着一些对比度或是亮度不明显的问题, 需要对图像进行适当的处理以减少不利因素的干扰, 再进行下一步的操作, 处理的流程图如图4所示. 其中, 图4(a)原始图像, 图4(b)–图4(d)分别是图4(a)的红通道, 绿通道和蓝通道图像, 图4(e)是绿通道使用CLAHE方法所得图像, 图4(f)是对图4(e)图像进行伽马校正. 根据图4所示, 红通道图像太亮, 蓝通道图像太暗, 绿通道图像比较适合, 但仅如此的对比度还不足, 需要再对对比度进行增强, 这里选择使用CLAHE算法[24], 最后使用伽马值对图像亮度进行调整. 为了适应网络训练尺寸, 需要将图像尺寸设置为高宽一致, 初始学习率0.001, 优化器Adam, 迭代次数为80次防止过度训练以得到泛化性能更好的网络.

|

图 4 视网膜血管图像的预处理流程 |

3.2 评价指标

本文所用评价指标有相似度Dice, 准确度acc, 以及平均交并比mIoU. 如表1所示, 其中各个指标的计算公式均为二值分割情况下的计算公式.

| 表 1 评价指标以及计算公式 |

3.3 实验结果

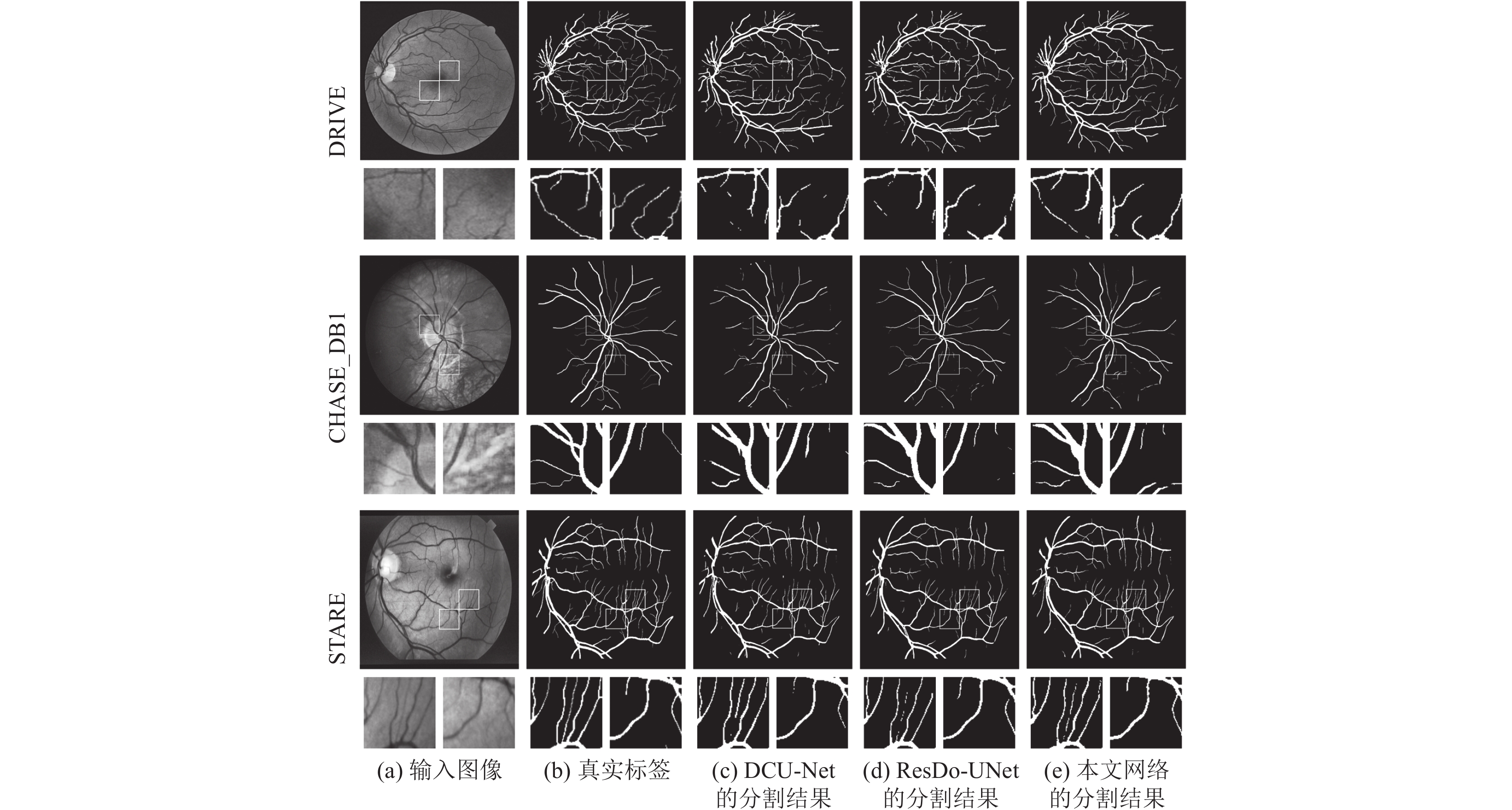

预测图像如图5所示, 可以看出, 本文网络的分割结果在细节提取上整体效果更好.

各个网络的评价指标的比较结果如表2所示, 可以看出本文的网络在3个数据集上的整体指标值要比最新的方法要好, 在DRIVE数据集上, 相比于DCU-Net, Dice和mIoU指标分别提高了0.12%, 0.06%; 相比于ResDO-UNet, Dice指标则提高了0.01%. 在CHASE_DB1数据集上, 相比于DCU-Net, 3个指标分别提高了0.31%, 0.07%, 0.24%; 相比起ResDO-UNet, acc提高了0.04%, mIoU提高了0.02%. 在STARE数据集上, 相比于DCU-Net, 3个指标分别提高了0.92%, 0.15%, 0.72%; 相比于ResDO-UNet, Dice提高了0.25%, mIoU提高了0.16%.

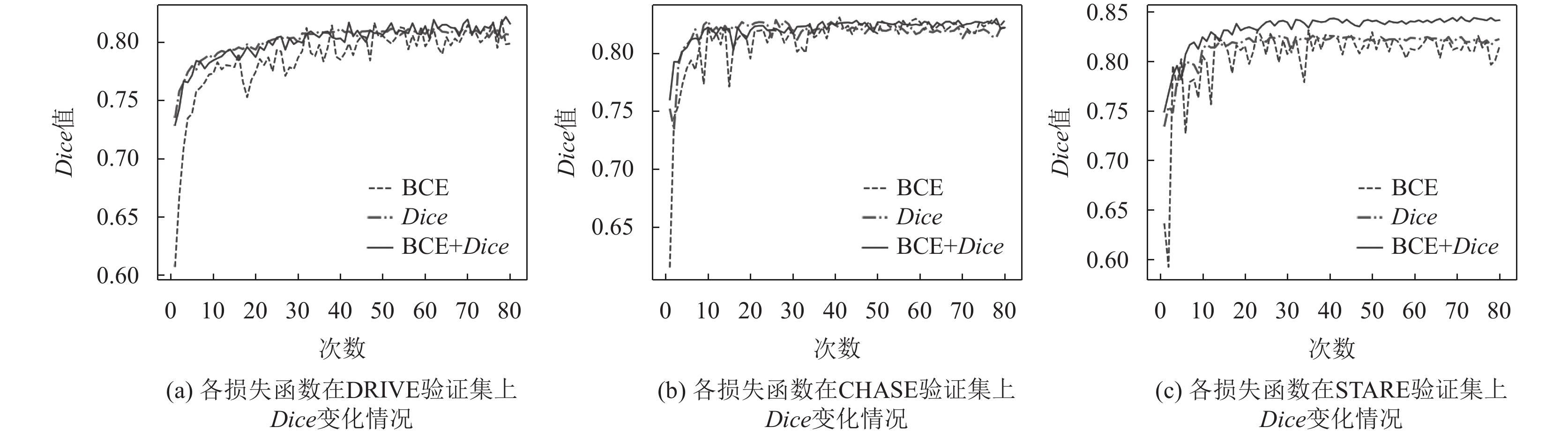

3.4 损失函数实验为了评估几种常见的损失函数对网络性能的影响程度, 选择使网络性能更好的损失函数, 进行了消融实验, 分别对单个损失函数以及组合损失函数进行了验证和测试, 实验结果如表3和图6所示. 表3中, BCE表示二值交叉熵. 由图6可以看出在3个数据集上二值交叉熵损失函数表现出来的Dice值的变化曲线波动幅度比较大, Dice损失表现出的曲线最平稳, 组合损失函数一方面减缓了波动的幅度, 另一方面整体的Dice数值曲线和Dice损失的曲线接近或略高, 比二值交叉熵损失函数曲线要高. 由表3可以看出, 在3个数据集上, 组合的损失函数整体的指标值也比两个单独的损失函数指标值要高.

|

图 5 在3个数据集上的分割结果 |

| 表 2 不同网络在3个数据集上的指标值比较 |

| 表 3 不同损失函数在3个数据集上的结果比较 |

4 结论与展望

本文提出了一种新的用于视网膜血管分割的网络, 在U-Net主干网的基础上, 将具有残差结构的ResDO-conv模块与用于减少区域间依赖性的DropBlock相结合, 得到一种新的卷积模块DR-Conv以提高网络学习的能力; 针对池化层造成的信息损失问题, 利用离散小波变换以替代; 以及混合损失函数用于优化网络训练过程, 尽可能降低预测图像与真实标签之间的差异. 将本文提出的网络应用于视网膜血管分割任务, 以提高网络性能, 获得更精确的分割结果. 同时, 为了验证本文网络的可行性, 通过在3个公共的视网膜血管图像数据集上与最新的方法进行比较, 说明我们提出的网络拥有更好的性能.

尽管我们的网络取得了较好的效果, 但是还有很多方面值得改进, 尽管使用组合损失性能有所提高, 但还需要找到优化效果更好的改进的损失函数, 或是利用多尺度的空间通道注意力, 将粗细血管分开进行处理, 多方向处理等, 之后的研究可以考虑从其中的几个方面入手, 从而获得性能更好的分割网络.

|

图 6 损失函数在3个数据集的验证集上的Dice变化曲线图 |

| [1] |

Sule OO. A survey of deep learning for retinal blood vessel segmentation methods: Taxonomy, trends, challenges and future directions. IEEE Access, 2022, 10: 38202-38236. DOI:10.1109/ACCESS.2022.3163247 |

| [2] |

Chen CH, Chuah JH, Ali R, et al. Retinal vessel segmentation using deep learning: A review. IEEE Access, 2021, 9: 111985-112004. DOI:10.1109/ACCESS.2021.3102176 |

| [3] |

Long J, Shelhamer E, Darrell T. Fully convolutional networks for semantic segmentation. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston: IEEE, 2015. 3431–3440.

|

| [4] |

Ronneberger O, Fischer P, Brox T. U-Net: Convolutional networks for biomedical image segmentation. Proceedings of the 18th International Conference on Medical Image Computing and Computer-assisted Intervention. Munich: Springer, 2015. 234–241.

|

| [5] |

Maji D, Sigedar P, Singh M. Attention res-UNet with guided decoder for semantic segmentation of brain tumors. Biomedical Signal Processing and Control, 2022, 71: 103077. DOI:10.1016/j.bspc.2021.103077 |

| [6] |

Jin QG, Meng ZP, Pham TD, et al. DUNet: A deformable network for retinal vessel segmentation. Knowledge-based Systems, 2019, 178: 149-162. DOI:10.1016/j.knosys.2019.04.025 |

| [7] |

Yang X, Li ZQ, Guo YQ, et al. DCU-Net: A deformable convolutional neural network based on cascade U-Net for retinal vessel segmentation. Multimedia Tools and Applications, 2022, 81(11): 15593-15607. DOI:10.1007/s11042-022-12418-w |

| [8] |

Liu YH, Shen J, Yang L, et al. ResDO-UNet: A deep residual network for accurate retinal vessel segmentation from fundus images. Biomedical Signal Processing and Control, 2023, 79: 104087. DOI:10.1016/j.bspc.2022.104087 |

| [9] |

Ghiasi G, Lin TY, Le QV. DropBlock: A regularization method for convolutional networks. Proceedings of the 32nd International Conference on Neural Information Processing Systems. Montréal: Curran Associates Inc., 2018. 10750–10760.

|

| [10] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE, 2016. 770–778.

|

| [11] |

Li D, Dharmawan DA, Ng BP, et al. Residual U-Net for retinal vessel segmentation. Proceedings of the 2019 IEEE International Conference on Image Processing (ICIP). Taipei: IEEE, 2019. 1425–1429.

|

| [12] |

Zhang JX, Jiang ZK, Dong J, et al. Attention gate ResU-Net for automatic MRI brain tumor segmentation. IEEE Access, 2020, 8: 58533-58545. DOI:10.1109/ACCESS.2020.2983075 |

| [13] |

Cao JM, Li YY, Sun MC, et al. Do-conv: Depthwise over-parameterized convolutional layer. IEEE Transactions on Image Processing, 2022, 31: 3726-3736. DOI:10.1109/TIP.2022.3175432 |

| [14] |

Han ZM, Jian MW, Wang GG. ConvUNeXt: An efficient convolution neural network for medical image segmentation. Knowledge-based Systems, 2022, 253: 109512. DOI:10.1016/j.knosys.2022.109512 |

| [15] |

Li Y, Wang Y, Leng T, et al. Wavelet U-Net for medical image segmentation. Proceedings of the 29th International Conference on Artificial Neural Networks and Machine Learning. Bratislava: Springer, 2020. 800–810.

|

| [16] |

Dikkala U, Mosiganti KJ, Alagirisamy M. Wavelet decomposition methodology for improved retinal blood vessel segmentation. Proceedings of ICSADL 2021 on Sentimental Analysis and Deep Learning. Singapore: Springer, 2022. 369–381.

|

| [17] |

Bagaria R, Wadhwani S, Wadhwani AK. A wavelet transform and neural network based segmentation & classification system for bone fracture detection. Optik, 2021, 236: 166687. DOI:10.1016/j.ijleo.2021.166687 |

| [18] |

Liu CX, Pang MY. Automatic lung segmentation based on image decomposition and wavelet transform. Biomedical Signal Processing and Control, 2020, 61: 102032. DOI:10.1016/j.bspc.2020.102032 |

| [19] |

Guo CL, Szemenyei M, Yi YG, et al. SA-UNet: Spatial attention U-Net for retinal vessel segmentation. Proceedings of the 25th International Conference on Pattern Recognition (ICPR). Milan: IEEE, 2021. 1236–1242.

|

| [20] |

Bagaria R, Wadhwani S, Wadhwani AK. A wavelet-based segmentation technique for medical images. Proceedings of ICSISCET 2020 on Artificial Intelligence and Sustainable Computing. Singapore: Springer, 2022. 65–77.

|

| [21] |

Othman G, Zeebaree D Q. The applications of discrete wavelet transform in image processing: A review. Journal of Soft Computing and Data Mining, 2020, 1(2): 31-43. |

| [22] |

Liu RH, Nan HY, Zou YY, et al. LSW-Net: A learning scattering wavelet network for brain tumor and retinal image segmentation. Electronics, 2022, 11(16): 2616. DOI:10.3390/electronics11162616 |

| [23] |

Zhao RJ, Qian BY, Zhang XL, et al. Rethinking dice loss for medical image segmentation. Proceedings of the 2020 IEEE International Conference on Data Mining (ICDM). Sorrento: IEEE, 2020. 851–860.

|

| [24] |

Reza AM. Realization of the contrast limited adaptive histogram equalization (CLAHE) for real-time image enhancement. Journal of VLSI Signal Processing Systems for Signal, Image and Video Technology, 2004, 38(1): 35-44. DOI:10.1023/B:VLSI.0000028532.53893.82 |

| [25] |

Guo CL, Szemenyei M, Hu YT, et al. Channel attention residual U-Net for retinal vessel segmentation. Proceedings of the 2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Toronto: IEEE, 2021. 1185–1189.

|

| [26] |

Shi ZJ, Wang TY, Huang Z, et al. MD-Net: A multi-scale dense network for retinal vessel segmentation. Biomedical Signal Processing and Control, 2021, 70: 102977. DOI:10.1016/j.bspc.2021.102977 |

2024, Vol. 33

2024, Vol. 33