2. 南京信息工程大学 计算机学院、网络空间安全学院, 南京 210044

2. School of Computer Science, Nanjing University of Information Science and Technology, Nanjing 210044, China

目标跟踪是计算机视觉领域热点研究问题. 它被广泛应用于体育赛事转播、视频监控[1]和无人机、无人车、机器车等领域. 近年来, 凭借着强大的表征学习能力, 深度学习发展迅速, 基于卷积神经网络(CNN)的深度跟踪器在速度和精度方面取得了很好的成绩. 其中, 基于孪生网络的跟踪模型是所有深度学习方法中最流行的跟踪器. 孪生跟踪器主要遵循检测跟踪的思想, 首先, 孪生跟踪器学习一个模板特征映射, 然后计算与搜索区域特征的相似度, 最后选择得分最高的位置作为目标的预测. 如何获得准确可靠的特征一直是跟踪技术努力的方向, SiamFC[2]、SiamRPN[3]、Siam-RPN++[4]、SiamAttn[5]、SiamCAR[6]、Ocean[7]等许多跟踪器在这方面取得很大的突破.

对于从孪生网络中获取的模板特征和搜索特征, 通常使用互相关运算来确定目标是否出现在搜索分支特征上. 互相关运算是跟踪网络中最重要的部分, 模板特征和搜索特征互相关运算输出的融合特征图对后续分类和回归目标至关重要. 在之前的文章中, 有3种经典的互相关操作: SiamFC[2]中的传统互相关、SiamRPN[3]中的Up-channel互相关和SiamRPN++[4]的深度可分离互相关(depth-wise cross-correlation). 然而, 这3种互相关方法只对模板特征和搜索特征进行一次交互操作, 使得融合特征图上的目标特征相对粗糙, 不利于跟踪器精确定位. 经过实验分析, 模板特征和搜索特征进行多次互相关运算可以逐步细化特征, 引导跟踪网络学习到更多的特征, 从而提高跟踪模型的性能. 为此, 本文设计了一个串联互相关模块, 旨在利用现有的深度可分离互相关方法, 对模板特征和搜索特征做多次的互相关操作增强融合特征图上的目标特征, 提升后续分类和回归结果的准确性, 以更少的参数实现速度和精度之间的平衡. 此外, 为了构建简单通用的跟踪模型, 本文还采用一种无锚、无候选框的目标预测方法. 融合特征图输入预测头部分, 输出3个分支: 分类分支、筛选分支、回归分支. 使用串联互相关模块和无锚框的目标预测方法, 跟踪模型能够应对多种具有挑战性的场景, 如目标消失再出现、背景昏暗等.

本文提出的框架为视觉跟踪领域提供新的思考视角, 主要贡献在于: 1)提出一种新的融合模板特征和搜索特征的方法, 细化了融合特征图上的目标特征, 提高了跟踪器的跟踪性能; 2)设计一种简单有效的目标预测方法, 该方法能够使跟踪器有效应对多种具有挑战性的场景, 目标消失再出现、背景昏暗等; 3)以ResNet-50为特征提取网络, 提出的目标跟踪方法在多个公开数据集上领先其他算法.

2 相关工作近些年, 基于孪生网络的跟踪方法不断的融合其他领域优秀的方法, 孪生网络的跟踪精度和成功率都有了很大的提升. 孪生跟踪器SiamFC[2]使用全卷积网络提取特征, 对提取到的模板图像特征和搜索区域特征进行相似性匹配, 输出响应得分图, 得分最高的位置即为目标所在. 由于SiamFC[2]在跟踪速度与跟踪精度之间的良好平衡, 为跟踪领域带来了新的方向, 成为当前最经典的孪生网络目标跟踪算法. 孪生跟踪器Siam-RPN[3]通过引入目标检测中的区域建议网络(RPN)用于跟踪任务中的目标预测, 得到更精确的目标边界框, 避免了多尺度测试带来的高计算消耗, 提高了跟踪速度. Wang等人[8]提出可同时实现视频目标跟踪和目标分割这两个任务的SiamMask算法, 在用于目标跟踪的孪生网络上增加一个掩码分支来实现目标分割, 同时优化网络. SiamMask[8]模型简单, 功能多样, 速度快, 其效果也超越了其他跟踪算法. 孪生跟踪器SiamRPN++[4]使用一个简单但是有效的空间采样方式来打破孪生网络用于跟踪不能有效利用深度网络的限制, 同时, 将传统的互相关操作用深度可分离互相关代替, 得到多通道具有不同语义特征的得分图, 使得跟踪目标更准确. 孪生跟踪器U-AST[9]解决了现有孪生网络仅依靠预测到的4条边来实现有效的回归, 无法解决复杂场景中目标边界框准确回归的问题. 孪生跟踪器GSiamMS[10]通过集成Res2Net模块和Transformer模块来应对现有孪生跟踪器很难处理目标受到大规模变化、类似物体干扰的场景, 以及孪生网络无法建立模板分支和搜索分支之间连接的问题.

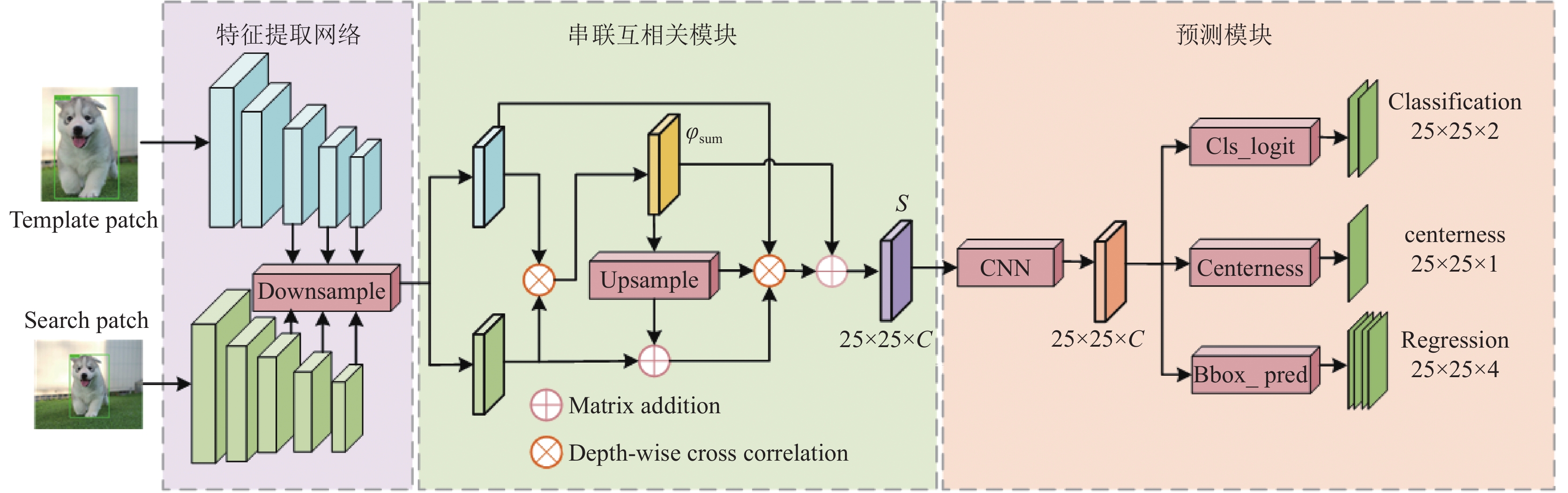

3 方法如图1所示, 论文整体框架有特征提取网络, 串联互相关模块, 预测头3个部分构成. 首先将经过剪裁的图像对输入到特征提取网络输出模板特征和搜索特征, 分别记为

论文使用ResNet-50作为特征提取网络. 将视频帧尺寸为127×127和255×255的图像对输入特征提取网络进行目标对象的特征提取, 得到不同阶段不同大小的特征图. 经过实验对比分析, 选取特征提取网络最后3个阶段的特征输入到串联互相关模块, 跟踪器的速度和准确度最好. 最后将3个阶段的细化特征利用一个Cat函数把3张特征图进行一个拼接操作, 得到一张整体特征融合图, 记为

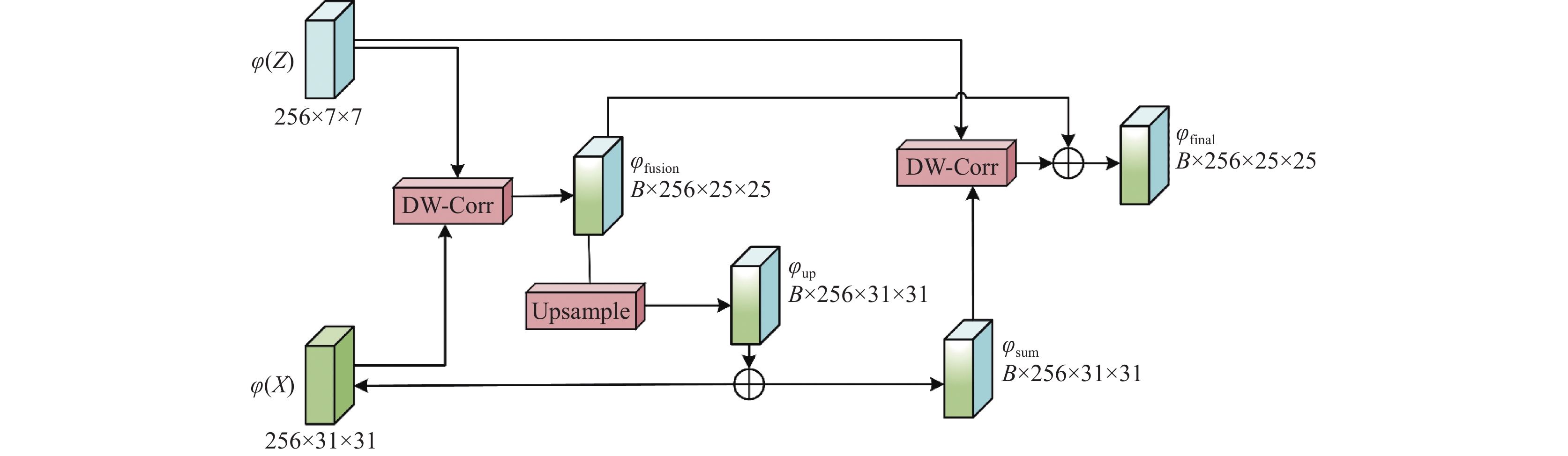

串联互相关模块的详细结构如图2所示. 以前的孪生网络互相关模块都是对模板特征和搜索特征进行一次互相关操作, 得到的是目标对象在搜索区域上的基本匹配信息, 使得融合特征图上的目标特征相对粗糙, 不利于跟踪器后续对目标精确定位. 为了解决上述问题, 对模板特征和搜索特征进行二次互相关运算, 不仅可以引导跟踪网络学习到更多明显的特征, 而且还可以提高跟踪模型的性能. 第1个互相关用于初始融合模板特征和搜索特征, 第2个互相关用于细化特征, 提高后续分类和回归任务的准确性. 串联互相关模块的输入是特征提取网络输出的模板特征

| $ {\varphi _{{\mathrm{fusion}}}} = \varphi \left( Z \right) * \varphi \left( X \right) $ | (1) |

其中,

| $ {\varphi _{{\mathrm{sum}}}} = {\lambda _{\text{1}}}{\textit{Upsample}}\left( {{\varphi _{{\mathrm{fusion}}}}} \right) + {\lambda _{\text{2}}}\varphi \left( X \right) $ | (2) |

其中, 经过反复实验

|

图 1 跟踪框架 |

|

图 2 串联互相关模块详细图 |

最后, 对

| $ {\varphi _{{\mathrm{final}}}} = \left( {\varphi \left( Z \right) * {\varphi _{{\mathrm{sum}}}}} \right) + {\varphi _{{\mathrm{fusion}}}} $ | (3) |

本文把特征提取网络后3个阶段的模板特征和搜索特征分别输入串联互相关模块得到3张融合特征图, 然后, 利用一个Cat函数把3张特征图进行一个拼接操作, 得到一张整体特征融合图

| $ S = Cat\left( {{\varphi _{{\mathrm{final}}}}, {\varphi _{{\mathrm{final}}}}, {\varphi _{{\mathrm{final}}}}} \right) $ | (4) |

其中, 3个

如图1所示, 串联模块输出的整体特征图

本文采用交叉熵损失进行分类, IOU损失进行回归预测.

| $ \left\{\begin{array}{*{20}{c}} {l = x - {x_0},\; t = y - {y_0}} \\ {r = {x_1} - x, \;b = {y_1} - y} \end{array} \right.$ | (5) |

利用回归目标, 可以计算出ground truth bounding box和这个预测的bounding box的IOU损失. 通过以下列公式计算回归损失:

| $ \begin{split} {L_{{\mathrm{reg}}}} = &\frac{1}{{\displaystyle\sum {\prod {\left( {reg\left( {i, j} \right)} \right)} } }}{\sum _{i, j}}reg\left( {i, j} \right) \\ &{L_{IOU}}\left( {{M^{{\mathrm{reg}}}}\left( {i, j:} \right), cls\left( {x, y} \right)} \right) \end{split} $ | (6) |

其中,

| $ \prod {\left( {reg\left( {i, j} \right)} \right)} = \left\{ {\begin{array}{*{20}{c}} 1, \\ 0, \end{array}} \right.\begin{array}{*{20}{l}} {{\mathrm{if}}} \; {reg_{\left( {i, j} \right)}^k > 0, \;k = 0, 1, 2, 3}&{} \\ {{\mathrm{otherwise}}}&{} \end{array} $ | (7) |

实验观察到, 远离目标中心的位置会产生低质量的预测框, 这降低了跟踪的性能. 因此在预测头部分添加了一个筛选分支, 筛选特征图上的每个点值给出相应位置的得分, 根据这些得分排除异常值筛选最优值. 筛选分支上每个点的得分

| $ C\left( {i, j} \right) = \prod {\left( {reg\left( {i, j} \right)} \right)} * \sqrt {\frac{{\min \left( {l, r} \right)}}{{\max \left( {l, r} \right)}} \times \frac{{\min \left( {t, b} \right)}}{{\max \left( {t, b} \right)}}} $ | (8) |

如果

| $ \begin{split} {L_{{\mathrm{cho}}}} = &\frac{{ - 1}}{{\displaystyle\sum {\prod {\left( {reg\left( {i, j} \right)} \right)} } }} \\ & \times {\sum _{\prod {\left( {reg\left( {i, j} \right)} \right)} = = 1}}\left(C\left( {i, j} \right) \times \log M_{w \times h \times 1}^{{\mathrm{cho}}}\left( {i, j} \right)\right. \\ & \left.+ \left( {1 - C\left( {i, j} \right)} \right) \times \log \left( {1 - M_{w \times h \times 1}^{{\mathrm{cho}}}\left( {i, j} \right)} \right) \right) \end{split} $ | (9) |

本文中的总损失函数定义如下:

| $ L = {L_{{\mathrm{cls}}}} + {\lambda _1}{L_{{\mathrm{cho}}}} + {\lambda _2}{L_{{\mathrm{reg}}}} $ | (10) |

其中,

实验配置: 本文遵循孪生网络的目标跟踪实验, 将数据集图片尺寸预处理为127×127×3 (宽, 高, 通道数)的模板图像, 255×255×3 (宽, 高, 通道数)的搜索图像. 本文硬件平台配置环境为RTX-2080 Ti GPU (11 GB memory)、Intel Core i9-9900 CPU以及内存容量为64 GB.

参数配置: 本文使用在ImageNet上预训练的权重初始化骨干网络, 并冻结前两层的参数. 本文一共训练了20个epoch, 前5个epoch的学习率为0.001–0.005, 后15个epoch的学习率从0.005指数衰减到0.000 05. 训练过程中, 本文设置批量大小为32, 随机梯度下降算法(stochastic gradient descent, SGD)的动量为0.9, 权重衰减为0.005.

4.2 实验数据集训练数据集: 为了增强网络的泛化性, 本文整个网络在ImageNet VID[11]、COCO[12]、ImageNet DET[11]和LaSOT[13]这4个数据集上进行端到端的训练. 具体地, 对于每个视频序列, 在视频的第1帧裁剪目标模板, 在后续的每帧中采样一次, 并裁剪搜索区域, 其中模板区域大小裁剪为127×127, 搜索区域大小裁剪为255×255.

测试数据集: 将本文跟踪器算法与最先进的跟踪器在OTB100[14]、UAV123[15]、GOT-10k[13]和LaSOT[16]这4个跟踪基准上进行比较. 本文的跟踪算法达到了最先进的结果, 并以每秒40帧的速度运行.

4.3 与现有算法对比分析本文实验在4个大型跟踪数据集上进行, 包括OTB100[14]、UAV123[15]、LaSOT[16]和GOT-10k[13], 将本文算法与先进的跟踪器比较和评估. 本文跟踪器获得了与排名靠前跟踪器相当的结果. 总体来看, 本文算法简单实用, 达到了精度和速度的平衡.

在OTB100数据集上对比实验: 图3为本文算法与其他主流目标跟踪模型在数据集OTB100上的跟踪成功率和精度曲线图. 主流跟踪模型包括SiamAttn[5]、SiamBAN[17]、SiamRPN++[3]、ECO[18]、SiamFC++[19]、Ocean[7]、SiamDW[20]和DaSiamRPN[21]. 由图3所知, 本文跟踪器达到了最好的性能. 与最近的SiamBAN相比, 本文跟踪器的成功率提高了1.8%, 精度提高了1.4%.

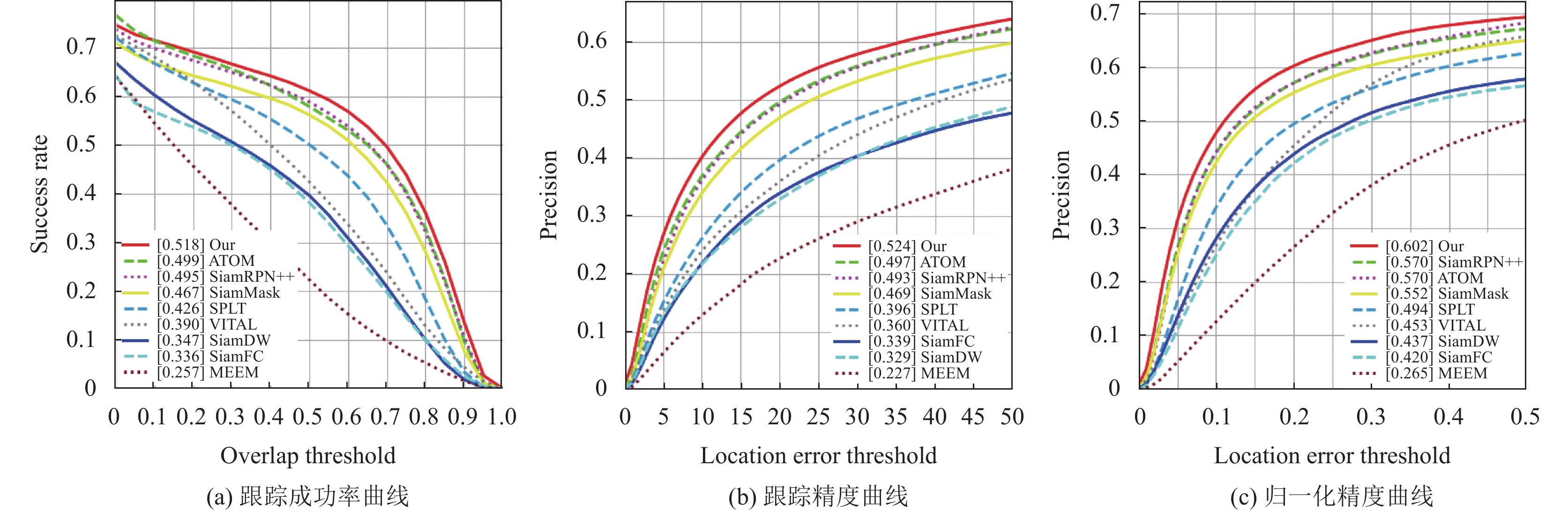

在LaSOT数据集上对比实验: 图4为本文算法与现有主流跟踪器在数据集LaSOT上比较的结果, 包括、ATOM[22]、SiamRPN++[3]、SiamMask[8]、SiamDW[20]等. ATOM的研究结果在其作者的网站上提供, 而其他的研究结果则由LaSOT的官方网站提供. 与SiamDW[20]相比, 本文跟踪器的成功率、精度和归一化精度分别提高了17.1%、19.5%和12.9%.

|

图 3 主流跟踪算法在OTB100数据集上的成功率图和精度图 |

|

图 4 主流跟踪算法在LaSOT数据集上的成功率图、精度图以及归一化精度图 |

在UAV123数据集上对比实验: 图5为本文算法与其他主流目标跟踪模型在数据集UAV123上的跟踪成功率和精度曲线图. 由图5可知本文跟踪模型在成功率和精度指标上分别达到65.5%和84.5%, 均优于其他对比主流跟踪器, 甚至比SiamAttn[5]跟踪器高出0.5%的成功率.

在GOT-10数据集对比实验: 表1给出了本文跟踪模型在GOT-10k数据集上的实验结果, 其中, 粗体代表跟踪器最好性能. 由表1可知, 本文方法在指标

|

图 5 主流跟踪算法在UAV123数据集上的成功率图和精度图 |

| 表 1 跟踪算法在GOT-10k数据集上的结果(%) |

5 消融实验

为了验证所提出的每个模块的有效性, 在数据集OTB100[14]上进行消融实验.

多阶段特征融合消融实验: 为了验证特征提取网络的各阶段特征怎么组合输入串联互相关模块能够实现最好的跟踪性能, 实验对比了res2, res3, res4不同阶段特征的组合方式的效果. 如表2所示, 其中, 粗体代表最好性能. 把骨干网络最后3层特征组合送入串联互相关模块中, 跟踪器实现了最好的跟踪性能.

| 表 2 本文跟踪器在OTB100数据集上特征组合分析 |

串联互相关模块的消融实验: 表3对串联互相关模块进行消融实验来验证其有效性, 其中, 粗体代表最好性能. 可以看出用串联互相关模块替代经典的互相关操作, 成功率和精度分别达到了71.4%和92.4%.

| 表 3 本文方法在OT100数据集上不同互相关操作结果 |

6 结论与展望

针对现有互相关方法只对模板特征和搜索特征进行一次交互操作, 使得融合特征图上的目标特征相对粗糙, 不利于跟踪器精确定位的问题. 为此, 本文设计了一个串联互相关模块, 旨在利用现有的深度互相关方法, 对模板特征和搜索特征做多次的互相关操作增强融合特征图上的目标特征, 提升后续分类和回归结果的准确性, 以更少的参数实现了速度和精度之间的平衡. 此外, 为了构建简单通用的跟踪模型, 本文还采用一种无锚、无候选框的目标预测方法, 引导跟踪网络学习到更多明显的特征, 从而提高跟踪模型的性能.

| [1] |

Xing JL, Ai HZ, Lao SH. Multiple human tracking based on multi-view upper-body detection and discriminative learning. Proceedings of the 20th International Conference on Pattern Recognition. Istanbul: IEEE, 2010. 1698–1701.

|

| [2] |

Bertinetto L, Valmadre J, Henriques JF, et al. Fully-convolutional Siamese networks for object tracking. Proceedings of the 2016 European Conference on Computer Vision. Amsterdam: Springer, 2016. 850–865.

|

| [3] |

Li B, Yan JJ, Wu W, et al. High performance visual tracking with Siamese region proposal network. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 8971–8980.

|

| [4] |

Li B, Wu W, Wang Q, et al. SiamRPN++: Evolution of Siamese visual tracking with very deep networks. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 4277–4286.

|

| [5] |

Yu YC, Xiong YL, Huang WL, et al. Deformable Siamese attention networks for visual object tracking. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 6727–6736.

|

| [6] |

Guo DY, Wang J, Cui Y, et al. SiamCAR: Siamese fully convolutional classification and regression for visual tracking. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 6268–6276.

|

| [7] |

Zhang ZP, Peng HW, Fu JL, et al. Ocean: Object-aware anchor-free tracking. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 771–787.

|

| [8] |

Wang Q, Zhang L, Bertinetto L, et al. Fast online object tracking and segmentation: A unifying approach. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 1328–1338.

|

| [9] |

Zhang DW, Fu YW, Zheng ZL. UAST: Uncertainty-aware Siamese tracking. Proceedings of the 39th International Conference on Machine Learning. Baltimore: PMLR, 2022. 26161–26175.

|

| [10] |

Liang W, Ding DR, Wei GL. Siamese visual tracking combining granular level multi-scale features and global information. Knowledge-based Systems, 2022, 252: 109435. DOI:10.1016/j.knosys.2022.109435 |

| [11] |

Russakovsky O, Deng J, Su H, et al. ImageNet large scale visual recognition challenge. International Journal of Computer Vision, 2015, 115(3): 211-252. DOI:10.1007/s11263-015-0816-y |

| [12] |

Lin TY, Maire M, Belongie S, et al. Microsoft COCO: Common objects in context. Proceedings of the 13th European Conference on Computer Vision. Zurich: Springer, 2014. 740–755.

|

| [13] |

Huang LH, Zhao X, Huang KQ. GOT-10k: A large high-diversity benchmark for generic object tracking in the wild. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(5): 1562-1577. DOI:10.1109/TPAMI.2019.2957464 |

| [14] |

Wu Y, Lim J, Yang MH. Online object tracking: A benchmark. Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Portland: IEEE, 2013. 2411–2418.

|

| [15] |

Mueller M, Smith N, Ghanem B. A benchmark and simulator for UAV tracking. Proceedings of the 14th European Conference on Computer Vision. Amsterdam: Springer, 2016. 445–461.

|

| [16] |

Fan H, Lin LT, Yang F, et al. LaSOT: A high-quality benchmark for large-scale single object tracking. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 5369–5378.

|

| [17] |

Chen ZD, Zhong BN, Li GR, et al. Siamese box adaptive network for visual tracking. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 6667–6676.

|

| [18] |

Danelljan M, Bhat G, Khan FS, et al. ECO: Efficient convolution operators for tracking. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 6931–6939.

|

| [19] |

Xu YD, Wang ZY, Li ZX, et al. SiamFC++: Towards robust and accurate visual tracking with target estimation guidelines. Proceedings of the 34th AAAI Conference on Artificial Intelligence. New York: AAAI, 2020. 12549–12556.

|

| [20] |

Zhang ZP, Peng HW. Deeper and wider Siamese networks for real-time visual tracking. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 4586–4595.

|

| [21] |

Zhu Z, Wang Q, Li B, et al. Distractor-aware siamese networks for visual object tracking. Proceedings of the 15th European Conference on Computer Vision (ECCV). Munich: Springer, 2018. 103–119.

|

| [22] |

Danelljan M, Bhat G, Khan FS, et al. ATOM: Accurate tracking by overlap maximization. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 4655–4664.

|

| [23] |

Lukežič A, Matas J, Kristan M. D3S—A discriminative single shot segmentation tracker. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 7131–7140.

|

| [24] |

Zheng LY, Tang M, Chen YY, et al. Learning feature embeddings for discriminant model based tracking. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 759–775.

|

2024, Vol. 33

2024, Vol. 33