2. 北京信息科技大学 计算机学院, 北京 100101;

3. 中国科学院大学, 北京 100049

2. Computer School, Beijing Information Science and Technology University, Beijing 100101, China;

3. University of Chinese Academy of Sciences, Beijing 100049, China

推荐系统致力于感知用户真实兴趣和解决信息爆炸问题, 近年来在流媒体内容分享[1,2], 电子商务[3]等在线服务中得到广泛应用, 具有重要的潜在商业价值. 在推荐问题中, 用户的兴趣倾向包含在与平台交互的历史行为记录中, 不同的行为反馈代表不同的推荐价值, 随着记录时间累积增长, 系统可以从大量的交互序列中挖掘用户的兴趣爱好, 从而实现个性化的推荐. 强化学习提供了一种建模上述序列推荐过程的工具, 其思路是将不同的用户反馈信号映射为不同的激励价值, 并通过最大化累积价值激励函数的优化过程, 同时挖掘用户的序列动态兴趣和长时平稳倾向.

尽管, 基于强化学习的推荐系统最近取得成功, 这得益于有效的价值激励函数设计, 但是启发式设计的价值激励函数往往面临区分度低的难题[4–6]. 价值激励函数区分度描述了不同用户行为反馈信号的量化价值之间的差异性[4–6]. 例如, 在电子商务场景中, 常见的用户行为包括点击反馈和购买反馈, 后者的价值直觉上远高于前者(如可设置模型的点击价值为0.2, 购买价值为1.0), 则区分度可以定义为“购买-点击”价值比[4–6], 价值比越大反映不同反馈信号之间的区分性越高. 作为强化学习优化过程的指导信号, 价值激励函数的区分度直接影响推荐策略空间的区分度, 即最优策略和策略空间其他备选策略簇的差异性. 这意味着, 价值激励函数的区分度决定了模型学习最优推荐策略的能力. 此外, 不合理的价值激励函数及区分度设计会导致模型学习到错误的用户反馈信号. 固定价值比形式可能导致不同价值的反馈信号互相替换, 如用5次被连续点击的商品替代1个被真实购买的商品. 一些研究发现, 仅追求高价值比的区分度设计会降低“动作-状态”价值函数时序差分学习的稳定性.

目前, 基于强化学习的推荐系统主要分为两个研究分支: (1) 衰减因子加权, 如DEAR[7], DEER[3], SQN[4], VPQ[6], SDAC[8], KERL[9], 其思路是调整超参数衰减因子强调高价值反馈的及时性, 降低可能等价替换的连续低价值推荐的累积激励函数, 间接惩罚低区分度策略. 这种方法需要依赖专家知识对特定领域任务进行大量调试才能得到性能满意的参数设置. (2) 逆激励函数学习, 如IRecGAN[10]、InvRec[11]、PGPR[12], 其思路是设计单独的优化目标学习激励函数, 其区分度被隐式地包含到激励函数的归纳偏置中[13]. 逆激励函数学习方法建模的归纳偏置[14]无法通过假设检验验证. 因此, 上述方法对价值激励函数的设计都缺乏充分的理论基础, 并导致模型学到的推荐策略总是次优的.

为了更合理地设计具有高区分度的价值奖励函数, 本文将因果理论引入到基于强化学习的推荐系统中. 一方面, 从因果推理的角度看, 区分度本质上是(反事实)假想模型推荐系统与(事实)真实系统之间的用户行为差异. 也就是说, 区分度越高时, 价值函数指导下训练的推荐策略网络产生的推荐结果应趋近于事实系统并尽可能远离反事实系统. 另一方面, 因果推断有助于改善序列推荐模型表现. 最新的序列推荐研究工作[15–17]也尝试用时序因果模型来描述基于循环神经网络RNN序列推荐模型的马尔可夫决策过程. 时序因果模型的可鉴别性仍然有待探索和验证, 并没有得到充分的理论证明, 而静态的结构因果模型可鉴别性的相关理论结论也不能被直接运用. 综上, 本文将区分度可视为一个反事实因果量, 采用结果因果模型来描述强化学习推荐系统(在实际应用中反事实因果模型一般未知[18]), 并用反事实推理来更好的学习推荐策略.

本文提供了一种新的基于反事实推理的序列推荐方法(counterfactual adversarial learning for recom-mendation, CAL4Rec). 首先, 本文引入结构因果理论模型来分析序列推荐过程, 分析结果显示用户兴趣倾向和区分度共同决定了价值激励, 因此可通过因果干预操作, 避免价值函数的区分度过低问题. 其次, 所提出方法设计了一种新颖的反事实增强的高区分度激励函数, 以通过更合理的区分度设计让激励机制更好地指导模型学习. 此方法根据序列推荐因果模型和反事实推理操作重新定义了区分度, 即反事实区分度, 并将用户内在兴趣倾向显式构建为因果结构方程, 再通过Gumbel-Max神经网络学习该方程来获得因果关系可鉴别的价值激励函数. 不同于之前启发式的和依赖专家知识的方法, 这种新设计具有更强的理论性, 因为模型所学习的用户兴趣归纳偏置是可检验的. 第三, CAL4Rec模型使用反事实生成对抗训练框架, 来根据上述高区分度激励函数训练强化学习序列推荐模型. 具体的, 生成器网络用于模拟假想推荐系统和生成反事实价值, 鉴别器网络利用高区分度激励函数来区分事实观测数据分布和反事实数据分布. 通过鉴别分数来引导生成器网络逼近用户真实交互行为及兴趣. 最后, 多个基准数据集上的总体性能对比和消融实验分析证明了CAL4Rec设计的有效性.

1 研究基础及术语本节针对CAL4Rec的工作基础进行阐述: 首先, 介绍了因果推理和强化学习相关的符号和定义; 然后, 详细介绍了序列推荐任务的研究工作进展.

1.1 术语符号: 大写字母

强化学习将序列推荐问题定义为一个马尔可夫决策过程

●

●

●

●

●

●

●

结构因果模型(structural causal model, SCM)是一组量化因果效应作用过程的方程[19], 定义为一个四元组

反事实联合概率分布(counterfactual distribution)描述了给定SCM中多种干预组合可能得到的潜在结果: 给定待学习(未知参数为

| ∫Dμ1[Y1[x1](μ)=y1,⋯,YK[xK](μ)=yK]dP(μ) | (1) |

其中,

| {fVj:Vj∈V∖Xk}∪{fX←x:X∈Xk} | (2) |

序列推荐作为推荐系统的重要研究分支受到研究人员的广泛关注[20,21], 其研究思路经历了深度学习时代前的协同滤波, 深度序列推荐模型和强化学习序列推荐3个阶段, 本节阐述不同阶段的研究工作基础.

1.2.1 序列推荐算法传统推荐算法假设相似的用户具有相似的喜好倾向提出了基于矩阵分解的协同滤波算法[22–24]. BPR[22]提出了一种贝叶斯个性化排序推荐方法(成对型排序损失函数), 使用一个有偏估计的分解矩阵作为推荐系统. 针对有偏估计矩阵分解的问题, NCF[24]首次提出使用深度神经网络估计“用户-商品”协同矩阵. FPMC[23]则针对矩阵分解的方法无法建模“用户-商品”交互过程的问题提出一种基于马尔可夫链的协同过滤模型, 将交互序列近似为一阶马尔可夫链, 并在序列化增强的成对型排序损失上优化. 上述方法无法建模高阶用户-商品交互过程.

传统推荐算法的缺点在于无法建模高阶用户-商品交互过程. 基于深度学习的推荐模型将“用户-商品”交互过程建模为时序序列, 模型的潜状态向量通过模型学习可以挖掘用户的高阶动态兴趣倾向. GRURec[25]应用序列化神经网络预测下一时刻用户的兴趣倾向. 为了解决循环神经网络的梯度消散问题和计算效率问题, Caser[26]和NextIt[27]使用卷积神经网络作为推荐骨干网络. SASRec[28]受到机器翻译等序列化生成任务的启发, 将Trasformer[29]结构作为推荐骨干网络. 由于序列推荐系统中存在多种用户反馈信号, 不同类型的反馈信号对系统具有不同的价值, 基于深度学习的推荐模型的局限是没有考虑不同反馈信号的价值.

1.2.2 强化学习序列推荐算法基于强化学习的序列推荐将用户交互序列建模为马尔可夫决策过程, 并通过最大化不同反馈信号的价值累积奖励函数来学习用户的长时兴趣, 弥补传统序列推荐方法受到梯度消散影响的不足. 其总体思路是将交互序列按照交互时刻的顺序划分为一系列连续的用户状态(state)转移, 该转移过程受到推荐动作(action)影响, 得到正反馈的推荐动作加入用户状态序列并通过编码映射学习用户状态向量, 并通过可调节的衰减因子最大化完整序列轨迹的累计价值奖励得到参数化的推荐策略

| maxπθEτ∼πθ[|τ|∑t=0γtr(st,at)] | (3) |

其中,

为了解决强化学习序列推荐算法存在的激励函数区分性不足的问题, 本文提出一种基于反事实生成对抗学习的序列推荐算法, 其核心思路是利用均匀分布模拟低区分度的推荐策略, 并通过生成对抗学习使得模型预测的反馈价值与事实观测值分布相近.

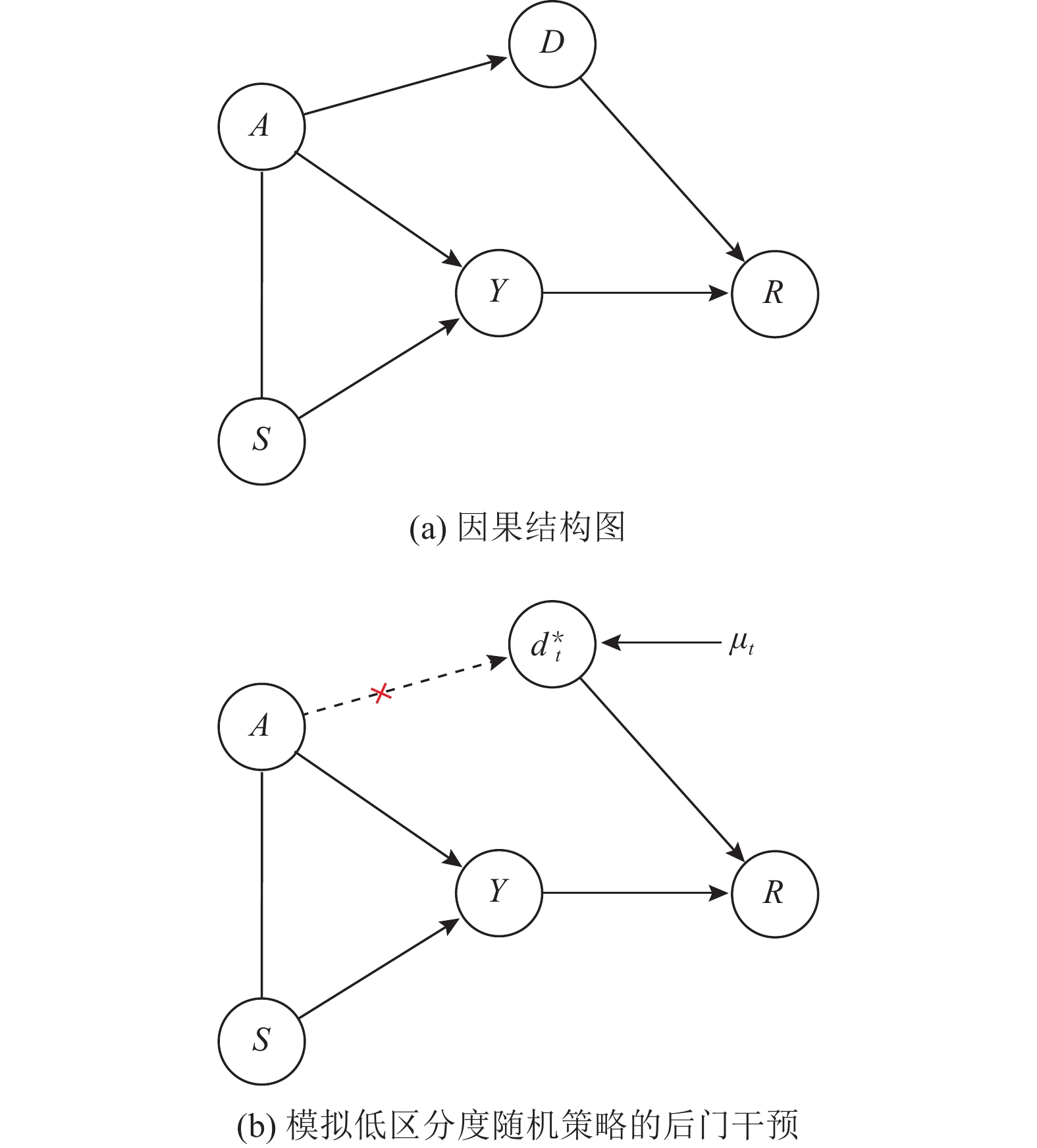

2 反事实生成对抗序列推荐模型CAL4Rec将结构因果图语言工具引入到序列推荐任务以提供可假设检验的和有理论依据保证的价值区分度模型. 本节首先介绍了序列推荐任务的定义, 在此基础上详述了CAL4Rec所提出的因果图模型和可学习的神经结构方程, 第2.4节阐述了用于学习图1所示结构因果模型的生成对抗算法, 最后讨论了CAL4Rec激励函数与已有工作的联系与区别.

|

图 1 CAL4Rec序列推荐的因果结构图 |

2.1 问题定义

序列推荐问题可以定义为给定用户

图1为CAL4Rec所提出的序列推荐因果结构与后门干预[31]. 图1(a)的因果图抽象了序列推荐过程各变量制约关系, 推荐系统根据用户当前的浏览状态

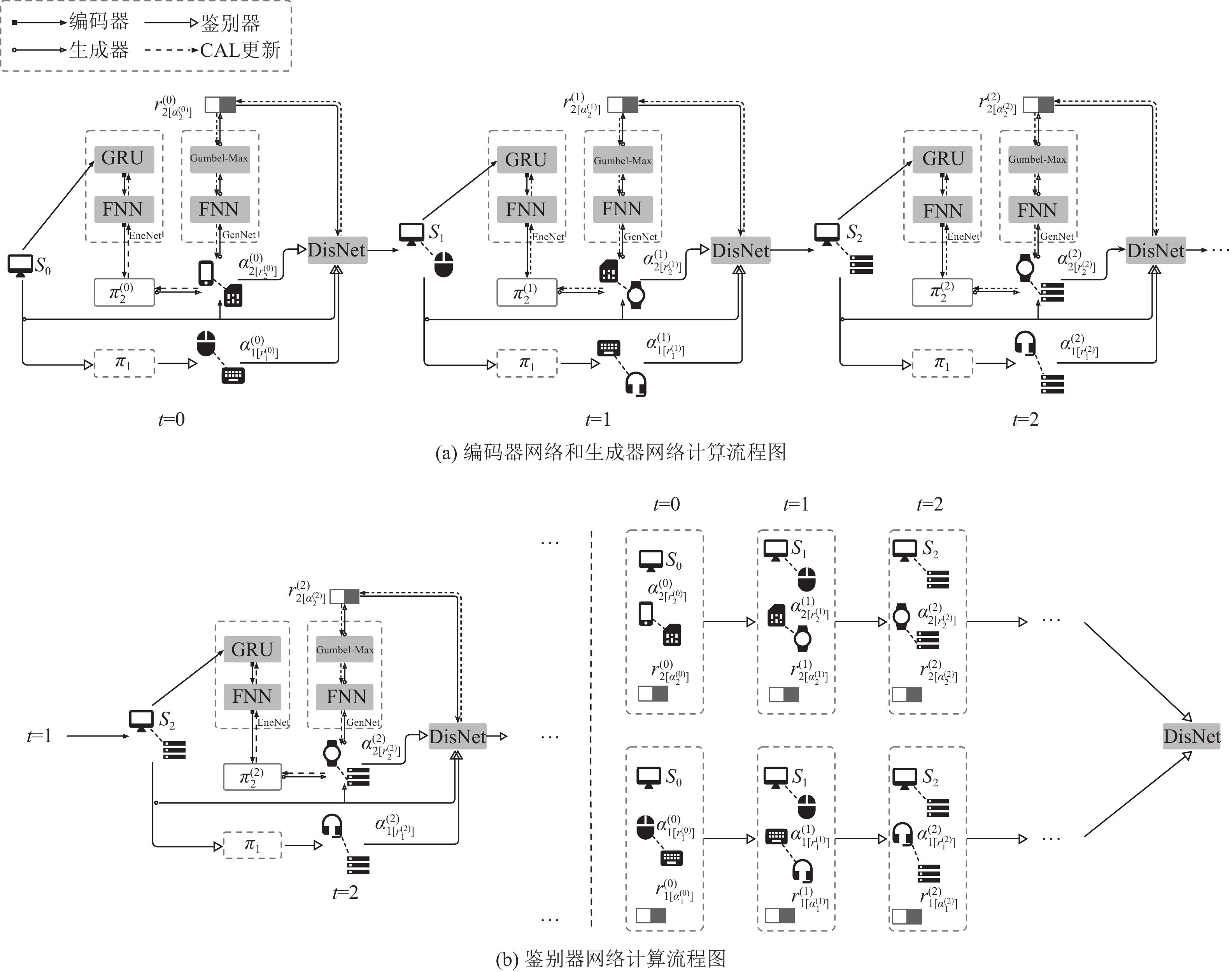

图1所提出的因果图定性地描述了序列推荐问题的结构因果模型SCM, 由于结构因果方程一般未知[18], CAL4Rec采用了时序单向的神经网络结构(如图2所示), 本节详细阐述该模型结构. 其中,

|

图 2 CAL4Rec总体架构 |

商品/用户的表征编码: 给定用户当前的浏览历史和推荐记录

| s(t)=E(s(t−1),e(t−1);θE) | (4) |

其中, 初始状态

推荐策略网络(因果图

| π(a∣s(t))=exp(Was(t)+ba)N∑jexp(Wjs(t)+bj) | (5) |

其中,

用户内倾向学习(因果图

| Y=fy(Wy[s(t);a(t)]+by) | (6) |

其中,

反事实增强的高区分度激励函数(因果图

| Dr=logpr(y∣s,a)−logμ | (7) |

其中,

| r(t)2[a]=argmaxr{Dr}=argmax{logpr(y∣s(t),a(t))−log(−log(μ(t)))} | (8) |

其中, 由于推荐问题搜索空间庞大(

为了学习第2.3节提出的模型结构, CAL4Rec采用生成对抗学习(算法1)编码器和生成器(图2(a)), 及鉴别器网络结构(图2(b)), 本节详细阐述该算法.

反事实生成对抗学习: 为了使价值激励函数(式(7))保持因果可鉴别的区分度的同时能反映用户真实倾向, CAL4Rec使用鉴别器网络

| L(t)D=Er(t)∼p(R1[a1])[logD(r(t)1[a1]∣s(t),a(t))]+Eμ(t)∼P(U)[log(1−D(G(μ(t)∣s(t),a(t))))] | (9) |

而生成器的优化目标为:

| L(t)G=Eμ(t)∼P(U)[log(1−D(G(μ(t)∣s(t),a(t))))] | (10) |

由式(9)和式(10)可知, 生成器试图使得推荐系统预测的用户反馈

自监督正则项: 由于鉴别器网络没有关于观测数据概率分布的先验知识, 因此其优化过程需要完全依赖生成器网络信息, 导致生成对抗学习过程难以挖掘用户兴趣倾向的序列动态性. 为了挖掘用户的序列动态特性以提升状态编码, CAL4Rec在编码器学习中引入自监督交叉熵目标函数作为正则目标:

| L(t)ssl=−∑a∈|A|1[A(t)1[r1]=a]log(π(a∣s(t))) |

其中, 推荐结果

算法1. 反事实生成对抗CAL学习

输入: 观测数据

输出: 鉴别器, 生成器和编码器的网络参数

1) 初始化参数

2) 令

3) 令

4) 批量采样

5) 批量采样观测数据

6) 计算梯度

7) 结束内循环

8) 批量采样

9) 计算梯度

10) 计算梯度

11) 结束外循环

值得指出的是, 算法1的生成对抗训练过程采用了经典的条件生成对抗网络(CGAN)的优化过程. 其相同之处在于, 当“生成-鉴别”过程趋于动态平衡时, 理论上生成器反事实预测分布与事实观测数据分布同簇(

图1提供了一种新的分类相关工作激励函数设计的因果视角. 深度序列推荐模型[25,26,28]和强化学习序列推荐模型[6,9,12,36,37]工作, 其编码器采用循环神经网络, 卷积神经网络和Transformer[29]等自回归深度模型, 即

| fr={0.2, if y=点击 1, if y=购买 | (11) |

上述方法或忽略了区分度(深度序列推荐模型)或区分度不可鉴别(强化学习序列推荐模型, 由式(11)可知存在5个点击反馈等价于1个购买的可能). 而式(7)保证CAL4Rec的反馈激励函数

为了验证CAL4Rec的有效性, 两个从真实电子商务场景采集的基准序列推荐数据集被用于实验分析. 为了证明提出方法有效地增加了激励函数的区分度, CAL4Rec首先与具有代表性的强化学习推荐系统SOTA基线方法比较了总体Top@k推荐性能. 为了验证关键设计的有效性, 在Retailrocket数据集上进行的消融实验进一步证明了Gumbel-Max算子和生成对抗学习(算法1)对推荐性能提升的帮助.

实验设置: Yoochoose和Retailrocket是两个序列推荐的标准数据集, 分别包含两类交互正反馈(点击和购买), 多类反馈的处理思路与两类反馈类似. 为了对比实验的公平一致性, 这里统一按照文献[4]的预处理过程, 删除了Yoochoose和Retailrocket中互动次数少于3次的交互序列, 得到的数据集统计结果如表1所示. 实验用于衡量推荐性能的两个指标是: 表征Top@k排序性能(

| HR=#点击命中数#点击总数 | (12) |

| 表 1 数据统计 |

对比基线: 针对3种具有代表性的SOTA强化学习序列推荐算法被作为比较基线: 基于“状态-动作”价值函数的SQN[4], VPQ[6], 和基于“动作-评论”架构的SAC[4], 3种方法联合优化时序差分学习[38] 和交叉熵自监督学习[28]. 为了证明CAL4Rec方法适用于不同编码器骨干网络, 实验考虑3种典型骨干网络结构: 循环神经网络GRU[25], 卷积神经网络NextIt[27]和Transformer[29]结构的SASRec[28].

实现细节: 两个数据集采用的输入序列长度均为10个当前时刻的近期交互, 编码向量均采用64维, 干预变量

表2为CAL4Rec在Retailrocket和Yoochoose数据集上的性能比较. 进一步分析可以发现: (1)对比不同骨干网络的实现结构, CAL4Rec均有一致的提升, 证明了所提出方法适用于多种序列推荐骨干网络, 该提升性来自于CAL4Rec利用了用户反馈的不同激励价值作为生成对抗学习过程的信号, SQN[4], SAC[4]和VPQ[6] 同样利用到了反馈信号作为价值激励函数. (2)对比同一个骨干网络的实现结构, CAL4Rec较SQN, SAC和VPQ总体性能平均提升了0.082 8, 证明了CAL4Rec的反馈奖励函数具备更大的区分度, 直观定性的分析, 这是因为生成对抗学习驱使编码器网络和生成器网络在均匀随机分布模拟低区分度推荐策略的干扰下, 拟合真实观测数据; 从因果角度定量的分析, 式(6)的鉴别性保证了用户反馈价值的区分度, 反馈价值的区分度进一步通过模型生成对抗训练过程保证了推荐策略式(4)的区分度.

| 表 2 整体性能比较 |

综上所述, 表2的实验结果证明CAL4Rec适用于多种编码器骨干网络并取得一致的区分度提升.

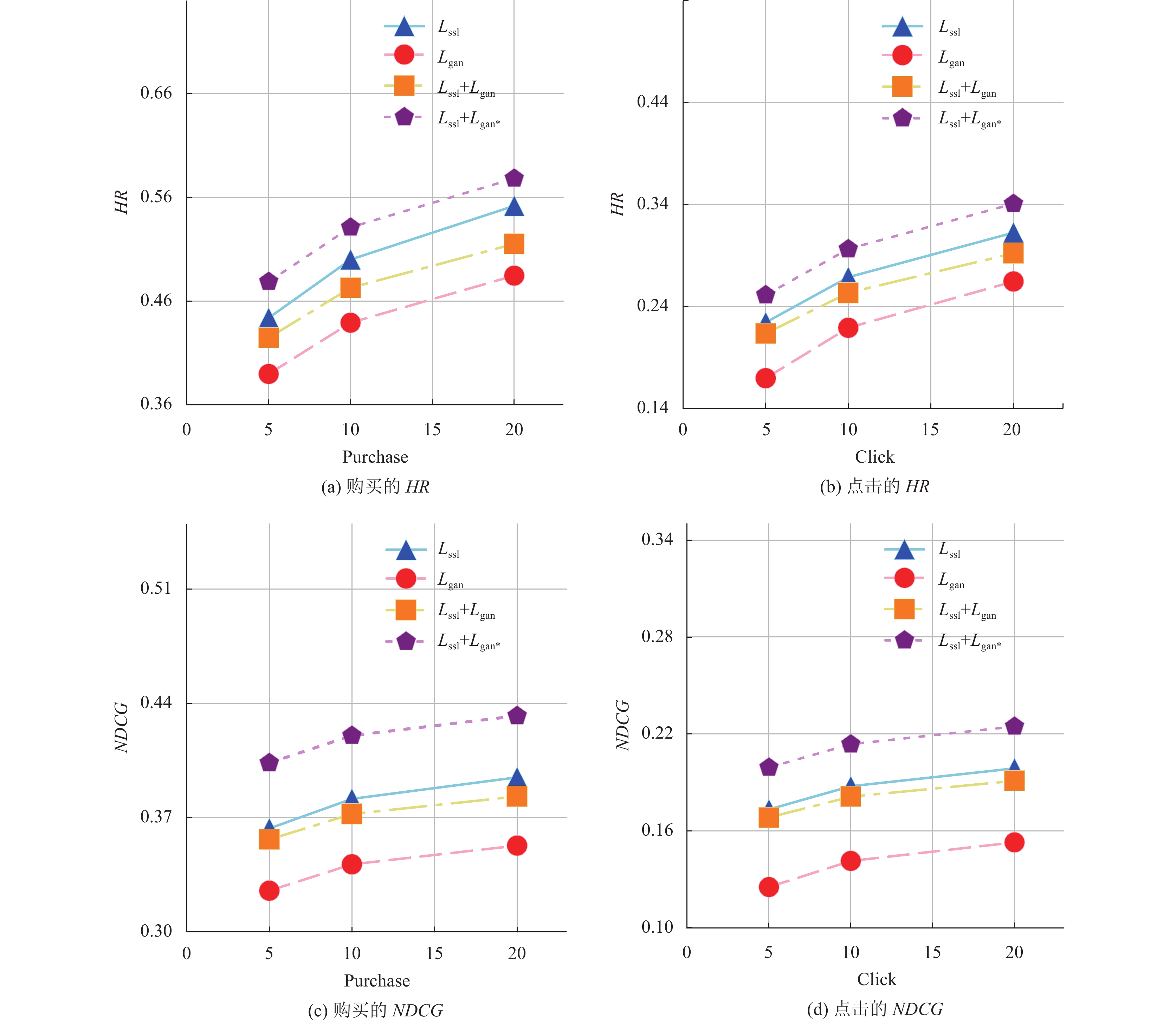

3.2 消融实验分析如图3所示, Retailrocket数据集上的消融实验分析进一步研究了关键设计模块Gumbel-Max模块(式(7)所示)和生成对抗联合优化学习目标(算法1)对CAL4Rec性能提升的作用, 实验中采用GRU作为编码器骨干网络, 不同的骨干网络均得到相似的变化趋势. 其中,

图3(a)–(d)的实验结果在两类反馈和两类评价指标上均得到了一致性的曲线趋势. 首先, 仅采用生成对抗学习过程(虚线

针对强化学习序列推荐面临的价值激励函数区分度不足的问题, 提出了一种反事实区分度增强的生成对抗序列推荐方法CAL4Rec. 它率先采用反事实推理定义区分度和价值激励函数, 其优点在于因果推理理论保证了该定义的鉴别性, 即Gumbel-Max的归纳偏置可假设检验. CAL4Rec采用一种自监督规范的生成对抗学习过程学习结构因果方程. 在一系列基准数据集上进行的广泛实验证明所提方法的有效性. CAL4Rec提供了一种利用因果图建模序列推荐过程并利用反事实鉴别性检验模型归纳偏置的思路, 为反事实缓解冷启动等关键问题提供了探索思路.

|

图 3 Retailrocket上Top@k消融实验结果 |

| [1] |

Hansen C, Hansen C, Maystre L, et al. Contextual and sequential user embeddings for large-scale music recommendation. Proceedings of the 14th ACM Conference on Recommender Systems. ACM, 2020. 53–62.

|

| [2] |

Covington P, Adams J, Sargin E. Deep neural networks for youtube recommendations. Proceedings of the 10th ACM Conference on Recommender Systems. Boston: ACM, 2016. 191–198.

|

| [3] |

Zhao XY, Zhang L, Ding ZY, et al. Recommendations with negative feedback via pairwise deep reinforcement learning. Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. London: ACM, 2018. 1040–1048.

|

| [4] |

Xin X, Karatzoglou A, Arapakis I, et al. Self-supervised reinforcement learning for recommender systems. Proceedings of the 43rd International ACM SIGIR Conference on Research and Development in Information Retrieval. ACM, 2020. 931–940.

|

| [5] |

Chen MM, Beutel A, Covington P, et al. Top-k off-policy correction for a REINFORCE recommender system. Proceedings of the 12th ACM International Conference on Web Search and Data Mining. Melbourne: ACM, 2019. 456–464.

|

| [6] |

Gao CQ, Xu K, Zhou KQ, et al. Value penalized Q-learning for recommender systems. Proceedings of the 45th International ACM SIGIR Conference on Research and Development in Information Retrieval. Madrid: ACM, 2022. 2008–2012.

|

| [7] |

Zhao XY, Gu CS, Zhang HSL, et al. DEAR: Deep reinforcement learning for online advertising impression in recommender systems. Proceedings of the 35th AAAI Conference on Artificial Intelligence. AAAI, 2021. 750–758.

|

| [8] |

Xiao T, Wang DL. A general offline reinforcement learning framework for interactive recommendation. Proceedings of the 35th AAAI Conference on Artificial Intelligence. AAAI, 2021. 4512–4520.

|

| [9] |

Wang PF, Fan Y, Xia L, et al. KERL: A knowledge-guided reinforcement learning model for sequential recommendation. Proceedings of the 43rd International ACM SIGIR Conference on Research and Development in Information Retrieval. ACM, 2020. 209–218.

|

| [10] |

Bai XY, Guan J, Wang HN. A model-based reinforcement learning with adversarial training for online recommendation. Proceedings of the 33rd International Conference on Neural Information Processing Systems. Vancouver: Curran Associates Inc., 2019. 963.

|

| [11] |

Chen XC, Yao LN, Sun AX, et al. Generative inverse deep reinforcement learning for online recommendation. Proceedings of the 30th ACM International Conference on Information & Knowledge Management. ACM, 2021. 201–210.

|

| [12] |

Xian YK, Fu ZH, Muthukrishnan S, et al. Reinforcement knowledge graph reasoning for explainable recommendation. Proceedings of the 42nd International ACM SIGIR Conference on Research and Development in Information Retrieval. Paris: ACM, 2019. 285–294.

|

| [13] |

Battaglia PW, Hamrick JB, Bapst V, et al. Relational inductive biases, deep learning, and graph networks. arXiv:1806.01261, 2018.

|

| [14] |

Pearl J. Theoretical impediments to machine learning with seven sparks from the causal revolution. Proceedings of the 11th ACM International Conference on Web Search and Data Mining. Marina Del Rey: ACM, 2018. 3.

|

| [15] |

Tsirtsis S, De A, Gomez-Rodriguez M. Counterfactual explanations in sequential decision making under uncertainty. Proceedings of the 35th Conference on Neural Information Processing Systems. NeurIPS, 2021. 30127–30139.

|

| [16] |

Bongers S, Forré P, Peters J, et al. Foundations of structural causal models with cycles and latent variables. The Annals of Statistics, 2021, 49(5): 2885-2915. |

| [17] |

Forré P, Mooij JM. Markov properties for graphical models with cycles and latent variables. arXiv:1710.08775, 2017.

|

| [18] |

Bareinboim E, Correa JD, Ibeling D, et al. On Pearl’s hierarchy and the foundations of causal inference. In: Geffner H, Dechter R, Halpern JY, eds. Probabilistic and Causal Inference: The Works of Judea Pearl. New York: ACM, 2022. 507–556.

|

| [19] |

Peters J, Janzing D, Schölkopf B. Elements of Causal Inference: Foundations and Learning Algorithms. Cambridge: The MIT Press, 2017.

|

| [20] |

Zhang S, Yao LN, Sun AX, et al. Deep learning based recommender system: A survey and new perspectives. ACM Computing Surveys, 2019, 52(1): 5. |

| [21] |

Fang H, Guo GB, Zhang DN, et al. Deep learning-based sequential recommender systems: Concepts, algorithms, and evaluations. Proceedings of the 19th International Conference on Web Engineering. Daejeon: Springer, 2019. 574–577.

|

| [22] |

Rendle S, Freudenthaler C, Gantner Z, et al. BPR: Bayesian personalized ranking from implicit feedback. Proceedings of the 25th Conference on Uncertainty in Artificial Intelligence. Montreal: AUAI Press, 2009. 452–461.

|

| [23] |

Rendle S, Freudenthaler C, Schmidt-Thieme L. Factorizing personalized Markov chains for next-basket recommendation. Proceedings of the 19th International Conference on World Wide Web. Raleigh North: ACM, 2010. 811–820.

|

| [24] |

He XN, Liao LZ, Zhang HW, et al. Neural collaborative filtering. Proceedings of the 26th International Conference on World Wide Web. Perth: International World Wide Web Conferences Steering Committee, 2017. 173–182.

|

| [25] |

Hidasi B, Karatzoglou A, Baltrunas L, et al. Session-based recommendations with recurrent neural networks. Proceedings of the 4th International Conference on Learning Representations. San Juan: ICLR, 2016.

|

| [26] |

Tang JX, Wang K. Personalized top-n sequential recommendation via convolutional sequence embedding. Proceedings of the 11th ACM International Conference on Web Search and Data Mining. Marina Del Rey: ACM, 2018. 565–573.

|

| [27] |

Yuan FJ, Karatzoglou A, Arapakis I, et al. A simple convolutional generative network for next item recommendation. Proceedings of the 12th ACM International Conference on Web Search and Data Mining. Melbourne: ACM, 2019. 582–590.

|

| [28] |

Kang WC, McAuley J. Self-attentive sequential recommendation. Proceedings of the 2018 IEEE International Conference on Data Mining. Singapore: IEEE, 2018. 197–206.

|

| [29] |

Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need. Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach: Curran Associates Inc., 2017. 6000–6010.

|

| [30] |

Mnih V, Kavukcuoglu K, Silver D, et al. Human-level control through deep reinforcement learning. Nature, 2015, 518(7540): 529-533. DOI:10.1038/nature14236 |

| [31] |

Pearl J. Causality. Cambridge: Cambridge University Press, 2009.

|

| [32] |

Sun F, Liu J, Wu J, et al. BERT4Rec: Sequential recommendation with bidirectional encoder representations from Transformer. Proceedings of the 28th ACM International Conference on Information and Knowledge Management. Beijing: ACM, 2019. 1441–1450.

|

| [33] |

Kumar A, Hong J, Singh A, et al. When should we prefer offline reinforcement learning over behavioral cloning? arXiv:2204.05618, 2022.

|

| [34] |

Meng ZQ, Liang SS, Fang JY, et al. Semi-supervisedly co-embedding attributed networks. Proceedings of the 33rd Conference on Neural Information Processing Systems. Vancouver: NeurIPS, 2019. 32.

|

| [35] |

Goodfellow I, Pouget-Abadie J, Mirza M, et al. Generative adversarial networks. Communications of the ACM, 2020, 63(11): 139-144. DOI:10.1145/3422622 |

| [36] |

Zha DC, Lai KH, Zhou KX, et al. Simplifying deep reinforcement learning via self-supervision. arXiv:2106.05526, 2021.

|

| [37] |

Zhou SJ, Dai XY, Chen HK, et al. Interactive recommender system via knowledge graph-enhanced reinforcement learning. Proceedings of the 43rd International ACM SIGIR Conference on Research and Development in Information Retrieval. ACM, 2020. 179–188.

|

| [38] |

Sutton RS, Barto AG. Reinforcement Learning: An Introduction. 2nd ed., Cambridge: MIT Press, 2018.

|

2024, Vol. 33

2024, Vol. 33