随着近年来互联网的快速发展, 互联网产生的文本数据越来越多, 文本信息过载问题日益严重, 导致用户需要花费大量时间去获取自己想要的信息. 如何从大量数据中提取出有效的关键信息成为近年来的一个研究热点. 文本摘要技术旨在将大文档的信息压缩成包含关键信息的文档, 从而帮助用户更快、更容易地消化文档中的核心信息. 然而, 不同的用户对于同一篇文章的摘要有不同喜好, 例如主题、摘要长度和具体性等. 因此, 生成个性化的摘要以满足不同用户的偏好也是摘要模型应该具备的能力.

按照输出摘要类型可以将摘要分为抽取式摘要和生成式摘要. 抽取式摘要从最初的文本中抽取关键句和关键词组成摘要, 这种方法生成的摘要内容全部来源于原文. 该方法天生具有语法错误率低的效果. 生成式可以自由生成摘要并能够生成新颖的单词和句子. 与抽取式摘要相比, 生成式摘要更加的灵活多变, 更可能产生流畅和连贯的摘要.

伴随AI的快速发展, 神经网络模型在各个领域都取得了显著的成就. 在自然语言处理领域, Seq2Seq模型结合一些其他网络或注意力机制, 在该领域表现出色. 这种模型已经在机器翻译、图像解释等领域取得了巨大的成功, 且在文本摘要领域也有不错的效果.

然而, 传统Seq2Seq模型在可控文本摘要任务中面临着3个问题: 首先, 大多数可控文本摘要方法集中于单属性控制, 对于多属性控制方法的研究较为有限; 其次, 多属性可控文本摘要方法在进行多属性控制时, 会出现控制能力下降, 无法合理兼顾所有控制属性的问题; 最后, 传统模型无法处理单词表外的单词.

为应对上述问题, 本文提出了一种基于扩展Transformer和指针生成网络的多要素可控文本摘要模型. 本论文的创新之处包括: 1)使用扩展后的Transformer接收源文本和指导信号, 保证在输出摘要的时候通过交互注意力同时去关注源文档和指导信号, 从而使摘要更加忠诚于指导信号. 2)引入指针生成网络, 使模型具有从源文档中复制文本的能力. 3)在注意力层中使用相对位置编码, 高效生成具有上下文语义信息的单词嵌入向量. 通过与其他几个模型的对比实验表明, 本文提出的模型在确保ROUGE指标不下降, 甚至有所提升的前提下, 可以生成更加满足用户偏好的个性化摘要.

1 相关工作在2014年, Sutslever等人[1]提出了一种广泛影响的序列到序列模型(sequence-to-sequence), 成功实现了英-法互译的文本语言任务. 2015年Bahdanau等人[2]将Seq2Seq模型与注意力机制结合, 这一组合在翻译任务上取得了巨大的成功. 这种将Seq2Seq模型与注意力机制的结合的方法为后来的研究者提供了巨大的启发. 同年, Luong等人[3]打破了Seq2Seq的单任务框架, 构建了一个序列到序列的多任务的框架. 2016年Chopra等人[4]在Bahdanau等人的模型基础上进行改进, 将其应用于文本摘要任务. Nallapati等人[5]提出带有注意力的解码器编码器循环神经(RNN)网络, 该模型的编码器和解码器完全由RNN神经网络组成, 在当时的文本摘要任务上达到了state-of-the-art的表现. 2017年, See等人[6]基于指针网络提出了指针生成网络模型, 该模型用于解决文本摘要任务中的未登录词问题. Vaswani等人[7]提出了一个完全摒弃RNN和CNN等网络的结构模型Transformer, 该模型完全依赖注意力机制来实现翻译任务, 并取得了出色的效果. 这一成功使得注意力机制成为一个研究热点. 随后, 出现了一系列预训练模型, 如BART[8]和GPT[9], 它们在微调之后可以很好完成自然语言处理领域的任务. Transformer的核心结构是self-attention机制, 但由于其无法对输入token的相对位置或绝对位置信息进行建模. 因此, 通常需要额外添加位置嵌入(positional embedding)来引入位置信息. 2018年, Shaw等人[10]通过在自注意力机制中引入token之间的相对位置向量, 构建输入序列的连接图, 高效地完成了位置信息的编码, 提高了模型的性能.

过去的文本摘要系统生成的摘要不受用户控制, 不同的用户生成同一份摘要, 这无法满足用户的个性化偏好. 因此, 生成可定制的个性化摘要已经成为摘要系统的必备功能. 2019年, Makino等人[11]通过一种全局优化的方法实现了摘要长度的可控性. 2020年, He等人[12]通过提示(prompt)方法实现了实体控制的生成摘要. 2021年, Cao等人[13]提出了预训练阶段的摘要生成解码器可以用于实现摘要风格控制的两种方法. 2022年, Zhong等人[14]实现了一个无监督的多粒度框架GRANUSUM, 用于控制生成摘要的粒度. 这些研究通常集中在单一属性的控制方面. 值得注意的是, Chan等人[15]在2021年通过受限马尔可夫决策过程的方法来对不同属性进行可控摘要生成, 但是否可以实现多属性的控制仍然是一个未知数. Goyal等人[16]通过混合多个解码器来研究多特征控制, 但他们仅在解码器上进行了改进, 使模型控制能力的提升比较有限. Dou等人[17]通过混合多个编码器的方法实现了多摘要多个属性的单独控制. 过去的研究大多过于专注于单个特定属性的控制, 而控制多个属性仍未得到充分探索. 数据集方面, 现有工作都是在改编自一般摘要数据集的伪数据集上进行评估. 为了解决这个问题, 2022年Zhang等人[18]提出了第1个多属性控制的人工注释的摘要数据集, 填补了多属性控制方面数据集的空缺. 该论文还提出了一个自动评估系统, 用于评估模型生成可控制摘要的能力.

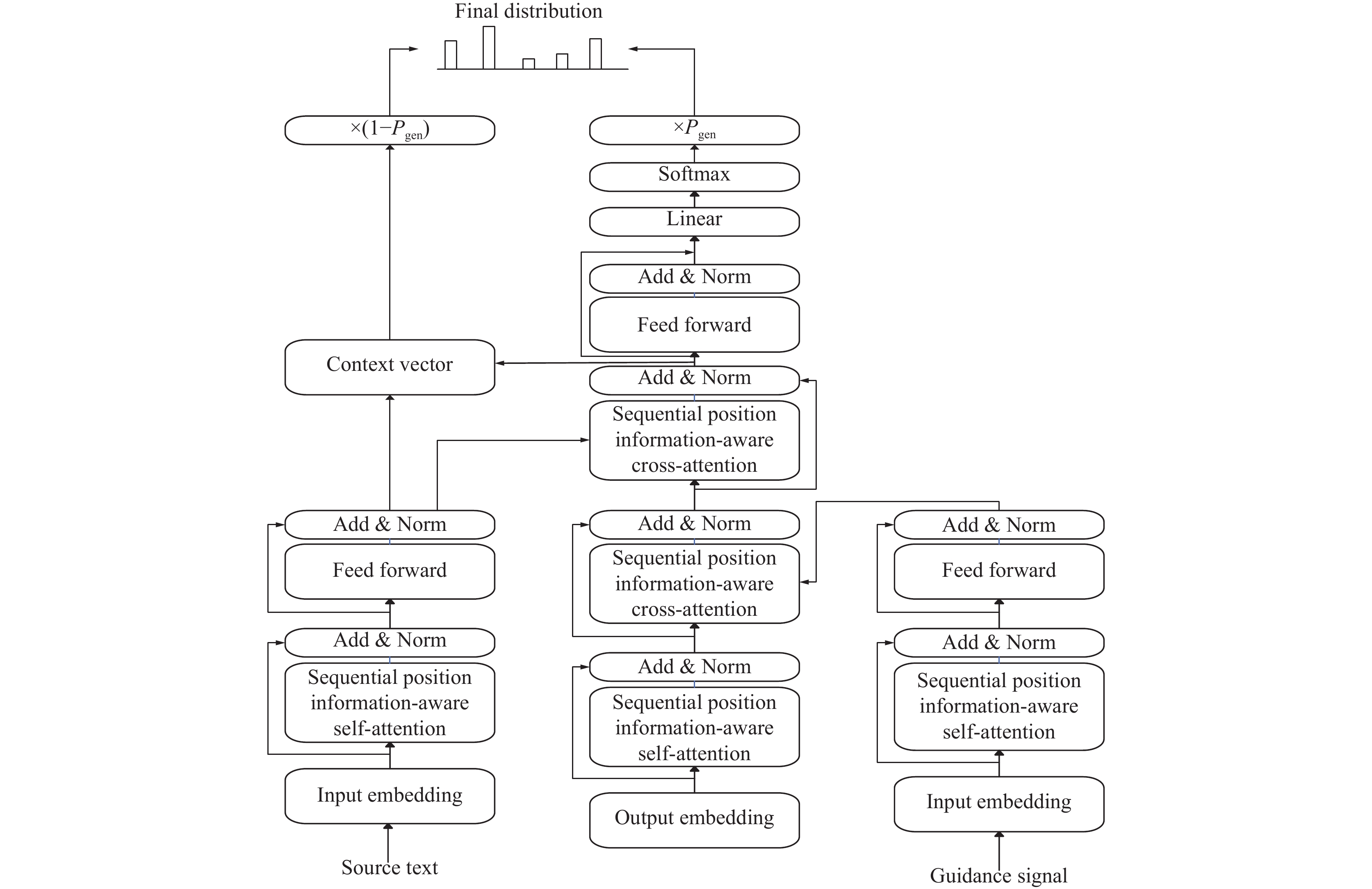

2 模型算法设计本文提出的模型总体架构如图1所示, 主要包括两个关键模块: 扩展Transformer模块和指针生成网络模块. 其中扩展Transformer通过BART进行实例化. 输入的文本和指导信号首先进入扩展Transformer模块的两个编码器进行特征提取, 然后将输出的特征向量与解码器进行交互后作为指针生成网络的输入. 指针生成网络结合生成式和抽象式摘要方法, 使模型具有从源文本中复制单词的能力, 同时也具有生成新单词的能力.

|

图 1 模型整体架构 |

2.1 扩展Transformer

在本文模型中, 为了使生成的摘要更加忠诚于文本, 我们采用两个编码器, 其中一个编码器用于对源文档进行编码, 而另一个编码器则用于对用户输入的指导信号进行编码. 每个编码器都包含

| x=LN(x+Self-Attention(x)) | (1) |

| x=LN(x+FFN(x)) | (2) |

| FFN(x)=max(0,xW1+b1)W2+b2 | (3) |

其中,

通常的Transformer只需处理一个编码器的输出, 但是本文模型的解码器必须同时处理源文档和引导信号两个输入. 解码器是由

| y=LN(y+Self-Attention(y)) | (4) |

| y=LN(y+Cross-Attention(y,g)) | (5) |

| y=LN(y+Cross-Attention(y,x)) | (6) |

| y=LN(y+FFN(y)) | (7) |

| FFN(y)=max(0,yW1+b1)W2+b2 | (8) |

其中,

编码器逐词读取源文本之后, 生成一个编码器隐藏状态的序列

| eti=vttanh(Whhi+Wsst+battn) | (9) |

| at=Softmax(et) | (10) |

其中,

| h∗t=∑iatihi | (11) |

将上下文向量和解码器隐藏状态拼接后输入两个线性层可以得到词汇分布

| Pvocab=Softmax(V′(V[st,h∗t]+b)+b′) | (12) |

其中,

指针生成网络为了解决OOV问题, 模型可以直接复制源文本中的单词也可以从词汇表中选择单词. 对于每一个时间步

| Pgen=σ(wTh×h∗t+wTSst+wTxxt+bptr) | (13) |

其中,

| P(w)=PgenPvocab(w)+(1−Pgen)∑i:wi=wati | (14) |

值得注意的是, 在式(14)中, 如果

| losst=−logP(w∗t) | (15) |

整体损失值为:

| loss=1TT∑t=0losst | (16) |

在Transformer模型中, 输入进编码器的嵌入由两个向量相加, 分别为单词嵌入(word embedding)和位置嵌入(position embedding). 本文提出的模型中, 单词嵌入采用了随机初始化的方法, 但同时将其设置为可训练的, 这意味着在训练过程中会不断优化嵌入表示. 这一处理方式与Transformer模型相似. 然而, 与传统Transformer不同的是, 本文模型不再使用位置嵌入来打破自注意力机制的置换不变性, 而是采用了更加高效的方法来输入序列的位置信息, 以达到生成更优质摘要的效果.

序列位置感知的注意力扩展普通注意力机制以考虑输入元素之间的成对关系. 直观来说, 它将输入建模为有标记的、有向的、完全连接的图. 对于两个输入的元素

| zi=n∑j=1qij(tjWV+qVij) | (17) |

| qij=expeij∑nk=1expeik | (18) |

| eij=tjWQ(tjWK+qKij)T√dz | (19) |

即对于各个Value和Key来说, 都会引入一个相互的位置关系表示.

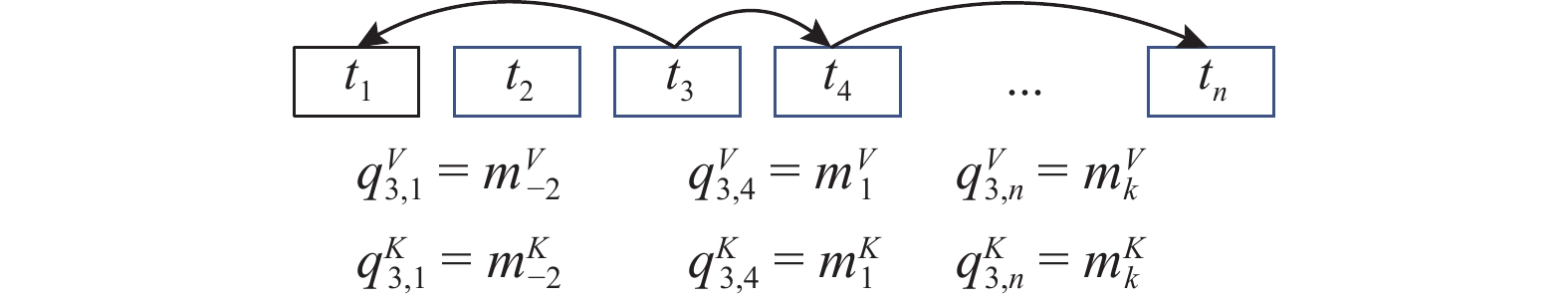

考虑到计算量、内存消耗以及远距离的精确位置信息效用不是很足等因素, 本文对最远的相对位置距离限制为

对于公式中的

| qKij=mKclip(j−i,k) | (20) |

| qVij=mVclip(j−i,k) | (21) |

| clip(x,k)=max(−k,min(k,x)) | (22) |

模型在训练过程去学习相对位置表示

|

图 2 相对位置向量实例 |

图2表示了相对位置或元素之间距离的实例边. 本文提出的模型会学习距离为

实验所采用的数据集是MACSum[18], 这是第1个专门用于多属性文本摘要控制的人工注释数据集. 该数据集包含了新闻文章和对话两个领域的源文本. 具体来说, MACSum源文本来自CNNDM的部分被称为MAC-Doc, 来自QMSum的部分被称为Mac-Dial.

MACSum涵盖了5个不同的控制属性, 分别是长度、提取性、特异性、主题和演讲者.

长度: 表示摘要的字数, 服务于用户阅读该摘要的时间预算.

提取性: 表示从源文本中提取摘要的比例, 当用户希望生成的摘要更多地从源文本中提取内容时, 这个控制属性可以起到作用.

特异性: 表示我们需要在摘要中包含细节和描述性内容的比例.

主题: 用户特别感兴趣的源内容.

演讲者: 对话中用户更喜欢的某些发言者.

3.2 实验评价指标我们采用ROUGE[19]评估中的ROUGE-1、ROUGE-2、ROUGE-L的F1值来度量文本摘要的质量. 同时, 还采用一个自动指标系统, 用于评估模型生成可控摘要的能力. 对于每个控制属性, 该系统定义了属性度量函数来表示控制程度. 在属性度量函数基础上提出了控制错误率(CER)和控制相关性(CC). CER使用度量函数来衡量生成摘要与标准摘要之间在控制程度上的距离. 一个优秀的模型应该具有较小的CER, 表明其生成的摘要与用户期望的控制属性更加一致. CC则是测量不同属性值的生成摘要之间度量函数的分布, 代表模型的控制属性定义相关的能力. 一个出色的模型应该具有与标准摘要相似的CC分布.

对于一个控制属性

| CER(ˆy,y)=|fr(ˆy)−fr(y)|fr(y)+ε | (23) |

其中,

| CC(ˆy1,ˆy2)=fr(ˆy1)−fr(ˆy2)Distance(v1,v2) | (24) |

其中,

综合使用这些指标, 我们能够全面评估模型的文本摘要质量和多属性可控性能

3.3 模型说明我们基于BART模型构建了本文的扩展Transformer模型, 并按照其超参数来训练总结器. 整个模型总共包含24个编码层, 其中顶层用预训练的参数初始化, 但两个编码器之间的参数是单独训练的. 解码器同样由24层组成, 其中解码器的第1个交互注意力块采用了随机初始化, 而第2个交叉注意力块则使用了预训练参数初始化. 在实验过程中, 我们将最远的相对位置距离

为了验证本文模型的有效性, 我们选择了5种不同的对比模型与本文提出的模型进行比较.

1)扩展Transformer (Trans-1): 融合普通注意力与双编码器-单解码器的基线模型.

2) PGN: 指针生成网络通过使用指针网络来使模型具备从源文本中复制单词的能力. 编码器和解码器都采用单层双向LSTM.

3) BART: 通过去噪自动编码进行了预训练, 是目前较为优秀的抽象摘要模型.

4) MatchSum[20]: 一种抽取模型, 可对BERTExt生成的候选摘要进行重新排序.

5)硬提示(HP)[21]: 使用控制属性的描述作为硬提示, 每个属性的构成都是“属性: 值”. 同时使用“;”连接5个控制属性并且其添加到输入源. 利用BART[9]作为骨架模型. 将该模型作为多属性可控文本摘要的基线模型与本文模型进行对比.

3.5 实验结果上述模型与本文提出的模型在数据集上的对比实验结果如表1、表2所示.

| 表 1 不同模型在MAC-Doc上的评估结果 |

| 表 2 不同模型在MAC-Dial上的评估结果 |

为了评估控制质量, 我们采用了两个关键指标: 控制错误率(CER)和控制相关性(CC). 此外, 我们还使用ROUGE分数来评估生成的摘要质量. 对于一个好的模型来说, 我们期望它生成的摘要具有较低的CER值, 越高的ROUGE值, 并且CC值越接近标准摘要. 表1展示了在MAC-Doc数据集上的实验结果. 本文提出的模型在ROUGE指标上与其他对比模型持平, 甚至在R1和R3上有提升. 其中R1达到了0.308, R3达到了0.259. 在4个控制属性上, CC和CER几乎都达到了最佳的性能水平. 这表明本文提出的模型在保证摘要质量的同时更加符合用户需求. PGN模型由于结合了生成式策略和提取式策略, 使得摘要生成的效果有了大幅的提升. 通过与Trans-1的对比实验, 我们可以发现, 对于许多低频词, 生成式方法生成并不可靠, 而指针生成网络的复制机制能够有效解决这个问题. 与PGN的对比实验结果显示扩展后的Transformer可以使生成的摘要更加忠诚于指导信号, 从而解决摘要不符合控制信号的问题. 此外模型引入序列位置感知注意力后相较于普通注意力可以有效提升生成摘要质量. 值得注意的是, 与HP模型相比, 本文提出的模型在抽取性和主题的控制能力上表现得更出色, 但在长度和具体性控制属性上略显不足. 这可能是因为不同的控制属性之间的存在一定的矛盾关系, 例如像长摘要需要包括更多的单词, 这不可避免地就会包含更多的信息. 相反, 简短的摘要单词数较少, 因此具体性自然会偏低. 为了实现更好的整体控制, 模型倾向于生成一种折中的摘要. 表2呈现了在MAC-Dial数据集上的结果. 与MAC-Doc数据集类似, 本文提出的模型在大多数指标上都获得了最高分. 但是长度控制方面性能略有下降. 这可能是因为CNNDM预训练为模型学习控制新闻文章的属性提供了某些有用的信息. 值得注意的是, CER不应跨数据集进行比较, 因为不同的数据集规模不同.

4 结论与展望本文提出了一种基于扩展Transformer和指针生成网络的多属性可控文本摘要模型. 模型包含两个编码器, 分别对源文档和指导信号进行编码. 在解码器中引入了两个交互注意力机制, 以指导模型关注源文档的特定部分, 从而生成满足用户个性化需求的摘要. 此外, 通过采用指针生成网络, 我们的模型能够在自动生成摘要的同时还具备从源文本中复制单词的能力. 同时, 引入相对位置表示于注意力机制中, 以高效地编码位置信息, 从而生成更高质量的摘要. 实验在MACSum数据集上进行了训练和测试, 实验结果表明, 该模型在保证摘要质量的前提下更加符合用户的个性化偏好. 尽管取得了显著进展, 但多属性可控文本摘要仍然是一个具有挑战性的研究领域, 值得我们继续深入探索和改进.

| [1] |

Sutskever I, Vinyals O, Le QV. Sequence to sequence learning with neural networks. Proceedings of the 27th International Conference on Neural Information Processing Systems. Montreal: MIT Press, 2014. 3104–3112.

|

| [2] |

Bahdanau D, Cho K, Bengio Y. Neural machine translation by jointly learning to align and translate. Proceedings of the 3rd International Conference on Learning Representations. San Diego: ICLR, 2015.

|

| [3] |

Luong MT, Le QV, Sutskever I, et al. Multi-task sequence to sequence learning. Proceedings of the 4th International Conference on Learning Representations. San Juan: ICLR, 2016.

|

| [4] |

Chopra S, Auli M, Rush AM. Abstractive sentence summarization with attentive recurrent neural networks. Proceedings of the 2016 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. San Diego: Association for Computational Linguistics, 2016. 93–98.

|

| [5] |

Nallapati R, Zhou BW, Dos Santos C, et al. Abstractive text summarization using sequence-to-sequence RNNs and beyond. Proceedings of the 20th SIGNLL Conference on Computational Natural Language Learning. Berlin: Association for Computational Linguistics, 2016. 280–290.

|

| [6] |

See A, Liu PJ, Manning CD. Get to the point: Summarization with pointer-generator networks. Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Vancouver: Association for Computational Linguistics, 2017. 1073–1083.

|

| [7] |

Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need. Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach: Curran Associates Inc., 2017. 6000–6010.

|

| [8] |

Lewis M, Liu YH, Goyal N, et al. BART: Denoising sequence-to-sequence pre-training for natural language generation, translation, and comprehension. Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics. Association for Computational Linguistics, 2019. 7871–7880.

|

| [9] |

Radford A, Narasimhan K, Salimans T, et al. Improving language understanding by generative pre-training. https://s3-us-west-2.amazonaws.com/openai-assets/research-covers/language-unsupervised/language_understanding_paper.pdf. [2023-08-10].

|

| [10] |

Shaw P, Uszkoreit J, Vaswani A. Self-attention with relative position representations. Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 2 (Short Papers). New Orleans: Association for Computational Linguistics, 2018. 464–468.

|

| [11] |

Makino T, Iwakura T, Takamura H, et al. Global optimization under length constraint for neural text summarization. Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. Florence: Association for Computational Linguistics, 2019. 1039–1048.

|

| [12] |

He J, Kryściński W, McCann B, et al. CTRLsum: Towards generic controllable text summarization. Proceedings of the 2022 Conference on Empirical Methods in Natural Language Processing. Abu Dhabi: Association for Computational Linguistics, 2020. 5879–5915.

|

| [13] |

Cao SY, Wang L. Inference time style control for summarization. Proceedings of the 2021 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Association for Computational Linguistics, 2021. 5942–5953.

|

| [14] |

Zhong M, Liu Y, Ge SY, et al. Unsupervised multi-granularity summarization. Proceedings of the 2022 Findings of the Association for Computational Linguistics: EMNLP 2022. Abu Dhabi: Association for Computational Linguistics, 2022. 4980–4995.

|

| [15] |

Chan HP, Wang L, King I. Controllable summarization with constrained Markov decision process. Transactions of the Association for Computational Linguistics, 2021, 9: 1213-1232. DOI:10.1162/tacl_a_00423 |

| [16] |

Goyal T, Rajani NF, Liu WH, et al. Hydrasum: Disentangling stylistic features in text summarization using multi-decoder models. arXiv:2110.04400, 2021.

|

| [17] |

Dou ZY, Liu PF, Hayashi H, et al. GSum: A general framework for guided neural abstractive summarization. Proceedings of the 2021 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Association for Computational Linguistics, 2020. 4830–4842.

|

| [18] |

Zhang YS, Liu Y, Yang ZY, et al. MACSum: Controllable summarization with mixed attributes. Transactions of the Association for Computational Linguistics, 2022, 11: 787-803. |

| [19] |

Lin CY. ROUGE: A package for automatic evaluation of summaries. Proceedings of the 2004 Workshop on Text Summarization Branches Out. Barcelona: Association for Computational Linguistics, 2004. 74–81.

|

| [20] |

Zhong M, Liu PF, Chen YR, et al. Extractive summarization as text matching. Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics. Association for Computational Linguistics, 2020. 6197–6208.

|

| [21] |

Raffel C, Shazeer N, Roberts A, et al. Exploring the limits of transfer learning with a unified text-to-text Transformer. The Journal of Machine Learning Research, 2020, 21(1): 140. |

2024, Vol. 33

2024, Vol. 33