互联网的飞速发展改变了民众获取新闻的方式, 但也加剧了各领域虚假新闻的传播. 每年各个领域层出不穷的虚假新闻不仅对人们的身心健康造成了严重的伤害, 也对国家社会安全造成了巨大的挑战[1]. 当前多领域虚假新闻检测任务面临两个问题, 分别为领域偏移问题和跨域关联问题.

不同领域的新闻在用词、情感表达、写作风格运用上往往存在明显的差别, 该现象被称为领域偏移问题[2]. 由于该问题的存在, 以往使用普通模型不区分领域直接预测的方式, 通常因无法成功捕捉到各领域间新闻的差异, 导致模型在各领域上的预测指标差别较大, 从而制约了综合预测指标的提升.

现实中的某个新闻主题往往会引起不同领域内新闻的讨论, 即跨领域主题关联现象, 该现象如图1所示. 图1(a)是使用基线模型MFEFND[3]提取新闻特征并使用t-SNE对特征降维, 在二维平面上对新闻领域分布情况的展示, 不同颜色表示不同的领域. 图1(b)是使用K-means算法对新闻特征进行主题聚类后, 对主题划分情况的降维展示. 由图1(a)和图1(b)相互对比可知, 不同领域的新闻确实存在主题关联现象. 该现象必然造成新闻领域边界划分的困难, 阻碍模型对新闻所属领域的判断, 进而使模型无法准确地运用领域特定的特征提取策略, 进一步制约了模型预测能力的提高. 本文将该现象引起的问题称为跨域关联问题.

|

图 1 新闻主题聚类可视化 |

针对上述两个问题, 本文提出了一种基于交叉特征感知融合的多领域虚假新闻检测(multi-domain fake news detection based on cross-feature perception fusion, CFPFND)方法. 本方法首先从文本意群划分、文本语义表述、情感表达、写作风格这4种角度提取新闻特征, 运用交叉注意力机制计算特征之间的交叉注意力权重, 从更深层次上捕捉不同特征之间的运用与表达差异. 本方法构建了4种新闻空间, 以新闻空间中的主题特征作为空间特征, 对待检测目标新闻进行空间感知, 通过主题相似性发现待检测新闻的跨领域关联关系. 本方法从新闻内容、新闻所属领域、新闻跨领域关联关系这3个维度控制交叉特征的融合过程, 使模型能够针对新闻内容, 从不同领域和不同关联关系中推理出新闻的特征提取策略, 有效应对领域偏移问题和跨域关联问题.

为了进一步提高模型对新闻所属领域的辨别能力, 本方法提出了一种联合训练框架对模型进行训练. 本框架以虚假新闻检测任务为主任务, 以领域分类任务为监督任务, 将两个任务同时训练并回传损失, 对模型参数进行优化, 通过提高模型的领域分类能力, 进一步提高其虚假新闻的检测能力.

综上所述, 本文的创新性如下.

1)通过对新闻数据进行分析, 本文提出了不同领域间新闻存在的跨域关联问题.

2)针对领域偏移问题和跨域关联问题, 本文提出了一种基于交叉特征感知融合的多领域虚假新闻检测方法, 捕捉不同领域间新闻的差异, 挖掘新闻之间的关联关系, 从多个维度控制模型在各领域上的特征融合策略.

3)本文在中英文数据集上使用联合训练框架对本方法的模型进行训练, 模型取得了更优的预测效果. 相较于最先进的模型, 本模型在中英文数据集上的F1分数分别达到了92.84%和85.49%, 分别提升1.16%和1.07%, 证明了本文所提出的方法和框架的有效性.

1 相关工作虚假新闻检测作为一个自然语言处理与社会计算交叉的研究领域, 近年来逐渐受到研究人员的关注. 而深度神经网络具有较强的数据建模能力, 在复杂任务中具有更优的表现, 因此, 深度神经网络一直在虚假新闻检测任务中扮演着重要的角色. Ma等人[4]首次将循环神经网络应用到虚假新闻检测任务中, 以隐藏层向量作为分类器的输入特征, 取得了较好的预测效果. Yu等人[5]对新闻文本进行直接建模, 将文本的特征向量拼接成矩阵, 然后利用卷积神经网络提取新闻文本矩阵的特征并进行分类.

随后, 多任务学习, 生成式深度学习, 图神经网络也逐渐被引入到虚假新闻检测任务中. Ma等人[6]首次将多任务学习方法应用到虚假新闻检测任务中, 以循环神经网络作为主干, 同时训练虚假新闻检测任务与立场检测任务, 通过两种训练任务促进虚假新闻检测模型性能的提升. Cheng等人[7]利用变分自编码器编码新闻文本信息, 获取新闻文本的嵌入表示, 随后将新闻向量运用于多任务学习. Vaibhav等人[8]将新闻文章中的句子构建为节点, 按照节点相似度构建节点之间的边, 把虚假新闻检测任务转换为图分类任务. Li等人[9]利用预训练的事实核查模型在外部知识中查找事实证据, 将事实证据与新闻内容构建为星形图, 使用图卷积网络融合新闻内容和事实证据. Ma等人[10]利用生成器生成谣言, 将谣言与非谣言相互转化以扩充训练数据, 使用判别器检测虚假新闻, 通过不断训练生成器和判别器, 提升了模型预测的鲁棒性和分类的准确率. Huang等人[11]提出了一个由自然语言推理指导自我批判序列训练的框架, 用于生成与人类撰写风格策略相似的训练数据, 在生成数据上训练的模型可以在公共数据集上取得较好的效果. Sheng等人[12]参考了事实核查方法, 使用新闻传播环境中具有时间关联的新闻作为辅助检测的依据, 证明了从宏观和微观两种新闻环境感知检测依据的有效性.

随着虚假新闻检测研究的不断深入, 多领域与跨领域虚假新闻检测逐渐成为研究的热点. Nan等人[3]首次提出了多领域虚假新闻检测任务, 设计了该任务的基线模型, 并公开了一个多领域数据集. Zhu等人[2]在新闻文本特征的基础上, 加入了情感和风格特征对新闻真假性进行预测, 使用领域记忆发掘新闻的潜在领域标签. Nan等人[13]使用元学习方法在多个领域的数据集上进行训练, 获得通用预测模型, 使用困惑度为指标, 研究了通用模型在新的领域上的迁移能力. Yue等人[14]提出了一种基于元学习的方法, 用于领域自适应的小样本虚假信息检测, 使用多个源任务训练初始模型, 并计算模型与元任务的相似度得分, 以相似度得分重新调整元梯度, 使模型能自适应地从源任务中学习特征. Ran等人[15]使用实例级对比学习和原型级对比学习方法对不同领域间新闻的领域偏移问题进行了研究, 使用交叉注意力机制增强了模型在跨领域预测中的鲁棒性. Choudhry等人[16]使用情感分类作为研究跨领域虚假新闻检测的指标, 并通过实验结果验证了情感引导方法在跨领域虚假新闻检测中的有效性.

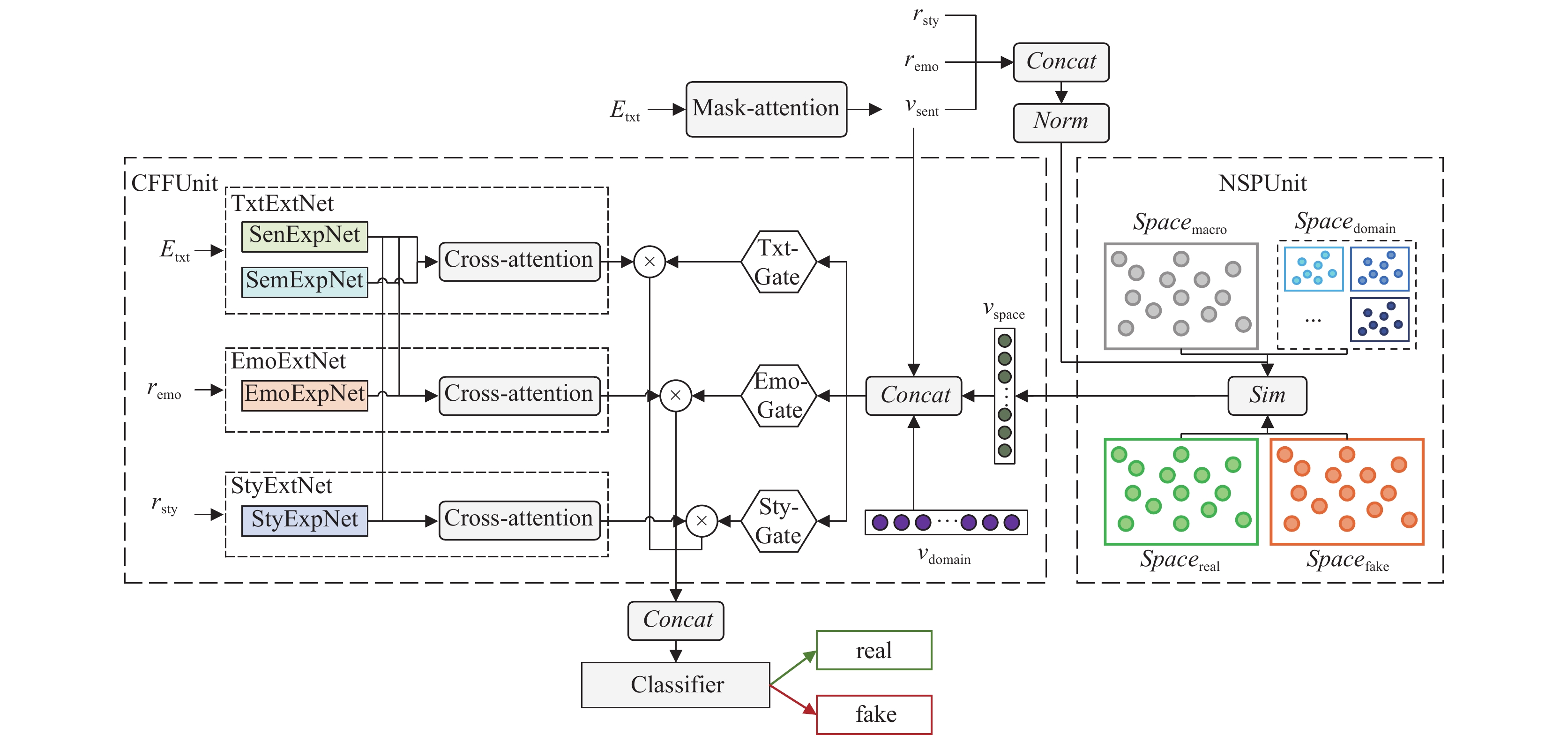

2 方法本节对CFPFND方法的模型进行介绍, CFPFND模型的总体结构如图2所示. 本模型包含交叉特征融合单元(cross feature fusion unit, CFFUnit)和新闻空间感知单元(news space perception unit, NSPUnit)两个主体部分. CFFUnit使用专家网络[17]提取新闻特征, 使用交叉注意力机制计算特征权重, 使用门控网络控制特征融合过程. NSPUnit用于构建新闻主题空间, 对待检测新闻的主题关联关系进行感知.

本方法使用中文BERT模型提取中文新闻文本特征, 使用RoBERTa模型提取英文新闻文本特征, 获得每一条待检测新闻的文本所对应的词向量

CFPFND模型为每个领域设置了一个领域特征向量vdomain. 具体来说, 当数据集中共有Ndomain个不同的领域时, 模型在初始化时会随机创建Ndomain个Embedding作为领域特征向量, 每个领域特征向量只与一个领域相对应. 在模型训练过程中, 待检测新闻所属领域的领域特征向量将作为门控网络的输入之一, 参与门控参数的计算. 每个领域特征向量只针对其所在领域的新闻进行训练, 根据损失进行优化, 因此, 该领域特征向量可以被认为只保存了其所在领域中所有新闻的特征.

2.1 交叉特征融合单元CFFUnitCFFUnit包含3种特征提取网络及其对应的门控网络, 3种特征提取网络分别为: 新闻文本特征提取网络(news text feature extraction network, TxtExtNet)、新闻情感特征提取网络(news emotion feature extraction network, EmoExtNet)、新闻风格特征提取网络(news style feature extraction network, StyExtNet), 每个特征提取网络使用多组专家网络提取特征.

2.1.1 新闻文本特征提取网络TxtExtNetTxtExtNet用于提取新闻文本中的意群成分特征与总体语义特征. 由于一维卷积神经网络的卷积核可以模拟文本词组划分并进行特征提取, 因此, 本方法使用多组TextCNN[20]作为意群特征专家网络(sense group feature expert network, SenExpNet)提取意群特征

| vseni=SenExpNeti(Etxt) | (1) |

| vsemi=SemExpNeti(Etxt) | (2) |

|

图 2 CFPFND模型总体结构 |

TxtExtNet使用交叉注意力机制(如式(3)所示)计算意群与语义之间的交叉作用特征, 获得包含语义作用权重的意群交叉特征

| fattcross(Qs,Kt,Vt)=Softmax(Qs(Kt)T√dk)Vt | (3) |

| Vsen×sem=fattcross(Vsen,Vsem,Vsem) | (4) |

| Vsem×sen=fattcross(Vsem,Vsen,Vsen) | (5) |

意群特征、语义特征及其交叉特征组成新闻文本的交叉特征

| VTXTcross=Concat(Vsen,Vsem,Vsen×sem,Vsem×sen) | (6) |

EmoExtNet使用多个MLP作为情感特征专家网络(emotion feature expert network, EmoExpNet), 提取不同程度的情感特征

| vemoi=EmoExpNeti(remo) | (7) |

EmoExtNet使用交叉注意力机制分别计算文本中的情感表达与运用特征, 获得情感交叉表达特征

| Vemo×txt=fattcross(Vemo,Vtxt,Vtxt) | (8) |

| Vtxt×emo=fattcross(Vtxt,Vemo,Vemo) | (9) |

情感特征和情感表达特征、情感运用特征组合为新闻情感的交叉特征

| VEMOcross=Concat(Vemo,Vemo×txt,Vtxt×emo) | (10) |

StyExtNet使用多个MLP作为风格特征专家网络(style feature expert network, StyExpNet), 提取不同角度的风格特征

| vstyi=StyExpNeti(rsty) | (11) |

与EmoExtNet交叉特征提取过程类似, StyExtNet使用交叉注意力机制计算获得风格交叉表现特征

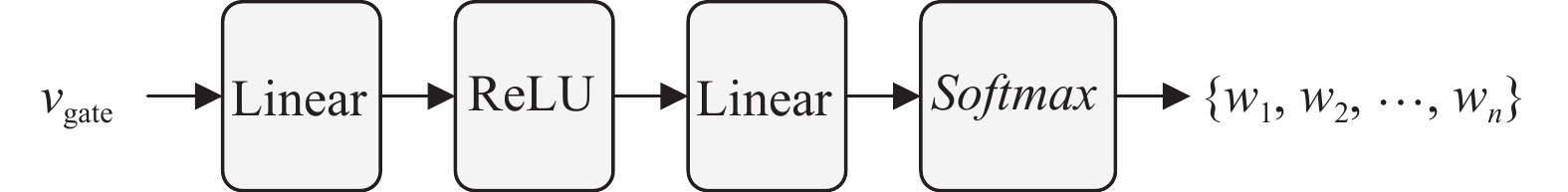

CFFUnit包含3种门控网络, 分别为: 文本特征门控网络(text feature gating network, TxtGate)、情感特征门控网络(emotion feature gating network, EmoGate)、风格特征门控网络(style feature gating network, StyGate). 3种门控网络的计算过程相同, 如图3所示.

|

图 3 门控网络的计算过程 |

门控网络的输入向量vgate的计算过程如式(12)所示.

| vgate=vsent⊕vdomain⊕vspace | (12) |

其中,

| vspace=NSPUnit(Norm(vsent⊕vemo⊕vsty)) | (13) |

3种门控网络接收vgate作为输入, 分别输出TxtExtNet的交叉特征融合参数

NSPUnit构建了4种新闻主题空间, 分别为: 宏观新闻空间Spacemacro、现实新闻空间Spacereal、谣言新闻空间Spacefake和Ndomain个领域新闻空间Spacedomain.

2.2.1 新闻空间构建模型读取数据集中所有的新闻文本数据, 提取特征, 构建新闻组合特征vunion, 如式(14)所示.

| vunion=Norm(vsent⊕remo⊕rsty) | (14) |

模型将所有新闻的组合特征存入宏观新闻集合, 将真实新闻和虚假新闻的组合特征分别存入真实新闻集合和虚假新闻集合, 按照新闻所属领域的不同, 将其组合特征存入特定的领域新闻集合.

NSPUnit使用K-means聚类算法对4种集合内的组合特征进行主题聚类, 将每个新闻主题类簇中心的新闻组合特征vunion作为该主题的特征topici. NSPUnit以每个空间中的所有主题特征作为该空间的特征, 因此, 宏观新闻空间

NSPUnit提取待检测新闻的组合特征vunion, 以相似度(计算过程如式(15)所示)作为感知参数在4种新闻空间中进行主题感知, 发现每种新闻空间中与待检测新闻组合特征相似度最高的主题特征

| Sim(vunion,topici)=vunion⋅topici‖vunion‖⋅‖topici‖ | (15) |

NSPUnit以加权相似度

| vspace=∑wsi⋅topicisim,i∈[macro,real,fake,domain] | (16) |

| wsi=Softmax(Sim)i=simisimmacro+simreal+simfake+simdomain | (17) |

模型的分类器使用MLP组合3种交叉特征, 输出新闻为真或假的概率, 如式(18)所示, 其中

| ˆy=MLP(VTXTcrossWTXT⊕VEMOcrossWEMO⊕VSTYcrossWSTY) | (18) |

本实验所使用的中文数据集为Weibo21数据集[3], 包含科技、军事、教育考试、灾难事故、政治、医药健康、财经商业、文体娱乐、社会生活9个领域, 各领域数据的统计信息如表1所示. 英文数据集是由FakeNewsNet数据集[22]与MM-COVID数据集[23]中的英文文本数据组成的, 包含Gossipcop、Politifact、COVID 3个领域的数据集, 各领域数据的统计信息如表2所示. 由表1和表2可知, 两个数据集中不同领域间的数据量存在较大的差异.

3.2 基线模型本实验选择了EANN[24]、MMoE[19]、MoSE[25]、EDDFN[26]、MDFEND和M3FEND[2], 共6个可以应用于多领域虚假新闻检测的模型作为基线模型. EANN是一个多模态虚假新闻检测模型, 本方法仅使用EANN提取新闻文本特征, 单模态EANN的结构与TextCNN基本一致. MMoE与MoSE是多任务学习模型, MMoE使用多组专家网络和多组门控网络控制不同任务的特征组合过程. MoSE是对MMoE的改进, 在专家网络之前添加了一个LSTM层作为shared bottom layer. 本实验按领域划分数据集, 将不同领域上的预测任务看作是不同的学习任务, 使MMoE和MoSE同时对多个领域的新闻做预测. EDDFN是一种用于跨领域虚假新闻检测的模型, EDDFN对不同领域进行隐式建模, 同时保留了领域特定的知识和跨领域的知识.

| 表 1 多领域中文数据集统计数据 |

| 表 2 多领域英文数据集统计数据 |

MDEFND是多领域虚假新闻检测的基线模型, 该模型使用多组TextCNN作为专家网络, 提取不同角度的新闻文本语义特征, 使用门控网络融合专家语义特征. M3FEND在MDEFND模型的基础上, 加入了新闻情感与写作风格特征, 使用多头注意力机制融合特征. 但是, 这两个模型都没有考虑跨域关联问题.

3.3 实验结果实验使用6个基线模型和CFPFND模型分别在中文和英文数据集上进行训练, 使用训练好的模型在测试集上进行预测, 统计各项预测结果, 在中文数据集上的预测结果如表3所示, 其中单个领域上的预测指标为F1分数. CFPFND模型在7个领域上的预测效果优于其他基线模型, 在数据量最大的社会生活领域上的F1分数远高于其他基线模型.

| 表 3 多领域中文数据集实验结果 |

模型在英文数据集上的预测结果如表4所示. CFPFND模型在Gossipcop和COVID两个领域上的预测结果优于其他基线模型, 在Politifact领域上的预测结果与最高预测结果非常接近. Gossipcop领域的数据量远高于Politifact和COVID两个领域, 因此在该领域上F1分数的高低将直接决定3项综合预测指标的高低.

通过表3和表4各模型间预测结果的对比可知, CFPFND模型在F1分数、准确率、AUC这3项指标上均取得了提升, 预测效果均优于所有的基线模型, 在多个领域上的F1分数也优于基线模型. 综上所述, 相较于基线模型, 本文所提出的检测方法及其模型, 具有较优的预测能力.

| 表 4 多领域英文数据集实验结果 |

3.4 联合训练框架

本框架以CFPFND模型的虚假新闻检测任务作为主任务, 以领域分类任务作为监督任务, 将主任务的预测损失与监督任务的预测损失按权重相加, 并将联合损失回传, 对模型参数进行优化, 框架执行过程如图4所示.

|

图 4 联合训练框架执行过程 |

联合损失计算过程如式(19)所示, 其中LossCFPFND为CFPFND模型的预测损失, Lossdomain为领域分类预测损失, α为权重参数.

| Loss=LossCFPFND+α×Lossdomain | (19) |

具体而言, CFPFND模型组合3种交叉特征之后, 分别送入虚假新闻检测分类器FNDClassifier和领域分类器DomainClassifier, 两个分类器均为MLP. FNDClassifier输出新闻真与假的概率, DomainClassifier输出新闻属于各个领域的概率值. 模型使用二元交叉熵损失函数计算LossCFPFND, 使用交叉熵损失函数计算Lossdomain. 同时, 参数α在训练过程中手动调整, 模型以获得最优预测效果的权重数值作为最终α取值.

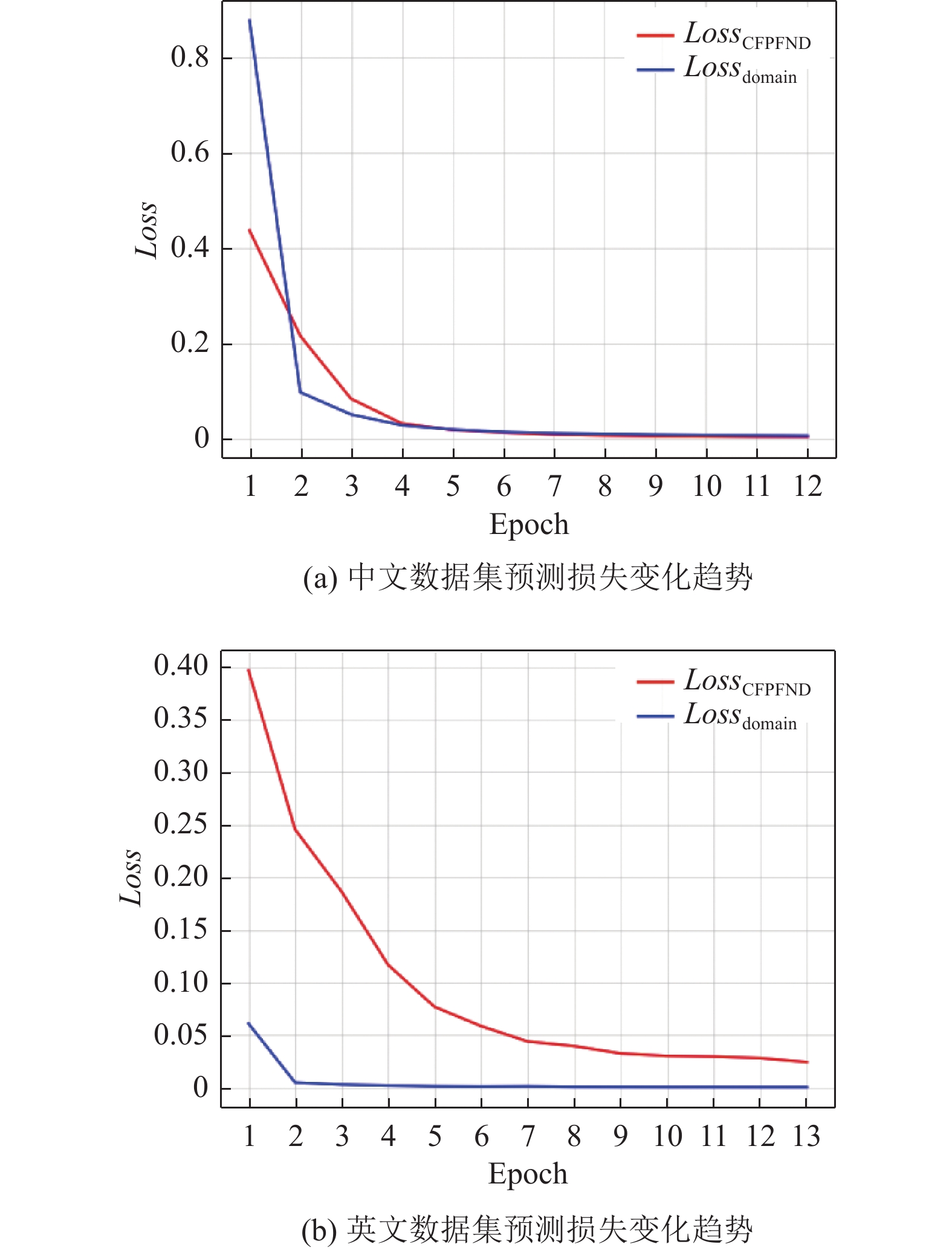

使用联合训练框架对CFPFND模型进行训练, 模型在中文和英文数据集上的预测损失变化曲线分别如图5(a)和图5(b)所示. 由图5可知, 虚假新闻检测的预测损失与领域分类预测损失具有相同的变化趋势, 证明两个任务具备相关性.

|

图 5 数据集预测损失变化趋势 |

3.5 联合训练实验结果

本联合训练实验以0.1作为权重取值间隔, 在区间[0, 1]上取11个数值作为权重参数α的值. 联合训练实验过程按照联合训练框架, 在每个α取值上进行10轮以上的训练, 记录每个α取值下最优的预测结果, 使用联合训练框架训练的模型在中文和英文测试集上取得的预测结果分别如表5和表6所示.

由表5和表6可知, 当中文和英文数据集上α的取值分别为0.1和0.5时, 模型能够获得最优的预测效果. 通过对比可知, 使用联合训练框架后, 取得最优预测效果的CFPFND模型不仅在3个预测指标上都取得了较大的提升, 还使中文数据集上各领域间F1分数的差距获得了缩小, 各领域预测结果较为均衡. 同时, 英文数据集上各领域的F1分数均高于其他α取值. 上述实验结果证明了CFPFND模型和联合训练框架在多领域虚假新闻检测上的有效性, 也证明了区分领域差异可以进一步提升模型的预测效果.

| 表 5 中文数据集实验结果 |

| 表 6 英文数据集实验结果 |

由于中文BERT模型和RoBERTa模型在基本分类任务上的良好性能, 当α的取值大于0.0时, 模型在领域分类任务上的预测准确率都达到了99%以上. 然而, 当领域分类任务损失的权重过大时, 使用联合训练框架得到的模型预测效果却弱于α=0时的预测效果. 由此可见, 使用权重参数α控制损失的相加是必要的.

4 总结本文提出了一种基于交叉特征感知融合的多领域虚假新闻检测方法, 该方法的模型通过交叉特征融合单元提取多种新闻特征, 捕捉不同特征之间深层次的运用与表达, 使用新闻空间感知单元提取新闻的跨领域关联关系, 利用门控网络执行不同领域新闻的特征融合策略, 有效地应对了领域偏移问题和跨域关联问题. 本文提出的联合训练框架在提高模型的新闻领域辨别能力的同时, 进一步提高了模型预测的效果.

| [1] |

Guo B, Ding YS, Yao LN, et al. The future of false information detection on social media: New perspectives and trends. ACM Computing Surveys, 2020, 53(4): 68. |

| [2] |

Zhu YC, Sheng Q, Cao J, et al. Memory-guided multi-view multi-domain fake news detection. IEEE Transactions on Knowledge and Data Engineering, 2023, 35(7): 7178-7191. |

| [3] |

Nan Q, Cao J, Zhu YC, et al. MDFEND: Multi-domain fake news detection. Proceedings of the 30th ACM International Conference on Information & Knowledge Management. New York: Association for Computing Machinery, 2021. 3343–3347.

|

| [4] |

Ma J, Gao W, Mitra P, et al. Detecting rumors from microblogs with recurrent neural networks. Proceedings of the 25th International Joint Conference on Artificial Intelligence. New York: AAAI Press, 2016. 3818–3824.

|

| [5] |

Yu F, Liu Q, Wu S, et al. A convolutional approach for misinformation identification. Proceedings of the 26th International Joint Conference on Artificial Intelligence. Melbourne: AAAI Press, 2017. 3901–3907.

|

| [6] |

Ma J, Gao W, Wong KF. Detect rumor and stance jointly by neural multi-task learning. Proceedings of the 2018 Web Conference. Lyon: International World Wide Web Conferences Steering Committee, 2018. 585–593.

|

| [7] |

Cheng MX, Nazarian S, Bogdan P. VRoC: Variational autoencoder-aided multi-task rumor classifier based on text. Proceedings of the 2020 Web Conference. Taipei: Association for Computing Machinery, 2020. 2892–2898.

|

| [8] |

Vaibhav V, Mandyam R, Hovy E. Do sentence interactions matter? Leveraging sentence level representations for fake news classification. Proceedings of the 13th Workshop on Graph-based Methods for Natural Language Processing. Hong Kong: Association for Computational Linguistics, 2019. 134–139.

|

| [9] |

Li JW, Ni SW, Kao HY. Meet the truth: Leverage objective facts and subjective views for interpretable rumor detection. Proceedings of the 2021 Findings of the Association for Computational Linguistics. Association for Computational Linguistics, 2021. 705–715.

|

| [10] |

Ma J, Gao W, Wong KF. Detect rumors on Twitter by promoting information campaigns with generative adversarial learning. Proceedings of the 2019 World Wide Web Conference. San Francisco: Association for Computing Machinery, 2019. 3049–3055.

|

| [11] |

Huang KH, McKeown K, Nakov P, et al. Faking fake news for real fake news detection: Propaganda-loaded training data generation. Proceedings of the 61st Annual Meeting of the Association for Computational Linguistics. Toronto: Association for Computational Linguistics, 2023. 14571–14589.

|

| [12] |

Sheng Q, Cao J, Zhang XY, et al. Zoom out and observe: News environment perception for fake news detection. Proceedings of the 60th Annual Meeting of the Association for Computational Linguistics. Dublin: Association for Computational Linguistics, 2022. 4543–4556.

|

| [13] |

Nan Q, Wang DD, Zhu YC, et al. Improving fake news detection of influential domain via domain-and instance-level transfer. Proceedings of the 29th International Conference on Computational Linguistics. Gyeongju: International Committee on Computational Linguistics, 2022. 2834–2848.

|

| [14] |

Yue ZR, Zeng HM, Zhang Y, et al. MetaAdapt: Domain adaptive few-shot misinformation detection via meta learning. Proceedings of the 61st Annual Meeting of the Association for Computational Linguistics. Toronto: Association for Computational Linguistics, 2023. 5223–5239.

|

| [15] |

Ran HY, Jia CY. Unsupervised cross-domain rumor detection with contrastive learning and cross-attention. Proceedings of the 27th AAAI Conference on Artificial Intelligence. Washington: AAAI Press, 2023. 13510–13518.

|

| [16] |

Choudhry A, Khatri I, Chakraborty A, et al. Emotion-guided cross-domain fake news detection using adversarial domain adaptation. Proceedings of the 19th International Conference on Natural Language Processing. New Delhi: Association for Computational Linguistics, 2022. 75–79.

|

| [17] |

Ma JQ, Zhao Z, Yi XY, et al. Modeling task relationships in multi-task learning with multi-gate mixture-of-experts. Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. London: Association for Computing Machinery, 2018. 1930–1939.

|

| [18] |

Zhang XY, Cao J, Li XR, et al. Mining dual emotion for fake news detection. Proceedings of the 2021 Web Conference. Ljubljana: Association for Computing Machinery, 2021. 3465–3476.

|

| [19] |

Yang YT, Cao J, Lu MY, et al. How to write high-quality news on social network? Predicting news quality by mining writing style. arXiv:1902.00750, 2019.

|

| [20] |

Kim Y. Convolutional neural networks for sentence classification. Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing. Doha: Association for Computational Linguistics, 2014. 1746–1751.

|

| [21] |

Liu PF, Qiu XP, Huang XJ. Recurrent neural network for text classification with multi-task learning. Proceedings of the 25th International Joint Conference on Artificial Intelligence. New York: AAAI Press, 2016. 2873–2879.

|

| [22] |

Shu K, Mahudeswaran D, Wang SH, et al. FakeNewsNet: A data repository with news content, social context, and spatiotemporal information for studying fake news on social media. Big Data, 2020, 8(3): 171-188. DOI:10.1089/big.2020.0062 |

| [23] |

Li YC, Jiang BH, Shu K, et al. Toward a multilingual and multimodal data repository for COVID-19 disinformation. Proceedings of the 2020 IEEE International Conference on Big Data. Atlanta: IEEE, 2020. 4325–4330.

|

| [24] |

Wang YQ, Ma FL, Jin ZW, et al. EANN: Event adversarial neural networks for multi-modal fake news detection. Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. London: Association for Computing Machinery, 2018. 849–857.

|

| [25] |

Qin Z, Cheng YC, Zhao Z, et al. Multitask mixture of sequential experts for user activity streams. Proceedings of the 26th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. New York: Association for Computing Machinery, 2020. 3083–3091.

|

| [26] |

Silva A, Luo L, Karunasekera S, et al. Embracing domain differences in fake news: Cross-domain fake news detection using multi-modal data. Proceedings of the 35th AAAI Conference on Artificial Intelligence. AAAI Press, 2021. 557–565.

|

2024, Vol. 33

2024, Vol. 33