近年来, 随着深度学习的蓬勃发展, 知识工程作为人工智能的另一个重要分支和基础设施, 在自然语言处理、信息检索和推荐等许多应用中发挥了越来越重要的作用. 通过知识工程, 研究人员可以从爆炸性数据中提取有价值的信息, 并使其为机器所理解. 这样, 人工智能相关的应用就不会只局限于较浅的层面, 而是可以对数据有更加深入的理解.

知识图谱(knowledge graph, KG)是一种知识形式, 也称为知识库, 它可以提供关于复杂现实世界的结构化语义信息. 事实上, 知识图谱可以被视为一种结构化和链接的数据, 它将关系事实存储在图结构中. 在当前的知识图谱中, 节点通常表示实体(包括实体、概念、类、属性等), 任意两个节点之间的边表示它们对应的语义关系. 知识图谱中的基本事实单元是由两个实体(节点)及其语义关系(边)组成的三元组.

知识图谱的构建过程, 也是对知识数据的提取和结构化过程. 此过程可分为几项必需的子任务, 如实体识别(entity recognition)、实体消歧(entity disambiguation)、关系抽取(relation extraction)和事件抽取(event extraction)等. 由于文本表达的多样性, 从文本中抽取关系并不是一项容易的任务, 这在很大程度上取决于文本理解的能力. 经典方法主要集中在特征工程上, 其目的是提取有效的特征来提取目标关系. 然而, 它们存在“语义差距”的问题. 这意味着所有特征都是基于符号表示(字符、单词、短语等)的, 这些符号表示存在多义和歧义的问题. 随着深度学习的发展, 深度神经网络在许多研究领域无疑表现出了其优势. 它们的基本优势是使用分布式表示而不是符号, 其中符号之间的精确匹配可以被分布式向量之间的运算所取代. 通过这种方式, 可以在很大程度上缓解语义差距问题. 其中, 图神经网络(graph neural network)可以通过节点的邻域信息聚合并更新节点, 利用其强大的信息传播能力学习数据间的语义关系和潜在信息, 使其可以很好地学习知识中的节点信息、节点间关系信息以及全局结构信息. 近年来, 通过图神经网络, 关系抽取任务在解决关系重叠、多元关系抽取、多义和歧义等问题中取得巨大进展. 因此, 本文的内容从基于图神经网络的关系抽取方法出发, 介绍关系抽取的特点、评价体系和常用数据集, 将关系抽取方法分为两大类, 分别阐述各个方法的核心思想以及优势与不足, 最后总结全文.

1 关系抽取 1.1 关系抽取的基本概念在自然语言处理领域, 关系一般是指文本中实体之间的关系, 如句法关系和语义关系. 因此, 关系抽取任务的主要目的是在从纯文本中提取实体之间有意义的关系信息.

实体之间的关系通常以关系三元组<E1, R, E2>的形式进行描述, 其中E1和E2是指实体的类型, 即主体与客体, R是指关系描述的类型. 即主体与客体之间的关系. 例如, “中国石油大学(华东)今年举办了运动会”, 则该语句中的E1为“中国石油大学(华东)”, E2为“运动会”, R为“举办”, 三元组为<中国石油大学(华东), 举办, 运动会>.

1.2 关系抽取的特点关系抽取的方法众多, 早期的关系抽取方法以基于规则的抽取方法为主, 此方法准确率高. 神经网络的出现, 使关系抽取的方法更加丰富, 包括基于监督、基于半监督、基于无监督以及基于远程监督[1,2]的方法. 各个方法的优缺点如表1所示.

| 表 1 关系抽取的方法比较 |

另外, 由于实体之间的关系类型繁多, 且实际场景中的关系错综复杂, 传统的简单关系抽取方法无法应对复杂场景的变化和复杂关系的建模, 比如多元关系抽取、关系重叠、嵌套关系抽取、多粒度关系抽取等问题.

由于不同的领域中的主要实体、事件等不尽相同, 因此不同领域之间的主要关系类型也不同. 例如, 学科领域主要的关系类型包括作者、单位、职称等关系类型, 自然灾害领域主要的关系类型包括因果、时间、并列等关系类型. 基于此, 针对不同领域的关系抽取方法也存在差异.

1.3 关系抽取任务的相关数据集用于关系抽取任务的数据集, 按照抽取的内容大小分类, 可分为句子级关系抽取数据集和文档级关系抽取数据集[3]. 按照数据集的语言分类, 可分为中文领域数据集和英文领域数据集. 大多数据集仅面向句子级关系抽取, 文档级关系抽取数据集较少, 如表2所示.

1.4 关系抽取的评价体系关系抽取任务常用的评价指标有精确率(Precision)、召回率(Recall)、F1值(F1). 其中把抽取结果集中正确抽取的记为TP (true positive), 错误抽取的记为FP (false positive)[4].

精准率指在所有预测为正例的样本中实际为正样本的比率, 计算公式如下:

| $ Precision = \frac{{TP}}{{TF + FP}} $ | (1) |

召回率又叫查全率, 指在所有正样本中预测正确的比率, 即正样本中模型找对了多少, 其计算公式为:

| $ Recall = \frac{{TP}}{{TP + FN}} $ | (2) |

F1值常被用来作为综合评价准确率和召回率的指标, 其计算公式为:

| $ F1 = \frac{{2\times Precision\times Recall}}{{Precision + Recall}} $ | (3) |

大多数方法使用精确率、召回率和F1值作为评估指标. 然而, 这样的评估存在一个问题, 即提取的正确关系没有出现在测试集中, 将被视为错误, 称为假阴性. 为了解决这个问题, 经常使用手动评估. 在人工注释器的帮助下, 现有的方法通常计算提取的前N个关系实例的精度.

| 表 2 关系抽取任务的相关数据集 |

2 图神经网络 2.1 图神经网络的介绍

传统的关系抽取方法大多依赖于规则和自然语言处理工具. 为了解决传统方法耗时、费力、准确性低的问题, Zeng等人[5]将卷积神经网络应用于关系抽取任务中. 同时为了减少对人工标注的依赖, Zeng等人[1]通过将知识库与非结构化文本对齐, 实现了自动构建训练数据, 减少了模型对人工标注数据的依赖, 增强了模型的跨领域的适应能力. 为了使模型更加关注有效信息, Lin等人[6]引入了图神经网络(GNN)来结合句子语义来表达关系, 并使用注意力机制来最大限度地减少样本中虚假标签的影响. 同时, 为了充分利用多个实体对之间的多跳依赖关系和句子中的隐含依赖信息, Zhu等人[7]将图神经网络引入到关系抽取任务中, 其中将节点表示实体, 关系与节点之间的路径相关联, 从而有效地解决了多跳关系推理的问题. 由此, 随着图神经网络的发展, 发现当其运用到关系抽取任务中时, 可以有效地表示实体之间的关系, 从而被广泛应用于关系抽取任务中.

GNN最早是由Scarselli等人[8]在2009年提出, 并通过Almeida-Pineda算法进行训练. 在句子中存在类似树或图的结构, 如依赖树和句法树, 这些句法树可以传递更丰富的结构信息, 有助于提取文本中实体之间的关系. 因此, 由于其突出的性能, 近年来已成为一种广泛应用的图分析方法[9], 图神经网络自然被用来对这种复杂的数据结构进行建模. 图神经网络的变体, 如图卷积网络(GCN)[10]、图注意力网络(GAT)[11]、图递归网络(GRN), 在许多关系抽取任务上表现出了突破性的性能. 其中, 运用最多的是图卷积网络和图注意力网络. 图神经网络的分类如图1所示.

|

图 1 图神经网络的分类 |

2.2 图卷积网络

近年来, GCN在自然语言处理任务中考虑依赖关系结构的方法被广泛应用. GCN的研究时间最长、成果最多, 是GNN最具代表性的模型, 它定义了对不规则图结构的卷积和读出操作, 以捕获常见的局部和全局结构模式. Marcheggiani等人[12]将GCN应用于词序列的语义角色标注任务上. Liu等人[13]通过GCN对长文档进行编码, 从而进行文本匹配. Cetoli等人[14]结合RNN和GCN来识别命名实体. Tian等人[15]提出的关系抽取模型A-GCN中运用了图卷积神经网络来区分重要的上下文信息. 另外, 图卷积神经网络可以将图和CNN结合在一起, 以此利用CNN来应用于图推理模型[10,16].

图卷积网络通过对相邻节点的特征进行卷积, 并将节点的信息传播给其最近的邻居. 通过堆叠GCN层, GCN可以提取每个节点的区域特征. GCN层通过考虑相邻节点的特征来检索新的节点特征, 公式如下:

| $ h_u^{l{\text{+1}}}{\text{ = }}ReLU\left(\sum\limits_{v \in N(u)}^{} ({W^l}h_v^l + {b^l})\right) $ | (4) |

其中, u是目标节点,

注意力机制已成功应用于许多基于序列的任务中, 如机器翻译[17]、机器阅读[18]、情感分析[19]等. 还有一些模型试图在图上推广注意力算子[11,20]. 与其他的算子相比, 基于注意力的算子为邻居分配了不同的权重, 这样不但可以减少噪声, 而且可以获得更好的结果.

图注意力网络(GAT)[11]将注意力机制纳入传播步骤, 它遵循自注意力策略, 通过关注其邻居来计算每个节点的隐藏状态. 节点v的隐藏状态可通过以下方式获得:

| $ {{h}}_v^{t + 1} = \rho \left(\sum\limits_{u \in {{N}_v}} {\alpha _{vu}}{{Wh}}_u^t\right) $ | (5) |

| $ {\alpha _{vu}} = \frac{{\exp ({{LeakyReLU}}({{{a}}^{\mathrm{T}}}[{{W}}{{{h}}_v}||{{W}}{{{h}}_u}]))}}{{\displaystyle\sum\limits_{k \in {N_v}} {\exp ({{LeakyReLU}}({{{a}}^{\mathrm{T}}}[{{W}}{{{h}}_v}||{{W}}{{{h}}_k}]))} }} $ | (6) |

其中, W是权重矩阵, a是单层MLP的权重向量.

此外, GAT利用多头注意力机制来稳定学习过程. 它应用K个独立的注意力头部矩阵来计算隐藏状态, 然后连接它们的特征(或计算平均值), 得到以下两个输出表示:

| $ {{h}}_v^{t + 1} = ||_{k = 1}^K\sigma \left(\sum\limits_{u \in {N_v}} {\alpha _{vu}^k} {{{W}}_k}{{h}}_u^t\right) $ | (7) |

| $ {{h}}_v^{t + 1} = \sigma \left(\frac{1}{K}\sum\limits_{k = 1}^K {\sum\limits_{u \in {N_v}} {\alpha _{vu}^k} {{{W}}_k}{{h}}_u^t} \right) $ | (8) |

其中,

根据输入的文本的类型可将关系抽取任务划分为: 句子级(sentence level)关系抽取、文档级(document level)关系抽取以及实体关系联合抽取方法. 句子级关系抽取是指三元组的两个实体在同一个句子中共现, 文档级关系抽取则是在一段完整的文档内进行关系抽取, 实体关系联合抽取方法则是将句中的实体抽取与关系抽取任务视为一个任务. 3种方法的侧重点各不相同, 下文将分别介绍几种具有代表性的方法.

3.1 句子级关系抽取方法 3.1.1 基于卷积运算的方法由于知识图谱天生不完整, 多数的现有知识图库都是稀疏的. 比如在Freebase中, 66%的人都是缺少出生地这一关系的, 由此引出了知识补全任务. Schlichtkrull等人[21]提出使用关系图卷积网络(R-GCN), R-GCN是GCN模型的扩展, 用于两个知识库的补全任务: 链接预测、实体分类. R-GCN模型由多个单层R-GCN模型、实体分类模型和链接预测模型组成. 实体分类模型在图中的每个节点上使用Softmax分类器, 分类器采用关系图卷积网络(R-GCN)提供的节点表示, 并预测标签. 该模型以及R-GCN的参数都是通过优化交叉熵损失学习得到的. 而链接预测模型可以看作是一个自编码器, 包括编码器和解码器两部分, 使用R-GCN产生节点的潜在表示, 以及张量分解模型Dist-Mult探索学习到的节点表达来预测边.

使用依赖树进行关系抽取, 可以更好解决目标实体之间的长距离问题, 但也存在着噪声. 因此, Tian等人[15]提出了一种基于注意力图卷积网络的依赖驱动关系提取方法(A-GCN). 首先从现成的依赖关系解析器中获取输入句子的依存关系树, 然后在依存关系树上构建图, 并为任意两个单词之间的不同标记依存关系分配不同的权重, 权重的计算基于连接及其依赖类型, 最后由 A-GCN 根据学习的权重预测关系. 这样做, A-GCN 不仅能够从依赖树中区分重要的上下文信息并相应地利用它们, 从而不需要依赖剪枝策略, 而且 A-GCN 还可以利用大多数先前忽略的依赖类型信息研究. 在ACE2005和SemEval2010两个数据集上的实验结果证明了A-GCN的有效性.

为了更好地学习节点之间的依赖关系, Li等人[22]提出通过基于注意力机制捕获上下文依赖关系, 并使用分布式强化学习来生成最优的关系信息表示, 来改进关系抽取任务. 这种方法被称为双注意力图卷积网络(DAGCN), 用于自适应地将局部特征与其全局相关性相集成. 具体来说, 在GCN之上附加了两种类型的注意力模块, 它们分别对空间维度和关系维度的语义相互依赖性进行建模. 位置注意力模块通过节点内部特征的所有位置处的特征的加权和来选择性地聚集每个位置处的特性. 同时, 关系注意力模块通过整合所有节点之间的相关特征, 选择性地强调相互依赖的节点关系. 将两个注意力模块的输出相加, 并使用强化学习来预测节点关系的分类, 以进一步改进特征表示, 从而有助于更精确地提取结果. 在TACRED和SemEval2010数据集上的实验结果表明, 该模型在各种评估指标上取得了较好的性能, 可以为关系抽取任务获得更多深层次的信息.

Guo等人[23]提出了一种基于注意力机制的图卷积网络——AGGCN模型, 该模型直接把一个完整的依赖树转换为全连接的权重图, 并将其作为输入, 区别于前者的修剪之后的输入, 称之为“软修剪”策略. 模型通过自注意力机制以端到端的形式学习所有边的权重, 可以做到选择性地保留有用的相关子结构.

AGGCN的框架图如图2所示, 由M个相同的块组成. 每个块由3种类型的层组成: 注意引导层、密集连接层和线性组合层. 模型的两个最大创新点在于注意引导层和密集连接层.

|

图 2 AGGCN框架图 |

Xue等人[24]提出了GDPNet模型. GDPNet利用潜在的多视图来捕获token之间各种可能的关系, 随之对这个图进行精炼以选择重要的词进行关系预测, 最后将改进的图表示和基于BERT模型的表示连接起来进行关系抽取. 同时提出了高斯图生成器(GGG)来生成多视图的边; 提出了一种图形池化方法DTWPool, 以灵活的池化比例细化从文本序列中学习到的潜在多视图. 在数据集DialogRE和TACRED上, 表明GDPNet在对话级和句子级事件抽取上都取得了较好的性能.

GDPNet的总体架构显示如图3所示. 其中有3个关键组件: BERT模块、图模块和Softmax分类器. BERT模块将令牌编码为相应的特性表示. 如图3所示, 图模块接受来自BERT的令牌表示, 并使用高斯图生成器构造一个多视图. 然后通过图卷积和DTWPool的多重交互对图进行细化. 最后, 将改进后的潜图输入Softmax分类器进行关系类型预测.

|

图 3 GDPNet框架图 |

先前的基于对话数据的关系抽取中, 没有充分利用说话者的信息. 因此, 可能导致未能对关键的话语间关系进行建模, 这些关系可能通过代词和触发词为相关论点实体提供额外的上下文信息. Chen等人[25]提出了一种基于图注意力网络的以归纳方式处理对话关系抽取的方法, 其中构建了包含有意义连接的说话者、实体、类型和话语节点的图. 该图被馈送到图注意力网络, 用于相关节点之间的上下文信息的传播, 从而有效地捕捉对话上下文. 在基准数据集DialogRE上的实验证明, 这种基于图的方法以显著优势优于目前最先进的方法, 有效地捕捉了对话中不同参数对之间的关系.

3.1.2 基于递归运算的方法在医学领域, 依赖树的准确性相对较低, 从而降低了它们的可用性. Song等人[26]提出了一种通过利用依赖森林来提升医学领域关系抽取的效果的方法. 森林包含许多可能的决策, 具有更高的召回率, 但噪声更大. 但将图递归神经网络用于表示森林, 能够有效区分有用的句法信息和噪声. 在两个生物医学关系抽取基准上的实验结果表明, 该方法优于标准的基于树的方法, 主要优势是实现了减轻域外解析错误.

同时, 远程监督的方法同时也暴露了其缺陷——存在错误标记的问题. Xie等人[27]提出了一种新的异构图神经网络(HGNN). HGNN是基于句子节点和实体节点, 通过句子节点将标签信息传递给相邻的实体节点, 实体节点可以充当句子和关系之间的桥梁, 并从这两种类型的节点中捕获丰富的领域信息. HGNN实现了当存在噪声数据和少量标注数据的情况下, 仍能保持较好的性能. 该实验在FewRel数据集上的结果表明, HGNN优于当时最优秀的基线模型. 句子级关系抽取方法比较见表3.

| 表 3 句子级关系抽取方法比较 |

3.2 文档级关系抽取方法 3.2.1 基于卷积运算的方法

句子间的关系抽取需要处理文档中的复杂语义关系, 这些关系需要局部、非局部、句法和语义依赖信息. Sahu等人[28]提出了一种新的句子间关系抽取模型, 该模型在文档级图上建立了带标签的图卷积神经网络模型. 该图使用各种句间和句内依赖关系来构建, 以此来捕获局部和非局部依赖关系信息. 为了预测实体对的关系, 使用了具有双仿射成对评分的多实例学习. 实验结果表明, 该模型在CDR和CHR两个数据集上实现了与最先进的神经模型相当的性能, 并且证明图中的所有边的类型对于句间关系抽取均为有效.

传统的GCN只采用词节点和邻接矩阵来表示图, 很难在长距离的实体对之间建立直接联系. Zhou等人[29]提出了一种全局上下文增强的图卷积网络——GCGCN, 该模型引入了实体对的上下文作为实体节点之间的边, 以此来对文档中多个实体之间的复杂语义交互进行建模. 同时, 利用一个大规模的远程监督数据集来预训练GCGCN模型, 然后通过对人工注释数据集进行微调, 以进一步提高文档级关系抽取的性能. 在DocRED数据集上的实验结果表明, 该模型可以有效地捕捉文档中丰富的全局上下文信息.

Zeng等人[30]首次提出了一种图聚合推理网络——GAIN, 来更好地处理文档级的关系提取. GAIN构造了两个图, 一个是异构的提及图, 另一个是实体级图. 前者利用图卷积神经网络学习来建模不同提及之间的复杂互动, 后者聚合了相同实体的潜在提及. 基于此, 提出了一种新的路径推理机制来推断实体之间的关系. 在公共数据集DocRED上的实验表明, 与之前的最先进技术相比, GAIN实现了显著的性能改进.

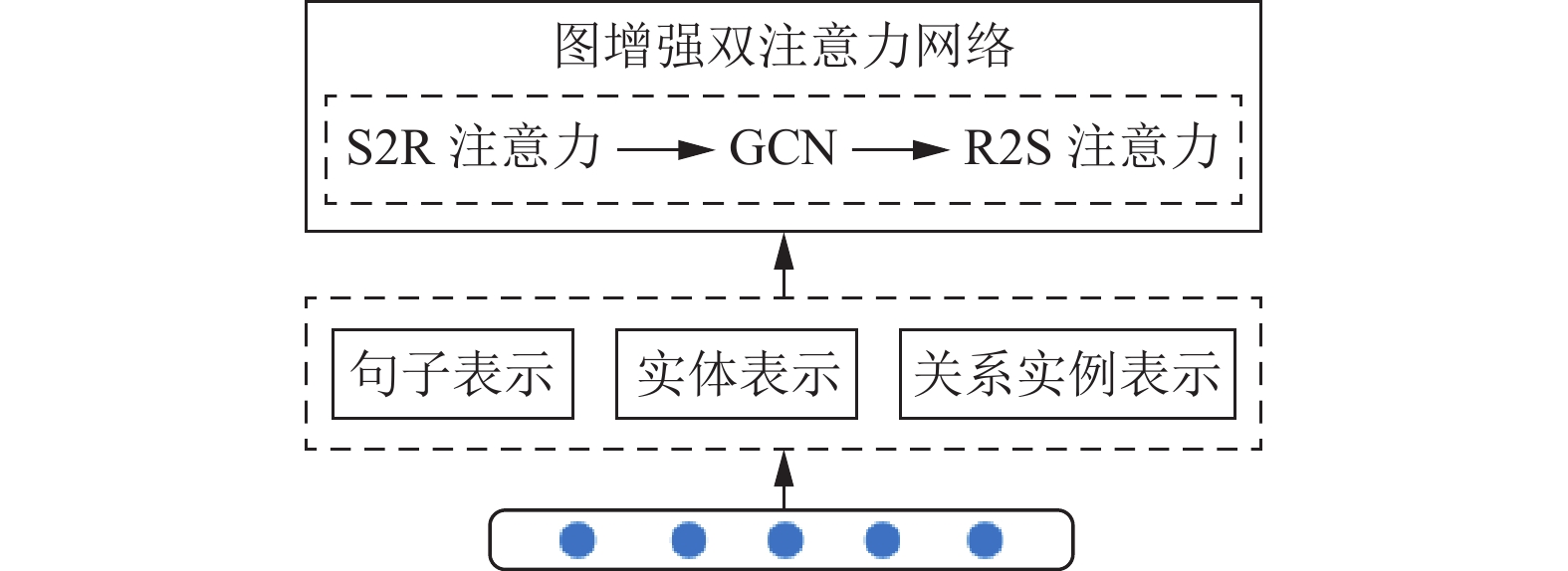

文档级关系提取需要语句间推理能力来捕获多个关系事实的局部和全局上下文信息. Li等人[31]提出了通过图增强双注意力网络——GEDA (见图4), 来更好地描述句子和关系实例之间的相互作用, 以改进整个文档的句子间推理. 在GEDA中, 由句子到关系(S2R)注意力生成的句子表示在被馈送到关系到句子(R2S)的注意力之前, 由异构图卷积网络进行细化和合成. GEDA的新颖之处主要在于基于图的句子表示精化, 以及分别基于注意力对偶和支持证据的两个简单而有效的正则化器. 实验验证了图增强双重注意力机制的优越性, 特别是在句间关系提取方面.

|

图 4 GEDA模型 |

基于图的方法取得了非常好的效果, 但是这些方法通常把所有实体对的重要程度都是看作是同等的, 而忽略了实体对之间是否存在关系, 这会影响编码器的注意力效果. Xu等人[32]于2021年提出了一种路径重构方法, 在不需要额外语法知识的情况下把输入的文档转化为一个异构图, 然后使用图注意力神经网络来编码图信息. 并从图中计算重构路径的概率来进行指示, 重建每个实体对的路径依赖. 把重构路径概率值作为对实体对之间是否有关系的判断, 计算一个预测损失, 最大化有关系的概率, 最小化无关系的概率. 在推理阶段, 把该概率值作为预测的一部分来帮助对该对实体间关系的判断, 通过重构路径的方法, 让模型更加关注于有关系的实体对, 从而提高模型的效果.

3.2.2 基于递归运算的方法过去在关系抽取方面的工作主要集中在单句中的二元关系上. 基于对抽取跨多个句子的n元关系的问题, Peng等人[33]提出了一种基于图长短期记忆网络(图LSTM)的通用关系抽取框架, 该框架可以很容易地扩展到跨句子的n元关系抽取. 该框架为探索不同的LSTM方法提供了一种统一的方法, 并结合了各种句内和句间依赖关系, 如顺序关系、句法关系和话语关系. 学习实体的上下文表示, 作为关系分类器的输入. 这不仅简化了对关系的处理, 而且实现了具有相关关系的多任务学习.

跨句n元关系抽取的典型方法是将输入转换为文档图, 集成各种句子内和句子间的依赖关系. 其中一种方法是将输入图拆分为两个DAG, 每个DAG采用DAG结构的LSTM. 尽管能够通过边来对语义知识进行建模, 但是重要信息可能会在分割过程中丢失. 因此, Song等人[34]在Peng等人[33]的基础上提出了一种图形状态LSTM模型, 该模型使用并行状态对每个单词进行建模, 通过消息传递机制不断更新状态值. 与DAG-LSTM相比, 该模型具有几个优势. 首先, 它不会改变输入图的结构, 因此不会丢失任何信息. 例如, 在计算节点的上下文向量时, 它可以很容易地合并同级信息. 其次, 它具有更好的并行性.

现有的文档级关系抽取方法大多是使用基于图的神经模型, 将单词作为节点, 将边缘作为它们之间的关系, 来编码句子之间的关系. 这些模型大多是基于节点的, 然而实体间的关系可以通过节点之间的路径形成的唯一的边表示来得到更好的表达. 因此, 在Verga等人[35]提出的双仿射关系注意力模型基础上, Christopoulou等人[36]提出了一种用于文档级关系提取的面向边的图神经网络模型. 该模型利用不同类型的节点和边来构建异质图, 同时利用图边上的推理机制, 使用多实例学习来对句内和句间关系进行建模. 这是第1次将面向边的模型用于文档级关系抽取的方法. 实验结果表明, 所提出的异质图可以有效地编码实体之间的依赖关系.

文档级关系抽取模型一般使用通用多跳卷积神经网络对实体对之间的关系的推理方法进行隐式的建模. Xu等人[37]于2021年提出了一个新颖的判断推理框架(HeterGSAN)来显式地对这些推理方法进行建模, 并提取出它们的推理路径. 该框架通过引入判别推理神经网络、基于构建的异构图和向量化的源实文档, 对推理路径进行建模, 从而通过分类器实现关系识别. 这是首次通过显式建模不同的推理方法来增强文档级关系抽取的性能. 该框架在大规模DocRE数据集上的实验结果表明了有效性. 文档级关系抽取方法比较见表4.

| 表 4 文档级关系抽取方法比较 |

3.3 实体关系联合抽取方法

上述方法主要侧重于在预先给定实体的情况下从文本中抽取关系. 然而, 从知识图谱构建的角度来看, 我们仍然需要先从文本中识别或抽取实体. 大多早期的方法, 通常采用流水式抽取(pipeline)[38,39], 逐步抽取实体及其关系. 但是, 这种方法会存在错误传播的问题. 因此, 学者们开始提出联合抽取[40]的方法, 这种方法假设实体抽取和关系抽取两个任务是相关联的, 并且可以相互促进. 有依靠NLP工具进行特征工程以进行联合提取[41], 也有应用神经网络联合提取实体和关系[42]. 然而, 当句子中存在多个不同的实体关系组时, 这些方法的效果并不是很好.

Zheng等人[43]提出了将实体关系联合抽取视为一个标记问题, 使用BIO对序列进行标注, 并基于这些标注可以输出用于实体关系抽取任务所需的三元组. 其中, 定义的标注的总数为N=2×4×|R|+1, |R|表示定义关系的数量.

为了解决关系重叠和实体重叠的问题, Fu等人[44]提出了一种采用图卷积网络联合学习命名实体和关系的端到端关系提取模型GraphRel. 该模型使用关系加权GCN来考虑命名实体和关系的相互作用, 以改进关系提取. 除了使用完整的词图来提取文本中所有词对之间的隐式特征外, 还使用线性和依赖结构来提取文本的顺序特征和局部特征. 在NYT和WebNLG两个数据集上的测试表明, GraphRel在保持较高准确率的同时, 显著提高了召回率.

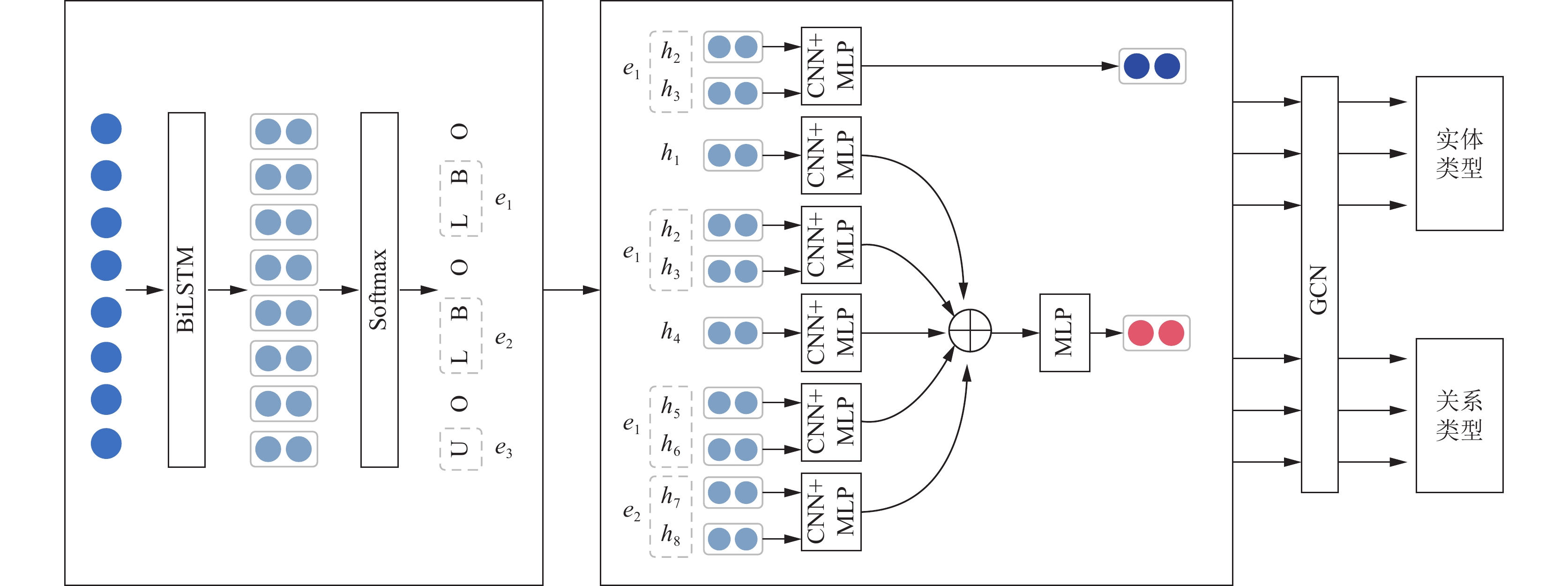

Sun等人[45]提出了一种新的实体关系联合抽取任务的范式(图5). 它首先识别实体跨度, 然后对实体类型和关系类型进行联合推理. 并为了解决联合抽取任务, 提出了一种新的运行在实体关系二分图上的图卷积网络. 通过引入二元关系分类任务[46], 能够更有效地利用实体关系二分图的结构. 在ACE2005上的实验表明, 该模型在实体抽取性能方面和关系抽取性能方面都实现了可观的效果.

|

图 5 Sun等人[45]提出的模型 |

Yuan等人[47]提出了一种基于边缘增强图对齐网络(EGAN)和词对关系标签(WPRT)的多模态实体关系联合抽取方法. EGAN通过增强图的边缘表示来提高图的对齐能力, 以更好地捕捉跨模态的信息. EGAN采用自注意力机制来计算每个节点的自注意力向量, 并将这些向量作为输入, 通过循环神经网络进行更新, 以生成每个节点的最终表示. WPRT通过为每个词对定义一组关系标签, 以对词之间的关系进行建模. WPRT使用双向长短期记忆网络(BiLSTM)来预测两个词之间的关系, 并使用交叉熵损失函数进行优化. 此外, 该方法还引入了一个双向条件随机场模型(BiCRF), 用于进一步约束词对之间的关系. 该方法在多个公开数据集上进行了实验验证, 结果表明该方法能够有效地进行多模态实体关系联合抽取方法.

3.4 基于图神经网络的关系抽取方法的应用基于图神经网络的关系抽取方法具有广泛的应用领域和重要的理论价值, 其中最为重要的应用领域是自然语言处理、信息检索、问答系统和生物信息学等.

在自然语言处理领域中, 关系抽取任务是抽取文本中实体之间的关系, 这对于后续的知识推理、问答系统等任务非常重要. 基于图神经网络的关系抽取方法可以利用实体和关系构成的图结构, 学习实体的表示向量, 从而识别出文本中的命名实体和实体之间的关系.

在信息检索领域中, 基于图神经网络的关系抽取方法可以用于信息检索任务, 通过抽取文本中的实体和关系信息, 构建知识图谱, 从而提供更加准确和智能的信息检索服务.

在问答系统领域中, 问答系统需要在大量信息中快速准确地找到答案. 基于图神经网络的关系抽取方法可以用于构建知识图谱, 提供实体和关系的语义信息, 从而支持问答系统的实现.

在生物信息学领域中, 涉及了大量的生物实体和关系, 基于图神经网络的关系抽取方法可以用于抽取生物实体之间的关系, 为后续的生物医学研究和疾病诊断等任务提供支持.

此外, 基于图神经网络的关系抽取方法还可以应用于社会网络分析、金融领域中的风险管理、电子商务中的产品推荐等领域.

4 总结与展望依赖于图神经网络的优势, 关系抽取方法的研究于近几年得到广泛关注和飞速发展, 关系抽取的模型也得到不断完善和性能上的提升, 并逐步走向各个领域的实际应用场景中, 实现预测、推理等功能. 该方法将关系抽取任务转化为图神经网络模型进行处理, 利用图神经网络强大的图表示学习和节点表示学习能力, 自动从文本中提取出实体之间的关系. 相较于传统方法, 在效率上、准确性上都得到了较大的发展.

基于图神经网络的关系抽取方法的一般流程如下: (1)将文本中的实体和关系转化为图: 将文本中的实体和关系转化为图, 其中实体和关系作为图的节点, 实体之间的关系作为图的边. (2)利用图神经网络进行图表示学习: 将上一步生成的图输入到图神经网络模型中进行表示学习, 图神经网络通过对节点和边的交互计算, 学习出每个节点的表示向量. (3)根据节点表示进行关系抽取: 根据上一步学习出的节点表示, 通过一定的判别模型, 如分类器、回归器等, 对节点之间的关系进行判断和抽取.

该类方法的主要优点包括: (1)自动性强: 基于图神经网络的关系抽取方法可以自动从文本中提取出实体之间的关系, 不需要人工干预. (2)处理复杂关系能力强: 图神经网络可以对复杂的关系进行建模和处理, 能够处理多种类型的关系. (3)性能优越: 图神经网络在进行表示学习和关系抽取时, 可以充分利用数据的结构信息, 相比传统的关系抽取方法, 具有更好的性能和准确率.

然而, 基于图神经网络的关系抽取方法也存在一些挑战和问题. 第一, 从早期的模式匹配到现有的神经网络模型, 关系抽取方法已经取得重大进展. 随着“信息爆炸”的出现, 人类的知识数量正在以指数型增长, 这也对关系抽取方法提出了新的要求. 我们需要一个能够稳健地利用更多信息, 有效地学习更多、更复杂的关系, 并能灵活、方便地运用到更开放的领域中, 更复杂和精细的图神经网络模型来建模不同类型的关系.

第二, 在数据集方面, 关系抽取方面的面向领域的标注数据相对较少, 这使得模型训练的样本有限, 实体和关系之间的连接可能稀疏, 容易导致过拟合, 影响模型的泛化能力. 正负样本之间也存在严重的不平衡问题, 会影响模型的分类性能. 且由于语言本身以及不同领域之间的多样性和复杂性, 标注数据的质量也难以保证.

第三, 不同的数据集和任务之间可能具有不同的特点和结构, 如何设计一个通用的图神经网络架构以适应不同的数据集和任务也是一个挑战. 此外, 如何将图神经网络与其他类型的关系抽取方法(如基于规则的方法、模板匹配方法等)相结合也是一个重要的研究方向.

相信随着对图神经网络这一领域更加深入的研究与探索, 关系抽取的发展将会得到质的飞跃, 人工智能领域的版图也将得到更大扩展.

| [1] |

Zeng DJ, Liu K, Chen YB, et al. Distant supervision for relation extraction via piecewise convolutional neural networks. Proceedings of the 2015 Conference on Empirical Methods in Natural Language Processing. Lisbon: Association for Computational Linguistics, 2015. 1753–1762.

|

| [2] |

Li Y, Long GD, Shen T, et al. Self-attention enhanced selective gate with entity-aware embedding for distantly supervised relation extraction. Proceedings of the 34th AAAI Conference on Artificial Intelligence. Palo Alto: AAAI Press, 2020. 8269–8276.

|

| [3] |

冯钧, 魏大保, 苏栋, 等. 文档级实体关系抽取方法研究综述. 计算机科学, 2022, 49(10): 224-242. DOI:10.11896/jsjkx.211000057 |

| [4] |

袁清波, 杜晓明, 杨帆. 限定域关系抽取研究综述. 计算机系统应用, 2021, 30(9): 24-40. DOI:10.15888/j.cnki.csa.008079 |

| [5] |

Zeng DJ, Liu K, Lai SW, et al. Relation classification via convolutional deep neural network. Proceedings of the 25th International Conference on Computational Linguistics: Technical Papers. Dublin: Dublin City University and Association for Computational Linguistics, 2014. 2335–2344.

|

| [6] |

Lin YK, Shen SQ, Liu ZY, et al. Neural relation extraction with selective attention over instances. Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Berlin: Association for Computational Linguistics, 2016. 2124–2133.

|

| [7] |

Zhu H, Lin YK, Liu ZY, et al. Graph neural networks with generated parameters for relation extraction. Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. Florence: Association for Computational Linguistics, 2019. 1331–1339.

|

| [8] |

Scarselli F, Gori M, Tsoi AC, et al. The graph neural network model. IEEE Transactions on Neural Networks, 2009, 20(1): 61-80. DOI:10.1109/TNN.2008.2005605 |

| [9] |

Zhou J, Cui GQ, Hu SD, et al. Graph neural networks: A review of methods and applications. AI Open, 2020, 1: 57-81. DOI:10.1016/j.aiopen.2021.01.001 |

| [10] |

Kipf TN, Welling M. Semi-supervised classification with graph convolutional networks. arXiv:1609.02907, 2017.

|

| [11] |

Velikovi P, Cucurull G, Casanova A, et al. Graph attention networks. arXiv:1710.10903, 2018.

|

| [12] |

Marcheggiani D, Titov I. Encoding sentences with graph convolutional networks for semantic role labeling. Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing. Copenhagen: Association for Computational Linguistics, 2017. 1506–1515.

|

| [13] |

Liu B, Zhang T, Niu D, et al. Matching long text documents via graph convolutional networks. arXiv:1802.07459, 2018.

|

| [14] |

Cetoli A, Bragaglia S, O’Harney AD, et al. Graph convolutional networks for named entity recognition. Proceedings of the 16th International Workshop on Treebanks and Linguistic Theories. Prague, 2017. 37–45.

|

| [15] |

Tian YH, Chen GM, Song Y, et al. Dependency-driven relation extraction with attentive graph convolutional networks. Proceedings of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing (Volume 1: Long Papers). Association for Computational Linguistics, 2021. 4458–4471.

|

| [16] |

Chen XJ, Jia SB, Xiang Y. A review: Knowledge reasoning over knowledge graph. Expert Systems with Applications, 2020, 141: 112948. DOI:10.1016/j.eswa.2019.112948 |

| [17] |

Bahdanau D, Cho K, Bengio Y. Neural machine translation by jointly learning to align and translate. arXiv:1409.0473, 2016.

|

| [18] |

Cheng JP, Dong L, Lapata M. Long short-term memory-networks for machine reading. Proceedings of the 2016 Conference on Empirical Methods in Natural Language Processing. Austin: Association for Computational Linguistics, 2016. 551–561.

|

| [19] |

Yuan L, Wang J, Yu LC, et al. Graph attention network with memory fusion for aspect-level sentiment analysis. Proceedings of the 1st Conference of the Asia-Pacific Chapter of the Association for Computational Linguistics and the 10th International Joint Conference on Natural Language Processing. Suzhou: Association for Computational Linguistics, 2020. 27–36.

|

| [20] |

Zhang JN, Shi XJ, Xie JY, et al. GaAN: Gated attention networks for learning on large and spatiotemporal graphs. arXiv:1803.07294, 2018.

|

| [21] |

Schlichtkrull M, Kipf TN, Bloem P, et al. Modeling relational data with graph convolutional networks. arXiv:1703.06103, 2017.

|

| [22] |

Li ZX, Sun YR, Zhu JW, et al. Improve relation extraction with dual attention-guided graph convolutional networks. Neural Computing and Applications, 2021, 33(6): 1773-1784. DOI:10.1007/s00521-020-05087-z |

| [23] |

Guo ZJ, Zhang Y, Lu W. Attention guided graph convolutional networks for relation extraction. Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. Florence: Association for Computational Linguistics, 2019. 241–251.

|

| [24] |

Xue FZ, Sun AX, Zhang H, et al. GDPNet: Refining latent multi-view graph for relation extraction. arXiv:2012.06780, 2020.

|

| [25] |

Chen H, Hong PF, Han W, et al. Dialogue relation extraction with document-level heterogeneous graph attention networks. arXiv:2009.05092, 2021.

|

| [26] |

Song LF, Zhang Y, Gildea D, et al. Leveraging dependency forest for neural medical relation extraction. arXiv:1911.04123, 2019.

|

| [27] |

Xie YX, Xu H, Li JE, et al. Heterogeneous graph neural networks for noisy few-shot relation classification. Knowledge-based Systems, 2020, 194: 105548. DOI:10.1016/j.knosys.2020.105548 |

| [28] |

Sahu SK, Christopoulou F, Miwa M, et al. Inter-sentence relation extraction with document-level graph convolutional neural network. Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. Florence: Association for Computational Linguistics, 2019. 4309–4316.

|

| [29] |

Zhou HW, Xu YB, Yao WH, et al. Global context-enhanced graph convolutional networks for document-level relation extraction. Proceedings of the 28th International Conference on Computational Linguistics. Barcelona: International Committee on Computational Linguistics, 2020. 5259–5270.

|

| [30] |

Zeng S, Xu RX, Chang BB, et al. Double graph based reasoning for document-level relation extraction. Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing (EMNLP). Association for Computational Linguistics, 2020. 1630–1640.

|

| [31] |

Li B, Ye W, Sheng ZH, et al. Graph enhanced dual attention network for document-level relation extraction. Proceedings of the 28th International Conference on Computational Linguistics. Barcelona: International Committee on Computational Linguistics, 2020. 1551–1560.

|

| [32] |

Xu W, Chen KH, Zhao TJ. Discriminative reasoning for document-level relation extraction. Proceedings of the 2021 Findings of the Association for Computational Linguistics: ACL-IJCNLP 2021. Association for Computational Linguistics, 2021. 1653–1663.

|

| [33] |

Peng NY, Poon H, Quirk C, et al. Cross-sentence N-ary relation extraction with graph LSTMs. arXiv:1708.03743, 2017.

|

| [34] |

Song LF, Zhang Y, Wang ZG, et al. N-ary relation extraction using graph-state LSTM. Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. Brussels: Association for Computational Linguistics, 2018. 2226–2235.

|

| [35] |

Verga P, Strubell E, McCallum A. Simultaneously self-attending to all mentions for full-abstract biological relation extraction. Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long Papers). New Orleans: Association for Computational Linguistics, 2018. 872–884.

|

| [36] |

Christopoulou F, Miwa M, Ananiadou S. Connecting the dots: Document-level neural relation extraction with edge-oriented graphs. Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP). Hong Kong: Association for Computational Linguistics, 2019. 4925–4936.

|

| [37] |

Xu W, Chen KH, Zhao TJ. Document-level relation extraction with reconstruction. Proceedings of the 35th AAAI Conference on Artificial Intelligence. Palo Alto: AAAI Press, 2021. 14167–14175.

|

| [38] |

Zelenko D, Aone C, Richardella A. Kernel methods for relation extraction. Proceedings of the 2002 Conference on Empirical Methods in Natural Language Processing. Association for Computational Linguistics, 2002. 71–78.

|

| [39] |

Chan YS, Roth D. Exploiting syntactico-semantic structures for relation extraction. Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics: Human Language Technologies. Portland: Association for Computational Linguistics, 2011. 551–560.

|

| [40] |

Zhao TY, Yan Z, Cao YB, et al. Asking effective and diverse questions: A machine reading comprehension based framework for joint entity-relation extraction. Proceedings of the 29th International Joint Conference on Artificial Intelligence. Yokohama, 2021. 3948–3954.

|

| [41] |

Yu XF, Lam W. Jointly identifying entities and extracting relations in encyclopedia text via a graphical model approach. Proceedings of the 23rd International Conference on Computational Linguistics. Beijing: Coling 2010 Organizing Committee, 2010. 1399–1407.

|

| [42] |

Zhang MS, Zhang Y, Fu GH. End-to-end neural relation extraction with global optimization. Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing. Copenhagen: Association for Computational Linguistics, 2017. 1730–1740.

|

| [43] |

Zheng SC, Wang F, Bao HY, et al. Joint extraction of entities and relations based on a novel tagging scheme. Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Vancouver: Association for Computational Linguistics, 2017. 1227–1236.

|

| [44] |

Fu TJ, Li PH, Ma WY. GraphRel: Modeling text as relational graphs for joint entity and relation extraction. Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. Florence: Association for Computational Linguistics, 2019. 1409–1418.

|

| [45] |

Sun CZ, Gong YY, Wu YB, et al. Joint type inference on entities and relations via graph convolutional networks. Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. Florence: Association for Computational Linguistics, 2019. 1361–1370.

|

| [46] |

孙长志. 基于深度学习的联合实体关系抽取 [博士学位论文]. 上海: 华东师范大学, 2019.

|

| [47] |

Yuan L, Cai Y, Wang J, et al. Joint multimodal entity-relation extraction based on edge-enhanced graph alignment network and word-pair relation tagging. Proceedings of the 37th AAAI Conference on Artificial Intelligence. Washington: AAAI Press, 2023. 11051–11059.

|

2024, Vol. 33

2024, Vol. 33