2. 广东佛山联创工程研究生院 软件专业部, 佛山 528300

2. Software Department, Guangdong Foshan Lianchuang Engineering Graduate School, Foshan 528300, China

图像语义分割是一种像素级别的分类任务, 旨在根据图像中每个像素点的语义含义进行分类, 并对各个类别赋予不同的语义标签[1]. 室内场景分割存在语义类别较多、物体特征不突出、光照不均匀等问题[2]. 随着深度传感器的普及, 采集的图像信息从彩色信息扩展到了 RGB-D 信息. RGB图像能够描述物体颜色和纹理之类的外观信息, 而深度图像能够描述物体的三维几何信息, 这种信息很难在RGB特征中提取并且不会随着光照的变化而变化. 近年来, 很多研究将颜色信息和深度信息结合起来用于语义分割任务, RGB-D 图像语义分割引入了对RGB数据进行补充的深度信息, 可以有效提高室内场景语义分割的性能[3].

1 相关工作随着深度学习的发展, 在RGB-D语义分割网络领域中也涌现了很多优秀的算法. 早期Gupta等人[4,5]将深度图编码成水平视差、地面高度和重力与表面法线之间的角度3个通道, 这种编码方式后来在其他算法中得到了广泛的应用, 但是该方法忽略了各个通道的独立成分, 具有一定局限性. 后来, 多层残差特征融合网络RedNet采用双分支架构, 将残差模块作为基本的模块应用于编码器和解码器, 并用元素求和的方式进行特征融合, 取得了不错的效果 [6]. 而在2019年发布的注意力互补网络ACNet[7]则首次利用了三平行分支的网络架构, 较好地平衡了RGB-D图像中RGB图像特征和深度图像特征, 有效利用了融合特征. Wu等人[8]在2022年提出了一种新的框架, 将深度信息纳入RGB卷积神经网络之中, 该网络能够生成一个2D的深度偏移量以指导RGB图像上的特征提取, 并引入了深度适应卷积和深度适应平均池化来取代基本的CNN运算符. Bai等人[9]则考虑深度数据的几何信息和局部相关性, 提出了一个像素差分卷积注意模块, 并将其扩展到集成差分卷积注意力, 使得网络能够传播长距离上下文依赖关系. 赵经阳等人[10]提出了一个可以自适应调整深度信息嵌入程度的特征提取模块, 能够更加合理地利用深度信息.

上述方法虽然在RGB-D语义分割任务中取得了不错的效果, 但仍然存在着一些不足.

第一, 大多数采用编码器-解码器架构的语义分割算法中, 编码器降低了空间维度, 提高了通道维度. 这种结构在编码器阶段就会因为空间维度的降低而造成部分特征损失, 进而造成分割性能上的降低.

第二, 由于深度传感器的物理特性, 深度信息中包含大量异常噪声特征, 直接利用时将会带来负面影响, 产生的不精确性可能会抵消引入深度图所带来的性能提高[10].

第三, 由于深度特征和RGB特征描述的信息差异很大, 因此对语义分割的贡献也有主要和次要之分, 过于简单的元素相加或者权值拼接等方式会融入过多的深度信息, 可能会对网络产生干扰.

基于上述, 为进一步有效融合深度信息, 提高室内复杂场景分割的性能, 本文提出了一种基于编码-解码架构的RGB-D分割网络, 并在NYUDv2数据集上进行训练和测试, 取得了不错的效果.

2 网络模型本文提出的融合深度信息的RGB-D语义分割网络模型的整体结构如图1所示, 主干网络为两个并行的卷积分支, 分别从RGB图和深度图提取特征, 并在编码器中添加极化注意力机制和双模态融合模块以减少特征损失并有效融合多模态信息. 将特征提取网络提取的特征送入深度聚合金字塔池化模块以聚合上下文信息, 获取区域之间的依赖关系. 最后, 通过跳跃连接聚合不同尺度特征, 使用3个解码器将特征图映射成要判别的类别, 再通过上采样操作逐步恢复图像分辨率. 就其内部4个主要模块介绍如下.

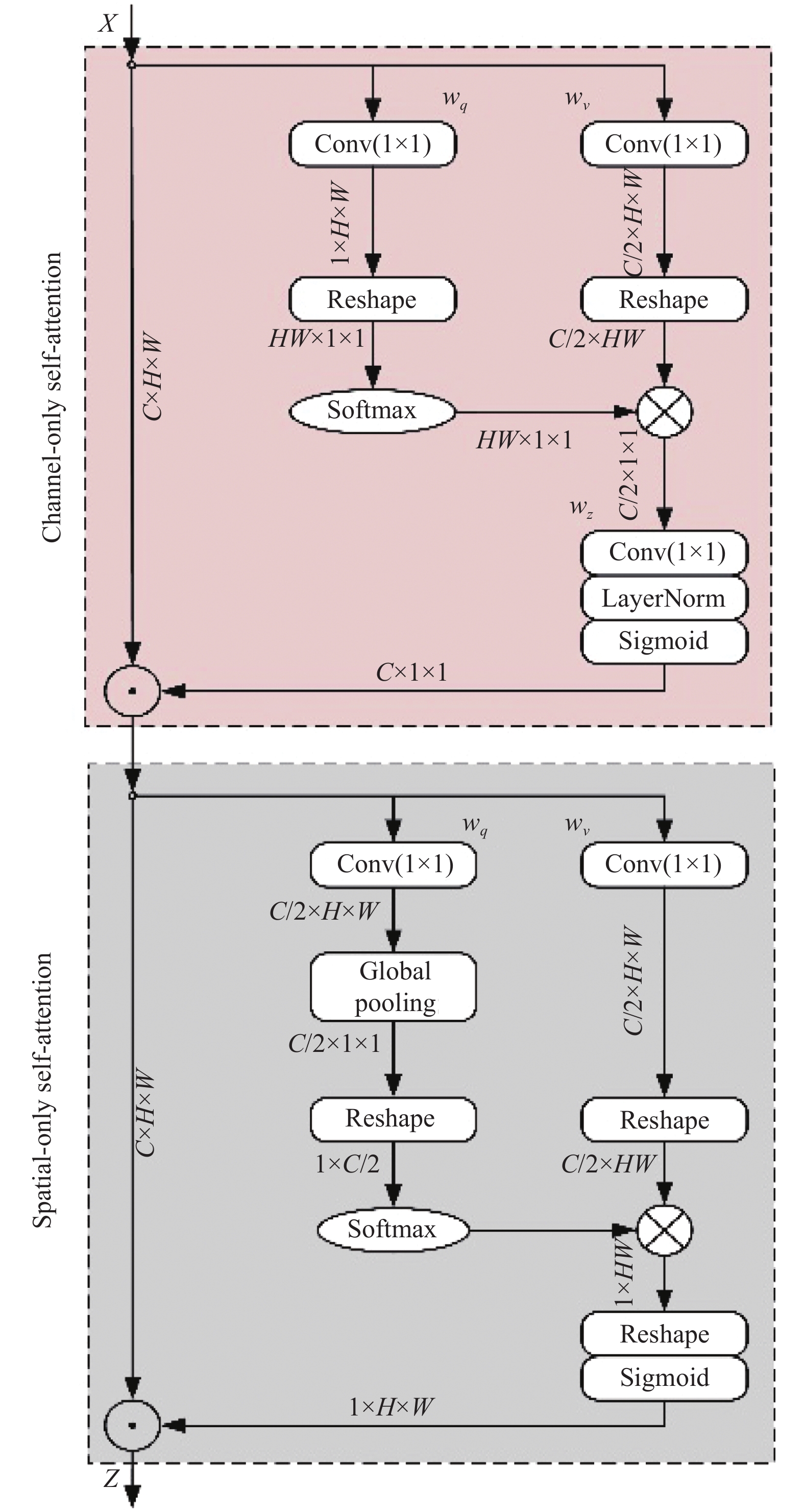

2.1 PSA极化注意力机制为了解决在编码器-解码器结构下语义分割的空间特征损失问题, 本文引入了一个极化注意力模块 (polarized self-attention, PSA)[11], 参考文献[11]中介绍的使用方法, 仅在RGB分支中的3×3卷积后添加PSA 注意力. 实验证明, 网络仅增加了少量的计算开支和参数数量, 却有效提高网络分割性能.

PSA是针对像素级回归任务提出的一种双重注意力机制, 用于增强或者抑制部分特征信息. 受极化滤波思想的启发, PSA具体可分为两个点: 第1点是极化滤波, 使图像的特征在一个维度方向上完全折叠, 同时让其正交方向的维度上保持高分辨率, 其主要作用就是在空间和维度两个分支上分别保持较高的分辨率, 降低由空间维度降低带来的特征损失. 第2点是特征增强, 采用Softmax进行归一化, 再使用Sigmoid函数增加注意力的动态范围, 能够更加真实地拟合输出分布.

图2所示为本文所采用的顺序结构的PSA, 上边为通道分支, 下边为空间分支, 输入和输出均为C×H×W. 在通道分支上, 先将输入特征X经过1×1卷积后转换为Q和V, Q的通道被全部压缩, 而V的通道则保持C/2. 经过Softmax函数后对Q的信息进行增强, 并增加注意力的范围, 然后将Q和V做矩阵乘法运算, 再经过1×1卷积, LN层将通道数量还原为C, 最后使用Sigmoid函数进行动态映射. 经过通道分支之后, 输出

|

图 1 网络总体框架图 |

|

图 2 PSA顺序结构 |

2.2 双模态特征融合模块BFM

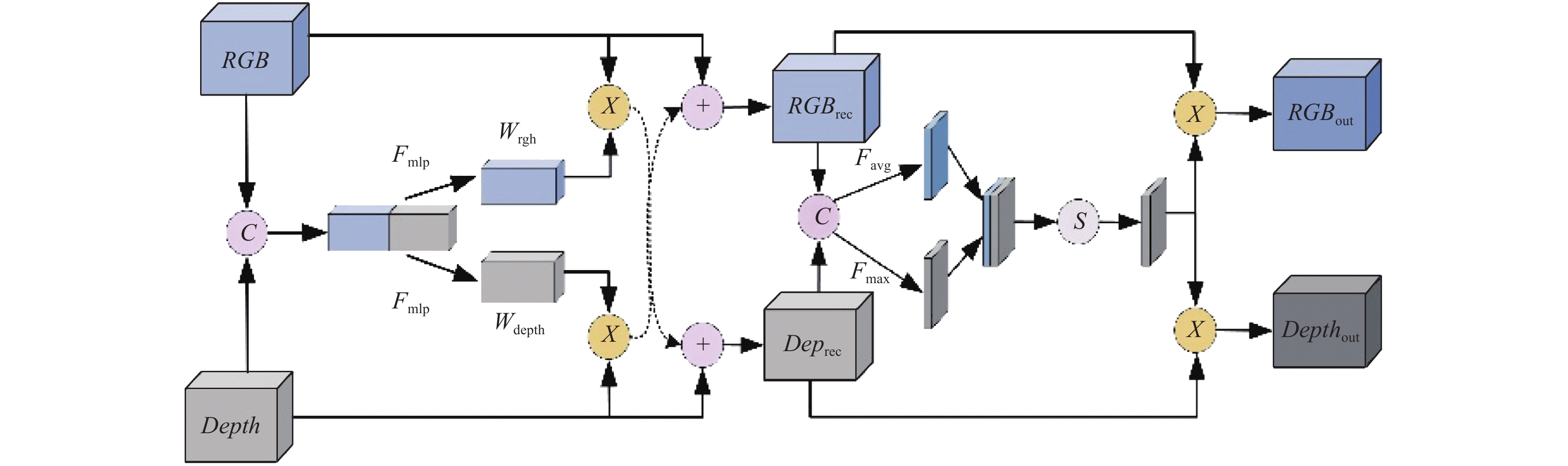

在网络模型中, 由于深度图像与RGB图像之间的差异性, 两种图像特征信息的融合是一个极大的挑战. 一个有效的双模态特征融合方法应该能从每个特征中识别出它们的优势, 将信息量最大的跨模态特征统一到有效的表示中. 受SA-Gate[12]和空间注意力机制的启发, 为了充分利用深度信息, 本文设计了一个双模态特征融合模块(bimodal feature fusion module, BFM), 该模块不仅可以有效地校准RGB特征, 而且还可以通过多个阶段来提取准确的深度信息, 将两者交替合并生成融合特征. 为了确保模态之间的信息特征传播, BFM被设计为具有两个操作, 即单一模态的特征校准和跨模态特征融合, 如图3所示.

特征校准: 该部分借鉴SA-Gate中的特征校准操作, 首先将两种模态的特征图

| W=σ(Fmlp(Fgp(RGBin||Depin))) | (1) |

| RGBrec=Depin×Wdepth+RGBin | (2) |

| Deprec=RGBin×Wrgb+Depin | (3) |

特征融合: 为了充分利用RGB特征和深度特征的互补性, 需要根据它们的表征能力在空间的某个位置互补地聚合双模态特征. 该部分首先将校准后的特征进行拼接操作, 得到一个新的特征模块, 接着对其进行平均池化AvgPool和最大池化MaxPool操作, 得到两个维度为1×H×W的空间注意力向量, 然后对两个向量进行拼接, 拼接后的向量维度为2×H×W, 最后对该向量进行卷积和Sigmoid激活函数操作, 并与校准后的特征

| F=[Avg(RGBrec||Deprec),Max(RGBrec||Deprec)] | (4) |

| RGBout=RGBrec⊗σ(convF) | (5) |

| Depthout=Deprec⊗σ(convF) | (6) |

输出的

|

图 3 双模态融合模块BFM |

2.3 上下文模块

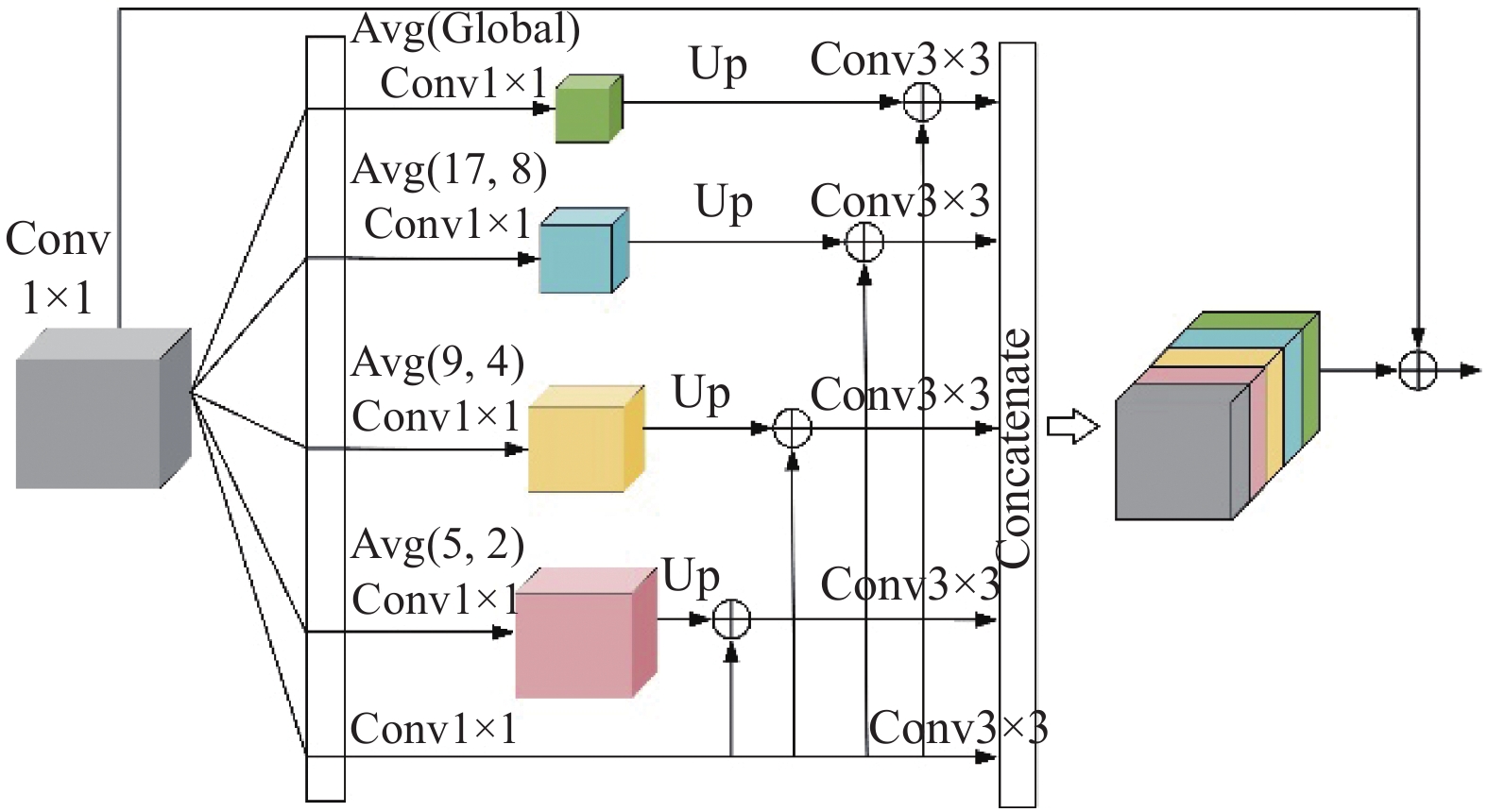

一幅图像中任何一个像素都与周围像素存在一定的关系, 大量像素的关联才形成了图像中的各种物体, 但是在经过残差网络对特征的提取和双模态特征融合之后, 由于不同感受野的语境关系和部分上下文信息的缺失会导致易混淆的物体和小尺寸物体的错误分类 [13], 针对这个问题, 本文在模型的编码器和解码器之间引入一个并行聚合金字塔池化模块(parallel aggregation pyramid pooling module, PAPPM)[14], 该模块将特征聚合与金字塔池化相结合, 输入低分辨率的特征图, 利用不同的池化方式增加感受野, 以融合不同尺度的特征信息, 捕获更加丰富的上下文信息. PAPPM结构如图4所示, 在模块内部, 由较大的池化核提取的上下文与更深的信息流集成, 并且通过将不同深度与不同大小的池化核集成而形成多尺度性质. 该模块是用序列BN-ReLU-Conv实现的, 并且对深度聚合金字塔池化模块的连接进行改进使其并行化, 减少了每个尺度的通道数, 因此几乎不影响推理速度.

2.4 解码器虽然经过双模态融合和上下文模块之后, 网络得到的特征图已经包含了丰富的语义信息和全局信息, 但将特征图直接送入编码器中进行下采样的时候会丢失细粒度细节, 因此, 参考文献[15,16] , 我们也采用了3个解码器模块. 解码器以上下文模块输出的512通道的特征图作为第1层的输入, 在后续解码器层中采用多尺度跳跃连接, 用1×1 卷积将来自编码器子网的浅层、低层、细粒度特征与来自解码器子网的深度、语义、粗粒度的相同尺度特征图结合在一起 , 从而获取包含低级空间信息和高级语义信息的全局特征, 有效地恢复目标对象的细节纹理 [17]. 同时, 在每一次跨层融合之后, 对特征图结果采用上采样方式来扩大分辨率, 再使用3×3的深度卷积来组合相邻特征.

|

图 4 并行聚合金字塔池化模块PAPPM |

3 实验 3.1 实验数据集

本文使用常用的RGB-D语义分割数据集NYUDv2评估所提出的模型. NYUDv2数据集包含1449张来自室内场景的RGB-D图像. 本文使用的语义标签划分为40类, 在实验中, 使用795张图像训练, 654个图像测试.

3.2 实验细节本文采用交叉熵函数作为损失函数, 并在每一个解码器模块后加一个输出, 将不同分辨率的输出和最后结果输入到网络末端得到最终损失函数:

| Loss(x,y)=1N∑i(1−lnexp(xi[yi])∑kexp(xi[k])) | (7) |

其中,

我们采用各种基准数据集最常用的标准, 像素精度PA、平均交并比mIoU以及各个类别交并比IoU作为评价指标. 计算公式如下:

| PA=k∑i=0Piik∑i=0k∑j=0Pij | (8) |

| IoU=Piik∑j=0Pij+k∑j=0Pji−Pii | (9) |

| mIoU=1k+1k∑i=0Piik∑j=0Pij+k∑j=0Pji−Pii | (10) |

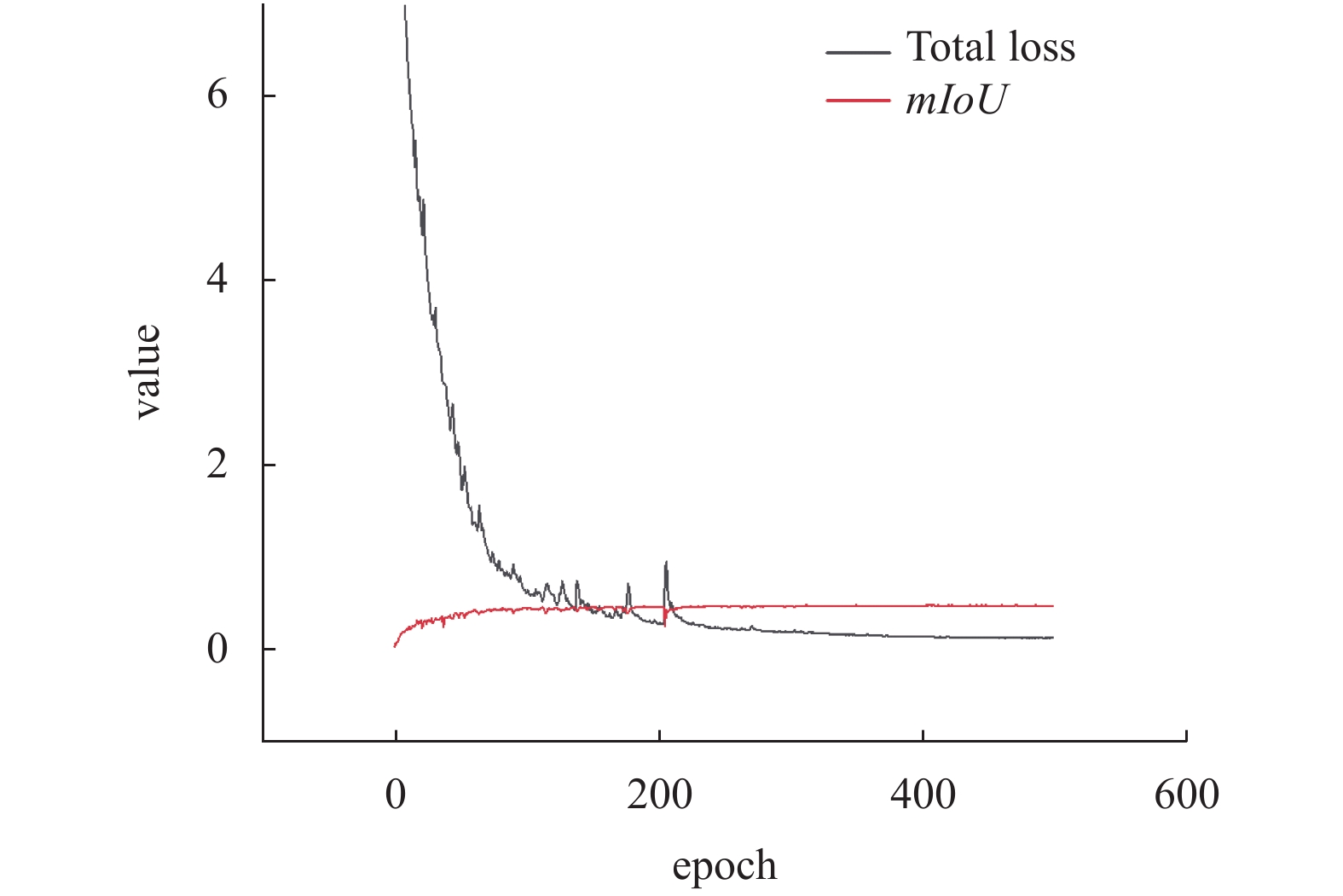

本文实验环境为64位Ubuntu 18.04操作系统, NVIDIA GeForce RTX 2080 TI显卡, 在CUDA 10.2、PyTorch 1.8.1下进行模型的训练与测试. 在训练过程中使用的优化器为SGD优化器, 训练批次大小为4, 初始学习率设置为0.01, 迭代次数为500个epoch. 图5所示黑色代表训练时损失函数变化曲线, 红色代表验证集的mIoU指标的变化曲线, 横坐标为迭代次数epoch. 从图5中可以看出, 随着epoch的增长, 损失函数在300个epoch左右趋于收敛, 随后有小幅下降, 指标mIoU也趋近收敛, 最终达到50.3%, 证明模型训练的可行性和算法的有效性.

|

图 5 总损失函数和 mIoU 变化曲线 |

3.3 实验分析 3.3.1 消融实验

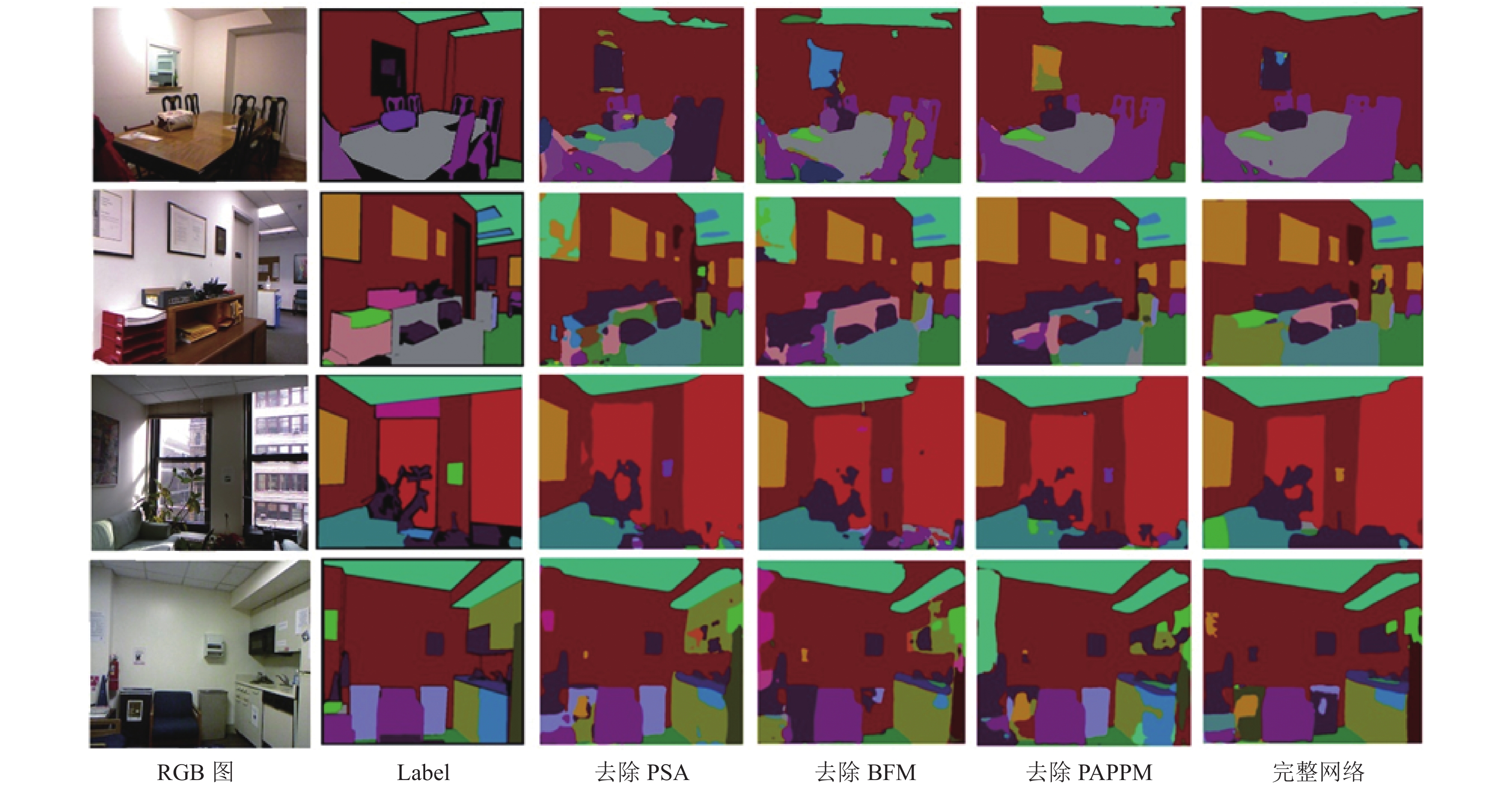

实验通过记录单独减少或使用简单操作替换每个模块后的网络性能, 证明本文构建的各个模块在整个网络中的优势. 消融实验如表1所示. 本文网络在NYUDv2数据集上40个类别的IoU值如表2所示, 图6所示为算法在NYUDv2数据集上的分割结果示例.

| 表 1 在NYUDv2数据集上的消融实验(%) |

| 表 2 本文算法在 NYUDv2数据集上各类别 IoU (%) |

(1) PSA极化注意力机制

从表1第2行可以看出, 当编码器部分不再使用PSA极化注意力机制, 在NYUDv2数据集上网络交并比和平均精度分别下降了1.6%和1.1%. 图6第3列为主干网络没有添加PSA极化注意力机制的分割结果. 而最后一列则是完整的网络模型的分割结果. 对比可以看出, 没有添加注意力机制的网络分割比较杂乱, 存在很多误匹配的情况.

|

图 6 分割结果 |

(2)双模态融合BFM模块

在两个主干网络提取特征之后对RGB特征和深度特征采用简单的元素相加的方式, 相比于原始网络在NYUDv2数据集上平均交并比和平均精度分别下降了1.4%和 0.8%. 由图6第4列和最后一列分割图像的对比可以看出, 像灯光下的墙壁和墙画之类的物体, 在边界不清、颜色相近和易混淆物体存在的场景下, 本文网络能更准确提取边界特征区分出不同物体种类, 同时对光照条件也具有更好的鲁棒性.

(3)并行聚合金字塔池化PAPPM模块

PAPPM模块去掉之后, 在NYUDv2数据集上网络平均交并比降低了0.7%和0.2%. 由图6的可视化结果可以看出, 去除并行金字塔池化模块后, 网络对于小目标物体的分割不再敏感, 会将一些如书本、盒子之类的小目标物体划分到与之相邻的大目标中; 而加入上下文模块之后加强了特征的全局信息, 强化了整个网络的分割能力.

3.3.2 模型对比本文采用的主干网络虽然是轻量级的ResNet34, 但性能超过了部分主干网络为ResNet101的算法. 而与主干为双分支的ResNet50的算法相比, 本文网络参数量较小, 但是取得了具有竞争力的效果. AFACNet与 AMBFNet与本文网络采用的是相同的特征提取网络, 但是这两个模型的分割精度分别为 48.2% 和50.0%, 略低于本文算法. 具体算法对比见表3.

| 表 3 算法对比(%) |

4 结论

针对室内复杂场景中, 图像语义分割存在的特征损失和双模态有效融合等问题, 本文提出了一种RGB-D室内场景语义分割网络. 该网络在编码器阶段引入了PSA极化注意力机制以减少空间维度上的特征损失, 构建了双模态特征融合模块以校准特征和融合多模态信息, 引入了并行聚合金字塔池化模块以捕获全局信息. 在常用的室内分割数据集上进行了实验, 验证了本文网络的有效性, 并展示了在NYUDv2数据集上的分割示例. 结果表明, 本文采用参数量较少的ResNet34作为主干网络, 可以在占用较少资源的情况下取得更好的效果, 因此具有一定的实际应用价值. 下一步将在该算法的基础上进行改进, 增加分类和方向估计等其他任务, 构建一种多任务的室内场景解析算法并在嵌入式系统上进行部署.

| [1] |

伏娜娜, 许钢, 陈玲, 等. 基于通道特征融合的RGB-D图像语义分割方法. 四川轻化工大学学报(自然科学版), 2022, 35(4): 42-48. |

| [2] |

梁博, 于蕾, 李爽. 基于卷积神经网络的多任务图像语义分割. 无线电工程, 2019, 49(7): 575-580. |

| [3] |

贺照蒙, 孔广黔, 吴云. 一种改进的室内场景语义分割网络. 计算机工程与应用, 2021, 57(16): 197-202. |

| [4] |

Gupta S, Arbelaez P, Malik J. Perceptual organization and recognition of indoor scenes from RGB-D images. Proceedings of the 2013 IEEE Conference on Computer Vision and Pattern Recognition. Portland: IEEE, 2013. 564–571.

|

| [5] |

Gupta S, Girshick R, Arbeláez P, et al. Learning rich features from RGB-D images for object detection and segmentation. Proceedings of the 13th European Conference on Computer Vision. Zurich: Springer, 2014. 345–360.

|

| [6] |

Jiang JD, Zheng LN, Luo F, et al. RedNet: Residual encoder-decoder network for indoor RGB-D semantic segmentation. arXiv:1806.01054, 2018.

|

| [7] |

Hu XX, Yang KL, Lei F, et al. ACNet: Attention based network to exploit complementary features for RGBD semantic segmentation. Proceedings of the 2019 IEEE International Conference on Image Processing (ICIP). Taipei: IEEE, 2019. 1440–1444.

|

| [8] |

Wu ZW, Allibert G, Stolz C, et al. Depth-adapted CNNs for RGB-D semantic segmentation. arXiv:2206.03939, 2022.

|

| [9] |

Bai LZ, Yang J, Tian CQ, et al. DCANet: Differential convolution attention network for RGB-D semantic segmentation. arXiv:2210.06747, 2022.

|

| [10] |

赵经阳, 余昌黔, 桑农. RGB-D语义分割: 深度信息的选择使用. 中国图象图形学报, 2022, 27(8): 2473-2486. |

| [11] |

Liu HJ, Liu FQ, Fan XY, et al. Polarized self-attention: Towards high-quality pixel-wise regression. arXiv:2107.00782, 2021.

|

| [12] |

Chen XK, Lin KY, Wang JB, et al. Bi-directional cross-modality feature propagation with separation-and-aggregation gate for RGB-D semantic segmentation. Proceedings of the 19th European Conference on Computer Vision. Glasgow: Springer, 2020. 561–577.

|

| [13] |

范润泽, 刘宇红, 张荣芬, 等. 基于多尺度注意力机制的道路场景语义分割模型. 计算机工程, 2023, 49(2): 288-295. DOI:10.19678/j.issn.1000-3428.0063257 |

| [14] |

Xu JC, Xiong ZX, Bhattacharyya SP. PIDNet: A real-time semantic segmentation network inspired by PID controllers. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE, 2023. 19529–19539.

|

| [15] |

Seichter D, Kӧhler M, Lewandowski B, et al. Efficient RGB-D semantic segmentation for indoor scene analysis. Proceedings of the 2021 IEEE International Conference on Robotics and Automation (ICRA). Xi’an: IEEE, 2021. 13525–13531.

|

| [16] |

张吉友, 张荣芬, 刘宇红, 等. 基于注意力机制的多模态图像语义分割. 液晶与显示, 2023, 38(7): 975-984. |

| [17] |

罗盆琳, 方艳红, 李鑫, 等. RGB-D双模态特征融合语义分割. 计算机工程与应用, 2023, 59(7): 222-231. |

| [18] |

Xing YJ, Wang JB, Chen XK, et al. 2.5D convolution for RGB-D semantic segmentation. Proceedings of the 2019 IEEE International Conference on Image Processing (ICIP). Taipei: IEEE, 2019. 1410–1414.

|

| [19] |

段立娟, 孙启超, 乔元华, 等. 基于注意力感知和语义感知的RGB-D室内图像语义分割算法. 计算机学报, 2021, 44(2): 275-291. |

| [20] |

Chen LZ, Lin Z, Wang ZQ, et al. Spatial information guided convolution for real-time RGBD semantic segmentation. IEEE Transactions on Image Processing, 2021, 30: 2313-2324. DOI:10.1109/TIP.2021.3049332 |

| [21] |

Xing YJ, Wang JB, Zeng G. Malleable 2.5D convolution: Learning receptive fields along the depth-axis for RGB-D scene parsing. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 555–571.

|

| [22] |

顾嘉城, 龙英文, 吉明明, 等. 一种面向室内场景的语义分割网络. 激光与红外, 2023, 53(4): 615-625. |

| [23] |

Zhu LZ, Kang ZZ, Zhou M, et al. CMANet: Cross-modality attention network for indoor-scene semantic segmentation. Sensors, 2022, 22(21): 8520. DOI:10.3390/s22218520 |

| [24] |

Cao JM, Leng HC, Lischinski D, et al. ShapeConv: Shape-aware convolutional layer for indoor RGB-D semantic segmentation. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision (ICCV). Montreal: IEEE, 2021. 7068–7077.

|

| [25] |

张静怡. 基于非对称融合和关联上下文的RGBD语义分割算法研究. 现代计算机, 2022, 28(1): 96-100. |

2024, Vol. 33

2024, Vol. 33