世界卫生组织于2019年10月发表的《世界视力报告》指出, 全球因青光眼、糖尿病视网膜病变及其他眼部疾病导致失明的人数超过4.18亿[1], 其中, 视网膜血管病变是致盲的主要原因之一, 同时, 眼底血管病变不仅表现在青光眼和白内障等眼科疾病中, 还与高血压、冠心病、糖尿病以及动脉粥样硬化等心血管疾病的严重程度直接相关[2]. 眼底血管的状况可在一定程度上反映疾病进展, 通过非入侵手段获取眼底血管图像后, 再对血管形态和生理特征进行分析, 可以有效地预测、诊断和预防相关眼部疾病[3,4]. 而据《中国眼科医疗服务行业现状深度分析与发展前景研究报告》显示, 近年来中国眼部相关疾病患者人数呈线性增长. 因此, 寻找准确度更高、分割效果更好的眼底血管自动化分割方法辅助医生进行快速、准确的诊断, 成为领域研究者努力的方向[5].

近年来, 硬件计算能力的不断提高和机器学习的快速发展在一定程度上推动图像分割领域发展. 深度学习更以其强大泛化能力, 在自动提取数据高级抽象特征, 识别、分类和检测准确率均较高, 在医学影像领域应用愈加广泛, 并取得显著成果[6]. 故将深度学习应用于眼底血管图像分割, 实现分割自动化, 可节约时间及人力成本, 且在一定程度上避免医务人员主观因素造成分割结果差异[7], 因此, 近年来基于深度学习的眼底血管图像分割研究热度一直居高不下.

为更好地把握眼底血管图像分割研究现状, 先后有多位研究者进行归纳综述, 如向陈君等[8]从图像特点和特征数据规则对眼底血管图像分割进行总结; 王诗惠等[9]从人工智能技术对眼底血管图像分割加以归纳; 姜百慧等[10]从深度学习在视网膜疾病应用进行总结. 但尚未涉及数据集整理分析, 对深度学习中有监督和无监督学习方法在眼底血管图像分割中的应用也无相对全面的对比研究. 鉴于此, 本文在梳理眼底图像血管分割方法的基础上, 对常用数据集及性能评价指标进行阐述, 并从有监督学习和无监督学习方法角度对眼底血管图像分割方法的性能表现进行对比分析, 以理清该领域目前所面临的挑战, 并对未来研究方向进行展望.

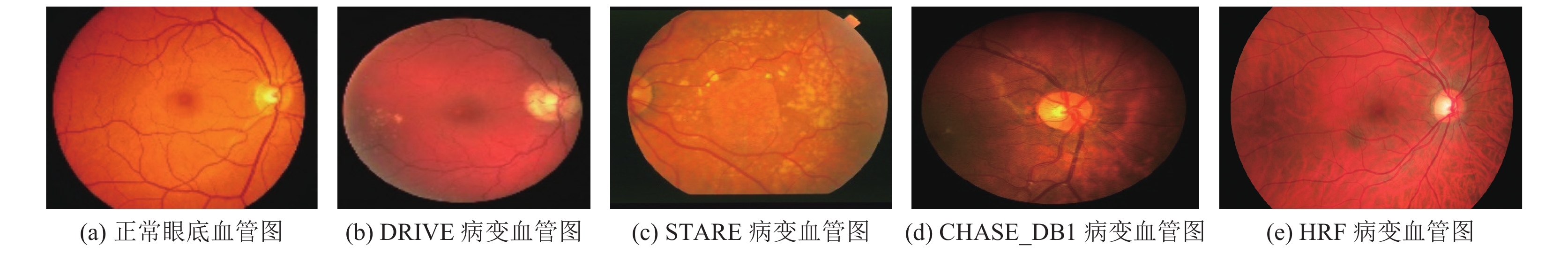

1 数据集和数据预处理 1.1 数据集数据集是医学图像处理研究的重要组成部分, 是考查不同算法性能的重要基础. 本节对眼底血管图像分割研究中常用数据集进行阐述, 正常眼底血管图例与不同数据集中病变图例对比如图1所示.

|

图 1 正常眼底血管图例与不同数据集中病变图例 |

1.1.1 DRIVE

DRIVE[11]来自荷兰糖尿病视网膜病变筛选计划, 从400名糖尿病患者中选出40张大小为565×584、存储格式为JPEG的图片, 由有5°视场(FOV)的佳能CR3非散瞳45CCD相机在45°视角下, 以768×584的像素捕获进行拍摄, 其中, 图像FOV呈圆形, 直径为540像素. 被收纳至数据集的图像已被裁剪并提供FOV遮罩图像, 其中, 7张为早期病变图像, 其余照片无明显病变迹象. 该数据集是视网膜血管图像分割研究最常用的数据集之一, 但建立后未更新图像数据集. 吴晨玥等[12]提出的CNN改进方法以及李大湘等[13]提出的U-Net改进方法等众多研究, 均使用该数据进行验证.

1.1.2 STARESTARE[14]最初由20张大小为700×605、存储格式为PPM的眼底图像组成, 每张图像至少由2名经验丰富专家进行手动分割, 其中10张有病变迹象, 其余图像无病变迹象, 使用时需人工设置掩膜, 同时该数据集中病变图像种类单一, 一定程度上影响模型性能, 在实际应用中需与其他数据集一并使用. 目前该数据集图像已扩展为40幅血管结果和80幅视神经检测结果图像. Du等[15]提出的多尺度线性结构检测网络及Liu等[16]提出的ESDO-U-Net眼底血管分割网络等众多研究, 均在STARE进行验证.

1.1.3 CHASE_DB1CHASE_DB1[17]是英国儿童心脏与健康研究CHASE一部分, 从多民族学校中获得图像. 该数据集用手持式Nidek NM-200-D眼底相机在30° FOV情况下记录学生双眼视网膜图像. 由28张大小为1280×960, 存储格式为TIFF的眼底图像组成. CHASE_DB1采集图像过程中招募志愿者具有种族差异化, 故数据集具有背景透明度不均、血管厚度不均匀特征, 有效解决病变图像种类单一问题. Zhang等[18]提出的桥接网络及Sun等[19]提出的基于U-Net改进网络, 均在该数据集上取得较好实验结果, 一定程度上缓解针对眼底血管厚度不均导致分割能力不足问题.

1.1.4 HRFHRF[20]由45张大小为3504×2336, 存储格式为JPEG的图像组成. 数据集中图像种类划分为健康患者、糖尿病视网膜病变患者和青光眼患者3类, 每张图像经人工标注, 是当时分辨率最高的一组数据集. Jebaseeli等[20]提出的将 Tandem PCNN 模型与支持向量机结合及Wu等[21]提出的SCS-Net网络等众多研究均使用该数据集进行验证, 在不同程度上促进眼底血管图像分割性能提高. 常见公开数据集各项数据比较如表1所示.

| 表 1 视网膜血管图像分割常用数据集 |

1.2 数据处理 1.2.1 数据预处理

眼底血管与背景对比度低, 在原始图像中进行图像分割会导致微小血管分割不足, 分割效果欠佳, 故需对数据集图像进行预处理, 眼底血管图像预处理方法通常有3步.

(1)提取G通道: 眼底血管图像为RGB图像, 包含R、G和B 三通道. 因绿色与背景对比度较高, 选取G通道并对其灰度化、归一化.

(2)自适应直方图均衡CLAHE: 在灰度图像中采用CLAHE方法, 进一步改善眼底血管与背景对比度, 获取更充分的图像细节.

(3)伽马校正: 伽马校正利用血管和背景间不同像素差异化进行伽马匹配, 再用非线性编码调整光线强度, 突出较暗区域血管. 预处理方法图例如图2所示.

1.2.2 数据扩充深度学习模型进行图像处理训练需大量图像作为训练集, 眼底血管图像常用数据集中图像数量较少, 无法满足训练需求, 故需对常用数据集进行数据扩充. 在处理过程中常用的数据扩充方法有随机旋转、翻转、缩放、裁剪以及高斯模糊和颜色、对比度增强等方法. 易三莉等[22]通过随机旋转和翻转的方式对数据集图像进行扩充, 并使用像素补零操作使图像的长宽相同. 孙颖等[23]通过将训练图像及掩码图划分为大小48×48的子块, 后随机组成的方式进行数据扩充, 如图3所示. 通过数据扩充可将图像数量扩充至20倍以上.

|

图 2 常用数据集预处理图例 |

|

图 3 图像子块以及相应掩码子块图 |

2 评价指标

评价标准用于评估视网膜血管图像分割在不同模型下的表现情况, 以准确率(accuracy, ACC)、灵敏度(sensitivity, SE)、特异性(specificity, SP)、ROC曲线下的面积(area under ROC curve, AUC)及F1-score几个评价指标最为常见.

(1) ACC指正确分类血管和背景像素数量占图像像素总数的比例, 表示整体分割性能, 取值范围在[0, 1], 如式(1)所示:

| $ \begin{gathered} ACC = \frac{{TP + TN}}{{TP + FP + TN + FN}} \end{gathered} $ | (1) |

(2) SE指正确分类血管像素的数量占血管像素总数的比例, 表示血管像素分割性能. 如式(2)所示:

| $ \begin{gathered} {\textit{SE}} = \frac{{TP}}{{TP + FN}} \end{gathered} $ | (2) |

(3) SP指正确分类背景像素的数量占背景像素总数的比例, 表示背景像素分割性能. 如式(3)所示:

| $ {\textit {SP}} = \frac{{TN}}{{TN + FP}} $ | (3) |

(4) AUC指敏感性与特异性的曲线图, 是一种分类器性能指标. 其AUC值大小与分类器性能成正比, 其中:

① TP (真阳性)指将血管像素正确检测为血管的像素点数.

② TN (真阴性)指将背景像素正确检测为背景的像素点数.

③ FN (假阴性)指将血管像素错误检测为背景的像素点数.

④ FP (假阳性)指将背景像素错误检测为血管的像素点数.

(5) F1-score是精确率(Precision)和召回率(Recall)的调和均值, 越接近1模型输出越好. 如式(4)所示:

| $ \begin{gathered} {F1}{\text{-}}{\rm{score}} = \frac{{2 \times Precision \times {Re}call}}{{Precision + {Re} call}} \end{gathered} $ | (4) |

其中,

| $ \begin{gathered} Pr{{e}}cision = \frac{{TP}}{{TP + FP}} \end{gathered} $ | (5) |

| $ \begin{gathered} {Re} call = \frac{{TP}}{{TP + FN}} \end{gathered} $ | (6) |

监督学习是深度学习的重要分支, 事先进行人工血管信息标注, 不断学习获得最优解, 主要包括卷积神经网络(convolutional neural network, CNN)、全卷积神经网络(full convolutional neural network, FCN)、残差神经网络(residual neural network, ResNet)及U-Net.

3.1.1 CNN及改进算法的应用传统神经网络中神经元与相邻两层的每个神经元相连接, 但后续研究出现因复杂度过高导致梯度消失问题. 为此, LeCun等[24]使用CNN架构, 将不同层神经元间的连接从线性变为非线性, 在保护层级网络基础上, 降低层间依赖及模型复杂度. CNN目前广泛用于医学图像分类、分割和定位等研究.

(1)工作原理: 在图像分割过程中, CNN将输入图像与过滤器做内积提取特征值, 后经一系列操作得到0–1范围内的输出与给定模型进行判断. CNN主要由卷积层、激活函数、池化层、全连接层等组成. 网络结构如图4所示.

|

图 4 CNN网络架构图 |

(2)应用: 使用CNN模型进行眼底血管图像分割, 因眼底血管直径及分布存在差异, 可能导致微小血管分割破裂及交差处分支血管分割错误等问题. 为此, Noh等[25]提出一种尺度空间近似CNN模型, 在CNN中加入多尺度结构和残差模块, 在多尺度表示和感受野进行平衡, ROC曲线AUC值达到了0.9916, 在一定程度改善薄血管、血管连接和中央血管反射的分割, 为该领域的研究奠定基础. Guo等[26]在此基础上提出一种基于CNN的双向对称级联网络BSCN, 引入密集扩张卷积模块提取不同血管直径特征信息, 改善因血管直径差异性导致的分割不足问题, 但在血管识别上待继续改进. 为此, Balasubramanian等[27]提出基于CNN和SVM的视网膜分割方法, 利用CNN提取特征向量, SVM对提取的特征值进行分类, 二者结合可自动学习特征值并完成识别, 只是分割过程中计算资源消耗较大; Yang等[28]提出基于改进深度森林的眼底血管图像分割方法, 将CNN与级联深度森林CF相结合, CNN对图像进行预处理提取特征区域, CF进行分类, 减小计算资源消耗, 但对低对比度、背景照明度不均的血管图像分割效果欠佳. 受新冠肺炎识别的Anam-net启发, Haider等[29]提出一种基于轻量级CNN编码器-解码器深度学习模型, 使用两个3×3卷积层堆栈, 减少可训练参数、扩大感受野, 降低计算复杂度, 但由于眼底血管粗细不一致, 分割结果易受影响. Xu等[30]提出一种非对称CNN, 利用二维Gabor滤波器获取血管粗细特征图, 设计分步连接模式主分段网、扩张卷积和跳跃连接模块的细分段网, 分别对粗细血管进行分割, 但 CNN中多次卷积及池化操作存在的微小信息丢失会影响分割性能. 为解决此类问题, Li等[31]提出多任务对称分割网络GDF-Net, 用两个对称网络分别对全局和细节进行分割, 避免微小信息丢失, 同时添加融合网络来提高血管分割精度. 荣震宇等[32]将最近颇受关注的转换器Transformer和多层感知机MLP结合, 可有效改善现有模型分割效果, 同时提高算法推理速度.

可见, 与传统方法相比CNN对数据集限制较小, 不同数据集无需手动调参, 实用性较高. 以CNN为基础的算法改进主要包括: (1)改进多尺度结构, 消除二次采样, 提高空间分辨率; (2)改进密集扩张卷积模块, 优化特征信息提取; (3)将CF与CNN相结合, 减小计算资源消耗; (4)改进Anam-net提出轻量化CNN模型, 提高血管分割精度. 各改进方法性能指标比较如表2所示.

| 表 2 基于CNN及改进方法的分割结果比较 |

由表2可知, 基于CNN的诸多改进, 使各项性能指标均有不同程度提高, 但SE仍处于较低水平, 且易受数据集影响, 存在同一改进算法在不同数据集中SE差距较大情况.

3.1.2 FCN及改进算法的应用CNN中图像只能以数值形式输出, 导致图像处理过程中语义层次的分割有待改进. 为此, Long等[33]于2015年提出一种新的分割模型FCN, 属于图像处理中语义层次分割的里程碑式发展.

(1)工作原理: FCN是在CNN基础上以卷积层替换全连接层, 输入图像无尺寸限制, 输出方式从数值形式变成图像形式. 网络架构如图5所示.

|

图 5 FCN网络架构图 |

(2)应用: FCN在语义层次分割改进较为明显, 但在应用于眼底血管图像分割时某些特定图像需预处理, 且对微小血管分割欠佳. 为突破FCN在眼底血管图像分割领域的局限性. Mo等[34]提出一种多层深度监督FCN, 在特定血管图像无需预处理, 降低对手工标注特征信息依赖度, 减少主观因素对实验结果的影响, 缓解梯度消失问题, 但对微小血管分割没有达到理想效果. Soomro等[35]提出由编码器和解码器组成的FCN用于眼底血管精确分割, 用跨步卷积层取代原有的池化层, 在微小血管分割上得到较为理想效果, 模型复杂度较高. 针对此问题, Jiang等[36]提出基于端到端FCN的眼底血管图像分割框架, 规避多模块固有缺陷、降低模型复杂度、提高模型泛化能力, 但计算成本较高. Sathananthavathi等[37]提出基于并行FCN的眼底血管图像分割结构, 该结构由两个FCN组成, 二者同时工作, 将单张血管图像提取时间缩短至2 s内, 降低了计算执行成本. 在此基础上, Khan等[38]提出一种FCN变体的监督方法, 保留卷积层的低级别边缘信息, 并将其运用到对微小血管信息捕获中, 降低存储需求、减少超参数、同时提高捕获信息的鲁棒性. Atli等[39]在模型的架构上加入残差模块, 提出基于FCN全自动眼底血管图像分割的模型Sine-Net, 上下采样操作分别提取薄厚血管信息, 但出现对非血管图像的错误识别. Jiang等[40]提出基于端到端的蝴蝶型FCN, 简称BFCN, 采用自动色彩增强技术改善血管与背景对比度低问题, 提高对非血管图像的识别, 同时加入多尺度信息提取模块获取更丰富的空间信息.

可见, FCN缓解语义层次分割不足问题, 为语义分割领域的发展奠定了基础, 但最初提出的FCN对眼底微小血管分割较为粗糙、对于血管像素分类时出现空间信息缺失, 及整体分割精度有待提高等问题[41]. 以FCN为基础的算法改进主要包括: (1)引入辅助分类器, 缓解梯度消失问题; (2)引入编码器-解码器, 解决输入图像尺寸受限问题; (3)引入残差, 将更多低层次的特征信息传递到架构较深层次; (4)引入色彩增强技术, 增强血管与背景对比度. 各改进方法性能指标比较结果如表3所示.

由表3可知, 基于FCN的改进方法AUC多保持在98%以上, ACC可达96%, 处于相对理想状态, 但因现有公开数据集中数据量普遍较少, 需注意分割结果是否存在偶然性, 部分性能指标是否可真实反映算法的实际性能, 如文献[39]中Sine-Net在不同数据集中SE差距较大. 研究人员可通过与医院合作, 建立私人数据集用于模型性能验证, 避免性能指标差距太大情况.

3.1.3 U-Net及改进算法的应用2015年, 受FCN设计理念及工作原理的启发, Ronneberger等[42]在MICCAI上提出U-Net, 在继承FCN语义层次分割优点的同时简化网络结构, 使其逐步成为图像分割领域的研究热点, 尤其是医学图像分割领域一度视为最受欢迎的分割方法之一.

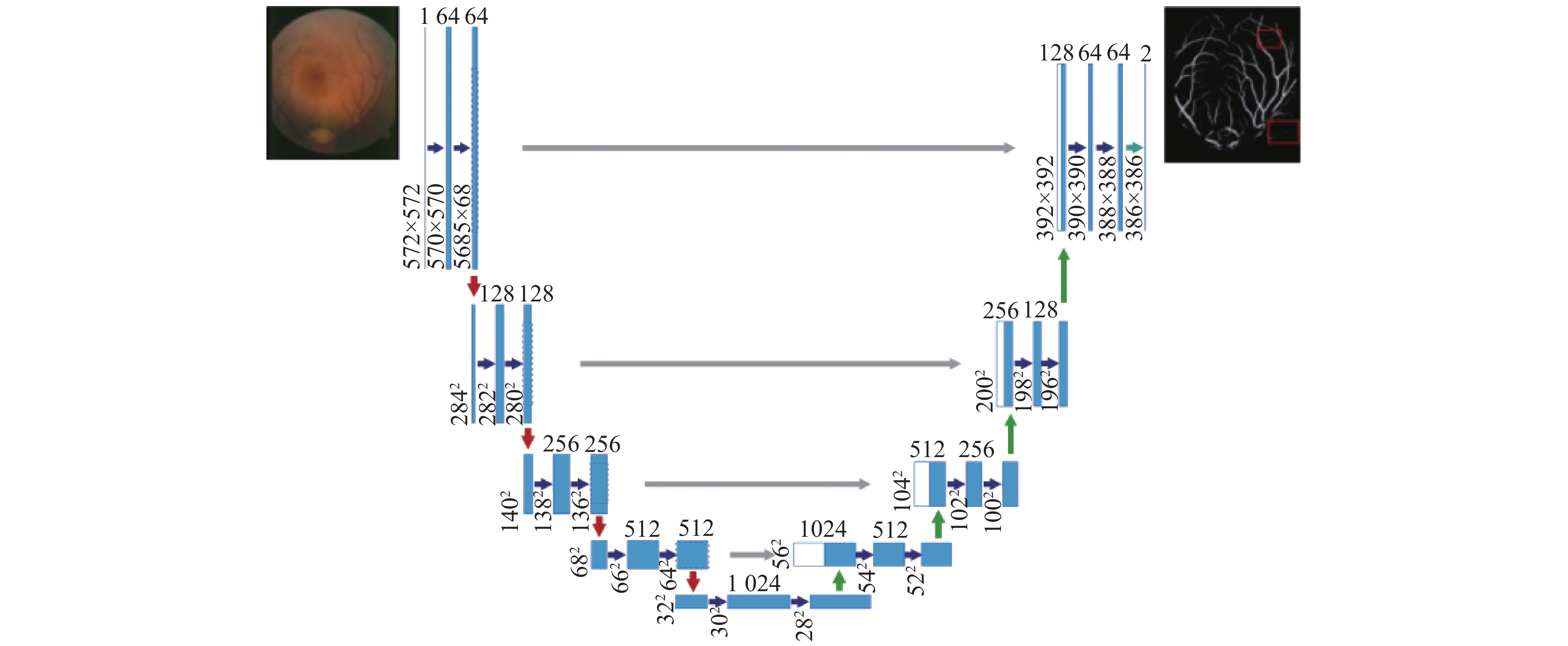

(1)工作原理: U-Net在FCN网络结构基础上取消原有的全连接层, 网络结构呈U型. 该模型主要包括编码部分、解码部分以及二者之间的跳跃连接部分. 编码部分通过卷积和池化操作获得图像特征信息, 由多个模块组成, 不同模块间进行下采样操作提取更深层次的语义信息; 解码部分进行上采样和反卷积操作, 将分辨率恢复至与输入图像分辨率一致; 跳跃连接层是为了防止图像特征信息在传递过程中丢失[43]. 网络架构如图6所示.

| 表 3 基于FCN及改进方法的结果比较 |

|

图 6 U-Net网络架构图 |

(2)应用: U-Net适用于小样本数据集图像分割, 但传统U-Net存在对直径较小的眼底血管分割精度较低、模型收敛速度有待提高及血管边界分割不足等问题. 为此, Wang等[44]提出一种硬注意网络眼底血管自动分割架构HAnet, 由3个解码器组成, 一个用于定位哪些图像区域“难”或“容易”, 另外两个解码器独立分割“难”和“易”的图像区域, 改善薄血管及血管边界等难分割区域被忽略问题, 受血管像素对比度影响, 血管分割精度有待提高. Cheng等[45]在U-Net中加入密集模块, 加强层与层之间联系, 提高分割精度, 但因加入密集网, 模型复杂度提高. Yuan等[46]提出一种新的深度学习模型AACA-MLA-D-U-Net, 降低模型复杂度, 引入dropout密集块和多层注意力模块, 保留卷积层间血管特征信息并对每层特征信息进行细化, 提高血管分割精度, 但未考虑特征信息从浅层网络向深层传递过程中由于传递不顺利产生噪声问题. Jiang等[47]提出多尺度剩余注意力网络MRA U-Net用于眼底血管图像分割, 多分辨率输入方式提取不同分辨率的特征信息, 避免浅层特征信息丢失, 再利用信息聚合优势缓解不同网络层次之间信息隔阂, 使传递更加顺利, 缓解噪声问题. Wang等[48]在U-Net上进行改进, 提出SERR-U-Net框架用于眼底血管图像分割, 加入残差结构缓解梯度消失问题, 并将注意力机制引入U-Net中获得更充分的血管特征信息.

由于U-Net变体无法充分识别眼底图像血管. Hu等[49]提出分层扩张卷积网络HDC-Net, 利用HDC模块捕捉眼底图像中易被忽略的血管特征, 残差双信道注意力模块获取信道信息, 提高模型辨别力, 但血管边界差异性较小, 识别较为困难. Liu等人[50]将U-Net中卷积运算CNN改为全局卷积网络和边界细化, 改善血管边界识别问题. Huang等[51]提出一种新的双分支融合U-Net模型DBFU-Net, 一个分支用于交叉熵训练, 另一分支用于加权改进交叉熵训练, 提高整体分割性能, 但形态学运算增加计算成本. Wu等[52]提出带有atrous块的ARN模型, 是将ResNet与U-Net相结合, 利用不同网络间优势互补, 提高血管分割性能, 同时减小计算成本; 在DRIVE和CHASE_DB1上验证的准确率为96.86%和97.46%, 在下采样过程中会丢失细节特征信息. Li等[53]提出多尺度注意力引导融合网络MAGF-Net, 用多尺度注意块搭建网络, 获取多尺度上下文特征信息, 在下采样过程中加入混合特征池块保留细节特征, 但病变后血管与背景对比度较低, 导致分割难度增大. 为此, Sun等[54]在U-Net提出一种可变形卷积和注意力机制分割方法SDAU-Net, 选用串联可变形卷积模块替代U-Net中原有的卷积模块, 解码部分加入轻量级注意力模块和双注意力模块提高对眼底病变图像中特征信息提取.

可见, U-Net在小样本图像分割中有较好分割效果. 以U-Net基础的算法改进主要包括: (1)引入可变形卷积, 自适应调节感受野; (2)引入多尺度输入, 获取更充分的空间上下文信息; (3)引入密集模块, 加强层与层间联系; (4)引入HDC模块, 捕获更充分的血管特征; (5)引入残差卷积与属性卷积, 在保证清晰度同时扩大感受野. 各改进方法性能指标比较结果如表4所示.

| 表 4 基于U-Net及改进方法的分割结果比较 |

由表4可知, 基于U-Net的改进算法性能整体表现优于CNN、FCN, 各项性能指标较为理想且趋于稳定, 为眼底血管图像分割领域较为成熟的方法.

3.1.4 ResNet及改进算法的应用2016年He等[55]发现网络深度加深会带来梯度爆炸问题, 为此提出ResNet, 该模型在多个知名计算机大赛中夺魁, 广受研究者青睐.

(1)工作原理: ResNet基于CNN结构进行改进, 每次卷积后将得到的特征矩阵与之前的特征矩阵相加作为下一次卷积的输入.

(2)应用: ResNet有效缓解梯度爆炸问题, 但最初将其应用于眼底血管图像分割时由于眼底血管分布情况的复杂性, 分割效果不佳, 无法达到临床应用需求. 为此, Ma等[56]对ResNet中的e通道扩宽, 传播更多低层特征信息, 引入残差空间金字塔模块获取不同尺度的血管特征, 整体分割精度得到提高, 在数据集DRIVE和STARE上采用交叉训练的验证的准确率为95.66%和96.45%, 但眼底成像结构复杂, 噪声干扰问题没有得到有效解决. Liu等[57]提出基于反向融合注意ResNet的眼底血管图像分割模型RFARN, 采用多尺度视网膜颜色恢复方式进行数据增强, 抑制噪声、突出血管结构, 将处理后图片输入至RFARN达到更准确的分割效果, 但当时采用层间特征聚合方式在一定程度上限制分割性能提高. Zhang等[58]提出一种用于眼底血管图像分割的层内金字塔尺度特征聚集网络Pyramid-Net, 引入层内金字塔级聚集块, 加强不同尺度间特征融合, 提高整体分割性能同时减小计算成本, 但由于眼底血管图像中微小血管众多, 存在细节分割不足. Gao等[59]提出一种基于双注意的多尺度特征融合ResNet用于眼底血管图像分割, 引入SA模块和ECA模块自适应获取焦点位置, 聚合高低级特征信息, 缓解因细节特征提取不足导致的噪声问题, 在数据集DRIVE和STARE上进行验证的准确率为97.95%和97.85%.

可见, ResNet通过对特征矩阵相加的方式, 有效缓解模型梯度不稳定问题. 以ResNet为基础的算法改进主要包括: (1)引入DropBlock, 可随机掉落连续区域, 丢弃结构化语义信息, 有效防止过拟合; (2)引入残差空间金字塔模块, 保留血管多尺度特征信息; (3)采用MSRCR图像预处理方式, 突出血管结构, 有效学习图像特征信息; (4)将多尺度输入图像融合至IPABs, 减少信息损失, 提高特征融合. 各改进方法性能指标比较结果如表5所示.

| 表 5 基于ResNet及改进方法的分割结果比较 |

由表5可知, 基于ResNet的改进算法, 在ACC表现较优, 数值可维持在97%以上, 同时SE与SP间差距较CNN有明显减小.

3.2 基于无监督学习的分割算法无监督学习指对未进行人工标注样本进行训练找到其隐藏信息, 不依赖人工标注血管图像, 目前较为受欢迎的模型是生成对抗网络(generative adversarial network, GAN). 无监督方法适用于未进行标记的数据训练, 但计算量较大, 计算成本增加, 同时分割精度有待提高[60].

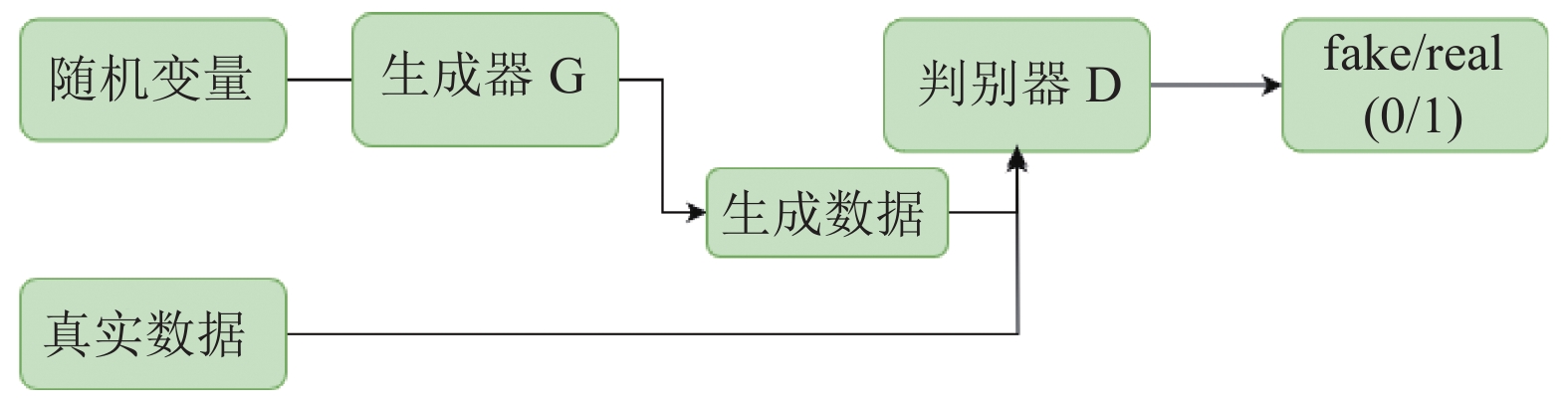

3.2.1 GAN及改进算法的应用2014年Goodfellow等[61]首次提出GAN模型.

(1)工作原理: GAN由生成器和判别器两部分组成, 生成器负责提供真假混合样本, 判别器负责从生成器提供的样本中判断样本真伪, 并将结果反馈至生成器, 多次重复训练, 直至判别器判别真伪概率接近0.5即可停止训练. 网络架构如图7所示.

|

图 7 GAN网络架构图 |

(1)应用: 最初将GAN应用于眼底血管图像分割时, 由于眼底血管结构复杂性, 整体分割结果低于人工分割水平. 为此, Wu等[62]将GAN与U-Net相结合提出一种被称为U-GAN的模型, 引入注意力门AG模型, 同时在生成器中用Denseblock替换卷积层, 增强抗噪干扰能力, 分割质量得到明显提高, 在数据集DRIVE上验证的准确率为96.15%, 但该模型无法检测到像素为1的薄血管. Yang等[63]提出一种SUD-GAN模型, 在GAN生成器的卷积层中添加短连接, 在判别器的卷积块间加入密接连接结构, 增强GAN识别能力, 可以检测到更多微小血管, 但该模型在损失函数上为平衡损失加入超参数影响整体分割性能. Park等[64]提出新型条件对抗网络模型M-GAN, 加入二元交叉熵和假负损失函数, 堆叠深度卷积神经网络, 达到平衡损失、增强分割鲁棒性效果, 但对微小血管分割效果有待改进. Yue等[65]对GAN进行改进提出SAD-GAN用于眼底血管图像分割, 用SE-ResNet模块替换生成器中的卷积层, 获取全局信道信息, 在鉴别器中引入初始块和展开卷积, 增强特征传输、扩大感受野, 改善微小血管分割不连续问题. Liu等人[66]提出注意力增强的GAN, 加入注意力增强模块, 获取图像内像素依赖关系, 有效解决数据不完善问题, 采用挤压激励模块抑制发生器产生无用信息, 设置梯度惩罚增强模型稳定性.

可见, 大量研究者通过对GAN的改进, 在模型的稳定性及判别能力上有较为明显的提升. 以GAN为基础的算法改进主要包括: (1)引入AG, 摆脱对外部监督的依赖性, 提高对目标结构关注度; (2)在判别器中引入密集连接结构, 增强浅层特征向深层网络的信息传输, 提高识别能力; (3)采用平衡损失和堆叠FCN方式, 提高血管分割性能; (4)引入SE-ResNet模块, 获取更充分的信道信息. 各改进方法性能指标比较结果如表6所示.

由表6可知, 基于GAN的改进算法性能指标中AUC、ACC、SP均呈稳定上升趋势, SE存在上下波动, 尚有一定提升空间, 研究人员未来可将该项性能指标的优化作为一个关注点.

3.3 小结从上述各种图像分割方法及其应用可见: (1) CNN是众多算法改进基础, 可简化传统神经网络, 减少模型参数, 增强空间提取能力, 但输入图像尺寸的局限性导致语义层次分割受影响. (2) FCN在CNN语义层次上的改进, 摆脱了图像输入尺寸局限性, 避免像素块输入导致的储存冗余, 但对细节信息捕获敏感度不足, 在图像边缘表现尤为明显. (3) U-Net以结构简单、训练速度快、所需标记样本数较少等优势深受研究人员青睐, 但存在下采样过程损失边缘特征信息及硬件设备要求高等问题. (4) ResNet有效缓解因网络深度产生梯度消失、爆炸等问题, 训练时间、速度及计算资源等方面的优化是今后的关注点. (5) GAN摆脱对数据集人工标注的依赖性, 降低人工干预因素影响, 但学习过程中无对应输出, 学习难度较大, 且模型稳定性较差. 眼底血管图像分割不同算法的总结如表7所示.

| 表 6 基于GAN及改进方法的分割结果比较 |

| 表 7 基于深度学习的眼底血管图像分割算法总结 |

4 总结与展望

眼底血管图像是目前眼部疾病的重要诊断依据. 本文从传统方法、有监督学习以及无监督学习这3个角度对眼底图像血管分割技术进行阐述, 随着深度学习的发展, 在视网膜血管图像分割应用中各项性能指标均有不同程度的提高, 但目前依然存在不尽人意之处.

(1)公开数据集少, 样本大都缺少更新. 目前仅有4个常用公开数据集, 且样本数量较少, 病变图像种类较为单一, 人工标注信息不够全面, 同时数据集建立时间较久, 除STARE基本无样本更新. 血管分割模型的改进通常需要多个数据集进行交叉验证, 但因各数据集图像侧重点不同, 实验结果不可避免存在差异化, 不利于模型评价的统一.

(2)对人工标注过于依赖. 目前研究多集中有监督学习, 数据依赖人工进行标注不仅专业要求较高, 过程也易受主观因素影响, 较难对特征信息进行全面标注, 可能导致部分模型无法达到预想状态.

(3)模型多缺乏临床应用检验. 研究人员对模型改进多从理论角度出发, 对临床应用中设备计算力支持等问题考虑不足, 成果大都未能真正应用在临床应用起到辅助诊断作用.

因此, 今后研究可侧重以下几点展开.

(1)对视网膜血管图像样本进行扩充. 倡议已有的公开数据集及时更新, 同时倡议创建中国自己的公开数据集, 同类数据集尽量实现预处理标准化, 以尽量实现模型评价统一化.

(2)尝试创建人工标注依赖度较低的模型. 将无监督与有监督结合将有助于缓解对人工标注样本的依赖性, 此类模型已在肺结节图像分割中取得较好实验结果, 可通过迁移学习辅以针对性改进, 设计满足符合视网膜血管图像分割需求的模型.

(3)模型改进要充分考虑硬件及应用需求. 研究人员可通过磁共振、CT成像等方式将图像从2D扩展到3D, 获得更充分的特征信息; 同时加强与影像医生及临床医生的沟通, 将图像分割模型的改进建立在临床应用的实际需求之上.

| [1] |

姚慧霞. 基于注意力机制和卷积神经网络的视网膜血管图像分割方法研究 [硕士学位论文]. 兰州: 西北师范大学, 2022.

|

| [2] |

朱承璋, 邹北骥, 向遥, 等. 彩色眼底图像视网膜血管分割方法研究进展. 计算机辅助设计与图形学学报, 2015, 27(11): 2046-2057. |

| [3] |

吕志金, 陈雪芳, 赵晓芳, 等. 新型下采样法在视网膜血管分割中的应用. 中国医疗器械杂志, 2023, 47(1): 38-42, 53. DOI:10.3969/j.issn.1671-7104.2023.01.006 |

| [4] |

Yin BJ, Li HT, Sheng B, et al. Vessel extraction from non-fluorescein fundus images using orientation-aware detector. Medical Image Analysis, 2015, 26(1): 232-242. DOI:10.1016/j.media.2015.09.002 |

| [5] |

LeCun Y, Bengio Y, Hinton G. Deep learning. Nature, 2015, 521(7553): 436-444. DOI:10.1038/nature14539 |

| [6] |

张欢, 仇大伟, 冯毅博, 等. U-Net模型改进及其在医学图像分割上的研究综述. 激光与光电子学进展, 2022, 59(2): 55-71. |

| [7] |

Dai PS, Luo HY, Sheng HW, et al. A new approach to segment both main and peripheral retinal vessels based on gray-voting and Gaussian mixture model. PLoS One, 2015, 10(6): e0127748. DOI:10.1371/journal.pone.0127748 |

| [8] |

向陈君, 张新晨. 基于眼底图像的视网膜血管分割方法综述. 工业技术创新, 2019, 6(2): 110-114. DOI:10.14103/j.issn.2095-8412.2019.02.021 |

| [9] |

王诗惠, 郝晓凤, 谢立科. 人工智能在视网膜疾病中应用的研究现状与展望. 中华眼科医学杂志(电子版), 2020, 10(6): 374-379. |

| [10] |

姜百慧, 项开来, 秦秀虹, 等. 深度学习在视网膜疾病中的应用. 眼科新进展, 2021, 41(7): 688-691, 695. |

| [11] |

Staal J, Abràmoff MD, Niemeijer M, et al. Ridge-based vessel segmentation in color images of the retina. IEEE Transactions on Medical Imaging, 2004, 23(4): 501-509. DOI:10.1109/TMI.2004.825627 |

| [12] |

吴晨玥, 易本顺, 章云港, 等. 基于改进卷积神经网络的视网膜血管图像分割. 光学学报, 2018, 38(11): 1111004. |

| [13] |

李大湘, 张振. 基于改进U-Net视网膜血管图像分割算法. 光学学报, 2020, 40(10): 1010001. |

| [14] |

Liskowski P, Krawiec K. Segmenting retinal blood vessels with deep neural networks. IEEE Transactions on Medical Imaging, 2016, 35(11): 2369–2380.

|

| [15] |

Du HW, Zhang XY, Song G, et al. Retinal blood vessel segmentation by using the MS-LSDNet network and geometric skeleton reconnection method. Computers in Biology and Medicine, 2023, 153: 106416. DOI:10.1016/j.compbiomed.2022.106416 |

| [16] |

Liu YH, Shen J, Yang L, et al. ResDO-UNet: A deep residual network for accurate retinal vessel segmentation from fundus images. Biomedical Signal Processing and Control, 2023, 79: 104087. DOI:10.1016/j.bspc.2022.104087 |

| [17] |

Owen CG, Rudnicka AR, Mullen R, et al. Measuring retinal vessel tortuosity in 10-year-old children: Validation of the computer-assisted image analysis of the retina (CAIAR) program. Investigative Ophthalmology & Visual Science, 2009, 50(5): 2004-2010. |

| [18] |

Zhang Y, He M, Chen ZN, et al. Bridge-Net: Context-involved U-Net with patch-based loss weight mapping for retinal blood vessel segmentation. Expert Systems with Applications, 2022, 195: 116526. DOI:10.1016/j.eswa.2022.116526 |

| [19] |

Sun MY, Li KQ, Qi XQ, et al. Contextual information enhanced convolutional neural networks for retinal vessel segmentation in color fundus images. Journal of Visual Communication and Image Representation, 2021, 77: 103134. DOI:10.1016/j.jvcir.2021.103134 |

| [20] |

Jebaseeli TJ, Durai CAD, Peter JD. Retinal blood vessel segmentation from diabetic retinopathy images using tandem PCNN model and deep learning based SVM. Optik, 2019, 199: 163328

|

| [21] |

Wu HS, Wang W, Zhong JF, et al. SCS-Net: A scale and context sensitive network for retinal vessel segmentation. Medical Image Analysis, 2021, 70: 102025. DOI:10.1016/j.media.2021.102025 |

| [22] |

易三莉, 陈建亭, 贺建峰. 基于多路径输入和多尺度特征融合的视网膜血管分割. 光电子·激光, 2021, 32(7): 735-741. |

| [23] |

孙颖, 丁卫平, 黄嘉爽, 等. RCAR-UNet: 基于粗糙通道注意力机制的视网膜血管分割网络. 计算机研究与发展, 2023, 60(4): 947-961. DOI:10.7544/issn1000-1239.202110735 |

| [24] |

LeCun Y, Bottou L, Bengio Y, et al. Gradient-based learning applied to document recognition. Proceedings of the IEEE, 1998, 86(11): 2278-2324. DOI:10.1109/5.726791 |

| [25] |

Noh KJ, Park SJ, Lee S. Scale-space approximated convolutional neural networks for retinal vessel segmentation. Computer Methods and Programs in Biomedicine, 2019, 178: 237-246. DOI:10.1016/j.cmpb.2019.06.030 |

| [26] |

Guo YF, Peng YJ. BSCN: Bidirectional symmetric cascade network for retinal vessel segmentation. BMC Medical Imaging, 2020, 20(1): 20. DOI:10.1186/s12880-020-0412-7 |

| [27] |

Balasubramanian K, Ananthamoorthy NP. Retracted article: Robust retinal blood vessel segmentation using convolutional neural network and support vector machine. Journal of Ambient Intelligence and Humanized Computing, 2021, 12(3): 3559-3569. DOI:10.1007/s12652-019-01559-w |

| [28] |

Yang X, Li ZQ, Guo YQ, et al. Retinal vessel segmentation based on an improved deep forest. International Journal of Imaging Systems and Technology, 2021, 31(4): 1792-1802. DOI:10.1002/ima.22610 |

| [29] |

Haider SI, Aurangzeb K, Alhussein M. Modified Anam-net based lightweight deep learning model for retinal vessel segmentation. Computers, Materials & Continua, 2022, 73(1): 1501–1526.

|

| [30] |

Xu YA, Fan YL. Dual-channel asymmetric convolutional neural network for an efficient retinal blood vessel segmentation in eye fundus images. Biocybernetics and Biomedical Engineering, 2022, 42(2): 695-706. DOI:10.1016/j.bbe.2022.05.003 |

| [31] |

Li JY, Gao G, Yang L, et al. GDF-Net: A multi-task symmetrical network for retinal vessel segmentation. Biomedical Signal Processing and Control, 2023, 81: 104426. DOI:10.1016/j.bspc.2022.104426 |

| [32] |

荣震宇, 刘建毅. 基于Transformer和MLP的眼底血管分割算法. 北京邮电大学学报, 2023, 46(1): 26-31. |

| [33] |

Long J, Shelhamer E, Darrell T. Fully convolutional networks for semantic segmentation. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 3431–3440.

|

| [34] |

Mo J, Zhang L. Multi-level deep supervised networks for retinal vessel segmentation. International Journal of Computer Assisted Radiology and Surgery, 2017, 12(12): 2181-2193. DOI:10.1007/s11548-017-1619-0 |

| [35] |

Soomro TA, Afifi AJ, Gao JB, et al. Strided fully convolutional neural network for boosting the sensitivity of retinal blood vessels segmentation. Expert Systems with Applications, 2019, 134: 36-52. DOI:10.1016/j.eswa.2019.05.029 |

| [36] |

Jiang Y, Zhang H, Tan N, et al. Automatic retinal blood vessel segmentation based on fully convolutional neural networks. Symmetry, 2019, 11(9): 1112. DOI:10.3390/sym11091112 |

| [37] |

Sathananthavathi V, Indumathi G, Swetha Ranjani A. Parallel architecture of fully convolved neural network for retinal vessel segmentation. Journal of Digital Imaging, 2020, 33(1): 168-180. DOI:10.1007/s10278-019-00250-y |

| [38] |

Khan TM, Naqvi SS, Arsalan M, et al. Exploiting residual edge information in deep fully convolutional neural networks for retinal vessel segmentation. Proceedings of the 2020 International Joint Conference on Neural Networks. Glasgow: IEEE, 2020. 1–8.

|

| [39] |

Atli İ, Gedik OS. Sine-Net: A fully convolutional deep learning architecture for retinal blood vessel segmentation. Engineering Science and Technology, an International Journal, 2021, 24(2): 271-283. DOI:10.1016/j.jestch.2020.07.008 |

| [40] |

Jiang Y, Wang FL, Gao J, et al. Efficient BFCN for automatic retinal vessel segmentation. Journal of Ophthalmology, 2020, 2020: 6439407. |

| [41] |

张立泽清. 基于FCN的视网膜血管图像分割与研究 [硕士学位论文]. 西安: 陕西科技大学, 2020.

|

| [42] |

Ronneberger O, Fischer P, Brox T. U-Net: Convolutional networks for biomedical image segmentation. Proceedings of the 18th International Conference on Medical Image Computing and Computer-assisted Intervention. Munich: Springer, 2015. 234–241.

|

| [43] |

孙雪. 基于U-Net的医学图像分割网络研究 [硕士学位论文]. 南京: 南京邮电大学, 2022.

|

| [44] |

Wang DY, Haytham A, Pottenburgh J, et al. Hard attention net for automatic retinal vessel segmentation. IEEE Journal of Biomedical and Health Informatics, 2020, 24(12): 3384-3396. DOI:10.1109/JBHI.2020.3002985 |

| [45] |

Cheng YL, Ma MN, Zhang LJ, et al. Retinal blood vessel segmentation based on densely connected U-Net. Mathematical Biosciences and Engineering, 2020, 17(4): 3088-3108. DOI:10.3934/mbe.2020175 |

| [46] |

Yuan YC, Zhang L, Wang LT, et al. Multi-level attention network for retinal vessel segmentation. IEEE Journal of Biomedical and Health Informatics, 2022, 26(1): 312-323. DOI:10.1109/JBHI.2021.3089201 |

| [47] |

Jiang Y, Wu C, Wang G, et al. MFI-Net: A multi-resolution fusion input network for retinal vessel segmentation. PLoS One, 2021, 16(7): e0253056. DOI:10.1371/journal.pone.0253056 |

| [48] |

Wang JK, Li X, Lv PQ, et al. SERR-U-Net: Squeeze-and-excitation residual and recurrent block-based U-Net for automatic vessel segmentation in retinal image. Computational and Mathematical Methods in Medicine, 2021, 2021: 5976097. |

| [49] |

Hu XL, Wang LJ, Cheng SL, et al. HDC-Net: A hierarchical dilation convolutional network for retinal vessel segmentation. PLoS One, 2021, 16(9): e0257013. DOI:10.1371/journal.pone.0257013 |

| [50] |

Liu CJ, Gu PH, Xiao ZY. Multiscale U-Net with spatial positional attention for retinal vessel segmentation. Journal of Healthcare Engineering, 2022, 2022: 5188362. |

| [51] |

Huang JP, Lin ZF, Chen YY, et al. DBFU-Net: Double branch fusion U-Net with hard example weighting train strategy to segment retinal vessel. PeerJ Computer Science, 2022, 8: e871. DOI:10.7717/peerj-cs.871 |

| [52] |

Wu J, Liu Y, Zhu YP, et al. Atrous residual convolutional neural network based on U-Net for retinal vessel segmentation. PLoS One, 2022, 17(8): e0273318. DOI:10.1371/journal.pone.0273318 |

| [53] |

Li JY, Gao G, Liu YH, et al. MAGF-Net: A multiscale attention-guided fusion network for retinal vessel segmentation. Measurement, 2023, 206: 112316. DOI:10.1016/j.measurement.2022.112316 |

| [54] |

Sun K, Chen Y, Chao Y, et al. A retinal vessel segmentation method based improved U-Net model. Biomedical Signal Processing and Control, 2023, 82: 104574. DOI:10.1016/j.bspc.2023.104574 |

| [55] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 770–778.

|

| [56] |

Ma YL, Li X, Duan XP, et al. Retinal vessel segmentation by deep residual learning with wide activation. Computational Intelligence and Neuroscience, 2020, 2020: 8822407. |

| [57] |

Liu WH, Jiang Y, Zhang JY, et al. RFARN: Retinal vessel segmentation based on reverse fusion attention residual network. PLoS One, 2021, 16(12): e0257256. DOI:10.1371/journal.pone.0257256 |

| [58] |

Zhang JW, Zhang YC, Qiu HL, et al. Pyramid-Net: Intra-layer pyramid-scale feature aggregation network for retinal vessel segmentation. Frontiers in Medicine, 2021, 8: 761050. DOI:10.3389/fmed.2021.761050 |

| [59] |

Gao JX, Huang QZ, Gao ZD, et al. Image segmentation of retinal blood vessels based on dual-attention multiscale feature fusion. Computational and Mathematical Methods in Medicine, 2022, 2022: 8111883. |

| [60] |

武婷婷. 基于生成对抗网络的视网膜血管图像分割算法研究 [硕士学位论文]. 郑州: 河南工业大学, 2021.

|

| [61] |

Goodfellow I, Pouget-Abadie J, Mirza M, et al. Generative adversarial nets. Proceedings of the 27th International Conference on Neural Information Processing Systems. Cambridge: MIT Press, 2014. 2672–2680.

|

| [62] |

Wu C, Zou YX, Yang Z. U-GAN: Generative adversarial networks with U-Net for retinal vessel segmentation. Proceedings of the 14th International Conference on Computer Science & Education. Toronto: IEEE, 2019. 642–646.

|

| [63] |

Yang TJ, Wu TT, Li L, et al. SUD-GAN: Deep convolution generative adversarial network combined with short connection and dense block for retinal vessel segmentation. Journal of Digital Imaging, 2020, 33(4): 946-957. DOI:10.1007/s10278-020-00339-9 |

| [64] |

Park KB, Choi SH, Lee JY. M-GAN: Retinal blood vessel segmentation by balancing losses through stacked deep fully convolutional networks. IEEE Access, 2020, 8: 146308-146322. DOI:10.1109/ACCESS.2020.3015108 |

| [65] |

Yue C, Ye MQ, Wang PP, et al. Generative adversarial network combined with SE-ResNet and dilated inception block for segmenting retinal vessels. Computational Intelligence and Neuroscience, 2022, 2022: 3585506. |

| [66] |

Liu ML, Wang ZD, Li H, et al. AA-WGAN: Attention augmented Wasserstein generative adversarial network with application to fundus retinal vessel segmentation. Computers in Biology and Medicine, 2023, 158: 106874. DOI:10.1016/j.compbiomed.2023.106874 |

2024, Vol. 33

2024, Vol. 33