带式运输机是我国工厂物料运输的关键一环, 其具有载量大、经济成本低等优势, 现阶段还有没有其他物料输送方式的效益可以超过带式运输机运输, 因此, 未来一段时间内, 带式运输机将继续占据我国工厂工业化生产的重要地位. 然而, 带式运输机在运送物料的过程中发生过各种各样的事故, 其中, 由于异物进入带式运输机的输送带而造成输送带损毁的事故占事故总数的61%[1]. 异物的来源多种多样, 现阶段, 工厂中基本采用人工巡检的方式检查传送带上是否有异物, 但是这种方法无法对异物进行长期有效的检测, 且漏检的概率很大. 因此, 利用深度学习构建异物检测网络, 对传送带进行全天候的检测, 是现阶段研究人员的主要研究目标.

目前, 基于深度学习的目标检测算法已经得到了较好的发展, 传统的单阶段检测网络, 例如YOLOv5[2]、single shot multibox detector[3]、VarifocalNet[4]等, 这些网络以牺牲精度为代价, 大幅度提高了网络的检测速度; 传统的双阶段检测网络, 以Fast-RCNN[5]、Mask-RCNN[6]、R-FCN[7]为代表, 虽然较好地提升了检测精度, 但随着带来的是模型复杂度的提升以及检测速度的降低.

与传统的目标检测任务既要求检测精度又要求预测框准确地将识别目标框住不同, 异物检测任务的主要目标是将图像中的非物料异物检测出来. 而且, 异物的图像与传统图像的特点也不相同, 在传统图像中, 被识别目标一般相对面积较大, 且特征明显, 易于识别, 而异物图像中的异物面积通常相对较较小, 且有些异物与物料的特征相似, 所以异物图像中有关异物特征信息相对较少. 在现有的异物检测方法中, 文献[8]通过计算原始图像与重构图像之间的重构误差来检测异物; 文献[9]提出了一种基于single shot multibox detector的网络, 通过对网络的损失函数进行改动来提高网络的性能; 文献[10]通过对图像之间的NMS差异特征的改动来提高网络的检测精度. 然而, 上述网络基本都采用“单一 CNN”或“单一CNN+new loss”的模式, 对网络的改动较小或者基本不改动, 导致模型的泛化能力不高, 无法针对多种多样的复杂场景, 而且并未考虑异物检测任务的核心问题. 因为不规则异物相对较小, 特征信息不多, 因此, 网络必须拥有较强的特征提取能力并且减少信息损失. 为了能够解决不规则异物识别任务的核心问题并且避免传统网络存在的问题, 本文提出了CAFN (coordinate attention and atrous convolution foreign detection network)模型, 通过在网络中加入coordinate attention机制, 提升网络的特征提取能力, 并且将网络backbone部分提取多尺度特征的常规卷积换为空洞卷积, 减少信息损失. 除此之外, 我们使用了CIoU函数作为损失函数, 相较于原始网络的GIoU损失函数, CIoU考虑得更为全面, 可以使网络的检测精度进一步提升.

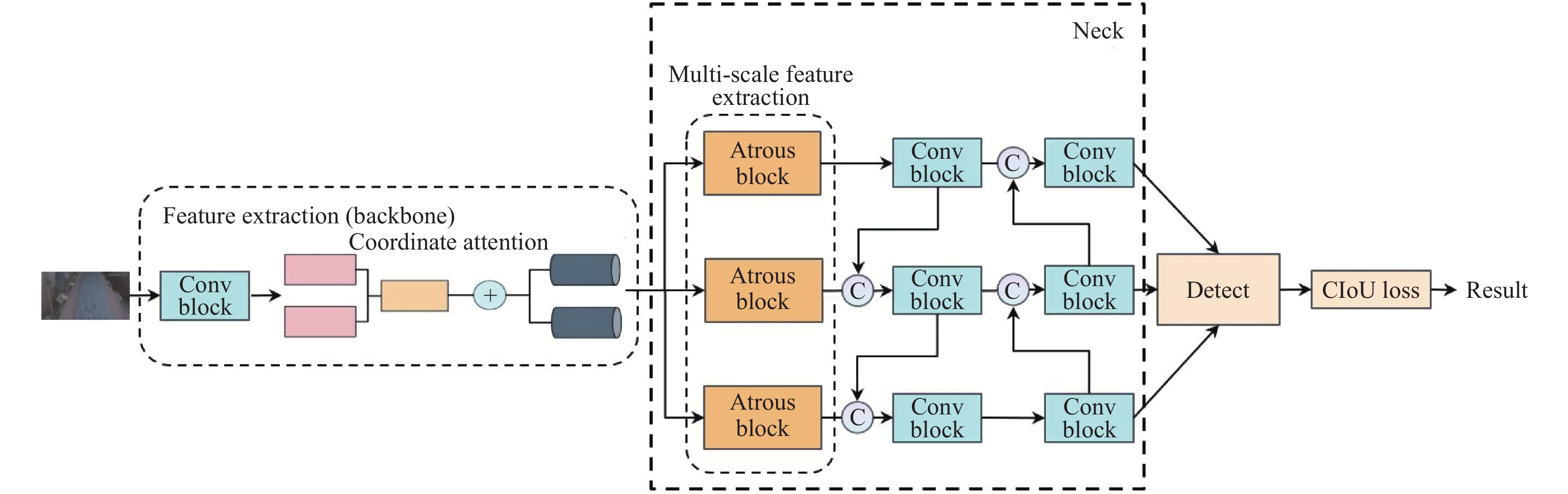

1 CAFN模型CAFN模型的整体框架如图1所示. 模型添加了coordinate attention机制, 来增强模型的特征提取能力, 该模型的具体流程如下.

|

图 1 CAFN网络结构 |

1) 输入待检测的图像.

2) 使用conv block提取图像特征, 利用coordinate attention机制将图像空间特征嵌入到通道注意力中, 增强图像特征中有用的信息, 并形成主干特征.

3) 使用由空洞卷积组成的atrous block提取主干特征中的不同尺度的特征, 减少信息丢失.

4) 对来自不同分支的不同尺度的特征进行特征融合, 分为下融合和上融合, 然后将融合后的特征输入到检测模块中.

5) 使用新的CIoU loss函数计算边界框的损失, 并进行梯度更新.

6) 输出当前模型的预测结果.

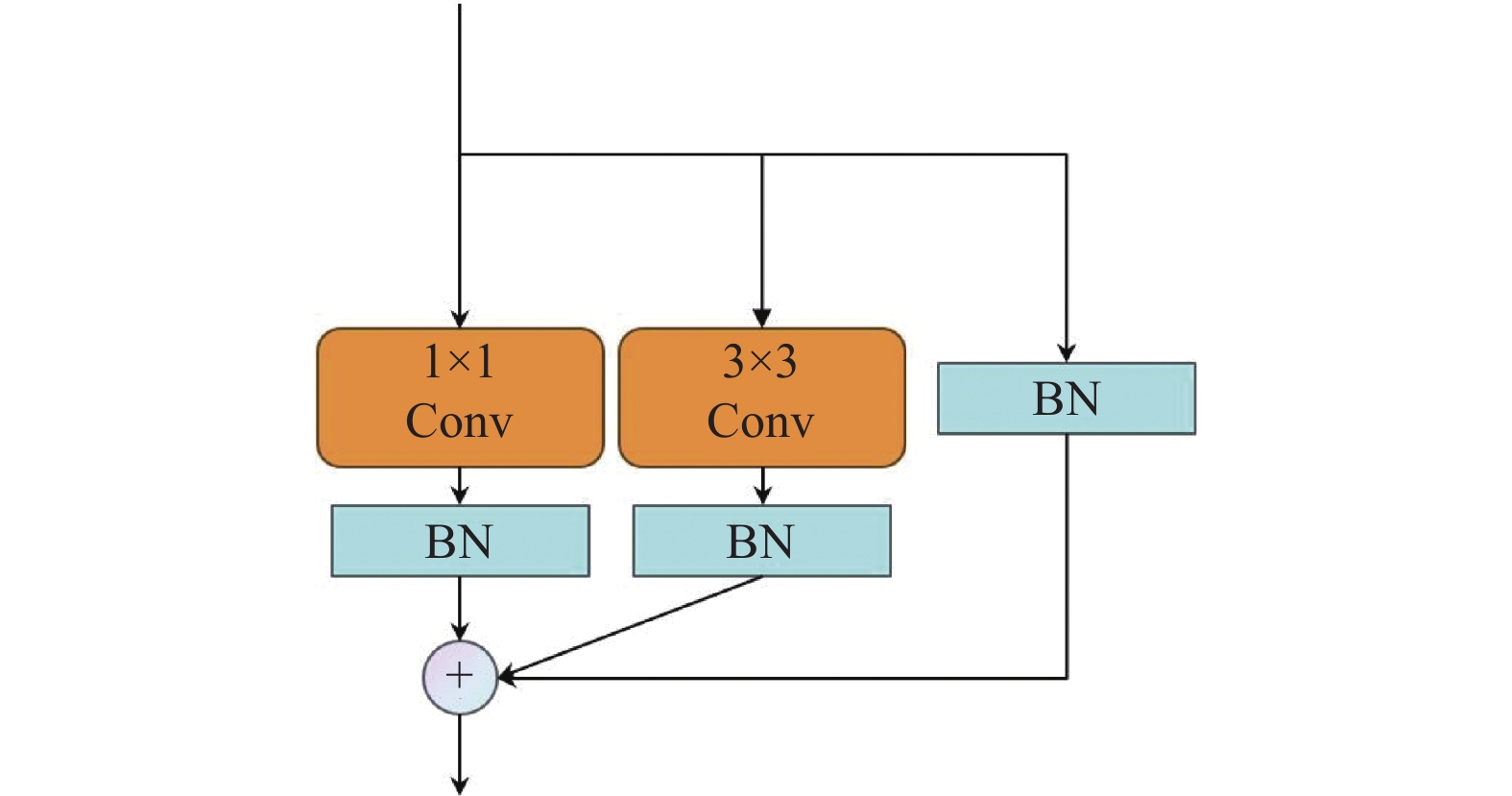

网络中的conv block模块由多个RepVGGBlock[11]构成, RepVGGBlock的结构如图2所示. 受ResNet[12]启发, RepVGGBlock是一种简单的残差结构, 它利用结构的重新参数化来将训练时的多分支拓扑结构与推理时的简单结构解耦, 与传统的多分支网络相比, 该结构显著降低了推理的时间成本.

|

图 2 RepVGGBlock结构 |

RepVGGBlock的计算过程可被概括为式(1):

| Output=BN(1×1Conv(Input))⊕BN(3×3Conv(Input))⊕BN(Input) | (1) |

其中,

近期的研究结果显示, 通道注意力, 例如SENet [13]注意力机制对于目标检测模型的性能提升有着很大的作用, 但通道注意力通常忽略了图像的空间信息, 也就是位置信息, 而位置信息对于异物检测任务来说非常重要[14], 因为该任务最关键的一点就是捕获图像中异物的位置. 传统的注意力机制, 例如BAM[15]和CBAM[16], 尝试通过减少特征向量的通道维度来利用空间位置信息, 然后使用常规卷积计算空间维度的注意力. 然而, 常规卷积只能捕获局部特征的关系, 而无法对视觉任务所必需的远程依赖关系进行建模[17,18].

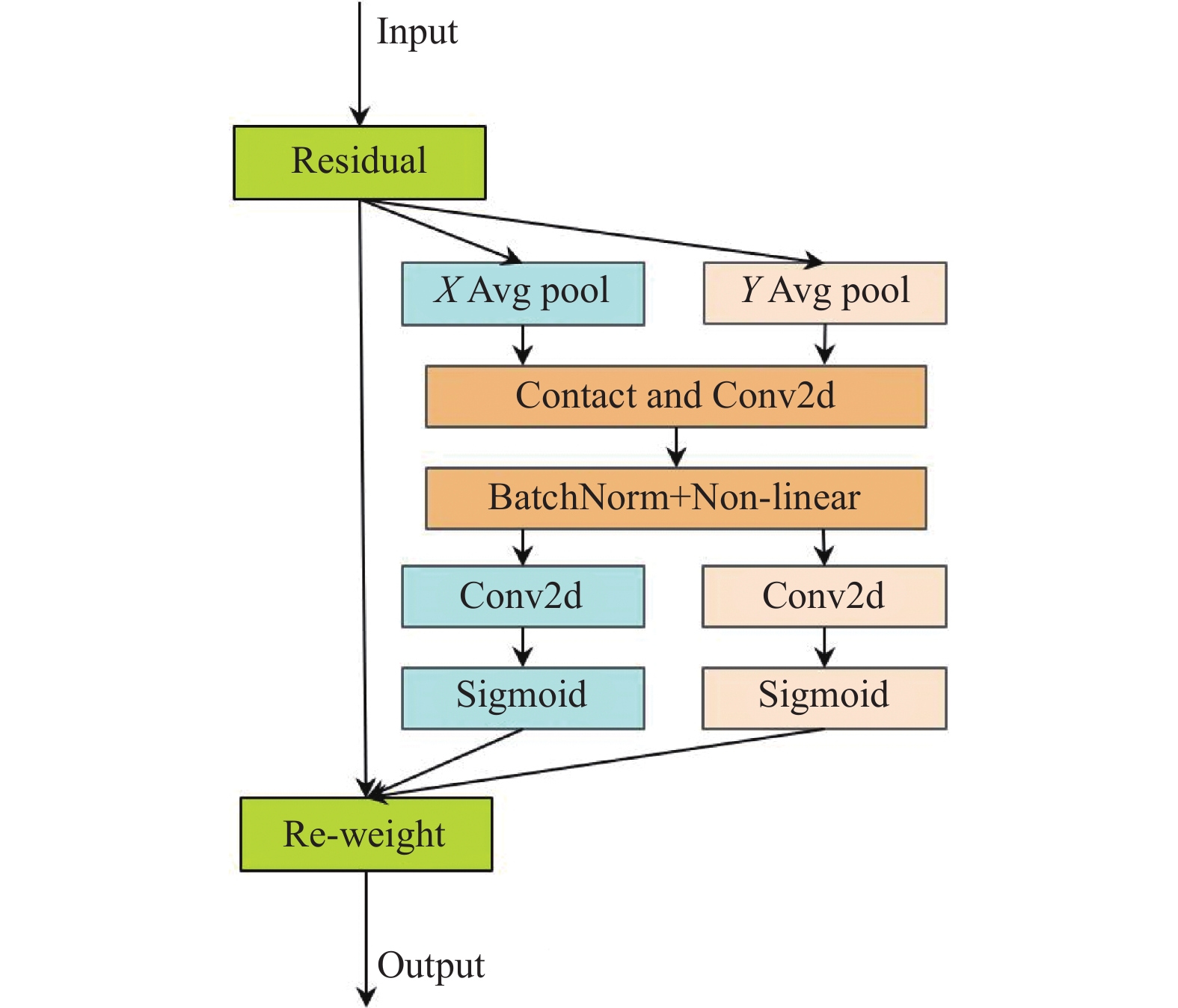

Coordinate attention机制很好地避免了这个问题. Coordinate attention机制利用两个1D的全局池化操作, 首先把沿水平和垂直方向输入的特征信息集成在2种单独的方向特征图中, 接着, 再把这2个具有嵌入的方向特征信号的特征图分别编码为两种注意力图, 每种注意力图捕获了输入特征图对沿同一个空间方向信息的长距离依赖性. 这样, 位置信息就可以被存储到生成的注意力图中. 这种方法在避免了二维全局池化引起的位置信息损失的同时, 也避免了产生显著的计算开销.

Coordinate attention机制的流程图如图3所示 (X Avg pool和Y Avg pool分别表示一维水平全局池化和一维垂直全局池化). 在coordinate attention机制中, 式(2)会被分解为一维的特征编码操作, 其目的是让注意力块利用特征图精确的位置信息捕获远程交互.

| zc=1H×WH∑i=1W∑j=1xc(i,j) | (2) |

其中, zc 是与第 c 个通道相关的输出.

|

图 3 Coordinate attention结构 |

因此, 对于给定输入X, 通过CA机制可以在池化内核的2个空间范围(H, 1)或(1, W)内分别沿水平坐标系和垂直坐标方向对每个通道进行解码. 所以, 第c个通道在高度h处的输出, 可表达为式(3):

| zhc(h)=1W∑0⩽i<Wxc(h,i) | (3) |

类似的, 宽度为 w 的第 c 个通道的输出可表示为式(4):

| zwc(w)=1H∑0⩽i<Hxc(j,w) | (4) |

与SENet不同, 上述的两个沿不同方向聚合特征的池化操作, 其会产生两个包含空间信息的特征图, 它允许注意力模块捕获不同空间方向的远程依赖性, 且另一个空间方向会保留精确的位置信息, 这有助于网络定位感兴趣的对象.

之后, CA机制通过Contact操作将两个特征图连接起来, 之后进行1×1卷积, 并进行归一化操作和BN操作, 过程如式(5)所示:

| f=δ(F1([zh,zw])) | (5) |

其中, [·,·]表示沿空间维度的串联操作,

| gh=σ(Fh(fh)) | (6) |

| gw=σ(Fw(fw)) | (7) |

其中,

之后, 输出gh和gw被扩展并分别用作注意力权重. 最后, CA机制的输出Y可被写为式(8):

| yc(i,j)=xc(i,j)×ghc(i)×gwc(j) | (8) |

Coordinate attention机制的具体算法描述如算法1所示.

算法1. Coordinate attention

输入: 图像浅层特征Input.

输出: 增强后的图像特征Output.

1. 将输入特征Input经过一维水平全局池化和一维垂直全局池化分别得到两个输出特征

2. 将

3. 将f分别经过两个卷积得到

4. 将

基于空洞卷积的模型被积极的用于语义分割和目标检测. 文献[19]实验了修改dilation rate以捕获提高网络捕获长距离信息的能力, 文献[20]在ResNet的最后两个模块中采用了混合空洞率, 而文献[21]进一步提出了可变形卷积, 是空洞卷积概念的进一步延伸. 文献[22]利用了图像标题和空洞卷积, 进一步提高了分割模型的准确性.

文献[23]认为, 尽管目标检测近年来取得了很大的进展, 但是针对小尺度物体的检测问题, 现阶段仍然没有较好的解决办法, 基于低级线索或DCNN的现有对象提议机制在小规模检测对象上的整体召回率较低, 而且DCNN的重复下采样导致深度卷积丢失了特征图的部分信息, 而这部分信息是高级特征信息, 对于目标检测来说是非常重要的, 为了解决这两个问题, 文献[23]提出了一种基于Fast-RCNN的统一深度神经网络, 这个网络是提出了一个空洞区域提议网络ARPN, 在最后一个卷积特征图上滑动一组空洞滤波器, 并增加膨胀率, 这个滤波器能够在不增加参数或操作数量的情况下扩大感受野, 从而能使ARPN更高效地捕获小尺度对象的特征; 文献[24]提出了一种基于空洞卷积的A2SPP (atrous atrous spatial pyramid pooling) 模块. 通过向原始 ASPP 的每个分支添加 CIEA 模块, 生成的 A2SPP 可以自动增强每个 3D 位置的基本尺度并抑制噪声尺度. 这种特征尺度聚合的方式提高了多尺度表示的能力. 此外, A2SPP添加了一个注意力残差分支来丰富多尺度特征. 使用A2SPP和CIEA作为基本模块, 构建了一个简单的编码器-解码器网络, 即A2SPPNet. 除此之外, 文献[25–27]将空洞卷积应用于目标检测.

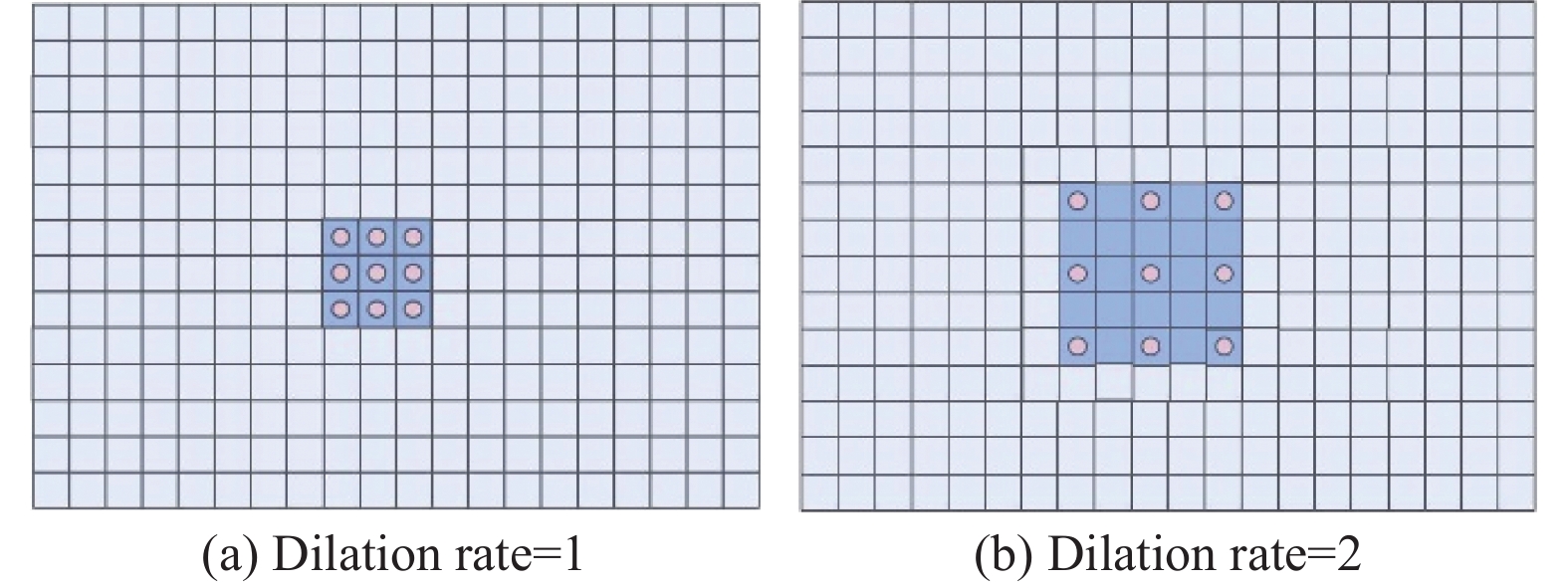

图4分别展示了空洞率为1的空洞卷积(图4(a))和空洞率为2的空洞卷积(图4(b)). 当空洞率为1时, 空洞卷积其实就是普通卷积. 本文将提取多尺度特征的卷积方式由常规卷积变为了空洞卷积. 由于空洞卷积能扩大感受野, 所以在提取多尺度特征时, 空洞卷积可以有效地减少信息丢失. 而且, 空洞卷积不会增加参数量, 因为卷积核大小和步长并未改变, 也没有增加新的卷积操作. 在我们的网络中, 我们将空洞率设置为2.

|

图 4 空洞卷积 |

1.3 损失函数

目标检测的损失函数一般由3部分组成: 分类损失、框回归损失以及对象损失.

框回归损失的主要目的是精确定位被检测对象的边框. 其中, IoU损失是现阶段常用且已经被公认有效的损失.

原始网络使用的是常规的GIoU损失函数, 他的损失函数表达式如式(9)所示:

| GIoU=IoU−C−(A∪B)C | (9) |

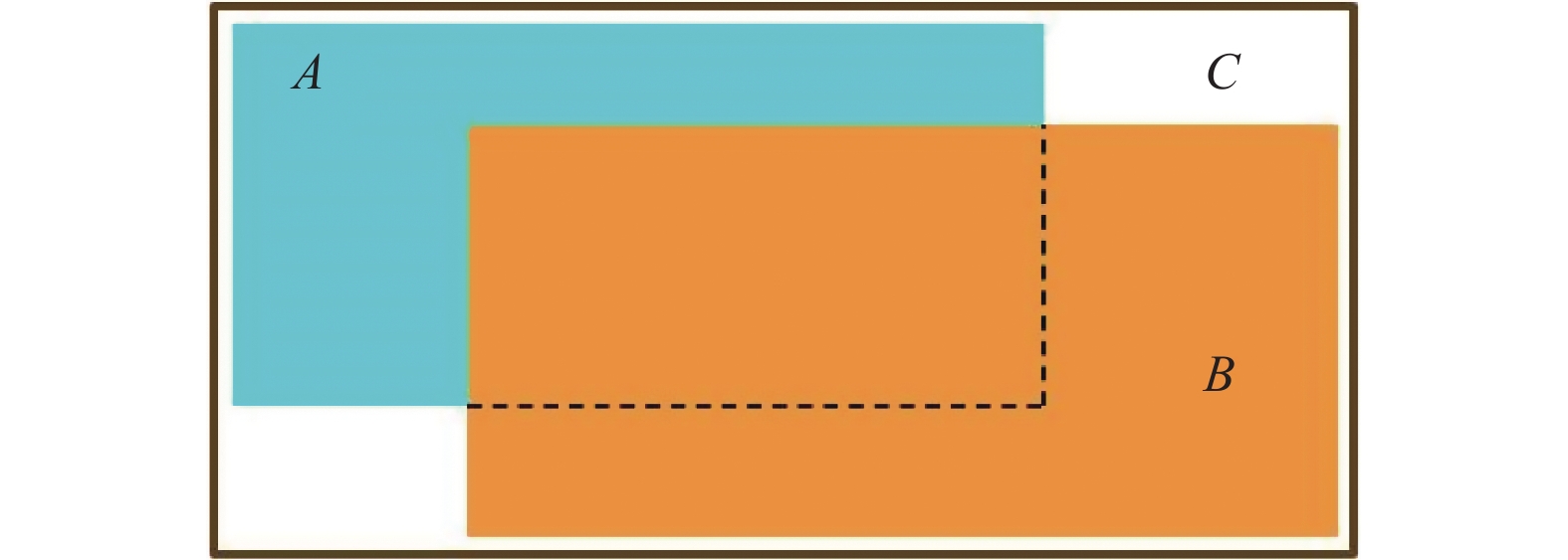

其中, IoU的表达公式如式(10)所示, IoU简称交并比. 图形化表达如图5所示.

| IoU=|A∩B||A∪B| | (10) |

其中, A是网络预测框(predict box), 也就是网络预测的物体位置; B是真实框(ground truth box), 也就是物体的正确位置.

|

图 5 IoU图形化表达 |

传统的GIoU损失函数, 仅考虑重叠框的面积的损失, 考虑元素较为单一, 严重依赖于IoU损失, 无法满足复杂的应用场景. 而CIoU[28]损失函数, 不仅考虑了框的重叠面积的损失, 还考虑了predict框与ground truth框中心点距离的归一化损失以及纵横比损失. CIoU损失函数的形式如式(11)所示:

| LCIoU=1−IoU+ρ(b,bgt)c2+αv | (11) |

其中, v和

| v=4π2(arctanwgthgt−arctanwh)2 | (12) |

| α=v(1−IoU)+v | (13) |

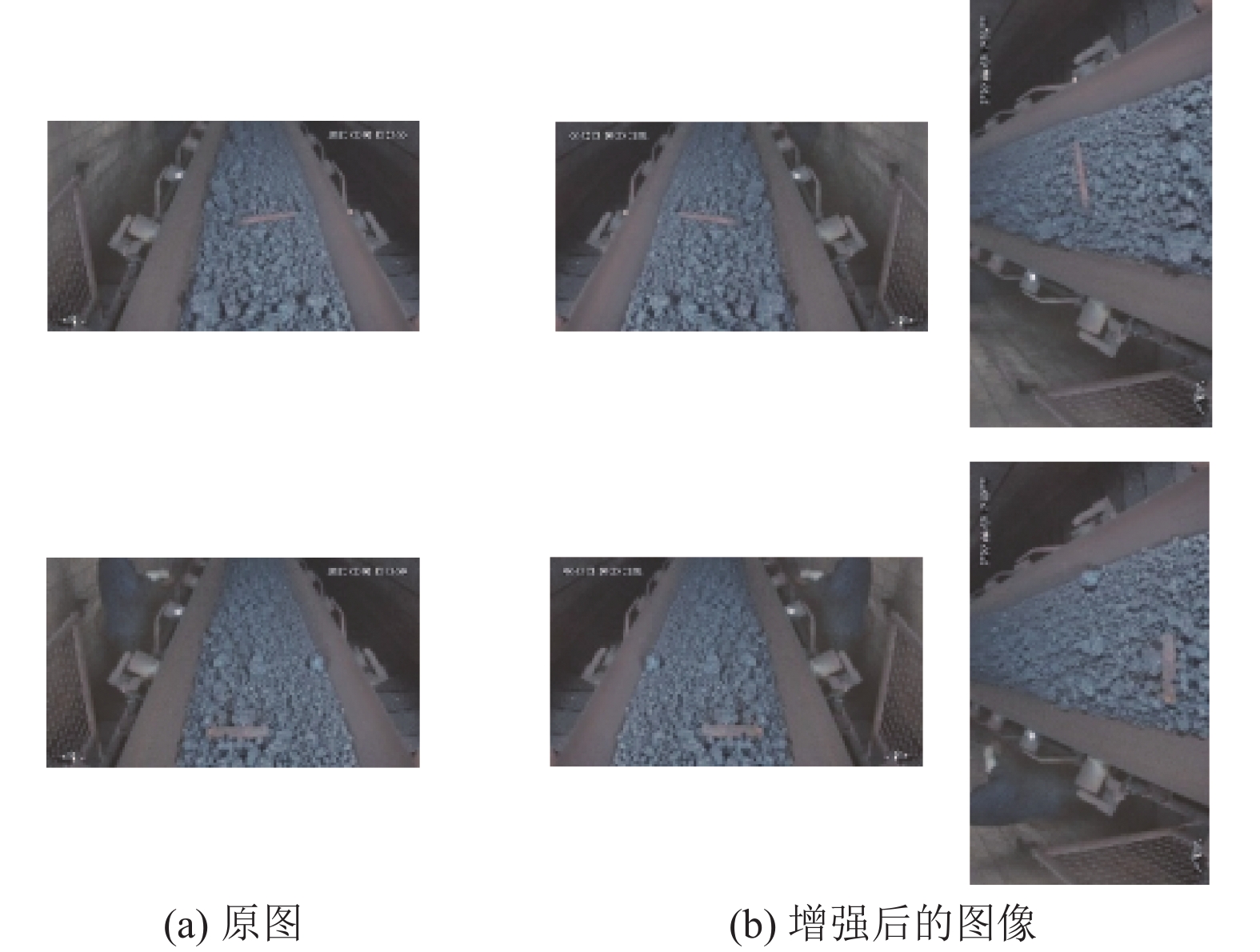

由于不规则异物检测任务比较特殊, 其数据通常都来自于工厂实地, 涉及企业机密, 因此现阶段并没有异物的公开数据集. 我们使用的异物数据集均来自于内蒙古某工厂, 我们通过现场采集和人工标注, 并对数据进行了数据增强, 构成了最终的不规则异物检测数据集, 数据集的数量及划分如表1所示. 我们进行的数据增强包括左右变换、旋转操作, 如图6所示. 除此之外, 我们还是用了公共数据集COCO对网络性能进行了评估, 以证明CAFN模型在传统目标检测任务上的有效性. COCO数据集是一个可以用于大规模目标检测任务的数据集, 它的trainset有118000张图像, valset有5000张图像.

| 表 1 不规则异物数据集(IFO)划分 |

|

图 6 不规则异物数据集的数据增强 |

2.2 实验环境

本文实验环境配置如表2所示.

| 表 2 实验环境配置 |

2.3 评价指标

不规则异物识别任务的核心目标就是将异物的位置标出, 所以预测框的位置是否精确直接决定了任务的成功与失败. 因此, 我们选用了AP、AP50、AP75这3个指标来进行网络性能的评价. 其中, 3个指标中AP的含义是平均精度(average precision, AP), AP指标的含义从IoU=0.5到IoU=0.95之间, 以0.05为步长, 所有区间的AP值加起来然后取平均值; AP50是指当IoU大于0.5时, 网络的AP值; AP75的含义是IoU大于0.75时, 网络的AP值. AP (平均精度)由召回率(recall, R)和准确率(precision, P)计算而来, AP的值越大, 说明网络的检测精度越高. 除此之外, 我们还使用了FPS指标来衡量网络的检测速度, FPS的含义是1 s的时间间隔内处理的图片数量.

2.4 实验参数我们实验的参数如表3所示, 除此之外, 我们使用随机梯度下降(SGD)优化器以及余弦衰减的学习率. 此外, 还利用了Warm-up、分组权重衰减策略和平均指数移动(EMA).

| 表 3 实验参数 |

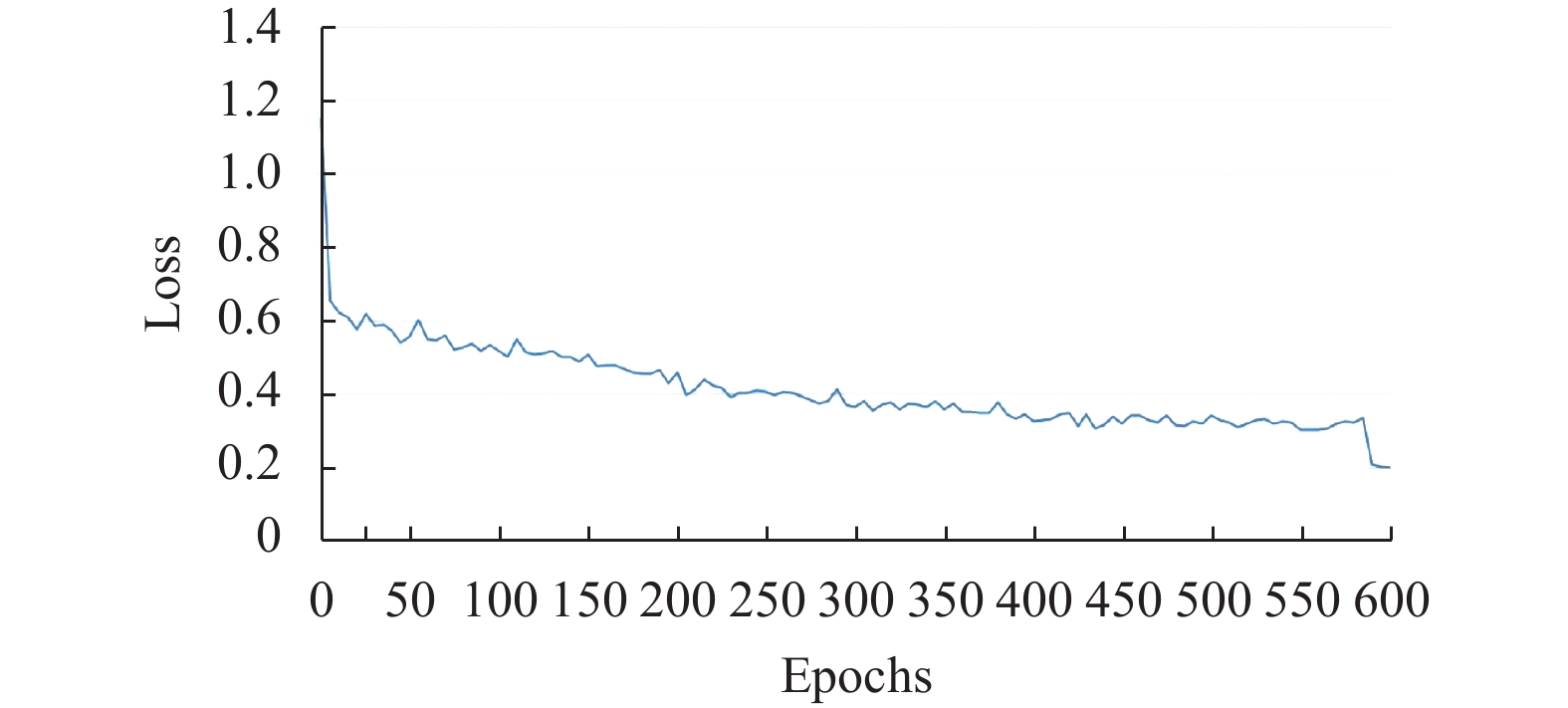

2.5 收敛曲线分析

使用CAFN模型在不规则异物数据集上经过600个轮次的训练后, loss的变化趋势如图7所示. 从图中可以看出, 损失曲线在开始训练阶段, 损失从1.18左右急速下降到0.7左右, 以及580个epochs模型损失从0.35左右急速下降到0.2左右, 这两个节点表明模型在急速收敛. 除了这两个特殊节点外, 其余曲线均缓慢波动下降, 整体损失是下降的, 证明我们的模型是有效的.

|

图 7 CAFN模型损失变化曲线 |

2.6 数据增强实验及分析

为了证明数据增强的有效性, 我们使用原始网络和CAFN网络分别对3种数据增强情况下的数据集进行了实验, 3种数据增强情况为: 1)没有数据增强, 即使用原始数据集; 2)仅左右变换, 即原始数据集+数据增强(左右变换); 3)完整增强(原始数据集+左右变换+旋转). 实验结果如表4所示, 其中, OM代表原始模型, CAFN代表本文提出的CAFN模型. Y代表原始数据集, LR代表数据增强(左右变换), RO代表数据增强(旋转).

| 表 4 数据增强实验(%) |

从表4中可以看出, 无论是原始模型还是CAFN模型, 经过数据增强后, 其模型的检测精度均有提升. 针对原始模型, 当仅使用原始数据集和左右旋转增强的数据集时, 相较于使用原始数据集, 原始模型的AP增加了27.3%, AP50增加了16.4%, AP75增加了24.6%; 当使用完整增强过的数据集后, 相较于使用原始数据集, 原始模型的AP增加了22.9%, AP50增加了20.0%, AP75增加了24.0%; 针对本文提出的CAFN模型, 当仅使用原始数据集和左右旋转增强的数据集时, 相较于使用原始数据集, CAFN网络的AP增加了27.4%, AP50增加了16.8%, AP75增加了26.7%, 使用完整增强过的数据集后, 相较于使用原始数据集, CAFN网络的AP增加了27.9%, AP50增加了23.6%, AP75增加了25.4%. 从结果可以看出, 本文进行的数据增强工作是有效的.

2.7 不同网络对比分析如表5和表6所示, 我们选用Faster-RCNN、Mask-RCNN、YOLOv6-S以及DETR这4种网络与我们提出的CAFN模型在异物数据集以及公共数据集COCO上进行了对比实验. Faster-RCNN是一种基于快速区域的卷积网络方法, Mask-RCNN为每个实例生成高质量的分割掩码, 通过对特征图进行随机遮挡来提高网络的鲁棒性, YOLOv6-S提出了一个基于高效可重新化参数的主干以及PAN拓扑的目标检测网络, 该方法较好地平衡了网络的速度与精度, DETR提出了一种基于Transformer的端到端的检测网络. 通过与这些网络进行对比实验, 证明ACFN模型在不规则异物检测任务以及传统目标检测任务上的有效性.

| 表 5 不同网络在不规则异物数据集上的对比实验 |

| 表 6 不同网络在公共数据集COCO上的对比实验 |

从表5中可以看出, 在不规则异物数据集上, DETR因为是以Transformer为基础结构的网络, 所以检测速度很慢; 我们提出的CAFN模型虽然识别速度不是最快的, 但是识别效果是最好的. 相较于每个主流网络, ACFN模型在AP、AP50、AP75这3个指标上均是最高的, 从而证明了ACFN网络在不规则异物检测任务上的有效性.

从表6可以看出, 在公共数据集COCO上, DETR因为是以Transformer为基础结构的网络, 所以虽然检测结果高但是检测速度很慢, 而且DETR网络只有AP50指标高于ACFN网络, 其他所有网络的所有指标均低于ACFN网络, 证明我们提出的网络在目标检测任务上尤其是高精度目标检测上优于传统网络. 表6的实验结果证明我们提出的CAFN网络在传统目标检测任务上也是十分有效的.

2.8 消融实验及分析本节中, 我们对网络进行了消融实验, 因为本文一共提出了3个创新点, 所以我们一共进行了7种不同组合的消融实验, 通过把某个模块或某两个模块增量地添加到原始网络当中, 来证明我们提出的模块是有效的. 实验结果见表7, 其中, CA代表coordinate attention机制, Atrous代表空洞卷积, CIoU代表新的损失函数.

从表7中可以看出, 当把coordinate attention模块、atrous block模块以及CIoU分别加入到网络中, AP值分别提高了2.2%、1.4%、1.3%, AP50分别提高了1.0%、0.2%、0.6%; AP75分别提高了0.1%、0.3%; 各个指标均有不同程度的提升, 证明我们提出的各个模块是有效的.

| 表 7 消融实验 (%) |

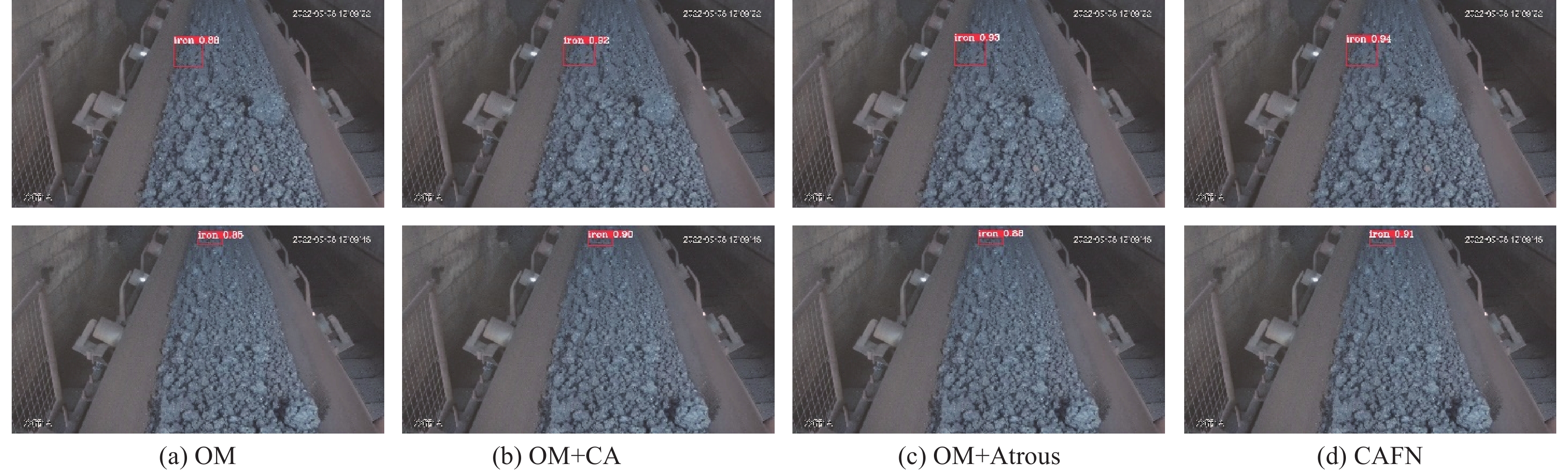

2.9 检测结果可视化实验

可视化实验的结果如图8所示, 其中, OM代表原始模型; CA代表coordinate attention机制; Atrous代表空洞卷积; CAFN代表本文提出的CAFN模型. 最左边的上下两张图片是两个不同的原始图像, 右边依次是添加不同模块后的可视化结果对比.

|

图 8 检测结果可视化实验 |

从结果中可以看出, 当检测目标处于图像边缘时, 将不同的模块加入到网络中, 检测效果均有提升, 当把所有的模块都加入到网络中, 组成本文提出的CAFN模型, 检测效果是最好的; 当检测目标与物料的特征差异较小时, 我们提出的模型检测效果也相对较好.

3 结论针对传统异物识别网络对于异物图像特征提取能力不足的问题、信息丢失的问题以及损失函数考虑不全面的问题, 我们提出了ACFN网络. 其中, coordinate attention机制通过将空间信息嵌入到通道注意力中, 使模型可以更好地获得图像的空间位置信息, 这对于异物识别任务来说有重要的意义. 空洞卷积由于其可以扩大感受野, 所以可以很好地防止异物特征的丢失, CIoU函数因为其全面的考虑, 所以拥有了比传统IoU损失函数更好的性能.

实验结果表明, 增强网络的特征提取能力以及减少特征信息的丢失, 不仅可以很好地解决异物识别的问题, 同时在传统目标检测任务上也有较好的性能.

| [1] |

曹虎奇. 煤矿带式输送机撕带断带研究分析. 煤炭科学技术, 2015, 43(S2): 130-134. |

| [2] |

Wu WT, Liu H, Li LL, et al. Application of local fully convolutional neural network combined with YOLOv5 algorithm in small target detection of remote sensing image. PLoS One, 2021, 16(10): e0259283. DOI:10.1371/journal.pone.0259283 |

| [3] |

Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector. Proceedings of the 14th European Conference on Computer Vision. Amsterdam: Springer, 2016. 21–37.

|

| [4] |

Zhang HY, Wang Y, Dayoub F, et al. VarifocalNet: An IoU-aware dense object detector. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 8510–8519.

|

| [5] |

Girshick R. Fast R-CNN. Proceedings of the 2015 IEEE International Conference on Computer Vision. Santiago: IEEE, 2015. 1440–1448.

|

| [6] |

He KM, Gkioxari G, Dollár P, et al. Mask R-CNN. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 2980–2988.

|

| [7] |

Dai JF, Li Y, He KM, et al. R-FCN: Object detection via region-based fully convolutional networks. Proceedings of the 30th International Conference on Neural Information Processing Systems. Barcelona: Curran Associates Inc., 2016. 379–387.

|

| [8] |

卢学明, 于在川, 许升起. 基于深度生成模型的煤矿运输皮带异物检测. 计算机系统应用, 2022, 31(5): 358-363. DOI:10.15888/j.cnki.csa.008468 |

| [9] |

Wang YB, Wang YJ, Dang LF. Video detection of foreign objects on the surface of belt conveyor underground coal mine based on improved SSD. Journal of Ambient Intelligence and Humanized Computing, 2023, 14(5): 5507-5516. DOI:10.1007/s12652-020-02495-w |

| [10] |

Xiao CK, Sun B, Wang YL, et al. Foreign object detection of sintering transport belt based on CNN. IFAC-PapersOnLine, 2021, 54(21): 25-30. DOI:10.1016/j.ifacol.2021.12.005 |

| [11] |

Ding XH, Zhang XY, Ma NN, et al. RepVGG: Making VGG-style ConvNets great again. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 13728–13737.

|

| [12] |

Targ S, Almeida D, Lyman K. ResNet in ResNet: Generalizing residual architectures. arXiv:1603.08029, 2016.

|

| [13] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7132–7141.

|

| [14] |

Wang HY, Zhu YK, Green B, et al. Axial-DeepLab: Stand-alone axial-attention for panoptic segmentation. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 108–126.

|

| [15] |

Park J, Woo S, Lee JY, et al. BAM: Bottleneck attention module. Proceedings of the 2018 British Machine Vision Conference. Newcastle: BMVA Press, 2018. 147.

|

| [16] |

Woo S, Park J, Lee JY, et al. CBAM: Convolutional block attention module. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 3–19.

|

| [17] |

Zhao HS, Shi JP, Qi XJ, et al. Pyramid scene parsing network. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 6230–6239.

|

| [18] |

Hou QB, Zhang L, Cheng MM, et al. Strip pooling: Rethinking spatial pooling for scene parsing. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 4002–4011.

|

| [19] |

Wu ZF, Shen CH, van den Hengel A. Bridging category-level and instance-level semantic image segmentation. arXiv:1605.06885, 2016.

|

| [20] |

Wang PQ, Chen PF, Yuan Y, et al. Understanding convolution for semantic segmentation. Proceedings of the 2018 IEEE Winter Conference on Applications of Computer Vision. Lake Tahoe: IEEE, 2018. 1451–1460.

|

| [21] |

Dai JF, Qi HZ, Xiong YW, et al. Deformable convolutional networks. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 764–773.

|

| [22] |

Wang GR, Luo P, Lin L, et al. Learning object interactions and descriptions for semantic image segmentation. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 5235–5243.

|

| [23] |

Guan TF, Zhu H. Atrous Faster R-CNN for small scale object detection. Proceedings of the 2nd International Conference on Multimedia and Image Processing. Wuhan: IEEE, 2017. 16–21.

|

| [24] |

Qiu Y, Liu Y, Chen YN, et al. A2SPPNet: Attentive atrous spatial pyramid pooling network for salient object detection. IEEE Transactions on Multimedia, 2022, 25: 1991-2006. |

| [25] |

Papandreou G, Kokkinos I, Savalle PA. Modeling local and global deformations in deep learning: Epitomic convolution, multiple instance learning, and sliding window detection. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 390–399.

|

| [26] |

Wang B, Ding H, Chen C. AC-YOLOv4: An object detection model incorporating attention mechanism and atrous convolution for contraband detection in X-ray images. Multimedia Tools and Applications, 2023: 1–20.

|

| [27] |

Huang J, Rathod V, Sun C, et al. Speed/accuracy trade-offs for modern convolutional object detectors. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 3296–3297.

|

| [28] |

Zheng ZH, Wang P, Liu W, et al. Distance-IoU loss: Faster and better learning for bounding box regression. Proceedings of the 34th AAAI Conference on Artificial Intelligence. New York: AAAI, 2020. 12993–13000.

|

2024, Vol. 33

2024, Vol. 33