雾、霾等复杂天气下捕获到的图像受到大气中混浊介质的影响, 具有明显的退化现象, 如颜色失真, 饱和度低、纹理细节模糊等, 而低质量的图像输入将难以解决其他高级计算机视觉任务, 导致图像分类、语义分割、目标检测及跟踪等任务的准确性降低[1–4]. 因此, 图像去雾[5]作为高级视觉任务的预处理步骤, 在计算机视觉任务中起着至关重要的作用. 图像去雾主要包括基于图像增强的去雾方法, 基于物理模型与先验知识的去雾方法和基于深度学习的去雾算法.

基于图像增强的去雾方法不依赖大气散射模型[6], 通过去除图像噪声、提高图像对比度来恢复清晰无雾图像, 如Retinex方法[7]、直方图均衡化[8]和小波变换[9]等, 此类方法并没有从根本上分析影响图像退化的因素, 导致去雾后的图像不够自然, 因此其去雾效果以及算法鲁棒性有限.

基于物理模型与先验知识的去雾算法通过先验知识或约束方程对物理模型参数进行估计, 以实现图像去雾. 最具代表性的是He等人[10]提出的基于暗通道先验(dark channel prior, DCP)的去雾算法, 该算法基于暗通道先验理论估算透射率与大气光值, 利用大气散射模型恢复无雾图像. Zhu等[11]提出颜色衰减先验(color attenuation prior, CAP)算法, 通过统计大量有雾图像, 发现雾霾浓度和图像的亮度与饱和度之差成正比, 由此建立了一个线性去雾模型. Meng等[12]提出一种边界约束和正则化去雾方法(BCCR), 使用边界约束估计透射率, 并增加上下文正则化来优化透射率, 可以较好地恢复图像中的细节信息. 虽然基于物理模型与先验信息的方法取得了显著的进展, 但是, 此类方法在无约束条件下, 通常会发生不准确的估计, 从而导致恢复出无雾图像的质量不够理想, 且这些手工制作的先验并不总是适用于各种现实世界的模糊场景.

与传统方法不同, 基于深度学习的图像去雾方法通过直接或间接地学习基于大规模数据集的映射函数来得到无雾图像. Cai等[13]提出基于卷积神经网络的介质传输估计网络DehazeNet, 通过估计模糊图像与其介质传输之间的映射关系实现端到端去雾; Li等[14]改进大气散射模型, 提出基于深度学习的图像去雾模型AOD-Net (all-in-one network), 将透射率图和大气光放到一个新的变量中, 通过轻量级卷积网络直接生成去雾图像; Chen等[15]提出一种基于平滑扩张卷积的门控上下文聚合网络GCANet, 解决了原始扩张卷积造成的网格化伪影问题; Qin等[16]提出一种特征融合注意力网络FFANet, 将像素注意机制与通道注意机制结合在一起构建双注意力模块, 应用注意力机制自适应学习不同特征信息的权重以实现图像去雾; Dong等[17] 基于生成对抗网络(generative adversarial network, GAN)提出了FD-GAN, 该网路将频率信息作为融合鉴别器的先验, 指导网络生成更加真实自然的去雾图像; Wu等[18]提出了一种基于对比学习的对比正则化算法AECR-Net, 利用清晰图像和有雾图像的信息分别作为正负样本, 并借助提出的CR (contrastive regularization)恢复无雾图像; Song等[19]提出一种U-Net的变体网络gUNet, 使用具有门控机制的残差块代替卷积块, 通过选择性内核融合主路径和跳过连接的特征图, 显著降低网络开销; Zheng等[20]提出的C2PNet, 结合物理感知双分支单元和课程学习对比正则化, 重新调整对比正则化中不同负样本的重要性, 提高去雾特征空间的可解释性. 除此之外, 随着Transformer逐渐应用于图像领域, Guo等[21]提出的DeHamer通过学习基于Transformer特征的调制矩阵来调制CNN特征, 解决Transformer与CNN之间的特征不一致问题, 同时提出一种新的传输感知三维位置嵌入, 有效地将先验信息引入Transformer, 以此提高去雾性能. Song等[22]提出了一种Swin Transformer和U-Net结合的图像去雾网络DehazeFormer, 通过对Swin Transformer的归一化层、激活函数和空间信息聚合方案进行改进, 使Transformer更适合于图像去雾.

然而, 随着数据驱动方法的发展和去雾性能的提高, 去雾网络的复杂性也在增加. 现有的基于深度学习的算法仍然存在以下挑战: 极易出现去雾不彻底、对比度下降和颜色失真现象; 模型参数量大; 训练策略复杂; 在真实有雾图像数据集上的去雾效果不理想.

对于以上问题, 本文提出了一种结合密集注意力的自适应特征融合图像去雾网络(adaptive feature fusion image dehazing network combined with dense attention, DAAF-Net), 该网络不依赖于大气散射模型, 而是通过学习有雾图像到无雾图像之间的映射关系来恢复无雾图像. DAAF-Net可以很好地解决局部雾霾残留及去雾不彻底现象, 在合成有雾图像以及真实有雾图像上具有强大的还原图像细节和色彩保真度的能力. 本文的具体贡献如下.

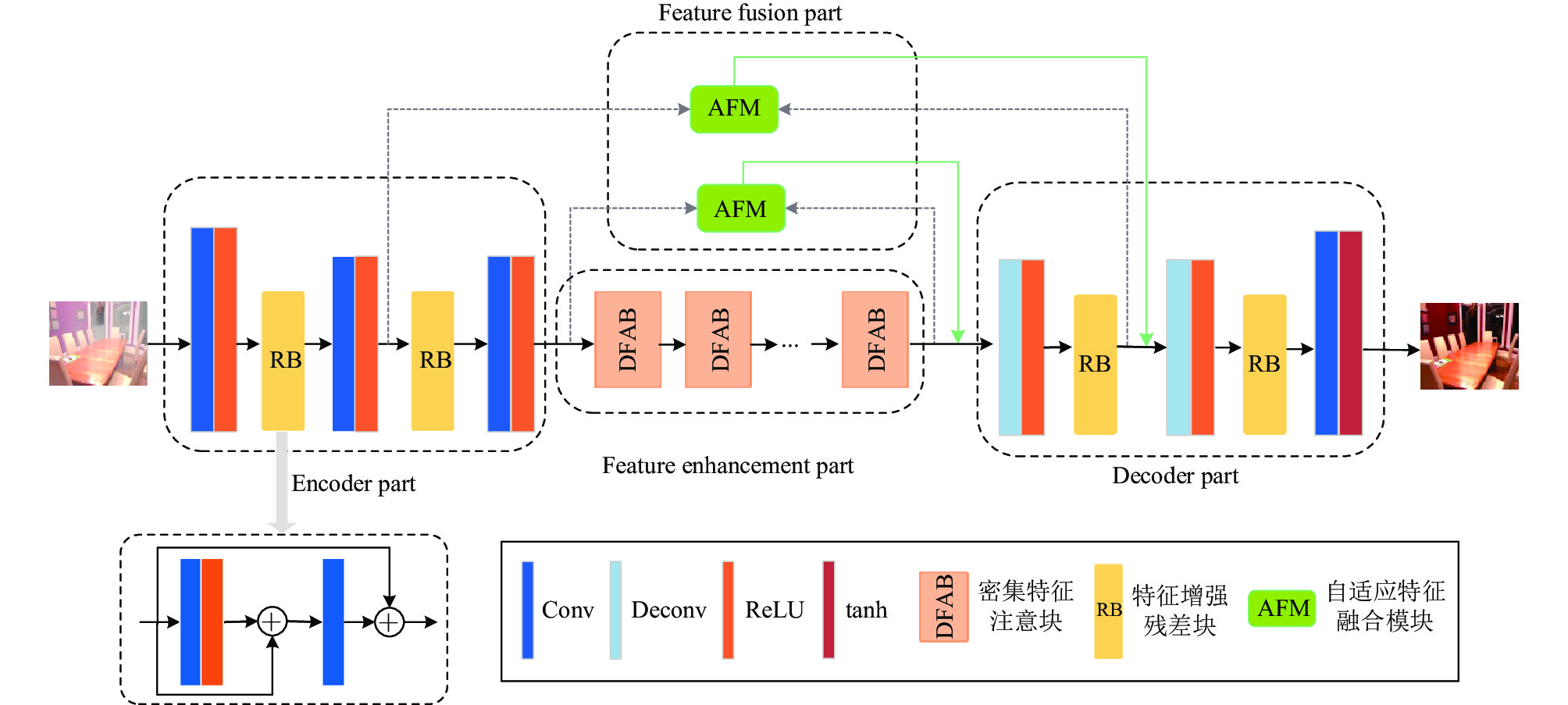

(1)提出结合密集注意力的自适应特征融合图像去雾网络. 通过一个包含特征增强部分(feature enhancement part)和特征融合部分(feature fusion part)的基于编解码器结构的去雾网络来有效地提取图像特征, 融合不同尺度特征信息, 恢复清晰无雾图像.

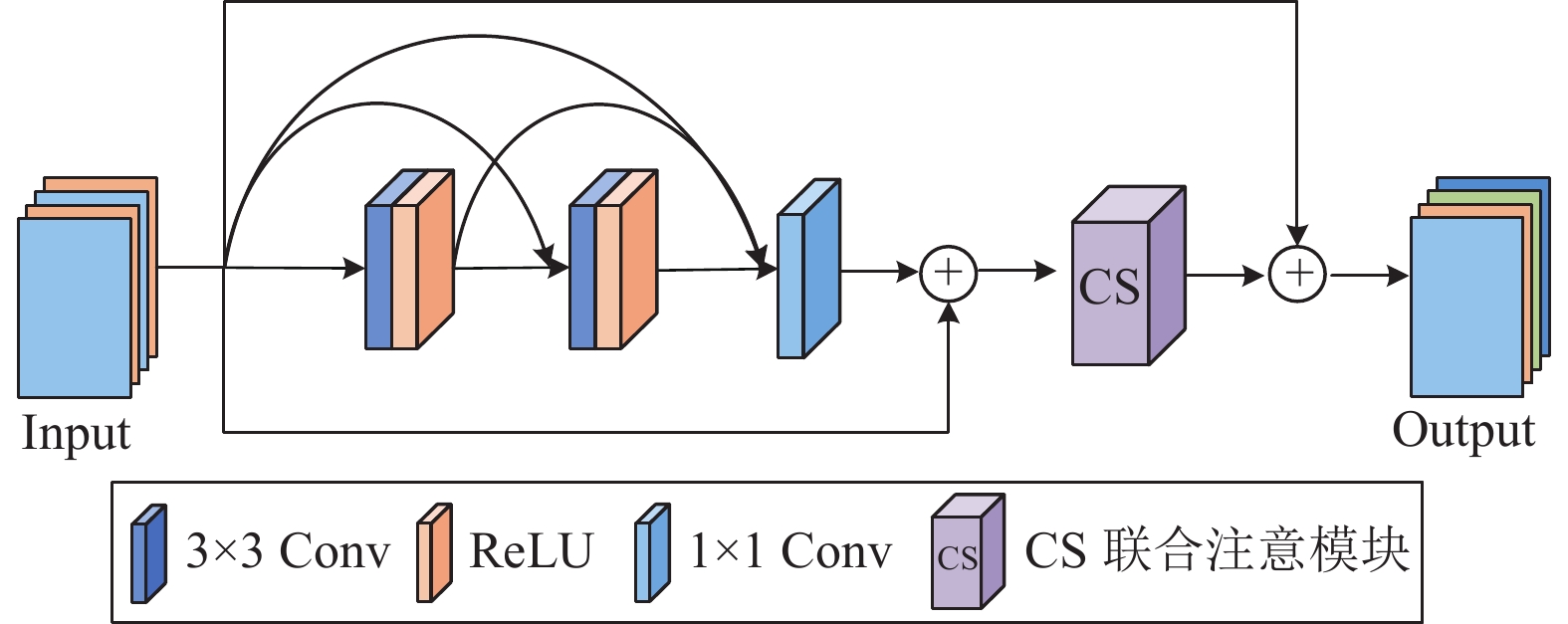

(2)提出一种嵌入CS联合注意模块(channel-spatial attention combination module)的密集特征注意块(dense feature attention block, DFAB). DFAB结合密集残差网络和注意力机制, 增强特征的重复利用, 有效防止梯度消失; CS联合注意模块依次从通道维度和空间维度聚焦上下文特征信息, 解决不同级别的不均匀雾度分布.

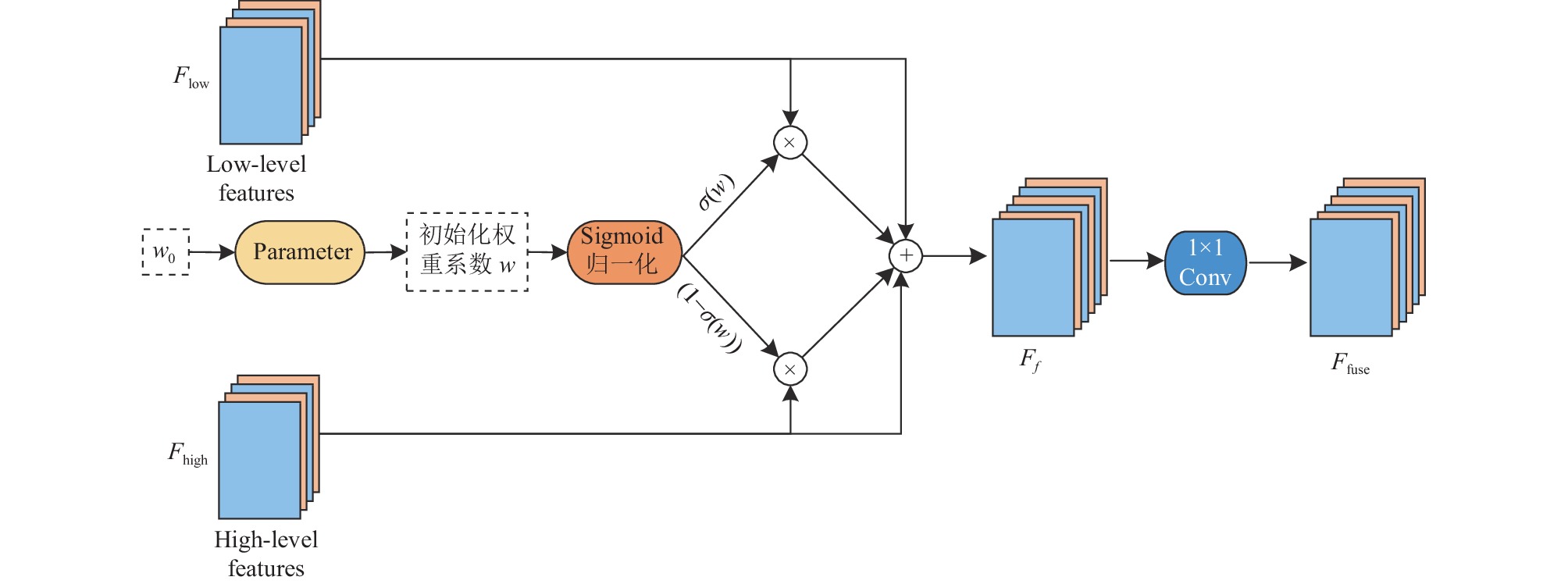

(3)提出融合低级与高级特征的自适应特征融合模块(adaptive feature fusion module, AFM), 动态融合下采样层和上采样层之间的信息以防止浅层特征逐渐退化.

2 DAAF-Net模型设计 2.1 网络总体架构本文提出了结合密集注意力的自适应特征融合图像去雾网络DAAF-Net. 该网络由编码器部分(encoder part)、特征增强部分(feature enhancement part)、解码器部分(decoder part)以及特征融合部分(feature fusion part)组成. DAAF-Net首先将输入的雾霾图像送入编码器中进行下采样, 利用多层卷积和特征增强残差块(feature-enhanced residual block, RB)提取浅层特征, 如图像轮廓、纹理等, 之后将编码器提取的图像特征送入特征增强部分, 由密集特征注意块学习低分辨率空间中的特征表示, 从而达到特征增强的目的, 最后将增强后的特征送入解码器部分来恢复清晰无雾图像, 与编码器部分不同的是, 解码器采用步长为2的反卷积将特征图像恢复为原始输入图像尺寸. 同时, 为了防止浅层特征丢失, 本文设计了自适应特征融合模块来充分融合上下采样层之间特征. 网络整体框架如图1所示.

2.2 密集特征注意块(DFAB)为获取图像的深层特征, 本文在特征增强部分叠加6个密集特征注意块DFAB, 进一步提高了DAAF-Net的性能. 密集特征注意块如图2所示. DFAB采用密集残差连接和注意力机制的思想, 一方面, 密集连接通过特征在通道上的连接来实现特征重用, 缓解梯度消失问题, 而局部残差学习绕过薄雾区域和低频信息, 使得主网络更多关注浓雾, 学习到更多有用的信息; 另一方面, CS联合注意模块依次从通道维度和空间维度聚焦上下文特征信息, 在处理不同类型的信息时提供额外的灵活性, 并且可以扩展CNN的表示能力.

|

图 1 DAAF-Net网络整体框架 |

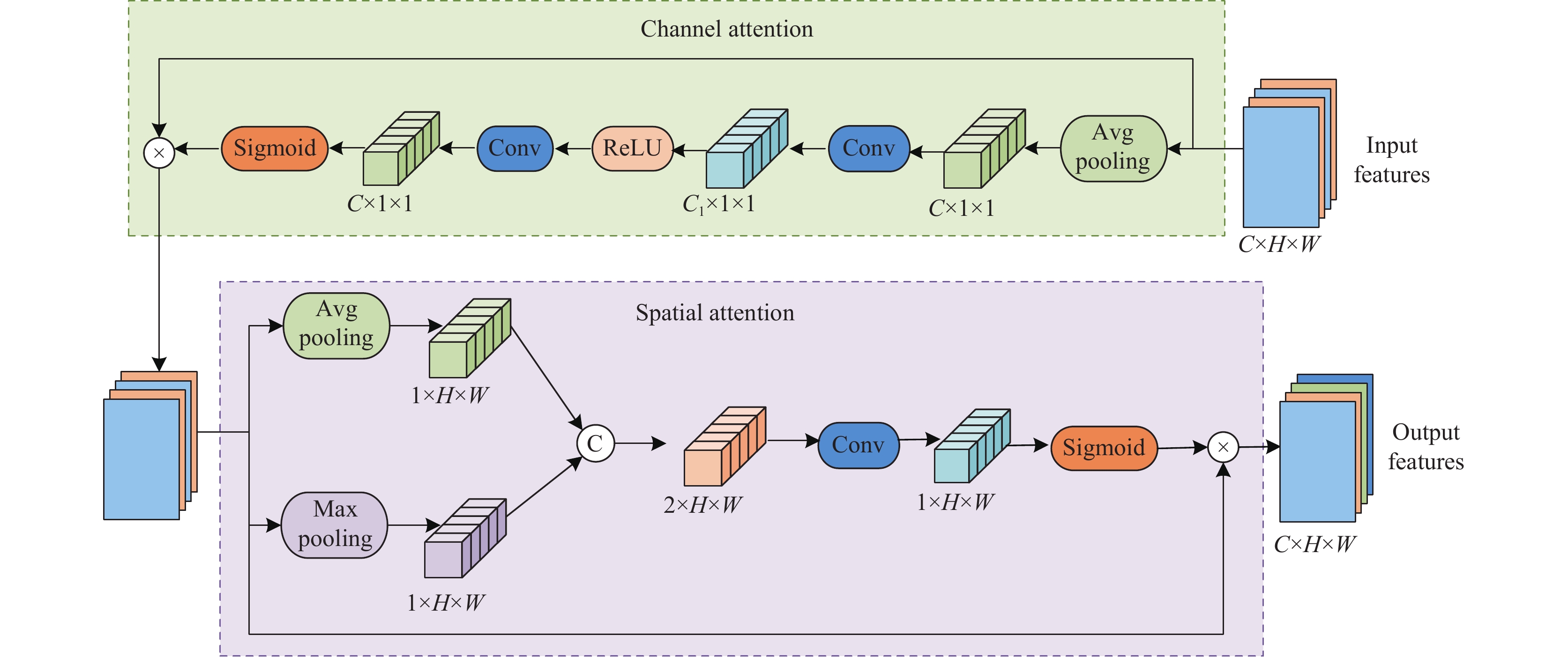

CS联合注意模块如图3所示. 该模块将通道注意力和空间注意力顺序连接以计算通道和空间维度上的注意权重, 使得输出的深层特征具有全局视野, 从而使网络能够更好地辨识重要特征依赖关系, 过滤非重要信息, 进而提升网络的性能.

通道注意力关注通道差异, 计算通道注意力特征图, 而不考虑上下文信息, 其权重系数

|

图 2 密集特征注意块 |

设

| GC=AvgPool(Fin) | (1) |

| WC=σ(Conv1×1(δ(Conv1×1(GC)))) | (2) |

其中,

将通道权重WC与输入特征Fin中各通道的对应元素相乘, 输出大小为C×H×W的特征图FC. 如式(3)所示:

| FC=WC⊗Fin | (3) |

在通道注意力之后, 引入空间注意力, FC即为空间注意力的输入特征, 首先对输入特征FC分别进行一个通道维度的最大池化和平均池化, 使网络分别获取纹理特征信息和全局上下文信息, 然后通过通道相加将池化操作后得到的包含不同空间信息的重要特征进行融合, 得到2×H×W维的特征. 此后经过卷积和Sigmoid函数, 得到权重系数WS. 计算过程如式(4)和式(5)所示:

| GS=Concat(AvgPool(FC),MaxPool(FC)) | (4) |

| WS=σ(Conv7×7(GS)) | (5) |

其中,

|

图 3 CS联合注意模块 |

将空间权重

| FS=WS⊗FC | (6) |

大量实验表明, 将编码器部分与解码器部分的特征融合在图像去雾以及其他低级视觉任务中是一种有效的技巧. 通常情况下, 去雾网络的低层次特征(如边缘和轮廓)可以在神经网络的浅层特征提取层捕获, 然而, 随着网络深度的增加, 网络的浅层特征逐渐退化, 使得图像恢复阶段所得到的特征图存在边缘模糊, 细节丢失等现象. 为了解决这个问题, 一部分工作通过引入包含逐元素相加(element-wise addition)或者通道相加(Concat)操作的跳过连接来生成新的特征. 然而, 对于本文的去雾网络, 简单的相加或串联操作并不能充分融合上采样层和下采样层之间特征. 鉴于此, 本文提出了自适应特征融合模块AFM, 该方法通过Parameter函数引入可训练的权重

|

图 4 自适应特征融合模块 |

编码器部分中的低级特征和相应的高级特征被传送到AFM模块, AFM通过自适应学习权重调整融合比例, 使下采样部分的浅层特征信息自适应地流向上采样部分, 这对于低级特征保留是十分有效的, 比加法操作更灵活. 该模块还通过跳过连接来添加输入特征, 以减轻梯度消失问题并简化学习过程. 最后, 通过1×1卷积层将融合后的特征进行投影, 得到最终的输出特征(即

| Ff=Flow +Fhigh +Flow ×σ(w)+Fhigh ×(1−σ(w)) | (7) |

| Ffuse =Conv1×1(Ff) | (8) |

其中, Ffuse是AFM处理后的最终输出, Ff是融合低级与高级特征后的特征图, Flow和Fhigh分别是来自下采样层和上采样层的低级特征和高级特征,

本文通过Smooth L1损失和感知损失加权相加来训练所提出的网络.

Smooth L1损失: Smooth L1损失结合了L1与L2范数的部分优点, 提供了去雾图像和真实图像之间差异的定量测量, L1范数可以防止潜在的梯度爆炸, 它对异常值的敏感性低于MSE损失. Smooth L1损失的表达式如式(9)和式(10)所示:

| LS=1N∑Nx=1∑3i=1FS(Ii(x)−Ji(x)) | (9) |

| FS(e)={0.5e2,if|e|<1|e|−0.5,otherwise | (10) |

其中,

感知损失: 不同于逐像素损失, 感知损失(perceptual loss)通过从预训练的神经网络中提取特征来量化估计去雾图像和真实图像之间的差异, 相比普通的L2损失而言, 可以增强输出特征的细节信息. 本文使用预训练的VGG16作为损失网络, 并从前3级(即Conv1-2、Conv2-2和Conv3-3)的最后一层提取特征. 感知损失的表达式如式(11)所示:

| LP=∑3j=11CjHjWj‖ϕj(ˆJ)−ϕj(J)‖22 | (11) |

其中,

总损失: 总损失函数表达式如式(12)所示:

| L=LS+λLP | (12) |

其中,

本文评估模型的数据集主要采用RESIDE数据集[24]和O-HAZE数据集[25]. RESIDE是一个大规模的合成有雾图像数据集, 共分为5个子集, 本文选取室内数据集ITS (indoor training set)和室外数据集OTS (outdoor training set)作为训练集, 综合目标测试集SOTS (synthetic objective testing set)为测试集. ITS包含1399张清晰图像, 每个清晰图像根据不同的大气光值和beta值合成10张模糊图像, 共包含13990张合成模糊图像. 与ITS相似, OTS选取2061张来自北京实时天气的真实室外图, 每张清晰图像合成35张有雾图像, 共包含72135张户外模糊图像. 为了加快模型的收敛速度, 本文从OTS中选取18200对合成室外图像来训练网络. SOTS测试集包括500对室内图像和500对室外图像, 由于SOTS室外测试集所包含的图像尺寸大小不同, 通过缩放操作将测试集图片调整为统一大小以便于与其他模型作对比. 除此之外, 为了验证模型的泛化性, 本文还采用真实世界数据集O-HAZE评估模型性能, O-HAZE数据集包含45张有雾图像和相应的清晰图像, 随机选取39张有雾图像作为训练集, 6张有雾图像作为测试集, 采用双线性插值的方式将这些图像Resize成380×360大小以便于训练.

3.1.2 评价指标为了客观评价本文算法的优劣, 采用峰值信噪比(peak signal-to-noise ratio, PSNR)和结构相似性(structural similarity, SSIM)作为去雾图像质量评价的客观指标. PSNR是一种评价图像质量的度量标准, PSNR越大, 图像失真越小. 其计算公式如式(13)所示:

| PSNR=10log10(MAX2IMSE) | (13) |

其中,

| MSE=1mn∑m−1i=0∑n−1j=0[I(i,j)−K(i,j)]2 | (14) |

其中,

SSIM是衡量两幅图像相似度的指标, 主要考量图像亮度、对比度和结构, 能够评价处理前后两张图片的接近程度, SSIM越大, 处理后的图片越接近原始图片. 其计算公式如式(15)所示:

| SSIM(x,y)=(2μxμy+c1)(2σxy+c2)(μ2x+μ2y+c1)(σ2x+σ2y+c2) | (15) |

其中,

本文使用Python 3.7和PyTorch 1.10搭建深度学习环境, 在NVIDIA GeForce RTX 3060 GPU上开展实验. 本文在RGB通道中训练网络, 训练图像被随机裁剪为240×240大小作为网络的输入, 网络模型训练使用Adam优化器, 批量大小为8, 其中

将本文算法与图像去雾领域的多个经典网络进行比较, 比较方法包括DCP[10]、AOD-Net[14]、GCANet[15]、GridDehazeNet[26]、MSBDN[27]、MSTN[28]和DehazeFormer-T[22]. 其中, DCP为经典的基于先验知识的方法, AOD-Net为改进大气散射模型的端到端去雾算法, 其他5种对比方法都是最近几年基于深度学习的图像去雾方法, GCANet为基于编解码器结构的门控上下文聚合网络, GridDehazeNet为基于注意力机制的一个3行6列的多尺度网格网络, MSBDN为基于U-Net的多尺度增强去雾网络, MSTN为基于多尺度特征融合模块和自适应特征选择模块的多尺度拓扑网络, DehazeFormer-T为Swin Transformer和U-Net结合的图像去雾网络DehazeFormer的一个变体网络. 为了定性地比较算法优劣, 本文采用统一的数据集及训练方案对各网络进行了重新训练, 将最终测试图像裁剪为统一大小用于结果展示.

3.3.1 合成有雾图像数据集上的结果不同去雾方法在SOTS合成测试集上对比实验结果如表1所示, 表1中加粗数据表示该组数据的最优结果. 与现有的方法相比, 本文提出的DAAF-Net在SOTS室内测试集上PSNR为35.81 dB和SSIM为0.9889 的最佳性能, 在SOTS室外测试集上PSNR为27.96 dB 和SSIM为0.9197的性能, 在SOTS室外测试集上SSIM略低于MSTN, 差距仅为0.0008. 除此之外, 本文算法的参数量仅为3.19M, 明显低于MSTN算法.

图5和图6分别展示了本文的DAAF-Net与现有的经典方法在SOTS室内测试集和SOTS室外测试集上的视觉效果. 在SOTS室内测试集上, AOD-Net整体去雾功能几乎失效, 存在大量的雾霾残留; DCP算法存在对比度偏低和颜色失真现象, 且在图像光线较暗的区域有明显的雾霾残留现象; 与DCP算法相反, GCANet对比度偏低、整体色彩较暗; 其他4种对比算法整体去雾效果较好, 但仍然有轻微的雾霾残留, 如GridDehazeNet算法的第1幅图片的桌角上方亮暗交替区域存在未恢复的薄雾; MSBDN算法的第1幅图片左面的一排椅子旁边存在雾霾残留; DehazeFormer-T算法第2幅图片左下角地面有雾霾残留; MSTN去雾效果较好, 但其定量评价结果仍低于本文算法.

| 表 1 不同方法在SOTS测试集上的定量评价结果 |

|

图 5 不同方法在SOTS室内图像上的测试结果 |

在SOTS室外测试集上, DCP去雾效果极差, 颜色偏移严重, 尤其是图像存在大面积白色区域和天空部分时颜色失真严重; AOD-Net整体图片较为模糊, 色彩较暗, 且第3幅图片远处的楼层模糊, 去雾不彻底; GCANet去雾效果较AOD-Net略好, 但第3幅图片远处的楼层仍有雾霾残留, 第2幅和第4幅图片天空区域色彩较暗; GridDehazeNet算法有明显的颜色伪影, 如第2幅图片的天空区域与第4幅图片的楼层旁边; MSBDN较清晰图片色彩略微偏暗; DehazeFormer-T算法第3幅图片远处的楼层颜色略暗; 本文模型与MSTN去雾效果较好, 颜色和细节体现上最接近标准无雾图.

3.3.2 真实有雾图像数据集上的结果合成有雾图像雾霾分布均匀, 因此各算法去雾效果较好, 而现实中真实世界拍摄的有雾图片通常伴随浓雾, 雾霾分布不均匀, 为进一步验证本文方法对真实有雾图像的有效性, 本文采用真实世界数据集O-HAZE对网络进行训练, 同时与上述其他去雾方法作对比, 不同去雾方法在O-HAZE数据集上对比实验如表2所示. 由表2可知, 本文提出的DAAF-Net在O-HAZE数据集上PSNR为22.75 dB, SSIM为0.7788, 获得了最优性能.

|

图 6 不同方法在SOTS室外图像上的测试结果 |

相应的视觉效果对比图如图7所示. 从图7可以观察到, 当使用真实有雾图像训练时, 模型测试结果普遍偏低. 其中, DCP算法图像整体色彩偏蓝, 存在严重的颜色偏差; 而AOD-Net色彩较暗, 图片对比度偏低, 视觉效果较差; GCANet去雾效果较好, 但图像色彩整体偏亮, 且有明显的雾霾残留; GridDehazeNet、MSBDN、MSTN和DehazeFormer-T都存在不同程度的雾霾残留现象, 如第1幅图片的木头在浓雾处明显去雾不彻底, 第2幅图片远处的树木、第3幅图片的草地和远处的树木以及第4幅图片的地面及栏杆处都有雾霾残留. 整体来说, 本文算法无论从去雾效果还是图像的色彩对比度恢复方面均优于其他算法.

| 表 2 不同方法在O-HAZE数据集上的定量评价结果 |

3.4 消融实验

为进一步验证网络中各模块的有效性, 在SOTS室内测试集上设计如下消融实验.

|

图 7 不同方法在O-HAZE数据集上的测试结果 |

3.4.1 不同模块组合消融实验

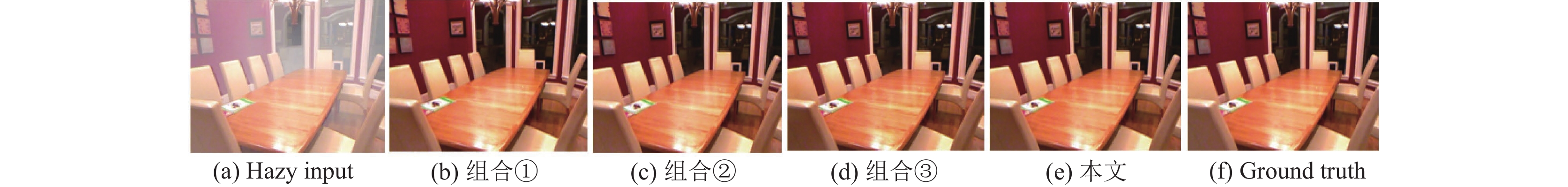

通过对网络中各模块进行不同的组合来构建消融实验. RB、DFAB、AFM模块有效性实验如表3所示, 可视化结果如图8所示. 其中包括以下组合: ① Base+DFAB; ② Base+RB+AFM; ③ Base+DFAB+AFM; ④ Base+RB+DFAB; ⑤ Base+RB+DFAB+AFM, 即本文网络. 其中, Base表示两个下采样层和两个上采样层构成的基础网络.

| 表 3 不同模块组合消融实验结果 |

由表3可以观察到, 无论是去除RB、DFAB、AFM模块中的哪一个模块, 网络性能都有一定程度的下降. 其中, 网络去除DFAB模块比原去雾网络性能下降明显, PSNR下降10.11 dB, SSIM下降0.0358. 另外, 网络去除RB残差块, PSNR下降3.78 dB; 网络去除AFM模块, PSNR下降1.19 dB. 从图8也可以看出, 组合②在红色墙面、桌面以及光线昏暗处都存在明显雾霾残留现象, 且整体对比度较低; 组合①和组合④在远处光线暗的区域细节模糊, 组合③和组合④在红色墙面处均有不同程度雾霾残留. 经对比可验证本文所提方法中各个模块的有效性.

|

图 8 不同模块组合消融实验可视化结果 |

3.4.2 DFAB模块消融实验

本节对DFAB模块中不同注意力机制进行消融实验来评估所提模块的影响, 将不包含DFAB模块的网络结构记为Base1, DFAB模块中去除CS联合注意模块的基础模块记为DB模块. 分别对以下组合进行实验: ① Base1+DB; ② Base1+DB+空间注意机制; ③ Base1+DB+通道注意机制; ④ Base1+DB+CS联合注意模块, 即本文网络. 定量评估结果如表4所示, 可视化结果如图9所示.

由表4可以看出, 无论缺少通道注意力还是空间注意力, 去雾性能都有一定程度的下降, 且DFAB引入CS联合注意模块比不使用该模块性能提高明显, PSNR提高4.57 dB, SSIM提高0.0088. 另外, 从图9展示的可视化效果来看, 缺少CS联合注意模块的网络图像恢复效果较差, 存在边缘细节模糊现象; 单独使用通道注意力或空间注意力后得到的无雾图效果较好, 但整体不如引入CS联合注意模块取得的效果好. 由此可以证明本文提出的CS联合注意模块以及特征增强注意块DFAB的有效性.

| 表 4 DFAB模块消融实验结果 |

|

图 9 DFAB模块消融实验可视化结果 |

4 结束语

针对目前图像去雾算法存在颜色失真、对比度下降和雾霾残留等现象, 本文提出结合密集注意力的自适应特征融合图像去雾网络, 在编解码器结构中引入密集残差网络和CS联合注意模块构建的密集特征注意块, 使网络依次从通道维度和空间维度聚焦上下文特征信息, 更多地关注图像的局部细节信息, 防止雾霾残留, 同时, 密集连接可以使网络提高特征重用, 具有很好的抗过拟合性能; 为充分融合不同级别的图像特征, 提出自适应特征融合模块, 使网络可以利用非相邻层级的特征信息, 避免浅层特征丢失. 本文网络不依赖于大气散射模型, 是一种端到端的图像去雾网络, 且参数量较小. 实验结果表明, 本文网络在合成有雾图像数据集和真实世界有雾图像上均可取得理想的去雾效果, 其恢复图像能够有效保留纹理细节, 同时在颜色、亮度与对比度方面也最接近真实图像. 尽管如此, 本文网络还存在一些不足: 模型的SSIM指标结果相对较低, 在真实世界数据集上的性能仍有待提高. 因此, 后续工作中, 将研究如何去除真实世界非均匀雾霾, 构建更适用于真实场景的小数据集雾图的去雾网络, 可考虑迁移学习等方法使模型更容易学习, 实现更贴合实际的应用研究.

| [1] |

Li JF, Zhuo L, Zhang H, et al. Effective data-driven technology for efficient vision-based outdoor industrial systems. IEEE Transactions on Industrial Informatics, 2020, 16(7): 4344-4354. DOI:10.1109/TII.2019.2936467 |

| [2] |

赵茂军, 郭凰, 白俊峰, 等. 基于通道注意力与条件生成对抗网络的图像去雾. 计算机系统应用, 2022, 31(11): 167-174. DOI:10.15888/j.cnki.csa.008804 |

| [3] |

Xiong YY, Liu HX, Gupta S, et al. MobileDets: Searching for object detection architectures for mobile accelerators. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 3824–3833.

|

| [4] |

朱钦权, 王同罕, 贾惠珍. 基于雾密度感知增强的去雾图像质量评价方法. 计算机工程, 2023, 49(6): 208-216, 226. DOI:10.19678/j.issn.1000-3428.0066460 |

| [5] |

王科平, 杨艺, 费树岷. 雾霾图像清晰化算法综述. 智能系统学报, 2023, 18(2): 217-230. |

| [6] |

Cantor A. Optics of the atmosphere—Scattering by molecules and particles. IEEE Journal of Quantum Electronics, 1978, 14(9): 698-699. DOI:10.1109/JQE.1978.1069864 |

| [7] |

张晓东, 秦娟娟, 贾仲仲. 多尺度Retinex在图像去雾算法中的应用研究. 西昌学院学报(自然科学版), 2021, 35(3): 60-65. DOI:10.16104/j.issn.1673-1891.2021.03.013 |

| [8] |

Kim TK, Paik JK, Kang BS. Contrast enhancement system using spatially adaptive histogram equalization with temporal filtering. IEEE Transactions on Consumer Electronics, 1998, 44(1): 82-87. DOI:10.1109/30.663733 |

| [9] |

Hsu WY, Chen YS. Single image dehazing using wavelet-based haze-lines and denoising. IEEE Access, 2021, 9: 104547-104559. DOI:10.1109/ACCESS.2021.3099224 |

| [10] |

He KM, Sun J, Tang XO. Single image haze removal using dark channel prior. Proceedings of the 2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami: IEEE Press, 2009. 1956–1963.

|

| [11] |

Zhu QS, Mai JM, Shao L. A fast single image haze removal algorithm using color attenuation prior. IEEE Transactions on Image Processing, 2015, 24(11): 3522-3533. DOI:10.1109/TIP.2015.2446191 |

| [12] |

Meng GF, Wang Y, Duan JY, et al. Efficient image dehazing with boundary constraint and contextual regularization. Proceedings of the 2013 IEEE International Conference on Computer Vision. Sydney: IEEE Press, 2013. 617–624.

|

| [13] |

Cai BL, Xu XM, Jia K, et al. DehazeNet: An end-to-end system for single image haze removal. IEEE Transactions on Image Processing, 2016, 25(11): 5187-5198. DOI:10.1109/TIP.2016.2598681 |

| [14] |

Li BY, Peng XL, Wang ZY, et al. AOD-Net: All-in-one dehazing network. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE Press, 2017. 4780–4788.

|

| [15] |

Chen DD, He MM, Fan QN, et al. Gated context aggregation network for image dehazing and deraining. Proceedings of the 2019 IEEE Winter Conference on Applications of Computer Vision. Waikoloa: IEEE Press, 2019. 1375–1383.

|

| [16] |

Qin X, Wang ZL, Bai YC, et al. FFA-Net: Feature fusion attention network for single image dehazing. Proceedings of the 34th AAAI Conference on Artificial Intelligence. New York: AAAI Press, 2020. 11908–11915.

|

| [17] |

Dong Y, Liu YH, Zhang H, et al. FD-GAN: Generative adversarial networks with fusion-discriminator for single image dehazing. Proceedings of the 34th AAAI Conference on Artificial Intelligence. New York: AAAI Press, 2020. 10729–10736.

|

| [18] |

Wu HY, Qu YY, Lin SH, et al. Contrastive learning for compact single image dehazing. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE Press, 2021. 10546–10555.

|

| [19] |

Song YD, Zhou Y, Qian H, et al. Rethinking performance gains in image dehazing networks. arXiv:2209.11448, 2022.

|

| [20] |

Zheng Y, Zhan JH, He SF, et al. Curricular contrastive regularization for physics-aware single image dehazing. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE Press, 2023. 5785–5794.

|

| [21] |

Guo CL, Yan QX, Anwar S, et al. Image dehazing transformer with transmission-aware 3D position embedding. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE Press, 2022. 5802–5810.

|

| [22] |

Song YD, He ZQ, Qian H, et al. Vision transformers for single image dehazing. IEEE Transactions on Image Processing, 2023, 32: 1927-1941. DOI:10.1109/TIP.2023.3256763 |

| [23] |

Zhang HY, Cissé M, Dauphin YN, et al. mixup: Beyond empirical risk minimization. Proceedings of the 6th International Conference on Learning Representations. Vancouver: OpenReview.net, 2018. 1–13.

|

| [24] |

Li BY, Ren WQ, Fu DP, et al. Benchmarking single-image dehazing and beyond. IEEE Transactions on Image Processing, 2019, 28(1): 492-505. DOI:10.1109/TIP.2018.2867951 |

| [25] |

Ancuti CO, Ancuti C, Timofte R, et al. O-HAZE: A dehazing benchmark with real hazy and haze-free outdoor images. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Salt Lake City: IEEE Press, 2018. 867–8678.

|

| [26] |

Liu XH, Ma YG, Shi ZH, et al. GridDehazeNet: Attention-based multi-scale network for image dehazing. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE Press, 2019. 7314–7323.

|

| [27] |

Dong H, Pan JS, Xiang L, et al. Multi-scale boosted dehazing network with dense feature fusion. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE Press, 2020. 2154–2164.

|

| [28] |

Yi QS, Li JC, Fang FM, et al. Efficient and accurate multi-scale topological network for single image dehazing. IEEE Transactions on Multimedia, 2022, 24: 3114-3128. DOI:10.1109/TMM.2021.3093724 |

2024, Vol. 33

2024, Vol. 33