土地覆盖指的是地表上的自然物体和人工建造的物体, 获取准确的土地覆盖类别, 有助于人们管理与保护土地资源[1]. 土地覆盖分类研究, 目前主要使用遥感数据源, 可以从遥感图像中及时获取准确的土地覆盖信息.

传统的遥感土地覆盖分类方法, 如目视解译法, 该方法简单, 但花费时间长且分类精度不高. 机器学习的方法, 如支持向量机[2]和决策树分类方法[3]等方法, 无法满足时效性和端到端的解译要求, 而且无法满足高分辨率遥感图像中丰富信息的解译要求.

基于像素的土地覆盖分类方法, 是按照地物的类别, 划分遥感图像中的每一个像素. 遥感技术不断发展, 高分辨率遥感图像能充分呈现地物的信息, 但也加大了土地覆盖分类任务的难度. 基于深度学习的卷积神经网络能自适应地提取图像的特征, 端到端的语义分割技术可用于土地覆盖分类任务. Zhang等人使用遥感图像的空间和光谱信息, 为土地覆盖分类任务提供端到端的深度学习方法, 实验结果优于传统机器学习的方法[4]. Chen等人使用并行的空洞卷积来扩大感受野, 以应对多尺度分割问题[5]. Zheng等人提出前景建模的方法来处理遥感图像中前景与背景不平衡的问题[6]. Yu等人提出了一种高效的双路径模型来处理空间和分类语义[7]. Xu等人提出了三分支的实时语义分割网络, 在推理时间和准确性之间实现了合理平衡[8]. 刘明威等人提出了一种基于U-Net改进的遥感图像语义分割模型, 实现了土地覆盖分类任务的自动化[9]. 何直蒙等人提出一种基于空洞卷积的深度学习网络, 来减少提取高分辨率遥感图像的建筑物时的细节损失[10]. 遥感图像中有多种地物, 每种地物所需要的分割尺度有差异, 所以遥感图像中多尺度, 是需要改善的问题. 而且在基于深度学习的语义分割方法中, 模型复杂, 分割结果的边界模糊, 也是需要关注的问题.

本文提出了一种基于边界与多尺度信息的轻量化语义分割网络(lightweight semantic segmentation network based on boundary and multi-scale, LSSN-BM), 用于土地覆盖分类任务. 主要工作如下: (1)首先, 本文使用轻量化的MobileNetV3模型[11]作为分类器, 并且在之后的分割模块中也采用深度可分离卷积来减少计算量. (2)其次, 多分支编码器模块中使用了PAN结构[12]来进行多尺度分割, 它包含自顶向下和自底向上的特征金字塔结构, 将高层特征与低层特征充分融合. (3)接着, 设计了一个边界增强模块, 它通过学习边界信息, 为分割任务提供丰富的边界细节信息. (4)然后, 设计了一个特征融合模块, 融合边界特征与多尺度语义特征. (5)最后, 对损失函数的使用进行探究, 本文使用组合损失函数, 语义分支使用多分类交叉熵损失函数, 而边界增强模块使用二分类交叉熵损失函数和Dice损失函数的结合.

1 LSSN-BM网络整体结构本文提出一种基于边界与多尺度信息的轻量化语义分割网络(LSSN-BM), 来改善遥感土地覆盖分类的模型复杂, 边界模糊和多尺度分割等问题.

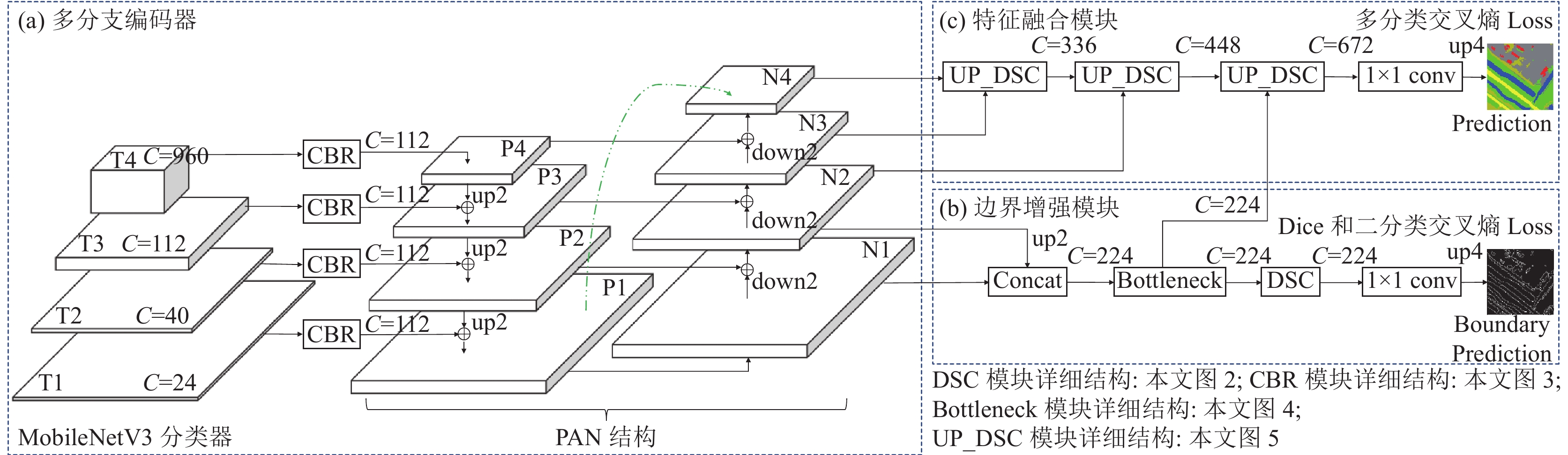

整体结构如图1, 分类器采用MobileNetV3-Large版本的网络结构, 本文将MobileNetV3的4个不同尺寸大小的特征图作为多分支编码器的输入. 图1(a)多分支编码器使用PAN结构, 它在FPN的自顶向下的结构基础上, 增加了自底向上的结构, 能充分融合高层与低层特征. 图1(b)是边界增强模块, 可以为遥感土地覆盖分类任务提供丰富的边界细节信息, 其中边界模块使用二分类交叉熵损失函数和Dice损失函数. 图1(c)是特征融合模块, 解码多尺度语义特征, 再和边界特征融合. 图1中, C表示通道数, up2表示上采样两倍, down2表示下采样两倍, up4表示上采样4倍.

2 LSSN-BM网络详细介绍 2.1 MobileNetV3分类器MobileNetV3模型[11]是一个轻量化的网络, 它使用深度可分离卷积来减少模型复杂度, 同时使用瓶颈结构, 增加特征图的通道数, 以增加非线性表现力.

MobileNetV3首先通过一个传统的卷积块提取特征, 再使用多个瓶颈模块继续提取特征, 最后使用1×1卷积调整通道数. 本文的分类器去掉了MobileNetV3-Large的平均池化和全连接层, 将4个不同尺寸大小的特征图作为多分支编码器的输入. 它们分别是主干网络4倍下采样、8倍下采样、16倍下采样和32倍下采样之后的特征图, 输出通道数分别为24、40、112和960.

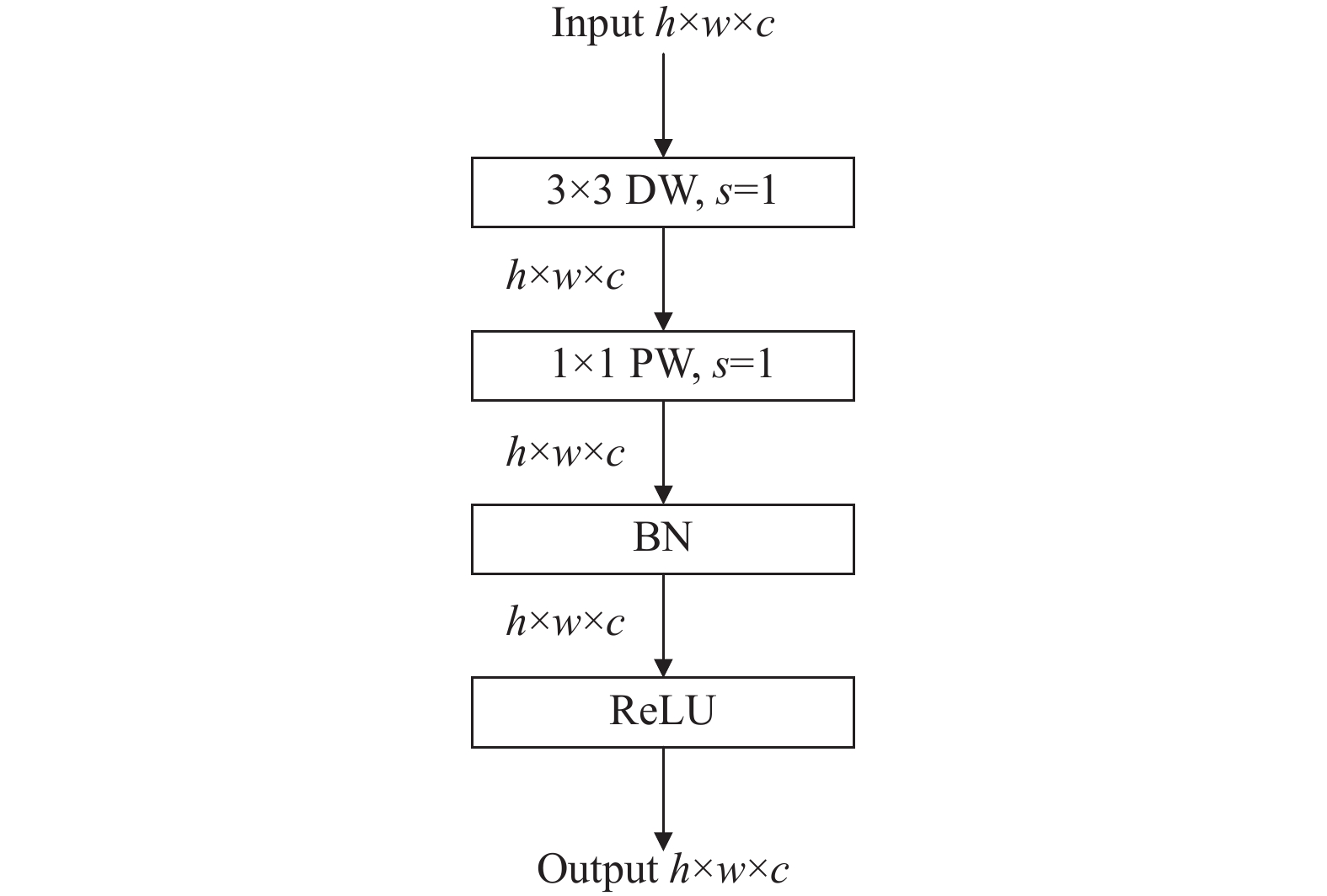

2.2 深度可分离卷积MobileNetV1网络[13]中使用了深度可分离卷积(depthwise separable convolution, DSC)来减少计算量, 它是深度卷积(depthwise convolution, DW)和逐点卷积(pointwise convolution, PW)的组合. PW用来进行通道的融合, 以实现改变特征图的通道数. DW在每个通道上进行卷积, 将单个滤波器应用到每个通道. 深度可分离卷积与普通卷积的计算量比值的计算如下:

| s=1N+1D2k | (1) |

其中, N表示输出通道数, 卷积核大小

本文在特征融合模块和边界增强模块中均使用了深度可分离卷积, 即图1中的DSC和UP_DSC模块. DSC模块的详细结构如图2所示, 先使用3×3的深度卷积提取特征, 然后是1×1的逐点卷积改变特征图的通道数. 使用DSC模块来替换3×3的普通卷积, 能减少模型计算量.

|

图 1 LSSN-BM网络结构 |

|

图 2 DSC模块 |

2.3 多分支编码器

文中的多分支编码器使用PAN模块[12], 它在FPN的自顶向下的结构基础上, 再加入了自底向上的路径增强, 用低层特征图中的精确的定位信息来增强特征金字塔. 这样的结构既包含较强的高层语义特征, 又包含低层的高分辨率特征. 为了将低层特征快速流动到顶层特征, 还加入了跳连接. 多分支编码器中的CBR模块如图3所示.

多分支编码模块把MobileNetV3分类器输出的

在自底向上的结构中, 特征图被下采样两倍再与高一层的特征图相加融合, 得到

本文设计了一个边界增强模块, 为语义分支提供边界细节信息, 以解决分类结果边界模糊的问题. Canny边缘检测算子[14], 具有较高的准确率和稳定性, 可以获取图像的边缘. 边界的真实标记图, 是使用Canny算法从已知的真实标记语义图中获取的.

He等人[15]为减轻深层网络中的梯度消失等问题, 设计了具有跳跃连接的残差结构. 瓶颈残差模块如图4所示, 它是先降低通道数, 然后使用3×3卷积继续提取特征, 最后再调整输出特征图的通道数.

由于低层特征图有更高的分辨率和较多的细节信息, 所以我们选取较低层的特征图来预测边界. 如图1(b)所示, 首先使用Concat操作实现N1和N2特征图的拼接, 再使用瓶颈残差模块[15]和DSC模块继续提取特征, 然后使用1×1卷积调整通道数后, 最后把特征图上采样到与Canny边缘检测后的边界标记图尺寸一致.

|

图 3 CBR模块 |

|

图 4 瓶颈残差模块 |

2.5 特征融合模块

本文设计了一个特征融合模块, 能充分融合边界增强模块的输出特征与多尺度分支编码器输出的语义特征, 以提高分类精确度. 图1(c)是特征融合模块, 它使用多个UP_ DSC模块来融合多尺度特征. 本文设计的UP_ DSC模块如图5所示, 它有两个输入特征图, 先把低分辨率特征图进行两倍上采样, 再把低分辨率特征图与高分辨特征图Concat连接, 最后使用深度可分离卷积, 即DSC模块提取特征.

|

图 5 UP_ DSC模块 |

多尺度分支编码器的输出特征图, 分别使用UP_ DSC模块融合多尺度语义特征, 得到丰富的语义特征图. 最后再使用UP_ DSC将语义特征图与边界增强模块的输出特征图进行融合, 经过1×1卷积调整通道数和4倍上采样得到最终的预测图.

2.6 组合损失函数本文设计了一个组合损失函数, 语义分支使用多分类交叉熵损失函数, 边界增强模块使用二分类交叉熵损失函数和Dice损失函数的结合. 在文献[6]中介绍了推广到像素级别的Focal损失函数, 以解决样本不平衡的问题. 文献[16]中介绍了用于在线困难样本挖掘的OHEM损失函数. 通过实验, 语义分支选取了交叉熵损失函数.

文献[17]总结了多种可用于语义分割的损失函数, 其中包含多分类交叉熵、二分类交叉熵和Dice损失函数等. 交叉熵损失函数被广泛用于分类目标, 由于分割其实是像素级别的分类, 所以它能应用到语义分割上. 多分类交叉熵损失计算如下:

| LCE(y,p)=−1Nn−1∑i=0k−1∑k=0(yi,klog(pi,k)) | (2) |

其中, y是真实标签, p是预测标签, n表示样本数, k是标签数, pi,k表示将第i个样本预测为第k个标签的概率.

Dice系数用于计算两张图像间的相似性, 可以缓解样本不平衡的问题. 二分类交叉熵虽然计算简单, 但不能很好地处理数据类别不平衡的情况. 由于边界增强模块中, 在对边界和背景二分类时, 边界与背景极其不平衡, 所以本文还引入了Dice损失函数来处理该问题, 如式(3). 但是Dice损失容易带来训练不稳定的情况, 所以在边界模块选取二分类交叉熵和Dice损失. 式(4)表示二分类交叉熵, 其中p是预测值, y是真实值. 本文的组合损失函数, 是边界增强模块的损失函数和语义分支的损失函数组合, 如式(5)所示.

| LDice(y,p)=1−2yp+1y+p+1 | (3) |

| LBCE(y,p)=−(ylog(p)+(1−y)log(1−p)) | (4) |

| Ltotal=LCE+LDice+LBCE | (5) |

WHDLD数据集[18]是遥感图像多分类数据集, 可用于遥感土地覆盖分类任务. WHDLD数据集的图像共为4940张, 空间大小为256×256, 分辨率为2 m的RGB图像. WHDLD数据集是按像素进行标记, 标记为6类区域, 分别是裸土、建筑物、人行道、道路、植被和水. 在本次实验中, WHDLD数据集被划分为训练集有2968张、验证集有992张和测试集有980张.

DeepGlobe土地覆盖分类数据集[19]有803张图像, 其空间大小为2448×2448, 分辨率为0.5 m. DeepGlobe数据集是按像素标注为7类区域, 包括城市、农业、牧场、森林、水、贫瘠和未知区域, 其中未知区域在分类时不需要考虑. DeepGlobe数据集划分为训练集644张和测试集159张.

3.2 实验设置及评价指标实验使用Python 3.7.11和PyTorch 1.11.0的环境, Ubuntu 20.0.4操作系统和具有10 GB显存的GeForce RTX 3080显卡. 所有骨干网络都使用ImageNet训练后的权重. 在实验中, 优化器使用SGD策略, 并将权重衰减设置为0.000 1, 将动量设置为0.9. 学习策略使用Poly动态调整学习率, 初始学习率为0.01, 动力为0.9. 训练的迭代次数为15 000次. WHDLD数据集批量大小为22. DeepGlobe数据集批量大小为4. 由于计算机的显存有限, 所以DeepGlobe数据集在训练时, 将输入图片大小调整为1024×1024. 在实验中的训练的时候采用了数据增强, 主要使用随机水平翻转、随机垂直翻转和随机旋转90°方法.

实验使用3个遥感土地覆盖分类任务中的评价标准: 平均交并比(mean intersection over union, mIOU)、总体精度(overall accuracy, OA)和F1分数(F1-score). 具体计算公式如下:

| mIOU=1k+1k∑i=0TPFN+FP+TP | (6) |

| OA=TP+TNTP+TN+FP+FN | (7) |

| Precision=TPTP+FP | (8) |

| Recall=TPTP+FN | (9) |

| F1-score=2×Precision×RecallPrecision+Recall | (10) |

其中, TP表示预测成功的正例数目, FP表示预测失败的正例数目, FN表示预测失败的负例数目, TN表示预测成功负例的数目. F1-score是综合评价精确率(Precision)和召回率(Recall)的指标.

模型的复杂度可以用参数量(Parameters)和网络推理中的累计乘加次数(Mult-adds)来评价. Parameters用来评价模型的空间复杂度, 而Mult-adds用来评价模型的时间复杂度, 并且能反映出模型的分割速度. 模型推理的实时性还可以采用FPS来评价, 即每秒传输帧数.

3.3 消融实验结果及分析WHDLD数据集的多分支编码器均采用CBR (A)结构. 模型LSSN-BM, 在边界增强模块使用二分类交叉熵和Dice损失的基础上, 对语义分支的损失函数选取进行了实验, 如表1所示. LSSN-BM_A的语义分支使用Focal损失函数, LSSN-BM_B使用OHEM损失, LSSN-BM_C使用交叉熵损失. 从表1中可以看出, LSSN-BM_C的实验结果表现更好, 即语义分支选取交叉熵损失函数.

| 表 1 WHDLD测试集上的损失函数选取实验 |

在语义分支使用交叉熵损失函数的基础上, 对每个模块的有效性进行了实验, 如表2所示. LSSN-BM_D, 只使用多分支编码器. LSSN-BM_E继续加入了特征融合模块, mIOU提高了1%, OA提高了0.43%, F1-score提高了0.81%, 表明特征融合模块的有效性. LSSN-BM_C是继续加入了边界增强模块, 更多保留了边界细节信息, 为语义分支提供边界细节信息. 从表2可以看出, 相比于LSSN-BM_E, LSSN-BM_C的mIOU再提高了1.63%, OA提高了0.72%, F1-score提高了1.41%, 虽然模型复杂度略有变大, 但仍然在可接受范围内.

| 表 2 WHDLD测试集上的消融实验 |

最终WHDLD数据集的模型选择LSSN-BM_C的设计, 选择MobileNetV3分类器, 同时使用了多分支编码器、特征融合模块和边界增强模块, 语义分支选择交叉熵损失函数.

由于DeepGlobe数据集的图片尺寸大于WHDLD数据集的图片尺寸, 对于DeepGlobe数据集来说, 获得更多的全局信息对分类任务有益, 所以引入了CBR (B)结构. 表3中第1行表示全部使用CBR (A)结构. 表3中第2行表示多分支编码器中低层的T1和T2特征图采用CBR (A)结构, 而高层的T3和 T4特征图采用CBR (B)结构, 且空洞卷积的膨胀率为r=[12, 25, 37]. 与第2行相比, 表3中第3行是把CBR (B)中空洞卷积的膨胀率改为r=[6, 13, 19]. 由此可以看出, 膨胀率r=[6, 13, 19]的空洞卷积, 表现结果最好, 相比于全部使用CBR (A)结构, mIOU提高了6.69%, OA提高了4.09%, F1-score提高了5.27%. 所以DeepGlobe数据集的模型选择了LSSN-BM_C2的设计, 即膨胀率为r=[6, 13, 19].

| 表 3 DeepGlobe测试集上的膨胀率选取实验 |

3.4 对比实验结果及分析

为进一步验证本文方法的有效性, 将本文模型与目前主流的语义分割模型Farseg模型[6]、BiSeNetV2模型[7]和PIDNet[8]进行对比. WHDLD的测试集上的模型复杂度对比如表4所示. WHDLD的测试集上的实验结果对比如表5所示. LSSN-BM_C网络相比其他方法, mIOU、OA和F1-score均有提升, mIOU达到了59.64%, OA达到了87.68%, F1-score达到了72.57%.

在WHDLD的测试集上的结果显示, 相比于Farseg模型, LSSN-BM_C的mIOU提高了2.55%, OA提高了1.23%, F1-score提高了2.28%. 而且对比Farseg模型, LSSN-BM_C模型的参数量减少了86.17%, 累计乘加次数减少了60.73%, 且FPS更优. 实验结果表明, 本文方法更容易部署且具有更快的推理速度.

| 表 4 WHDLD测试集上的模型复杂度对比 |

| 表 5 WHDLD测试集上的实验结果对比 (%) |

WHDLD测试集上, 相比于轻量级BiSeNetV2模型, LSSN-BM_C的mIOU提高了5.16%, OA提高了1.94%, F1-score提高了4.83%. 虽然LSSN-BM_C的累计乘加次数要略优于BiSeNetV2模型, 但LSSN-BM_C模型的参数量更少. 实验结果表明, 本文方法在满足模型轻量化同时, 能取得更好的分类效果.

在WHDLD的测试集上的结果显示, 相比于PIDNet实时语义分割模型, LSSN-BM_C的mIOU提高了3.96%, OA提高了1.91%, F1-score提高了3.62%. 而且对比PIDNet模型, LSSN-BM_C模型的参数量减少了88.37%, 累计乘加次数减少了48.66%, FPS更优. 实验结果表明, 本文方法在满足实时性要求的同时, 分类效果更好.

IOU值反映出不同类型地物的分类效果, LSSN-BM网络对裸土、人行道、道路、植被和水的IOU值均有提升. 且水和植被的分类结果优于其他类别.

在DeepGlobe测试集上的模型复杂度对比如表6所示. 在DeepGlobe的测试集上的实验结果对比如表7所示. 本文方法LSSN-BM_C2的mIOU达到了70.42%, OA达到了88.81%, F1-score达到了81.70%. DeepGlobe输入网络的图片尺寸为1024×1024, 图片尺寸越大对模型轻量化有着更高的要求.

| 表 6 DeepGlobe测试集上的模型复杂度对比 |

| 表 7 DeepGlobe测试集上的实验结果对比 (%) |

DeepGlobe的测试集上的结果显示, 相比于Farseg模型, LSSN-BM_C2的mIOU提高了0.57%, F1-score提高了0.62%. 虽然LSSN-BM_C2 的OA略低于Farseg, 但参数量减少了85.69%, 累计乘加次数减少了60.37%, 且FPS更优. 由此可以看出LSSN-BM_C2方法运行速度更快且更容易部署, 综合结果更优.

DeepGlobe的测试集的结果, 相比于轻量级BiSeNetV2模型, LSSN-BM_C2的mIOU提高了12.11%, OA提高了4.52%, F1-score提高了10.34%. 虽然其累计乘加次数要高于BiSeNetV2模型, 但模型参数量更少. 在遥感土地覆盖分类应用场景中, 速度与精度的平衡是需要考虑的问题, LSSN-BM_C2模型能在一定轻量化的情形下, 取得更好的分类效果.

DeepGlobe的测试集上的结果, 相比于PIDNet实时语义分割模型, LSSN-BM_C2的mIOU提高了24.78%, OA提高了12.86%, F1-score提高了23.77%. LSSN-BM_C2模型的部署和推理时间更快, 而且对比PIDNet模型, LSSN-BM_C2模型的参数量减少了87.97%, 累计乘加次数减少了48.2%. 而且FPS基本接近, LSSN-BM_C2方法满足实时性要求, 在该数据集上能大幅提高遥感土地覆盖分类任务精度.

在遥感土地覆盖分类应用场景中, 速度与精度的平衡是需要考虑的问题, LSSN-BM_C2模型可以在一定轻量化的情形下, 取得更好的分类效果. DeepGlobe测试集上不同地物的IOU值反映出, 在所有土地覆盖类别中, 农业和森林的分类结果优于其他类别.

为了探寻更大尺寸图像的效率和精度, 在表8中, 我们将DeepGlobe数据集的图片尺寸调整为1152×1152. 此时本文LSSN-BM_C2模型的mIOU为 69.91%, OA为 88.37%. 与表6相比, 表8中的图片尺寸增大后, 每个模型的累计乘加次数有所上升, FPS速度有所下降, 从中可以看出图片尺寸越大, 处理每张图片会需要更多的时间. 而且由于计算机硬件显存的限制, 此时Farseg模型已经显存不足, 无法进行训练, 即图片尺寸越大对模型轻量化有着更高的要求.

图6是WHDLD的测试集中的一张图像的分割效果, 可以看出LSSN-BM模型更接近于真实标签, 而且对人行道等小目标细节的划分更优, 表明边界增强模块是有效的. 图7是DeepGlobe的测试集中的一张图像的分割效果, 可以看出LSSN-BM模型明显优于BiSeNetV2和PIDNet模型, 且与复杂Farseg模型的结果基本相当. LSSN-BM模型为遥感图像的土地覆盖分类任务提供了一个轻量级的解决方案

| 表 8 DeepGlobe调整尺寸后的实验结果对比 |

|

图 6 WHDLD测试集语义分割结果 |

|

图 7 DeepGlobe测试集语义分割结果 |

4 结论与展望

高分辨率遥感图像提供了丰富的纹理和空间分布等信息, 给土地覆盖分类任务带来了更大的挑战. 针对遥感土地覆盖分类任务的模型复杂, 边界模糊和多尺度等问题, 本文提出了一种基于边界与多尺度信息的轻量化语义分割网络LSSN-BM. 采取轻量MobileNetV3分类器, 之后的分割中也使用深度可分离卷积来减少计算量; 多分支编码器采用PAN结构来进行多尺度分割; 设计了边界增强模块来提供边界细节特征; 设计了一个充分融合边界特征与多尺度语义特征的特征融合模块; 并且使用组合损失函数. LSSN-BM网络在WHDLD数据集上的mIOU达到了59.64%, OA达到了87.68%, F1-score达到了72.57%, 在DeepGlobe数据集上的mIOU达到了70.42%, OA达到了88.81%, F1-score达到了81.70%. LSSN-BM网络实现了推理时间和准确性的平衡, 且模型更加轻量化, 为土地覆盖分类提供了一个可行方案. 此外, 对土地覆盖分类的变化检测也是未来工作重要的研究方向.

| [1] |

童心仪. 面向广域土地覆盖的高分辨率遥感影像分类方法研究[博士学位论文]. 武汉: 武汉大学, 2020.

|

| [2] |

Khatami R, Mountrakis G, Stehman SV. A meta-analysis of remote sensing research on supervised pixel-based land-cover image classification processes: General guidelines for practitioners and future research. Remote Sensing of Environment, 2016, 177: 89-100. DOI:10.1016/j.rse.2016.02.028 |

| [3] |

Yang C, Wu GF, Ding K, et al. Improving land use/land cover classification by integrating pixel unmixing and decision tree methods. Remote Sensing, 2017, 9(12): 1222. DOI:10.3390/rs9121222 |

| [4] |

Zhang X, Han LX, Han LH, et al. How well do deep learning-based methods for land cover classification and object detection perform on high resolution remote sensing imagery?. Remote Sensing, 2020, 12(3): 417. DOI:10.3390/rs12030417 |

| [5] |

Chen LC, Zhu YK, Papandreou G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation. Proceeding of the 15th European Conference on Computer Vision (ECCV). Munich: Springer, 2018. 833–851.

|

| [6] |

Zheng Z, Zhong YF, Wang JJ, et al. Foreground-aware relation network for geospatial object segmentation in high spatial resolution remote sensing imagery. Proceeding of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 4095–4104.

|

| [7] |

Yu CQ, Gao CX, Wang JB, et al. BiSeNet V2: Bilateral network with guided aggregation for real-time semantic segmentation. International Journal of Computer Vision, 2021, 129(11): 3051-3068. DOI:10.1007/s11263-021-01515-2 |

| [8] |

Xu JC, Xiong ZX, Bhattacharyya SP. PIDNet: A real-time semantic segmentation network inspired by PID controllers. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Vancouver: IEEE, 2023. 19529–19539.

|

| [9] |

刘明威, 方静, 詹曙. 基于深度学习的土地覆盖遥感图像分割方法. 合肥工业大学学报(自然科学版), 2022, 45(6): 753-759. |

| [10] |

何直蒙, 丁海勇, 安炳琪. 高分辨率遥感影像建筑物提取的空洞卷积E-Unet算法. 测绘学报, 2022, 51(3): 457-467. DOI:10.11947/j.AGCS.2022.20200601 |

| [11] |

Howard A, Sandler M, Chen B, et al. Searching for MobileNetV3. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision (ICCV). Seoul: IEEE, 2019. 1314–1324.

|

| [12] |

Liu S, Qi L, Qin HF, et al. Path aggregation network for instance segmentation. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 8759–8768.

|

| [13] |

Howard AG, Zhu ML, Chen B, et al. MobileNets: Efficient convolutional neural networks for mobile vision applications. arXiv:1704.04861.

|

| [14] |

Canny J. A computational approach to edge detection. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1986, PAMI-8(6): 679-698. DOI:10.1109/TPAMI.1986.4767851 |

| [15] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 770–778.

|

| [16] |

Shrivastava A, Gupta A, Girshick R. Training region-based object detectors with online hard example mining. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 761–769.

|

| [17] |

Jadon S. A survey of loss functions for semantic segmentation. Proceedings of the 2020 IEEE Conference on Computational Intelligence in Bioinformatics and Computational Biology (CIBCB). Via del Mar: IEEE, 2020. 1–7.

|

| [18] |

Shao ZF, Zhou WX, Deng XQ, et al. Multilabel remote sensing image retrieval based on fully convolutional network. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2020, 13: 318-328. DOI:10.1109/JSTARS.2019.2961634 |

| [19] |

Demir I, Koperski K, Lindenbaum D, et al. DeepGlobe 2018: A challenge to parse the earth through satellite images. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW). Salt Lake City: IEEE. 2018. 172–181.

|

2024, Vol. 33

2024, Vol. 33