医学影像学是现代医学的重要诊病手段之一, 医学图像的解释对诊断准确性起着决定性作用. 医学图像包括多种类型, 如X光图像、CT图像、超声图像、显微图像等. 在医学图像处理中, 边缘检测技术是重要的技术之一. 如在心血管领域, 通过检测血管的边缘, 可以帮助医生评估血管的通畅度、狭窄程度, 进而评估疾病的严重性. 在手术过程中, 边缘检测技术能够为手术团队提供准确的器官边界信息和轮廓定位, 从而为手术操作提供更加精确的引导. 降低手术风险, 提高手术的成功率.

医学图像在采集过程中可能受到多种因素的影响, 导致图像产生模糊. 例如, 患者或设备的移动、摄像设备的局限性以及某些人体组织结构的复杂性等.在处理模糊医学图像时, 边缘特征具有至关重要的作用, 是临床诊断、病理识别和分析的基础[1]. 模糊医学图像边缘检测对于提高医疗诊断水平、促进医学研究和创新以及支持智能医疗技术发展都具有普遍的重要性.为满足人们对模糊医学图像进一步分析和识别的需求, 模糊医学图像边缘检测技术体现出了较大难度和重要意义[2].

针对这些问题, 研究者进行了大量的研究, 提出了各种边缘检测方法, 基于传统方法的有: Shah等[3]对Canny算法进行改进, 将原来的高斯滤波器改成中值滤波器, 有效克服噪声干扰, 保留边缘有用数据, 提高边缘检测精度. Balochian等[4]提出一种使用分数阶微分(FOD)与Prewitt算子相结合的边缘检测新方法. FOD利用相邻像素的信息隐式执行加权平均, 不仅可以计算图像的导数, 还可以消除噪声. 其在医学图像边缘检测方面具有广阔的潜力. Kumar等[5]采用两级边缘检测方法, 首先使用引导图像滤波增强图像边缘, 其次在这些增强图像上应用增强蚁群优化方法进行边缘检测, 具有较好的边缘检测性能. 随着深度学习技术的快速发展, 特别是卷积神经网络(convolutional neural network, CNN)的出现, CNN显示出在自动学习自然图像的高级表示方面具有巨大潜力. 利用CNN进行边缘检测, 已经成为计算机视觉领域的一种新的趋势[6]. 如: Liu等[7]利用FPN (feature pyramid network)思想结合高层和底层的特征映射进行边缘检测. 提出一种全卷积网络RCF (richer convolutional feature)来高效地利用每一个CNN层的特征. He等[8]提出了一种双向级联网络BDCN (bi-directional cascade network)架构, 该架构包括使用CNN网络的每个块和一个尺度增强模块来生成多尺度特征, 然后连接所有输出以获得最终的边缘图. 李翠锦等[9]提出跨层融合的边缘检测算法CLF (cross fusion edge detection algorithm based on CNN). 该算法通过交叉融合不同层特征并计算损失值的方式来改善在多尺度图像边缘提取中常见的梯度消失问题. Soria等[10]提出了DexiNed (dense extreme inception network), 该网络模型通过使用膨胀卷积来增加感受野的方式, 有效地捕捉图像中的边缘特征. 以及采用反卷积和上采样技术, 生成高分辨率的边缘图像. Su等[11]提出了一个简单、轻量级但有效的架构, 像素差异网络PiDiNet (pixel difference network). PiDiNet采用了新的像素差卷积, 将传统的边缘检测算子集成到现代CNN中流行的卷积运算中, 以提高边缘检测任务性能. Elharrouss等[12]提出精细表示的边缘检测网络CHRNet (cascaded and high-resolution convolutional network). 在网络阶段保持边缘图像的高分辨率, 每个阶段都将子块与前一层的输出连接起来, 避免丢失某些边缘特性, 实现图像边缘检测任务.

在医学领域, 边缘检测对于疾病诊断、手术规划、跟踪疾病的进展等都有重要意义. 如: Zhang等[13]提出新型的U形医学图像分割网络ST-Unet (Swin Transformer boosted U-Net), 该网络使用Swin Transformer作为编码器, CNN作为解码器. 将跨层特征增强模块CLFE取代传统的连接方法, 以实现更准确的边缘检测. Zhang等[14]提出了一种边缘感知引导网络ET-Net (edge-attention guidance network). 利用边缘引导模块学习早期编码层中的边缘注意力表示, 然后将其转移到多尺度解码层, 使用加权聚合模块进行融合. 边缘注意力表示有助于最终边缘的准确性. Wang等[15]提出了一种端到端特征细化网络FRNet (feature refinement neural network). 该网络采用编码器-解码器网络作为骨干, 在编码器和解码器上分别应用空间细化路径和语义细化路径两条附加路径, 以提高模型的详细表示能力和判别能力. 引入了一种特征自适应融合块, 可以有效地组合不同深度的特征, 从而提高医学图像边缘检测的精度.

相较于自然图像和一般的医学图像, 模糊医学图像因边缘模糊、对比度低、非均匀性、噪声多等特性, 现有很多算法难以提取此类图像的精确边缘信息. 为此, 本文提出了一种基于深度学习的模糊医学图像边缘检测算法. 主要贡献包括: 1)对原始网络CHRNet进行剪枝, 使模型更加高效和轻量化; 2)网络的特征提取阶段设计注意力模块(selective kernel channel attention and spatial attention module, SKSAM)让模型更加关注目标信息的提取, 抑制不相关的信息, 达到提高特征表示能力的目的; 3)网络特征融合阶段增加了上下文感知融合块, 使得神经网络更好地利用多尺度信息, 获得更为丰富的上下文特征信息, 从而能够实现更加精准的特征融合. 这种特殊处理方式有助于提高边缘检测的精度和鲁棒性; 4)提出了一种二分类交叉熵损失(binary cross-entropy loss)和Dice损失结合在一起的新损失函数. 它能综合考虑像素级别的准确性和边界的平滑性, 提供更好的梯度信号, 并平衡像素级别和边界级别的准确性, 从而在边缘检测任务中获得更好的性能.

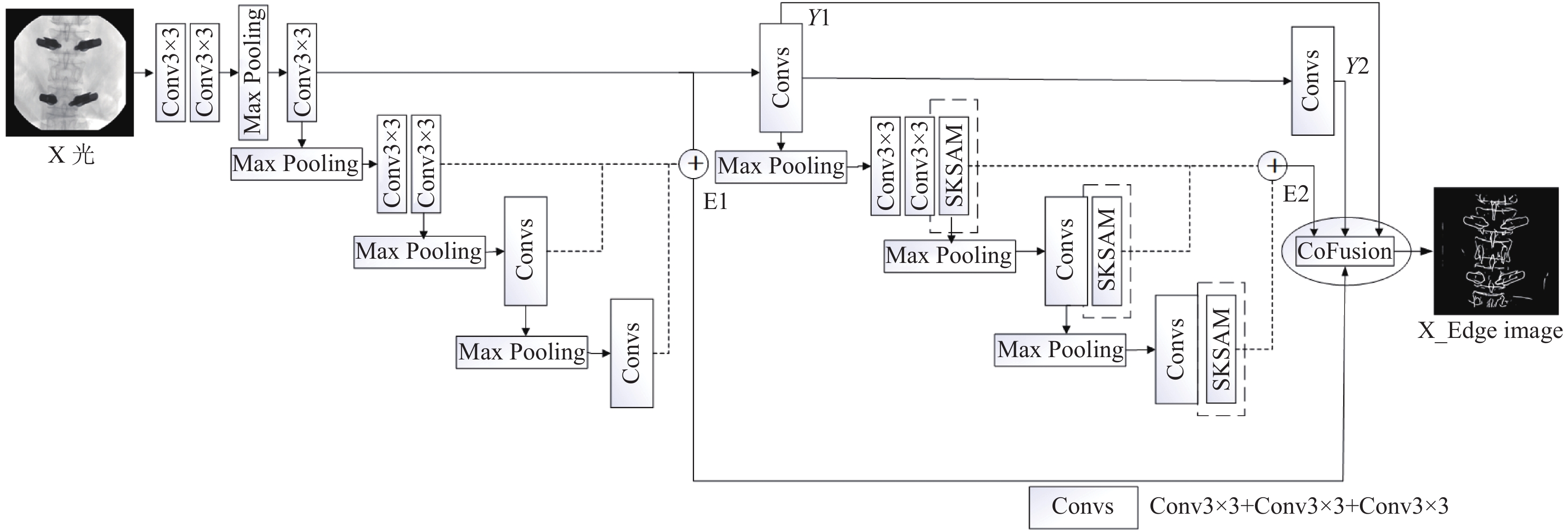

1 网络结构 1.1 本文网络结构为了解决模糊医学图像边缘检测中定位不清晰和噪声较多的问题, 本文采用了CHRNet作为基础网络结构, 并在其基础上进行了改进得到ECENet网络, 该网络由输入、特征提取和边缘预测3个模块组成. 其中, 输入模块用于对原始图像进行预处理, 特征提取模块利用卷积神经网络对特征进行抽取, 边缘预测模块利用一个小型网络对边缘进行预测. 较深的网络结构可能在一定程度上过度拟合训练数据, 导致模型对于模糊医学图像的细节特征过于敏感, 而忽略了更高级别的语义信息[16]. 通过对原始网络结构的最后两层进行剪枝[17], 减少网络层数降低模型的复杂性, 使其更专注于捕捉图像的整体结构和边缘特征. 由于模糊图像中的细节信息模糊或缺失, 导致网络特征提取效果不佳. 在特征提取阶段引入了SKSAM模块(图1虚线框表示), 该模块自适应地提取图像特征并减少噪声的影响. ECENet采用上下文感知融合模块(图1椭圆形框表示)[18]来连接和融合网络中多个尺度的输出. 这使得网络能够融合来自不同尺度的信息, 从而提高边缘信息预测的准确性. 本文通过结合二分类交叉熵损失[19]和Dice损失[20]来优化损失函数. 这种组合同时考虑了像素级精度和边界平滑度, 在模型训练期间提供更好的梯度信号, 可以更好地应对模糊医学图像带来的挑战, 并提高整体边缘检测性能. ECENet整体结构如图1所示.

|

图 1 ECENet整体网络结构 |

1.2 卷积注意力模块(SKSAM)

在深层网络中, 随着网络层数的增加, 特征图的表示变得更加复杂, 其中包含了更多的信息. 然而, 这也意味着网络可能会学习到大量无用的信息, 导致网络性能的下降. 这些无用的信息会干扰网络的学习和推理, 影响模型的性能. 本文设计SKSAM注意力机制, 能够自适应地对不同通道和空间位置进行加权. 该注意力模块包括通道注意力模块和空间注意力模块. 特征通道注意力模块可以自适应地调整特征图中不同通道的重要性, 以便更好地利用重要的特征, 抑制无用的特征. 空间注意力模块可以自适应地调整特征图中不同位置的重要性, 以便更好地利用重要的信息, 抑制无用的信息[21]. 这使得网络可以更加关注目标骨骼的特征, 减轻噪声等不重要信息的干扰, 使深层网络能够更加精确地揭示图像的语义信息, 从而提高模型的准确性和鲁棒性.

卷积注意力模块SKSAM是一个轻量级的注意力模块, 它能关注重要特征并抑制不必要的特征. 该模块融合了SK通道注意力(selective kernel channel attention)[22]和空间注意力(spatial attention). SK通道注意力模块: 首先特征图F通过分组卷积操作被分成2个分支. 其中一个分支采用3×3的卷积操作, 而另一个分支采用5×5的卷积操作. 每个分支生成一个特征图. 然后将两个分支的特征图相加, 并进行全局平均池化操作, 得到一个长度为C的全局信息向量Y. 将Y经过一个全连接(FC)层进行聚合压缩, 得到一个维度为C的向量Z. 该向量通过2个全连接(FC)层分别映射回长度为C的向量. 然后, 对这2个向量在通道维度上进行Softmax运算, 得到2个权重向量. 这些权重与原先2个分支的输出特征图进行逐元素相乘, 得到经过加权的特征图. 最后, 对这2个特征图进行求和, 得到最终的输出特征图FC. 空间注意力模块: 将特征图FC (经过SK通道注意力计算后)在通道维度分别进行最大值池化和平均池化, 将通道维度压缩为1, 保留空间信息. 这些池化特征被连接起来, 然后通过一个卷积层提取特征并减少通道维度为1. 接下来使用Sigmoid激活函数[23], 得到最终的空间注意力权重图MS. 最后特征图FC按像素点与注意力权重图MS相乘, 产生最终的特征图FS.

SKSAM注意力模块能够捕捉不同位置的特征之间的关系, 以及动态选择重要特征并忽略无关特征. 使得网络能够学习到不同的特征图和不同位置像素点的重要性, 从而增强了神经网络的特征提取能力和泛化能力, 该模块的详细结构如图2所示.

|

图 2 卷积注意力模块(SKSAM) |

1.3 上下文感知融合块(CoFusion)

在卷积神经网络中, 卷积核的大小和形状是固定的, 它们对每个位置的特征都是一样的, 无法自适应地处理不同位置的特征. 图像中不同位置的像素点的重要性是不同的. 上下文感知融合块可以帮助模型更好地捕捉图像中的上下文信息, 从而提高模型的性能.

上下文感知融合块是通过自适应的注意力机制来捕获图像的上下文信息, 即根据局部特征的不同权重进行加权平均. 该模块可以学习每个区域的重要性, 并将不同区域的特征进行整合, 从而提高特征的表征能力. 同时, 可以显著提高特征提取的鲁棒性, 降低噪声等因素的影响.

在上下文感知融合块中, 不同尺度的特征信息图E=[e1, e11, e2, e22]被拼接放入3×3卷积块(CNR)中学习, 得到得分图Cscore=[Cijl]∈EH×W×4. Cscore中的每个元素表示对应位置在不同特征图中的得分, 反映了该位置的重要性. 接着, Cscore被输入到Softmax激活函数中进行标准化, 得到上下文权重图Wcontext=[Wijl]. Wcontext中的每个元素表示对应位置在不同特征图中的上下文权重, 权重越大表示该位置的上下文信息对特征融合的贡献越大. 在这个融合过程中, 每个尺度的特征图都能够访问同一空间中的所有信息, 从而获取更加丰富的上下文信息, 实现更加精准的特征融合, 模块的详细结构如图3所示.

通过式(1), 得到上下文权重图.

| wijl=ecijl4∑k=1ecijl | (1) |

通过式(2), 式(3)得到最终边缘预测Final.

| CoFusion(E)=4∑1Wcontext⊗E | (2) |

其中,

| Final=Sigmoid(CoFusion(E)) | (3) |

|

图 3 上下文感知融合块(CoFusion) |

1.4 损失函数

损失函数(loss function)是用来度量模型的预测值f(x)与真实值Y的差异程度的运算函数, 它是一个非负实值函数. 损失函数越小, 模型的鲁棒性就越好.而在训练过程中, 损失函数是最为重要的环节之一, 本文对CHRNet原有的损失函数进行了改进. CHRNet使用的损失函数为二分类交叉熵损失(binary cross-entropy loss), 是一种常用的度量二分类模型分类错误率的损失函数. 它可以用来衡量真实标签与预测标签之间的差距. 在二分类问题中, 通常使用0和1表示两个类别. 二分类交叉熵损失可表示为:

| Lbce=−1N N∑i=1[yilog(pi)+(1−yi)log(1−pi)] | (4) |

其中, N是总样本数, yi是第i个样本的真实值, pi是第i个样本的预测值.

在边缘检测中, 图像中的边缘像素(正类别)通常远小于非边缘像素(负类别). 由于边缘像素数量较少, 模型可能倾向于预测更多的非边缘像素, 导致预测偏差[24]. 将Dice系数作为损失函数的一部分, Dice系数关注预测边缘和真实边缘之间的交叉区域, 度量它们之间的相似性, 有助于解决类别不平衡问题.

Dice系数是一种集合相似度度量函数, 通常用于计算两个样本的相似度. 它一种简单而有效的相似度计算方法. Dice系数计算的损失为:

| Ld=N∑ip2i+N∑iy2i2N∑ipiyi | (5) |

其中, N是总样本数, yi是第i个样本的真实值, pi是第i个样本的预测值.

模糊医学图像通常具有较低的对比度和模糊度, 边缘信息不够清晰和明显. 二分类交叉熵损失可以帮助模型学习到图像中的局部特征和纹理信息, 从而提高对边缘的像素级预测准确性. Dice系数损失可以帮助模型生成与真实边缘更相似的预测结果, 即更好地捕捉边缘的形状和位置信息. 综合二分类交叉熵损失和Dice系数损失, 使模型在边缘检测任务中更全面地考虑局部特征和整体形状, 从而提高边缘检测的准确性和鲁棒性.

本文网络的最终损失函数为二分类交叉熵损失(binary cross-entropy loss)和Dice损失的结合. α和β是权重因子, 用于平衡二分类交叉熵损失(binary cross-entropy loss)和Dice系数损失(Dice loss)之间的贡献. 通过使用适当的权重因子α和β平衡两个组成部分[25], 模型可以学习在准确定位和形状相似性之间取得平衡, 从而提高边缘检测性能.

| L=αLbce+βLd | (6) |

为了验证本文边缘提取算法的有效性, 本文采用了来自医院的真实数据集, 包含不同形态下的脊柱、胫骨、骨盆和跟骨的不同模态医学图像. 把数据集经过旋转、缩放、平移、翻转等数据增强方式将数据集扩大到10000张图片. 其中8000张用于训练, 1000张用于验证, 1000张用于测试, 图片大小为1024×1024像素.

2.2 实验环境本文实验使用NVIDIA GeForce RTX3080服务器(12 GB显存), CPU型号为i7-12700, 在PyTorch框架环境下进行训练和测试. 网络训练批处理大小为1, 网络测试批处理大小为1, 采用了Adam优化器, 初始学习率为0.005, 权值衰减为0.1, 进行了30次迭代训练.

2.3 评价指标边缘检测中常用到两种指标, 即数据集最优尺度(ODS)和单张图片最优尺度(OIS). ODS是通过在数据集中使用固定阈值来评估边缘检测结果, 而OIS则是针对每张图片使用最优阈值进行评估[26]. 为了获得更加精细化的边缘图像来进行评估, 实验中通常会使用非最大抑制技术对模型输出的边缘图像进行细化处理. 峰值信噪比 (PSNR) 和结构指数相似度 (SSIM) 也用来衡量边缘提取性能[27]. 它们通常是医学专业人员关注的指标. PSNR用来评价噪声水平或图像失真. PSNR的值越大, 说明失真越少, 生成图像的质量越好. PSNR的计算方式为:

| PSNR=10×log10Max2MSE | (7) |

其中, Max是用于表示图像像素值的最大值; MSE是边缘结果图像与原始标签图像之间的均方误差.

SSIM是计算两张图片相似程度的度量标准. 它主要考虑了图像的结构信息, 因此可以更好地反映人眼的感知结果. SSIM的值在0到1之间, 值越大表示两张图片的相似度越高, 质量越好. SSIM的计算方式为:

| SSIM(x,y)=(2μx μy+C1)(2σxy+C2)(μ2x+μ2y+C1)(σ2x+σ2y+C2) | (8) |

其中, x表示原图; y表示边缘图像; μx表示原图像素均值; μy表示边缘图像像素均值; σx表示原图像素方差; σy边缘图像像素方差; σxy表示原图和边缘图像的像素协方差; C1和C2是常量.

2.4 实验结果为了验证SKSAM注意力模块在关注目标骨骼特征时能够减轻噪声干扰的能力, 我们进行了一项实验, 向模糊医学图像人工添加了噪声, 以更真实地评估该注意力模块的性能. 图4对比展示了在处理噪声模糊医学图像时是否使用注意力模块的边缘提取结果. 通过对比图像效果, 我们可以发现, 在网络中使用SKSAM注意力模块后, 能有效地降低噪声的影响.

|

图 4 SKSAM注意力模块的效果对比图 |

为了研究ECENet各模块的贡献, 本文采取了一系列操作进行消融实验, 实验结果如表1–表3所示. 首先, 本文对原始的CHRNet模型进行了剪枝操作, 删除了最后两个子块, 进行了训练和测试, 发现效果明显有所提升. 接下来, 在网络结构中引入注意力机制SKSAM, 并对其进行了训练和测试, 实验结果表明, 引入该注意力机制后的边缘检测效果得到了提升.随后, 对原有的融合方式进行了改进, 采用了上下文感知融合块, 并进行了边缘检测的实验. 实验结果显示, 采用上下文感知融合块替换原有融合方式后, 边缘检测结果得到了进一步改善, 说明上下文感知融合块在边缘检测中起到了重要作用. 最后使用新的损失函数进行网络的训练测试, 得到最佳效果. 模型的ODS和OIS指标分别提高了13.1%和13.5%, 不同骨骼部位的PSNR指标和SSIM指标也都上升. 通过以上消融实验, 本文对各个模块进行了深入研究, 并验证了它们在边缘检测中的贡献.

| 表 1 ECENet消融实验ODS、OIS指标对比 |

为了评估本文算法在模糊医学图像边缘提取任务中的性能, 本文将在保持相同配置的情况下与最新边缘检测网络CHRNet和两个基于VGG16 (visual geometry group network 16)的经典边缘检测网络RCF和BDCN进行对比. 以下是模糊医学图像边缘检测结果的对比, 包括原始图像以及本文算法、CHRNet、RCF和BDCN的结果图. 从图5中可以看出, 本文提出的边缘检测算法能够更加清晰地提取出目标骨骼的边缘, 而其他网络的边缘检测效果有较多噪声表明了这些算法在复杂医学图像中的鲁棒性存在一定的局限性.

| 表 2 ECENet消融实验PSNR指标对比(dB) |

| 表 3 ECENet消融实验SSIM指标对比 |

本文将4组算法与人工标记的目标骨骼数据边缘信息进行比较, 各算法性能的精度验证结果如表4–表6所示. 经分析可知: (1)本文算法的ODS、OIS、PSNR和SSIM指标均优于其他所有网络模型, 提取的图像边缘更加清晰、完整. (2)对于不同的骨骼都可以保留更多有用的边缘信息, 消除肌肉阴影, 有效区分目标区域和噪声区域. 以上对比说明, 本文算法加强了被检测图像的边缘效果, 改善了图像的边缘质量.

|

图 5 不同算法的结果对比图 |

| 表 4 ODS、OIS指标对比 |

| 表 5 PSNR指标对比(dB) |

3 结论与展望

模糊医学图像的边缘检测任务具有挑战性, 医学图像通常受到噪声、模糊和变形等因素的影响, 使得图像边缘模糊、不连续或部分缺失. 本文提出了一种基于深度学习的模糊医学图像边缘检测算法, 在CHRNet的基础上进行网络结构和损失函数的改进, 缩减网络规模, 让网络更高效; 在特征提取阶段引入注意力机制, 关注目标骨骼的提取, 减少噪声影响; 通过上下文感知融合块将不同尺度的结果进行融合, 以获取更丰富、更准确的最终边缘图像. 本文经过实验验证了一系列改进措施的有效性, 并展示了本文方法相对于其他方法的优越性. 鉴于目前的研究工作, 未来的研究方向有如下两个方面: (1)将所提出的算法应用于临床实践, 验证其在实际医学图像分析任务中的应用潜力和效果. (2)结合生成对抗网络和迁移学习等先进技术, 进一步改进模型的性能和泛化能力.

| 表 6 SSIM指标对比 |

| [1] |

Hu MD, Zhong Y, Xie SX, et al. Fuzzy system based medical image processing for brain disease prediction. Frontiers in Neuroscience, 2021, 15: 714318. DOI:10.3389/fnins.2021.714318 |

| [2] |

Jawdekar A, Dixit M. Deep learning and fuzzy logic based intelligent technique for the image enhancement and edge detection framework. Traitement du Signal, 2023, 40(1): 351-359. DOI:10.18280/ts.400135 |

| [3] |

Shah BK, Kedia V, Raut R, et al. Evaluation and comparative study of edge detection techniques. IOSR Journal of Computer Engineering, 2020, 22(5): 6-15. |

| [4] |

Balochian S, Baloochian H. Edge detection on noisy images using Prewitt operator and fractional order differentiation. Multimedia Tools and Applications, 2022, 81(7): 9759-9770. DOI:10.1007/s11042-022-12011-1 |

| [5] |

Kumar A, Raheja S. Edge detection using guided image filtering and enhanced ant colony optimization. Procedia Computer Science, 2020, 173: 8-17. DOI:10.1016/j.procs.2020.06.003 |

| [6] |

Jing JF, Liu SJ, Wang G, et al. Recent advances on image edge detection: A comprehensive review. Neurocomputing, 2022, 503: 259-271. DOI:10.1016/j.neucom.2022.06.083 |

| [7] |

Liu Y, Cheng MM, Hu XW, et al. Richer convolutional features for edge detection. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 5872–5881.

|

| [8] |

He JZ, Zhang SL, Yang M, et al. Bi-directional cascade network for perceptual edge detection. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 3823–3832.

|

| [9] |

李翠锦, 瞿中. 基于卷积神经网络的跨层融合边缘检测算法. 计算机应用研究, 2021, 38(7): 2183-2187. Li CJ, Qu Z. Cross fusion edge detection algorithm based on CNN. Application Research of Computers, 2021, 38(7): 2183-2187. DOI:10.19734/j.issn.1001-3695.2020.07.0269 |

| [10] |

Soria X, Riba E, Sappa A. Dense extreme inception network: Towards a robust CNN model for edge detection. Proceedings of the 2020 IEEE Winter Conference on Applications of Computer Vision. Snowmass: IEEE, 2020. 1912–1921.

|

| [11] |

Su Z, Liu WZ, Yu ZT, et al. Pixel difference networks for efficient edge detection. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 5097–5107.

|

| [12] |

Elharrouss O, Hmamouche Y, Idrissi AK, et al. Refined edge detection with cascaded and high-resolution convolutional network. Pattern Recognition, 2023, 138: 109361. DOI:10.1016/j.patcog.2023.109361 |

| [13] |

Zhang J, et al. ST-Unet: Swin Transformer boosted U-Net with cross-layer feature enhancement for medical image segmentation. Computers in Biology and Medicine, 2023, 153: 106516. DOI:10.1016/J.COMPBIOMED.2022.106516 |

| [14] |

Zhang ZJ, Fu HZ, Dai H, et al. Et-net: A generic edge-attention guidance network for medical image segmentation. Proceedings of the 22nd International Conference on Medical Image Computing and Computer-assisted Intervention. Shenzhen: Springer, 2019. 442–450.

|

| [15] |

Wang D, Hu GQ, Lyu C. FRNet: An end-to-end feature refinement neural network for medical image segmentation. The Visual Computer, 2021, 37(5): 1101-1112. DOI:10.1007/s00371-020-01855-z |

| [16] |

Almalki YE, Ali MU, Kallu KD, et al. Isolated convolutional-neural-network-based deep-feature extraction for brain tumor classification using shallow classifier. Diagnostics, 2022, 12(8): 1793. DOI:10.3390/diagnostics12081793 |

| [17] |

Wang H, Qin C, Zhang YL, et al. Emerging paradigms of neural network pruning. arXiv:2103.06460v1, 2021.

|

| [18] |

Huan LX, Xue N, Zheng XW, et al. Unmixing convolutional features for crisp edge detection. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 44(10): 6602-6609. DOI:10.1109/TPAMI.2021.3084197 |

| [19] |

Ruby U, Yendapalli V. Binary cross entropy with deep learning technique for image classification. International Journal of Advanced Trends in Computer Science and Engineering, 2020, 9(10): 5393-5397. |

| [20] |

Setiawan AW. Image segmentation metrics in skin lesion: Accuracy, sensitivity, specificity, dice coefficient, Jaccard index, and Matthews correlation coefficient. 2020 International Conference on Computer Engineering, Network, and Intelligent Multimedia (CENIM). Surabaya: IEEE, 2020. 97–102.

|

| [21] |

Liu HJ, Yang ZY, Zhang HF, et al. Edge detection with attention: From global view to local focus. Pattern Recognition Letters, 2022, 154: 99-109. DOI:10.1016/j.patrec.2022.01.006 |

| [22] |

Li X, Wang WH, Hu XL, et al. Selective kernel networks. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Long Beach: IEEE, 2020. 510–519.

|

| [23] |

Dubey SR, Singh SK, Chaudhuri BB. Activation functions in deep learning: A comprehensive survey and benchmark. Neurocomputing, 2022, 503: 92-108. DOI:10.1016/j.neucom.2022.06.111 |

| [24] |

Hou SM, Jia CL, Wang YB, et al. A review of the edge detection technology. Sparklinglight Transactions on Artificial Intelligence and Quantum Computing (STAIQC), 2021, 1(2): 26-37. DOI:10.55011/STAIQC.2021.1203 |

| [25] |

Yeung M, Sala E, Schönlieb CB, et al. Unified Focal loss: Generalising Dice and cross entropy-based losses to handle class imbalanced medical image segmentation. Computerized Medical Imaging And Graphics, 2022, 95: 102026. DOI:10.1016/j.compmedimag.2021.102026 |

| [26] |

Sun R, Lei T, Chen Q, et al. Survey of image edge detection. Frontiers in Signal Processing, 2022, 2: 826967. DOI:10.3389/frsip.2022.826967 |

| [27] |

Sara U, Akter M, Uddin MS. Image quality assessment through FSIM, SSIM, MSE and PSNR—A comparative study. Journal of Computer and Communications, 2019, 7(3): 8-18. DOI:10.4236/jcc.2019.73002 |

2024, Vol. 33

2024, Vol. 33