2. 中国科学院 沈阳计算技术研究所, 沈阳 110168;

3. 辽宁省化工过程工业智能化技术重点实验室, 沈阳 110142

2. Shenyang Institute of Computing Technology, Chinese Academy of Sciences, Shenyang 110168, China;

3. Liaoning Provincial Key Laboratory of Intelligent Technology for Chemical Process Industry, Shenyang 110142, China

近年来, 随着工业生产自动化的不断发展, 螺钉、齿轮、轴承等常见工件成为工业生产中的重要组成部分, 在整个工业加工流程中有着重要作用. 实际工业生产过程中经常面临工件摆放堆叠的情况, 与理想情况下单个工件出现在工作场景存在显著差异. 工件堆叠引发了繁杂的视角和相互遮挡关系, 给生产制造过程带来了挑战: 常见的堆叠问题对工件识别、定位和跟踪等工作造成极大影响, 使工作难以顺利进行. 与传统的单一工件重建不同, 在现实场景中需要处理的是多个工件之间的相互遮挡、视角变化等复杂情况. 因此需要通过利用多视角图像和相应的相机位姿信息, 以解决工件堆叠场景下的重建难题. 多视图立体(multi-view stereo, MVS)重建[1]旨在以立体匹配为主要线索, 从一系列图像、相应的相机位姿和已知参数中重建出场景三维模型. 本研究旨在实现对工件堆叠场景的高质量三维重建, 为实际生产制造提供准确可靠的场景还原和模型重建. 这将有助于优化生产过程中的工件识别、定位和跟踪等关键环节, 提高生产效率和质量水平, 为工业制造领域的发展带来新的技术突破和应用前景.

在传统MVS方法中, Snavaly等人[2]设计了首个增量式的运动恢复结构(structure from motion, SFM)系统, 估计相机位姿并获得目标的三维稀疏点云, 然后利用 MVS生成目标的三维稠密点云模型, 后续的论文研究都遵循了Snavaly等人[2]设计的流程. 2016年, Schonberger等人[3]提出了COLMAP, 在原有增量式SFM的基础上引入了一种几何验证策略, 采用信息增强场景图, 从而提高初始化和三角测量组件的鲁棒性, 并进行一系列优化, 使系统在鲁棒性和完整性方面明显优于当时现有技术的同时保持其效率. 由于深度学习的出色表现, 许多学者开始将深度学习运用到MVS算法中, 2018年, Yao等人[4]提出了一种端到端的深度学习架构MVSNet, 用于从多视图图像中推断深度图. 该网络首先提取深度视觉图像特征, 然后通过可微单应性变换构建3D成本体积. 然后应用3D卷积来进行代价体正则化和回归初始深度图, 最后用参考图像对其进行细化以生成最终输出. 2019年, Yao等人[5]又在原来的基础上对正则化、深度推断、后处理3个部分进行优化, 提出了R-MVSNet, 在提高性能的同时减少了内存消耗, 但相应的训练时间大大增加. 2019年, Gu等人[6]首次提出了一种级联网络结构CasMVSNet, 通过一个较小的代价体估计低分辨率的深度图, 然后根据上一级输出的深度图, 缩减当前尺度的深度假设范围. 2022 年, Yang等人[7]提出的CVP-MVSNet, 以粗略到精细的方式构建成本体积金字塔, 而不是以固定分辨率构建成本体积, 从而实现紧凑、轻量级的网络, 并推断高分辨率深度图, 获得更好的重建结果. 2020年, Yu等人[8]提出了Fast-MVSNet, 利用数学高斯牛顿迭代法来优化, 其中的模块都是轻量级的, 保证了工作效率, 但是重建数据一般. 2020年, Yi等人[9]提出PVA-MVSNet, 通过引入两种新的自适应视图聚合: 逐像素视图聚合和逐体素视图聚合, 以较小的额外内存消耗合并了不同视图中的成本方差, 在重建方面有了显著的改进. 2021年, Wang等人[10]首次在端到端可训练架构中引入迭代多尺度Patchmatch, 并在每次迭代中使用一种新的、经过学习的自适应传播和评估方案来改进Patchmatch核心算法, 在内存和速度上有很大的提升, 但重建效率有所下降. 2022年, Ding等人[11]提出了TransMVSNet网络结构, 是首次将Transformer运用到MVS任务中, 在特征匹配部分取得了不错的效果, 但整体性能一般, 受设备性能影响较大. 2022年, Chang等人[12]提出RC-MVSNet, 通过施加深度渲染一致性损失, 以约束靠近对象表面的几何特征, 从而减轻遮挡影响, 比许多有监督的方法具有竞争力, 在训练周期上有着较好的性能.

目前多视图立体三维重建技术对于具有弱纹理区域[13–15]的工件重建工作中, 多个工件堆叠带来了复杂的视角和遮挡关系, 存在图像特征点提取难度大、特征配准精度低的诸多情况. 本文为实现对特定区域中重建稀疏的表面保留更多的结构信息和纹理细节, 同时丰富堆叠工件细节以及提高重建精度, 提出一种多视图立体重建算法, 在级联架构的基础上进行优化并完成MVS任务, 使用DTU数据集进行训练和测试, 并自己采集堆叠工件图像做出数据集用来实现工件的三维重建. 本文的主要工作如下: (1)在特征提取部分, 在金字塔网络FPN[16]后添加可变形卷积DCNv2模块[17]来增大卷积的范围提升模型的表现力, 控制好偏移的范围, 避免提取不相关的特征信息; (2)在代价体正则化部分, 引入SE (squeeze-and-excitation)通道注意力机制模块[18]来提高网络的特征表达能力, 增强模型的性能和泛化能力; (3)最后根据实际项目工程场景, 采集并制作了一个堆叠工件的数据集, 包括各角度的图像以及每张图片对应的相机位姿信息, 并用该数据集较好地实现了堆叠工件场景的三维点云恢复, 验证了本文算法的实用性.

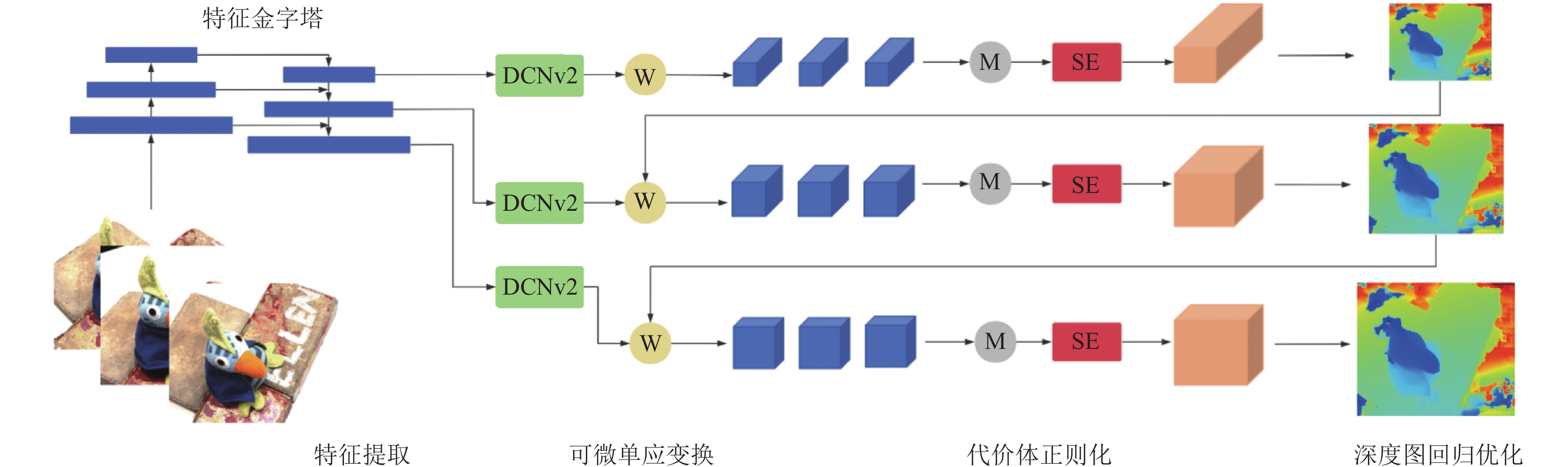

2 方法本文设计的多视图立体匹配深度学习网络架构依照CasMVSNet采用级联结构, 利用多张堆叠工件图像和对应的相机位姿信息对实际场景进行三维模型重建. 将融合可变卷积DCNv2的金字塔特征提取模块和融合SE通道注意力机制模块整合到基准级联结构网络中, 以增强特征表达和注意力集中能力. 并按照标准的特征提取、可微单应变换、代价体正则化、深度图回归4大步骤完成场景的三维重建工作, 以确保重建结果的准确性和稳定性. 整体而言, 本文所提出的网络架构在图1中得以清晰展示, 为实现高效三维重建工作奠定了坚实基础.

|

图 1 本文网络架构 |

2.1 基于可变卷积DCNv2的金字塔特征提取网络

在多视角图像匹配的复杂过程中, 为了全面把握目标信息, 通过构建多尺度特征金字塔, 以涵盖不同尺度下的细节和特征. 然而, 在这一过程中, 传统的卷积操作却显得力不从心, 因为传统卷积核所采用的固定大小卷积核和感受野在捕捉多样的尺度和形态特征上表现欠佳. 这种局限性会引起网络对特征处理的不足, 因为卷积核和感受野的设定可能无法灵活适配不同场景的大小和形状变化, 从而导致部分关键特征信息的遗漏.

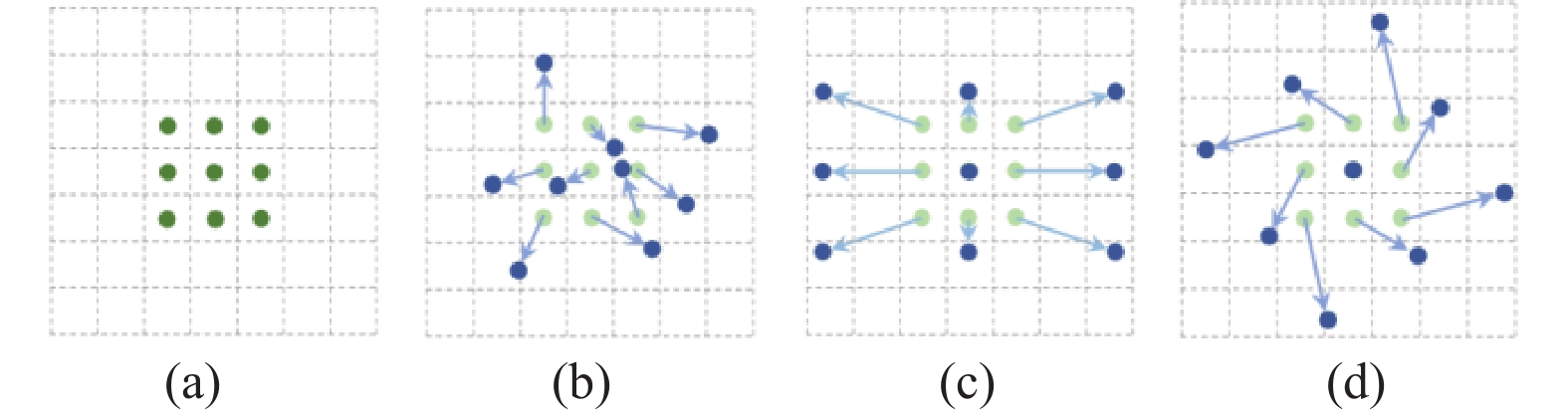

针对以上问题, 本文引入了可变卷积 DCNv2, 可变卷积允许网络在学习过程中动态地调整卷积核的形状和位置, 从而扩大了卷积操作的感受野, 集中于感兴趣的区域或目标, 以更有效地捕捉不同纹理区域的特征. 传统卷积操作和可变卷积操作采样的方式大不相同, 如图2所示.

图2中, (a)代表了标准卷积的采样方式, 用圆点表示. (b)则展示了可变形卷积中, 通过增强偏移的变形采样位置, 用圆点和箭头来呈现. (c)和(d)是对(b)的特殊情况的描述, 说明可变形卷积技术能够适应各种尺度、纵横比和旋转的变换. 对于输出特征图y上的每个位置

| y(p0)=∑pn∈Rw(pn)⋅x(p0+pn) | (1) |

|

图 2 标准和可变卷积中 3×3采样位置 |

在可变卷积中, 规则网格R通过偏移

| y(p0)=∑pn∈Rw(pn)⋅x(p0+pn+Δpn) | (2) |

采样是在不规则和偏移位置

| x(p)=∑qG(q,p)⋅x(q) | (3) |

可变卷积DCNv2在此基础上为了进一步增强可变形卷积神经网络对空间支持区域的控制能力, 引入了一种调制机制. 调制机制为网络模块提供了另一个自由维度来调整其空间支持区域. x(p)和y(p)分别表示来自输入特征图x和输出特征图y的位置处p的特征. 调制的可变卷积可以表示为:

| y(p)=K∑k=1wk⋅x(p+pk+Δpk)⋅Δmk | (4) |

其中,

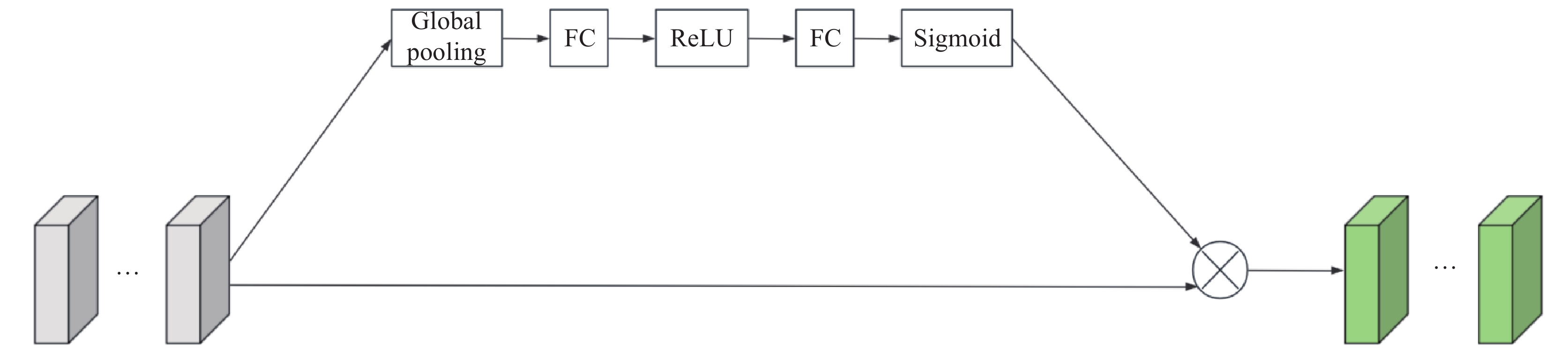

在构建三维代价体及后续重建部分中, 代价体积是指从多个视角获取的图像中重建的三维场景中的每个点的深度候选集合. 由于非朗伯面、弱纹理及遮挡等因素会包含噪声信息, 需要对其进行正则化. 而代价体积正则化的目标是优化代价体积, 以使其对应于真实深度值. 然而普遍网络无法自适应地调整通道间的权重, 且每个分支产生的特征图重要性存在差异, 从而出现特征选择不当的问题. 在此过程中, 本文引入SE通道注意力机制模块, SE模块是一种轻量级的门控机制, 通过学习特征通道之间的关系, 动态地调整每个通道的权重, 提取和强调最重要的特征信息, 并抑制不太有用的特征信息. 从而使得网络能够更好地捕获关键信息, 提高网络对输入数据的表达能力. 其主要流程由图3所示.

|

图 3 SE模块 |

首先是压缩操作, 对输入的图像特征u进行全局平均池化, 得到当前特征的全局压缩特征量. 通过缩小空间维度H×W来生成数据, 其计算公式如式(5)所示:

| zc=Fsq(uc)=1H×WH∑i=1W∑j=1uc(i,j) | (5) |

然后进行激励操作, 用于完全捕获通道依赖关系, 使其能够学习通道之间的非线性相互作用, 并确保多个通道被强调. 将经过上一步压缩得到的z进行处理, 获得最终的激励权重, 其计算公式如式(6)所示. 其中

| s=Fex(z,W)=σ(g(z,W))=σ(W2δ(W1z)) | (6) |

接着, 将上一步生成的激励权重s对特征图u进行权重赋值, 获得最终的特征图, 使其尺寸大小与输入的原特征图完全一样, SE通道注意力机制模块不改变特征图的大小. 其最终输出是通过式(7)激活重新缩放变换输出获得的.

| ˜Xc=Fscale(uc,sc)=sc⋅uc | (7) |

本文实验所使用计算平台的主要参数: 32 GB内存、NVIDIA GeForce RTX 3080显卡. 运行系统环境: Windows 10, 编程语言: Python, 深度学习框架: PyTorch.

3.2 DTU数据集实验分析 3.2.1 DTU数据集DTU数据集[19]是一个涵盖多种对象的室内公开数据集, 具有广泛的应用价值, 尤其在计算机视觉和三维重建领域. 它涵盖了多种室内对象, 为研究者们提供了丰富的实验数据. 这个数据集的采集过程十分精细, 采用了一个安装有结构光扫描仪的工业机器臂, 对物体进行多视角的拍摄, 可获取每个视角的相机内、外参数. 这种拍摄方式能够捕捉到物体的各个细节, 从而生成高质量的三维模型.

数据集中一共有124个场景, 每个场景都取 49 个相机位置, 对应于每个场景 RGB 图像和结构光标签的数量, 每个视角有7种不同亮度的图像, 可以更好地应对光照变化对三维重建的影响, 提高算法的鲁棒性和准确性. 数据集中包括每张RGB图像的摄像头参数、拍摄图像、真实深度图和掩膜.

3.2.2 实验细节本文将所提出的方法与CasMVSNet及其他方法在DTU数据集上进行实验对比, 在训练过程中, 将输入图片数量设为N=3, 其中包括1张主要参考图像和2张其邻近图像, 将图像分辨率设置为640×512. 采用三级级联成本体积, 从第1阶段到第3阶段, 每个阶段的平面扫描深度假设的数量分别为 48、32、8, 对应的深度间隔被设置为 4、2、1. 使用Adam优化器训练16个epoch. 初始学习率为0.001, β1=0.9, β2=0.999. 在第10、12、14个epoch后将其缩小2倍, batchsize 大小设为1. 在测试过程中, 输入图片数量设为N=5, 其中包括1张主要参考图像和4张其邻近图像, 将图像分辨率设置为1600×1200, 深度采样次数D=192.

3.2.3 实验结果实验使用 DTU 数据集提供的官方 Matlab 脚本评估点云的准确性Acc、完整性Comp以及整体性能Overall这3个指标[20,21]. Acc衡量的是重建点云到真实值的距离, Comp衡量的是真实值到重建点云的距离, 需要计算precision值和recall值, 指标越低越好, 表示重建值R与真值G之间的距离越小, 恢复的点云越准确. 首先定义R中的一个点r到G的距离, r到G中所有点的距离中, 最小的距离就是r到整个G的距离, 计算公式如式(8)所示:

| er→G=ming∈G||r−g|| | (8) |

并在式(8)基础上定义一个阈值d, 统计所有距离小于d的点的个数, 然后通过式(9)得到最终百分比结果.

| P(d)=100|R|∑r∈R[er→G<d] | (9) |

Recall的计算与前者相似, 用于衡量G 到 R的距离. 计算公式如式(10)、式(11)所示:

| eg→R=minr∈R||g−r|| | (10) |

| R(d)=100|G|∑g∈G[eg→R<d] | (11) |

在计算出以上的指标后, 就可以计算出衡量precision和recall的整体指标F-score, 具体计算公式如式(12)所示:

| F(d)=2P(d)R(d)P(d)+R(d) | (12) |

其中, Overall是3个指标中最重要的, 是准确性Acc和完整性Comp的总和平均值, 代表着重建整体性误差. 本文评价指标Acc、Comp以及整体性能Overall的关系如式(13)所示:

| Overall=Acc+Comp2 | (13) |

由表1中数据可得, 本文所提出的方法完整性Comp和整体性能Overall指数都是最低的, 虽然准确性Acc没有达到最低, 但是整体上来说本方法在与其他方法对比三维重建中性能最好, 证明了所提方法的有效性. 完整性Comp和整体性Overall的提高主要得益于可变卷积DCNv2模块和SE通道注意力机制模块, 其中可变卷积DCNv2模块通过灵活调整卷积核的形状和大小, 有效地捕获了不同尺度下的特征, 从而提升了模型对于图像中物体边缘和细节的感知能力. 与此同时, SE通道注意力机制模块能够动态地调整不同通道的重要性权重, 有针对性地增强对于关键特征的抽取, 从而使模型更加聚焦于关键信息, 进一步提高了整体的性能表现.

| 表 1 DTU 数据集重建指标结果 (mm) |

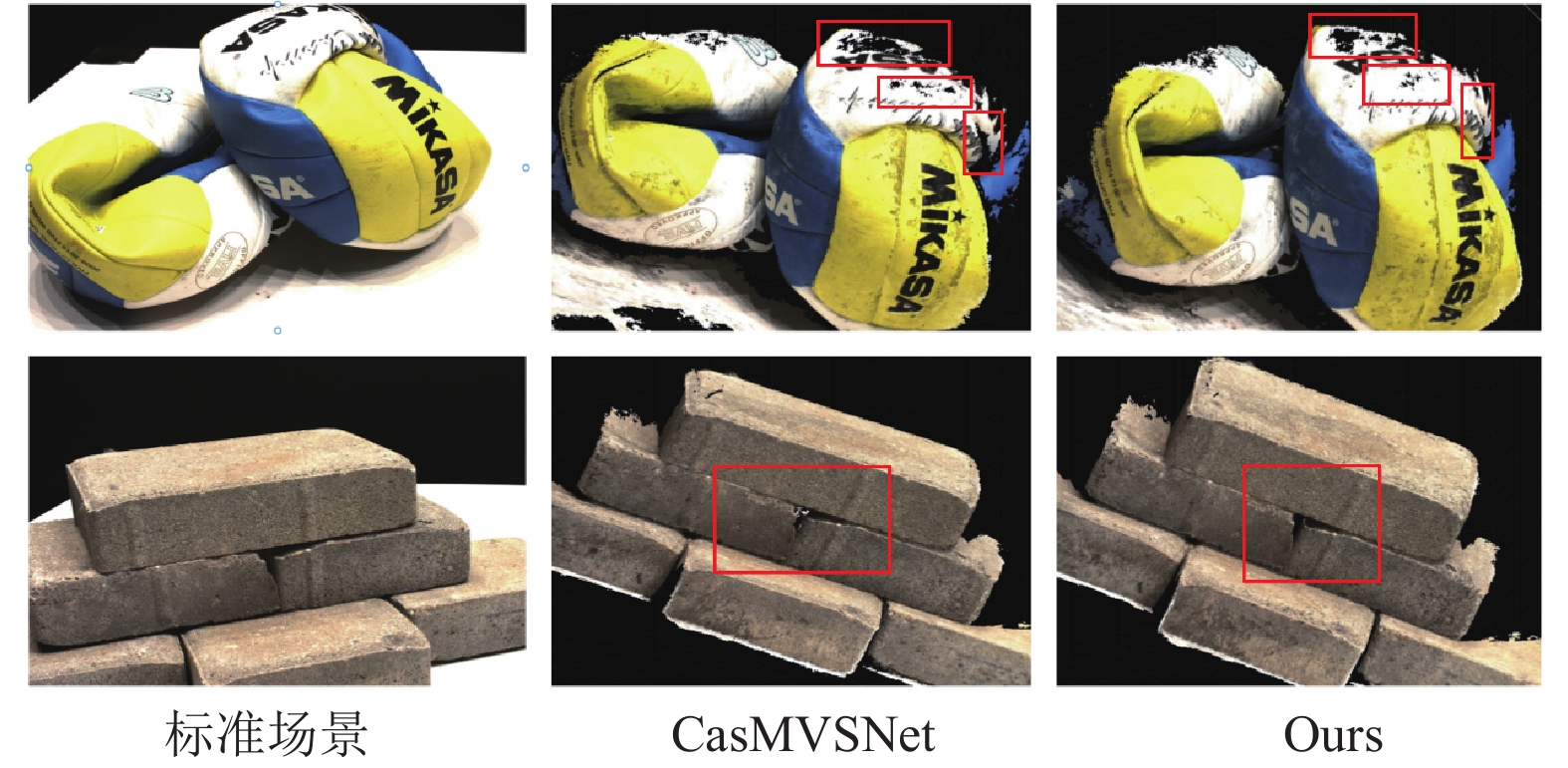

具体在点云数据生成方面, 该方法在细节处理过程中对比其他方法也有较好的表现, 选用scan34和scan62两个场景进行对比, 点云效果对比如图4所示. 从方框标注的部分, 可清晰地看出, 本文算法点云信息更加丰富, 尤其是在scan34对比中可以看到, CasMVSNet砖缝中间还存在着大面积的空白, 而本文算法在物体边缘和细节的感知能力较强, 已经基本实现了填补空洞的目标.

3.2.4 消融实验本节进行了一系列的消融实验, 以验证本文提出算法中关键模块的有效性, 该部分采用与第 3.2 节相同的参数在 DTU 测试集上进行以下4组消融研究: (a) Baseline, 即采用基准网络, 不添加任何额外的模块; (b) Baseline+DCNv2模块; (c) Baseline+SE模块; (d) Baseline+DCNv2模块+SE模块; 文中算法通过比较展现出了优秀的性能水平. 各个模块的性能结果如表2所示.

|

图 4 实验的对比 |

| 表 2 定量消融实验分析对比 (mm) |

通过深入对比表2中的定量结果, 观察了它们对模型性能的影响. 首先, 单独引入DCNv2后, 准确性指标显著下降, 表明DCNv2模块提升了网络对复杂几何形状和细节的捕捉能力, 从而提高了模型的准确性. 然而, 完整性指标上升, 这是由于DCNv2的卷积核可以动态变形, 在某些区域的特征提取过程中产生了更多的噪声或不连续性, 导致完整性下降. 其次, 单独引入SE模块后, 准确性指标同样下降, 这表明SE模块通过自适应调整通道间的权重, 增强了重要特征的表示能力, 从而提高了模型的准确性. 然而, 完整性指标上升, 这是因为SE模块在增强重要特征时忽略了一些边缘或细节特征, 导致完整性下降.

当同时引入DCNv2和SE模块时, 准确性和完整性指标均下降, 这表明两者的结合能够在捕捉复杂几何形状和增强特征表示上互补, 进一步降低了准确性误差. SE模块在全局上自适应调整通道间的权重, 能够平衡DCNv2引入的噪声和不连续性, 从而改善了完整性. 这使得整体性指标显著下降, 说明这种结合方式在处理复杂几何形状和增强特征表示方面具有显著优势, 提升了模型的整体性能.

综上所述, 单独引入DCNv2或SE模块分别提升了模型的某些方面, 但同时也引入了一些新的问题. 而同时引入DCNv2和SE模块能够互相补充, 平衡特征提取过程中出现的问题, 从而显著提升模型的整体性能. 我们可以清晰地看到每个模块在提升点云重建整体性能方面所起到的积极作用. 这些模块不仅各自独具特色, 而且相互协作, 共同构成了本文所提算法的核心架构.

3.3 自建数据集实验分析 3.3.1 堆叠工件图像数据集为了验证本文算法在重建堆叠工件的实用性、对待纹理稀疏、纹理重复和细节处理区域的性能, 自行采集并制作了堆叠工件图像数据集用于测试. 该数据集是从多角度环绕拍摄一组实际工厂项目中出现的堆叠工件场景, 仿照DTU数据集的部分场景需求, 在堆叠工件这一场景共拍摄了49张场景图片. 为了确保目标场景立体匹配信息的完整性和目标模型重建的质量, 原始图片的分辨率为3024×4032, 以尽可能捕获场景的细节和特征. 在数据采集后, 利用COLMAP对每个图片进行标定, 得到了对应的一套相机参数以及视觉选定. 具体的场景图片如图5所示.

|

图 5 COLMAP中每个图片的机位 |

这一步骤是为了准确地还原出每张图片所对应的拍摄视角和相机参数, 为后续的立体匹配和三维重建提供了基础. 随后, 使用了MVSNet架构中提供的colmap2mvsnet脚本工具, 对COLMAP的输出文件进行处理, 将其转化为本文架构可输入的数据集格式. 这个过程包括了将视觉几何信息转换为深度信息, 并进行了适当的格式转换和数据处理, 以满足本文算法的输入要求. 通过这一步骤, 成功将原始的图片数据转换为了适合于本文算法的输入数据集, 最终数据集包括, 49张去畸变后的图片、49个对应的相机参数文件以及一个用于定义视觉图像对及其相对关系的配置文件. 该数据集提供了丰富的场景信息和几何结构, 为本文算法提供了充足的数据基础, 从而确保了重建模型的质量和准确性.

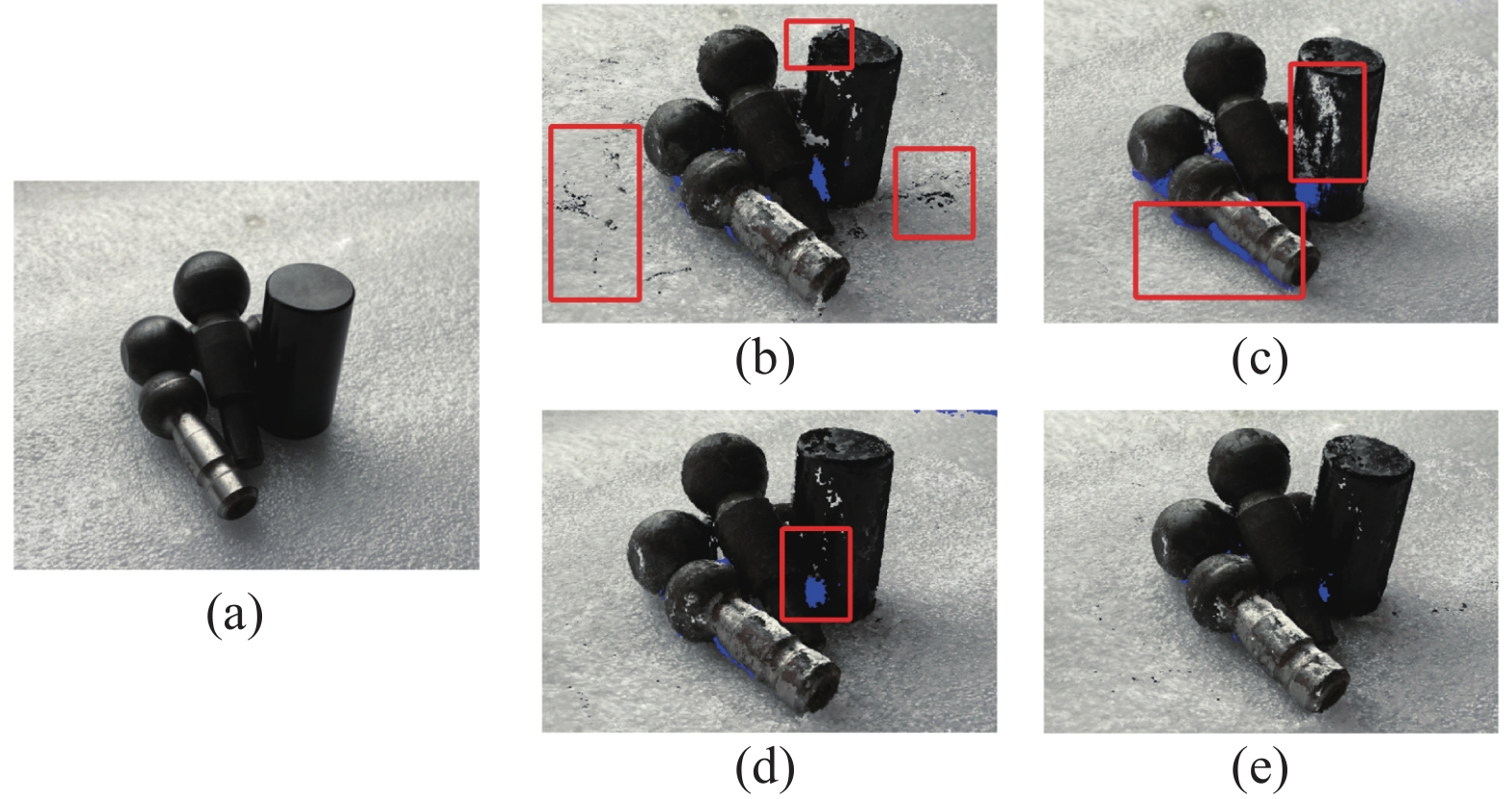

3.3.2 实验结果本文的训练参数设置与上文相同, 针对自建的堆叠工件图像数据集进行三维重建. 该实验比较了不同算法在堆叠工件三维重建场景中的表现, 如图6所示.

|

图 6 不同方法得到的堆叠工件场景的三维重建结果 |

图6中, 标准场景(图6(a)): 标准堆叠工件场景图像. RC-MVSNET (图6(b)): 在重建过程中产生了较多噪点和错误的细节区域. CasMVSNet (图6(c)): 重建质量有所提升, 但仍有一些缺失的重建点云细节. TransMVSNet (图6(d)): 表现良好, 但仍存在少量重建点云细节错误.

实验结果表明, 本文的算法(图6(e))能够在保持重建细节的同时, 较为精确地重建出工件的三维模型, 重建的细节更精确, 噪点显著减少, 通过扩大卷积范围和增强特征表达能力, 整体重建效果更好. 值得注意的是, 在对堆叠工件进行重建时, 由于场景本身存在大量的重复纹理, 工件堆叠后, 颜色、形状等局部特征非常相似. 然而, 本文算法在重建过程中能够准确地区分不同工件之间的差异, 实现重建目标.

总体而言, 我们的改进算法通过更有效地捕捉和表达特征信息, 在完整性和细节上明显优于其他算法, 重建出来的效果与真实场景高度相似, 展示了更高的重建质量和模型性能, 为工件识别抓取项目的后续进行, 奠定了基础.

4 总结本文提出了一种基于多视图立体深度学习的堆叠工件三维重建技术, 旨在解决工业自动化中常见的堆叠问题对工件识别、定位和跟踪等工作的影响. 针对现有方法在处理具有弱纹理区域的工件重建时存在的问题, 本文提出了一种优化的多视图立体重建算法. 该算法通过优化级联结构、引入可变形卷积DCNv2和SE通道注意力机制等关键技术, 成功地完成了对堆叠工件的三维模型重建. 在实验方面, 首先在DTU数据集上进行了训练和测试, 并验证了算法的有效性. 结果显示, 所提出的方法在完整性以及整体性能方面均表现出色, 优于基准方法. 进一步地, 在自建堆叠工件图像数据集上也取得了良好的重建效果. 这些结果验证了所提出方法的可行性和有效性, 为工业自动化领域提供了一种更加高效、精确的数字化解决方案. 未来, 我们将继续改进和优化算法, 进一步推动堆叠工件三维重建技术与自动化技术的融合, 以满足智能自动化中对于精准、高效生产的需求.

| [1] |

鄢化彪, 徐方奇, 黄绿娥, 等. 基于深度学习的多视图立体重建方法综述. 光学 精密工程, 2023, 31(16): 2444-2464. |

| [2] |

Snavely N, Seitz SM, Szeliski R. Photo tourism: Exploring photo collections in 3D. ACM SIGGRAPH 2006 Papers. Boston: ACM, 2006. 835–846. [doi: 10.1145/1179352.1141964]

|

| [3] |

Schönberger JL, Frahm JM. Structure-from-motion revisited. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 4104–4113. [doi: 10.1109/CVPR.2016.445]

|

| [4] |

Yao Y, Luo ZX, Li SW, et al. MVSNet: Depth inference for unstructured multi-view stereo. Proceedings of the 15th European Conference on Computer Vision. Munich, Germany: Springer, 2018. 785–801.

|

| [5] |

Yao Y, Luo ZX, Li SW, et al. Recurrent MVSNet for high-resolution multi-view stereo depth inference. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 5520–5529. [doi: 10.1109/CVPR.2019.00567]

|

| [6] |

Gu XD, Fan ZW, Dai ZY, et al. Cascade cost volume for high-resolution multi-view stereo and stereo matching. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2019. 2492–2501. [doi: 10.1109/CVPR42600.2020.00257]

|

| [7] |

Yang JY, Mao W, Alvarez JM, et al. Cost volume pyramid based depth inference for multi-view stereo. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 44(9): 4748-4760. DOI:10.1109/TPAMI.2021.3082562 |

| [8] |

Yu ZH, Gao SH. Fast-MVSNet: Sparse-to-dense multi-view stereo with learned propagation and gauss-newton refinement. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle: IEEE, 2020. 1946–1955. [doi: 10.1109/CVPR42600.2020.00202]

|

| [9] |

Yi HW, Wei ZZ, Ding MY, et al. Pyramid multi-view stereo net with self-adaptive view aggregation. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 766–782.

|

| [10] |

Wang FJH, Galliani S, Vogel C, et al. PatchmatchNet: Learned multi-view patchmatch stereo. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 14189–14198. [doi: 10.1109/CVPR46437.2021.01397]

|

| [11] |

Ding YK, Yuan WT, Zhu QT, et al. TransMVSNet: Global context-aware multi-view stereo network with Transformers. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022. 8575–8584. [doi: 10.1109/CVPR52688.2022.00839]

|

| [12] |

Chang D, Božič A, Zhang T, et al. RC-MVSNet: Unsupervised multi-view stereo with neural rendering. Proceedings of the 17th European Conference on Computer Vision. Tel Aviv: Springer, 2022. 665–680. [doi: 10.1007/978-3-031-19821-2_38]

|

| [13] |

栗博, 何红艳, 王钰, 等. 面向弱纹理空间目标的特征点匹配方法. 航天返回与遥感, 2024, 45(1): 99-110. DOI:10.3969/j.issn.1009-8518.2024.00.009 |

| [14] |

徐一成, 里鹏, 李帅, 等. 基于区域的弱纹理零件三维跟踪方法. 计算机集成制造系统, 1–21. https://link.cnki.net/urlid/11.5946.TP.20231129.1512.002. (2023-11-30)[2024-04-17]. [doi: 10.13196/j.cims.2023.0222]

|

| [15] |

陈蔓菲. 基于多视图的工件三维重建技术研究 [硕士学位论文]. 长春: 长春理工大学, 2023. [doi: 10.26977/d.cnki.gccgc.2023.000265]

|

| [16] |

Lin TY, Dollár P, Girshick R, et al. Feature pyramid networks for object detection. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 936–944. [doi: 10.1109/CVPR.2017.106]

|

| [17] |

Zhu XZ, Hu H, Lin S, et al. Deformable ConvNets V2: More deformable, better results. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Long Beach: IEEE, 2019. 9300–9308. [doi: 10.1109/CVPR.2019.00953]

|

| [18] |

Hu J, Shen L, Albanie S, et al. Squeeze-and-excitation networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(8): 2011-2023. DOI:10.1109/TPAMI.2019.2913372 |

| [19] |

Aanaes H, Jensen RR, Vogiatzis G, et al. Large-scale data for multiple-view stereopsis. International Journal of Computer Vision, 2016, 120(2): 153-168. |

| [20] |

Seitz SM, Curless B, Diebel J, et al. A comparison and evaluation of multi-view stereo reconstruction algorithms. Proceedings of the 2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2006. 519–528. [doi: 10.1109/CVPR.2006.19]

|

| [21] |

Knapitsch A, Park J, Zhou QY, et al. Tanks and temples: Benchmarking large-scale scene reconstruction. ACM Transactions on Graphics (TOG), 2017, 36(4): 78. DOI:10.1145/3072959.3073599 |

2024, Vol. 33

2024, Vol. 33