2. 南京信息工程大学 计算机学院, 南京 210044

2. School of Computer Science, Nanjing University of Information Science & Technology, Nanjing 210044, China

群体行为识别旨在理解和分析集体中多个个体的行为模式、交互及动态变化, 探索人群在不同情境下的行为特征和规律, 涉及机器学习、社会学和心理学等多个学科的交叉研究, 近年来得到广泛关注[1,2].

目前许多方法致力于构建多人场景下个体之间的互动关系, 以准确推断出群体行为. 早期基于循环神经网络(RNN)[3–6]的方法可有效探索长时间段内的运动规律. 现有方法常使用卷积神经网络(CNN)[7–9]与图卷积网络(GNN)[10,11]模拟个体关系, 并结合注意力机制[12–15], 精细化提取人物的关系信息, 搭建关系交互图. 这些方法有效探索了集体中多个个体间的互动线索, 为群体行为识别的发展起到了促进作用.

尽管上述方法取得了良好的效果, 但仍存在以下问题.

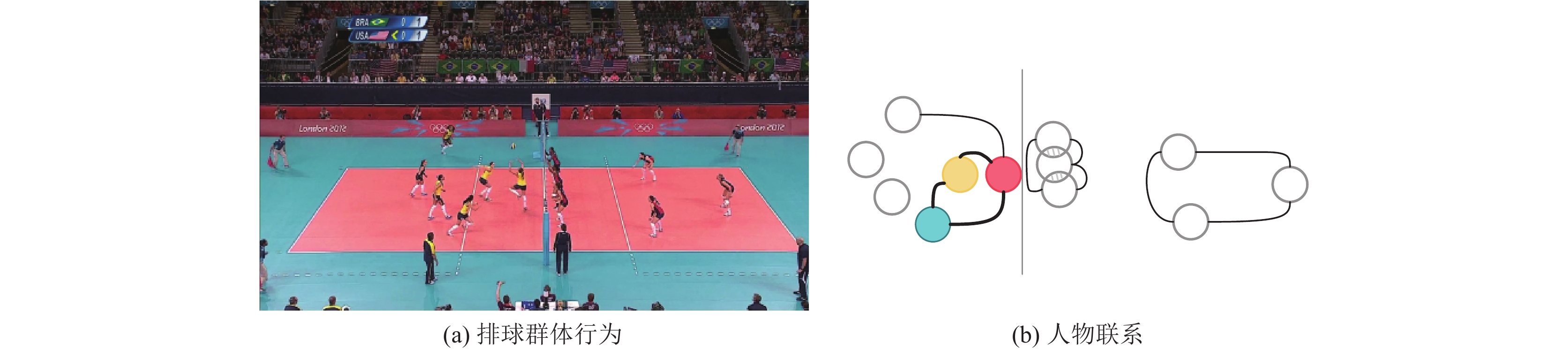

(1)忽略场景上下文信息, 致使行为识别精度较低. 在识别群体行为时, 场景上下文信息指人物所在场景中有助于判断个体与群体动作的环境和背景信息. 例如在排球运动中, 排球的运动轨迹通常会决定运动员的位置与行为倾向, 对运动员群体行为的判断起重要作用. 另外, 场景的布局与结构、其他人物的动态变化也会对目标人物的行为识别准确度产生一定的影响. 然而, 现有方法侧重于个体间的关系建模, 很少探索场景中与人物相关的线索. 这些方法通常直接从原始图像中提取包含了场景信息的全局特征, 然后基于标注的人物位置, 使用RoI Align对该特征进行感兴趣区域映射, 获取包含了人物细节信息的个体特征, 并最终利用个体特征预测群体行为的类别. 如图1(a)所示, 若仅利用标注框内的人物区域特征, 则会忽略其与全局场景的联系, 影响最终的行为识别效果.

(2)图片中存在人物遮挡的情况, 致使缺失部分人物信息. 如图1(a)中右侧灰色框中的3位防守人物, 相互之间存在遮挡的情况, 无法精确地获取外观细节. 若仅利用其个体特征进行群体行为推理, 则会由于信息缺失而影响行为识别的精度.

(3)难以确定关键人物, 致使分类结果被无关个体干扰. 场景中每个个体对群体行为的影响程度不同, 只有明确关键人物才能实现更加精确的群体行为分类. 如图1(a)、(b)所示, 其中标注的3位人物均具有较大的动作幅度, 相较于其他人物, 他们的互动关系也更为紧密, 对群体行为的识别结果起决定性作用. 若选择其他人物进行群体行为的判断, 则会使分类结果出错. 因此不能随意选取个体来判断整体行为或者给所有个体分配相同的参与权重, 否则会导致行为分类结果被无关个体所干扰. 如何充分利用人物所在场景的上下文信息, 并判断不同个体在识别过程中对群体行为的影响重要性, 是群体行为识别领域中亟待解决的重要问题. 此外, 在实际应用场景中, 数据集通常包含不同数量的样本类别, 导致模型倾向于预测出现频率更高的类别.

|

图 1 视频中排球群体行为的示例 |

为解决上述问题, 本文提出一个基于全局-个体特征融合的群体行为识别模型GIFFNet (global-individual feature fusion network), 通过融合全局场景特征与个体人物特征, 解决行为识别时人物特征中场景信息缺失的问题. 具体而言, GIFFNet使用GIFF模块将个体特征与全局特征紧密联合, 充分利用视频帧中的场景上下文信息. 通过将场景信息嵌入人物特征中, GIFFNet不仅能够丰富特征训练时的场景信息, 还可以弥补人物遮挡的外观细节缺失问题. 其次, 若某些帧之间的场景变化较大, 可以通过融合全局特征捕捉这些动态变化, 提高模型的鲁棒性. 同时, 为了捕捉视频中的关键帧与图片中的关键人物, GIFF模块中利用注意力机制聚焦关键信息, 实现精细化的特征提取. 另外, 针对图片分类的过程中数据集样本失衡的问题, 本文在标准交叉熵损失的基础上进行优化, 采用动态参数的思想, 取得显著的效果提升. 总体而言, 本文的贡献包括以下几个方面.

● 本文提出GIFFNet, 融合了全局场景特征与个体人物特征, 并利用表征能力增强的融合特征进行群体行为的推理.

● 为高效整合场景上下文信息与个人特征, 本文提出了GIFF模块, 为个体动作与群体行为类别的推理提供了信息丰富的融合特征.

● 本文对损失函数进行优化, 采用动态分配权重的策略, 解决了数据集中潜在的样本失衡问题.

● 实验表明, 本文在两个大型的群体行为数据集——Volleyball[3]与Collective Activity[16]上, 取得了出色的群体行为识别准确度.

1 相关工作群体行为分析与识别是计算机视觉和人工智能领域中的重要研究方向之一, 其目标是通过对视频数据的准确分析, 捕捉群体中个体之间的互动和协同行为. Choi等人[16]提出群体行为识别的概念, 随后研究者们展开一系列研究.

1.1 基于传统深度学习的群体行为识别方法早期研究者们使用传统方法和特征工程实现群体行为识别. 该类方法根据视频帧中人员的运动轨迹, 结合目标检测和目标跟踪等技术, 分析运动者的空间位置信息以确定动作的类别. 然而, 由于人物外观信息以及场景信息的重要性, 仅使用空间位置信息难以实现高精度的识别结果. 为解决这一问题, 研究者们引入一些手工设计的特征描述子, 如早期广受关注的方向梯度直方图(HOG)特征描述子. 这些特征描述子能够提取人物的空间信息、运动信息、场景上下文等, 以更加准确地判断人物动作.

随着深度学习的兴起, 其在群体行为识别领域内取得了巨大成功. Ibrahim等人[3]提出一个层次化的时序深度学习模型, 利用长短时记忆网络(LSTM)在长时间段内建模人物的动态信息, 并结合卷积网络提取场景的全局特征, 实现对群体行为的分类. 此外, 作者提出了Volleyball数据集, 作为一个用于群体行为识别方向的大型数据集, 为该领域的后续研究做出了巨大贡献. 意识到人与人之间互动关系在群体行为识别中的重要性后, Wu等人[10]提出构建关系图的方法, 基于图的数据结构, 有效地在视频帧中的人员之间搭建起了联系. Yuan等人[11]在此基础上, 提出时空双线性池化的方法, 进一步探索关系图的结构. 同年, Yuan等人[8]又结合人物的时空交互关系, 通过构建关系域, 动态地探索人物之间的联系. 为解决数据集标签错误的问题, Demirel等人[12]尝试重新标注Volleyball数据集中错误的样本, 并通过注意力池化有效提升了群体行为识别的准确度. 此外, 为解决数据集标签缺失的问题, 半监督与无监督学习的方法[17–19]也逐渐应用于群体行为识别领域中, 并取得了显著成果. 与上述方法不同的是, 本文致力于将场景特征与个体特征进行融合, 并利用融合后的增强特征进行动作推理, 以探求更好的分类效果.

1.2 基于Transformer的群体行为识别方法2017年, Vaswani等人[20]首次提出注意力机制的概念与Transformer模型. 这一机制模拟人类视觉系统的工作方式, 针对不同的输入部分分配不同的注意力权重, 实现对重要信息的聚焦. 受注意力机制思想的启发, 后续研究者们进行创新, 诞生了一系列性能优秀的算法, 如SENet[21]等.

最初, 注意力机制应用于语义分割的领域. 为解决图像识别问题, Dosovitskiy等人[22]提出Vision Transformer (ViT)模型. ViT首先将整个图像分割成16个较小的patch, 然后对每个patch进行线性映射与位置编码, 以获取ViT编码器的输入. ViT编码器与原始的Transformer相同, 使用了多头自注意力(MSA)机制, 以便聚焦图像中的重要信息, 并通过MLP层获取分类结果. 整个模型可包含多层, 根据训练效率和分类结果确定最终的层数. Liu等人[23]提出Swin Transformer, 利用SW-MSA机制偏移图片像素并窗口化输入特征, 在降低计算量的同时, 实现更高的识别准确度, 成为Transformer中的经典模型之一. 为了将更加轻量化的ViT模型应用于计算机视觉领域, Mehta等人[24,25]提出MoblieViT模型, Vasu等人[26]提出FastViT模型, 在保持原有识别效率的基础上, 减少了资源消耗. 在群体行为识别领域中, 结合Transformer等注意力机制模型, 可对提取的人物特征进行细化. Han等人[27]提出一个基于时空双路径Transformer的群体行为分类模型, 通过组合时-空与空-时两个不同顺序的网络, 多角度地分析人物动作特征. Li等人[28]将Transformer与聚类结合, 提出用于群体行为识别的模型GroupFormer. Tamura等人[29]针对社会群体行为活动, 利用Transformer模型细分子类群体行为活动, 探索子类群体之间的关系线索. 然而, 这些方法未能提前融合人物细节与场景特征, 导致在预测群体行为时缺失场景信息. 为了解决这一问题并捕捉人物所在场景中的重要信息, 本文提出了GIFF模块, 将场景信息嵌入人物特征中, 为群体行为推理提供了良好的条件. GIFF模块借鉴了Transformer模型的结构, 能够有效增强特征的表征能力.

2 方法在本节中, 首先对模块的整体框架做出概述, 然后针对框架中的子模块进行详细介绍. 相对于现有方法, GIFFNet不仅能够细致捕获人物互动关系, 还强调了结合场景上下文信息的重要性. 接着, 对框架内部具体模块展开阐述, 包括全局-个体特征融合(GIFF)模块、融合时机的评估以及损失函数的优化等.

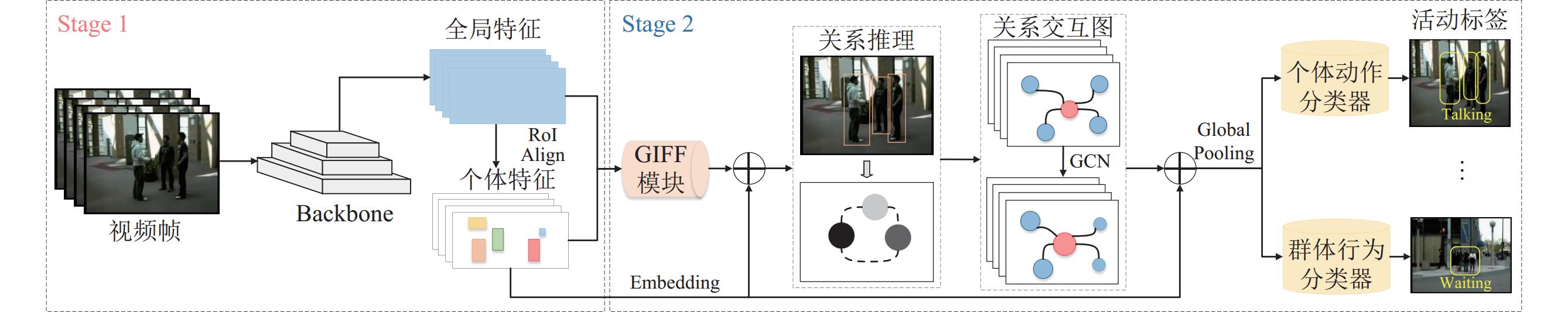

2.1 网络概述本文提出的网络分为两个主要阶段. 在第1阶段中, 首先, 选取数据集中的图像, 利用骨干网络提取图像原始特征, 即包含了场景信息的全局特征. 接着, 结合人物在场景中的位置, 使用RoI Align对全局特征进行感兴趣区域映射, 得到包含人物外观细节的个体特征. 全局特征与个体特征是第1阶段的输出, 为特征融合与群体行为预测的基础. 而第2阶段主要负责特征融合与群体行为的预测. 为实现个体特征与全局特征的融合, GIFFNet构建了GIFF模块, 将场景信息嵌入个体特征中, 获取能够同时表达场景信息与人物细节的融合特征, 解决了场景信息缺失与人物遮挡等问题, 为识别群体行为提供了良好的条件. 在确定特征的融合时机并进行特征融合后, 计算人物之间的联系以构建关系交互图. 最终, 利用图卷积网络对关系交互图进行训练, 并使用分类器预测群体行为的标签, 计算群体行为的识别准确度与训练损失. 本文采用全监督的方法, 模型整体框架如图2所示, 两个阶段的具体流程如下.

|

图 2 GIFFNet整体框架 |

Stage 1: 将原始的视频裁剪成帧, 以RGB模态的图像为输入, 利用骨干网络分别提取图像的全局特征

Stage 2: 将Stage 1中得到的全局特征Xg和个体特征Xi送入Stage 2中的网络进一步训练, 实现个体人物动作的识别, 并据此进一步推理群体行为类别. 首先, 通过GIFF模块将特征Xg与Xi融合, 将Xg中包含的场景上下文信息融入Xi中, 输出增强后的个体特征

| Gi,j=h(fa(xai,xaj),fs(xsi,xsj)) | (1) |

其中, Gi,j为人物i与j之间的关系交互图,

| Xl+1=σ(GXlWl)+Xl | (2) |

其中,

接着, 将GCN训练得到的输出特征与原始的个体特征相加, 经过全局平均池化层, 并通过个体动作分类器与群体行为分类器, 以获取最终的个体动作标签与群体行为标签. 群体行为标签的预测准确度是本文评判模型的重要指标. 另外, 为解决数据集样本失衡的问题, 本文在标准交叉熵损失的基础上采用动态分配权重的策略进行改进.

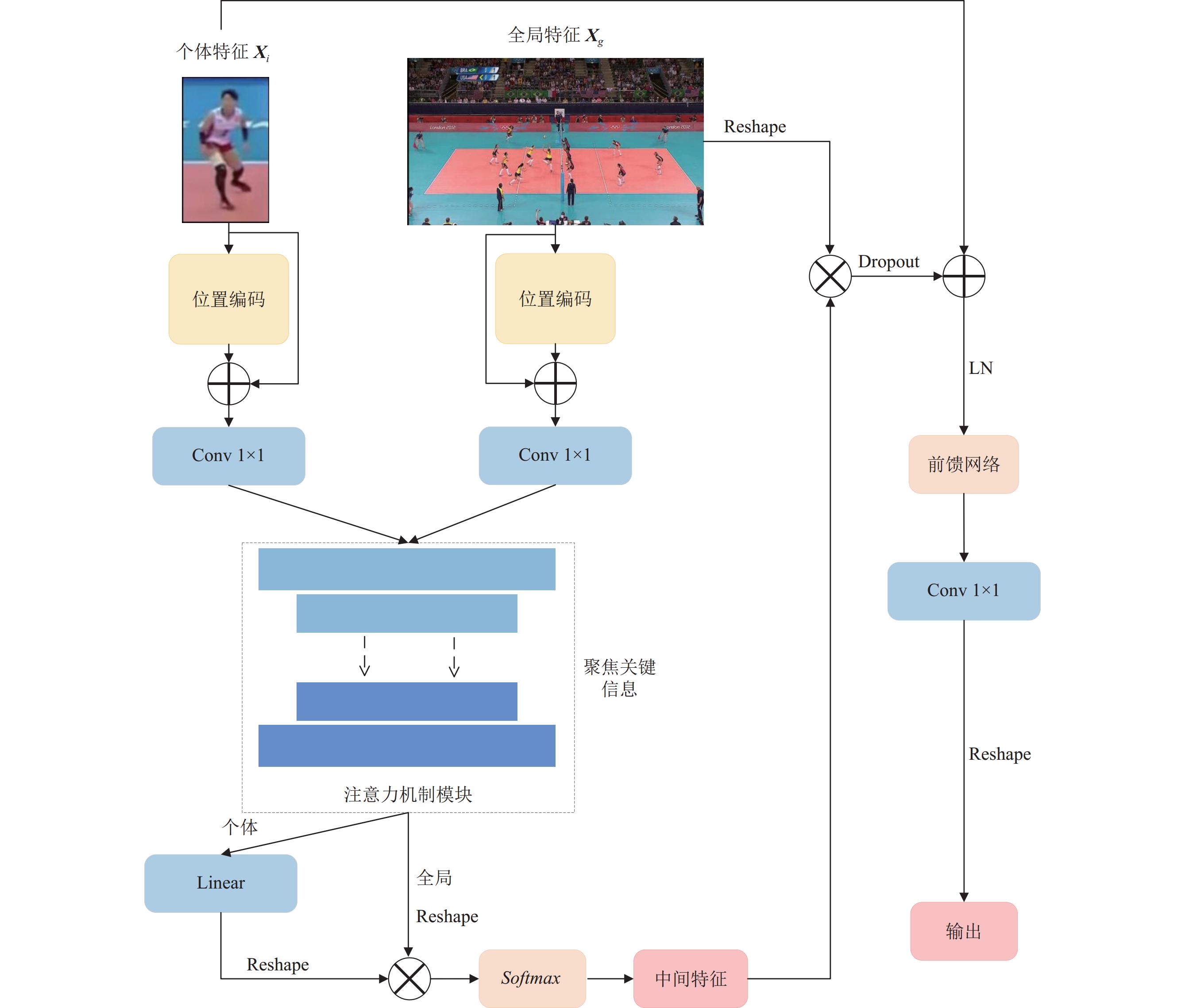

2.2 全局-个体特征融合(GIFF)模块GIFF整体框架如图3所示.

|

图 3 GIFF模块整体框架 |

在传统的群体行为识别算法中, 通常直接对个体特征进行学习训练, 随后进行群体行为的预测. 然而, 这样的做法仅利用了人物的细节信息, 忽略了人物与场景信息之间的重要关联. 例如, 在排球运动中, 球的位置与运动轨迹常常影响运动员的行为执行策略. 如果仅利用运动员的姿态、外观等细节信息, 而忽略场景中球与运动员的联系, 难以进一步判断人物的行为类别. 此外, 如果人物被场景中的物体或其他人物遮挡, 则会导致预测群体行为时缺失某些重要的人物细节信息. 为弥补这些缺陷, 本文提出GIFF模块, 用于融合个体特征与全局特征, 将场景上下文信息嵌入个体特征中, 以增强特征的表达能力.

GIFF模块的输入包括两部分: 第1阶段输出的个体特征

算法 1. GIFF模块

输入: 全局特征Xg, 个体特征Xi.

输出: 融合特征Xfused.

1. 将Xi与Xg输入GIFF模块;

2. 位置编码与下采样: 利用式(3)对Xi与Xg进行位置编码与下采样处理, 得到

3. 注意力机制模块: 利用式(4)对

4.

5. 调整

6. 乘积融合与归一化: 利用式(6)对

7. 乘积融合与残差计算: 利用式(7)将Xtmp与

8. 正则化与前馈网络: 利用式(8)对

9. 利用式(9)调整

10. 输出Xfused;

首先, 为了更好地理解图像中不同区域的重要性, GIFF模块利用位置编码(position encoding, PE)处理Xi与Xg, 为其添加位置信息. 此外, 为了减少参数量, GIFF模块采用了bottleneck结构, 通过使用1×1卷积核的pointwise卷积层来统一规划两种特征的通道数.

| X′=Conv1×1(PE(X)+X) | (3) |

其中, PE与Conv1×1分别代表位置编码和pointwise卷积层. X表示个体特征Xi和全局特征Xg, Xi与Xg经过式(3)运算后输出

为进一步提炼两种特征的关键信息, GIFF模块添加了通道注意力机制, 细化了

| ˆX′=ChannelAtt(X′)=wb×c×1×1×X′ | (4) |

其中, w是注意力模块中训练所得的权重矩阵, 与特征

接着,

| ˆX′i_emb=Linear(ˆX′i) | (5) |

| Xtmp=Softmax(ˆX′g׈X′i_emb) | (6) |

其中, Linear与Softmax分别表示线性嵌入层与Softmax层.

GIFF模块将Xtmp与

| ˆX″i=Xtmp׈X′g+ˆX′i_emb | (7) |

| ˆXfused=LN(FFN(LN(ˆX″i))) | (8) |

其中, LN和FFN分别代表层归一化和前馈网络,

如图2所示, GIFF模块的输出需与Xi再次进行残差相加. 为了便于这两个特征的运算, GIFF模块内使用了一个1×1大小卷积核的pointwise卷积层, 对Xfused的通道数进行还原, 并调整Xfused使其与Xi的形状保持一致.

| Xfused=Conv1×1(ˆXfused) | (9) |

其中,

总体而言, GIFF模块主要起到了以下两个作用.

首先, GIFF模块对全局特征与个体特征进行位置编码与网络层训练, 使其带有位置信息并提取有效的特征表示. 然后, 将这两类特征通过乘积融合与残差融合的方式进行结合. 乘积融合能够捕捉它们之间的细微关系, 而残差融合则保留了原始特征信息. 这一过程将全局特征中包含的场景信息融入个体特征, 使融合后的特征能够同时表达人物的细节信息与场景信息, 从而为群体行为识别提供了充分的条件.

其次, GIFF模块内的注意力机制模块动态地为两类特征分配权重, 能够聚焦于视频中的关键人物和数据集中的关键帧. 这一机制有效地防止了无关因素对后续群体行为识别流程的干扰, 提高了模型的识别准确性和鲁棒性. 另外, 考虑到运算复杂度大的问题, GIFF模块借鉴了bottleneck的结构, 有效地降低了参数量.

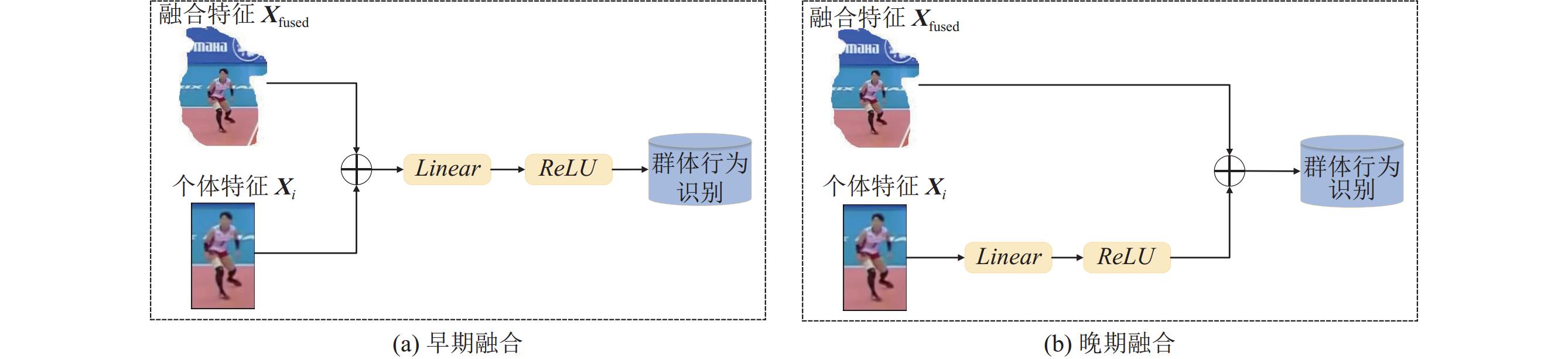

2.3 融合方式GIFF模块成功地将场景信息嵌入个体特征中, 但为了更充分地保留个体特征中的人物细节信息, GIFF模块的输出Xfused需要与个体特征Xi再做一次残差计算. 针对这一过程, 本文提出了两种不同的融合方式, 根据融合时机的差异, 分为早期融合和晚期融合, 如图4所示.

|

图 4 两种特征融合方式 |

图4(a)展现了早期融合策略, GIFF模块输出Xfused后直接与Xi进行相加融合, 然后经过线性嵌入层提炼特征信息, 并利用ReLU激活函数进行非线性变换, 得到最终的融合特征Ffused. 早期融合策略简化了融合步骤, 能够快速融合特征并进行后续处理, 但可能会导致部分原始特征信息在融合过程中被忽略. 图4(b)展现了晚期融合策略, Xi首先单独经过线性嵌入层与ReLU激活函数处理, 随后再与Xfused相加融合, 获取最终的融合特征Ffused. 晚期融合策略保留了Xi中更多的原始特征信息, 通过优先对Xi进行处理, 可以更充分地提取目标人物的细节信息, 使融合后的特征更具表征能力. 尽管该策略的融合步骤相对复杂, 但能够有效提升特征的表示能力. 通过对这两种策略的分析与比较, 可以发现早期融合策略适用于需要快速处理和融合特征的场景, 而晚期融合策略则更适用于需要保留更多原始人物特征信息并进行深入特征提取的场景. 式(10)和式(11)展现了早期融合与晚期融合的计算过程.

| Fefused=ReLU(LN(Linear(Xfused+Xi))) | (10) |

| Flfused=ReLU(LN(Linear(Xi)))+Xfused | (11) |

其中,

现有群体行为识别方法通常使用标准交叉熵损失来确定预测动作与真实动作之间的差距, 但并未解决样本分类不平衡的问题. 当数据集中某类样本量远超其他样本或数据集样本量较小时, 将会导致模型倾向于预测占比量更多的类别, 从而影响模型的性能. 例如在Collective Activity数据集中, 样本数据量仅有约1G大小, 其较小的样本量会导致分类样本的失衡. 通过调整损失函数, 可以提升模型对少数类别的预测性能, 在一定程度上缓解样本失衡问题. 为解决该问题, 本文在标准交叉熵损失的基础上, 采取动态分配权重的策略, 针对损失函数做出了一定的改进, 对最终的行为分类起到了较好的促进效果. 具体介绍如下.

| loss=α(1−pt)γL(ya,¯ya) | (12) |

| pt=exp(L(ya,¯ya)) | (13) |

其中, L代表交叉熵损失函数, ya和

为应对群体行为识别领域中的多种挑战, 研究者们开发并广泛应用两个经典数据集, 分别为Volleyball数据集和Collective Activity数据集.

Volleyball数据集是一个用于群体行为识别和分析的数据集, 专注于排球比赛中的群体动作设计. 该数据集旨在帮助研究人员开发算法来识别和分析排球比赛中的不同群体行为, 如发球、传球、扣球、拦网等. 其在55场大型排球赛事中进行动作的采集, 包括了

Collective Activity数据集涵盖44个视频片段, 每个视频片段约有200–1800个视频帧. 该数据集采用监控摄像头进行视频采集, 旨在捕捉多个行动者在不同场景中的集体活动. 根据场景中行动者的动作差异, 设置了5个群体行为标签: crossing、waiting、queueing、walking、talking和6个个体行为标签: NA、crossing、waiting、queueing、walking、talking.

3.2 实验细节本文在一张NVIDIA A800 (80 GB)的显卡上对两个数据集进行实验, 整个模型使用PyTorch框架实现. 为了减少消耗并提高代码运行性能, 实验中使用了预训练的模型结果, 据此进行进一步的模型拟合与推理判断. 在两个群体数据集上, 本文设置约70%的数据为训练集, 30%的数据为测试集. 在Volleyball数据集中, 输入图像的大小为(720, 1024), 选取的骨干网络为VGG-16, 共设置了60轮的训练与测试, 初始学习率lr设为1×10−4, 每10轮缩减1/2, 并在第40轮固定为1×10−5; 在Collective Activity数据集中, 输入图像的大小为(480, 720), 选取的骨干网络为 Inception-v3, 共设置了30轮的训练与测试, 学习率lr固定为5×10−5. 另外, 在两个数据集上训练与测试时, dropout ratio设为0.3, 权重衰退设为1×10−4, 损失函数计算中α和γ的值分别为0.25和0.2. 衡量准确度的两个指标分别为多类分类准确度(multi-class classification accuracy, MCA)和类平均精确度(mean per class accuracy, MPCA).

3.3 对比实验表1展示了GIFFNet与其他流行算法在Volleyball数据集上群体行为的识别准确度对比结果. 在该数据集的实验中, GIFFNet选用的骨干网络为VGG-16. 结果显示GIFFNet的MCA值与MPCA值分别高达93.8%与93.9%, 个体动作的准确率也达到83.6%, 优于多个经典的群体行为识别算法, 甚至在准确度上超越近年来提出的高精度识别模型.

| 表 1 本文方法与其他流行方法在Volleyball数据集上的识别率对比 (%) |

表2展示了GIFFNet与其他流行算法在Collective Activity数据集上群体行为的识别准确度对比结果. 在该数据集的实验中, GIFFNet选用的骨干网络为Inception-v3. 比较来看, GIFFNet在样本数量较少的数据集上同样取得出色的识别效果, 模型精度优于近年提出的流行算法, 其MCA和MPCA值分别高达96.1%与95.8%.

| 表 2 本文方法与其他流行方法在Collective Activity数据集上的识别率对比 (%) |

从两个测试数据集上的实验结果来看, GIFFNet通常比基于RNN的算法具有更优秀的性能, 同时相对开销更小. 相较于基于GNN与CNN的方法, GIFFNet也取得精度上的优势. 在样本量较小的Collective Activity数据集上, GIFFNet实现更高的识别准确度, 优于其他的流行算法.

3.4 消融实验为验证特征融合模块和损失函数对整体网络的有效性与兼容性, 本文针对这两个方面实施详尽的消融实验. 表3与表4分别是在两个群体行为数据集上展开的消融实验数据, 结果表明本文提出的融合模块与改进的损失函数均对识别结果有显著提升.

| 表 3 针对融合模块和损失函数在Volleyball数据集上的消融数据 (%) |

| 表 4 针对融合模块和损失函数在Collective Activity数据集上的消融数据 (%) |

本文基础模型使用的损失函数为标准交叉熵损失, 根据Volleyball数据集上的消融实验结果, 其准确率约为93.2%. 在基础模型的基础上, 单独添加GIFF模块后, 能够将全局场景信息嵌入个体特征中并加以预测, 其准确度分别提升至93.6%. 其原因是通过融合全局场景信息后, 能够有效弥补信息缺失的问题, 以提高模型的识别准确度. 另外, 在标准交叉熵损失函数的基础上, 单独改进损失函数后, 一定程度上解决了样本失衡的问题, 使识别准确度提升至93.4%. 将损失函数改进并添加GIFF模块后, 模型的识别准确率进一步提高, 高达93.8%. 这表明GIFFNet在Volleyball数据集上取得了较好的性能提升效果. 在Collective Activity数据集的消融实验中, 基础模型的准确率约为95.3%, 其损失函数同样为标准交叉熵损失. 随后, 单独添加GIFF模块后, 准确率提升至95.7%. 仅对损失函数进行改进的情况下, 准确率达到95.8%. 最后, 同时添加GIFF模块并对损失函数进行改进时, 识别准确率显著提高至96.1%. GIFFNet在Collective Activity数据集上取得了显著的性能提升, 证明了以融合场景信息的个体特征为识别模型的输入能够提高整体网络的鲁棒性.

为验证GIFF模块的最佳适用性, 本文在两个数据集上展开消融实验. 根据融合时机的差异, 对GIFF模块的输出与个体特征进行外部融合, 实验结果如表5与表6所示. 在早期融合中, GIFF模块的输出特征Xfused直接与原个体特征Xi相加, 再经过嵌入层以得到最终的融合特征, 这可能会导致Xi与Xfused中部分特征的信息丢失与混合. 而在晚期融合中, 在个体特征Xi获取嵌入信息后, 再与GIFF模块的输出特征Xfused相加获取融合特征, 能够使模型更充分地利用输入特征Xi中的信息, 与Xfused进行更有效的融合, 使得最终的融合特征能够更好地表示人物之间的关系. 实验结果显示, 结合晚期融合的模型识别准确率更高, 在Volleyball数据集上, 早期融合和晚期融合的准确率分别为93.2%和93.8%; 而在Collective Activity数据集上, 准确率分别为95.8%和96.1%. 由于晚期融合能够更充分地利用输入特征的信息, 减少信息丢失, 因此相较于早期融合, 其效果更佳.

| 表 5 针对融合时机在Volleyball数据集上的消融数据 (%) |

| 表 6 针对融合时机在Collective Activity数据集上的消融数据 (%) |

对图像进行位置编码能够更好地理解图像特征上的位置信息. 为验证图像编码在本文模型中的有效性, 本文在Volleyball数据集上展开消融实验, 实验结果如表7所示. 实验结果显示, 在GIFF模块中不包含位置编码的情况下, 准确率仅有93.2%; 当对GIFF模块中的全局特征进行位置编码后, 准确率提升至93.5%; 最后, 对GIFF模块中的两类特征都进行位置编码, 准确率进一步提升至93.8%. 这表明位置编码对模型理解图像特征起到积极的促进作用.

| 表 7 针对位置编码在Volleyball数据集上的消融数据 (%) |

3.5 可视化

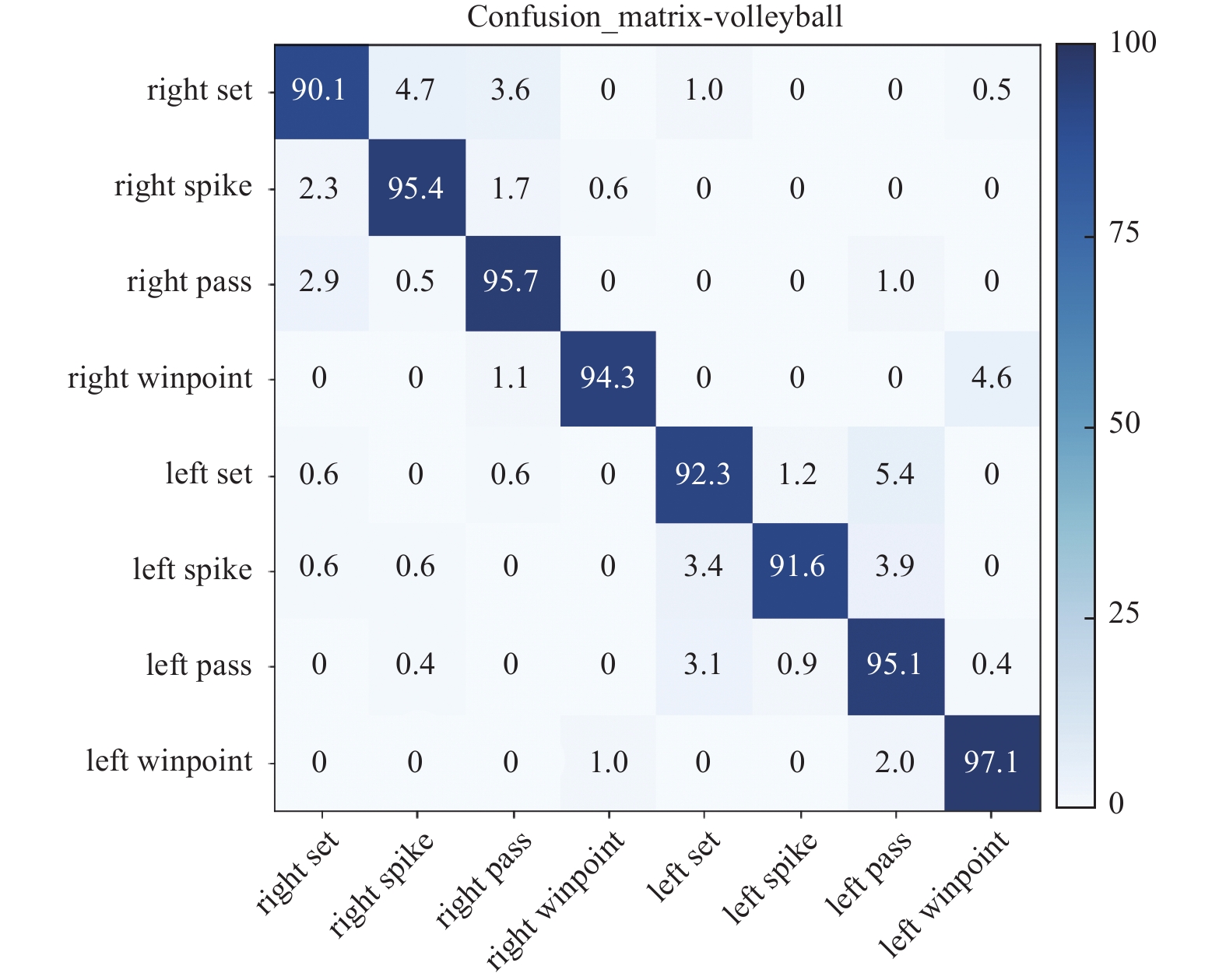

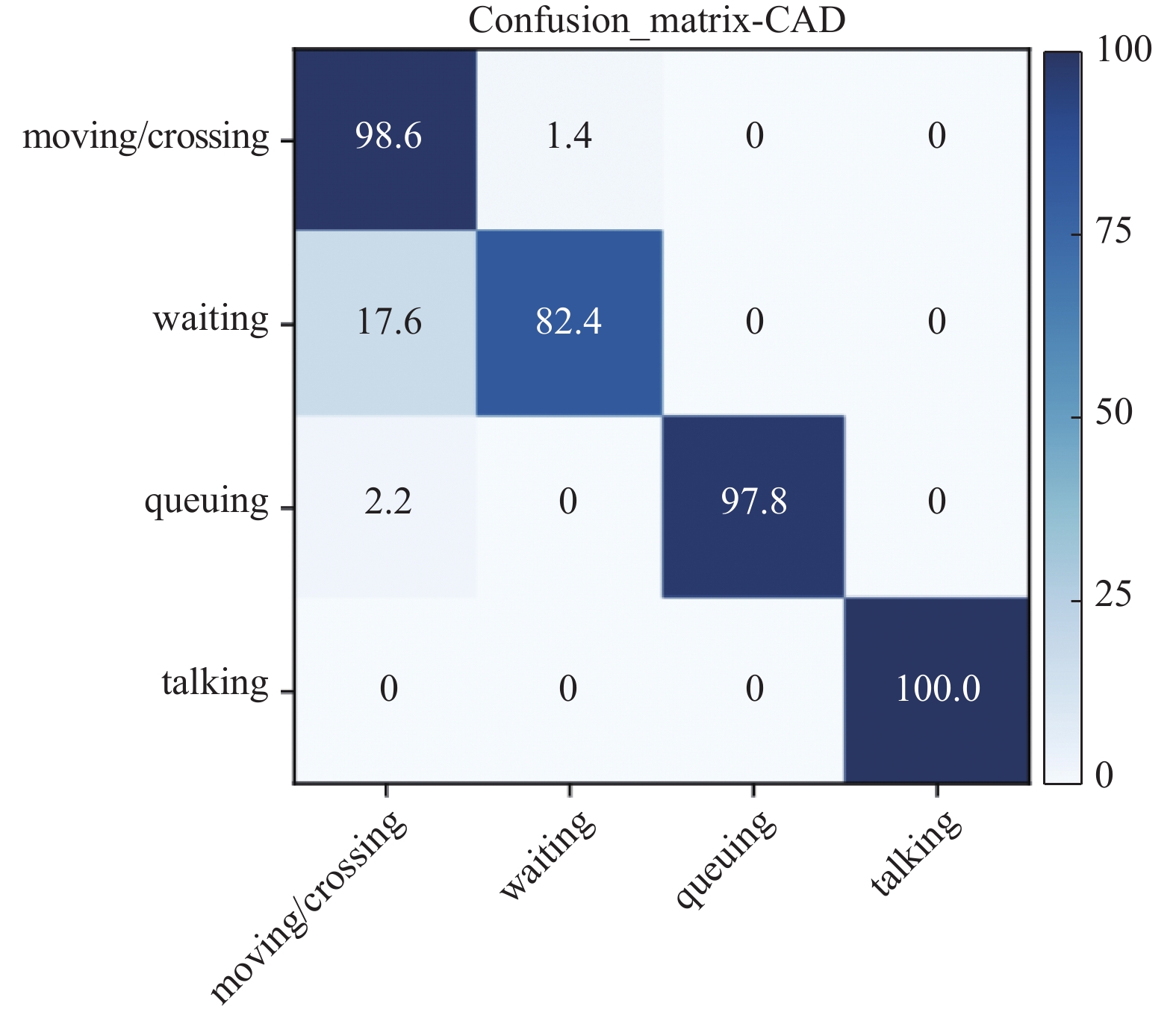

图5和图6展示了GIFFNet在两个数据集上混淆矩阵的可视化结果, 均取得了出色的识别准确率. 对于Volleyball数据集中的每个动作, GIFFNet的识别准确率都超过90%. 在Collective Activity数据集的动作识别中, 为了简化模型的输出的复杂度, 将行为较为相近的moving和crossing标签映射为一个类别moving/crossing, 使群体活动的类别从5个简化为4个. 结果显示moving/crossing和waiting两类行为的识别存在一定误差, 这是由于在某些场景下, 两者的动作形态较为相似, 同时数据集样本较少也会对最终的分类结果产生一定的影响.

|

图 5 GIFFNet在Volleyball数据集上的混淆矩阵 |

|

图 6 GIFFNet在Collective Activity数据集上的混淆矩阵 |

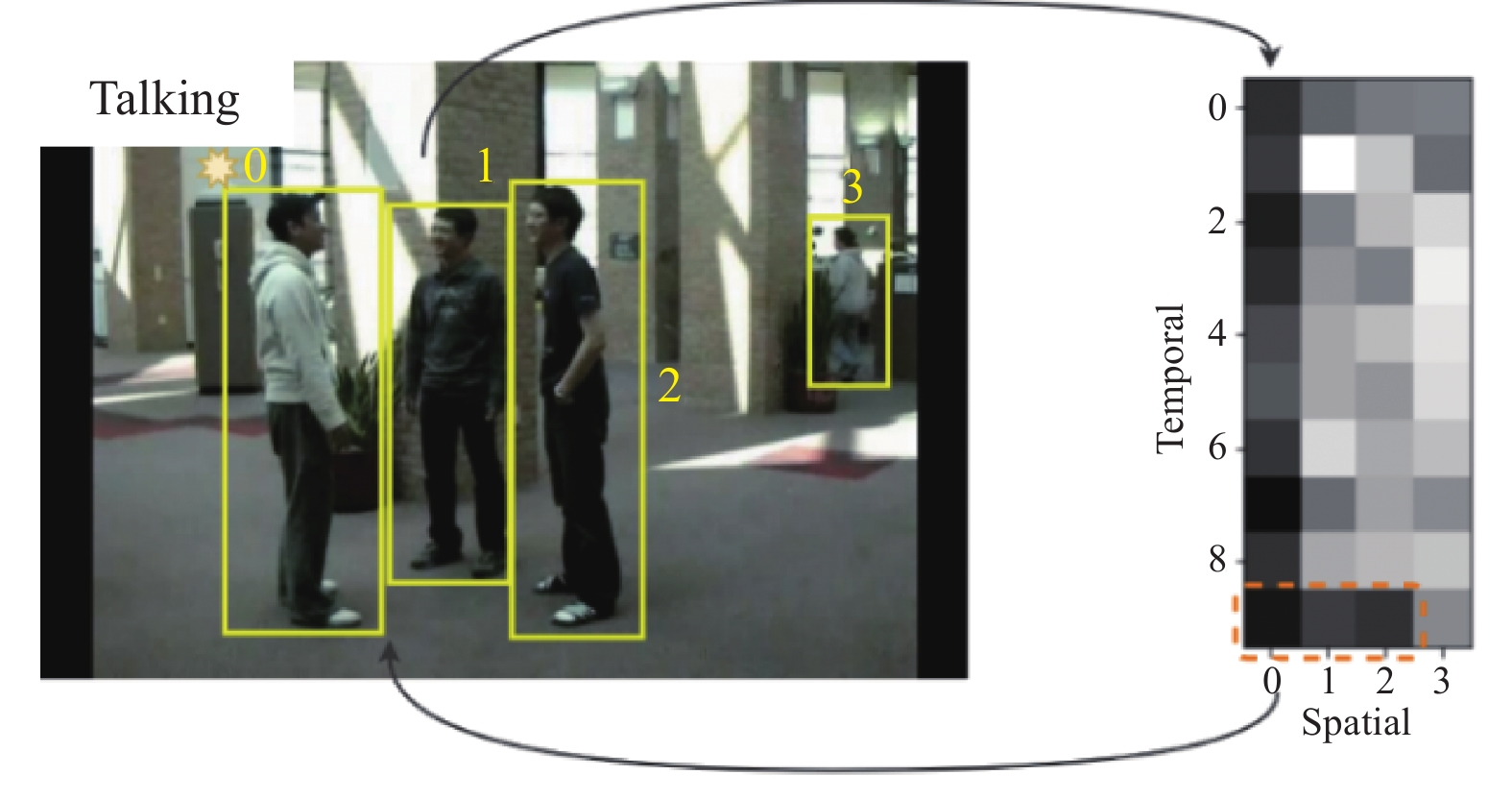

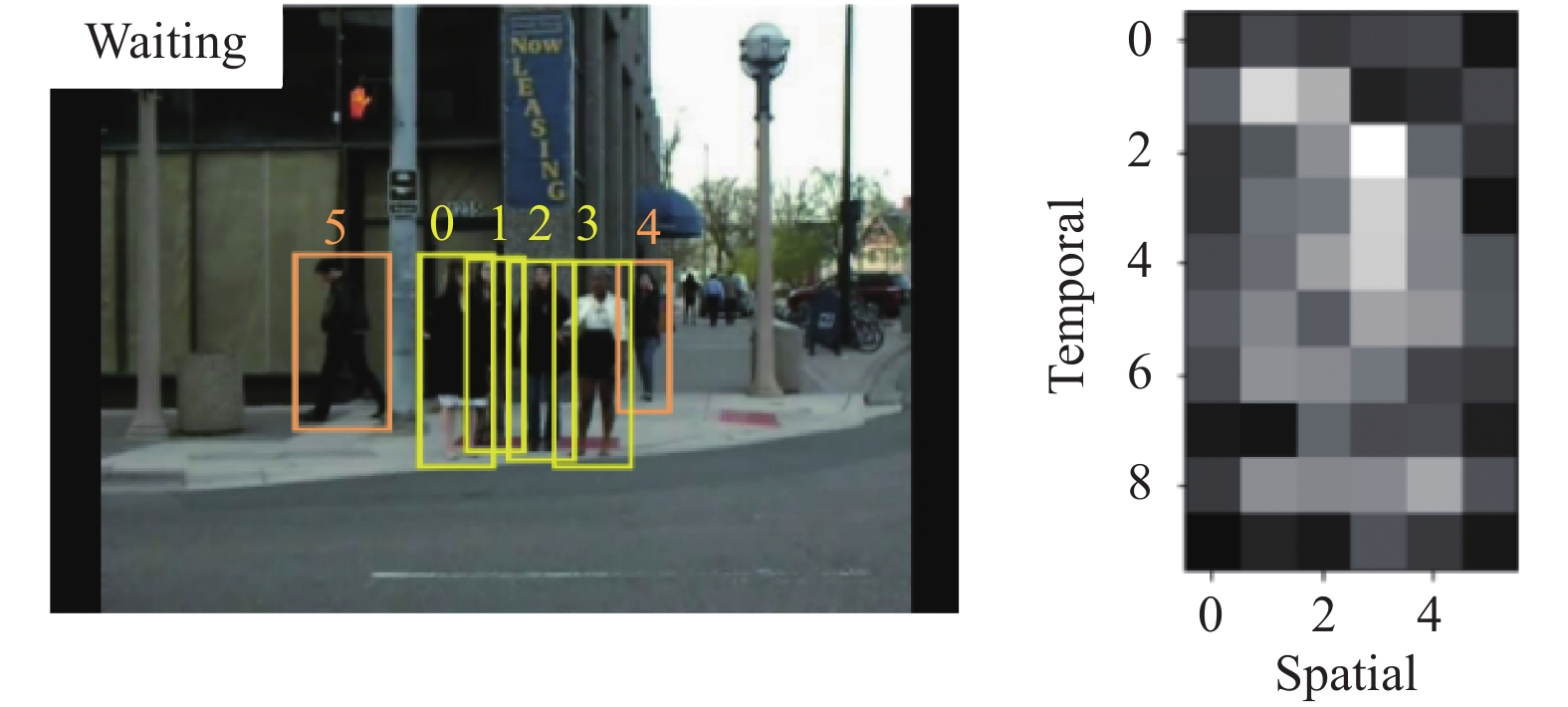

图7展示了群体行为talking的可视化结果, 左图检测框中标注了目标人物, 右图展示了标注人物在时空层面上的动作权重, 颜色越深代表权重越大. 其中人物0在10个时间段内具有最大的平均权重, 是群体活动中的关键人物; 人物3是群体行为中的边缘人物, 具有最小的权重. 此外, 人物0, 1, 2具有明显的协作行为, 右图框出的权重颜色较深, 证明了他们在空间层面上的合作关系更为紧密. 在判别群体行为的过程中, 可能会出现目标群体包括多个行为类型的情况. 图8展示了群体行为waiting的可视化结果, 如左图所示, 标注的人物包括waiting与walking两种行为. 为了确定最终的群体行为类别, 分类器会根据各类行为的权重值大小, 选定权重最大的行为作为判别结果. 图8所示的示例经过分类器的选择, 判定为waiting的行为类别.

|

图 7 Collective Activity数据集中行为talking的可视化示例 |

|

图 8 Collective Activity数据集中waiting的可视化示例 |

4 结论与展望

针对群体行为识别时场景信息缺失的问题, 本文提出一种基于全局-个体特征融合的群体行为识别方法GIFFNet. 总体来说, GIFFNet分为两个阶段, 其一为特征提取阶段, 其二为特征融合与行为推理阶段. GIFFNet中的全局-个体特征融合(GIFF)模块, 能够有效地提取全局特征中的场景信息, 并与个体特征进行融合, 达到增强特征表达能力的目的. 另外, GIFF模块通过注意力机制以聚焦场景中的关键人物与数据集中的关键帧, 为群体行为的识别提供良好的准备条件. 为确定融合时机的适配性, 本文研究了早期融合与晚期融合策略, 以总结出最佳的融合方式. 此外, 本文在标准交叉熵损失的基础上, 以动态分配权重的思想对损失函数做出了优化, 一定程度上解决了数据集样本失衡的问题. GIFFNet在两个基线数据集Volleyball与Collective Activity上实现了高精度的群体活动识别, 其中多类分类准确度分别为93.8%、96.1%, 类平均精确度分别为93.9%、95.8%. 同时, GIFF模块借鉴bottleneck模型的思想降低了计算复杂度, 但参数量依然较大. 在未来的研究中, 拟考虑实现更加轻量化的群体行为识别网络模型.

| [1] |

吴建超, 王利民, 武港山. 视频群体行为识别综述. 软件学报, 2023, 34(2): 964–984. [doi: 10.13328/j.cnki.jos.006693]

|

| [2] |

Wu LF, Wang Q, Jian M, et al. A comprehensive review of group activity recognition in videos. International Journal of Automation and Computing, 2021, 18(3): 334-350. DOI:10.1007/s11633-020-1258-8 |

| [3] |

Ibrahim MS, Muralidharan S, Deng ZW, et al. A hierarchical deep temporal model for group activity recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 1971–1980.

|

| [4] |

Tang JH, Shu XB, Yan R, et al. Coherence constrained graph LSTM for group activity recognition. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 44(2): 636-647. DOI:10.1109/TPAMI.2019.2928540 |

| [5] |

Shu XB, Zhang LY, Sun YL, et al. Host-parasite: Graph LSTM-in-LSTM for group activity recognition. IEEE Transactions on Neural Networks and Learning Systems, 2021, 32(2): 663-674. DOI:10.1109/TNNLS.2020.2978942 |

| [6] |

Qi MS, Qin J, Li AN, et al. StagNet: An attentive semantic RNN for group activity recognition. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 104–120.

|

| [7] |

Shi L, Zhang YF, Cheng J, et al. Two-stream adaptive graph convolutional networks for skeleton-based action recognition. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 12018–12027.

|

| [8] |

Yuan HJ, Ni D, Wang M. Spatio-temporal dynamic inference network for group activity recognition. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 7456–7465.

|

| [9] |

Azar SM, Atigh MG, Nickabadi A, et al. Convolutional relational machine for group activity recognition. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 7884–7893.

|

| [10] |

Wu JC, Wang LM, Wang L, et al. Learning actor relation graphs for group activity recognition. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 9956–9966.

|

| [11] |

Yuan HJ, Ni D. Learning visual context for group activity recognition. Proceedings of the 35th AAAI Conference on Artificial Intelligence. AAAI, 2021. 3261–3269.

|

| [12] |

Demirel B, Ozkan H. DECOMPL: Decompositional learning with attention pooling for group activity recognition from a single volleyball image. arXiv:2303.06439, 2023.

|

| [13] |

Gavrilyuk K, Sanford R, Javan M, et al. Actor-Transformers for group activity recognition. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 836–845.

|

| [14] |

Pramono RRA, Chen YT, Fang WH. Empowering relational network by self-attention augmented conditional random fields for group activity recognition. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 71–90.

|

| [15] |

Cheng Y, Wang W, Ren ZP, et al. Multi-scale feature fusion and Transformer network for urban green space segmentation from high-resolution remote sensing images. International Journal of Applied Earth Observation and Geoinformation, 2023, 124: 103514. DOI:10.1016/j.jag.2023.103514 |

| [16] |

Choi W, Shahid K, Savarese S. What are they doing? Collective activity classification using spatio-temporal relationship among people. Proceedings of the 12th IEEE International Conference on Computer Vision Workshops. Kyoto: IEEE, 2009. 1282–1289.

|

| [17] |

Chappa NVS, Nguyen P, Nelson AH, et al. SPARTAN: Self-supervised spatiotemporal Transformers approach to group activity recognition. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Vancouver: IEEE, 2023. 5158–5168.

|

| [18] |

Yan R, Xie LX, Tang JH, et al. Social adaptive module for weakly-supervised group activity recognition. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 208–224.

|

| [19] |

Kim D, Lee J, Cho M, et al. Detector-free weakly supervised group activity recognition. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022. 20051–20061.

|

| [20] |

Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need. Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach: Curran Associates Inc., 2017. 6000–6010.

|

| [21] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7132–7141.

|

| [22] |

Dosovitskiy A, Beyer L, Kolesnikov A, et al. An image is worth 16x16 words: Transformers for image recognition at scale. Proceedings of the 9th International Conference on Learning Representations. OpenReview.net, 2021.

|

| [23] |

Liu Z, Lin YT, Cao Y, et al. Swin Transformer: Hierarchical vision Transformer using shifted windows. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 9992–10002.

|

| [24] |

Mehta S, Rastegari M. MobileViT: Light-weight, general-purpose, and mobile-friendly vision Transformer. Proceedings of the 10th International Conference on Learning Representations. OpenReview.net, 2022.

|

| [25] |

Mehta S, Rastegari M. Separable self-attention for mobile vision Transformers. arXiv:2206.02680, 2022.

|

| [26] |

Vasu PKA, Gabriel J, Zhu J, et al. FastViT: A fast hybrid vision Transformer using structural reparameterization. Proceedings of the 2023 IEEE/CVF International Conference on Computer Vision. Paris: IEEE, 2023. 5762–5772.

|

| [27] |

Han MF, Zhang DJ, Wang YL, et al. Dual-AI: Dual-path actor interaction learning for group activity recognition. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022. 2980–2989.

|

| [28] |

Li SC, Cao QG, Liu LB, et al. GroupFormer: Group activity recognition with clustered spatial-temporal Transformer. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 13648–13657.

|

| [29] |

Tamura M, Vishwakarma R, Vennelakanti R. Hunting group clues with Transformers for social group activity recognition. Proceedings of the 17th European Conference on Computer Vision. Tel Aviv: Springer, 2022. 19–35.

|

| [30] |

Bagautdinov T, Alahi A, Fleuret F, et al. Social scene understanding: End-to-end multi-person action localization and collective activity recognition. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 3425–3434.

|

| [31] |

Yan R, Tang JH, Shu XB, et al. Participation-contributed temporal dynamic model for group activity recognition. Proceedings of the 26th ACM International Conference on Multimedia. Seoul: ACM, 2018. 1292–1300.

|

| [32] |

Hu GY, Cui B, He Y, et al. Progressive relation learning for group activity recognition. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 977–986.

|

| [33] |

Wang DL, Liu J, Zhou Y. Group activity recognition based on temporal semantic sub-graph network. Proceedings of the 14th International Conference on Machine Learning and Computing. Guangzhou: ACM, 2022. 401–406.

|

| [34] |

Shu TM, Todorovic S, Zhu SC. CERN: Confidence-energy recurrent network for group activity recognition. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 4255–4263.

|

| [35] |

Yan R, Xie LX, Tang JH, et al. HiGCIN: Hierarchical graph-based cross inference network for group activity recognition. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2023, 45(6): 6955-6968. DOI:10.1109/TPAMI.2020.3034233 |

2024, Vol. 33

2024, Vol. 33