海洋是世界上最大的资源库, 占据着地球表面绝大部分的面积, 蕴含着丰富的资源, 如石油、天然气、海产品等[1]. 为满足人类社会的快速发展, 人们不断对海洋进行开发. 近10年来, 相关水下机器人和探测技术得到了快速的发展, 例如配备了智能水下目标检测系统的自主潜水器[2]和遥控潜水器, 在海洋资源的开发以及保护的过程中, 起到了至关重要的作用. 随着计算机视觉的发展, 目标检测开始愈发重要, 而水下目标检测分为声学系统检测和光学系统检测[3], 同声学图像相比, 光学图像具备更高的分辨率以及信息量, 并且在获取的方法上更加轻易[4]. 因此, 基于光学系统的水下目标检测更加受到人们关注. 目标检测是计算机视觉的一个核心的分支, 现有的目标检测的方法, 大致可以分为两大类: 传统的目标检测方法和基于深度学习的目标检测方法[5].

传统的目标检测方法通常分为3个阶段: 区域选择、特征提取和特征分类[6]. 首先通过滑动窗口选择感兴趣的区域[7]. 然后, 应用尺度不变特征变换(SIFT)[8]、定向梯度直方图(HOG)[9]等多种特征提取算法提取每个感兴趣区域的特征. 最后, 采用支持向量机(SVM)等机器学习算法[10]对提取的特征进行分类, 判断窗口是否包含对象. 然而, 由于传统方法需要设计各种大小的窗口, 并且依赖于机器学习方法进行分类, 因此存在一些局限性.

深度学习的出现改变了目标检测领域, 它的高速度和通用性使其广泛应用于许多领域, 不需要人工干预, 减少了人为因素造成的错误. 目前, 基于深度学习的目标检测算法主要分为两大类: 基于区域提议的算法和基于回归的算法. 前一类又称为两阶段目标检测算法, 这一类的代表性算法包括R-FCN (region-based fully convolutional networks)[11]和R-CNN (region-CNN)系列算法 (R-CNN[12], Fast R-CNN[13], Faster R-CNN[14], Mask-R-CNN[15], Cascade-R-CNN[16]等). Li等人[17]将Fast R-CNN应用于水下图像的识别和检测, 使用新的数据集共12种水下生物, 相较于R-CNN平均精度有所提高. Zeng等人[18]将对抗性遮挡网络(AOV)运用到Faster R-CNN当中, 开发了一种新的框架, 用于水下海产品的目标检测. 尽管基于区域的算法有较高的精度, 但它们往往速度较慢, 无法做到实时检测. 而后者基于回归的目标检测算法, 又称为一阶段目标检测算法, 可以从图像中直接预测目标的位置和类别, 而不需要进行额外的识别或提取区域的步骤, 突出了强大的实时处理的能力. 这一类的代表算法包括SSD(single shot multibox detector)[19], 和YOLO (you only look once)[20]算法家族. 强伟等人[21]将ResNet作为基础网络的SSD检测模型, 用于水下目标检测. Li等人[22]开发了一种基于YOLOv3的浮游生物的检测网络, 该网络采用了密集连接的结构, 便于特征传递. 黄廷辉等人[23]提出了一种基于F-CBAM注意力机制的YOLOv5水下目标检测FAttention-YOLOv5模型. Wang等人[24]利用加权ghost-CSPDarknet和简化的PANet, 提出了一种轻量化的水下目标检测网络LUO-YOLOX.

随着Transformer在计算机视觉领域的普及, Facebook的研究人员巧妙地利用Transformer架构提出了一个新的目标检测器DETR[25]. 它可以通过Transformer学习到全局特征, 将目标检测视为集合预测问题, 减少了很多人工先验知识, 不需要手工设计的组件, 如非极大值抑制(NMS)和锚框生成, 从而实现了端到端的目标检测. 然而, DETR存在训练周期长, 收敛速度慢等问题, 且对于小目标的检测能力仍有很大的进步空间.

针对上述问题, 为解决水下目标的检测精度低, 对小目标的检测性能较差, 且实时性较差的问题, 本文提出了FERT-DETR目标检测架构, 更加轻量化且能够有效地提升精准度. 该方法的主要改进如下.

(1)将RT-DETR中的骨干网络ResNet18替换为Faster Block, 降低了网络参数量, 且在其中使用高效多尺度(EMA)注意力, 提升骨干网络的提取效率.

(2)在AIFI中使用级联群体注意力模块(CGA), 解决了多头注意力机制中计算冗余的问题, 提高计算效率, 通过增加模型深度提升模型容量.

(3)将CCFM结构进行重写, 使用高水平筛选特征金字塔(HS-FPN)[26], 实现跨尺度连接, 多层次融合. 增强了模型的特征表达能力.

1 改进的RT-DETR算法DETR算法于2020年推出, 是一款基于Transformer架构的端到端的目标检测器, 与传统的基于CNN的目标检测方法不同的是, 消除了很多手工设计的组, 如锚框生成和非极大值抑制, 大大简化了目标检测的流程. 但是DETR也存在许多不足: 相较于其他模型参数量较大, 收敛速度慢. 为解决这些问题, 基于DETR的改进不断被提出, Deformable DETR[27]提出了多尺度可变形注意力方法, 加速模型的收敛速度和降低算法的复杂度, 同时也解决了小目标检测性能不足的问题; DAB-DETR[28]通过引入去噪思想来加快模型的收敛速度; 随后DINO[29]更加进一步完善这套框架, 使其精度有了更高的提升. 但就“实时性”而言, DETR系列依旧无法媲美YOLO系列. 2023年, 百度推出了实时性的目标检测器RT-DETR[30], 能够在保持高精度的同时提供实时性能, RT-DETR的骨干网络采用CNN架构, 如流行的ResNet或者百度的HGNet, 编码器组件采用高效的混合编码器, 通过内部尺度的相互解耦和跨尺度融合解决多尺度特征, 这种独特的结构降低了计算的成本, 解码器采用多层Transformer解码器, 可以在推理过程中灵活选择不同的解码器层数, 从而自适应的调整推理速度.

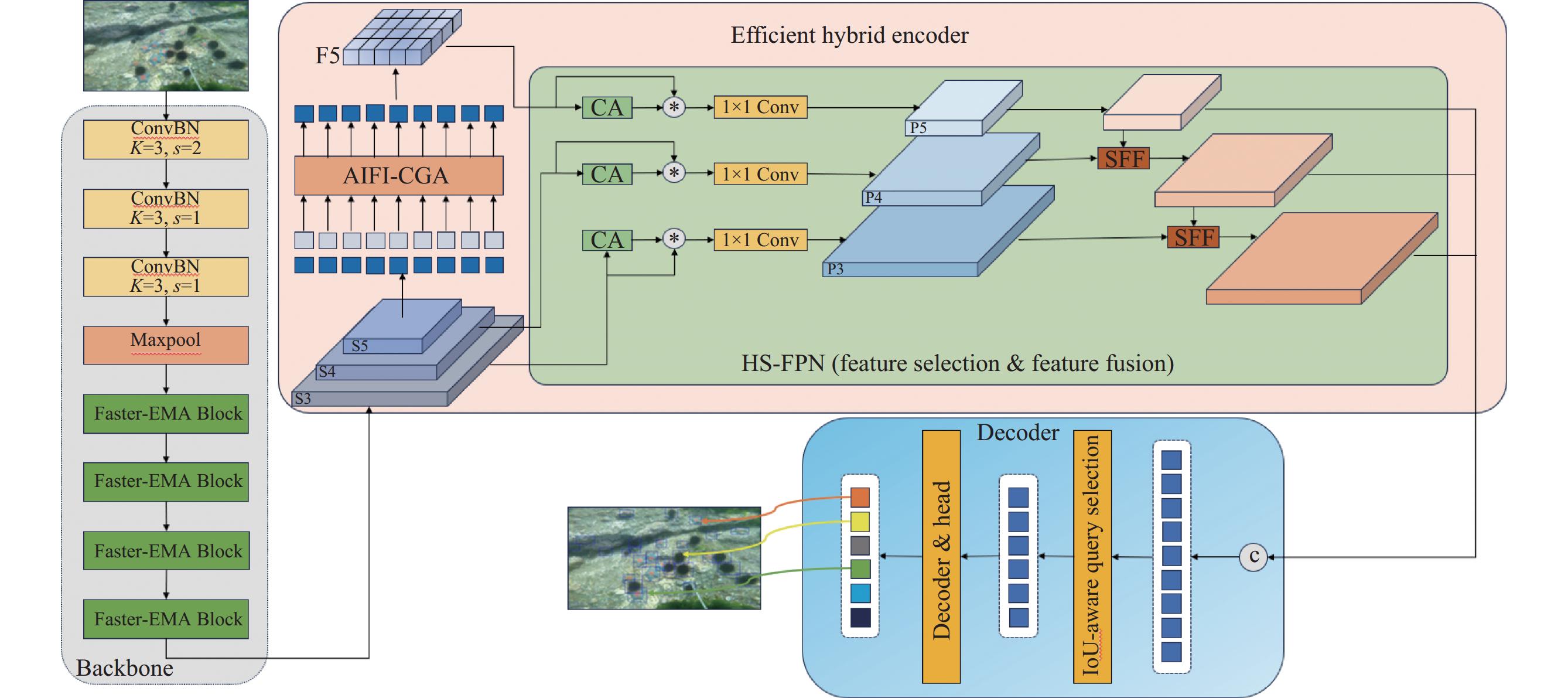

为了使RT-DETR更加适合水下任务, 解决海洋底栖息生物目标小而密集导致的探测精度低的问题, 以及进一步减少模型参数量和实时性问题. 本文提出了一种改进的FERT-DETR算法, 算法的流程图如图1所示. 检测模型的整体架构由一个骨干网络, 一个编码器, 一个解码器组成, 输入图像首先经过改进的FasterNet-EMA Block输出最后3层特征图; 之后来到编码器部分, 由于最后一层S5特征层的信息较多, AIFI-CGA会单独处理S5特征层, 处理后记为F5, 之后将S3、S4和F5交由高水平筛选特征金字塔HS-FPN进行跨尺度特征融合; 最后来到解码器部分, 通过查询选择将预测头映射到置信度和边界盒上, 得到最终的检测结果.

|

图 1 算法流程图 |

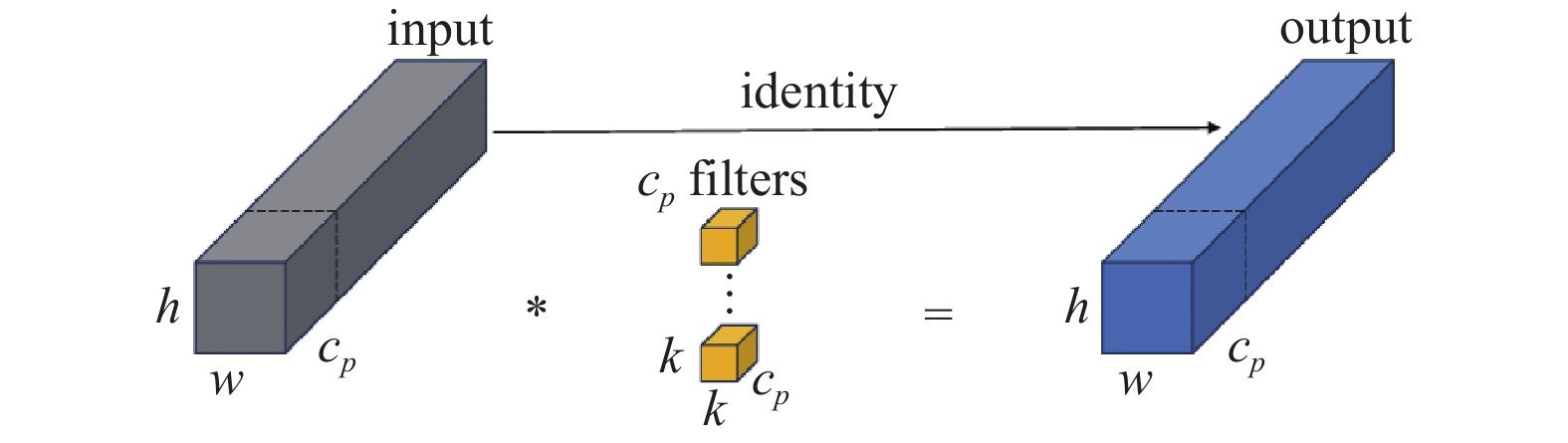

1.1 FasterNet与PConv模块

为了设计一个更加轻量化快速的神经网络, 许多研究都是在降低FLOPs, 例如MobileNets[31], ShuffleNet[32], GhostNet[33]等, 但是FLOPs和延时(Latency)并不是遵循一一对应的关系, 上述的这些方法虽然减小了FLOPs, 但会造成另一种缺点, 即内存访问(memory access)的增加, 对于小模型的训练时间往往是显著的. 所以, 计算一个模型的延时方法如式(1)所示.

| Latency=FLOPsFLOPS | (1) |

其中,

|

图 2 PConv部分卷积结构图 |

假设输入和输出的特征映射具有相同的通道c, 则PConv的FLOPs以及内存访问情况如式(2)、式(3)所示:

| h×w×k2×c2p | (2) |

| h×w×2cp+k2×c2p≈h×w×2cp | (3) |

其中,

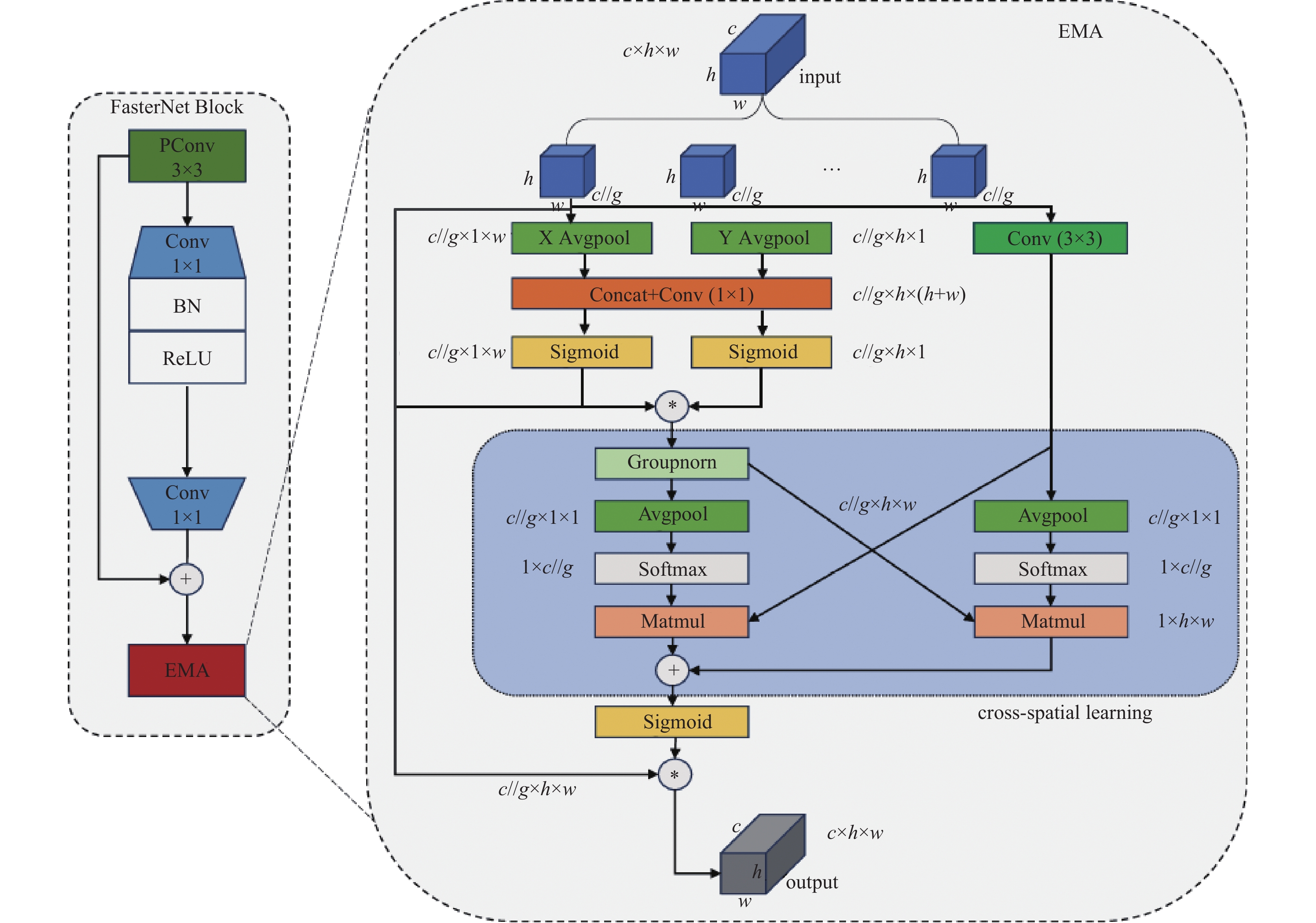

由于水下生物的游动性以及环境原因, 图片中的水下生物存在重叠、遮挡情况, 导致出现错检漏检的情况. 为解决此类问题, 通过引入注意力模块动态调整模型对于图像中各个区域的权重分配, 增强模型对于目标区域的关注度, 提高检测能力. 近年来, 空间注意力和通道注意力的有效性已经得到了很好的证实. 为保证每个通道的信息并减少计算开销, 在CA注意力模块[34]上提出了一种新的高效多尺度注意力(EMA)模块[35]. EMA通过特征分组、并行子网、跨空间学习等策略, 在卷积操作中学习有效的通道描述, 且不降低通道维数, 图3右侧展示了实现过程.

对于任意输入特征图

|

图 3 FasterNet-EMA模块结构图 |

EMA有效地解决了传统的注意力机制的缺点, 它显示了出色的计算效率和泛化能力, 利用EMA的灵活性和轻量化特性, 将其集成到了FasterNet Block当中, 形成了FasterNet-EMA模块, 如图3所示.

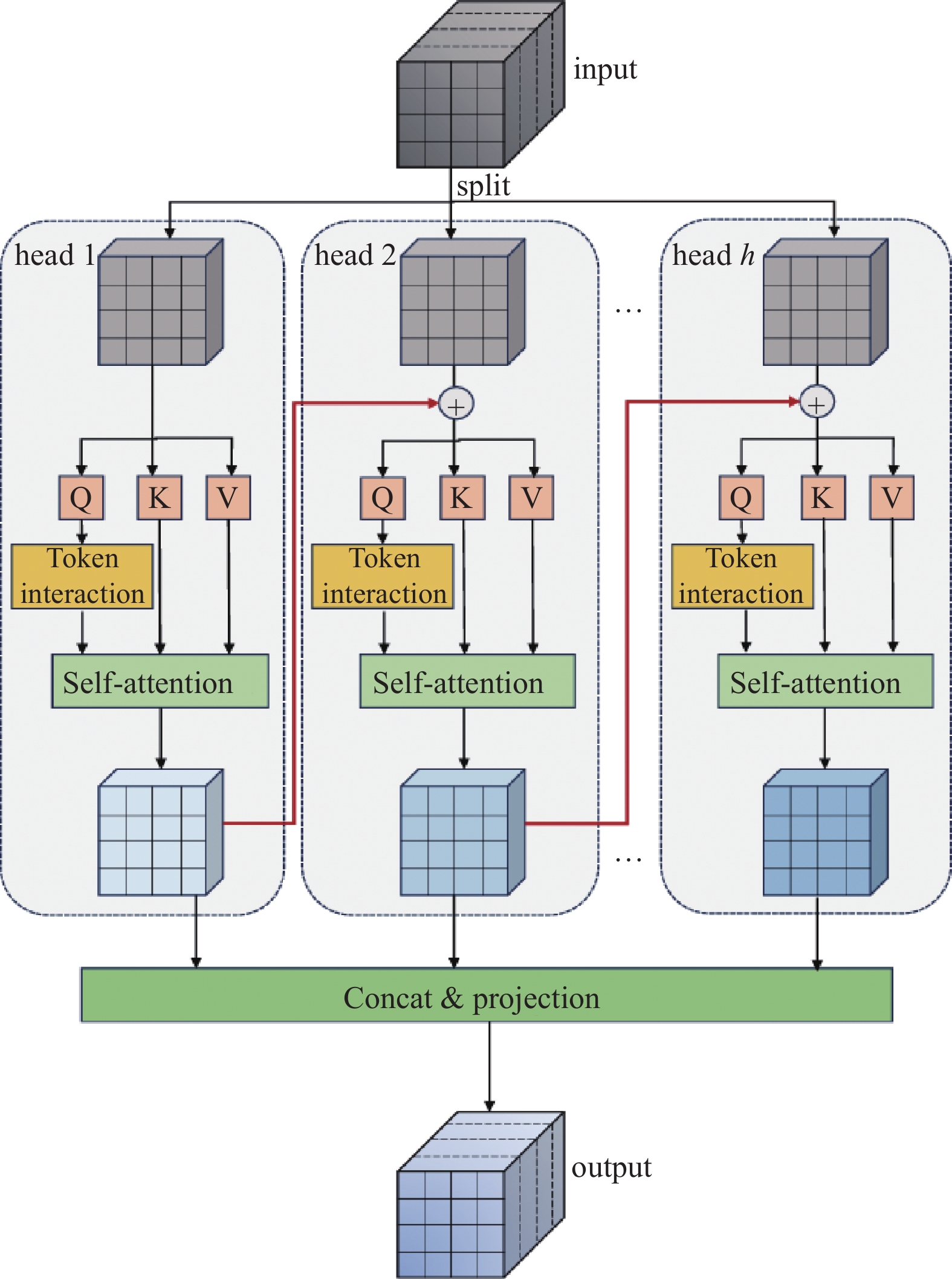

1.3 AIFI-CGA模块随着Transformer的发展, 从自然语言处理领域发展到计算机视觉领域, 具有较强的全局建模的能力, 其核心思想是自注意力机制. 但在不同头部之间的注意力图具有高度的相似性, 导致计算冗余, 为解决该问题, 通过级联群体注意力(cascaded group attention)模块[36]将完整特征切分为不同部分, 并将这些部分输入到不同的注意力头当中, 从而既节约了计算成本, 又提高了注意力的多样性, 最后, 将不同的注意力头的输出特征级联在一起, 得到最终结果. 其结构如图4所示.

|

图 4 级联群体注意力模块结构图 |

通过将级联群体注意力模块加入RT-DETR的AIFI模块当中, 可以将不同的特征语义信息提供给每个注意力头, 以提高多样性; 还可以增加网络深度, 在不引入额外参数的情况下, 提高模型容量.

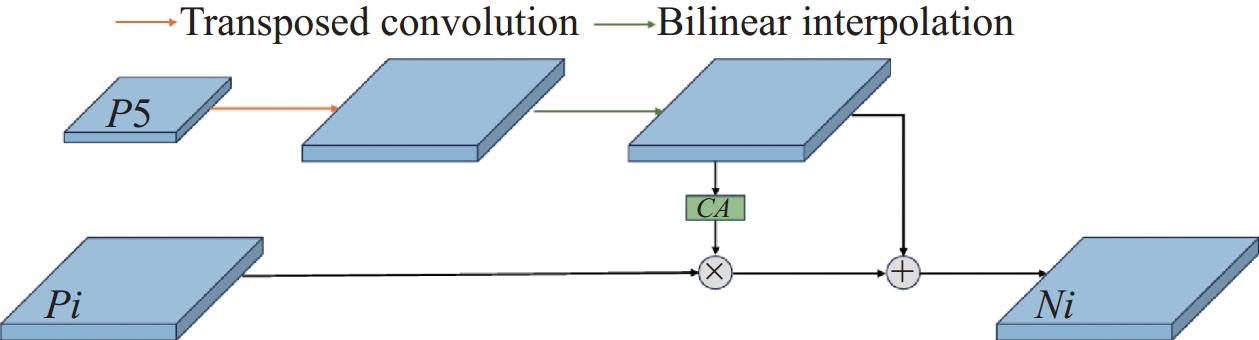

1.4 高水平筛选特征金字塔在水下目标检测数据集当中, 不同生物之间存在大小差异, 并且相同的生物也会因为位置、拍摄角度的不同导致尺寸差异, 因此对于不同尺寸的水下生物的识别会存在一定困难. 为解决水下目标数据集存在的多尺度问题, 设计了基于RT-DETR的高水平筛选特征金字塔(HS-FPN)[26], 来解决多尺度的特征融合问题. 其结构图如图1右侧HS-FPN (feature selection & feature fusion)所示. HS-FPN可以分为特征选择(feature selection)和特征融合(feature fusion)两部分, 首先对于不同的特征尺度进行选择, 之后将高层信息和底层信息进行融合.

特征选择模块主要由通道注意力(channel attention, CA)和维度匹配模块两部分组成. CA注意力根据通道的重要性, 选择性的保留和弱化特征图中的不同通道, 帮助筛选出低级特征和高级特征中的有用信息, 提高模型对目标特征的表达能力. 由于不同尺度的特征图具有不同的通道数, 因此在特征融合之前采用1×1卷积将每个尺度的特征图通道数缩小为256, 以保证不同尺度的特征图能够进行维度匹配. 选择特征融合模块(select feature fusion, SFF)通过将高层特征作为权重来筛选底层特征中重要的语义信息, 能够有效地结合高级特征的语义信息和低尺度的细节信息, 实现有目的的特征融合. SFF的结构图如图5所示.

|

图 5 SFF模块结构图 |

对于输入的高层特征

| fatt=BL(T−Conv(fhigh)) | (4) |

| fout=flow×CA(fatt)+fatt | (5) |

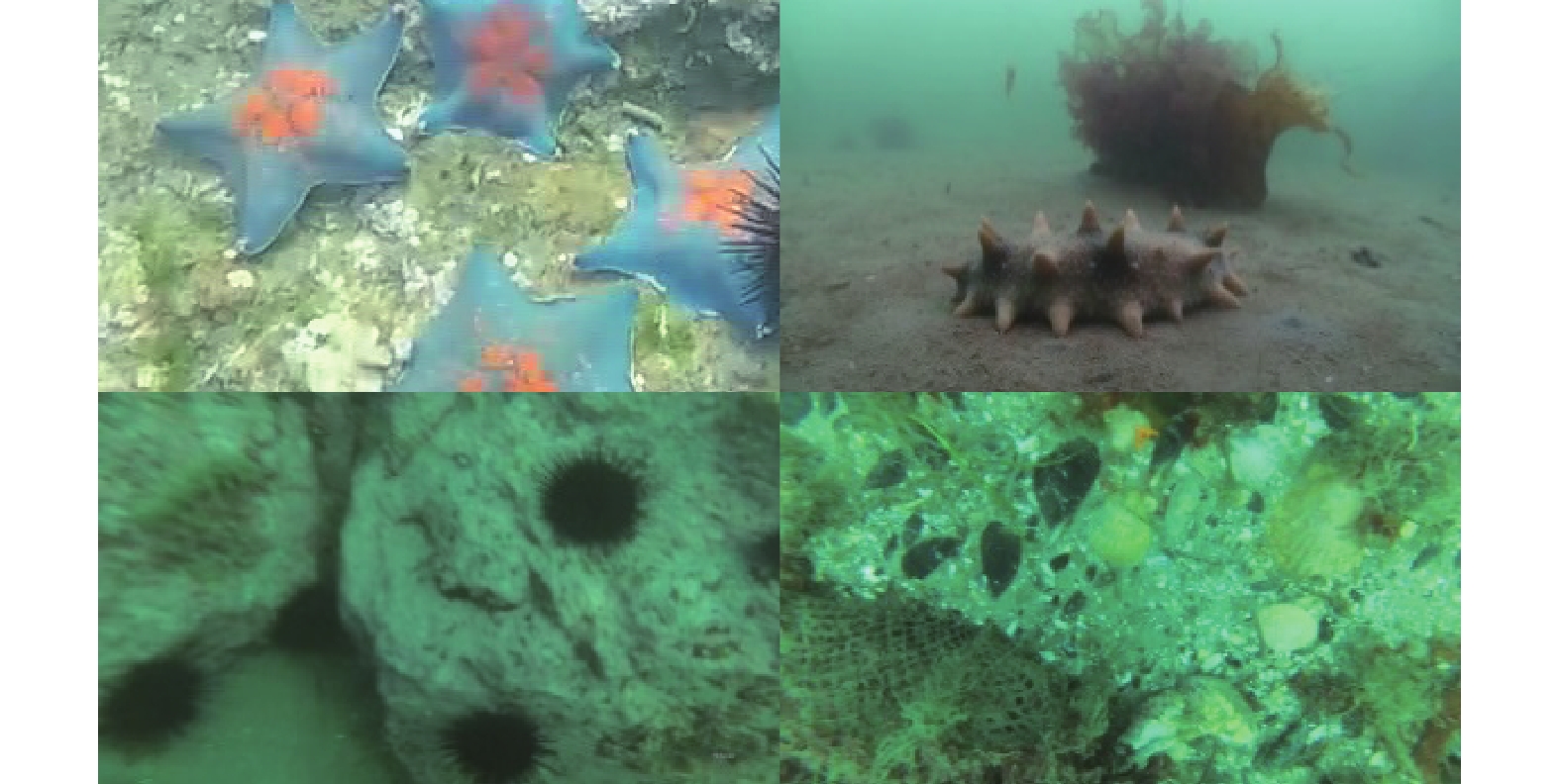

本文使用的数据集为2020年全国水下机器人专业竞赛(URPC2020)目标识别组数据集和DUO (detecting underwater objects) 探测水下物体数据集[37], 两个数据集均由4种水下生物组成, 分别是: 海星、扇贝、海胆、海参. URPC2020数据集共有

|

图 6 部分训练集图片 |

2.1.2 实验环境和参数设置

本实验所使用的硬件是Intel(R) Core(TM) i5-12400F (CPU), NVIDIA GeForce RTX 4060 (8 GB) (GPU), 16 GB内存, Windows操作系统, 软件环境为PyTorch 1.12.0, CUDA 10.2, 代码运行环境为Python 3.9. 输入图像大小为640×640, 运行100 epoch, 优化器为AdamW, 学习率为

本实验使用精准度(P)、召回率(R)、平均精度均值(mAP)、参数量(params)和浮点运算次数(GFLOPs)共5个指标客观的评价模型性能. 精准率表示预测为正样本的那些数据里预测正确的数据个数, 计算公式如式(6)所示. 召回率表示真实为正例的那些数据里预测正确的数据个数, 计算公式如式(7)所示. 平均精度均值(mAP)是目标检测中最常用的评估指标之一, mAP是一个综合指标, 他在不同的平均准确率(AP)之下计算平均准确率. 计算公式如式(8)、式(9)所示.

| P=TPTP+FP | (6) |

| R=TPTP+FN | (7) |

| AP=∫10P(R)dR | (8) |

| mAP=1cc∑i=1AP(i) | (9) |

其中,

本文采用了多种方法来改进RT-DETR算法, 为了说明改进方法的有效性, 在URPC2020数据集上进行消融实验, 将RT-DETR作为基准模型对比分析改进的结果, 并对实验结果进行分析, 实验结果汇总如表1所示.

| 表 1 消融实验结果 |

实验1为原始的RT-DETR的算法, 实验2在原始模型的基础上, 将R18的Block替换为Faster-EMA, 模型的参数量以及计算量分别下降2.98×106和5.4, mAP提升了1.6个百分点, 表明Faster-EMA能够使模型更加轻量化, 且对于图像特征提取效率更高. 实验3在编码器中引入CGA模块, 在参数量和计算量上无明显变化, mAP提升了1.5个百分点, 表明改进的网络能够更准确地关注图像的重要信息, 过滤掉背景信息, 提升模型的表现能力. 实验4将CCFM替换为HS-FPN, 参数量和计算量分别下降1.86×106和3.8, mAP提升了1.3个百分点, 表明使用多尺度特征融合, 将每个尺度上的信息进行选择融合, 更好的捕捉目标在不同尺度上的表现, 提升模型的性能. 实验5、6、7为同时引入两个改进模块, 组合使用对于检测性能的提升要高于使用单个改进模块, 表明各个模块之间的改进不会产生冲突. 实验8为本文的改进算法, 参数量和计算量分别下降5.01×106和9.2, mAP提升了3.1个百分点, 显著降低了参数量以及计算量. 综上所述, 本文所提方法能够在基准模型之上得到有效的改进, 在提高了平均检测精度的同时, 降低了参数量和计算量.

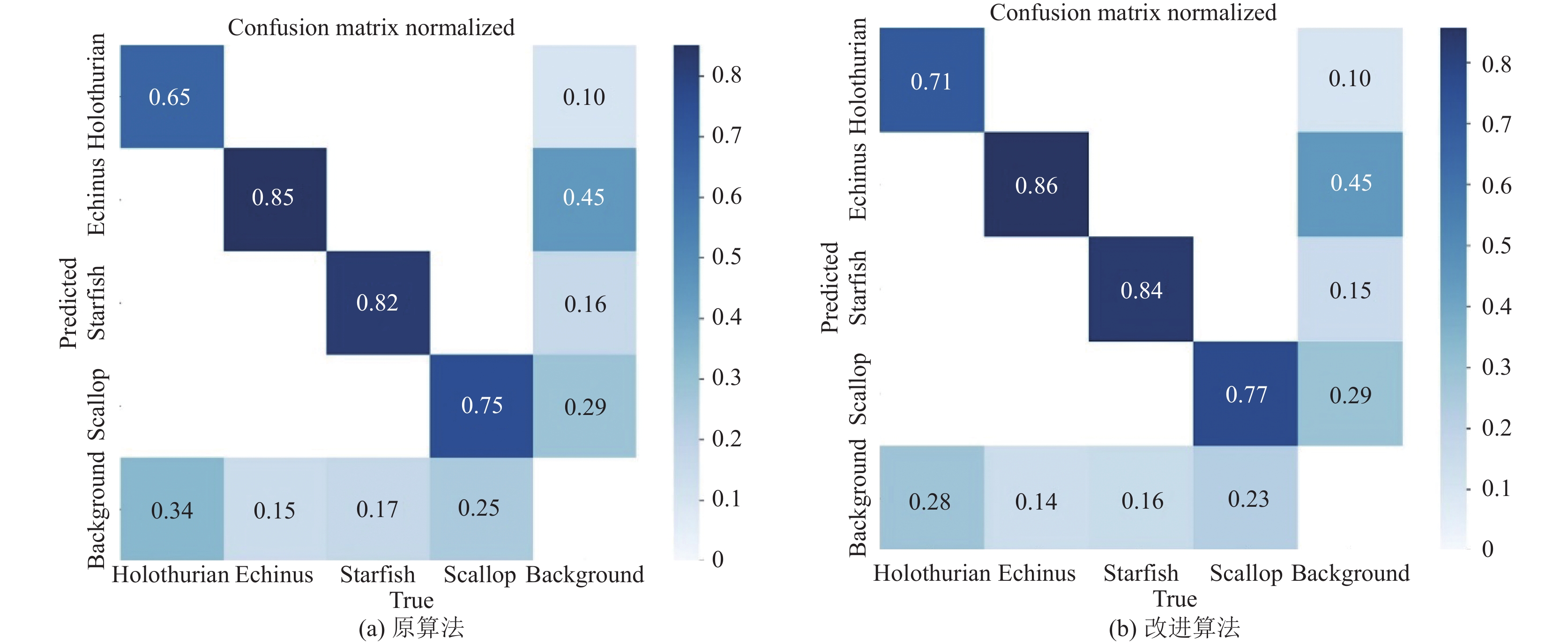

在实验过程中, 使用图7混淆矩阵更加清晰地看出原模型与改进后的模型对水下4种目标的检测效果, 其中对角线代表检测正确的比例, 横坐标代表真实标签, 纵坐标代表预测标签, 可以看出改进后的模型在各类别检测正确的比例都有提升, 检测为背景的比例也有所减少, 表明改进模型的检测能力有所提高.

|

图 7 原算法与改进算法混淆矩阵 |

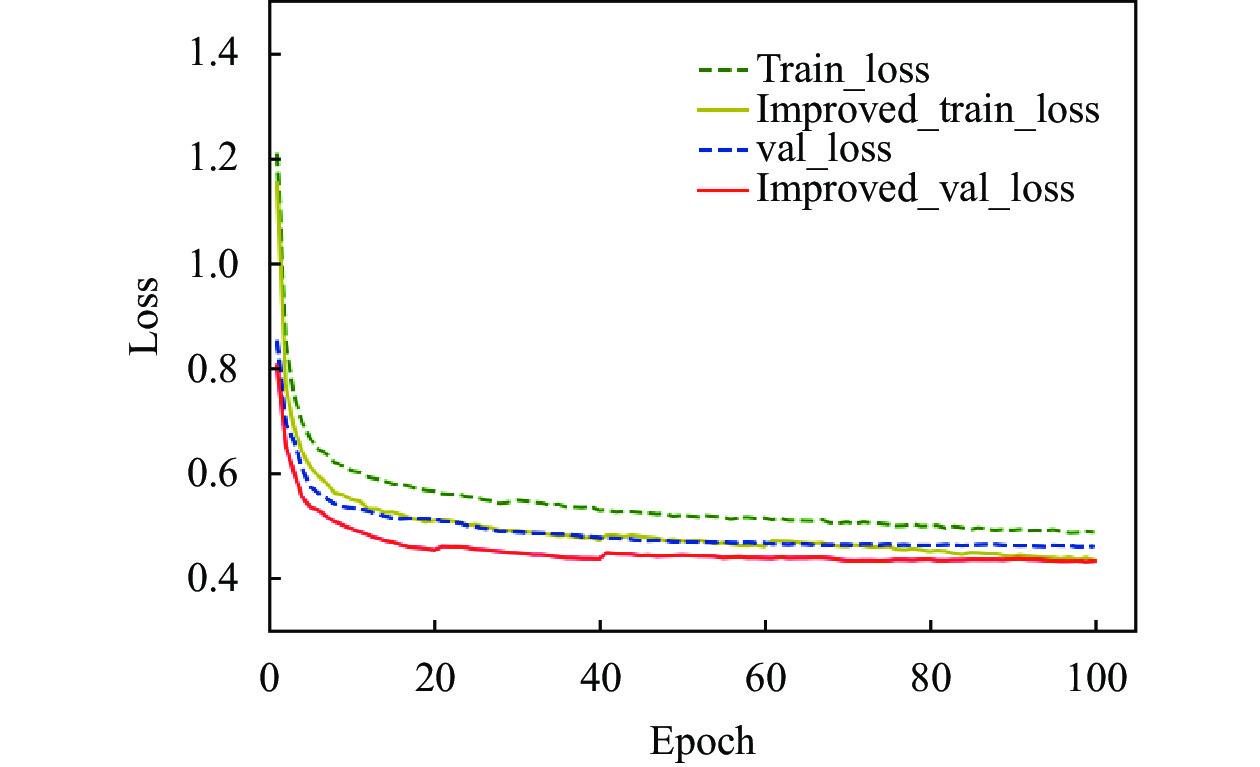

改进前后的模型在训练过程中的损失曲线如图8所示. 其中虚线为原始的RT-DETR算法, 实线为改进后的FERT-DETR算法, 可以看出改进后的算法损失值下降得更快, 且收敛效果更好.

|

图 8 损失曲线对比图 |

2.2.2 不同模型实验结果对比

将本文所提的改进FERT-DETR算法同其他主流目标检测算法进行对比, 探究算法的优越性, 每个模型在URPC2020数据集和DUO数据集上进行实验, 实验结果如表2所示.

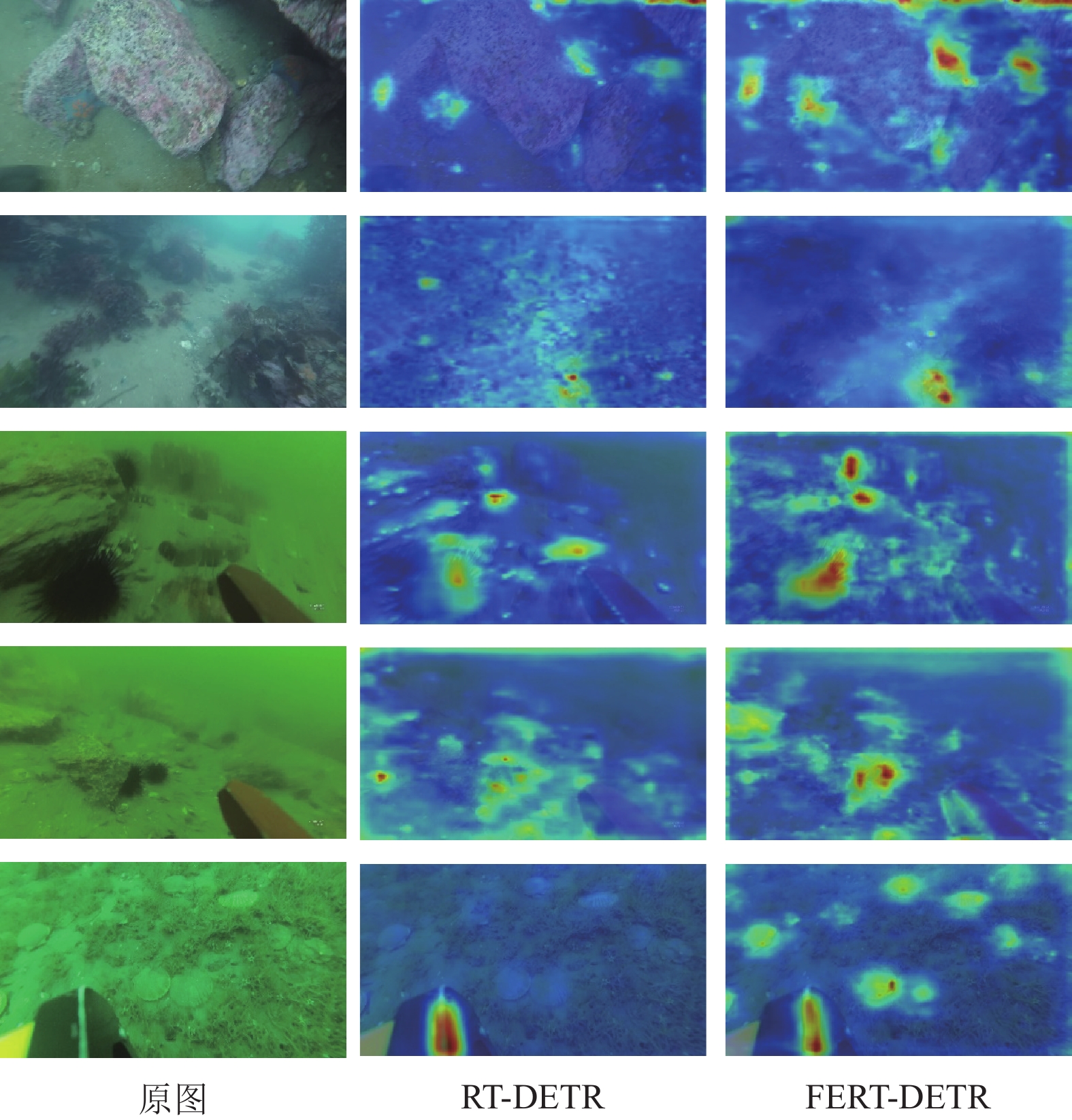

2.2.3 不同模型实验结果对比为了更好地比较本文所使用的方法与原模型在水下目标检测方面的效果, 图9展示了两者的热力图对比结果. 可以看出, RT-DETR模型存在较多的错检和漏检情况, 而本文的方法相对较少. 通过热力图可以看出, 在加入注意力机制后的改进算法能够对目标更加敏感. 对于环境复杂, 图片模糊的情况下, 引入多尺度融合的特征网络能够更好地检测出模糊、遮挡的目标. 因此本文可以更好地应用于水下目标检测.

| 表 2 横向对比实验结果 |

|

图 9 热力图对比 |

2.2.4 不同模型实验结果对比

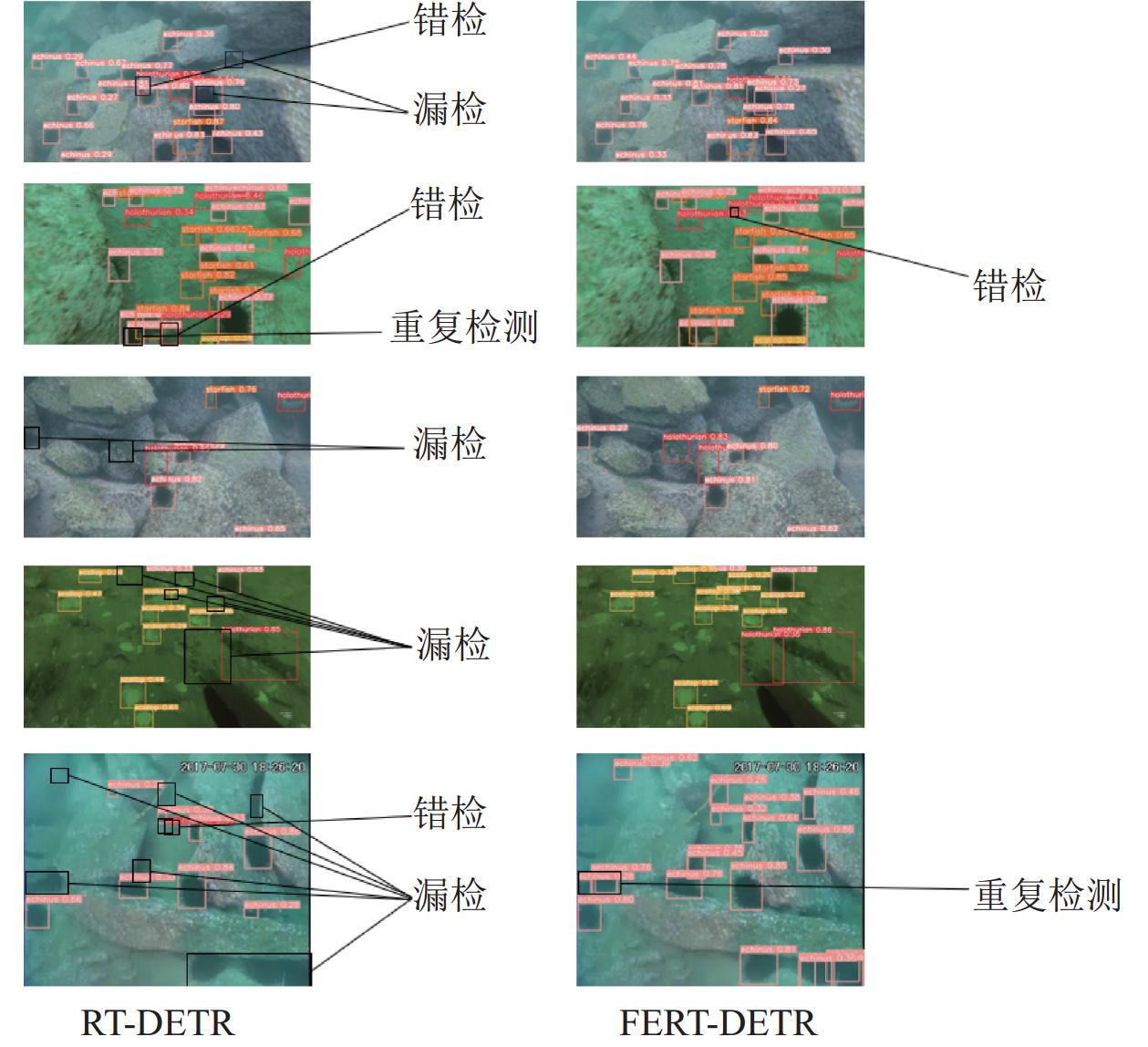

图10展示了FERT-DETR模型对比RT-DETR原模型的检测效果, 从图中可以看到, 原模型对于水下目标检测由于图像模糊、遮挡、小目标等因素存在较多的错检、漏检和重复检测的情况. 而改进的FERT-DETR也存在部分错检漏检情况, 但明显优于原模型的检测效果. 总体来看, 本文的改进能够显著解决水下图像的模糊遮挡等问题, 增强检测精度, 更加适合于水下目标检测.

|

图 10 总体检测实验图对比 |

3 结论与展望

本文针对水下目标模糊和遮挡等问题, 在RT-DETR网络模型的基础上提出了FERT-DETR. 该方法通过更换骨干网络, 使用更加轻量化的FasterNet Block, 又在其骨干网络的基础上加入EMA注意力机制, 使模型对目标更加敏感, 增强特征提取能力. 之后提出AIFI-CGA, 既节约了计算成本, 又提高了注意力的多样性以及模型容量. 最后通过优化特征融合网络, 使用高水平筛选特征金字塔HS-FPN替换CCFM, 能够有效地提升模型对遮挡目标的检测性能. 通过一系列的实验, 证明本文所提算法的有效性. 本文方法仍有改进空间, 基于Transformer的目标检测最大问题来自计算量, 所以未来工作可以在模型规模和检测速度上进行优化.

| [1] |

Khan A, Fouda MM, Do DT, et al. Underwater target detection using deep learning: Methodologies, challenges, applications and future evolution. IEEE Access, 2024, 12: 12618–12635. DOI:10.1109/ACCESS.2024.3353688 |

| [2] |

Sahoo A, Dwivedy SK, Robi PS. Advancements in the field of autonomous underwater vehicle. Ocean Engineering, 2019, 181: 145-160. DOI:10.1016/j.oceaneng.2019.04.011 |

| [3] |

Ghafoor H, Noh Y. An overview of next-generation underwater target detection and tracking: An integrated underwater architecture. IEEE Access, 2019, 7: 98841-98853. DOI:10.1109/ACCESS.2019.2929932 |

| [4] |

Liu K, Liang YQ. Enhancement of underwater optical images based on background light estimation and improved adaptive transmission fusion. Optics Express, 2021, 29(18): 28307-28328. DOI:10.1364/oe.428626 |

| [5] |

Shi J, Zhuo X, Zhang C, et al. Research on key technologies of underwater target detection. Proceedings of the 7th Symposium on Novel Photoelectronic Detection Technology and Applications. Kunming: SPIE, 2021. 1128–1137. [doi: 10.1117/12.2586895]

|

| [6] |

Fu HX, Song GQ, Wang YC. Improved YOLOv4 marine target detection combined with CBAM. Symmetry, 2021, 13(4): 623. DOI:10.3390/sym13040623 |

| [7] |

Felzenszwalb PF, Girshick RB, McAllester D, et al. Object detection with discriminatively trained part-based models. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(9): 1627-1645. DOI:10.1109/TPAMI.2009.167 |

| [8] |

Lowe DG. Distinctive image features from scale-invariant keypoints. International Journal of Computer Vision, 2004, 60(2): 91-110. DOI:10.1023/B:VISI.0000029664.99615.94 |

| [9] |

Dalal N, Triggs B. Histograms of oriented gradients for human detection. Proceedings of the 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Diego: IEEE, 2005. 886–893. [doi: 10.1109/CVPR.2005.177]

|

| [10] |

Hearst MA, Dumais ST, Osuna E, et al. Support vector machines. IEEE Intelligent Systems and Their Applications, 1998, 13(4): 18-28. DOI:10.1109/5254.708428 |

| [11] |

Dai JF, Li Y, He KM, et al. R-FCN: Object detection via region-based fully convolutional networks. Proceedings of the 30th International Conference on Neural Information Processing Systems. Barcelona: Curran Associates Inc., 2016. 379–387.

|

| [12] |

Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation. Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus: IEEE, 2014. 580–587. [doi: 10.1109/CVPR.2014.81]

|

| [13] |

Girshick R. Fast R-CNN. Proceedings of the 2015 IEEE International Conference on Computer Vision. Santiago: IEEE, 2015. 1440–1448. [doi: 10.1109/ICCV.2015.169]

|

| [14] |

Ren SQ, He KM, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks. Proceedings of the 28th International Conference on Neural Information Processing Systems. Montreal: MIT Press, 2015. 91–99.

|

| [15] |

He KM, Gkioxari G, Dollár P, et al. Mask R-CNN. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 2980–2988. [doi: 10.1109/ICCV.2017.322]

|

| [16] |

Cai ZW, Vasconcelos N. Cascade R-CNN: Delving into high quality object detection. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 6154–6162. [doi: 10.1109/CVPR.2018.00644]

|

| [17] |

Li X, Shang M, Qin HW, et al. Fast accurate fish detection and recognition of underwater images with Fast R-CNN. Proceedings of the OCEANS 2015-MTS/IEEE Washington. Washington: IEEE, 2015. 1–5. [doi: 10.23919/OCEANS.2015.7404464]

|

| [18] |

Zeng LC, Sun B, Zhu DQ. Underwater target detection based on Faster R-CNN and adversarial occlusion network. Engineering Applications of Artificial Intelligence, 2021, 100: 104190. [doi: 10.1016/j.engappai.2021.104190]

|

| [19] |

Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector. Proceedings of the 14th European Conference on Computer Vision. Amsterdam: Springer, 2016. 21–37. [doi: 10.1007/978-3-319-46448-0_2]

|

| [20] |

Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 779–788. [doi: 10.1109/CVPR.2016.91]

|

| [21] |

强伟, 贺昱曜, 郭玉锦, 等. 基于改进SSD的水下目标检测算法研究. 西北工业大学学报, 2020, 38(4): 747-754. DOI:10.3969/j.issn.1000-2758.2020.04.008 |

| [22] |

Li Y, Guo JH, Guo XM, et al. Toward in situ zooplankton detection with a densely connected YOLOv3 model. Applied Ocean Research, 2021, 114: 102783. DOI:10.1016/j.apor.2021.102783 |

| [23] |

黄廷辉, 高新宇, 黄春德, 等. 基于FAttention-YOLOv5的水下目标检测算法研究. 微电子学与计算机, 2022, 39(6): 60-68. DOI:10.19304/J.ISSN1000-7180.2021.1261 |

| [24] |

Wang Z, Chen HJ, Qin HD, et al. Self-supervised pre-training joint framework: Assisting lightweight detection network for underwater object detection. Journal of Marine Science and Engineering, 2023, 11(3): 604. DOI:10.3390/jmse11030604 |

| [25] |

Carion N, Massa F, Synnaeve G, et al. End-to-end object detection with Transformers. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 213–229. [doi: 10.1007/978-3-030-58452-8_13]

|

| [26] |

Chen YF, Zhang CY, Chen B, et al. Accurate leukocyte detection based on deformable-DETR and multi-level feature fusion for aiding diagnosis of blood diseases. Computers in Biology and Medicine, 2024, 170: 107917. DOI:10.1016/j.compbiomed.2024.107917 |

| [27] |

Zhu XZ, Su WJ, Lu LW, et al. Deformable DETR: Deformable Transformers for end-to-end object detection. arXiv:2010.04159, 2021.

|

| [28] |

Liu SL, Li F, Zhang H, et al. DAB-DETR: Dynamic anchor boxes are better queries for DETR. Proceedings of the 10th International Conference on Learning Representations. OpenReview.net, 2022.

|

| [29] |

Zhang H, Li F, Liu SL, et al. DINO: DETR with improved denoising anchor boxes for end-to-end object detection. arXiv:2203.03605, 2022.

|

| [30] |

Zhao YA, Lv WY, Xu SL, et al. DETRs beat YOLOs on real-time object detection. arXiv:2304.08069, 2024.

|

| [31] |

Howard AG, Zhu ML, Chen B, et al. MobileNets: Efficient convolutional neural networks for mobile vision applications. arXiv:1704.04861, 2017.

|

| [32] |

Zhang XY, Zhou XY, Lin MX, et al. ShuffleNet: An extremely efficient convolutional neural network for mobile devices. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 6848–6856. [doi: 10.1109/CVPR.2018.00716]

|

| [33] |

Han K, Wang YH, Tian Q, et al. GhostNet: More features from cheap operations. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 1577–1586. [doi: 10.1109/CVPR42600.2020.00165]

|

| [34] |

Hou QB, Zhou DQ, Feng JS. Coordinate attention for efficient mobile network design. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 13708–13717. [doi: 10.1109/CVPR46437.2021.01350]

|

| [35] |

Ouyang DL, He S, Zhang GZ, et al. Efficient multi-scale attention module with cross-spatial learning. Proceedings of the 2023 IEEE International Conference on Acoustics, Speech and Signal Processing. Rhodes Island: IEEE, 2023. 1–5. [doi: 10.1109/ICASSP49357.2023.10096516]

|

| [36] |

Liu XY, Peng HW, Zheng NX, et al. EfficientViT: Memory efficient vision Transformer with cascaded group attention. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE, 2023. 14420–14430. [doi: 10.1109/CVPR52729.2023.01386]

|

| [37] |

Liu CW, Li HJ, Wang SC, et al. A dataset and benchmark of underwater object detection for robot picking. Proceedings of the 2021 IEEE International Conference on Multimedia & Expo Workshops. Shenzhen: IEEE, 2021. 1–6. [doi: 10.1109/ICMEW53276.2021.9455997]

|

2024, Vol. 33

2024, Vol. 33