2. 南京信息工程大学 计算机学院、网络空间安全学院, 南京 210044;

3. 南京理工大学 计算机科学与工程学院, 南京 210094

2. School of Computer Science & School of Cyber Science and Engineering, Nanjing University of Information Science & Technology, Nanjing 210044, China;

3. School of Computer Science and Engineering, Nanjing University of Science and Technology, Nanjing 210094, China

由于其便利性和准确性, 人脸识别已被应用于一些交互式智能应用, 如签到和移动支付. 然而, 现有的人脸识别系统容易受到各种表现形式的攻击, 包括打印、重放、化妆、3D面具等[1]. 因此, 学术界和工业界都广泛关注开发用于保护人脸识别系统的人脸活体检测技术[2].

由于手工特征已被证明在区分真实样本和攻击样本方面具有辨别力[2], 一些最近的混合方法将手工特征与深度特征结合用于人脸活体检测[3–5]. 关于真实样本和攻击样本之间的区别, 高频特征强调了高频干扰的存在, 例如在打印和视频攻击中出现的莫尔纹. 另一方面, 低频特征突出了颜色失真的问题[5]. 采用像素级监督可以提供更精确和与任务相关的上下文线索, 从而改善内在特征学习. 因此, 最近的研究探索了伪深度标签来指导模型训练[6–8]. 这些方法涉及训练模型来预测真实样本的实际深度, 同时攻击样本置零值. 深度图被用于通过像素级监督估计面部深度信息[6]. Wang等人[7]通过主成分分析表明, 从深度图领域提取的特征在相同网络结构中比从RGB领域提取的特征表现出更大的鲁棒性.

Tian等人[9]发现, 从更多的视图学习, 得到的表示能更好地捕捉底层场景语义. Khosla等人[10]将自监督对比方法扩展到全监督, 有效地利用标签信息. 在特征归一化超平面中, 属于同一类的点簇被拉在一起, 同时将不同类别的样本簇推开. 本文将监督对比学习[10]与多视图对比学习[9]相结合. 此外, 本文将非对称三元组损失[11]加入特征学习中, 进一步减小了正样本之间的距离, 从而得到了更紧凑的正样本分布.

常用的多尺度特征融合方法包括拼接和加权求和等[12–14]. 然而, 在处理多视图差异时, 这些方法并不总是最优选择. 因此, 本文提出了两阶段双线性特征融合方法. 在第1阶段, 将3个频率特征融合视为多尺度特征融合, 本文采用可学习的独立权重的加权求和方法来融合频率特征. 在第2阶段, 由于视图之间存在较大尺度, 语义等差异性, 将频率特征和深度图特征融合视为常规的特征融合可能会导致特征信息冗余, 降低多特征学习的多信息优势. 本文引入了双线性模型[15]来融合这些特征. 总结起来, 本文的主要贡献如下.

1) 本文提出了一种结合了频率图像和深度图的多分支网络. 该网络结合了高频和低频编码器, 以提取经常被忽视的高频干扰信息和凸显色彩失真的低频信息, 以及由生成对抗网络生成的深度图提高人脸活体检测的泛化能力.

2) 将有监督多视图对比学习应用到多视图学习中, 最大化了相同样本不同视图之间的相似性, 更好地捕捉人脸潜在的语义信息.

3) 提出了一种两阶段双线性特征融合方法, 以解决高频、低频、深度图中不同尺度和不兼容特征的难题.

1 相关工作 1.1 人脸活体检测一些基于卷积神经网络的人脸活体检测模型在单一数据集实验中取得了良好的结果. 然而, 在面对跨数据集实验时, 这些只由二元交叉熵损失监督的模型表现出较差的泛化能力. 而且, 端到端的模型很难解释. 此外, 混合算法存在手工设计特征与深度特征之间不兼容的明显缺点, 这可能限制模型的性能[2]. 频率特征和深度图像的融合同样面临着这一挑战. 为了缓解这个问题, 本文确定了不同特征的独立权重, 并采用双线性模型进行特征融合.

生成对抗网络是人脸活体检测算法中较为流行的网络, 特别是在风格迁移和域转换等任务中. 编码器-解码器生成对抗网络[16]能够生成具有连续姿态变化的逼真面部图像. 许多当前的域自适应算法利用GAN来减少源域和目标域之间的差异. 例如, Feng等人[17]采用GAN将特征从源域映射到目标域. Wang等人[18]利用GAN混合不同域中的内容特征来学习域无关的内容特征.

在人脸活体检测(face anti-spoofing, FAS)中利用面部深度图是一种常见的做法. 最近的几项研究[6,19]已经将像素级伪深度标签纳入到辅助FAS模型中. 这些标签强制对真实样本进行准确的深度预测, 而对欺诈样本则采用零值映射. Liu等人[6]将深度图像引入作为FAS模型的辅助信息. Wang等人[7]采用了神经网络的域对抗训练[20], 用于训练编码器将RGB图像转换为深度图像.

1.2 对比学习对比学习是一种判别方法, 旨在将相似样本聚集在一起, 将不同样本远离彼此[21]. Chen等人[22]提出了一种用于对比学习视觉表示的简单框架. 标签作为掩码矩阵, 用于区分正负样本[10]. 在FAS的背景下, Sun等人[23]采用了监督对比学习来实现不同域之间的数据分离. 这是通过将分类标签与域标签相结合来实现的. 域信息也被引入到掩码矩阵中. Tian等人[9]认为, 人们通过多个感官通道来观察世界. 每个视角都是嘈杂且不完整的, 但它们是重要的因素. 因此, 他们尝试学习能够捕捉多个感官视角之间共享信息的表示. 本文通过利用不同视图的两两排列作为样本对, 并使用类标签作为正负样本分类的指示器来实现这一目标.

1.3 特征融合特征融合是多分支网络中的重要且常见的操作, 它增强了多个编码器提取的特征. 基本的融合操作包括逐元素相加, 相乘, 拼接等. He等人[24]采用基于注意力的方法来融合多视图特征. Kim等人[15]利用点积近似双线性池化方法来融合多视图特征. 双线性池化涉及对特征进行元素级乘积操作, 有效地保留了每个视图的信息.

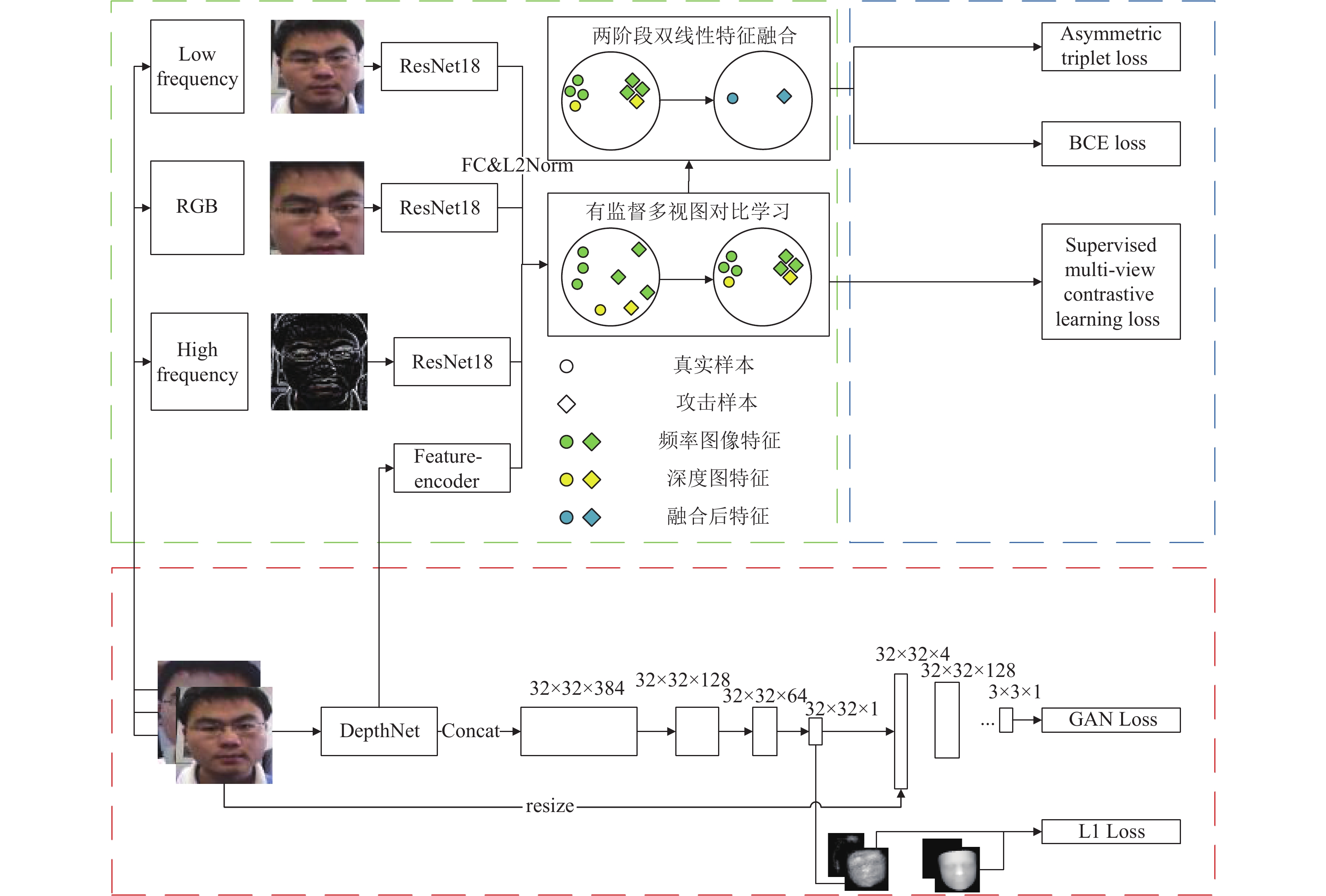

2 方法 2.1 总体架构如图1所示, 本文所提出的网络可以分为3个模块.

(1) 模块1: RGB图像被分解为高频图、低频图和RGB原图像. 其次, 使用生成对抗网络生成面部深度图. 深度图编码器结构采用了DepthNet[6].

(2) 模块2: 使用多个编码器提取深度图特征和多尺度频率特征. 提取频率特征的编码器采用ResNet18[25]. 提取深度图特征的编码器为一个具有3个3×3卷积核的3层卷积神经网络. 之后, 这些特征通过全连接和L2归一化映射到超平面上. 接着, 有监督多视图对比学习方法被用来训练多视图特征.

|

图 1 网络总体架构 |

(3) 模块3: 通过两阶段双线性特征融合方法融合频率特征和深度图特征. 我们还使用非对称三元组损失来学习紧凑的正样本特征分布. 最后, 通过二元交叉熵(BCE)损失进行特征分类.

综上, 本文的模型共有两个同步的训练流程, 流程1中通过生成对抗网络将RGB图像转换为深度图, 为流程2提供生成深度图作为输入之一. 在流程1中, 本文使用DepthNet提取原RGB图像, 为生成对抗网络中的深度图生成器提供特征输入.

流程2对各个视图进行特征提取, 对比学习, 特征融合以及最后的分类. 流程2中, 本文使用一个3层卷积神经网络提取已生成的深度图特征, 使用ResNet18提取预处理后的频率图像特征. 在提取了4种视图特征后, 本文使用多视图有监督对比学习来训练各个视图特征, 使用full graph方法, 将所有的视图进行完全的两两配对, 配对的视图作为对比学习的输入, 使得不同视图相同类型的特征拉近, 不同类型的特征拉远. 最后, 本文通过两阶段双线性特征融合方法融合多视图特征并送入分类器分类.

在两个流程之前, 本文通过MTCNN来对人脸视频数据进行人脸检测并以15帧每次的速率截取人脸图像.

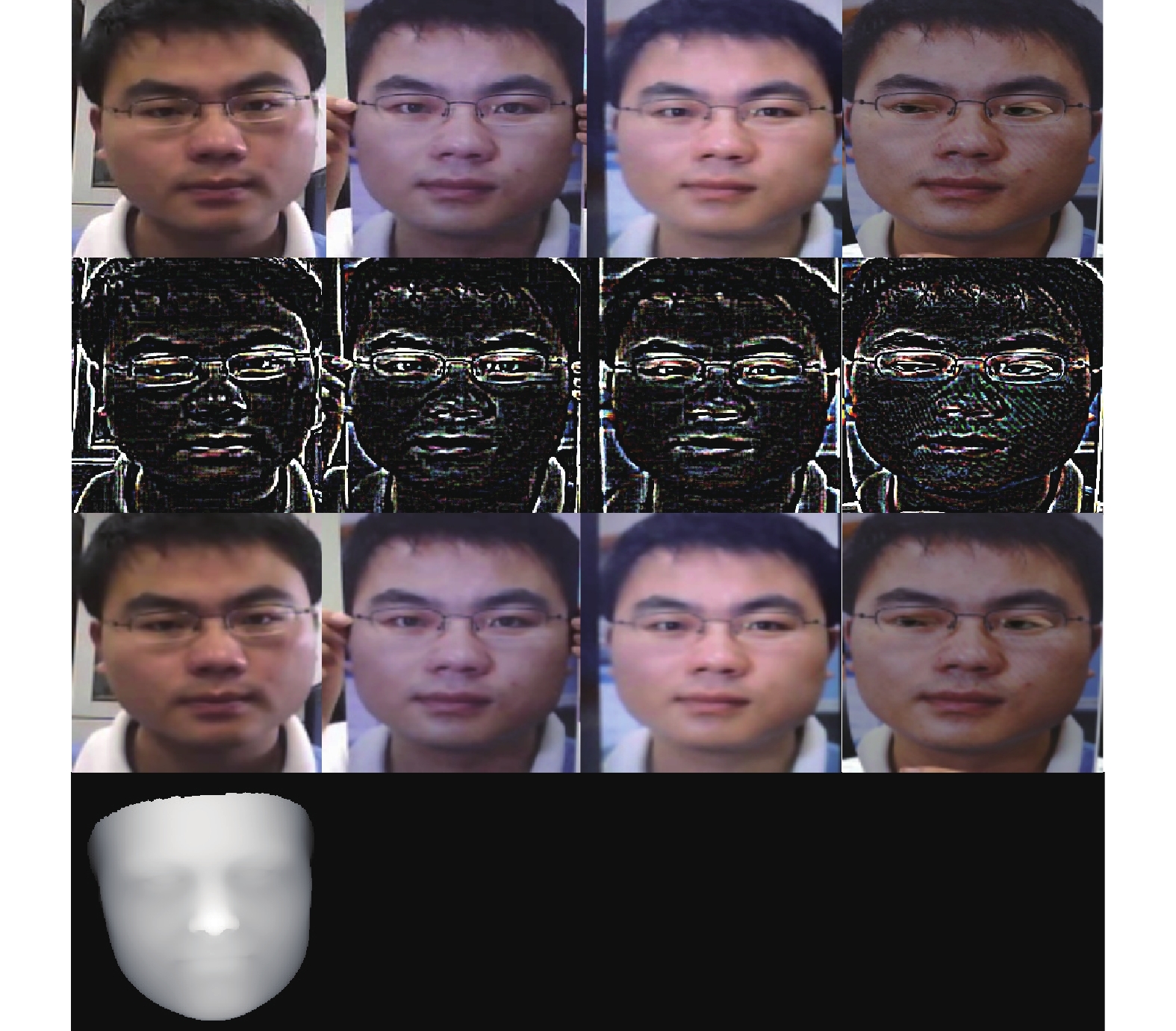

2.2 图像分解与真实深度图生成本文按照文献[8]的方法来对RGB图像进行分解. 首先, 使用平均池化层对原始图像进行下采样. 原始图像大小设置为256×256, 下采样后的图像大小为64×64. 然后, 使用双线性插值将图像上采样回原始图像大小. 通过将RGB图像从再次上采样的图像中减去, 得到高频图像. 再次上采样的图像即为低频图像. 具体公式如下.

| {IH=I−U256(D64(I))IL=U256(D64(I)) | (1) |

其中,

给定一个大小为

在一个多视角batch中,

| LSup=∑i∈I−1|P(i)|∑p∈P(i)log(exp(zi⋅zp/τ)∑a∈A(i)exp(zi⋅za/τ)) | (2) |

多个编码器的输入经过编码、全连接和L2归一化后, 这些输入被投影到一个超平面上, 分别表示为

| LSMCL=∑1⩽i<j⩽MLSup(Vi,Vj) | (3) |

|

图 2 频率图像与Ground Truth深度图 |

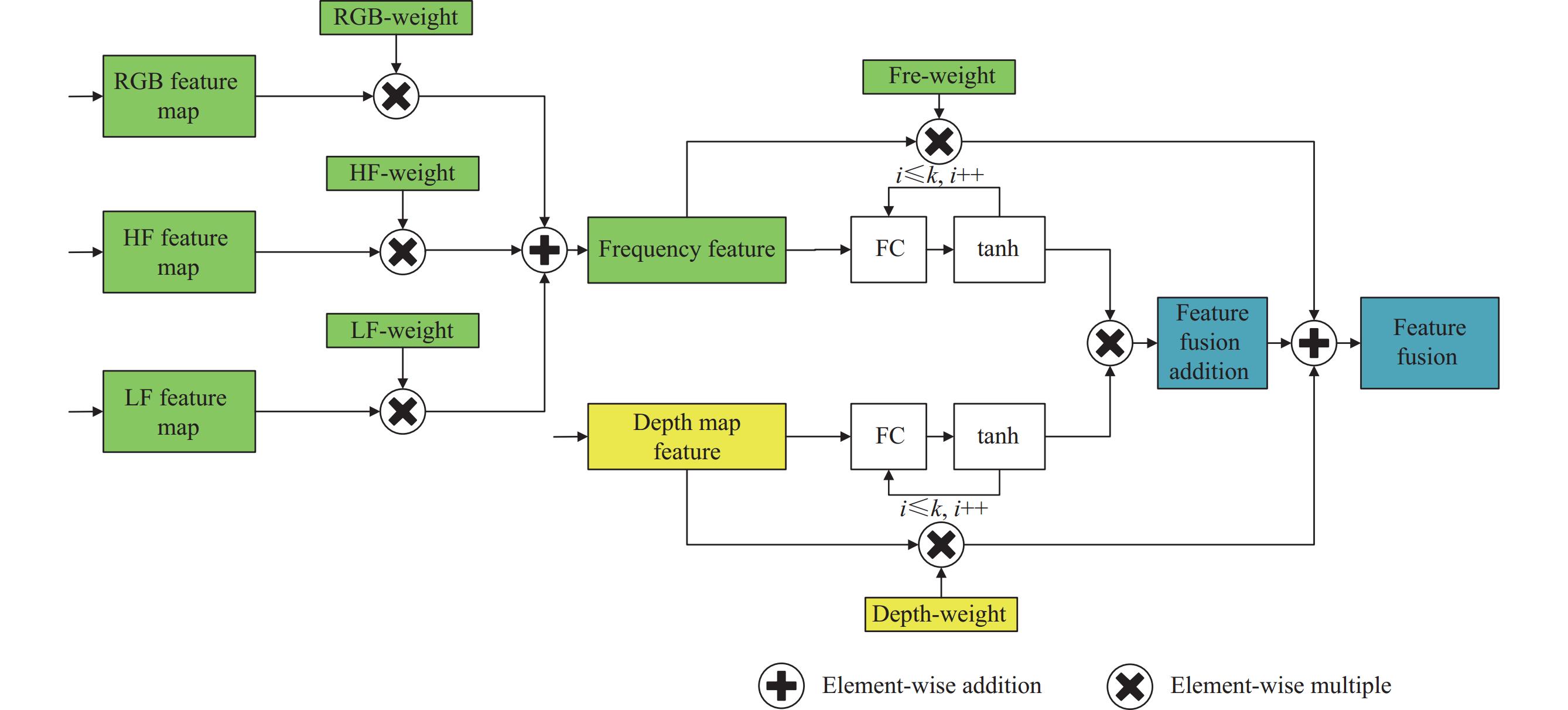

2.4 两阶段双线性特征融合

如图3所示, 特征融合可以分为两个阶段. 第1个阶段涉及融合频率特征. 尽管高频图像和低频图像来自同一个RGB领域, 但它们具有不同的输入, 针对具有相同输入的场景设计的传统多视角融合方法并不适用于从不同输入融合特征的任务. 因此, 频率特征融合, 求和的权重被初始化为独立的可学习参数. 然后, 这些权重参数与它们的频率特征相乘, 最后将多个频率特征相加. 如式(4)所示:

| Ffre=λhFh+λlFl+λiI | (4) |

其中,

|

图 3 两阶段双线性特征融合 |

第2阶段是融合频率特征和深度图特征. 频率特征和深度图特征来自不同的领域. 深度图特征的编码器结构与频率特征的编码器结构不同, 因此这些特征之间存在兼容性问题. 然而, 双线性池化融合方法可以缓解或忽略这些问题. 通过利用特征的互相点积, 双线性池化可以实现特征融合, 而不依赖于显式的权重分配. 此外, 双线性池化不受特征维度的限制, 可以应用于任意维度的特征. 这种特性使其特别适用于融合特征, 包括深度图特征和融合的频率特征. Kim等人[15]通过使用矩阵之间的Hadamard乘积来近似双线性池化. 这有效地减少了涉及的参数数量. 本文按照他的方法在双线性池化中进行操作[15]. 式(5)描述了融合过程, 如下所示.

| {Fbp=Ufre∘VdepF=λfreFfre+λdepFdep+λbpFbp | (5) |

其中,

通过生成对抗网络生成深度图的损失如式(6)[27].

| λGANargminGmaxDLGAN(G,D)+λL1L1(G) | (6) |

其中,

分类的总损失如式(7)所示.

| L=λSMCLLSMCL+λtriLtri+Lcls | (7) |

其中,

本文具体的方法流程为, 首先, 对原RGB图像进行频率图像预处理, 生成高频图像和低频图像. 使用3DDFA-V2模型将原RGB图像作为输入, 生成Ground Truth深度图. 通过生成对抗网络生成深度图, 输入为原RGB图像和 Ground Truth深度图. 接着, 频率图像和生成的深度图作为输入, 使用ResNet18和3层卷积神经网络提取多视图特征. 将多视图特征全连接并归一化, 使用full graph方法两两配对, 使用有监督多视图对比学习训练配对的多视图特征, 使用两阶段双线性特征融合方法融合多视图特征. 之后, 将多视图特征送入分类器分类. 最后, 根据式(6)计算生成对抗损失, 根据式(7)计算对比学习损失, 有监督多视图三元组损失和二元交叉熵分类损失.

3 实验 3.1 数据集本次实验使用了CASIA-FASD (CASIA face anti-spoofing dataset)数据集[28], Idiap Replay-Attack数据集[29], MSU-MFSD数据集[30]及OULU-NPU数据集[31].

MSU-MFSD数据集包含来自35个受试者的280个视频, 分别使用笔记本电脑摄像头和智能手机摄像头进行拍摄, 分辨率分别为640×480和720×480. 主要包括两种不同的欺骗攻击, 例如打印照片攻击和视频重放攻击.

CASIA-FASD数据集包含50个受试者, 3个场景, 其中包括150个真实视频和450个攻击视频. 所有人脸都是正面的. 该数据集被分为训练集和测试集, 比例分别为40% (20个受试者)和60% (30个受试者). 没有验证集.

Replay-Attack数据集包含50个受试者的

OULU-NPU数据集包含

本文使用PyTorch实现代码. 使用MTCNN[32]进行人脸检测. 人脸图像和深度图都被调整为256×256像素大小. 与大多数人脸活体检测算法一致, 在数据增强方面采用了常见的技术, 如颜色抖动、随机旋转和归一化.

本文提出的模型分为3个模块. 模块1对应生成对抗网络生成深度图, 模块2对应多视图特征训练和融合, 模块3为分类. 在3个模块中, 模块1的输入为人脸RGB图像和Ground Truth深度图, 输出为生成的深度图. 模块2的输入为频率图像和模块1生成的深度图, 输出为融合的多视图特征. 模块3的输入为融合的多视图特征, 输出为分类结果0或1.

模型由于分为3个模块, 且生成对抗网络较为难训练, 在训练3个数据集, 测试一个数据集所需时间较长. 在推理阶段, 由于本文使用的各模块的网络结构较为简单, 单张图像的处理时间极短, 可以满足实时性的响应. 此外, 本文还引入了在对比学习中表现良好的数据增强方法, 如随机裁剪和CutOut, 用于RGB图像的增强. 网络训练的batch size大小为25、学习率为

为了评估每个视图的贡献, 消融实验是必要的. 消融实验的协议在CASIA-FASD数据集上进行训练, 在Replay-Attack数据集上进行测试[33], 简称为C→I. 表1评估了使用单一特征(如RGB图像、低频图像和高频图像)的影响. 结果表明, 仅使用单独的频率图像会导致较差的性能, HTER值分别为25.73%、33.97%和25.72%. 通过使用注意力机制融合高频和低频特征进行研究, 得到改进的HTER值为21.5%. 最后, 在频率图像融合过程中加入RGB图像略微改进了性能, 为21.2%.

| 表 1 消融实验 |

其次, 我们检验了添加深度图特征的有效性, 得到了16.69%的HTER. 它优于单独使用高频和低频特征的效果. 接着, 我们分别探索了深度图特征与RGB图像特征、低频特征和高频特征的组合. 这些组合得到的HTER分别为16.56%、15.98%和14.25%, 超过了仅使用深度图特征的性能. 最后, 通过使用两阶段双线性特征融合所有特征, 获得了11.22%的更好实验结果. 通过添加有监督多视图对比学习获得了最佳结果, 达到了9.97%. 这些发现表明, 频率特征和深度图特征确实提高了人脸活体检测的精确度.

3.4 不同特征融合方法对比实验为了提高性能, 我们对比了几种特征融合方法. 对比实验的训练集是CASIA-FASD, 测试集是Replay-Attack, 简称为C→I. 第1种方法是引入了APM (attention perceptive module)[34]. APM利用通道注意力和空间注意力机制进行特征融合. 第2种方法与第1种方法类似, 但是频率特征与独立权重相加, 与第1种方法不同. 为频率特征和深度图特征的独立加权求和分配了两个独立的权重. 第3种方法中[24], 首先, 多分支网络通过squeeze-and-excitation (SE)模块使用通道注意力. 然后, 多个分支的输出通过连接操作进行组合. 第4种方法是直接对图像特征进行求和. 第5种方法是直接对频率特征进行求和. 由于频率特征主要用作辅助分类, 它们乘以0.5的因子然后加到深度图特征上. 第6种方法是使用两阶段双线性特征融合方法, 将近似双线性池化得到的融合特征作为最终的多视角特征. 第7种方法仍然使用两阶段双线性特征融合方法, 但是通过近似双线性池化得到的融合多视角特征被视为残差. 这些残差与最初融合的频率特征和深度图特征使用独立可学习的权重相加. 比较实验的结果如表2所示, 最佳结果是通过最终的两阶段双线性方法实现的.

| 表 2 特征融合方法对比实验 |

3.5 单一数据集实验

为了验证模型, 我们使用OULU-NPU数据集进行了内部实验, 涵盖了4个协议. 协议I评估了模型在不同场景下的性能. 协议II评估了模型对不同攻击方法的鲁棒性. 协议III考察了模型在面对不同成像设备(特别是不同手机)时的准确性. 协议IV综合了前面提到的各个类别. 它全面验证了模型在不同场景、攻击方法和成像设备下的性能. 表3呈现了对4个协议进行评估的结果. 在协议I、III和IV中, 融合频率图像和深度图像的本文模型在分类准确性的有效性上得到了确认. 协议IV涵盖了OULU-NPU中的所有不同因素. 在协议IV中取得的出色性能验证了该模型在各种环境中的综合适用性和准确性, 例如有效处理不同攻击、不同设备捕获的人脸和多样化的场景.

| 表 3 在OULU-NPU数据集上的单一数据集实验 (%) |

3.6 跨数据集实验

不同数据集之间的攻击类型、上下文和成像设备变化等客观环境是不同的. 为了评估所提出模型的泛化能力, 需要进行跨数据集的实验. 因此, 本研究采用了目前最主流的跨数据集实验协议[18]进行FAS研究.

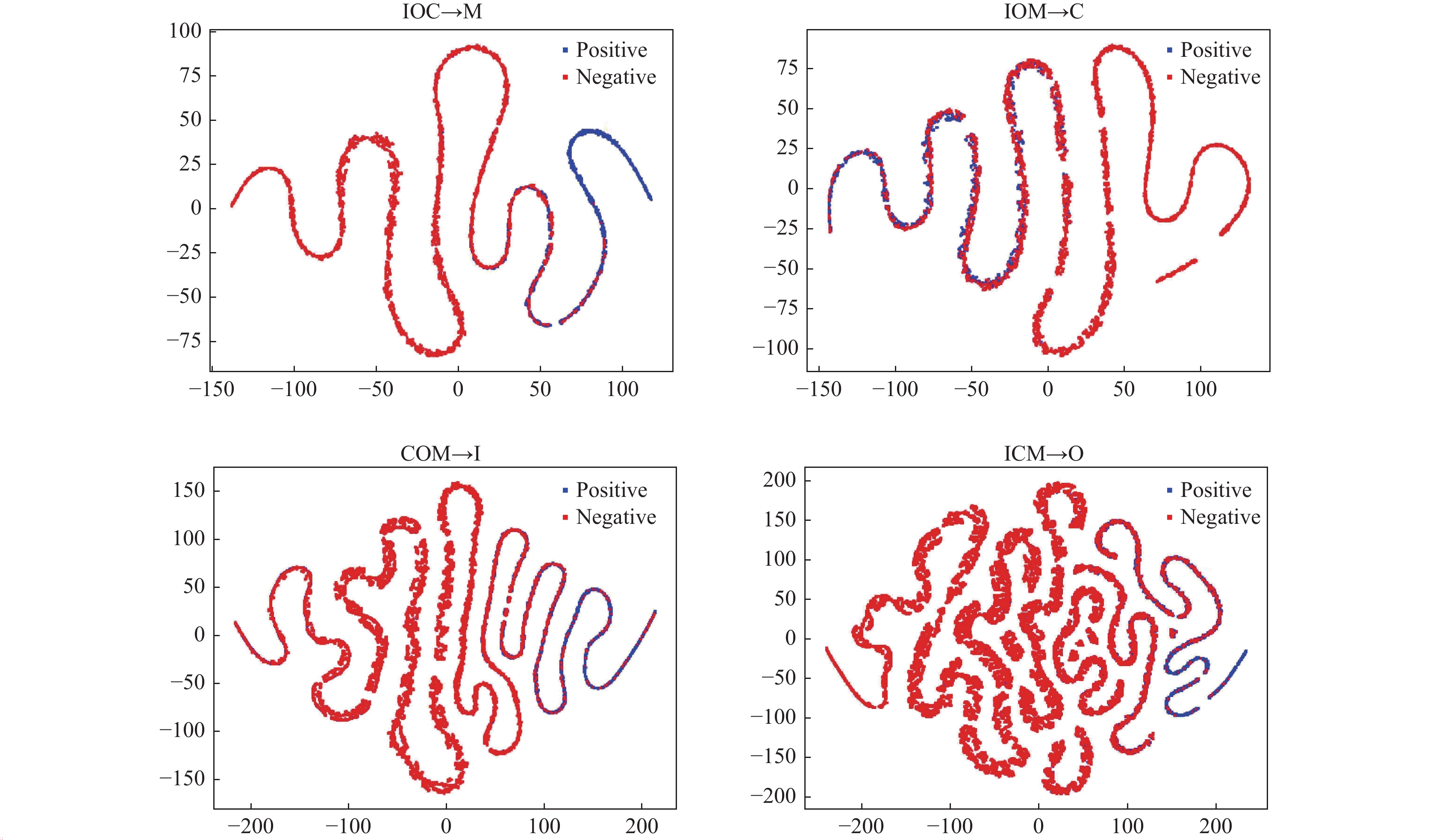

在跨数据集中, 在4个数据集中, 选择其中3个数据集进行训练, 剩余一个数据集进行测试. 这4个实验分别为IOC→M、IOM→C、COM→I和ICM→O. 我们使用半错误率HTER和曲线下面积作为这些实验的评估指标. 如表4的结果所示, 本文提出的模型在4个实验中始终优于其他多模块或者多视图方法. 结果验证了我们的模型在使用更大的数据集进行训练时的良好的泛化能力.

| 表 4 在4个公开数据集上的跨数据集实验 (%) |

3.7 可视化与分析

为了使得实验结果更加直观, 本文使用2D t-SNE[43]将跨数据集实验的4个结果进行可视化, 图4显示了跨数据集实验中的每个实验协议下的正负样本的特征分布. 图5展示了在IOC→M实验协议下的模型推理阶段, 随机真实与欺骗样本的Ground Truth深度图和模型生成的深度图. 其中绿色框架中的图像为真实样本, 红色框架中的图像为欺骗样本.

|

图 4 可视化正负样本特征分布 |

图4中, 正负样本的特征边界是分离的, 然而, 在IOM→C实验中, 由于在训练期间没有包含CASIA数据集, 尤其是CASIA数据集中的高分辨率图像, 分布边界显得模糊不清. 这表明本文所提出的模型在一定程度上依赖于数据集图像的质量. 尽管在特征融合中的权重更新中, 由于深度图的泛化能力, 提高了模型在面对未知攻击时的泛化性, 但它并没有完全解决人脸活体检测对数据集质量的依赖性. 因此, 解决数据集质量依赖问题仍然是我们未来研究的重点.

|

图 5 随机样本的Ground Truth深度图以及生成的深度图 |

4 总结

本文提出了一种多分支网络, 旨在有效融合频率特征和深度图特征, 从而提高FAS的准确性和泛化能力. 为了增强特征分布的紧凑性, 采用了有监督对比学习方法来学习多视图特征. 为了解决不同输入导致的特征不兼容问题, 提出了一种两阶段双线性特征融合方法. 为了评估所提出的模型, 本文在4个公开数据集上进行了一些消融实验, 对比实验, 单一数据集和跨数据集实验. 实验结果验证了该模型在不同场景下的准确性和泛化能力. 然而, 我们的模型仍然存在一些缺点. 例如, 图像质量对我们的分类结果有影响. 为了缓解这个问题, 未来我们计划将域泛化与本文模型相结合, 尝试训练更具有泛化能力的特征.

| [1] |

Guo JZ, Zhu XY, Zhao CX, et al. Learning meta face recognition in unseen domains. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 6162–6171.

|

| [2] |

Yu ZT, Qin YX, Li XB, et al. Deep learning for face anti-spoofing: A survey. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2023, 45(5): 5609-5631. |

| [3] |

Song X, Zhao X, Fang LJ, et al. Discriminative representation combinations for accurate face spoofing detection. Pattern Recognition, 2019, 85: 220-231. DOI:10.1016/j.patcog.2018.08.019 |

| [4] |

Asim M, Ming Z, Javed MY. CNN based spatio-temporal feature extraction for face anti-spoofing. Proceedings of the 2nd International Conference on Image, Vision and Computing. Chengdu: IEEE, 2017. 234–238.

|

| [5] |

Chen BL, Yang WH, Wang SQ. Face anti-spoofing by fusing high and low frequency features for advanced generalization capability. Proceedings of the 2020 IEEE Conference on Multimedia Information Processing and Retrieval. Shenzhen: IEEE, 2020. 199–204.

|

| [6] |

Liu YJ, Jourabloo A, Liu XM. Learning deep models for face anti-spoofing: Binary or auxiliary supervision. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 389–398.

|

| [7] |

Wang YH, Song XN, Xu TY, et al. From RGB to depth: Domain transfer network for face anti-spoofing. IEEE Transactions on Information Forensics and Security, 2021, 16: 4280-4290. DOI:10.1109/TIFS.2021.3102448 |

| [8] |

Liu YJ, Liu XM. Spoof trace disentanglement for generic face anti-spoofing. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2023, 45(3): 3813-3830. |

| [9] |

Tian YL, Krishnan D, Isola P. Contrastive multiview coding. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 776–794.

|

| [10] |

Khosla P, Teterwak P, Wang C, et al. Supervised contrastive learning. Proceedings of the 34th International Conference on Neural Information Processing Systems. Vancouver: Curran Associates Inc., 2020. 1567.

|

| [11] |

Jia YP, Zhang J, Shan SG, et al. Single-side domain generalization for face anti-spoofing. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 8481–8490.

|

| [12] |

Dai YM, Gieseke F, Oehmcke S, et al. Attentional feature fusion. Proceedings of the 2021 IEEE Winter Conference on Applications of Computer Vision. Waikoloa: IEEE, 2021. 3559–3568.

|

| [13] |

Lin TY, Dollár P, Girshick R, et al. Feature pyramid networks for object detection. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 936–944.

|

| [14] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7132–7141.

|

| [15] |

Kim JH, On KW, Lim W, et al. Hadamard product for low-rank bilinear pooling. Proceedings of the 5th International Conference on Learning Representations. Toulon: OpenReview.net, 2017.

|

| [16] |

Hu C, Feng ZH, Wu XJ, et al. Dual encoder-decoder based generative adversarial networks for disentangled facial representation learning. IEEE Access, 2020, 8: 130159-130171. DOI:10.1109/ACCESS.2020.3009512 |

| [17] |

Feng J, Dong ZY, Shi YC, et al. Domain adaptation based on ResADDA model for face anti-spoofing detection. Proceedings of the 2021 International Conference on Computer Engineering and Artificial Intelligence. Shanghai: IEEE, 2021. 295–299.

|

| [18] |

Wang Z, Wang ZH, Yu ZT, et al. Domain generalization via shuffled style assembly for face anti-spoofing. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022. 4113–4123.

|

| [19] |

Wang ZZ, Yu ZT, Zhao CX, et al. Deep spatial gradient and temporal depth learning for face anti-spoofing. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 5041–5050.

|

| [20] |

Ganin Y, Lempitsky V. Unsupervised domain adaptation by backpropagation. Proceedings of the 32nd International Conference on Machine Learning. Lille: JMLR.org, 2015. 1180–1189.

|

| [21] |

Jaiswal A, Babu AR, Zadeh MZ, et al. A survey on contrastive self-supervised learning. Technologies, 2021, 9(1): 1–22. |

| [22] |

Chen T, Kornblith S, Norouzi M, et al. A simple framework for contrastive learning of visual representations. Proceedings of the 37th International Conference on Machine Learning. Vienna: PMLR.org, 2020. 1597–1607.

|

| [23] |

Sun YY, Liu YJ, Liu XM, et al. Rethinking domain generalization for face anti-spoofing: Separability and alignment. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE, 2023. 24563–24574.

|

| [24] |

He D, He XP, Yuan R, et al. Lightweight network-based multi-modal feature fusion for face anti-spoofing. The Visual Computer, 2023, 39(4): 1423-1435. |

| [25] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 770–778.

|

| [26] |

Guo JZ, Zhu XY, Yang Y, et al. Towards fast, accurate and stable 3D dense face alignment. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 152–168.

|

| [27] |

Goodfellow I, Pouget-Abadie J, Mirza M, et al. Generative adversarial networks. Communications of the ACM, 2020, 63(11): 139-144. DOI:10.1145/3422622 |

| [28] |

Zhang ZW, Yan JJ, Liu SF, et al. A face antispoofing database with diverse attacks. Proceedings of the 5th IAPR International Conference on Biometrics. New Delhi: IEEE, 2012. 26–31.

|

| [29] |

Chingovska I, Anjos A, Marcel S. On the effectiveness of local binary patterns in face anti-spoofing. Proceedings of the 2012 International Conference of Biometrics Special Interest Group. Darmstadt: IEEE, 2012. 1–7.

|

| [30] |

Wen D, Han H, Jain AK. Face spoof detection with image distortion analysis. IEEE Transactions on Information Forensics and Security, 2015, 10(4): 746-761. DOI:10.1109/TIFS.2015.2400395 |

| [31] |

Boulkenafet Z, Komulainen J, Li L, et al. OULU-NPU: A mobile face presentation attack database with real-world variations. Proceedings of the 12th IEEE International Conference on Automatic Face & Gesture Recognition. Washington: IEEE, 2017. 612–618.

|

| [32] |

Zhang KP, Zhang ZP, Li ZF, et al. Joint face detection and alignment using multitask cascaded convolutional networks. IEEE Signal Processing Letters, 2016, 23(10): 1499-1503. DOI:10.1109/LSP.2016.2603342 |

| [33] |

Boulkenafet Z, Komulainen J, Akhtar Z, et al. A competition on generalized software-based face presentation attack detection in mobile scenarios. Proceedings of the 2017 IEEE International Joint Conference on Biometrics. Denver: IEEE, 2017. 688–696.

|

| [34] |

Liu J, Zhang FY, Zhou ZY, et al. BFMNet: Bilateral feature fusion network with multi-scale context aggregation for real-time semantic segmentation. Neurocomputing, 2023, 521: 27-40. DOI:10.1016/j.neucom.2022.11.084 |

| [35] |

Yang X, Luo WH, Bao LC, et al. Face anti-spoofing: Model matters, so does data. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 3502–3511.

|

| [36] |

Jourabloo A, Liu YJ, Liu XM. Face de-spoofing: Anti-spoofing via noise modeling. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 297–315.

|

| [37] |

Liu YJ, Stehouwer J, Liu XM. On disentangling spoof trace for generic face anti-spoofing. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 406–422.

|

| [38] |

Yu ZT, Zhao CX, Wang ZZ, et al. Searching central difference convolutional networks for face anti-spoofing. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 5294–5304.

|

| [39] |

Yang JW, Lei Z, Li SZ. Learn convolutional neural network for face anti-spoofing. arXiv:1408.5601, 2014.

|

| [40] |

de Freitas Pereira T, Komulainen J, Anjos A, et al. Face liveness detection using dynamic texture. EURASIP Journal on Image and Video Processing, 2014, 2014: 2. DOI:10.1186/1687-5281-2014-2 |

| [41] |

Shao R, Lan XY, Li JW, et al. Multi-adversarial discriminative deep domain generalization for face presentation attack detection. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 10015–10023.

|

| [42] |

Wang GQ, Han H, Shan SG, et al. Unsupervised adversarial domain adaptation for cross-domain face presentation attack detection. IEEE Transactions on Information Forensics and Security, 2021, 16: 56-69. DOI:10.1109/TIFS.2020.3002390 |

| [43] |

Cieslak MC, Castelfranco AM, Roncalli V, et al. t-distributed stochastic neighbor embedding (t-SNE): A tool for eco-physiological transcriptomic analysis. Marine Genomics, 2020, 51: 100723. DOI:10.1016/j.margen.2019.100723 |

2024, Vol. 33

2024, Vol. 33