多目标跟踪(multi-object tracking, MOT)是利用目标的空间和时间特征在整个视频序列中预测目标位置的一项任务. 多目标跟踪的目标是在图像或视频的连续帧中识别和连接多个移动目标, 同时在时间序列中保持它们的身份. 更具体地说, 多目标跟踪是获取初始检测集合、分配唯一ID并在视频帧之间跟踪它们, 同时保持分配的ID的过程. 目前, 多目标跟踪已经成为深度学习中的重要课题, 在自动驾驶等领域有着广泛应用.

在最近的研究中, 多目标跟踪任务主要遵循检测后跟踪(tracking-by-detection, TBD)范式[1–5]进行探索. TBD范式包括两个阶段: 目标检测阶段和跟踪阶段. 在目标检测阶段, 对视频帧中的目标进行定位和识别. 在跟踪阶段[6,7], 连接被检测到的目标到现有轨迹或通过建模被跟踪对象的状态变化[8,9], 并将它们与检测结果匹配, 建立新的轨迹.

与TBD范式不同, 联合检测和跟踪(joint detection and tracking, JDT)范式将目标检测阶段和跟踪阶段耦合.

尽管一些研究[10,11]表明JDT范式取得了一些进展, 但检测任务与重新识别(re-identification, ReID)任务有很大的区别, 并且JDT范式的共享功能模型可能会降低每个任务的性能. TBD范式通过将目标检测和跟踪分为两个独立的阶段, 可以更有效地利用计算资源, 适用于资源受限的环境或实时应用.

许多TBD方法在实现跟踪阶段的方式上存在差异. 跟踪阶段通常包括两个部分: (1)运动建模和状态估计. 卡尔曼滤波器(Kalman filter, KF)[12]通常是这类任务的典型选择. (2)数据关联. TBD方法通常通过逐帧匹配, 在当前帧的检测和先前存在的轨迹集之间建立一对一的关联. 解决数据关联问题, 主要有两种方法[13]: (1)定位视频帧中的目标, 使用二部图匹配算法将预测轨迹边界框和当前检测边界框的交并比(intersection of union, IoU)关联起来. (2)对目标的外观进行建模以解决ReID任务. 在跟踪阶段, Sort[1,14] 和DeepSort[3] 使用卡尔曼滤波器来估计目标状态, 并假设恒定速度模型作为帧之间的过渡函数, 是最经典且应用最广泛的算法.

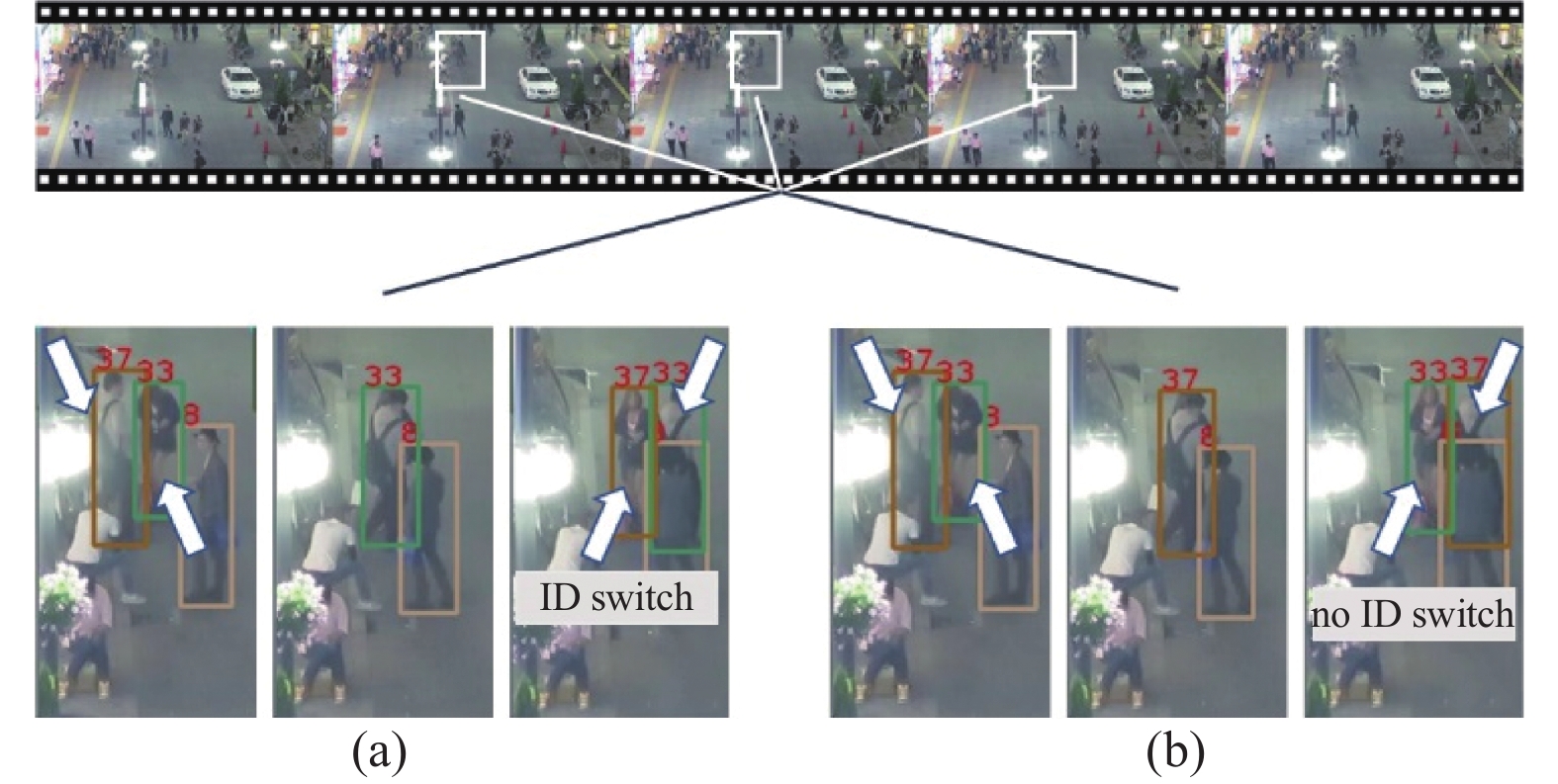

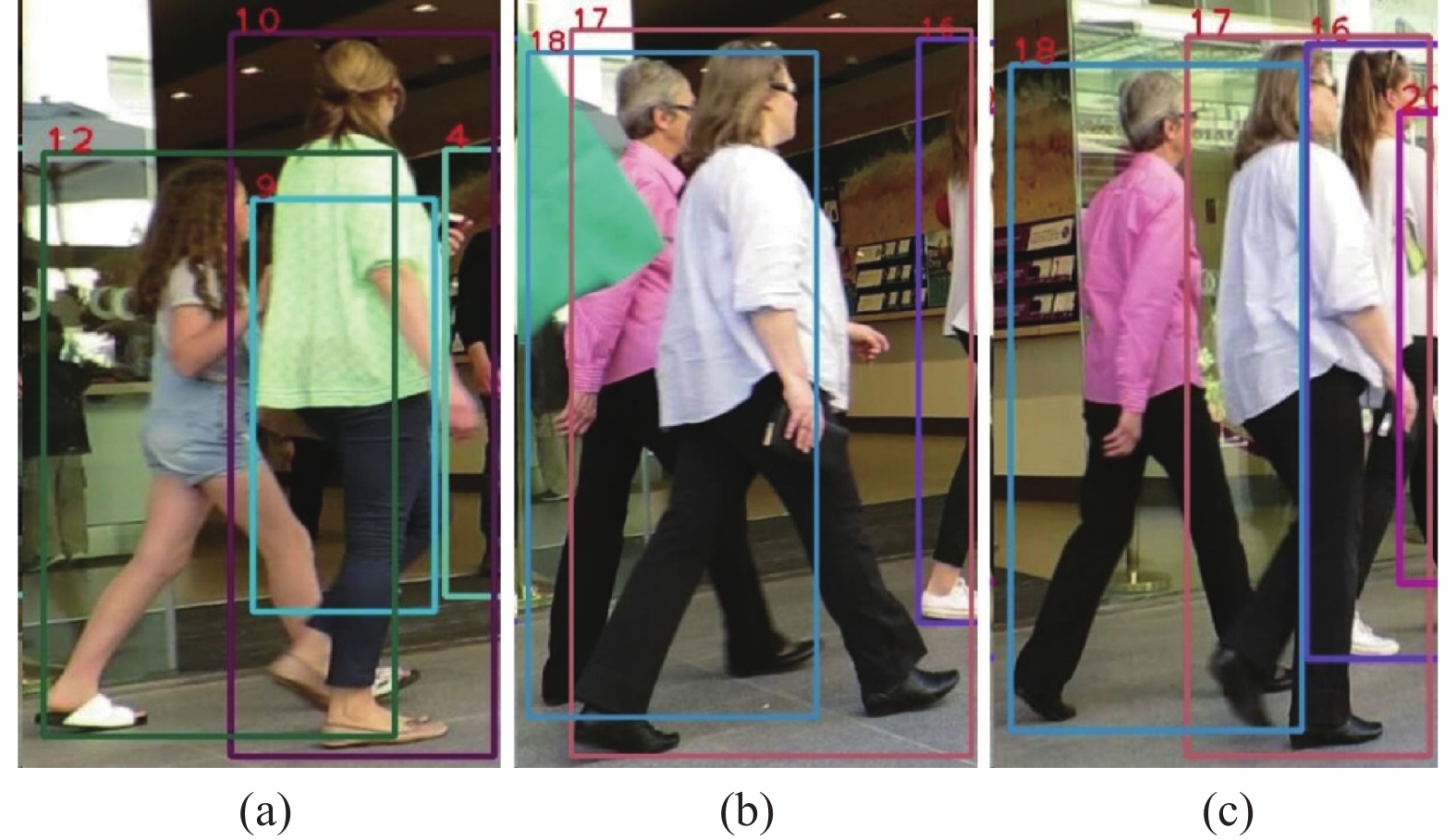

然而, Sort和DeepSort算法仍存在一些局限性. 首先, 高帧率下可以将行人移动近似为线性运动, 但也使模型对噪声更为敏感. 具体而言, 目标的运动和状态存在不确定性, 运动和状态不确定性带来的噪声在高帧率视频中被放大[14]; 另外, 传感器误差和测量过程中的干扰也会向原始模型引入噪声. 其次, Sort算法的数据关联策略不够鲁棒. Sort算法使用IoU作为相似性度量, 其性能依赖于目标检测算法的质量. Sort算法在利用基于运动的线索进行短期关联方面取得了一些成功, 但Sort算法无法在一段时间内为相同目标保持相同的身份, 导致频繁的ID切换, 如图1所示. DeepSort通过引入外观特征来恢复长时间遮挡对象的身份, 在原始IoU匹配的基础上, 它还引入级联匹配和ReID网络减少ID切换. 然而, 目标在遭受严重遮挡或强烈的外界光照变化时, DeepSort的外观嵌入模型[9]提取的外观信息变得不可靠. 此外, 许多外观追踪器采用了指数移动平均(exponential moving average, EMA)方法[15]作为特征更新策略. EMA减小了外界噪声的干扰, 然而, 在外观特征更新时, 会带来滞后性. 换句话说, EMA对当前帧的外观特征响应较慢, 导致一些高度可信的外观被忽视.

|

图 1 拥挤和遮挡场景的示例 |

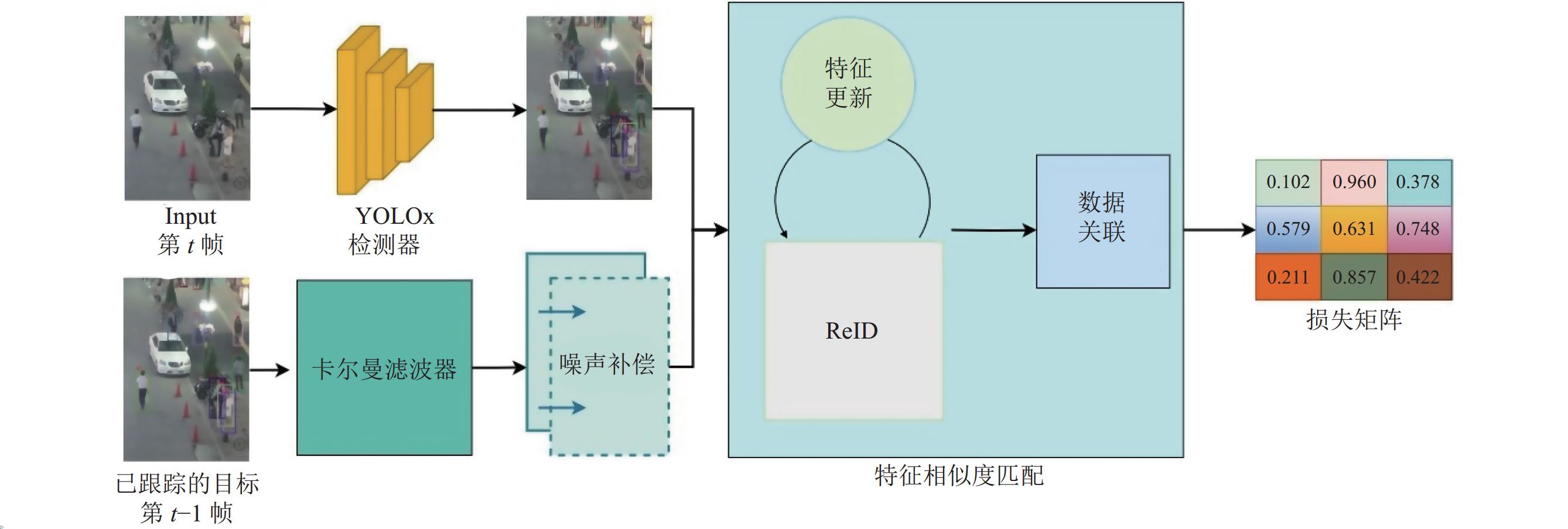

为了缓解这些局限性的影响, 本文在这项工作中提出了一些改进. 方法的流程如图2所示. 首先, 在MOT场景中的运动模型主要受到过程噪声和测量噪声的影响, 因此本文设计了一个噪声补偿模块来减小由过程和测量噪声引起的误差. 具体而言, 由于遮挡程度的变化和每个目标实例运动和状态不确定性的差异, 每个实例对噪声的敏感性在视频序列中也会有所变化, 通过动态调整过程噪声和测量噪声, 以减小噪声带来的误差, 产生更准确的预测. 其次, 为了减少由严重遮挡引起的错误匹配, 本文设计了一个新的数据关联模块. 它可以通过结合运动和外观线索来恢复长时间丢失的对象身份. 此外, 研究发现使用EMA更新特征的外观追踪器可能会忽略最近的重要外观信息, 为此, 本文提出了一个新颖的特征更新策略, 以获取更可信的外观线索并减少对当前特征的滞后.

本文提出的方法被命名为Ecsort, 主要贡献如下.

(1) 提出了一种新颖的跟踪器Ecsort, 它结合了强大的运动和外观线索, 以解决由遮挡和密集场景引起的预测误差和错误匹配问题.

(2) 在原始的运动模型上设计并添加了一个噪声补偿模块, 可以减小由场景噪声引起的模型误差, 并防止轨迹偏移, 以产生更精准的预测.

(3) 提出了一种新颖的特征更新策略, 用于学习具有判别性的外观特征. 此外, 设计了一个新的数据关联模块, 用于匹配相邻帧之间的轨迹和检测. 本文将以上两个模块集成到一个特征相似度匹配模块中, 可以在遮挡和拥挤场景中重新识别对象并恢复丢失的轨迹.

|

图 2 Ecsort的pipeline |

1 相关工作 1.1 检测后跟踪(TBD)范式

随着目标检测器[16–20]的发展, 越来越多的跟踪器利用强大的检测器实现卓越的跟踪性能[5,13]. 许多现代跟踪器遵循TBD范式, 将MOT分为两个独立的任务, 即目标检测和跟踪. 目标检测器, 如Faster R-CNN[16] 、CenterNet[17] 、SDP[21] 、DPM[22]等, 在预测目标边界框时表现出卓越的性能. 然后, 通过关联网络, 将检测结果与相邻帧之间的轨迹进行匹配. 由于检测可以直接由检测器生成, 因此, TBD范式更侧重于在跟踪阶段提高性能.

在早期的研究中, Sort采用卡尔曼滤波器生成候选边界框, 并利用匈牙利算法构建轨迹, 通过计算边界框的重叠来关联不同帧的检测结果. IoU-Tracker[2]则是将前一帧的轨迹与当前帧的检测结果相关联. 尽管这些方法简单高效, 但它们依赖于最近邻假设[23], 导致Sort和IoU-Tracker在遮挡和拥挤的场景中性能发挥较差. 一些研究致力于优化Sort一类的算法, 而不使用ReID特征以实现更好的跟踪性能. 例如, ByteTrack[5]通过利用低分检测与轨迹的相似性来提高跟踪性能, OC-Sort[14]提出了一种以观测为中心的Sort算法来解决遮挡和非线性物体运动的跟踪误差. 然而, 大多数工作[6–8,10]侧重于通过引入ReID网络来区分目标外观, 以产生更强大的预测并提高匹配的准确性[24].

1.2 运动模型大多数MOT算法采用的运动模型基于贝叶斯滤波器[25], 将运动预测视为状态估计, 通过最大化后验估计[14]来预测下一帧的状态. 经典的卡尔曼滤波器以线性恒定速度模型为假设, 是一个遵循预测-更新循环的递归贝叶斯滤波器. 鉴于其简单的特性, 许多研究利用卡尔曼滤波器来预测目标运动. 考虑到线性运动假设的局限性, 一些研究开始探索卡尔曼滤波器的更高级变体, 以增强不同方面的运动预测. 例如, 扩展卡尔曼滤波器(extended Kalman filter, EKF)[26]和无迹卡尔曼滤波器(unscented Kalman filter, UKF)[27], 它们被用来处理非线性运动. 然而, 它们仍依赖于对近似KF假设的高斯先验, 并且需要运动模式假设. 一些研究采用KF的变体, 如NSA-Kalman滤波器[13,15,28]将检测分数合并到KF中. 另一方面, 粒子滤波器[14,29]用于处理非线性运动, 但消耗大量计算资源. 因此, 粒子滤波器很少在MOT任务中被使用, 大多数采用的运动模型仍然基于卡尔曼滤波器.

1.3 外观模型为了在数据关联中实现卓越的性能, 一些工作[30–32]引入了ReID特征作为外观模型, 通过外观线索来区分对象. 在早期的工作中, DeepSort使用外观特征进行数据关联. 此后, 大多数方法倾向于通过训练复杂的外观模型来提取可靠的外观特征. MOTDT[31]通过在共享特征图上应用RoI-pooling [33]实现实时跟踪. JDE[34]在一阶段目标检测器YOLOv3[18,32]中添加了额外的ReID分支, 以减少成本计算并获得高效的ReID特征. FairMOT[9]通过共享的骨干网络学习目标的定位和外观特征, 以获得更好的外观嵌入. 最近, TransTrack[35]、TrackFormer[10]和MOTR[11]尝试利用注意力机制来跟踪对象. 尽管这些算法训练技术很先进, 但这些方法需要较高的推理计算成本. 本文提出了一种低滞后性的外观特征更新策略, 使模型在不增加推理成本的情况下, 学习物体的判别性特征.

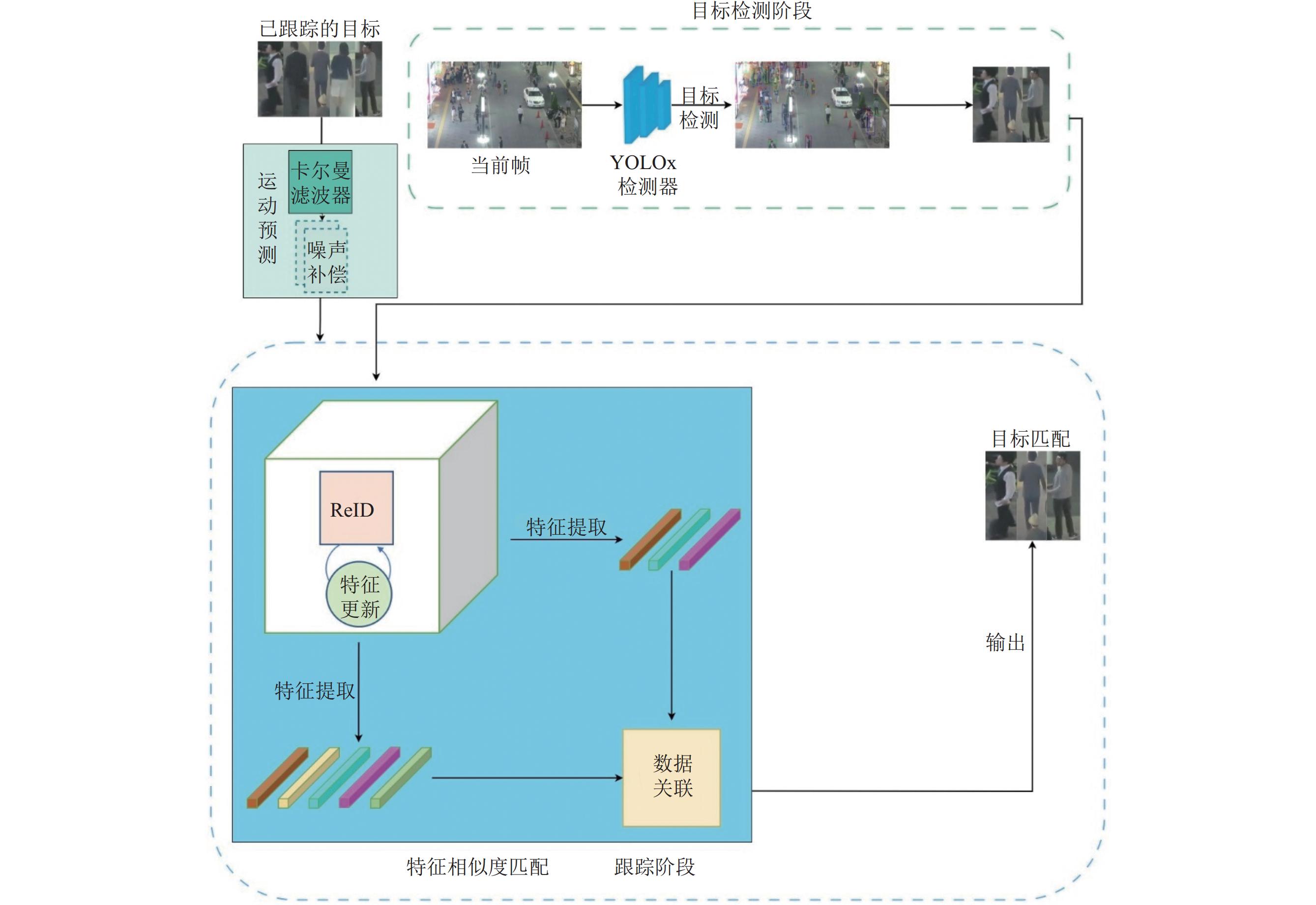

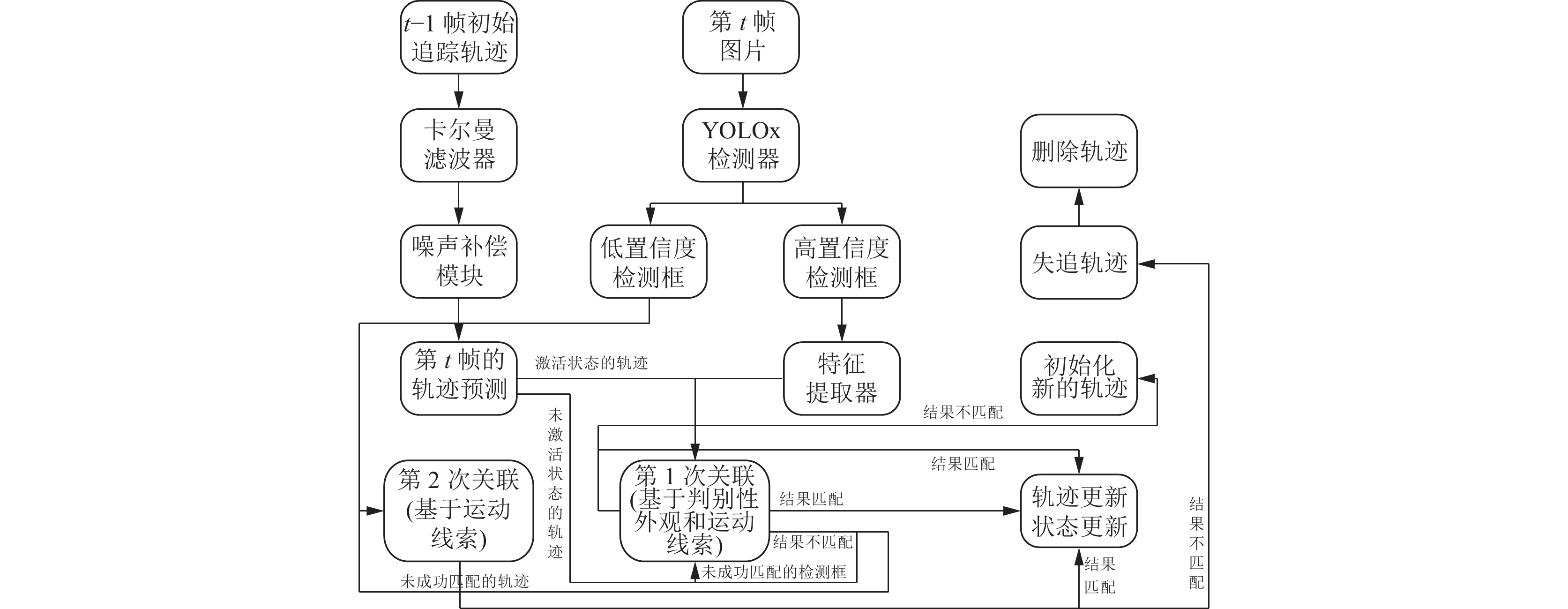

2 方法在本节中, 基于现有TBD方法的缺点进行了几项改进. 通过将这些改进引入到ByteTrack跟踪器中, 本文提出了Ecsort跟踪器, 其总体架构如图3所示, 包括目标检测和跟踪两个阶段. Ecsort算法的流程图如图4所示.

2.1 卡尔曼滤波器概述在Sort中, 状态向量被表示为一个七元组

|

图 3 Ecsort跟踪器总体架构图 |

2.2 噪声补偿模块

为了对图像中不同帧之间的目标运动进行建模, 通常使用带有恒定速度模型的卡尔曼滤波器(KF). KF通过利用依赖于前一帧和当前测量的状态估计来估计下一个时间步长的目标状态.

KF的目标是在给定测量

| $ {x_k} = {F_k}{x_{k - 1}} + {n_{k - 1}} $ | (1) |

| $ {{\textit{z}}_k} = {H_k}{x_k} + {v_k} $ | (2) |

其中,

| $ {{n}}_{{k-1}}\sim \mathcal{N}(0, {Q}_{k}) \text{, } {{v}}_{{k}}\sim \mathcal{N}(0, {R}_{k}) $ | (3) |

卡尔曼滤波器包括预测阶段和更新阶段, 遵循递归方程:

| $ {\hat{x}}_{k\mid k-1}={F}_{k}{\hat{x}}_{k-1\mid k-1} $ |

其中,

| $\left\{ \begin{split} &{P}_{k|k-1}={F}_{k}{P}_{k-1|k-1}{F}_{k}^{\top }+{Q}_{k} \\ & {K}_{k}={P}_{k|k-1}{H}_{k}^{\top }{({H}_{k}{P}_{k|k-1}{H}^{\top }_{k}+{R}_{k})}^{-1} \end{split} \right.$ | (4) |

| $\left\{ \begin{split} &{\hat{x}}_{k\mid k}={\hat{x}}_{k\mid k-1}+{K}_{k}({{\textit{z}}}_{k}-{H}_{k}{\hat{x}}_{k\mid k-1}) \\ & {P}_{k\mid k}=(I-{K}_{k}{H}_{k}){P}_{k\mid k-1} \end{split} \right.$ | (5) |

|

图 4 Ecsort算法的流程图 |

由于运动和状态的不确定性引入的过程噪声, 在高帧率视频中的连续帧之间被放大, 同时, 目标遮挡、摄像机运动和光照变化导致测量结果不太可靠, 会为运动模型引入测量噪声. 在更新阶段, 原始运动模型忽略由目标遮挡、状态和运动不确定性以及摄像机运动带来的噪声, 后验状态估计经过预测-更新循环后, 容易造成误差积累, 导致系统建模不可靠. 为了解决这些问题, 通过调整不同场景的噪声, 以获得更可靠的运动模型:

| $ {\tilde{Q}}_{k}=\left(1+\frac{\delta }{{\epsilon }_{k}}\right)\times {Q}_{k} $ | (6) |

| $ {\tilde{R}}_{k}=\gamma \times {\epsilon }_{k}^{1-\gamma }\times {R}_{k} $ | (7) |

其中,

大多数配备外观嵌入模型的跟踪器[13,15]尝试通过引入复杂的ReID网络来提取可靠的外观特征, 这在性能上带来了轻微的提高, 但使网络结构更加复杂, 牺牲了大量的计算资源和时间成本.

在最近的工作[13,15]中, 轨迹的外观嵌入是由逐帧深度检测嵌入的指数移动平均(EMA)描述的. 它需要一个平滑因子

| $ e_i^t = \alpha \times e_i^{t - 1} + (1 - \alpha )\times f_i^t $ | (8) |

其中,

然而, 标准EMA有一些局限性. EMA给予早期特征更大的权重, 过于依赖先前的特征. 同时, 它对当前特征的变化响应不及时, 并且在特征更新期间可能会忽略外观特征的短期变化, 潜在地导致重要特征信息的丢失, 这对于恢复被遮挡对象是不利的. 平滑因子的选择对EMA的性能有重要影响. 平滑因子的选择不当可能导致过度平滑或平滑不足, 从而影响外观嵌入的可靠性.

因此, 本文提出了一种新颖且高效的低滞后EMA来替代标准EMA. 首先, 通过减少先前特征的比例, 并同等增加当前特征的比例来减少EMA中的滞后. 其次, 设计一个自适应平滑因子

| $ e_i^t = {\alpha _a}\times[e_i^{t - 1} + \beta \times(f_i^t - e_i^{t - 1})] + (1 - {\alpha _a})\times sf_i^t $ | (9) |

| $ {\alpha _a} = {\alpha _c} + (1 - {\alpha _c})\times\min \left(1 - \frac{{{\delta _t} - {\delta _{t - 1}}}}{{1 - {\delta _{t - 1}}}}, 1\right) $ | (10) |

| $ \beta = \left\{ {\begin{array}{*{20}{l}} {\beta - {\psi _{\rm high}}},&{\beta > {\psi _{\rm dis}}} \\ {0.1},&{{\psi _{\rm high}} < \beta < {\psi _{\rm dis}}} \\ {0.05},&{{\psi _{\rm low}} < \beta < {\psi _{\rm high}}} \\ {0.01},&\rm{otherwise} \end{array}} \right. $ | (11) |

其中,

在最近的研究中, 一些不依赖外观的跟踪器[5,14], 例如, Sort简单地使用IoU作为相似性度量, 随着检测器的发展, 基于IoU的数据关联算法在跟踪性能上进步显著, 但它们的整体性能不如配备外观模型的跟踪器. 其次, 许多配备外观模型的跟踪器采用了外观和运动成本的一般加权和作为数据关联策略, 它们过度依赖外观并相对性地忽视了运动线索, 导致目标在外观不可靠时性能表现较差.

为了充分利用最新的多目标跟踪研究, 将外观模型集成到跟踪器Ecsort中. 外观模型基于BOT, 使用ResNet50作为主干网络.

回顾一些最近的研究, 并发现仅依赖外观特征可能不够有效甚至是无效的. 因此, 本文提出了一种新的方法, 使用余弦距离和IoU掩码将外观特征和运动线索结合作为数据关联算法. 首先, 过滤掉余弦距离和IoU距离超过给定阈值的候选对象, 仅保留余弦相似度和IoU相似度较高的候选目标. 然后, 根据余弦距离低于给定阈值且IoU距离高于给定阈值的条件将剩余候选目标分为两部分. 接下来, 对剩余划分的候选目标分别应用不同的加权和作为它们的代价矩阵. 最后, 选择每个矩阵元素中余弦距离和IoU距离的最小值作为最终成本矩阵.

| $ {d_{i, j}} = \left\{ {\begin{array}{*{20}{l}} {\zeta \times d_{i, j}^{\rm cos} + (1 - \zeta )\times d_{i, j}^{\rm iou}},&{d_{i, j}^{\rm cos} < \eta{_{\rm emb}}, \eta _{\rm iou} > d_{i, j}^{\rm iou}} \\ 1,&{d_{i, j}^{\rm cos} > \eta{_{\rm emb}}, \eta_{\rm iou} < d_{i, j}^{\rm iou}} \\ {\lambda \times d_{i, j}^{\rm cos} + (1 - \lambda )\times d_{i, j}^{\rm iou}},&{\rm otherwise} \end{array}} \right. $ | (12) |

| $ {Cos} {t_{i, j}} = \min ({d_{i, j}}, d_{i, j}^{\rm iou}) $ | (13) |

其中,

本文在典型的MOT基准测试上评估了跟踪器Ecsort: MOT17[36]和MOT20[37]数据集, 它们处于“私有检测”协议下. MOT17包括用静止和移动摄像机捕捉的视频序列, 而MOT20的场景看起来更拥挤. 两个数据集都由训练集和测试集组成, 不包含验证集. 对于消融研究, Ecsort遵循ByteTrack, 使用MOT17训练集中每个视频的前半部分进行训练, 后半部分进行验证[5,38].

评估指标: 采用广为接受的CLEAR指标[39]作为本文的评估指标. 它包含多目标跟踪精度(MOTA)、ID F1 score (IDF1)、关联精度(AssA)、检测精度(DetA)、ID switch (IDs)、高阶跟踪精度(HOTA)等.

| $ {{MOTA}} = 1 - \frac{{\displaystyle\sum {(FN + FP + IDs)} }}{{GT}} $ | (14) |

其中, GT是所有真实值的数目, MOTA基于FN、FP、IDs综合判定跟踪错误次数, 更强调检测性能, IDs与检测器稳定性相关[40].

| $ IDF1 = \frac{{2\times IDTP}}{{IDTP + IDFP + IDFN}} $ | (15) |

IDF1一般被用来评价跟踪性能[41], IDF1指标是正确关联的目标占所有真实目标和检测目标之和的比例, 其中IDTP、IDFP、IDFN指标均考虑了ID信息[42], 因此IDF1能体现目标身份维持能力[43]. 对于外观特征提取器, Ecsort采用FastReID中的SBS50模型, 对MOT17和MOT20数据集训练60 epoch的默认训练策略.

实现细节: 所有实验都在Intel(R) Xeon(R) Gold5218R CPU@2.10 GHz和NVIDIA A10 GPU上运行. 本文的基线(baseline)基于ByteTrack, 检测器采用了和ByteTrack相同的YOLOx, 来对跟踪性能进行公平的比较[1,2,28]. 本文遵循ByteTrack, 在MOT17验证集上进行消融研究. 在所有实验中, 将

|

表 1 MOT17验证集的 |

|

表 2 MOT17验证集的 |

3.2 消融实验

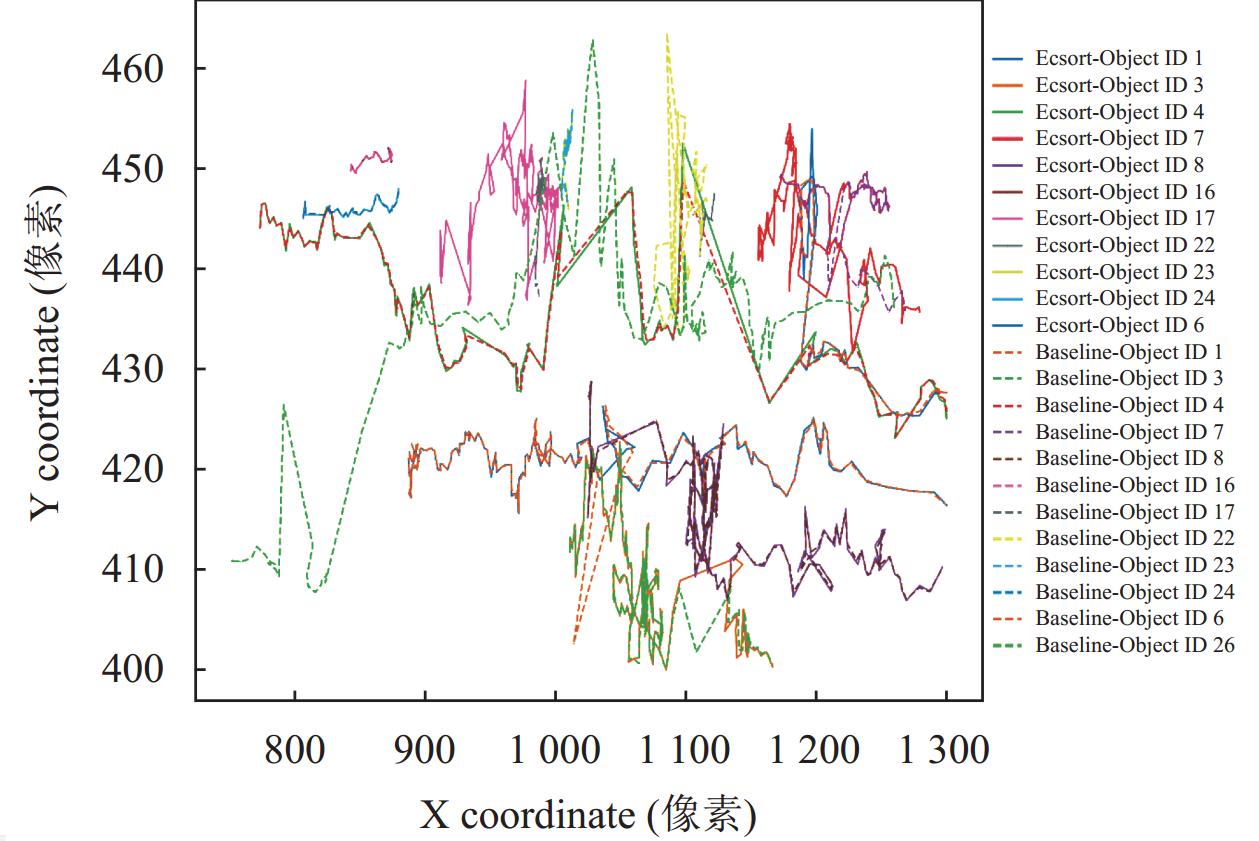

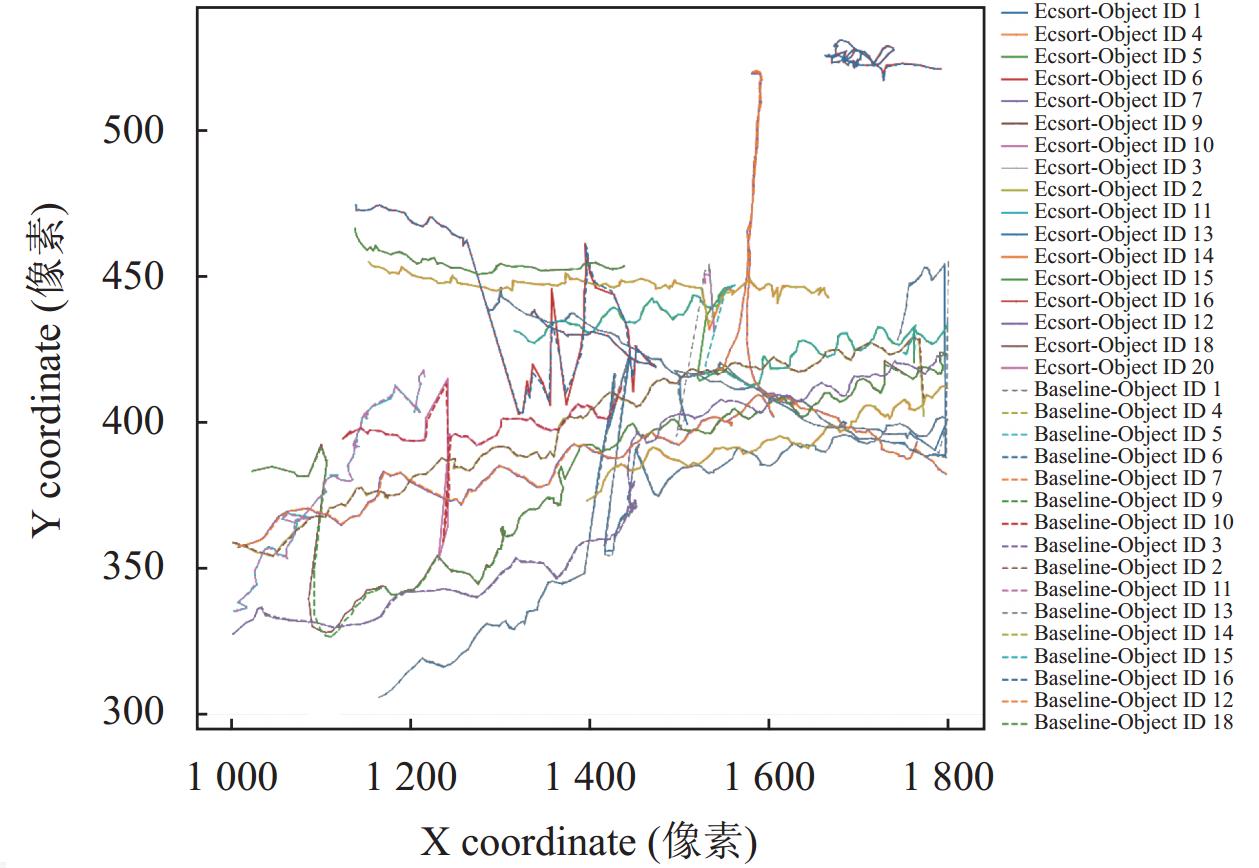

首先, 进行消融实验来验证和量化每个组成部分的贡献. 本文主要关注追踪器的性能, 所以直接使用ByteTrack的YOLOx检测器. 为了公平比较, 所有实验的跟踪参数和baseline的其他设置都是相同的. 在本节中, 验证噪声补偿模块和特征相似度匹配模块对baseline的影响. 与baseline相比, 在MOT17验证集上, 单独引入噪声补偿模块对MOTA、IDF1的性能分别提升0.1、0.8, 产生的ID switch相较于baseline减少了19, 单独引入特征相似度匹配模块对MOTA、IDF1的性能分别提升0.2、0.9, 产生的ID switch减少了20. 两个模块组合后引入对MOTA、IDF1的性能分别提升0.4、1.2, 产生的ID switch减少了29, 如表4所示. 实验结果表明噪声补偿模块和特征相似度匹配模块的引入可以实现更强大的预测和更准确的关联. 本文将部分跟踪结果的轨迹可视化, 如图5、图6所示.

|

表 3 MOT17验证集的 |

| 表 4 MOT17验证集的消融实验 |

|

图 5 MOT17-02-FRCNN 序列的轨迹比较 |

3.3 实验分析

噪声补偿模块分析. 卡尔曼滤波器使用线性运动模型来预测物体轨迹在下一帧中的位置. 然而, MOT场景中包含由行人状态和运动的不确定性、摄像机运动和光照变化引起的噪声, 受这些噪声的影响, 原始卡尔曼滤波器的运动模型容易造成误差累积, 产生不可靠的预测结果. 如图7所示, 原始卡尔曼滤波器预测视频序列下一帧目标轨迹的位置时, 它通常会导致轨迹边界框发生偏移, 例如图7中, (a)中ID为13的行人、(b)中ID为20的行人和(c)中ID为23的行人, 上一帧预测产生的边界框没有完整的覆盖当前帧的目标, 这将为IoU关联引入误差, 从而导致IoU关联不准确, 也会影响目标的特征提取. 为此, Ecsort入了噪声补偿模块, 以减少噪声引起的模型误差, 产生更准确的预测. 表4显示了噪声补偿模块的影响. 本文将表4的结果部分可视化, 如图8所示, 添加噪声补偿模块后的卡尔曼滤波器能产生更精准的预测. 实验结果和可视化结果表明, 噪声补偿模块可以减少轨道边界框的偏移, 并能产生更准确的预测.

|

图 6 MOT17-09-FRCNN 序列的轨迹比较 |

|

图 7 原始卡尔曼滤波器预测目标轨迹位置的结果 |

特征相似度匹配模块分析. 基于IoU的方法通常被用于解决拥挤和遮挡问题, 但这些方法通常会导致遮挡场景中频繁的ID switch, 如图9中(a1)–(d1)所示, 在发生拥挤和遮挡时, (a1)中ID为30的行人在经过数帧后ID切换成了34, (b1)中ID为13和25的行人由原来的ID切换成了36和13, (c1)中ID为71的行人由原来的ID变换成67, (d1)中ID为37和33的行人由原来的ID切换成了33、37. 而Ecsort通过学习物体的判别性外观和运动线索来解决遮挡和拥挤场景, 将有效减少ID切换, 例如图9中(a2)–(d2)所示.

|

图 8 添加噪声补偿后预测目标轨迹位置的结果 |

|

图 9 对比是否使用外观线索对跟踪性能的影响 |

本文对传统的IoU方法和Ecsort在处理遮挡问题方面的能力进行了比较, 可视化结果如图9所示, 实验证明了特征相似度匹配模块的有效性. 此外, 本节对特征相似度匹配模块做了消融研究, 实验表明特征更新和数据关联模块在MOTA和IDF1指标方面都提高了性能, 都有效减少了ID switch, 结果如表5所示. 本文将表4 的结果部分可视化, 如图9所示. 图9(a1)–(d1), 采用运动线索(IoU)用于将当前检测与历史轨迹相匹配, 产生了ID switch; 图9(a2)–(d2), 使用特征相似度匹配模块学习目标的判别性外观特征和运动线索, 有效避免了ID switch. 可视化结果证明了特征相似度匹配模块提高了目标身份关联性能, 可以有效解决拥挤和遮挡场景下身份关联错误问题.

| 表 5 MOT17验证集特征相似度匹配模块的消融实验 |

3.4 基准评价

本文将Ecsort与最先进的跟踪器在MOT17和MOT20测试集上进行比较, 所有结果都来自官方的MOTChallenge服务器, 结果如表6–表9所示.

MOT17测试集的结果: 如表6、表7所示, Ecsort在许多主要指标(如IDF1、HOTA、AssA和DetA)上优于所有最先进的跟踪器. 与TBD范式的跟踪器相比, 跟踪器Ecsort在IDF1、HOTA、AssA、DetA、IDs性能指标方面表现最好; 与JDT范式的跟踪器相比, Ecsort在MOTA、IDF1、HOTA、AssA、DetA性能指标方面表现更加优异. 与基线跟踪器ByteTrack相比, 在MOT17测试集上, Ecsort在IDF1、HOTA、AssA、DetA方面的性能分别提高了1.1%、0.5%、0.6%、0.3%, 产生的ID switch减少了645, 测试集的稳定提升证明了所提方法的鲁棒性.

| 表 6 在MOT17测试集上与TBD范式的跟踪方法对比 |

MOT20测试集的结果: MOT20被认为是难度更高、更复杂的基准测试, 与MOT17相比, MOT20的拥挤和闭塞场景更为严重. 如表8、表9所示, 在这个更具挑战性的场景中, 与TBD范式相比, Ecsort在IDF1、HOTA、AssA、DetA性能指标方面排名第一; 与JDT范式相比, Ecsort在所有性能指标方面都有明显领先. 与基线ByteTrack相比, Ecsort在IDF1, HOTA, AssA, DetA性能方面分别提高了2.3%, 1.9%, 3.4%, 0.2%, 测试集的稳定提升证明了所提方法的鲁棒性.

| 表 7 在MOT17测试集上与JDT范式的跟踪方法对比 |

| 表 8 在MOT20测试集上与TBD范式的跟踪方法对比 |

| 表 9 在MOT20测试集上与JDT范式的跟踪方法对比 |

4 结论

本文提出了Ecsort算法来处理多目标跟踪问题. 通过学习目标的判别性外观特征和运动线索来处理噪声干扰、拥挤和遮挡问题, 减少多目标跟踪中预测不准确、外观不可靠、关联错误现象的发生. 噪声补偿模块的引入可以减小由场景噪声引起的模型误差, 提高预测精度, 防止了轨道偏移. 特征相似度匹配模块的引入带来了更鲁棒的外观和更准确的数据关联. MOT17和MOT20数据集上的结果表明了Ecsort的有效性和鲁棒性. 未来的工作针对如何在保证提升精度和稳定性的同时, 提升跟踪器的速度, 达到实时性跟踪这一方面进行研究.

| [1] |

Bewley A, Ge ZY, Ott L, et al. Simple online and realtime tracking. Proceedings of the 2016 IEEE International Conference on Image Processing. Phoenix: IEEE, 2016. 3464–3468.

|

| [2] |

Bochinski E, Eiselein V, Sikora T. High-speed tracking-by-detection without using image information. Proceedings of the 14th IEEE International Conference on Advanced Video and Signal Based Surveillance. Lecce: IEEE, 2017. 1–6.

|

| [3] |

Wojke N, Bewley A, Paulus D. Simple online and realtime tracking with a deep association metric. Proceedings of the 2017 IEEE International Conference on Image Processing. Beijing: IEEE, 2017. 3645–3649.

|

| [4] |

Yu FW, Li WB, Li QQ, et al. POI: Multiple object tracking with high performance detection and appearance feature. Proceedings of the 2016 Computer Vision—ECCV 2016 Workshops. Amsterdam: Springer, 2016. 36–42.

|

| [5] |

Zhang YF, Sun PZ, Jiang Y, et al. ByteTrack: Multi-object tracking by associating every detection box. Proceedings of the 17th European Conference on Computer Vision. Tel Aviv: Springer, 2022. 1–21.

|

| [6] |

Wang YH, Hsieh JW, Chen PY, et al. SMILEtrack: Similarity learning for occlusion-aware multiple object tracking. arXiv:2211.08824, 2022.

|

| [7] |

Cai JR, Xu MZ, Li W, et al. MeMOT: Multi-object tracking with memory. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022. 8090–8100.

|

| [8] |

Brasó G, Leal-Taixé L. Learning a neural solver for multiple object tracking. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 6247–6257.

|

| [9] |

Zhang YF, Wang CY, Wang XG, et al. FairMOT: On the fairness of detection and re-identification in multiple object tracking. International Journal of Computer Vision, 2021, 129(11): 3069-3087. DOI:10.1007/s11263-021-01513-4 |

| [10] |

Meinhardt T, Kirillov A, Leal-Taixé L, et al. TrackFormer: Multi-object tracking with Transformers. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022. 8844–8854.

|

| [11] |

Zeng FG, Dong B, Zhang Y, et al. MOTR: End-to-end multiple-object tracking with Transformer. Proceedings of the 17th European Conference on Computer Vision. Tel Aviv: Springer, 2022. 659–675.

|

| [12] |

Welch GF. Kalman filter. In: Ikeuchi K, ed. Computer Vision: A Reference Guide. Cham: Springer, 2020. 1–3.

|

| [13] |

Aharon N, Orfaig R, Bobrovsky BZ. BoT-SORT: Robust associations multi-pedestrian tracking. arXiv:2206.14651, 2022.

|

| [14] |

Cao JK, Pang JM, Weng XS, et al. Observation-centric SORT: Rethinking SORT for robust multi-object tracking. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE, 2023. 9686–9696.

|

| [15] |

Du YH, Zhao ZC, Song Y, et al. StrongSORT: Make DeepSORT great again. IEEE Transactions on Multimedia, 2023, 25: 8725-8737. DOI:10.1109/TMM.2023.3240881 |

| [16] |

Ren SQ, He KM, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks. Proceedings of the 28th International Conference on Neural Information Processing Systems. Montreal: MIT Press, 2015. 91–99.

|

| [17] |

Duan KW, Bai S, Xie LX, et al. CenterNet: Keypoint triplets for object detection. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 6569–6578.

|

| [18] |

Redmon J, Farhadi A. YOLOv3: An incremental improvement. arXiv:1804.02767, 2018.

|

| [19] |

Bochkovskiy A, Wang CY, Liao HYM. YOLOv4: Optimal speed and accuracy of object detection. arXiv:2004.10934, 2020.

|

| [20] |

Ge Z, Liu ST, Wang F, et al. YOLOx: Exceeding YOLO series in 2021. arXiv:2107.08430, 2021.

|

| [21] |

Yang F, Choi W, Lin YQ. Exploit all the layers: Fast and accurate CNN object detector with scale dependent pooling and cascaded rejection classifiers. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 2129–2137.

|

| [22] |

Felzenszwalb P, McAllester D, Ramanan D. A discriminatively trained, multiscale, deformable part model. Proceedings of the 2008 IEEE Conference on Computer Vision and Pattern Recognition. Anchorage: IEEE, 2008. 1–8.

|

| [23] |

Liang C, Zhang ZP, Zhou X, et al. Rethinking the competition between detection and ReID in multiobject tracking. IEEE Transactions on Image Processing, 2022, 31: 3182-3196. DOI:10.1109/TIP.2022.3165376 |

| [24] |

Qin Z, Zhou SP, Wang L, et al. MotionTrack: Learning robust short-term and long-term motions for multi-object tracking. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE, 2023. 17939–17948.

|

| [25] |

Gurajala R, Choppala PB, Meka JS, et al. Derivation of the Kalman filter in a Bayesian filtering perspective. Proceedings of the 2nd International Conference on Range Technology. Chandipur: IEEE, 2021. 1–5.

|

| [26] |

Yang SS, Baum M. Extended Kalman filter for extended object tracking. Proceedings of the 2017 IEEE International Conference on Acoustics, Speech and Signal Processing. New Orleans: IEEE, 2017. 4386–4390.

|

| [27] |

Menegaz HMT, Ishihara JY, Borges GA, et al. A systematization of the unscented Kalman filter theory. IEEE Transactions on Automatic Control, 2015, 60(10): 2583-2598. DOI:10.1109/TAC.2015.2404511 |

| [28] |

Du YH, Wan JF, Zhao YY, et al. GIAOTracker: A comprehensive framework for MCMOT with global information and optimizing strategies in VisDrone 2021. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision Workshops. Montreal: IEEE, 2021. 2809–2819.

|

| [29] |

Jinan R, Raveendran T. Particle filters for multiple target tracking. Procedia Technology, 2016, 24: 980-987. DOI:10.1016/j.protcy.2016.05.215 |

| [30] |

Seidenschwarz J, Brasó G, Serrano VC, et al. Simple cues lead to a strong multi-object tracker. Proceedings of the 2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver: IEEE, 2023. 13813–13823.

|

| [31] |

Chen L, Ai HZ, Zhuang ZJ, et al. Real-time multiple people tracking with deeply learned candidate selection and person re-identification. Proceedings of the 2018 IEEE International Conference on Multimedia and Expo. San Diego: IEEE, 2018. 1–6.

|

| [32] |

Wang Q, Zheng Y, Pan P, et al. Multiple object tracking with correlation learning. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 3876–3886.

|

| [33] |

Girshick R. Fast R-CNN. Proceedings of the 2015 IEEE International Conference on Computer Vision. Santiago: IEEE, 2015. 1440–1448.

|

| [34] |

Wang ZD, Zheng L, Liu YX, et al. Towards real-time multi-object tracking. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 107–122.

|

| [35] |

Sun PZ, Cao JK, Jiang Y, et al. TransTrack: Multiple object tracking with Transformer. arXiv:2012.15460, 2020.

|

| [36] |

Milan A, Leal-Taixe L, Reid I, et al. MOT16: A benchmark for multi-object tracking. arXiv:1603.00831, 2016.

|

| [37] |

Dendorfer P, Rezatofighi H, Milan A, et al. MOT20: A benchmark for multi object tracking in crowded scenes. arXiv:2003.09003, 2020.

|

| [38] |

Zhou XY, Koltun V, Krähenbühl P. Tracking objects as points. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 474–490.

|

| [39] |

Weng XS, Wang JR, Held D, et al. 3D multi-object tracking: A baseline and new evaluation metrics. Proceedings of the 2020 IEEE/RSJ International Conference on Intelligent Robots and Systems. Las Vegas: IEEE, 2020. 10359–10366.

|

| [40] |

秦泽宇, 黄进, 杨旭, 等. 基于注意力机制和卡尔曼滤波的多目标跟踪. 计算机系统应用, 2021, 30(12): 128-138. DOI:10.15888/j.cnki.csa.008214 |

| [41] |

Ristani E, Solera F, Zou R, et al. Performance measures and a data set for multi-target, multi-camera tracking. Proceedings of the 2016 European Conference on Computer Vision. Amsterdam: Springer, 2016. 17–35.

|

| [42] |

王林, 郑有玲. 结合孪生网络重检的长期目标跟踪算法. 计算机系统应用, 2022, 31(4): 188-195. DOI:10.15888/j.cnki.csa.008425 |

| [43] |

Bergmann P, Meinhardt T, Leal-Taixé L. Tracking without bells and whistles. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 941–951.

|

2024, Vol. 33

2024, Vol. 33