当成像设备在夜间或低光环境中捕获图像时, 捕获的图像可能会出现内容模糊、可视性差和颜色丢失等问题. 这些问题不仅阻碍了人类对捕获图像数据的感知, 而且影响了计算机视觉中图像预处理和特征识别的后续阶段, 给现代工业智能应用带来了挑战. 为了减轻这些影响, 许多学者已经提出了不同算法来增强暗图像.

当人们在低光环境下拍摄照片时, 通常依靠人工照明或开启相机闪光灯的方法进行, 其他外部条件保持不变. 因此, 在同一环境下, 打光后的图像与不打光图像的亮度和图像呈现效果有很大差别. 鉴于此, RelightGAN暗图像增强网络使用卷积网络代替手动照明过程, 进而点亮暗图像, 该网络的目的是从正常图像中分离出照光层, 同时保留图像本身有用的颜色信息, 然后与暗图像融合, 该方法摆脱了各种图像参数设置的限制, 从周围环境的角度考虑图像恢复. 特殊的双判别器的循环结构为网络提供两组内容损失和对抗性损失, 两组损失函数共同作用于一个生成器, 指导其生成最佳的光照层图像. 通过测试, 可以证明RelightGAN暗图像增强网络对来自不同领域的真实低光图像增强具有良好的适应性.

本文的主要贡献概括如下: 1) 提出了一个新的假设, 并将其应用于暗图像增强领域. 基于生成对抗网络设计了一种用于暗图像增强的网络RelightGAN; 2) 设计特殊的双判别器循环结构约束生成器, 与使用单个判别器相比, 能够生成更有效的光照层图像; 3) 为了使增强后的图像保留更多的关键信息, 向传统的ResNet网络结构中加入注意力机制(CBAM), 设计出新型的残差结构CBAM-Res. RelightGAN增强暗图像的方法保留了原始图像的固有属性, 避免了其他算法在增强过程中遇到的色彩失真、对比度降低和明显噪声等常见问题. 实验证明与当前较流行的暗图像增强算法和网络相比, RelightGAN网络能够实现更好的暗图像恢复效果.

1 研究现状通常用于处理暗图像的方法可以分为传统算法和基于深度学习的神经网络方法两大类. 传统的图像增强算法是从暗图像本身入手对图像直接增强, 使处理后的图像具有更高的对比度, 以此达到增强暗图像的目的, 例如直方图均衡化(histogram equalization, HE)[1]、拉普拉斯算法[2,3]、对数LOG算子[4–6], 此类方法鲁棒性较差, 易出现颜色失真的问题, 且增强后的图像边缘信息会丢失. Retinex理论以颜色恒常性(色感一致性)为基础提出, 该理论将图像分解为反射分量和光照分量, 由此发展形成两种传统方法: 单尺度 Retinex (SSR)[7]通过高斯滤波器估计光照分量、多尺度 Retinex (MSRCR)[8]在SSR的基础上引入不同尺度高斯滤波和颜色恢复因子, 获得所估计照度图像. 王以涵等人[9]利用低秩矩阵估计实现了对Retinex模型分解出的反射层的噪声一致, 进一步以光照层为引导进行图像融合保留图像原有细节. 虽然上述方法在一定程度上都能解决暗图像质量低的问题, 且能得到较好的亮度和颜色保留度, 但是算法的适应性不强, 应用场景有限.

基于深度学习的方法适应性较强. Wei等人[10]基于Retinex理论提出RetinexNet, 首先对暗图像分解, 将其分为光照层和反射层, 通过增强光照层, 将其与分离出的反射层图像相结合实现暗图像增强. Wang等人[11]结合注意力机制和Retinex算法提出CA&R网络来增强暗图像. 神经网络训练最重要的是训练数据集的质量, 而成对的明暗图像采集几乎是不可能的, 大多数网络采用的是合成数据集, 这也限制了网络增强暗图像后的效果. 随着生成式对抗网络(GAN)逐渐成为学术界研究热点, Guo等人[12] 提出零参考深度曲线估计的方法将光照增强问题转化为使用深度网络对特定图像曲线的估计问题. GANs在图像合成和图像转换方向上得到了快速的发展, 近几年, 利用生成式对抗网络增强暗图像的方法也逐渐被提出. Jiang等人[13]提出无监督生成对抗网络EnlightenGAN, 不需要成对数据集训练, 利用自正则感知损失来约束生成器, 减小暗图像与正常图像之间的特征距离. 无监督学习虽然解决了成对数据集获取的难题, 诸如稳定训练、颜色失真、跨域信息相关性等问题仍然存在. 因此通过改变暗图像本身的物理性质同时恢复暗图像亮度、对比度、饱和度、锐化、分辨率是极其困难的. 而且将暗图像完全转变为正常图像也是不可能实现的.

2 研究方法 2.1 RelightGAN 网络原理在RelightGAN网络中, 依据观察到的暗环境下打光后的图像与不打光的图像成像差异性, 提出一个假设, 即打光后的图像是由不打光图像和一个亮光层融合而成. 将暗图像

| IL=Lnor+Llow | (1) |

其中,

| L′nor=IL+Llow | (2) |

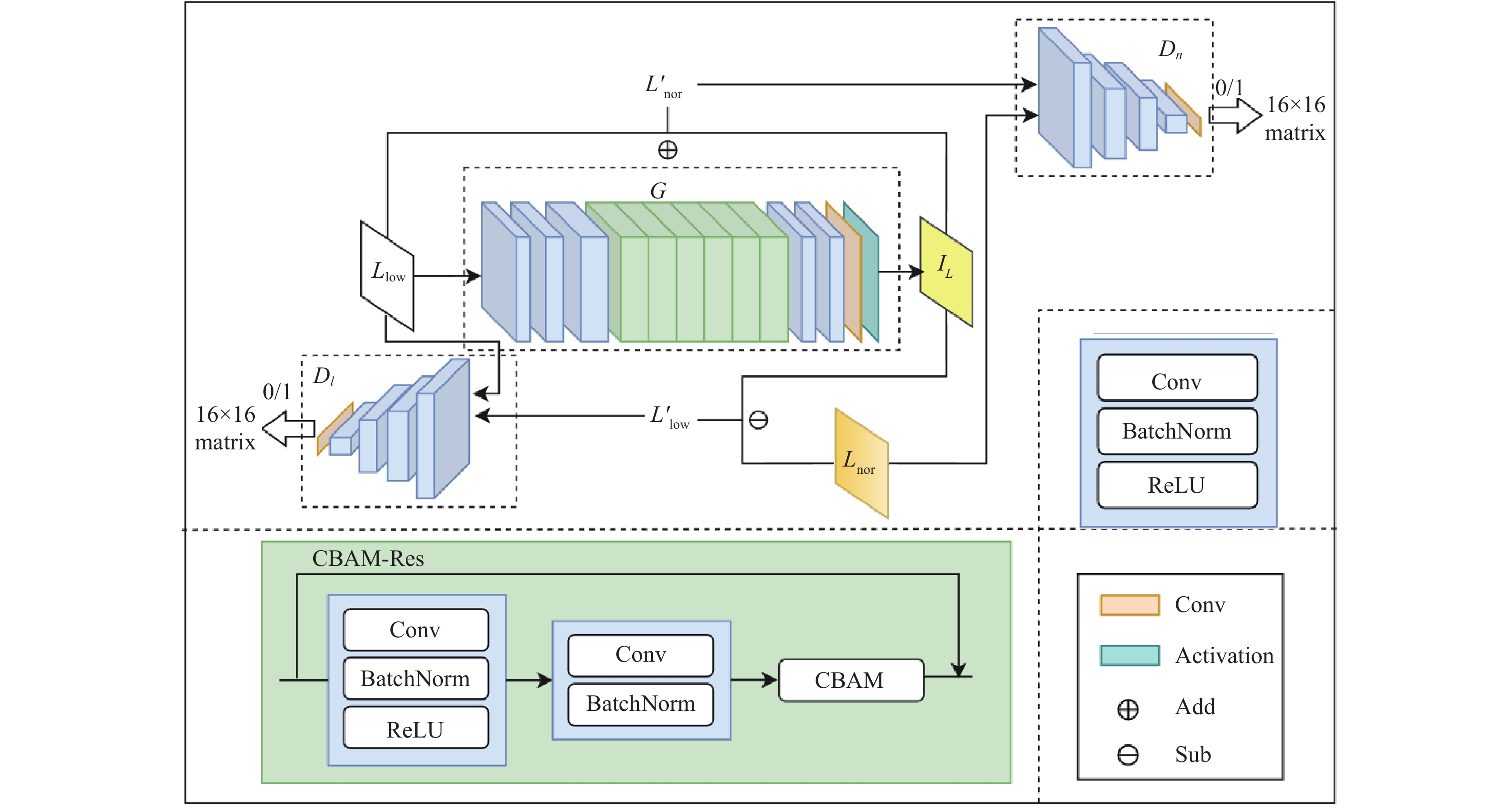

RelightGAN网络结构如图1所示. 采用双判别器的循环结构, 网络以

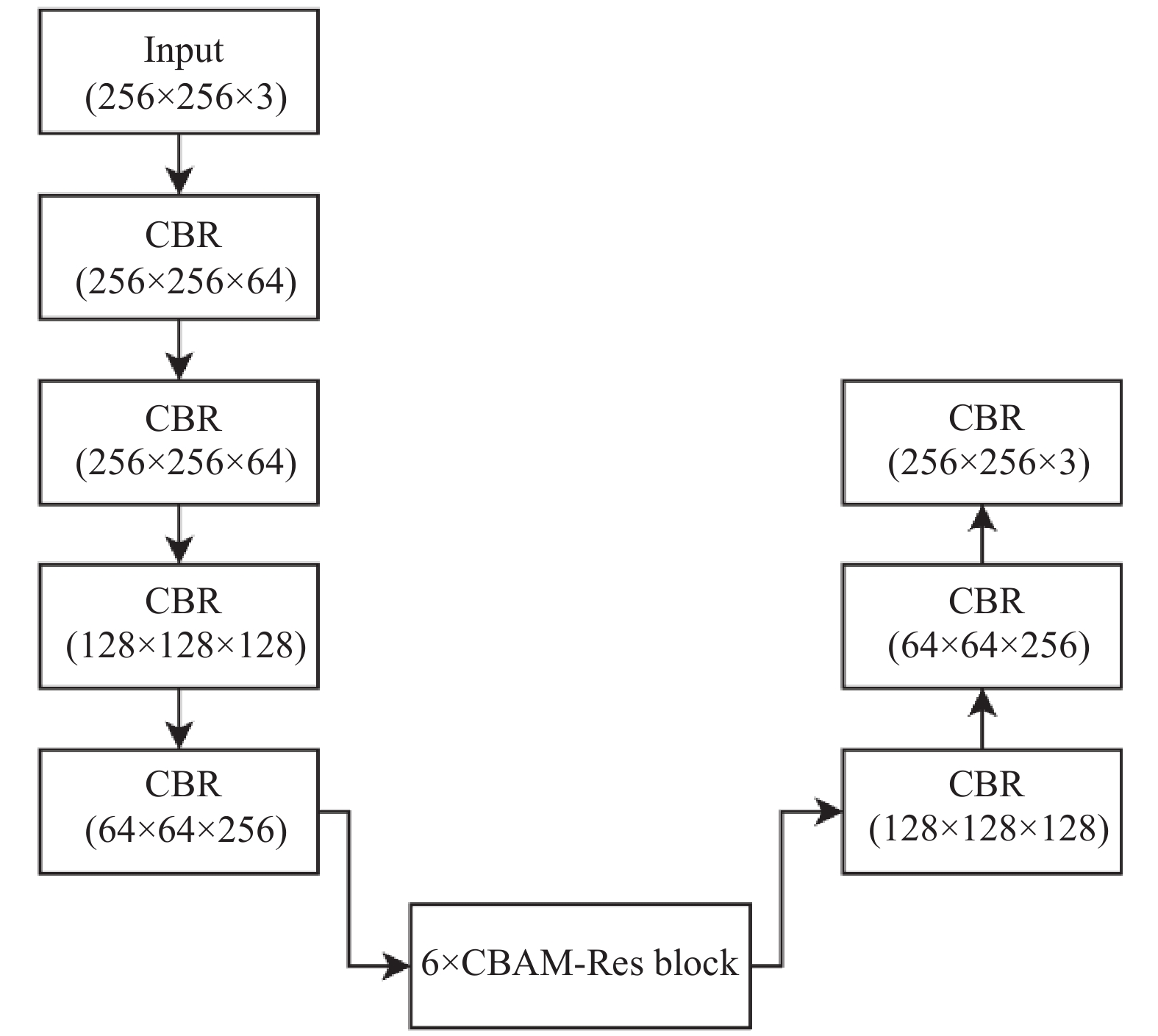

生成器G的网络层结构如图2所示, 由6个卷积层和6个残差块组成, 每个ResBlock包含两个卷积操作, 提供更大的接受域, 并防止梯度消失问题. 其中CBR表示卷积层、归一化层和ReLU组合.

|

图 1 RelightGAN网络结构 |

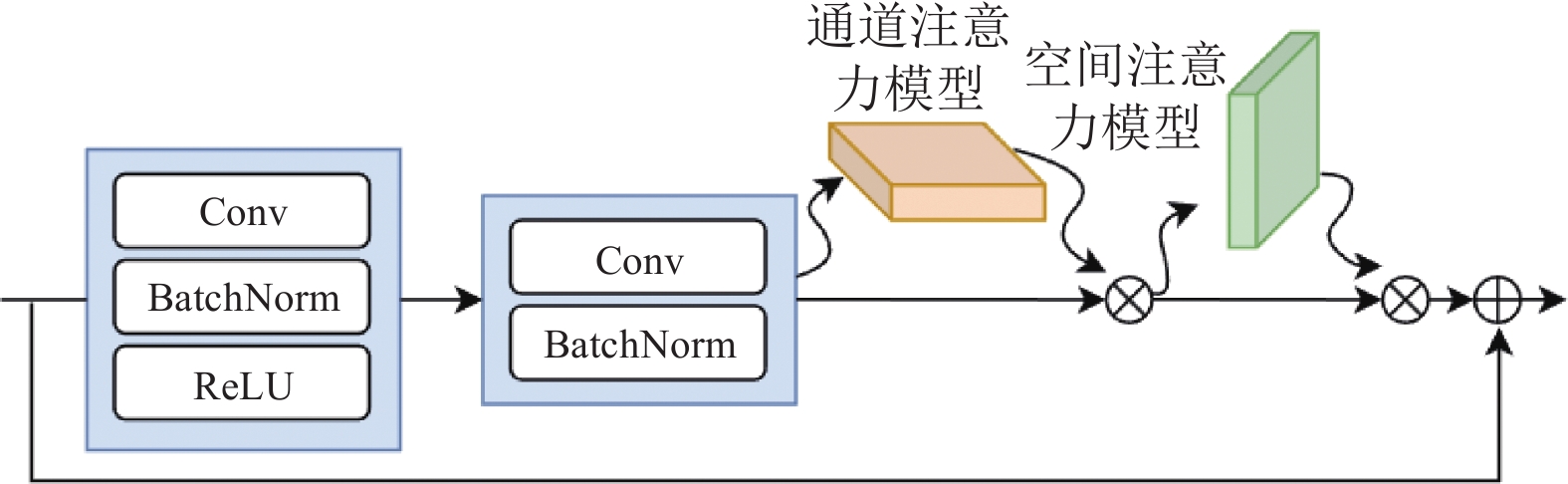

初始的残差结构在生成图像时容易受到其他因素的影响, 生成的图像中会产生伪影, 缺乏足够的关键信息还原能力. 为了解决这一问题, 在生成器的ResBlock中引入混合注意力机制CBAM模块构建CBAM-Res结构. CBAM是一个由空间注意机制和通道注意机制组成的注意力机制模型. CBAM-Res结构如图3所示, 引入的CBAM-Res模块利用通道注意力机制为每个通道的特征分配权重, 使得网络能够优先考虑重要的特征层, 并最大限度地减少来自次要通道的冗余信息对图像生成的影响. 通过在残差块中串联两个注意力模块, 生成器网络可以更有效地提取和表达重要特征, 抑制不重要的特征, 提高生成图像的质量.

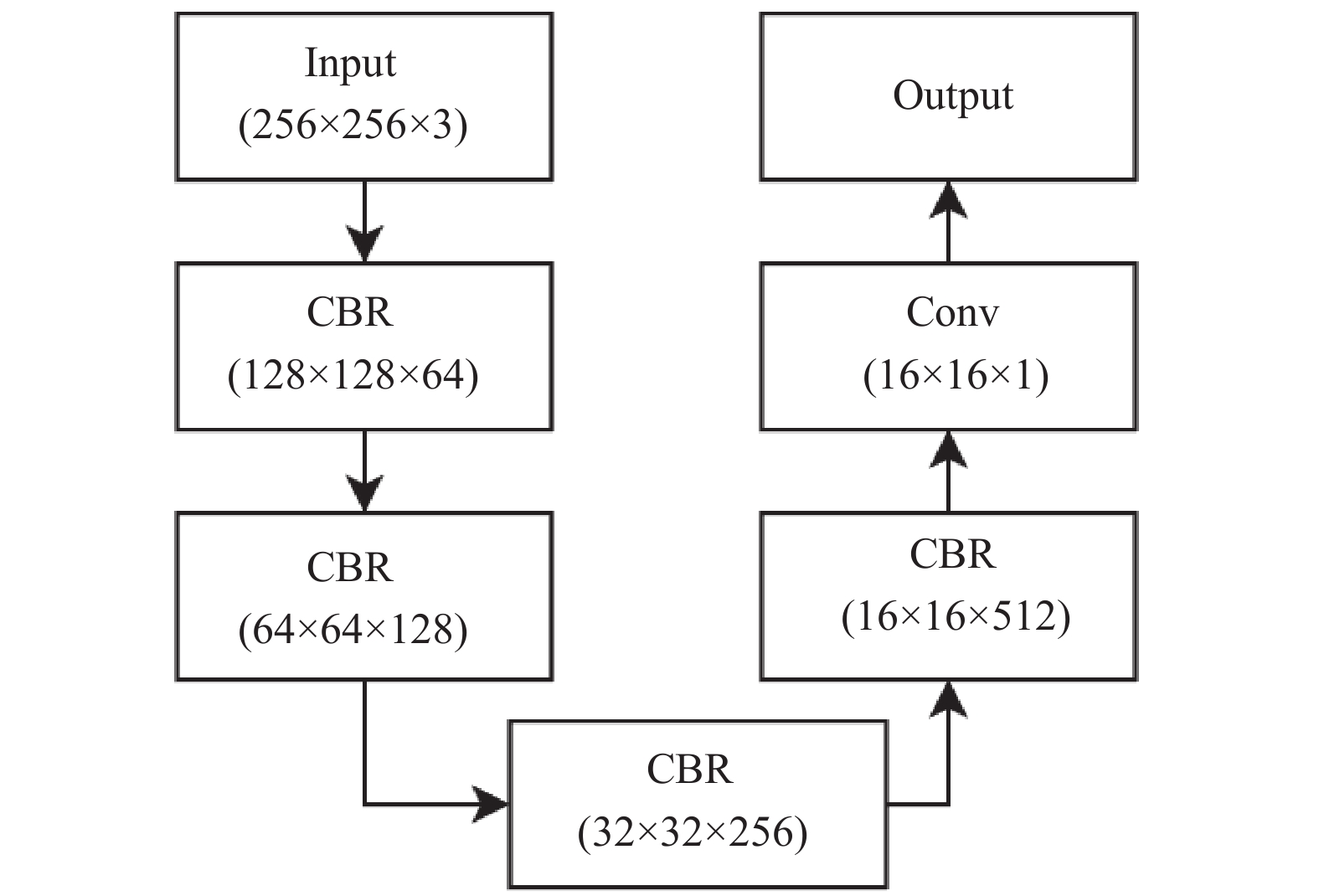

2.4 判别器判别器

RelightGAN网络依据GAN网络搭建, 该网络由一个生成器G和两个判别器

对抗损失:

| min | (3) |

| \begin{split} & \mathop {\min }\limits_G \mathop {\max }\limits_{{D_l}} {L_{{\mathrm{GAN}}{D_l}}}\left( {G, {D_l}} \right) = {E_{{L_{{\mathrm{low}}}}\sim{P_{{\mathrm{data}}}}\left( {{L_{{\mathrm{low}}}}} \right)}}\left[ {\log \left( {{D_l}\left( {{L_{{\mathrm{low}}}}} \right)} \right)} \right] \\ & + {E_{{L_{{\mathrm{nor}}}}\sim{P_{{\mathrm{data}}}}\left( {{L_{{\mathrm{nor}}}}} \right)}}\left[ {\log \left( {1 - {D_l}\left( {{L_{{\mathrm{nor}}}} - G\left( {{L_{{\mathrm{low}}}}} \right)} \right)} \right)} \right] \end{split} | (4) |

其中,

|

图 2 生成器网络层结构 |

|

图 3 CBAM-Res结构 |

两个内容损失函数用L1损失来定义, L1损失在保持颜色和亮度稳定性方面更有效, 如式(5)、式(6)所示:

| \begin{split} {L_{{\mathrm{GANT}}}} =& \frac{1}{{WH}}\mathop {\mathop \sum \limits^H }\limits_{j = 1} \mathop {\mathop \sum \limits^W }\limits_{i = 1} \left| {L_{{\mathrm{nor}}}}\left( {{x_i}, {y_j}} \right) \right.\\ & \left.-G\left( {{L_{{\mathrm{low}}}}\left( {{x_i}, {y_j}} \right)} \right) - {L_{{\mathrm{low}}}}\left( {{x_i}, {y_j}} \right) \right| \end{split} | (5) |

| \begin{split} {L_{{\mathrm{GANI}}}} = &\frac{1}{{WH}}\mathop {\mathop \sum \limits^H }\limits_{j = 1} \mathop {\mathop \sum \limits^W }\limits_{i = 1} \left| {L_{{\mathrm{low}}}}\left( {{x_i}, {y_j}} \right) \right.\\ & \left. +G\left( {{L_{{\mathrm{low}}}}\left( {{x_i}, {y_j}} \right)} \right) - {L_{{\mathrm{nor}}}}\left( {{x_i}, {y_j}} \right) \right| \end{split} | (6) |

暗图像增强网络的总损失函数可表示为式(7):

| L={\lambda }_{1}{L}_{{\mathrm{GAN}}{D}_{n}}+{\lambda }_{2}{L}_{{\mathrm{GAN}}{D}_{l}}+{\lambda }_{3}{L}_{{\mathrm{GANT}}}+{\lambda }_{4} {L}_{{\mathrm{GANI}}} | (7) |

其中,

|

图 4 判别器网络层结构 |

3 研究结果 3.1 数据集

本文的训练集和测试集数据来自于LOL[10]公共数据集和由RAISE[14]在RetinexNet中合成的数据. 该数据集由

图像增强算法通常使用峰值信噪比(PSNR)和结构相似性(SSIM)作为定量指标[15]. 计算公式如下:

| {\textit{PSNR}} = 10{\log _{10}}\left( {\frac{{MA{X_I}^2}}{\textit{MSE}}} \right) | (8) |

| {\textit{SSIM}}\left(X, Y\right)=l\left(X, Y\right)\times c\left(X, Y\right)\times s\left(X, Y\right) | (9) |

其中,

| {\mathrm{Brightness}}:\; l\left( {X, Y} \right) = \frac{{2{\mu _X}{\mu _Y} + {C_1}}}{{{\mu _X}^2 + {\mu _Y}^2 + {C_1}}} | (10) |

| {\mathrm{Contrast}}:\;c\left( {X, Y} \right) = \frac{{2{\sigma _X}{\sigma _Y} + {C_2}}}{{{\sigma _X}^2 + {\sigma _Y}^2 + {C_2}}} | (11) |

| {\mathrm{Structure}}:\;s\left( {X, Y} \right) = \frac{{{\sigma _{XY}} + {C_3}}}{{{\sigma _X}{\sigma _Y} + {C_3}}} | (12) |

其中,

为了评估RelightGAN网络的有效性, 选用Retinex-Net[10]、Zero-DCE[12], 以及流行的EnlightenGAN[13]图像增强算法使用同一数据集训练网络. 选用LOL15张数据集进行测试, 图像大小设置为256×256, 实验对比从客观和主观两个方向评估增强后的图像质量. 图6展示了不同方法增强后的暗图像.

|

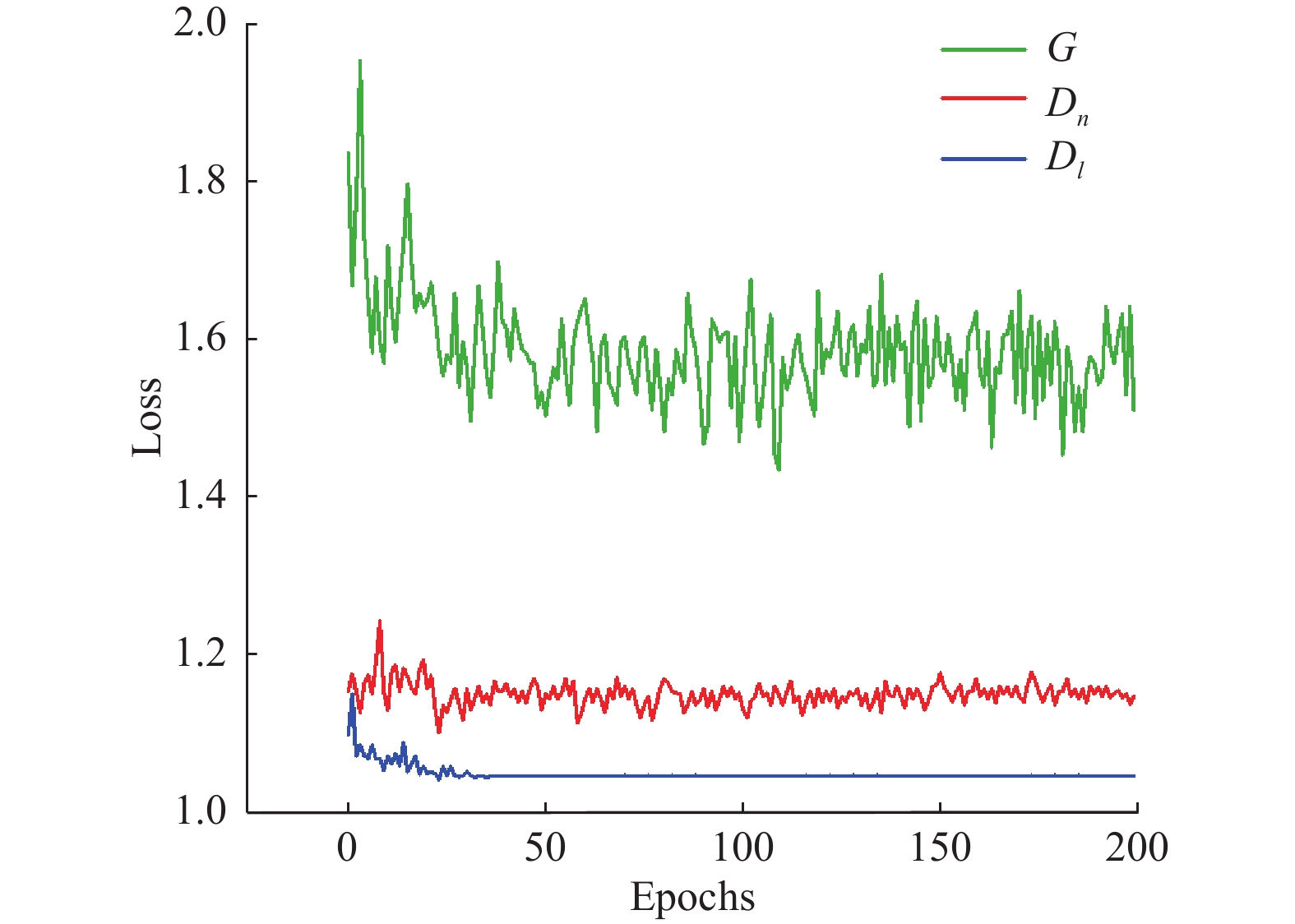

图 5 判别器和生成器loss值收敛曲线 |

|

图 6 对实验结果的主观视觉评价 |

由图6可以看出RetinexNet能够实现暗图像的增强, 然而, 增强后的图像存在更明显的色彩失真问题, 这是由于Retinex理论假设光照在整个图像内平缓变化, 但实际上图像的边缘区域光照变化更加剧烈. 因此, 网络生成的图像在边缘区域容易出现光晕现象. 此外, 增强后的图像还可能出现边缘模糊和边缘信息丢失的问题. 直接利用EnlightenGAN网络处理后的图像与RetinexNet相比没有出现颜色失真和边缘区域光晕现象, 但是增强后的图像亮度低, 颜色修复与真实颜色有色差, 基于Zero-DCE算法的暗图像增强效果较理想, 但与真实图像相比亮度过低, 亮度提升不明显. RelightGAN网络从外界环境角度观察直接生成亮光层信息, 生成的打光后的图像保留了真实场景的大部分信息, 且不会发生亮度低、颜色失真、对比度低、噪声严重等问题. 利用梯度损失函数有效地避免了正常图像边缘信息丢失的问题.

为了更直观地看到每种方法的性能, 使用同一数据集训练不同网络, 然后对比图像增强后的测试集PSNR和SSIM平均值, 结果如表1所示.

从表1可以看出, Zero-DCE算法的PSNR值最低, 但SSIM值优于RetinexNet, 在这3种方法中, 综合来看EnlightenGAN是表现最好的, RelightGAN网络PSNR和SSIM值均优于其他3种实验算法, 与Enlighten-GAN算法相比, PSNR值提高了12.81%, SSIM值提高了5.95%. 这客观地证明了RelightGAN网络增强暗图像的有效性.

| 表 1 不同方法增强暗图像的实验结果对比 |

为验证CBAM-Res残差块的性能, 进行了网络有无通道注意力机制的对比实验, 如表2所示, 可以看出加入了CBAM-Res残差块的网络性能优于ResNet残差块, 验证了设计的CBAM-Res残差块的有效性.

| 表 2 网络有无通道注意力机制实验对比结果 |

3.4 真实场景测试情况

为了验证RelightGAN网络在真实场景中的性能, 使用5个公开可用的数据集DICM[16], LIME[17], NPE[18], VV[13]和MEF[19]进行测试. 使用NIQE对增强后的图像进行客观评价, NIQE是一种被广泛认可的无参考图像质量评估工具, 用于定量比较没有地面真实度的真实图像恢复. 对比过程中使用256×256像素的标准化图像尺寸进行评估. 表3显示了5个公开可用的数据集通过不同方法增强后的NIQE值. 较低的NIQE值表示较好的视觉质量, 从表3可知RelightGAN网络拥有最优的整体平均NIQE值.

| 表 3 NIQE 对比结果 |

图7直观地显示了5种类型数据集的部分增强图像. 如图7所示, RetinexNet增强后的图像确实恢复了一些暗图像场景信息, 但它往往会出现色彩失真、图像过曝或饱和等问题, 这些都可能会对图片的可见性产生负面影响. 与RetinexNet网络相比EnlightenGAN和Zero-DCE能够实现较好的增强效果, 但对于部分场景图像增强效果不明显. 与前3种网络相比, RelightGAN网络具有更好的暗图像增强效果. 此外, 增强后的图像在最大程度上有效地保留了原始颜色信息和细节.

|

图 7 真实场景下暗图像增强效果对比 |

4 结论与展望

图像增强技术是当前工业和社会领域重要的研究内容, 基于生成对抗网络改进的RelightGAN网络不再把暗图像通过算法还原为正常场景图像, 而是通过算法将未打光的暗场景图像转换为打光下拍摄的暗场景图像, 同样可增强暗图像的可视性. RelightGAN暗图像增强网络利用两个判别器和一个生成器组成的循环结构, 构建对抗性损失和内容损失约束生成器生成最优的照明层信息, 生成器中加入的CBAM-Res结构使得网络训练过程中细节信息保留更完整. 实验表明, 在主观评价方面RelightGAN网络点亮后的暗图像效果明显增强, 暗图像的可见性也得到了显著提高. 在客观评价方面, 与较流行的EnlightenGAN相比, RelightGAN网络增强后的暗图像PSNR值提高了约12.81%, SSIM值提高了5.95%. 对真实暗场景图像增强后的NIQE值较低, 充分证明了研究的有效性.

| [1] |

Cheng HD, Shi XJ. A simple and effective histogram equalization approach to image enhancement. Digital Signal Processing, 2004, 14(2): 158-170. DOI:10.1016/j.dsp.2003.07.002 |

| [2] |

刘申澳, 韩永华. 基于MSRCR-拉普拉斯金字塔方法的低照度图像增强. 图像与信号处理, 2022, 11(3): 113-124. DOI:10.12677/JISP.2022.113013 |

| [3] |

Islam SM, Mondal HS. Image enhancement based medical image analysis. Proceedings of the 10th International Conference on Computing, Communication and Networking Technologies (ICCCNT). Kanpur: IEEE, 2019. 1–5. [doi: 10.1109/ICCCNT45670.2019.8944910]

|

| [4] |

Mitchell JN. Computer multiplication and division using binary logarithms. IRE Transactions on Electronic Computers, 1962, EC-11(4): 512-517. DOI:10.1109/TEC.1962.5219391 |

| [5] |

Nnolim UA. Design and implementation of novel, fast, pipelined HSI2RGB and log-hybrid RGB2HSI colour converter architectures for image enhancement. Microprocessors and Microsystems, 2015, 39(4–5): 223-236. DOI:10.1016/j.micpro.2015.04.005 |

| [6] |

Nnolim UA. Log-hybrid architecture for tonal correction combined with modified un-sharp masking filter algorithm for colour image enhancement. Integration, 2015, 48: 221-229. DOI:10.1016/j.vlsi.2014.09.001 |

| [7] |

Dong X, Wang G, Pang Y, et al. Fast efficient algorithm for enhancement of low lighting video. Proceedings of the 2011 IEEE International Conference on Multimedia and Expo (ICME). Barcelona: IEEE, 2011. 1–6. [doi: 10.1109/ICME.2011.6012107]

|

| [8] |

Rahman ZU, Jobson DJ, Woodell GA. Retinex processing for automatic image enhancement. Proceedings of SPIE 4662, Human Vision and Electronic Imaging VII. San Jose: SPIE, 2002. 390–401. [doi: 10.1117/12.469537]

|

| [9] |

王以涵, 郝世杰, 韩徐, 等. 基于低秩矩阵估计的暗光图像增强模型. 计算机科学, 2022, 49(1): 187-193. DOI:10.11896/jsjkx.210600090 |

| [10] |

Wei C, Wang WJ, Yang WH, et al. Deep Retinex decomposition for low-light enhancement. Proceedings of the 2018 British Machine Vision Conference. Newcastle: BMVA Press, 2018. 155.

|

| [11] |

Wang Y, Chen J, Han YJ, et al. Combining attention mechanism and Retinex model to enhance low-light images. Computers & Graphics, 2022, 104: 95-105. DOI:10.1016/j.cag.2022.04.002 |

| [12] |

Guo CL, Li CY, Guo JC, et al. Zero-reference deep curve estimation for low-light image enhancement. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle: IEEE, 2020. 1777–1786. [doi: 10.1109/CVPR42600.2020.00185]

|

| [13] |

Jiang YF, Gong XY, Liu D, et al. EnlightenGAN: Deep light enhancement without paired supervision. IEEE Transactions on Image Processing, 2021, 30: 2340-2349. DOI:10.1109/TIP.2021.3051462 |

| [14] |

Dang-Nguyen DT, Pasquini C, Conotter V, et al. RAISE: A raw images dataset for digital image forensics. Proceedings of the 6th ACM Multimedia Systems Conference. Portland: ACM, 2015. 219–224. [doi: 10.1145/2713168.2713194]

|

| [15] |

Wang Z, Bovik AC, Sheikh HR, et al. Image quality assessment: From error visibility to structural similarity. IEEE Transactions on Image Processing, 2004, 13(4): 600-612. DOI:10.1109/TIP.2003.819861 |

| [16] |

Lee C, Lee C, Kim CS. Contrast enhancement based on layered difference representation. Proceedings of the 19th IEEE International Conference on Image Processing. Orlando: IEEE, 2012. 965–968. [doi: 10.1109/ICIP.2012.6467022]

|

| [17] |

Guo XJ, Li Y, Ling HB. LIME: Low-light image enhancement via illumination map estimation. IEEE Transactions on Image Processing, 2017, 26(2): 982-993. DOI:10.1109/TIP.2016.2639450 |

| [18] |

Wang SH, Zheng J, Hu HM, et al. Naturalness preserved enhancement algorithm for non-uniform illumination images. IEEE Transactions on Image Processing, 2013, 22(9): 3538-3548. DOI:10.1109/TIP.2013.2261309 |

| [19] |

Li JQ, Li JC, Fang FM, et al. Luminance-aware pyramid network for low-light image enhancement. IEEE Transactions on Multimedia, 2021, 23: 3153-3165. DOI:10.1109/TMM.2020.3021243 |

2024, Vol. 33

2024, Vol. 33