目标检测是计算机视觉领域中的研究热点, 一直备受关注. 其核心任务在于准确地识别并定位出图像或视频中的目标物体. 目标检测不仅能够为后续的视觉任务提供有力的支撑, 而且已经在各行各业中得到了广泛应用. 现有的目标检测方法可以分为3大类: 传统方法、深度学习方法和深度强化学习方法.

传统方法依赖手工设计的特征提取器来进行目标检测. 采用滑动窗口策略, 通过在图像上滑动不同大小的窗口来选取潜在目标区域, 再使用如尺度不变特征变换(scale-invariant feature transform, SIFT)[1]和方向梯度直方图(histogram of oriented gradients, HOG)[2]等特定设计的提取器从这些区域中提取特征, 最后通过分类器进行分类和检测. 这类方法准确率低且难以适用于复杂场景.

基于深度学习的目标检测方法主要分为两阶段方法和单阶段方法. 两阶段方法首先筛选候选区域, 再进行精确检测. R-CNN[3]是最早的两阶段方法, 通过选择性搜索生成候选框, 并从中提取特征, 最后通过分类器和回归器得到检测结果. 然而, R-CNN存在计算冗余且检测速度慢的问题. 为了改进这些问题, 后续的研究提出了Fast R-CNN[4]、Faster R-CNN[5]、Mask R-CNN[6]、Cascade R-CNN[7]等方法, 这些方法在不同方面提升了检测性能, 实现了更为高效的目标检测. 单阶段目标检测算法以SSD[8]、YOLO[9]、RetinaNet[10]等为代表, 相较于两阶段方法, 其简化了检测流程, 直接将图像划分为网格并预测边界框, 从而大大提高了检测速度. 这些算法的发展为实际应用提供了更高效解决方案. 但这些方法往往参数量大且存在大量冗余候选框.

近年来, 一些基于深度强化学习的目标检测方法被提出. 这类方法将目标检测问题看作控制问题, 并建模为马尔可夫决策过程(Markov decision process, MDP), 通过智能体与环境交互学习最优策略来实现对目标的定位与识别. Caicedo等人[11]首次将深度强化学习用于目标定位任务, 通过智能体不断学习动作策略来搜索目标, 直至触发终止动作, 得到预测结果. 这种方法展示了深度强化学习在目标检测领域的潜力和有效性. 随后, Bellver等人[12]提出了一种改进的深度强化学习目标检测方法, 采用分层策略. 该方法中, 智能体会先识别图像中的一个感兴趣区域, 然后逐步缩小这一区域, 进而在上一步选择的区域内继续寻找更小的目标区域, 最终形成层次化的检测结构. 这种分层策略有助于提高目标检测的精度和效率. 文献[13]提出的Tree-RL方法则采用自顶向下的搜索策略, 从整个图像开始逐步细化目标位置. 在每个搜索窗口, 算法递归地从动作空间中选取最佳动作, 生成新的窗口, 从而实现精准检测. Xu等人[14]提出了一种名为AHDet的深度强化学习模型, 基于人类的视觉认知过程, 分为AIM和HIT两个步骤, 实现从粗略到精细的检测. 文献[15]侧重于让智能体学习纠正不准确边界框, 在粗定位的基础上实现边界框自动精细化. 文献[16]利用层次化的树型候选区域来减少评估数量, 并引入缩放和微调阶段、可变长宽比及多种奖励函数来提升检测效果. ReinforceNet[17]模型中使用基于卷积神经网络的区域选择网络(RS-net)和边界框细化网络(BBR-net)来加强智能体的区域选择和细化能力.

为进一步提高检测效率, 本文提出一种基于改进奖励机制的深度强化学习目标检测模型. 同样将检测问题视为控制问题, 建立马尔可夫决策模型. 但使用融入通道注意力机制(squeeze-and-excitation network, SENet)[18]的VGG16特征提取模块[19]作为强化学习的状态输入; 使用综合考虑了真实框与预测框中心点距离、长宽比差异以及交并比的改进奖励机制作为奖励; 使用位移、形变和缩放这3类定位动作; 利用Dueling DQN[20]算法进行训练. 整个过程能够在使用较少候选框的情况下就精准定位到目标区域. 最后通过实验验证了本文模型的有效性.

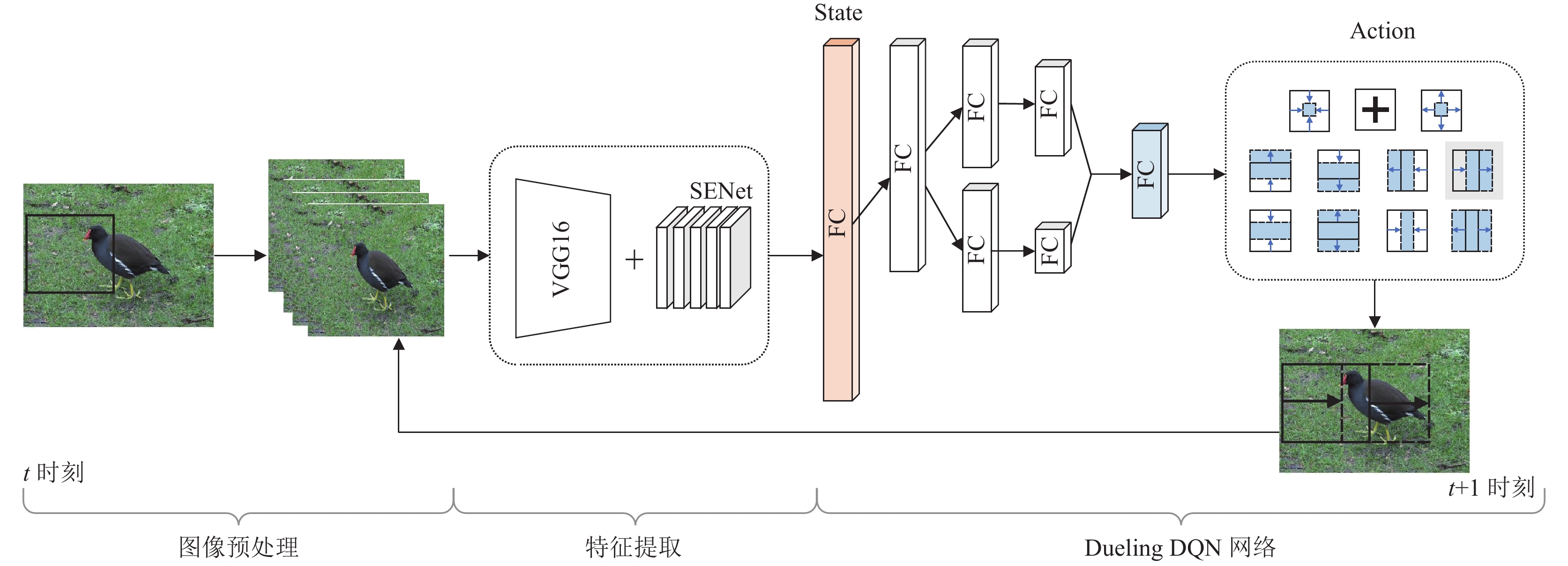

1 基于改进奖励机制的深度强化学习目标检测模型本节将目标检测过程建模为马尔可夫决策过程, 利用深度强化学习算法来让智能体做出最优决策. 基于改进奖励机制的深度强化学习目标检测模型如图1所示. 令定位框为智能体, 定位框每一时刻生成的预测框由

在本节, 对目标检测模型中的动作、状态、奖励以及训练策略进行详细介绍.

|

图 1 基于改进奖励机制的深度强化学习目标检测模型图 |

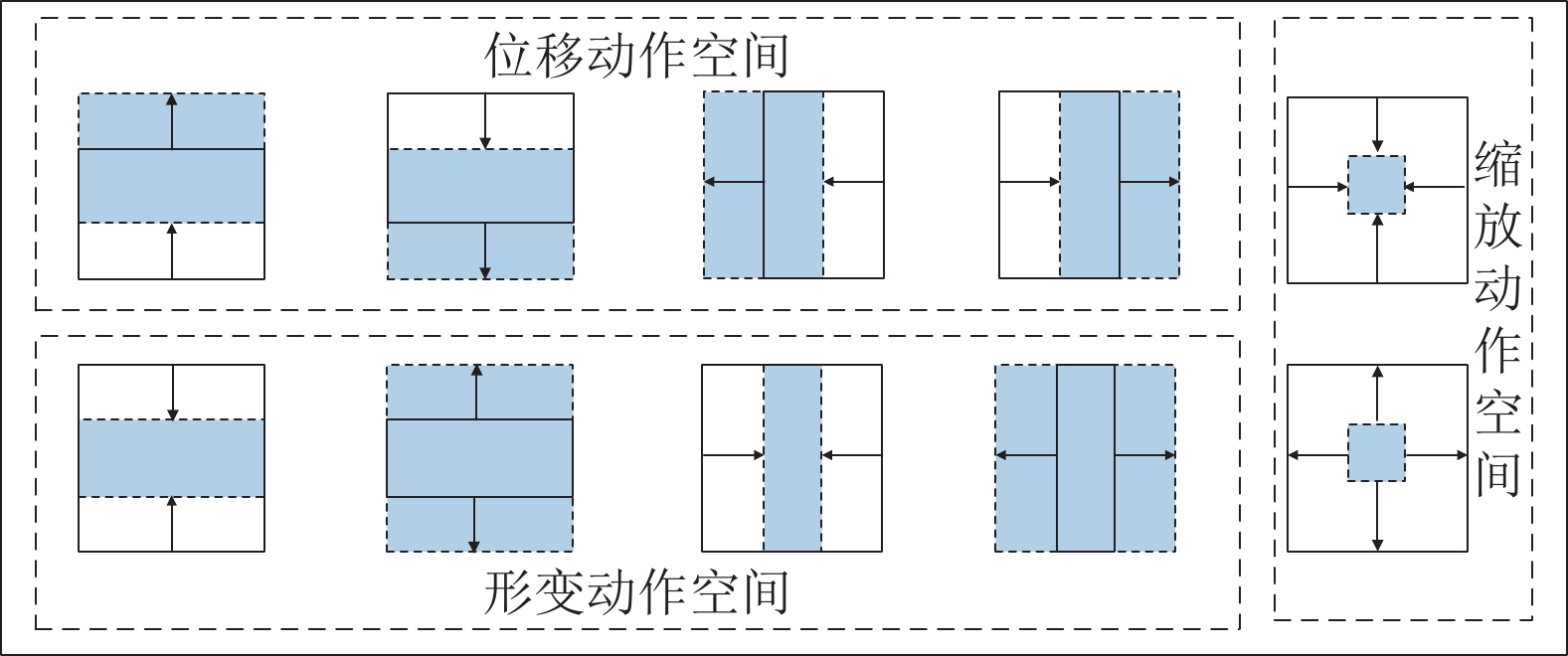

1.1 动作

在强化学习中, 动作是智能体为了达到目标而采取的行为, 通过执行动作, 智能体能够影响环境并获得相应的奖励或惩罚. 在本文模型中, 将动作定义为

|

图 2 定位动作空间 |

定位动作可以对预测框进行离散的更改, 这些更改由特定的行动步长Δx和Δy来决定. 将变化系数定义为μ, 取值在0–1之间, 代表更改幅度为当前预测框长或宽的μ倍. 例如, 执行向右平移动作时会将Δx添加到

| {\Delta} x = \mu \cdot ({x^t_{\max }} - {x^t_{\min }}) | (1) |

| {\Delta} y = \mu \cdot ({y^t_{\max }} - {y^t_{\min }}) | (2) |

此外, 在执行定位动作时, 若预测框因动作调整而超出图像边界, 模型会自动对其进行强制剪裁处理, 以确保预测框始终保持在图像的有效范围内. 以上动作空间的设定避免了冗余和重复动作的存在. 若变化系数的取值足够小, 定位框便可调整至任意形状和大小. 通过不同动作的组合, 定位框可以覆盖到图像中的任意一块区域.

终止动作用于终止序列过程. 当智能体执行终止动作时, 代表智能体认为当前预测框区域是目标所在区域, 即找到了物体, 会以黑色十字架形式进行标识. 此时, 智能体会结束当前搜索的序列, 并在初始位置重新启动该框, 以开始新一轮的搜索.

1.2 状态在强化学习中, 状态是智能体在决策过程中的观察, 它包含了有关环境的必要信息, 以便智能体能够做出决策. 在本文模型中, 环境设为输入的图像, 将状态定义为

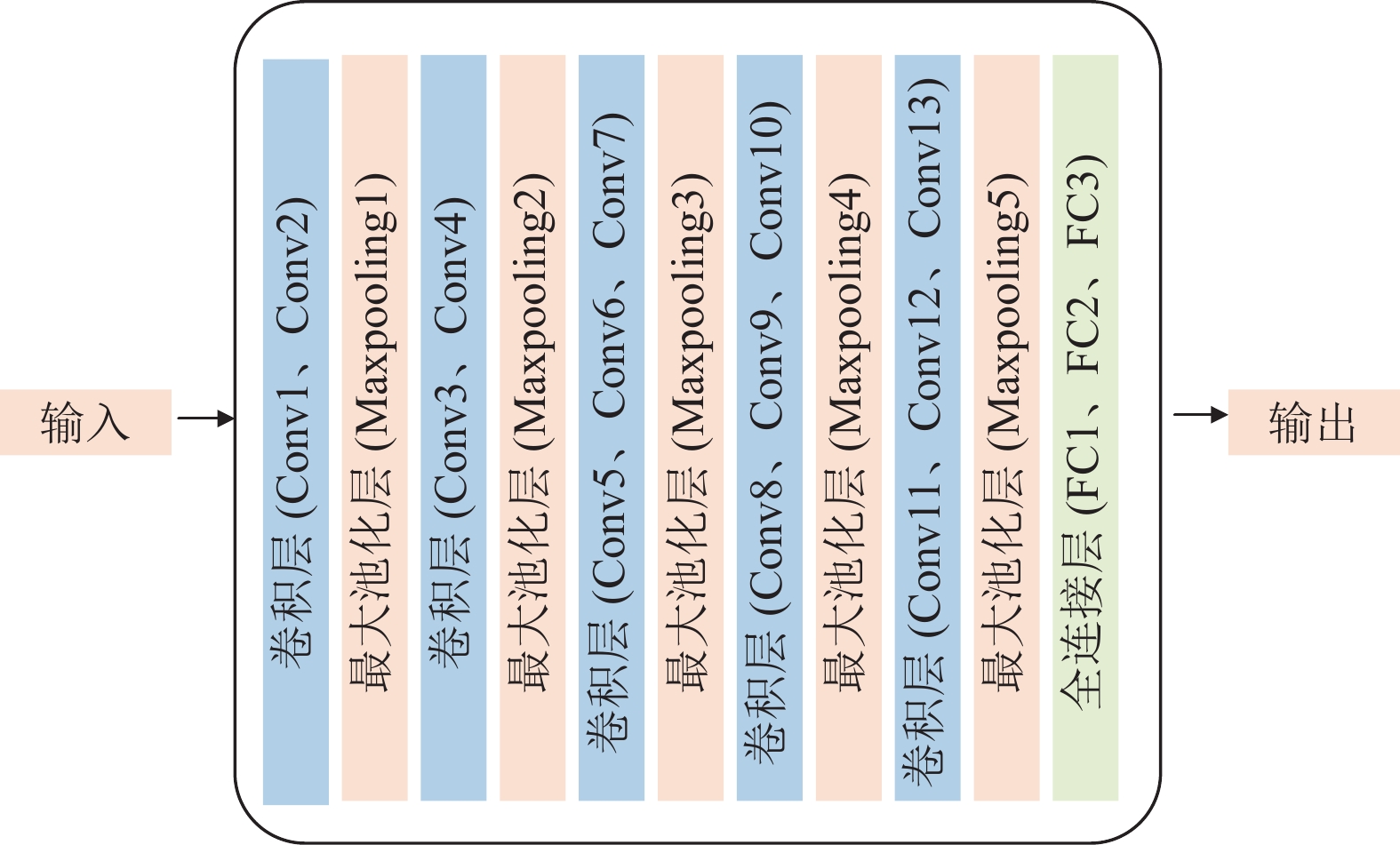

具体来说, 将经过预处理后的图像经过VGG16网络进行特征提取以得到图像特征, VGG16网络主要由13个卷积层、5个池化层和3个全连接层组成. 其特点是结构相对简单, 没有太多的参数, 通过堆叠多个卷积层和池化层来提取图像的特征. VGG16网络的卷积核大小为3×3, 步长为1; 最大池化操作的窗口尺寸是2×2. VGG16网络的结构图如图3所示. 将图像输入VGG16网络中, 得到经第5层池化层处理后产生的结果.

|

图 3 VGG16模块 |

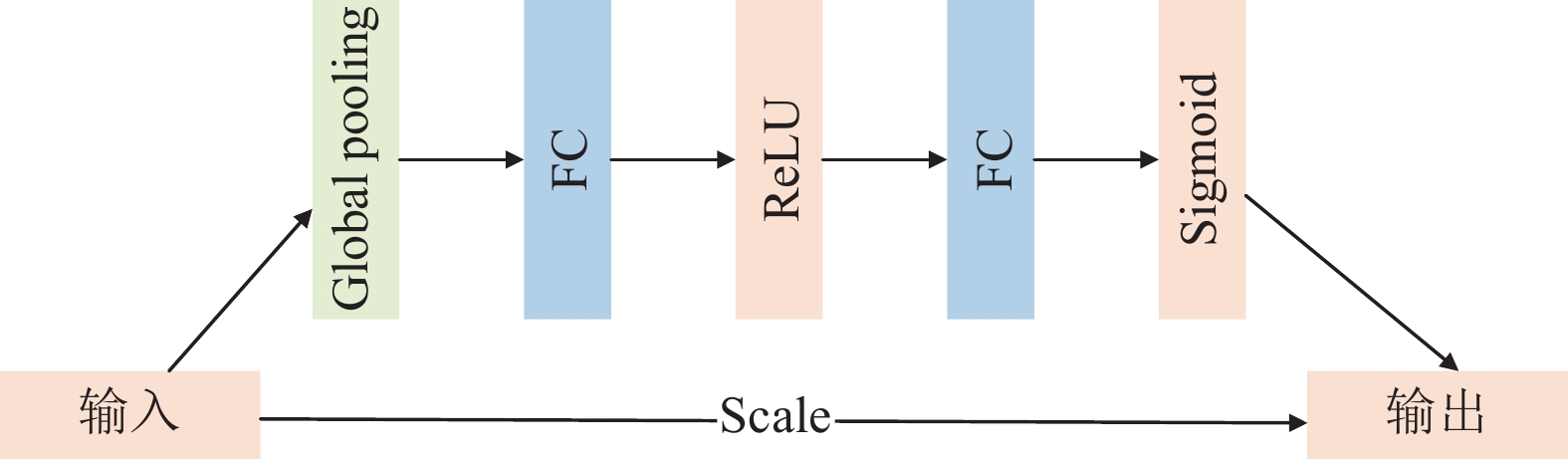

为显式地建模特征通道间的依赖关系, 提高网络模型对图像特征的提取能力. 在VGG16模型中加入SENet模块来让模型学习每个通道的重要程度, 进而强化重要的特征并抑制非重要的特征. 通道注意力机制模块的结构如图4所示. SENet模块包含3个主要操作: Squeeze操作、Excitation操作和Scale操作. Squeeze操作通过全局平均池化(global pooling)来聚合每个通道的全局信息, 得到一个表示通道全局特征的向量. Excitation操作利用这个向量来预测每个通道的重要性. 首先经过第1个全连接层来进行降维操作, 减少计算量并捕获通道间的全局信息, 使用ReLU激活函数来引入非线性, 帮助模型学习更复杂的通道间关系. 接着经过第2个全连接层来进行升维操作, 将特征重新映射到与原始通道数相同的维度, 用Sigmoid激活函数将输出值限制在0–1之间, 生成归一化的通道权重. 随后, 通过Scale操作将权重加权到每个通道的特征上, 实现特征的重标定.

最终, 将经过VGG16模块和SENet模块处理后得到的特征图展平成一维向量作为目标检测模型的状态输入. 此外, 在模型中, 会取连续4帧图像作为输入, 使模型更全面地捕捉环境的动态性, 提高模型的感知能力和决策准确性.

|

图 4 SENet模块 |

1.3 奖励

在强化学习中, 奖励用于评估智能体在某个状态下采取行动的好坏, 并指导智能体逐步学习如何做出最优决策. 在本目标检测模型中, 将奖励定义为

交并比(IoU)作为衡量预测框与真实目标框相似度的指标, 是通过比较两者的交集区域与并集区域面积来实现的. 设

| IoU(t) = \frac{{{b_t} \cap g}}{{{b_t} \cup g}}\;\; | (3) |

在t时刻, 当智能体选择动作at从状态st转换为st+1时, 智能体会得到一个奖励rt, 预测框的位置坐标变为bt+1, 预测框和真实目标框的交并比变为IoU(t+1), 将奖励rIoU定义为:

| {r_{IoU}}(t + 1) = sign(IoU(t + 1) - IoU(t)) | (4) |

在此处的奖励中, 引入符号函数是为了更直观地量化奖励. 若t+1时刻的预测框优于t时刻的预测框, 便用1表示, 意为奖励; 若t+1时刻的预测框差于t时刻的预测框, 便用−1表示, 意为惩罚; 若t+1时刻的预测框与t时刻的预测框相比, 并没有明显地接近或远离真实框, 便用0表示, 表示不奖励也不惩罚.

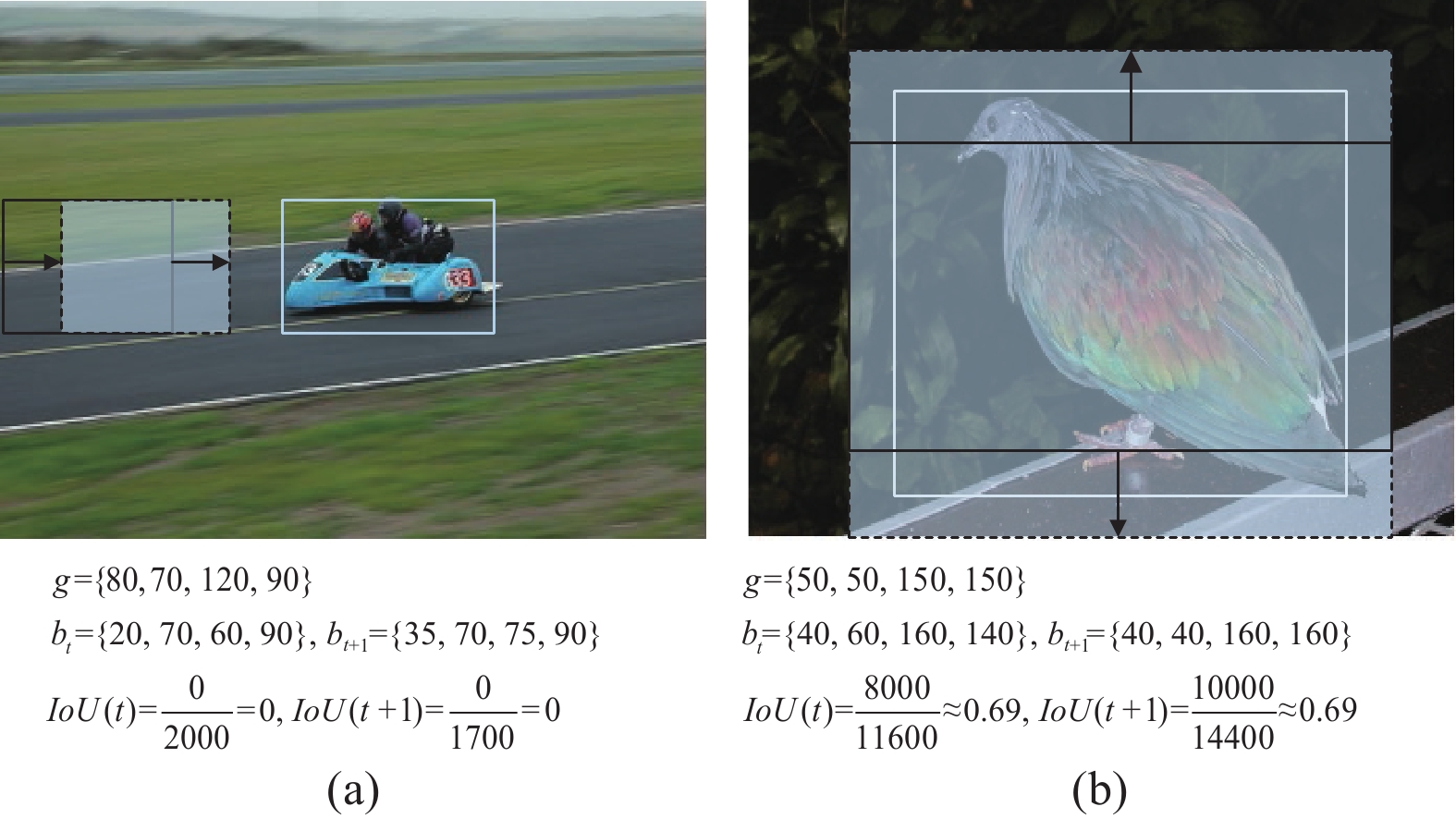

但仅使用IoU作为奖励, 会出现奖励不准确的情况, 如图5所示.

|

图 5 奖励不合理情况 |

图5中, 白色实线框代表真实框所在位置, 由g表示; 黑色实线框和蓝色虚线框分别代表t时刻和t+1时刻预测框的位置, 由bt和bt+1表示; t时刻和t+1时刻预测框与真实框的交并比分别由IoU(t)和IoU(t+1)表示.

在图5(a)中, t时刻和t+1时刻预测框和真实框的交并比都是0, 但明显可以看出, t+1时刻预测框的位置要更接近真实框的位置; 在图5(b)中, 虽然t时刻和t+1时刻预测框和真实框的交并比都是0.69, 但t+1时刻预测框的位置不仅完整框住了目标而且形状也更接近于真实框. 若只考虑IoU作为奖励的组成部分, 在这两类情况下, 都会给予智能体0的奖励, 但这显然是不合理的.

为了进一步完善这一评价体系, 在奖励机制中引入预测框和真实框中心点之间的距离(Dist)和高宽比(Ratio)作为补充信息. 距离的计算额外提供了预测框和真实框的位置信息, 高宽比的计算额外提供了预测框的形状信息, 而且都能避免在IoU相同但预测框具有差异的情况下, 智能体被给予不恰当奖励的情况, 进而确保智能体在评估过程中的客观性和准确性.

t时刻的预测框bt和真实框g之间的中心点距离定义为:

| Dist(t)=\sqrt{\begin{align} & {{\left( \frac{{{y}^{g}_{\max }}+{{y}^{g}_{\min }}}{2}-\frac{{{y}^{t}_{\max }}+{{y}^{t}_{\min }}}{2} \right)}^{2}} +{{\left( \frac{{{x}^{g}_{\max }}+{{x}^{g}_{\min }}}{2}-\frac{{{x}^{t}_{\max }}+{{x}^{t}_{\min }}}{2} \right)}^{2}} \\ \end{align}} | (5) |

t时刻的预测框bt和真实框g之间的高宽比之差定义为:

| Ratio(t) = \left| {\frac{{{y^g_{\max }} - {y^g_{\min }}}}{{{x^g_{\max }} - {x^g_{\min }}}} - \frac{{{y^t_{\max }} - {y^t_{\min }}}}{{{x^t_{\max }} - {x^t_{\min }}}}} \right| | (6) |

当智能体从t时刻转变为t+1时刻, 距离变为Dist(t+1), 高宽比之差变为Ratio(t+1). 距离和高宽比引起的奖励rDist和rRatio仍采用符号函数的形式, 可表示为:

| {r_{Dist}}(t + 1) = - sign(Dist(t + 1) - Dist(t)) | (7) |

| {r_{Ratio}}(t + 1) = - sign(Ratio(t + 1) - Ratio(t)) | (8) |

至此, 便可构成一个更加准确的奖励机制. 具体来说, rIoU表示定位框在执行动作后与真实框的重叠程度是否变大; rDist表示定位框选取动作后的预测框中心点是否更接近真实框中心点; rRatio表示智能体选取动作后的形状是否更相似于真实框. 同时引入α、β、χ这3个系数来代表这3个指标对于奖励的重要程度. 总奖励r可表示为:

| r(t) = \alpha \cdot {r_{IoU}}(t) + \beta \cdot {r_{Dist}}(t) + \chi \cdot {r_{Ratio}}(t) | (9) |

使用改进后的奖励机制, 无论是图5(a)中的情况, 还是图5(b)中的情况, 系统都会给智能体奖励, 而不是既不奖励也不惩罚, 这是符合人们的认知的.

除此以外, 智能体选择终止动作时, 代表定位框认为已经检测到了目标, 此时会给智能体不同的奖励. 当预测框与真实框之间的IoU大于阈值

| r({t_{\rm end}}) = \left\{ {\begin{array}{*{20}{l}} { + \eta, }&{\rm if}\;\;{IoU({t_{\rm end}}) \geqslant \delta } \\ { - \eta, }&{\rm else} \end{array}} \right. | (10) |

在本模型, 使用Dueling DQN算法进行训练. 该算法有助于模型更好地理解和区分不同动作在当前状态下的潜在价值. Dueling DQN算法沿用了DQN的基本框架, 使用深度神经网络来近似Q值函数, 将状态作为输入, 并输出每个动作的Q值. 然而, 与DQN不同的是, 在Dueling DQN中, 网络结构分为两部分: 共享层和特殊层. 共享层用于提取输入数据的特征, 特殊层则分为价值流和优势流. 价值流对应价值函数, 优势流对应优势函数. 价值函数输出一个实数, 用于表示当前状态的整体价值, 而优势函数则负责输出一个与动作数量等长的向量, 每个元素表示对应动作相对于其他动作的优势. 最后, 将价值函数和优势函数进行结合, 得到每个动作的最终Q值. 在训练过程中, Dueling DQN使用与DQN相同的经验回放和目标网络技巧. 经验回放用于存储和重放过去的经验. 目标网络定期从主网络复制权重, 以稳定训练过程. 具体迭代过程如算法1所示.

算法1. Dueling DQN算法

初始化: 经验回放缓冲区Ω, 状态-动作值函数

for

初始化环境并获取观测数据o1.

初始化序列s1={o1}并对序列进行预处理ϕ1=ϕ(s1).

for

通过概率ϵ选择一个随机动作at, 否则选择动作at=argmaxaQ(ϕ(st), a; θ).

执行动作at并获得观测数据ot+1和奖励数据rt.

设置st+1={st, at, ot+1}并得到ϕt+1=ϕ(st+1).

存储状态转移数据(ϕt, at, rt, ϕt+1)到Ω中.

从Ω中随机采样小批量数据(ϕi, ai, ri, ϕi+1).

若ϕi+1不是终止状态, 设置

否则, 设置Yi=ri.

在(Yi–Q(ϕi, ai;

end for

end for

2 实验设置与评价指标 2.1 实验数据集实验选用PASCAL VOC2007数据集和 PASCAL VOC2012数据集. 这两个公开数据集一共包含猫、狗、飞机、船等20个类别. 标签采用XML文件的格式标注, 详细记录了每个目标对象在图像中的位置. 在训练过程中, 使用PASCAL VOC2007和 PASCAL VOC2012两个数据集联合进行训练. 测试时, 在PASCAL VOC2012数据集中挑选

本文提出的基于改进奖励机制的深度强化学习目标检测模型采用Python作为开发语言, 在TensorFlow框架下进行实验. 具体配置信息如表1所示.

| 表 1 实验环境配置信息 |

参数配置可分为马尔可夫建模过程参数配置和训练过程参数配置. 在马尔可夫建模过程中, 设置动作变化系数μ为0.2; 将改进奖励机制中rIoU(t)、rDist(t)和rRatio(t)的权重系数α、β、χ分别设为0.7、0.2和0.1; 在终止动作的奖励中, 设置终止阈值δ为 0.5, 终止奖励

本文采用平均精度(mAP)和平均交并比(mIoU)作为评价指标来评估本文模型的性能. 平均交并比(mIoU)与交并比(IoU)有关, 交并比是预测框与真实框的交集面积和并集面积之比; 平均准确率(mAP)与准确率(precision, P)有关, 准确率指的是预测结果中预测正确的正样本个数占被模型预测为正样本的个数的比例, 评价指标的计算公式可表示为:

| mIoU = \frac{{ \displaystyle\sum\limits_{i = 1}^n {Io{U^{(i)}}} }}{n} | (11) |

| P = \frac{{TP}}{{TP + FP}} | (12) |

| mAP = \frac{{\displaystyle\sum\limits_{i = 1}^n {{P^{(i)}}} }}{n} | (13) |

其中, TP、FP表示正确框和误检框的数量, n表示检测的总类别数.

3 实验结果分析 3.1 消融实验为验证本文所提改进模型的有效性, 用mAP和mIoU作为评价指标, 在火车、牛、小轿车、羊、飞机、沙发、猫和椅子这8类上测试, 令Caicedo-RL[11]作为基线算法, 将文中所提部分分成4组(即VGG16模块、SENet模块、改进奖励机制R'和Dueling DQN算法), 进行消融实验. 其中, “√”代表使用该策略, “×”代表不使用该策略. 实验结果如表2所示.

| 表 2 消融实验结果对比 |

在表2中可以看出, 如果仅使用VGG16模块特征提取后的结果作为状态输入, 准确率不会上升, 反而会下降0.6%, 交并比仅提升0.2%. 仅使用SENet模块, 准确率和交并比的提升也不明显. 但使用加入了SENet的VGG16特征提取模块后的结果作为状态输入, 准确率有了3.3%的提升, 交并比有了4%的提升, 可以说明特征提取的越好, 最终得到的预测框就会与真实框越接近. 使用改进奖励机制后准确率有了7.2%的提升, 表明一个合理的奖励机制有利于智能体找到目标. 使用Dueling DQN算法进行训练, 无论是准确率还是交并比, 也都会有一定程度上的提升. 本文所提策略如果全部使用, 准确率会比Caicedo-RL模型提高9.8%, 交并比会提高5.6%.

3.2 对比实验为进一步验证模型的性能, 将改进后的模型与Caicedo-RL、Hierarchical-RL[12]和Stefan-RL[16]这3个模型进行对比实验, 在测试集上进行测试, 测试集中一共包含20个类别. 同样使用mAP和mIoU作为模型的评价指标, 将火车、牛、小轿车、羊、飞机、沙发、猫和椅子这8类的结果进行展示. mAP和mIoU的具体实验结果如表3和表4所示. 通过表3和表4可以看出, 改进后模型无论是在准确率还是交并比上, 都有一定程度的提升. mAP达到57.4%, 相比于Caicedo-RL、Hierarchical-RL和Stefan-RL模型, 分别提高9.8%、24.3%、30.7%; mIoU达到60.7%, 比在Caicedo-RL模型上的测试结果提高5.6%, 比在Hierarchical-RL模型的测试结果提高19.6%, 比在Stefan-RL模型的测试结果提高11.1%.

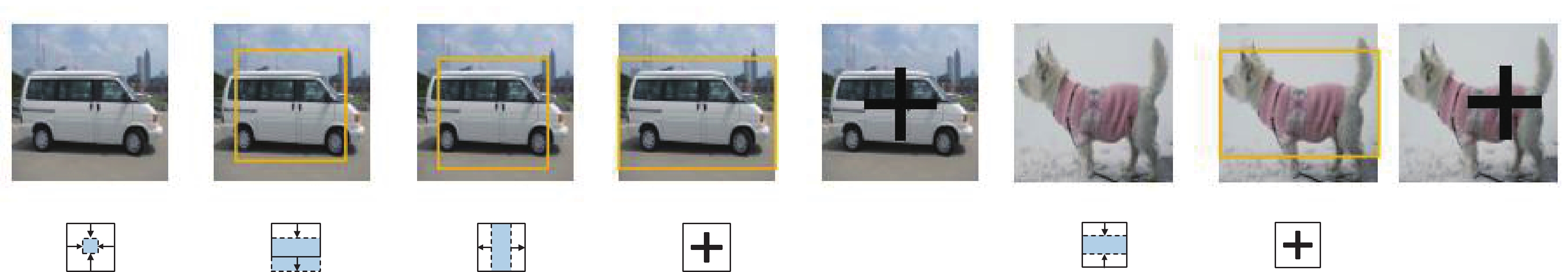

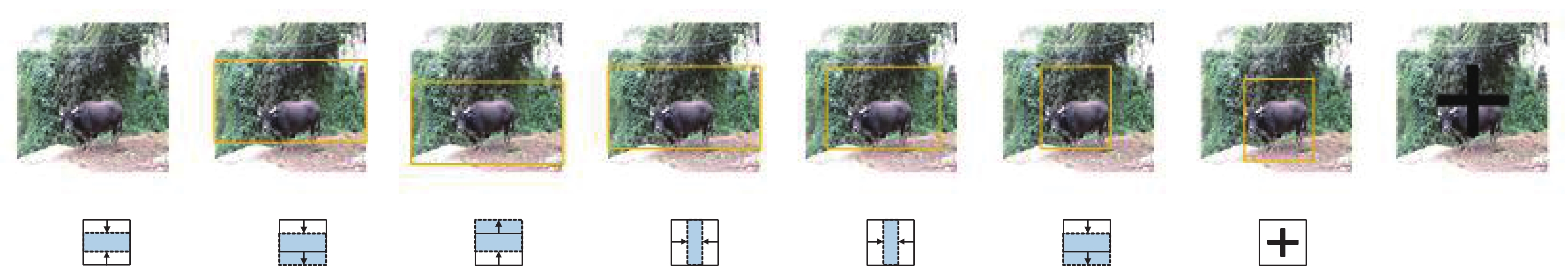

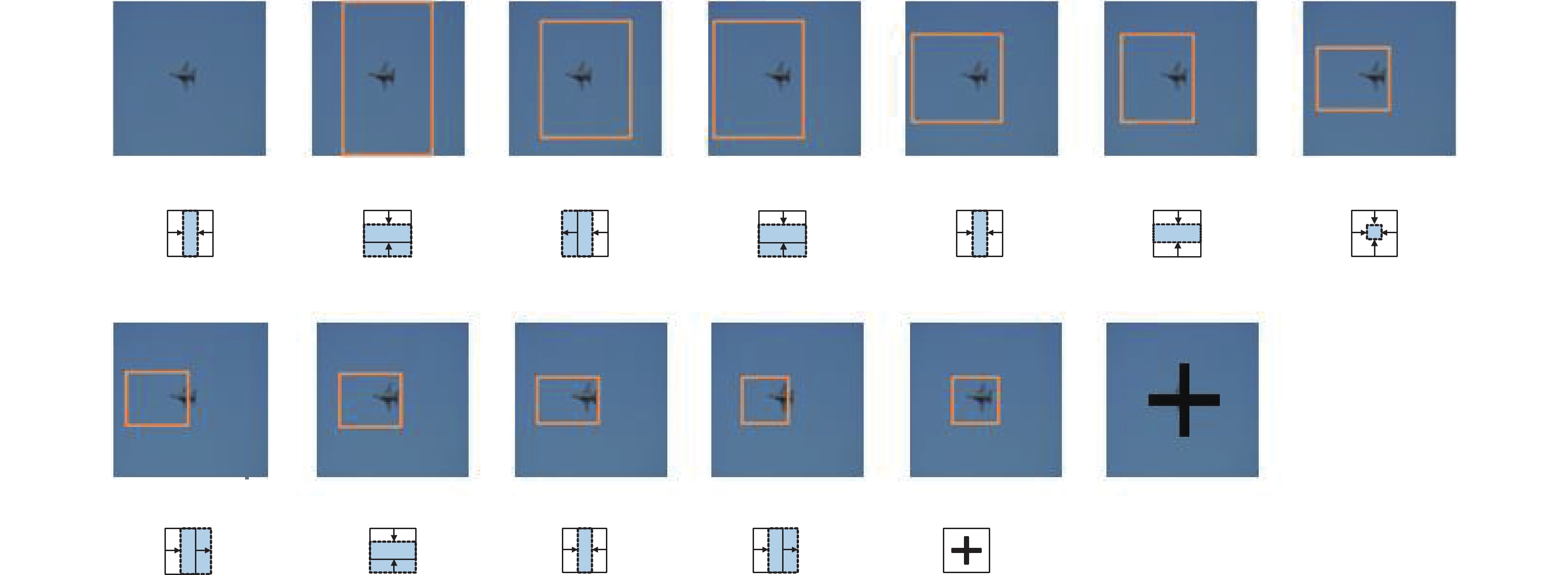

3.3 可视化结果为了直观地展示智能体在决策过程中的表现, 将定位框在每一步选择动作后产生的预测框进行可视化. 图6–图8展示了智能体是如何通过一步一步的动作来调整预测框的位置和形状, 并在合适的时机选择终止动作, 以达到最终的检测效果. 图6展示了智能体在检测大型目标时的过程, 以车和狗为例, 其在图片中的占比较大, 在检测定位车时仅用了4步, 检测定位狗时仅用了2步; 在图7中, 展示了智能体检测中型目标时的过程, 以检测牛为例, 牛在图片中的占比适中, 在检测牛时智能体采取了7次动作; 图8展示了智能体在检测小型目标时的过程, 以检测飞机为例, 该飞机在图片中占比较小, 智能体需要12步才可检测定位到目标. 本模型在检测定位小型目标时所需候选框个数要多于在检测中型目标和大型目标时所需的候选框个数.

| 表 3 对比实验mAP结果 (%) |

| 表 4 对比实验mIoU结果 (%) |

|

图 6 大目标检测过程可视化 |

|

图 7 中目标检测过程可视化 |

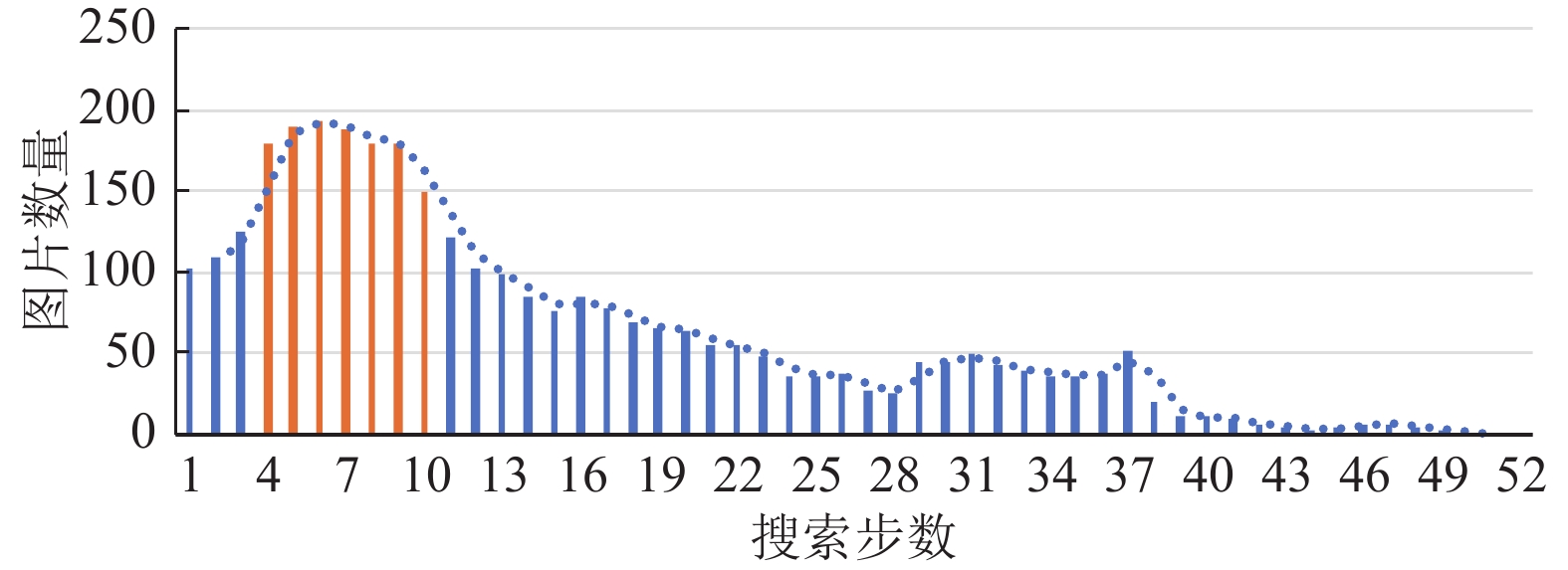

图9中, 展示了智能体在检测定位物体时所需搜索步数的分布情况. 通过观察条形图, 可以发现, 大部分物体的检测定位过程所需的步数集中在第4–10步这一区间内. 一部分物体需要相对较多的搜索步骤, 即第29–37步, 但这一比例相对较低. 这可能是由于这些目标物体占比过小或是因为这些目标物体所处的环境较为复杂, 导致智能体需要更多的步数来进行定位和搜索. 几乎没有物体需要超过40步才可以被定位到, 这一定程度上体现了智能体在检测定位过程中的高效性.

|

图 8 小目标检测过程可视化 |

|

图 9 定位物体时所需搜索步数分布图 |

4 总结与展望

为解决深度强化学习目标检测模型中存在的检测精度低和速度慢的问题, 本文提出一种基于改进奖励机制的深度强化学习目标检测模型. 通过实验发现, 该模型在检测任务中有较好的表现, 可以在使用4–10个候选框后便检测定位到目标, 同时取得57.4%的准确度. 通过对强化学习状态部分的改进, 使模型对特征的提取更加充分, 通过对奖励的改进, 使模型对智能体每一步执行的动作有了更准确的评价, 通过对训练算法的改进, 使模型对状态和动作的认知更客观. 然而本文方法也存在一些不足, 如特征提取不充分、未充分考虑时间因素、对小目标检测效果差等, 仍需要对模型进行相关的改进. 针对特征提取不充分问题, 可选择更好的特征提取网络; 针对未考虑时间因素的问题, 可引入GRU等模块, 对小目标检测效果差问题, 可引入更精确的区域细化网络.

| [1] |

Lowe DG. Distinctive image features from scale-invariant keypoints. International Journal of Computer Vision, 2004, 60(2): 91-110. DOI:10.1023/b:visi.0000029664.99615.94 |

| [2] |

Dalal N, Triggs B. Histograms of oriented gradients for human detection. Proceedings of the 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Diego: IEEE, 2005. 886–893. [doi: 10.1109/CVPR.2005.177]

|

| [3] |

Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation. Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus: IEEE, 2014. 580–587. [doi: 10.1109/CVPR.2014.81]

|

| [4] |

Girshick R. Fast R-CNN. Proceedings of the 2015 IEEE International Conference on Computer Vision (ICCV). Santiago: IEEE, 2015. 1440–1448. [doi: 10.1109/ICCV.2015.169]

|

| [5] |

Ren SQ, He KM, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. DOI:10.1109/TPAMI.2016.2577031 |

| [6] |

He KM, Gkioxari G, Dollár P, et al. Mask R-CNN. Proceedings of the 2017 IEEE International Conference on Computer Vision (ICCV). Venice: IEEE, 2017. 2980–2988. [doi: 10.1109/ICCV.2017.322]

|

| [7] |

Cai ZW, Vasconcelos N. Cascade R-CNN: Delving into high quality object detection. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 6154–6162. [doi: 10.1109/CVPR.2018.00644]

|

| [8] |

Yang J, Wang LQ. Feature fusion and enhancement for single shot multibox detector. Proceedings of the 2019 Chinese Automation Congress (CAC). Hangzhou: IEEE, 2019. 2766–2770. [doi: 10.1109/CAC48633.2019.8996582]

|

| [9] |

Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE, 2016. 779–788. [doi: 10.1109/CVPR.2016.91]

|

| [10] |

Lin TY, Goyal P, Girshick R, et al. Focal loss for dense object detection. Proceedings of the 2017 IEEE International Conference on Computer Vision (ICCV). Venice: IEEE, 2017. 2999–3007. [doi: 10.1109/ICCV.2017.324]

|

| [11] |

Caicedo JC, Lazebnik S. Active object localization with deep reinforcement learning. Proceedings of the 2015 IEEE International Conference on Computer Vision (ICCV). Santiago: IEEE, 2015. 2488–2496. [doi: 10.1109/ICCV.2015.286]

|

| [12] |

Bellver M, Giró-i-Nieto X, Marqués F, et al. Hierarchical object detection with deep reinforcement learning. arXiv: 1611.03718, 2016.

|

| [13] |

Jie ZQ, Liang XD, Feng JS, et al. Tree-structured reinforcement learning for sequential object localization. Proceedings of the 30th International Conference on Neural Information Processing Systems. Barcelona: Curran Associates Inc., 2016. 127–135.

|

| [14] |

Xu N, Huo CL, Zhang X, et al. AHDet: A dynamic coarse-to-fine gaze strategy for active object detection. Neurocomputing, 2022, 491: 522-532. DOI:10.1016/j.neucom.2021.12.030 |

| [15] |

Ayle M, Tekli J, El-Zini J, et al. Bar—A reinforcement learning agent for bounding-box automated refinement. Proceedings of the 34th AAAI Conference on Artificial Intelligence. Palo Alto: AAAI Press, 2020. 2561–2568. [doi: 10.1609/aaai.v34i03.5639]

|

| [16] |

König J, Malberg S, Martens M, et al. Multi-stage reinforcement learning for object detection. Proceedings of the 2019 Computer Vision Conference. Las Vegas: Springer, 2019. 178–191. [doi: 10.1007/978-3-030-17795-9_13]

|

| [17] |

Zhou M, Wang RJ, Xie CJ, et al. ReinforceNet: A reinforcement learning embedded object detection framework with region selection network. Neurocomputing, 2021, 443: 369-379. DOI:10.1016/j.neucom.2021.02.073 |

| [18] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7132–7141. [doi: 10.1109/CVPR.2018.00745]

|

| [19] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition. Proceedings of the 3rd International Conference on Learning Representations. San Diego: ICLR, 2015.

|

| [20] |

Wang ZY, Schaul T, Hessel M, et al. Dueling network architectures for deep reinforcement learning. Proceedings of the 33rd International Conference on Machine Learning. New York: JMLR.org, 2016. 1995–2003.

|

2024, Vol. 33

2024, Vol. 33