2. 香港大学 理学院, 香港 999077;

3. 马拉达伦大学 未来智能技术系, 西曼兰 72123

2. Faculty of Science, The University of Hong Kong, Hong Kong 999077, China;

3. Division of Intelligent Future Technologies, Mälardalen University, Västmanlands Län 72123, Sweden

实验室科研团队及其成员的研究产出(如发表的论文数量、申请的发明专利和课题数量)是各大高校和科研院所采用的重要业绩评估指标[1]. 然而, 影响实验室成员及其团队科研产出的影响因素比较复杂, 如科研任务与科研人员兴趣、能力的匹配度, 实验室科研任务分配的合理性, 科研人员的时间投入及其科研效率等. 这些因素都直接影响实验室团队的研究产出和研究队伍建设, 以及成员个人的研究产出、对科研过程的满意度等. 2022年芝加哥大学的Adam Weiss就玩手机行为对科研人员工作过程及其效率的影响, 在《Nature Careers Community》期刊上发表了一篇题为“Turning off my phone improved my science”的文章[2]. 该文章指出, 在科研工作过程中频繁玩手机, 会影响对科学问题的深入思考、降低科研工作效率, 增加无效的科研时间投入[3–5].

目前, 关于实验室科研团队任务调度过程和科研人员工效的分析和评估研究较少, 不利于优化现有的科研评价体系和提高实验室科研团队的研究产出. 采用量化方法记录和评估实验室团队及其成员的科学研究工作过程, 发掘制约实验室团队研究产出和成员个人科研工效的过程性因素, 通过实验室团队任务管理优化和科研人员自我反思提高科研工作效率及其满意度, 是当前实验室科研团队和科研人员亟待解决的重要问题. 科研工效的评估和比较, 有助于促进实验室成员相互激励、自我反思科研过程中存在的问题, 如频繁玩手机影响对科学问题的深入思考, 造成宝贵科研时间的浪费等. 为此, 我们针对实验室科研工作过程评估和科研工效分析的需求, 研究了一个基于多模态的实验室科研工效分析系统MASRE.

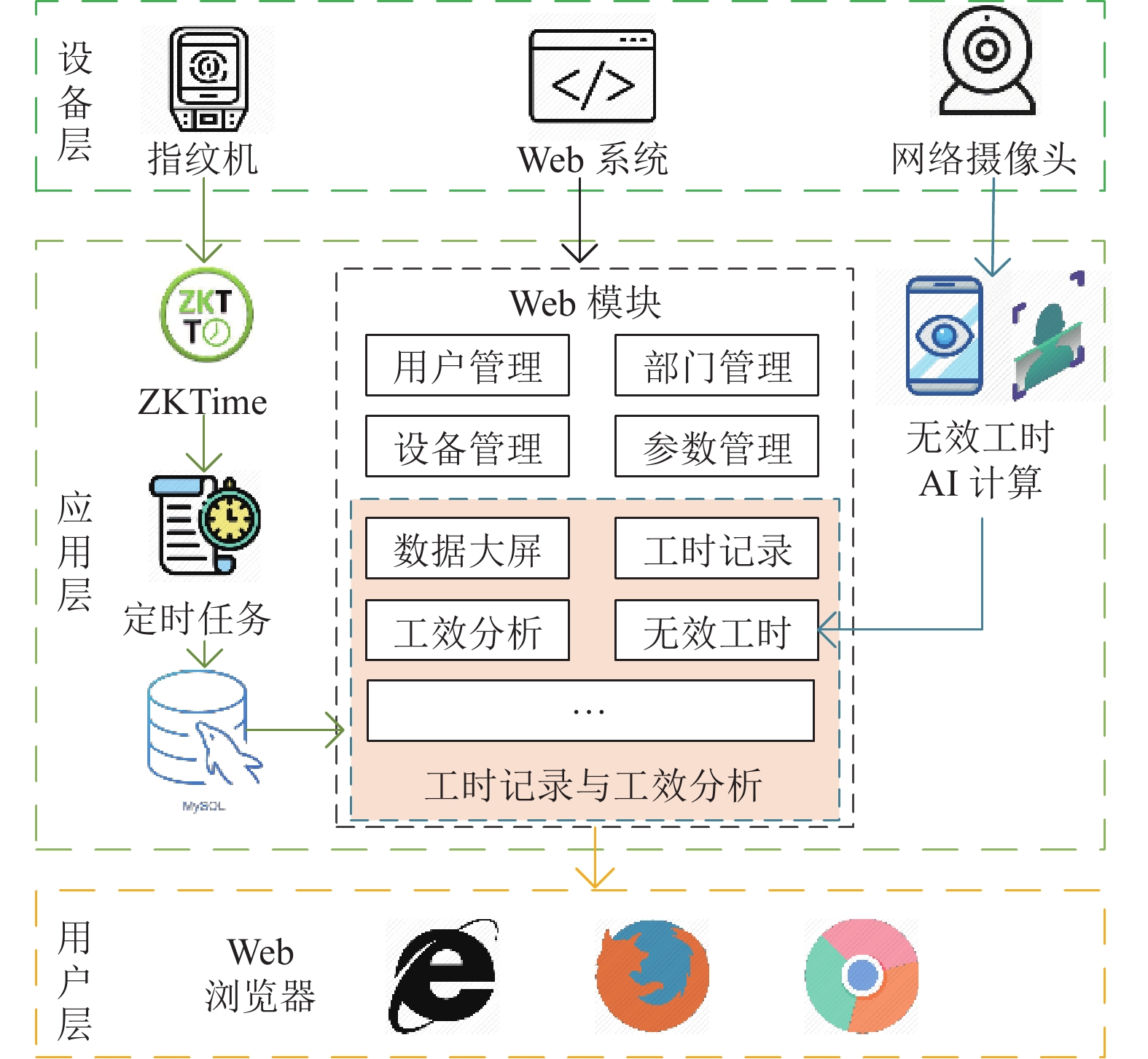

1 系统架构与功能如图1所示, 基于多模态的科研工效分析系统MASRE由设备层、应用层和用户层构成. 其中, 设备层主要由用来进行多模态工时数据采集的指纹机、Web系统、网络摄像头等组成. 应用层包括两大核心功能, 即基于监控视频的无效工时AI计算, 以及用于工时计算和工效评估的Web模块. 用户层是用来进行系统管理和访问的各种Web浏览器, 如Microsoft Edge、Google Chrome、Mozilla Firefox等.

|

图 1 基于多模态的科研工效分析系统架构 |

MASRE系统的应用层提供用户管理、部门管理、设备层中所有设备管理等信息管理功能, 支持通过参数管理配置用户角色、用户系统访问权限、实验室上下班考勤时间范围等科研团队工效分析的个性化信息. 此外, 应用层详细记录实验室成员的工时, 包括考勤机打卡工时和通过Web系统登记的工时, 利用AI计算模块基于网络摄像头自动识别的科研人员因玩手机行为导致的无效工时. 在此基础上, 依据实验室认定的科研产出记录成员的学术积分, 利用所设计的科研工效计算方法分析实验室成员的科研工效. 以本文作者所属团队的科研工效分析为例, MASRE系统的部署场景及其主页面如图2所示, 系统部署所需的硬件设备包括1台高性能计算服务器、1个指纹考勤机和1个或多个高清摄像头.

MASRE系统的核心功能及其特色表现在: (1)将科研工作中的有效工时界定为工作时间减去较长时间玩手机行为导致的无效工时, 并支持基于网络摄像头和玩手机行为识别方法自动记录实验室科研人员的无效工时; (2)详细记录实验室科研人员的工作过程, 以可视化图形方式实时展示实验室成员的工时、有效工时、工效的实时对比与分析结果, 激励科研人员投入较多科研时间; (3)以学术积分方式评估科研产出, 基于学术积分/获得该积分所用的总工时评估实验室成员的科研工效; (4)支持通过实验室成员的科研工效分析和对比, 挖掘制约实验室科研团队及其成员科研效率提升的关键因素, 帮助实验室科研团队及其成员个人提高科研效率和研究产出; (5)为保护用户隐私, 系统对所有用户信息、工时和工效数据进行加密存储, 且不保存用户科研工作过程的任何图像信息.

|

图 2 MASRE系统试验场景及其主页面 |

2 系统实现的关键技术 2.1 多模态科研工时采集与统计

MASRE系统支持通过指纹考勤机、人脸识别考勤机、Web系统、网络摄像头等多模态方式, 采集自愿参与实验室科研工效分析的科研人员的工时和无效工时数据. 然后, 系统根据实验室设置的上下班日期时间范围, 确定上下班打卡时间区间、当日实验室要求的基本工时.

系统采用一个定时任务, 每隔5 min更新一次考勤机中用户考勤记录, 并将其写入MASRE系统的工时数据表, 以实现来自考勤机的工时数据采集. 系统采用上、下班时间, 这样成对的时间区间记录工时. 针对用户忘记在下班时间打卡的问题, 系统提供在下个工时统计时间区间开始的前5 min, 为该用户进行自动打下班卡. 而非到了下班时间, 系统就立即自动打下班卡, 这样的设计可避免用户在某上班时间段外加班导致的额外工时无法正确记录的问题. 同时, 为采集用户因参加实验室会议、外出科研工作等原因无法利用考勤机记录的工时, MASRE系统支持以外出申请和参会方式自动记录工时信息. 参加会议和外出出差的自动打卡也是依据实验室上下班时间范围进行数据写入, 这是为了避免因参加会议(或外出科研工作)的工时与考勤机工时重复的问题.

为了使实验室成员之间形成相互激励机制, MASRE系统以折线图和柱状图的形式, 在数据大屏页面实时显示实验室成员当日(当周/当月/当年)的最长和最短工时排名、早到晚退排名.

2.2 基于二进制的工时统计由于部分考勤机的工时记录同步时间间隔较长(如5 min)时, 系统无法实时更新用户工时记录. 这样, 当工时记录的时间区间重叠时, 可能会出现如图3中编号为1871和1876的工时记录. 为此, MASRE系统采用时间差值的方法计算工时, 利用360个16进制数表示一天的24 h, 采用位运算进行工时统计. 单个用户每日工时记录的合并采用或运算. 合并后的16进制数转换为一个长度为1440位的二进制数, 其中1的个数即为当日该用户的总工时(单位为min). 所设计的工时统计方法如算法1所示, 既可解决工时记录可能存在时间交叉的问题, 也可降低计算逻辑的复杂性.

|

图 3 系统采集的多模态工时记录(含时间重叠的工时记录) |

算法1. 用户当日工时统计

输入: 当日工时记录records

输出: 当日总工时workHours (h)

1)将records按照上班和下班时间进行匹配, 获得多个工时区间workTimeList;

2) work = 0 //用户当日工时区间的16进制表示

3) for workTime in workTimeList

4) hex = tranferToHex(workTime); //将工时区间转换为16进制表示形式

5) work = work | hex; //将每个工时区间互相进行按位或运算

6) end for

8) count = 0; //用户当日的总工时(min)

9) while work!=0 do //统计二进制数work中1的个数, 即计算count的值

10) work &= (work – 1);

11) count ++;

12) end while

13) workHours = count/60; //用户当日工时

只要将算法1的输入改为当日用户的无效工时记录, 即可实现用户当日无效工时的统计. 此外, 采用按位与运算可判断两个时间区间是否存在冲突, 以实现系统自动判断用户提交会议邀请时的时间区间错误提醒.

2.3 基于玩手机行为的无效工时统计实验室科研工作过程中的玩手机行为具有以下两个基本特征[6,7]: (1)动作的持续性. 只用当玩手机动作在某段时间(如25 s)内持续出现, 才应被界定为玩手机行为. 否则, 将出现的玩手机动作归于正常的手机使用行为, 如接打电话、回复消息等. (2)动作的间接性. 玩手机行为实施过程中, 用户并不一定每秒钟都会发生一个玩手机动作, 出现的玩手机动作往往间隔数秒. 为此, 只有用户发生了一定时长的玩手机行为, 才会导致无效工时的产生. 此外, 构成一次玩手机行为的多个玩手机动作之间可能有一定的时间间隔.

依据玩手机行为的上述特征, 设计了一种如图4所示的无效工时检测方法, 以自动采集实验室科研人员工作过程中玩手机行为导致的无效工时. 如图4所示, 基于玩手机行为识别自动采集无效工时的方法包括以下几个步骤: (1)从网络视频流中每隔5 s采样一帧图像, 利用单步目标检测模型YOLOv7[8]检测其中的人(person对象)和手机(watching-phone对象). (2)若检测到watching-phone对象, 则表示该帧图像中存在玩手机动作. 这时, 计算watching-phone区域和person区域和IoU (intersection over union)值, 将与每个wathing-phone区域IoU值最大的一个person对象标识为存在玩手机动作的人. (3)裁剪获得视频帧中存在玩手机动作的person对象区域, 采用本文所设计的姿态可变人脸识别算法识别发生玩手机动作的行为人. (4)采用本文设计的玩手机行为识别算法, 自动识别用户是否发生了玩手机行为. (5)若某用户发生了一段时间的玩手机行为, 则通过工效系统提供的API写入一组无效工时记录, 以记录该用户无效工时的起止时间.

|

图 4 无效工时检测方法 |

为实现无效工时统计, 本文所设计的玩手机动作检测算法、姿态可变的人脸识别算法和玩手机行为识别算法分别在第3节进行具体论述.

3 基于玩手机行为的无效工时计算方法这部分详细阐述为实现MASRE系统的无效工时计算, 所设计的玩手机动作检测算法、姿态可变的人脸识别算法和玩手机行为识别算法.

3.1 玩手机动作检测算法为实现用户玩手机动作检测, 首先从PaddleX违规规使用手机数据集中选取了1589个清晰度较高、非打电话动作的样本. 其次, 利用实验室网络摄像头采集了669个玩手机动作的新样本. 最后, 利用数据集标注工具Labelimg 对采集的2258个图像样本进行重新标注, 共标注了3511个person对象和2602个watching-phone对象, 数据集格式采用PASCAL VOC.

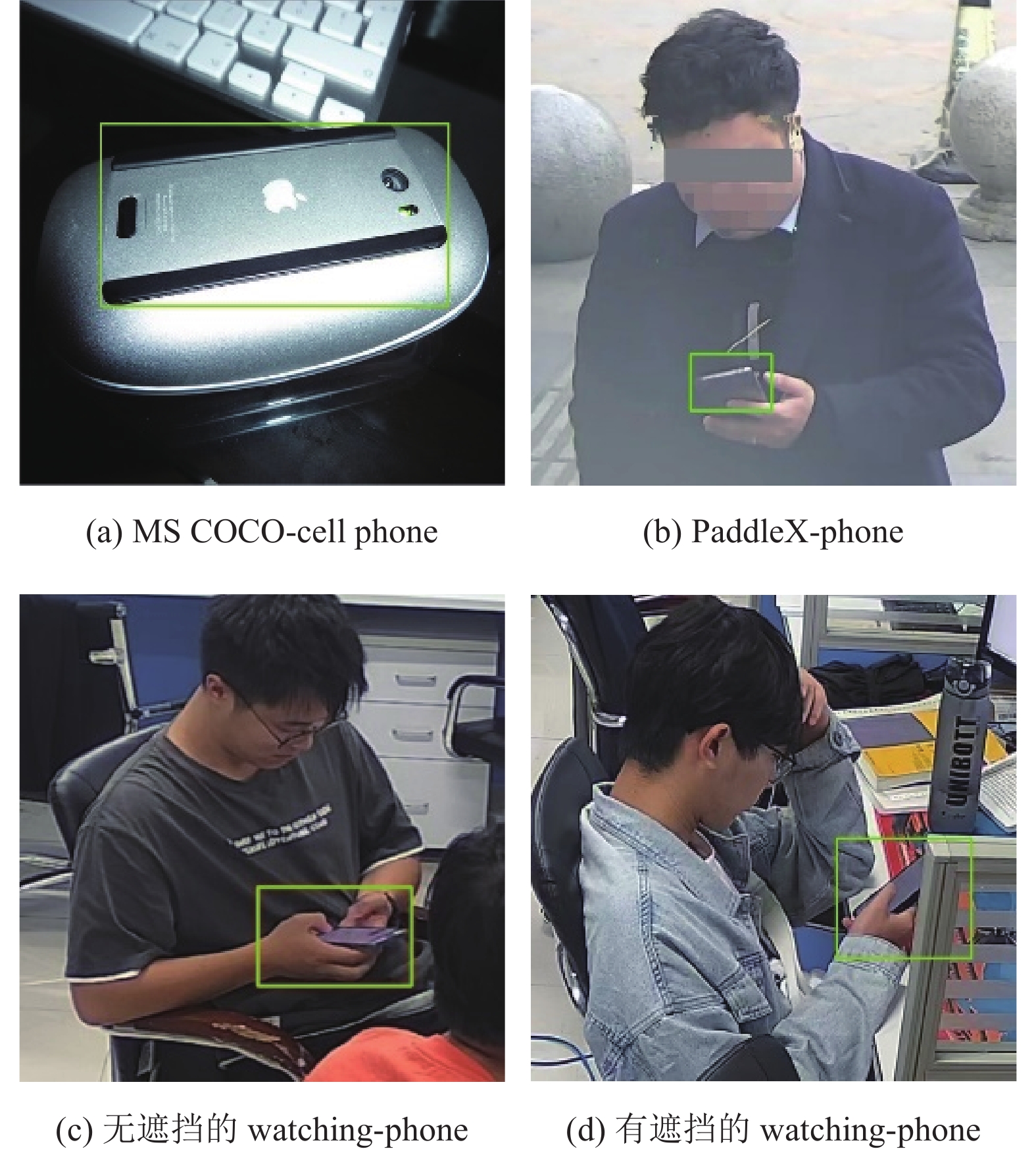

从图5可以看出, 目标检测数据集MS COCO[9]中标注的cell phone对象和PaddleX违规使用手机数据集中标注的phone对象仅标注了手机区域(如图5(a)和图5(b)所示), 不能很好地标识发生玩手机动作时手与手机的相互特征. 在标注用于玩手机动作检测的watching-phone对象时, 充分考虑玩手机动作发生时, 手机周围应有用户手的图像信息. 因此, 将watching-phone对象的边框界定为用户手腕的位置(如图5(c)所示), 以避免放在桌上的手机被误检为watching-phone对象. 同时, 由于实验室工作环境比较复杂, 玩手机动作中的手机可能存在被遮挡的问题. 因此, 采集并标注了53张有遮挡现象的样本, 如图5(d)所示.

|

图 5 wathing-phone对象与其他数据集中phone对象标注方法的对比 |

|

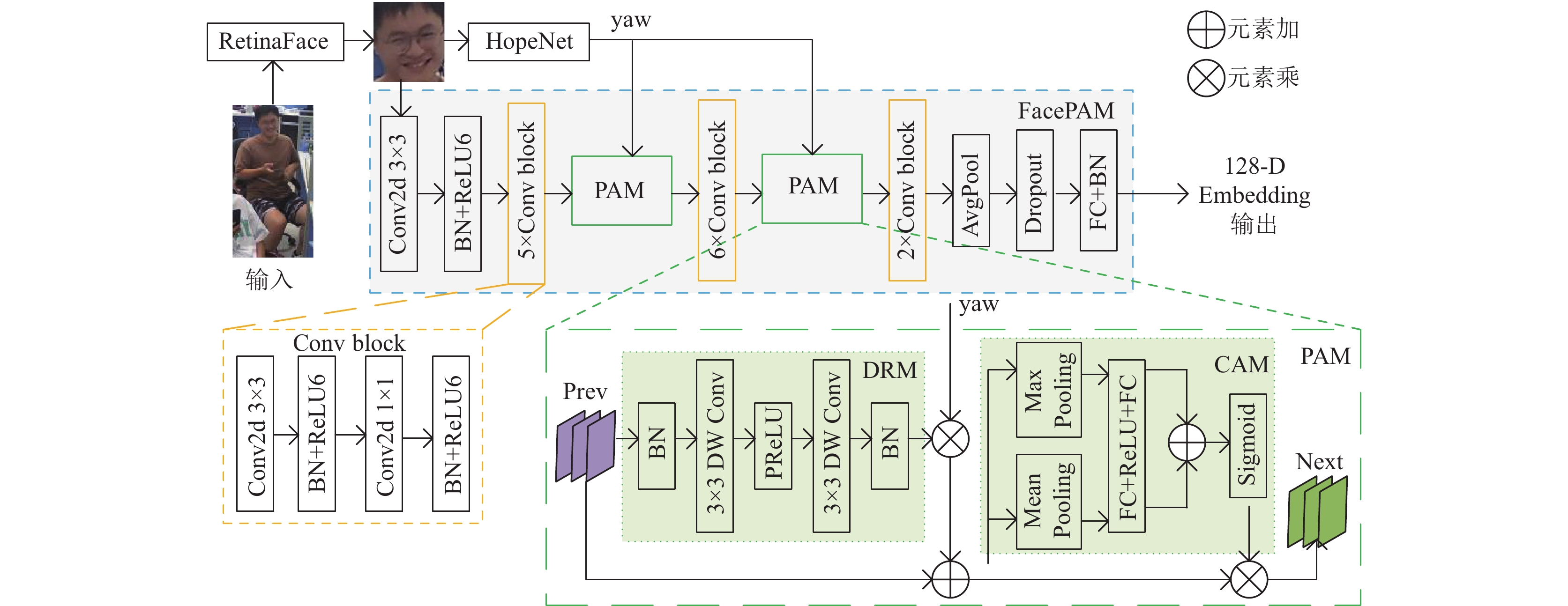

图 6 姿态可变的人脸识别模型FacePAM的网络结构 |

基于玩手机动作检测数据集和PyTorch实现的YOLOv7模型, 我们在NVIDIA 1080Ti GPU上训练了一个玩手机动作检测模型(person和watching-phone的检测精度分别达到了97.98%和95.72%), 用于实现面向网络监控视频的玩手机动作检测.

3.2 姿态可变的人脸识别算法大部分人脸识别算法受限于正面人脸的要求, 姿态可变的人脸识别成为解决真实场景中人脸识别问题的关键技术. 为根据person对象中姿态多变的人脸图像准确识别玩手机动作的人员身份[10], 设计了一种端到端的姿态可变的人脸识别算法HRP, 包括基于RetinaFace[11]的人脸检测、基于HopeNet[12]的头部姿态估计、姿态可变的人脸识别模型FacePAM (如图6所示)共3个部分.

RetinaFace是一种单步的高性能人脸检测网络, 从视频图像帧中准确提取人脸图像, 作为下一步头部姿态估计模块和人脸识别模型FacePAM的输入. 头部姿态估计采用多损失深度神经网络HopeNet, 根据输入的二维人脸图像预测头部姿态的偏航角yaw. 姿态可变的人脸识别模型FacePAM的输入是人脸检测模型RetinaFace输出的人脸图像和HopeNet模型预测的偏航角yaw, 输出的是一个用于人脸特征匹配的128维向量(128-D Embedding). 利用FacePAM模型输出的人脸特征向量, 检索用户人脸图像库中特征相似度最大的人脸图像, 从而识别玩手机用户的身份信息.

姿态可变的人脸识别模型FacePAM是HRP算法的核心, 主要由卷积层、卷积块(Conv block)、姿态注意力模块PAM (pose attention module)[13]等构成. 其中, 卷积块由1个3×3大小的卷积层、Batch normalization (BN)层、ReLU6激活层、1个1×1大小的卷积层等构成, 用于人脸特征的提取. PAM模块包括深度残差模块DRM (depthwise residual module)和通道注意力模块CAM (channel attention module)两部分. DRM模块使用Depthwise卷积网络学习头部姿态变化的附加特征, 输出特征首先与HopeNet预测的偏航角yaw进行按元素相乘运算, 然后与其输入特征进行按元素相加, 得到CAM模块的输入特征. CAM模块对经过最大池化(max pooling)和平均池化(mean pooling)后的特征进行按元素相加, 并将经Sigmoid函数处理的特征与CAM模块的输入特征进行按元素相乘, 得到PAM模块输出的通道注意力特征. PAM模块的引入, 可在分层特征空间提取人脸姿态特征, 提高姿态变化场景中的人脸识别准确度.

RetinaFace和HopeNet分别采用在WIDER FACE[14]和300W-LP数据集[15]上训练得到的模型. 在CASIA-WebFace数据集[16]上训练的FacePAM模型, 在LFW数据集[17]上的人脸识别精度达到了98.61%.

3.3 玩手机行为识别算法根据玩手机行为的两大特征[18–20], 设计了一种基于玩手机行为识别的无效工时计算算法, 如图7所示. 该算法的输入是视频流中玩手机动作检测和人脸识别的结果, 输出检测到的用户无效工时. 以用户A为例, 假设其初始状态的玩手机动作因子a_x=0 (0

当用户A的玩手机动作因子a_x<5时, 检测到用户A的玩手机动作, 表示出现了用户A正常使用手机的动作. 当a_x从0增加到5时(a_x

当用户A的玩手机动作因子a_x<5时, 检测到用户A的玩手机动作, 表示出现了用户A正常使用手机的动作. 当a_x从0增加到5时(a_x

构成同一次玩手机行为的动作之间可能间隔数秒. 当检测到用户的一次玩手机行为结束时, 立即写入无效工时记录不符合玩手机行为的这一重要特征, 也无法表示玩手机行为导致无效工时的真实情况. 经过统计分析, 将两次玩手机行为之间的最长间隔为设置为70 s比较符合玩手机行为的间歇性特征. 因此, 无效工时计算算法在检测到玩手机行为结束70 s后, 才进行无效工时写入. 在检测到用户A的某次玩手机行为结束时, 将无效工时写入计时器变量a_time赋值为14. 当用户A未发生新的玩手机动作时, 执行计时操作a_time=a_time–1. 当a_time=0 (玩手机行为已结束14×5=70 s)时, 写入用户A的本次无效工时记录, 开始时间为t1, 结束时间为t2. 若在t2时刻之后的70 s时间间隔内, 系统再次检测到用户A的玩手机动作且a_x增加到5时, 表示用户A正在发生的玩手机行为并未结束, 则这时将a_flag重置为1. 同时, 当在a_x减到2 (a_x<3)且a_flag=1时, 更新玩手机行为结束时刻t2的值, 并根据后续视频图像帧中玩手机动作的检测结果判断用户A是否结束了本次玩手机动作. 当用户A结束本次玩手机行为之后, a_x将从3减少到0, 以开始下一次基于玩手机行为的无效工时计算.

|

图 7 基于玩手机行为识别的无效工时计算算法 |

4 科研工效分析方法及其应用案例

MASRE系统首先根据实验室的科研产出评价标准, 将科研产出(如学术论文、发明专利、软件著作权、竞赛获奖、科研项目等)以学术积分形式进行量化. 同时, 系统将科研工效界定为学术积分与获得该积分所用工时(kh为单位)的比值. 依据每个科研产出获取期间的工时和有效工时, 系统分别计算工效A (学术积分/有效工时)和工效B (学术积分/工时), 并以折线图的形式显示实验室成员的工时排名和工效排名. 此外, 采用(工效A–工效B)/工效A方法计算工效损失率, 以评估玩手机行为对科研工效的影响. 实验室成员可通过个人中心查看不同时间区间内其工效的变化曲线以及玩手机行为对工效的影响情况, 分析自己科研过程中存在的问题及其影响因素.

以2022年10月20日–2022年11月14日期间, p1、p2和p3这3位作者合作完成本系统软件著作权申请材料撰写的科研过程为例, 进行实验室科研工效分析. 团队将该项科研产出的学术积分认定为2.0分, p2和p3分别完成了玩手机动作检测算法、姿态可变的人脸识别和玩手机行为识别算法3部分申请材料内容的撰写, 均获得学术积分0.5分. p1则完成了其余部分申请材料的撰写和统稿工作, 故获得学术积分1.0分. MASRE系统针对这项科研产出计算的科研工效结果如表1所示.

| 表 1 实验室科研工效分析案例 |

从表1可以看出, p2和p3的学术积分相同, 但前者的工时比后者少21.17 h, 故前者的工效高于后者. 同时, 前者的工效损失率明显低于后者, 这是因为前者由于玩手机行为导致的无效工时较少. p1的工时最少、工效最高, 但其玩手机行为导致的无效工时却最高, 其工效损失率达到了30.83%. 从该实例可以看出, 玩手机行为对实验室科研工效具有显著影响. 若p1将无效工时降低到团队最小(3.25 h), 则他仅用59.30 h工时即可完成该项科研任务, 其工效A将从17.84分/kh提高到29.15分/kh. 这样, p1将会节省其获得同样科研产出所需的工时, 提高科研工效, 创造更轻松的科研工作过程. 另一方面, 若他投入同样的81.05 h工时开展科研工作, 其将可能获得额外0.37分的科研产出.

5 结束语针对实验室科研工作过程性评估的需求, 研究了一种基于多模态的科研工效分析系统MASRE. 该系统支持利用多模态设备采集实验室科研工作者的工时数据, 基于网络监控视频自动识别科研工作过程中的玩手机行为及其导致的无效工时. 此外, MASRE系统可根据统计的工时、无效工时和科研工作获得的学术积分, 自动计算实验室成员的科研工效. 依据科研工效计算结果, 实验室成员可对自己的科研工作过程进行评估, 发现和反思影响自己科研工效提升的过程性因素, 如长时间玩手机行为导致对研究内容的思考不够深入等. 同时, 实验室负责人可依据团队成员的科研工效, 分析实验室科研任务分配及其进度安排的科学性和合理性, 探索实验室科研任务协同与调度的优化策略, 提高团队成员及整个实验室的科研产出.

| [1] |

Gralka S, Wohlrabe K, Bornmann L. How to measure research efficiency in higher education? Research grants vs. publication output. Journal of Higher Education Policy and Management, 2019, 41(3): 322-341. DOI:10.1080/1360080X.2019.1588492 |

| [2] |

Weiss A. Turning off my phone improved my science. Nature, 2022.

|

| [3] |

Lin YQ, Liu Y, Fan WJ, et al. Revisiting the relationship between smartphone use and academic performance: A large-scale study. Computers in Human Behavior, 2021, 122: 106835. DOI:10.1016/j.chb.2021.106835 |

| [4] |

杨阳, 杨晟云, 宋雯静. 手机成瘾与研究生学业拖延: 中介和调节作用分析. 甘肃广播电视大学学报, 2021, 31(1): 78-84. |

| [5] |

Abd Rashid J, Aziz AA, Rahman AA, et al. The influence of mobile phone addiction on academic performance among teenagers. Jurnal Komunikasi: Malaysian Journal of Communication, 2020, 36(3): 408-424. DOI:10.17576/JKMJC-2020-3603-25 |

| [6] |

王泽杰, 沈超敏, 赵春, 等. 融合人体姿态估计和目标检测的学生课堂行为识别. 华东师范大学学报(自然科学版), 2022(2): 55-66. |

| [7] |

王文雅. 办案区场景玩手机行为识别的深度学习算法[硕士学位论文]. 西安: 西安电子科技大学, 2021.

|

| [8] |

Wang CY, Bochkovskiy A, Liao HYM. YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors. arXiv:2207.02696, 2022.

|

| [9] |

Lin TY, Maire M, Belongie S, et al. Microsoft COCO: Common objects in context. Proceedings of the 13th European Conference on Computer Vision. Zurich: Springer, 2014. 740–755.

|

| [10] |

王治强, 孙晓东, 杨永, 等. 人脸识别算法在考勤系统的应用. 计算机系统应用, 2021, 30(1): 89-93. DOI:10.15888/j.cnki.csa.007755 |

| [11] |

Deng JK, Guo J, Ververas E, et al. RetinaFace: Single-shot multi-level face localisation in the wild. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 5202–5211.

|

| [12] |

Ruiz N, Chong E, Rehg JM. Fine-grained head pose estimation without keypoints. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Salt Lake City: IEEE, 2018. 2074–2083.

|

| [13] |

Tsai EJ, Yeh WC. PAM: Pose attention module for pose-invariant face recognition. arXiv:2111.11940, 2021.

|

| [14] |

Yang S, Luo P, Loy CC, et al. WIDER FACE: A face detection benchmark. IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 5525–5533.

|

| [15] |

Zhu XY, Lei Z, Lin XM, et al. Face alignment across large poses: A 3D solution. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 146–155.

|

| [16] |

Yi D, Lei Z, Liao SC, et al. Learning face representation from scratch. arXiv:1411.7923, 2014.

|

| [17] |

Huang GB, Ramesh M, Berg T, et al. Labeled faces in the wild: A database for studying face recognition in unconstrained environments. Technical Report, Amherst. 2007.

|

| [18] |

詹健浩, 吴鸿伟, 周成祖, 等. 基于深度学习的行为识别多模态融合方法综述. 计算机系统应用, 2023, 32(1): 41-49. DOI:10.15888/j.cnki.csa.008805 |

| [19] |

周雪雪, 雷景生, 卓佳宁. 基于多模态特征学习的人体行为识别方法. 计算机系统应用, 2021, 30(4): 146-152. DOI:10.15888/j.cnki.csa.007875 |

| [20] |

吴晨, 孙强, 倪宏宇, 等. 基于骨架序列提取的异常行为识别. 计算机系统应用, 2022, 31(11): 215-222. DOI:10.15888/j.cnki.csa.008773 |

2024, Vol. 33

2024, Vol. 33