2. 贵州民族大学 贵州省模式识别与智能系统重点实验室, 贵阳 550025

2. Guizhou Province Key Laboratory of Pattern Recognition and Intelligent Systems, Guizhou Minzu University, Guiyang 550025, China

面部表情识别是人类表达情感的主要方式之一, 在人际交往过程中, 面部表情是人们相互传递和理解情绪状态的重要媒介之一. 随着人工智能的发展, 其在人机交互、自动驾驶、安全监控、心理健康评估、智能辅助等方面具有广泛的应用研究价值. 因此, 面部表情识别受到越来越多的关注, 我们把对面部表情(中性、高兴、生气、悲伤、恐惧、厌恶、惊讶、轻蔑等)的情绪状态研究称为面部表情识别. 虽然面部表情识别在许多领域展现出很高的应用价值, 但在识别过程中会遇到诸多不可避免的问题, 如局部遮挡. 局部遮挡导致面部难以提取有效的识别特征, 从而降低局部遮挡条件下面部表情识别的准确率. 如何在面部处于局部遮挡的状态下准确地识别面部表情, 仍然是一个亟待解决的重大研究课题.

早期传统的机器学习方法主要使用手工制作的特征或浅层学习, 如局部二值模式(LBP)[1]、稀疏学习[2]和方向梯度直方图(HOG)[3]. 然而, 在局部遮挡下这些手工制作的特征通常不够鲁棒和准确. 随着深度学习的不断发展, 许多研究者提出了各种深度学习网络模型[4–6]. 近年来, 局部遮挡的面部表情识别的注意机制也得到了更多的研究, 重点关注更有意义的表达区域[7,8]. Wang等人[9]提出了区域注意力网络(RAN)来自适应的获取表情的关键区域, 缓解了局部遮挡变化带来的表情识别问题, 但采用固定位置裁剪、随机裁剪和基于标志点的裁剪方法, 可能导致局部区域的位置不确定性, 同时使用单一的注意力机制可能无法同时关注面部的多个区域特征. Zhao等人[10]设计了全局多尺度和局部注意网络(MA-Net)来关注局部与全局显著特征, 以减少局部遮挡的干扰问题, 但单一的局部注意力块专注几个不重叠的区域, 可能会导致一些关键的信息丢失. Xue等人[11]提出了能够学习丰富的关系感知局部表示的迁移模型, 引导该模型学习斑块内的不同信息, 并确定斑块之间的丰富关系, 该方法可以提高面部表情识别的准确性, 并且能够更好地捕捉到不同表情之间的关系, 在一定程度上缓解了局部遮挡面部表情识别的问题. Liu等人[12]提出了自适应局部裁剪, 特别是对眼和嘴部分别进行裁剪, 引导模型找到更易区分的部分, 对局部遮挡变化具有鲁棒性, 但该方法无法准确裁剪与表情相关的关键区域, 可能会产生一些冗余的特征. Ju等人[13]基于掩码的注意力并行网络, 利用关键地标检测提取的二值掩码构建基于掩码的注意力模块, 定位与表达相关的区域, 嵌入到并行网络提取特征, 将提取的并行特征从空间维度上分割成多个独立的块, 独立预测面部表情, 以解决局部遮挡问题. 单一的掩码注意力模块可能无法获取面部多个区域的特征, 导致获取的面部特征信息不够丰富. Gong等人[14]提出一种基于多特征融合网络(MFNet), 设计了浅层Gabor卷积网络, 增强了学习特征对方向和尺度变化的适应能力及局部细节特征的捕获能力, 提高了野外表情识别的准确率. 该方法利用局部和分层特征来缓解野外的面部表情识, 在遮挡的情况下, 提取特征具有一定的局限性. Ruan等人[15]针对局部遮挡的面部, 提出了一种构建路径选择多网络模型的方法, 以实现面部局部遮挡场景下的表情识别. 文献[16]提出了一种遮挡面部表情识别框架FER-AM, 结合注意力机制网络对不同的特征分配不同的权重, 进而能够使得 FER-AM 更关注人脸面部的关键特征, 如未被遮挡的区域, 最终能够有效地解决面部遮挡问题.

局部遮挡条件下的直接对面部进行特征提取仍然面临一定的困难, 因此, 许多学者尝试着利用注意力机制关注局部特征, 以获得关键区域的表达信息及鲁棒特征. 注意力机制是通过引导模型关注局部未被遮挡的面部区域, 有效选择面部局部区域特征, 缓解了遮挡条件下的面部表情识别问题. 然而, 这些方法都是通过单一的注意力机制来引导模型, 而局部遮挡的面部表情识别可能需要多个区域特征来识别表情. 因此, 为了解决局部遮挡条件下面部难以提取有用识别特征的问题, 本文提出了一种基于加权多头并行注意力的局部遮挡面部表情识别模型, 该模型能够同时关注局部未被遮挡的多个面部区域, 并且以较小的参数量和计算量提高了局部遮挡下面部表情识别的准确率.

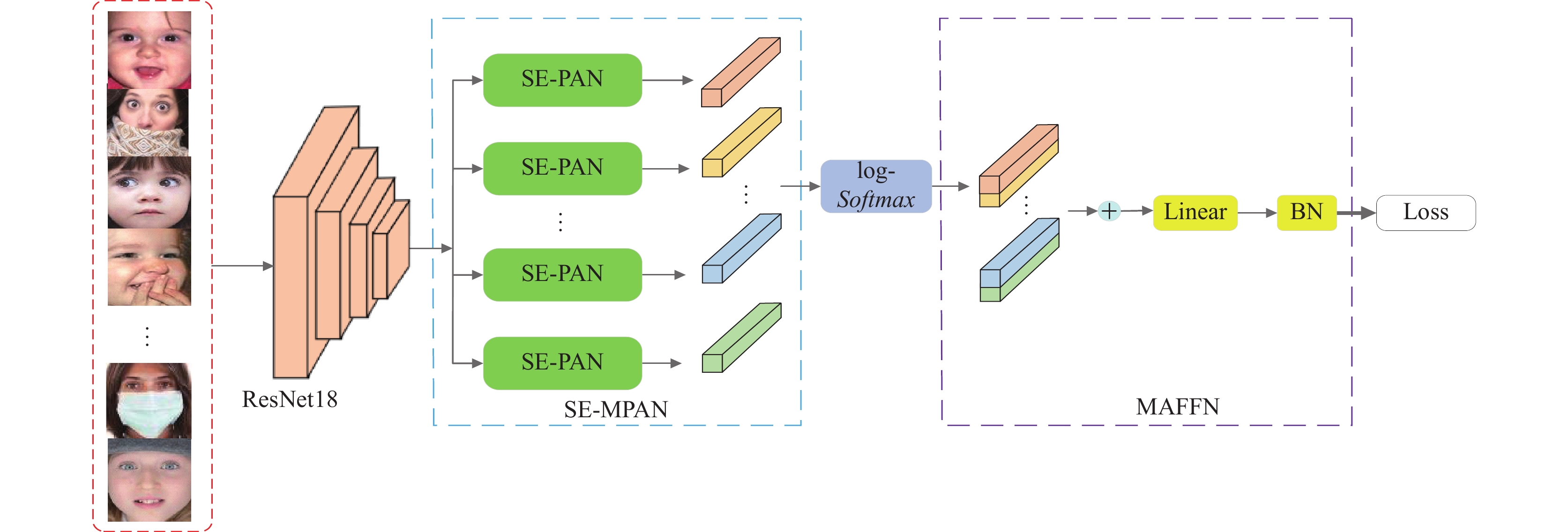

2 模型框架本文所提出的模型由特征提取器(ResNet18)、加权多头并行注意力网络(SE-multi-head parallel attention network, SE-MPAN)和多注意力融合网络(multi-attention fusion network, MAFN)这3部分组成, 如图1所示. 首先通过特征网络提取面部表情的基本人脸特征; 然后, SE-MPAN由多个单一的加权注意力网络(SE-attention network, SE-AN)组成, 构造多头注意子空间来同时关注面部多个区域特征; 最后, MAFN来融合多个区域特征的分布, 同时减少重复区域的聚焦, 更全面地捕捉关键表达区域.

|

图 1 基于加权多头并行注意力的局部遮挡面部表情识别模型结构图 |

2.1 特征提取器

为了建立轻量级的网络模型, 本文采用轻量级的残差网络ResNet18[17]作为骨干网络进行特征提取, 残差网络结构利用残差连接的方法能够很好地处理网络退化、梯度消失及爆炸问题. 考虑到面部表情存在类内与类间的变化问题, 为了更好地区分不同表情, 本文设计了内聚损失函数, 以优化面部表情的类内距离和类间距离, 并构建更精确的表情识别空间分布.

令γr是ResNet18骨干网络, pr是其参数, xi是输入特征向量, 则:

| X′i=γr(pr,xi) | (1) |

对于k类的面部表情识别, 在ResNet18骨干网络提取特征过程中, 采用内聚损失函数进行优化类内距离和类间距离, 该损失可表述为:

| LC=1NN∑i=1‖x′i−cyi‖22σ2c | (2) |

其中, N表示batch中训练样本的数量,

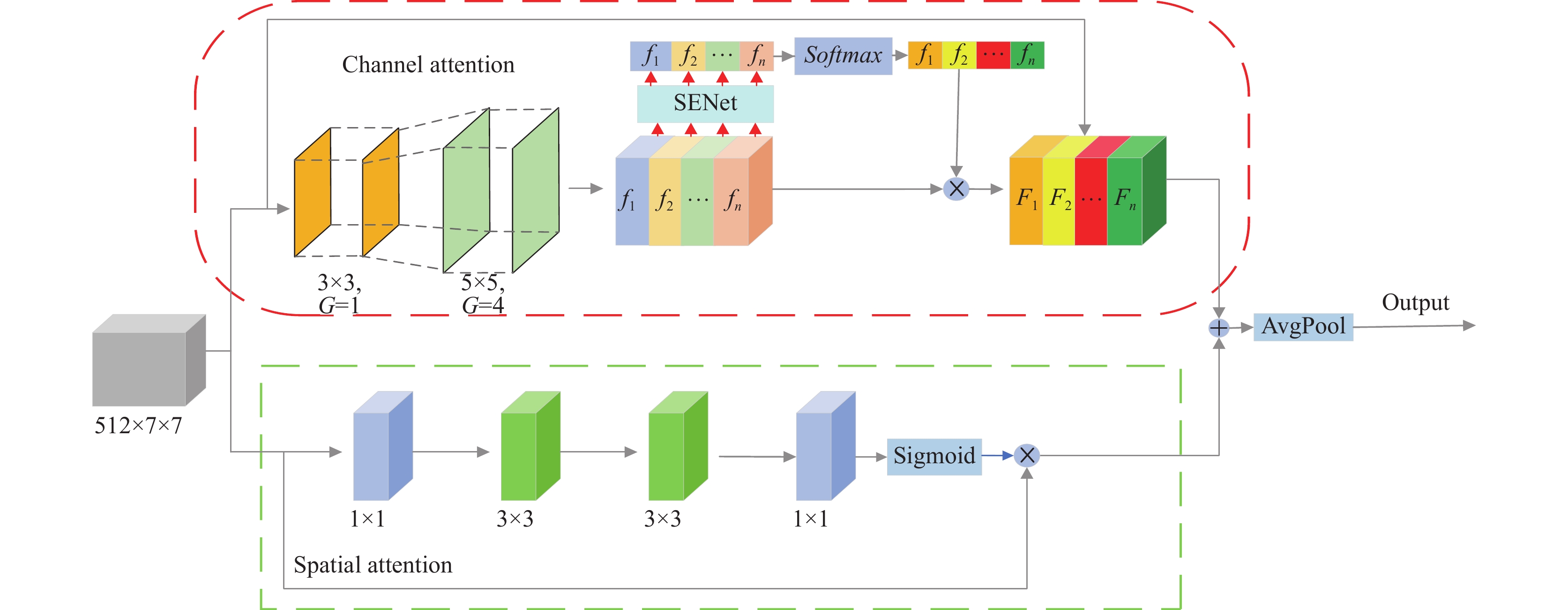

如图2所示, 加权注意力网络(SE-attention network, SE-AN)由通道注意单元和空间注意单元并行连接组成, 以获取感兴趣的面部特征区域.

|

图 2 加权并行注意力网络(SE-PAN) |

通道注意单元由两个普通的

| f=Concat([f1,f2,⋯,fn]), n=1,2,⋯,S | (3) |

为了增强每个通道间的关系, 使用轻量级的SENet模块[18]对获取的多尺度通道特征进行重新加权, 该模块称为SEWeight. 首先SEWeight的squeeze采用全局池化操作, 先将

| ZC=1W×HW∑i=1H∑j=1f(i,j) | (4) |

| Z=σ(W2δ(W1Z)) | (5) |

其中,

算法1. SE-AN通道单元模块

Input: 输入空间大小为

1. conv_kernels=[3, 3, 5, 5], conv_groups=[1, 1, 4, 4] //两个普通的

2. for S=1 to 4 do //将特征图

3. n=1, i=0

4.

5. n=n+1, i=i+1

6. end

7. end for

8.

9.

10.

11.

Output: 通道特征图

对提取的多尺度特征的通道信息使用SEWeight 进行重新加权, 以加强通道内部间的交互, 加权计算可表述为:

| Zn=SEWeight(fn), n = 1, 2, 3, ⋯, S | (6) |

其中,

| Fn=fn×Softmax(Zn) | (7) |

将所有加权重构的特征进行组合, 得到最终的通道特征, 并与输入的特征

| Foutput=X′i×Concat([F1,F2,⋯,Fn]) | (8) |

空间注意单元由两个

| F′output=X′i×σ(f1×11(f3×31(f3×31(f1×11(X′i))))) | (9) |

其中,

算法2. SE-AN空间单元模块

Input: 输入空间大小为

1.

2.

3.

4.

5.

6. end

Output: 空间特征图

最后, 将处理后的通道注意特征和空间注意特征行融, 经过全局平均池化(GAP)操作, 得到SE-AN注意特征图.

| Attentioni=Foutput+F′output, i=1,2,3,⋯,h | (10) |

其中,

加权多头并行注意力(SE-MPAN)由多个加权注意力网络(SE-AN)组成, 具体流程如算法3所示. SE-MPAN能够捕捉面部的多个区域, 形成多个注意图, 为了避免注意力重叠, 首先利用log-Softmax函数对注意图进行缩放, 强调最感兴趣的关键区域, 然后使用分区损失引导注意力集中关注不同区域, 最后将注意力图通过BN层归一化.

算法3. SE-MPAN模块

Input: SE-AN注意特征图,

1.

2.

3.

Output: 预测表情类别

假设

| log(Softmax(A))=exp(Ai)c∑j=1exp(Aj) | (11) |

其中,

分区损失可表示为:

| LAF=1NCN∑i=1C∑j=1log(1+1σ2i,j) | (12) |

其中,

本文所使用的损失函数为cross-entropy loss, 可表述为:

| LCE=−1NN−1∑i=0logeW(k)Tyiv(k)i+b(k)yiC−1∑j=0eW(k)Tyjv(k)j+b(k)yj | (13) |

其中,

最终的损失函数为:

| L=λ1LC+λ2LAF+LCE | (14) |

其中,

在RAF-DB和 FERPlus数据集上, 使用官方对齐的图像训练, 所有数据集的输入都将图像重塑为224×224大小的像素, 采用随机裁剪、水平翻转和擦除等数据增强的方法来避免过拟合. 实验采用ResNet18作为模型的基准网络, 为了公平评估模型, 使用在MSCeleb-1M[19]人脸识别数据集上预训练的ResNet18模型. 我们的方法是在 Linux/CentOS 7.6 操作系统下基于PyTorch代码实现的, 模型是在A100-PCIE-40GB的工作站上训练的. 模型的总参数是18.13M, 浮点运算次数为2.02 GFLOPs.

在模型训练过程中, 使用带动量优化器的SGD进行优化, 其中动量参数为0.9, 权重衰减设置为1E–4. 本文的方法在RAF-DB和FERPlus数据集上进行100 epochs的模型训练, 批量大小分别为256和64, 初始学习率分别为0.1和0.04, 每10个epochs衰减为原来的0.1.

3.2 数据集RAF-DB[20]是一个包含29672张真实场景的面部图像数据集, 标注了7种基本表情和11种复合表情标签, 在本文实验中, 使用7种基本表情进行表情识别, 其中训练集12271张图像, 测试集3068张图像.

FERPlus[21]是在FER2013数据集上重新标记得到的真实场景中的表情数据集, 这些图像被重新标记为10类极度不平衡的表情. 本文实验选择在7种基本表情中增加了contempt 类别表情进行测试. 其中包含28709张训练图像, 3589张验证图像, 3589张测试图像, 大小为48×48像素.

Occlusion-RAF-DB和Occlusion-FERPlus是Wang等人[9]为了检验真实遮挡场景下面部表情识别模型的性能, 分别从RAF-DB的测试集和FERPlus的测试集中建立的两个遮挡数据子集, 包含735和605张, 这些测试集标注了口罩、眼镜和手等不同类型的遮挡, 在本文的实验中, 使用Occlusion-RAF-DB和Occlusion-FERPlus两个遮挡数据子集分别验证本文所提方法.

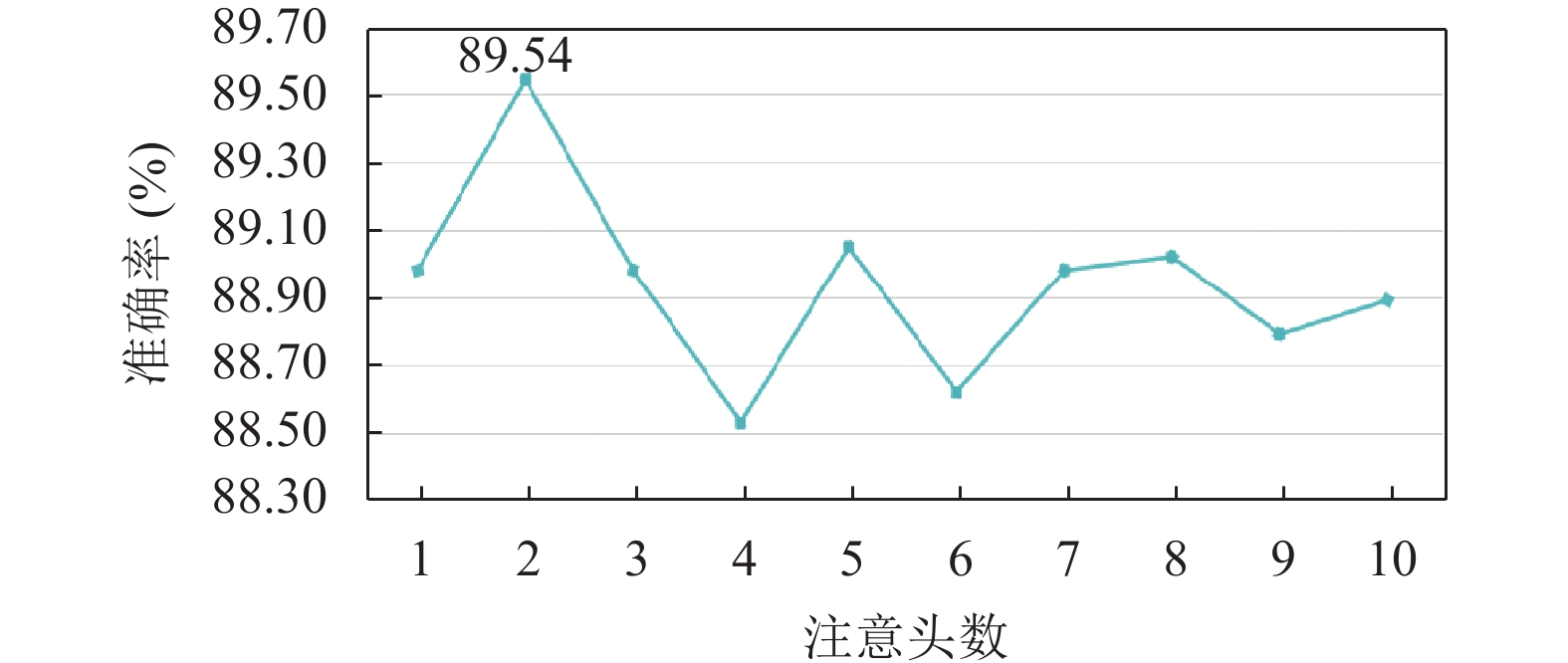

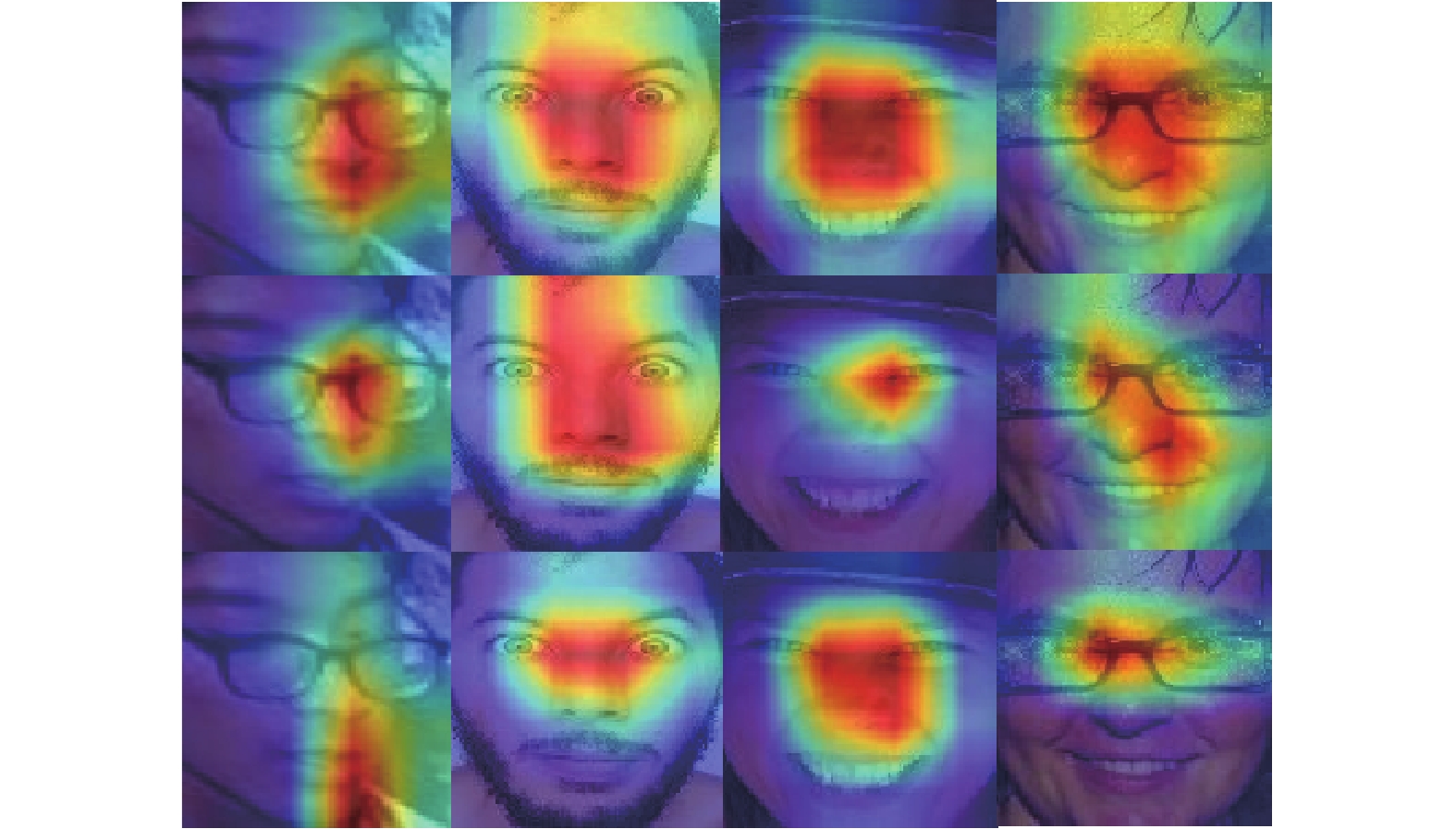

3.3 消融分析(1)验证SE-MPAN模块的数量对模型性能的影响. 如图3, 横坐标表示注意头数, 纵坐标表示准确率, RAF-DB准确率随着注意头数(1−10)的增加而变化, 当头数为2时, 达到了最好的准确率89.54%, 实验表明, 提出的MAFFN优于单一的注意力模块. 当头数大于2时, 会产生精度上的降低或震荡. 对于精度上的降低可能是因为增加注意力头数会引入一些冗余的信息. 当不同的注意力头都注意到了相似的特征时, 模型可能会对这些特征进行过度关注, 从而导致信息的冗余, 降低了模型的精度. 对于精度上的震荡可能是因为增加注意力头数会增加模型的复杂度, 使得模型的训练变得更加困难, 造成模型训练不稳定, 导致精度的震荡. 为了验证SE-MPAN的有效性, 使用类激活映射Grad-CAM++[22]进行可视化, 如图4所示, 数据集来自RAF-DB, 第1行是baseline 的可视化效果, 第2、3行是SE-MPAN 可视化效果. 第1、4张图像为遮挡人脸, 模块只能聚焦局部未被遮挡的多个区域, 这与之前的假设是一致的. 第2、3张图像为正面人脸, 模块也能够聚焦面部局部多个显著区域.

|

图 3 注意头数对模型的影响 |

|

图 4 SE-MPAN可视化效果 |

(2)超参数

在本文中, 所提出的模型在公开数据集RAF-DB和 FERPlus上与最先进的方法进行比较. 使用准确率(Accuracy)评估模型的性能, 准确率通常用于衡量分类模型的性能, 它表示模型正确预测的样本数与总样本数之间的比例, 可表示为:

| Accuracy=TN×100% | (15) |

其中,

RAF-DB: 从表2中的结果表明, 本文的方法优于许多先进的方法, 获得了89.54%的准确率. 与基于注意力的方法RAN[9]、LANet[23]及MAPNet[13]相比, 本文的方法在性能上优于三者. 相比于其他特征网络, 本文的方法仍然高于性能最好的MFNet[14]方法, 提高了1.01%.

FERPlus: 从表3中的结果表明, 本文的方法达到了89.13%的准确率. 对于基于注意力的方法RAN[9], 我们的方法优于RAN, 提高了0.58%. 同时, 我们的方法仍然优于其他特征提取网络模型.

|

表 1 超参数 |

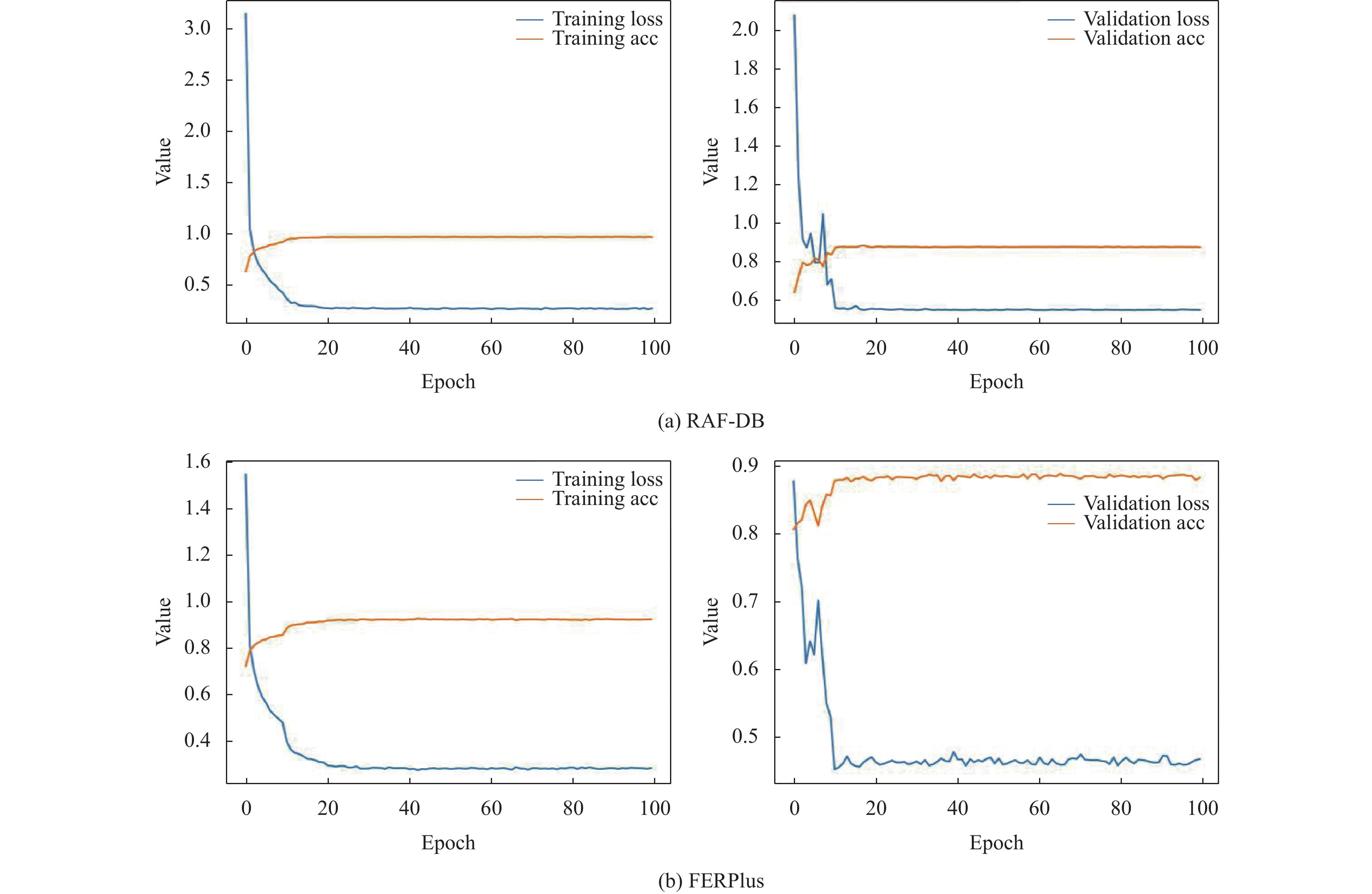

训练和验证精度曲线: 本文分析了RAF-DB和FER-Plus两个数据集的训练和验证精度曲线, 从图5可以看出, 在RAF-DB和FERPlus两个数据集上分别迭代100个epochs, 相对较短的学习周期内, 模型收敛速度快, 第18个epochs之后, 模型趋近于稳定状态, 并达到最佳性能的准确率.

| 表 2 在RAF-DB上与最先进的方法进行比较(%) |

| 表 3 在FERPlus上与最先进的结果进行比较(%) |

|

图 5 RAF-DB、FERPlus数据集的训练和验证精度曲线 |

3.5 真实遮挡的数据集上验证模型

为了评估本文模型在真实遮挡条件下的性能, 本文的方法在真实遮挡Occlusion-RAF-DB和Occlusion-FERPlus数据集上进行实验验证. 图6是一些真实遮挡数据样本图像. 从表4中的结果表明, 本文的方法在Occlusion-RAF-DB和Occlusion-FERPlus数据集上分别获得了87.47%、86.28%, 这明显优于最先进的方法. 因此, 在真实遮挡的面部表情数据集上的实验结果表明, 本文的方法在真实遮挡变化的条件下具有很强的鲁棒性, 这对于实际应用来说, 解决面部局部遮挡变化问题, 提高模型在测试集上的识别准确率以及在计算机视觉领域内落地使用, 才是最具有价值的.

4 结论本文针对在面部局部遮挡条件下难以提取有效的识别特征问题, 其中局部遮挡的面部表情识别可能需要多个区域特征识别表情, 而单一的注意力机制无法同时关注面部多个区域特征识别表情. 因此, 本文提出了一种基于加权并行注意力的局部遮挡面部表情识别模型, 该模型能够同时关注局部未被遮挡的多个面部区域, 有效缓解了遮挡对表情识别的干扰, 并且以较小的参数量和计算量提高了局部遮挡下面部表情识别的准确率. 在RAF-DB和FERPlus公开数据集上的实验表明, 本文的模型相比与其他最先进的方法取得了最优的性能. 在真实遮挡条件下, 同样表现出最鲁棒的性能. 在未来的工作中, 将设计更鲁棒、更轻量化的注意力机制来提高局部遮挡条件下的面部表情识别, 提高其在诸多领域的应用价值具有重大意义.

|

图 6 真实遮挡数据样本 |

| 表 4 在真实遮挡的数据集Occlusion-RAF-DB和Occlusion-FERPlus上进行评估(%) |

| [1] |

Shan CF, Gong SG, McOwan PW. Facial expression recognition based on local binary patterns: A comprehensive study. Image and Vision Computing, 2009, 27(6): 803-816. DOI:10.1016/j.imavis.2008.08.005 |

| [2] |

Zhong L, Liu QS, Yang P, et al. Learning active facial patches for expression analysis. Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Providence: IEEE, 2012. 2562–2569.

|

| [3] |

Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation. Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus: IEEE, 2014. 580–587.

|

| [4] |

Wang JH, Ding HY, Wang SF. Occluded facial expression recognition using self-supervised learning. Proceedings of the 16th Asian Conference on Computer Vision. Macao: Springer, 2022. 1077–1092.

|

| [5] |

Liu C, Hirota K, Dai YP. Patch attention convolutional vision transformer for facial expression recognition with occlusion. Information Sciences, 2023, 619: 781-794. DOI:10.1016/j.ins.2022.11.068 |

| [6] |

Zhang XH, Zhang XM, Zhou JZ, et al. Occlusion-aware facial expression recognition based region re-weight network. Proceedings of the 18th Pacific Rim International Conference on Artificial Intelligence. Hanoi: Springer, 2021. 209–222.

|

| [7] |

Lu Y, Wang SG, Zhao WT, et al. WGAN-based robust occluded facial expression recognition. IEEE Access, 2019, 7: 93594-93610. DOI:10.1109/ACCESS.2019.2928125 |

| [8] |

Fan YR, Li VOK, Lam JCK. Facial expression recognition with deeply-supervised attention network. IEEE Transactions on Affective Computing, 2022, 13(2): 1057-1071. DOI:10.1109/TAFFC.2020.2988264 |

| [9] |

Wang K, Peng XJ, Yang JF, et al. Region attention networks for pose and occlusion robust facial expression recognition. IEEE Transactions on Image Processing, 2020, 29: 4057-4069. DOI:10.1109/TIP.2019.2956143 |

| [10] |

Zhao ZQ, Liu QS, Wang SM. Learning deep global multi-scale and local attention features for facial expression recognition in the wild. IEEE Transactions on Image Processing, 2021, 30: 6544-6556. DOI:10.1109/TIP.2021.3093397 |

| [11] |

Xue FL, Wang QC, Guo GD. TransFER: Learning relation-aware facial expression representations with transformers. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 3581–3590.

|

| [12] |

Liu HW, Cai HL, Lin QC, et al. Adaptive multilayer perceptual attention network for facial expression recognition. IEEE Transactions on Circuits and Systems for Video Technology, 2022, 32(9): 6253-6266. DOI:10.1109/TCSVT.2022.3165321 |

| [13] |

Ju LZ, Zhao X. Mask-based attention parallel network for in-the-wild facial expression recognition. Proceedings of the 2022 IEEE International Conference on Acoustics, Speech and Signal Processing. Singapore: IEEE, 2022. 2410–2414.

|

| [14] |

Gong WJ, Wang CQ, Jia JL, et al. Multi-feature fusion network for facial expression recognition in the wild. Journal of Intelligent & Fuzzy Systems, 2022, 42(6): 4999-5011. |

| [15] |

Ruan LH, Han YX, Sun JR, et al. Facial expression recognition in facial occlusion scenarios: A path selection multi-network. Displays, 2022, 74: 102245. DOI:10.1016/j.displa.2022.102245 |

| [16] |

张本文, 高瑞玮, 乔少杰. 新型融合注意力机制的遮挡面部表情识别框架. 重庆理工大学学报(自然科学), 2023, 37(9): 217–226.

|

| [17] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 770–778.

|

| [18] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7132–7141.

|

| [19] |

Guo YD, Zhang L, Hu YX, et al. MS-Celeb-1M: A dataset and benchmark for large-scale face recognition. Proceedings of the 14th European Conference on Computer Vision. Amsterdam: Springer, 2016. 87–102.

|

| [20] |

Li S, Deng WH, Du JP. Reliable crowdsourcing and deep locality-preserving learning for expression recognition in the wild. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 2852–2861.

|

| [21] |

Barsoum E, Zhang C, Ferrer CC, et al. Training deep networks for facial expression recognition with crowd-sourced label distribution. Proceedings of the 18th ACM International Conference on Multimodal Interaction. Tokyo: ACM, 2016. 279–283.

|

| [22] |

Zhou BL, Khosla A, Lapedriza A, et al. Learning deep features for discriminative localization. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 2921–2929.

|

| [23] |

Ma H, Celik T, Li HC. Lightweight attention convolutional neural network through network slimming for robust facial expression recognition. Signal, Image and Video Processing, 2021, 15(7): 1507-1515. DOI:10.1007/s11760-021-01883-9 |

| [24] |

Zhao ZQ, Liu QS, Zhou F. Robust lightweight facial expression recognition network with label distribution training. Proceedings of the 35th AAAI Conference on Artificial Intelligence. AAAI Press, 2021. 3510–3519.

|

| [25] |

Wang K, Peng XJ, Yang JF, et al. Suppressing uncertainties for large-scale facial expression recognition. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 6897–6906.

|

| [26] |

Ma FY, Sun B, Li ST. Facial expression recognition with visual transformers and attentional selective fusion. IEEE Transactions on Affective Computing, 2023, 14(2): 1236-1248. DOI:10.1109/TAFFC.2021.3122146 |

| [27] |

Xia HY, Li CY, Tan YM, et al. Destruction and reconstruction learning for facial expression recognition. IEEE MultiMedia, 2021, 28(2): 20-28. DOI:10.1109/MMUL.2021.3076834 |

| [28] |

Gao WJ, Li L, Zhao HY. Facial expression recognition method based on SpResNet-ViT. Proceedings of the 2nd Asia-Pacific Conference on Communications Technology and Computer Science. Shenyang: IEEE, 2022. 182–187.

|

| [29] |

Jiang J, Deng WH. Disentangling identity and pose for facial expression recognition. IEEE Transactions on Affective Computing, 2022, 13(4): 1868-1878. DOI:10.1109/TAFFC.2022.3197761 |

| [30] |

Gong WJ, Qian YR, Fan YY. MPCSAN: Multi-head parallel channel-spatial attention network for facial expression recognition in the wild. Neural Computing and Applications, 2023, 35(9): 6529-6543. DOI:10.1007/s00521-022-08040-4 |

2024, Vol. 33

2024, Vol. 33