21世纪被认为是脑科学时代, 探索和揭示脑的奥秘已成为当代自然科学研究所面临的最重大的挑战之一. 脑电图(electroencephalogram, EEG)是一种记录脑电波的电生理监测方法. 而基于脑电信号实现的脑机接口(brain computer interface, BCI)可以在人脑和计算机或其他外部设备之间建立直接的信息交互和控制通道, 是人类了解和提高脑功能的重要手段, 正成为脑科学、生物医学及康复工程、智能信息处理等领域的一个研究热点.

但是脑电具有个体差异性、非稳态等特性. 针对同一个任务, 脑电信号会随着被试的变化而变化即每个被试的信号是不太一样的, 存在协变量偏移(covariate shift)现象. 即使是同一个任务同一个被试, 也会随着时间的变化而呈现不同的脑电信号, 后一种的典型是同一个被试不同时间分段之间的偏移. 一个时间分段通常时间较长, 时间分段之间存在休息.

传统脑电分类的方法按照是否独立于被试, 可分为两种. 第1种, 针对每个被试(subject specific)的方法, 即用每一个被试的数据训练一个模型用于分类. 这种方法的优点在于可以针对每个被试训练一个独特的模型, 适应性更好. 然而, 由于心理学实验中收集到的每个被试的数据量通常很少, 样本数量通常不超过1 000个, 因此存在样本偏少的问题. 这使得使用深度学习方法进行训练变得困难. 第2种, 对于所有被试通用(subject independent)的方法, 即用所有被试的数据训练一个统一的模型. 这种方法的优点在于, 集合了所有数据后, 可以使用深度学习方法进行训练. 然而, 这种方法不能针对每个被试进行个性化优化.

迁移学习方法能够结合上述两种方法的优点. 因此本文提出基于域对抗迁移的方法. 本文所提出的迁移学习方法总体网络框架是先用MMCNN[1]作为骨干网络提取信号特征, 再将源域被试上学习到的特征迁移到目标域被试上. 传统迁移学习方法通常都是单源的迁移, 即从一个源域迁移到一个目标域, 而心理学实验采集到的脑电信号是来自多个被试的, 可以理解为多个域, 在进行迁移的时候, 需要从众多被试中选择一个和目标被试脑电信号最相似的被试, 即从多个源域中选取一个最佳源域用于迁移.

本文提出了一个新的迁移框架, 来提高运动想象任务的分类准确率. 该框架由一个源域选择算法MSTE和一个迁移算法ToSAN组成. 本文的贡献在于: (1) 提出了一个新的源域选择算法MSTE, 同时考虑了类别和时间子域上源域和目标域的距离以及源域内部时间子域之间的距离, 从而计算出最佳的“源域—目标域”配对. (2) 提出了一个新的基于域对抗神经网络的迁移方法ToSAN, 该方法不仅利用了目标域信息还将特征分解, 对齐对分类任务有关的特征. (3) 本文所提出的迁移算法和源域选择算法在两个经典数据集上进行了广泛的实验. 实验结果表明, 所提出的框架在分类准确率方面明显优于对比方法.

1 相关工作脑电波是一种使用电生理指标记录大脑活动的方法. 大脑在活动时, 大量神经元同步发生的突触后电位经过总和后形成的. 它记录大脑活动时的电波变化, 是脑神经细胞的电生理活动在大脑皮层或头皮表面的总体反映[2]. 目前关于脑电信号分类任务有众多研究算法提出.

机器学习利用一套数学模型和算法来逐步提高任务的性能. 它将训练数据集作为输入, 在验证集或者测试集上进行预测来优化模型. 脑电信号分类任务中, 常用的机器学习算法包括支持向量机(SVM)、K最近邻算法(KNN)、贝叶斯网络和随机森林等. Chatterjee等人[3]利用基于统计、基于小波的能量熵和基于RMS、PSD的平均功率和不良功率形成相应的特征向量, 然后使用SVM、MLP进行分类. Tang等人[4]设计了一个基于KNN的平滑自动编码器来实现对运动想象脑电信号的精准识别. Blankertz等人[5]优化了空间过滤器用于鲁棒的信号分析.

近年来, 伴随着深度学习在计算机视觉、语音识别、自然语言理解等领域的不断突破, 虽然大多数脑机接口系统仍然依赖于手动提取的特征, 但最近的许多工作已经探索了深度学习在脑电信号中的应用. Craik等人[6]系统回顾了深度学习在脑电信号分类任务中的历史和发展. Schirrmeister等人[7]提出了著名的Deep ConvNet, Shallow ConvNet以及Hybrid ConvNet, 这3个网络分别从网络结构和训练策略两方面探讨了卷积神经网络在运动想象数据集分类任务上的表现. EEGNet[8]是第1个用于各种脑电信号分类任务的标志性网络. MMCNN[1]采用了多分支多尺度的结构, 利用不同尺度的卷积核大小来捕获特征提高分类准确率. Zhang等人[9]同时考虑了脑电信号在时间和空间上的特征, 有效利用了电极的相对位置信息, 提高了脑电信号分类准确率.

但上述这些方法不能在各种脑机接口范式中发挥全部威力, 原因是脑电信号的特征高度受年龄、心理等不同个体差异的影响, 不同个体的脑电信号对于同一事件可能存在不同[10]. 且脑电信号存在非平稳, 低信噪比, 对特定任务敏感的信息难以过滤等特性. 此外, 每次心理学实验收集的样本量有限, 限制了模型的训练. 在计算机视觉以及语音领域, 迁移学习飞速发展. 迁移学习能够有效优化脑电信号信息提取的不足, 同时减少对数据量的需求, 学界开始研究在脑电信号上应用迁移方法. Dagois等人[11]应用10个个体的正则化判别分析得分来学习不同被试之间的类条件分布, 用于运动想象任务中的时间环节校准. Li等人[12]借鉴了DANN[13], 通过在每个源域上训练一个DANN模型, 然后根据各个模型在测试数据上的表现加权集成, 将集成后的结果作为最终结果输出. Demsy等人[14]同时利用欧几里得对齐(Euclidean alignment, EA)和迁移成分分析(transfer component analysis, TCA)[15]进行被试间的迁移学习. 传统方法关注频域信息而忽略了多模态信息. 为此, Tan等人[16]把EEG转变为脑电光流信息, 有效保留了多模态的信息, 在此基础上将脑电光流和图片一块进行训练提取特征, 联合训练可以强制网络学习具有迁移性的通用特征, 从图片中获得知识并把它转移到脑电光流中. Fahimi等人[17]采用了经典的预训练微调的方式进行迁移. Wu等人[18]介绍了脑机接口的整个训练流程, 以及各种迁移方法如CSP、RCSP、EA、PS、wAR、LDA方法的组合, 并做了详尽的实验说明迁移方法在流程上的应用和效果.

但并不是所有的迁移都能造成积极影响. Agarwal等人[19]详细阐述了源域和目标域的数据分布不同可能造成负迁移. 同样在脑电数据中, 不同被试间的分布差异并不均衡, 某些被试数据之间的分布差距可能过于巨大, 当这些被试被选为源域和目标域进行迁移时迁移效果反而会下降, 即发生负迁移现象. 因此需要慎重选择合适的源域和目标域进行迁移.本文收集了广泛的源域选择算法, 发现主要有以下这几种类型的方法用于源域选择.

(1)聚类方法. Wu等人[18]通过K-means聚类方法, 选出聚类后与目标域最接近的源域进行迁移. Song等人[20]提出了P3 map聚类方法用于源域选择.

(2)基于模型的方法. Li等人[12]提出了一个多源域选择算法, 假设有标签的源域数据和无标签的目标域数据分布相似, 枚举了N个在源域上训练的分类器, 然后选出分类准确率最高的

(3)距离度量方法. Cui等人[22]提出使用推土机距离(earth mover’s distance, EMD)评估域相似性, 进而根据域相似性选择源域. Chen等人[23]提出了分层距离(stratified distance), 通过使用分层距离评估相似性选择源域, 不同于其他方法只关注全局的信息, 该方法同时关注了局部信息.

(4)特征相似性方法. Gong等人[24]提出了ROD算法选择源域, ROD算法能同时集成几何和统计特征信息. 几何上, 主角度越小说明几何上越对齐; 统计上, 当两种不同数据集映射到子空间后的对称KL散度越小说明统计上越接近. Jeon等人[25]根据被试在静息状态脑电信号中的功率谱密度特征选择合适的源域. Zhang等人[26]提出了DTE的源域选择算法. DTE算法通过计算源域内部类间散度矩阵与源域目标域之间类间散度矩阵来获得域之间的相似性进而选择源域.

2 方法运动想象任务的脑电信号被定义为

给定源域

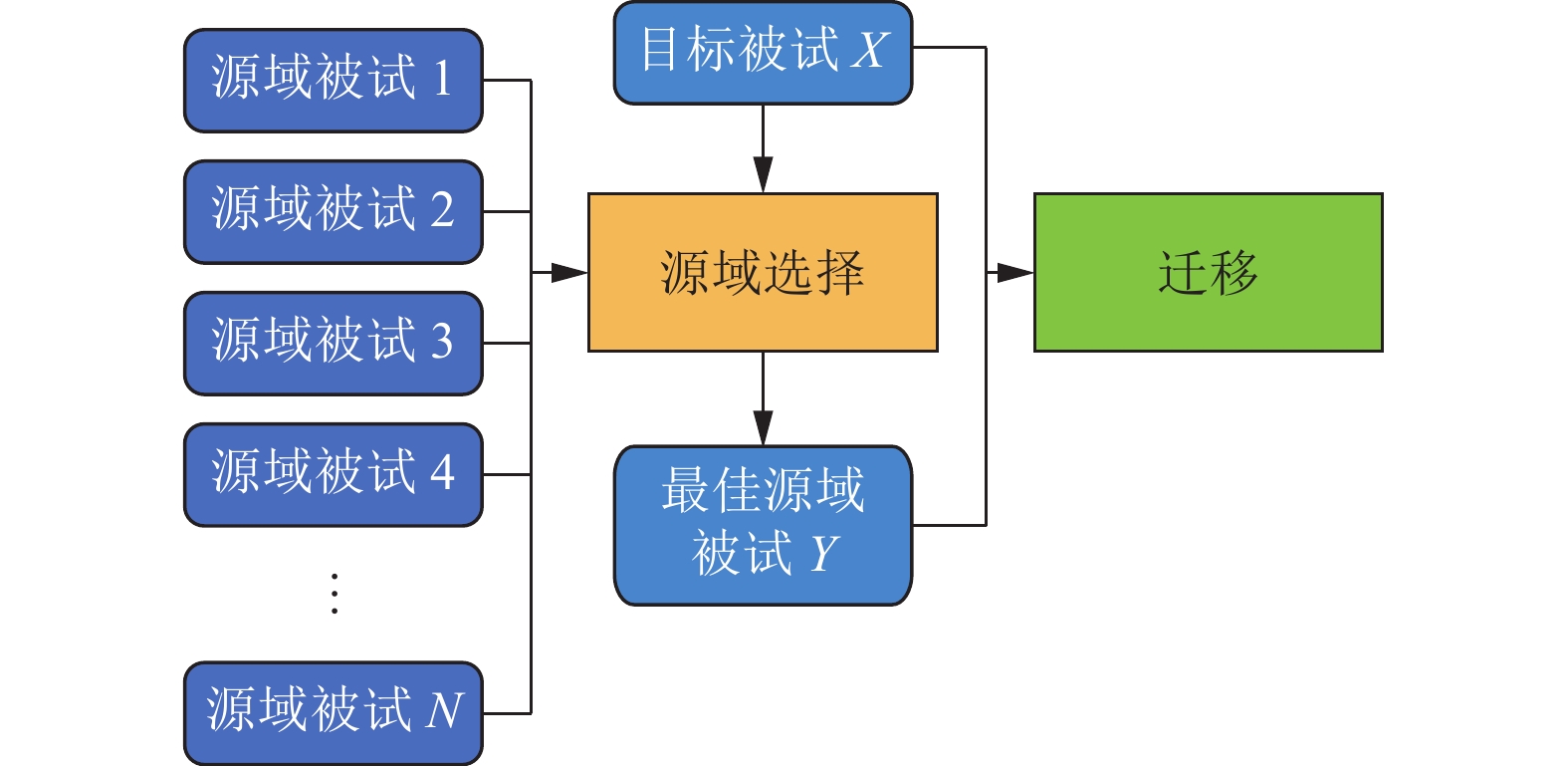

本文所提出的迁移学习整体框架如图1所示, 主要有源域选择和迁移两部分组成. 本节将详细介绍用于脑电信号分类任务的单源域选择方法MSTE以及任务导向的子域对抗神经网络ToSAN.

|

图 1 迁移学习整体框架 |

2.1 源域选择算法

本节提出了一个新的单源域选择方法MSTE (multi-subdomain transferability estimation).

2.1.1 最大均值差异最大均值差异 (maximum mean discrepancy, MMD)[27]是一个核学习方法. 该方法通过在样本空间中寻找一个映射函数, 将样本映射到高维空间, 再计算两个不同分布

| dH(p,q)≜‖Ep[ϕ(xs)]−Eq[ϕ(xt)]‖2H | (1) |

其中,

| ˆdH(p,q)=‖1ns∑xi∈Dsϕ(xi)−1nt∑xj∈Dtϕ(xj)‖2H=1n2sns∑i=1ns∑j=1k(xsi,xsj)+1n2tnt∑i=1nt∑j=1k(xti,xtj)−2nsntns∑i=1nt∑j=1k(xsi,xtj) | (2) |

其中,

启发于MSDAN[28], 本文提出了一个新的源域选择方法MSTE. 不同于MSDAN独立考虑了时间子域和类别子域, MSTE同时考虑了时间子域和类别子域之间的相互影响, 此外MSTE还考虑了源域单被试内部的时间漂移问题, 使得源域和目标域数据之间的相似性得到准确度量. MSTE与其他方法的核心差异在于源域和目标域的相似度度量的设计. MSTE的相似度度量函数的表示如下:

| dL(Ds,Dt)=1C×TC∑c=1T∑τ=1‖1nc,τs∑xi∈Dc,τsϕ(xi)−1nc,τt∑xj∈Dc,τtϕ(xj)‖2H+λ1C×(T−1)C∑c=1T−1∑τ=1‖1nc,τs∑xi∈Dc,τsϕ(xi)−1nc,τ+1s∑xj∈Dc,τ+1sϕ(xj)‖2H | (3) |

其中,

MSTE相似度度量函数包含了两部分. 第1部分是源域和目标域在时间和类别子域上的MMD距离, 第2部分是源域内部不同时间分段之间的MMD距离. 第1部分表示源域和目标域在每一类每一时间段之间的MMD距离, 该部分越小说明源域和目标域在每一类每一时间段上的差异越小. 第2部分表示源域中每一个被试所做试次的前后时间段之间的MMD距离均值, 该部分越小说明每个被试在执行运动想象分类任务时的时间漂移越小. 两部分相结合, MSTE的相似度度量函数的值越小, 说明源域和目标域之间差异越小, 更适合作为迁移配对.

2.2 迁移方法本节提出了一个新的迁移方法ToSAN (task-oriented subdomain adversarial transfer network).

2.2.1 用于域适应的对抗学习框架生成对抗网络 (generative adversarial network, GAN)[29]包含了一个生成网络和一个鉴别网络, 其中生成网络不断生成类似于真实样本的样本最大化地迷惑鉴别网络, 而鉴别网络则尽可能地区别真实样本和生成样本. 启发于GAN, 域对抗适应网络能够有效地学习可迁移特征. 域对抗神经网络也类似于双人博弈, 包含了特征提取器

| L(θf,θy,θd)=1ns∑xi∈DsLy(Gy(Gf(xi)),yi)−λ2ns+nt∑xi∈(Ds∪Dt)Ld(Gd(Gf(xi)),di) | (4) |

其中,

| (ˆθf,ˆθy)=argmin | (5) |

| {\hat \theta _d} = \arg {\max _{{\theta _d}}}L\left( {{\theta _f}, {\theta _y}, {\theta _d}} \right) | (6) |

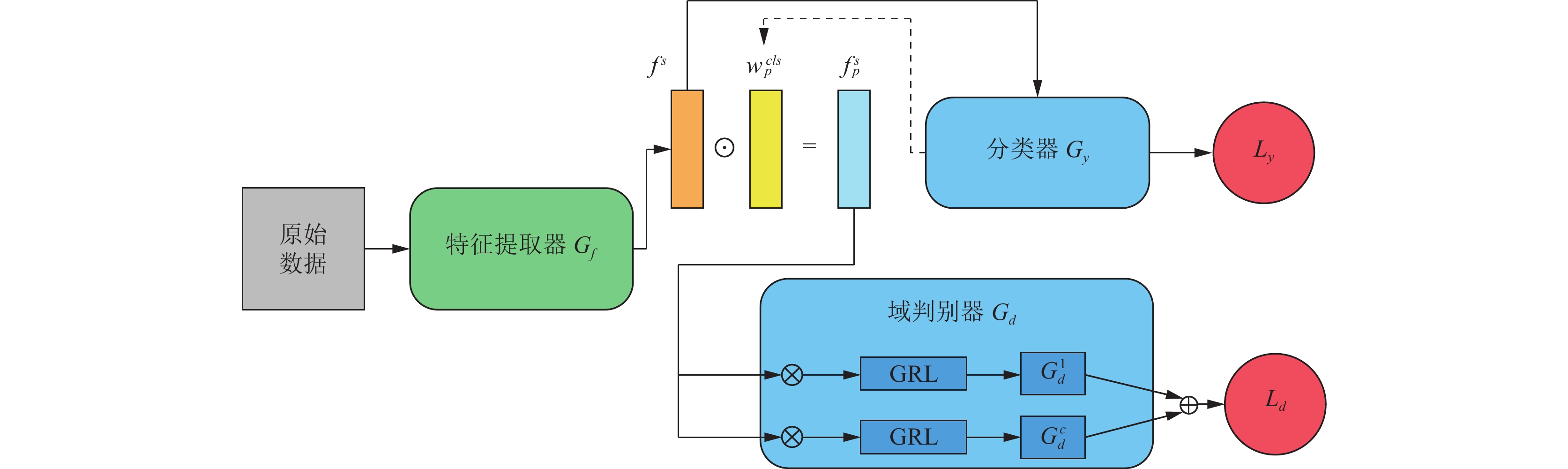

ToSAN的具体框架如图2所示. 主要包含以下几个组件.

|

图 2 ToSAN 总体框架 |

(1)特征提取器

(2)分类器

| \begin{split} {L_y} =& - \frac{1}{{{n_s}}}\sum\limits_{{{{x}}_i} \in {D_s}} {\sum\limits_{c = 1}^C {{P_{{{{x}}_i} \to c}}} } \log {G_y}\left( {{G_f}\left( {{{{x}}_i}} \right)} \right) \\ & - \frac{1}{{{n_t}}}\sum\limits_{{{{x}}_i} \in {D_t}} {\sum\limits_{c = 1}^C {{P_{{{{x}}_i} \to c}}} } \log {G_y}\left( {{G_f}\left( {{{{x}}_i}} \right)} \right) \end{split} | (7) |

其中,

|

图 3 运动想象实验流程图 |

(3)域判别器

| {L_l} = \frac{1}{{{n_s} + {n_t}}}\sum\limits_{c = 1}^C {\sum\limits_{{{{x}}_i} \in {D_s} \cup {D_t}} {L_d^c} } \left( {G_d^c\left( {\hat y_i^c{G_f}\left( {{{{x}}_i}} \right)} \right), {d_i}} \right) | (8) |

其中,

还有其他一些符号解释如下, 图2中

| {w^{cls}} = \frac{{\partial {y^c}}}{{\partial {f^s}}} | (9) |

其中,

| {f_p} = w_p^{cls} \odot {f^s} = {\textit{z}}{w^{cls}} \odot {f^s} | (10) |

其中,

| {\textit{z}}=\sqrt{\frac{\Vert {f}^{s}{\Vert }_{2}^{2}}{{\Vert {w}^{cls}\odot {f}^{s}\Vert }_{2}^{2}}}=\sqrt{\frac{{\displaystyle \sum _{c=1}^{C}{({f}_{c}^{s})}^{2}}}{{\displaystyle \sum _{c=1}^{C}{\left({w}_{c}^{cls}{f}_{c}^{s}\right)}^{2}}}} | (11) |

本节将在BCI Competition IV 2a和BCI Competition IV 2b数据集上比较ToSAN算法与其他迁移算法, 验证ToSAN算法的有效性. 在实验中, 不同的被试将作为源域或者目标域, 所提出的ToSAN方法也将在源域和目标域被试上进行迁移. 此外, 本文还比较了一些源域选择算法, 评估了本文所提出的源域选择算法MSTE的有效性. 考虑到源域选择算法可能对迁移方法的结果存在一定技巧的影响, 本节先介绍了迁移方法, 并用随机期望这一指标评估了迁移方法的有效性, 然后再在迁移方法上应用了源域选择方法.

3.1 实验环境和参数设置实验过程中所使用的软硬件环境配置如下: 中央处理器: Intel(R) Xeon(R) Gold 6240R CPU @ 2.40 GHz; 显卡: Tesla V100s-PCIE-32 GB; 内存: 250 GB; 操作系统: Ubuntu 18.04LTS. 本节的所有的深度迁移方法均采用相同的实验参数, 批量大小为128, 最大的epoch数量为500, 并设置早停技术防止过拟合, 早停阈值数目为30. 选用随机梯度下降方法(SGD)作为优化器. L2正则惩罚项被用于防止模型过拟合, 具体数值为0.000 5. 考虑到随机梯度下降方法的训练收敛速度较慢, 以及可能掉入局部极值点, 不能找到全局最优极值点, 本文在SGD的基础上增加了动量(momentum), 并设置动量值为0.9. 初始学习率是0.001, 并按式(12)进行迭代:

| lr = \frac{\omega }{{{{\left( {1 + 10\delta } \right)}^\beta }}} | (12) |

其中,

在本节实验中总共用到了如下两个数据集.

(1) BCI Competition IV 2a数据集: 从 9 名健康被试中收集, 其中包含 4 种不同的运动想象任务(分别是左手、右手、双脚和舌头的运动想象). 具体实验流程图如图3所示, 对于每个任务, 由1.25 s的线索提示和3 s的运动想象组成, 这里我们选择由线索提示和运动想象组成的4 s任务时间进行分析. 实验由22个 Ag/AgCl电极记录, 采样频率为250 Hz. 此外, 信号在 0.5 Hz和100 Hz之间进行带通滤波. 每个被试有2个时间分段. 每个时间分段由6次运行组成. 因此, 每个被试有576个试次, 总共有5 184试次.

(2) BCI competition IV 2b数据集: 采集自9名健康被试, 与BCI Competition IV 2a数据集相比, BCI Competition IV 2b数据集考虑了2种不同的运动想象任务(左手和右手运动的想象). 另外, 不同的是每个被试有5个时间分段. 前两个时间分段没有反馈. 每个时间分段包含120个试次. 最后3个时间分段有反馈, 每个时间分段包含160个试次. 这里我们也选择了由线索提示和运动想象组成的4 s任务时间进行分析. 实验由3个Ag/AgCl 电极记录, 分别为C3、Cz和C4. 采样频率和带通滤波器与BCI Competition IV 2a数据集相同. 总共有6 480个试次.

在本节实验中, 两个数据集均选取左右手的运动想象任务数据.

3.3 实验设置为了验证已有迁移算法和提出的ToSAN算法的有效性, 本文针对BCI Competition IV 2a和BCI Competition IV 2b数据集中的9个被试每2个被试进行了双向跨被试实验. 总共有

本文提出的源域选择算法与如下方法进行了比较: DTE[26]、Symmetrical KL[32] 、ROD[24]、1-Wasserstein Distance、2-Wasserstein Distance、最差选择、随机选择期望. 本文进行比较的源域选择算法具体如下.

(1) DTE[26]: 一个经典的基于脑电信号的运动想象任务的源域选择算法. DTE是一种在无监督场景下对二维数据(

(2) Symmetrical KL[32]: 一种经典的相似性度量算法. 对称形式的KL散度作为距离度量. 最短的距离作为相应的源域选择算法结果.

(3) ROD[24]: 第1个经典的源域选择算法.

(4) 1-Wasserstein Distance: 一种经典的相似性度量算法. 用1阶推土机距离作为源域和目标域的距离度量. 最短的距离作为相应的源域选择算法结果.

(5) 2-Wasserstein Distance: 一种经典的相似性度量算法. 用2阶推土机距离作为源域和目标域的距离度量. 最短的距离作为相应的源域选择算法结果.

(6)最差选择: 根据提出的源域选择算法MSTE选出的最差下限结果.

(7)随机选择期望: 所有源域和目标域被试组合的分类结果平均值.

本文提出的ToSAN方法与如下方法进行了比较: MMCNN[1]、joint distribution adaptation (JDA)[33]、multi-subdomain adaptation network (MSDAN)[28]、manifold embedded knowledge transfer (MEKT)[26]、PS-RCSP-wAR[18]. 本文进行比较的迁移算法具体如下.

(1) MMCNN[1]: 一种非迁移的深度神经网络用于运动想象的脑电信号分类. 作为JDA、MSDAN以及ToSAN的特征提取网络.

(2) JDA[33]: JDA同时考虑了边缘分布适配和条件分布适配. 由MMCNN[1]提取出来的脑电信号特征作为输入.

(3) MSDAN[28]: 一种用于运动想象脑电信号分类的深度迁移算法. 由MMCNN[1]作为骨干网络提取运动想象任务的脑电信号特征.

(4) MEKT[26]: 一种基于流形的传统迁移算法.

(5) PS-RCSP-wAR[18]: 融合了PS、RCSP以及wAR三种方法的迁移方法.

本文使用准确率作为模型性能的评价指标. 准确率的计算公式如下:

| ACC = \frac{{TP + TN}}{{TP + TN + FP + FN}} | (13) |

其中,

ToSAN以及其他对比的方法在BCI Competition IV 2a和BCI Competition IV 2b数据集上的分类结果都呈现如下. 表1和表2分别展示了ToSAN在BCI Competition IV 2a和BCI Competition IV 2b数据集上8×9=72个配对迁移结果. 每个迁移结果都是由源域被试迁移到目标域被试. 表2的每一列代表目标域被试, 每一行代表源域被试. 对于每个目标域被试, 最佳的源域被试对应的迁移结果都用加粗表示.

| 表 1 ToSAN在BCI Competition IV 2a上的迁移结果(%) |

| 表 2 ToSAN在BCI Competition IV 2b上的迁移结果(%) |

表3展示了JDA, MSDAN, MEKT, PS-RCSP-wAR以及ToSAN在BCI Competition IV 2a和BCI Competition IV 2b数据集上的随机期望准确率. 这里随机的含义是对于每一个目标域被试, 随机选择一个非本身的源域被试进行迁移, 而随机期望表示所有目标域被试的迁移结果的期望值即将每个源域迁移到目标域的结果取平均.

| 表 3 迁移算法在BCI Competition IV 2a和BCI Competition IV 2b上的迁移结果(%) |

表4和表5分别展示了源域选择算法在BCI Competition IV 2a和BCI Competition IV 2b数据集上的结果. 表4和表5的第1行1–9数字表示目标域序号, 随后几行分别给出了对于每一个目标域, 每种源域选择方法下的源域选择结果. 表4和表5最后一列展现了ToSAN与各种源域选择算法结合后的平均准确率. 不难看出本文所提出的源域选择算法在两个数据集上均表现优异, 优于所有比较的算法, 进一步证明了本文提出的方法的优越性.

3.5 消融实验为了进一步说明迁移方法和源域选择方法成分的有效性, 本文进行了深入的消融实验. 图4依次对ToSAN的成分进行消融实验, 可以看出, 随着任务导向的特征对齐, 目标域标签信息逐步去除, ToSAN在BCI Competition IV 2a和BCI Competition IV 2b数据集上的随机期望准确率也在逐步下降, 说明每一个成分都必不可少, 都对分类结果产生积极影响.

本文提出的源域选择方法MSTE含有两个部分, 一个是时间和类的混合距离, 还有一个是源域内同一类不同时间之间的距离, 图5展现了仅有时间与类的混合距离作为源域选择方法在BCI Competition IV 2a和BCI Competition IV 2b数据集上的结果以及完整的源域选择方法在BCI Competition IV 2a和BCI Competition IV 2b数据集上的结果. 显然, 完整的源域选择算法的性能更加优秀, 说明源域选择算法各个成分的有效.

| 表 4 BCI Competition IV 2a上的源域选择算法 |

| 表 5 BCI Competition IV 2b上的源域选择算法 |

|

图 4 迁移方法 ToSAN 各个成分的消融性能 |

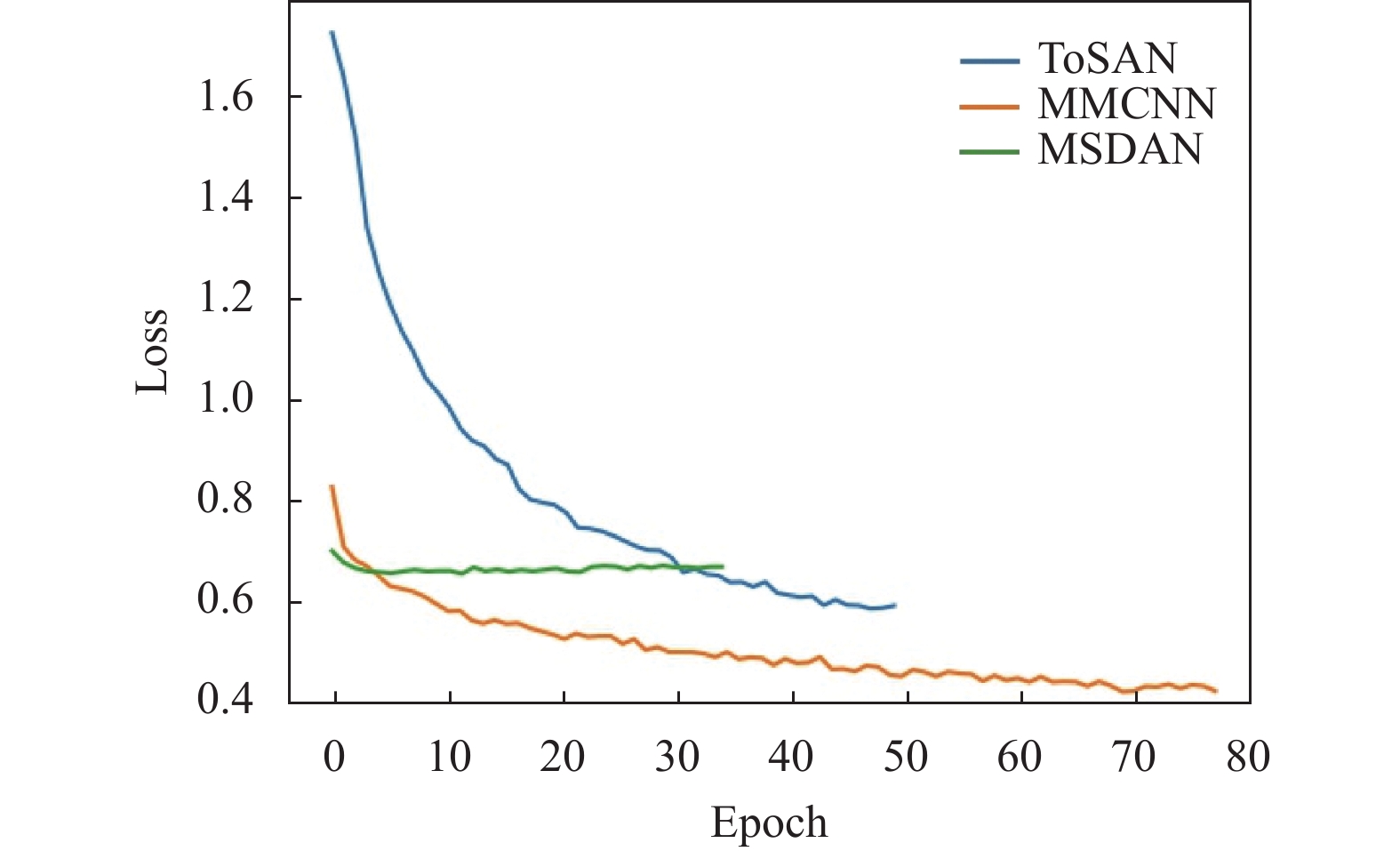

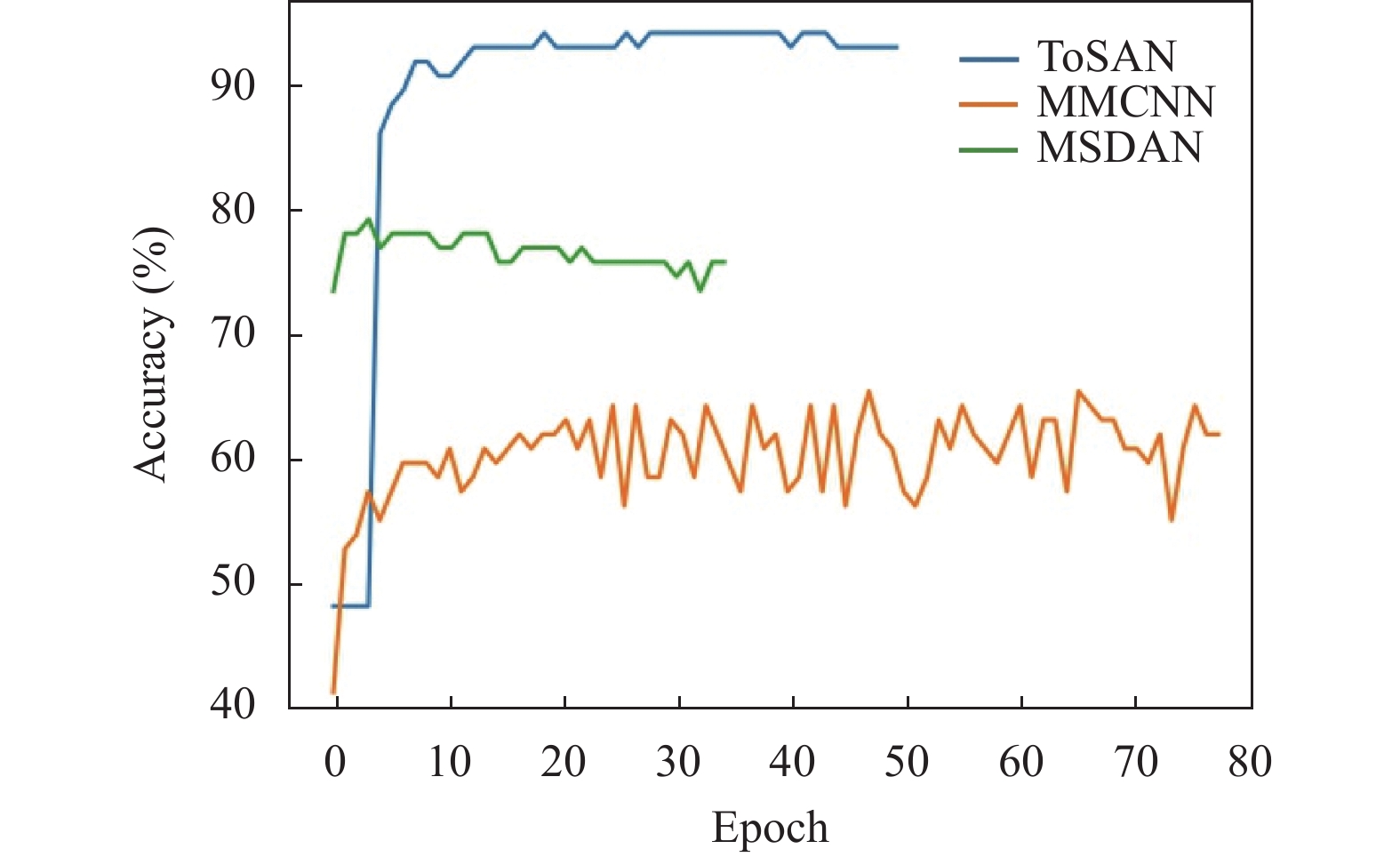

3.6 收敛性分析

此外, 本文给出了ToSAN的收敛性相关分析, 以BCI Competition IV 2a数据集上被试4到被试3的迁移为例, 其训练损失曲线和测试准确率曲线如图6和图7所示. 从图6和图7可以看出, 在相同的迭代次数下, ToSAN比MMCNN[1]和MSDAN[28]收敛得更快更稳. 值得注意的是, 相比于其他方法, MMCNN在训练过程中只用到了源域数据, 而在测试过程中使用了目标域数据. 由于源域数据和目标域数据分布并不完全相同, 会导致图中MMCNN的训练集损失收敛曲线较低, 同时测试集准确率不高的情况. 图6和图7结果表明, 所提出的ToSAN不仅可以达到良好性能, 而且可以很容易地训练出稳定的结果.

|

图 5 源域选择方法 MSTE 各个成分的消融性能 |

|

图 6 损失收敛曲线 |

|

图 7 准确率收敛曲线 |

4 结论与展望

在这项工作中, 对于运动想象的脑电信号分类任务, 本文提出了一个新的迁移算法ToSAN和一个新的单源域选择算法MSTE. ToSAN使用了对抗域神经网络作为基础网络框架, 在迁移的过程中不仅利用了源域的信息还有效利用了目标域的标签信息. ToSAN细化了以往特征迁移的粒度, 把源域的特征进行分解, 筛选出与分类任务有关的特征, 然后在此基础上对这些特征进行对齐, 忽略和分类无关的特征. 新的源域选择算法MSTE同时考虑了时间和类别子域上源域和目标域的距离, 以此作为源域选择的依据. ToSAN与MSTE两个算法相辅相成. 为了验证所提出的ToSAN以及MSTE的有效性, 本文在2个经典的运动想象数据集BCI Competition IV 2a和BCI Competition IV 2b上进行了细致全面的实验. 实验结果表明ToSAN算法优于所有比较的算法, 提出的源域选择算法MSTE也优于其余的算法, 两者结合, 分类效果突出.

在未来的工作中, 将ToSAN和MSTE方法扩展到更多的运动想象数据集上是一个实际可行的目标. 更进一步地, 将这些运动想象方法扩展到其他脑机接口范式的数据集中则是一个具有挑战性的目标.

| [1] |

Jia ZY, Lin YF, Wang J, et al. MMCNN: A multi-branch multi-scale convolutional neural network for motor imagery classification. Proceedings of the 2020 Joint European Conference on Machine Learning and Knowledge Discovery in Databases. Ghent: Springer, 2020. 736–751.

|

| [2] |

张海军, 王浩川. 多导联EEG信号分类识别研究. 计算机工程与应用, 2008, 44(24): 228-230. |

| [3] |

Chatterjee R, Bandyopadhyay T. EEG based motor imagery classification using SVM and MLP. Proceedings of the 2nd International Conference on Computational Intelligence and Networks (CINE). Bhubaneswar: IEEE, 2016. 84–89.

|

| [4] |

Tang XL, Wang T, Du YM, et al. Motor imagery EEG recognition with KNN-based smooth auto-encoder. Artificial Intelligence in Medicine, 2019, 101: 101747. DOI:10.1016/j.artmed.2019.101747 |

| [5] |

Blankertz B, Tomioka R, Lemm S, et al. Optimizing spatial filters for robust EEG single-trial analysis. IEEE Signal Processing Magazine, 2008, 25(1): 41-56. DOI:10.1109/MSP.2008.4408441 |

| [6] |

Craik A, He YT, Contreras-Vidal JL. Deep learning for electroencephalogram (EEG) classification tasks: A review. Journal of Neural Engineering, 2019, 16(3): 031001. DOI:10.1088/1741-2552/ab0ab5 |

| [7] |

Schirrmeister RT, Springenberg JT, Fiederer LDJ, et al. Deep learning with convolutional neural networks for EEG decoding and visualization. Human Brain Mapping, 2017, 38(11): 5391-5420. DOI:10.1002/hbm.23730 |

| [8] |

Lawhern VJ, Solon AJ, Waytowich NR, et al. EEGNet: A compact convolutional neural network for EEG-based brain-computer interfaces. Journal of Neural Engineering, 2018, 15(5): 056013. DOI:10.1088/1741-2552/aace8c |

| [9] |

Zhang YS, Cai H, Nie L, et al. An end-to-end 3D convolutional neural network for decoding attentive mental state. Neural Networks, 2021, 144: 129-137. DOI:10.1016/j.neunet.2021.08.019 |

| [10] |

Lotte F, Bougrain L, Cichocki A, et al. A review of classification algorithms for EEG-based brain-computer interfaces: A 10 year update. Journal of Neural Engineering, 2018, 15(3): 031005. DOI:10.1088/1741-2552/aab2f2 |

| [11] |

Dagois E, Khalaf A, Sejdic E, et al. Transfer learning for a multimodal hybrid EEG-fTCD brain-computer interface. IEEE Sensors Letters, 2019, 3(1): 7100704. |

| [12] |

Li JP, Qiu S, Shen YY, et al. Multisource transfer learning for cross-subject EEG emotion recognition. IEEE Transactions on Cybernetics, 2020, 50(7): 3281-3293. |

| [13] |

Ganin Y, Ustinova E, Ajakan H, et al. Domain-adversarial training of neural networks. The Journal of Machine Learning Research, 2016, 17(1): 2096-2030. |

| [14] |

Demsy O, Achanccaray D, Hayashibe M. Inter-subject transfer learning using euclidean alignment and transfer component analysis for motor imagery-based BCI. Proceedings of the 2021 IEEE International Conference on Systems, Man, and Cybernetics (SMC). Melbourne: IEEE, 2021. 3176.

|

| [15] |

Pan SJ, Tsang IW, Kwok JT, et al. Domain adaptation via transfer component analysis. IEEE Transactions on Neural Networks, 2011, 22(2): 199-210. DOI:10.1109/TNN.2010.2091281 |

| [16] |

Tan CQ, Sun FC, Zhang WC. Deep transfer learning for EEG-based brain computer interface. Proceedings of the 2018 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). Calgary: IEEE, 2018. 916–920.

|

| [17] |

Fahimi F, Zhang Z, Goh WB, et al. Inter-subject transfer learning with an end-to-end deep convolutional neural network for EEG-based BCI. Journal of Neural Engineering, 2019, 16(2): 026007. DOI:10.1088/1741-2552/aaf3f6 |

| [18] |

Wu DR, Jiang X, Peng RM. Transfer learning for motor imagery based brain-computer interfaces: A tutorial. Neural Networks, 2022, 153: 235-253. DOI:10.1016/j.neunet.2022.06.008 |

| [19] |

Agarwal N, Sondhi A, Chopra K, et al. Transfer learning: Survey and classification. Smart Innovations in Communication and Computational Sciences: Proceedings of the 2020 ICSICCS. Springer, 2021. 145–155.

|

| [20] |

Song XY, Zeng Y, Tong L, et al. P3-MSDA: Multi-source domain adaptation network for dynamic visual target detection. Frontiers in Human Neuroscience, 2021, 15: 685173. DOI:10.3389/fnhum.2021.685173 |

| [21] |

Zuo YK, Yao HT, Xu CS. Attention-based multi-source domain adaptation. IEEE Transactions on Image Processing, 2021, 30: 3793-3803. DOI:10.1109/TIP.2021.3065254 |

| [22] |

Cui Y, Song Y, Sun C, et al. Large scale fine-grained categorization and domain-specific transfer learning. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 4109–4118.

|

| [23] |

Chen YQ, Wang JD, Huang MY, et al. Cross-position activity recognition with stratified transfer learning. Pervasive and Mobile Computing, 2019, 57: 1-13. DOI:10.1016/j.pmcj.2019.04.004 |

| [24] |

Gong BQ, Shi Y, Sha F, et al. Geodesic flow kernel for unsupervised domain adaptation. Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition. Providence: IEEE, 2012. 2066–2073.

|

| [25] |

Jeon E, Ko W, Suk HI. Domain adaptation with source selection for motor-imagery based BCI. 2019 7th International Winter Conference on Brain-computer Interface (BCI). Gangwon: IEEE, 2019. 1–4.

|

| [26] |

Zhang W, Wu DR. Manifold embedded knowledge transfer for brain-computer interfaces. IEEE Transactions on Neural Systems and Rehabilitation Engineering, 2020, 28(5): 1117-1127. DOI:10.1109/TNSRE.2020.2985996 |

| [27] |

Gretton A, Borgwardt KM, Rasch MJ, et al. A kernel two-sample test. The Journal of Machine Learning Research, 2012, 13: 723-773. |

| [28] |

Chen Y, Yang R, Huang MJ, et al. Single-source to single-target cross-subject motor imagery classification based on multisubdomain adaptation network. IEEE Transactions on Neural Systems and Rehabilitation Engineering, 2022, 30: 1992-2002. DOI:10.1109/TNSRE.2022.3191869 |

| [29] |

Goodfellow I, Pouget-Abadie J, Mirza M, et al. Generative adversarial networks. Communications of the ACM, 2020, 63(11): 139-144. DOI:10.1145/3422622 |

| [30] |

Liu DZ, Zhang J, Wu HR, et al. Multi-source transfer learning for EEG classification based on domain adversarial neural network. IEEE Transactions on Neural Systems and Rehabilitation Engineering, 2023, 31: 218-228. DOI:10.1109/TNSRE.2022.3219418 |

| [31] |

Wei GQ, Lan CL, Zeng WJ, et al. ToAlign: Task-oriented alignment for unsupervised domain adaptation. Proceedings of the 35th Advances in Neural Information Processing Systems. 2021. 13834–13846.

|

| [32] |

Borji A, Itti L. State-of-the-art in visual attention modeling. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(1): 185-207. DOI:10.1109/TPAMI.2012.89 |

| [33] |

Long MS, Wang JM, Ding GG, et al. Transfer feature learning with joint distribution adaptation. Proceedings of the 2013 IEEE International Conference on Computer Vision. Sydney: IEEE, 2013. 2200–2207.

|

2023, Vol. 32

2023, Vol. 32