随着我们对海洋探索的不断推进, 对水下传感网络(underwater sensor networks, UWSNs)的研究越来越受到研究者的青睐. 陆地通信与海洋通信有着本质的不同, 陆地通信所用的电磁波在水下传输具有严重的衰减, 水下环境更适用于声波进行传输. 并且水声通信在水中遭受着严重的频率相关衰减, 这就导致声学调制解调器的传输功率消耗要比陆地通信高得多[1-3]. 因此传统的陆地通信协议, 并不适用于水声通信. 此外, 在水下实现通信, 还会有声波的传输高延时; 水中节点会动态漂移造成链路断裂; 水下节点能量有限等问题.

为了克服UWSNs的问题, 已经提出了许多路由协议来解决在水下传感网络中数据传输的问题. 许多经典传统算法被提了出来, 如基于向量的转发协议[4]、定向洪泛基于路由协议[5]和基于深度的协议DBR[6]等. 然而, 传统的优化方法受到在实践中难以获得的先验信道统计知识的限制, 很容易陷入局部最优和水下路由空洞问题[7,8]. 因此, 转向智能自适应的在线学习方法非常重要.

为了解决水下路由局部最优和水下路由空洞问题, 研究员们开始转向对智能算法的研究, 例如蚁群优化(ant colony optimization , ACO)和(Q-learning, QL)强化学习算法[9]. ACO 是 Dorigo等人在1996年引入的一种基于群体的元启发式方法[10]. 蚁群可以通过跟踪信息素来找到它们的巢穴和食物来源之间的最短路径. 然后, 较短路径上的蚂蚁比较长路径上的蚂蚁更早到达目的地. 此外, 强化学习算法(reinforcement learning, RL)[11]作为一种自适应算法, 可以通过学习训练解决水下路由局部最优和水下路由空洞问题, 实现水下更节能高效的路由机制. 目前, 强化学习已被证明是解决无线通信网络中各种问题的有效在线学习技术. 通过即时与外部环境交互的奖励反馈, RL智能体可以在没有任何先验系统知识的情况下学习最优策略. 如基于 Q-learning 的节能和生命周期感知路由协议(Q-learning-based energy-efficient and lifetime-aware routing protocol, QELAR)[12], 该协议根据节点的能量定义了其奖励函数. QELAR虽然在能效方面表现良好, 但缺乏深度和延迟信息来优化路由程序, 使得节点容易陷入局部最优. 基于Q学习辅助的蚁群算法 (Q-learning aided ant colony routing protocol, QLACO)[13], 该协议根据节点能量、深度和节点连接稳定系数定义奖励函数, 并通过给单个节点添加等待时间的方式解决空洞问题, 但是由于数据传输经过节点的等待时间是不同的, 容易使得节点陷入局部最优, 降低网络性能.

因此, 本文基于蚁群优化(ACO)算法以及QL强化学习算法, 提出一种基于Q学习辅助的蚁群算法(Q-learning ant colony optimization, QACO), 用以实现水下通信路由协议. 将节点深度、能量、传输延迟信息和水深链路质量(link quality indicator, LQI)[14]加入到奖励参数中, 使得奖励机制的评判更加全面. 并运用ACO实现信息的路由以及链路奖励的更新, 使得网络能在更短的时间找到最优路径, 提升网络的性能.

1 系统模型及问题表述 1.1 水下传感网络系统模型水声网络传感器的水下部署见图1, 分别有水底数据采集节点、水中移动AUV, 以及水面数据接收节点构成. 假设水下网络一共有

| {d_{i, j}} = \sqrt {{{\left( {{x_1} - {x_2}} \right)}^2} + {{\left( {{y_1} - {y_2}} \right)}^2} + {{\left( {{{\textit{z}}_1} - {{\textit{z}}_2}} \right)}^2}} | (1) |

且每个节点的发射功率和接收功率分别为

|

图 1 水声网络示意图 |

1.2 水下声学信道分析

不同于陆地通信, 水下是靠水声信道传输数据的. 因此, 水声信道的传输路径选择尤为重要. 不同的传输路径会导致不同的平均信噪比(SNR)[15]和链路吞吐量, 从而影响链路的能量消耗.

水声信道增益通常由距离和频率相关的大尺度衰落和时变多径衰落来描述. 信道增益

| A(d, f) = \gamma \bar A(d, f) | (2) |

其中,

| \bar A(d, f) = {d^k}a{(f)^d} | (3) |

其中,

| 10\lg a(f) = \frac{{0.11{f^2}}}{{1 + {f^2}}} + \frac{{44{f^2}}}{{4100 + {f^2}}} + 2.75 \times {10^{ - 4}}{f^2} + 0.003 | (4) |

| {\theta _{{f, d}}} = \Pr \left\{ {{{BE}}{{{R}}_{{f, d}}} \leqslant \delta } \right\} | (5) |

其中,

除了水下路径损耗之外, 环境噪声也会对节点的能量消耗造成影响. 水下环境噪声主要分为4种类型: 湍流噪声、船舶噪声、海浪噪声和热噪声. 假设4种噪声的功率谱密度和为:

| {\textit{SNR}} (d, f) = \frac{{P/A(d, f)}}{{N(f)\Delta f}} | (6) |

其中,

| {P_{{\text{success }}}} = 1 - \frac{1}{2}\left( {1 - \sqrt {\frac{{{\textit{SNR}} (d, f)}}{{1 + {\textit{SNR}}(d, f)}}} } \right) | (7) |

水声网络中, 有可能存在某一节点失效, 或者某一节点能量耗尽, 造成链路断裂的情况. 并引发路有空洞问题. 因此建立一个数学模型, 及时的评估链路质量, 以便尽早地发现问题, 提高系统的稳定性. 根据第1.2节定义的水下网络模型, 假设

| {M}_{i, j}=\left\{\begin{array}{*{20}{l}} 0,& {d}_{i, j} > {R}_{0}\\ {a}_{1}\times \left[\mathrm{ln}\left({R}_{0}/{\left({b}_{1}^{2}\cdot {d}_{ij}\right)}^{2}+{b}_{1}\right.\right], & 0 < {d}_{i, j}\leqslant{R}_{0}\\ {a}_{1}\cdot {b}_{1}& {d}_{i, j}=0 \end{array} \right. | (8) |

其中,

在UWSNs的数据传输过程中, 一条合适的传输路径受到传输节点深度、能量、延时的影响. 因此, 本文的设计的路由协议优化目标将围绕以上3点展开. 将路由协议基于蚁群算法的实现方式, 运用QL的决策设计理念. 将网络中央处理器看成一个集中式智能体, 在数据传输过程中, 不断地从环境中获取经验, 给出决策, 实现最优的动作. 最终实现一种路由, 以较低的数据传输延时均衡网络中的能量消耗. 假设

| {V_n} = \sum\limits_{n = 1}^N {{D_{(n, t)}}} /{E_{(n, t)}}{T_{(n, t)}} | (9) |

其中,

| {D_{(n, t)}} = {D_{\textit{z}}}\Bigg/\sum\limits_{i = 1, j = 2}^{{n_{\zeta e}}} {{d_{ij}}} | (10) |

| EX = \sum\limits_{j = 1}^{{n_{\zeta {\text{e}}}}} {\left( {{E_{(j, t)}} - {E_{{\rm{init}}}}} \right)} /{n_{{\zeta _e}}} | (11) |

| {E_{(n, t)}} = \sum\limits_{j = 1}^{{n_{\zeta e}}} {{{\left( {\left( {{E_{{\rm{init}}}} - {E_{(j, t)}}} \right) - EX} \right)}^2}} /{n_{{\zeta _e}}} | (12) |

| {{{T}}_{(n, t)}} = \left( {\sum\limits_{j = 1}^{{n_{\zeta e}}} {\left( {1 - \left( {{E_{(j, t)}}/{E_{{\text{init }}}}} \right)} \right)} \times {T_{\max }} + \eta } \right)/{n_{{\zeta _e}}} | (13) |

其中,

| {\pi _*} = \arg \max \sum\limits_{n \in N} {{V_n}} | (14) |

QACO的实现主要有两部分, 第1部分为做决策部分, 由QL强化学习算法完成; 第2部分为路由行为的实现, 由蚁群算法完成. 本节将对这两部分进行详细阐述.

2.1 强化学习及奖励机制 2.1.1 强化学习框架RL是机器学习的一个重要分支, 它为马尔可夫决策过程(MDP)提供了最优策略. 具体来说, 在MDP范式中, 智能体在时隙

| {r_t} = P_{{s_t}{s_{t + 1}}}^{{a_t}}r_{{s_t}{s_{t + 1}}}^{{a_t}} | (15) |

MDP的目标是找到最优策略

| {R_t} = \sum\limits_{k = t + 1}^\infty {{\gamma ^{k - t - 1}}} {r_k} | (16) |

其中,

| {Q_\pi }(s, a) = {R_t} + \gamma \sum\limits_{{s_{t + 1}} \in S} {P_{{s_t}{s_{t + 1}}}^{{a_t}}} Q\left( {{s_{t + 1}}, {a_t}} \right) | (17) |

通过策略学习,

在水声环境中, 数据的传输包括成功和失败. 因此环境分别对成功和失败反馈奖励. 因此, 本文定义在某个时隙

| R_{i, j}^* = {P_{i, j}}{R_{i, j}} + {\widetilde P_{i, j}}{\text{ }}{\widetilde R_{i, j}} | (18) |

其中,

| P_{{s_t}{s_{t + 1}}}^{{a_t}} = \sum\limits_{i = 1, j = 1, i \ne j}^{{n_{{\zeta _e}}}} {{P_{i, j}}} /{n_{{\zeta _e}}} | (19) |

由式(7)得

| {R_{i, j}} = {\alpha _1}{E_{i, j}} + {\alpha _2}D + {\alpha _3}{T_{i, j}} + {M_{i, j}} | (20) |

其中,

| {E_{i, j}} = - \left( {{c_i} + {c_j}} \right) | (21) |

其中,

| {c_i} = 1 - \frac{{{E_i}}}{{{E_{{\text{init }}}}}} | (22) |

式(21)中,

| D = - \frac{{\left| {{D_{ix}} - {D_{jx}}} \right|}}{{{D_{ij}}}} | (23) |

其中,

| {T_{ij}} = {T_i} + {T_j} | (24) |

| {{{T}}_i} = \left( {1 - \left( {{E_i}/{E_{{\text{init }}}}} \right)} \right)\times{T_{\max }} + \eta | (25) |

其中,

| {\widetilde R_{i, j}} = {\alpha _1}{c_i} + {\alpha _2}D + {\alpha _3}{T_i} + {M_{i, j}} | (26) |

综上所述, 第

| {R_t} = \sum\limits_{i = 1, j = 1, i \ne j}^{{n_{\zeta e}}} {R_{i, j}^*} | (27) |

QACO通过将进行节点之间信息交互的数据包看作蚂蚁, 在网络中进行传播, 维护网络环境. 路由行为的实现, 主要分为4个阶段: 向前蚂蚁阶段、回溯蚂蚁阶段、路由维持阶段、数据传输阶段.

2.2.1 向前蚂蚁阶段向前蚂蚁阶段: 发生在路由发现, 建立网络拓扑结构期间. 是一个全链路探测阶段, 蚂蚁由源节点出发, 采用

(1)经过节点的剩余能量

(2)蚂蚁经过节点的累积队列延迟

节点

| \Lambda = \left\{ {\begin{array}{*{20}{l}} 0,&{{d_{i, j}} > {R_0}或 {d_{i, j}} = 0} \\ 1,&{0 < {d_{i, j}} \leqslant {R_0}} \end{array}} \right. | (28) |

在

| {\Psi _g} = \hat \Gamma \times {{\rm{e}}^{Q\left( {{s_t}, {a_t}} \right) + \gamma \sum\limits_{{s_{t + 1}}{\in S}} {P_{{s_t}{s_{t + 1}}}^{{a_t}}} Q\left( {{s_{t + 1}}, {a_t}} \right)}} | (29) |

其中,

| \hat \Gamma = {{\sum \Lambda } \mathord{\left/ {\vphantom {{\sum \Lambda } {{n_{{\varsigma _e}}}}}} \right. } {{n_{{\varsigma _e}}}}} (\Lambda = 1) | (30) |

其中,

| {\psi _*} = \arg \max \sum {{\Psi _n}} | (31) |

其他向前蚂蚁变为回溯蚂蚁, 将路径的

|

图 2 向前蚂蚁探索过程 |

2.2.3 路由维持和数据传输阶段

当源节点以一定的流量不断地发送数据时, 向前蚂蚁周期性地产生, 由于水下网络拓扑环境不是单一固定的, 是实时变化的, 因此在路由维持阶段, 还要处理网络拥堵问题. 网络拥堵情况由指标

| \phi = 1 - \left( {{N_{{\rm{receive}}}}/{N_{{\text{send }}}}} \right) | (32) |

其中,

为了评估QACO协议的性能, 本文构建了水下传感网络仿真环境, 并将传统DBR算法与本节中的算法相比较. 具体的仿真参数设置如下: 空间为一个

算法1. QACO路由决策算法

输入: 初始化Q-learning参数: 折扣因子

输出: 式(14)得出的路由决策.

● 初始化阶段

1. 初始化节点参数: 中继节点

2. 初始化Q网络相关参数: 折扣因子

● QACO路由及决策

3.

4.

5. 向前蚂蚁依次从源节点出发, 广播节点

6. 基于

7. 计算相邻

8. 若

9. 计算第

10. 将状态输入Q网络计算Q值

11. 根据评估模型对第传到目的节点的

12. 最优路径回溯蚂蚁向源节点传回响应信息, 其余回溯蚂蚁则分别返回更新链路信息.

13. 信息更新完成, 选择动作

14. 以式(27)更新计算动作的奖励

15.

16.

| 表 1 系统仿真参数 |

3.2 仿真结果分析

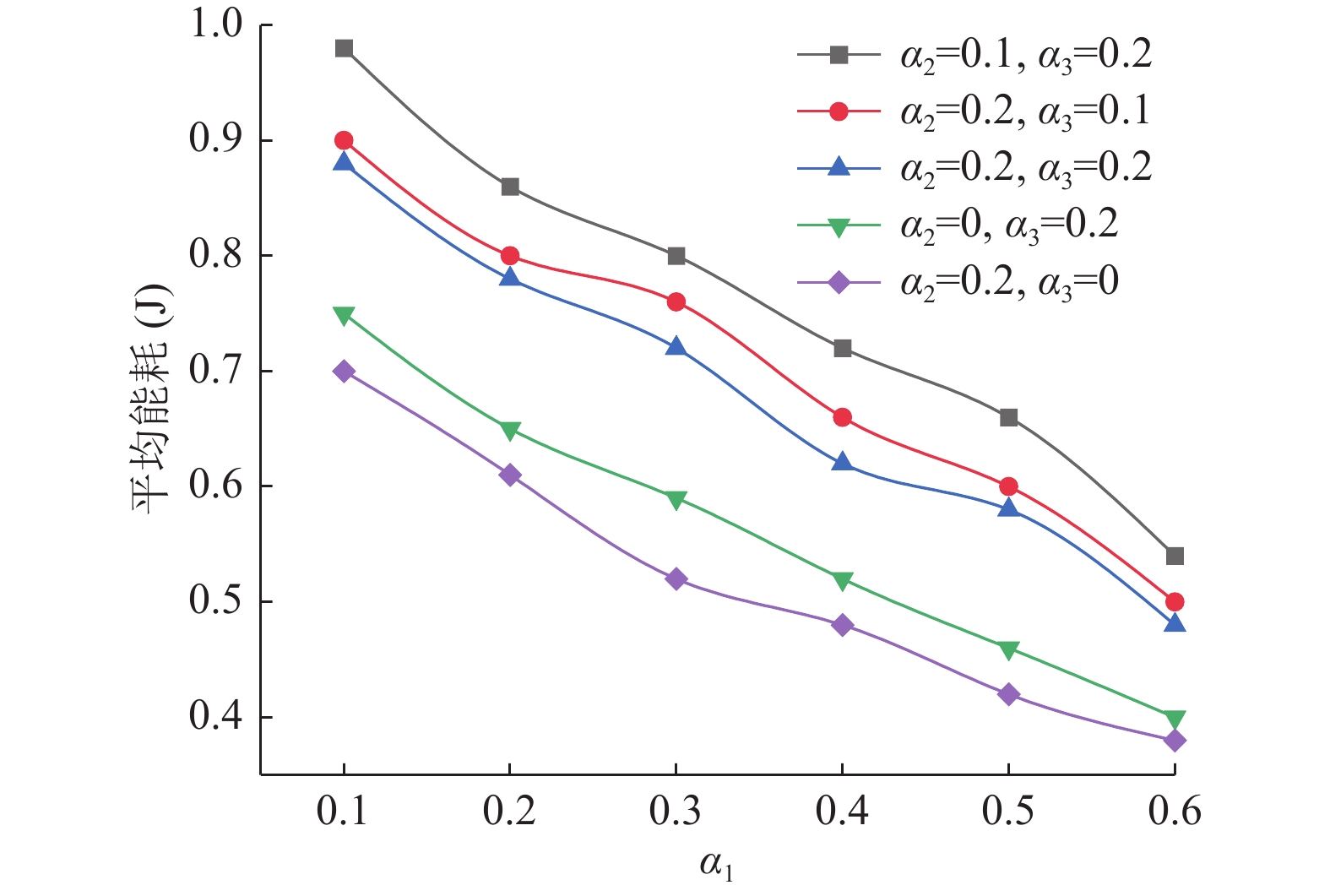

如图3所示, 首先对不同

|

图 3 不同

|

由图3可知, 得出了不同权重下对网络能耗的影响情况, 为了使得网络性能更加, 取

|

图 4 网络节点平均延时 |

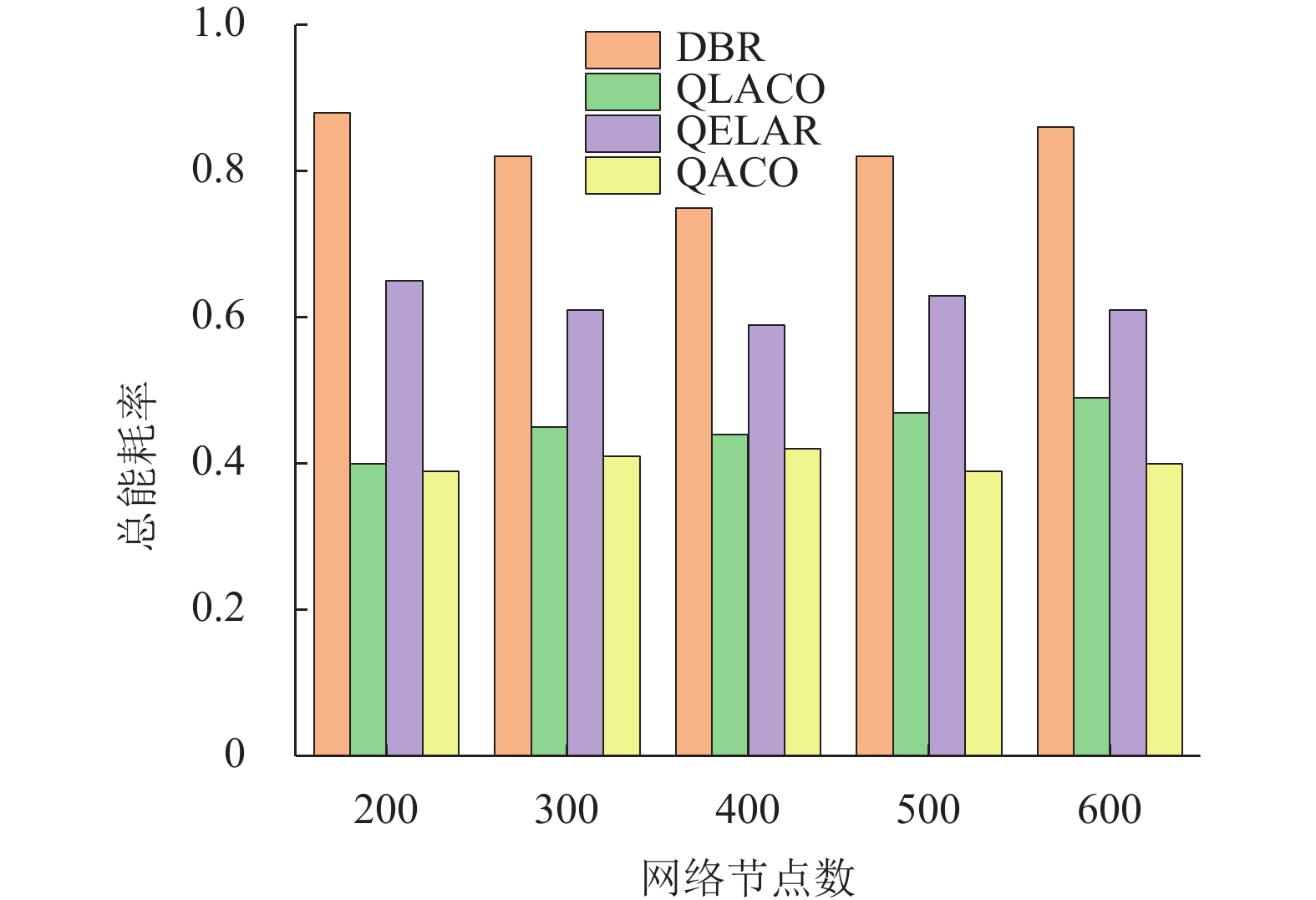

结合图5和图6, 随着网络节点数量的增加, 采用QACO路由协议和与QELAR、QLACO和DBR协议相比, 具有更长的网络生命周期和最少的能耗. 由于QLACO在处理路由空洞时会造成节点长时间的等待, 增加节点能量的消耗, 容易使节点陷入局部最优, 并且在节点数量增加时这一弊端显得更为明显. 而QACO通过链路质量因子LQI来判断链路好坏, 并兼顾考虑节点深度、能量、延时, 使得路由得出全局最优选择, 避免了路有空洞问题. 同时QACO采用智能蚂蚁进行路由行为, 优化了链路的传输效率, 降低了系统能耗, 延长了网络的生命周期.

|

图 5 网络生命周期图 |

|

图 6 网络的能耗比 |

4 结论

本文提出了一种基于Q学习优化的蚁群智能水声网络路由协议, 利用Q学习进行确定全局路由最优选择, 并设计基于延迟、剩余能量、深度和链路质量相关奖励函数. 并将蚁群算法应用于水声传感网络的路由行为, 实现水下数据的稳定可靠传输, 并解决了路有空洞问题, 分别从网络的延时、能量消耗、生命周期方面对协议进行了仿真实验, 实验证明, QACO算法在延时, 能耗以及网络的生命周期方面都明显优于QELAR、QLACO和DBR算法.

| [1] |

Zhang RX, Ma XL, Wang DQ, et al. Adaptive coding and bit-power loading algorithms for underwater acoustic transmissions. IEEE Transactions on Wireless Communications, 2021, 20(9): 5798-5811. DOI:10.1109/TWC.2021.3070363 |

| [2] |

Doosti-Aref A, Ebrahimzadeh A. Adaptive relay selection and power allocation for OFDM cooperative underwater acoustic systems. IEEE Transactions on Mobile Computing, 2018, 17(1): 1-15. |

| [3] |

Chen XK, Yang HJ, Wang QM, et al. Network coding-based relay selection and power distribution for underwater cooperative communication networks. Proceedings of the 2020 International Conference on Wireless Communications and Signal Processing. Nanjing: IEEE, 2020. 596–601.

|

| [4] |

Xie P, Cui HJ, Lao L. VBF: Vector-based forwarding protocol for underwater sensor networks. Proceedings of the 5th International Conference on Research in Networking. Coimbra: Springer, 2006. 1216–1221.

|

| [5] |

Hwang D, Kim D. DFR: Directional flooding-based routing protocol for underwater sensor networks. Proceedings of the OCEANS 2008. Quebec City: IEEE, 2008. 1–7.

|

| [6] |

Yan H, Shi ZJ, Cui JH. DBR: Depth-based routing for underwater sensor networks. Proceedings of the 7th International Conference on Research in Networking. Singapore: Springer, 2008. 72–86.

|

| [7] |

Yildiz HU, Gungor VC, Tavli B. Packet size optimization for lifetime maximization in underwater acoustic sensor networks. IEEE Transactions on Industrial Informatics, 2019, 15(2): 719-729. DOI:10.1109/TII.2018.2841830 |

| [8] |

Nazareth P, Chandavarkar BR. Link and void aware routing protocol for underwater acoustic sensor networks. Proceedings of the 12th International Conference on Computing Communication and Networking Technologies. Kharagpur: IEEE, 2021. 1–6.

|

| [9] |

Shi YM, Rong ZH. Analysis of Q-learning like algorithms through evolutionary game dynamics. IEEE Transactions on Circuits and Systems II: Express Briefs, 2022, 69(5): 2463-2467. DOI:10.1109/TCSII.2022.3161655 |

| [10] |

Dorigo M, Maniezzo V, Colorni A. Ant system optimization by a colony of cooperating agents.IEEE Transactions on Systems, Man, and Cybernetics, Part B (Cybernetics). 1996, 26(1): 29–41.

|

| [11] |

Lyu L, Shen Y, Zhang SC. The advance of reinforcement learning and deep reinforcement learning. Proceedings of the 2022 IEEE International Conference on Electrical Engineering, Big Data and Algorithms. Changchun: IEEE, 2022. 644–648.

|

| [12] |

Hu TS, Fei YS. QELAR: A Q-learning-based energy-efficient and lifetime-aware routing protocol for underwater sensor networks. Proceedings of the 2008 IEEE International Performance, Computing and Communications Conference. Austin: IEEE, 2008. 247–255.

|

| [13] |

Fang ZR, Wang JJ, Jiang CX, et al. QLACO: Q-learning aided ant colony routing protocol for underwater acoustic sensor networks. Proceedings of the 2020 IEEE Wireless Communications and Networking Conference. Seoul: IEEE, 2020. 1–6.

|

| [14] |

Malajner M, Gleich D. Study of link quality indicator for possible usage in angle of arrival estimation. Proceedings of the 21 International Conference on Systems, Signals and Image Processing. Dubrovnik: IEEE, 2014. 195–198.

|

| [15] |

Haneef N, Chandavarkar BR. Dependency of routing protocol on pH and SNR in underwater communications. Proceedings of the 12th International Conference on Computing Communication and Networking Technologies. Kharagpur: IEEE, 2021. 1–7.

|

| [16] |

Deng ZC, Yu X, Zhu ZB, et al. Adaptive kalman filter based single beacon underwater tracking with unknown effective sound velocity. Proceedings of the 8th IEEE International Conference on Underwater System Technology: Theory and Applications. Wuhan: IEEE, 2018. 1–5.

|

| [17] |

Brekhovskikh LM, Lysanov YP. Fundamentals of Ocean Acoustics. 3rd ed., New York: Springer-Verlag, 2003.

|

| [18] |

Bhandarkar AB, Jayaweera SK. Optimal trajectory learning for UAV-mounted mobile base stations using RL and greedy algorithms. Proceedings of the 17th International Conference on Wireless and Mobile Computing, Networking and Communications. Bologna: IEEE, 2021. 13–18.

|

2023, Vol. 32

2023, Vol. 32