中文分词为自然语言处理(natural language processing, NLP)的基础性任务之一, 对于各种下游任务有直接影响. 总结以往的中文分词研究, 可以分为以下几种方案: 1)基于词典的分词方法[1]; 2)构建分词规则的方法[2]; 3)依据机器学习模型的方法[3, 4]; 4)依据深度学习模型的方法[5, 6]. 将中文分词建模为序列标注任务是分词的主流方法之一[7, 8], 该方法给每一个字符赋予对应的分词标签以明确某个字符在词中的具体位置来完成分词, 当前最主流的分词标签集合为: {S: 单字成词, B: 词的起始位置, M: 词的中间位置, E: 词的结束位置}.

随着深度学习技术和计算机硬件的不断发展, 构建并训练拥有大规模参数的预训练语言模型(例如: BERT[9]、XLNet[10]、ZEN[11]等)成为可能, 预训练语言模型提升了大部分自然语言处理任务的性能上限, 中文分词自然也不例外. 近年来, 关于融合句法知识的深度学习模型的研究有了一定发展. 其中, Tian等人[12]提出一种融合句法知识的双通道自注意力模型, 提高了分词和词性标注的联合学习模型的性能. 韩虎等人[13]构建一种融合句法知识和位置信息的交互图自注意力机制模型, 提升了方面级情感分析的识别能力. Chen等人[14]利用键值记忆网络融合句法知识, 对实体内部单词级别的关系和跨实体间关系进行建模, 构建关系抽取模型, 取得了性能上的提升. Zhang等人[15]通过可视化发现, 在阅读理解任务中, 自注意力机制会关注一些不太重要的虚词, 所以利用句法依存知识对自注意力机制加以约束.

以上的研究结果表明, 将句法知识融入到NLP深度学习模型中会有更好的表现, 因此, 有理由相信, 融合句法知识的中文分词模型能够进一步提升模型分词的能力. 本文在Zhang等人[15]研究基础上, 将句法依存中词之间的依存关系, 转化为字符之间的关系, 并根据句法依存树将位置信息编码到模型中, 构建一种句法依存引导的自注意力机制的中文分词模型(Chinese word segmentation model based on self-attention mechanism guided by syntactic dependency, AM-GSD).

1 方 法传统的自注意力机制对所有字符不加显示约束地计算注意力向量, 这会使得自注意力机制变得分散, 使分词模型更容易受到一些不必要信息的干扰. 本文的出发点是利用句法依存关系对自注意力机制加以引导, 从而削减一些噪声, 进一步提升模型分词的性能.

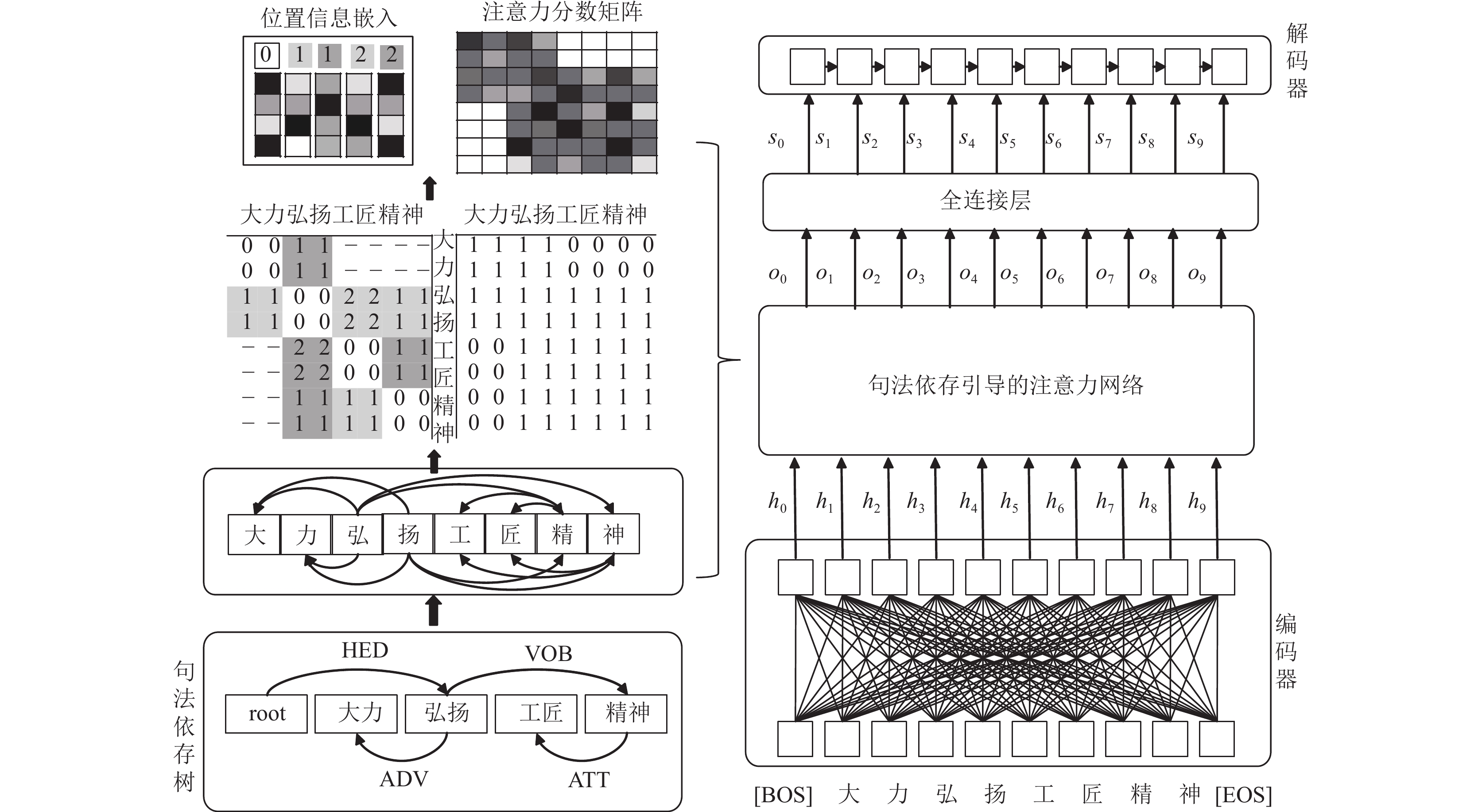

1.1 算法框架概述本文提出的中文分词模型AM-GSD的结构如图1所示.

|

图 1 AM-GSD模型结构 |

AM-GSD通过句法依存树对自注意力机制进行引导, 把句法知识融入到模型中, 使得模型着重关注那些对当前字符的分词标签有句法依存影响的字符, 学习它们对于当前字符的影响程度. 同时, AM-GSD基于句法依存树进行位置编码, 把句法依存树上的位置信息融入到模型中. AM-GSD首先利用编码器将输入的文本序列转化为相对应的语义表征向量, 然后利用句法依存工具获取到相对应的句法依存树, 并利用句法依存树引导自注意力机制, 将语义表征向量和句法依存树上的位置信息输入到引导后的自注意力网络中, 最后将输出的语义表征向量输入到解码器中得到相应的分词标签. 下面将分别对句法依存引导的自注意力机制, 编码器-解码器和损失函数进行详细的介绍.

1.2 句法依存引导的自注意力机制句法依存树刻画的是文本序列中各个单词之间的依存关系. 如图2所示, 词汇“弘扬”和词汇“精神”存在着这种依存关系, 其中, 词汇“弘扬”是支配词, 词汇“精神”是从属词, 二者被依存弧所连接, 依存弧上的标识为依存关系类型. 每一个句子都会有一个依存关系核心词, 其与句子中的其他词汇存在着直接或间接的联系.

|

图 2 句法依存树 |

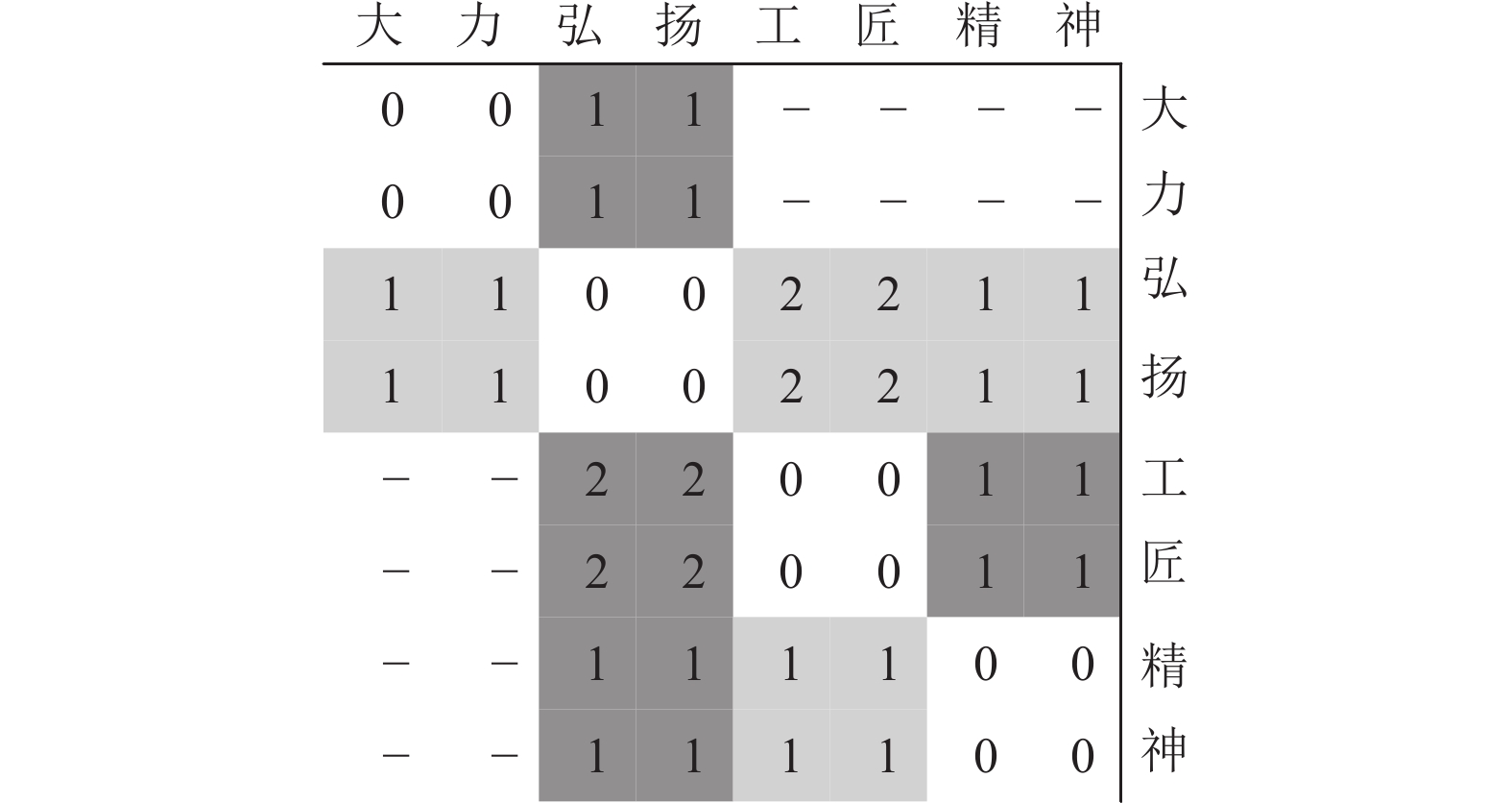

如图3所示, 根据句法依存树, 我们可以将词与词之间的依赖关系转化为字符与字符之间的关系, 从而可以对自注意力机制进行引导, 把句法知识融入到分词模型中.

|

图 3 字符之间的关系 |

假设存在文本序列

| Mij={1, i=j or cj∈Si or Si=Sj0, otherwise | (1) |

如图3所示, “大”的反向连通节点为“弘”和“扬”, 反之, “弘”和“扬”的正向连通节点集中也有“大”, 因此, 示例句子对应的矩阵的第1行中(1, 1)(1, 3)(1, 4)位置上的数值为1, 第1列(3, 1)(4, 1)位置上的数值为1.

本文将编码器BERT的输出作为句法依存引导的自注意力机制的输入, 句法依存引导的自注意力机制的前向传播计算过程如式(2)–式(4)所示:

| oi=n∑j=1aij(hjWv) | (2) |

| aij=ReLU(eij) | (3) |

| eij=Mij((hiWq)(hjWk)T√d) | (4) |

其中,

位置编码(positional encoding, PE)在自注意力机制中的作用十分重要, 其可以将文本序列中单词的相对位置信息融入到自注意力机制中, 从而可以避免只传递词嵌入所产生的混乱问题. 基于此, 本文受前人工作[16, 17]的启发, 根据句法依存关系获得位置编码信息.

对于一个文本序列

| Pij={lij, xi支配xj¬lij, xj支配xi0, xi和xj共词−1, xi和xj无关系 | (5) |

其中,

|

图 4 位置关系矩阵 |

在算法设计中, 可以初始化两个位置信息矩阵

| oi=n∑j=1aij(hjWv+Tvij) | (6) |

| aij=ReLU(eij) | (7) |

| eij=Mij((hiWq)(hjWk+Tkij)T√d) | (8) |

其中,

(1) 编码器

在文本序列

| hi=Encoder(xi) | (9) |

其中,

(2) 解码器

将

| ˆyi=Decoder(si) | (10) |

其中,

本文采用负对数似然损失函数的标准反向传播算法进行训练, 计算方法如式(11)所示:

| L(θ)=−∑ilog(p(yi|xi;θ)) | (11) |

其中,

本文选取中文分词常用的PKU, MSR, AS和CITYU这4个数据集作为本文的评测数据集, 并按照官方标准划分训练集和测试集, 上面的4个数据集中, AS和CITYU是繁体中文数据集, 需将其转化为简体中文后用于模型的评测. 4个数据集的各项统计指标如表1所示.

| 表 1 数据集各项指标 |

2.2 评测指标

本文所选评测指标为

| F1=2×准确率×召回率准确率+召回率 | (12) |

| Roov=正确分类OOV词的数量测试集中OOV词的数量×100% | (13) |

其中,

本文实验的编程环境为Python 3.7.12, 深度学习框架PyTorch的版本为1.12.1+cu113, 实验的运行环境为Ubuntu 18.04.5; CPU型号为Intel(R) Xeon(R) Gold 6330 CPU @ 2.00 GHz, GPU为Tesla A100, 显存为40 GB, CUDA的版本为11.6.

2.4 参数设置本文实验的一些重要参数设置如表2所示.

| 表 2 一些重要参数 |

2.5 算法伪代码

为了更直观的理解本文算法过程, 将算法伪代码整理如算法1.

算法1. 句法依存引导的自注意力机制的分词模型

输入: 带有标注的数据D; 最大迭代轮数E.

输出: 在测试集上损失最小的模型

初始化: 模型参数

for

for

for 文本序列

位置嵌入索引矩阵

for

end

end

if

end

renturn

为了评测AM-GSD模型的有效性, 选取近几年来的分词模型与其进行对比, 对比实验结果如表3所示.

| 表 3 对比实验结果1 (%) |

从表3可以看到, 文献[18]将文本序列中的成词信息融入到分词模型中; 文献[19]将Transformer和CRF结合起来构建分词模型; 文献[20]构建了一种多准则的分词模型; 文献[21]将n-gram片段语义信息融入到LSTM分词模型中; 文献[22]提出了一种基于机器阅读理解模型的分词方法, 针对性地解决中文分词序列标注模型很难获取句子的长距离语义依赖的问题; 文献[23]首先训练一个分词模型来生成初始的分词结果, 然后用语言模型的预测结果来评价分词结果的质量, 最后用增强的最小风险训练方法来提高分词模型的性能; 文献[24]是一种多标准分词方法, 其设置一个私有层和一个公共层来分别学习每个标准的特定特征和所有标准的公有特征, 然后将其二者拼接, 输入到CRF中, 计算得分函数. 以上的研究成果都取得了不错的效果, 可以看到本文提出的模型在其中的表现还是不错的, 在3个指标上取得了最好的成绩.

上面是从绝对角度来对比的, 下面本文将与另外一些中文分词SOTA模型进行提升量的对比, 对比结果如表4所示.

模型1利用键值记忆网络将成词信息注入到模型中; 模型2构建了一种带标签注意力的记忆网络, 将标签的依赖关系融入到模型中. 这两个模型都取得了不错的提升效果, 从表中可以看出本文的模型在提升量上的对比上并不处于优势地位, 但还是有一定的提升, 而且本文baseline模型的指标数值较高, 说明AM-GSD在一个较高的基础水平上仍有一定的提升.

| 表 4 对比实验结果2 (%) |

2.7 消融实验

为了进一步验证AM-GSD模型的有效性, 对其进行消融实验, 实验的结果如表5所示.

| 表 5 消融实验结果 (%) |

本文有两个改进之处.

(1) 利用句法依存树引导自注意力机制, 使模型只关注那些对当前字符的分词标签有句法依存影响的字符, 将句法知识融入到模型之中.

(2) 针对引导后的自注意力机制提出一种基于句法依存树的位置编码方式, 对引导后的自注意力机制进行位置编码.

从BERT-crf和AM-GSD的对比结果来看, AM-GSD相较于BERT-crf在PKU、MSR、AS和CITYU的

从AM-GSD和AM-GSD (PE)的对比结果来看, AM-GSD(PE)相较于AM-GSD在PKU、MSR、AS和CITYU的

为了更直观的说明AM-GSD的作用, 本文以文本序列“大力弘扬工匠精神”为例, 画出其热力图如图5和图6所示.

|

图 5 未加句法引导的自注意力机制可视化结果 |

|

图 6 句法引导的自注意力机制可视化结果 |

通过图5和图6对比得出, BERT-crf (图5)的自注意力比较分散, 每个字符之间的相关性比较复杂; 而AM-GSD (图6)的自注意力比较集中, 字符之间的相关性在句法依存关系的引导下得到了一定程度的简化. 这也印证了, AM-GSD可以很好地基于句法依存关系对自注意力机制进行引导, 相当于对分词模型进行剪枝, 从而进一步提升了模型的分词性能.

3 结论与展望本文提出一种句法依存引导的自注意力机制分词模型, 并针对性地提出一种基于句法依存树的位置编码方式. 模型将句法依存知识融入到分词模型中, 提高了模型分词的性能和泛化能力.

本文并未考虑句法依存关系类型, 获得的句法依存关系也存在一定的错误, 这会对分词模型产生负面影响. 在未来的研究工作中, 可以将引入的句法依存知识进一步完整化.

| [1] |

Zhang Q, Liu XY, Fu JL. Neural networks incorporating dictionaries for Chinese word segmentation. Proceedings of the 2018 AAAI Conference on Artificial Intelligence. New Orleans: AAAI, 2018. 5682–5689.

|

| [2] |

Wu AD, Jiang ZX. Word segmentation in sentence analysis. Proceedings of the 1998 International Conference on Chinese Information Processing. Beijing: Tsinghua University Press, 1998. 169–180.

|

| [3] |

Asahara M, Goh CL, Wang XJ, et al. Combining segmenter and chunker for Chinese word segmentation. Proceedings of the 2nd SIGHAN Workshop on Chinese Language Processing. Sapporo: ACM, 2003. 144–147.

|

| [4] |

Fan C, Li Y. Research on Chinese word segmentation based on conditional random fields. Proceedings of the 17th International Conference on Intelligent Computing Theories and Application. Shenzhen: Springer, 2021. 316–326.

|

| [5] |

Qun N, Yan H, Qiu XP, et al. Chinese word segmentation via BILSTM+Semi-CRF with relay node. Journal of Computer Science and Technology, 2020, 35(5): 1115-1126. DOI:10.1007/s11390-020-9576-4 |

| [6] |

Tian YH, Song Y, Xia F, et al. Improving Chinese word segmentation with wordhood memory networks. Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics. ACL, 2020. 8274–8285.

|

| [7] |

章登义, 胡思, 徐爱萍. 一种基于双向LSTM的联合学习的中文分词方法. 计算机应用研究, 2019, 36(10): 2920-2924. DOI:10.19734/j.issn.1001-3695.2018.03.0239 |

| [8] |

Cai TT, Ma ZY, Zheng H, et al. NE-LP: Normalized entropy- and loss prediction-based sampling for active learning in Chinese word segmentation on EHRs. Neural Computing and Applications, 2021, 33(19): 12535-12549. DOI:10.1007/s00521-021-05896-w |

| [9] |

Devlin J, Chang MW, Lee K, et al. BERT: Pre-training of deep bidirectional Transformers for language understanding. Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics. Minneapolis: ACL, 2019. 4171–4186.

|

| [10] |

Yang ZL, Dai ZH, Yang YM, et al. XLNet: Generalized autoregressive pretraining for language understanding. Proceedings of the 33rd International Conference on Neural Information Processing Systems. Vancouver: ACM, 2019. 517.

|

| [11] |

Diao SZ, Bai JX, Song Y, et al. ZEN: Pre-training Chinese text encoder enhanced by n-gram representations. Findings of the Association for Computational Linguistics: EMNLP. ACL, 2020. 4729–4740.

|

| [12] |

Tian YH, Song Y, Ao X, et al. Joint Chinese word segmentation and part-of-speech tagging via two-way attentions of auto-analyzed knowledge. Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics. ACL, 2020. 8286–8296.

|

| [13] |

韩虎, 吴渊航, 秦晓雅. 面向方面级情感分析的交互图注意力网络模型. 电子与信息学报, 2021, 43(11): 3282-3290. DOI:10.11999/JEIT210036 |

| [14] |

Chen GM, Tian YH, Song Y, et al. Relation extraction with type-aware map memories of word dependencies. Findings of the Association for Computational Linguistics. ACL, 2021. 2501–2512.

|

| [15] |

Zhang ZS, Wu YW, Zhou JR, et al. SG-Net: Syntax-guided machine reading comprehension. Proceedings of the 2020 AAAI Conference on Artificial Intelligence. New York: AAAI, 2020. 9636–9643.

|

| [16] |

Shaw P, Uszkoreit J, Vaswani A. Self-attention with relative position representations. Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 2 (Short Papers). New Orleans: ACL, 2018. 464–468.

|

| [17] |

Wang X, Tu ZP, Wang LY, et al. Self-attention with structural position representations. Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP). Hong Kong: ACL, 2019. 1403–1409.

|

| [18] |

Nguyen DV, Vo LB, van Thin D, et al. Span labeling approach for Vietnamese and Chinese word segmentation. Proceedings of the 18th Pacific Rim International Conference on Artificial Intelligence. Hanoi: Springer, 2021. 244–258.

|

| [19] |

Qiu XP, Pei HZ, Yan H, et al. A concise model for multi-criteria Chinese word segmentation with Transformer encoder. Findings of the Association for Computational Linguistics: EMNLP 2020. ACL, 2020. 2887–2897.

|

| [20] |

Chen XC, Shi Z, Qiu XP, et al. Adversarial multi-criteria learning for Chinese word segmentation. Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Vancouver: ACL, 2017. 1193–1203.

|

| [21] |

Gong JJ, Chen XC, Gui T, et al. Switch-LSTMs for multi-criteria Chinese word segmentation. Proceedings of the 2019 AAAI Conference on Artificial Intelligence. Honolulu: AAAI, 2019. 6457–6464.

|

| [22] |

周裕林, 陈艳平, 黄瑞章, 等. 一种采用机器阅读理解模型的中文分词方法. 西安交通大学学报, 2022, 56(8): 95-103. DOI:10.7652/xjtuxb202208010 |

| [23] |

Maimaiti M, Liu Y, Zheng YH, et al. Segment, mask, and predict: Augmenting Chinese word segmentation with self-supervision. Proceedings of the 2021 Conference on Empirical Methods in Natural Language Processing. Punta Cana: ACL, 2021. 2068–2077.

|

| [24] |

Huang WP, Cheng XY, Chen LK, et al. Towards fast and accurate neural Chinese word segmentation with multi-criteria learning. Proceedings of the 28th International Conference on Computational Linguistics. Barcelona: ACL, 2020. 2062–2072.

|

| [25] |

韩士洋, 马致远, 杨芳艳, 等. 针对中文分词的带标签注意力的成词记忆网络. 计算机应用研究, 2022, 39(6): 1651-1655. DOI:10.19734/j.issn.1001-3695.2021.11.0592 |

2023, Vol. 32

2023, Vol. 32