随着经济的发展, 道路上的车辆数量也显著增加, 道路上的行车压力也越来越大, 随之而来的交通事故也逐年递增. 自动驾驶能够辅助甚至代替驾驶员控制车辆安全运行, 能够减少交通事故的发生, 缓解和改善道路拥堵状况, 是未来的发展趋势[1]. 环境感知系统利用雷达和摄像头等多种硬件传感器为自动驾驶系统提供可靠的外部环境判断, 是自动驾驶系统进行控制和决策的基础. 通过车载前视摄像头进行目标检测是环境感知的重要组成部分, 已经成为目前研究热点[2].

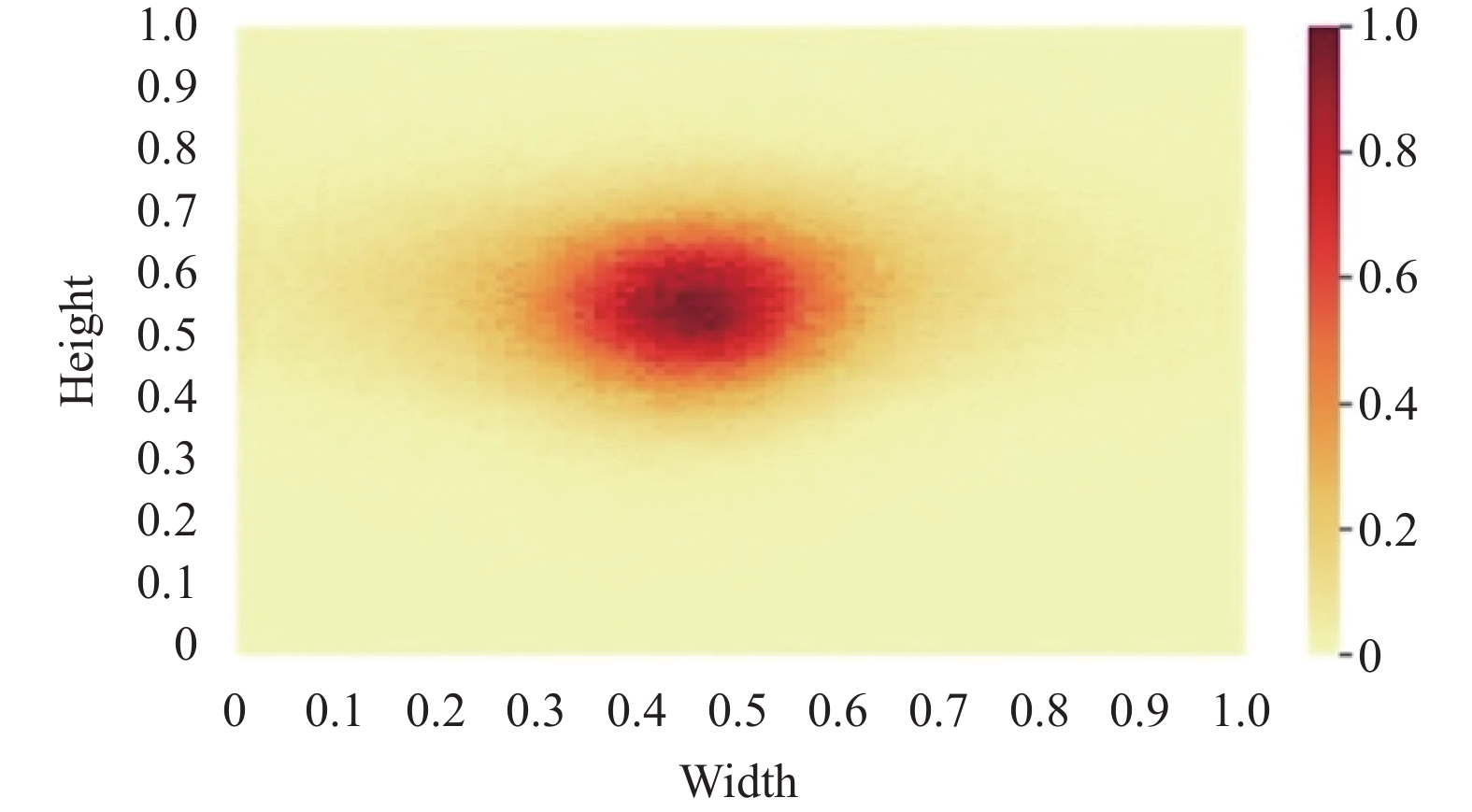

在自动驾驶场景中, 由于车载摄像机视角相对固定, 拍摄得到的道路图像具有特殊的空间性质. 图像底部主要由道路组成, 中间部分包含各种相对较小的物体, 而顶部主要包括建筑物和天空, 并且不同类别在图像中的分布也不均匀[3]. 本文统计了BDD100K数据集[4]中不同类别在图像中的位置分布, 如图1所示. 从图1中可以看到, 交通信号灯(traffic light)和交通标识(traffic sign)主要集中在图像顶部区域, 汽车(car)在图像中下部道路区域出现的概率更高, 而行人(person)主要分布在图像两侧的非行驶区域或道路边缘. 此外, 因为车载摄像头存在透视投影, 导致同样大小的物体离摄像头越近成像越大, 而离摄像头越远成像越小. 在这种情况下, 道路目标的尺寸与其在图像中的位置有很强的相关性[5]. 如图2所示, 小目标主要集中在图像高度比例为0.4–0.7, 宽度比例为0.3–0.6区域, 这意味着小目标往往出现在图像的中上区域.

目前流行的目标检测算法分为两类: 以R-CNN系列[6]为代表的两阶段检测算法和以YOLO系列[7]、SSD[8]、RetinaNet[9]为代表的单阶段检测算法. 两阶段目标检测算法先进行区域提议再进行分类和定位, 而单阶段目标检测算法直接由图像特征得到目标的类别概率和检测框位置. 虽然两阶段目标检测算法检测精度高但检测效率较差, 无法满足自动驾驶高实时性要求. 同时, 单阶段检测算法速度较快但检测精度低于两级检测器[10].

|

图 1 BDD100K类别分布热力图 |

自动驾驶计算平台的计算资源有限, 需要同时处理检测、跟踪、决策等多种传感和计算任务. 这要求应用在车端的检测算法需要具有较小的内存占用率和计算资源占用率[11]. 因此, 如何在保持实时目标检测能力的同时, 提升检测精度是近几年的研究重点. Cai等人[11]改进了YOLOv4算法, 使用可变形卷积代替特征提取网络的最后一个输出层并且设计了一个新的特征融合模块进行特征融合, 提高了平均检测精度. Zhu等人[12]提出一种新的目标检测网络TPH-YOLOv5. 在YOLOv5的基础上集成卷积注意力模块, 使模型在检测不同尺度物体时能关注重要的特征, 提升特征提取能力. Chen等人[13]在YOLOv3-tiny上进行裁剪, 量化网络中的参数, 降低了算法运行复杂度. 刘革等人[14] 用MobileNet V3替换RetinaNet的特征提取网络, 引入GIoU改进损失函数, 提高了网络特征提取能力. 李彦辰等人[15]以Efficientdet为基础框架, 设计多尺度注意力机制模块应用于特征融合网络, 提高了对小目标的检测精度.

|

图 2 BDD100K小目标分布热力图 |

综上所述, 虽然对于自动驾驶领域目标检测已经取得一定成果, 但是缺少针对自动驾驶场景特有的空间特征进行优化设计, 没有很好地利用这一关键特征. 并且由于小目标面积小、图像模糊、易受噪声影响、网络卷积层数过深等因素, 导致很难有效提取小目标特征, 检测精度有待进一步提高. 因此, 提出一种改进YOLOv5的空间特征增强网络SE-YOLOv5, 主要改进点如下.

(1) 为了增强网络对目标类别位置分布的感知和定位能力, 提出了一种位置注意力模块. 它能够提取元素级空间位置特征图, 根据像素的空间位置自适应调整图像特征权重, 增强网络特征提取能力.

(2) 针对小目标信息缺失的问题, 提出一种小目标增强模块. 通过自下而上以及自上而下的双向特征调制, 结合深层特征的语义信息以及浅层特征的细节信息, 获得更丰富的小目标特征, 提高网络对小目标的检测性能.

1 网络改进 1.1 改进YOLOv5s网络结构YOLOv5是一种单阶段目标检测算法, 具有部署成本低、灵活度高和检测速度快的特点. 其网络结构可以分为输入端(Input)、主干网络(Backbone)、颈部网络(Neck)、检测网络(Head)这4个部分. 输入端主要完成图像增强、锚框计算、图像缩放等预处理操作; 主干网络使用CSPDarknet53和SPPF提取图像特征; PANet结构作为颈部网络用于聚合特征; 最后在检测网络对3种尺度特征图进行目标的分类和预测. 此外, YOLOv5根据网络深度和宽度可以分为依次递增的4个版本, 分别为YOLOv5s、YOLOv5m、YOLOv5l以及YOLOv5x.

综合考虑算法检测速度和精度, 本文选用YOLOv5s作为基础网络, 在颈部网络中添加位置注意力模块, 帮助网络感知道路目标在图像中的空间位置分布, 增强网络特征提取能力; 在主干网络中添加小目标增强模块, 丰富检测网络中小目标特征信息, 提高网络小目标检测精度, 改进后的SE-YOLOv5s网络结构如图3所示.

1.2 位置注意力模块本文在HANet[3]的基础上设计了一种位置注意力模块, 它能够提取自动驾驶场景中空间位置注意力特征, 对不同通道特征以及空间位置进行加权, 增强网络对目标类别和位置分布的感知和定位能力, 模块结构如图4所示. 给定特征图

(1) 特征压缩. 首先, 经过全局平均池化聚合高度和宽度方向上的上下文, 接着通过1×1的卷积在通道维度上对特征图进行压缩, 剔除冗余通道特征, 减少参数量, 如式(1)所示.

| ˆX=Conv(AvgPool(X)) | (1) |

其中,

(2) 计算位置注意力特征图. 为了生成像素级位置注意力特征图, 同时使用通道注意力和空间注意力, 以捕获像素间的空间上下文相关性和通道间的语义相关性. 同时, 为了提高计算效率, 使用并联提取注意力特征, 减少计算时间成本. 其中, 通道注意力计算过程如式(2)–式(4)所示.

| Gavg(X)=σ(FC(δ(FC(AvgPool(X))))) | (2) |

| Gmax(X)=σ(FC(δ(FC(MaxPool(X))))) | (3) |

| Ac(X)=Gavg(X)+Gmax(X) | (4) |

其中,

|

图 3 SE-YOLOv5s网络结构 |

|

图 4 位置注意力模块结构 |

在计算空间注意力权重时, 引入CoordConv模块[16]. CoordConv通过在输入特征中增加两个坐标通道, 增强卷积的空间特征提取能力, 能更好地学习自动驾驶场景中的空间位置分布. 空间注意力可用如式(5)表示.

| AS(X)=σ(Conv(Cd(AvgPool(X),MaxPool(X)))) | (5) |

其中,

| A=Upsample(Ac(X)⊗As(X)) | (6) |

其中,

为了提高小目标的检测精度, 本文在非对称上下文调制模块[17]的基础上进行改进, 设计了一种小目标增强模块, 如图5所示.

如图5所示, 小目标增强模块主要由自下而上的逐点通道上下文调制模块和自上而下的全局上下文调制模块构成, 通过对浅层高分辨率特征以及深层高级语义特征进行多尺度交换, 以获得包含小目标细节信息以及语义信息的增强特征.

1.3.1 自下而上的通道上下文调制如图6所示, 自下而上的上下文调制为一个逐点通道注意力, 其中每个空间位置的通道特征上下文被单独聚合. 该模块利用浅层特征中丰富的小目标细节信息自下而上的生成空间细节上下文调制权重, 弥补深层特征中缺失的小目标细节信息, 主要流程如下.

|

图 5 小目标增强模块结构 |

|

图 6 自下而上调制模块结构 |

(1) 特征裁剪. 首先对浅层特征在高度比例为0.4–0.7, 宽度比例为0.3–0.6区域进行裁剪, 获取包含小目标的特征区域, 并减少冗余特征和参数量.

(2) 尺度匹配. 考虑到特征尺寸匹配问题, 采用双线性插值算法生成与

| α(X)=BI(Crop(X)) | (7) |

(3) 计算调制权重. 经过两次逐点卷积和激活函数获得调制权重, 最终经过逐点相乘得到调制后的高级特征

| Y′=σ(PWC(δ(PWC(α(X)))))⊗PWC(Y) | (8) |

其中,

自上而下的上下文调制模块通过全局上下文信息来指导浅层特征, 并将全局语义特征嵌入到浅层特征中, 减少浅层特征噪声信息的干扰. 模块结构如图7所示, 调制步骤如下.

|

图 7 自上而下调制模块结构 |

1)建模全局上下文信息. 使用了简化版的全局上下文模块(global context, GC)[18]来建模全局上下文信息, 如式(9)所示.

| β(Y)=PWC(Y)⊗ρ(PWC(PWC(Y))) | (9) |

2)瓶颈转换. 将全局上下文特征通过卷积捕获通道间依赖, 如式(10)所示.

| γ(Y)=σ(PWC(δ(PWC(Y)))) | (10) |

3)特征融合. 使用乘法融合策略将上下文特征嵌入到浅层特征中, 实现特征融合. 调制特征可以由式(11)得到.

| X′=α(X)⊗γ(β(Y)) | (11) |

其中,

BDD100K数据集是2018年由伯克利大学发布的大规模、多样化自动驾驶数据集, 涵盖一天中不同时间、天气条件和驾驶场景. 本文在BDD100K数据集的基础上筛除一些不均衡的类别, 最终选取其中46500张图片进行训练, 按照7:2:1比例随机分配, 其中训练集32550张图片, 验证集9300张图片, 测试集4650张图片, 重新分类为汽车、大车、人、两轮车、交通灯和交通标识共6种道路目标.

实验使用NVIDIA GeForce RTX 3090显卡进行模型训练和测试, CPU为Intel(R) Xeon(R) Platinum 8255C. 系统和软件环境为Ubuntu 22.04, Python 3.8.10, 深度学习框架为PyTorch 1.10.2, 训练配置如表1所示.

| 表 1 模型训练配置 |

2.2 评价指标

为了更好地观察网络对不同尺度目标的检测效果, 使用COCO评价指标进行评价, 具体名称和含义如表2所示.

| 表 2 模型训练配置 |

2.3 消融实验

为了证明改进模块的有效性, 设置了4组对比实验, 如表3所示, 其中“√”表示在基准网络中加入该模块. 从表3中可以看到, YOLOv5s+LAM修改 YOLOv5s的Neck部分, 在每个Concat模块后添加位置注意力模块, 相比于YOLOv5s, APS, APM, APL均有一定提高, 分别为0.7%, 1.6%, 1.2%. 说明位置注意力模块能够学习道路目标的空间位置分布规律, 增强网络特征提取能力, 整体提高网络检测性能. YOLOv5s+STEM在YOLOv5s中增加小目标增强分支, 与YOLOv5s相比, APS, APM分别提高2.6%以及1.2%, APL基本保持不变. 这表明小目标增强模块在不影响中大目标检测的情况下, 能够充分结合浅层丰富的小目标空间细节信息以及深层高级语义信息, 得到更为有效的小目标特征, 提高对小对象的检测性能. 结合位置注意力模块和小目标增强模块的改进网络检测性能有显著的提高, APS提高了2.8%, APM提高了2.5%, APL提高了2%. 由此可见, 改进后的SE-YOLOv5s网络能够有效提高对不同尺度道路目标的检测精度.

| 表 3 消融实验结果(%) |

2.4 对比实验

为了检验改进网络在道路目标检测算法中的性能, 选择目前主流的道路目标检测网络进行比较, 在相同数据集上的实验结果如表4所示. 从表4可知, YOLOv3-tiny和YOLOv4-tiny网络检测速度很快, 但检测精度较低; YOLOv5m在YOLOv5s网络的基础上加宽加深, 其检测效果最好, 但网络计算量和参数量较大, 检测帧率相较于YOLOv5s下降明显, 无法满足自动驾驶的实时性需求; 改进网络与RetinaNet、SSD以及YOLOXs网络相比, 计算量和参数量更低, 并且平均精度有明显领先. 由此可见, 改进的空间特征增强网络在显著提高检测精度的同时检测帧率仍满足实时性要求, 综合性能优于目前其他主流检测算法.

| 表 4 网络对比结果 |

2.5 可视化实验

本文在BDD100K数据集中挑选出包含不同类别的道路图片输入YOLOv5s网络, 然后对网络检测层前一层的3个卷积特征图进行Grad-CAM[22]可视化. 可视化得到的热力图对比结果如图8所示, 其中左侧为YOLOv5s检测热力图, 右侧为添加LAM模块后检测热力图. 热力图中绿色目标框中的目标为预测目标, 像素对预测目标贡献的高低用冷暖颜色区分, 颜色较暖的红色表示对预测目标贡献度高, 颜色较冷的蓝色表示对预测目标贡献度低.

从热力图对比结果中可以看出YOLOv5s网络的注意力为分散, 并且对一些目标类别不会出现的地方也会产生响应. 比如在图8(a)–(c)中, 需要识别的对象为道路上的目标, 然而网络在其不会出现的天空区域产生了错误的响应; 而在图8(d)中, 需要预测的目标为交通标识, 它往往出现在图像顶部区域, 而图像底部地面区域却分散了网络的注意力. 这些错误位置的特征响应会降低特征的有效性和鲁棒性, 导致预测目标分类和定位准确度降低, 甚至出现违反常理的预测结果. 添加了LAM模块改进后的网络对预测目标的注意力更为集中, 显著减少了各类别对错误区域的特征响应. 这表明LAM模块能够很好地学习数据集中各类别的空间分布特征, 并根据目标类别抑制错误空间区域的响应, 帮助网络聚焦关键区域, 从而提高网络的分类和定位的准确度.

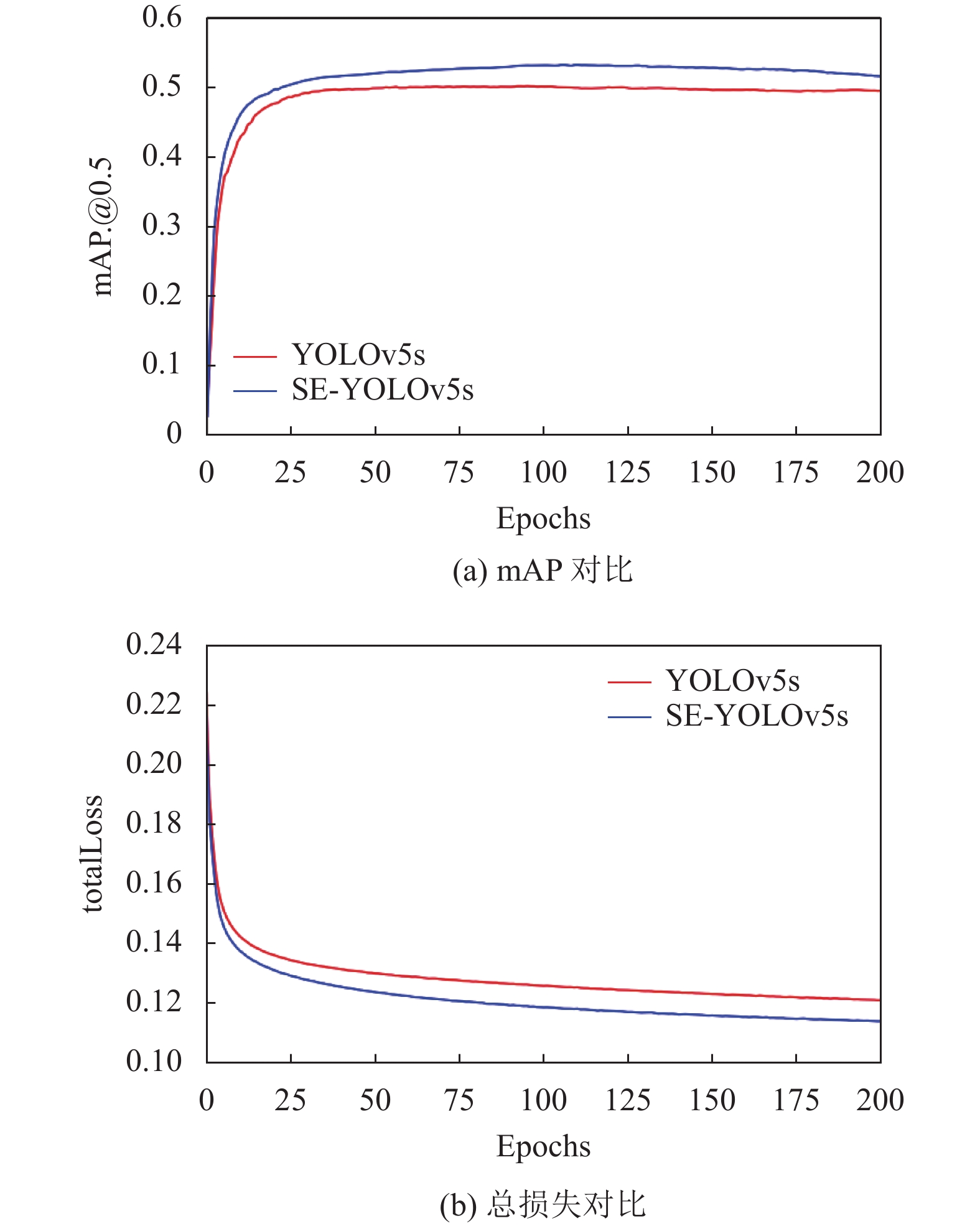

2.6 网络改进前后对比为了更好地分析改进模块对网络整体性能的影响, 改进前后网络的mAP@0.5以及总损失(totalLoss)对比图如图9所示, 其中总损失为分类损失、置信度损失、定位损失之和. 从图9(a), (b)中的曲线变化可以发现, 改进后的网络在训练125轮时收敛, mAP@0.5达到最大, 并且在训练过程中mAP@0.5整体高于改进前的YOLOv5s网络, 总体损失值也更低.

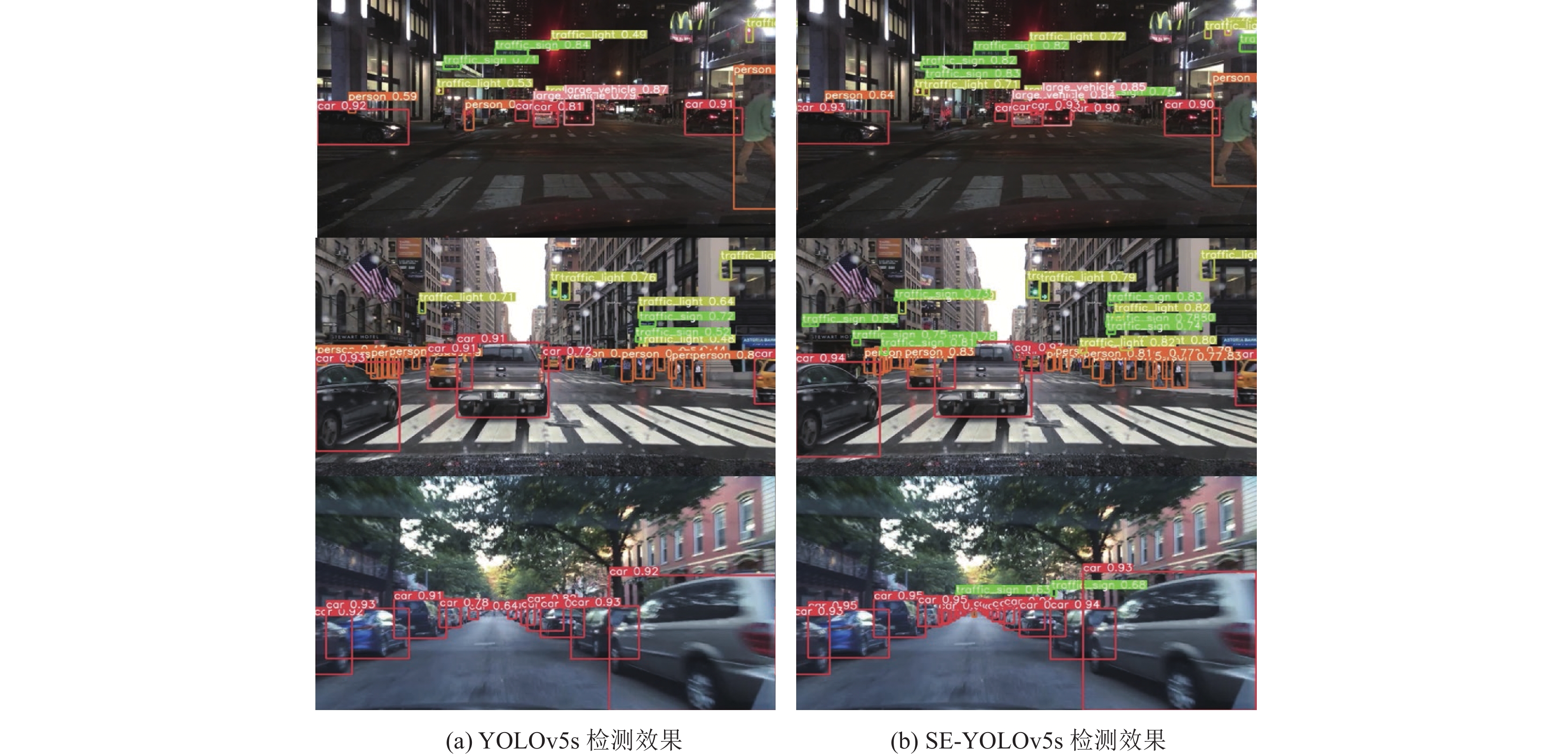

改进前后网络在测试集上的实际检测效果对比图如图10所示. 从图10可以看到, 改进后的SE-YOLOv5s网络有更好的检测效果, 可以检测出YOLOv5s漏检和错检的道路目标, 并且在不同光照以及复杂道路场景下鲁棒识别目标.

|

图 8 热力图对比 |

|

图 9 网络改进前后mAP和总损失对比 |

|

图 10 模型检测效果对比 |

3 结论与展望

本文在YOLOv5s网络的基础上, 通过分析自动驾驶场景下目标类别和尺寸的空间分布规律, 提出了一种空间特征增强网络SE-YOLOv5s, 成功提高了网络对不同尺度道路目标的检测性能. 为了增强网络的空间特征提取能力, 在颈部网络中添加位置注意力模块, 帮助网络感知道路目标在图像中的空间位置分布. 针对检测层中小目标细节信息缺失的问题, 添加小目标增强模块, 结合浅层和深层特征进行多尺度融合, 丰富检测层的小目标特征信息. 实验结果表明, 改进后的SE-YOLOv5s网络在没有过多增加计算量和参数量的情况下, 显著提高了对道路目标的检测精度, 优于改进前的YOLOv5s网络.

| [1] |

章军辉, 陈大鹏, 李庆. 自动驾驶技术研究现状及发展趋势. 科学技术与工程, 2020, 20(9): 3394-3403. DOI:10.3969/j.issn.1671-1815.2020.09.005 |

| [2] |

Dai XR. HybridNet: A fast vehicle detection system for autonomous driving. Signal Processing: Image Communication, 2019, 70: 79-88. DOI:10.1016/j.image.2018.09.002 |

| [3] |

Choi S, Kim JT, Choo J. Cars can’t fly up in the sky: Improv-ing urban-scene segmentation via height-driven attention networks. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 9373–9383.

|

| [4] |

Yu F, Chen HF, Wang X, et al. BDD100K: A diverse driving dataset for heterogeneous multitask learning. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 2636–2645.

|

| [5] |

Carranza-García M, Lara-Benítez P, García-Gutiérrez J, et al. Enhancing object detection for autonomous driving by optimizing anchor generation and addressing class imbalance. Neurocomputing, 2021, 449: 229-244. DOI:10.1016/j.neucom.2021.04.001 |

| [6] |

Girshick R. Fast R-CNN. Proceedings of the 2015 IEEE International Conference on Computer Vision. Santiago: IEEE, 2015. 1440–1448.

|

| [7] |

Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 779–788.

|

| [8] |

Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector. Proceedings of the 14th European Conference on Computer Vision. Amsterdam: Springer, 2016. 21–37.

|

| [9] |

Lin TY, Goyal P, Girshick R, et al. Focal loss for dense object detection. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 2980–2988.

|

| [10] |

Zou ZX, Chen KY, Shi ZW, et al. Object detection in 20 years: A survey. Proceedings of the IEEE, 2023, 111(3): 257-276. DOI:10.1109/JPROC.2023.3238524 |

| [11] |

Cai YF, Luan TY, Gao HB, et al. YOLOv4-5D: An effective and efficient object detector for autonomous driving. IEEE Transactions on Instrumentation and Measurement, 2021, 70: 4503613. |

| [12] |

Zhu XK, Lyu SC, Wang X, et al. TPH-YOLOv5: Improved YOLOv5 based on transformer prediction head for object detection on drone-captured scenarios. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision Workshops. Montreal: IEEE, 2021. 2778–2788.

|

| [13] |

Chen SB, Lin W. Embedded system real-time vehicle detection based on improved YOLO network. Proceedings of the 3rd IEEE Advanced Information Management, Communicates, Electronic and Automation control Conference. Chongqing: IEEE, 2019. 1400–1403.

|

| [14] |

刘革, 郑叶龙, 赵美蓉. 基于RetinaNet改进的车辆信息检测. 计算机应用, 2020, 40(3): 854-858. |

| [15] |

李彦辰, 张小俊, 张明路, 等. 基于改进Efficientdet的自动驾驶场景目标检测. 计算机工程与应用, 2022, 58(6): 183-191. DOI:10.3778/j.issn.1002-8331.2109-0190 |

| [16] |

Liu R, Lehman J, Molino P, et al. An intriguing failing of convolutional neural networks and the coordconv solution. Proceedings of the 32nd International Conference on Neural Information Processing Systems. Montréal: Curran Associates Inc., 2018. 9628–9639.

|

| [17] |

Dai YM, Wu YQ, Zhou F, et al. Asymmetric contextual modulation for infrared small target detection. Proceedings of the 2021 IEEE Winter Conference on Applications of Computer Vision. Waikoloa: IEEE, 2021. 949–958.

|

| [18] |

Cao Y, Xu JR, Lin S, et al. GCNet: Non-local networks meet squeeze-excitation networks and beyond. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision Workshop. Seoul: IEEE, 2019. 1971–1980.

|

| [19] |

Redmon J, Farhadi A. YOLOv3: An incremental improvement. arXiv:1804.02767, 2018.

|

| [20] |

Bochkovskiy A, Wang CY, Liao HYM. YOLOv4: Optimal speed and accuracy of object detection. arXiv:2004.10934, 2020.

|

| [21] |

Ge Z, Liu ST, Wang F, et al. YOLOX: Exceeding YOLO series in 2021. arXiv:2107.08430, 2021.

|

| [22] |

Selvaraju RR, Cogswell M, Das A, et al. Grad-CAM: Visual explanations from deep networks via gradient-based localization. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 618–626.

|

2023, Vol. 32

2023, Vol. 32