2. 江苏省智能气象探测机器人工程研究中心, 南京 210044;

3. 江苏省大数据分析技术重点实验室, 南京 210044;

4. 江苏省大气环境与装备技术协同创新中心, 南京 210044

2. Jiangsu Province Engineering Research Center of Intelligent Meteorological Exploration Robot, Nanjing 210044, China;

3. Jiangsu Key Laboratory of Big Data Analysis Technology, Nanjing 210044, China;

4. Jiangsu Collaborative Innovation Center of Atmospheric Environment and Equipment Technology, Nanjing 210044, China

深度图在许多计算机视觉任务中得到应用, 如解决增强现实中的虚实遮挡问题[1]和解决无人驾驶的距离判断问题. 虽然结构光或激光雷达传感器等专业硬件设备也可以提供逐像素的深度图, 但这些主动获得深度图的传感器不仅笨重、昂贵, 还会受到噪声和人为因素的影响. 此外, 还可以通过多视角立体视觉[2, 3]和三维重建[4]等方法获得深度信息. 使用双目摄像头并利用多视角立体视觉算法和三维重建算法获得深度图, 计算量相对较大, 且对于低纹理场景的深度估计效果不好[5]. 由于使用深度学习训练好的网络模型进行深度估计能够使用较少的计算量来获得更好的效果, 因此使用深度学习的方法是上述方法的一个不错的代替方案.

近些年来, 随着深度学习在计算机视觉任务中的广泛应用, 许多工作都将深度学习与深度估计相结合. 江俊君等[6]将基于深度学习的深度估计分为监督学习和自监督学习两种途径. 其中监督学习将图像与传感器收集到的真实深度图信息作为输入[7, 8], 并利用估计的深度与真实深度的不一致性作为损失函数来训练网络. 然而, 监督学习方法依赖于大型标记的RGB-D数据集, 获取这样的大型数据集成本较高. 为了避免使用大型标记数据集, 单目深度估计的自监督方法被提出. 文献[9-11]使用图像重建损失取代以地面真实深度构建的损失. 自监督学习的方法一般通过一个位姿网络(PoseNet)来辅助训练深度网络(DepthNet), 但在预测深度时只使用DepthNet. 然而, 在许多实际应用中不仅需要使用DepthNet还需要使用PoseNet , 如自动驾驶、增强现实以及将整个网络集成到移动设备上进行实时训练. 同时将DepthNet和PoseNet集成到嵌入式设备上, 对嵌入式设备的计算能力的要求非常高, 无法有效地在存储和内存空间有限的嵌入式设备上运行. 为了提供密集的逐像素预测, 现在主流的自监督单目深度估计网络还继续延用Dosovitskiy等[12]提出的结构, 对所有特征映射进行上采样, 来为高分辨率任务提供局部精细的信息. 如果只是使用主流的轻量化编码器, 来轻量化网络, 并和Dosovitskiy等[12]提出的结构进行结合使用, 会导致特征图的细节过多的丢失导致不好的预测结果.

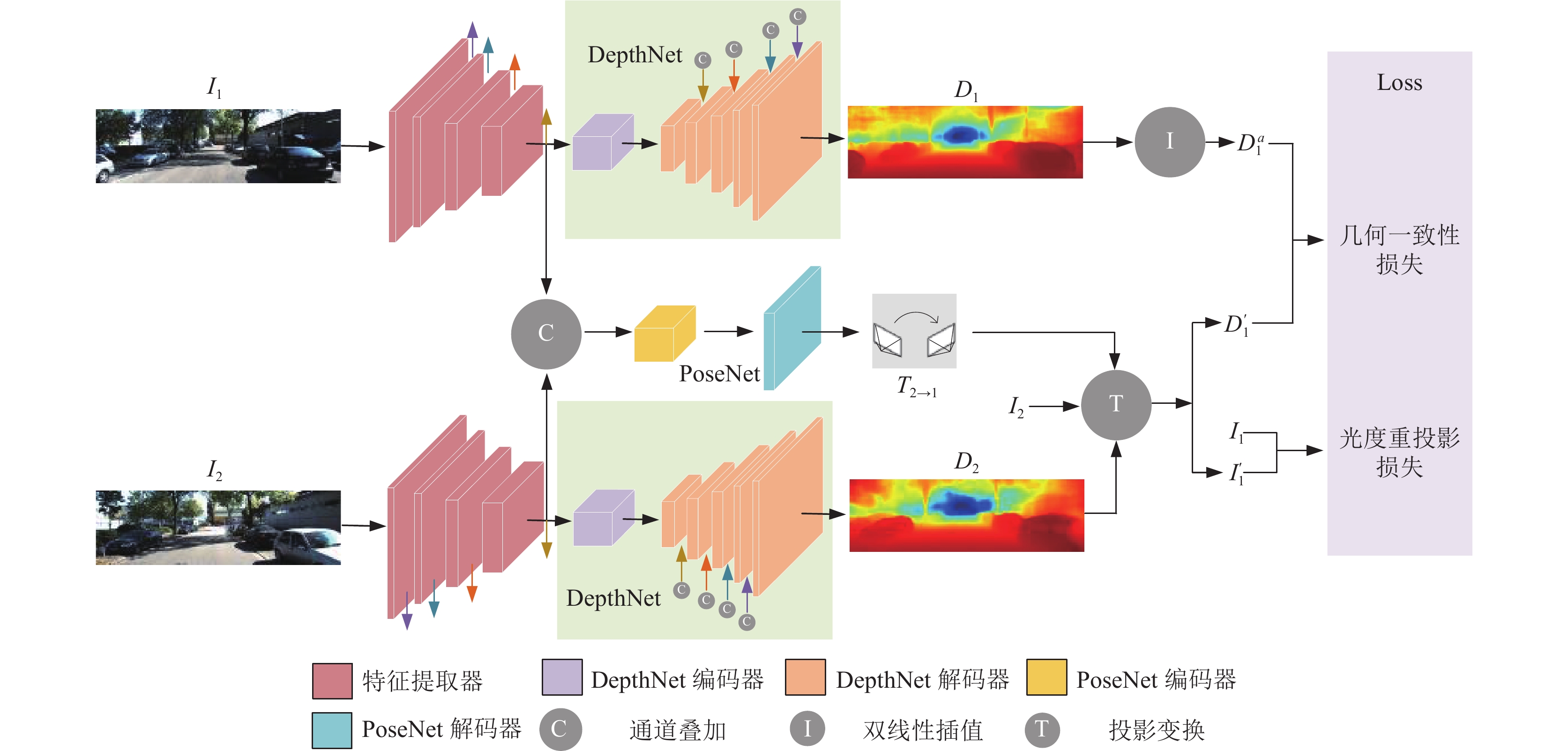

为了解决这个问题, 本文提出了一个有别于已有自监督单目深度估计模型的轻量化模型(LightDepth). LightDepth的重点在于轻量化PoseNet和DepthNet的编码器以及DepthNet的解码器, 同时减少细节的缺失. 与已有的将DepthNet和PoseNet分成两个独立网络的方法不同, 本文的DepthNet与PoseNet共用一个特征提取器(见图1). 此外, 本文通过使用带线性结构的深度可分离卷积构建DepthNet的编码器和解码器, 其不仅具有非常轻量级的参数, 还能在KITTI数据集[13]上取得不错的预测效果(见表1).

本文的主要工作总结如下.

(1)本文提出了一种新的轻量化的单目深度估计框架, 该框架中的DepthNet和PoseNet共用一个特征提取器.

(2)本文设计了一个高效且轻量的DepthNet, 其能保持在一个非常轻的尺寸, 同时用于从视频序列进行实时高性能无监督单目深度预测.

|

图 1 自监督单目深度估计网络结构框架 |

| 表 1 KITTI数据集上的测试结果 |

1 相关工作

本节回顾了以RGB图像作为输入, 并在测试时估计每个像素的深度值作为输出的相关工作. 根据训练时是否使用真实深度, 可以将这些工作分为监督深度估计和自监督深度估计. 此外, 还对自监督单目深度估计任务的轻量化的工作进行了总结.

1.1 监督深度估计单目深度估计的一种方法是监督学习. Eigen等[7]最早使用卷积神经网络来解决深度估计问题. 对于输入的RGB图像中的每一个像素点, 模型都需要预测出深度图像对应像素的深度值, 预测的深度值可以作为监督信号来训练网络. Laina等[23]首次将残差网络应用到深度估计领域. 该模型由一个编码器和一个解码器组成, 在编码端使用残差网络获得更强的特征提取能力. Liu等[24]将连续条件随机场的知识与卷积神经网络相结合, 进行单幅图像的深度预测. Li等[25]提出先用深度神经网络对超像素尺度的深度进行回归, 然后用条件随机场进行处理, 通过结合超像素和像素尺度的深度获得更好的预测结果. 由于深度值具有有序的特点, Fu等[8]将深度分类问题归结为一个有序回归问题, 提出了使用间隔递增离散化(SID)策略来代替常规的均匀分段策略(UD), 提高了估计精度. 受该工作的启发, Bhat等[26]将分段策略进一步泛化, 使用网络训练出分段区间, 进一步提高了深度估计的精度. 监督单目深度估计能获得较高的估计结果, 但其需要地面真实深度作为监督信息来训练网络. 然而, 大量收集训练集所需的深度图是昂贵的.

1.2 自监督深度估计单目深度估计的另一种是自监督学习. 其方法大致可以分为两类, 第1类使用立体图像对进行深度估计, 第2类使用单目相机获得的视频序列进行深度估计. Garg等[9]最早提出使用无监督学习的方法来获得深度图, 其在训练阶段利用立体图像对. Godard等[27]的工作将深度估计框架化为一个视图合成问题, 并通过最小化右视图重建误差和从左视图生成右视图之间的重建误差重建目标[28], 同时还引入了可微的插值函数来克服之前模型在训练阶段可能陷入局部最优的问题. Poggi等[29]提出了使用3张图片之间的几何约束来训练模型, 这种方法有效地减少了遮挡物体对训练结果的影响.

相比使用立体图像对进行深度估计的网络, 在训练阶段使用单目视频序列的方法增加了一个姿态网络来估计帧间的相对位姿[10]. 尽管这种方法存在尺度模糊和动态物体对训练结果的影响[18]等限制, 但是单目自监督深度估计能够从原始视频中学习, 不需要真实的深度信息作为约束, 能够更容易的获得数据集, 更易于拓展. Godard等[18]以像素为单位进行最小化重投影误差, 并提出以自动掩膜损失来减小动态物体对训练结果的影响. Shu等[21]提出了特征度量损失来解决无纹理或低分辨率像素造成的局部最小问题. 马成齐等[30]提出一种自动屏蔽损失来损失函数来处理物体运动造成的边界伪影, 使预测效果细节更加饱满. Watson等[22]认为在测试时可以使用视频帧形式的序列信息, 并提出了一种新的自监督深度估计模型, 其在测试时利用可用的多帧深度进行估计, 以达到比之前方法更好的效果. 这启发了相关的工作, Guizilini等[20]提出一种新的结构用于成本体积生成, 并通过交叉注意力机制和自注意力机制来完善多视图特征匹配. 他们的网络获得了较好的深度估计结果, 在很大程度上超过了其他自监督的方法, 甚至超过了监督的单帧架构. 但使用成本体积量的方式会极大地消耗计算量, 所有本文在网络中并未使用成本体积量的形式.

1.3 轻量化的自监督单目深度估计虽然基于视频序列的自监督单目深度估计的数据容易获得, 也易于拓展, 但其需要更复杂、更深的网络架构. 由于深度估计在自动驾驶、增强现实等任务下对模型有推理速度、规模量级的限制要求, 需要使复杂的深度估计网络轻量化, 以减少参数量和计算量, 同时其估计的深度精度应保持在一个合理的范围内. 对于轻量化的自监督单目深度估计, Poggi等[31]利用立体图像对进行训练, 使用从单个输入图像中提取的特征金字塔快速地推断出精确的深度图, 其减少了参数量, 并在CPU上获得了实时性. Liu等[32]利用视频帧进行训练, 提出了使用循环神经网络(RNN)的一个单元循环提取特征的方法来减小模型参数量. 该网络只轻量化了DepthNet, 并没有轻量化PoseNet. 由于在增强现实等应用中, PoseNet估计的两帧之间的位姿也可以被利用. 还有些移动端需要实时的进行训练, 也需要将PoseNet和DpehtNet一起集成到设备上. 本文从这个角度出发, 提出了一种轻量化网络LightDepth, 其DepthNet和PoseNet总体参数量为35.33 MB, 并且在轻量化网络的同时还能在KITTI数据集上取得不错的效果, 其恢复深度图的平均绝对误差也保持在0.129.

2 本文方法 2.1 LightDepth的整体流程与之前的工作[21, 30]一样, LightDepth也是以最小化光度重投影误差进行建模. 该模型主要是将目标帧

本文的目的是在轻量化网络的同时, 取得不丢失过多细节信息的预测结果. 为了让DepthNet解码器获得精细的局部信息, 网络保留了Dosovitskiy等[12]提出的结构, 其对所有特征映射进行上采样, 同时为了减少参数量, 将PoseNet和DepthNet共用一个特征提取器, 见图1. ResNet-18[33]的最后一层由4个通道数为512的3×3卷积和一个平均池化组成, 其参数量为34 MB, 所以本文的特征提取器只使用了ResNet-18的前3层, 其输出的是通道数为256的张量, 参数量只有10.4 MB. 这不仅保证了提取出的特征具有代表性, 还能保证网络的轻量性.

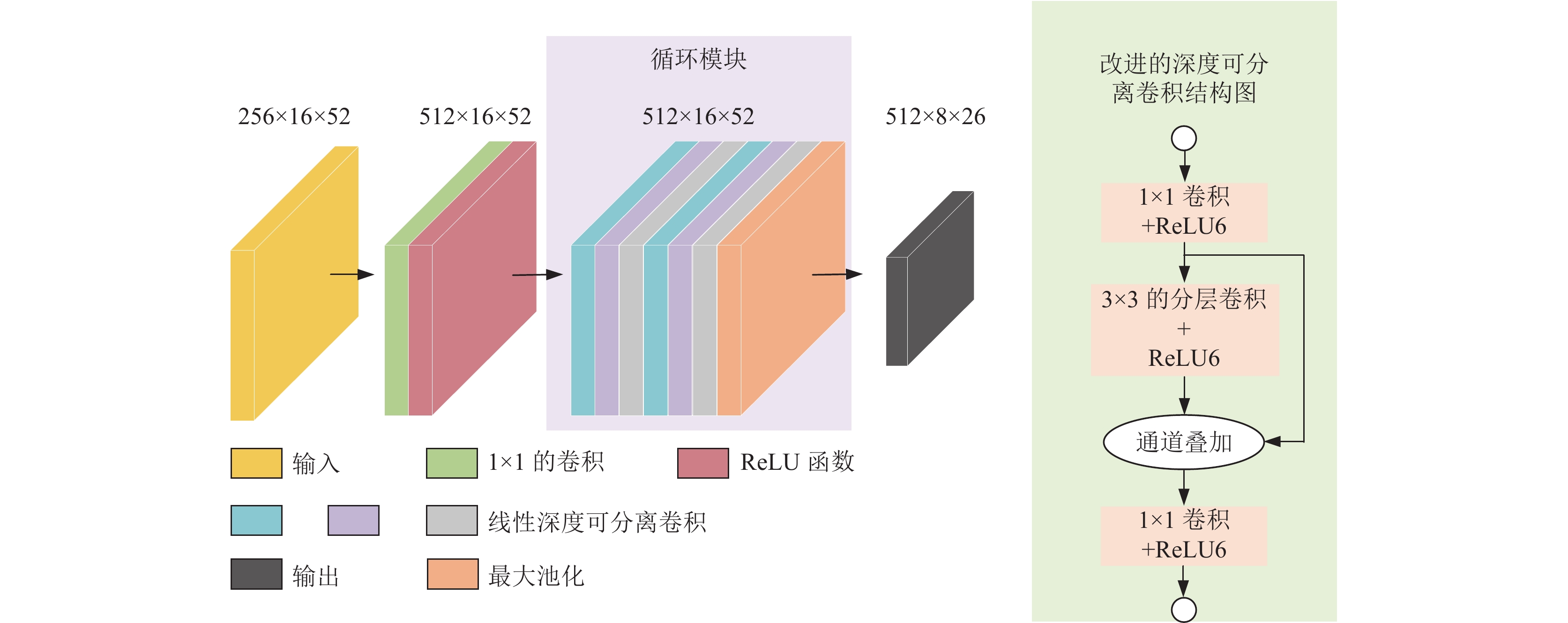

2.2 编码器如图2所示, 本文的DepthNet编码器主要由一个1×1的卷积层和一个循环模块组成. 本文使用1×1的卷积层对特征编码器提取出来的特征进行升维, 然后通过ReLU激活, 将该层的输出通道数设置为512. 本文提出的循环模块主要由3个带有线性结构的深度可分离卷积组成, 其3个深度可分离卷积交替放置. 每个模块循环使用两次. 为了实现复用性, 每个模块的输入通道和输出通道设计为相同都是512. 图2中颜色相同的线性深度可分离卷积代表同一个卷积, 其使用同一组参数. 由于深度可分离卷积[34]提取的图片特征不充分, 在本文任务中会导致部分物体轮廓丢失的情况. 从Han等[35]中获得启发, 通过更廉价的线性操作来减少特征图的冗余, 获得更多信息的特征图. 本文的线性深度可分离卷积结构如图2, 其主要由两个1×1的卷积层和一个3×3的分层卷积组成. 为了让3×3的可深度分离卷积和1×1的卷积结果的特征联系更加紧密, 本文通过将两个卷积出来的结果在通道数上叠加, 再通过一个1×1的卷积来学习跨通道信息.

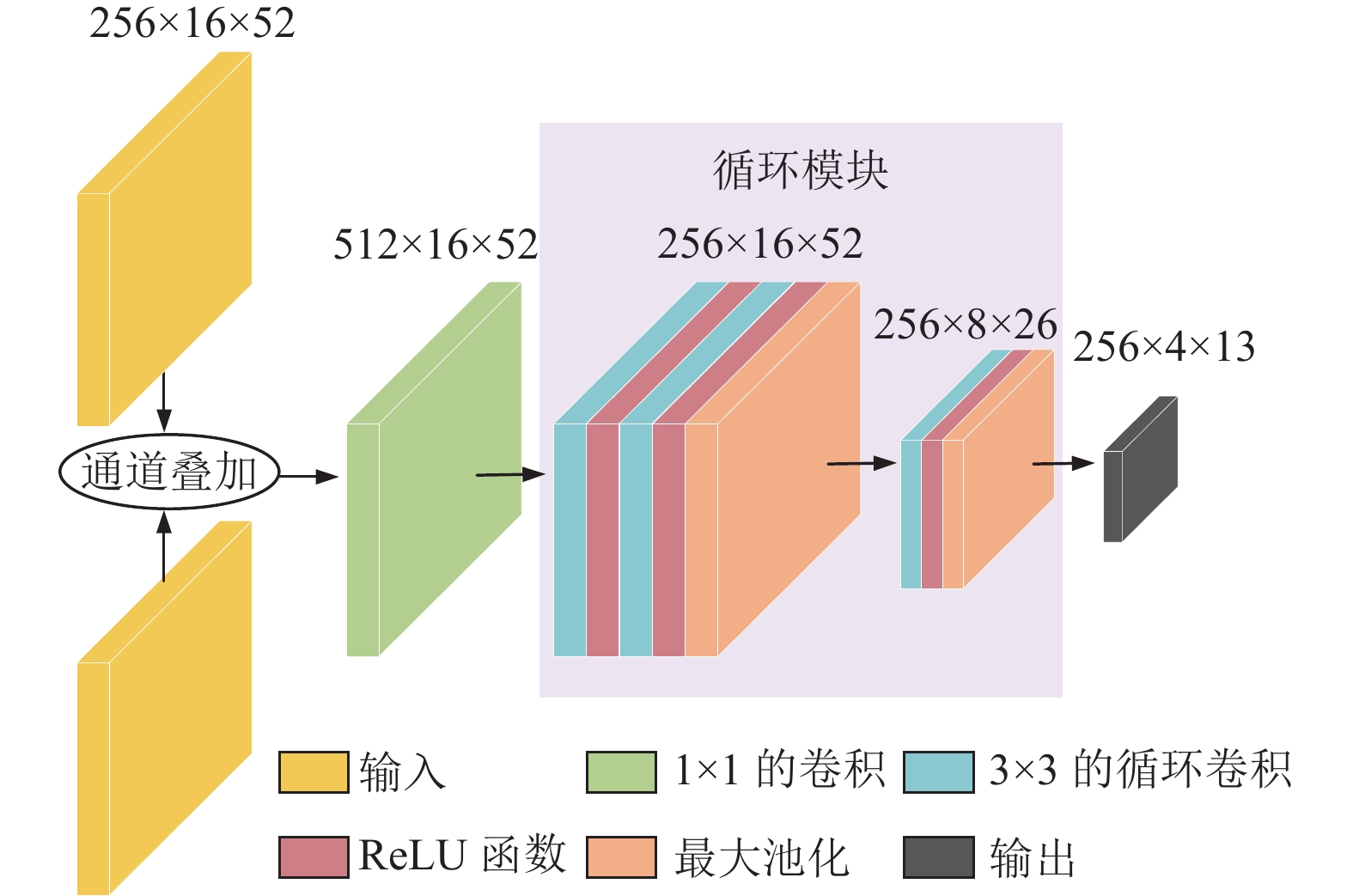

如图3所示, PoseNet的编码器由一个循环模块组成. 本文将从特征提取器获得的两张图片的特征在通道上进行叠加得到通道数为512的张量, 并将其作为PoseNet的输入. 为了将两张图片特征的信息更好的聚合起来, 循环模块的第1层使用的是一个标准的1×1卷积, 输入通道数为512, 输出通道数为256, stride为1. 从RNN循环网络中得到启发, 本文提出的循环模块由1个3×3的卷积组成. 该3×3的卷积的输入和输出通道数设计为相同为256. 首先, 将输入张量送入到1×1的卷积层中, 获得大小为512×16×52的张量. 然后, 将获得的张量送入到3×3的循环卷积层中, 在反复经过3次同一个3×3的循环卷积层后, 结束循环模块. 为了减少计算量, 在循环模块的最后两层卷积模块的后面使用最大池化层来降低空间维度. 最后, 循环模块输出的张量大小为256×4×13.

|

图 2 DepthNet编码器 |

|

图 3 PoseNet编码器 |

2.3 DepthNet解码器

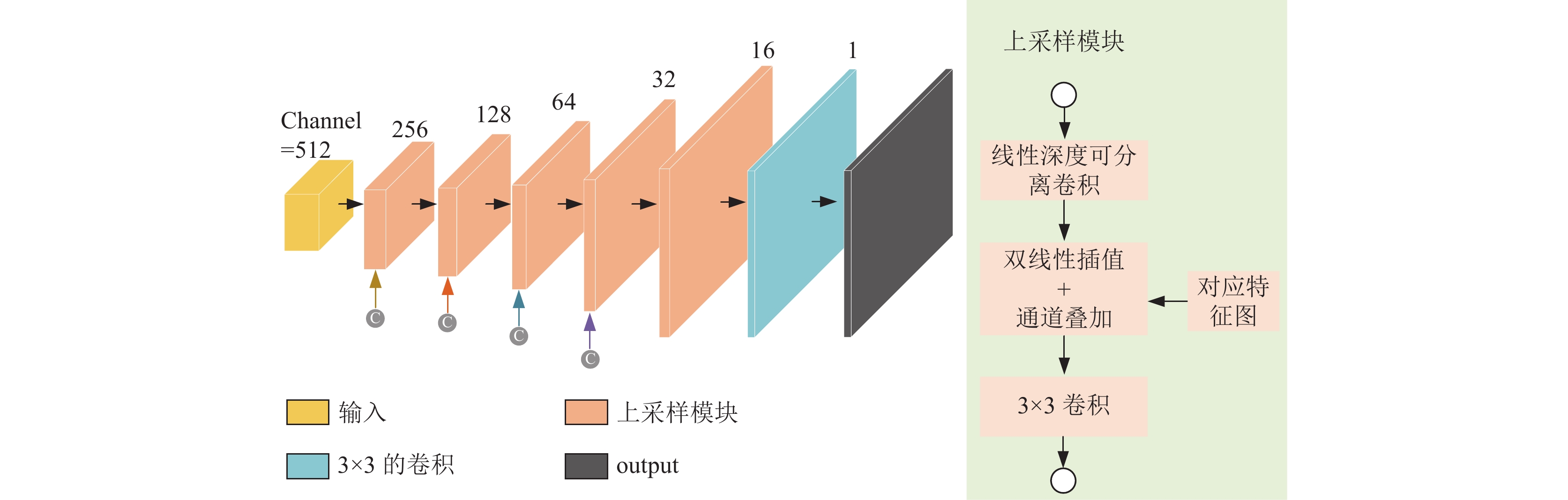

为了满足高精度和实时性的要求, 本文设计了一种新型高效的上采样模块对编码器输出的特征图进行上采样和聚合, 如图4. 本文将从DepthNet编码器获得的特征图直接作为解码器的输入. 与解码器disponet[10]全使用3×3的卷积不同, 本文的解码器使用线性深度可分离卷积与标准的3×3卷积交替使用的方法. 交替使用线性深度可分离卷积与标准的3×3的卷积可以在轻量化网络的同时, 还能指导网络不丢失训练目标, 保证了不错的预测效果. 为了提高预测精度, 在经过改进的深度可分离卷积后, 采用双线性插值方法将多尺度的特征图插值到相同的空间分辨率, 再进行通道拼接. 本文解码器在输出层的激活是Sigmoid, 其他地方的激活函数使用的是ELU函数. 本文将Sigmoid输出x转换为深度,

在本节中, 将介绍训练LightDepth的损失函数. 本文的损失函数主要由3部分构成, 其分别为重投影光度损失

| L=αMLp+βLg+δLs | (5) |

其中,

| Lp=∑p∈I(λ‖I′1(p)−I1(p)‖1+γ1−SSIM(I′1(p),I1(p))2) | (6) |

其中,

为了减小动态物体对恢复深度图效果的影响, 本文引入了Bian等[19]提出的动态掩膜

| Lg=∑p∈I|Da1(p)−D′1(p)|Da1(p)+D′1(p) | (7) |

| M=1−|Da1(p)−D′1(p)|Da1(p)+D′1(p) | (8) |

其中,

式(1)中的

|

图 4 DepthNet解码器 |

在低纹理场景下, 光度损失的效果不佳, 本文采用了平滑损失

| Ls=∑p(e−∇I1(p).∇D1(p))2 | (9) |

其中,

本文在KITTI原始数据集[13]上使用文献[7]的数据集分割方式进行模型的训练和测试. 其中697张图片作为测试集, 39 810张图片作为训练集, 4 424张图片作为验证集. 其中每幅图片的分辨率约为1226×370像素. 为了提高效率, 并保持原始图片的长宽比, 将Light-Depth输入图片大小设置为832×256. 为了增强数据的随机性, 在训练阶段本文通过随机裁剪缩放和水平翻转进行数据增强. LightDepth使用的是PyTorch Library[37]框架, 在单张NVIDIA RTX 3090上进行训练, 系统为Ubuntu 16.04.6, 训练时间为16 h. 3张连续帧被作为Light-Depth的输入, 其中将第2帧作为参考帧, 计算参考帧与其他两帧的损失函数. 为了最大程度上利用数据, 将参考帧与其他两帧互换角色, 再次计算损失. 本文使用Adam[38]优化器, 学习率设置为0.000 07, batch_size设置为8, 总计训练200轮. 在每一轮中随机抽取1 000张图片进行训练. 在对恢复深度图的效果进行评价时, 本文使用的是和Zhou等[10]一样的指标. 使用平均绝对误差(AbsRel)、均方根误差(RMSE)、均方根对数误差(logRMSE)和在阈值(

| {AbsRel=1NN∑i=1|Di−D∗i|D∗iSqRel=1NN∑i=1|Di−D∗i|2D∗iRMSE=√1NN∑i=1|Di−D∗i|2logRMSE=√1NN∑i=1|lgDi−lgD∗i|2δ=max(DiD∗i,D∗iDi)<T |

其中,

表1显示了在KITTI数据集[13]上的评估结果, 其第1列列出了每个网络总参数的大小. LightDepth在总体参数量上获得了最小的参数(35.33 MB). 在预测深度图精度方面, 本文的方法恢复深度图的AbsRel获得了0.129. 值得注意的是Guizilini等[39]使用了语义标签学习, Zhao等[40]使用了光流学习来提高精确度. 而该算法使用不附加信息的单目方法就获得了不错的预测精度, 并轻量化了网络, 这证明了共用一个编码器方法的有效性和本文使用的轻量化的DepthNet的合理性. 与ManyDepth[22]相比, 虽然LightDepth的AbsRel下降0.036, 但是ManyDepth的参数量是LightDepth的5.5倍.

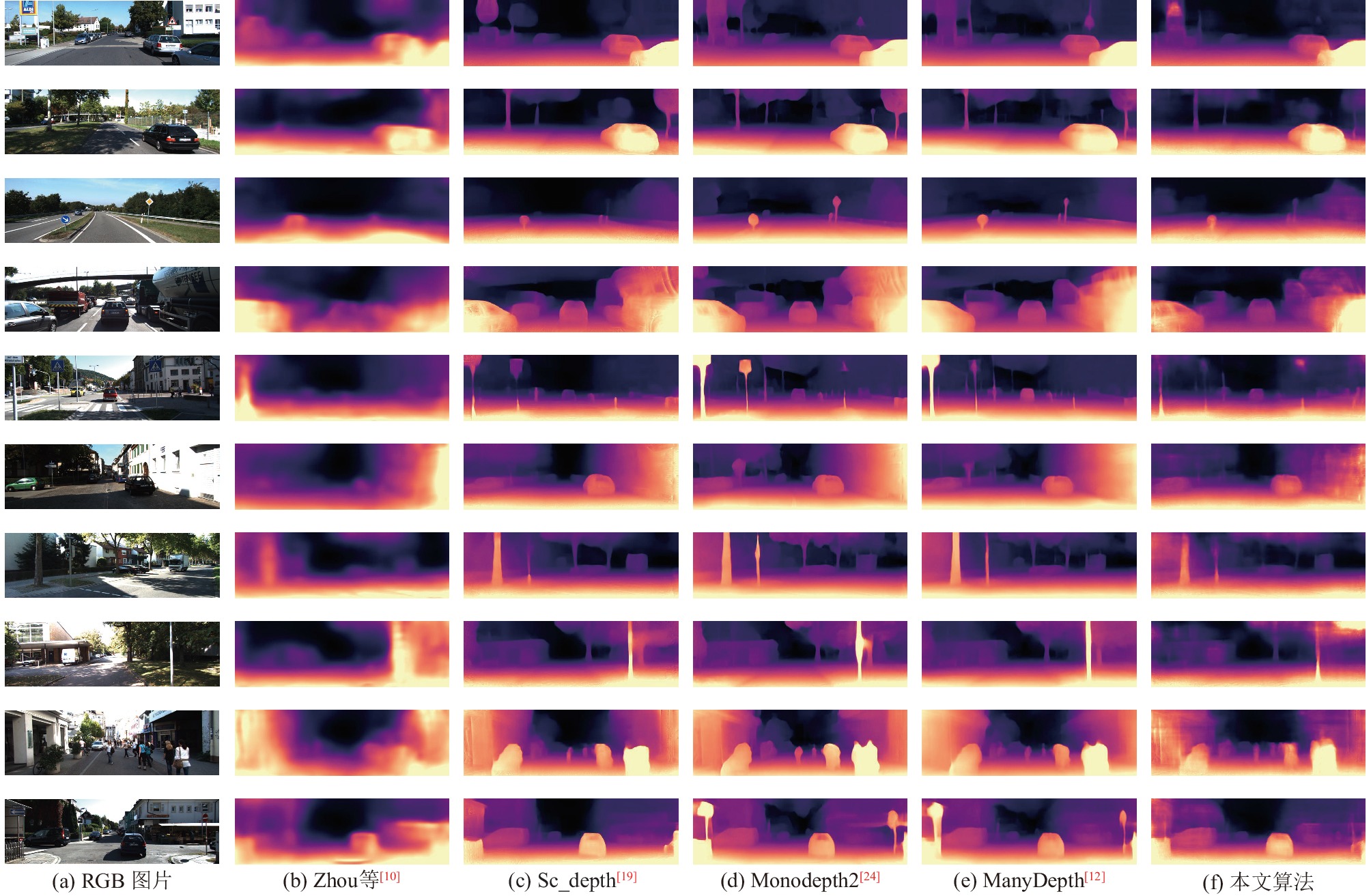

图5中展示了10张RBG图片和各个网络估计出来的视差图. 虽然LightDepth在勾勒物体细节方面要弱于最近的工作, 但其可以清晰地画出物体轮廓, 极少的存在物体丢失的现象. 这对改善在自动驾驶和无人机安全等应用中具有重要意义.

|

图 5 KITTI数据集上的可视化结果 |

3.3 消融实验

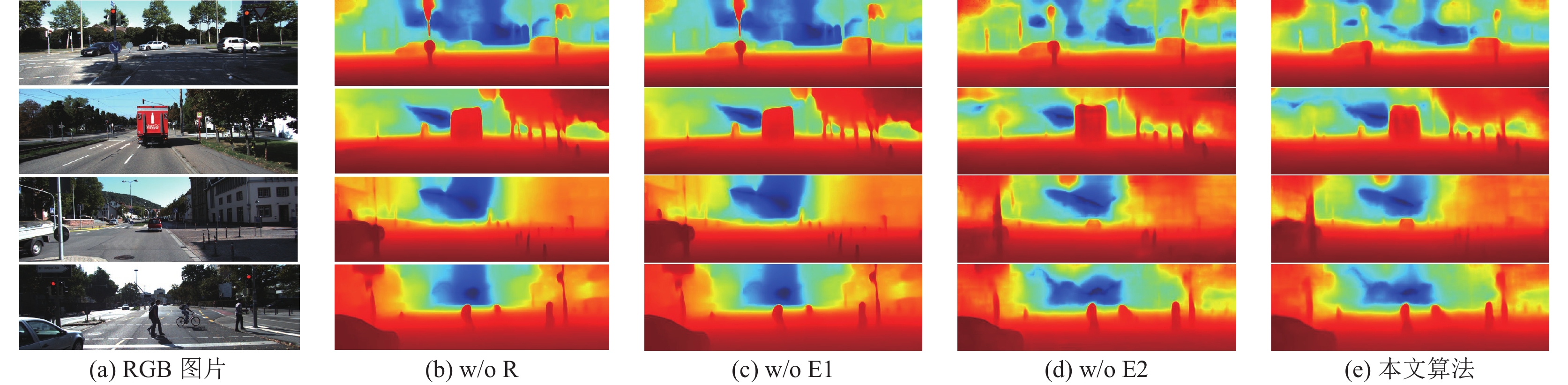

为了更好地展示共用特征提取器和轻量化的DepthNet在无监督单目深度估计中的整体性能, 本文进行了消融实验. 结果见表2. “w/o R”方法表示DepthNet和PoseNet没有共用一个特征编码器. 其使用两个独立ResNet-18网络进行作为PoseNet和DepthNet网络的编码器, 再通过各自的解码器进行深度估计. “w/o E1”方法表示两个网络共用特征提取器, 并对PoseNet的编码器进行了轻量化的处理, 而DepthNet依然使用的是ResNet-18的最后一层作为编码器. “w/o E2”表示两个网络共用特征提取器, 并对两个网络的编码器进行了轻量化处理. “估计图片的时间”表示估计测试集中697张图片所需要的时间.

通过对表2的方法“w/o R”和方法“w/o E1”进行对比, 发现共用特征提取器的方法, 能够大量的减小网络的参数量, 但是其对预测结果的影响也比较大. 通过方法“w/o E1”和方法“w/o E2”的对比发现, 使用改进的深度可分离卷积作为编码器, 其能够轻量化编码器, 并且能实现深度网络的功能. 通过方法“w/o E2”和本文方法对比发现, 虽然本文的线性深度可分离卷积在通道数小的时候会增加参数量, 但是其可以将更多的性能放在小通道上, 用以获得更好的效果, 并且其在小通道数增加的参数量相比大通道减少的参数量可以忽略不计. 因此, 本文方法可以帮助嵌入式设备节省存储和内存空间. 图6给出消融实验估计的深度图.

| 表 2 消融实验结果 |

|

图 6 消融实验可视化结果 |

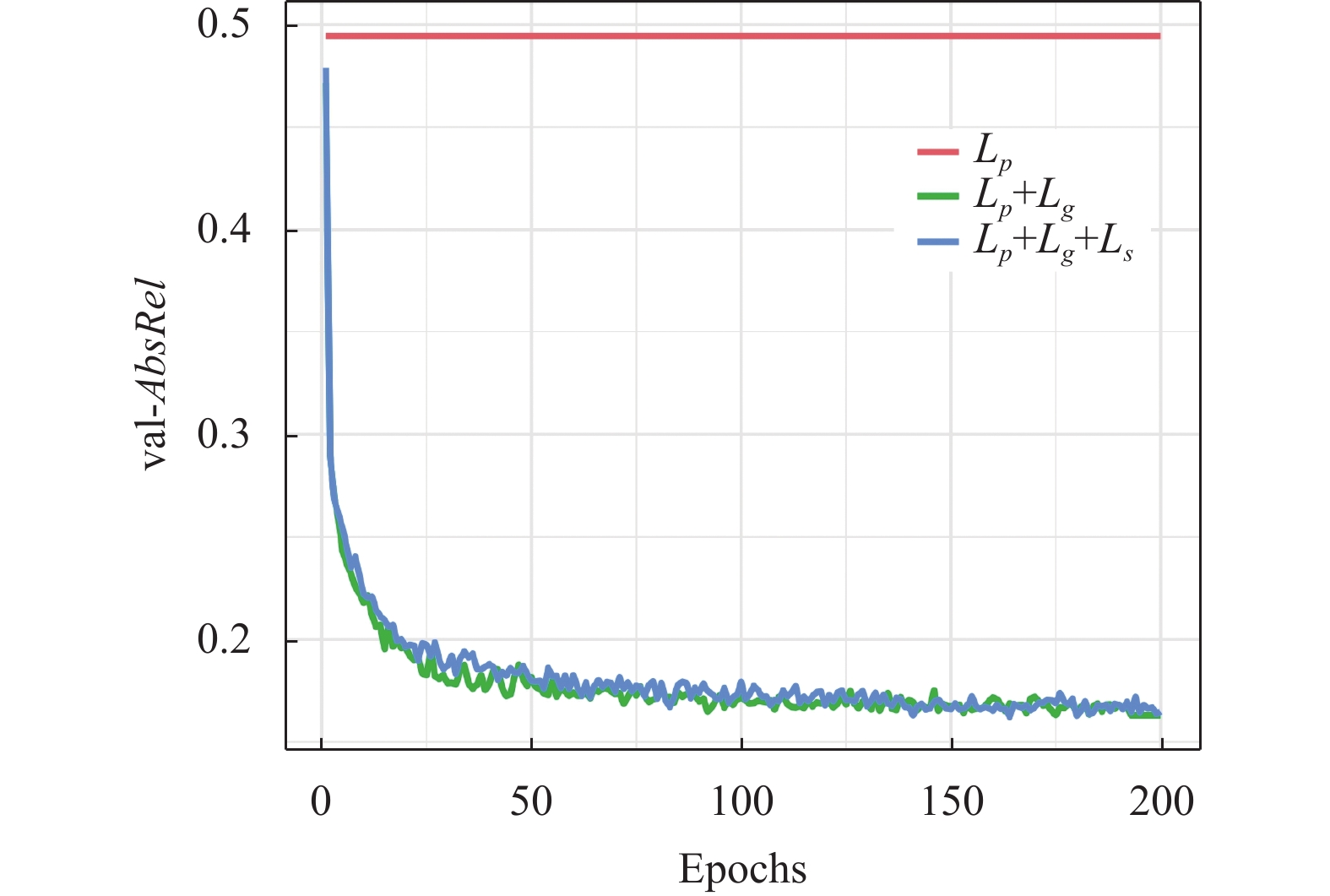

为了验证本文使用3个损失函数对本文网络的影响, 本文同样对损失函数进行消融实验. 表3为使用不同损失函数时网络训练结果, 其中val-AbsRel表示在验证集上的平均绝对误差, tes-AbsRel表示在测试集上的平均绝对误差. 由于轻量化的原因, 当网络只使用损失函数

| 表 3 不同损失函数下的误差 |

|

图 7 不同损失函数下的验证误差曲线 |

4 结论与展望

本文提出了一种轻量化的自监督单目深度估计网络LightDepth, 其DepthNet和PoseNet共用一个特征提取器. 该轻量化结构大大降低了PoseNet的网络参数量. 此外, 还设计了一个高效的DepthNet, 其使用线性深度可分离卷积大大的轻量化了网络参数量. 通过在KITTI数据集上进行了大量实验, 证明本文提出的轻量化网络具有有效性和高效率. 该方法具有轻量化和估计精度较好的优点, 在增强现实和自动驾驶等应用上具有广泛的应用前景.

| [1] |

刘万奎, 刘越. 用于增强现实的光照估计研究综述. 计算机辅助设计与图形学学报, 2016, 28(2): 197-207. DOI:10.3969/j.issn.1003-9775.2016.02.001 |

| [2] |

Hou YL, Peng JW, Hu ZH, et al. Planarity constrained multi-view depth map reconstruction for urban scenes. ISPRS Journal of Photogrammetry and Remote Sensing, 2018, 139: 133-145. DOI:10.1016/j.isprsjprs.2018.03.003 |

| [3] |

Mostegel C, Fraundorfer F, Bischof H. Prioritized multi-view stereo depth map generation using confidence prediction. ISPRS Journal of Photogrammetry and Remote Sensing, 2018, 143: 167-180. DOI:10.1016/j.isprsjprs.2018.03.022 |

| [4] |

Zeller N, Quint F, Stilla U. Depth estimation and camera calibration of a focused plenoptic camera for visual odometry. ISPRS Journal of Photogrammetry and Remote Sensing, 2016, 118: 83-100. DOI:10.1016/j.isprsjprs.2016.04.010 |

| [5] |

公冶佳楠, 李轲. 基于光场图像序列的自适应权值块匹配深度估计算法. 计算机系统应用, 2020, 29(4): 195-201. DOI:10.15888/j.cnki.csa.007387 |

| [6] |

江俊君, 李震宇, 刘贤明. 基于深度学习的单目深度估计方法综述. 计算机学报, 2022, 45(6): 1276-1307. DOI:10.11897/SP.J.1016.2022.01276 |

| [7] |

Eigen D, Puhrsch C, Fergus R. Depth map prediction from a single image using a multi-scale deep network. Proceedings of the 27th International Conference on Neural Information Processing Systems. Montreal: ACM, 2014. 2366–2374.

|

| [8] |

Fu H, Gong MM, Wang CH, et al. Deep ordinal regression network for monocular depth estimation. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 2002–2011.

|

| [9] |

Garg R, B. G. VK, Carneiro G, et al. Unsupervised CNN for single view depth estimation: Geometry to the rescue. Proceedings of the 14th European Conference on Computer Vision. Amsterdam: Springer, 2016. 740–756.

|

| [10] |

Zhou TH, Brown M, Snavely N, et al. Unsupervised learning of depth and ego-motion from video. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 6612–6619.

|

| [11] |

Zhan HY, Garg R, Weerasekera CS, et al. Unsupervised learning of monocular depth estimation and visual odometry with deep feature reconstruction. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 340–349.

|

| [12] |

Dosovitskiy A, Fischer P, Ilg E, et al. FlowNet: Learning optical flow with convolutional networks. Proceedings of the 2015 IEEE International Conference on Computer Vision (ICCV). Santiago: IEEE, 2015. 2758–2766.

|

| [13] |

Geiger A, Lenz P, Stiller C, et al. Vision meets robotics: The KITTI dataset. The International Journal of Robotics Research, 2013, 32(11): 1231-1237. DOI:10.1177/0278364913491297 |

| [14] |

Mahjourian R, Wicke M, Angelova A. Unsupervised learning of depth and ego-motion from monocular video using 3D geometric constraints. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 5667–5675.

|

| [15] |

Luo CX, Yang ZH, Wang P, et al. Every pixel counts++: Joint learning of geometry and motion with 3D holistic understanding. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020, 42(10): 2624-2641. DOI:10.1109/TPAMI.2019.2930258 |

| [16] |

Ranjan A, Jampani V, Balles L, et al. Competitive collaboration: Joint unsupervised learning of depth, camera motion, optical flow and motion segmentation. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 12232–12241.

|

| [17] |

Gordon A, Li HH, Jonschkowski R, et al. Depth from videos in the wild: Unsupervised monocular depth learning from unknown cameras. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 8976–8985.

|

| [18] |

Godard C, Mac Aodha O, Firman M, et al. Digging into self-supervised monocular depth estimation. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 3827–3837.

|

| [19] |

Bian JW, Zhan HY, Wang NY, et al. Unsupervised scale-consistent depth learning from video. International Journal of Computer Vision, 2021, 129(9): 2548-2564. DOI:10.1007/s11263-021-01484-6 |

| [20] |

Guizilini V, Ambruș R, Chen D, et al. Multi-frame self-supervised depth with transformers. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022. 160–170.

|

| [21] |

Shu C, Yu K, Duan Z X, et al. Feature-metric loss for self-supervised learning of depth and egomotion. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 572–588.

|

| [22] |

Watson J, Mac Aodha O, Prisacariu V, et al. The temporal opportunist: Self-supervised multi-frame monocular depth. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 1164–1174.

|

| [23] |

Laina I, Rupprecht C, Belagiannis V, et al. Deeper depth prediction with fully convolutional residual networks. Proceedings of the 4th International Conference on 3D Vision (3DV). Stanford: IEEE, 2016. 239–248.

|

| [24] |

Liu FY, Shen CH, Lin GS. Deep convolutional neural fields for depth estimation from a single image. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 5162–5170.

|

| [25] |

Li B, Shen CH, Dai YC, et al. Depth and surface normal estimation from monocular images using regression on deep features and hierarchical CRFs. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015. 1119–1127.

|

| [26] |

Bhat SF, Alhashim I, Wonka P. AdaBins: Depth estimation using adaptive bins. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 4008–4017.

|

| [27] |

Godard C, Mac Aodha O, Brostow GJ. Unsupervised monocular depth estimation with left-right consistency. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 6602–6611.

|

| [28] |

Wang Z, Bovik AC, Sheikh HR, et al. Image quality assessment: From error visibility to structural similarity. IEEE Transactions on Image Processing, 2004, 13(4): 600-612. DOI:10.1109/TIP.2003.819861 |

| [29] |

Poggi M, Tosi F, Mattoccia S. Learning monocular depth estimation with unsupervised trinocular assumptions. Proceedings of the 2018 International Conference on 3D vision (3DV). Verona: IEEE, 2018. 324–333.

|

| [30] |

马成齐, 李学华, 张兰杰, 等. 抗遮挡的单目深度估计算法. 计算机工程与应用, 2021, 57(2): 217-222. DOI:10.3778/j.issn.1002-8331.1911-0346 |

| [31] |

Poggi M, Aleotti F, Tosi F, et al. Towards real-time unsupervised monocular depth estimation on CPU. Proceedings of the 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Madrid: IEEE, 2018. 5848–5854.

|

| [32] |

Liu J, Li Q, Cao R, et al. MiniNet: An extremely lightweight convolutional neural network for real-time unsupervised monocular depth estimation. ISPRS Journal of Photogrammetry and Remote Sensing, 2020, 166: 255-267. DOI:10.1016/j.isprsjprs.2020.06.004 |

| [33] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: 2016. 770–778.

|

| [34] |

Howard AG, Zhu ML, Chen B, et al. MobileNets: Efficient convolutional neural networks for mobile vision applications. arXiv:1704.04861, 2017.

|

| [35] |

Han K, Wang YH, Tian Q, et al. Ghostnet: More features from cheap operations. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 1577–1586.

|

| [36] |

Pilzer A, Lathuilière S, Sebe N, et al. Refine and distill: Exploiting cycle-inconsistency and knowledge distillation for unsupervised monocular depth estimation. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 9760–9769.

|

| [37] |

Paszke A, Gross S, Chintala S, et al. Automatic differentiation in PyTorch. Proceedings of the 31st Conference on Neural Information Processing Systems. Long Beach: NIPS, 2017.

|

| [38] |

Kingma DP, Ba LJ. Adam: A method for stochastic optimization. Proceedings of the 2015 International Conference on Learning Representations. San Diego: ICLR, 2015.

|

| [39] |

Guizilini V, Hou R, Li J, et al. Semantically-guided representation learning for self-supervised monocular depth. Proceedings of the 8th International Conference on Learning Representations. Addis Ababa: ICLR, 2020.

|

| [40] |

Zhao W, Liu SH, Shu YZ, et al. Towards better generalization: Joint depth-pose learning without PoseNet. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 9148–9158.

|

2023, Vol. 32

2023, Vol. 32