目前在瓷砖表面缺陷检测环节中, 主要通过质检人员利用人眼主观地去判断瓷砖表面是否存在瑕疵. 质检人员长时间在强光高噪音的环境下工作, 存在检测效率低、人力成本高、检测质量不稳定等问题. 相较于人工检测, 使用机器来实现瓷砖表面缺陷的自动检测也存在很多问题, 主要包括: 1)瓷砖表面缺陷包含极小缺陷, 可能只有几个像素点, 机器检测出极小目标的能力有限; 2)瓷砖缺陷包括: 斑点、白点、磕碰、落脏等, 种类繁多; 3)有些瓷砖表面缺陷特征与瓷砖本身花纹有相似之处. 因此, 瓷砖表面缺陷检测一直是困扰瓷砖行业的痛点, 也是瓷砖行业发展的瓶颈.

很多学者开始使用机器视觉的相关技术去解决瓷砖表面缺陷检测的问题, Sameer Ahamad等人[1]对图像进行形态学操作, 并采用模糊规则对瓷砖的缺陷进行分类. Samarawickrama等人[2]使用Matlab软件对瓷砖表面的角缺陷、边缺陷以及划痕进行检测, 通过计算图像的白色像素和整副图像的白色像素的数值判定区域是否存在缺陷. Alamsyah等人[3]使用数字图像处理的方法去检测瓷砖表面缺陷, 首先使用中位滤波器对图像数据进行预处理, 然后基于纹理采用灰度共生矩阵 (GLCM)方法提取纹理数据, 最后采用最临近节点算法 (KNN)方法对图像数据进行分类. Birlutiu等人[4]使用深度学习的方法对瓷盘进行检测, 网络仅包含784个神经元, 准确率却达到89%. 相比于传统的目标检测方法, 基于深度学习的目标检测方法具有更高的目标检测准确率, 拥有更强的鲁棒性和泛化能力.

近年来, 基于深度学习的目标检测算法在工业领域得到了广泛应用, 它可以迅速准确地定位和分类目标, 主要分为两大类: 第1类是两阶段目标检测算法, 该类算法在模型训练时分为2个步骤, 第1步是训练区域建议网络(region proposal network), 第2步是训练目标区域检测的网络. 在推理过程中, 算法生成一系列作为样本的候选框, 再通过卷积神经网络进行样本分类, 代表模型有R-CNN[5]、Fast R-CNN[6]、Faster R-CNN[7]、Cascade R-CNN[8]. 另一类目标检测算法是以YOLO (you only look once)[9]为代表的一阶段目标检测算法, 该类算法将物体检测任务当成回归问题来处理, 它并不需要区域建议网络, 直接产生物体的类别概率和位置坐标值. 经过单次检测即可直接得到最终的检测结果, 因此它的检测速度非常快, 代表模型还有SSD (single shot multi-box detector)[10]、YOLOv3[11]、YOLOv4[12]和RetinaNet[13].

瓷砖生产过程中对表面缺陷检测的实时性要求非常高, 并且瓷砖表面缺陷只占瓷砖总面积的很小部分, 因此检测模型需要具备检测微小目标缺陷的能力. 目前有学者尝试把YOLOv5检测模型应用到该工业场景中, Lu等人[14]提出了一种基于YOLOv5的瓷砖表面缺陷检测方法, 采用优化瓶颈层和主干网络并添加SE[15]注意力机制模块的方法去改进YOLOv5模型. 但是该研究所使用的数据集是未公开的, 其改进后的模型参数量和计算量仍然较大. 此外, 该研究没有分析瓷砖表面缺陷偏小的特性并对检测模型进行改进, 且目前有较多比SE 模块更先进的注意力机制.

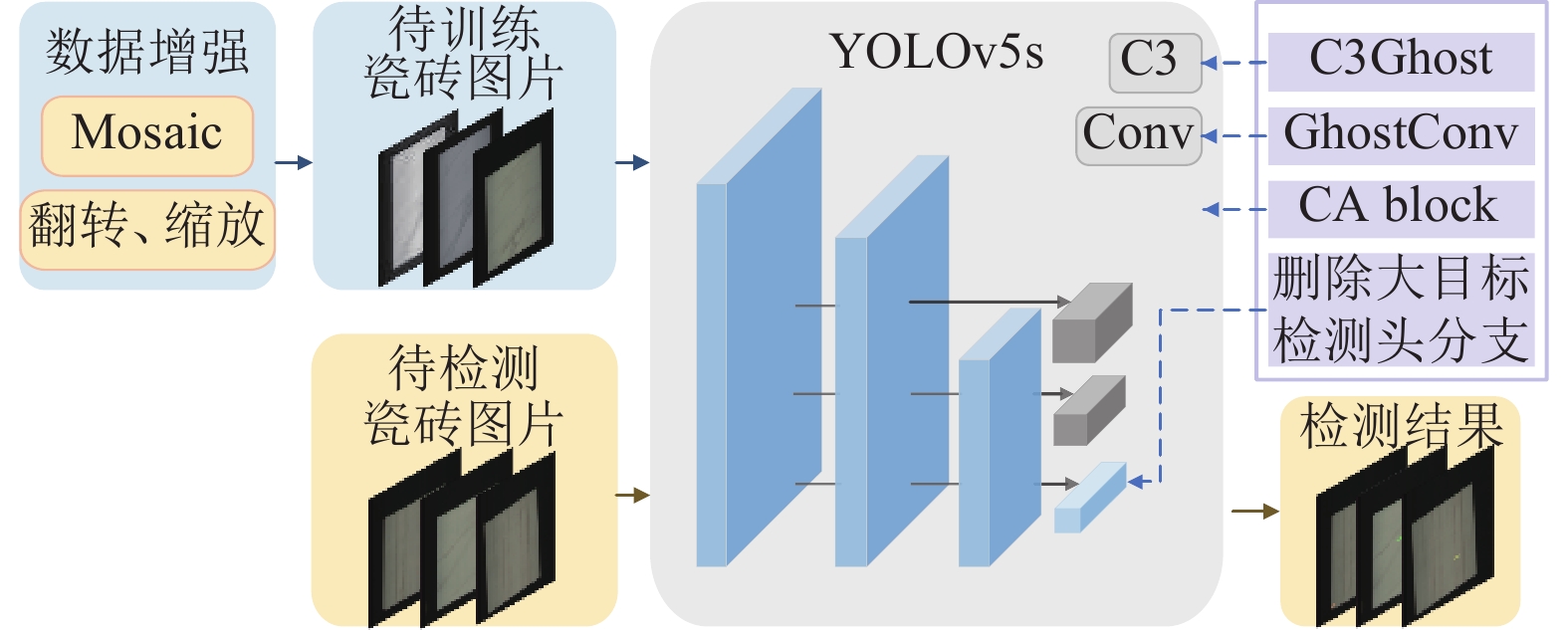

针对上述问题, 本文提出一种基于改进YOLOv5的瓷砖表面缺陷检测方法, 主要贡献如下: 1)根据瓷砖表面缺陷的特征, 删除冗余目标检测头分支, 对检测模型结构进行优化. 2)在网络中使用基于ghost module[16]的轻量化模块, 提高模型的检测速度. 3)添加CA (coordinate attention)[17]注意力机制模块, 增强模型提取目标特征的能力. 本文的总体执行流程如图1所示, 我们用公开的瓷砖表面缺陷数据集来训练改进后的YOLOv5s模型, 得到训练好的检测模型, 把待检测的瓷砖图像输入到训练好的模型进行检测, 最终得到瓷砖图像的检测结果.

|

图 1 总体流程图 |

1 瓷砖表面缺陷数据集 1.1 瓷砖表面缺陷类型

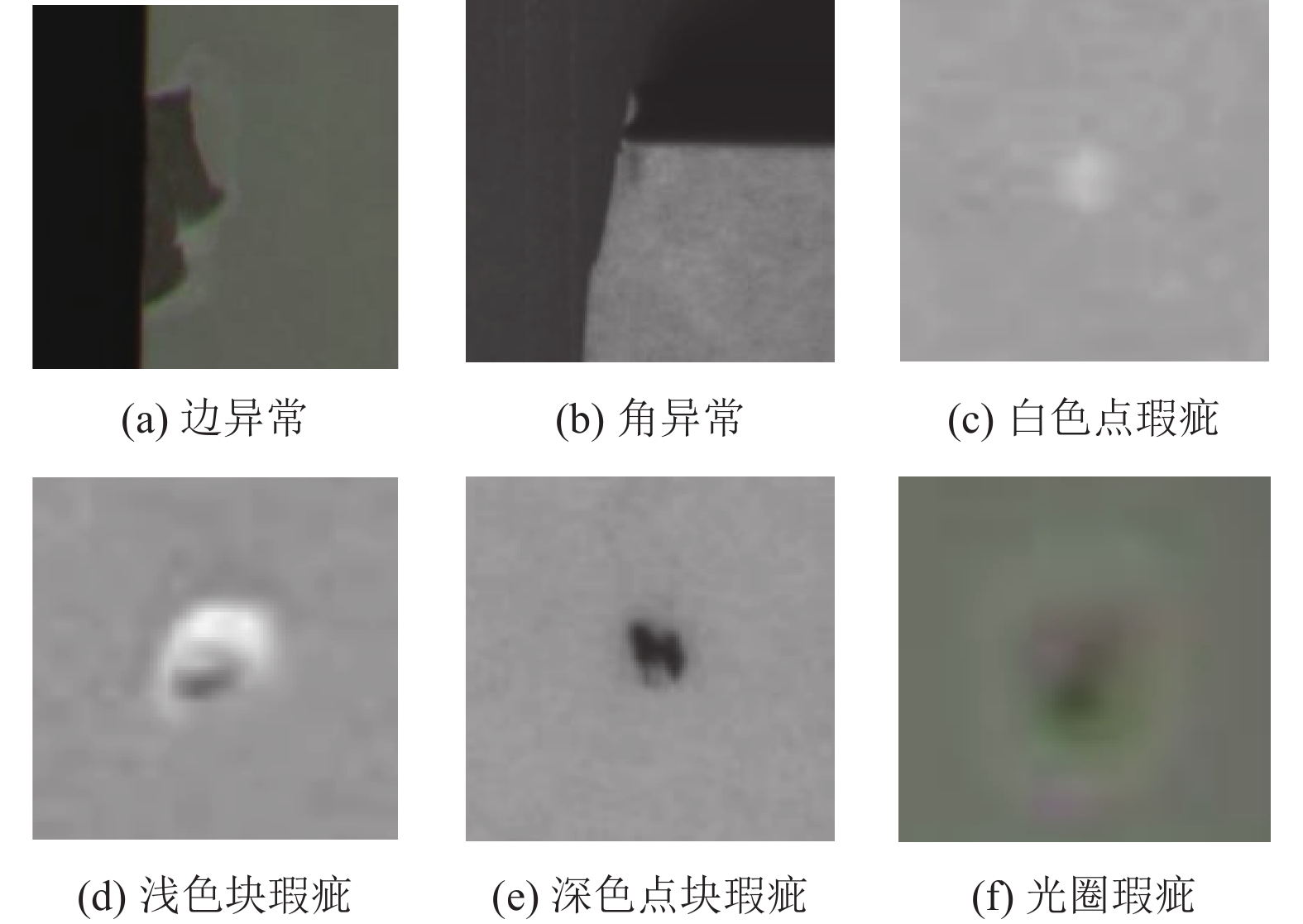

本文使用的数据集是天池瓷砖瑕疵检测数据集, 共有5388张图像. 如图2所示, 主要分为6种缺陷, 分别是边异常、角异常、白色点瑕疵、浅色块瑕疵、深色点块瑕疵和光圈瑕疵. 本文从中随机选取4168张作为训练集, 610张作为验证集, 610张作为测试集.

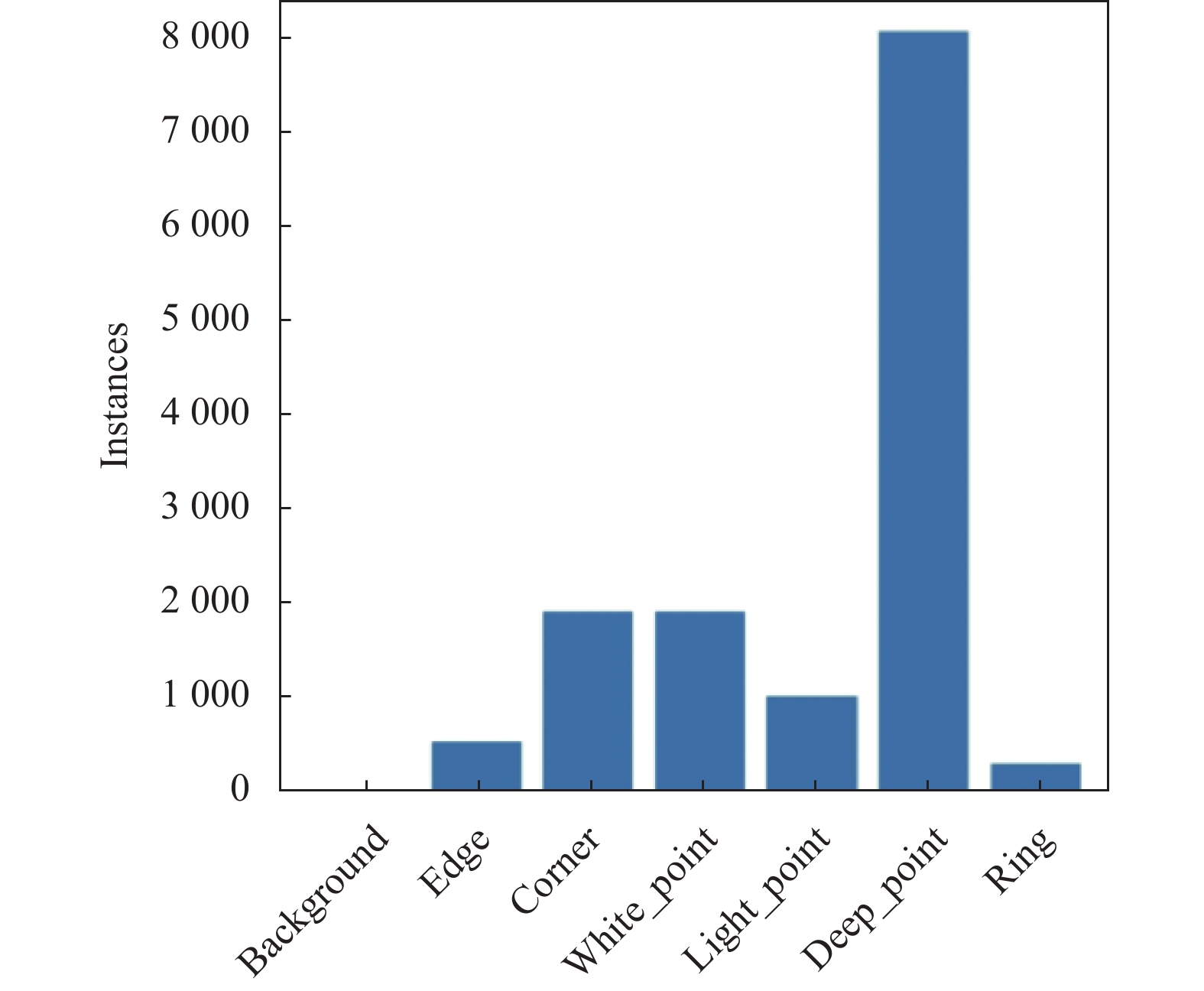

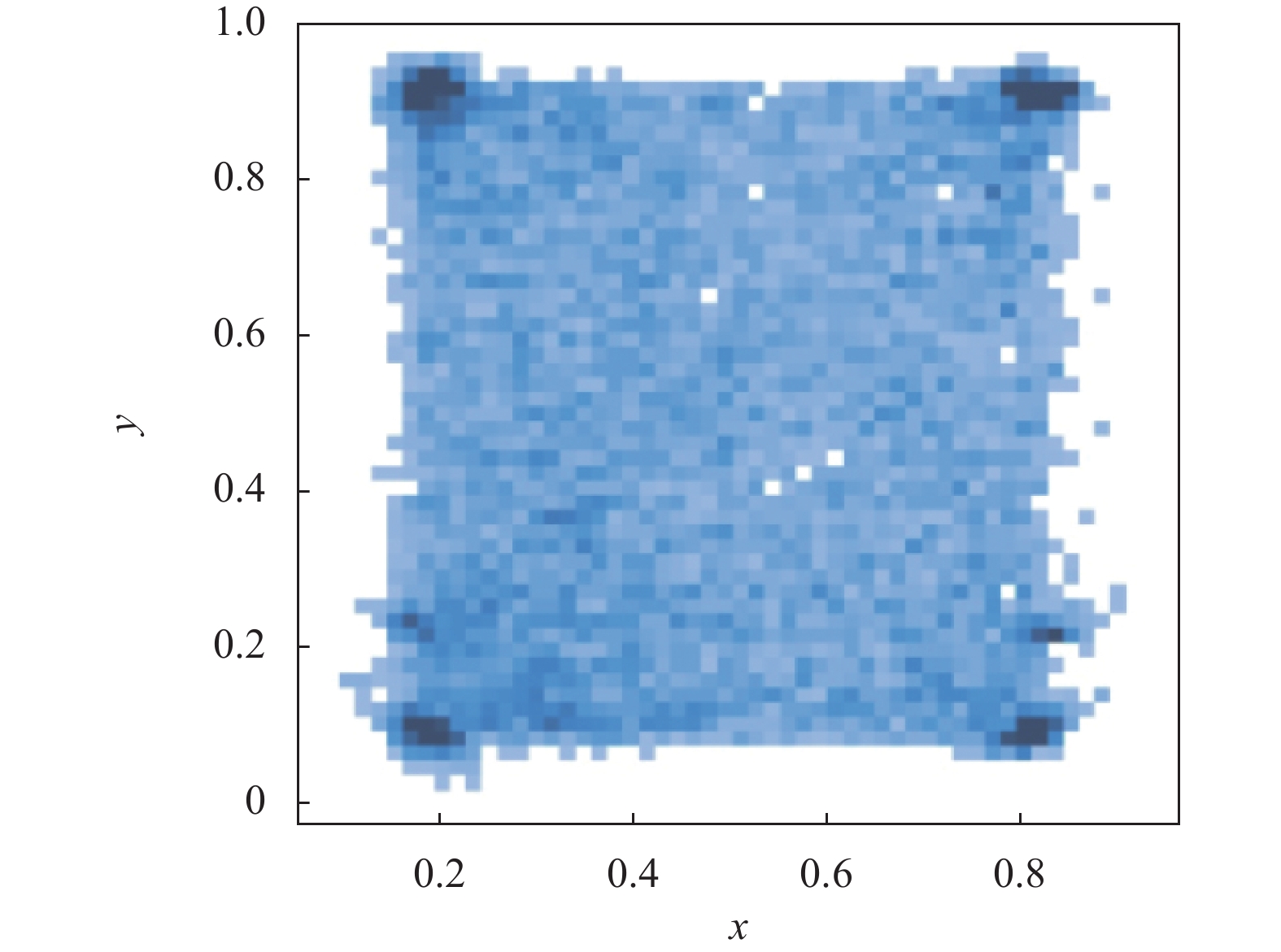

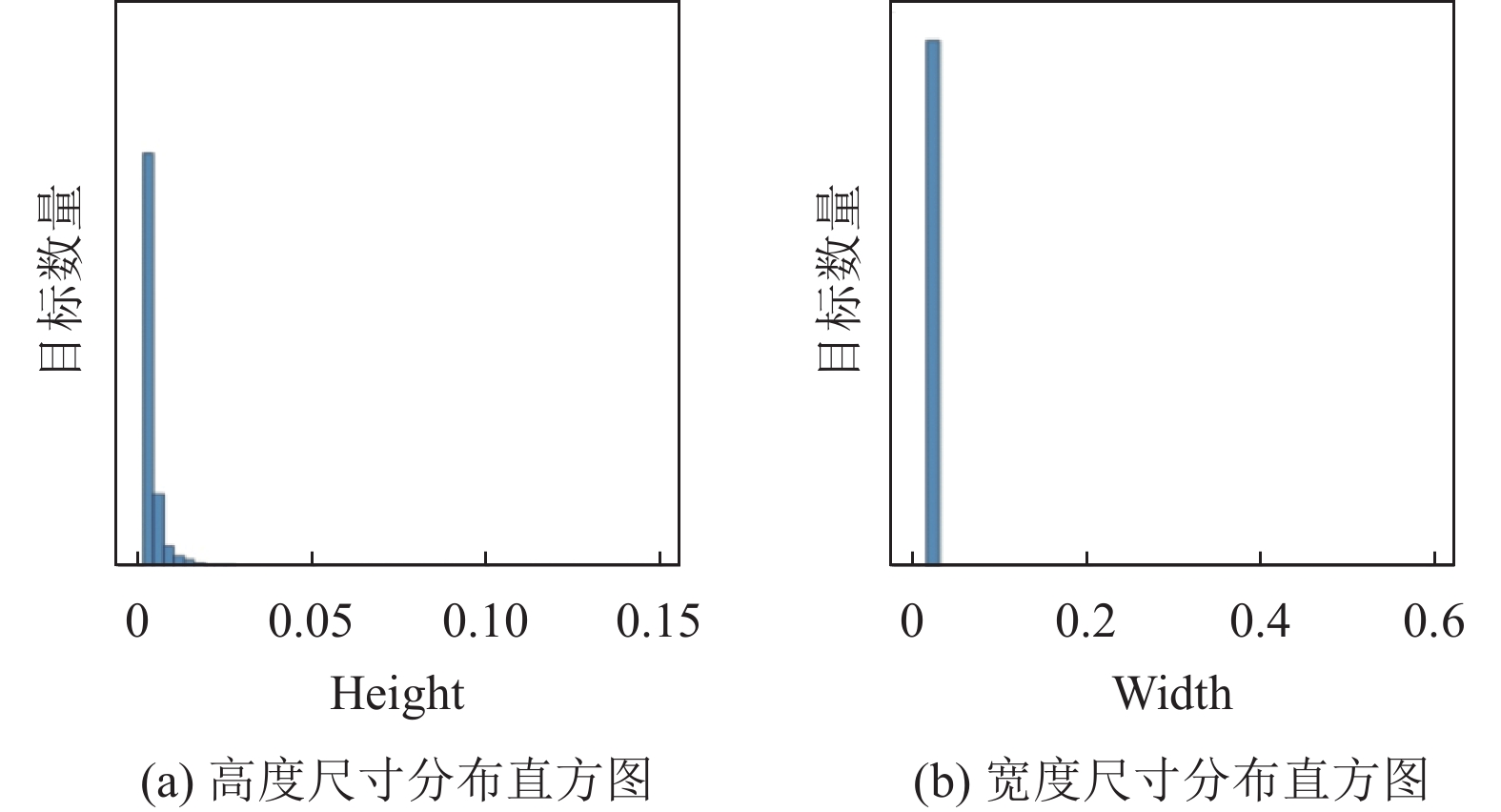

1.2 瓷砖表面缺陷数据集分析对瓷砖瑕疵检测数据集( https://tianchi.aliyun.com/dataset/110088)进行数据分析, 图3统计了数据集中各种缺陷类型的样本数量, 发现深色点块瑕疵出现的频率最高, 超过总样本数量的一半. 图4为瓷砖表面缺陷的位置分布图, 发现目标缺陷分布较为均匀, 其中边异常和角异常大概率发生在制品的边缘处, 所以四角的缺陷数量会更多. 图5(a)为瓷砖表面缺陷的高度尺寸分布直方图, 图5(b)为宽度尺寸分布直方图, 发现绝大部分瓷砖表面缺陷高度尺寸要小于原始图像高度尺寸的0.5%, 宽度尺寸小于原始图像宽度尺寸2%, 瓷砖表面缺陷只占原始图像中很小一部分面积, 且目标缺陷的长宽尺寸较小, 因此小目标检测是瓷砖表面缺陷检测的重点.

|

图 2 瓷砖表面缺陷类型 |

|

图 3 缺陷数量统计图 |

|

图 4 缺陷位置分布图 |

|

图 5 缺陷尺寸分布直方图 |

2 YOLOv5检测算法及改进 2.1 YOLOv5算法

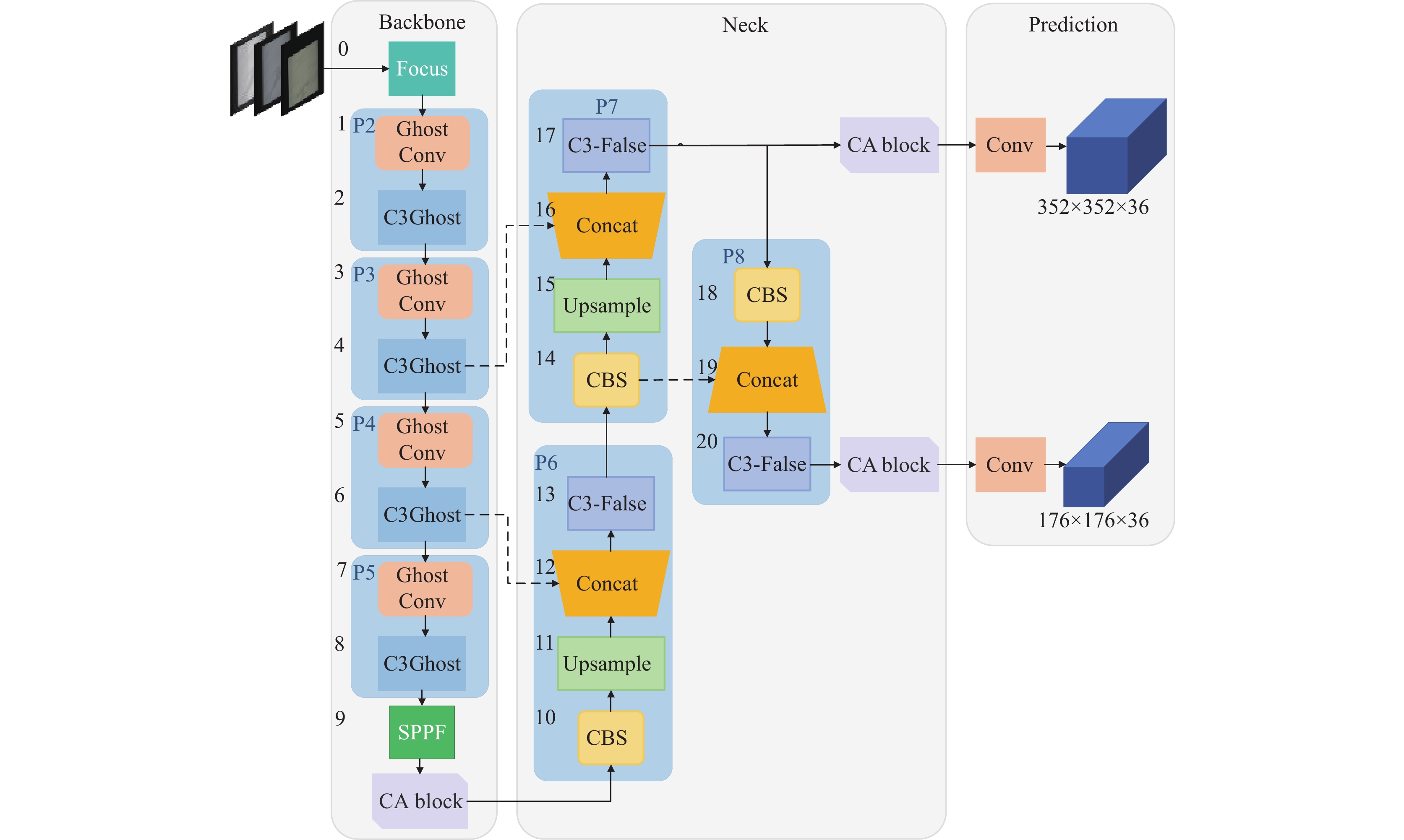

YOLOv5s的整体网络结构如图6所示, 可以分为Backbone、Neck和Prediction这3个部分. 其中Backbone网络主要由Focus、CBS、C3和SPPF模块组成, 主要功能是提取输入图像的信息. 在Backbone网络最后加入SPPF (spatial pyramid pooling-fast)模块, 能显著增加了感受野, 分离出最重要的上下文特征, 对比普通的SPP[18]方法, SPPF以更少的计算量和更快的速度就能产生与SPP一样的效果. Neck网络借鉴了FPN+PANet[19]网络结构, 它的主要功能是实现Backbone网络中不同层级之间的信息交互. 在Prediction网络, YOLOv5s有3个目标检测头分支, 分别对小目标、中目标和大目标进行目标检测, 本文输入网络的图像尺寸为2816×2816×3, 在Prediction网络会使用352×352、176×176和88×88的网格分别检测小目标、中目标和大目标. YOLOv5使用CIoU loss[20]作为边界框坐标回归的损失函数, 解决了IoU和GIoU[21]存在的收敛速度慢和回归不精确等问题.

|

图 6 YOLOv5s的网络结构 |

2.2 YOLOv5算法改进

为了解决瓷砖表面缺陷检测存在的小目标检测困难、实时性要求高的问题, 本文提出的适用于瓷砖表面缺陷检测的改进型YOLOv5s模型. 如图7所示, 改进点主要分为3个部分: 1)模型结构改进: 删除原模型中专门用来检测大目标的冗余检测头分支; 2)模型轻量化改进: 使用轻量化模块ghost convolution和C3Ghost替换原模型Backbone网络中的C3和普通卷积模块; 3)添加注意力机制: 为了让模型更关注重要的区域, 在Backbone和Neck网络末端添加CA (coordinate attention) block.

2.2.1 模型结构改进YOLOv5s在Prediction网络有3个目标检测头分支, 它们的感受野各不相同. 其中大目标检测头所使用网格大小为88×88, 每个网格的长宽尺寸为输入图像的长宽尺寸的1.14%. 但是数据集中绝大多数缺陷的高度尺寸要小于原始图像高度尺寸的0.5%, 因此大目标检测头分支检测瓷砖表面缺陷的能力会较弱.

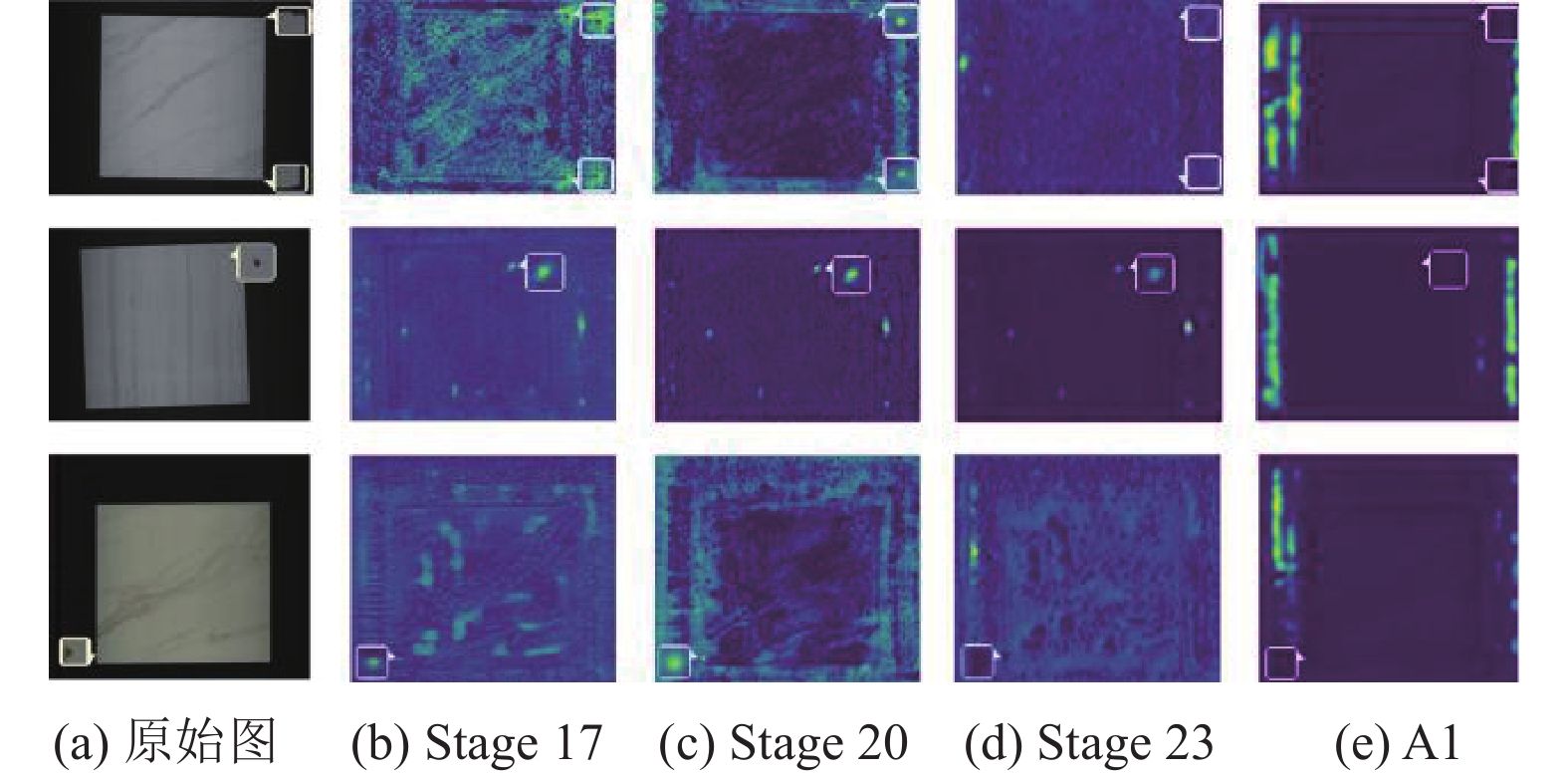

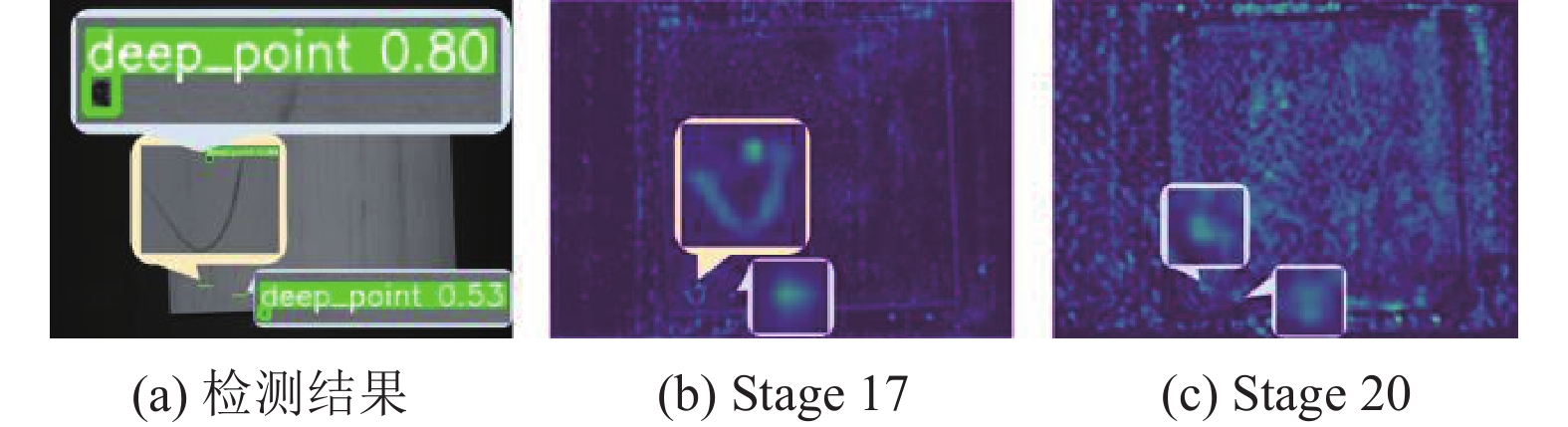

图8为YOLOv5s在不同阶段生成的特征图, 可以发现在stage 17和stage 20生成的特征图中目标缺陷的特征信息最清晰, 但是从stage 23生成的特征图可以发现, 缺陷的特征信息开始变得模糊, 部分特征信息已经消失.

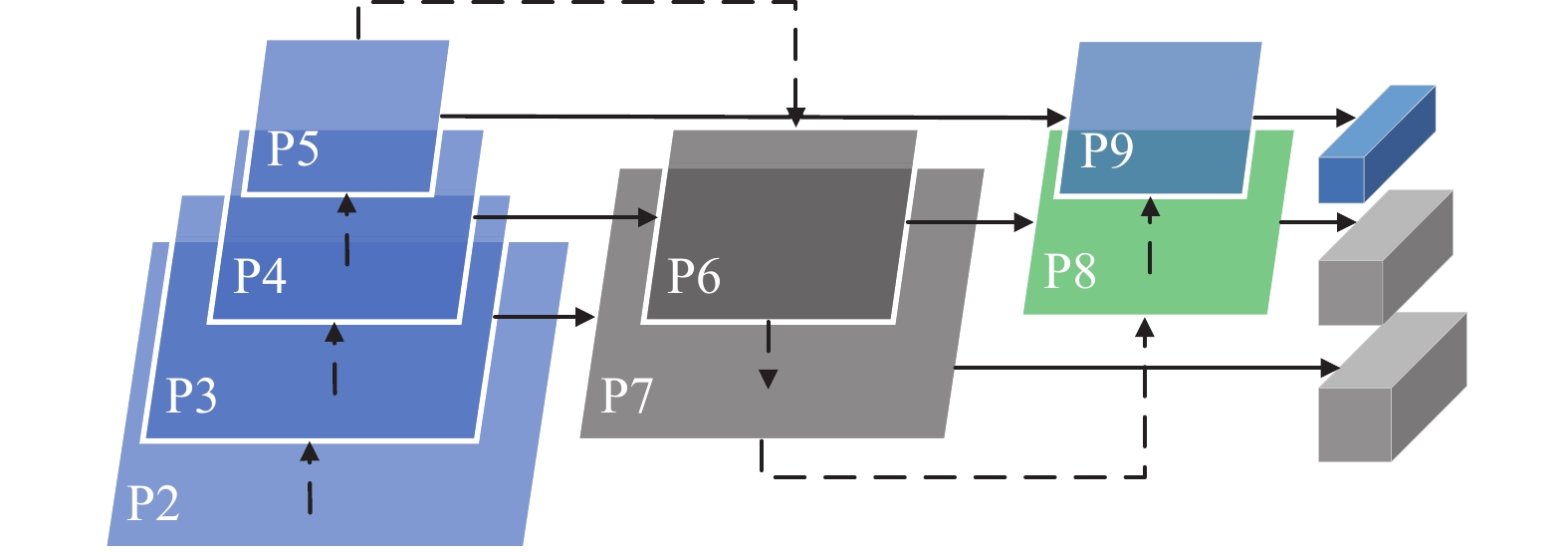

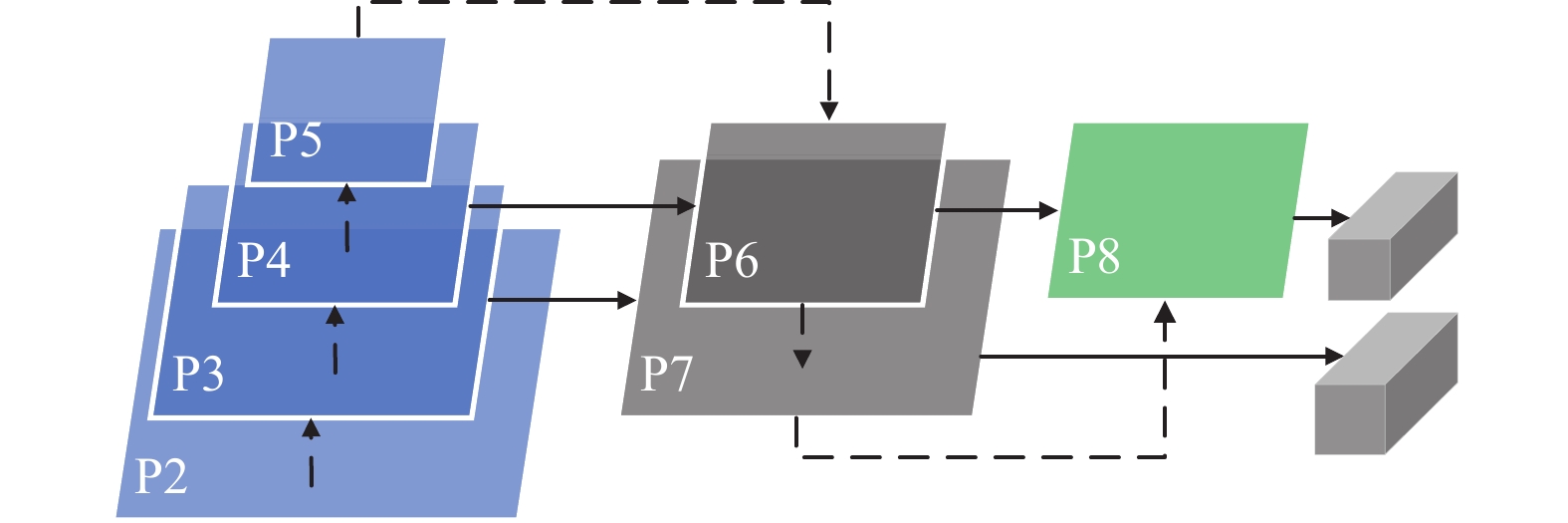

图9为YOLOv5s的结构简图, 由于瓷砖表面缺陷的尺寸很小, P9部分输出的特征图是专门用来检测大尺寸目标, 因此该部分的作用有限, 改进后的YOLOv5s模型删除了原模型P9部分. 图10为删除大目标检测头后的模型, 模型命名为YOLOv5s-de, 该模型可以减少原始模型的参数量和计算量, 提升模型的检测速度.

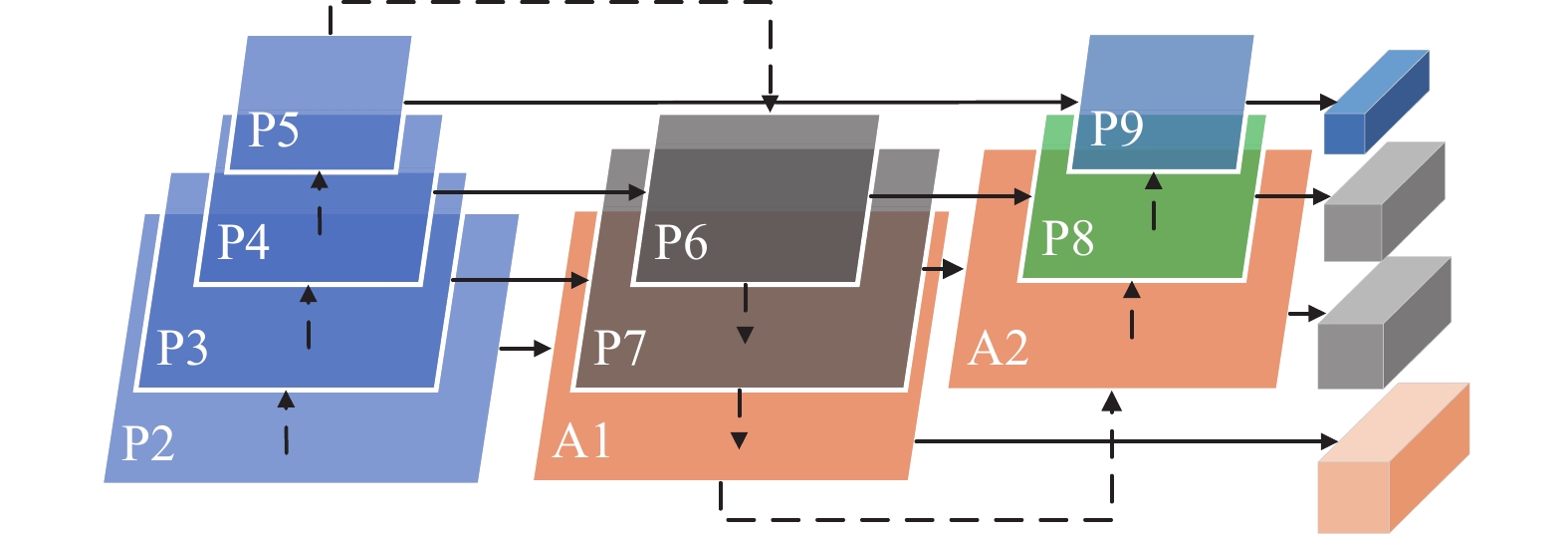

为了对比拥有不同数量目标检测头分支的YOLOv5s模型, 本文在Prediction网络添加了一个专门针对微小目标的检测头, 如图11所示, 在Neck网络中采用FPN+PANet[19]的网络结构, 添加了A1和A2部分, A1与P2输出的特征信息拼接后直接对微小目标进行检测, 本文把添加微小目标检测头的模型命名为YOLOv5s-ad.

图8(e)为A1部分输出的特征图, 可以发现, 在YOLOv5s模型的基础上, 所添加的微小目标缺陷检测头并不能有效提取目标缺陷的特征信息, 检测效果较差. 主要原因是所使用的模型是YOLOv5s, 属于YOLOv5系列中较为轻量的模型, 输入的图像信息只经过Backbone网络中P2部分处理后, 就与Neck网络A1部分输入的信息进行拼接, 且P2部分中的C3模块只有一层bottleneck, 提取特征信息的能力较弱, 因此所添加的微小目标检测头的检测能力有限.

|

图 7 改进后的YOLOv5s网络结构 |

|

图 8 YOLOv5s各阶段生成的特征图 |

|

图 9 原模型结构简图 |

|

图 10 YOLOv5s-de结构简图 |

|

图 11 YOLOv5s-ad结构简图 |

2.2.2 模型轻量化改进

本文对YOLOv5s模型进行轻量化改进思路是使用基于ghost module[16]的ghost convolution和C3Ghost去分别替换原模型Backbone网络中的普通卷积和C3模块.

假设输入特征是

为解决上述问题, ghost module将卷积操作分为2个部分: 第1部分涉及普通卷积, 但是输出只有

| $ {y_{ij}} = {\Phi _{i, j}}({y'_i} ),\;{\text{ }}\forall i = 1,\;\cdots,\;m,\;{\text{ }}j = 1,\;\cdots,\;s $ | (1) |

其中,

| $ \begin{split} {r_s} &= \dfrac{{n \cdot h' \cdot w' \cdot c \cdot k \cdot k}}{{\dfrac{n}{s} \cdot h' \cdot w' \cdot c \cdot k \cdot k + \left( {s - 1} \right) \cdot \dfrac{n}{s} \cdot h' \cdot w' \cdot d \cdot d}} \\ & = \dfrac{{c \cdot k \cdot k}}{{\dfrac{1}{s} \cdot c \cdot k \cdot k + \dfrac{{s - 1}}{s} \cdot d \cdot d}} \approx \dfrac{{s \cdot c}}{{s + c - 1}} \approx s \end{split} $ | (2) |

其中,

| $ {r_c} = \frac{{n \cdot c \cdot k \cdot k}}{{\dfrac{n}{s} \cdot c \cdot k \cdot k + \left( {s - 1} \right) \cdot \dfrac{n}{s} \cdot d \cdot d}} \approx \dfrac{{s \cdot c}}{{s + c - 1}} \approx s $ | (3) |

与普通的卷积神经网络相比, ghost module总体所需的参数量和计算量都更少. 另外, ghost module尝试利用简单的线性操作获得更多的相似特征图, 这些ghost特征映射可以充分揭示内在特征的信息, 从而增强模型的特征提取能力. 虽然生成的ghost特征图来源于原始特征图, 但他们之间存在着显著差异, 这意味着生成的特征图足够灵活, 能够满足特定任务的需求.

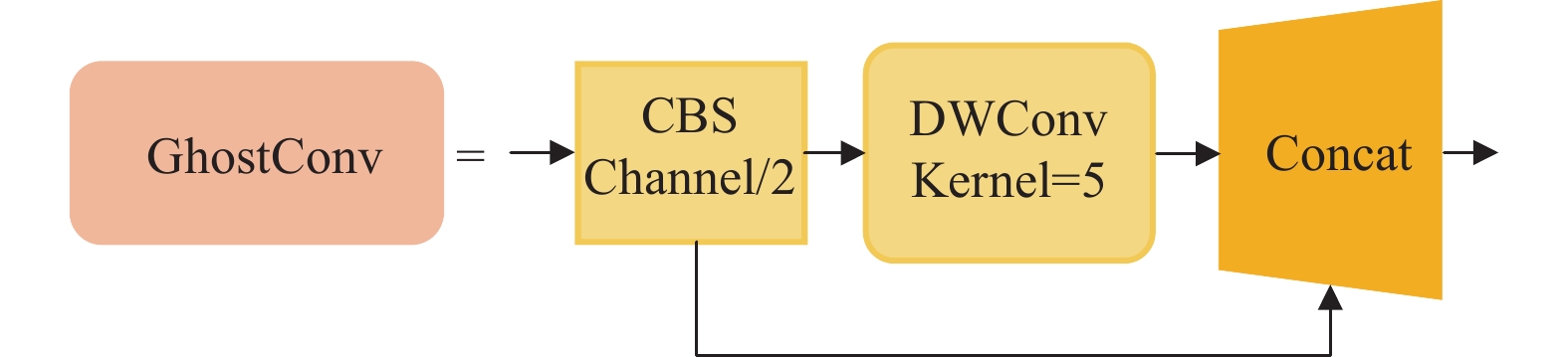

如图12所示, ghost convolution的第1个卷积是CBS模块, 但输出特征图的通道数只有普通CBS模块输出通道数的一半. 第2个卷积是深度可分离卷积[22], 使用DWConv表示, 它的卷积核大小为5×5. 相较于普通卷积, ghost convolution减少了非关键特征的学习成本, 通过组合少量卷积核与更廉价的线性操作去代替常规卷积方式, 能有效降低模型对计算资源需求.

|

图 12 Ghost convolution模块结构 |

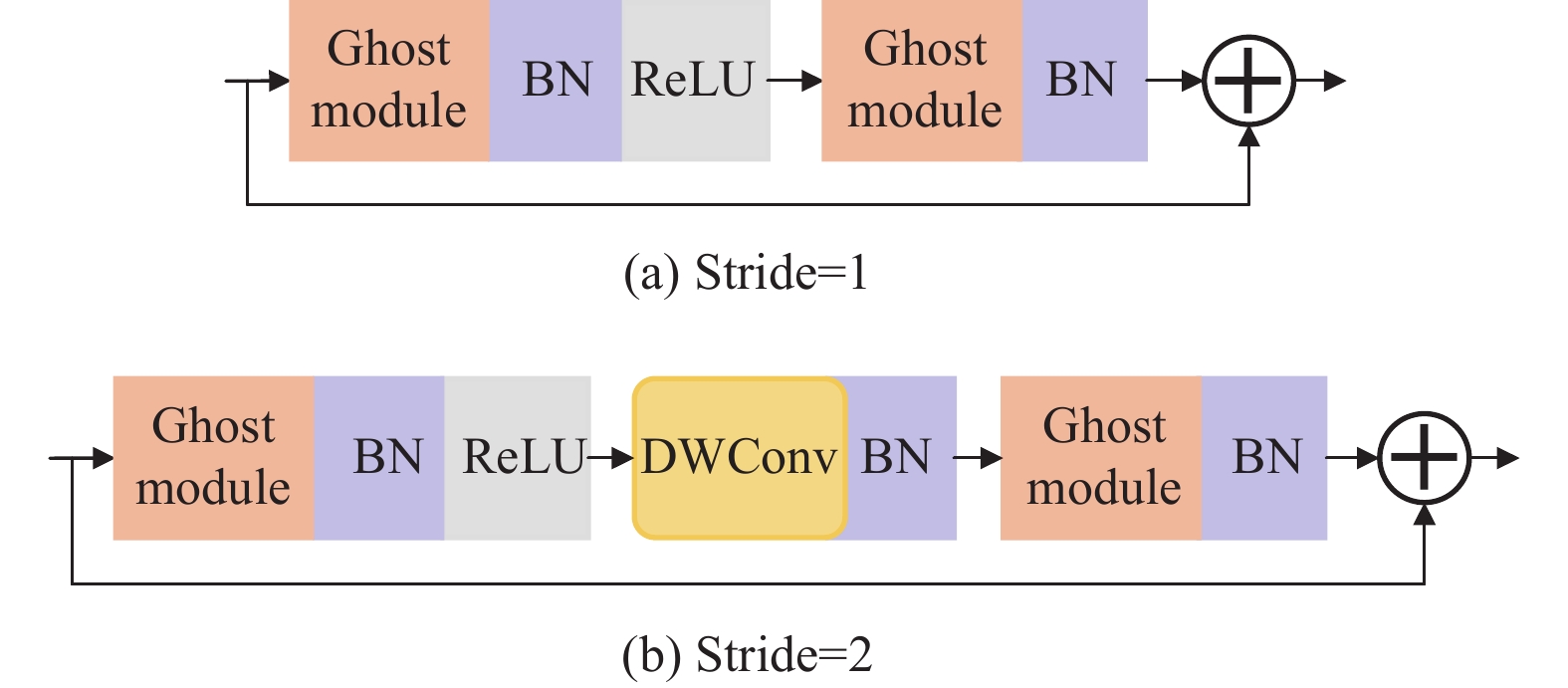

C3Ghost是在C3模块中使用ghost bottleneck作为瓶颈层的网络结构, 其中, ghost bottleneck把ghost module引用到瓶颈层模块中. 如图13所示, ghost bottleneck有stride=1和stride=2两种情况, 第1个ghost module是一个增加通道数量的扩展层, 将输出通道数与输入通道数之间的比率称为扩展比率; 第2个ghost module减少了与shortcut路径相匹配通道的数量, 并使用shortcut方法融合这2个ghost module的输入和输出. 在实际应用中, ghost module的卷积主要是使用逐点卷积来完成, 可以有效提高模型的效率.

|

图 13 Ghost bottleneck模块结构 |

2.2.3 添加注意力机制

注意力模块可以使用全局信息来有选择地强调信息特征, 关注信息量丰富的通道特征, 并抑制不重要的通道特征. 本文在改进模型的基础上对比了两种不同的注意力机制模块, 分别是SE block[15]和CA block[17].

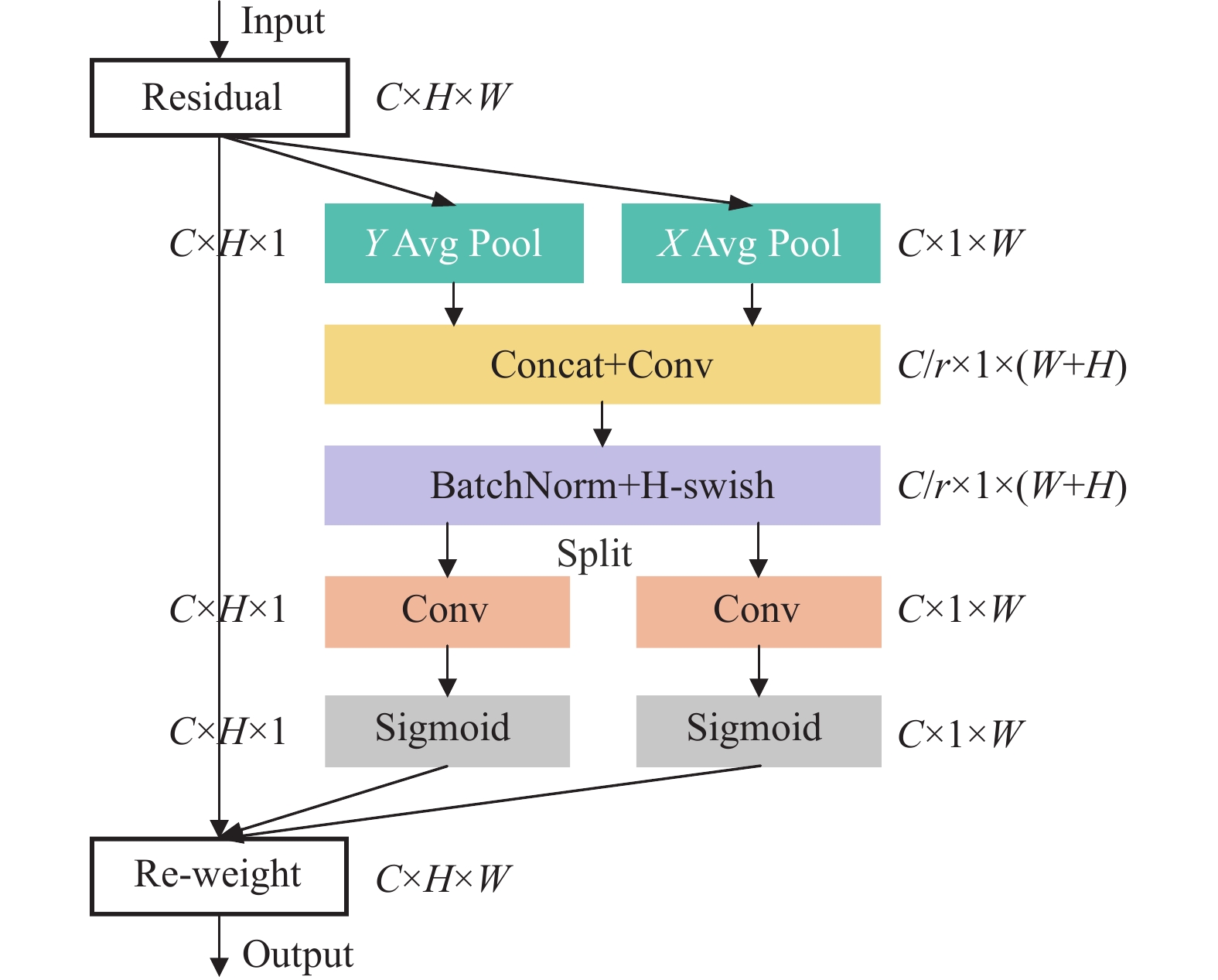

CA block网络结构如图14所示, 相比于SE block, 它除了考虑通道间的关系外, 还考虑了特征空间的位置信息, 在通道注意力中结合水平方向信息和垂直方向信息, 这能帮助模型更加精确地定位和识别感兴趣的目标.

|

图 14 Coordinate attention block结构 |

首先对输入的特征信息

| $ {\textit{z}}_c^h\left( h \right) = \frac{1}{W}\sum\limits_{0 \leqslant i < W} {{x_c}\left( {h, i} \right)} $ | (4) |

相似地, 通道数为c且在宽度w处的输出表示为:

| $ {\textit{z}}_c^w\left( w \right) = \frac{1}{H}\sum\limits_{0 \leqslant j < H} {{x_c}\left( {j, w} \right)} $ | (5) |

然后对式(4)和式(5)输出的特征图进行拼接操作, 如式(6)所示, 送入到共享的1×1卷积变换函数

| $ f = \delta \left( {{F_1}\left( {\left[ {{{\textit{z}}^h}, {{\textit{z}}^w}} \right]} \right)} \right) $ | (6) |

接下来将特征图

| $ {g^h} = \sigma \left( {{F_h}\left( {{f^h}} \right)} \right) $ | (7) |

| $ {g^w} = \sigma \left( {{F_w}\left( {{f^w}} \right)} \right) $ | (8) |

最后用注意力权重乘以原始输入的特征图, 得到注意力模块最终输出的特征信息:

| $ {y_c}\left( {i, j} \right) = {x_c}\left( {i, j} \right) \times g_c^h\left( i \right) \times g_c^w\left( j \right) $ | (9) |

本文训练和测试所使用的GPU为Nvidia RTX 3090, 操作系统为Ubuntu, 版本为20.04, 采用PyTorch深度学习框架, 版本号为1.9.0, CUDA版本为11.2, cuDNN版本8.0.5. 训练的初始学习率为0.01, 最大迭代次数为400, batch size设置为4.

本文从平均精度均值 (mean average precision, mAP)、参数量、计算量、模型权重4个评价指标去衡量模型的性能. 如式(10)–式(12)所示, 平均精度均值 (mAP)是模型检测精度的评价指标, 它与精确率 (precision)和召回率(recall)相关, AP(c)表示类别c的平均精确率, N(classes)表示多目标分类任务中类别的个数, 某个类别的平均精确率(AP)是指P-R曲线和坐标轴所围区域的面积. 进行多标签图像分类任务时, 把每一个类别的AP值相加后除以类别数量, 最终得到所有类别的平均精度均值.

| $ precision = \frac{{TP}}{{TP + FP}} $ | (10) |

| $ recall = \frac{{TP}}{{TP + FN}} $ | (11) |

| $ mAP = \frac{{\displaystyle\sum\limits_{c \in {\textit{classes}}} {AP(c)} }}{{N({\textit{classes}})}} $ | (12) |

YOLOv5应用了类似EfficientNet[23]中的channel和layer控制因子, 提供了5种不同复杂度的版本. 由于瓷砖表面缺陷检测对实时性要求很高, 检测模型需要具备更快的检测速度, 因此本文对复杂度较小的前3种模型作对比, 分别是YOLOv5n、YOLOv5s和YOLOv5m. 实验结果如表1所示, YOLOv5s能够保证在较高平均精度均值的前提下, 所需要耗费的计算量较少, 检测时间较短, 在检测速度和检测精度两个方面更为均衡, 因此后面的模型均是在YOLOv5s的基础上进行改进.

| 表 1 YOLOv5不同复杂度模型性能对比 |

3.2.2 模型结构改进分析

由于瓷砖表面缺陷尺寸偏小的特性, 本文提出了在YOLOv5s基础上删除大目标检测头的YOLOv5s-de模型. 为了确定最佳的检测头分支数量, 本文还构建了添加微小目标检测头的YOLOv5s-ad模型.

实验结果如表2所示, 可以发现YOLOv5s-de模型在平均精度均值、模型参数量、计算量、模型权重以及检测速度方面均是最优, 相比于YOLOv5s模型, mAP0.5提升0.6%, 参数量减少25.7%, 计算量减少9%. 而YOLOv5s-ad模型检测效果很差. 因此, 通过对比拥有不同数量的目标检测头的模型, 发现在YOLOv5s模型的基础上只保留小目标检测头和中目标检测头是模型结构改进的最佳策略.

| 表 2 拥有不同数量目标检测头的模型实验结果对比 |

3.2.3 消融实验

以YOLOv5s-de为基准模型进行消融实验, 实验主要包括以下2个部分: 第1部分是对比3种不同的轻量化模块, 包括深度可分离卷积, ghost convolution以及C3Ghost. 第2部分对比两种不同的注意力机制模块, 包括SE block和CA block.

从表3可以发现使用ghost convolution和C3Ghost模块可以显著减少原模型的参数量和计算量, 使用后模型的平均精度均值、参数量和计算量均要优于基准模型, 其中mAP0.5提升了0.1%, 参数量和计算量均减少了36%. 在主干网络使用ghost module替代卷积层, 使用廉价的线性操作即可生成大量的特征映射, 帮助模型以更少的参数实现了更高的识别性能.

| 表 3 消融实验 |

使用ghost convolution和C3Ghost两种轻量化模块, 再选择添加CA block后的模型平均精度均值最高, 达到66%, 相比于原YOLOv5s模型, mAP0.5提升了1.8%, 参数量减少了48.7%, 计算量减少了38.7%, 在参数量和计算量少于原模型的基础上, 实现了更高的平均精度均值, 更快的检测速度.

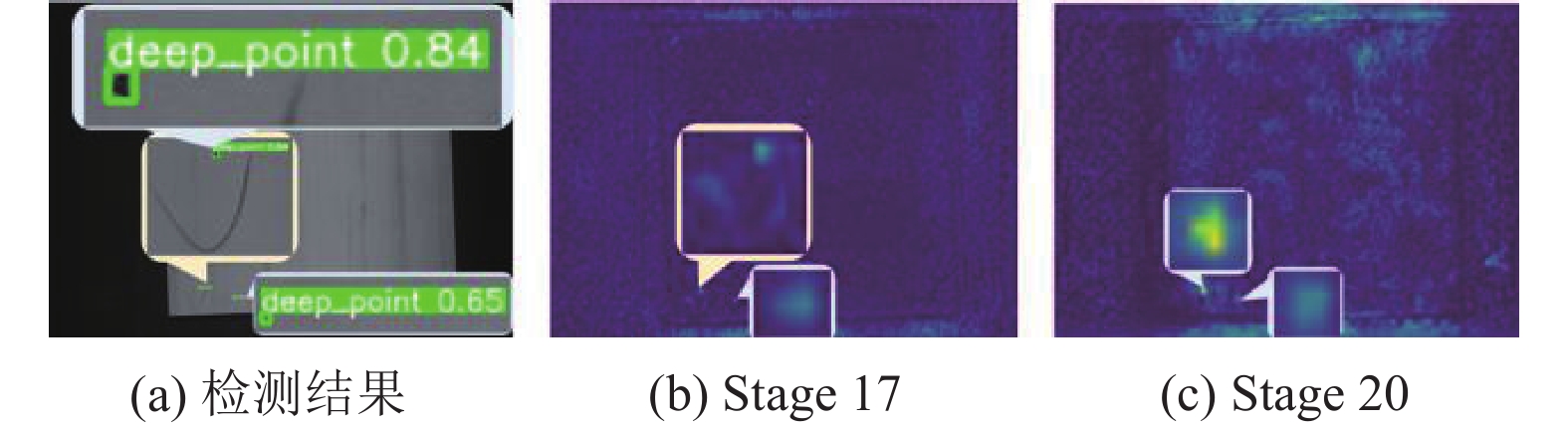

对比图15和图16的检测结果可以发现, 添加CA block的模型对目标缺陷的预测置信度要高于添加SE block的模型. 对比图15(b)和图16(b)在stage 17输出的特征信息可以发现, 对于一些干扰信息, 如图15(a)中出现的用黑色油性笔所做的标记, 添加CA block的检测模型对这些干扰信息的抑制效果更好. 对比图15(c)和图16(c)在stage 20输出的特征信息可以发现, 添加CA block的检测模型提取目标缺陷特征信息的能力要明显强于添加SE block的模型.

|

图 15 添加SE block后模型的检测结果及生成的特征图 |

|

图 16 添加CA block后模型的检测结果及生成的特征图 |

3.2.4 不同模型性能对比

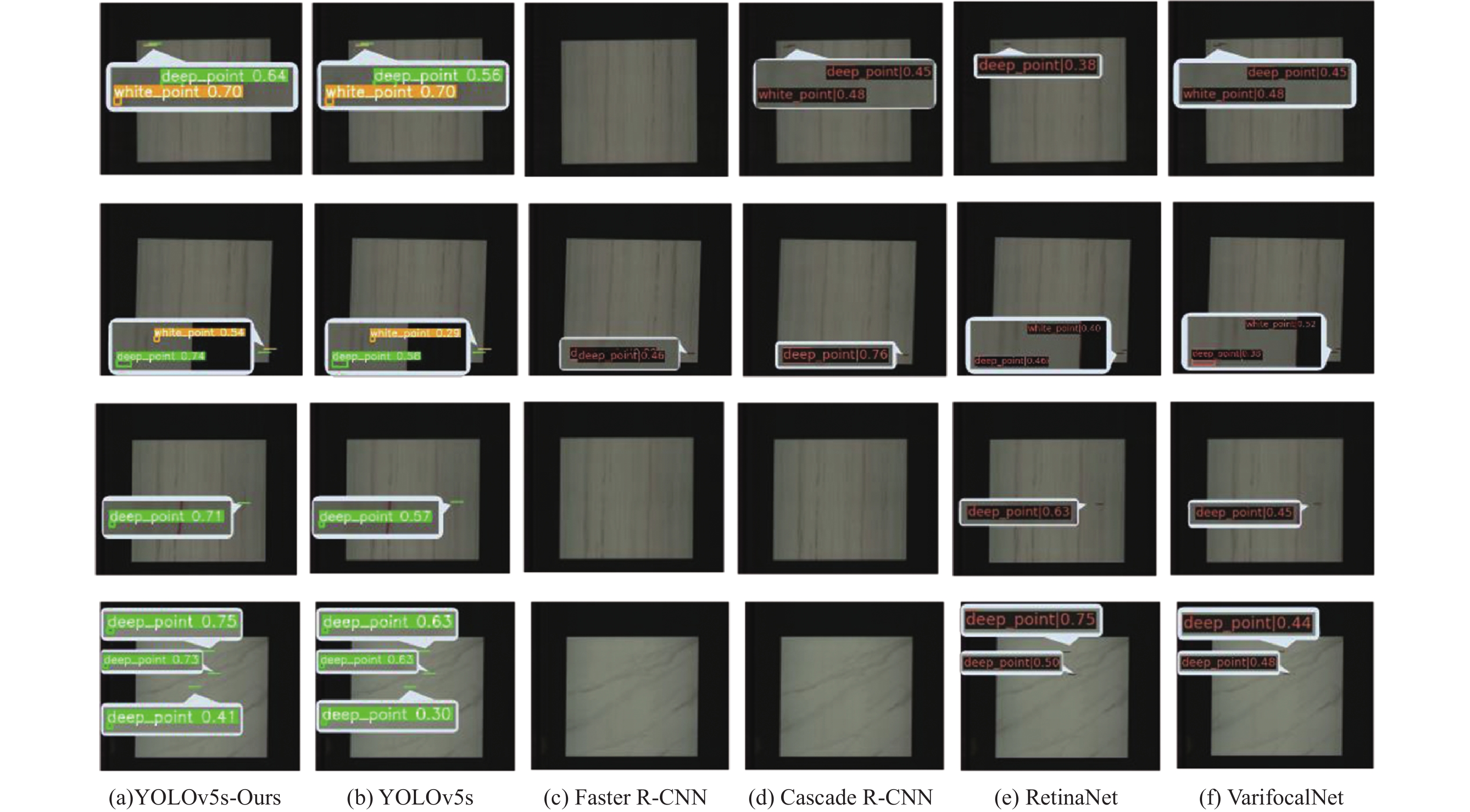

本文对比不同的目标检测模型, 包括Faster R-CNN[7]、Cascade R-CNN[8]、RetinaNet[13]和VarifocalNet[24], 它们所使用的主干网络结构均为ResNet-101[25]. 对比的模型还包括YOLOv3-tiny和YOLOX-s模型, 它们分别是YOLOv3[11]和YOLOX[26]模型的轻量化版本, 输入的图像尺寸大小均为2816×2816×3.

从表4可以看出YOLOv5s模型对比其他目标检测模型, 平均精度均值更高, 并且模型的参数量和计算量更少. 在所有对比的模型中, 改进后的模型YOLOv5s-Ours在平均精度均值、参数量、计算量和模型权重方面均为最优. YOLOv5s-Ours在模型参数量和计算量最少的基础上, 实现了最高的检测精度.

3.2.5 不同类型缺陷识别性能对比瓷砖表面缺陷检测的重点和难点是检测出微小目标缺陷, 表5对比了不同模型检测各类型缺陷的平均精确率, 可以发现对于出现频率极高的小目标缺陷如深色点块瑕疵、浅色点瑕疵以及白色点瑕疵, YOLOv5s-Ours的平均精确率远远高于原YOLOv5s模型, 对小目标缺陷拥有更出色的检测能力.

| 表 4 不同目标检测模型性能对比 |

对比图17中YOLOv5s和YOLOv5s-Ours的混淆矩阵可以发现, 改进后的模型错误分类更少, 对所有缺陷类型都实现了更精准的分类, 尤其是对小目标缺陷的分类能力要强于YOLOv5s模型.

3.2.6 不同模型实测性能对比针对测试数据, 图18展示了不同目标检测模型的检测结果, 从实验结果可以看出YOLOv5s-Ours对目标缺陷的预测置信度要高于原YOLOv5s模型, 并且YOLOv5s-Ours对比其他检测模型, 能够检测出更多的目标缺陷, 改进后的模型对小目标缺陷检测效果优异, 适用于检测瓷砖表面缺陷这种类型的微小目标. 并且改进后模型参数量和计算量最少, 能够很好地满足瓷砖表面缺陷检测对实时性的要求.

| 表 5 各种缺陷类型的平均精确率 |

4 结论与展望

本文提出了一种基于改进的YOLOv5的瓷砖表面缺陷检测方法, 通过删除冗余检测头分支以及使用ghost convolution和C3Ghost来实现模型的轻量化, 并且添加CA注意力机制模块, 提升模型关注重要区域信息的能力. 改进后的模型在平均精度均值、参数量、计算量以及模型权重方面均优于YOLOv5s和其他对比的目标检测模型, 对小目标缺陷拥有出色的检测效果. 在后续的工作中, 会将改进后的模型部署在嵌入式设备上, 应用到实际瓷砖表面缺陷检测环节中, 实现应用落地.

|

图 17 混淆矩阵 |

|

图 18 检测结果 |

| [1] |

Sameer Ahamad N, Bhaskara Rao J. Analysis and detection of surface defects in ceramic tile using image processing techniques. Microelectronics, Electromagnetics and Telecommunications. New Delhi: Springer, 2016. 575–582.

|

| [2] |

Samarawickrama YC, Wickramasinghe CD. Matlab based automated surface defect detection system for ceremic tiles using image processing. Proceedings of the 6th National Conference on Technology and Management (NCTM). Malabe: IEEE, 2017. 34–39.

|

| [3] |

Alamsyah R, Wiranata AD, Rafie. Defect detection of ceramic tiles using median filtering, morphological techniques, gray level co-occurrence matrix and K-nearest neighbor method. Scientific Research Journal, 2019, 7(4): 41-46. |

| [4] |

Birlutiu A, Burlacu A, Kadar M, et al. Defect detection in porcelain industry based on deep learning techniques. Proceedings of the 19th International Symposium on Symbolic and Numeric Algorithms for Scientific Computing (SYNASC). Timisoara: IEEE, 2017. 263–270.

|

| [5] |

Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation. Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus: IEEE, 2014. 580–587.

|

| [6] |

Girshick R. Fast R-CNN. Proceedings of the 2015 IEEE International Conference on Computer Vision. Santiago: IEEE, 2015. 1440–1448.

|

| [7] |

Ren SQ, He KM, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks. Proceedings of the 28th International Conference on Neural Information Processing Systems. Montreal: MIT Press, 2015. 91–99.

|

| [8] |

Cai ZW, Vasconcelos N. Cascade R-CNN: Delving into high quality object detection. Proceedings of the 2018 IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 6154–6162.

|

| [9] |

Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 779–788.

|

| [10] |

Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector. Proceedings of the 14th European Conference on Computer Vision. Amsterdam: Springer, 2016. 21–37.

|

| [11] |

Redmon J, Farhadi A. YOLOv3: An incremental improvement. arXiv:1804.02767, 2018.

|

| [12] |

Bochkovskiy A, Wang CY, Liao HYM. YOLOv4: Optimal speed and accuracy of object detection. arXiv:2004.10934, 2020.

|

| [13] |

Lin TY, Goyal P, Girshick R, et al. Focal loss for dense object detection. Proceedings of the 2017 IEEE International Conference on Computer Vision. Venice: IEEE, 2017. 2980–2988.

|

| [14] |

Lu QH, Lin JM, Luo LF, et al. A supervised approach for automated surface defect detection in ceramic tile quality control. Advanced Engineering Informatics, 2022, 53: 101692. DOI:10.1016/j.aei.2022.101692 |

| [15] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7132–7141.

|

| [16] |

Han K, Wang YH, Tian Q, et al. GhostNet: More features from cheap operations. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 1577–1586.

|

| [17] |

Hou QB, Zhou DQ, Feng JS. Coordinate attention for efficient mobile network design. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 13708–13717.

|

| [18] |

He KM, Zhang XY, Ren SQ, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916. DOI:10.1109/TPAMI.2015.2389824 |

| [19] |

Liu S, Qi L, Qin HF, et al. Path aggregation network for instance segmentation. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 8759–8768.

|

| [20] |

Zheng ZH, Wang P, Liu W, et al. Distance-IoU loss: Faster and better learning for bounding box regression. Proceedings of the 34th AAAI Conference on Artificial Intelligence, AAAI 2020, the 32nd Innovative Applications of Artificial Intelligence Conference, IAAI 2020, the 10th AAAI Symposium on Educational Advances in Artificial Intelligence. New York: AAAI Press, 2020: 12993–13000.

|

| [21] |

Rezatofighi H, Tsoi N, Gwak JY, et al. Generalized intersection over union: A metric and a loss for bounding box regression. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 658–666.

|

| [22] |

Chollet F. Xception: Deep learning with depthwise separable convolutions. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 1800–1807.

|

| [23] |

Tan MX, Le QV. EfficientNet: Rethinking model scaling for convolutional neural networks. Proceedings of the 36th International Conference on Machine Learning. Long Beach: PMLR, 2019. 6105–6114.

|

| [24] |

Zhang HY, Wang Y, Dayoub F, et al. VarifocalNet: An IoU-aware dense object detector. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 8510–8519.

|

| [25] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 770–778.

|

| [26] |

Ge Z, Liu ST, Wang F, et al. YOLOX: Exceeding YOLO series in 2021. arXiv:2107.08430, 2021.

|

2023, Vol. 32

2023, Vol. 32