在斯隆数字巡天任务中, 准确定位和识别天文图像中的小尺度天体是获取其物理信息的关键, 对探索天体形成和演化有着重要的意义. 传统的天文目标检测方法[1]是通过设置阈值将目标从背景中提取出来, 算法简单容易操作. 但面对小目标时, 合适阈值的确定需要人为参与反复试验, 时间效率低, 自动化程度不够.

随着计算机算力不断地提升, 大规模数据的涌现, 基于深度学习的目标检测技术逐渐替代传统的人工提取特征的方式成为主流. Girshick等人率先提出基于深度学习的目标检测算法R-CNN[2], 且一出现就占据了主流. 之后, Girshick又提出了Fast R-CNN目标检测网络[3], 优化了网格结构, 将目标分类和候选框回归同步进行, 不仅大幅度提升了速度而且精度也有所提升. Redmon等人提出YOLO目标检测网络[4], 极大地提升了检测速度. Liu等人2015年提出了SSD目标检测网络[5], 将候选框的回归和检测直接在多个尺寸的特征图上进行, 在检测速度与精度上达到了均衡.

基于深度学习的目标检测算法模型通常是针对通用目标数据集设计的, 大多针对具有一定尺寸或比例的大中型目标[6], 对小目标的关注程度不够, 难以适用于复杂背景下的小目标检测. 在实际的天文应用场景中目标检测算法面临着更大的挑战, 根据国际光学工程学会定义, 小目标是指在256×256像素的图像中, 成像面积小于80像素的目标, 即目标尺寸小于原图的0.12%则认为是小目标. 然而, SDSS天文图像大小为2048×1489像素, 像素值跨度较大, 相比于常用的数据集, 面积小于100像素的目标在天文图像中面积占比远远小于0.12%, 观测难度和检测难度更大[7]. 更重要的是, 天文图像中目标繁杂, 差异较大, 体积大亮度高的天体对小尺度天体的检测造成极大干扰.

针对上述问题, 本文选用含信息最多且噪声较少的i, r, g三波段测光图像, 并将图像切割成多个512×512子图, 降低小尺度天体的观测难度和检测难度. 提出一种基于Mask-GAN和YOLOv3的小尺度天体检测方法, 主要贡献如下: 1)基于Mask-GAN的干扰天体屏蔽. 首先设计了一种面向天文图像的特定目标Mask构建算法, 利用自适应阈值分割和连通域分析获取干扰目标区域, 并提出各波段分割区域特征扩充和邻近目标排除方式构建干扰目标Mask, 改进了以往分割方法运用到天文图像时出现光晕残留和邻近目标错误分割问题. 其次, 构建基于门控卷积的GAN模型, 结合干扰天体Mask完成屏蔽干扰任务, 避免当前目标检测算法在检测小目标时受到体积较大亮度较高的天体干扰. 2)基于改进YOLOv3的小尺度天体检测. 构建一个融合CBAM (convolutional block attention module)[8]注意力模块的EfficientNet模型作为YOLOv3[9]的主干特征提取网络, 加强了网络的特征提取能力, 并扩展4个有效特征层更多地利用浅层特征信息检测小尺度天体. 3)提出一种浅层特征图注意力机制SAt (shallow feature maps attention mechanism)提升浅层特征图权重, 加大网络对小目标关注的同时更好地利用浅层特征图丰富的细节信息检测小目标.

1 相关工作 1.1 目标检测算法传统的天文目标检测方法首先对图像背景和背景噪声初始估计, 之后对图像进行背景减法, 利用图像的灰度特征设置阈值来检测目标, 获取目标的物理信息. 方法需要进行多次试验才能找到一个合适的阈值将目标提取出来, 时效性差, 容易出现遗漏错检的现象, 在面对海量数据时自动化程度不够. 随后, 有大量研究者提出了各类开源软件用于检测星体和提取星体信息. SourceExtractor以其处理速度快、输出参数灵活等优点在深度巡天中得到了良好的发展与广泛的应用[10]. 但在提取不同类别的目标时, 参数设定存在较大的差异, 很难在目标的检测能力和分解能力之间达到平衡. 近年来, 基于深度学习的目标检测技术取得了巨大的进步, 然而, 小目标的检测任务仍然面临着巨大的困难和挑战[11], 检测任务的多样性和复杂性导致算法在实际应用中面临着更大的挑战, 相关算法研究缺乏通用性, 难以迁移到其他应用场景下的小目标检测任务.

1.2 基于GAN图像孔洞填充图像修复[12]也称为图像补全或图像孔洞填充, 是在缺失区域内合成可替代的内容的任务, 在视觉上达到真实效果并在语义层面上正确. 图像修复可以看作是一种图像生成任务, 填充图像中的缺失区域, 生成缺失的像素. 生成对抗网络GAN[13]是一种由生成网络和判别网络构成的具有对抗思想的深度生成式模型, 是非监督式学习的一种方法. 通过生成器与判别器之间相互博弈的方式进行学习, 相互优化, 生成以假乱真的样本. 该特性使得生成对抗网络非常契合图像修复, 因此基于生成对抗网络的图像修复技术得到了广泛的运用. 但是, 传统卷积通常将图像的所有像素都当作有效值计算且感受野十分有限, 不能有效地建立破损区域和远离其较远的完好区域之间的联系, 导致目标区域与周围区域不连贯和边界变形的问题. Yu等人[14]提出的门控卷积在所有层的每个空间位置为每个通道提供可学习的动态特征选择机制在一定程度上缓解了上述问题.

目前, 由于很难收集大量成对的真实受损图像, 科研人员在进行图像修复实验时往往选择合适的图像数据集, 然后在原始数据中随机添加矩形掩模或不规则掩模. 然而, 在实际的天文应用场景中, 为了移除图中特定天体, 必须针对特定目标设计一种掩模构建算法, 以完成特定区域的修复任务.

2 方法 2.1 基于Mask-GAN的干扰目标移除 2.1.1 干扰天体Mask构建算法屏蔽干扰的关键就在于如何获取干扰目标. 传统天文目标检测和图像分割都是基于固定阈值的, 需要人为多次试验才能确定一个合适的阈值将感兴趣的目标分割出来, 在面对大规模的数据集时, 不仅时效性差而且自动化程度不够.

因此, 为了提升效率, 降低天文图像中复杂背景噪声的影响, 首先对图像进行高斯滤波处理, 其次根据图像的灰度特性, 求出图像最大和最小灰度值

| $ {T_0} = ({c_{\max }} + {c_{\min }})/2 $ | (1) |

根据

| $ {T_{k + 1}} = ({c_{{\rm{obj}}}} + {c_{{\rm{bkg}}}})/2 $ | (2) |

如此反复迭代, 直到

|

图 1 自适应阈值分割 |

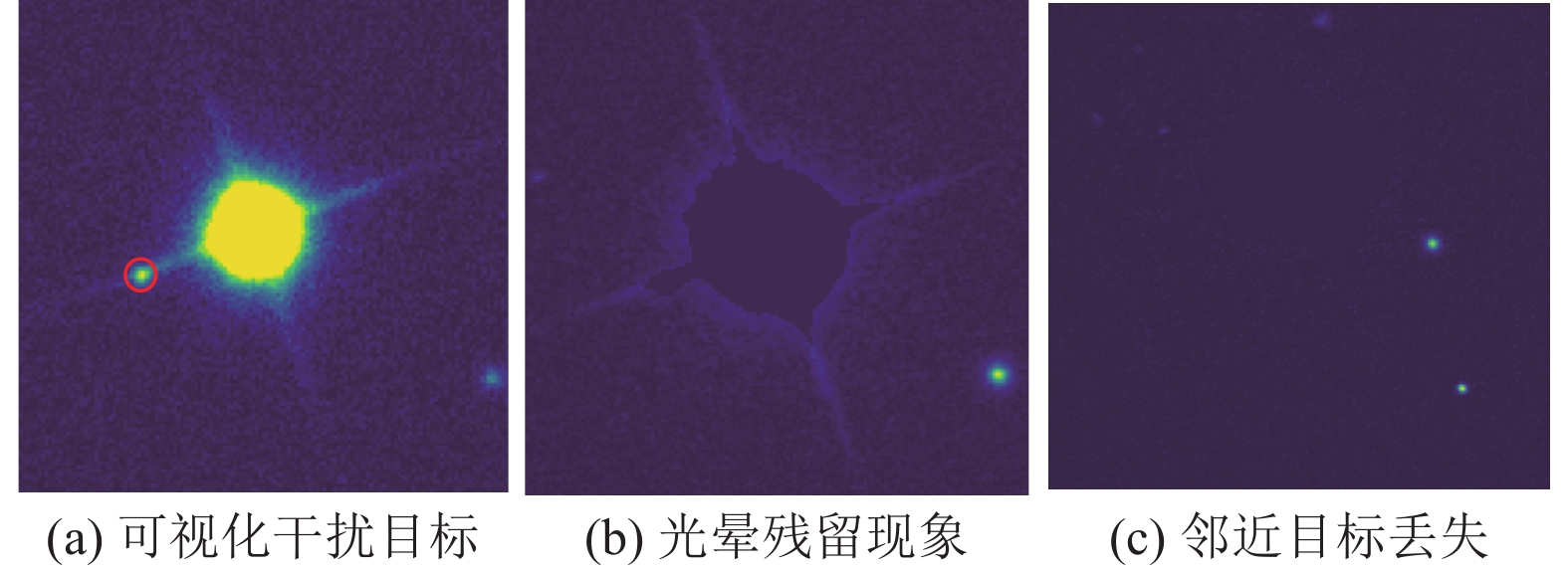

由于天体周围伴有光晕, 传统的图像分割在分割天文图像时存在一定的局限性, 容易产生光晕残留或边缘伪影现象, 如图2(b)所示. 此外, 如图2(c)所示, 天体图像中目标聚集, 图像分割具有局限性, 容易将邻近干扰目标的非干扰目标划分到同一分割区域, 导致移除干扰目标时, 错误地将邻近目标屏蔽, 造成邻近目标丢失现象, 图2(a)为干扰目标, 圆圈标记为邻近非干扰目标. 因此, 本文提出分割区域扩充和邻近目标排除方法进行优化以避免上述问题.

|

图 2 光晕残留和邻近目标丢失 |

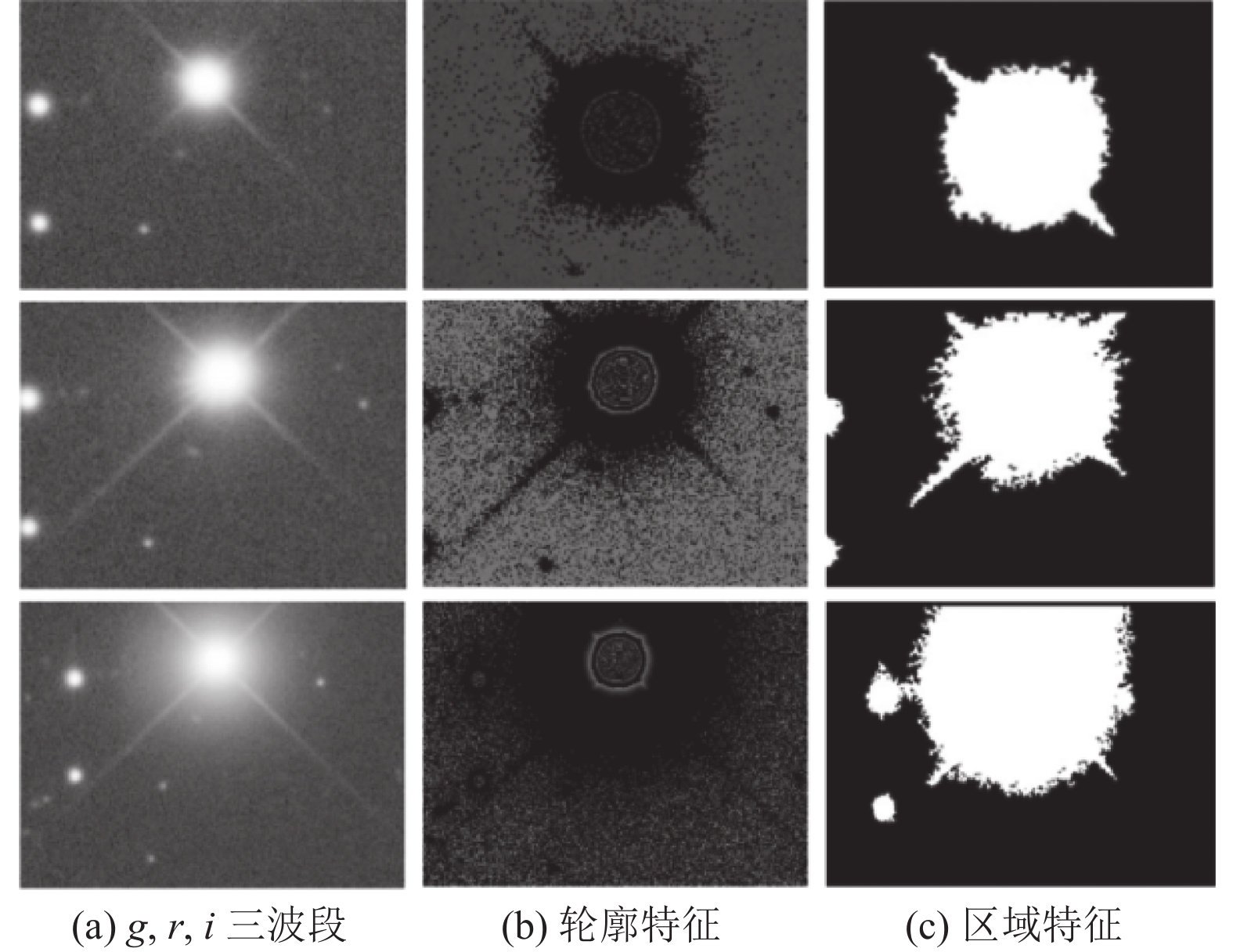

1)分割区域扩充. SDSS天文数据是由不同滤镜拍摄生成的不同波段图像, 同一星体在不同波段中成像效果不同, 如图3所示, 亮度较高并伴有较强光晕的干扰星体, 在g, r, i三种滤镜拍摄下其光晕强度、范围大小和轮廓特征不同, 对应Mask中目标分割区域特征也不同. 为了得到更好的前景与背景分割效果, 将各个波段的Mask相加:

| $ {M_n} = M_n^g + M_n^r + M_n^i,\; n = 1, 2, \cdots, N $ | (3) |

得到一个融合各波段轮廓特征和分割区域特征的二进制单通道掩模

|

图 3 不同波段同一天体 |

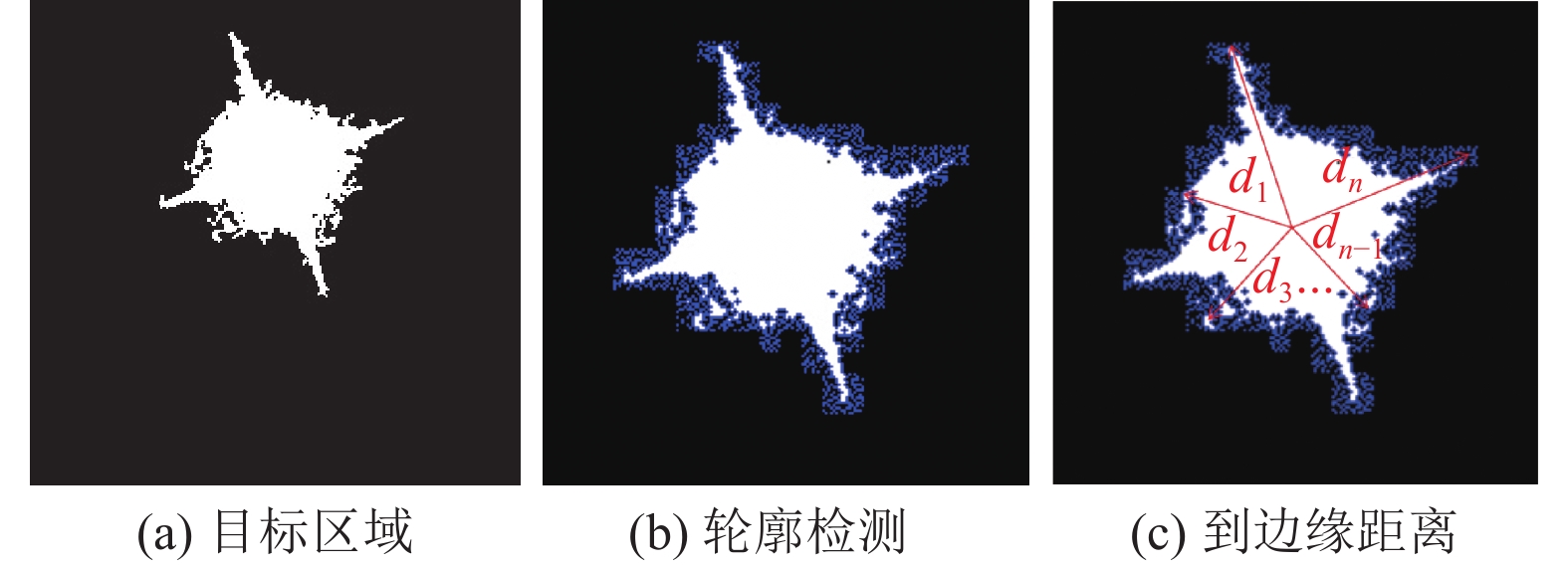

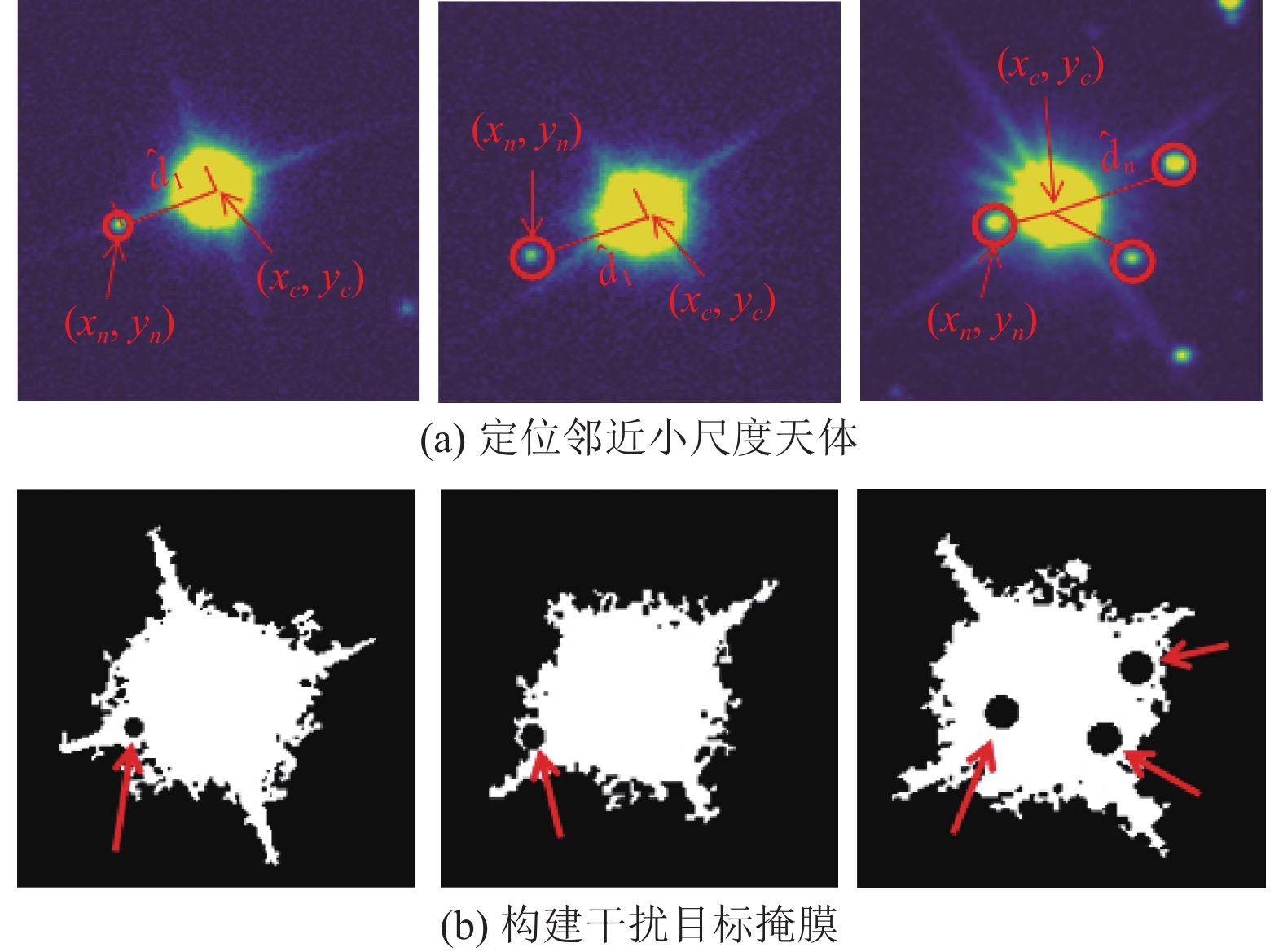

2)邻近目标排除. 为了避免邻近目标丢失影响目标检测结果, 需要进行邻近目标排除. 首先利用干扰目标的峰值像素坐标估计干扰目标质心

| $ {d_n} = \sqrt {{{({x_c} - {x_n})}^2} + {{({y_c} - {y_n})}^2}} ,\; n = 1, 2, \cdots, N $ | (4) |

| $ D = \max ({d_1}, {d_2}, \cdots, {d_N}) $ | (5) |

|

图 4 干扰区域质心到边缘距离 |

根据D来确定一个邻近范围, 检测在此范围内存在的目标, 认为是容易受到分割影响而被错误屏蔽的邻近目标. 具体为利用源检测算法[17]检测干扰目标之外的天体, 获得其质心坐标

| $ {\hat d_n} = \sqrt {{{({x_c} - {{\hat x}_n})}^2} + {{({y_c} - {{\hat y}_n})}^2}} ,\; n = 1, 2, \cdots, N $ | (6) |

满足

|

图 5 避免丢失邻近小尺度目标 |

算法1. 干扰天体Mask构建算法

输入: SDSS单波段图像

输出: 干扰目标掩膜

1. 确定阈值T;

2. 阈值分割;

3. 二值化图像;

4.if 组成像素数n >100 and像素值>T:

5. 提取干扰目标区域;

6. 区域扩张:

7. 区域轮廓检测, 统计轮廓点坐标

8. 计算干扰区域中心坐标

9. 源检测算法获得其余目标的坐标

10.

11.

12.

13. if

14. 获取邻近目标区域;

15. 将邻近目标区域从干扰目标区域排除;

16. return 干扰目标掩膜

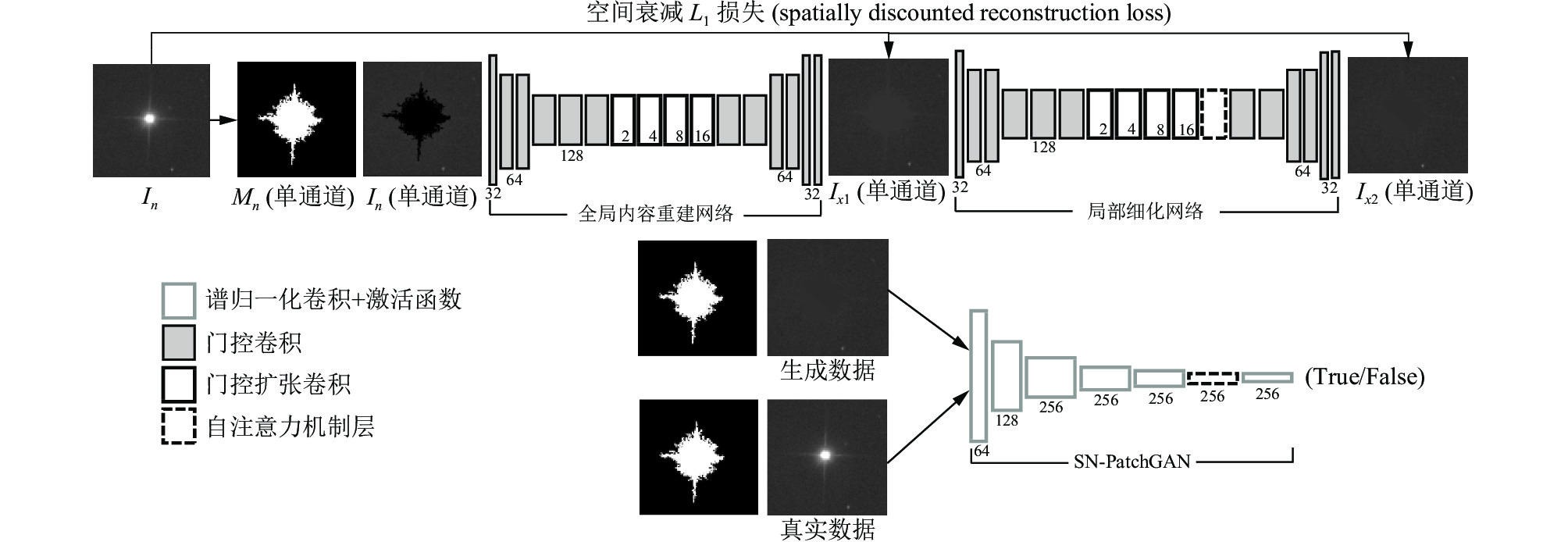

在实际场景中的图像修复的应用更多在于去除图中不想要的部分. 本文基于编码器-解码器的形式, 构建了一个GAN模型, 结合构建的干扰天体Mask来完成天文图像的干扰屏蔽任务. 生成网络分为全局内容重建网络和局部细节修复网络, 由门控卷积模块, 门控扩张卷积模块和空间注意力机制模块搭建而成. 全局重建主要用于获取全局特征, 生成一个粗糙的修复结果. 局部细节修复主要用于把握局部特征, 细化全局重建结果. 由于所移除的天体面积较大, 形状不规则, 传统卷积无法较好地补全其对应的缺失区域并且容易将图像的所有像素都当成有效值去计算, 故引入门控卷积避免以上问题. 门控扩张卷积通过逐层增大感受野来提升修复效果. 判别器按照PatchGAN结构[18]构建, 通过对天文图像局部区域进行差别判断, 更好地关注图像细节, 有利于修复缺失区域. 此外对每个标准卷积层进行谱归一化[19]提高训练的稳定性.

全局内容重建网络结构包括11个门控卷积层, 4个门控扩张卷积层以及2个反卷积层. 局部修复网络结构与全局网络结构相似, 不同的是加入自注意力机制. 如图6所示, 首先, 通过式(7)将干扰天体区域去除, 生成缺失图像

| $ {I'_n} = {I_n} \otimes (1 - {M_n}) $ | (7) |

其中,

| $ {I_{x1}} = {I'_n} + {I_{x1}} \otimes {M_n} $ | (8) |

之后将

| $ {I_{x2}} = {I'_n} + {I_{x2}} \otimes {M_n} $ | (9) |

式(8)和式(9)均保留原巡天图像的非修补区域, 仅对缺失的干扰天体区域进行修补. 最后, 将真实数据

|

图 6 生成对抗网络模型 |

本工作是利用图像修复技术移除体积较大亮度较高的天体并对缺失区域进行填充, 一个可行的修复结果可能会和原始图像差距很大, 如果只用原始图像作为唯一衡量标准是不合理的, 因此使用空间衰减损失L1作为重构损失, 计算为:

| $ {L_1} = {\gamma ^l} \times {M_n} \times [{\left\| {{I_n} - {I_{x1}}} \right\|_1} + {\left\| {{I_n} - {I_{x2}}} \right\|_1}] $ | (10) |

其中,

| $ {L_D} = E[ReLU(1 - D({I_n}, {M_n}))] + E[ReLU(1 + D({I_{x2}}, {M_n}))] $ | (11) |

| $ {L_G} = - E[D({I_{x2}}, {M_n})] + {L_1} $ | (12) |

其中, G为生成器, D为判别器,

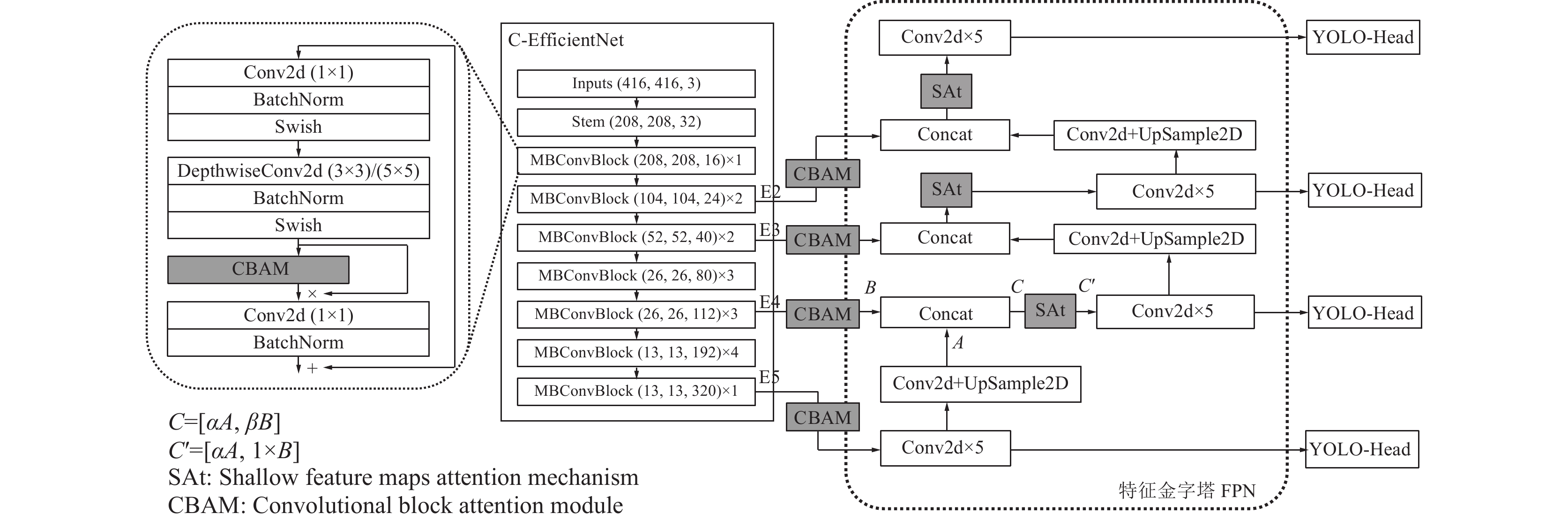

YOLOv3是一种经典的基于深度卷积神经网络目标检测算法, 由3个主要组成部分组成: 主干特征提取网络Darknet53、特征融合结构FPN和特征预测YOLO-Head. 特征提取的好坏直接影响网络的预测效果, 为了加强主干网络的特征提取能力, 提取到更好的小尺度天体特征, 获得更好的检测效果, 通常采用的方式有增加网络的深度, 网络的宽度和图像的分辨率. EfficientNet从以上3个方面同时拓展网络特性, 很好地平衡了分辨率, 深度和宽度这3个维度.

因此, 本文基于经典的YOLOv3模型, 采用EfficientNet模块并用CBAM注意力模块代替原有的SE模块, 从图像空间和通道两方面同时确定注意力区域, 构建一个C-EfficientNet结构作为YOLOv3主干特征提取网络, 如图7所示, 更好地抑制复杂天文背景下的无关信息, 提升网络对小尺度天体的关注度, 加强网络的特征提取能力. 图8所示为CBAM模块结构, 前半部分为通道注意力机制, 对输入特征图的高、宽进行处理并对每一个通道分配权重; 后半部分为空间注意力机制, 对特征层每一个特征点分配权重.

|

图 7 目标检测网络模型 |

|

图 8 CBAM模块结构 |

尽管目标检测阶段的输入为去除体积较大亮度较高的干扰天体后的图像, 极大程度上避免了干扰, 但在剩余目标中仍然存在许多组成像素非常少的天体, 经过多次下采样后, 其特征信息已经模糊甚至丢失. 原始YOLOv3通过主干特征提取网络后, 得到3个不同尺度的有效特征层进行目标物体的检测, 但是浅层特征分辨率高, 细节特征信息丰富更利于检测小目标, 对于检测小尺度天体而言, 仅利用3个尺度的有效特征层并不能充分利用浅层特征信息, 会导致部分目标信息丢失. 因此, 为了达到较好的检测效果, 本文提取EfficientNet中的4个有效特征层E2、E3、E4、E5作为检测分支结构, 并在此之后也加入CBAM注意力模块, 作为特征融合部分的输入进行之后的跨尺度连接和特征融合. 虽然多加了一个特征层, 增加了参数和计算量, 但是EfficientNet模块中的深度可分离卷积Depthwise-Conv2d大幅度地减少了网络的参数量, 很好地平衡了这个问题.

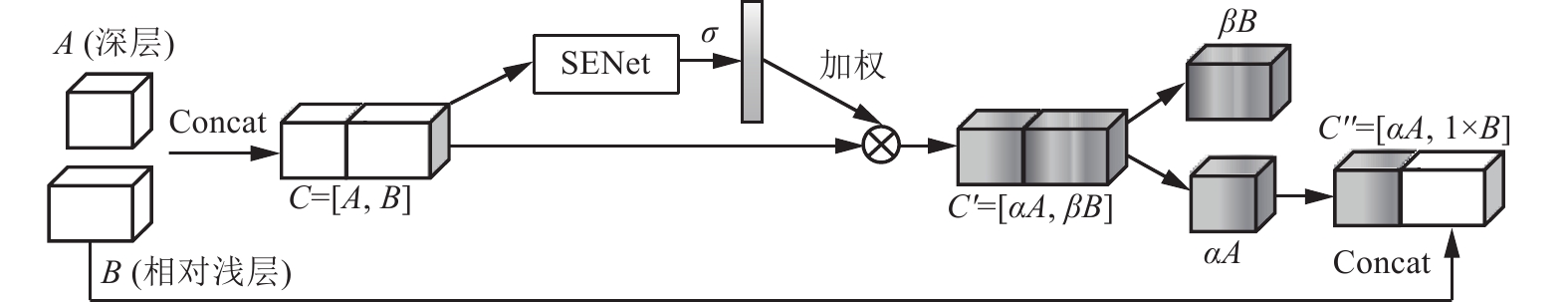

在特征融合部分, 本文提出一种浅层特征图注意力机制SAt, 通过提升浅层特征图权重, 让网络更好地利用浅层特征图的细节特征、较小的感受野检测小尺度天体. 如图9所示, 由于深层P5和浅层P4经过卷积和上采样操作得到特征图A与B, 之后进行通道上的拼接得到C:

| $ C = \left[ {A, B} \right] $ | (13) |

|

图 9 浅层特征图注意力机制SAt |

故在完成由深到浅的特征融合后加入通道注意力机制模块SENet (squeeze-and-excitation network)[20]. 预测各个通道的重要程度分配取值范围0到1的权重

| $ C' = [\alpha A, \beta B] $ | (14) |

其中,

| $ C'' = [\alpha A, 1 \times B] $ | (15) |

变相地加大浅层特征图B的权重, 而保持A的权重不变, 提升网络对浅层特征的关注, 其中权重

本文中所使用的数据集来源于SDSS发布DR16版本的测光图像数据, 图像为单通道, 大小为2048×1489. 选用包含信息最多且噪声较少的i, r, g三个波段测光图像共计900张, 每个波段300张. 将每幅图像切割成12个512×512大小的子图, 每个波段共计3 600张子图作为本实验的数据集. 构建各个子图的干扰目标Mask后, 分别训练i, r, g三个波段图像的GAN网络模型, 生成各自的修复图像. 由于SDSS各波段图像为单通道图像, 相对于3通道图像, 目标携带的特征信息较少, 因此, 在目标检测阶段, 将处理过后的i, r, g三波段子图合成RGB图像增加目标的特征信息. 通过8:2的比例将数据集分为训练集和测试集, 并根据星表记录的天体信息, 将小尺度目标标记为恒星与星系两个类别. 由于各波段之间存在一定的偏移, 直接合成是会出现各个波段图像无法对齐的现象, 本文以g波段的坐标系为标准将三者对齐.

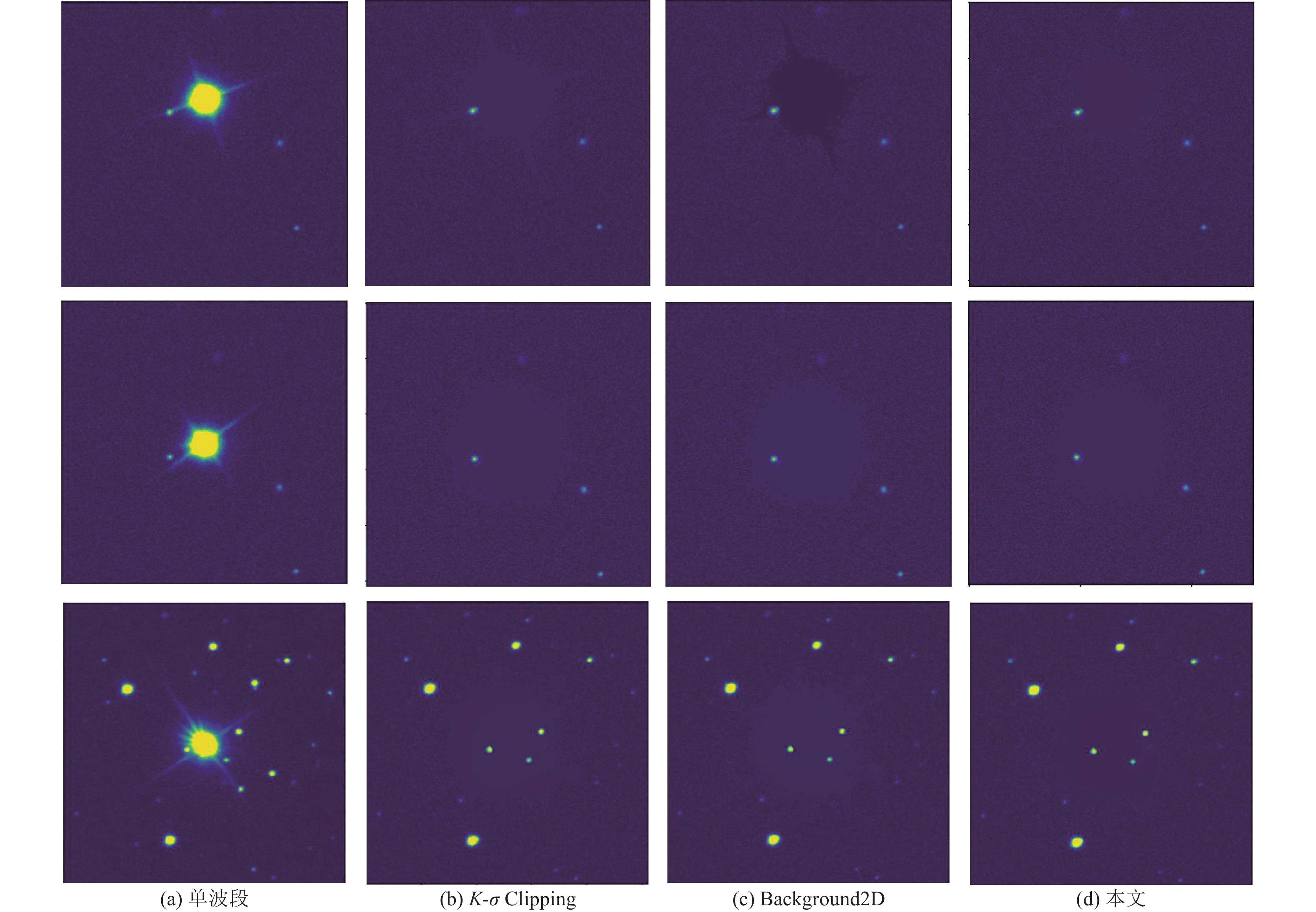

3.2 目标屏蔽与区域填充实验分析天文背景估计方法用于估计图像背景和背景噪声, 构建的二维背景图可以用于缺失区域的填充. 常用的方法有: K-σClipping方法[21]和二维背景估计法Back-ground2D[22]. 前者是通过反复迭代直到所有像素收敛到定范围之内, 最终直接用区域均值或是众数近似背景值. 后者考虑到背景和背景噪声在整个图中的变化, 将图像分为若干子区域, 对子区域进行背景和背景噪声估计生成的二维图像.

本文通过与传统的天文背景估计方法做比较, 从图像的主观效果和客观指标上对本文方法进行评估. 图10所示为利用K-σClipping方法、Background2D背景估计法以及本文生成对抗模型对图像的填充效果. K-σClipping和Background2D方法虽不会造成严重失真, 但区域边缘过渡效果并不自然, 视觉效果突兀, 存在明显修复痕迹, 图像整体连贯性较差. 相比而言, 本文方法对缺失区域的填充效果良好.

在客观指标上, 以峰值信噪比PSNR (peak signal-to-noise ratio)和结构相似性SSIM (structural similarity index measure)作为评价指标来定量衡量方法效果. PSNR基于对应像素点之间的误差, 是一种使用广泛的图像客观评价标准, 数值越大, 修复结果越好. SSIM是一种衡量图像之间相似性的指标, 取值范围是0到1, 数值越大, 代表两个图像越相似. 本实验计算了3种方法在g, r, i三个波段图像数据修复中PSNR和SSIM的平均值, 结果如表1所示.

相比于传统方法, 本文方法在上各项评价指标上达到了最优. 这表明, 本文基于深度学习构建的生成对抗模型在填充缺失区域任务中达到了修复痕迹自然, 区域边缘过度平滑, 视觉逼真的效果. 这是因为生成网络采用由粗到细两个阶段进行内容重建, 既考虑了全局特征也做到了局部细化, 保证了图像整体结构的统一. 此外, 门控扩张卷积增大感受野, 门控卷积使网络具有动态特征选择能力, 这些提升了网络的修复能力. 分析各波段的数据指标发现, 由于不同波段背景噪声复杂程度不同, 导致不同波段图像评价指标存在差异, 其中g波段指标较高.

3.3 目标检测消融实验分析为了验证各模块有效性, 本文进行消融实验. 实验结果如表2所示, 使用EfficientNet代替原始YOLOv3的主干特征提取网络并用CBAM模块代替MBconv-Block中原有的SE模块, 同时在有效特征层之后也添加CBAM模块, 结合空间与通道注意力机制, 提升网络对目标的关注, 加强网络的特征提取能力, 相比原始YOLOv3模型, 在mAP上提升了2.13%. 多增加一个特征层分支E2, 能更多地利用浅层分辨率高、细节特征信息丰富的优点检测小尺度天体, 在mAP上又提升了1.04%. 在特征融合之后, 提出了一种基于通道注意力机制的提升浅层特征图权重方式SAt, 加大网络对浅层信息的关注, 提升小目标检测效果, 在mAP上又提升了1.08%. 利用Mask-GAN模块有效地屏蔽了体积较大亮度较高的天体, 在改进的YOLOv3模型上mAP又提升了2.63%, 由此证明该模块有效地避免了复杂的天文环境对小尺度天体的检测造成的干扰.

|

图 10 缺失区域的填充效果 |

| 表 1 图像修复质量评价指标 |

| 表 2 消融实验结果(%) |

3.4 目标检测对比实验分析

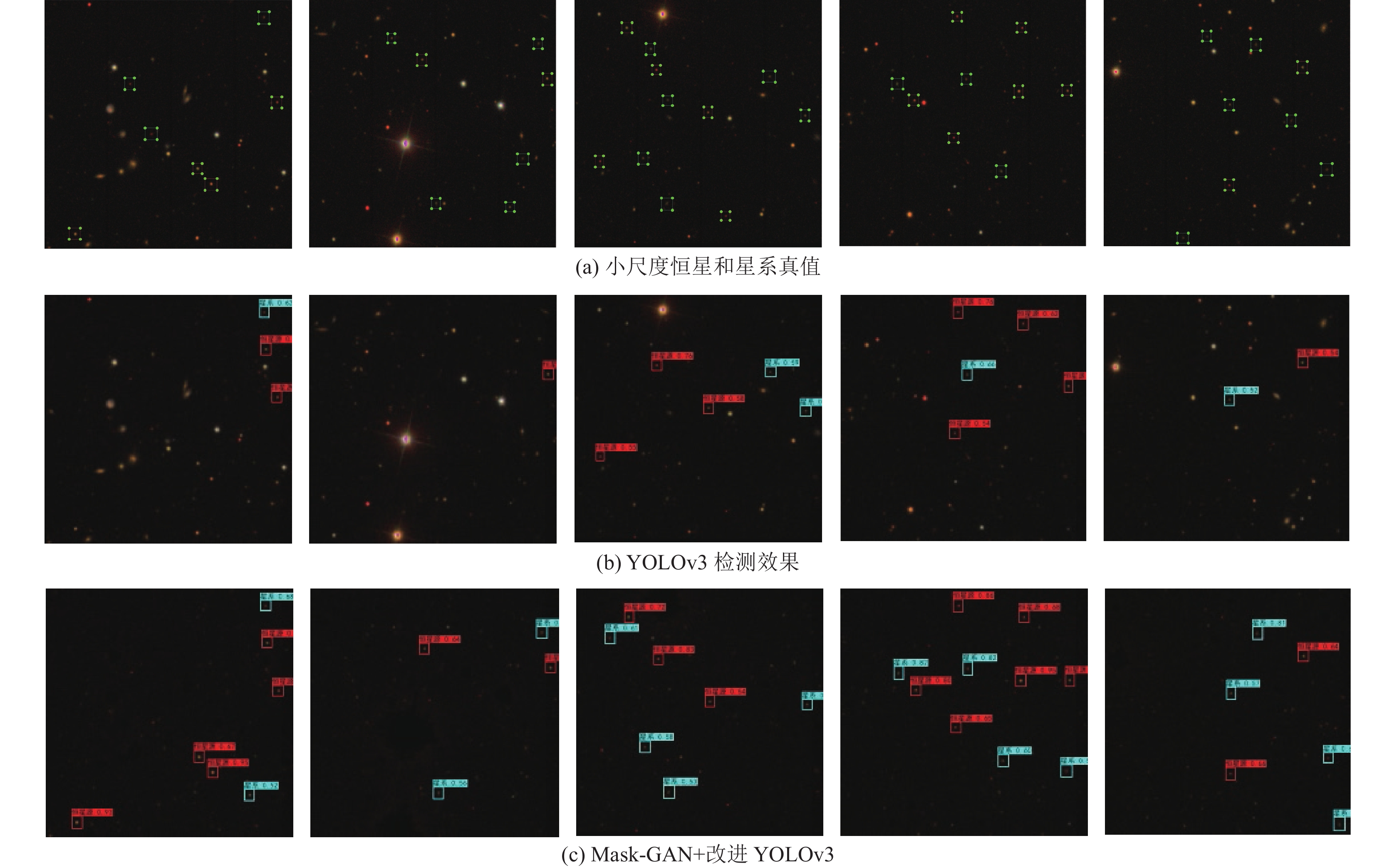

在真实天文数据集上, 将本文模型与Faster R-CNN, SSD, YOLOv3, YOLOv4进行实验对比, 以验证本文模型的效果. 从表3可以看出Faster R-CNN虽然引入区域生成网络RPN (region proposal network)和感兴趣区域池化RoI (region of interest pooling), 但在天文图像中小尺度目标的检测, 无论是召回率还是精确度都较差. SSD虽然在检测精度上有了大幅度提升, 但是在小目标的召回率和平均精度方面仍然较低, 也不适用于本项任务. YOLOv3在特征提取部分采用了Darknet53网络结构, 在特征利用部分构建了特征金字塔(FPN), 可以看出小尺度天体的检测效果有了的明显的提升. YOLOv4作为YOLOv3改进版, 在检测目标召回率上有了些许的提升, 平均精度基本与YOLOv3持平. 本文的方法极大程度上减少了干扰目标对目标检测的影响, 使检测网络更多关注于图中小尺度星系; 并引入了有较强特征提取能力的网络以及注意力机制, 提升了网络对目标特征的提取能力; 同时更好地利用浅层特征信息提升小目标的检测效果, 在本数据集上检测效果最好. 检测效果如图11所示, 验证了本文方法在检测天文图像中小尺度星系的实用性和高效性. 由于小尺度星系表面亮度较弱, 相对于恒星特征不明显, 检测难度更大, 故其召回率和平均精度相比恒星要低.

| 表 3 算法性能对比(%) |

|

图 11 本文方法实验验证结果 |

4 总结

传统的天文目标检测方法自动化程度差, 且SDSS天文图像中体积较大, 亮度较高的天体对小尺度目标的检测造成了极大干扰, 当前目标检测算法的检测效果并不理想. 针对上述问题, 本文提出了一种基于Mask-GAN的干扰屏蔽方法, 并构建了一个基于EfficientNet网络的YOLO模型, 加强网络的特征提取能力; 利用注意力机制和提升浅层特征图的权重来加大网络对目标的关注度. 在SDSS天文数据集上与其他经典目标检测算法相比, 本文提出的方法具有较好的检测效果. 但由于真实的天文图像中背景信息复杂, 对一些表面亮度较低的目标检测效果不好, 因此, 未来工作将着重研究如何降低复杂背景及背景噪声对检测的干扰, 以及在小尺度天体的特征加强方面进行更多探索.

| [1] |

Zheng CX, Pulido J, Thorman P, et al. An improved method for object detection in astronomical images. Monthly Notices of the Royal Astronomical Society, 2015, 451(4): 4445-4459. DOI:10.1093/mnras/stv1237 |

| [2] |

Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation. Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus: IEEE, 2014. 580–587.

|

| [3] |

Girshick R. Fast R-CNN. Proceedings of the 2015 IEEE International Conference on Computer Vision. Santiago: IEEE, 2015. 1440–1448.

|

| [4] |

Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 779–788.

|

| [5] |

Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector. Proceedings of the 14th European Conference on Computer Vision. Amsterdam: Springer, 2016. 21–37.

|

| [6] |

Kisantal M, Wojna Z, Murawski J, et al. Augmentation for small object detection. arXiv:1902.07296, 2019.

|

| [7] |

Du Buisson L, Sivanandam N, Bassett BA, et al. Machine learning classification of SDSS transient survey images. Monthly Notices of the Royal Astronomical Society, 2015, 454(2): 2026-2038. DOI:10.1093/mnras/stv2041 |

| [8] |

Woo S, Park J, Lee JY, et al. CBAM: Convolutional block attention module. Proceedings of the 15th European Conference on Computer Vision (ECCV). Munich: Springer, 2018. 3–19.

|

| [9] |

Redmon J, Farhadi A. YOLOv3: An incremental improvement. arXiv:1804.02767, 2018.

|

| [10] |

Annunziatella M, Mercurio A, Brescia M, et al. Inside catalogs: A comparison of source extraction software. Publications of the Astronomical Society of the Pacific, 2013, 125(923): 68-82. DOI:10.1086/669333 |

| [11] |

Nguyen ND, Do T, Ngo TD, et al. An evaluation of deep learning methods for small object detection. Journal of Electrical and Computer Engineering, 2020, 2020: 3189691. DOI:10.1155/2020/3189691 |

| [12] |

Elharrouss O, Almaadeed N, Al-Maadeed S, et al. Image inpainting: A review. Neural Processing Letters, 2020, 51(2): 2007-2028. DOI:10.1007/s11063-019-10163-0 |

| [13] |

Goodfellow I, Pouget-Abadie J, Mirza M, et al. Generative adversarial networks. Communications of the ACM, 2020, 63(11): 139-144. DOI:10.1145/3422622 |

| [14] |

Yu JH, Lin Z, Yang JM, et al. Free-form image inpainting with gated convolution. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 4470–4479.

|

| [15] |

Zou YL, Zhao JY, Wu YH, et al. Segmenting star images with complex backgrounds based on correlation between objects and 1D Gaussian morphology. Applied Sciences, 2021, 11(9): 3763. DOI:10.3390/app11093763 |

| [16] |

Arbeláez P, Maire M, Fowlkes C, et al. Contour detection and hierarchical image segmentation. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(5): 898-916. DOI:10.1109/TPAMI.2010.161 |

| [17] |

Longmore SN, Collins RP, Pfeifer S, et al. Adapting astronomical source detection software to help detect animals in thermal images obtained by unmanned aerial systems. International Journal of Remote Sensing, 2017, 38(8–10): 2623–2638.

|

| [18] |

Isola P, Zhu JY, Zhou TH, et al. Image-to-image translation with conditional adversarial networks. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 1125–1134.

|

| [19] |

Miyato T, Kataoka T, Koyama M, et al. Spectral normalization for generative adversarial networks. arXiv:1802.05957, 2018.

|

| [20] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 7132–7141.

|

| [21] |

Bonaldi A, An T, Brüggen M, et al. Square kilometre array science data challenge 1: Analysis and results. Monthly Notices of the Royal Astronomical Society, 2021, 500(3): 3821-3837. DOI:10.1093/mnras/staa3023 |

| [22] |

Gagliano A, Narayan G, Engel A, et al. Ghost: Using only host galaxy information to accurately associate and distinguish supernovae. The Astrophysical Journal, 2021, 908(2): 170. DOI:10.48550/arXiv.2008.09630 |

2023, Vol. 32

2023, Vol. 32