近年来人工智能技术不断发展, 从人工神经网络到卷积神经网络再到Transformer架构, 深度学习模型在生活中有着越来越广泛的运用. 但是, 研究者发现深度神经网络非常容易受到对抗样本的威胁[1, 2], 大量研究表明, 通过给良性样本添加特定的微小扰动制作成对抗样本在不引起人警觉的情况下可以轻易地欺骗模型, 从而产生大相径庭的预测结果. 攻击者可以通过伪造人脸图片来欺骗人脸识别模型从而非法入侵个人账户, 通过发射激光就可以攻击基于AI视觉的自动驾驶汽车[3]. 制作攻击性更强、隐蔽性更高的对抗样本是对抗学习研究的一个重要方向, 有利于评估网络模型的鲁棒性和安全性, 并促进更加强大的防御方法的开发.

根据攻击过程中掌握目标模型知识的程度可以将现有的对抗攻击方法分为白盒攻击和黑盒攻击[4]. 在白盒攻击方式中, 攻击者具有目标模型的完整知识, 可以分为基于梯度的攻击, 如FGSM[2]、PGD[5], 基于优化的方法C&W[6]和基于生成对抗网络的攻击. 而黑盒攻击有很大限制, 攻击者无法访问模型细节, 只能查询访问的结果, 攻击难度更高, 在现实中更普遍. 黑盒攻击的一种实现方式是基于对抗样本迁移性实现迁移攻击, 以白盒攻击方法攻击代理模型生成对抗样本来获得对黑盒模型的欺骗. 提高模型的迁移性的优化方向主要有3类, 包括优化标准目标(FGSM、PGD)、修改注意力 (AOA[7]、ATA[8])和平滑梯度(DI[9]、TI[10]).

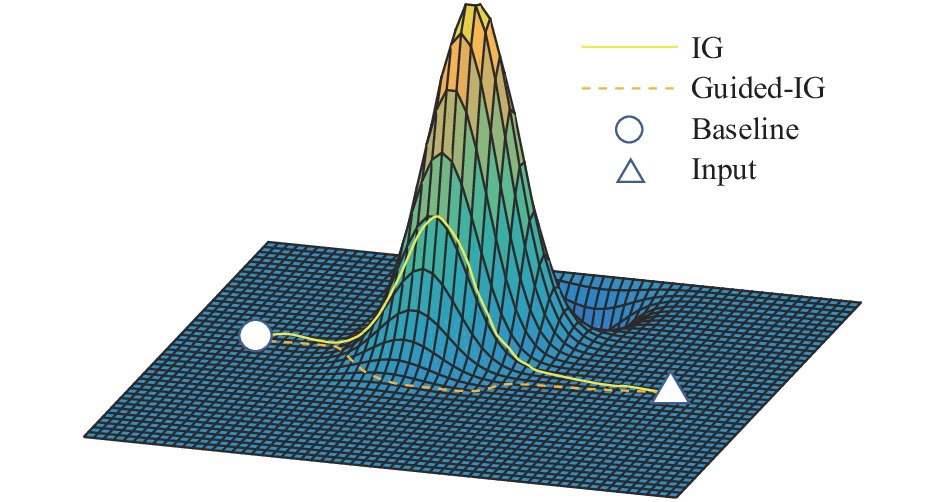

现有算法迁移攻击效果普遍不佳, Huang等人[11]将积分梯度(integrated gradient, IG)[12]引入对抗攻击, 提出了目前最先进的TAIG算法, 证明其可以从以上3个方面同时进行攻击, 在黑盒模式下具有较强的迁移攻击成功率. TAIG-S是TAIG算法的一个标准版本, 计算从基线到目标对象直线路径上的梯度的累积, 可以有效解决梯度饱和问题, 将注意力图作为反向更新方向来生成对抗样本. 但是其采用的直线路径未经过优化, 易进入与预测结果不相关的像素从而导致误差累积, 产生无效噪声干扰, 在一定程度上损失了迁移攻击的成功率. 为了解决上诉问题, 本文将引导积分梯度(Guided-IG)[13]引入对抗攻击, 提出了Guided-TAIG方法. 具体的, 如图1所示, 在 TAIG-S算法基础上, 计算积分梯度时摒弃简单的直线计算, 沿着输入、基线和模型确定的自适应方向, 将计算生成的引导积分梯度作为对抗攻击过程中梯度的更新方向. 该算法可以过滤不相关像素的梯度误差累积, 更精细准确地找到模型最关注的特征区域, 进而生成攻击性和迁移性更强的对抗样本.

|

图 1 IG与Guided-IG积分路径示意图 |

本文贡献主要有: (1) Guided-TAIG将积分梯度的直线路径优化为自适应路径, 修正攻击过程的扰动方向, 精确攻击模型关注的区域; (2)通过大量实验验证了所提算法在白盒和黑盒两种模式下都具有明显优越性.

1 相关工作 1.1 对抗攻击对抗样本的概念最早由Szegedy等人[1]于2013年提出, 发现在输入图片中添加微小的扰动成为对抗样本, 可以使图片以高置信度被误分为其他类别. 对抗样本的生成数学描述如下.

设图像分类器为函数

| $ pred(x) = \mathop {\arg \max }\limits_i {\textit{Softmax}}(F{(x)_i}),\quad i = 1, \cdots, k $ | (1) |

假设图像的真实标签为

| $ pred({x_{{\rm{adv}}}}) \ne {y_{{\rm{true}}}},\quad {\rm{s.t.}}\quad {x_{{\rm{adv}}}} = x + \delta $ | (2) |

人类在做判断时往往选择性的关注信息的一部分, 忽略不重要的特征, 归因技术可以用来显示输入图片每个像素对最终结果的影响程度, TAIG-S首次将积分梯度用于生成对抗样本, 积分梯度是神经网络归因分析的工具, 结合了直接梯度DeepLift[14]和基于反向传播的归因技术LRP[15], 满足敏感性和不变性, 可以表明每个像素对网络输出的重要性, 从而可以作为网络的注意力. 积分梯度是从参考图像

| $ {{I}}{{{G}}_i}(f, x, r) = ({x_i} - {r_i}) \times \int_{\eta = 0}^1 {\frac{{\partial f(r + \eta \times (x - r))}}{{\partial {x_i}}}d\eta } $ | (3) |

其中,

积分梯度采用简单的直线路径, 生成的结果具有大量无效像素产生的非零梯度积分累计噪声, 这由于网络模型的曲面映射形状, 沿直线很容易穿过非均匀梯度区域. 引导积分梯度是一种自适应路径的方法, 如图1所示, 在积分梯度基础上, 舍弃固定的积分方向, 不是所有像素的增量都相等, 而是在每一步都进行选择, 选择一个像素子集, 这些像素具有不等于输入的最小绝对值, 然后下一步只移动子集中那些更接近输入图像强度的部分, 当所有像素的强度与输入一致时, 则路径更新结束.

2 基于Guided-IG的对抗样本生成方法本文提出了一种基于引导积分梯度的对抗样本生成方法Guided-TAIG, 下面详细介绍该方法的具体实现过程.

首先, 如第1.1节所描述, 定义一个映射函数

| $ {{IG}}_i^{}({X^I}) = \int_{\alpha = 0}^1 {\frac{{\partial F(\gamma (\alpha ))}}{{\partial {\gamma _i}(\alpha )}}\frac{{\partial {\gamma _i}(\alpha )}}{{\partial \alpha }}} d\alpha $ | (4) |

积分梯度用路径上每一点的梯度累积来代替单独输入一点的梯度, 可以避免进入模型饱和区梯度为0的情况. 简单的, 当积分路径是直线, 即

| $ {{IG}}({X^I}) = \sum\limits_{j = 1}^m {\sum\limits_{i = 1}^n {\frac{{\partial F(\gamma ({\alpha _j})}}{{\partial {\gamma _i}({\alpha _j})}}} ({\gamma _i}({\alpha _j}) - {\gamma _i}({\alpha _{j - 1}}))} $ | (5) |

原始的积分路径穿过非均匀的梯度区域, 路径上可能会存在着与输入无关的非零梯度方向, 随着积分的累积, 与预测结果不相关区域的梯度值不会相互抵消而会成为噪声, 由此在对抗攻击任务的过程中, 计算后的不准确的更新方向会降低生成的对抗样本的攻击性与迁移性. 而理想的积分路径

| $ {\gamma ^ * } = \arg \min \;{l_{{\rm{noise}}}} + {l_{{\rm{distance}}}} $ | (6) |

| $ {l_{{\rm{noise}}}} = \sum\limits_{i = 1}^n {\int_{\alpha = 0}^1 {\left| {\frac{{\partial F(\gamma (\alpha ))}}{{\partial {\gamma _i}(\alpha )}}\frac{{\partial {\gamma _i}(\alpha )}}{{\partial \alpha }}} \right|} } {\kern 1pt} d\alpha $ | (7) |

| $ {l_{{\rm{distance}}}} = \int_{\alpha = 0}^1 {\left\| {\gamma (\alpha ) - {\gamma ^{{\rm{cal}}}}(\alpha )} \right\|} {\kern 1pt} d\alpha $ | (8) |

其中,

在实际计算中, 采用离散化的思想进行近似, 将从基线

| $ {S}_{{\rm{tmp}}}=\left\{\right|\partial F(x)/\partial {x}_{i}\left|\right\}\text{, }\;其中,\;i\in \left\{j\right|{x}_{j}\ne {x}_{j}^{I}\} $ | (9) |

将

| $ {\left(\frac{\partial {\gamma }_{i}(\alpha )}{\partial \alpha }\right)}^{{\rm{new}}}= \left\{\begin{array}{l}{x}_{i}^{I}-{x}_{i}^{B}, \;\text{if}\;i\in S\\ 0,\; 其他\end{array}\right. $ | (10) |

令每一段的引导积分梯度为

| $ \begin{split} & {{Guided {\textit{-}} IG}}({X^I}) = \sum\limits_{j = 1}^m {\sum\limits_{i = 1}^n {{{Guided {\textit{-}} I}}{{{G}}_{j - 1, j}}} } \\ & = \sum\limits_{j = 1}^m {\sum\limits_{i = 1}^n {\frac{{\partial F(\gamma ({\alpha _j})}}{{\partial {\gamma _i}({\alpha _j})}}} {{\left( {\frac{{\partial {\gamma _i}({\alpha _j})}}{{\partial {\alpha _j}}}} \right)}^{{\rm{new}}}}({\alpha _j} - {\alpha _{j - 1}})} \end{split} $ | (11) |

图2展示了积分梯度与引导积分梯度生成的归因图, 可以看出引导积分梯度过滤了原始梯度大量的无关噪声, 模型关注的区域更加集中. 引导积分梯度更能提取直接与网络模型预测结果相关的像素的强度, 反向更改这些像素点的值可以更改输入中包含的具体某一类别的信息, 这是对抗攻击可以进行的内部原因, 并可以直接应用于高质量对抗样本的生成过程. 类比FGSM和I-FGSM[16]类型的攻击方法, 可以有以下单步攻击和多步攻击形式.

|

图 2 IG与Guided-IG归因图 |

对于输入图像

| $ {X^*} = X + \varepsilon \times sign({{Guided {\textit{-}} IG}}(X)) $ | (12) |

其中,

| $\left\{ \begin{split} & X_0^* = X_{}^I \\ & X_{i + 1}^* = Clip\left\{ {\left. {X_i^* + \frac{\varepsilon }{T} \times sign({{Guided {\textit{-}} IG}}(X_i^*))} \right\}} \right. \end{split} \right.$ | (13) |

其中,

本节设计实验来验证和分析Guided-TAIG算法生成对抗样本的效果以及该方法的参数设计和对比研究. 分别介绍实验选用的数据集、白盒模式下的攻击效果、黑盒迁移的攻击性能以及算法参数分析.

3.1 实验设计为了公正合理地评判不同攻击方法的优劣, 被测模型选择深度学习史上各阶段的经典模型VGG-16[17], ResNet-50[18] , InceptionV3 (Inc-V3)[19], EfficentNet B3 (Effi-B3)[20]. 随着深度学习的发展, 近几年Transformer架构的模型逐步展现出比传统CNN架构模型更具优势, 所以也选择了最先进的基于Transformer架构的分类模型Swin Transformer (Swin)[21]和MViTv2[22]. 并且对比了引入卷积的Transformer架构, convolutional Transformers (CvT)[23], 分别选取各种模型的版本为Swin-B, MViTv2-B和CvT-13, 所有模型均在ImageNet数据集上进行训练.

本文使用的数据集为从ImageNet[24]挑选的1 000张图片, 并且保证所有分类模型都可以正确预测结果, 这样可以忽略不同模型分类准确度的差异, 只关注对抗样本生成算法本身在不同结构模型上的攻击效果.

算法1. Guided-TAIG流程

输入: 分类模型

输出: 对抗样本

1.

2.

3. for

4.

5.

6. for

7.

8. while

9.

10.

11.

12. 寻找

13.

14.

15.

16.

17.

18.

19. end while

20. end for

21.

22.

23. end for

24. return

比较算法选择白盒攻击算法FGSM, C&W, 以及黑盒迁移性较强的攻击算法TAIG-S. 在白盒攻击中限制最大扰动像素大小

评测指标包括: (1)攻击成功率: 攻击成功样本数/总样本数量; (2)平均攻击耗时: 每个样本的平均生成时间; (3)平均噪声和: 单样本平均添加的扰动在RGB三通道绝对值的和.

实验代码采用PyTorch框架编写, 硬件平台采用两块NVIDIA GeForce RTX 3090.

3.2 白盒单步攻击首先将Guided-TAIG与流行的攻击方法进行比较, 实验限制为白盒单步攻击, 即直接攻击模型本身, 并且对原图只进行一轮扰动更新, 限定相同的最大扰动距离

| 表 1 不同攻击算法单步攻击模型的成功率(%) |

给图片添加绝对值更小的扰动可以使攻击更加隐蔽, 表2比较了不同算法平均生成的每张对抗样本中修改像素3个颜色通道绝对值的和, 记为

| 表 2 不同攻击算法单步攻击平均噪声和平均耗时 |

|

图 3 攻击CvT-13生成的对抗样本 |

3.3 黑盒迁移攻击

迁移攻击是黑盒攻击常用的攻击方式, 主要利用了对抗样本具有迁移性, 通过攻击代理模型来生成对未知模型的攻击, 不同模型都偏向于利用图片的相似特征. 固定

这部分具体检验Guided-TAIG算法中不同参数对算法性能的影响.

首先固定Guided-TAIG积分梯度划分段

| 表 3 单步攻击代理模型生成对抗样本的迁移攻击成功率(%) |

Guided-TAIG采用离散自适应的方式来计算积分梯度, 固定

在更新路径时, 选择的最小部分比例

|

图 4 不同迭代轮数T攻击成功率 |

|

图 5 不同分段数

|

|

图 6 不同比例

|

4 结论与展望

本文改进了TAIG-S算法, 引入引导积分梯度到对抗攻击, 提出了一种Guided-TAIG算法, 限制了更新路径不相关的梯度累积并分别给出了Guided-TAIG单步攻击和多步攻击的形式. 实验表明该方法对不同架构的模型都具有较强的白盒攻击成功率, 生成的对抗样本噪声更小, 更具隐蔽性. 在黑盒迁移攻击实验中取得了最好的效果, 在实际攻击中相比TAIG-S提升了0.4%–10%的成功率. 随着迭代步数的增加对实验模型较容易的达到95%以上的攻击成功率. 劣势是该算法精确计算每一小段方向, 耗时较多. 后续计划将对积分路径进行更加细致化的改进, 增强对抗样本的攻击性能.

| [1] |

Szegedy C, Zaremba W, Sutskever I, et al. Intriguing properties of neural networks. arXiv:1312.6199, 2013.

|

| [2] |

Goodfellow IJ, Shlens J, Szegedy C. Explaining and harnessing adversarial examples. arXiv:1412.6572, 2014.

|

| [3] |

Duan RJ, Mao XF, Qin AK, et al. Adversarial laser beam: Effective physical-world attack to DNNs in a blink. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 16057–16066.

|

| [4] |

Ren K, Zheng TH, Qin Z, et al. Adversarial attacks and defenses in deep learning. Engineering, 2020, 6(3): 346-360. DOI:10.1016/j.eng.2019.12.012 |

| [5] |

Madry A, Makelov A, Schmidt L, et al. Towards deep learning models resistant to adversarial attacks. arXiv:1706.06083, 2017.

|

| [6] |

Carlini N, Wagner D. Towards evaluating the robustness of neural networks. Proceedings of the 2017 IEEE Symposium on Security and Privacy (SP). San Jose: IEEE, 2017. 39–57.

|

| [7] |

Chen SZ, He ZB, Sun CJ, et al. Universal adversarial attack on attention and the resulting dataset DAmageNet. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 44(4): 2188-2197. DOI:10.1109/TPAMI.2020.3033291 |

| [8] |

Wu WB, Su YX, Chen XX, et al. Boosting the transferability of adversarial samples via attention. Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020. 1158–1167.

|

| [9] |

Xie CH, Zhang ZS, Zhou YY, et al. Improving transferability of adversarial examples with input diversity. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 2725–2734.

|

| [10] |

Dong YP, Pang TY, Su H, et al. Evading defenses to transferable adversarial examples by translation-invariant attacks. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 4307–4316.

|

| [11] |

Huang Y, Kong AWK. Transferable adversarial attack based on integrated gradients. arXiv:2205.13152, 2022.

|

| [12] |

Sundararajan M, Taly A, Yan QQ. Gradients of counterfactuals. arXiv:1611.02639, 2017.

|

| [13] |

Kapishnikov A, Venugopalan S, Avci B, et al. Guided integrated gradients: An adaptive path method for removing noise. Proceedings of the 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 5048–5056.

|

| [14] |

Shrikumar A, Greenside P, Kundaje A. Learning important features through propagating activation differences. Proceedings of the 34th International Conference on Machine Learning. Sydney: JMLR.org, 2017. 3145–3153.

|

| [15] |

Bach S, Binder A, Montavon G, et al. On pixel-wise explanations for non-linear classifier decisions by layer-wise relevance propagation. PLoS One, 2015, 10(7): e0130140. DOI:10.1371/journal.pone.0130140 |

| [16] |

Kurakin A, Goodfellow IJ, Bengio S. Adversarial examples in the physical world. arXiv:1607.02533, 2018.

|

| [17] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition. arXiv:1409.1556, 2014.

|

| [18] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 770–778.

|

| [19] |

Szegedy C, Vanhoucke V, Ioffe S, et al. Rethinking the inception architecture for computer vision. Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 2818–2826.

|

| [20] |

Tan MX, Le QV. EfficientNet: Rethinking model scaling for convolutional neural networks. Proceedings of the 36th International Conference on Machine Learning. Long Beach: PMLR, 2019. 6105–6114.

|

| [21] |

Liu Z, Lin YT, Cao Y, et al. Swin Transformer: Hierarchical vision Transformer using shifted windows. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 9992–10002.

|

| [22] |

Li YH, Wu CY, Fan HQ, et al. MViTv2: Improved multiscale vision Transformers for classification and detection. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022. 4794–4804.

|

| [23] |

Wu HP, Xiao B, Codella N, et al. CvT: Introducing convolutions to vision Transformers. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 22–31.

|

| [24] |

Deng J, Dong W, Socher R, et al. ImageNet: A large-scale hierarchical image database. Proceedings of the 2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami: IEEE, 2009. 248–255.

|

2023, Vol. 32

2023, Vol. 32