2. 青岛科技大学 大数据学院, 青岛 266061;

3. 珠海市岭南大数据研究院 时空大数据研究室, 珠海 519080

2. School of Big Data, Qingdao University of Science and Technology, Qingdao 266061, China;

3. Spatio-temporal Big Data Research Office, Zhuhai Big Data Research Institute, Zhuhai 519080, China

精确的作物分类是精准农业的共同要求, 它对精准农业中的各个方向都有着重要意义, 包括作物长势分析[1]、作物产量估计[2]、作物种植管理[3]、农田信息提取[4]等. 因此, 如何高效、精确地获取作物分布信息已成为当今精准农业的重要问题[5, 6].

长期以来, 农田的作物种植信息主要通过综合统计或抽样调查获取的, 这种方法耗时耗力、主观性强且存在时滞问题[7]. 遥感技术的出现为农作物信息调查提供了便利, 其具有分辨率高、覆盖范围广的优势, 可以为相关部门提供更准确的农田信息[4,8,9], 而目前卫星遥感主要受天气和访问周期的限制, 因此低空、灵活的无人机成为作物信息调查的重要工具之一[10, 11], 它具有成本低、不受云影响、更高的空间分辨率和可搭载特定传感器等优点[12-14].

无人机可见光图像作物分类还处于发展阶段, 使用植被指数和机器学习结合的分类方式对无人机可见光图像进行作物分类具有一定局限性. 原因是机载微型传感器采集的图像数据波段较少, 仅红、绿、蓝3个通道, 这导致光谱特征采集不足; 其次, 超高的空间分辨率带来了丰富的纹理信息, 对于具有相似纹理的作物更不易区分[15-17]. 深度学习的发展为充分利用高分辨率遥感图像中丰富的细节信息提供了保障[18], 近年来深度学习在计算机视觉领域得到广泛的应用, 其精度高, 鲁棒性好等优势为使用遥感图像进行作物识别提供新的思路[19, 20]. 目前深度学习在计算机视觉领域的应用主要在自然场景图像上, 在图像分类、目标检测等领域相较于传统数字图像处理方法展示出明显优势. 基于遥感图像与自然场景图像有很高的相似性, 以及研究人员所做工作, 说明将深度学习技术应用在作物信息获取上是可行的, 已有研究人员对深度学习方法在无人机可见光图像上的作物分类进行了研究, 如Chew等人[21]使用深度神经网络和迁移学习对卢旺达地区的无人机图像进行作物分类, 该模型在测试集上的F1指标达0.86. 虽然深度神经网络可以很好应用于无人机图像的作物分类, 但在高分辨率图像中, 特征信息往往表现为多尺度, 单尺度在作物分类的适用性方面存在较大局限性, 因为小尺度往往会关注大面积特征, 而大尺度则会关注小面积特征[22-24]. 人类视觉系统遵循目标、环境、背景观察模式, 从高分辨率图像中提取信息应该具有类似的特征. 通常用于提取高分辨率可见光遥感图像中作物空间信息分布的卷积神经网络只能将遥感图像分割成局部图像块进行单独处理, 由于没有充分考虑不同作物目标的多尺度特征以及它们所处场景的上下文信息, 直接使用同一层级的单一尺度进行作物提取或识别的方法无法最大化作物间差距. 为了充分利用上下文信息, 需要对多尺度结构及其语义信息进行实际挖掘. Transformer[25]的出现为上下文信息的提取提供了保障, 它通过多头注意力对全局依赖关系进行建模, 从而获取更丰富的全局信息, Dosovitskiy等人[26]提出的ViT模型首次将Transformer结构应用于图像分类领域, 很多研究人员也在此基础上将其应用于图像的下游任务中. Transformer结构也进一步解决精准农业中精细作物分类问题, Reedha等人[27]将ViT模型应用于作物与杂草的识别, 解决了无人机图像中具有相似纹理特征的杂草和作物难以区分的问题. 也有研究人员将多尺度信息与Transformer进行结合, 提出了MPViT模型[28], 该模型探索了多尺度patch embedding和多路径结构在下游任务中的适用性, 在ImageNet数据集中表现出优异的结果. MPViT模型的提出, 为多尺度多路径的Transformer在精细作物分类中的应用提供了研究基础.

针对使用单尺度卷积神经网络对作物误分及对地块边缘特征提取不充分问题, 本文提出了一种基于无人机图像的多尺度深度语义分割模型, 该模型对不同尺度的特征图进行同步的全局注意力操作, 以最大化不同尺度下的作物间差异, 提高模型对地块边缘特征的提取; 使用轻量的全局注意力降低并行结构的计算量, 提高模型的训练效率. 该模型进一步验证了使用高分辨率图像进行精细作物分类的可行性.

1 多尺度作物分类模型 1.1 模型结构MSAT模型通过深度可分离卷积获取多尺度特征图来获取同一网络层级下的不同尺度的作物信息, 这些信息被映射为一维序列独立的馈送到因子注意力模块中, 该模块通过建模远距离信息来获取作物的全局特征, 解决了对地块边缘信息提取不充分的问题, 内置的卷积相对位置编码弥补了对块 (patch)内局部信息的建模, 提高了模块对作物细节信息的提取能力.

模型采用编码器-解码器结构, 编码器部分对图像特征进行逐级提取, 解码器部分还原低分辨率图像尺度并与浅层网络融合. MSAT模型结构如图1所示, 编码器部分由骨干网络Efficientnet-b1[29]和多尺度因子注意力模块组成, 其中, Efficientnet-b1网络对输入图像

|

图 1 MSAT模型结构 |

1.2 多尺度patch embedding

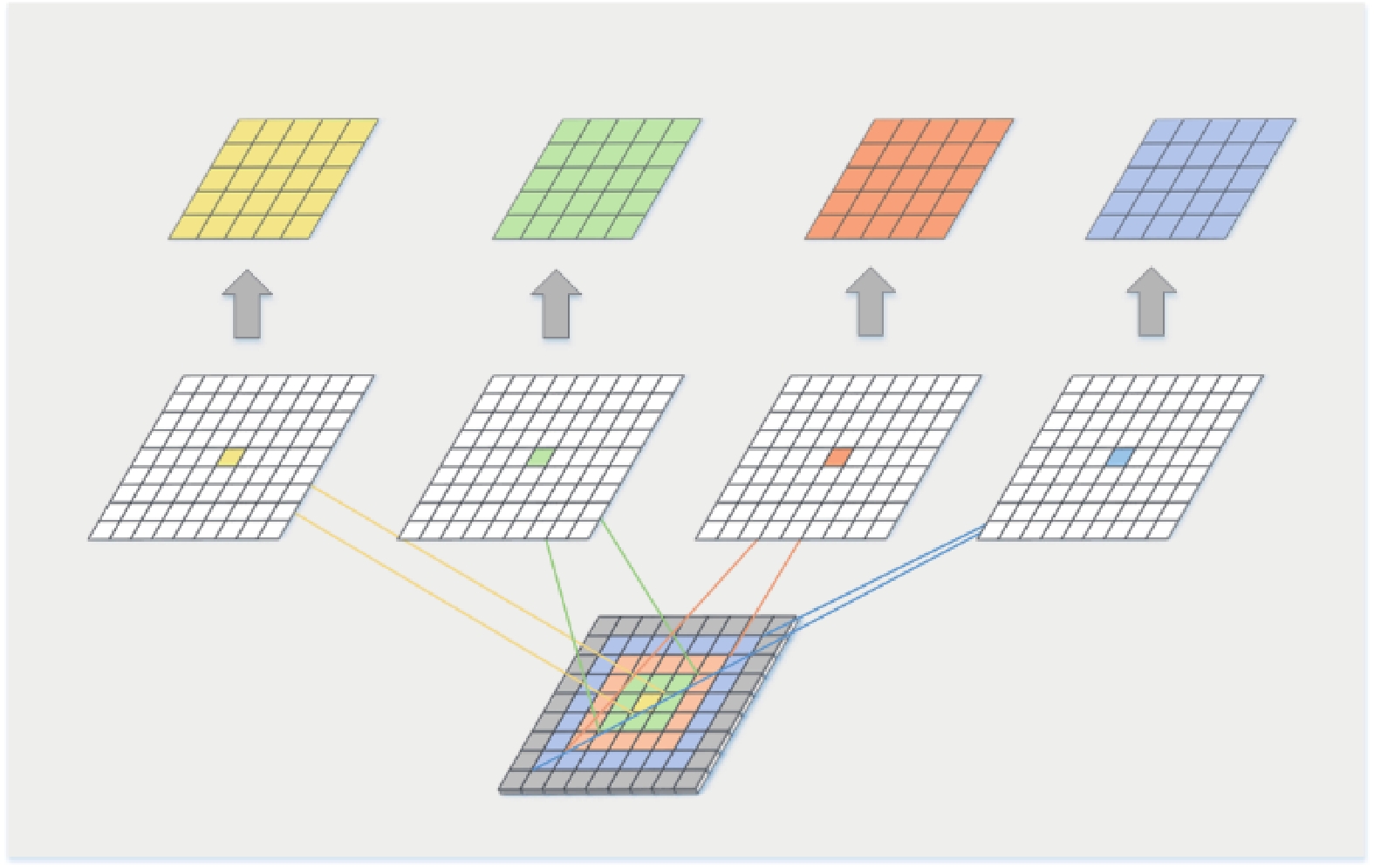

本文设计了一个多尺度patch embedding层, 如图2所示, 该层通过对深度可分离卷积设置不同的填充值和卷积核大小来获取粗粒度和细粒度的作物特征图, 再使用重叠卷积对不同尺度的特征图进行patch embedding, 最后对其进行1D-Reshape特征映射, 将

|

图 2 多尺度patch embedding |

DeepLabv3+模型中的空洞卷积通过设置不同的空洞率来获取作物的全局特征, 受像素间空洞的影响, 空洞卷积无法充分地建模相邻像素的依赖关系, 导致对作物的纹理特征关注较少, 若使用空洞卷积获取多尺度特征, 因子注意力模块在建模全局特征时就无法兼顾局部特征. 相反, 深度可分离卷积对相邻像素进行建模并通过填充来补充边缘特征, 相较于空洞卷积可以捕获更丰富的作物细节信息. 因此模型使用深度可分离卷积来获取多尺度特征, 具体而言, 对前一阶段的输出进行不同比率的填充, 补充对作物特征图边缘特征的提取, 深度可分离卷积可以通过调整填充比率来控制图像大小, 设置卷积核大小分别为1×1、3×3、5×5和7×7, 以获取由细到粗的多尺度特征图. 将获取的多尺度特征图输入到重叠卷积中, 其中, 卷积核为

| $ H' = \frac{{H - K + 2P}}{S} + 1, \; W' = \frac{{W - K + 2P}}{S} + 1 $ | (1) |

卷积注意力机制包括因子注意力机制、卷积相对位置编码和卷积位置编码3部分, 该模块通过在因子注意力模块中实现相对位置嵌入, 并采用高效的卷积块, 其生成的映射用于后续的前馈网络. 卷积注意力模块的结构如图3所示, 输入特征先进行卷积位置编码, 再通过嵌入相对位置编码的因子注意模块.

|

图 3 卷积注意力模块 |

卷积注意力的计算公式如式(2)所示,

| $ ConvAtt(X) = \frac{Q}{{\sqrt C }}(\textit{Softmax} {(K)^{\rm{T}}}V) + EV $ | (2) |

(1) 因子注意力机制

Transformer中的自注意力机制使用线性变换

| $ Att(X) = \textit{Softmax} \left(\frac{{Q{K^{\rm{T}}}}}{{\sqrt C }}\right)V $ | (3) |

| $ \begin{split} FactorAtt(Q, K, V) &= \phi (Q)(\psi {(K)^{\rm{T}}}V) \\ & =\frac{Q}{{\sqrt C }}(\textit{Softmax} {(K)^{\rm{T}}}V) \end{split} $ | (4) |

其中,

(2) 卷积相对位置编码

没有位置编码, Transformer就仅由线性层和注意力层组成, 这样就限制了在每个patch内建模作物细节信息的能力, 无法计算其局部特征差异, 局部特征获取不充分, 则会导致相似纹理的作物被混淆, 为提高模型patch内部信息的建模能力, CoAT集成了相对位置编码

| $ EV = Q \circ DepthwiseConv1D(P, V) $ | (5) |

其中,

将查询中的每个通道、位置编码和值向量视为内部头, 对于每个内部头

| $ E_{ij}^{(l)} = M(i, j)q_i^{(l)}p_{j - i}^{(l)} $ | (6) |

| $ EV_i^{(l)} = \sum\nolimits_j^{} {E_{ij}^{(l)}v_j^{(l)}} $ | (7) |

其中,

(3) 卷积位置编码

与绝对位置编码相似, 卷积位置编码的思想是将位置编码直接插入到输入图像特征中, 以丰富相对位置编码的效果. 首先, 将输入特征进行深度可分离卷积, 再按照标准绝对位置编码将产生的位置感知特征与输入特征进行融合, 从而完成对输入特征的卷积位置编码.

2 数据集介绍 2.1 卷积注意力机制研究区位于广西壮族自治区贵港市的港南区和桂平市 (北纬22°39′–24°2′, 东经109°11′–110°39′). 该地属亚热带季风气候区, 年均气温21.5℃, 年均降雨量1600 mm. 各季节气候特点是: 冬季偏暖, 降水偏少; 春季温度正常, 降水稍偏少; 夏季气温偏高, 降水正常; 秋季偏暖, 降水偏少. 该地区为水稻、甘蔗、玉米、香蕉和柑橘等作物提供了良好的种植条件.

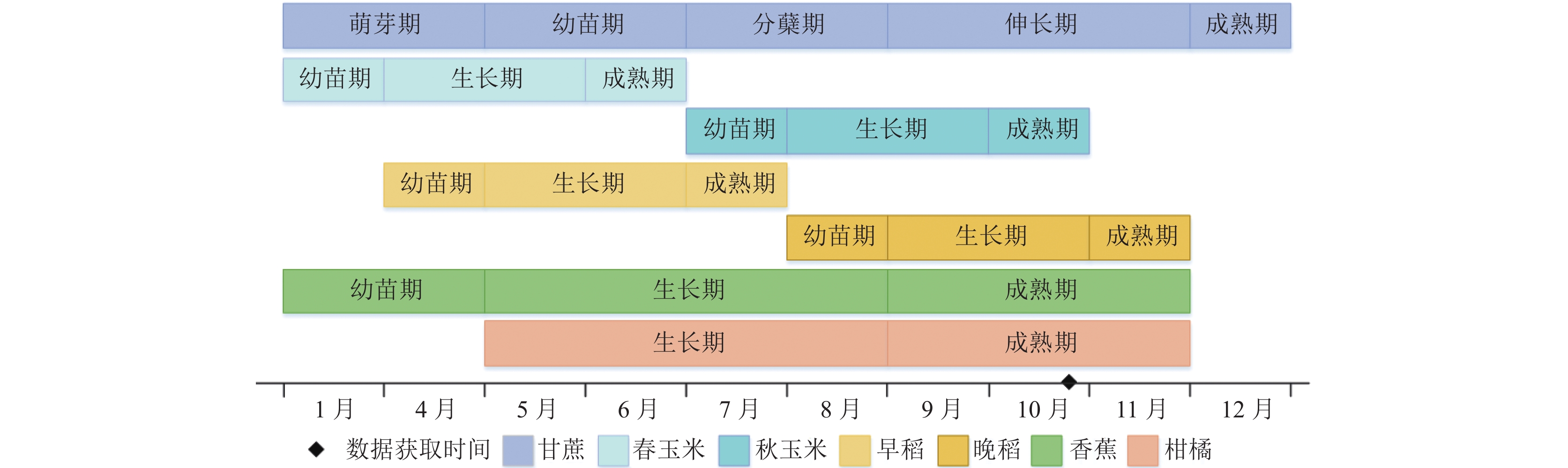

研究选取了贵港市主要粮食作物水稻、玉米, 经济作物甘蔗、香蕉和柑橘作为分类对象. 各作物物候日历如图4所示. 水稻一般4月份和8月份种植, 分别于7月份和11月份收割; 玉米则在3月份和7月份种植, 6月份和10月份收割, 生长周期短; 而甘蔗生长周期较长, 一般3月份播种, 12月份收割; 香蕉和柑橘则一般成熟于9–11月份.

|

图 4 研究区主要作物物候日历 |

2.2 无人机图像采集

本文实验所用的无人机型是大疆M300 RTK无人机, 搭载精灵4RTK相机, 航拍时间为2021年10月28日, 拍摄当天天气晴朗、风轻, 飞行高度设置为150 m, 地面分辨率设置为6 cm. 采集的图像包含3个波段: 红色、绿色和蓝色. 我们根据研究区的实际情况采集7个作物信息丰富的区域进行实验, 总面积为550公顷.

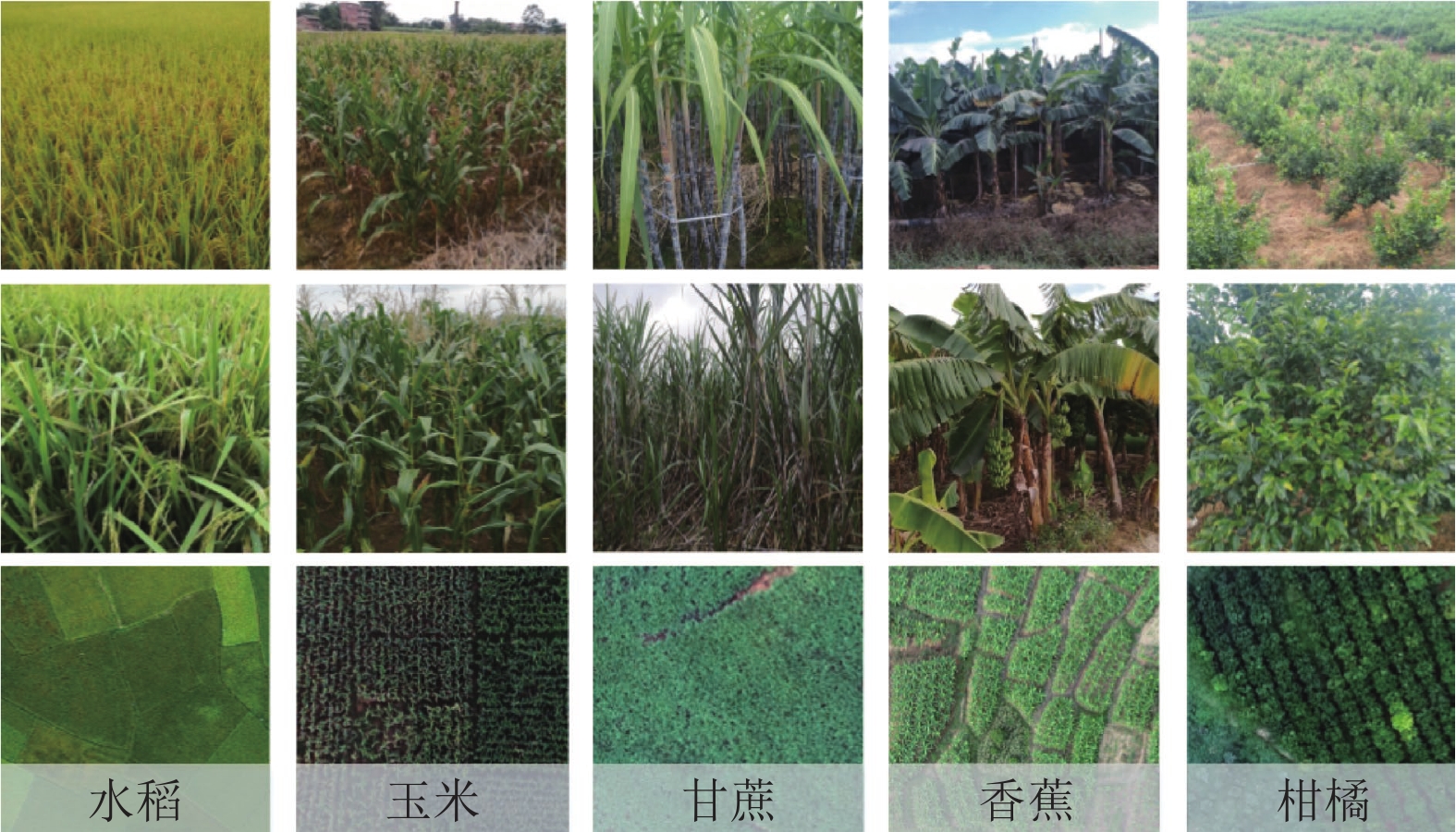

从物候日历图 (图4)和作物采样图 (图5)可以看出, 10–11月之间作物都处于成熟区、纹理特征差异较大. 该时期作物分别为晚稻、秋玉米、甘蔗、香蕉和柑橘. 对该时期的作物进行实地样本采集, 如图5所示, 可以看出, 水稻株苗密集、呈浅绿色; 甘蔗枝叶错综复杂且种植密集; 玉米与甘蔗的叶面结构较为相似, 但玉米叶面发黄、种植有序且间距大; 香蕉相较于玉米和甘蔗叶片更大, 成放射状; 柑橘种植间隔大, 成点状排列.

|

图 5 研究区作物采样图及正射影像 |

2.3 数据预处理

用于分类的5类研究区作物为水稻、玉米、甘蔗、香蕉和柑橘, 根据实地作物采样对研究区域进行田块矢量数据采集及点位采样, 从而根据田块矢量数据及点位数据对采集区域的正射影像进行目视解读, 并使用ArcGIS软件对各类作物进行真实值标注, 标注结果如表1所示.

| 表 1 研究区作物类别及标注信息 |

本实验根据已标注的无人机遥感图像构建样本数据库, 将7个区域的数据裁剪为512×512大小的图片, 如表1所示, 各样本的样本量比例为水稻:玉米:香蕉:甘蔗:柑橘=5:4:3:3:5, 样本较为均衡, 无长尾现象, 将所有数据划分为训练集、验证集和测试集, 选取其中6个区域的数据作为训练集和验证集, 包含9810张图片, 另一个区域作为测试集, 包含3450张图片.

3 实验结果及分析 3.1 实验设置实验环境使用的CPU为Intel Xeon W-2245, 128 GB内存, 显卡型号为NVIDIA GeForce RTX 3060Ti, CUDA版本11.3, 使用PyTorch框架搭建模型. 模型训练使用Adam优化器, 动量设置为0.9, 权重衰减设置为0.0005; 学习率衰减策略使用指数衰减, 初始学习率设为0.001; 批次大小设置为8, 迭代次数设置为100.

训练使用交叉熵损失函数和Dice损失函数的加权平均. 交叉熵损失函数表达式如式(8)所示, 其中,

| $ {L_{{\rm{cross}}}} = - \sum\nolimits_{i = 1}^n {p({x_i})\ln (q({x_i}))} $ | (8) |

Dice损失的函数表达式如式(9)所示, 其中,

| $ {L_{{\rm{Dice}}}} = 1 - \frac{{2\left| {x \cap y} \right|}}{{\left| x \right| + \left| y \right|}} $ | (9) |

为准确定量地验证模型在测试集中准确性, 本实验采用IoU (intersection over union)、MIoU和总体分类精度 (OA)来评估分类结果. 其中, IoU表示真实值与预测值的交并比, MIoU为平均交并比, 该指标可以反映分割结果和真实结果之间的重合程度. 总体分类精度是所有正确预测数与总数的比值.

| $ IoU = \frac{{TP}}{{TP + FN + FP}} $ | (10) |

| $ MIoU = \frac{1}{{k + 1}}\sum\nolimits_{i = 0}^{{k}} {\frac{{{p_{ii}}}}{{\displaystyle\sum\nolimits_{j = 0}^k {{p_{ij}}} + \displaystyle\sum\nolimits_{j = 0}^k {{p_{ji}} - {p_{ii}}} }}} $ | (11) |

| $ OA = \frac{{TP + TN}}{{TP + FN + FP + TN}} $ | (12) |

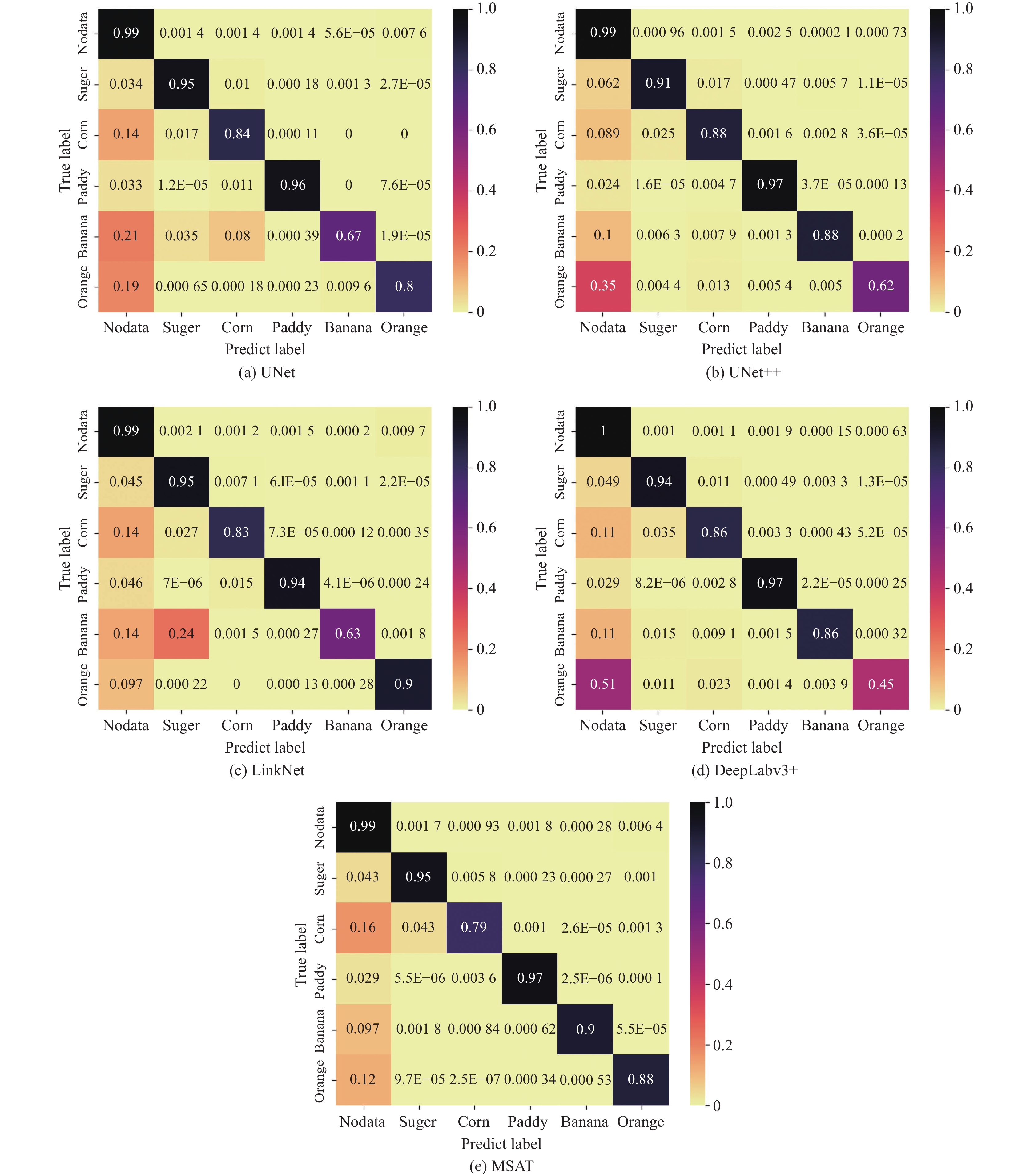

本实验对广西壮族自治区贵港市的水稻、玉米、甘蔗、香蕉和柑橘进行分类, 选用的数据集为贵港市7个区域的无人机图像数据, 图片大小为512×512, 训练集包含9810张图片, 测试集包含3450张图片. 为评估MSAT模型在农作物分类中的有效性, 本实验将其与UNet[32]、UNet++[33]、LinkNet[34]、DeepLabv3+模型进行了对比, 从定性和定量两方面分析评估结果, 在农作物数据集上的分类混淆矩阵和精度评估如图6和表2所示.

|

图 6 各模型的分类结果可视化 |

由图6和表2可以看出MSAT模型相较于其他模型在农作物数据集上有更高的分割精度. 具体而言, 如表2所示, 与DeepLabv3+模型相比, 本文提出的多尺度因子注意力模型MSAT在MIoU和OA指标上分别提高了8.6%, 1.32%. 与UNet模型、UNet++模型和LinkNet模型相比, MIoU和OA分别提高了6.8%、5.2%、7.5%和0.53%、0.66%、0.42%. 从图6的5种模型的混淆矩阵可以看出, 柑橘被误分为背景类, 原因是柑橘种植区内有其他呈点状种植的树种与柑橘纹理较相似; 图像的分辨率较高, 且玉米、甘蔗和香蕉3种作物的叶面结构较为相似, 从而增加了模型对3者的区分难度, 导致了这3类作物之间不同程度的误分. 而MSAT模型的多尺度全局注意力机制使其不止关注作物纹理特征, 更可以结合作物的种植背景和种植结构来区分, 如玉米植株的排列较为整齐, 排与排之间有空隙, 地块边缘整齐; 甘蔗种植紧密, 植株之间无明显空隙, 地块边缘不规则, 呈弯曲状; 香蕉植株之间距离较大, 排列无序且稀疏, 地块边缘无不规则. 如果仅依据3种作物的叶面纹理特征进行区分, 则无法突出玉米、甘蔗和香蕉3类作物之间的差异, MSAT充分获取上下文信息, 可以从叶面纹理结构和种植背景、种植结构3方面对3类作物进行分类, 同时也增强了模型对柑橘和其他树种的区分能力. MSAT与其余4类模型相比, 在水稻、玉米、香蕉、柑橘4类作物上都有提升, 但甘蔗的分割精度相较于UNet下降了0.021, 结合混淆矩阵, 分析原因可能是与玉米存在一定的误分, 该问题可通过增加玉米和甘蔗的样本量来提升模型对二者的区分能力.

| 表 2 各模型在农作物数据集上的分割精度 |

图7为5类模型对水稻、玉米、甘蔗、香蕉和柑橘5种作物分割结果, 从左到右依次为真实值标注, MSAT、UNet、UNet++、LinkNet和DeepLabv3+模型的分割结果. 结合表2与图7, 分析可知基于卷积网络的UNet、UNet++和LinkNet对玉米、甘蔗和香蕉的分割结果较差, 且对地块边缘的分割不规则, 香蕉大多被误分为玉米和甘蔗. 原因是UNet、UNet++和LinkNet这3个模型主要通过建模相邻像素信息来获取局部特征, 对上下文信息获取不充分, 导致玉米、甘蔗和香蕉这3类有相似纹理的作物无法很好地区分, 分割边缘不平滑. DeepLabv3+模型具有多尺度卷积结构, 通过空洞卷积扩大感受野以获取更充分的上下文信息, 但该结构对局部信息的构建能力较弱, 导致作物也呈现一定程度的误分, 而MSAT模型基于多尺度的因子注意力机制, 多尺度结构可以充分获取全局信息, 因子注意力机制可以补充局部信息, 二者的结合具有强大的全局和局部特征表达能力, 提高作物的识别能力.

|

图 7 各模型预测结果对比图 |

图8展示了5类模型在整个测试区域的农作物分割结果, 依次为真实值标注、MSAT、UNet++、UNet、LinkNet和DeepLabv3+模型. 其中, LinkNet和DeepLabv3+对香蕉作物有不同程度的误分, LinkNet模型对香蕉的分类精度不高, IoU只有0.599, DeepLabv3+模型将部分柑橘误分为背景, 使得模型对柑橘的分类结果较低, IoU为0.449, 图6的混淆矩阵也显示了LinkNet将香蕉误分为甘蔗的概率和DeepLabv3+将柑橘误分为背景的概率较大. UNet++模型和UNet模型分别在柑橘和香蕉的分类上有一定程度的误分. 相比之下, MSAT模型对作物的分类效果更好, 无明显误分现象, 且对作物地块的提取也更完整. 实验选取的测试区域各作物种植较分散, 存在多种作物交叉种植情况, 如图8中的ground truth所示, 左上角和右下角区域交叉分布较为密集, 主要容易产生交叉种植的作物为住房周围的玉米、水稻及河道边的香蕉, 对比图5的ground truth与MSAT, 交叉种植的作物无明显误分现象, 中间区域存在甘蔗和柑橘误分的情况, 对比原始图像发现原因为地块边缘的水稻存在小部分倒伏现象, 纹理较为混乱. 根据图6(e)混淆矩阵分析各类作物的分类情况, 无明显误分现象, 存在少量玉米、香蕉、甘蔗预测为背景值的情况, 分析原因可能是存在部分收割后的玉米、甘蔗残株, 及种植较为零散的香蕉.

|

图 8 各模型在测试集上的全域预测结果 |

3.4 消融实验

为进一步验证多尺度因子注意力模块的有效性, 本文设置了一组消融实验. 实验将本文提出的多尺度因子注意力模型MSAT与原模型DeepLabv3+、多尺度卷积为空洞卷积的因子注意力模型MSAT-AC进行比较, 通过对比三者在农作物数据集上的分割精度来讨论多尺度因子注意力结构的有效性. 如表3所示, 本文提出的基于深度可分离卷积的因子注意力模型MSAT分割结果优于基于空洞卷积的因子注意力模型MSAT-AC和DeepLabv3+模型. 对比DeepLabv3+模型与MSAT-AC模型, 直接在DeepLabv3+模型上加入多尺度的因子注意力模块分割精度不增反减, 原因是因子注意力机制中的卷积相对位置编码可以增强多尺度特征图中对局部信息的建模能力, 而空洞卷积后的特征图相邻像素之间无直接联系, 这导致CoAT无法有效建模patch内的局部信息且在建模上下文信息时也会漏掉一些信息, 从而导致直接在DeepLabv3+模型上应用因子注意力机制后模型性能降低. 为解决这一问题, 使用深度可分离卷积替换空洞卷积, 对比MSAT模型和MSAT-AC模型, MI

| 表 3 验证多尺度注意力模块在农作物数据集上的有效性 |

4 结论与展望

本文提出了一种基于多尺度因子注意力的农作物分类模型MSAT. 该模型对无人机图像进行逐级特征提取, 并对第4阶段的特征图进行多尺度嵌入, 通过一个多尺度注意力机制, 该机制解决了常规Transformer无法充分获取图像局部信息的问题, 增加了纹理相似作物之间的差距, 增强了对边缘信息的提取能力, 提高了分类结果的准确度. 在农作物数据集上的对比实验表明, 该模型对农作物的总体分类精度达到了98.1%, 平均交并比达到0.861, 相较于对比模型都有一定提升, 尤其对玉米、甘蔗和柑橘的分类结果更佳. 为进一步验证MSAT模型的性能, 设计了一组消融实验, 探索基于深度可分离卷积的多尺度注意力机制的有效性. 多尺度模型要求并行的Transformer结构需要足够轻量, 较大的注意力结构导致较慢的训练速度, 但降低模型规模也会一定程度影响模型分类准确度, 针对该问题, 后续将继续探索兼顾训练速度和分类精度的多尺度模型. 本研究为多尺度注意力机制在农作物分类领域的探索提供了研究基础, 并进一步验证了无人机图像在精准农业中的适用性.

| [1] |

Nasirzadehdizaji R, Cakir Z, Sanli FB, et al. Sentinel-1 interferometric coherence and backscattering analysis for crop monitoring. Computers and Electronics in Agriculture, 2021, 185: 106118. DOI:10.1016/j.compag.2021.106118 |

| [2] |

周亮, 慕号伟, 马海姣, 等. 基于卷积神经网络的中国北方冬小麦遥感估产. 农业工程学报, 2019, 35(15): 119-128. DOI:10.11975/j.issn.1002-6819.2019.15.016 |

| [3] |

Mubin NA, Nadarajoo E, Shafri HZM, et al. Young and mature oil palm tree detection and counting using convolutional neural network deep learning method. International Journal of Remote Sensing, 2019, 40(19): 7500-7515. DOI:10.1080/01431161.2019.1569282 |

| [4] |

Yang GF, He Y, Yang Y, et al. Fine-grained image classification for crop disease based on attention mechanism. Frontiers in Plant Science, 2020, 11: 600854. DOI:10.3389/fpls.2020.600854 |

| [5] |

Tatsumi K, Yamashiki Y, Morante AKM, et al. Pixel-based crop classification in Peru from Landsat 7 ETM+ images using a random forest model. Journal of Agricultural Meteorology, 2016, 72(1): 1-11. DOI:10.2480/agrmet.D-15-00010 |

| [6] |

Kumar P, Prasad R, Choudhary A, et al. A statistical significance of differences in classification accuracy of crop types using different classification algorithms. Geocarto International, 2017, 32(2): 206-224. |

| [7] |

Wu MQ, Yang LC, Yu B, et al. Mapping crops acreages based on remote sensing and sampling investigation by multivariate probability proportional to size. Transactions of the Chinese Society of Agricultural Engineering, 2014, 30(2): 146-152. |

| [8] |

Du XD, Cai YH, Wang S, et al. Overview of deep learning. Proceedings of the 31st Youth Academic Annual Conference of Chinese Association of Automation (YAC). Wuhan: IEEE, 2016. 159–164.

|

| [9] |

Liang J, Zheng ZW, Xia ST, et al. Crop recognition and evaluation using red edge features of GF-6 satellite. Journal of Remote Sensing, 2020, 24(10): 1168-1179. |

| [10] |

刘帅兵, 杨贵军, 周成全, 等. 基于无人机遥感影像的玉米苗期株数信息提取. 农业工程学报, 2018, 34(22): 69-77. DOI:10.11975/j.issn.1002-6819.2018.22.009 |

| [11] |

Yang MD, Tseng HH, HsuY C, et al. Semantic segmentation using deep learning with vegetation indices for rice lodging identification in multi-date UAV visible images. Remote Sensing, 2020, 12(4): 633. DOI:10.3390/rs12040633 |

| [12] |

韩文霆, 张立元, 牛亚晓, 等. 无人机遥感技术在精量灌溉中应用的研究进展. 农业机械学报, 2020, 51(2): 1-14. DOI:10.6041/j.issn.1000-1298.2020.02.001 |

| [13] |

Gómez-Candón D, Virlet N, Labbé S, et al. Field phenotyping of water stress at tree scale by UAV-sensed imagery: New insights for thermal acquisition and calibration. Precision Agriculture, 2016, 17(6): 786-800. DOI:10.1007/s11119-016-9449-6 |

| [14] |

Stöcker C, Bennett R, Nex F, et al. Review of the current state of UAV regulations. Remote Sensing, 2017, 9(5): 459. DOI:10.3390/rs9050459 |

| [15] |

Ozdarici-Ok A, Ok AO, Schindler K. Mapping of agricultural crops from single high-resolution multispectral images—Data-driven smoothing vs parcel-based smoothing. Remote Sensing, 2015, 7(5): 5611-5638. DOI:10.3390/rs70505611 |

| [16] |

Zhao WZ, Du SH. Learning multiscale and deep representations for classifying remotely sensed imagery. ISPRS Journal of Photogrammetry and Remote Sensing, 2016, 113: 155-165. DOI:10.1016/j.isprsjprs.2016.01.004 |

| [17] |

Kwak GH, Park NW. Impact of texture information on crop classification with machine learning and UAV images. Applied Sciences, 2019, 9(4): 643. DOI:10.3390/app9040643 |

| [18] |

Zhu XX, Tuia D, Mou LC, et al. Deep learning in remote sensing: A comprehensive review and list of resources. IEEE Geoscience and Remote Sensing Magazine, 2017, 5(4): 8-36. DOI:10.1109/MGRS.2017.2762307 |

| [19] |

Rebetez J, Satizábal HF, Mota M, et al. Augmenting a convolutional neural network with local histograms—A case study in crop classification from high-resolution UAV imagery. Proceedings of the European Symposium on Artificial Neural Networks, Computational Intelligence and Machine Learning. Bruges, 2016. 27–29.

|

| [20] |

汪传建, 赵庆展, 马永建, 等. 基于卷积神经网络的无人机遥感农作物分类. 农业机械学报, 2019, 50(11): 161-168. DOI:10.6041/j.issn.1000-1298.2019.11.018 |

| [21] |

Chew R, Rineer J, Beach R, et al. Deep neural networks and transfer learning for food crop identification in UAV images. Drones, 2020, 4(1): 7. DOI:10.3390/drones4010007 |

| [22] |

Han ZM, Dian YY, Xia H, et al. Comparing fully deep convolutional neural networks for land cover classification with high-spatial-resolution Gaofen-2 images. ISPRS International Journal of Geo-Information, 2020, 9(8): 478. DOI:10.3390/ijgi9080478 |

| [23] |

Yang YD, Zhuang Y, Bi FK, et al. M-FCN: Effective fully convolutional network-based airplane detection framework. IEEE Geoscience and Remote Sensing Letters, 2017, 14(8): 1293-1297. DOI:10.1109/LGRS.2017.2708722 |

| [24] |

Karim F, Majumdar S, Darabi H. Insights into LSTM fully convolutional networks for time series classification. IEEE Access, 2019, 7: 67718-67725. DOI:10.1109/ACCESS.2019.2916828 |

| [25] |

Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need. Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach: Curran Associates Inc., 2017. 6000–6010.

|

| [26] |

Dosovitskiy A, Beyer L, Kolesnikov A, et al. An image is worth 16x16 words: Transformers for image recognition at scale. arXiv:2010.11929, 2020.

|

| [27] |

Reedha R, Dericquebourg E, Canals R, et al. Transformer neural network for weed and crop classification of high resolution UAV images. Remote Sensing, 2022, 14(3): 592. DOI:10.3390/rs14030592 |

| [28] |

Lee Y, Kim J, Willette J, et al. MPViT: Multi-path vision transformer for dense prediction. Proceedings of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans: IEEE, 2022. 7277–7286.

|

| [29] |

Tan MX, Le QV. EfficientNet: Rethinking model scaling for convolutional neural networks. Proceedings of the 36th International Conference on Machine Learning. Long Beach: PMLR, 2019. 6105–6114.

|

| [30] |

Chen LC, Zhu YK, Papandreou G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 833–851.

|

| [31] |

Xu WJ, Xu YF, Chang T, et al. Co-scale conv-attentional image transformers. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: IEEE, 2021. 9981–9990.

|

| [32] |

Ronneberger O, Fischer P, Brox T. U-Net: Convolutional networks for biomedical image segmentation. Proceedings of the 18th International Conference on Medical Image Computing and Computer-assisted Intervention. Munich: Springer, 2015. 234–241.

|

| [33] |

Zhou ZW, Rahman Siddiquee M, Tajbakhsh N, et al. UNet++: A nested U-Net architecture for medical image segmentation. Proceedings of the 4th Deep Learning in Medical Image Analysis and Multimodal Learning for Clinical Decision Support. Granada: Springer, 2018. 3–11.

|

| [34] |

Chaurasia A, Culurciello E. LinkNet: Exploiting encoder representations for efficient semantic segmentation. Proceedings of the 2017 IEEE Visual Communications and Image Processing (VCIP). St. Petersburg: IEEE, 2017. 1–4.

|

2023, Vol. 32

2023, Vol. 32