目标跟踪[1]作为计算机视觉的一个重要研究领域, 其具有一定挑战性, 一直以来都是计算机视觉领域中广大研究人员热切关注的对象. 目标跟踪技术在民用和军事方面都有着许多的应用前景. 在民用方面, 目前已经广泛应用于车辆跟踪导航、医学诊断、安防监控、虚拟现实等多个行业. 除了以上所述的民用之外, 目标跟踪还在军事方面包括精准打击、无人机侦察、导航规划等领域具有同样的研究和应用价值. 尽管目标跟踪有着众多应用领域, 但随着不断变化的复杂场景和目标本身的变化作为影响跟踪效果的常见因素, 造成算法的性能下降, 设计一种在复杂场景下具备高精度和成功率的目标跟踪算法是目标跟踪领域的技术难题.

目标跟踪的方法按照模式主要分为生成式跟踪算法和判别式跟踪算法. 前者首先构建目标模型, 在后续帧中寻找相似特征, 逐步迭代完成目标匹配, 实现跟踪. 经典的生成式跟踪算法包括卡尔曼滤波算法(KF)[2], 其应用在线性高斯问题的场景; 粒子滤波算法(PF)[3]可有效解决非线性非高斯问题, 但不适用于跟踪灵活性强的目标; 均值漂移算法[4]通过将目标和候选目标的概率密度函数间的距离最小化来跟踪目标. 生成式跟踪算法没有利用背景信息, 仅通过简单目标模型来定义待跟踪目标, 具有很大局限性, 跟踪效果差. 判别式跟踪算法需要同时分析目标和背景信息, 通过比较二者不同, 以获得精确的目标模型, 进而确定当前帧中的目标位置实现跟踪, 背景信息的引入, 使得判别式跟踪算法优势增加. 在判别式跟踪算法中比较有代表性的为相关滤波算法, 具有较高的速度和准确度. 相关滤波的目标跟踪算法[5]比较经典的包括核相关滤波器(KCF)[6], 通过循环矩阵生成多个样本, 利用不同样本进行回归训练, 并采用点乘计算, 降低运算量, 使得算法满足实时性, 但难以应对物体的尺度变化; 空间正则化的判别式相关滤波器(SRDCF)[7], 基于DCF算法, 填充操作取值为4, 可检测区域增大, 同时在空间增加惩罚因子防止模型过拟合; 判别尺度空间跟踪算法(DSST), 提出位置滤波器与尺度滤波器, 可以精准的估计目标尺度; 快速判别尺寸空间跟踪算法(fDSST)[8]在DSST的基础上进行特征压缩、降维和插值, 运算速度有很大提升; 以及Staple算法[9], 针对HOG特征应对形变严重情况抵抗力差和COLOR特征难以区分目标与背景的缺点, 结合两种特征因子优点学习目标.

随着深度学习方法的发展, 在判别式跟踪算法中出现了基于深度学习建立的跟踪框架, 它通过训练端到端的卷积神经网络模型[10], 实现目标跟踪. 与相关滤波的跟踪算法相比, 通过神经网络学习的特征辨别能力更强且跟踪效果更稳定, 因此逐渐在目标跟踪领域脱颖而出. 基于孪生网络的目标跟踪算法由于具有领先的精度和准确率, 在各类跟踪算法中脱颖而出. 全卷积孪生网络(SiamFC)[11]将孪生网络应用到目标跟踪中, 将AlexNet作为主干网络进行特征提取, 模板分支和搜索分支输出特征图, 进行互卷积操作, 得到目标响应结果再反向映射到原图, 得到当前帧位置. 孪生候选区域生成网络(SiamRPN)[12]除孪生网络部分, 新增了候选区域部分, 其包含分类分支与回归分支, 并将anchor引入到跟踪领域, 计算位置差得到回归标签, 极大地提高了定位精度. 分散注意力的孪生候选区域生成网络(DaSiamRPN)[13]对训练数据进行处理, 产生正负样本, 大大提高网络判别能力, 并提出了干扰物感知模型和local-to-global的策略来更新模板、进行长时间跟踪.

以上方法在当时都取得了不错效果, 但相关滤波建立的模型无有效预测机制, 训练样本不会保存, 以往样本逐渐失效, 且模型不会区别对待异常样本, 若出现目标形状变化、背景干扰、遮挡等情况, 会导致跟踪失效. 此外, 基于深度学习的目标跟踪方法不断改进, 但包括孪生网络在内的深度学习跟踪算法仍有一定不足, 具体包括: 1)空间位置信息及背景信息易忽略, 在相似物干扰及背景杂乱情况识别目标能力差; 2)多数网络采用浅层网络提取特征, 不能充分提取丰富特征信息; 3)模板图像采用视频第1帧作为模板或者加权平均更新模板, 导致目标被遮挡或者发生较大形变等情况后跟踪框漂移.

针对上述问题, 本文优化了应用浅层网络AlexNet[14]提取目标特征的SiamRPN, 提出一种融合坐标信息及模板更新的孪生网络跟踪算法MCUSiamRPN. 特征提取网络采用改进使之更适用于跟踪的MobileNetV3网络 (MobileNetV3S)[15], 提取更丰富的特征信息; 融入坐标注意力模块[16], 关注目标位置空间信息; 引入模板自适应更新模块[17], 根据初始模板和当前帧, 自适应性地更新下一帧模板. 算法分别在OTB100与UAV123 数据集上进行跟踪实验, 本文所提算法的跟踪精度与成功率数据均最高, 并做了消融实验对比, 各个模块的引入均对算法的跟踪性能有效提升.

1 MCUSiamRPN算法描述本文算法MCUSiamRPN的总体框架如图1所示, 主要分为3个模块: 特征提取网络模块、RPN回归分类模块、模板更新模块. 在SiamRPN算法的基础上, 选取MobileNetV3S 进行特征提取, 模板和搜索两分支的权值共享、结构相同, 截取跟踪视频的第1帧作为模板帧Z、后续帧为检测帧X, 127×127×3的 Z与255×225×3的X作为输入分别通过特征提取网络, 在第3、7和11个block融入坐标注意力模块, 将位置信息引入到通道, 分别提取特征并融合特征信息, 将融合后的特征信息与经过完整特征提取网络的特征信息结合生成特征图, 输入到RPN部分, 模板分支输出的特征图作为卷积核与搜索分支输出的特征图进行互相关操作, 分类分支最终得到Z中各区域的目标和背景信息, 回归分支得到预测框与真实框的相对位置差, 使得回归后的跟踪框确定目标真实位置. 另外, 引入自适应模板模块, 将视频首帧信息与模板更新模块的输出信息融合并应用到当前帧的跟踪, 以此来进行跟踪过程的模板更新. 本文框架的设计, 有效地提取了丰富的特征信息及位置信息, 并解决了模板单一的问题.

|

图 1 MCUSiamRPN算法框架图 |

1.1 特征提取网络MobileNetV3S

本文基准算法SiamRPN采用5层卷积的AlexNet进行特征提取, 不能提取丰富语义信息, 跟踪模型鲁棒性较差. 目标跟踪特征提取网络排名靠前的深层网络ResNet50[18], 精度提升显著但网络结构复杂、参数过多导致计算量过大并不适用于配置低的设备. 为了提取浅层与深层特征的同时减少参数, 本文选取MobileNetV3作为MCUSiamRPN的特征提取网络. MobileNetV3采用深度可分离卷积[19], 与标准卷积相比, 卷积层数加深的同时参数减少, 计算量降低. 另外MobileNetV3中采用逆残差结构[20], 与标准残差结构不同, 其调换了降维和升维的顺序, 先使用1×1卷积实现升维, 再通过3×3的逐通道卷积提取特征, 最后使用1×1卷积实现降维, 就能够提取更多的信息.

为了使MobileNetV3在复杂场景下有效的处理单目标跟踪问题, 本文对网络结构进行了重新改进, 得到MobileNetV3S网络结构检测分支特征提取网络结构见表1.

| 表 1 MobileNetV3S网络结构 |

MobileNetV3S具体改进如下.

(1)应对孪生网络输入模板图像尺寸为127×127×3尺寸较小的问题, 将MobileNetV3中卷积层和block步长缩短为1, 用于保存深层特征图中丰富的有效信息, 更有利于跟踪.

(2)优化现有的主干网络结构, 删减网络末端平均池化层和1×1卷积层, 使用常规卷积层与坐标注意力模块结合提取目标的特征信息, 丰富预测特征, 弥补删除末端卷积层的不足.

(3)由于MobileNetV3需进行padding操作维持特征尺寸, 当目标移动到搜索范围边界附近时, 原始特征周围的填充会诱发潜在的位置偏差, 预测精度会降低, 为了减少padding操作对跟踪效果的影响, 将原网络中5×5的卷积核缩小为3×3的卷积核, 产生最外层无效信息通过Crop操作裁剪.

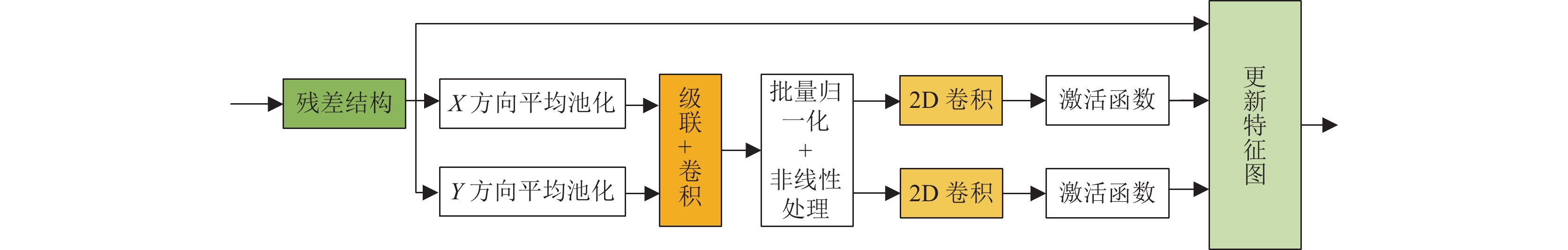

1.2 坐标注意力模块注意力模块可从全局信息中重点关注对当前跟踪目标更关键的细节信息. 目前常用的卷积注意力模块[21]只引入局部位置信息, 不能捕获特征图相距较远两个像素之间的相关性, 即远程依赖. 坐标注意力模块可将位置信息引入到通道, 其将通道注意力分解为两个1维特征编码过程, 分别沿X方向和Y方向聚合特征, 分别捕获远程依赖关系和保留精确的位置信息, 生成一对方向和位置敏感的特征图. 具体操作如图2所示.

|

图 2 坐标注意力模块 |

(1)坐标信息嵌入

输入的特征信息经过残差结构, 使用尺寸(H, 1)和(1, W)的池化核对各通道沿X方向和Y方向进行编码, X方向得到的一维特征为:

| zhc(h)=1W∑0⩽i<Wxc(h,i) | (1) |

Y方向得到的一维特征为:

| zwc(w)=1H∑0⩽j<Hxc(j,w) | (2) |

其中, h与w为输入特征图的高度和宽度; c为所在通道数.

(2)坐标注意力生成

将池化操作生成的两个特征图

| f=δ(F1([zh,zw])) | (3) |

其中, δ为非线性激活函数ReLU; F1是将X方向与Y方向的池化结果进行级联操作.

然后经过批量归一化和H-Swish函数的非线性操作, 将f分为f h和f w两个独立张量. 利用两个1×1卷积Fh和Fw将特征图f h和f w变换为和输入同样的通道数, 得到两个方向的权重:

| gh=σ(Fh(fh)) | (4) |

| gw=σ(Fw(fw)) | (5) |

其中,

最后将gh和gw拓展为与输入特征具有相同维度, 与输入特征xc(i, j)按位相乘得到坐标注意力模块最终输出为:

| yc(i,j)=xc(i,j)×ghc(i)×gwc(j) | (6) |

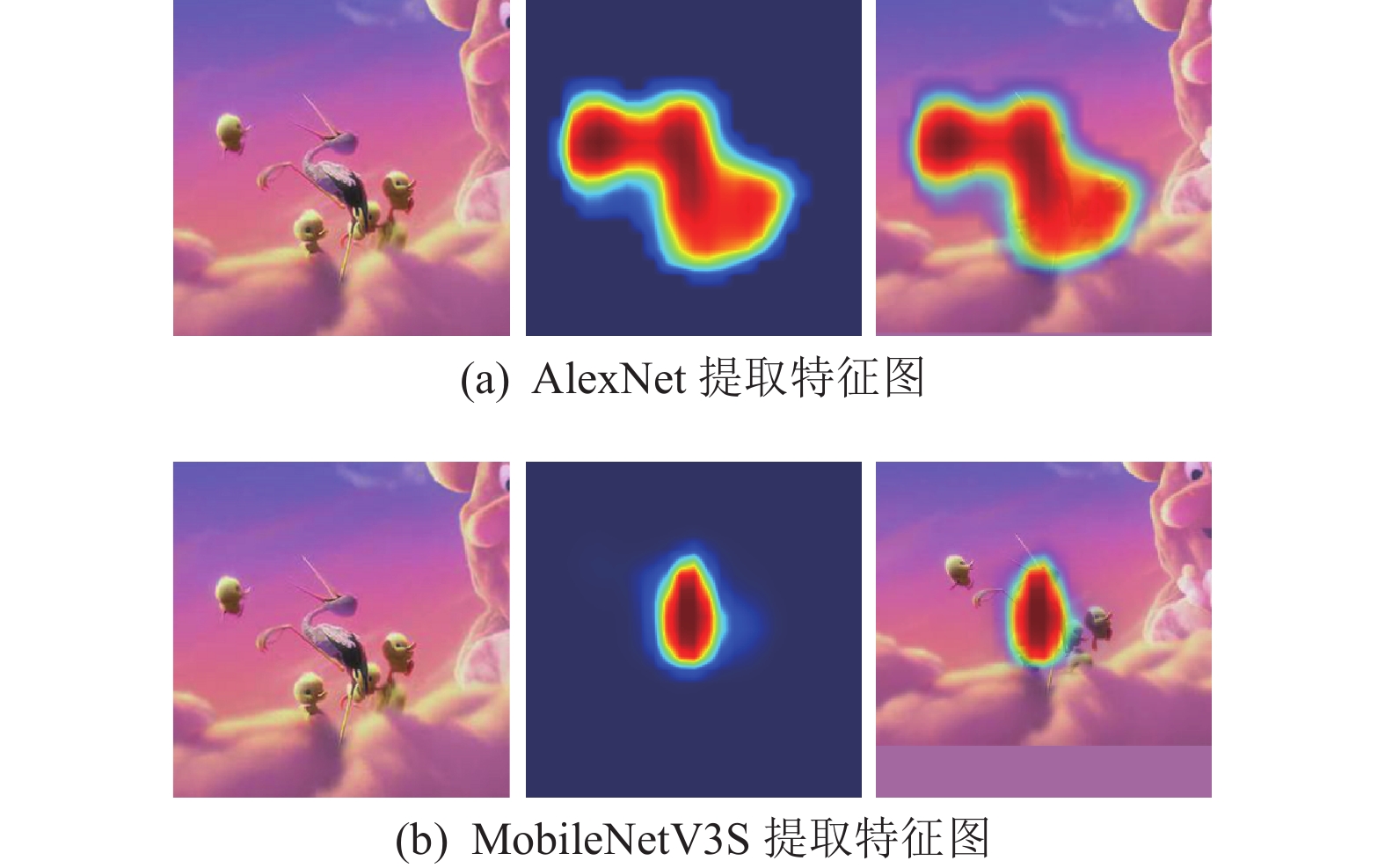

采用AlexNet和本文结合坐标注意力模块的MobileNetV3S特征提取网络分别在OTB100数据集的bird2序列场景中提取特征信息, 特征图如图3所示.

|

图 3 提取特征图分析 |

由图3可以看出, 经过MobileNetV3S提取多层特征信息并融合坐标注意力的输出特征图不容易受周围环境及相似物干扰, 响应得分图高的区域与所跟踪目标外观几乎重合.

1.3 自适应模板更新模块SiamRPN选择视频的首帧作为模板图像, 不能适应后期目标的形变、遮挡等场景, 因此引入自适应模板更新模块来解决这个问题, 将首帧模板信息与模板更新的输出融合并应用于当前帧的跟踪, 以提升应对复杂场景跟踪框漂移的稳健性, 其结构如图4所示.

模板更新函数为:

| ~Ti=ϕ(TGT0,Ti)+TGT0 | (7) |

其中,

|

图 4 自适应模板更新模块 |

模板更新的计算过程如下.

(1)将视频首帧模板信息

(2)级联的特征经过1×1×2×C×96的卷积层、ReLU层和1×1×96的卷积层, 与首帧模板信息融合, 输出更新模板. 其中, C代表

实验处理器采用CPU Intel(R) Xeon(R) CPU E5-26304 @ 2.20 GHz 2.20 GHz (2处理器), RAM为64 GB, 编程语言使用Python 3.7, 在PyTorch 1.7.1框架下进行跟踪操作. 在PyCharm 2018.2.2.0中进行程序的搭建及调试.

2.2 数据集本实验训练集采用了GOT-10k数据集[22], 训练后选用了100个包含多种挑战属性视频序列的OTB100数据集[23]和包含123个由低空无人机捕获的视频序列的UAV123数据集[24]进行测试, 采用精度(precision)和成功率(success rate)作为性能评价指标.

2.3 OTB100数据集实验结果分析 2.3.1 定性分析OTB100数据集包括了离开视野、光照变化、尺度变化、遮挡、形变等多种接近现实情况并具有挑战性复杂场景, 为了充分验证本文算法的跟踪能力, 将本文提出的算法MCUSiamRPN (使用Ours表示)与具代表性的相关滤波及孪生网络算法进行对比, 对比算法包括: fDSST、Staple、SRDCF、SiamFC、SiamRPN、DaSiamRPN, 实验结果如图5所示. 由图5可看出, 相关滤波类的跟踪算法精度和成功率都比较低, 其中跟踪效果相对较好的SRDCF的跟踪精度仅达到了0.789, 成功率达到了0.598, 跟踪效果最差的fDSST, 跟踪精度为0.666, 成功率为0.517. 孪生网络算法跟踪效果除了SiamFC外, 其他算法较高, SiamRPN与DaSiamRPN的跟踪精度都在0.840以上, 成功率也都在0.620以上. 本文算法在精度和成功率上都优于6种对比算法, 与基准算法SiamRPN相比有很大提升, 精度提升了5.3%, 达到了0.900; 成功率提升了3.7%, 达到了0.666.

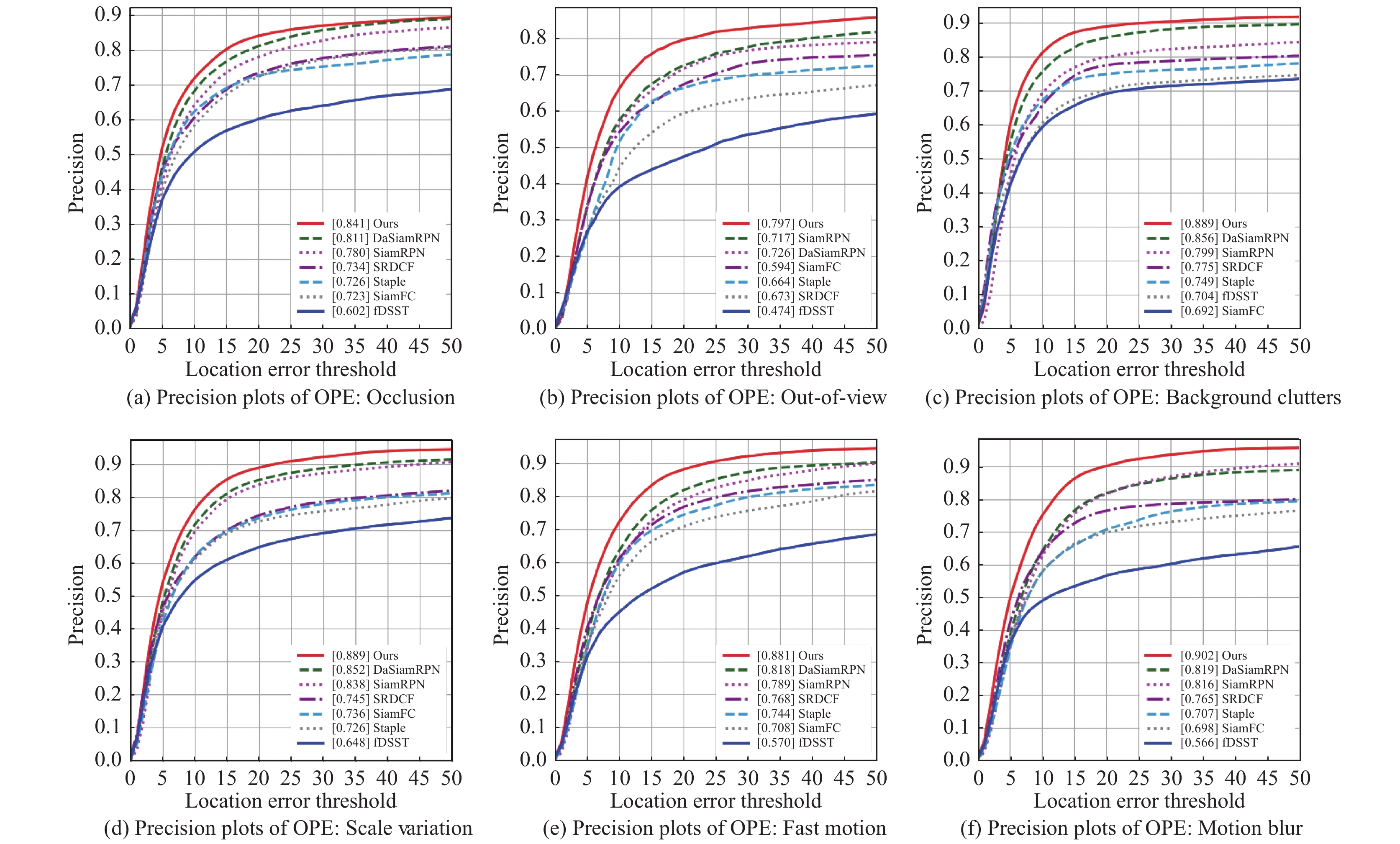

2.3.2 定量分析为了深入验证本文算法应对不同复杂场景的跟踪性能, 在遮挡(occlusion)、离开视野(out-of-view)、背景干扰(background clutters)、尺度变化(scale variation)、快速移动(fast motion)、运动模糊(motion blur)这6个常见的复杂场景进行跟踪测试. 跟踪结果的精度如图6所示, 成功率如图7所示. 由图6、图7可以看出, 在这6个场景中, 基于孪生网络的跟踪算法整体跟踪性能要优于相关滤波的跟踪算法, 尤其是应对离开视野的场景, 优越性更加明显. MCUSiamRPN的精度和成功率都高于其他算法, 尤其应对离开视野、快速移动和运动模糊3个场景, 优势更加突出, 跟踪精度达到了0.797、0.881、0.902, 成功率达到了0.616、0.650、0.661; 而DaSiamRPN在这3个场景的跟踪精度分别为0.717、0.818、0.819, 成功率为0.537、0.621、0.625; 跟踪效果较好的相关滤波算法SRDCF跟踪精度与成功率仅为0.594、0.768、0.765与0.460、0.597、0.594. 在这6种场景中与基准算法SiamRPN相比, 精度分别提升了6.1%、7.1%、9.0%、5.1%、9.2%、8.6%, 成功率分别提升了4.3%、7.4%、6.3%、3.2%、5.1%、3.9%.

|

图 5 OTB100数据集精度与成功率对比 |

|

图 6 部分复杂场景精度图 |

2.3.3 不同场景的可视化结果分析

采用本文算法和6种比较算法在OTB100数据集4个视频序列进行可视化结果分析, 如图8所示.

Bolt2视频序列中, 存在目标快速运动、相似物过多以及短时遮挡的影响, 相关滤波算法中, SRDCF表现良好, 但Staple和fDSST跟踪性能较差; 孪生网络算法中, SiamRPN在196帧由于相似物过多, 跟踪框发生轻微飘逸; SiamFC由于其网络结构简单, 跟踪飘逸严重. 本文算法和DaSiamRPN可以较好地应对这个场景.

Biker视频序列中, 跟踪目标快速移动导致运动模糊和目标尺度变化, SiamRPN完成了跟踪任务, 但84帧尺度不能适应快速移动后的目标; DaSiamRPN在目标瞬时掉头后产生了跟踪框飘逸, 84帧飘逸出目标. 其他相关滤波算法和孪生网络算法都在目标掉头70帧后跟踪性能下降, 跟踪框漂移到目标外; 本文算法可以较好地适应尺度的变化并完成跟踪.

|

图 7 部分复杂场景成功率图 |

|

图 8 部分视频序列跟踪结果 |

Human3视频序列中, 目标存在着运动模糊、遮挡及相似物等干扰, 目标穿过人群, 其他算法都发生了跟踪错误, 跟踪框转移到附近相似物; 本文算法和DaSiamRPN在整个序列能够准确跟踪目标.

Matrix视频序列中, 涉及运动模糊、遮挡、背景干扰等因素影响, 本文算法全程实现了更加准确的跟踪目标; DaSiamRPN的跟踪框在38帧发生短暂飘逸, 由于其具有从局部到全局的搜索策略, 在61帧跟踪框又回到目标周围; 除DaSiamRPN的其他算法在经过38帧后, 由于场景复杂程度过高, 导致目标跟丢.

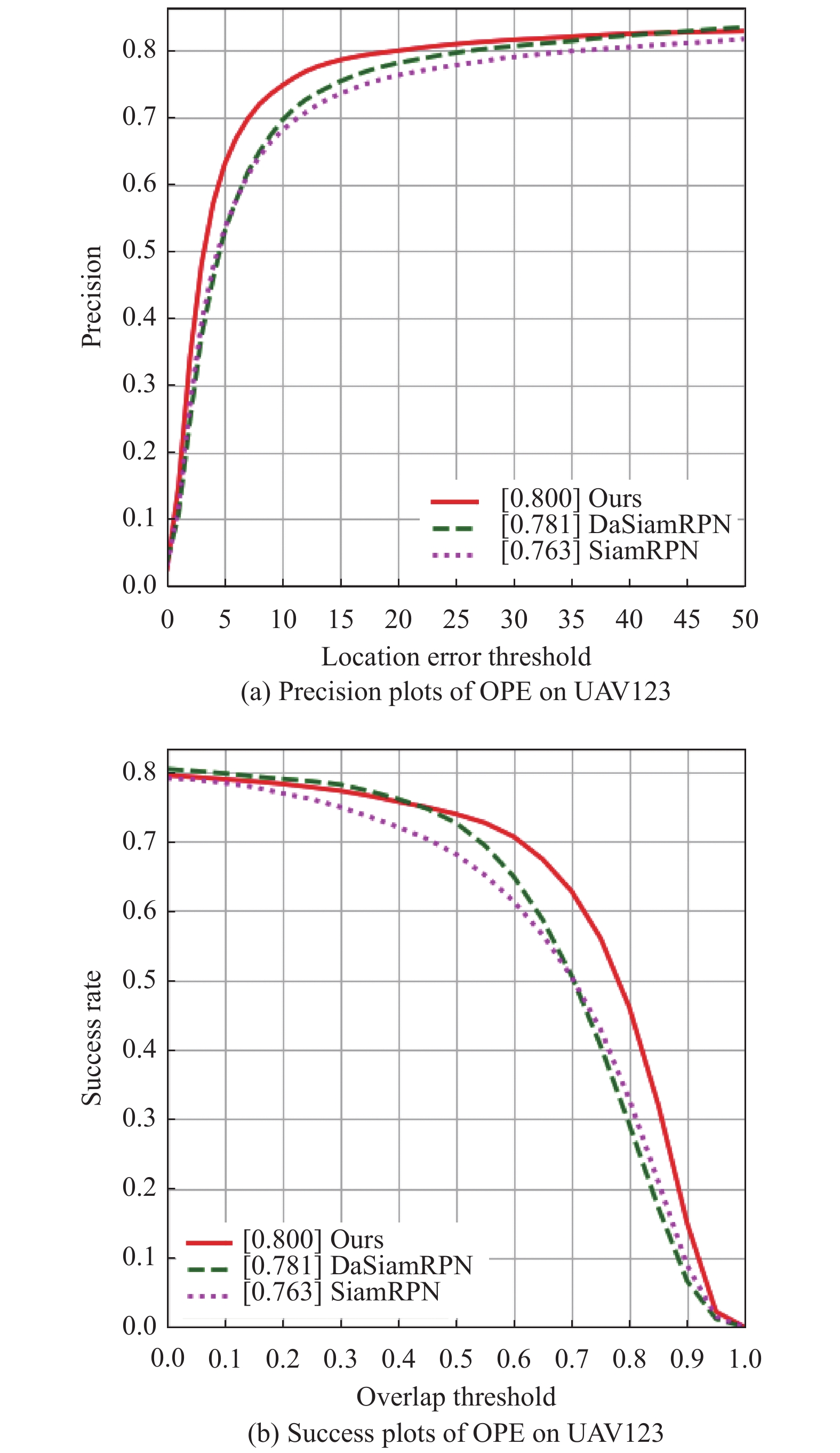

2.4 UAV23数据集实验结果分析为了确保算法适应不同类型场景, 本文将SiamRPN、DaSiamRPN、和MCUSiamRPN (使用Ours表示)在UAV123数据集上进行测试, 实验结果如图9所示.

由图9可得, MCUSiamRPN算法的精度达到0.800, 高出SiamRPN算法3.7%; 成功率达到0.608, 高出SiamRPN算法5.2%, 也都高于采用模板更新策略的DaSianRPN, 可见本文算法在同类算法中优势明显.

|

图 9 UAV123数据集精度与成功率对比 |

将MCUSiamRPN与SiamRPN、DaSiamRPN这3种算法在UAV123数据集中5种复杂场景进行试验, 对比算法的跟踪效果. 跟踪精度和成功率结果如表2所示.

| 表 2 3种算法在5种场景跟踪效果 |

由表2可得, 在所选相机运动、尺度变化、快速运动、离开视野与纵横比改变5种不同复杂场景下, 本文算法相较于DaSiamRPN与SiamRPN在各类场景的跟踪精度和成功率都有一定领先, 特别是在离开视野场景中, 本文算法和SiamRPN算法比较, 精度和成功率分别超出了8.0%和8.3%, 达到了0.775与0.567. 由此可见, 本文算法可较好的应对UAV123中的这些复杂场景, 具有较强的鲁棒性.

2.5 消融实验为了验证MCUSiamRPN在使用MobileNetV3S进行多层特征融合、坐标注意力及模板更新这3个改进点的有效性, 本文在OTB100数据集进行消融实验, 在SiamRPN算法的基础上, 分别引入各个改进点进行对比, 其中多层特征融、坐标注意力模块与模板更新都依赖于MobileNetV3S, 因此无法直接单独导入. 本实验通过控制变量所做7个对比实验得到的结果如表3所示.

实验结果表明, 本文提出4个部分的改进, 分别对跟踪精度和成功率起到了一定作用. 实验2结果, 表明使用MobileNetV3S进行特征提取后效果提升较好, 实验3表明, 特别是多层特征融合之后, 效果明显. 实验4和实验6表明, 坐标注意力模块的效果稍优于模板更新模块. 实验7表明, 4个部分共同改进的结果最优.

| 表 3 消融实验结果 |

3 结束语

本文提出融合坐标信息及模板更新的孪生网络跟踪算法, 通过MobileNetV3S提取各层特征并分别送入坐标注意力模块进行多层融合, 丰富语义信息; 为了解决目标跟丢及形变问题, 使用改进的自适应模块更新模板, 整合首帧与当前帧模板信息, 自适应更新的目标模板信息, 有效的应对目标因前景背景发生变化产生与初始目标帧差别过大的问题. 由实验可分析得出, 本文所提算法MCUSiamRPN相比于SiamRPN精度和成功率都有了很大提升, 能够较好地应对多种复杂场景, 特别对在目标离开视野、快速运动等场景具有良好的稳性, 证明了本文算法的有效性.

| [1] |

韩瑞泽, 冯伟, 郭青, 等. 视频单目标跟踪研究进展综述. 计算机学报, 2022, 45(9): 1877-1907. |

| [2] |

王广玉, 窦磊, 窦杰. 基于自适应卡尔曼滤波的多目标跟踪算法. 计算机应用, 2022, 42(S1): 271-275. |

| [3] |

Zhang LP, Nie JH, Zhang SL, et al. Research on the particle filter single-station target tracking algorithm based on particle number optimization. Journal of Electrical and Computer Engineering, 2021, 2021: 2838971. |

| [4] |

Yu HQ, Sharma A, Sharma P. Adaptive strategy for sports video moving target detection and tracking technology based on mean shift algorithm. International Journal of System Assurance Engineering and Management, 2021. 1–11.

|

| [5] |

虞跃洋, 史泽林, 刘云鹏. 基于前景感知的时空相关滤波跟踪算法. 激光与光电子学进展, 2019, 56(22): 221503. |

| [6] |

Henriques JF, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596. DOI:10.1109/TPAMI.2014.2345390 |

| [7] |

Danelljan M, Häger G, Khan FS, et al. Learning spatially regularized correlation filters for visual tracking. Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago: IEEE, 2015. 4310–4318.

|

| [8] |

孟琭, 李诚新. 近年目标跟踪算法短评-相关滤波与深度学习. 中国图象图形学报, 2019, 24(7): 1011-1016. DOI:10.11834/jig.190111 |

| [9] |

Bertinetto L, Valmadre J, Golodetz S, et al. Staple: Complementary learners for real-time tracking. Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016. 1401–1409.

|

| [10] |

盖荣丽, 蔡建荣, 王诗宇, 等. 卷积神经网络在图像识别中的应用研究综述. 小型微型计算机系统, 2021, 42(9): 1980-1984. DOI:10.3969/j.issn.1000-1220.2021.09.030 |

| [11] |

Bertinetto L, Valmadre J, Henriques JF, et al. Fully-convolutional Siamese networks for object tracking. Proceedings of the Computer Vision Workshops. Amsterdam: Springer, 2016. 850–865.

|

| [12] |

Li B, Yan JJ, Wu W, et al. High performance visual tracking with siamese region proposal network. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 8971–8980.

|

| [13] |

Zhu Z, Wang Q, Li B, et al. Distractor-aware siamese networks for visual object tracking. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 103–119.

|

| [14] |

Krizhevsky A, Sutskever I, Hinton GE. ImageNet classification with deep convolutional neural networks. Proceedings of the 25th International Conference on Neural Information Processing Systems. Lake Tahoe: ACM, 2012. 1097–1105.

|

| [15] |

Howard A, Sandler M, Chen B, et al. Searching for MobileNetV3. Proceedings of 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 1314–1324.

|

| [16] |

Hou QB, Zhou DQ, Feng JS. Coordinate attention for efficient mobile network design. Proceedings of 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021. 13713–13722.

|

| [17] |

Zhang LC, Gonzalez-Garcia A, van de Weijer J, et al. Learning the model update for siamese trackers. Proceedings of 2019 IEEE/CVF International Conference on Computer Vision. Seoul: IEEE, 2019. 4009–4018.

|

| [18] |

Li B, Wu W, Wang Q, et al. SiamRPN++: Evolution of siamese visual tracking with very deep networks. Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019. 4277–4286.

|

| [19] |

Howard AG, Zhu ML, Chen B, et al. MobileNets: Efficient convolutional neural networks for mobile vision applications. arXiv:1704.04861, 2017.

|

| [20] |

Sandler M, Howard A, Zhu ML, et al. MobileNetV2: Inverted residuals and linear bottlenecks. Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018. 4510–4520.

|

| [21] |

Woo S, Park J, Lee JY, et al. CBAM: Convolutional block attention module. Proceedings of the 15th European Conference on Computer Vision. Munich: Springer, 2018. 3–19.

|

| [22] |

Huang LH, Zhao X, Huang KQ. GoT-10k: A large high-diversity benchmark for generic object tracking in the wild. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(5): 1562-1577. DOI:10.1109/TPAMI.2019.2957464 |

| [23] |

Wu Y, Lin J, Yang MH. Object tracking benchmark. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1834-1848. DOI:10.1109/TPAMI.2014.2388226 |

| [24] |

Mueller M, Smith N, Ghanem B. A benchmark and simulator for UAV tracking. Proceedings of the 14th European Conference on Computer Vision. Amsterdam: Springer, 2016. 445–461.

|

2023, Vol. 32

2023, Vol. 32