2. 哈尔滨工程大学南安普顿海洋工程联合学院, 哈尔滨 150001;

3. 哈尔滨工程大学 未来技术学院, 哈尔滨 150001

2. Southampton Ocean Engineering Joint Institute at Harbin Engineering University, Harbin 150001, China;

3. School of Future Technology, Harbin Engineering University, Harbin 150001, China

随着我国铁路建设的高速发展和铁路基础线路维修、电力线路维修等越来越频繁, 对施工组织行车、人员、机具设备等财产安全保障的需求也在不断提升. 现有的专门针对列控系统(CTCS)[1]和列车自动保护子系统(ATP)[2]都采用信号闭塞、接近应答手段保证行车安全, 但列控系统只能监测合作目标, 对于具有突发性、不可预测的非合作目标侵限事件的发生不能提前预警[3]. 尤其工务机械车在施工作业时, 地面信号系统通常处于关闭或者失效状态, 不能起到监控列车的作用, 这将直接影响施工车辆的行车安全.

在调车及施工作业中可能发生诸多影响行车安全的客观(恶劣天气、光照条件受限、目视观测距离不够等)与主观(司机身体、精力等)方面的干扰因素问题. 例如LKD2-T1型列控中心设备发生异常、5829AG轨道电路与列控中心的通信出现故障导致的“甬温线7.23”铁路交通事故, 说明除地面信号控制系统之外, 一套与信号系统完全独立的, 可自主侦测预警, 能全天时、全天候工作的车载安全保障系统是非常必要的[3]. 并且, 此安全保障系统的算法设计应满足: (1)脱离地面信号控制; (2)不依赖无线及卫星通信; (3)自动化精准判断.

国外对轨道交通以及在无人驾驶等领域研究时间较长, 因此对轨道障碍物检测等相关研究工作开始的也比较早, 较多为通过实时采集的视频图像与已采集好的数据中心的视频图像做比对, 从而来判断轨道内部是否存在障碍物. 国内通过借鉴法国、日本、德国等发达国家在铁路安全监测系统的优点, 利用BP神经网络、Kalman+mean shift 算法等进行研究. 现在的轨道车防撞系统仍存在较大的碰撞隐患: 如对铁轨、入侵物及道岔等目标, 基于传统算法的目标识别成功率低、达到危险距离时预警延误率高、轨道车防碰撞控制精度差等问题.

轨道车智能防护辅助预警系统通常会涉及物体检测、可行驶区域与不可行驶区域划分等工作, 以检测列车前方可能存在的危险目标以及行驶区域界限, 用于后续的侵限判别工作, 针对这类问题在深度学习领域有许多算法能够处理这些任务, 例如, 可用于检测物体的 Faster R-CNN[4]、YOLOv5[5]等目标检测算法, 实现语义分割的UNet[6]、DeepLab[7]和PSPNet[8], 车道线检测的有 SCNN算法[9], 但这些算法多为单一任务算法. 当存在多种任务情形下的需求时, 逐一实现会存在计算资源紧缺、耗时过长等问题. 另外, 利用深度学习对交通场景进行理解时信息量是巨大的, 不同任务提取的信息有相当一部分是重叠的, 对于这部分信息可以通过多任务网络来实现信息共享, 建立一个相同的特征提取主干从而减小了工作量. 因此, 探索对于多任务情形时使用的多任务网络方法是至关重要的.

我们提出一种基于YOLOv5改进的轨道侵入物检测与行驶区域分割多任务学习算法, 使用一个共享编码器及一个检测与分割对应的解码器, 完成目标检测、可行驶区域分割和火车分割任务. 本算法可以实现对光学视场扫描范围内的目标进行判断追踪, 同时可以对被锁定目标物的各项重要数据进行记录. 本算法对未知目标可以进行特征记录与学习, 并且可以通过数据集升级实现对新目标的检测判断与追踪.

1 多任务学习算法为提高轨道车行驶安全, 本算法的目的是更加准确、快速地对侵限的异物进行检测. 我们的首要任务就是检测出可能出现在轨道上的侵入物, 然后再分割出列车的正常行驶区域, 以便对侵入正常行驶区域的异物进行预警.

在侵入物检测和行驶区域分割任务方面, 前人通过利用YOLOv3目标检测[10]+Canny边缘检测[11]策略进行实验. 然而这种方法存在一定问题, 比如目标检测的模型过大、检测精度和鲁棒性不足、Canny等这类传统的边缘检测算法对曲线检测错误严重等. 为了解决以上问题, 本文提出一种基于YOLOv5改进的兼顾精度与检测速度的轨道侵入物检测与可行驶区域分割的多任务学习算法. 与YOLOv3相比, 在相同时间消耗时, YOLOv5的实验效果优于YOLOv3, 占用的网络量级更轻; 并且YOLOv5与YOLOv3相比另一个明显的优势是YOLOv5分为YOLOv5s[12]、YOLOv5m[13]、YOLOv5l[14]、YOLOv5x[15]这4种模型, 可以根据工作场景不同进行灵活选择.

为了提高轨道侵入物检测与行驶区域分割的效果, 本文在传统的YOLOv5框架基础上进行了改进, 将原网络中冗余的编码器模块去除, 删除了多余的共享块以便减小计算消耗, 使得在轻量型硬件系统上进行的网络端对端训练更容易实现. 通过实验发现, 本方法能够解决弯曲的轨道分割、精确的目标检测以及火车分割等任务, 在检测和分割效果上都有明显的提升.

为了从图像中高效的提取更多特征, 本方法使用了轻量级MobileNet V3[16]作为编码器, 主要是把C3模块换成MobileNet V3模块, 这些特征图被提取出来, 将送入到Neck网络得到3个特征层, 最后送入2个任务的解码器中: 检测头(detect head)、可行驶区域分割头(segment head). 针对目标检测任务, Neck网络使用了“路径聚合”的PAN网络, 可以获得很好特征融合效果; 对于分割任务, 将FPN的3个输出特征层送入到分割模块, 为了融合不同尺度的特征, 分割模块加上FFM特征融合模块[17], 进一步采用了最近邻上采样层以降低计算量. 分割解码器不仅具有高精度输出, 同时推理速度非常快. 因此, 此网络是一种单阶段网络, 包含一个共享编码器, 两个不同任务的解码器, 不同解码器之间没有复杂的、耦合的、冗余的模块, 这可以极大降低计算量, 可以满足端到端训练.

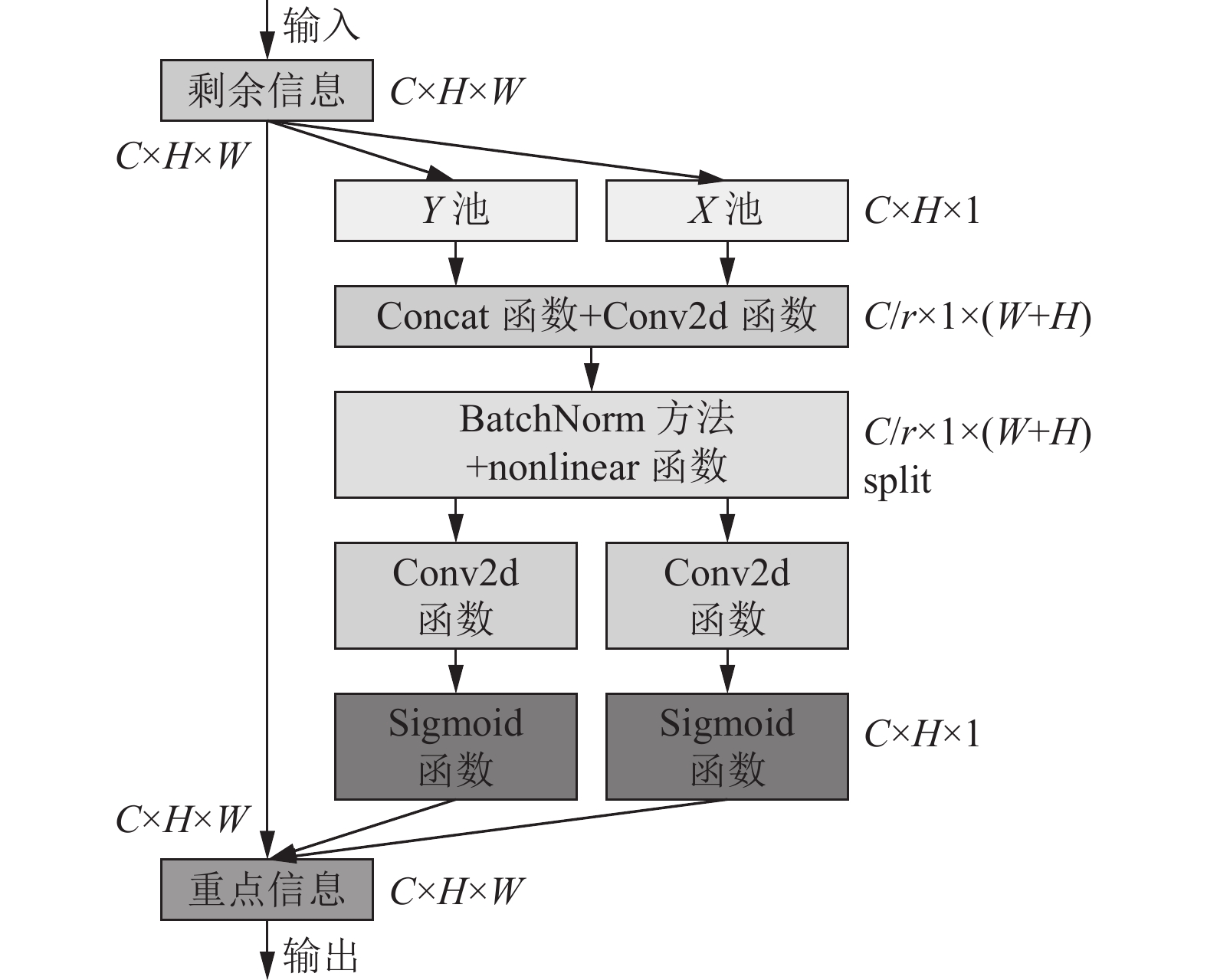

解码器是基于one-stage[18]检测网络YOLOv5, 其具备的主要优点有: (1) one-stage检测网络比two-stage[19]检测网络更快. (2) one-stage检测器基于网格的预测机制与语义分割任务相关. 不同级别和尺度的语义特征在编码器输出的特征图中被融合, 良好地完成像素级语义预测, 如图1所示.

|

图 1 多任务分割网络框架 |

1.1 编码器

编码器由骨干网络(Backbone)和颈部网络(Neck)组成. 其中提取输入图像的特征由骨干网络完成. 它通常由一些经典的图像分类网络构成. 考虑到YOLOv5表现在物体检测上的出色性能, 本文骨干网络选取特征提取网络CSPDarknet[20]. 它能在优化 CSPNet 时解决梯度重复的问题. 特征重用和特征传播会得到支持, 计算量和参数量将得到一定程度的减少, 这比较有益于保证网络的实时性.

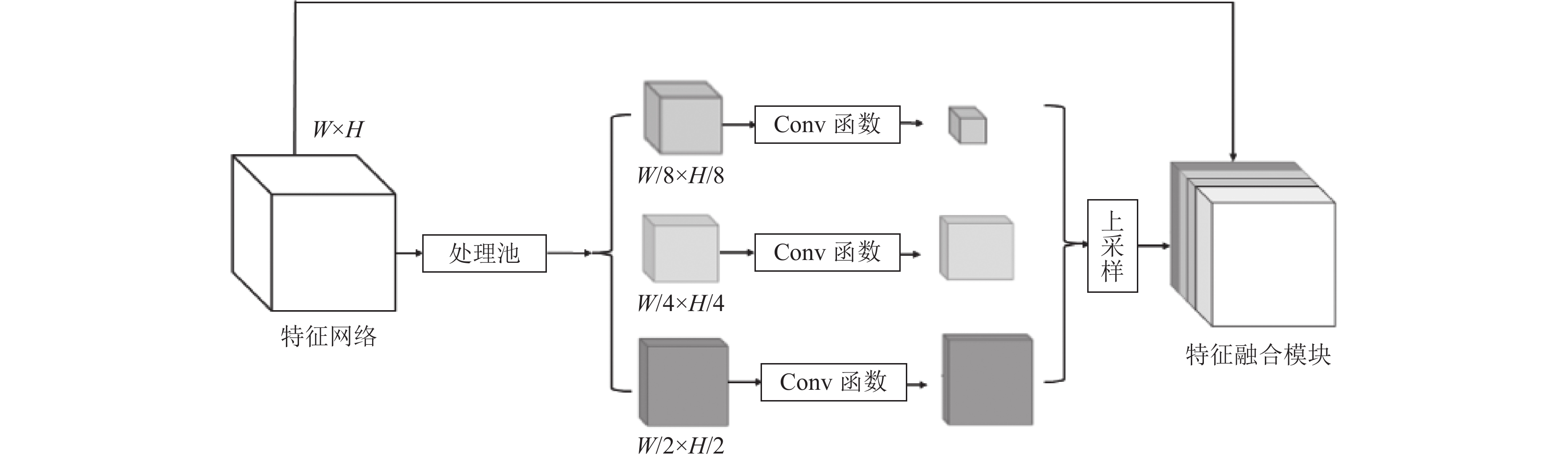

融合骨干网络产生的特征由颈部网络完成, 特征金字塔网络(FPN)模块[21]和空间金字塔池(SPP)模块[22]作为主要部分. 不同尺度的特征在SPP中生成并融合, 而融合不同语义层次的特征则由FPN完成, 多尺度、多语义层次的信息等都将在生成的特征中得到体现, 为了融合这些特征, 本方法采用串联的方法, 将多尺度、多语义层次的信息进行卷积操作进行融合叠加. 特征融合模块如图2所示.

为了让模型精度有所提升, 如图3所示在骨干网络中引入了注意力机制, 注意力机制的核心构架就是想培养系统注意力, 能够将无关信息忽略, 从而只关注重点信息[23].

|

图 2 特征融合模块 |

|

图 3 注意力机制 |

与机器翻译中的注意力机制应用思想相仿, 视觉中的注意力机制其实也是学出一个权重分布, 再将这个权重分布施加于之前的特征上, 以忽略无关信息而关注重点信息. 如图4所示在该网络过中协调注意力机制得到融合, 效果有一定程度的提升. 卷积神经网络的层数的加深的过程, 是特征提取从低层次到高层的语义特征的提取过程. 我们通过连接、卷积、激活处理等, 将低层特征更多的细节信息与高层特征更多的语义信息高效融合, 改善分割模型.

|

图 4 多尺度融合机制 |

1.2 译码器

网络中包含的两个特定解码器检测头与可行驶区域分割头. 其中检测头与YOLOv4的头部在某些程度上相似, 均采用基于锚点(anchor)的多尺度检测方案. 首先, 采用路径聚合网络(PAN)结构[24], 理论上这是一种自下而上的特征金字塔网络. FPN自上而下将语义特征传递, PAN自下而上将定位特征传递, 两者结合从而获得更好的特征融合效果, PAN中的多尺度融合特征图被直接使用, 来进行检测. 每个网格在多尺度特征图里将被分配3个不同长宽比的先验锚点, 位置的偏移量、尺度化的高度和宽度由检测头预测, 对每个类别的分类概率和分类置信度也将被其检测测出来.

可行驶区域分割头采用类似PSPNet结构, 首先提取其中16、19、22的特征层的输出特征, 把他们一起送入分割网络中作为输入, 然后经过特征融合模块进行融合特征, 之后经过SPP模块, 将输入进来的特征层分成6×6、3×3、1×1区域, 每个区域内部各自进行平均池化, 然后经过3个上采样过程, 将输出特征图恢复到原图大小, 通道数是4, 分别代表输入图像中每个像素对于可行驶、不可行驶、火车和背景的概率. 除此之外, 上采样层使用最邻近插值方法以便降低计算成本.

1.3 损失函数由于网络中有两个解码器, 因此多任务损失包含2个部分. 对于

| Ldet=α1Lclass+α2Lobj+α3Lbox | (1) |

其中,

分割损失

| Lce=−[ylogˆy+(1−y)log(1−ˆy)] | (2) |

其中,

| Ldice=1−2|X∩Y||X|+|Y|=1−2TP2TP+FP+FN | (3) |

| Lseg=Lce+Ldice | (4) |

最终损失函数是目标检测损失和分割损失加权和, 如式(5)所示, 其中

| Lall=λ1Ldet+λ2Lseg | (5) |

模型可以单独检测训练、单独分割训练, 然后融合训练与分割方面的内容. 共两个训练方式, 分别为目标检测和分割模型. 本算法采用一步一步的训练方法. 首先, 我们仅训练编码器和检测头; 然后锁定编码器和探测头并训练; 最后整个神经网络由全部两个任务联合训练而成.

算法1. 联合训练算法

输入: 具有参数

输出: 训练后神经网络

1) procedure Train(

2) repeat

3) Sample a mini-batch (

4)

5)

6) until

7) end procedure

8)

9) Train(

10)

11) Train(

12)

13) Train(

14) return trained network

此方法是端到端训练方式, 是

此外, 我们还尝试了一些交替优化范式来逐步训练模型. 在每一步中, 模型可以专注于一个或多个相关的任务, 把不相关的任务放在不同的训练步骤之中. 即使所有任务不都是相关的, 本算法中的端到端的训练模型仍然可以通过这种范式对每个任务进行充分的学习, 通过使用大数据集、减少复杂的共适应关系等, 提高模型泛化能力. 算法说明了一种逐步训练方法的过程.

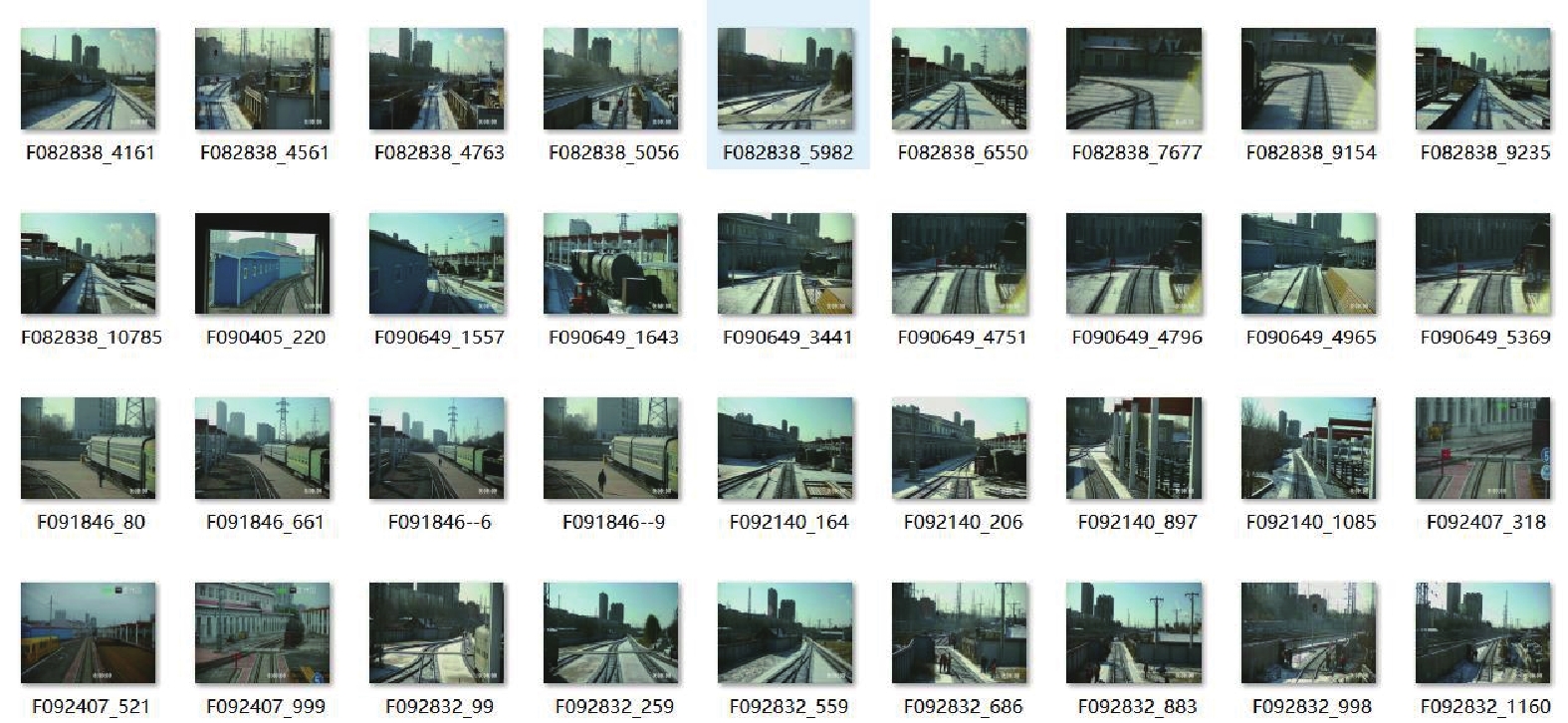

2 可行性实验 2.1 数据集为验证本文算法, 在哈尔滨铁路路段采集数据, 构建检测和分割数据集, 命名为custom数据集. 数据集分为模型分割数据和目标检测数据两部分, 每个部分又由训练数据集和验证数据集组成, 每个训练数据集有近2 000张图片, 每个验证数据集有400张图片, 具有地理、环境和天气多样的特点. 如图5所示为custom数据集的部分展示.

|

图 5 数据集 |

2.2 模型训练

为验证多任务学习算法的可行性, 本文将数据集中的数据分目标检测、分割模型、融合模型3种方式进行训练, 融合模型就是目标检测和分割组合在一起的模型. 检测正确率为所有正样本中正确被预测出来的比例, 作为检测精度的评估指标. 检测平均精度衡量一个类别检测好坏. 分割精度是对所有类别的IOU取平均, 该用于评估不同模型的分割性能. 综合正确率是指预测对的数量对总的预测数量的占比. 表1为3种训练方式下训练得到的结果.

| 表 1 不同模型性能比较 |

由表1中数据可知, 目标检测准确率与融合模型准确率都高于75%, 且融合模型的检测正确率均比单纯目标检测高2.3%. 同时, 单纯目标检测与融合模型的检测平均精度大于75%, 说明数据训练时, 测量的真实性和数据的预测之间具有很强的相关性. 单纯分割模型与融合模型的分割精度分别为93.3%和95.4%. 融合模型较单纯的分割模型分割精度提高了2.1%. 融合模型的综合正确率也高达75.5%.

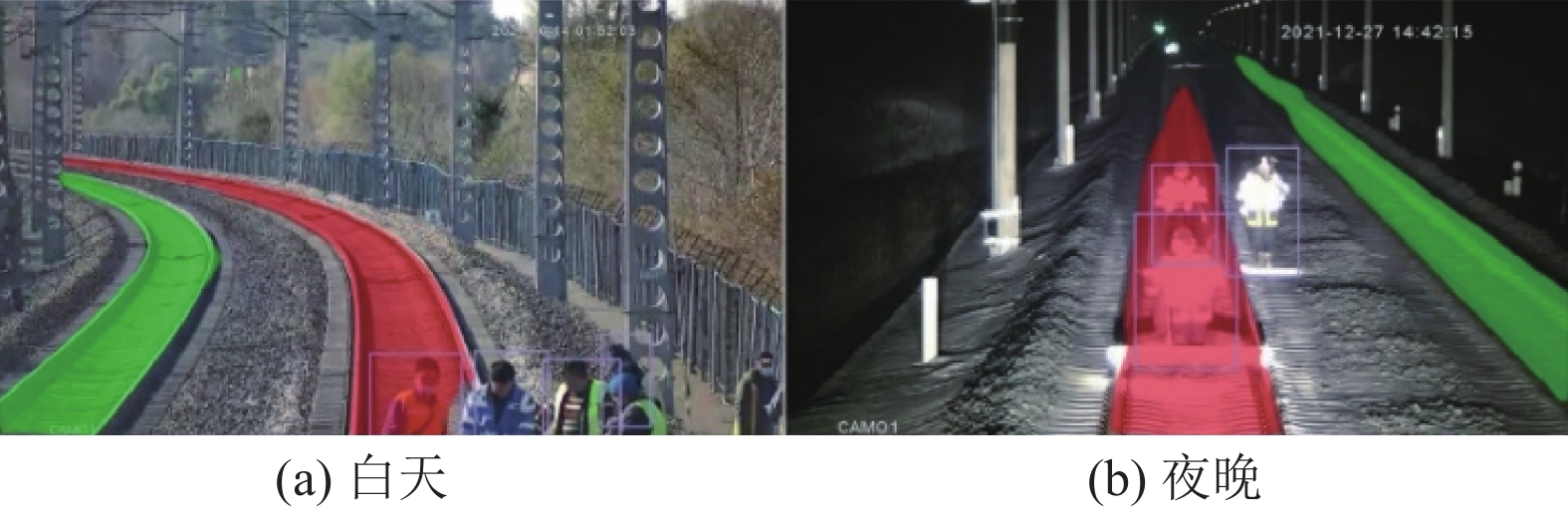

2.3 检测与分割检测效果如图6所示, 可行驶区域用红色标记, 不可行驶区域由绿色标记.

|

图 6 检测效果 |

为了应对复杂多变的环境, 本文构建了白天和夜晚的轨道车数据集, 划分测试和训练数据集, 如图7所示, 该模型可以在白天和夜晚准确检测出人体, 体现了模型具有一定鲁棒性.

|

图 7 白天、夜晚检测图片 |

2.4 算法精度

Baseline+DeepLab+FFM+Att模型为团队对DeepLab的一次改造, 简称DeepLab改进模型. 首先提取了YOLOv5的16、19、22特征层, 把他们一起送入分割网络中作为输入, 然后经过FFM模块进行融合特征, 之后经过pyramid pooling module模块, 将输入进来的特征层分成6×6、3×3、1×1区域, 每个区域内部各自进行平均池化, 然后经过3个上采样过程, 将输出特征图恢复到原图大小. 此外, 上采样层使用最邻近插值方法来降低计算成本而不是反卷积. DeepLabv3+模型的主体是带有空洞卷积的DCNN, 可以采用常用的分类网络如ResNet, 然后是带有空洞卷积的空间金字塔池化模块, 主要是为了引入多尺度信息. 相比于DeepLabv3+模型, 由表2实验数据得, 无论是分割基础模型、DeepLab, 还是DeepLab改进模型, 其分割精度均在90%左右, 说明本文模型可以在90%以上的准确度的前提下, 进行高精度的分割. 3个模型的帧率分别为25.7 Hz、23.1 Hz、22.6 Hz, 极大地提高了推理能力.

| 表 2 精度数据对比 |

3 结论与展望

本文提出一种基于YOLOv5改进的轨道侵入物检测与行驶区域分割多任务学习算法, 通过编码器提取特征图送到解码器中, 编码器中主骨干网络选取特征提取网络CSPDarknet, 运用其优越的性能完成检测任务, 经过分割网络、FFM模块进行融合特征、金字塔池模块, 将输入进来的特征层分成6×6、3×3、1×1区域并各自进行平均池化, 将输出特征图恢复到原图大小, 通道数分别代表输入图像中每个像素对于可行驶、不可行驶、火车和背景的概率完成分割任务. 不同级别和尺度的语义特征在编码器输出的特征图中被融合, 良好地完成像素级语义预测. 为验证本文算法, 构建轨道侵入物检测和轨道分割数据集, 采用了目标检测、分割模型、融合模型3种方式进行训练, 选取多个评估指标, 由实验数据可得, 我们的模型可以在保证足够高的准确度的前提下, 进行高精度的分割.

本算法能够划分列车的正常行驶和非正常行驶区域, 精确、快速地对入侵的侵入物进行检测, 可良好的辅助对侵入物预警工作, 为轨道车行驶安全提供途径.

| [1] |

王强, 刘智平, 王松林, 等. CTCS-1级列控系统总体方案思考与建议. 中国铁路, 2021(2): 81-87. DOI:10.19549/j.issn.1001-683x.2021.02.081 |

| [2] |

曾晓青. ATP子系统列车追踪间隔及防护研究. 铁道运营技术, 2021, 27(2): 24-25. DOI:10.13572/j.cnki.tdyy.2021.02.009 |

| [3] |

刘海波, 盛蒙蒙, 杨晓倩. 一种车载毫米波列车防撞雷达系统研究. 雷达学报, 2013, 2(2): 234-238. DOI:10.3724/SP.J.1300.2013.20091 |

| [4] |

Wu SL, Wang Y, Yang HY, et al. Improved Faster R-CNN for the detection method of industrial control logic graph recognition. Frontiers in Bioengineering and Biotechnology, 2022, 10: 944944. DOI:10.3389/fbioe.2022.944944 |

| [5] |

王鹏飞, 黄汉明, 王梦琪. 改进YOLOv5的复杂道路目标检测算法. 计算机工程与应用, 2022, 58(17): 81-92. DOI:10.3778/j.issn.1002-8331.2205-0158 |

| [6] |

赵红爱, 王旭智, 万旺根. 一种用于车辆图像分割的MSSA-UNet模型. 电子测量技术, 2022, 45(8): 102-107. DOI:10.19651/j.cnki.emt.2208764 |

| [7] |

Wu H, Song HN, Huang JH, et al. Flood detection in dual-polarization SAR images based on multi-scale DeepLab model. Remote Sensing, 2022, 14(20): 5181. DOI:10.3390/rs14205181 |

| [8] |

Wu YQ, Sun YB, Zhang SQ, et al. A size-grading method of antler mushrooms using YOLOv5 and PSPNet. Agronomy, 2022, 12(11): 2601. DOI:10.3390/agronomy12112601 |

| [9] |

Janarthanan P, Murugesh V, Sivakumar N, et al. An efficient face detection and recognition system using RVJA and SCNN. Mathematical Problems in Engineering, 2022, 2022: 7117090. DOI:10.1155/2022/7117090 |

| [10] |

霍爱清, 杨玉艳, 谢国坤. 基于改进YOLOv3算法的车辆目标检测. 计算机工程与设计, 2022, 43(7): 1981-1989. DOI:10.16208/j.issn1000-7024.2022.07.023 |

| [11] |

李浩然, 李镇翰, 吴田, 等. 二维最大熵阈值优化的Canny算子的绝缘子边缘检测研究. 高压电器, 2022, 58(11): 205-211, 220. DOI:10.13296/j.1001-1609.hva.2022.11.026 |

| [12] |

Du WS, Zhu YJ, Li SS, et al. Spikelets detection of table grape before thinning based on improved YOLOv5s and K-means under the complex environment. Computers and Electronics in Agriculture, 2022, 203: 107432. DOI:10.1016/j.compag.2022.107432 |

| [13] |

闫彬, 樊攀, 王美茸, 等. 基于改进YOLOv5m的采摘机器人苹果采摘方式实时识别. 农业机械学报, 2022, 53(9): 28-38, 59. DOI:10.6041/j.issn.1000-1298.2022.09.003 |

| [14] |

Li G, Fu LS, Gao CQ, et al. Multi-class detection of kiwifruit flower and its distribution identification in orchard based on YOLOv5l and Euclidean distance. Computers and Electronics in Agriculture, 2022, 201: 107342. DOI:10.1016/j.compag.2022.107342 |

| [15] |

邢宇驰, 李大军, 叶发茂. 基于YOLOv5的遥感图像目标检测. 江西科学, 2021, 39(4): 725-732. DOI:10.13990/j.issn.1001-3679.2021.04.029 |

| [16] |

Zhang P, Liu XM, Yuan J, et al. YOLO5-spear: A robust and real-time spear tips locator by improving image augmentation and lightweight network for selective harvesting robot of white asparagus. Biosystems Engineering, 2022, 218: 43-61. DOI:10.1016/j.biosystemseng.2022.04.006 |

| [17] |

范艺华, 董张玉, 杨学志. 结合上下文编码与特征融合的SAR图像分割. 中国图象图形学报, 2022, 27(8): 2527-2536. DOI:10.11834/jig.210056 |

| [18] |

Wu XY, Wu ZY, Ju LL, et al. A one-stage domain adaptation network with image alignment for unsupervised nighttime semantic segmentation. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2023, 45(1): 58-72. DOI:10.1109/TPAMI.2021.3138829 |

| [19] |

Sohn S, Byun HE, Lee JH, et al. Two-stage deep learning for online prediction of knee-point in Li-ion battery capacity degradation. Applied Energy, 2022, 328: 120204. DOI:10.1016/j.apenergy.2022.120204 |

| [20] |

Wu D, Liao MW, Zhang WT, et al. YOLOP: You only look once for panoptic driving perception. Machine Intelligence Research, 2022, 19(6): 550-562. DOI:10.1007/s11633-022-1339-y |

| [21] |

Zhu LX, Lee F, Cai JW, et al. An improved feature pyramid network for object detection. Neurocomputing, 2022, 483: 127-139. DOI:10.1016/j.neucom.2022.02.016 |

| [22] |

邓天民, 方芳, 周臻浩. 基于改进空间金字塔池化卷积神经网络的交通标志识别. 计算机应用, 2020, 40(10): 2872-2880. DOI:10.11772/j.issn.1001-9081.2020020214 |

| [23] |

李宗民, 李亚传, 赫俊民, 等. 专注智能油藏储量预测的深度时空注意力模型. 中国石油大学学报(自然科学版), 2020, 44(4): 77-82. DOI:10.3969/j.issn.1673-5005.2020.04.009 |

| [24] |

刘超, 韩懈. 基于SE-YOLOv4的变电站断路器分合状态识别算法. 软件导刊, 2022, 21(9): 40-44. DOI:10.11907/rjdk.212435 |

2023, Vol. 32

2023, Vol. 32