2. 中国石化胜利油田分公司海洋采油厂, 东营 257237

2. SINOPEC Shengli Oilfield Branch Offshore Oil Production Plant, Dongying 257237, China

海洋能源开发是经济稳定快速发展的重要支撑, 也是民生基础设施安全可靠运行的关键保障之一. 保证海洋探测开采平台安全运作生产是推动能源发展的重要前提[1, 2], 其中加强对平台登陆点(靠船排)的管控是保证安全生产的重点, 通过使用一系列的防范技术, 及时对靠船排的登陆情况进行分析, 从而降低该领域的安全风险. 当前, 停泊靠船排作业时仍需要现场人员对作业进度进行管控, 装设于现场的录像设备只起到辅助提供材料作用. 以上监管形式存在管理和控制效率不高、处理过程迟缓等问题, 同时需要较高的人力成本, 会造成一定的经济损失.

随着全球化的迅猛发展, 人工智能、数字化技术等已广泛应用于各行业的实践中, 其中智能油田的建设已成为整个石油行业转型增效的关注重点[3]. 以人工智能为核心驱动力, 从而开发智能监管系统对靠船排登陆现场实行安全检测是智能油田建设中的重要一环. 利用视频设备对作业过程中的违章情况进行实时检测, 智能监管系统可以实现所有时段的安全监管, 在节省人力成本的同时, 有效减少登陆往返平台过程中的安全隐患, 提高作业效率[4].

跳板作为登陆往返开采平台运维作业中必不可少的辅助工具. 其作用在于保证往返船舶和作业平台之间的工作人员的安全, 从而降低人员落水风险. 在人员换值、物资运输、平台维护等作业工程中, 船舶完成停靠后, 需要搭设跳板进行往返作业. 但现实中存在部分员工安全意识较差, 出现未在登陆平台预先搭设跳板的状况, 对作业带来较大安全隐患. 在作业任务繁重或作业场景复杂导致视野受限等情况下, 现场监管人员对所有的违章行为都难以做到监控, 极易引发安全事故. 鉴于以上情况, 设计一种能够实时自动监测跳板搭设情况的措施方法应用于靠船排场景下的安全监管中势在必行.

1 相关工作 1.1 靠船排安全管控靠船排安全管控主要针对来往船只的靠泊预警、靠泊后的安全设备搭设等进行管控. 但大多数需要监管人员现场监督, 按照施工安全要求依次排查, 效率低下且成本较高. 随着智能化油田建设工作的逐步开展, 海上平台的设施日益完善, 为丰富辅助人员监管手段提供了必要支撑. 靠船排安全措施检测除了通过激光、GPS[5]与人工监管相结合的方式以外, 还可依靠计算机视觉技术辅助靠泊预警[6, 7]与较少或无人员监管结合的新方式.

1.2 目标检测由于海上作业平台环境较差, 时常出现因海上风浪较大导致视频传输卡顿或摄像头视角突然转向等情况. 因此本研究重点考虑跳板是否搭设的事件结果而非事件过程, 即研究重心为检测单帧图像是否搭设跳板而非搭设跳板的过程行为. 综上, 本文采用了单帧检测效果更优秀、更符合实际情况的目标检测模型, 而非具有时间序列关系的深度检测模型. 当下目标检测领域随着卷积神经网络的诞生和发展有了很大的进步[8]. 当下主流的目标检测模型虽然基本满足实时性, 但检测速度表现较好的大多仍是one-stage结构的检测模型. 其中主要分为两种思想流派: 基于先验框与无先验框. 基于先验框的方法使特征图经过区域候选网络或其他区域选择算法生成一系列预先定义好的矩形框作为候选框, 之后这些候选框所对应的特征图进行分类和回归从而得到目标区域. 而无先验框则是摒弃先验框的思想, 利用关键点进行回归获取目标框. 两者代表分别为YOLO系列方法[9]与2018年Law等人提出的CornerNet[10]. 前者受到区域建议网络(RPN)[11]影响, 引入先验框沿用至今. 后者通过回归预测左上角和右下角的角点检测目标. Zhou等人[12]与Duan等人[13]依照CornerNet思想分别衍生出ExtremeNet与CenterNet. 它们分别通过预测极值点和中心点与预测角点及中心点来回归获取目标. 近两年Transformer结构网络进入计算机视觉领域, 带来喜人的表现. 在Transformer网络基础上, Carion等人提出端到端的目标检测新框架DETR[14], 但小目标检测效果不佳. 2022 年Liu等人提出Swin Transformer[15]意在替代现有目标检测网络主干, 具有巨大的研究潜力, 但目前表现相较于成熟目标检测算法仍不出色.

1.3 边缘检测虽然目标检测检技术已经十分成熟, 但其仍无法获取目标细致轮廓, 在判断目标间位置关系方面有很大局限性. 近几年, 图像描述领域[16]的模型中存在对图像中目标间相对位置的大致描述[17], 但其仅限于方位词的描述, 无法提供更细致的位置关系. 此外, 本文样本数量有限, 采用图像描述模型易造成"物体幻觉"问题的发生[18], 即检测出场景中不存在的对象, 极大的影响下一步的判别. 因此, 为获得更细致的目标间的位置关系, 本文考虑利用边缘检测的方法以提取目标轮廓.

边缘检测早期依靠传统的算子Sobel、Canny提取物体轮廓, 其研究中心主要是如何设计滤波器以获得局部相邻元素的像素的最高梯度, 但其仅考虑到像素间颜色或亮度差异忽略了更大感受野中的纹理特征. 2004年, Martin等人[19]引入纹理特征, 提出Pb算法. 2011年, Arbeláez等人引入多尺度和SVD的局部线索改进了Pb算法的变种gPb[20]. 随着卷积神经网络的提出, 边缘检测领域研究由低层次特征的结合转变到如何抽取高层次有效抽象特征. 2015年, Bertasius等人提出Deep-Edge[21]将轮廓检测问题抽象为成分分类和回归综合问题. 同年, Xie等人提出一种基于FCN[22]和深度监督网络的边缘检测算法HED[23]. 其采用多尺度融合抽象出边缘特征, 实验结果明显优于传统边缘检测算子. 在其基础上又相继出现CEDN、RCF[24]、CED[25]、RCN[26]等一系列方法. 边缘检测虽然已经取得了不错的效果, 但对于轮廓的描绘较为粗犷, 从而造成轮廓间的相互侵染, 增大轮廓提取难度.

2 整体思路为有效解决靠船排场景下船舶靠泊时跳板搭设管控问题, 本文提出一种目标检测与边缘检测相结合的智能监控方法. 首先对现场监控视频进行取帧, 利用YOLOv5[27]算法检测船舶、靠船排以及跳板位置, 根据检测位置截取图像, 并利用边缘检测PiDiNet算法[28]对其进行轮廓提取, 通过设计算法判断是否存在船舶已经停靠但跳板未搭设情况. 最终提出一种端到端的跳板搭设检测算法, 其是由目标检测, 边缘检测以及特定判别算法相结合而成.

2.1 算法结构图1描述了本文设计的目标检测与边缘检测相结合的跳板搭设检测方法的具体流程. 首先通过网络接口获取流媒体服务器中视频流, 截取帧图像, 将该图像输入至YOLOv5网络获取船舶、靠船排、跳板位置信息. 针对位置信息截取图片, 将其作为PiDiNet网络的输入, 获取目标轮廓信息. 之后利用判别算法, 得出本张图片是否存在未搭设跳板情况. 如果存在, 则对其中的违规目标区域进行标识并针对检测结果生成异常信息保存至本地.

|

图 1 整体流程图 |

2.2 对于YOLOv5的改进

YOLOv5s主要包括特征提取网络(backbone)、特征融合网络(neck)、预测网络(head) 这3个模块组成. Backbone模块对预处理后的数据进行特征提取得到feature map. Neck模块将不同层次的feature map进行融合, 使特征图拥有语义特征的同时拥有位置特征, 检测性能从而得到提升. Head模块针对特征图进行边界框回归预测, 通过损失函数修正网络, 并对预测出的边界框进行非极大值抑制, 排除干扰项输出预测边界框. 由于跳板目标较小且所处环境背景复杂, 因此减少背景噪声干扰是主要解决问题, 原有的YOLOv5s网络对于小目标检测效果较差. 针对上述问题, 对YOLOv5s网络进行改进, 网络结构如图2所示, 调整如下.

(1)引入卷积注意力机制(SCAM): 注意力机制主要分为空间注意力机制、通道注意力机制以及混合注意力机制3种. 本文针对混合注意力模块(convolutional block attention module, CBAM)进行改进, 提出空间-通道注意力模块 (spatial channel attention module, SCAM), 使模型可以在更准确的注意力区域获取更多的有效特征. 如图3所示. 首先利用CAM与特征图

| $ Z_c= {\textit{Sigmoid}} \left( \begin{gathered} conv\left( {AvgPool\left( Y \right)} \right) + conv\left( {MaxPool\left( Y \right)} \right) \end{gathered} \right) $ | (1) |

将其与输入的特征图

| $ {{Y_c = Y}} \otimes {{Z_c}} $ | (2) |

| $ {{Z_s}} = {\textit{Sigmoid}}\left( {conv\left( \begin{gathered} AvgPool\left( Y \right), MaxPool\left( Y \right) \end{gathered} \right)} \right) $ | (3) |

其融合了通道和空间注意力. 与CBAM不同的是, 并未将

| $ Y_s = Y \otimes Z_s $ | (4) |

| $ Z_{CS} = {\textit{Sigmoid}}\left( {Y_C \oplus Y_S} \right) $ | (5) |

将两者加和目的是进一步综合空间和通道两个维度的特征, 互补应用于输入特征图. SCAM作为通用模块, 可以嵌入YOLOv5网络结构中, 进行端到端的训练.

|

图 2 改进后的YOLOv5s的网络结构图 |

|

图 3 空间通道注意力模块 |

(2)引入注意力特征融合模块(CB-AFF): YOLOv5多尺度特征融合方法的通常操作是特征的简单求和或拼接, 使得不同尺度特征图以固定权重分配特征, 从而忽视不同尺度特征图间的差异. 这种操作方式很容易丢失语义丰富且分辨率较低的特征图中小目标的有效特征信息, 从而造成漏检[28]. 为解决此问题, 本文从特征融合角度出发, 设计了一种基于CBAM的混合注意力(SB-AFF)模块. 核心思路是在特征融合过程中加入注意力机制, 通道、空间双维度混合, 对不同尺度特征图分配注意力权重, 动态地改变融合特征权重分配, 提高模型对小目标特征提取能力提升. 具体公式表示如下:

| $ CBAM\left( X \right) = {\textit{Sigmoid}}\left( \begin{gathered} Z_s\left( {Z_c\left( X \right) \otimes X} \right) \otimes \left( {Z_c\left( X \right) \otimes X} \right) \end{gathered} \right) $ | (6) |

| $ Z = \left( \begin{gathered} CBAM\left( {X \oplus Y} \right) \otimes X + \left( {1 - CBAM\left( {X \oplus Y} \right)} \right) \otimes Y \end{gathered} \right) $ | (7) |

其中,

图4为CB-AFF模块的结构示意图, 本文没有分别计算

PiDiNet网络采用新的像素差卷积, 将传统的边缘检测算子集成到现CNN模型的卷积操作中, 相较于后者, 其模型架构兼顾边缘梯度敏感的同时更加轻量化. 其网络主要分为3个部分: 主干部分(efficient backbone)、边缘生成部分(efficient side structure)、损失函数(loss function). Efficient backbone主要有4个阶段, 其中阶段间有最大池化层进行下采样链接, 提取不同尺度的边缘特征图. Efficient side structure将上个模块中每个阶段的边缘特征图进行进一步丰富细化生成每个阶段的边缘图. 调用损失函数计算生成的边缘图与真实值的损失, 以进一步修正网络参数, 网络模型结构如图5所示. 由于使用该模型提取的边缘较为粗犷, 很难区分目标间的细致边缘[29], 因此对该模型的损失函数部分进行改进. 具体调整如下.

|

图 4 混合注意力特征融合模块 |

|

图 5 边缘检测PiDiNet网络结构图 |

(1)改进损失函数: PiDiNet网络中所采用的损失函数是边缘检测网络中最常用的加权交叉熵函数. 网络模型使用该函数能够有效地识别出目标的边缘. 但生成的结果边缘都过厚, 从而导致相邻但不相互遮挡的目标边缘重叠, 无法准确生成目标轮廓. 假设一张图片中所有像素点为所有数据, 而属于边缘的像素点只占所有像素点的小部分, 因此边缘检测属于类不平衡问题. 受骰子系数解决类不平衡问题启发, 本文将骰子系数引入损失函数中, 公式如下:

| $ Ldice\left( {P, G} \right) = Dist\left( {P, G} \right) = \frac{{\displaystyle\sum\nolimits_i^N {p_i^2} + \displaystyle\sum\nolimits_i^N {g_i^2} }}{{2\displaystyle\sum\nolimits_i^N {{p_i}{g_i}} }} $ | (8) |

| $ Lcross\left( {P, G} \right) = - \sum\nolimits_i^N {\left( \begin{gathered} {g_i}\log {p_i} + \left( {1 - {g_i}} \right)\left( {1 - \log {p_i}} \right) \end{gathered} \right)} $ | (9) |

| $ L\left( {P, G} \right) = \alpha Ldice\left( {P, G} \right) + \beta Lcross\left( {P, G} \right) $ | (10) |

其中,

安全措施的判别严重依赖目标间的空间关系. 本文提出一种基于目标边缘的安全措施判别算法, 让其判断跳板是否按照要求搭设. 首先利用改进的YOLOv5对其进行目标检测, 若检测结果数组标签中同时含有船舶、靠船排对象, 则将截取图像中两者对应部分依次输入边缘检测模型中, 得到两者边缘轮廓分别记为RimBoat、RimBoatrow. 利用moments函数计算轮廓的空间矩特征Mv: 零阶矩Mv[m00]、一阶矩(Mv[m10], Mv[m01]), 由式(11)得到轮廓质心(Cxv, Cyv).

| $\left\{ \begin{array}{l} M_v = moments\left( {Rimv} \right) \\ (Cx_v, Cy_v) = \left( M_v\left[ {m10} \right]/M_v\left[ {m00} \right] , M_v\left[ {m01} \right]/M_v\left[ {m00} \right] \right) \\ v \in \left\{ {Boat, Boatrow} \right\} \\ \end{array} \right.$ | (11) |

为确定船舶是否停靠以及跳板是否搭设, 设计算法1.

算法1. 安全措施判别算法

1) 将边缘轮廓点集RimBoat按照其质心(CxBoat, CyBoat)分为4个子点集, 依次表示在质心上部(x≤CyBoat)的点集CtopBoat、在质心下部(x≥CyBoat)的点集CbottomBoat、在质心左侧(x≤CxBoat)的点集CleftBoat、在质心右侧(x≥CxBoat)的点集CrightBoat.

2) 对于点集RimBoatrow采取同上一步操作.

3) 计算两者质心连线角度angle(0°–90°);

4) 若0°≤angle≤45°, 则进入第5)步; 否则进入第6)步.

5) 若CxBoatrow≤CxBoat则取点集CleftBoat与点集CrightBoatrow, 否则取点集CrightBoat与点集CleftBoatrow; 将提取的点集利用第7)步方法进行计算.

6) 若CyBoatrow≤CyBoat则取点集CtopBoat与点集CbottomBoatrow, 否则取点集CbottomBoat与点集CtopBoatrow; 将提取的点集利用第7)步方法进行计算.

7) 计算点集中点与点的距离, 过滤奇异值后, 取加权平均值dist作为轮廓间距离, 权值由点距质心间连线距离所决定.

8) 判断dist是否超过阈值, 若超过阈值则认为船舶没有靠泊, 结束检测, 否则认为船舶已经靠泊, 进一步判断跳板搭设情况.

9) 若目标检测未检测出跳板, 则返回“unerected”并结束检测, 否则对跳板进行边缘检测, 并利用霍夫变换进一步优化边缘, 返回跳板边缘轮廓点集Rimdrawboard.

10) 由于跳板为规则类矩形对象, 因此取过其质心且平行于两条较长边直线与船舶靠船排质心连线相交角度LinesAngel(0°~90°). 若30°≤LinesAngel≤90°, 则认为未搭设跳板结束检测, 否则进一步比较靠船排船舶间交汇点与跳板质心距离, 若距离小于阈值则认为跳板正常搭设; 否则认为未搭设.

算法1不仅可以检测船舶是否靠泊, 还可以判断跳板是否搭设, 若判断为船舶已靠泊且未搭设跳板, 就发出提示信息并且把当前图像标注保存下来. 为凸显算法逻辑, 流程图如图6所示. 若仅检测船舶是否靠泊, 则可以把算法简化, 省略第9)、10)步.

|

图 6 安全措施判定算法流程图 |

3 实验分析

本文实验主要硬件环境为: 2张NVIDIA GeForce RTX 1080Ti, Inter i5 10400作为中央处理器. 软件环境为: 采用Windows 10系统, 编译语言及版本为Python 3.7.12, 选择PyTorch进行深度学习网络搭建.

3.1 YOLOv5实验本次实验采集可用样本数据3116张, 其中船舶、靠船排、跳板分别标记有2472、2254、1203张. 将该样本数据分为训练集2804张和测试集312张. 以上数据使用Labelme工具框出目标之后转化为PascalVOC格式.

为增强模型泛化性能, 将数据进行随机翻转, 其每一张翻转概率为0.5. 本次实验的评价指标为模型大小, 交并比IoU阈值取0.5时的均值平均精度mAP05以及IoU阈值从0.5到0.95的平均均值平均精度mAP05:95. 每个模型均训练300个epochs, 初始学习率仍沿用默认设置为0.01, 训练过程运用退火算法灵活调成学习率, batch size设置为8, image size设置为640. 试验效果如表1所示

| 表 1 YOLOv5s实验设置及结果 |

综合以上结果, 本文选用了YOLOv5s作为目标检测部分的基本网络, 并加入注意力模块SCAM以及将注意力模块引入特征融合部分, 最终模型可以达到79.1%的mAP05以及54.5%的mAP05:95此外研究还发现, 将混合注意力模块CBAM以及注意力融合模块CBAFF一起使用时, 评价结果并不理想, 说明过多CBAM模块堆叠使感受野受限导致准确率下降.

3.2 综合实验目标检测模型训练完成后, 再与其他部分结合, 如边缘检测算法、安全措施判别算法等, 构建靠船排场景下的搭设跳板检测方法. 为了验证该方法的性能, 本文选取现场场景下船舶靠泊靠船排作业图像300张, 其中合规搭设跳板164张, 不合规136张. 本实验采用检测准确率作为评价指标, 其计算公式如式(13):

| $ f\left( {y_i} \right) = \left\{ \begin{gathered} 1, \; y_i = Y_i \\ 0, \; y_i \ne Y_i \\ \end{gathered} \right. $ | (12) |

| $ ACC = \frac{{\displaystyle\sum\nolimits_{i = 1}^N {f\left( {y_i} \right)} }}{N} $ | (13) |

其中,

为了进一步验证本方法的稳定性以及引入深度学习进行边缘检测的有效性, 本文重复多次上述实验, 并将其结果与使用传统算子进行边缘检测算法的结果进行比较, 结果取多次有效实验的平均值, 实验结果如表2.

| 表 2 边缘检测验证实验结果 |

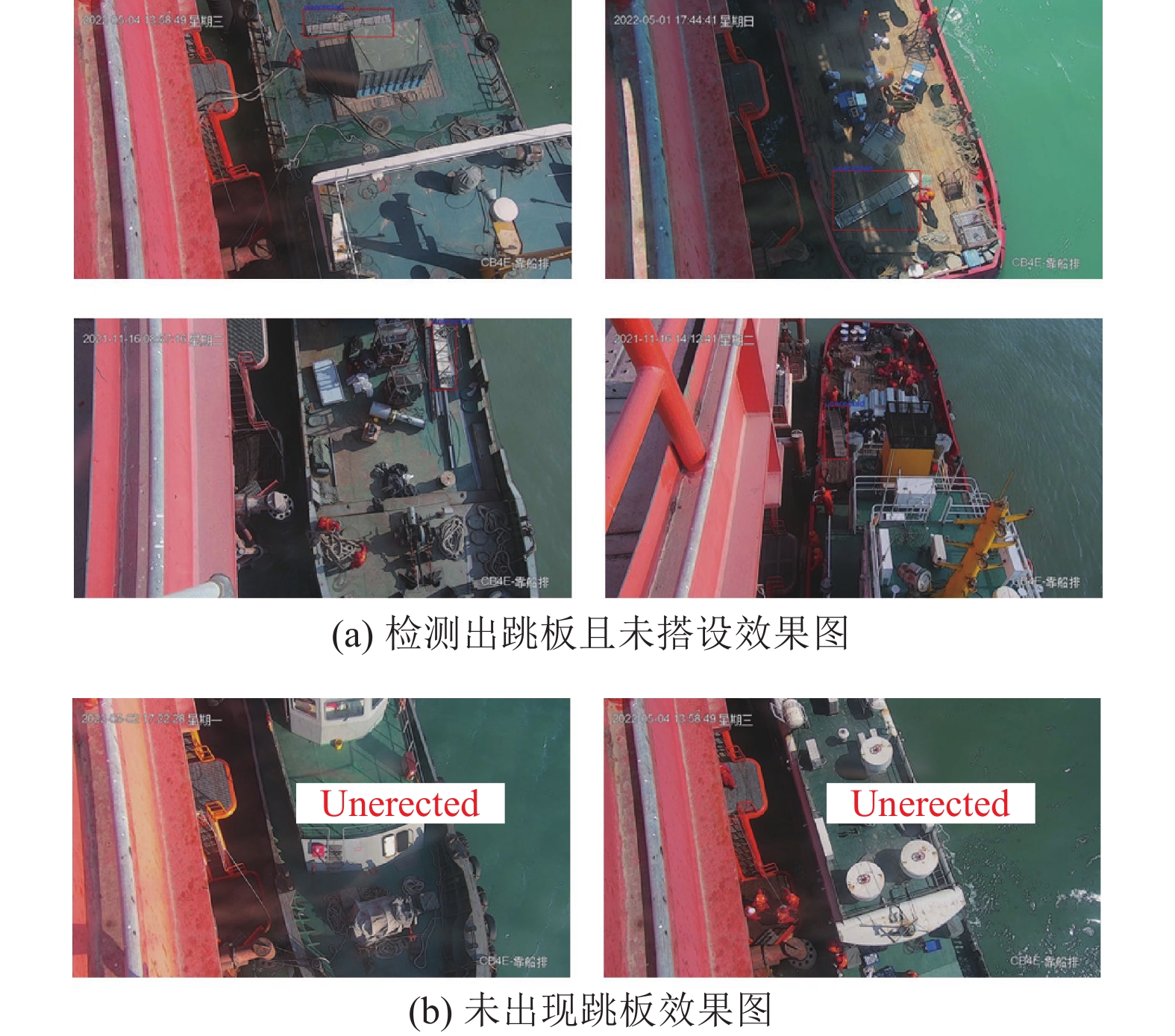

从表2结果得出, 本文利用改进后的边缘检测方法可以有效提升安全措施检测方法的准确性, 准确率相较于传统边缘检测提升19.2个百分点. 误检率下降幅度较大, 误检数量从72.8张减少到16.2张. 改进后的边缘检测方法相较于原PiDiNet边缘检测, 前者边缘轮廓进一步细化, 轮廓间交叠情况减少, 因此误检数量由26.7减少至16.2. 但其漏检指标未明显下降, 是由于漏检数量会受到目标检测算法的影响, 最终实验效果如图7所示.

|

图 7 实验结果图 |

检测到未按照要求搭设跳板的情形分为两种: 若检测到跳板则将跳板信息保存, 通过OpenCV使用矩形框将其标识生成异常信息; 若未出现跳板则只保存该帧图像生成异常信息. 将该信息推送至相关人员并发出警报.

4 结论与展望本文结合深度学习中的目标和轮廓的检测, 以及特定的安全措施判别算法, 提出了一种安全措施的检测方法, 具体应用于靠船排现场. 首先基于数据特点, 改进了YOLOv5网络, 包括提出空间-通道注意力模块, 将混合注意力机制引入特种融合部分. 之后为获取目标的空间特征, 修改边缘检测网络PiDiNet的损失函数, 最后借助目标外接边缘, 结合安全措施判别算法进行违规检测. 实验结果证明, 改进的YOLOv5以及PiDiNet在靠船排场景下的数据集上取得了更好的结果, 提出的安全措施判别算法也能更贴切地检测出视频中的违规行为, 其在具备高精度的同时, 有效满足实际应用中对速度的要求, 能够有效提高海上平台安全管控效能.

另外, 实验结果表明, 在方法上还存在一定数量的漏检和误检现象, 分析结果得出, 对于遮挡较为严重的情况误检以及漏检发生概率较大, 未来将考虑利用多目摄像来进一步丰富目标特征, 提升检测准确性.

| [1] |

范建超, 李富荣, 刘小龙. 海洋钻井平台不安全行为分析及对策. 现代职业安全, 2022(4): 26-28. DOI:10.3969/j.issn.1671-4156.2022.04.012 |

| [2] |

郭燕群, 罗进军, 姜海瑞, 等. 海洋石油作业中人的不安全行为控制的探讨. 中国石油和化工标准与质量, 2021, 41(24): 54-55. DOI:10.3969/j.issn.1673-4076.2021.24.026 |

| [3] |

毕岩滨. 浅谈国内外智能油田建设现状. 中国石油和化工标准与质量, 2022, 42(8): 100-102. DOI:10.3969/j.issn.1673-4076.2022.08.035 |

| [4] |

聂晓炜. 智能油田关键技术研究现状与发展趋势. 油气地质与采收率, 2022, 29(3): 68-79. |

| [5] |

徐承军, 黄庆林, 吴建曲. 船舶离靠泊辅助系统的发展与展望. 港口装卸, 2020(5): 50-55. DOI:10.3963/j.issn.1000-8969.2020.05.016 |

| [6] |

李达, 吕柏呈, 武文华, 等. 海洋平台现场监测技术现状及展望. 中国海上油气, 2022, 34(2): 165-179. DOI:10.11935/j.issn.1673-1506.2022.02.019 |

| [7] |

穆胜军, 汪伟奎, 张华, 等. 船舶智能辅助靠泊系统研究与开发. 珠江水运, 2021(22): 111-112. |

| [8] |

Zaidi SSA, Ansari MS, Aslam A, et al. A survey of modern deep learning based object detection models. Digital Signal Processing, 2022, 126: 103514. DOI:10.1016/j.dsp.2022.103514 |

| [9] |

邵延华, 张铎, 楚红雨, 等. 基于深度学习的YOLO目标检测综述. 电子与信息学报, 2022, 44(10): 3697-3708. DOI:10.11999/JEIT210790 |

| [10] |

Law H, Deng J. CornerNet: Detecting objects as paired keypoints. International Journal of Computer Vision, 2020, 128(3): 642-656. DOI:10.1007/s11263-019-01204-1 |

| [11] |

Ren S, He KM, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. DOI:10.1109/TPAMI.2016.2577031 |

| [12] |

Zhou XY, Zhuo JC, Krähenbühl P. Bottom-up object detection by grouping extreme and center points. Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Long Beach: IEEE, 2019. 850–859.

|

| [13] |

Duan KW, Bai S, Xie LX, et al. CenterNet: Keypoint triplets for object detection. Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision (ICCV). Seoul: IEEE, 2019. 6568–6577.

|

| [14] |

Carion N, Massa F, Synnaeve G, et al. End-to-end object detection with transformers. Proceedings of the 16th European Conference on Computer Vision. Glasgow: Springer, 2020. 213–229.

|

| [15] |

Liu Z, Lin YT, Cao Y, et al. Swin transformer: Hierarchical vision transformer using shifted windows. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision. Montreal: 2021. 9992–10002.

|

| [16] |

Ghandi T, Pourreza H, Mahyar H. Deep learning approaches on image captioning: A review. arXiv:2201.12944, 2022.

|

| [17] |

Wang P, Yang A, Men R, et al. OFA: Unifying architectures, tasks, and modalities through a simple sequence-to-sequence learning framework. Proceedings of the 39th International Conference on Machine Learning. Baltimore: PMLR, 2022. 23318–23340.

|

| [18] |

Rohrbach A, Hendricks LA, Burns K, et al. Object hallucination in image captioning. Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. Brussels: ACL, 2018. 4035–4045.

|

| [19] |

Martin DR, Fowlkes CC, Malik J. Learning to detect natural image boundaries using local brightness, color, and texture cues. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2004, 26(5): 530-549. DOI:10.1109/TPAMI.2004.1273918 |

| [20] |

Arbeláez P, Maire M, Fowlkes C, et al. Contour detection and hierarchical image segmentation. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(5): 898-916. DOI:10.1109/TPAMI.2010.161 |

| [21] |

Bertasius G, Shi JB, Torresani L. DeepEdge: A multi-scale bifurcated deep network for top-down contour detection. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston: IEEE, 2015. 4380–4389.

|

| [22] |

Long J, Shelhamer E, Darrell T. Fully convolutional networks for semantic segmentation. Proceedings of the 2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston: IEEE, 2015. 3431–3440.

|

| [23] |

Xie S, Tu Z. Holistically-nested edge detection. Proceedings of the 2015 IEEE International Conference on Computer Vision (ICCV). Santiago: IEEE, 2015. 1395–1403.

|

| [24] |

Liu Y, Cheng M M, Hu X W, et al. Richer convolutional features for edge detection. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 5872–5881.

|

| [25] |

Wang YP, Zhao X, Huang KQ. Deep crisp boundaries. Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017. 1724–1732.

|

| [26] |

Kelm AP, Rao VS, Zölzer U. Object contour and edge detection with refinecontournet. Proceedings of the 18th International Conference on Computer Analysis of Images and Patterns. Salerno: Springer, 2019. 246–258.

|

| [27] |

Liu S, Qi L, Qin HF, et al. Path aggregation network for instance segmentation. Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Salt Lake City: IEEE, 2018. 8759–8768.

|

| [28] |

Su Z, Liu WZ, Yu ZT, et al. Pixel difference networks for efficient edge detection. Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision (ICCV). Montreal: IEEE, 2021. 5097–5107.

|

| [29] |

Cao YJ, Lin C, Li YJ. Learning crisp boundaries using deep refinement network and adaptive weighting loss. IEEE Transactions on Multimedia, 2021, 23: 761-771. DOI:10.1109/TMM.2020.2987685 |

2023, Vol. 32

2023, Vol. 32