随着人工智能技术的蓬勃发展和互联网数据的日益递增, 如何从海量的非结构化数据中提取出结构化信息逐渐成为自然语言处理(natural language processing, NLP)领域的研究热点. 信息抽取(information extraction, IE)作为自然语言处理的3大任务之一, 其目标就是从非结构化的文本中提取结构化信息, 这种方式是构建和扩充新的知识图谱以及结构化知识库的重要前置技术. 关系抽取(relation extraction, RE)属于信息抽取的一个重要步骤, 旨在基于两个给定实体的相关上下文中提取实体之间的对应关系. 因为具有提取文本信息的能力, 所以有利于NLP领域的很多应用(如信息检索、对话生成和问题回答等).

传统监督模型在关系抽取任务中得到了广泛的探索. 然而, 他们模型上的表现在很大程度上取决于训练数据的规模和质量. 为了构建大规模的数据, Mintz等人[1]提出了一种新的远程监督机制, 通过将现有的知识库与文本对齐来自动标注训练示例构建数据集, 而这属于一种弱监督的学习方式. 因为远程监督构建语料效率高、人工成本低的缘故吸引了许多国内外研究者的关注. 远程监督关系抽取的第1个挑战是噪声标签, 为了解决这一问题, 一些研究者试图通过整合外部信息来丰富模型的背景知识. 一般来说, 外部信息, 如实体描述[2]、实体类型[3]和知识图谱[4], 将被编码为向量形式, 然后通过简单的连接或注意力机制集成到远程监督关系抽取模型(distantly-supervised relation extraction, DSRE)中, 除了上述隐式知识, 知识库(know-ledge base)中存在一些显式的信息没有充分利用到, 而这种信息可以有效地增强模型在有噪声示例影响下的判别能力. 远程监督关系抽取第2个挑战是长尾关系, 长尾关系是指存在一些关系类别的训练示例数目过少的问题, 该问题在实际应用场景中经常可见. 在最广泛使用的NYT-10数据集[5]中有着大约70%的长尾关系数据, 这就意味着远程监督关系抽取模型在限定数量的训练示例中学习能力十分重要, 因此, 本文探索了一种基于双通道的结合外部知识增强的关系抽取方法, 通过丰富的外部知识信息与文本信息结合, 提高DSRE模型的关系判别能力.

1 相关工作多示例学习(multi-instance learning, MIL)方法[6]是目前远程监督关系抽取的主流方法之一, 其基本思想是将通过远程监督构建的具有相同的实体对的句子文本组成一个包(或称为句包), 并以包为单位进行预测. Zeng等人[7]提出了一种分段卷积神经网络(piecewise convolutional neural networks, PCNN), 该工作使用了预训练的词向量将单词映射到低维度向量空间, 然后使用卷积神经网络对句包文本进行特征提取, 从而能够自动捕捉上下文信息. 注意力机制(attention mechanism)也是目前远程监督关系抽取的热门方法之一, Lin等人[8]提出了一种句子级别的注意力机制(sentence-level attention), 使用了PCNN模型对句包内的句子进行卷积核最大池化操作. 然后对于每个句子与关系向量计算相似度并使用Softmax函数进行归一化, 最后对包内句子进行加权求和获得句包表征. 本文中的句子编码器部分将采取该模型作为基线. 由于现阶段知识库和训练语料的缺失, 使得远程监督所构建的数据集中部分关系类别示例数目过少, 导致关系抽取模型训练不够充分. 辅助信息增强的方法能很好地缓解这种训练不充分的问题, 基本思路是引入额外知识信息来提升模型的关系判别能力, 如实体关系信息、条件约束、知识表示等. Vashishth等人[9]利用知识库中包含的辅助信息(side information)和实体类型信息(entity type)辅助增强关系抽取效果. Li等人[10]使用自注意力机制(self-attention)结合实体信息来实现对语义信息的增强, 利用了自注意力机制可以有效地帮助模型关注更为重要的语义信息. Xu等人[11]结合了知识表示和文本句子表征, 提出了基于异构表征方法来增强远程监督关系抽取. Liu等人[3]结合实体类型对于关系预测的约束作用, 提出了一种多粒度的实体类型约束方法, 并集成到了远程监督关系抽取模型中. 上述工作为辅助信息增强提供了不同思路, 我们可以发现实体类型为DSRE模型理解实体提供了有意义的信息. 并在关系抽取过程中发挥了重要作用.

图卷积神经网络(graph convolutional networks, GCN)已经应用了到NLP的许多经典任务中, 如语义角色标注[12]、依存关系句法分析[13]和机器翻译等. 本文使用了GCN神经网络构建外部知识引入模块, 发现所构建的关系与实体的图结构中边的约束信息也十分重要, 为DSRE模型识别噪声示例提供了直接而有效的先验信息.

2 基于外部知识增强的关系抽取模型 2.1 任务定义给定一个句包B和对应实体对(e1, e2), 远程监督关系抽取任务的目的是预测句包所对应的实体对(e1, e2)的关系ri. 构建图结构三元组G(graph)={T, R, E}, 其中T, R, E分别表示实体类型、关系和边的集合. 本文的目标是结合外部知识中的实体类型和关系类型, 以及实体类型与关系类型之间边的约束信息, 来增强远程监督关系抽取模型知识信息的获取, 从而提升模型整体的性能和效果. 在此基础上进一步研究传统句子编码器和预训练模型编码器对DSRE任务的影响.

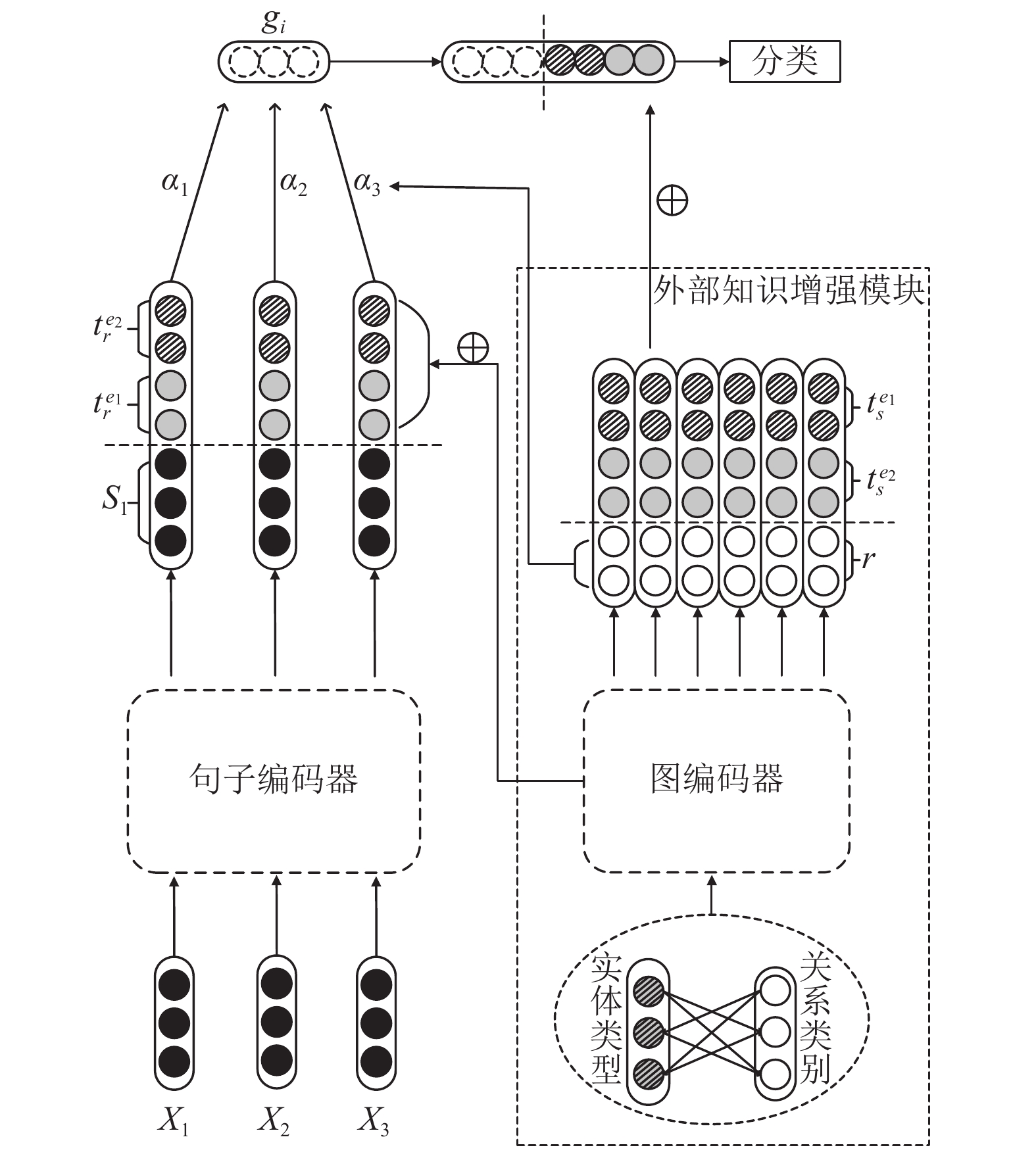

2.2 模型架构本文模型主要分成两个模块. 1)句子编码器模块, 该部分主要目标是完成对句包中句子文本的编码, 将句子由文本信息转化为向量表征. 具体流程见第2.3节和第2.4节. 本文采取传统模型和预训练模型两种句子编码器进行实验探究. 2)外部知识增强模块, 与一般的DSRE模型的管道(pipeline)训练形式不同, 本文使用了双通道的训练形式, 利用句子编码器和外部知识增强模块的图卷积编码器分别抽取句包文本特征和知识库类型信息特征, 再进行特征拼接和融合. 外部知识增强模块的主要任务是将知识库中获得的实体类型和关系类型信息通过GCN神经网络进行编码, 提取相对应的向量表征, 该模块具体流程见第2.5节. 双通道关系抽取模型的整体架构如图1.

|

图 1 模型流程图 |

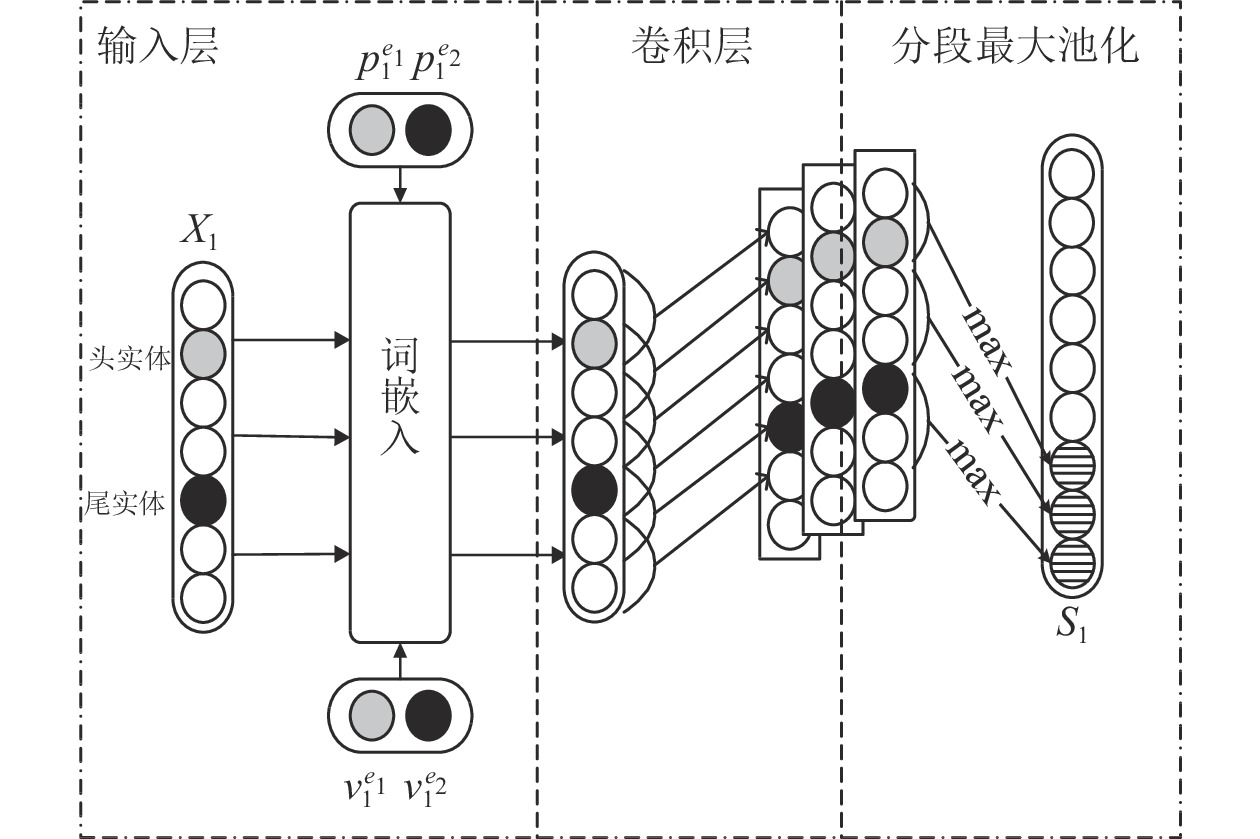

2.3 传统模型句子编码器

对于句子编码器的输入层, 输入一个句子X={x1, …, xn}, n为句子长度, xi表示句子中的每个单词. 通过一个预训练好的嵌入矩阵将每个单词xi转换为一个dw维度的向量vi, 然后用词向量

| xpi=[vi;pe1i;pe2i]∈Rdw+2dp | (1) |

| xei=[vi;ve1i;ve2i]∈R3dw | (2) |

其中,

| Me=Sigmoid(λ⋅(WeXe+be)) | (3) |

| ˜Xp=tanh(WpXp+bp) | (4) |

| X=Me⊗Xe+(1−Me)⊗˜Xp | (5) |

其中,

对于输入序列X={x1, …, xn}, 一维卷积是权重矩阵W与序列X的输入矩阵之间的运算. W为卷积的滤波器, xi是与句子中的第i个单词相关联的输入向量. 一般来说, 让xi:j表示xi到xj的级联, ω表示滤波器的大小. 定义向量qi作为第i个窗口内的ω个词向量的级联, 得到新的序列qi:

| qi=WTxi−ω+1:j,1⩽i⩽m | (6) |

qi的序列长度是nl–ω+1. 因为滑动窗口存在滑出边界的情况, 所以超出长度的部分会填充零元素, 使得向量qi的数量就等于句子nl的长度. 卷积结果是一个特征图矩阵Q={q1, …,

分段最大池化的目的是获取句子序列的结构化信息. 经过卷积层后, 每个特征图Qi按两个实体的位置分为3个部分{

| h={qi1,qi2,qi3} | (7) |

其中,

| s=ReLU(hi:m)∈R3m | (8) |

通过上述句子编码器, 我们可以得到一个句包中每个句子的向量表征s. 传统编码器结构如图2.

|

图 2 传统句子编码器 |

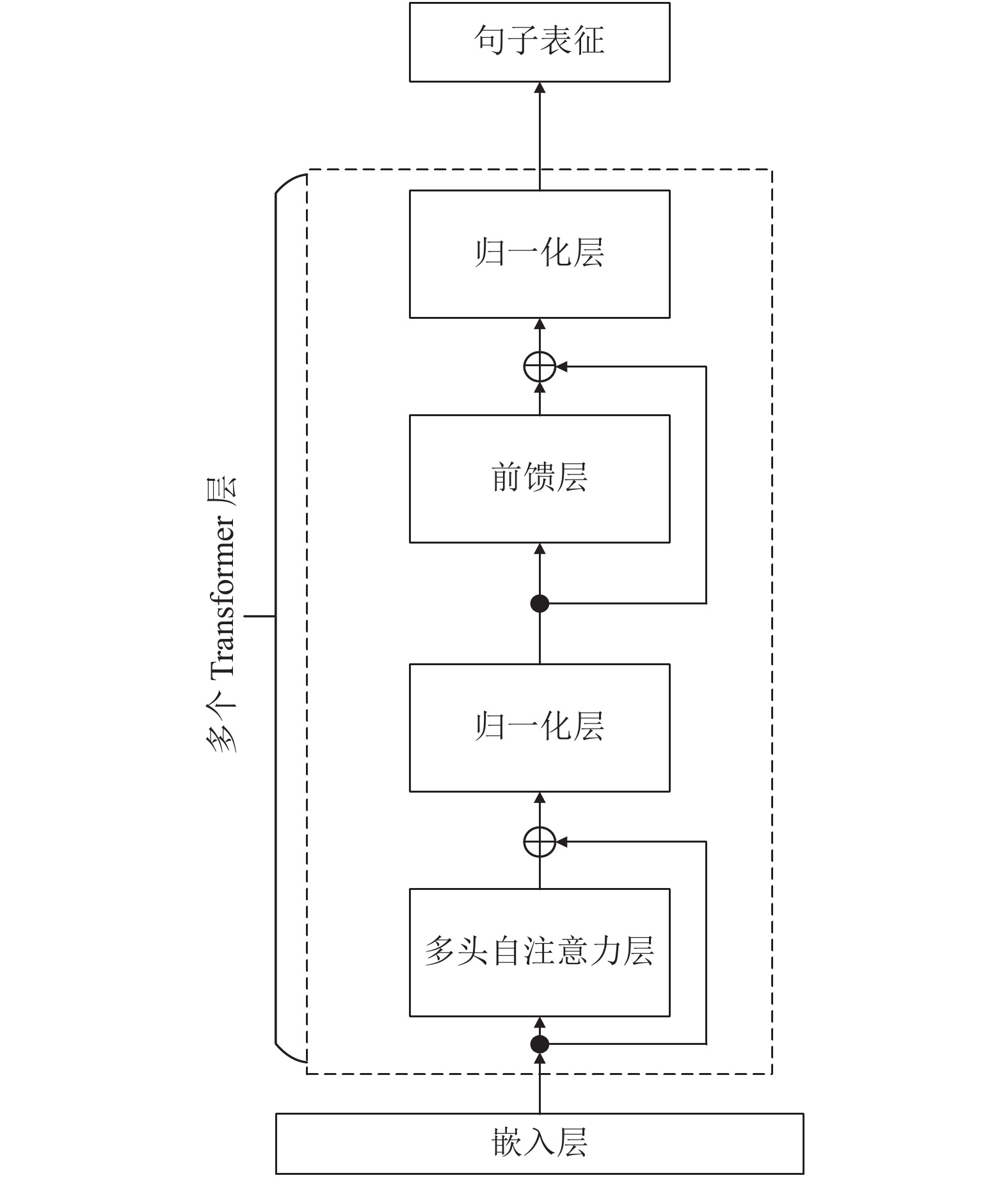

2.4 预训练模型句子编码器

BERT[14]作为预训练语言模型, 在大量的无监督语料上进行了充分的训练. 并且学习了字符级、单词级、句子级以及句间关系的特征, 很好地缓解了传统的Word2Vec、FastText、GloVe等词嵌入方法无法解决的“一词多义”问题. BERT采用了深层的双向Transformer[15]作为组件, 由此学习左右上下文信息, 并生成最终的深层双向语言表征.

本文使用BERT预训练语言模型作为句子编码器进行了实验探究, 将输入句子序列转换为特征向量, 并在DSRE任务上进行了微调. BERT采取了WordPiece的分词算法, 输入为一个标记(token)序列. 在具体的分类任务中, 输入的每一个序列首部插入特定的分类标记[CLS]该分类标记对应的最后一个Transformer隐藏层输出, 用于表示整个序列的表征信息.

在BERT基础上, 本文还采用了RoBERTa模型[16]作为句子编码器进行对比. 相比BERT模型, RoBERTa采取了更为细粒度的BPE分词算法, 并且取消了BERT的下一个句子预测(next sentence prediction, NSP)任务. 在Transformer层的堆叠上两个模型相同, 预训练编码器架构如图3.

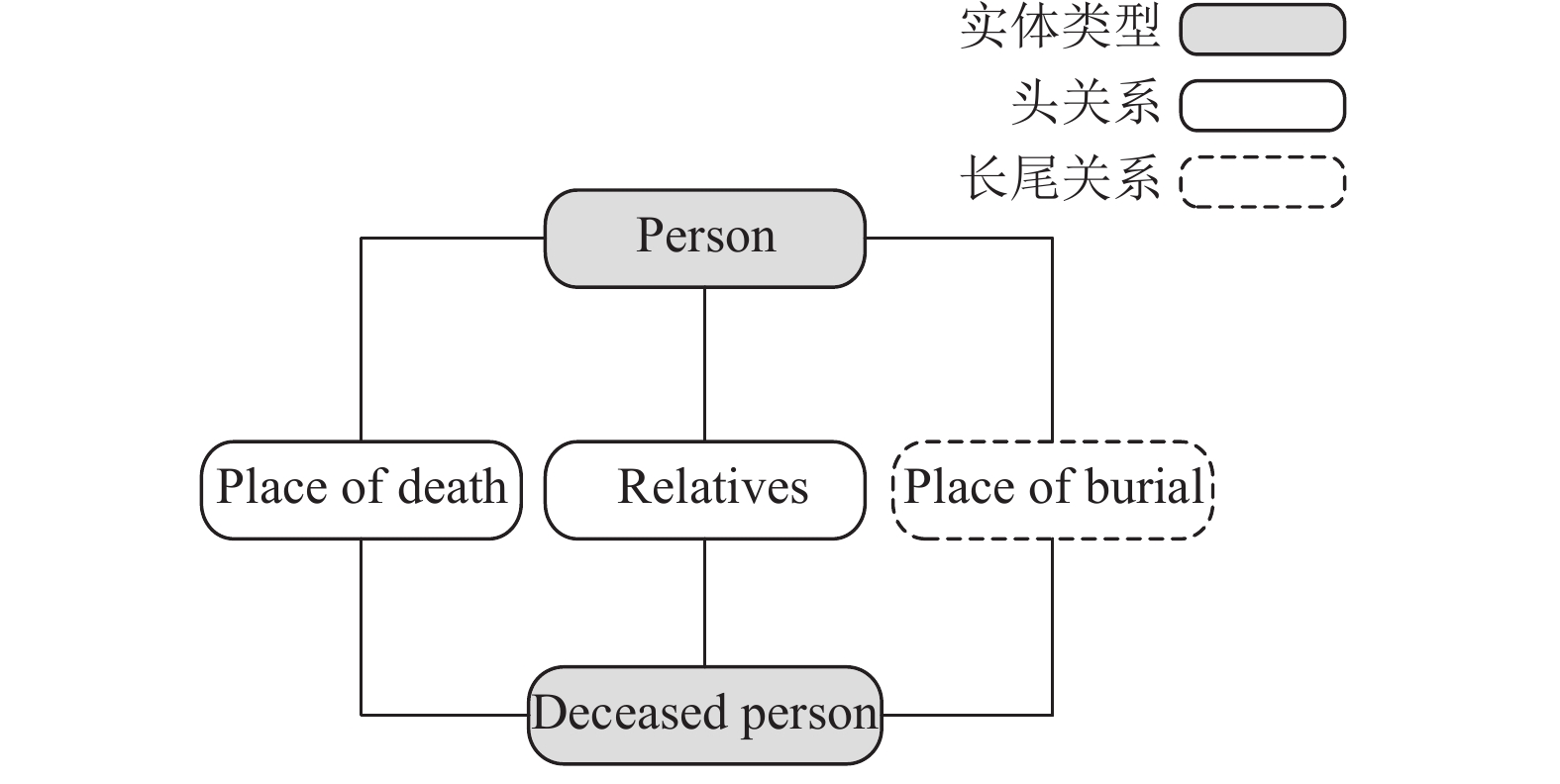

2.5 外部知识增强模块在FreeBase[17]知识库中提供了可以利用的可靠类型信息. 在本文的工作中, 使用了从知识库中获得的实体类型和关系类型信息. 通过NLP工具对每个句子进行命名实体识别, 预处理句子文本获得实体类型信息. 例如, “广州是广东的省会”, 通过命名实体识别可以得到头实体e1“广州”, 对应实体类型是“城市”, 尾实体e2“广东”, 对应实体类型是“省份”, 而实体类型信息将用于最后句包表征构建. 每个实体之间存在多种关系, 构建如图4的图结构, 每个实体之间边的权重就是对应关系. 在预处理过程中会将对应实体转换为知识库中存在的实体类型(如ORG、LOC、PERSON等).

|

图 3 预训练模型编码器 |

|

图 4 图结构示意图 |

同样关系也会转化为知识库中对应的关系类型. 图4中头关系表示数据集中样本数目较多的关系类别, 而长尾关系则表示样本数目较少的关系类别. 利用图卷积神经网络能够聚合相邻节点信息的特点, 使得长尾关系能够聚合更多的信息.

定义图结构为一个三元组G(graph)={T, R, E}, 其中T表示实体类型节点, R表示实体关系节点, E代表边, 从节点ni到节点nj的一条边被表示为(i, j, lr), 其中lr表示关系标签. 节点集合为N(node)=T

| Aij={1,if{ni,nj}∈E0,other | (9) |

对于每个节点ni∈N, 随机初始化一个dn维度的嵌入向量

GCN能够聚合每个节点的相邻节点信息和自身的信息. 为了聚合节点自身的信息, 将自环添加到图结构中, 即Aii=1. 以嵌入节点v(0)和邻接矩阵A作为输入, 利用GCN来提取节点表征. GCN中第k层节点ni的计算可定义为:

| n(k)i=ReLU(∑ni=1AijW(k)n(k−1)i+b(k)) | (10) |

其中, 参数W(k)和b(k)分别代表第k层的权重矩阵和偏置向量. 根据输出表征

由上述两个编码器我们得到句包表征

对于每个句子Si, 本文使用NLP工具来识别其目标实体的类型. 对于未识别的实体类型, 将分配特殊类型Unkown. 假设

| gi=[si;te1r1;te2r2]∈R3dn,1⩽i⩽ns | (11) |

同样, 通过在类型表征矩阵T中查找可以得到实体类型表征

| ci=[ri;te1s1;te2s2]∈R3dn | (12) |

其中, ri和

图卷积编码器是为了得到实体类型

| αi=exp(giri)∑nsj=1exp(gjrj) | (13) |

其中, r为图表征中的关系标签特征, 经过加权求和后可以得到句包表征, 再与实体类型表征

| br=∑nsi=1αigi | (14) |

| ˜b=[br;te1s1;te2s2] | (15) |

最后, 将句包表征

| P(r|B;G;θ)=Softmax(Wbr˜b+br) | (16) |

本文实验采取的是交叉熵损失函数, 公式为式(17), 其中n为句包的数量, rk为句包Bk的标签,

| J(θ)=−1n∑nk=1logP(rk|Bk;G;θ) | (17) |

| k∗=argmax | (18) |

GDS数据集: Jat等人[18]利用谷歌关系抽取语料集对网页信息进行标注得到的数据集, 其中, 训练集有13161个示例、7580个实体对, 测试集包括5663个示例、3247个实体对, 一共有4种语义关系以及NA标签, 具体见表1.

| 表 1 GDS数据集 |

NYT-10数据集: Riedel等人[5]通过将FreeBase和纽约时报语料进行对齐构建了NYT数据集. 其中训练集由2005年和2006年新闻组成, 测试集由2007年新闻组成. NYT数据集包括了52种语义关系和NA标签, 训练集共包括522611个示例、281270个实体对, 测试集包括172448个示例、96678个实体对. GDS数据集和NYT数据集对比见表2.

| 表 2 GDS数据集和NYT数据集 |

3.3 评估标准

在进行远程监督关系抽取性能评估时, 采用了关系抽取常用评价指标进行评估, 包括精确率(precision, P)、召回率(recall, R), 计算公式如下:

| P = \frac{{TP}}{{TP + FP}} | (19) |

| R = \frac{{TP}}{{TP + FN}} | (20) |

其中. TP为真正例, FN为假反例,FP为假正例. 为了直观呈现本实验效果, 还使用了PR曲线(precision-recall curve)和AUC值(area under curve)来将本文模型与基线模型进行对比.

本文使用P@N作为模型评估指标, 该指标是指在句包中选取一定数量的示例进行实验时, 将得分最高的前N个示例进行流出法进而得到精确率. 实验设置为选取一个(one), 两个(two), 全部(all)示例进行训练, 分别评估3种选择下的P@100, P@200和P@300.

3.4 基线模型(1) Mintz[1]: 一种多分类逻辑回归的远程监督关系抽取模型.

(2) PCNN+ATT[8]: 分段卷积神经网络模型作为句子编码器, 加入句子级别的选择注意力机制的远程监督模型.

(3) RESIDE[9]: 一种借助辅助信息和实体类型信息辅助增强的远程监督关系抽取模型.

(4) PCNN+HATT[19]: 一种基于PCNN编码器利用层次化注意力机制的远程监督模型.

(5) PCNN+BATT[20]: 一种基于PCNN编码器利用包级别注意力机制的远程监督模型.

(6) DISTRE[21]: 一种基于GPT-2编码器在远程监督数据集下进行微调的远程监督模型.

(7) DSRE-VAE[22]: 一种基于变分自编码器(VAE)的DSRE模型, 可以通过加入外部知识库的先验知识来进一步改进.

3.5 超参数设置表3、表4中列出了本文实验所使用的超参数, 其中表3为传统模型PCNN和CNN的参数设置, 表4为预训练模型BERT和RoBERTa的参数设置.

| 表 3 传统模型参数设置 |

| 表 4 预训练模型参数设置 |

3.6 实验结果分析

为了评估本文提出方法的有效性, 将其与第3.4节基线模型在GDS和NYT-10数据集上进行实验探究, 具体如表5和表6. 同时为了验证句子编码器对于本文模型的影响, 也使用了预训练模型BERT作为句子编码器并加入外部知识增强模块, 构建成BERT+GCN模型, 可以发现预训练模型BERT在特征提取能力上相较于传统模型PCNN更为优异, 在两个基准数据集上AUC值均有一定提升, 其中GDS数据集上P@100和P@200指标更是达到了99%的SOTA的效果.

本文模型PCNN+GCN与使用了句子级别注意力机制的基线模型PCNN+ATT, 使用了层次注意力机制的PCNN+HATT模型, 以及使用了包级别注意力机制的PCNN+BATT模型在两个数据集上AUC值均有提升. 说明外部信息中的实体类型和所构建图结构中存在的正确的关系规则, 对于降噪和长尾关系抽取两个任务上均有显著改进. 同时句包之间的不同粒度的注意力机制会受文本句包的局限性影响, 认为所有句包中至少有一个句子是拥有正确的标签. 然而通过对远程监督数据集进行分析, 其实存在有大量全是噪声示例的句包, 而句子级别和句包级别注意力机制对于都是噪声示例的噪声包是很难甄别的. 外部信息不会被原本知识库通过远程监督构建的错误标签样本所干扰, 能很好地筛选这些噪声句包, 外部信息中的关系类型信息是知识库中提取的正确的关系规则, 对于错误分配标签的句包能通过注意力机制为之分配较低权重, 从而缓解全噪声句包的问题.

| 表 5 GDS数据集上模型AUC值、P@N |

| 表 6 NYT-10数据集上模型AUC值、P@N |

RESIDE作为外部信息增强的模型基线, 本文模型PCNN+GCN在两个基准数据集上与其相比也有一定提升, 主要原因是PCNN+GCN具备更高效率和性能, RESIDE模型使用了38种实体类型作为外部知识引入, 而本文模型只采用了18种类型却取得了更优的效果. 本文模型相较于RESIDE实体类型信息主要针对的长尾实体, 这些长尾实体因为训练示例数目较少从而使得模型难以充分学习到上下文信息. 而且RESIDE模型采取的别名信息, 在本文的BERT-GCN模型中是可以通过预训练模型在大规模语料的预训练中提前获取的, 因此提供的外部信息会相对冗余. 本文提出的轻量级PCNN+GCN因为本身所提供外部实体类型较少, 实际训练过程中效率更高, 且针对性地选取了一些长尾实体类型, 在面对长尾问题上处理更为优秀.

本文模型相较于主流最优模型DSRE-VAE在两个基准数据集上AUC值均有提升. 本文提出的外部知识增强模块与DSRE-VAE引入的外部KB知识不同. 外部知识增强模块主要利用了图结构中的关系类型和实体类型信息, 而DSRE-VAE利用了KB知识库的先验知识, 通过图嵌入的方式来进行外部知识引入. 但DSRE-VAE构建的先验知识规模要远远大于本文所提出的外部知识增强模块所构建的图结构信息. 因此在P@200和P@300指标上都要优于本文模型. 但本文模型在AUC值上的提升意味着模型整体鲁棒性更强, 主要原因是因为外部信息规模太大导致的, 大量的外部信息可能存在冗余, 使得模型训练效率不高, 且没有针对性的选取长尾实体类型, 使得缓解长尾问题任务上不占优势. 但DSRE-VAE模型所提出的概率模型, 对于句子表征空间的描述类似于知识库, 可解释性更强, 未来工作也会考虑将该先验知识空间集成到本模型进行优化.

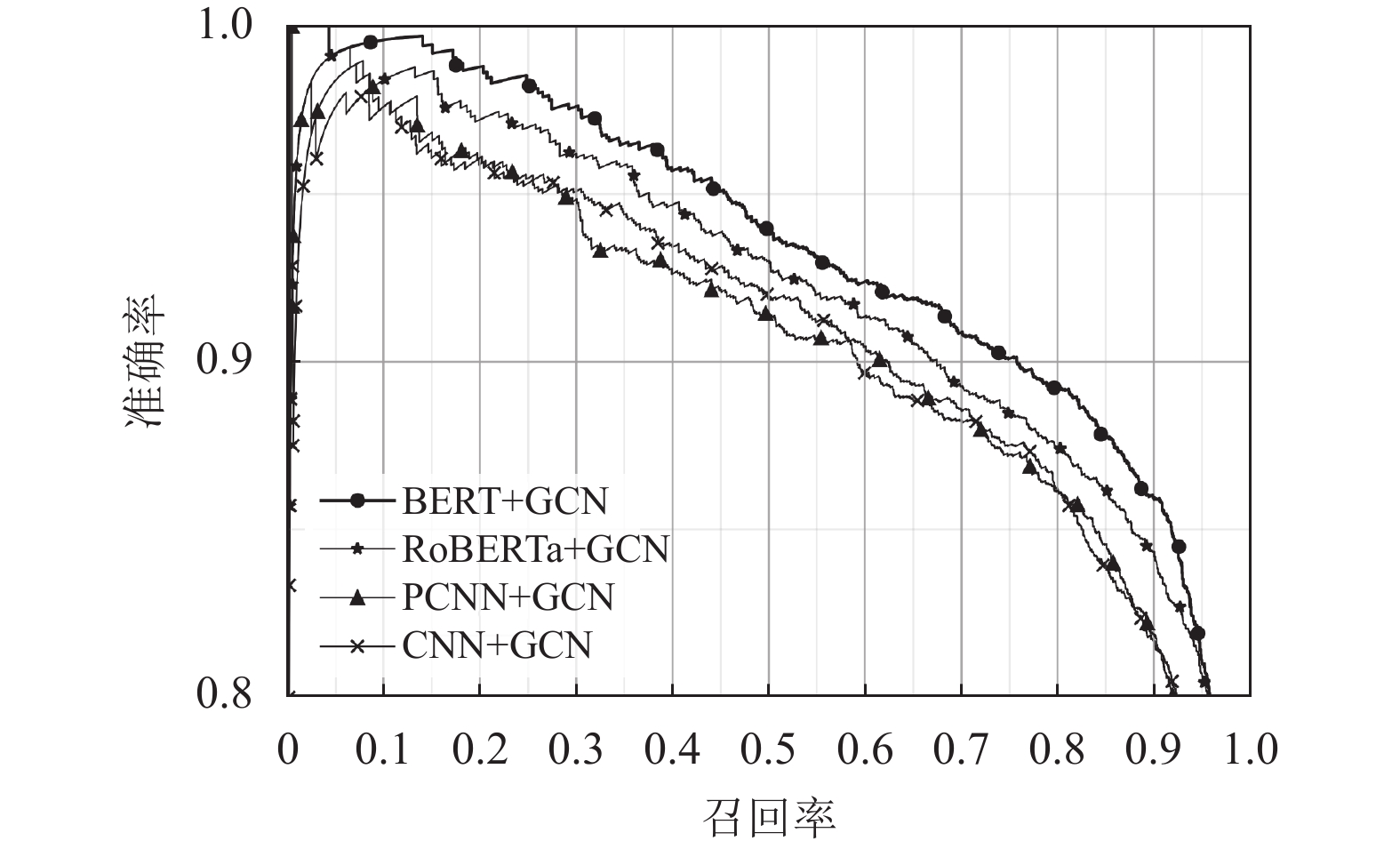

3.7 消融实验本文对于句子编码器部分进行了对比试验, 如图5, 主要采取了传统模型CNN、PCNN以及预训练模型BERT、RoBERTa作为句子编码器进行对比. 句子编码器与外部知识增强模块结合方式如图2, 编码器会将句包文本转为向量表征, 与外部知识增强模块的类型信息表征进行融合, 再继续进行关系抽取的多分类任务. 实验发现传统模型CNN与PCNN, 在NYT-10数据集上AUC值有明显提升. 主要原因是NYT-10数据集的噪声影响严重, 而PCNN相较于CNN引入了位置编码和分段最大池化技术, 对句包文本特征提取和降噪的效果更优, 鲁棒性更强. 预训练模型BERT、RoBERTa相比于PCNN模型AUC值均有一定提升, 说明预训练模型相比于传统模型捕捉上下文信息的能力更强, 因为在大量语料上进行过预训练, 从而泛化能力更优.

本文在句子编码器部分相对于传统模型PCNN添加了(实体-感知)词嵌入[10]的方式, 同时还增加了基于图卷积GCN的知识增强模块, 针对这两部分改进进行了相关消融实验来验证有效性. 根据表7和表8可知, 去除了知识增强模块(w/o GCN)后, PCNN+GCN和BERT+GCN在GDS和NYT-10数据集上AUC值均有明显下降. 说明GCN可以学习到关系标签之间更明确的相关性, 即正确的关系规则, 提高了DSRE任务的抽取性能. 去除了(实体-感知)词嵌入(w/o ENT)后, 在GDS和NYT-10数据集上PCNN+GCN和BERT+GCN模型AUC值都有一定下降, 说明实体信息的嵌入对于编码器在特征抽取过程中句包文本信息进行了很好的补充.

|

图 5 GDS数据集上模型对比PR曲线图 |

| 表 7 GDS数据集上模型AUC值(%) |

| 表 8 NYT数据集上模型AUC值(%) |

4 总结

本文提出了一种基于外部知识增强的远程监督关系抽取模型, 能有效地处理远程监督所带来的噪声和长尾问题. 通过句子编码器中词嵌入的优化以及外部知识引入的实体类型和关系类型信息, 提升了模型对于句包文本的特征提取效果, 从而缓解了噪声示例对DSRE任务的影响. 同时外部知识增强模块利用了GCN神经网络, 能很好地将头节点的信息通过神经网络的边传递到长尾节点, 丰富长尾节点信息的同时, 缓解了长尾示例带来的模型训练不充足的问题. 但是外部知识的引入不能从根本上解决实际场景的远程监督数据集的问题, 因为外部引入的实体类型和关系类型信息, 不能够囊括所有领域. 未来希望在跨领域且低资源的远程监督数据下进行关系抽取研究.

| [1] |

Mintz M, Bills S, Snow R, et al. Distant supervision for relation extraction without labeled data. Proceedings of the Joint Conference of the 47th Annual Meeting of the ACL and the 4th International Joint Conference on Natural Language Processing of the AFNLP. Suntec: ACL, 2009. 1003–1011.

|

| [2] |

Ji GL, Liu K, He SZ, et al. Distant supervision for relation extraction with sentence-level attention and entity descriptions. Proceedings of the 31th AAAI Conference on Artificial Intelligence. San Francisco: AAAI, 2017. 3060–3066.

|

| [3] |

Liu Y, Liu K, Xu LH, et al. Exploring fine-grained entity type constraints for distantly supervised relation extraction. Proceedings of the 25th International Conference on Computational Linguistics: Technical Papers. Dublin: ACL, 2014. 2107–2116.

|

| [4] |

Wang GY, Zhang W, Wang RX, et al. Label-free distant supervision for relation extraction via knowledge graph embedding. Proceedings of 2018 Conference on Empirical Methods in Natural Language Processing. Brussels: ACL, 2018. 2246–2255.

|

| [5] |

Riedel S, Yao LM, McCallum A. Modeling relations and their mentions without labeled text. Proceedings of the 2010 European Conference on Machine Learning and Knowledge Discovery in Databases. Barcelona: Springer, 2010. 148–163.

|

| [6] |

Zhou ZH. Multi-instance learning: A survey. Technical Report, Nanjing: Nanjing University, 2004.

|

| [7] |

Zeng DJ, Liu K, Chen YB, et al. Distant supervision for relation extraction via piecewise convolutional neural networks. Proceedings of the 2015 Conference on Empirical Methods in Natural Language Processing. Lisbon: ACL, 2015. 1753–1762.

|

| [8] |

Lin YK, Shen SQ, Liu ZY, et al. Neural relation extraction with selective attention over instances. Proceedings of the 54th Annual Meeting of the Association for Computational Linguistics. Berlin: ACL, 2016. 2124–2133.

|

| [9] |

Vashishth S, Joshi R, Prayaga SS, et al. RESIDE: Improving distantly-supervised neural relation extraction using side information. Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. Brussels: ACL, 2018. 1257–1266.

|

| [10] |

Li Y, Long GD, Shen T, et al. Self-attention enhanced selective gate with entity-aware embedding for distantly supervised relation extraction. Proceedings of the 34th AAAI Conference on Artificial Intelligence. New York: AAAI, 2020. 8269–8276.

|

| [11] |

Xu P, Barbosa D. Investigations on knowledge base embedding for relation prediction and extraction. arXiv:1802.02114, 2018.

|

| [12] |

Bastings J, Titov I, Aziz W, et al. Graph convolutional encoders for syntax-aware neural machine translation. Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing. Copenhagen: ACL, 2017. 1957–1967.

|

| [13] |

Strubell E, McCallum A. Dependency parsing with dilated iterated graph CNNs. Proceedings of the 2nd Workshop on Structured Prediction for Natural Language Processing. Copenhagen: ACL, 2017. 1–6.

|

| [14] |

Devlin J, Chang MW, Lee K, et al. BERT: Pre-training of deep bidirectional transformers for language understanding. Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. Minneapolis: ACL, 2019. 4171–4186.

|

| [15] |

Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need. Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach: Curran Associates Inc., 2017. 6000–6010.

|

| [16] |

Liu YH, Ott M, Goyal N, et al. RoBERTa: A robustly optimized BERT pretraining approach. arXiv:1907.11692, 2019.

|

| [17] |

Bollacker K, Evans C, Paritosh P, et al. Freebase: A collaboratively created graph database for structuring human knowledge. Proceedings of the 2008 ACM SIGMOD International Conference on Management of Data. Vancouver: ACM, 2008. 1247–1250.

|

| [18] |

Jat S, Khandelwal S, Talukdar P. Improving distantly supervised relation extraction using word and entity based attention. arXiv:1804.06987, 2018.

|

| [19] |

Han X, Yu PF, Liu ZY, et al. Hierarchical relation extraction with coarse-to-fine grained attention. Proceedings of 2018 Conference on Empirical Methods in Natural Language Processing. Brussels: ACL, 2018. 2236–2245.

|

| [20] |

Ye ZX, Ling ZH. Distant supervision relation extraction with intra-bag and inter-bag attentions. Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1. Minneapolis: ACL, 2019. 2810–2819.

|

| [21] |

Alt C, M Hübner, Hennig L. Fine-tuning pre-trained transformer language models to distantly supervised relation extraction. Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics. Florence: ACL, 2019. 1388–1398.

|

| [22] |

Christopoulou F, Miwa M, Ananiadou S. Distantly supervised relation extraction with sentence reconstruction and knowledge base priors. Proceedings of 2021 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies. ACL, 2021. 11–26.

|

2023, Vol. 32

2023, Vol. 32